Les moteurs de recherche ont toujours été essentiels pour trouver des informations, mais le comportement des utilisateurs a évolué. Au lieu de simples recherches par mot-clé comme « smartphones », les gens posent désormais des requêtes plus spécifiques et personnalisées comme « meilleurs téléphones à petit prix pour les jeux ».

Parallèlement, les grands modèles linguistiques (LLM) tels que ChatGPT transforment la recherche en agissant comme des systèmes intelligents de questions-réponses.

En s'intégrant aux moteurs de recherche traditionnels, ils améliorent la recherche d'informations grâce à la génération augmentée par la recherche (RAG), rendant les résultats plus précis et plus sensibles au contexte.

Plutôt que de se faire concurrence, les LLM et les moteurs de recherche travaillent ensemble pour traiter plus efficacement les requêtes complexes. Dans cet article, nous explorerons comment cette intégration façonne l'avenir de la recherche.

⏰ Résumé en 60 secondes

- Les moteurs de recherche traditionnels ont souvent du mal à gérer de grands ensembles de données, à assurer la maintenance de la qualité des données et à briser les silos.

- Ils sont également confrontés à des défis en matière de sécurité, d'évolutivité et de fourniture de résultats pertinents sur le plan contextuel.

- Les grands modèles linguistiques, tels que ChatGPT, améliorent la précision des recherches, permettent la recherche sémantique et offrent l’assistance pour les requêtes en langage naturel.

- Les LLM améliorent également les capacités de recherche multimodale et rendent la découverte de connaissances plus personnalisée et plus efficace.

- Les fonctionnalités de recherche connectée et d'IA de ClickUp s'appuient sur ces avancées en centralisant vos données, ce qui permet une récupération rapide et précise des informations.

- ClickUp s'intègre parfaitement à diverses plateformes, offrant un accès en temps réel à votre contenu, rationalisant les flux de travail et améliorant la productivité globale.

Sans plus attendre, plongeons-nous dans le vif du sujet !

Que sont les LLM ?

Les grands modèles linguistiques (LLM) sont des systèmes d'intelligence artificielle avancés qui traitent et génèrent le langage humain. Ils sont entraînés à partir de vastes ensembles de données de texte, ce qui leur permet d'effectuer des tâches telles que la traduction, la résumation et les discussions.

Parmi les exemples les plus populaires de LLM, on peut citer GPT-3 et GPT-4, largement reconnus pour leur capacité à traiter des requêtes linguistiques complexes.

Contrairement aux moteurs de recherche traditionnels qui dépendent de mots-clés, un moteur de recherche basé sur le LLM va au-delà des requêtes superficielles. Il comprend le contexte et l'intention derrière les questions, fournissant des réponses directes et détaillées.

👀 Le saviez-vous ? 71 % des utilisateurs préfèrent la personnalisation de la part des marques et des entreprises qu'ils choisissent.

Fonctionnalités des moteurs de recherche LLM

Les moteurs de recherche LLM offrent des fonctionnalités avancées qui redéfinissent la manière dont les utilisateurs accèdent aux informations et interagissent avec elles. Examinons leurs principales fonctionnalités :

- Compréhension sémantique des requêtes : les moteurs de recherche LLM interprètent le sens des requêtes de recherche, allant au-delà des mots-clés pour comprendre l'intention et le contexte de l'utilisateur.

- Traitement du langage naturel (NLP) : les utilisateurs peuvent formuler leurs requêtes de manière conversationnelle sans avoir besoin de mots-clés exacts, ce qui rend les recherches plus intuitives.

- Pertinence contextuelle : les résultats de recherche sont personnalisés en fonction des requêtes et interactions précédentes, garantissant ainsi des informations plus pertinentes et actualisées.

- Génération de réponses : ces systèmes fournissent des réponses complètes directement dans les résultats de recherche, notamment des résumés, des explications et même des formats créatifs tels que des récits ou des guides étape par étape.

- Intégration de graphes de connaissances : les moteurs de recherche LLM utilisent des graphes de connaissances pour établir des connexions entre des concepts et des entités connexes, offrant ainsi des informations plus approfondies.

- Recherche conversationnelle : les utilisateurs peuvent engager une discussion, poser des questions complémentaires et affiner leurs recherches pour une expérience plus interactive.

- Résultats adaptatifs : les résultats s'ajustent dynamiquement en fonction de l'emplacement, des intérêts et des recherches précédentes, offrant ainsi une expérience plus personnalisée.

- Synthèse de l'information : au lieu de s'appuyer sur une seule source, les moteurs de recherche LLM agrègent les données provenant de plusieurs sources, offrant ainsi une perspective plus large.

👀 Le saviez-vous ? Avec l'utilisation croissante des enceintes connectées et des assistants vocaux, 50 % de toutes les recherches sont désormais effectuées à la voix. À mesure que les grands modèles linguistiques seront intégrés à ces systèmes, les recherches vocales deviendront encore plus précises, offrant un accès plus rapide aux informations sur plusieurs plateformes, qu'il s'agisse de fichiers, de tâches ou de notes de réunion.

Techniques de recherche avancées avec les LLM

À mesure que la technologie de recherche progresse, les LLM tels que GPT-4, BERT et T5 transforment la manière dont les moteurs de recherche traitent les requêtes, personnalisent les résultats et affinent les classements. Découvrons comment ces modèles redéfinissent l'avenir de la recherche.

Comment les LLM envoient les requêtes de recherche

La recherche a évolué, passant de simples requêtes par mot-clé à des recherches sémantiques par vecteur. Au lieu de rechercher un terme spécifique comme « Mont Fuji », les utilisateurs peuvent rechercher « montagnes au Japon » et le système renvoie des résultats basés sur le sens.

Reformuler les requêtes sous forme de questions, par exemple « Quelles sont les montagnes célèbres au Japon ? », permet d'affiner la précision de la recherche. Les modèles linguistiques à grande échelle (LLM) améliorent également les recherches en déclenchant des requêtes supplémentaires si le niveau de confiance est faible, à l'aide de techniques telles que FLARE.

Le raisonnement en chaîne améliore encore les recherches en décomposant les tâches en étapes logiques, comme le montre AutoGPT. De plus, la recherche conversationnelle permet aux assistants alimentés par LLM d'affiner les requêtes en temps réel, garantissant ainsi des résultats plus précis tout au long d'une interaction.

Recherche personnalisée et prise en compte du contexte

La prise en compte du contexte est l'une des fonctionnalités les plus puissantes des LLM. Contrairement aux moteurs de recherche traditionnels, qui classent les résultats en fonction des correspondances de mots-clés, les LLM tiennent compte de l'intention de l'utilisateur, de son emplacement, de son historique de recherche et de ses interactions passées.

Grâce à un ajustement précis avec des données spécifiques au domaine, les LLM personnalisent les résultats de recherche afin de reconnaître les modèles et de hiérarchiser les contenus pertinents. Par exemple, un utilisateur qui recherche fréquemment des recettes végétaliennes verra s'afficher des options à base de plantes lorsqu'il recherchera les « meilleures recettes pour le dîner ».

Les LLM interprètent également les requêtes multimodales, en comprenant à la fois le texte et les images pour obtenir des résultats plus précis. De plus, ils créent un contexte longitudinal, en apprenant des interactions continues afin de suggérer de manière proactive des requêtes pertinentes.

Les LLM dans le reclassement et l'amélioration des résultats des moteurs de recherche

Les LLM améliorent les moteurs de recherche en réorganisant dynamiquement les résultats afin de mieux refléter l'intention de l'utilisateur. Contrairement au classement traditionnel basé sur des mots-clés, les LLM utilisent des mécanismes d'attention pour analyser le contexte complet d'une requête et hiérarchiser le contenu pertinent.

Par exemple, la mise à jour BERT (Bidirectional Encoder Representations from Transformers) de Google a révolutionné la recherche en comprenant le contexte derrière des mots tels que « apple » (pomme) et « Apple » (entreprise technologique).

Les LLM contribuent également à améliorer l'efficacité des SERP (pages de résultats des moteurs de recherche). En analysant des facteurs tels que le taux de clics (CTR), le taux de rebond et le temps de visite, les LLM peuvent ajuster les classements en temps réel, améliorant ainsi les résultats qui suscitent un engagement élevé de la part des utilisateurs.

📖 À lire également : Comment rechercher rapidement des fichiers PDF

Outils populaires de moteurs de recherche LLM

À mesure que la recherche basée sur l'IA évolue, plusieurs moteurs de recherche utilisant des modèles linguistiques de grande taille gagnent en popularité grâce à leurs capacités avancées. Perplexity AI fournit des réponses directes avec des sources citées, rendant les recherches plus interactives et informatives.

You. com offre une expérience personnalisable, permettant aux utilisateurs de hiérarchiser les sources, d'intégrer des résumés générés par l'IA et d'interagir avec des assistants IA.

Nous savons tous que nous pouvons nous tourner vers ces moteurs de recherche pour récupérer des informations et obtenir des réponses rapides. Mais qu'en est-il de l'emplacement d'un fichier crucial au travail ? Ou de la récupération d'une discussion riche en données pour votre prochaine grande présentation ?

C'est là que ClickUp, l'application tout-en-un pour le travail, entre en scène !

📮 ClickUp Insight : 46 % des travailleurs du savoir s'appuient sur une combinaison de chat, de notes, d'outils de gestion de projet et de documentation d'équipe simplement pour suivre leur travail. Pour eux, le travail est dispersé sur des plateformes déconnectées, ce qui rend plus difficile l'organisation. En tant qu'application tout-en-un pour le travail, ClickUp unifie tout cela. Grâce à des fonctionnalités telles que ClickUp E-mail gestion de projet, ClickUp Notes, ClickUp Chat et ClickUp Brain, tout votre travail est centralisé en un seul endroit, consultable et connecté de manière transparente. Dites adieu à la surcharge d'outils et bonjour à une productivité sans effort.

ClickUp Brain combine des capacités de recherche avancées avec des fonctionnalités complètes de gestion de projet, permettant la connexion des tâches, des fichiers, des membres de l'équipe et des projets en un seul endroit. Plus besoin de passer d'une application à l'autre ou de gérer des outils fragmentés et des silos d'informations !

Les coûts liés à l'inefficacité due à des outils déconnectés sont stupéfiants :

- 2,5 heures/jour : les travailleurs du savoir consacrent environ 30 % de leur journée de travail à la recherche d'informations.

- 3 600 changements d'application par jour : les employés activent/désactivent les applications et les fenêtres plus de 3 600 fois par jour, perdant ainsi 4 heures par semaine à se réorienter.

- 23 minutes perdues : chaque changement d'application perturbe la concentration, et il faut près de 23 minutes pour se remettre dans le bain.

420 000 dollars par an: c'est la somme que perdent chaque année les entreprises de 100 employés en raison d'une mauvaise communication et d'outils déconnectés.

Ces inefficacités entraînent une perte de temps, une baisse du moral et une augmentation des coûts opérationnels. Heureusement, l'IA connectée transforme ces défis en opportunités pour une prise de décision plus intelligente, une récupération plus rapide des informations et une exécution sans faille.

Voici comment la recherche connectée de ClickUp transforme la collaboration :

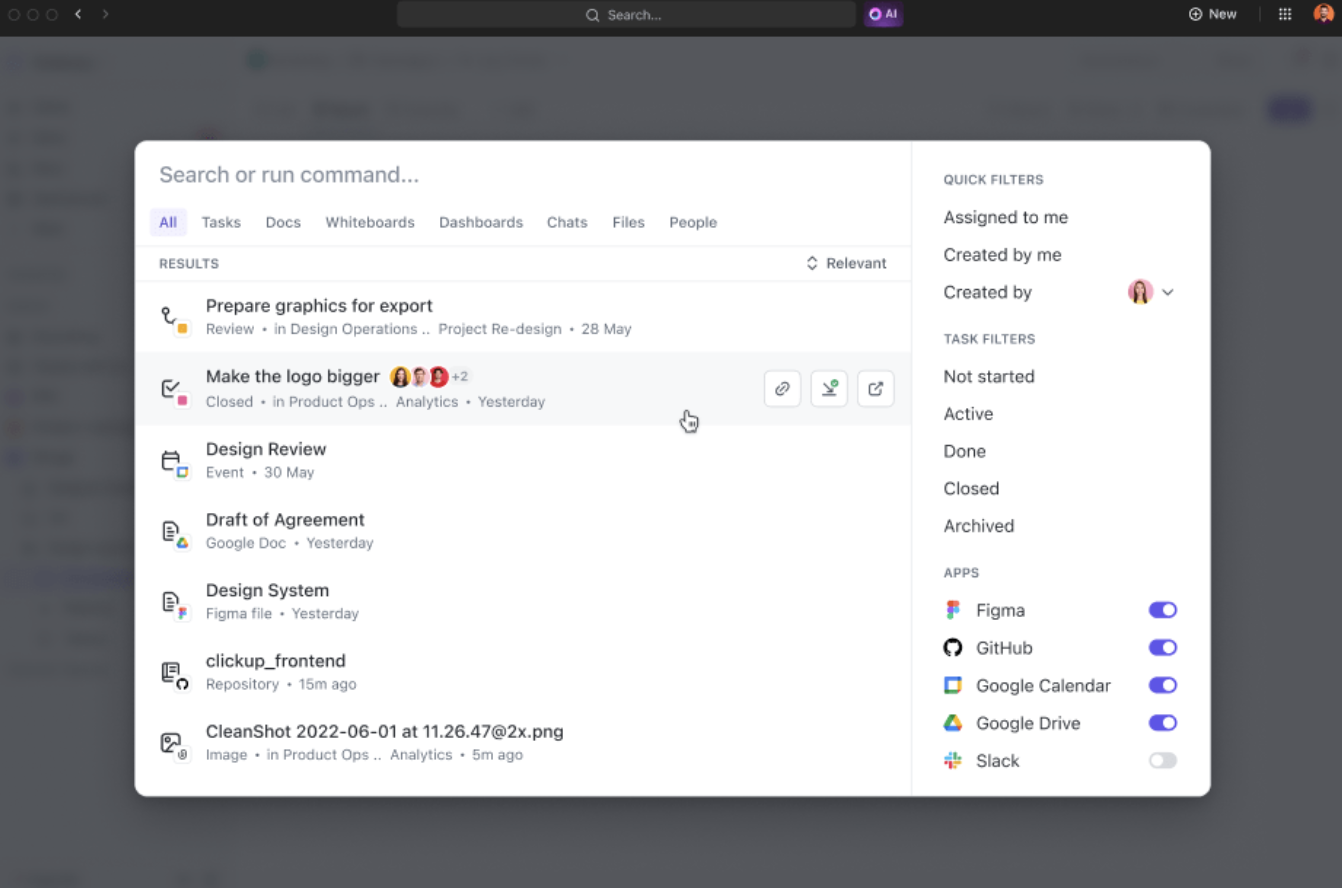

- Recherche unifiée : accédez à toutes les informations de votre entreprise à partir d'une seule plateforme, ce qui vous permet de gagner près de quatre heures par semaine en réduisant le nombre d'applications à activer/désactiver.

- Pertinence basée sur l'IA : obtenez des résultats de recherche personnalisés et adaptés au contexte de vos projets, améliorant ainsi la prise de décision grâce à un accès instantané aux informations les plus pertinentes.

- Intégration facile des outils : effectuez une connexion transparente avec des outils existants tels que Google Drive, SharePoint, Figma et Slack sans avoir besoin d'une installation complexe.

Par exemple, lorsque vous revenez de vacances, il vous suffit de demander à ClickUp Brain des informations sur l'avancement de vos projets. Il vous fournira une liste claire et organisée des éléments importants à mener et des discussions qui ont eu lieu pendant votre absence.

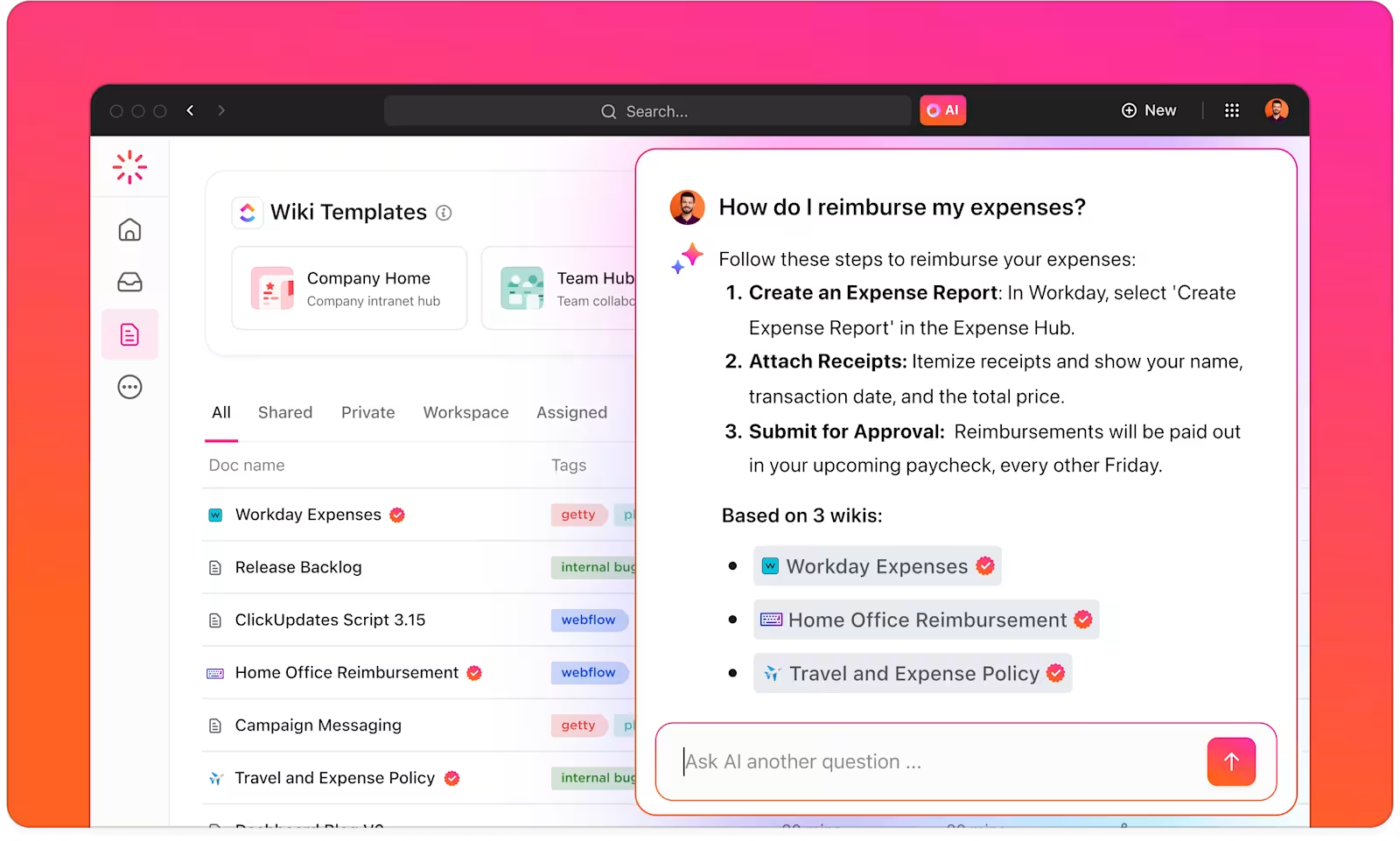

Avec ClickUp Brain, vous disposez d'un gestionnaire de connaissances intelligent qui vous aide à trouver tout ce dont vous avez besoin dans votre environnement de travail et vos applications connectées.

ClickUp Brain comprend le contexte de vos tâches et vous propose des suggestions pertinentes en fonction de vos préférences de travail ou de vos activités principales. Pour les créateurs de contenu, par exemple, il fournit des suggestions pour la création de contenu, le brainstorming et les tâches connexes.

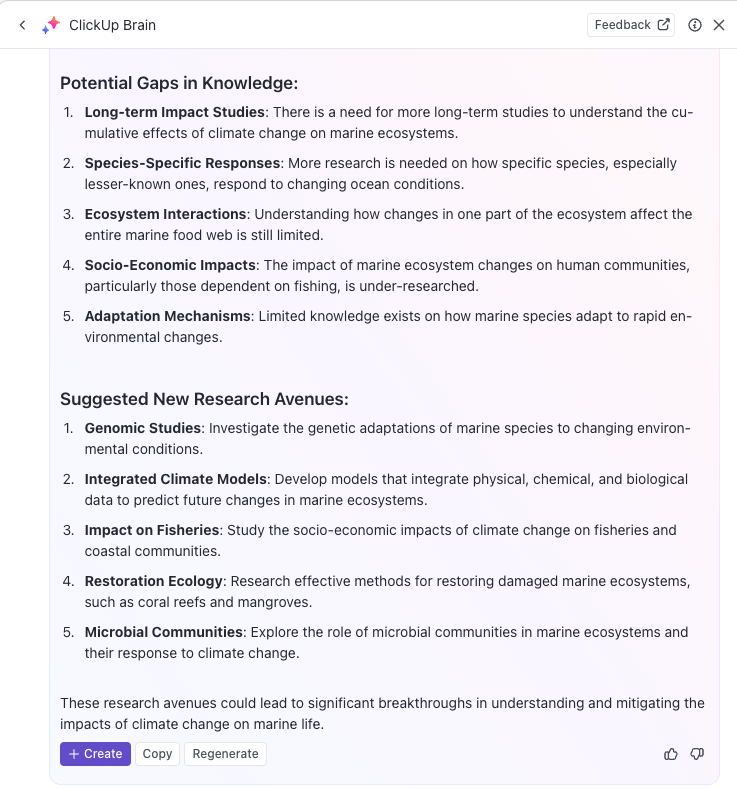

Vous pouvez même utiliser l'IA pour réaliser l'automatisation de tâches répétitives ou mettre à jour le statut des tâches à l'aide de simples invites, ce qui vous permet de vous concentrer sur des tâches plus complexes. Si vous recherchez un moteur de recherche IA puissant pour booster votre productivité, ClickUp Brain est la solution qu'il vous faut.

Avec ClickUp Brain, vous pouvez optimiser votre base de connaissances en classant, ajoutant des étiquettes et organisant automatiquement toutes les informations pertinentes.

Par exemple, les équipes de recherche peuvent utiliser ClickUp pour créer un système centralisé de gestion des connaissances afin de stocker toutes les informations, tous les documents et tous les résultats de recherche dans un format facilement accessible.

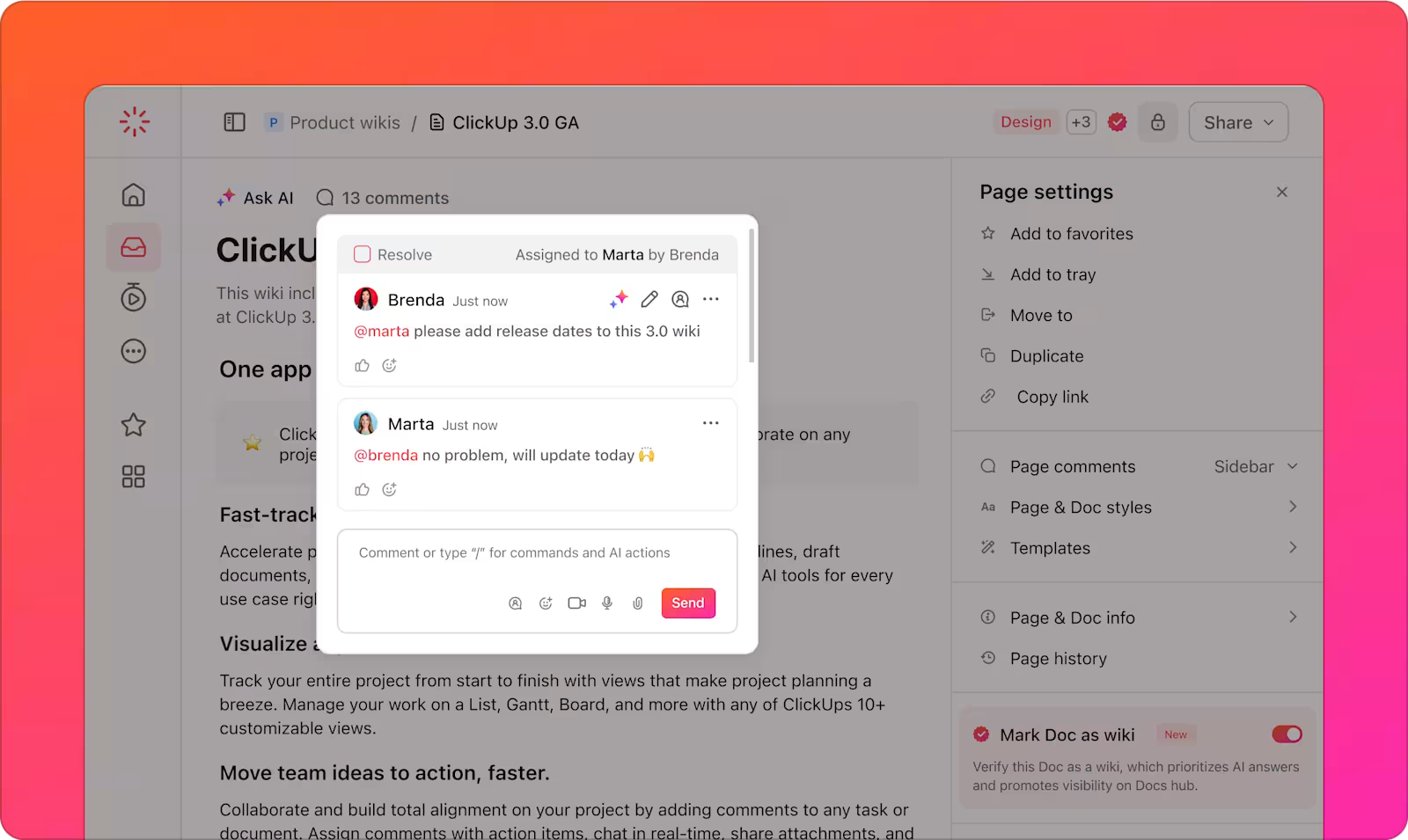

De plus, la polyvalence de ClickUp Docs permet la création de wikis, de référentiels de documents et la gestion des tâches liées aux connaissances.

Vous pouvez également organiser les informations de différentes manières, en utilisant les espaces, les dossiers et les listes ClickUp pour structurer le contenu et le retrouver rapidement. Votre équipe peut facilement trouver et accéder aux données appropriées lorsqu'elle en a besoin, sans perdre de temps à effectuer des recherches sur plusieurs plateformes.

De plus, la plateforme permet de suivre les tâches et les projets via les tâches ClickUp grâce aux informations obtenues à partir des moteurs de recherche LLM. Vous pouvez intégrer les résultats de recherche basés sur l'IA directement dans vos flux de travail de suivi des tâches et des projets, ce qui facilite la mise en œuvre des connaissances que vous avez découvertes.

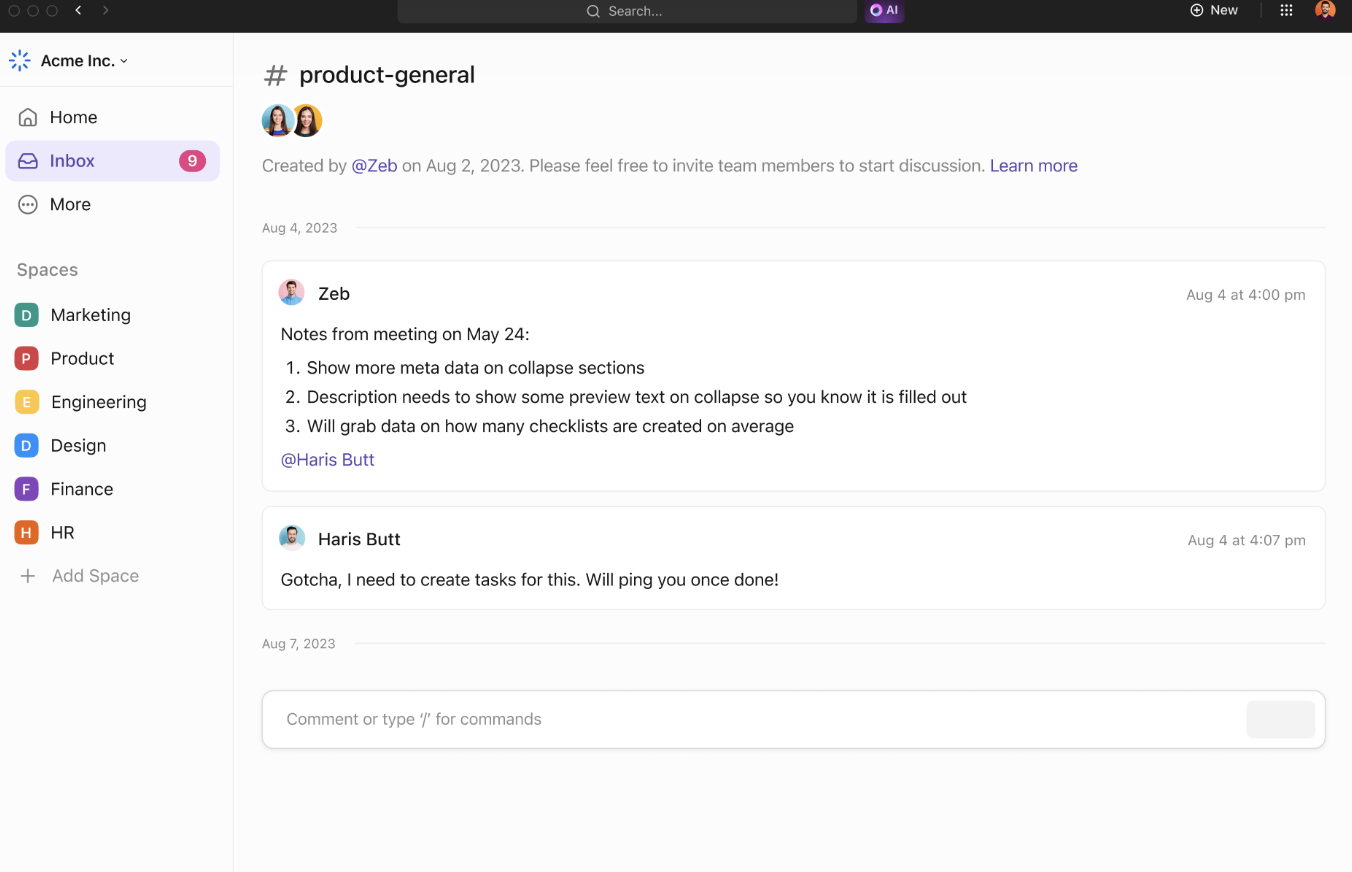

Les outils de collaboration de ClickUp renforcent encore l'efficacité des équipes et le partage d'informations. ClickUp Chat permet aux membres de l'équipe de discuter des projets, de partager leurs idées et de poser des questions en temps réel.

Les commentaires assignés permettent de communiquer clairement sur des documents ou des tâches spécifiques, garantissant ainsi que tout le monde reste informé des mises à jour du projet.

Les équipes peuvent collaborer en partageant des idées et en visualisant des concepts. Ajoutez des notes, téléchargez des images et intégrez des liens pour améliorer le contexte. Utilisez des connecteurs pour lier les idées et mettre en évidence leurs relations.

Lorsque vos idées sont prêtes, convertissez-les en tâches suivibles à partir des tableaux blancs ClickUp afin de respecter le calendrier prévu.

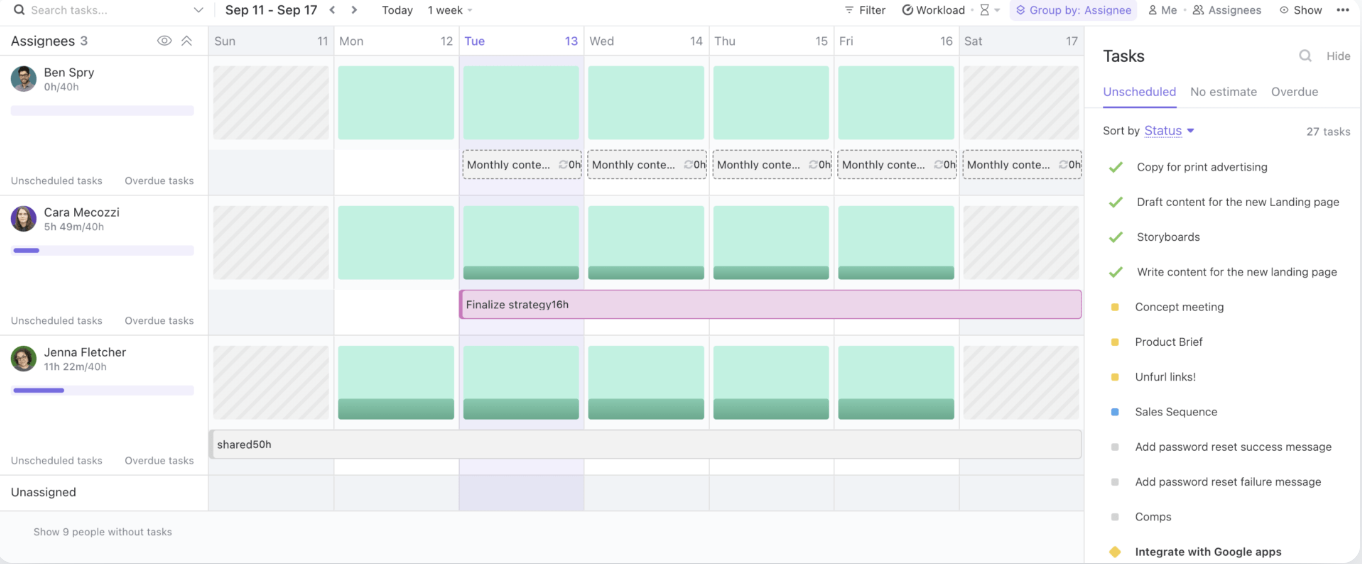

Enfin, la vue « Charge de travail » de ClickUp vous permet de gérer la capacité de votre équipe, de suivre les tâches en cours et d'allouer efficacement les ressources.

En fournissant un hub central pour le partage des connaissances et la collaboration, ClickUp rationalise les flux de travail et améliore l'efficacité des équipes.

📖 À lire également : Les meilleurs logiciels de gestion de documents pour s'organiser

Bonnes pratiques pour l'utilisation des moteurs de recherche LLM

Lorsque vous utilisez des moteurs de recherche LLM, il est essentiel de suivre les bonnes pratiques qui maximisent leur potentiel tout en gérant les risques.

Ces stratégies vous aideront à tirer le meilleur parti de vos outils basés sur l'IA, en garantissant une mise en œuvre fluide et une réussite à long terme :

- Définissez des cas d'utilisation clairs : collaborez dès le début entre les équipes de l'entreprise et techniques afin d'établir des cas d'utilisation spécifiques et mesurables. Alignez les objectifs afin de vous assurer que la solution répond aux besoins appropriés et facilite l'évaluation de la progression.

- Mettez en place des processus d'admission réfléchis : tenez compte de la sensibilité des données, des risques potentiels et des utilisateurs visés lorsque vous hiérarchisez les cas d'utilisation. Utilisez une approche par niveaux de risque pour évaluer quels projets offrent le plus de valeur avec un minimum de dommages.

- Concentrez-vous sur la collecte, le test et la validation des données : garantissez des données fiables et factuelles en améliorant les pratiques de collecte, de libellé, de stockage et de traitement.

- Mettez en œuvre des procédures de test standardisées : créez des processus de test reproductibles s'appuyant sur des guides et des pratiques prédéfinies. Assurez-vous d'obtenir des résultats cohérents, un système fiable et des modèles d'IA bien testés avant le déploiement.

- Mettez en place une surveillance continue : surveillez les performances du système au fil du temps, en vous adaptant à l'évolution des données, du comportement des utilisateurs et de la technologie.

- Déployez des campagnes de formation et de communication : dotez votre équipe des connaissances nécessaires pour utiliser les Outils d'IA de manière responsable et efficace. Lancez des programmes de formation et de communication qui couvrent à la fois les aspects techniques et éthiques de l'IA.

Défis et solutions dans la recherche basée sur le LLM

Les moteurs de recherche basés sur le LLM offrent un potentiel énorme, mais ils posent également un certain nombre de défis. Vous trouverez ci-dessous quelques défis courants liés à l'IA et des solutions pratiques pour les surmonter :

Qualité et pertinence des données

Les moteurs de recherche basés sur le LLM dépendent fortement de la qualité et de la pertinence des données qu'ils traitent. Des données de mauvaise qualité ou obsolètes peuvent entraîner des résultats de recherche inexacts ou non pertinents, ce qui nuit à l'expérience de l'utilisateur.

✨ En se concentrant sur des données de haute qualité et à jour, les organisations peuvent s'assurer que leur moteur de recherche alimenté par LLM renvoie des résultats pertinents et fiables.

Manque de transparence

Les modèles LLM sont souvent considérés comme des « boîtes noires », dont le raisonnement à l'origine des résultats n'est pas immédiatement apparent pour les utilisateurs. Ce manque de transparence peut rendre difficile pour les utilisateurs de faire confiance aux résultats qu'ils obtiennent.

✨ En intégrant des fonctionnalités d'explicabilité au moteur de recherche, les organisations peuvent donner aux utilisateurs des informations sur les raisons pour lesquelles des résultats spécifiques ont été renvoyés.

Biais et préoccupations éthiques

Les LLM peuvent hériter des biais des données sur lesquelles ils sont entraînés, ce qui peut conduire à des résultats biaisés ou contraires à l'éthique. Si les données d'entraînement ne sont pas diversifiées ou représentatives, le moteur de recherche peut refléter ces biais, ce qui a un impact sur la prise de décision et l'équité.

✨ Il est essentiel de vérifier et de mettre à jour régulièrement les données d'entraînement afin d'identifier et d'atténuer ces biais. De plus, l'intégration de divers ensembles de données et la surveillance des résultats garantissent que le moteur de recherche produit des résultats plus équilibrés, équitables et éthiques.

Complexité et intégration du système

L'intégration de moteurs de recherche basés sur le LLM dans les flux de travail et les applications existants peut s'avérer difficile, notamment lorsqu'il s'agit de systèmes hérités ou de sources de données multiples. La complexité de la connexion de ces nouveaux outils à des plateformes établies peut ralentir la mise en œuvre.

✨ Grâce à la recherche connectée de ClickUp, vous pouvez trouver rapidement n'importe quel fichier, qu'il soit stocké dans ClickUp, dans une application connectée ou sur votre disque local.

Le problème des hallucinations

Les hallucinations désignent les instances où le modèle génère des informations factuellement incorrectes, inventées ou non pertinentes. Cela se produit parce que le modèle, plutôt que de puiser directement dans des sources indexées, « hallucine » parfois des données basées sur des modèles appris pendant l'entraînement.

✨ Des techniques avancées telles que l'ingénierie des invites et les données d'entraînement de haute qualité améliorent la fiabilité des LLM. Le réglage fin à l'aide de données spécifiques au domaine réduit les hallucinations, tandis que l'intégration de graphiques de connaissances garantit des résultats de recherche précis et fondés sur des faits.

📖 À lire également : Comment créer un environnement de travail collaboratif pour optimiser la productivité

L'avenir de la recherche avec les LLM

La prochaine génération de moteurs de recherche basés sur le LLM promet une précision, une adaptabilité et une réactivité encore plus grandes, en particulier dans le traitement des requêtes complexes et dynamiques des utilisateurs. Ces systèmes s'adapteront de manière dynamique à l'évolution des besoins des utilisateurs, en tirant des enseignements des interactions antérieures et des données en temps réel.

Par exemple, dans un contexte d'entreprise, un LLM pourrait interpréter une requête telle que « Trouver l'analyse du taux de désabonnement des clients du dernier trimestre » et renvoyer non seulement le fichier brut, mais aussi des informations synthétisées, des tendances pertinentes et des conclusions exploitables.

Les secteurs qui dépendent de la gestion d'ensembles de données vastes et complexes sont ceux qui ont le plus à gagner :

- Dans le domaine de la santé, les grands modèles linguistiques peuvent fournir une assistance pour améliorer la précision des diagnostics en analysant et en recoupant en quelques secondes les notes cliniques, les résultats d'imagerie et les articles de recherche.

- Les professionnels du droit bénéficieront d'outils capables d'analyser une jurisprudence d'extension afin de mettre en évidence les précédents pertinents.

- Les équipes financières peuvent utiliser les LLM pour des tâches telles que la détection des fraudes en temps réel, l'analyse prédictive des marchés et l'automatisation des contrôles de conformité.

L'intégration de capacités de recherche multimodales, combinant la reconnaissance du texte, de voix et d'images, élargira encore davantage l'utilité des LLM.

Par exemple, une équipe collaborant au lancement d'un produit pourrait instantanément télécharger des images, les annoter à l'aide de commandes vocales et récupérer les documents et rapports associés. Ce niveau d'adaptabilité rend les LLM indispensables pour garantir un accès transparent à divers formats de données.

Les plateformes telles que ClickUp, associées à la recherche optimisée par LLM, offrent une solution robuste pour organiser et accéder aux fichiers, optimiser les flux de travail et améliorer l'efficacité de la prise de décision.

Boostez votre flux de travail grâce à la recherche optimisée par LLM

À mesure que les moteurs de recherche basés sur l'IA et alimentés par les LLM continuent d'évoluer, ils révolutionnent la manière dont les entreprises récupèrent les informations sur les pages web et gèrent les données.

Grâce à leur capacité à comprendre le contexte, à fournir des résultats plus précis et à s'intégrer de manière transparente aux flux de travail des entreprises, les LLM ouvrent la voie à des opérations plus intelligentes, plus rapides et plus efficaces.

Et lorsqu'il s'agit de trouver un moteur de recherche IA parfaitement intégré à votre flux de travail, rien ne vaut ClickUp Brain. Que vous ayez besoin de localiser rapidement un fichier ou une tâche, de réfléchir à des idées ou même de rédiger un e-mail, les puissantes capacités IA de ClickUp Brain peuvent tout gérer.

L'intégration avec les outils complets de gestion de projet de ClickUp garantit que tout est à portée de main, vous aidant à rester organisé, à gagner du temps et à prendre plus rapidement des décisions fondées sur les données.

Alors, qu'attendez-vous ? Inscrivez-vous dès aujourd'hui à ClickUp et soyez plus productif grâce à ClickUp Brain !