Die meisten Teams testen LLM-Zusammenfassungs-Tools, indem sie ihnen ein Beispiel-Dokument zuführen und es dann als erledigt betrachten. Das Modell, das Ihre Quartalsberichte perfekt zusammenfasst, könnte Ihre Slack-Threads verhunzen, und das Modell, das sich perfekt für juristische Schriftsätze eignet, könnte Fakten in Ihren Kunden-E-Mails falsch wiedergeben.

Dieser Leitfaden führt Sie durch die besten LLMs für die Textzusammenfassung, zeigt Ihnen, wie Sie diese anhand Ihrer tatsächlichen Workload bewerten können, und erklärt, wie Sie diese Zusammenfassungen direkt mit Maßnahmen in Ihrem Workflow verbinden können.

LLM-Zusammenfassungsmodelle auf einen Blick

| Modell | Am besten geeignet für | Beste Features | Preise |

|---|---|---|---|

| ClickUp Brain | Teams, die eine Zusammenfassung direkt in ihrem Workflow wünschen Größe des Teams: Jedes Team, das ClickUp für Projekte und Kommunikation nutzt | Arbeitsplatzbezogene Zusammenfassungen, Zusammenfassungen von Meetings mit KI-Notetaker, Erstellung von Aktionspunkten, Multi-LLM-Routing, Suche in natürlicher Sprache | Free Forever; Benutzerdefinierte Anpassung für Unternehmen verfügbar |

| OpenAI GPT-4o | Ausgefeilte, für Führungskräfte geeignete Zusammenfassungen Teamgröße: Kleine bis große Teams, die hochwertige abstrakte Ergebnisse benötigen | Menschenähnliche Zusammenfassungen, multimodale Unterstützung, zuverlässige Befolgung von Anweisungen, großes Kontextfenster | API-Bezahlung pro Token, ChatGPT Plus 20 $/Monat |

| Claude 3. 5 Sonett | Compliance-relevante oder hochtechnische Dokumente Teamgröße: Rechts-, Finanz- und Enterprise-Teams | Erweitertes Kontextfenster, geringe Halluzination, hervorragende Steuerung des Formats, starke Argumentation | API-Bezahlung pro Token, Claude Pro-Abonnement |

| Google Gemini 1. 5 Pro | Teams, die intensiv mit Google Workspace arbeiten Teamgröße: Teams aus den Bereichen Betrieb, Forschung und mit vielen Meetings | Bis zu 1 Million Token im Kontextfenster, Integration von Google Meet und Drive, multimodale Zusammenfassung | Nutzungsbasierte Preisgestaltung über Google KI Studio oder Vertex AI |

| Meta LLaMA 3 | Selbst gehostete und anpassbare Zusammenfassungs-Pipelines Teamgröße: Technikorientierte, auf Datenschutz fokussierte Teams | Vollständig selbst gehostet, Feinabstimmungsfunktion, hohe Zusammenfassungsqualität, vollständige Datenkontrolle | Kostenlose Open-Source-Gewichte, Infrastrukturkosten fallen an. |

| Mistral Large | Teams, die EU-Datenresidenz und hybride Bereitstellung benötigen Teamgröße: EU-Unternehmen oder complianceorientierte Organisationen | Hybride verwaltete API oder selbst gehostet, hohe Zusammenfassungsqualität, effiziente Token-Nutzung | Wettbewerbsfähige API-Preise, offene Gewichte verfügbar |

Wie wir Software bei ClickUp bewerten

Unser Redaktionsteam folgt einem transparenten, forschungsgestützten und herstellerneutralen Prozess, sodass Sie darauf vertrauen können, dass unsere Empfehlungen auf dem tatsächlichen Wert des Produkts basieren.

Hier finden Sie eine detaillierte Übersicht darüber, wie wir Software bei ClickUp bewerten.

Worauf sollten Sie bei einem LLM für die Zusammenfassung achten?

Die Wahl des falschen Zusammenfassungsmodells führt zu Geldverschwendung für umständliche APIs, zu Schwierigkeiten mit komplexen Setups oder einfach zu minderwertigen Zusammenfassungen, die nicht hilfreich sind. Bevor Sie sich mit bestimmten Modellen befassen, sollten Sie verstehen, was eine effektive Zusammenfassung von einer generischen Ausgabe unterscheidet, damit Sie eine klügere Wahl treffen können.

Verarbeitet Ihre tatsächlichen Dokumenttypen

Ein Modell, das sich hervorragend für die Zusammenfassung von Forschungsarbeiten eignet, kann Schwierigkeiten mit Slack-Unterhaltungen oder Meeting-Protokollen haben. Suchen Sie nach LLMs, die für die spezifischen Dokumenttypen getestet wurden, mit denen Ihr Team täglich arbeitet – seien es Verträge, Kunden-E-Mails, technische Dokumentationen oder Meeting-Notizen.

Bietet ein ausreichendes Kontextfenster

Das Kontextfenster bestimmt, wie viel Text das Modell in einem einzigen Durchgang verarbeiten kann. Wenn Sie stundenlange Protokolle von Meetings oder lange Forschungsberichte zusammenfassen, benötigen Sie ein Modell mit einem erweiterten Kontextfenster. Andernfalls müssen Sie Dokumente in Teile zerlegen und verlieren dadurch die Kohärenz, die sich aus der gemeinsamen Verarbeitung ergibt.

Ausgewogenes Verhältnis zwischen Geschwindigkeit und Qualität

Einige Modelle legen den Schwerpunkt auf die Inferenzgeschwindigkeit, während andere auf die Ausgabequalität optimiert sind. Für die Echtzeit-Zusammenfassung während Meetings ist die Geschwindigkeit wichtiger. Für die Erstellung von Executive Briefings hat die Qualität Vorrang. Überlegen Sie, wo Ihre Anwendungsfälle in diesem Spektrum liegen.

Bietet geeignete Zugriffsoptionen

Die technischen Ressourcen und Anforderungen an die Sicherheit Ihres Teams sollten ausschlaggebend dafür sein, ob Sie eine verwaltete API, eine selbst gehostete Bereitstellung oder einen hybriden Ansatz benötigen. Teams von Unternehmen mit strengen Datenrichtlinien benötigen möglicherweise lokale Optionen, während kleinere Teams möglicherweise die Bequemlichkeit von Cloud-APIs bevorzugen.

Die 6 besten LLMs für die Textzusammenfassung

Die überwältigende Anzahl verfügbarer Modelle macht die Auswahl des richtigen Modells zu einer Herausforderung. Jedes der unten aufgeführten Modelle ist ein starker Anwärter, aber welches das „beste” ist, hängt ganz von den spezifischen Anforderungen Ihres Teams ab. Wir bewerten sie hinsichtlich Genauigkeit, Kontextfenstergröße, Geschwindigkeit und Zugriffsoptionen.

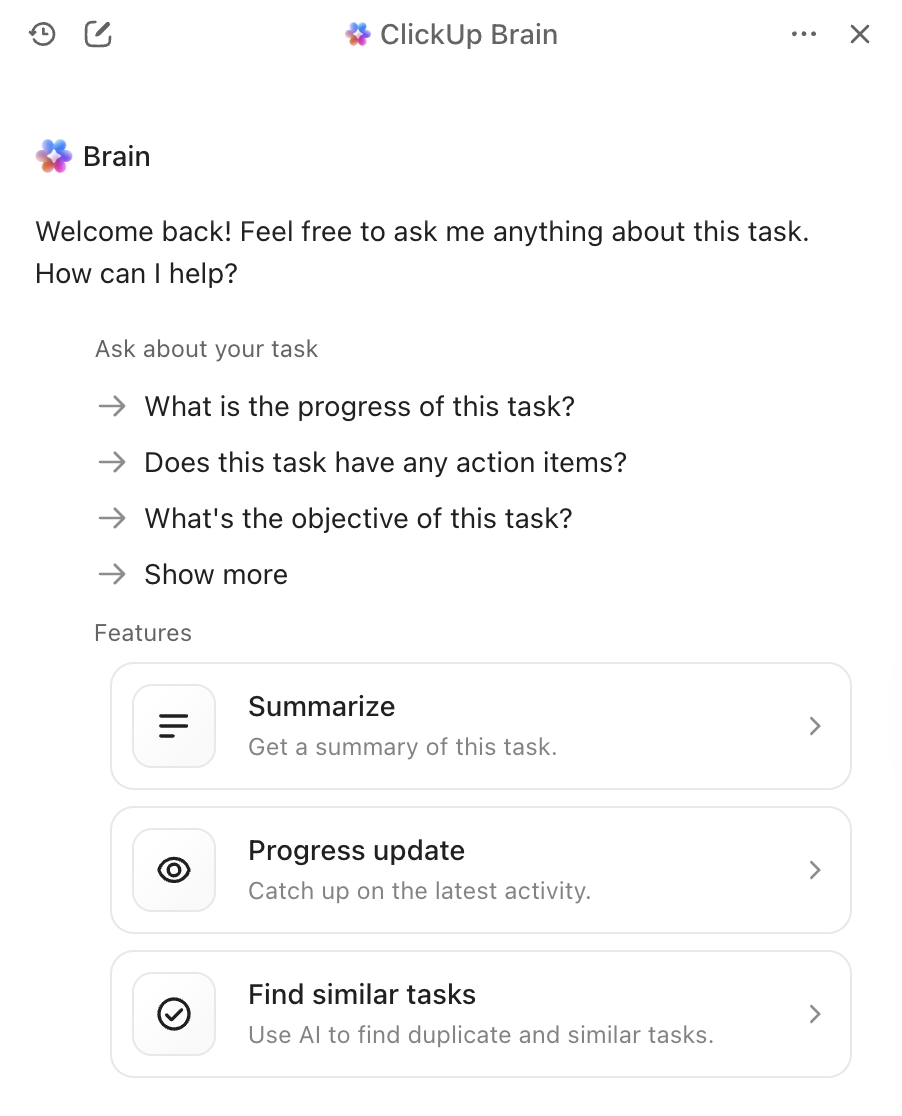

1. ClickUp Brain (am besten geeignet für KI-gestützte Zusammenfassungen innerhalb Ihres Workflows)

Das größte Problem bei eigenständigen Zusammenfassungstools ist nicht die Qualität ihrer Zusammenfassungen, sondern das, was danach passiert. Sie erstellen eine brillante Zusammenfassung, kopieren sie dann manuell in Ihr Projektmanagement-Tool, erstellen daraus Aufgaben und informieren Ihr Team über die nächsten Schritte. ClickUp Brain beseitigt diese Reibungsverluste, indem es die Zusammenfassung direkt in Ihren Workflow integriert.

Mit ClickUp Brain geben Sie einfach @brain in einen beliebigen Aufgabenkommentar oder eine ClickUp-Chat-Nachricht ein und bitten Sie das Tool, den Kontext zusammenzufassen. Es liefert sofort eine Zusammenfassung, indem es sein Wissen über Ihren Workspace nutzt und die jeweilige Aufgabe oder den jeweiligen Kanal, in dem Sie sich befinden, priorisiert. Da Brain Ihre Projekte, Dokumente und Unterhaltungen versteht, sind seine Zusammenfassungen sofort umsetzbar und nicht nur isolierte Texte, die Sie manuell verarbeiten müssen.

Die besten Features von ClickUp Brain

- Fassen Sie Aufgaben, Dokumente, Chat-Threads und Meeting-Aufzeichnungen zusammen, ohne Ihren Workspace zu verlassen.

- Nutzt mehrere LLMs im Hintergrund, sodass Sie optimale Ergebnisse erzielen, ohne sich um die Auswahl der Modelle kümmern zu müssen.

- Wandelt Zusammenfassungen direkt in Aufgaben mit Mitarbeitern und Fälligkeitsdaten um.

- Versteht den Kontext Ihres Workspaces für relevantere, umsetzbare Zusammenfassungen.

- Integriert sich in ClickUp AI Notetaker, um Meetings automatisch zu erfassen und zusammenzufassen.

Limitierungen von ClickUp Brain

- Um alle Vorteile nutzen zu können, muss innerhalb des ClickUp-Ökosystems gearbeitet werden.

- Am besten geeignet für Team-Workflows statt für die Bearbeitung einzelner Dokumente.

Preise für ClickUp Brain

2. OpenAI GPT-4o (am besten geeignet für ausgefeilte, für Führungskräfte geeignete Zusammenfassungen)

Wenn Sie eine ausgefeilte, nuancierte Zusammenfassung benötigen, die Sie mit Führungskräften freigeben können, ist GPT-4o die erste Wahl. Seine Stärke liegt in der hochwertigen abstrakten Zusammenfassung, die Texte erzeugt, die sich lesen, als wären sie von einem Menschen geschrieben worden. Dank des großen Kontextfensters und der multimodalen Fähigkeiten kann es nicht nur Dokumente, sondern auch Texte aus Bildern oder Audio-Transkripten zusammenfassen.

Sie können über eine weit verbreitete API darauf zugreifen, sodass es sich leicht in Ihre bestehenden KI-Tools für Meetings integrieren lässt. Der Nachteil ist, dass es sich um einen proprietären Dienst mit nutzungsabhängiger Preisgestaltung handelt und es bei der Zusammenfassung sehr langer Dokumente zu leichten Verzögerungen kommen kann.

Die besten Features von GPT-4o

- Erstellt abstrakte Zusammenfassungen in menschlicher Qualität, die nur minimal bearbeitet werden müssen.

- Verarbeitet multimodale Eingaben, einschließlich Bildern und Audio-Transkripten.

- Bietet umfangreiche API-Dokumentation und Unterstützung bei der Integration.

Limitierungen von GPT-4o

- Nutzungsbasierte Preise können bei umfangreichen Zusammenfassungen zu hohen Kosten führen.

- Die Inferenzlatenz steigt bei sehr langen Dokumenten.

- Ein proprietäres Modell bedeutet weniger Kontrolle über die Datenverarbeitung.

Preise für GPT-4o

- API-Zugriff mit Pay-per-Token-Preismodell

- ChatGPT Plus-Abonnement für 20 $/Monat für den privaten Gebrauch

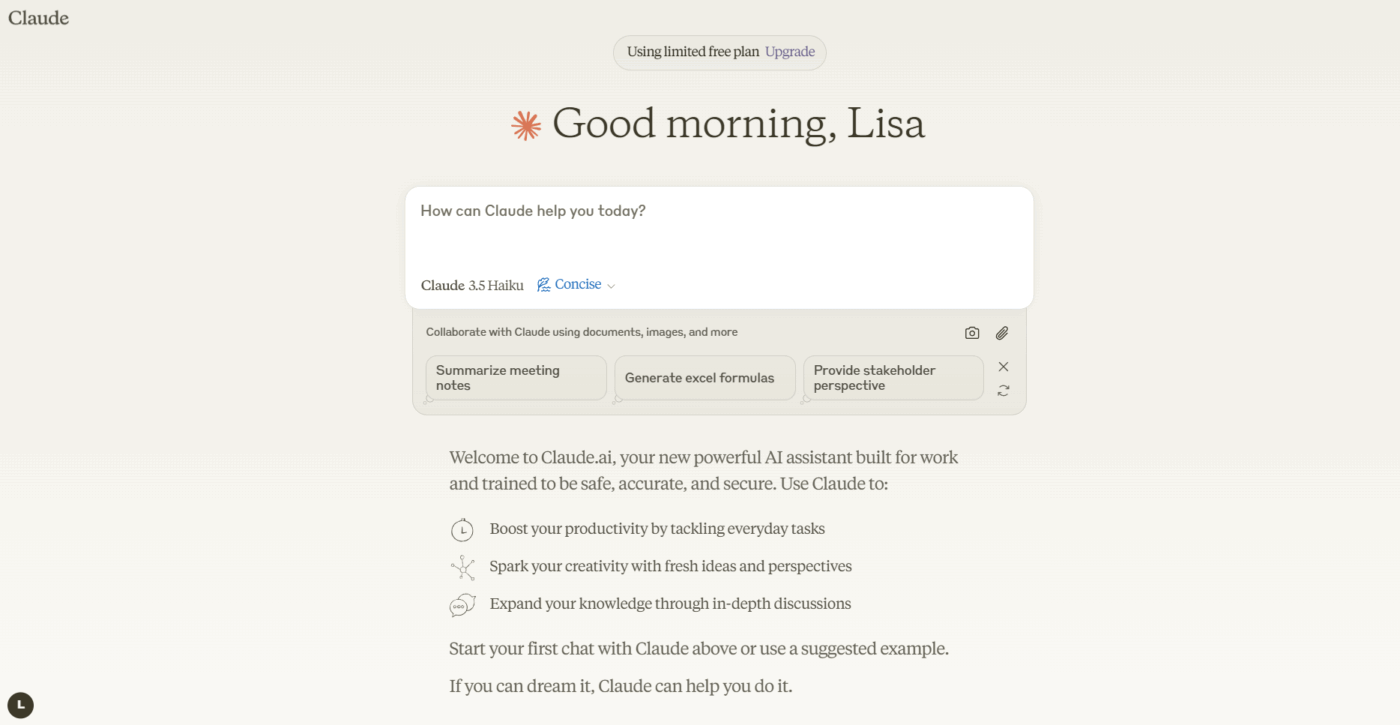

3. Anthropic Claude 3. 5 Sonnet (am besten geeignet für Dokumente, bei denen Compliance eine wichtige Rolle spielt)

Wenn Ihr Team mit hochsensiblen oder komplexen Dokumenten arbeitet, ist Claude 3. 5 Sonnet genau auf Ihre Bedürfnisse zugeschnitten. Es verfügt über ein erweitertes Kontextfenster, sodass es ganze lange Berichte in einem einzigen Durchgang verarbeiten und zusammenfassen kann. Was es wirklich auszeichnet, ist seine Fähigkeit, nuancierte Anweisungen zu befolgen – Sie können eine Zusammenfassung in einem bestimmten Format, Tonfall oder mit Schwerpunkt auf bestimmten Themen anfordern, und es liefert mit hoher Genauigkeit.

Der starke Fokus von Anthropic auf Sicherheitsausrichtung trägt dazu bei, das Risiko zu verringern, dass das Modell Fakten erfindet – ein entscheidendes Feature für compliancebewusste Teams, die mit Rechts- oder Finanzdokumenten arbeiten. Für Teams, die bereits KI-Dokumentenzusammenfassungen verwenden, lässt sich Claude gut in bestehende Workflows integrieren.

Die besten Features von Claude 3. 5 Sonnet

- Das erweiterte Kontextfenster verarbeitet ganze Berichte in einem Durchgang.

- Hervorragende Befolgung von Anweisungen für benutzerdefinierte Format- und Tonanforderungen

- Eine starke Sicherheitsausrichtung reduziert das Risiko von Halluzinationen.

Claude 3. 5 Limitierungen von Sonnet

- Proprietäres Modell mit regionalen Verfügbarkeitsunterschieden

- Die API-Preise können für die Nutzung in Unternehmen erheblich sein.

Preise für Claude 3. 5 Sonnet

- API-Zugriff mit Pay-per-Token-Preismodell

- Claude Pro-Abonnement für den individuellen Gebrauch verfügbar

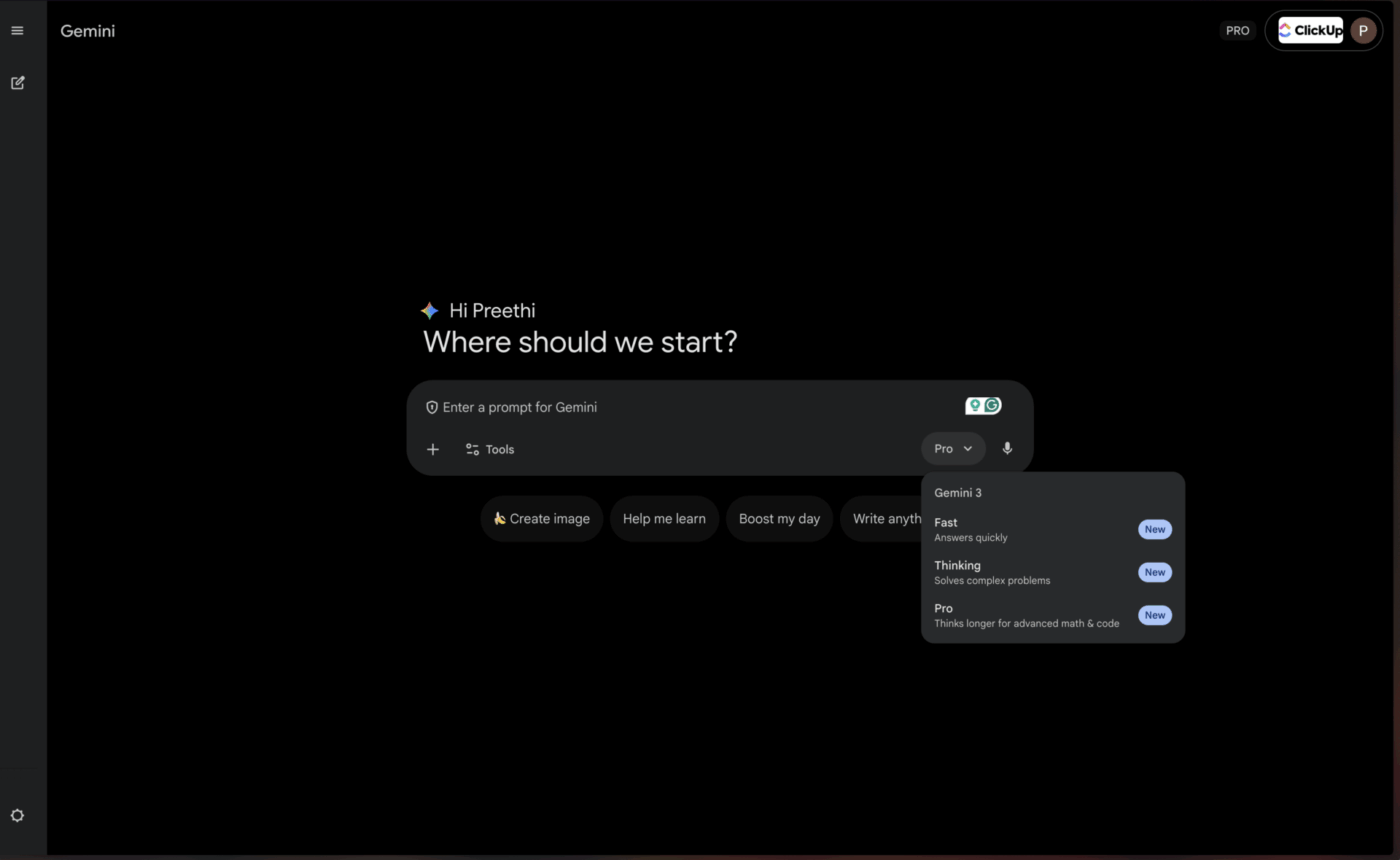

4. Google Gemini 1. 5 Pro (am besten geeignet für Benutzer von Google Workspace)

Für Teams, die bereits vollständig im Google-Ökosystem arbeiten, bietet Gemini 1. 5 Pro ein nahezu unübertroffenes Maß an Komfort. Es verfügt über eines der derzeit größten Kontextfenster – bis zu 1 Million Token – und eignet sich daher perfekt zum Zusammenfassen umfangreicher Meeting-Protokolle aus Google Meet oder zum Synthetisieren von Informationen aus mehreren Forschungsarbeiten, die in Google Drive gespeichert sind.

Dank der nativen Integration in Google Workspace können Sie Zusammenfassungen erstellen, ohne die Tools verlassen zu müssen, die Sie täglich verwenden. Dies ist besonders wertvoll für Teams, die innerhalb des Google-Ökosystems stark auf KI-Tools zur Erstellung von Meeting-Zusammenfassungen angewiesen sind.

Die besten Features von Gemini 1. 5 Pro

- Ein riesiges Kontextfenster mit 1 Million Tokens verarbeitet extrem lange Dokumente.

- Native Google Workspace-Integration für einen nahtlosen Workflow

- Multimodale Funktionen für Text, Bilder und Videos

Limitierungen von Gemini 1. 5 Pro

- Um alle Vorteile nutzen zu können, sind Investitionen in das Google-Ökosystem erforderlich.

- Die Leistung außerhalb der Google-Integration kann hinter der von Mitbewerbern zurückbleiben.

Preise für Gemini 1. 5 Pro

- Verfügbar über Google KI Studio und Vertex AI.

- Die Preise variieren je nach Nutzung und Vereinbarungen mit Unternehmen.

📌 ClickUp Insight: Der durchschnittliche Berufstätige verbringt täglich mehr als 30 Minuten mit der Suche nach arbeitsbezogenen Informationen – das sind über 120 Stunden pro Jahr, die durch das Durchsuchen von E-Mails, Slack-Threads und verstreuten Dateien verloren gehen. Ein intelligenter KI-Assistent, der in Ihren Workspace eingebettet ist, kann dies ändern, indem er innerhalb von Sekunden die richtigen Dokumente, Unterhaltungen und Aufgaben-Details anzeigt.

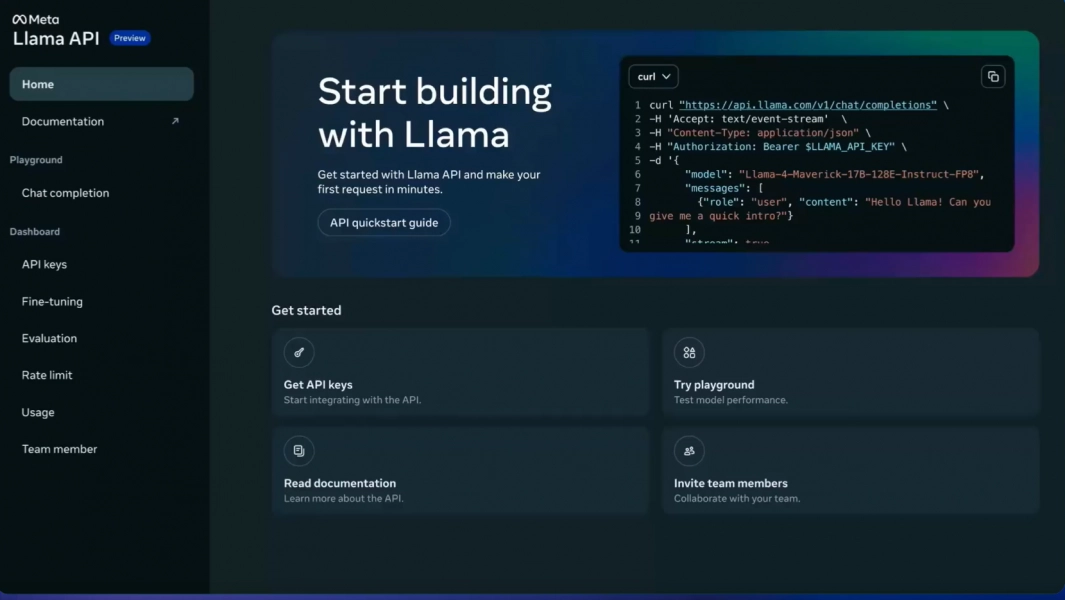

5. Meta LLaMA 3 (am besten geeignet für selbst gehostete, anpassbare Pipelines)

Ihr Team benötigt die vollständige Kontrolle über seine Daten und möchte vermeiden, sensible Informationen an einen Drittanbieter zu senden. Hier kommt ein Open-Source-Modell wie LLaMA 3 zum Einsatz. Sie können es auf Ihren eigenen Servern hosten, es an die spezifischen Daten Ihres Unternehmens anpassen, um Ihre Fachsprache besser zu verstehen, und es benutzerdefiniert anpassen – ganz ohne Lizenzgebühren.

Die Qualität der Zusammenfassungen ist beeindruckend und steht oft der von proprietären Modellen in nichts nach. Der Haken daran ist die Notwendigkeit einer technischen Infrastruktur. Ihr Team benötigt die technischen Ressourcen, um das Modell zu implementieren und zu warten, da keine sofort einsatzbereite verwaltete API verfügbar ist. Damit eignet es sich perfekt für technisch orientierte oder datenschutzorientierte Unternehmen.

Die 3 besten Features von LLaMA

- Vollständige Datenkontrolle durch selbst gehostete Bereitstellung

- Feinabstimmungsfunktion für domänenspezifische Terminologie

- Keine Lizenzgebühren für die kommerzielle Nutzung

Limitierungen von LLaMA 3

- Erfordert eine umfangreiche technische Infrastruktur für die Bereitstellung.

- Keine verwaltete API – Ihr Team kümmert sich um die Wartung.

- Die Komplexität des Setups kann die Amortisationszeit verzögern.

Preise für LLaMA 3

- Kostenlose Nutzung mit Open-Source-Lizenz

- Die Infrastrukturkosten hängen von der Wahl des Hostings ab.

6. Mistral Large (am besten geeignet für die Datenhoheit in der EU)

Was, wenn Sie die Flexibilität von Open Source wünschen, aber nicht über die Ressourcen verfügen, um die Infrastruktur selbst zu verwalten? Mistral Large bietet einen überzeugenden Mittelweg. Das von einem europäischen Unternehmen entwickelte Produkt liefert eine wettbewerbsfähige Zusammenfassungsleistung mit einem starken Fokus auf Effizienz.

Mistral bietet sowohl eine verwaltete API für einfachen Zugriff als auch Open-Weight-Modelle für Teams, die mehr Kontrolle wünschen. Dieser hybride Ansatz ist sein entscheidender Vorteil. Der Nachteil ist ein kleineres Ökosystem von Drittanbieter-Integrationen im Vergleich zu Giganten wie OpenAI und Google. Es ist eine ausgezeichnete Wahl für Teams, die ein Gleichgewicht zwischen Komfort und Kontrolle suchen, insbesondere für solche mit EU-Datenhoheitskriterien.

Die besten Features von Mistral Large

- Hybrider Zugriff über verwaltete API oder selbst gehostete Bereitstellung

- Starke Leistung bei Einhaltung der europäischen Datenhoheit

- Wettbewerbsfähige Preise im Vergleich zu den wichtigsten proprietären Modellen

Limitierungen von Mistral Large

- Kleineres Integrationsökosystem als OpenAI oder Google

- Weniger umfangreiche Dokumentation und Community-Ressourcen

Preise für Mistral Large

- API-Zugriff mit wettbewerbsfähigen Preisen pro Token

- Open-Weight-Modelle für Selbsthosting verfügbar

💡 Profi-Tipp: Wenn Ihr Hauptziel darin besteht, stundenlange Protokolle von Meetings in einem Durchgang zusammenzufassen, sollten Sie Modelle mit dem größten Kontextfenster wie Gemini 1. 5 Pro bevorzugen. Wenn Sie dem Modell die spezifische Terminologie Ihres Unternehmens beibringen müssen, ist eine Open-Source-Option wie LLaMA 3 die richtige Wahl.

💡 Profi-Tipp: Wenn Ihr Hauptziel darin besteht, stundenlange Protokolle von Meetings in einem Durchgang zusammenzufassen, sollten Sie Modelle mit dem größten Kontextfenster wie Gemini 1. 5 Pro bevorzugen. Wenn Sie dem Modell die spezifische Terminologie Ihres Unternehmens beibringen müssen, ist eine Open-Source-Option wie LLaMA 3 die richtige Wahl.

Vergleich von LLM-Modellen zur Zusammenfassung

Ein schneller Vergleich hilft Ihnen, auf einen Blick zu erkennen, welches Modell den obersten Prioritäten Ihres Teams entspricht.

ClickUp Brain integriert die Zusammenfassung direkt in Ihren Workflow als konvergierter KI-Workspace, der sich am besten dafür eignet, Zusammenfassungen in sofortige Maßnahmen umzusetzen, wobei der entscheidende Kompromiss darin besteht, dass er innerhalb des ClickUp-Ökosystems optimal funktioniert.

GPT-4o bietet als proprietäres Modell ein großes Kontextfenster, das sich am besten für ausgefeilte und nuancierte Zusammenfassungen eignet, wobei der Schlüssel zum Erfolg die nutzungsbasierte Preisgestaltung ist.

Claude 3. 5 Sonnet bietet ein erweitertes Kontextfenster als proprietäres Modell, das sich ideal für compliance-sensitive Dokumente eignet, wobei die regionale Verfügbarkeit das primäre Limit darstellt.

Gemini 1. 5 Pro bietet als proprietäres Modell ein riesiges Kontextfenster, das sich perfekt für Google Workspace-Benutzer eignet, obwohl die Bindung an ein bestimmtes Ökosystem ein Problem darstellen könnte.

LLaMA 3 umfasst ein großes Kontextfenster als Open-Source-Modell, das sich für selbst gehostete, anpassbare Pipelines eignet, jedoch Investitionen in die Infrastruktur erfordert.

Mistral Large verfügt über ein großes Kontextfenster mit einem hybriden Zugriffsansatz, der sich hervorragend für die Anforderungen der EU an die Datenresidenz eignet, obwohl es über ein kleineres Integrationsökosystem verfügt.

📖 Lesen Sie auch: Die besten KI-Transkriptions-Zusammenfasser

So bewerten Sie die Qualität der LLM-Zusammenfassung

Um zu wissen, ob die Zusammenfassungen eines Modells tatsächlich gut sind, bedarf es eines klaren Bewertungsrahmens. Sich auf eine schlechte Zusammenfassung zu verlassen, kann schlimmer sein, als gar keine Zusammenfassung zu haben, da dies zu schlechten Entscheidungen aufgrund ungenauer Informationen führen kann.

Schlüssel-Kriterien

Die Genauigkeit bestimmt, ob die Zusammenfassung die Hauptpunkte des Originaltextes korrekt wiedergibt, ohne Fakten zu erfinden oder Fehler zu machen. Dies ist für geschäftskritische Dokumente unverzichtbar.

Kohärenz misst, ob die Zusammenfassung leicht zu lesen ist und einen logischen Flow hat oder sich wie ein Wirrwarr unzusammenhängender Sätze anfühlt. Gute Zusammenfassungen behalten die narrative Struktur bei.

Prägnanz bewertet, ob die Zusammenfassung direkt auf den Punkt kommt oder mit Füllworten und unnötigen Begriffen überladen ist. Die besten Zusammenfassungen maximieren die Informationsdichte.

Befolgung von Anweisungen testet, ob das Modell Ihre Anforderungen hinsichtlich bestimmter Tonalitäten, Formate oder Schwerpunktbereiche wie Aufzählungspunkte oder Briefings im Executive-Stil erfolgreich umsetzen kann.

Konsistenz bewertet, ob das Modell qualitativ hochwertige Zusammenfassungen für verschiedene Dokumenttypen erstellt oder nur bei bestimmten Dokumenttypen gute Ergebnisse liefert.

Ein einfaches Test-Framework

Wählen Sie drei Dokumente aus, mit denen Ihr Team regelmäßig arbeitet – eine Projektbeschreibung, ein Protokoll des Meetings und einen E-Mail-Thread mit einem Kunden. Führen Sie jedes Dokument mit derselben Eingabeaufforderung durch die Modelle, die Sie in Betracht ziehen. Lassen Sie dann ein Teammitglied die Ergebnisse anhand der oben genannten Kriterien bewerten. Es gibt zwar automatisierte Metriken, aber nichts geht über eine menschliche Überprüfung, um subtile Fehler zu erkennen.

🔍 Wussten Sie schon? Teams wie QubicaAMF haben durch die Abschaffung veralteter Wissensmanagementprozesse mit ClickUp mehr als 5 Stunden pro Woche eingespart – das sind über 250 Stunden pro Person und Jahr. Stellen Sie sich vor, was Ihr Team mit einer zusätzlichen Woche Produktivität pro Quartal alles erreichen könnte.

🔍 Wussten Sie schon? Teams wie QubicaAMF haben durch die Abschaffung veralteter Wissensmanagementprozesse mit ClickUp mehr als 5 Stunden pro Woche eingespart – das sind über 250 Stunden pro Person und Jahr. Stellen Sie sich vor, was Ihr Team mit einer zusätzlichen Woche Produktivität pro Quartal alles erreichen könnte.

Was sind die Limite der Verwendung von LLMs für die Dokumentenzusammenfassung?

Diese Technologie hat echte Limite, die Sie kennen sollten, bevor Sie sich für einen bestimmten Ansatz entscheiden.

Risiken durch Halluzinationen

Das größte Risiko ist die Halluzination, bei der das Modell mit Überzeugung falsche Details angibt, die plausibel klingen. Rechtsteams, Finanzanalysten und alle, die mit compliance-sensiblen Dokumenten arbeiten, sollten Zusammenfassungen mit hohem Risiko immer von einem Menschen überprüfen lassen.

Kontextfenster-Obergrenzen

Selbst die größten Modelle haben ein Limit, sodass extrem lange Dokumente möglicherweise in Abschnitte unterteilt werden müssen. Diese Unterteilung kann dazu führen, dass das Modell Verbindungen zwischen weit voneinander entfernten Abschnitten übersieht oder den gesamten Erzählbogen verliert.

Verlust von Nuancen

Subtile Argumente oder Minderheitsmeinungen werden in Zusammenfassungen oft verflacht. Wenn es für Ihren Anwendungsfall wichtig ist, abweichende Meinungen oder Randfälle zu bewahren, müssen Sie die Eingabeaufforderungen sorgfältig formulieren oder gewisse Informationsverluste in Kauf nehmen.

Herausforderungen aufgrund von Domänenspezifität

Ein Allzweckmodell versteht möglicherweise ohne Feinabstimmung die spezifische Fachsprache Ihres Feldes nicht. Medizinische, juristische und technische Felder erfordern oft zusätzliches Training oder sorgfältiges Prompt Engineering.

Sicherheitsaspekte

Das Senden sensibler Unternehmensdaten an eine API eines Drittanbieters birgt immer ein gewisses Risiko. Für streng vertrauliche Dokumente können selbst gehostete Modelle oder Vereinbarungen mit spezifischen Datenverarbeitungsbedingungen erforderlich sein.

Dies sind keine Gründe, die Technologie zu meiden, aber es sind wichtige Überlegungen. Sie können diese Risiken durch intelligente Vorgehensweisen mindern: Lassen Sie wichtige Zusammenfassungen immer von einem Menschen überprüfen, verwenden Sie selbst gehostete Modelle für hochsensible Daten und verwenden Sie klare Eingabeaufforderungen, damit das Modell wichtige Nuancen beibehält.

📌 ClickUp Insight: 62 % der Wissensarbeiter verlassen sich auf dialogorientierte KI-Tools wie ChatGPT und Claude. Ihre vertraute Chatbot-Oberfläche und ihre vielseitigen Fähigkeiten könnten ihre Beliebtheit in verschiedenen Rollen und Branchen erklären. Allerdings verursacht das Wechseln zu einer anderen Registerkarte, um der KI jedes Mal eine Frage zu stellen, zusätzliche Kosten für das Umschalten und den Kontextwechsel.

📌 ClickUp Insight: 62 % der Wissensarbeiter verlassen sich auf dialogorientierte KI-Tools wie ChatGPT und Claude. Ihre vertraute Chatbot-Oberfläche und ihre vielseitigen Fähigkeiten könnten ihre Beliebtheit in verschiedenen Rollen und Branchen erklären. Allerdings verursacht das Wechseln zu einer anderen Registerkarte, um der KI jedes Mal eine Frage zu stellen, zusätzliche Kosten für das Umschalten und den Kontextwechsel.

Einsatz von ClickUp Brain in Ihrem Zusammenfassungs-Workflow

Sie haben gesehen, wie ClickUp Brain zu den besten LLMs für die Zusammenfassung zählt. Lassen Sie uns nun untersuchen, wie Sie Workflows erstellen können, die diese Zusammenfassungen in echte Steigerungen der Produktivität umwandeln. Der Unterschied zwischen einer nützlichen Zusammenfassung und vergeblichem Aufwand besteht darin, ob sie eine Verbindung zu Maßnahmen hat – und genau hier glänzt ein Converged AI Workspace.

[Bildplatzhalter: ClickUp-Workspace mit Brain-Zusammenfassung, integriert in Aufgaben und Dokumente]

Erhalten Sie Zusammenfassungen direkt an Ihrem Arbeitsplatz während der Arbeit.

Eliminieren Sie die frustrierende manuelle Übergabe, indem Sie die Zusammenfassung direkt in Ihre Projekte integrieren. Mit ClickUp Brain geben Sie einfach @brain in einen beliebigen Aufgabenkommentar oder eine ClickUp-Chat-Nachricht ein und bitten Sie das Programm, den Kontext zusammenzufassen. Es liefert sofort eine Zusammenfassung unter Verwendung seines Wissens über Ihren Workspace und priorisiert dabei die jeweilige Aufgabe oder den jeweiligen Kanal, in dem Sie sich befinden.

Verwandeln Sie Meeting-Aufzeichnungen automatisch in Aktionselemente.

Um sich nach einem verpassten Meeting auf den neuesten Stand zu bringen, müssen Sie nicht mehr stundenlang Notizen durchlesen. Bleiben Sie voll und ganz in Unterhaltungen eingebunden, während der ClickUp AI Notetaker die Meeting-Notizen für Sie erfasst. Nach dem Meeting erhalten Sie ein Transkript und eine Zusammenfassung. Sie können sogar festlegen, dass automatisch Aktionspunkte generiert und in ClickUp-Aufgaben mit Mitarbeitern und Fälligkeitsdaten umgewandelt werden.

Nutzen Sie mehrere LLMs, ohne sich um die Auswahl der Modelle kümmern zu müssen.

Erzielen Sie hochwertige Ergebnisse, ohne sich selbst um die Modellauswahl kümmern zu müssen, denn ClickUp Brain nutzt hinter den Kulissen mehrere LLMs. So sieht dieser Workflow in der Praxis aus: Es findet ein Meeting statt, der ClickUp AI Notetaker erfasst alles, ClickUp Brain liefert eine Zusammenfassung der wichtigsten Entscheidungen und die Aktionspunkte sind bereits in Ihrem Projektplan enthalten. Sie können sogar @My Brain verwenden, um einen Thread privat zusammenzufassen oder eine Antwort zu entwerfen, bevor Sie ihn mit dem Team freigeben.

✨ Echte Ergebnisse: Die eigentliche Herausforderung besteht darin, Zusammenfassungen in Maßnahmen umzusetzen. ClickUp Brain zeichnet sich dadurch aus, dass es Zusammenfassungen direkt mit Aufgaben in Ihrem Workflow verbindet und so die Lücke zwischen Erkenntnis und Umsetzung schließt, die bei eigenständigen Zusammenfassungstools besteht.

✨ Echte Ergebnisse: Die eigentliche Herausforderung besteht darin, Zusammenfassungen in Maßnahmen umzusetzen. ClickUp Brain zeichnet sich dadurch aus, dass es Zusammenfassungen direkt mit Aufgaben in Ihrem Workflow verbindet und so die Lücke zwischen Erkenntnis und Umsetzung schließt, die bei eigenständigen Zusammenfassungstools besteht.

Fazit

Das beste LLM für die Zusammenfassung ist dasjenige, das den individuellen Anforderungen Ihres Teams entspricht – sei es ein großes Kontextfenster für lange Berichte, Open-Source-Flexibilität für benutzerdefinierte Anpassungen oder die nahtlose Integration in Ihre vorhandenen Tools. Bevor Sie sich committen, testen Sie Ihre Favoriten immer mit Ihren eigenen Dokumenten aus der Praxis, um zu sehen, wie sie funktionieren.

Aber denken Sie daran: Eine Zusammenfassung ist nur dann wertvoll, wenn sie mit Maßnahmen verbunden ist. Die Zusammenfassung wandelt sich von einer eigenständigen Aufgabe zu einer tief in die Plattformen eingebetteten Funktion, mit denen Sie bereits arbeiten. Der eigentliche Gewinn an Produktivität entsteht dadurch, dass die Lücke zwischen der Gewinnung von Erkenntnissen und deren Umsetzung geschlossen wird.

Starten Sie kostenlos mit ClickUp und integrieren Sie KI-Zusammenfassungen direkt in Ihre Aufgabenverwaltung, Ihren Chat und Ihre Dokumente.

Häufig gestellte Fragen

Was ist der Unterschied zwischen extraktiver und abstraktiver LLM-Zusammenfassung? Bei der extraktiven Zusammenfassung werden Schlüssel-Sätze direkt aus dem Originaltext extrahiert, während bei der abstraktiven Zusammenfassung völlig neue Sätze generiert werden, um die Kernaussage zu vermitteln. Moderne LLMs verwenden in erster Linie die abstrakte Methode, die zu natürlich klingenden Zusammenfassungen führt, die den Kern des Ausgangsmaterials besser wiedergeben.

Wie schneiden Open-Source-LLMs im Vergleich zu proprietären Modellen wie GPT-4 bei der Zusammenfassung ab? Open-Source-Modelle bieten vollständige Kontrolle über Ihre Daten und die Möglichkeit, sie an Ihre spezifischen Bedürfnisse anzupassen, erfordern jedoch technische Ressourcen für die Wartung. Proprietäre Modelle bieten Komfort und Benutzerfreundlichkeit durch eine API, sind jedoch mit Nutzungskosten verbunden und bieten weniger Kontrolle über die Daten. Der Qualitätsunterschied hat sich deutlich verringert, da Open-Source-Optionen wie LLaMA 3 in vielen Anwendungsfällen mit der Leistung proprietärer Modelle mithalten können.

Können LLM-Zusammenfassungs-Tools Besprechungsnotizen und Projektaktualisierungen verarbeiten? Ja, die meisten LLMs sind sehr effektiv bei der Zusammenfassung von Konversationstexten wie Besprechungsnotizen. Die eigentliche Herausforderung besteht darin, diese Zusammenfassungen in Maßnahmen umzusetzen. Hier zeichnen sich Tools wie ClickUp Brain aus, indem sie Zusammenfassungen direkt mit Aufgaben in Ihrem Workflow verknüpfen, anstatt sie als isolierte Textdokumente zu belassen.

Welche Größe der Kontextfenster benötige ich für meine Dokumente? Für Standard-Geschäftsdokumente mit weniger als 10.000 Wörtern verfügen die meisten modernen LLMs über ausreichende Kontextfenster. Für Meeting-Protokolle von mehr als einer Stunde oder umfassende Forschungsberichte benötigen Sie Modelle mit erweiterten Kontextfenstern wie Claude 3. 5 Sonnet oder Gemini 1. 5 Pro. Das 1-Millionen-Token-Fenster von Gemini 1. 5 Pro kann praktisch jede Zusammenfassungsaufgabe für einzelne Dokumente bewältigen.

Wie kann ich das Risiko von Halluzinationen in LLM-Zusammenfassungen reduzieren? Verwenden Sie klare, spezifische Anweisungen, die das Modell auffordern, nur das zusammenzufassen, was in der Quelle ausdrücklich angegeben ist. Fordern Sie Zitate oder Verweise auf bestimmte Abschnitte an, wenn Genauigkeit entscheidend ist. Lassen Sie bei Dokumenten mit hohem Risiko immer einen menschlichen Prüfer die Zusammenfassung mit dem Original vergleichen. Ziehen Sie bei der Arbeit mit compliance-sensiblen Inhalten Modelle mit stärkerer Sicherheitsausrichtung wie Claude in Betracht.