A maioria dos desenvolvedores consegue colocar a API Gemini em funcionamento em menos de 10 minutos.

O verdadeiro desafio vem depois da configuração.

Este guia mostra como obter sua chave API, instalar o SDK e fazer sua primeira solicitação.

Você também aprenderá como manter seus fluxos de trabalho de API organizados, para que sua equipe não perca tempo reinventando soluções ou procurando documentação.

O que é a API Gemini?

A API Gemini é a interface do Google para acessar sua família de modelos de IA multimodal, permitindo que os desenvolvedores integrem geração de texto, compreensão de imagens, assistência de código e IA conversacional em aplicativos.

Ele foi projetado para equipes de produto, engenheiros e empresas que desejam adicionar recursos poderosos de IA aos seus produtos sem precisar criar grandes modelos de linguagem do zero.

Os grandes modelos de linguagem da Gemini, como Gemini 3 Flash e Gemini 3 Pro, são multimodais, o que significa que podem lidar com vários tipos de entrada, incluindo texto, imagens, áudio e vídeo. A API em si usa a arquitetura REST API , que é uma forma padrão de comunicação entre sistemas de computador pela Internet.

Para tornar isso ainda mais fácil, o Google fornece kits de desenvolvimento de software (SDKs) para linguagens populares como Python, JavaScript e Go. É útil entender a diferença entre a API e o Google AI Studio.

| Uso principal | Aplicações de produção | Prototipagem e testes |

| Método de acesso | Chamadas SDK baseadas em código | Interface visual baseada na web |

| Ideal para | Desenvolvedores que criam aplicativos | Experimentando com prompts |

💡Dica profissional: mantenha todo o contexto do seu projeto em um só lugar e evite procurar informações em diferentes ferramentas, criando uma base de conhecimento interna para seus projetos de IA. Com o ClickUp Docs, você pode vincular trechos de código e documentação da API diretamente às tarefas da sua equipe, eliminando a proliferação de ferramentas e acelerando a adoção da IA.

Como obter sua chave API Gemini

Sua equipe pode estar pronta para começar a construir, mas primeiro você precisa de uma chave API.

Para usar a API Gemini, você precisa de uma chave para autenticar suas solicitações, e gerenciar essas chaves é o primeiro passo para um gerenciamento de fluxo de trabalho mais tranquilo. Você precisará de uma conta Google para começar.

Veja como obter sua chave:

- Navegue até o Google AI Studio

- Faça login com sua conta do Google

- Clique em Obter chave API na barra lateral esquerda.

- Selecione Criar chave API em um novo projeto ou escolha um projeto Google Cloud existente.

- Copie sua chave gerada imediatamente e armazene-a em um local seguro.

Sua chave API concede acesso à sua cota e faturamento Gemini — trate-a como uma senha. 🔑

Sua chave API concede acesso à sua cota e faturamento Gemini — trate-a como uma senha. 🔑

Para equipes maiores, você também pode gerenciar chaves por meio do Google Cloud Console, que oferece controles mais avançados.

Como instalar o SDK Gemini

Um novo desenvolvedor se junta ao seu projeto de IA, mas passa o primeiro dia lutando com a configuração do ambiente em vez de escrever código.

A versão Python está incorreta ou falta uma dependência, levando ao clássico problema de “funciona na minha máquina”.

Essa é frequentemente a razão pela qual os desenvolvedores perdem 3 horas por semana. Essas inconsistências retardam a integração e introduzem bugs imprevisíveis que desperdiçam um tempo valioso de engenharia.

Um SDK, ou Kit de Desenvolvimento de Software, simplifica essas interações da API, lidando com a autenticação, formatação de solicitações e análise de respostas para você. Para evitar problemas de configuração, sua equipe precisa de um processo padronizado e documentado para instalar o SDK Gemini.

Veja como instalá-la nos ambientes mais comuns.

Para Python:

- Observação: você precisará do Python 3.9 ou mais recente. Usar um ambiente virtual é uma prática recomendada para evitar conflitos com outros projetos.

Para JavaScript/Node.js:

- Observação: isto é para uso em um ambiente Node.js.

Após a instalação, você precisa configurar sua chave API como uma variável de ambiente. Isso mantém sua chave segura e fora do seu código-fonte.

- No Mac/Linux: export GEMINI_API_KEY="sua-chave-api-aqui"

- No Windows: setx GEMINI_API_KEY "sua-chave-de-API-aqui"

Você tem algumas opções de SDK para usar:

- SDK Python: a escolha mais popular, com documentação abrangente. É ideal para ciência de dados e aplicativos de back-end.

- SDK JavaScript: a melhor opção para criar aplicativos web e back-ends Node.js.

- Go SDK: uma ótima opção para desenvolvedores que criam microsserviços de alto desempenho em Go.

- API REST: se você estiver usando uma linguagem sem um SDK oficial, poderá sempre fazer solicitações HTTP diretas à API REST.

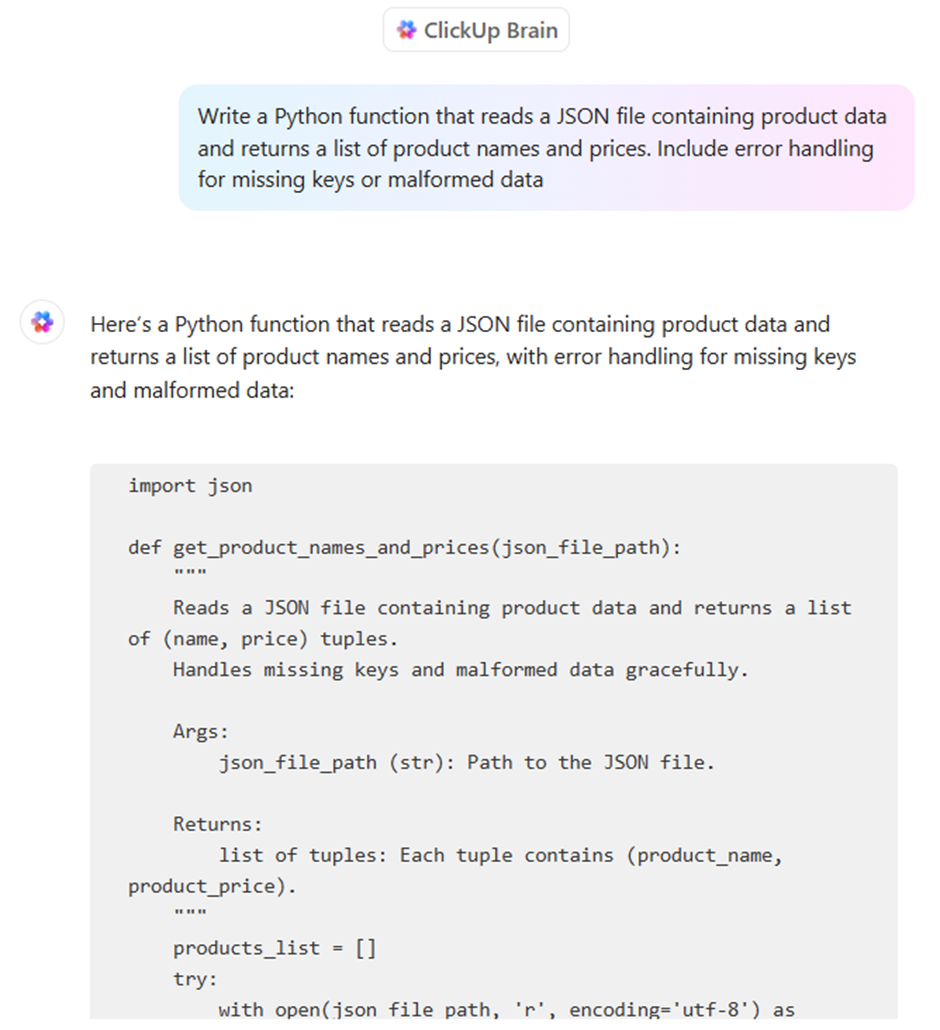

💡Dica profissional: padronize seu ambiente de desenvolvimento e acelere a integração criando uma lista de verificação que todos os novos membros da equipe possam seguir. Salve-a como um modelo no ClickUp Tasks e, se alguém tiver dificuldades, poderá usar o ClickUp Brain para obter respostas na documentação da sua equipe. Aqui está um guia rápido:

📖 Leia mais: Gemini x ChatGPT para codificação: qual é melhor?

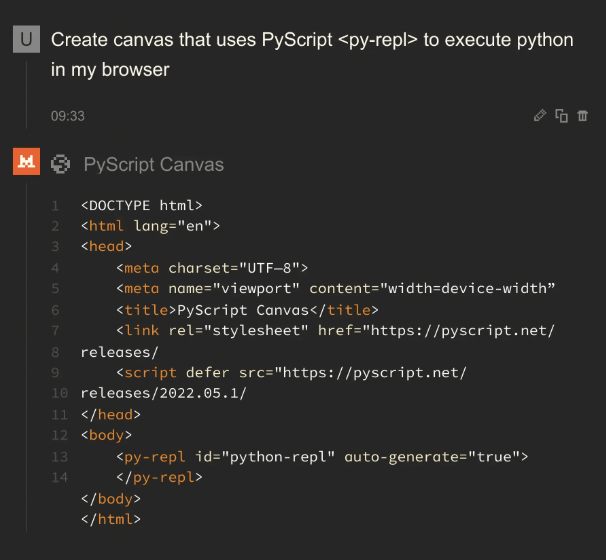

Como fazer sua primeira solicitação da API Gemini

Sua equipe finalmente está fazendo chamadas de API, mas cada desenvolvedor está descobrindo como fazer isso por conta própria.

Uma chamada de API bem-sucedida é simples: você envia um prompt para um modelo Gemini e recebe uma resposta.

O verdadeiro desafio é tornar esse processo repetível e escalável para toda a sua equipe. Aqui estão alguns exemplos de como fazer sua primeira solicitação.

Exemplo em Python

Este código envia um prompt de texto simples para a API Gemini e imprime a resposta.

Vamos detalhar isso:

- Importar e configurar: isso carrega a biblioteca do Google e configura a autenticação usando a chave API que você configurou anteriormente.

- Inicializar modelo: aqui, você informa ao código qual modelo Gemini específico usar. O Gemini 3 Flash é otimizado para tarefas de alta velocidade e alto volume, enquanto o Gemini 3 Pro é projetado para raciocínio profundo e fluxos de trabalho complexos e com várias etapas.

- Gerar conteúdo: Esta é a ação. Você está enviando sua pergunta para o modelo.

- Acesse a saída: a resposta do modelo é armazenada no objeto de resposta, e você pode acessar o texto com response.text.

Exemplo em JavaScript

Se você estiver trabalhando em um ambiente Node.js, o processo é semelhante, mas usa a sintaxe async/await do JavaScript.

Exemplo de API REST

Se você não estiver usando Python ou JavaScript, poderá sempre se comunicar diretamente com a API usando um comando curl. Isso é ótimo para testes rápidos ou para uso em linguagens sem um SDK dedicado.

Este comando envia uma solicitação HTTP para o endpoint da API e retorna a resposta como um objeto JSON.

Facilite para sua equipe encontrar e reutilizar trechos de código e prompts bem-sucedidos criando uma biblioteca compartilhada.

O que você pode criar com a API Gemini?

A API Gemini é incrivelmente versátil. Aqui estão algumas coisas que você pode criar:

- Ferramentas de geração de conteúdo: automatize rascunhos de blogs, publicações em redes sociais e textos de marketing.

- Chatbots e assistentes virtuais: crie interfaces conversacionais para suporte ao cliente ou help desks internos.

- Assistência de código: gere trechos de código, explique funções complexas e ajude a depurar erros.

- Auxiliares de análise de dados: resuma relatórios densos e extraia insights importantes de textos não estruturados.

- Aplicações multimodais: analise imagens ou processe conteúdo de vídeo para torná-lo pesquisável.

- Processamento de documentos: extraia informações de PDFs e traduza documentos para diferentes idiomas.

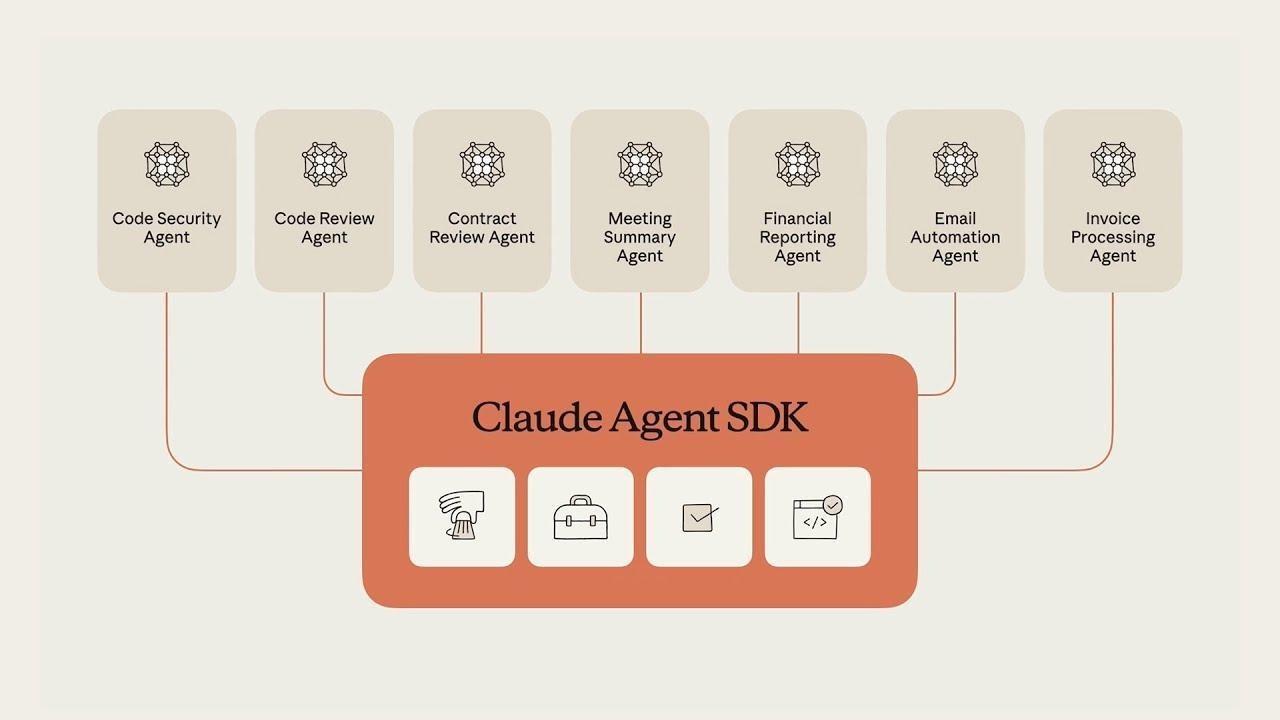

Criando fluxos de trabalho com agentes com a Gemini

Ao contrário de um chatbot padrão que responde a perguntas de forma linear, um fluxo de trabalho de agente no Gemini permite que o modelo perceba um objetivo, raciocine através de um plano e execute uma série de ações autônomas em ferramentas externas.

Essa mudança “agênica” é impulsionada por três recursos principais do ecossistema Gemini 3:

- Modo “Pensamento” nativo: usando o parâmetro thinking_level, agora você pode alternar entre “baixo” para velocidade e “alto” para tarefas complexas. No modo de raciocínio alto, o Gemini 3 Pro gera “tokens de pensamento” ocultos para validar sua própria lógica antes de fornecer uma resposta, reduzindo drasticamente as alucinações.

- Assinaturas de pensamento: para evitar o “desvio de raciocínio” em tarefas com várias etapas, a API agora emite assinaturas de pensamento criptografadas. Os desenvolvedores devem passar essas assinaturas de volta no histórico de conversas para garantir que o agente mantenha sua linha de raciocínio exata em diferentes chamadas de API e execuções de ferramentas.

- Protocolo de Contexto de Modelo (MCP): O Gemini agora usa o MCP padrão da indústria para se conectar a ferramentas. Isso permite que seu agente se “conecte” instantaneamente aos seus bancos de dados existentes, Slack ou GitHub sem que você precise escrever um código de integração personalizado para cada função.

📮 ClickUp Insight: equipes de baixo desempenho são 4 vezes mais propensas a usar mais de 15 ferramentas, enquanto equipes de alto desempenho mantêm a eficiência limitando seu kit de ferramentas a 9 ou menos plataformas.

Mas que tal usar apenas uma plataforma para tudo isso?

O ClickUp reúne suas tarefas, projetos, documentos, wikis, bate-papos e chamadas em uma única plataforma, completa com fluxos de trabalho alimentados por IA. Pronto para trabalhar de forma mais inteligente? O ClickUp funciona para todas as equipes, torna o trabalho visível e permite que você se concentre no que é importante, enquanto a IA cuida do resto.

Exemplo em Python: criando um agente de pesquisa

Este trecho demonstra como inicializar um agente de alto raciocínio que mantém um “fio de pensamento” persistente por meio do SDK Gemini mais recente.

📖 Leia mais: Como usar um chatbot para o seu negócio

Como manter sua chave API Gemini segura

Sua equipe está lançando recursos, mas suas práticas de segurança são uma preocupação secundária.

Às vezes, as chaves API são deixadas no código — contribuindo para os 23,7 milhões de segredos vazados para o GitHub público em 2024 — e não há um processo formal para alterná-las. Isso deixa sua organização vulnerável ao uso não autorizado, o que pode levar a contas inesperadas e graves violações de segurança.

Uma abordagem reativa à segurança é uma receita para o desastre. Você precisa de um sistema proativo de gerenciamento de conhecimento para gerenciar credenciais e proteger seus aplicativos e os dados da sua empresa.

Aqui estão as melhores práticas essenciais para manter sua chave API Gemini segura:

- Use variáveis de ambiente: Nunca, jamais codifique chaves diretamente em seu código-fonte. Armazene-as em arquivos .env ou variáveis de ambiente do sistema.

- Adicione. env ao seu. gitignore: esta etapa simples evita que você acidentalmente envie suas chaves secretas para um repositório de código público.

- Alterne as chaves regularmente: gere novas chaves periodicamente no Google Cloud Console e desative as antigas.

- Implemente controles de acesso: use o Gerenciamento de Identidade e Acesso (IAM) do Google Cloud para restringir quem em sua equipe pode visualizar ou gerenciar chaves API.

- Monitore o uso: fique de olho no painel de uso da API no Google Cloud Console para identificar qualquer atividade incomum que possa indicar um comprometimento.

- Use chaves separadas para ambientes: mantenha chaves diferentes para seus ambientes de desenvolvimento, teste e produção para limitar o alcance de um possível vazamento.

Preços da Gemini

- Gemini 3 Flash: ~$0,50 por 1 milhão de entradas / $3,00 por 1 milhão de saídas

- Gemini 3 Pro: ~$2,00 por 1 milhão de entradas / $12,00 por 1 milhão de saídas (para contextos com menos de 200 mil)

- Base de pesquisa: observe que o Google agora cobra US$ 14 por 1.000 consultas de pesquisa para a base de pesquisa, uma vez que você exceda a cota mensal gratuita (5.000 consultas).

Limitações do uso da API Gemini

Sua aplicação está ativa, mas você está enfrentando problemas inesperados.

A API está mais lenta do que o esperado durante os horários de pico ou está retornando respostas inconsistentes que confundem os usuários.

Compreender as limitações da API é o primeiro passo; documentar suas soluções alternativas é o que ajuda você a escalar com eficácia.

Esteja ciente destas restrições comuns:

- Limites de taxa: o plano gratuito tem limites para solicitações por minuto e tokens por dia, o que pode causar gargalos em aplicativos de alto volume.

- Variabilidade de latência: os tempos de resposta podem variar de acordo com a complexidade do seu prompt e a carga geral do servidor.

- Restrições da janela de contexto: cada modelo tem um número máximo de tokens (palavras e partes de palavras) que pode processar em uma única solicitação, o que pode ser um desafio para resumir documentos muito longos.

- Disponibilidade regional: alguns modelos ou recursos podem não estar disponíveis em todas as regiões geográficas.

- Consistência de saída: a IA generativa pode produzir resultados ligeiramente diferentes mesmo para o mesmo prompt, o que pode exigir que você crie etapas de validação em seu fluxo de trabalho.

- Sem dados em tempo real: o conhecimento dos modelos não é atualizado em tempo real, portanto, eles não podem fornecer informações sobre eventos muito recentes.

Embora a API Gemini seja uma potência multimodal, a criação de um aplicativo pronto para produção geralmente requer uma estratégia multimodelo. Dependendo das necessidades específicas do seu projeto em termos de profundidade de raciocínio ou precisão de codificação, você pode considerar estas alternativas à Gemini.

A maioria das ferramentas de IA promete facilitar o desenvolvimento, mas muitas vezes acabam sendo apenas mais uma guia desconectada em uma pilha já lotada. Você pode usar a API Gemini para alimentar o backend do seu aplicativo, uma ferramenta separada para resumir notas de reuniões e uma terceira plataforma para gerenciar suas tarefas de sprint. Essa teia de contextos dispersos e ferramentas isoladas é a “expansão da IA”.

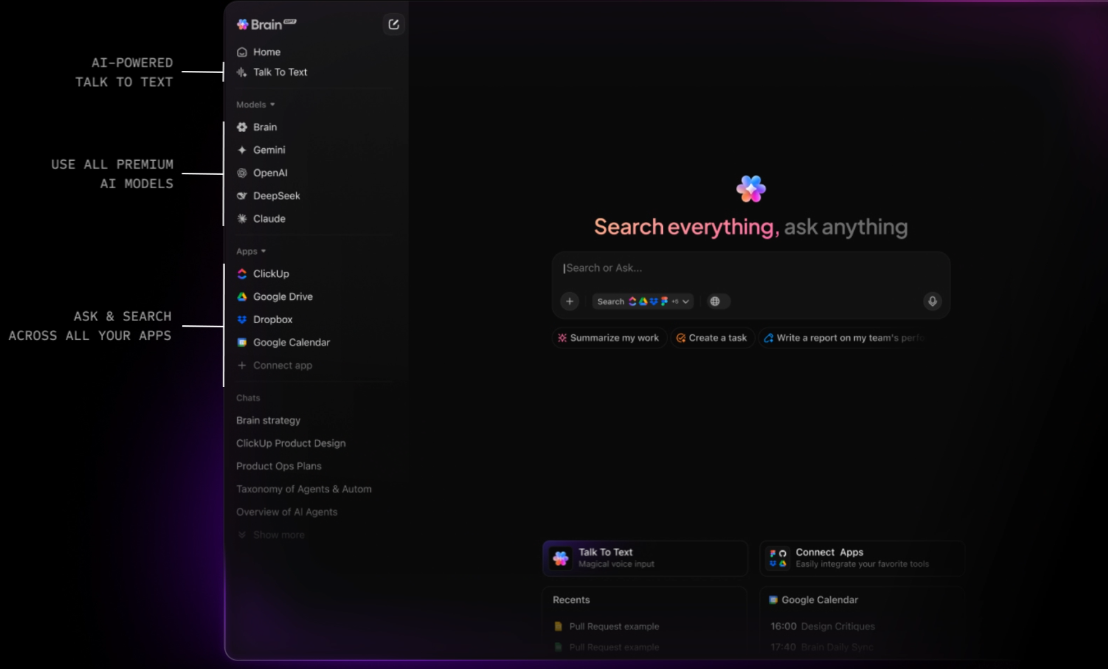

O ClickUp é o primeiro Espaço de Trabalho de IA Convergente que conecta suas tarefas, documentos e pessoas com uma camada de inteligência central. Ao contrário das APIs independentes, que exigem que você crie seus próprios sistemas de recuperação de contexto (RAG), o ClickUp Brain já “conhece” tudo em seu espaço de trabalho.

Como a IA é integrada nativamente, ela não apenas “gera texto”, mas também entende a relação entre a documentação da API Gemini, os prazos do seu projeto e o progresso em tempo real da sua equipe.

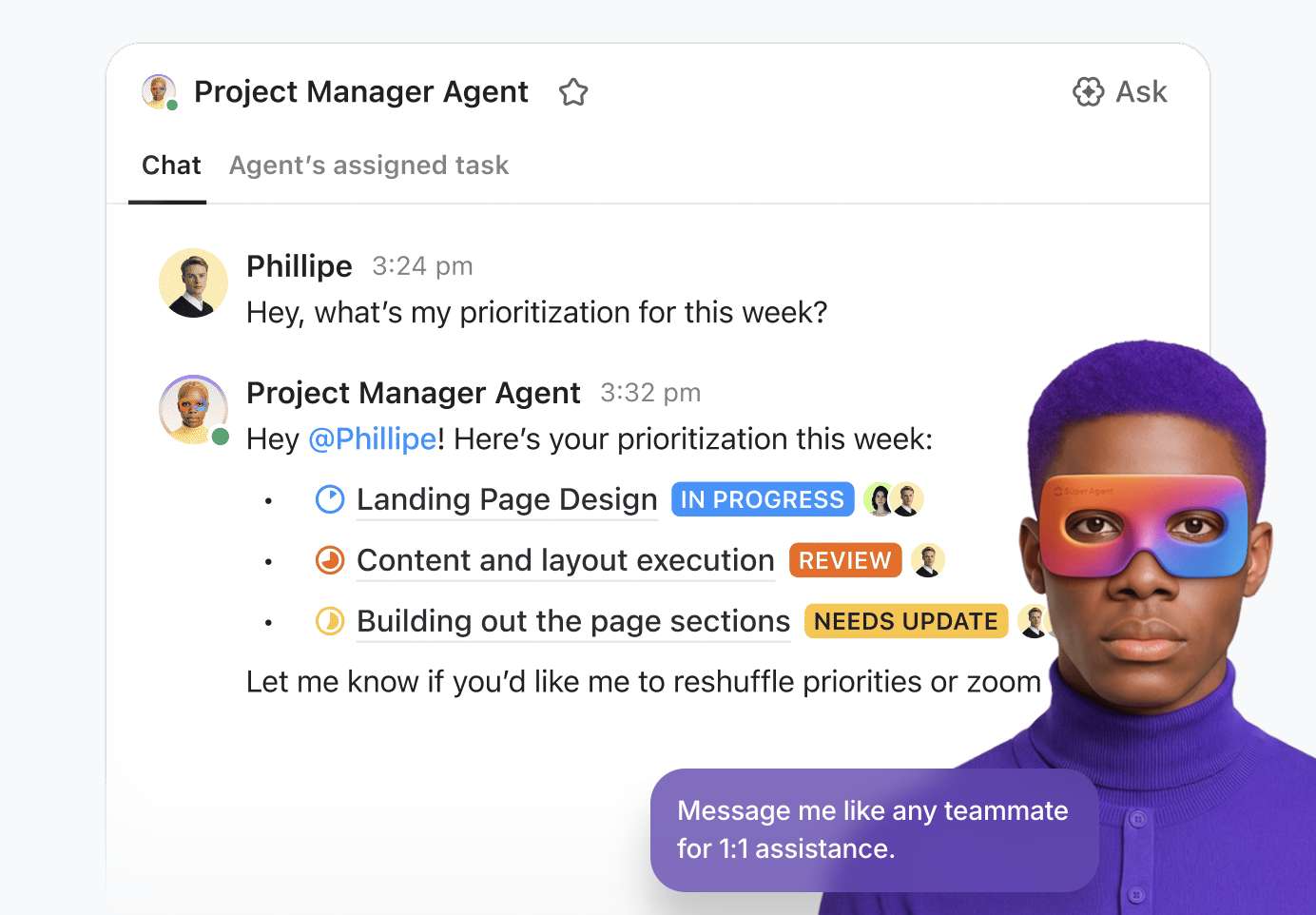

Habilite o “Ask AI” em qualquer lugar e implante agentes autônomos

O verdadeiro poder do ClickUp reside na sua capacidade de transformar conhecimento em ação. Com o Brain Assistant, você pode “perguntar à IA” de qualquer lugar do seu espaço de trabalho — ou até mesmo por meio de um companheiro de desktop enquanto escreve código no seu IDE. Você pode revelar instantaneamente os riscos do projeto perguntando: “Qual foi o feedback sobre a última implementação do Gemini 3 Pro?” O ClickUp Brain fará uma pesquisa profunda em todo o seu histórico, fornecendo uma resposta citada com links para a tarefa exata ou thread de comentários onde a discussão aconteceu.

Para equipes que criam produtos complexos de IA, o ClickUp vai além da simples assistência, permitindo que você implante Superagentes . Eles são colegas de equipe digitais autônomos e sem código que lidam com o “trabalho pesado” do seu ciclo de vida de desenvolvimento. Você pode configurar um Agente de Triagem para monitorar os bugs recebidos da sua integração Gemini ou um Agente de Gerenciamento de Projetos que identifica proativamente os bloqueadores de sprint e gera resumos diários com base na atividade da sua equipe. É um sistema inteligente que mantém seu pipeline de desenvolvimento em movimento 24 horas por dia, 7 dias por semana.

Uma plataforma unificada de gerenciamento de trabalho para o desenvolvedor moderno

O ClickUp Docs funciona como um caderno técnico compartilhado pela sua equipe. Seja para elaborar um PRD para um novo recurso multimodal ou armazenar seus protocolos de segurança da API Gemini, tudo fica conectado.

Uma linha de código em um Doc pode se tornar instantaneamente uma tarefa, e o ClickUp Brain permite que você aproveite a Pesquisa Empresarial para recuperar arquivos e conversas de aplicativos conectados, como Google Workspace, GitHub e Figma, usando pesquisa semântica.

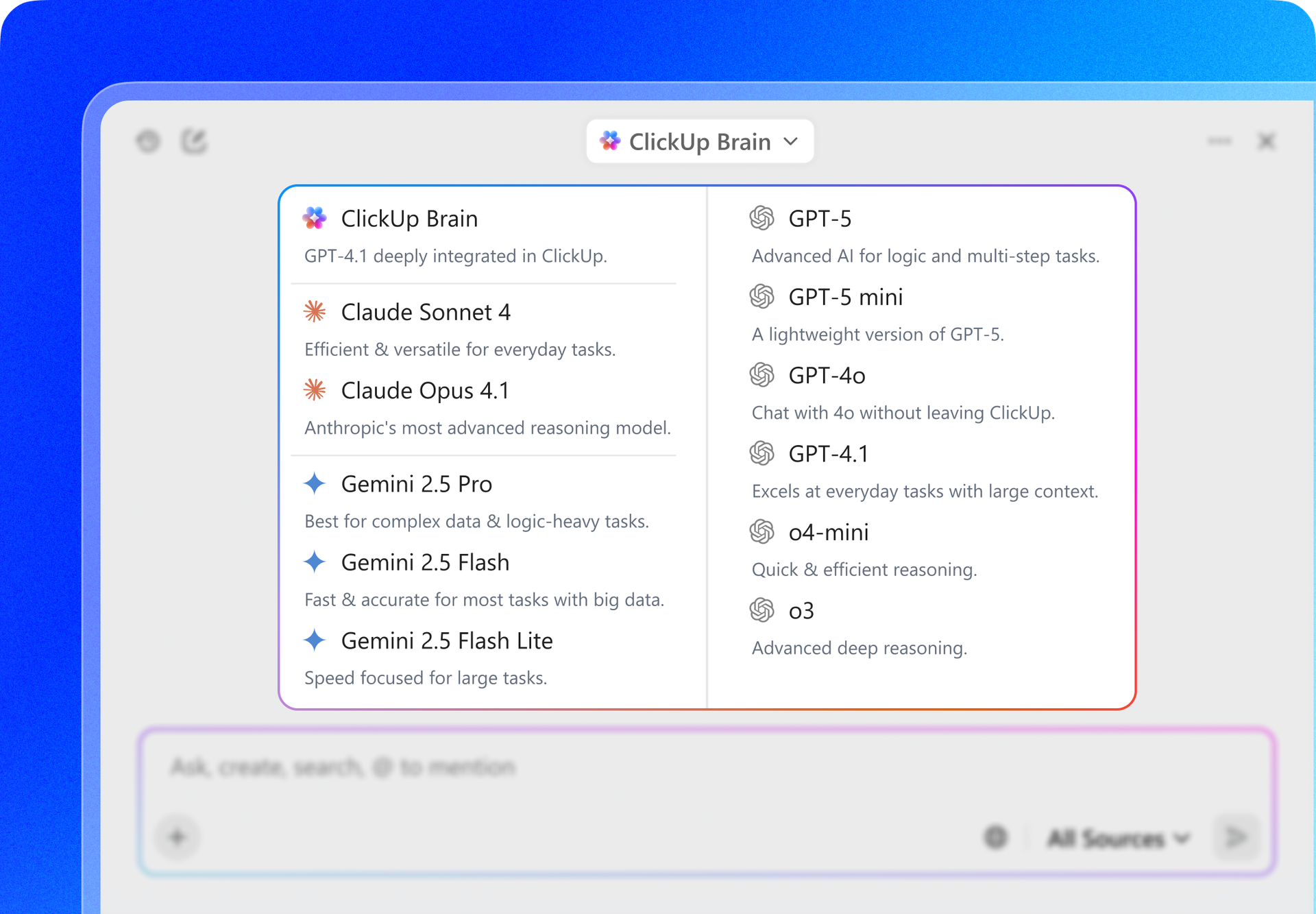

Além disso, o ClickUp oferece flexibilidade multimodelo. Enquanto você cria com a API Gemini, pode usar a interface do ClickUp para alternar entre Gemini 3, GPT-5.2 e Claude 4.5 para comparar resultados ou rascunhos de especificações técnicas. Isso garante que você sempre tenha o melhor “cérebro” para a tarefa em questão, sem nunca sair do seu ambiente de gerenciamento de projetos.

Melhores recursos do ClickUp

Limitações do ClickUp

Preços do ClickUp

Avaliações e comentários do ClickUp

O que os usuários reais estão dizendo sobre o ClickUp?

Os modelos, campos personalizados, prioridades, pontos scrum, planos e várias opções de visualização do ClickUp, apesar de uma ligeira curva de aprendizagem, permitiram à nossa equipe adaptar a ferramenta às nossas necessidades em evolução e maximizar a eficiência. Suas poderosas integrações com ferramentas como Google Drive, reuniões, calendários e o robusto suporte à API aprimoram nosso fluxo de trabalho de maneira integrada. Além disso, os formulários do ClickUp agregam um valor substancial às nossas operações. No geral, tudo no ClickUp é tão poderoso e útil que não quero mudar nada. Sinto fortemente que o ClickUp foi desenvolvido com as preferências do usuário em mente, tornando-o perfeito para nossas necessidades.

A vantagem do ClickUp: em vez de escrever código para conectar seu banco de dados a um LLM, o BrainGPT, um superaplicativo de IA independente do ClickUp, atua como uma interface independente de modelo já conectada às suas tarefas, documentos e repositórios de código.

Isso permite que você:

A plataforma API da OpenAI continua sendo a principal concorrente para desenvolvedores que criam aplicativos complexos e “inteligentes”. Com o lançamento da série GPT-5.2, a OpenAI avançou em direção ao “raciocínio agênico”, em que o modelo pausa automaticamente para validar sua lógica antes de responder.

Ao contrário da integração estreita do Gemini com o Google Workspace, a OpenAI oferece uma abordagem “Foundry” mais modular, tornando-a a escolha preferida para desenvolvedores que desejam uma plataforma neutra em relação ao fornecedor, que se adapta a diferentes provedores de nuvem, como Azure e AWS.

O Gemini 3 Flash, por outro lado, oferece um processamento de vídeo significativamente mais rápido e uma janela de contexto muito maior, com 2 milhões de tokens, enquanto o GPT-5.2 atualmente limita seu contexto nativo a 400.000 tokens.

Melhores recursos da API OpenAI

Limitações da API OpenAI

Preços da API OpenAI

Avaliações e comentários sobre a API OpenAI

O que os usuários reais estão dizendo sobre a OpenAI?

Ficamos extremamente impressionados com os modelos de IA e, especialmente, com o acesso à API. Ao integrar a OpenAI às nossas soluções de CRM (BROSH CRM), podemos oferecer valor real e tangível aos nossos clientes por meio da automação alimentada por IA. A OpenAI permite que o BROSH CRM forneça recursos avançados baseados em IA em várias áreas. Nossos clientes se beneficiam de respostas de IA de alta qualidade e sensíveis ao contexto em seus canais de comunicação, geradas diretamente a partir dos dados do CRM. Isso melhora drasticamente as interações com os clientes, ao mesmo tempo em que economiza tempo e recursos.

📖 Leia mais: Como usar a API ChatGPT para suas aplicações

O Claude, desenvolvido pela Anthropic, é a alternativa ideal para desenvolvedores que priorizam a precisão técnica e o raciocínio “semelhante ao humano”. O Claude 4.5 Sonnet é amplamente considerado o modelo mais confiável para engenharia de software, superando consistentemente outros em benchmarks de codificação, como o SWE-bench.

Um de seus recursos de destaque é o Claude Code, uma ferramenta CLI que permite que o modelo interaja diretamente com seu terminal local e sistema de arquivos para depurar e enviar código.

O Gemini 3 Pro se destaca no processamento de grandes quantidades de dados de uma só vez (como um vídeo de 1 hora), mas o Claude é frequentemente preferido para tarefas em que a “vibração” e a precisão da saída são mais críticas do que o volume total de dados processados.

Melhores recursos da API Claude

Limitações da API Claude

Preços da API Claude

Avaliações e comentários sobre a API Claude

O que os usuários reais estão dizendo sobre a API Claude?

A taxa de uso da API é mais cara do que a do ChatGPT ou Gemini, mas se você quiser apenas fazer perguntas, pode usar a versão para desktop, então não é grande coisa. No entanto, não é a melhor opção se você quiser incorporá-la a um aplicativo.

📖 Leia mais: Como usar a Claude AI para uma codificação eficiente e precisa

A Mistral AI fornece modelos de alto desempenho que oferecem uma alternativa aos sistemas “fechados” do Google e da OpenAI. É considerada líder para empresas que exigem soberania de dados ou desejam implantar modelos em sua própria infraestrutura privada.

Os modelos principais da Mistral, como o Mistral Large 3, são projetados para serem eficientes e “sem filtros”, dando aos desenvolvedores mais controle sobre o comportamento do modelo em comparação com as proteções de segurança mais rígidas frequentemente encontradas no Gemini ou no Claude.

Melhores recursos da Mistral AI

Limitações da IA Mistral

Preços da Mistral AI

Avaliações e comentários sobre a Mistral AI

O que os usuários reais estão dizendo sobre a Mistral AI?

A opinião de um usuário diz:

Perguntei sobre uma figura da história do nosso país. O GEMINI distinguiu corretamente entre duas pessoas muito diferentes com o mesmo nome e sobrenome: uma era historiadora e professora universitária, a outra era uma combatente da resistência deportada durante a Segunda Guerra Mundial. O Mistral AI me deu apenas a descrição da primeira.

Ferramentas alternativas de IA para usar

Embora a API Gemini seja uma potência multimodal, a criação de um aplicativo pronto para produção geralmente requer uma estratégia multimodelo. Dependendo das necessidades específicas do seu projeto em termos de profundidade de raciocínio ou precisão de codificação, você pode considerar estas alternativas à Gemini.

1. ClickUp (ideal para equipes que precisam de uma IA sensível ao contexto integrada ao seu fluxo de trabalho)

A maioria das ferramentas de IA promete facilitar o desenvolvimento, mas muitas vezes acabam sendo apenas mais uma guia desconectada em uma pilha já lotada. Você pode usar a API Gemini para alimentar o backend do seu aplicativo, uma ferramenta separada para resumir notas de reuniões e uma terceira plataforma para gerenciar suas tarefas de sprint. Essa rede de contextos dispersos e ferramentas isoladas é a “expansão da IA”.

O ClickUp é o primeiro Espaço de Trabalho de IA Convergente que conecta suas tarefas, documentos e pessoas com uma camada de inteligência central. Ao contrário das APIs independentes, que exigem que você crie seus próprios sistemas de recuperação de contexto (RAG), o ClickUp Brain já “conhece” tudo em seu espaço de trabalho.

Como a IA é integrada nativamente, ela não apenas “gera texto”, mas também entende a relação entre a documentação da API Gemini, os prazos do seu projeto e o progresso em tempo real da sua equipe.

Habilite o “Ask AI” em qualquer lugar e implante agentes autônomos

O verdadeiro poder do ClickUp reside em sua capacidade de transformar conhecimento em ação. Com o Brain Assistant, você pode “perguntar à IA” de qualquer lugar do seu espaço de trabalho — ou até mesmo por meio de um companheiro de desktop enquanto escreve código no seu IDE. Você pode revelar instantaneamente os riscos do projeto perguntando: “Qual foi o feedback sobre a última implementação do Gemini 3 Pro?” O ClickUp Brain fará uma pesquisa profunda em todo o seu histórico, fornecendo uma resposta citada com links para a tarefa exata ou thread de comentários onde a discussão aconteceu.

Para equipes que criam produtos complexos de IA, o ClickUp vai além da simples assistência, permitindo que você implante Super Agentes . Eles são colegas de equipe digitais autônomos e sem código que lidam com o “trabalho pesado” do seu ciclo de vida de desenvolvimento. Você pode configurar um Agente de Triagem para monitorar os bugs recebidos da sua integração Gemini ou um Agente de Gerenciamento de Projetos que identifica proativamente os bloqueadores de sprint e gera resumos diários com base na atividade da sua equipe. É um sistema inteligente que mantém seu pipeline de desenvolvimento em movimento 24 horas por dia, 7 dias por semana.

Uma plataforma unificada de gerenciamento de trabalho para o desenvolvedor moderno

O ClickUp Docs funciona como um caderno técnico compartilhado pela sua equipe. Seja para elaborar um PRD para um novo recurso multimodal ou armazenar seus protocolos de segurança da API Gemini, tudo fica conectado.

Uma linha de código em um Doc pode se tornar instantaneamente uma tarefa, e o ClickUp Brain permite que você aproveite a Pesquisa Empresarial para recuperar arquivos e conversas de aplicativos conectados, como Google Workspace, GitHub e Figma, usando pesquisa semântica.

Além disso, o ClickUp oferece flexibilidade multimodelo. Enquanto você cria com a API Gemini, pode usar a interface do ClickUp para alternar entre Gemini 3, GPT-5.2 e Claude 4.5 para comparar resultados ou rascunhos de especificações técnicas. Isso garante que você sempre tenha o melhor “cérebro” para a tarefa em questão, sem nunca sair do seu ambiente de gerenciamento de projetos.

Melhores recursos do ClickUp

- Pesquisa universal e pergunte à IA: recupere dados instantaneamente no ClickUp, Slack, GitHub e Drive, ou peça à IA para resumir qualquer documento ou sequência de tarefas de qualquer lugar do espaço de trabalho.

- Agentes sem código: Implante agentes sem código para automatizar a criação de tarefas, atualizações de status e relatórios, transformando o gerenciamento manual de projetos em um fluxo de trabalho autônomo.

- Chat com IA integrada: mencione @Brain em qualquer thread do ClickUp Chat para transformar instantaneamente uma conversa em uma tarefa formatada ou para obter um resumo de uma longa discussão.

- Painéis alimentados por IA: visualize a saúde da equipe com painéis em tempo real que usam IA para identificar riscos de sprint, prever atrasos e explicar tendências de dados em linguagem simples.

- AI Writer for Docs: Elabore requisitos técnicos, SOPs e agendas de reuniões pré-preenchidas com os dados e o contexto específicos do seu projeto.

Limitações do ClickUp

- A eficácia da IA está ligada à higiene do seu espaço de trabalho; se sua equipe não mantiver as tarefas e os documentos atualizados, a IA terá menos “contexto” para extrair suas respostas.

Preços do ClickUp

Avaliações e comentários do ClickUp

- G2: 4,7/5 (mais de 10.900 avaliações)

- Capterra: 4,6/5 (mais de 4.500 avaliações)

O que os usuários reais estão dizendo sobre o ClickUp?

Os modelos, campos personalizados, prioridades, pontos scrum, planos e várias opções de visualização do ClickUp, apesar de uma ligeira curva de aprendizagem, permitiram à nossa equipe adaptar a ferramenta às nossas necessidades em evolução e maximizar a eficiência. Suas poderosas integrações com ferramentas como Google Drive, reuniões, calendários e o robusto suporte à API aprimoram nosso fluxo de trabalho de maneira integrada. Além disso, os formulários do ClickUp agregam um valor substancial às nossas operações. No geral, tudo no ClickUp é tão poderoso e útil que não quero mudar nada. Sinto fortemente que o ClickUp foi desenvolvido com as preferências do usuário em mente, tornando-o perfeito para nossas necessidades.

Os modelos, campos personalizados, prioridades, pontos scrum, planos e várias opções de visualização do ClickUp, apesar de uma ligeira curva de aprendizagem, permitiram à nossa equipe adaptar a ferramenta às nossas necessidades em evolução e maximizar a eficiência. Suas poderosas integrações com ferramentas como Google Drive, reuniões, calendários e o robusto suporte à API aprimoram nosso fluxo de trabalho de maneira integrada. Além disso, os formulários do ClickUp agregam um valor substancial às nossas operações. No geral, tudo no ClickUp é tão poderoso e útil que não quero mudar nada. Sinto fortemente que o ClickUp foi desenvolvido com as preferências do usuário em mente, tornando-o perfeito para nossas necessidades.

A vantagem do ClickUp: em vez de escrever código para conectar seu banco de dados a um LLM, o BrainGPT, um superaplicativo de IA independente do ClickUp, atua como uma interface independente de modelo já conectada às suas tarefas, documentos e repositórios de código.

Isso permite que você:

- Alterne entre modelos: use o Gemini 3 para tarefas de contexto massivas de 2 milhões de tokens e, em seguida, mude para o Claude 4.5 para obter precisão de codificação — tudo na mesma janela.

- Pesquisa unificada: pergunte “Quais foram as especificações finais de segurança da API discutidas na reunião do mês passado?” e obtenha uma resposta fundamentada, extraída simultaneamente do Slack, GitHub e ClickUp Docs.

- Talk-to-Text: Use o aplicativo BrainGPT Desktop para ditar comandos como “Crie um ticket Jira para a integração Gemini e atribua-o ao desenvolvedor líder” — sem necessidade de teclado

2. API OpenAI (ideal para inteligência de uso geral e raciocínio de agentes)

A plataforma API da OpenAI continua sendo a principal concorrente para desenvolvedores que criam aplicativos complexos e “inteligentes”. Com o lançamento da série GPT-5.2, a OpenAI avançou em direção ao “raciocínio agênico”, em que o modelo pausa automaticamente para validar sua lógica antes de responder.

Ao contrário da integração estreita da Gemini com o Google Workspace, a OpenAI oferece uma abordagem “Foundry” mais modular, tornando-a a escolha preferida para desenvolvedores que desejam uma plataforma neutra em relação ao fornecedor, que pode ser dimensionada em diferentes provedores de nuvem, como Azure e AWS.

O Gemini 3 Flash, por outro lado, oferece um processamento de vídeo significativamente mais rápido e uma janela de contexto muito maior, com 2 milhões de tokens, enquanto o GPT-5.2 atualmente limita seu contexto nativo a 400.000 tokens.

Melhores recursos da API OpenAI

- Use o Modo de Pensamento para lidar com problemas complexos e de várias etapas que exigem verificação interna antes de gerar uma resposta final.

- Acesse a API em tempo real para criar experiências multimodais de baixa latência, incluindo interações nativas de fala para fala.

- Aproveite a API de pesquisa de arquivos (Vector Store) para criar sistemas RAG (Retrieval-Augmented Generation) com gerenciamento de documentos integrado.

Limitações da API OpenAI

- O uso pode se tornar caro muito rapidamente se não for monitorado com cuidado, especialmente ao usar modelos de alto raciocínio como o GPT-5. 2 Pro

Preços da API OpenAI

- GPT-5. 2: US$ 1,75/1 milhão de entradas | US$ 14,00/1 milhão de saídas

- GPT-5. 2 Pro: US$ 21,00/1 milhão de entradas | US$ 168,00/1 milhão de saídas

- GPT-5 Mini: US$ 0,25/1 milhão de entradas | US$ 2,00/1 milhão de saídas

Avaliações e comentários sobre a API OpenAI

- G2: 4,7/5 (mais de 840 avaliações)

- Gartner Peer Insights: 4,4/5 (mais de 60 avaliações)

O que os usuários reais estão dizendo sobre a OpenAI?

Ficamos extremamente impressionados com os modelos de IA e, especialmente, com o acesso à API. Ao integrar a OpenAI às nossas soluções de CRM (BROSH CRM), podemos oferecer valor real e tangível aos nossos clientes por meio da automação alimentada por IA. A OpenAI permite que o BROSH CRM forneça recursos avançados baseados em IA em várias áreas. Nossos clientes se beneficiam de respostas de IA de alta qualidade e sensíveis ao contexto em seus canais de comunicação, geradas diretamente a partir dos dados do CRM. Isso melhora drasticamente as interações com os clientes, ao mesmo tempo em que economiza tempo e recursos.

Ficamos extremamente impressionados com os modelos de IA e, especialmente, com o acesso à API. Ao integrar a OpenAI às nossas soluções de CRM (BROSH CRM), podemos oferecer valor real e tangível aos nossos clientes por meio da automação alimentada por IA. A OpenAI permite que o BROSH CRM forneça recursos avançados baseados em IA em várias áreas. Nossos clientes se beneficiam de respostas de IA de alta qualidade e sensíveis ao contexto em seus canais de comunicação, geradas diretamente a partir dos dados do CRM. Isso melhora drasticamente as interações com os clientes, ao mesmo tempo em que economiza tempo e recursos.

📖 Leia mais: Como usar a API ChatGPT para seus aplicativos

3. API Claude (ideal para codificação de alto risco e redação técnica detalhada)

O Claude, desenvolvido pela Anthropic, é a alternativa ideal para desenvolvedores que priorizam a precisão técnica e o raciocínio “semelhante ao humano”. O Claude 4. 5 Sonnet é amplamente considerado o modelo mais confiável para engenharia de software, superando consistentemente outros em benchmarks de codificação, como o SWE-bench.

Um de seus recursos de destaque é o Claude Code, uma ferramenta CLI que permite que o modelo interaja diretamente com seu terminal local e sistema de arquivos para depurar e enviar código.

O Gemini 3 Pro se destaca no processamento de grandes quantidades de dados de uma só vez (como um vídeo de 1 hora), mas o Claude é frequentemente preferido para tarefas em que a “vibração” e a precisão da saída são mais críticas do que o volume total de dados processados.

Melhores recursos da API Claude

- Mantenha a lógica complexa do projeto usando o Claude Projects, que permite agrupar documentos e códigos relacionados para um melhor contexto.

- Use o Prompt Caching para reduzir significativamente os custos e a latência de solicitações repetitivas e de alto volume.

- Execute e teste o código em tempo real no ambiente do modelo usando a Ferramenta de Análise (Execução de Código).

Limitações da API Claude

- Atualmente, o Claude não possui ferramentas nativas de geração de imagens ou vídeos, exigindo que os desenvolvedores integrem APIs de terceiros para trabalhos criativos visuais.

Preços da API Claude

- Claude 4. 5 Opus: US$ 15,00/1 milhão de entradas | US$ 75,00/1 milhão de saídas

- Claude 4.5 Sonnet: US$ 3,00/1 milhão de entradas | US$ 15,00/1 milhão de saídas

- Claude 4.5 Haiku: US$ 1,00/1 milhão de entradas | US$ 5,00/1 milhão de saídas

Avaliações e comentários sobre a API Claude

- G2: 4,4/5 (mais de 55 avaliações)

- Capterra: 4,6/5 (mais de 20 avaliações)

O que os usuários reais estão dizendo sobre a API Claude?

A taxa de uso da API é mais cara do que a do ChatGPT ou Gemini, mas se você quiser apenas fazer perguntas, pode usar a versão para desktop, então não é grande coisa. No entanto, não é a melhor opção se você quiser incorporá-la a um aplicativo.

A taxa de uso da API é mais cara do que a do ChatGPT ou Gemini, mas se você quiser apenas fazer perguntas, pode usar a versão para desktop, então não é grande coisa. No entanto, não é a melhor opção se você quiser incorporá-la a um aplicativo.

4. Mistral AI (ideal para flexibilidade de peso aberto e soberania de dados)

A Mistral AI fornece modelos de alto desempenho que oferecem uma alternativa aos sistemas “fechados” do Google e da OpenAI. É considerada líder para empresas que exigem soberania de dados ou desejam implantar modelos em sua própria infraestrutura privada.

Os modelos principais da Mistral, como o Mistral Large 3, são projetados para serem eficientes e “sem filtros”, dando aos desenvolvedores mais controle sobre o comportamento do modelo em comparação com as proteções de segurança mais rígidas frequentemente encontradas no Gemini ou no Claude.

Melhores recursos da Mistral AI

- Implante modelos em seu próprio hardware ou VPC (Virtual Private Cloud) para obter o máximo de privacidade e segurança de dados.

- Use o Mistral Memories para salvar e recuperar contextos importantes em diferentes sessões sem precisar reenviar dados manualmente.

- Acesse o Diretório de Conectores para vincular facilmente seus modelos a fontes de dados externas, como Notion, GitHub e Slack.

Limitações da IA Mistral

- A documentação e o suporte da comunidade para o Mistral não são tão extensos quanto os do Google ou OpenAI, o que pode levar a uma curva de aprendizado mais íngreme para novos desenvolvedores.

Preços da Mistral AI

- Mistral Large 3: US$ 2,00/1 milhão de entradas | US$ 6,00/1 milhão de saídas

- Mistral Small: US$ 0,20/1 milhão de entradas | US$ 0,60/1 milhão de saídas

- Mistral Free: acesso limitado à API para testes

Avaliações e comentários sobre a Mistral AI

- G2: 4,4/5 (avaliações iniciais limitadas)

- Capterra: 4,5/5 (avaliações iniciais limitadas)

O que os usuários reais estão dizendo sobre a Mistral AI?

A opinião de um usuário diz:

Perguntei sobre uma figura da história do nosso país. A GEMINI distinguiu corretamente entre duas pessoas muito diferentes com o mesmo nome e sobrenome: uma era historiadora e professora universitária, a outra era um combatente da resistência deportado durante a Segunda Guerra Mundial. A Mistral AI me deu apenas a descrição da primeira.

Perguntei sobre uma figura da história do nosso país. A GEMINI distinguiu corretamente entre duas pessoas muito diferentes com o mesmo nome e sobrenome: uma era historiadora e professora universitária, a outra era um combatente da resistência deportado durante a Segunda Guerra Mundial. A Mistral AI me deu apenas a descrição da primeira.

APIs facilitadas com o ClickUp

Começar a usar a API Google Gemini é simples: você obtém uma chave, instala um SDK e faz sua primeira chamada de API. Mas, à medida que você passa de um script simples para um aplicativo de produção, surgem os verdadeiros desafios: gerenciar chaves, documentar prompts e manter o trabalho da sua equipe organizado.

A API Gemini oferece recursos poderosos de IA, mas integrá-la ao seu fluxo de trabalho pode criar documentação dispersa, acompanhamento fragmentado de projetos e mudanças intermináveis de contexto.

As equipes que centralizam seu desenvolvimento de IA junto com o gerenciamento de tarefas e a documentação avançam mais rapidamente e mantêm um contexto melhor. A escolha de onde você organiza esse trabalho determinará a eficácia com que você pode inovar e colaborar.

Comece gratuitamente com o ClickUp e experimente como um espaço de trabalho convergente pode transformar seu processo de desenvolvimento de IA.

Perguntas frequentes sobre a API Gemini

Sim, o Google oferece um generoso plano gratuito para o Gemini 3 Flash e Pro através do Google AI Studio. No entanto, ferramentas especializadas como o Google Search Grounding têm uma taxa (US$ 14/1 mil consultas) após as primeiras 5.000 solicitações por mês.

O Google AI Studio é uma ferramenta baseada na web para experimentar prompts e gerar chaves API rapidamente. A API Gemini é a interface programática que você usa em seu código para incorporar esses recursos de IA em seus próprios aplicativos.

Sim, a API Gemini suporta conversas com várias respostas, o que a torna uma ótima opção para criar chatbots internos, bots de suporte ao cliente ou assistentes de equipe. Você usaria a API como o “cérebro” do chatbot e criaria a interface do usuário separadamente.

Os limites de taxa variam dependendo do modelo que você está usando e se você está no nível gratuito ou pago. O nível gratuito tem limites mais baixos de solicitações por minuto, enquanto os planos pagos oferecem maior rendimento para aplicativos de produção.