Os mecanismos de pesquisa sempre foram essenciais para encontrar informações, mas o comportamento do usuário evoluiu. Em vez de pesquisas simples por palavras-chave como “smartphones”, as pessoas agora fazem consultas mais específicas e personalizadas, como “melhores celulares econômicos para jogos”.

Enquanto isso, grandes modelos de linguagem (LLMs), como o ChatGPT, transformam a pesquisa ao atuarem como sistemas inteligentes de perguntas e respostas.

Ao se integrarem aos mecanismos de pesquisa tradicionais, eles aprimoram a recuperação de informações por meio da geração aumentada por recuperação (RAG), tornando os resultados mais precisos e sensíveis ao contexto.

Em vez de competir, os LLMs e os mecanismos de pesquisa trabalham juntos para lidar com consultas complexas de maneira mais eficaz. Neste artigo, exploraremos como essa integração está moldando o futuro da pesquisa.

⏰ Resumo de 60 segundos

- Os mecanismos de pesquisa tradicionais muitas vezes têm dificuldade em gerenciar grandes conjuntos de dados, manter a qualidade dos dados e quebrar silos.

- Eles também enfrentam desafios relacionados à segurança, escalabilidade e fornecimento de resultados contextualmente relevantes.

- Modelos de linguagem grandes, como o ChatGPT, aumentam a precisão da pesquisa, permitem a pesquisa semântica e oferecem suporte a consultas em linguagem natural.

- Os LLMs também melhoram os recursos de pesquisa multimodal e tornam a descoberta de conhecimento mais personalizada e eficiente.

- Os recursos de pesquisa conectada e IA do ClickUp se baseiam nesses avanços, centralizando seus dados e permitindo a recuperação rápida e precisa de informações.

- O ClickUp se integra perfeitamente a várias plataformas, fornecendo acesso em tempo real ao seu conteúdo, otimizando fluxos de trabalho e melhorando a produtividade geral.

Sem mais delongas, vamos começar!

O que são LLMs?

Os modelos de linguagem grandes (LLMs) são sistemas avançados de inteligência artificial que processam e geram linguagem humana. Eles são treinados em extensos conjuntos de dados de texto, equipando-os para lidar com tarefas como tradução, resumo e conversas.

Alguns dos exemplos mais populares de LLMs incluem GPT-3 e GPT-4, amplamente reconhecidos por sua capacidade de lidar com consultas complexas relacionadas à linguagem.

Ao contrário dos mecanismos de pesquisa tradicionais que dependem de palavras-chave, um mecanismo de pesquisa baseado em LLM vai além das consultas superficiais. Ele entende o contexto e a intenção por trás das perguntas, fornecendo respostas diretas e detalhadas.

👀 Você sabia? 71% dos usuários preferem personalização das marcas e empresas que escolhem.

Recursos dos mecanismos de pesquisa LLM

Os mecanismos de pesquisa LLM oferecem recursos avançados que redefinem a forma como os usuários da Internet acessam e interagem com as informações. Vamos examinar seus principais recursos:

- Compreensão semântica da consulta: os mecanismos de pesquisa LLM interpretam o significado por trás das consultas de pesquisa, indo além das palavras-chave para entender a intenção e o contexto do usuário.

- Processamento de linguagem natural (NLP): os usuários podem formular consultas de forma coloquial, sem a necessidade de palavras-chave exatas, tornando as pesquisas mais intuitivas.

- Relevância contextual: os resultados da pesquisa são personalizados com base em consultas e interações anteriores, garantindo informações mais relevantes e atualizadas.

- Geração de respostas: esses sistemas fornecem respostas abrangentes diretamente nos resultados de pesquisa, incluindo resumos, explicações e até formatos criativos, como histórias ou guias passo a passo.

- Integração de gráficos de conhecimento: os mecanismos de pesquisa LLM usam gráficos de conhecimento para conectar conceitos e entidades relacionados, oferecendo insights mais profundos.

- Pesquisa conversacional: os usuários podem participar de um diálogo interativo, fazendo perguntas complementares e refinando suas pesquisas para uma experiência mais interativa.

- Resultados adaptáveis: os resultados são ajustados dinamicamente com base na localização, nos interesses e nas pesquisas anteriores, proporcionando uma experiência mais personalizada.

- Síntese de informações: em vez de depender de uma única fonte, os mecanismos de pesquisa LLM agregam dados de várias fontes, proporcionando uma perspectiva mais ampla.

👀 Você sabia? Com o uso crescente de alto-falantes inteligentes e assistentes de voz, 50% de todas as pesquisas agora são baseadas em voz. À medida que grandes modelos de linguagem são integrados a esses sistemas, as pesquisas por voz se tornarão ainda mais precisas, fornecendo acesso mais rápido a informações em várias plataformas, sejam arquivos, tarefas ou notas de reuniões.

Técnicas avançadas de pesquisa com LLMs

À medida que a tecnologia de pesquisa avança, LLMs como GPT-4, BERT e T5 estão transformando a forma como os mecanismos de pesquisa processam consultas, personalizam resultados e refinam classificações. Vamos explorar como esses modelos estão redefinindo o futuro da pesquisa.

Como os LLMs enviam consultas de pesquisa

A pesquisa evoluiu de simples consultas por palavras-chave para pesquisas vetoriais semânticas. Em vez de pesquisar um termo específico como “Monte Fuji”, os usuários podem pesquisar “montanhas no Japão” e o sistema recupera resultados baseados no significado.

Reformular consultas em perguntas — como “Quais são as montanhas famosas no Japão?” — pode refinar a precisão da pesquisa. Os modelos de linguagem grandes (LLMs) também aprimoram as pesquisas, acionando consultas adicionais se a confiança for baixa, usando técnicas como FLARE.

O raciocínio em cadeia melhora ainda mais as pesquisas, dividindo as tarefas em etapas lógicas, como visto no AutoGPT. Além disso, a pesquisa conversacional permite que os assistentes baseados em LLM refinem as consultas em tempo real, garantindo resultados mais precisos durante toda a interação.

Pesquisa personalizada e reconhecimento de contexto

A consciência contextual é um dos recursos mais poderosos dos LLMs. Ao contrário dos mecanismos de pesquisa tradicionais, que classificam os resultados por correspondência de palavras-chave, os LLMs levam em consideração a intenção do usuário, a localização, o histórico de pesquisa e as interações anteriores.

Ao fazer o ajuste fino com dados específicos do domínio, os LLMs personalizam os resultados da pesquisa para reconhecer padrões e priorizar o conteúdo relevante. Por exemplo, um usuário que pesquisa frequentemente receitas veganas verá opções à base de plantas ao procurar por “melhores receitas para o jantar”.

Os LLMs também interpretam consultas multimodais, compreendendo tanto textos quanto imagens para obter resultados mais precisos. Além disso, eles criam um contexto longitudinal, aprendendo com interações contínuas para sugerir consultas relevantes de forma proativa.

LLMs na reclassificação e melhoria dos resultados dos motores de busca

Os LLMs aprimoram os mecanismos de pesquisa, reclassificando dinamicamente os resultados para refletir melhor a intenção do usuário. Ao contrário da classificação tradicional baseada em palavras-chave, os LLMs usam mecanismos de atenção para analisar o contexto completo de uma consulta e priorizar o conteúdo relevante.

Por exemplo, a atualização BERT (Bidirectional Encoder Representations from Transformers) do Google revolucionou a pesquisa ao compreender o contexto por trás de palavras como “apple” (fruta) e “Apple” (empresa de tecnologia).

Os LLMs também contribuem para melhorar a eficiência da SERP (página de resultados do mecanismo de pesquisa). Ao analisar fatores como taxa de cliques (CTR), taxa de rejeição e tempo de permanência, os LLMs podem ajustar as classificações em tempo real, impulsionando resultados que proporcionam alto envolvimento do usuário.

📖 Leia também: Como pesquisar arquivos PDF rapidamente

Ferramentas populares de mecanismos de pesquisa LLM

À medida que a pesquisa baseada em IA evolui, vários mecanismos de pesquisa de modelos de linguagem de grande porte estão ganhando força por seus recursos avançados. A Perplexity AI fornece respostas diretas com fontes citadas, tornando as pesquisas mais interativas e informativas.

O You.com oferece uma experiência personalizável, permitindo que os usuários priorizem fontes, integrem resumos gerados por IA e interajam com assistentes de IA.

Todos sabemos que podemos recorrer a esses mecanismos de pesquisa para recuperar informações e obter respostas rápidas. Mas e quanto a localizar aquele arquivo crucial no trabalho? Ou recuperar uma conversa repleta de pontos de dados para sua próxima grande apresentação?

É aqui que entra em cena o ClickUp, o aplicativo que faz tudo para o trabalho!

📮 ClickUp Insight: 46% dos profissionais do conhecimento dependem de uma combinação de bate-papo, notas, ferramentas de gerenciamento de projetos e documentação da equipe apenas para acompanhar seu trabalho. Para eles, o trabalho está espalhado por plataformas desconectadas, tornando mais difícil manter a organização. Como o aplicativo completo para o trabalho, o ClickUp unifica tudo. Com recursos como ClickUp Email Project Management, ClickUp Notes, ClickUp Chat e ClickUp Brain, todo o seu trabalho fica centralizado em um só lugar, pesquisável e perfeitamente conectado. Diga adeus à sobrecarga de ferramentas e dê as boas-vindas à produtividade sem esforço.

O ClickUp Brain combina recursos avançados de pesquisa com recursos abrangentes de gerenciamento de projetos, conectando tarefas, arquivos, membros da equipe e projetos em um só lugar. Chega de alternar entre aplicativos ou lidar com ferramentas fragmentadas e silos de informações!

Os custos da ineficiência causada por ferramentas desconectadas são impressionantes:

- 2. 5 horas/dia: os profissionais do conhecimento passam cerca de 30% do seu dia de trabalho procurando informações.

- 3.600 alternâncias de aplicativos/dia: os funcionários alternam entre aplicativos e janelas mais de 3.600 vezes por dia, perdendo 4 horas por semana para se reorientar.

- 23 minutos perdidos: cada mudança de aplicativo atrapalha o foco, levando quase 23 minutos para voltar ao ritmo normal.

US$ 420.000 por ano: organizações com 100 funcionários perdem esse valor anualmente devido a falhas de comunicação e ferramentas desconectadas.

Essas ineficiências levam à perda de tempo, diminuição do moral e aumento dos custos operacionais. Felizmente, a IA conectada transforma esses desafios em oportunidades para uma tomada de decisão mais inteligente, recuperação mais rápida de informações e execução perfeita.

Veja como a Pesquisa Conectada do ClickUp transforma a colaboração:

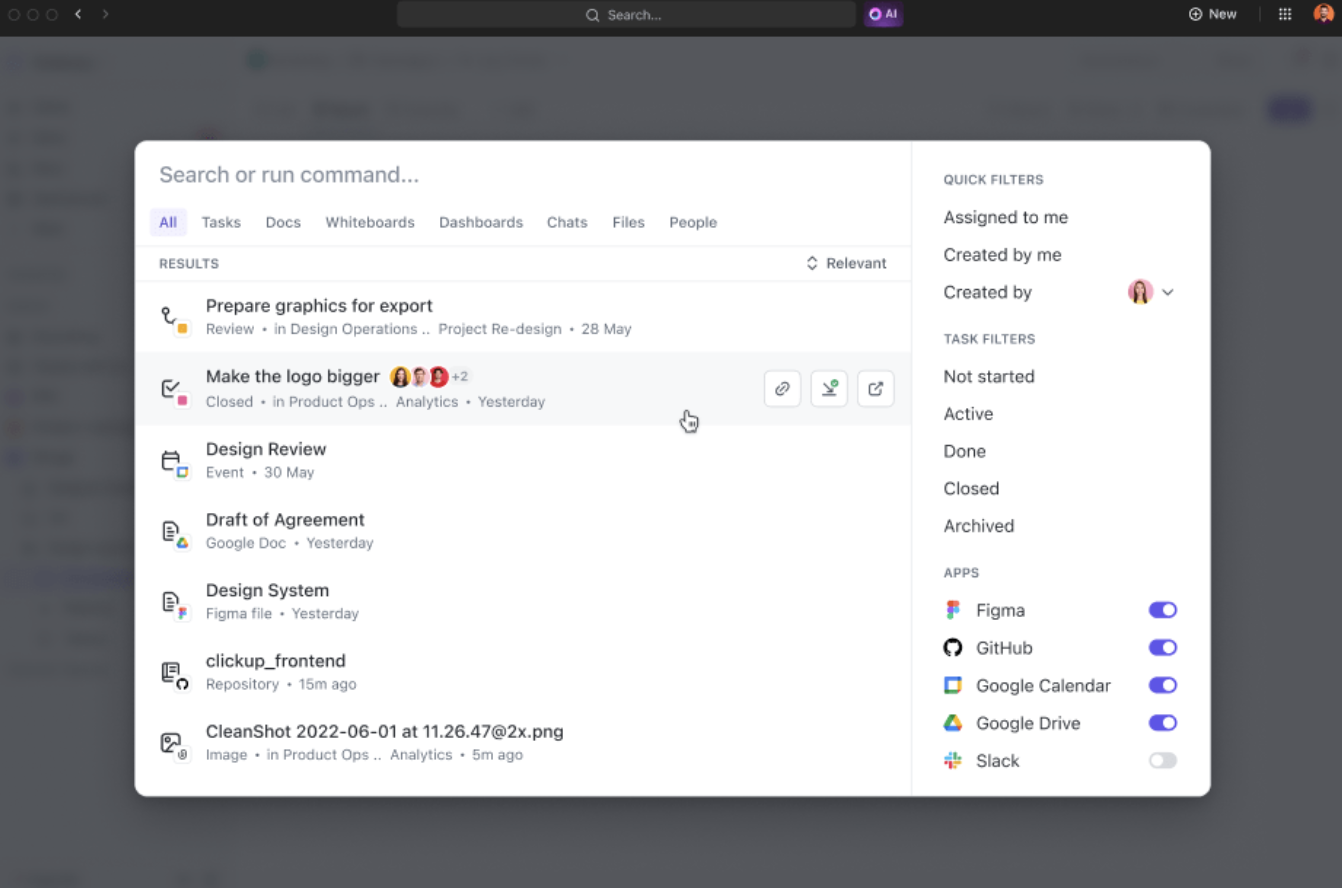

- Pesquisa unificada: acesse todas as informações da sua empresa a partir de uma única plataforma, economizando quase quatro horas por semana ao reduzir a alternância entre aplicativos.

- Relevância impulsionada por IA: obtenha resultados de pesquisa personalizados e sensíveis ao contexto, adaptados aos seus projetos, melhorando a tomada de decisões com acesso instantâneo às informações mais relevantes.

- Integração fácil de ferramentas: conecte-se perfeitamente a ferramentas existentes, como Google Drive, SharePoint, Figma e Slack, sem a necessidade de configurações complexas.

Por exemplo, ao retornar de uma folga, basta solicitar ao ClickUp Brain atualizações sobre seus projetos. Ele fornecerá pontos-chave organizados de forma clara com itens de ação críticos e discussões que ocorreram enquanto você estava ausente.

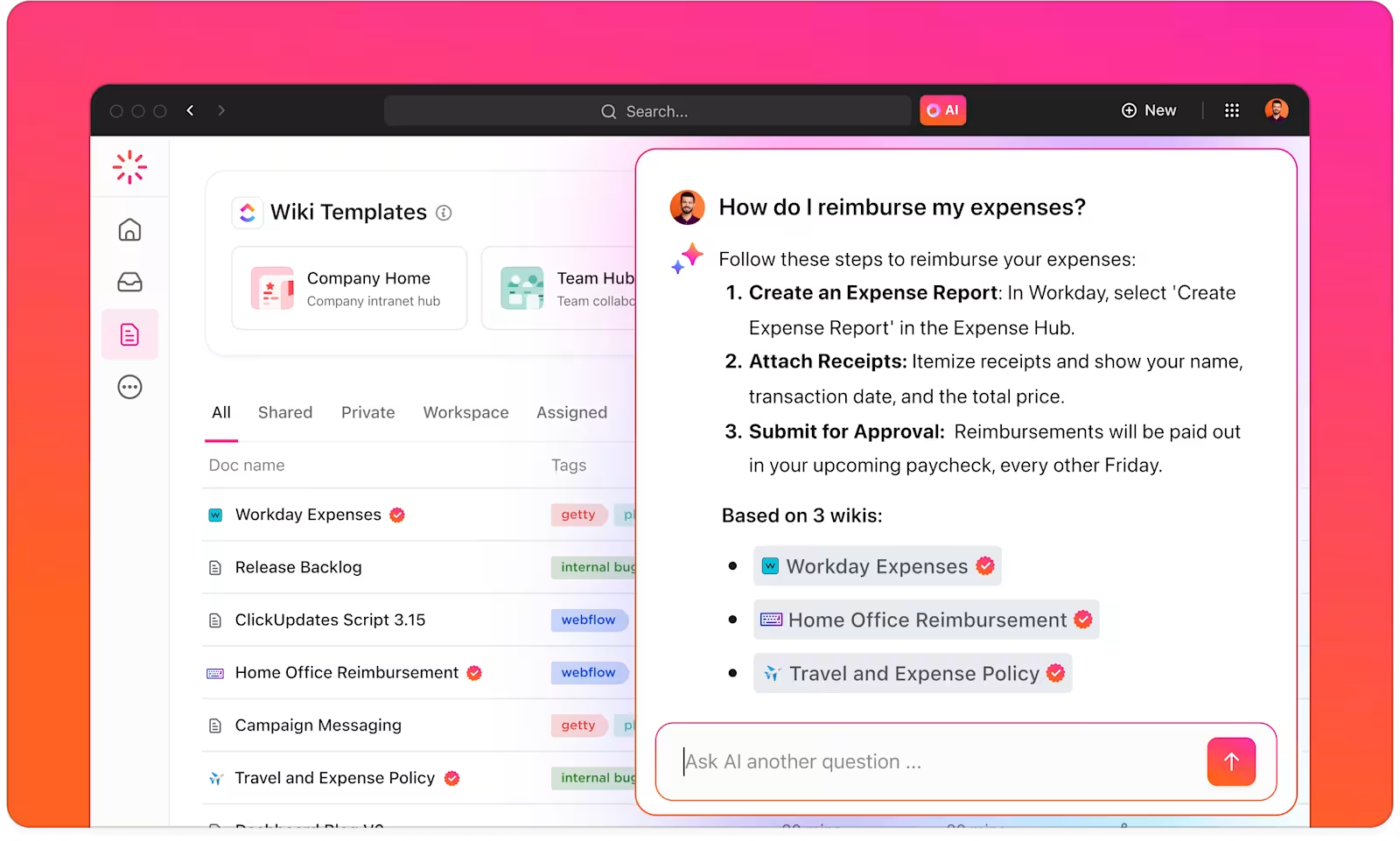

Com o ClickUp Brain, você tem um gerenciador de conhecimento inteligente que ajuda a encontrar tudo dentro do seu espaço de trabalho e aplicativos conectados.

O ClickUp Brain entende o contexto de suas tarefas e oferece sugestões relevantes com base em suas preferências de trabalho ou atividades principais. Para criadores de conteúdo, por exemplo, ele fornece sugestões para criação de conteúdo, brainstorming e tarefas relacionadas.

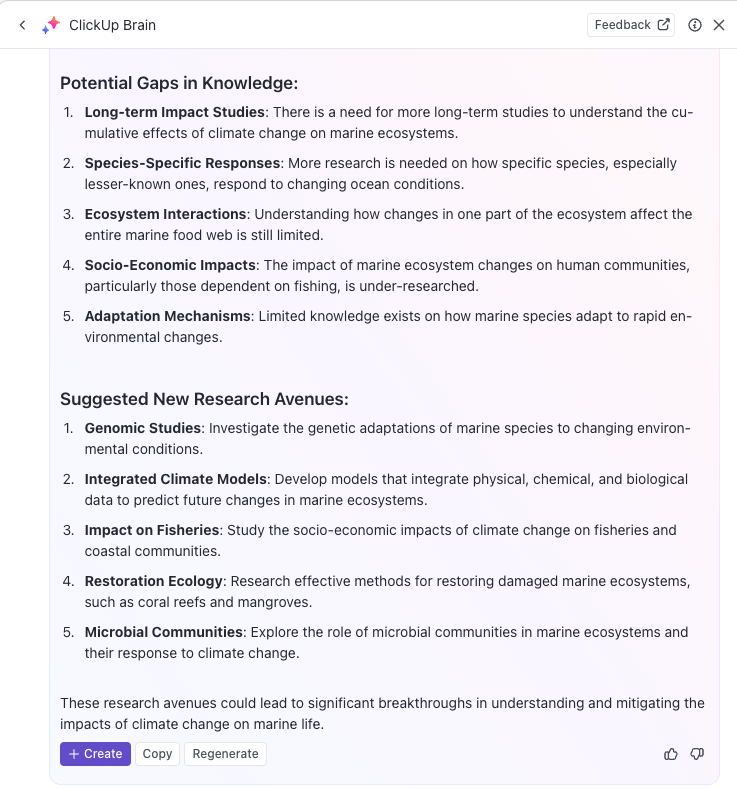

Você pode até usar a IA para automatizar tarefas repetitivas ou atualizar o status das tarefas com prompts simples, permitindo que você se concentre em trabalhos mais complexos. Se você está procurando um mecanismo de pesquisa de IA poderoso para aumentar a produtividade, o ClickUp Brain é a solução ideal.

Com o ClickUp Brain, você pode otimizar sua base de conhecimento categorizando, marcando e organizando automaticamente todas as informações relevantes.

Por exemplo, equipes de pesquisa podem usar o ClickUp para criar um sistema centralizado de gerenciamento de conhecimento para armazenar todos os insights, documentos e resultados de pesquisa em um formato facilmente acessível.

Além disso, a versatilidade do ClickUp Docs oferece suporte à criação de wikis, repositórios de documentos e gerenciamento de tarefas relacionadas ao conhecimento.

Você também pode organizar as informações de várias maneiras, usando o ClickUp Spaces, pastas e listas para estruturar o conteúdo para uma recuperação rápida. Sua equipe pode facilmente encontrar e acessar os dados certos quando necessário, sem perder tempo pesquisando em várias plataformas.

Além disso, a plataforma ajuda a rastrear tarefas e projetos por meio do ClickUp Tasks com base nas informações obtidas dos mecanismos de pesquisa LLM. Você pode integrar os resultados de pesquisa com inteligência artificial diretamente em seus fluxos de trabalho de rastreamento de tarefas e projetos, facilitando a implementação do conhecimento que você descobriu.

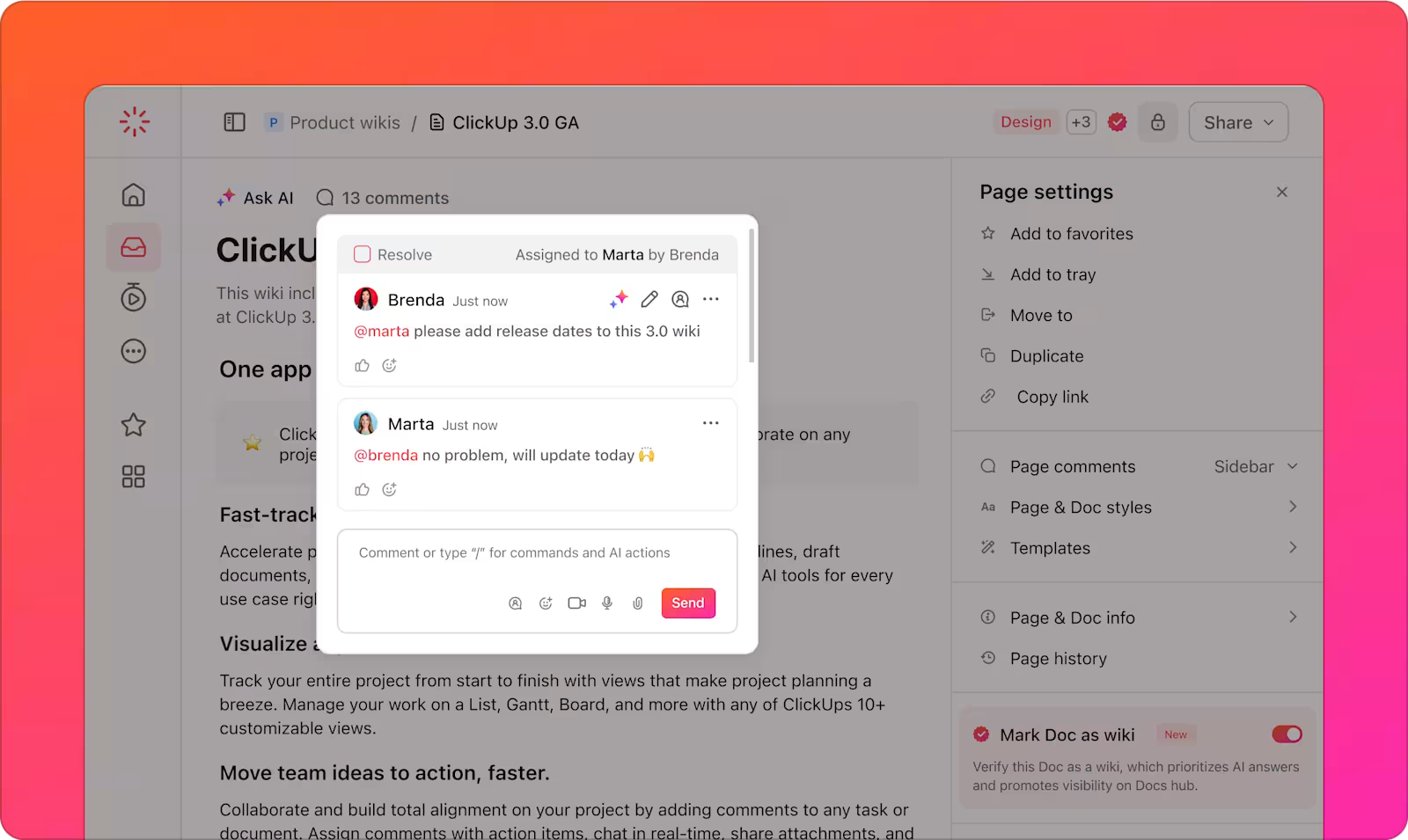

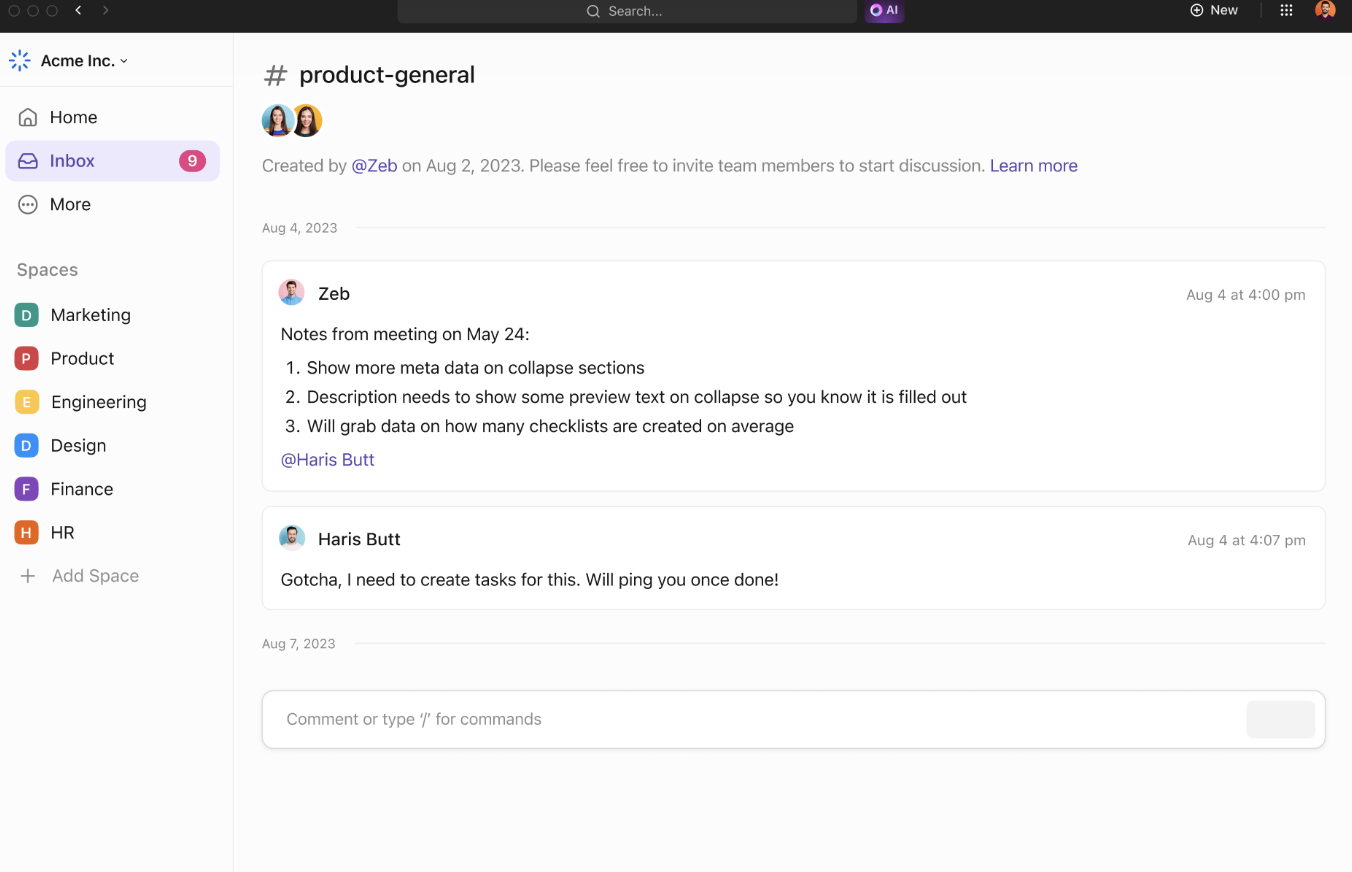

As ferramentas de colaboração do ClickUp aumentam ainda mais a eficiência da equipe e o compartilhamento de informações. O ClickUp Chat permite que os membros da equipe discutam projetos, compartilhem ideias e façam perguntas em tempo real.

Os comentários atribuídos fornecem uma maneira clara de se comunicar sobre documentos ou tarefas específicas, garantindo que todos fiquem informados sobre as atualizações do projeto.

As equipes podem colaborar compartilhando ideias e visualizando conceitos. Adicione notas, carregue imagens e incorpore links para melhorar o contexto. Use conectores para ligar ideias e destacar suas relações.

Quando suas ideias estiverem prontas, converta-as em tarefas rastreáveis no ClickUp Whiteboards para manter tudo dentro do prazo.

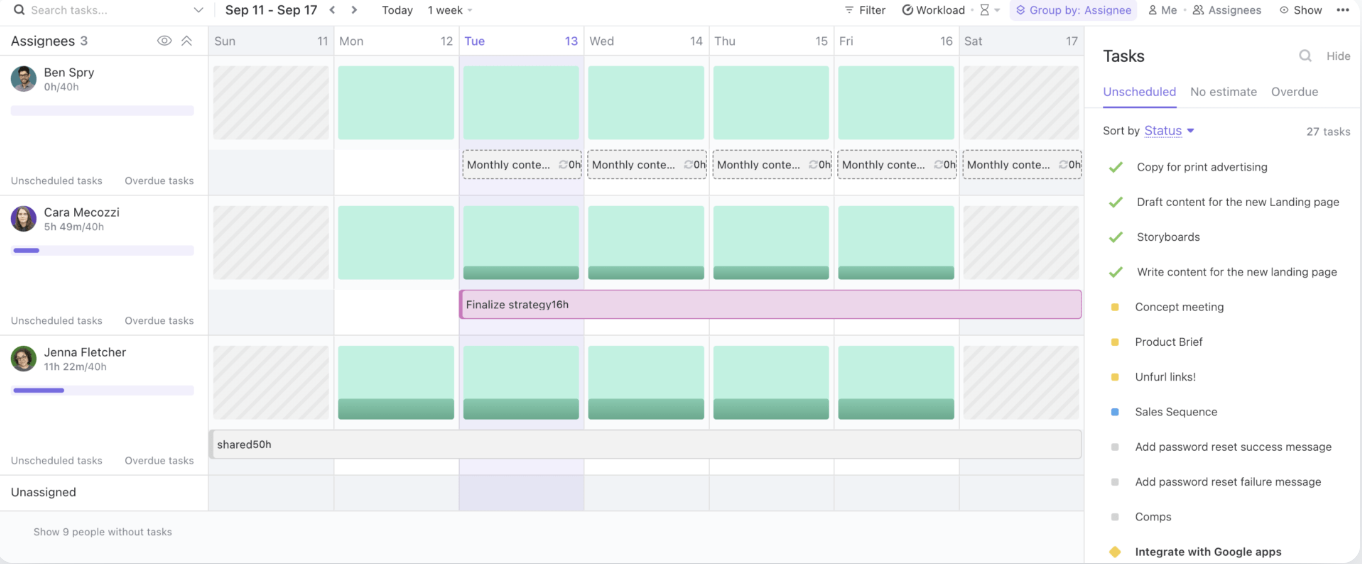

Por fim, a Visualização da Carga de Trabalho do ClickUp permite que você gerencie a capacidade da equipe, acompanhe as tarefas em andamento e aloque recursos de maneira eficaz.

Ao fornecer um hub centralizado para compartilhamento de conhecimento e colaboração, o ClickUp otimiza os fluxos de trabalho e melhora a eficiência da equipe.

Melhores práticas para usar mecanismos de pesquisa LLM

Ao usar mecanismos de pesquisa LLM, é essencial seguir as melhores práticas que maximizam seu potencial e, ao mesmo tempo, gerenciam os riscos.

Essas estratégias ajudarão você a tirar o máximo proveito de suas ferramentas baseadas em IA, garantindo uma implementação tranquila e sucesso a longo prazo:

- Defina casos de uso claros: colabore desde o início entre as equipes comerciais e técnicas para estabelecer casos de uso específicos e mensuráveis. Alinhe os objetivos para garantir que a solução atenda às necessidades certas e facilite a avaliação do progresso.

- Estabeleça processos de admissão criteriosos: considere a sensibilidade dos dados, os riscos potenciais e os usuários pretendidos ao priorizar os casos de uso. Use uma abordagem por níveis de risco para avaliar quais projetos oferecem mais valor com o mínimo de danos.

- Concentre-se na coleta, teste e validação de dados: garanta dados sólidos e baseados em fatos, melhorando as práticas de coleta, rotulagem, armazenamento e processamento.

- Implemente procedimentos de teste padronizados: crie processos de teste repetíveis, apoiados por manuais e práticas predefinidas. Garanta resultados consistentes, confiabilidade do sistema e modelos de IA bem testados antes da implantação.

- Configure o monitoramento contínuo: monitore o desempenho do sistema ao longo do tempo, adaptando-se às mudanças nos dados, no comportamento do usuário e na tecnologia.

- Implemente campanhas de treinamento e comunicação: equipe sua equipe com o conhecimento necessário para usar as ferramentas de IA de maneira responsável e eficaz. Lance programas de treinamento e comunicação que abranjam os aspectos técnicos e éticos da IA.

Desafios e soluções na pesquisa baseada em LLM

Os mecanismos de pesquisa baseados em LLM oferecem um enorme potencial, mas também apresentam seus próprios desafios. Abaixo estão alguns desafios comuns da IA e soluções práticas para superá-los:

Qualidade e relevância dos dados

Os mecanismos de pesquisa baseados em LLM dependem muito da qualidade e da relevância dos dados que processam. Dados ruins ou desatualizados podem levar a resultados de pesquisa imprecisos ou irrelevantes, afetando a experiência do usuário.

✨ Ao se concentrarem em dados atualizados e de alta qualidade, as organizações podem garantir que seus mecanismos de pesquisa baseados em LLM retornem resultados relevantes e confiáveis.

Falta de transparência

Os modelos LLM são frequentemente considerados “caixas pretas”, em que o raciocínio por trás de seus resultados não é imediatamente aparente para os usuários. Essa falta de transparência pode dificultar a confiança dos usuários nos resultados que recebem.

✨ Ao incorporar recursos de explicabilidade ao mecanismo de pesquisa, as organizações podem fornecer aos usuários insights sobre por que resultados específicos foram retornados.

Preconceitos e questões éticas

Os LLMs podem herdar vieses dos dados com os quais são treinados, o que pode levar a resultados distorcidos ou antiéticos. Se os dados de treinamento não forem diversificados ou representativos, o mecanismo de pesquisa poderá refletir esses vieses, afetando a tomada de decisões e a imparcialidade.

✨ Auditar e atualizar regularmente os dados de treinamento é essencial para identificar e mitigar esses vieses. Além disso, incorporar conjuntos de dados diversificados e monitorar os resultados garante que o mecanismo de pesquisa produza resultados mais equilibrados, justos e éticos.

Complexidade e integração do sistema

Integrar mecanismos de pesquisa baseados em LLM a fluxos de trabalho e aplicativos existentes pode ser uma tarefa difícil, principalmente quando se lida com sistemas legados ou várias fontes de dados. A complexidade de conectar essas novas ferramentas a plataformas estabelecidas pode retardar a implementação.

✨ Com a Pesquisa Conectada do ClickUp, você pode encontrar rapidamente qualquer arquivo, esteja ele armazenado no ClickUp, em um aplicativo conectado ou em seu disco local.

A questão das alucinações

Alucinações referem-se a casos em que o modelo gera informações factualmente incorretas, inventadas ou irrelevantes. Isso acontece porque o modelo, em vez de extrair diretamente de fontes indexadas, às vezes “alucina” dados com base em padrões aprendidos durante o treinamento.

✨ Técnicas avançadas, como engenharia de prompt e dados de treinamento de alta qualidade, aumentam a confiabilidade do LLM. O ajuste fino com dados específicos do domínio reduz as alucinações, enquanto a integração do gráfico de conhecimento garante resultados de pesquisa precisos e baseados em fatos.

O futuro da pesquisa com LLMs

A próxima geração de pesquisa baseada em LLM promete ainda mais precisão, adaptabilidade e capacidade de resposta, especialmente no tratamento de consultas complexas e dinâmicas dos usuários. Esses sistemas se adaptarão dinamicamente às necessidades em evolução dos usuários, aprendendo com interações anteriores e dados em tempo real.

Por exemplo, em um ambiente corporativo, um LLM poderia interpretar uma solicitação como “Encontre a análise de rotatividade de clientes do último trimestre” e retornar não apenas o arquivo bruto, mas também insights sintetizados, tendências relevantes e conclusões acionáveis.

Os setores que dependem do gerenciamento de conjuntos de dados vastos e complexos são os que mais têm a ganhar:

- Na área da saúde, grandes modelos de linguagem podem apoiar a precisão do diagnóstico, analisando e cruzando notas clínicas, resultados de imagens e artigos de pesquisa em segundos.

- Os profissionais do direito se beneficiarão de ferramentas que podem analisar uma extensa jurisprudência para destacar precedentes relevantes.

- As equipes financeiras podem usar LLMs para tarefas como detecção de fraudes em tempo real, análise preditiva de mercado e automatização de verificações de conformidade.

A integração de recursos de pesquisa multimodal — combinando reconhecimento de texto, voz e imagem — ampliará ainda mais a utilidade dos LLMs.

Por exemplo, uma equipe colaborando no lançamento de um produto pode carregar imagens instantaneamente, fazer anotações com entradas de voz e recuperar documentos e relatórios relacionados. Esse nível de adaptabilidade torna os LLMs essenciais para garantir o acesso contínuo a diversos formatos de dados.

Plataformas como o ClickUp, combinadas com a pesquisa baseada em LLM, oferecem uma solução robusta para organizar e acessar arquivos, otimizar fluxos de trabalho e impulsionar a eficiência na tomada de decisões.

Potencialize seu fluxo de trabalho com a pesquisa baseada em LLM

À medida que os mecanismos de pesquisa baseados em IA e alimentados por LLMs continuam a evoluir, eles estão revolucionando a forma como as empresas recuperam informações de páginas da web e gerenciam dados.

Com sua capacidade de compreender o contexto, fornecer resultados mais precisos e se integrar perfeitamente aos fluxos de trabalho corporativos, os LLMs estão abrindo caminho para operações mais inteligentes, rápidas e eficientes.

E quando se trata de encontrar um mecanismo de pesquisa de IA perfeitamente integrado ao seu fluxo de trabalho, nada supera o ClickUp Brain. Se você precisa localizar rapidamente um arquivo ou tarefa, debater ideias ou até mesmo redigir um e-mail, os poderosos recursos de IA do ClickUp Brain podem cuidar de tudo isso.

A integração com as ferramentas abrangentes de gerenciamento de projetos do ClickUp garante que tudo esteja ao seu alcance, ajudando você a se manter organizado, economizar tempo e tomar decisões baseadas em dados com mais rapidez.

Então, o que você está esperando? Inscreva-se hoje mesmo no ClickUp e seja mais produtivo com o ClickUp Brain!