Heeft uw AI-model ooit een zelfverzekerd antwoord gegeven dat uw gebruikers achterhaald noemden? Dat is het soort ervaring dat ertoe leidt dat je team elk antwoord in twijfel trekt.

Het klinkt als de nachtmerrie van elke ontwikkelaar en AI-liefhebber, toch?

Grote taalmodellen (LLM's) werken op trainingsgegevens, maar naarmate de gegevens ouder worden, sluipen er onnauwkeurigheden in. Omdat hertraining miljoenen kost, is optimalisatie het slimste middel.

Retrieval Augmented Generation (RAG) en fine-tuning zijn de beste methoden om de nauwkeurigheid te verbeteren. Echter, gezien de verschillen tussen elke aanpak, zijn ze ideaal voor verschillende toepassingen. Het juiste framework is de sleutel tot het effectief verbeteren van uw LLM.

Maar welke is geschikt voor u?

Dit artikel behandelt het dilemma in deze RAG vs. fine-tuning gids. Of u nu werkt met domeinspecifieke gegevens of oplossingen zoekt voor het ophalen van gegevens van hoge kwaliteit, hier vindt u antwoorden!

samenvatting ⏰60 seconden

- Het verbeteren van de prestaties van LLM's en AI-modellen is een sleutelonderdeel van elke business en ontwikkelingsfunctie. Hoewel RAG en fine-tuning populaire benaderingen zijn, is het belangrijk om hun nuances en impact te begrijpen

- RAG rust LLM's uit met realtime, externe gegevensopvraag, waardoor de kosten voor omscholing afnemen

- Fine-tuning optimaliseert LLM's door te trainen op gespecialiseerde datasets, waardoor de nauwkeurigheid voor domeinspecifieke Taken wordt verbeterd

- RAG is het beste voor snel veranderende gegevensomgevingen zoals financiën, juridische updates en klantenservice

- Fine-tuning is ideaal voor merkspecifieke AI, industrieën waar compliance een grote rol speelt en sentimentanalyse

- ClickUp Brain combineert beide, waarbij RAG wordt gebruikt voor contextuele inzichten en fine-tuning voor automatisering en content generatie op maat

- ClickUp's AI-tools verbeteren het ophalen van kennis, automatisering van werkstromen en projectmanagement voor topefficiëntie

Wat is Retrieval-Augmented Generation (RAG)?

Kijkt u naar nieuwe rapportages en enquêtes die uw LLM niet heeft gebruikt? Dan hebt u RAG nodig. Laten we de basisprincipes van deze aanpak bekijken om dit beter te begrijpen.

Definitie van RAG

RAG is een AI-framework waarbij extra informatie wordt opgehaald voor uw LLM om de responsnauwkeurigheid te verbeteren. Voordat een LLM antwoord wordt gegenereerd, worden de meest relevante gegevens opgehaald uit externe bronnen, zoals kennisbronnen of databases.

Zie het als de onderzoeksassistent binnen het LLM of generatieve AI-model.

👀 Wist u dat? LLM's, vooral tekstgeneratoren, kunnen hallucineren door valse maar plausibele informatie te genereren. En dat allemaal door gaten in de trainingsgegevens.

De belangrijkste voordelen van RAG

Het is nu waarschijnlijk wel duidelijk. RAG is een extra laag verbonden AI die uw bedrijfsprocessen nodig hebben. Om het potentieel ervan te benadrukken, zijn hier de voordelen die het met zich meebrengt:

- Lagere trainingskosten: Dankzij het dynamisch ophalen van informatie hoeft het model niet vaak opnieuw te worden getraind. Dit leidt tot een kosteneffectievere inzet van AI, vooral voor domeinen met snel veranderende gegevens

- Schaalbaarheid: Breidt de kennis van LLM uit zonder de grootte van het primaire systeem te vergroten. Ze helpen bedrijven om te schalen, grote datasets te beheren en meer query's uit te voeren zonder hoge computerkosten

- Realtime updates: Geeft de laatste informatie weer in elke respons en houdt het model relevant. Prioriteit geven aan nauwkeurigheid door middel van real-time updates is van vitaal belang bij veel activiteiten, waaronder financiële analyse, gezondheidszorg en nalevingscontroles

📮 ClickUp Insight: De helft van onze respondenten worstelt met de invoering van AI; 23% weet gewoon niet waar te beginnen, terwijl 27% meer training nodig heeft om iets geavanceerds te doen.

ClickUp lost dit probleem op met een vertrouwde chatinterface die aanvoelt als tekst. Teams kunnen meteen aan de slag met eenvoudige vragen en verzoeken en ontdekken dan gaandeweg de krachtigere functies en workflows voor automatisering, zonder de intimiderende leercurve die zo veel mensen tegenhoudt.

RAG-gebruiksgevallen

Vraagt u zich af waar RAG uitblinkt? Overweeg deze sleutelgebruiksgevallen:

Chatbots en klantenservice

Query's van klanten vereisen vaak up-to-date en contextbewuste antwoorden. RAG verbetert de mogelijkheden van de chatbot door de nieuwste ondersteuningsartikelen, beleidsregels en stappen voor probleemoplossing op te halen.

Dit maakt nauwkeurigere, real-time assistentie mogelijk zonder uitgebreide training vooraf.

Dynamisch ophalen van documenten

RAG optimaliseert het zoeken naar documenten door de meest relevante secties uit grote opslagplaatsen te halen. In plaats van algemene samenvattingen kunnen LLM's gerichte antwoorden geven uit bijgewerkte handleidingen, onderzoeksrapporten of juridische documenten.

Door LLM's met RAG te gebruiken, kunt u informatie sneller en nauwkeuriger ophalen.

🧠 Leuk weetje: Meta, eigenaar van Facebook, Instagram, Threads en WhatsApp, introduceerde RAG in de ontwikkeling van LLM in 2020.

Wat is finetuning?

Laten we eens kijken wat finetuning doet.

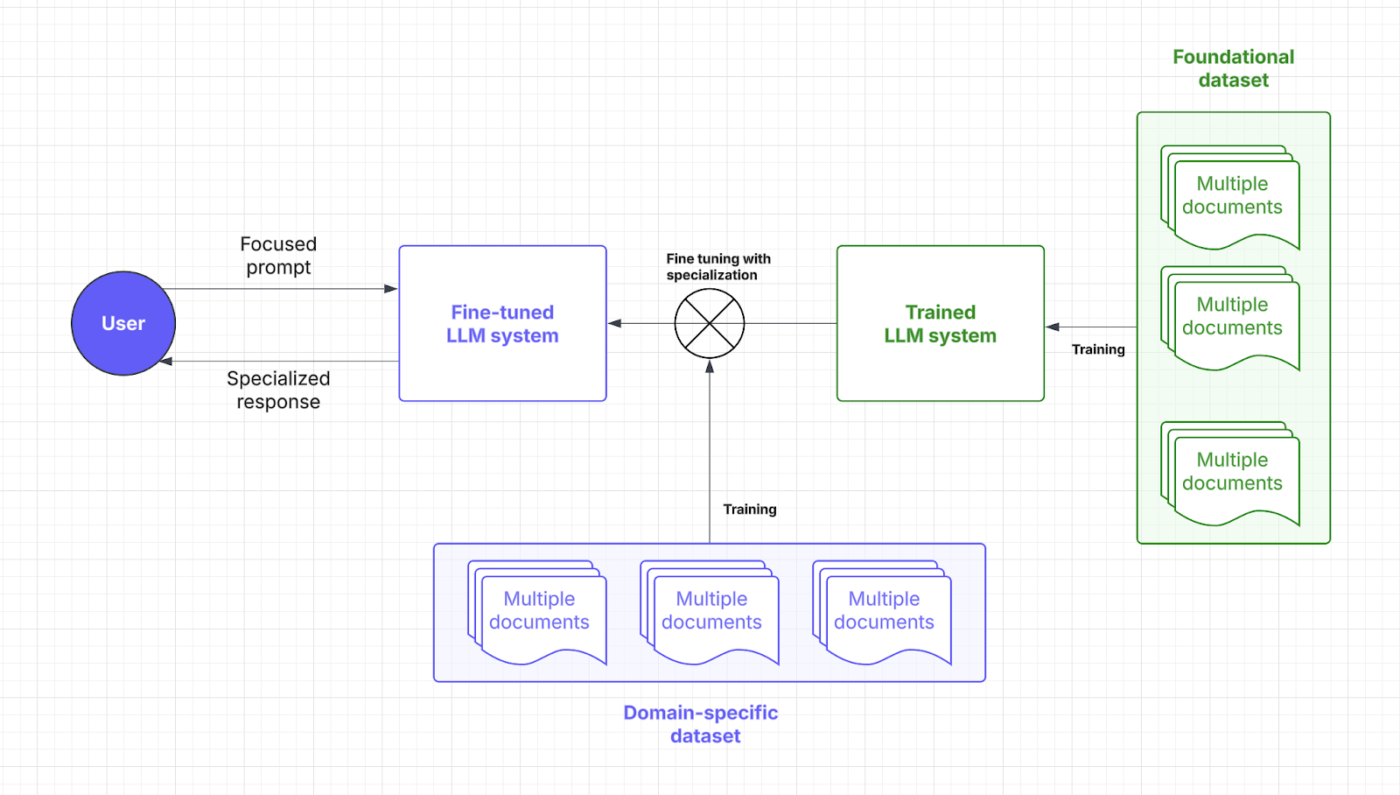

Definitie van fine-tuning

Bij fine-tuning wordt een vooraf getraind taalmodel getraind. Ja, veel trainen, wat kan worden uitgelegd via punt en focus.

Weet u dat? In Large Language Model (LLM) training zijn "gewichten" de aanpasbare parameters binnen het neurale netwerk die de sterkte van verbindingen tussen neuronen bepalen en in wezen de geleerde informatie opslaan; het trainingsproces optimaliseert deze gewichten om voorspellingsfouten te minimaliseren.

"Focus" omvat verschillende aspecten: het gaat om het zorgvuldig verzamelen van gegevens om de kwaliteit en relevantie te waarborgen, het gebruik van aandachtsmechanismen om relevante invoersegmenten te prioriteren en gerichte fine-tuning om het model te specialiseren voor specifieke Taken.

Door middel van gespecialiseerde datasets kunnen AI-modellen zich met fine-tuning richten op het uitvoeren van domeinspecifieke Taken. Door modelgewichten en focus aan te passen, krijgt uw LLM meer contextueel begrip en nauwkeurigheid.

Denk aan het finetunen van de master die uw LLM nodig heeft om de taal van uw branche te spreken. Laten we eens kijken waar deze AI-strategie het prompt response-proces binnenkomt:

Voordelen van fine-tuning

Fine-tuning technieken zijn gewoon AI tweaking. Het is meer de mogelijkheid om in te zoomen op vooraf gedefinieerde details. Dit zijn de voordelen ervan:

- Taakspecifieke optimalisatie: Gespecialiseerde datasets verscherpen LLM reacties voor specifieke Taken. Wilt u gebruikers helpen de hoofdpijn van complexe prompts over te slaan? Fine-tuning helpt ontwikkelaars om AI-oplossingen op maat te krijgen

- Verbeterde nauwkeurigheid voor nichetoepassingen: Domeinkennis vermindert fouten en verbetert de nauwkeurigheid van elke respons. Fine-tuning verhoogt ook de betrouwbaarheid van een LLM, waardoor bedrijven kunnen afzien van micromanagement en handmatig toezicht

- Fine-tuning leert LLM's bedrijfstermen, stijl en regelgeving. Dit zorgt voor een consistente merkstem en sectorspecifieke naleving

Gebruikscases voor fine-tuning

Uw fine-tuningproces ontsluit target efficiëntie. Hier blinkt het uit:

Domeinspecifieke QA-systemen

Sectoren als de juridische sector, de gezondheidszorg en de financiële sector zijn afhankelijk van nauwkeurige, domeinbewuste AI-antwoorden. Fine-tuning rust LLM's uit met gespecialiseerde kennis en zorgt zo voor nauwkeurige vraagbeantwoording (QA).

Een juridische AI-assistent kan bijvoorbeeld contracten nauwkeuriger interpreteren, terwijl een medische chatbot op symptomen gebaseerde begeleiding kan bieden met behulp van vertrouwde datasets.

Sentimentanalyse en aangepaste werkstromen

Bedrijven gebruiken een verfijnd model om merken te bewaken, feedback van klanten te analyseren en workflows te automatiseren die zijn afgestemd op unieke operationele behoeften. Een AI-tool kan genuanceerd sentiment in productbeoordelingen detecteren en bedrijven helpen hun aanbod te verfijnen.

In HR helpt het combineren van fine-tuning met natuurlijke taalverwerking AI bij het analyseren van werknemersenquêtes en het signaleren van zorgen over de werkplek met een groter bewustzijn van de context.

💡 Pro Tip: Fine-tuning kan het toevoegen van meer diverse gegevens inhouden om mogelijke vertekeningen te verwijderen. Het is niet echt domeinspecifiek, maar het is nog steeds een cruciale toepassing.

Vergelijking: RAG vs. Fijnafstemming

Het valt niet te ontkennen dat beide AI-strategieën gericht zijn op prestatieverbetering.

Maar kiezen lijkt nog steeds lastig, toch? Hier volgt een overzicht van fine-tuning vs. RAG om u te helpen de juiste beslissing te nemen voor uw LLM investeringen.

| Aspect | RAG (Retrieval-augmented generation) | Fijnafstemming |

| Definitie | Stelt LLM in staat om realtime relevante gegevens op te halen uit externe bronnen met een speciaal systeem | Traint een vooraf getraind model met gespecialiseerde datasets voor domeinspecifieke Taken |

| Prestaties en nauwkeurigheid | Geweldig voor het real-time ophalen van gegevens, maar nauwkeurigheid is afhankelijk van de kwaliteit van externe gegevens | Verbetert contextuele nauwkeurigheid en Taakspecifieke reacties |

| Kosten en benodigde middelen | Kosteneffectiever vooraf richt zich op real-time gegevenstoegang | Vereist meer middelen voor initiële training, maar kosteneffectief op de lange termijn |

| Onderhoud en schaalbaarheid | Zeer schaalbaar en flexibel, maar afhankelijk van de frequentie van updates van externe bronnen | Vereist frequente updates en onderhoud, maar biedt stabiele prestaties op lange termijn |

| Gebruiksgevallen | Chatbots, dynamisch ophalen van documenten, real-time analyse | Domeinspecifieke QA-systemen, sentimentanalyse en aanpassing van merkstemmen |

| Wanneer kiezen | Snel veranderende gegevens, real-time updates en prioriteren van resourcekosten | Nicheklantensegmenten, domeinspecifieke logica, merkspecifieke aanpassing |

| Ideaal voor | Industrieën hebben realtime, nauwkeurige informatie nodig (financiën, juridisch, klantenservice) | Sectoren die specifieke taal, compliance of context vereisen (gezondheidszorg, juridisch, HR) |

Wilt u meer duidelijkheid om uw twijfels weg te nemen? Hier vindt u een vergelijking van de sleutelaspecten die van invloed zijn op uw behoeften.

Prestaties en nauwkeurigheid

Als het op prestaties aankomt, speelt RAG een sleutelrol door nieuwe gegevens van externe bronnen op te halen. De nauwkeurigheid en responstijden zijn afhankelijk van de kwaliteit van deze gegevens. Deze afhankelijkheid van externe databases stelt RAG in staat om actuele informatie effectief te leveren.

Bij fine-tuning wordt de manier waarop het model verwerkt en reageert verbeterd door gespecialiseerde bijscholing. Dit proces levert meer contextueel accurate reacties op, vooral voor nichetoepassingen. Fijnafgestelde LLM's zijn ideaal om consistentie te behouden in industrieën met strenge eisen, zoals de gezondheidszorg of de financiële sector.

Bottom line: RAG is geweldig voor real-time gegevens en fine-tuning voor contextueel nauwkeurige reacties.

Een gebruiker van Reddit zegt,

Als u een klein model en een goede database gebruikt in de RAG-pijplijn, kunt u datasets van hoge kwaliteit genereren, beter dan met uitvoer van een AI van hoge kwaliteit.

Als u een klein model en een goede database gebruikt in de RAG-pijplijn, kunt u datasets van hoge kwaliteit genereren, beter dan met uitvoer van een AI van hoge kwaliteit.

Pro Tip: Om uw LLM naar een specifieke uitvoer te leiden, moet u zich richten op effectieve, snelle engineering.

Vereisten voor kosten en middelen

RAG is meestal kosteneffectiever omdat het alleen een laag toevoegt voor het ophalen van externe gegevens. Omdat niet het hele model opnieuw getraind hoeft te worden, komt het naar voren als een veel budgetvriendelijkere optie, vooral in dynamische omgevingen. De operationele kosten voor real-time gegevenstoegang en opslagruimte kunnen echter oplopen.

Fine-tuning vereist meer voorbereiding van de dataset en meer trainingsmiddelen, maar is een investering op lange termijn. Eenmaal fijn afgesteld, hoeven LLM's minder vaak te worden bijgewerkt, wat leidt tot voorspelbare prestaties en kostenbesparingen. Ontwikkelaars moeten de initiële investering afwegen tegen de lopende operationele kosten.

Bottom line: RAG is kosteneffectief, eenvoudig te implementeren en levert snel voordeel op. Fijnafstemming vergt vooraf veel middelen, maar verbetert de kwaliteit van LLM en bespaart operationele kosten op de lange termijn.

💡 Pro Tip: Uw RAG-systeem is net zo slim als de gegevens die het gebruikt. Houd uw databronnen schoon en verpak ze met nauwkeurige, actuele gegevens!

Onderhoud en schaalbaarheid

RAG biedt een uitstekende schaalbaarheid omdat de focus voornamelijk ligt op het uitbreiden van de externe bron. De flexibiliteit en het aanpassingsvermogen maken het perfect voor snel veranderende industrieën. Het onderhoud is echter afhankelijk van de frequentie van updates van externe databases.

Fine-tuning heeft vrij frequent onderhoud nodig, vooral wanneer domeinspecifieke informatie verandert. Hoewel het meer middelen vergt, biedt het een grotere consistentie in de tijd en zijn er geleidelijk minder aanpassingen nodig. Dat gezegd hebbende, schaalbaarheid voor fine-tuning is veel complexer en heeft te maken met uitgebreidere en meer diverse datasets.

Bottom line: RAG is het beste voor snel schalen en fine-tuning voor minimaal onderhoud en stabiele prestaties.

Een gebruiker van Reddit voegt toe,

Als de Taak klein is, is het vaak efficiënter om gewoon een groter model te krijgen in plaats van een kleiner model te fine-tunen.

Als de Taak klein is, is het vaak efficiënter om gewoon een groter model te krijgen in plaats van een kleiner model te fine-tunen.

👀 Wist je dat? Er zijn nu AI-oplossingen die kunnen ruiken. Met hoe complex geuren zijn, is dat veel regelmatige fine-tuning en complexe gegevens ophalen.

Welke aanpak is geschikt voor uw toepassing?

Ondanks dat je de nuances begrijpt, kan het nemen van een beslissing leeg aanvoelen zonder duidelijke referentie of context. Laten we een paar Business scenario's doorlopen om te laten zien hoe elk AI-model beter werkt.

Wanneer kiezen voor RAG

RAG helpt om uw LLM te voeden met de juiste feiten en informatie, waaronder technische normen, verkoopgegevens, feedback van klanten en meer.

Hoe gebruikt u dit? Overweeg deze scenario's om RAG toe te passen in uw activiteiten:

Use case #1: Real-time analyse

- Scenario: Een fintech bedrijf biedt AI-gebaseerde marktinzichten voor handelaren. Gebruikers vragen naar aandelentrends en het systeem moet de nieuwste marktrapporten, SEC-filings en nieuws ophalen

- Waarom RAG wint: Stockmarkten bewegen snel, dus het voortdurend bijscholen van AI-modellen is duur en inefficiënt. RAG houdt alles scherp door alleen de meest recente financiële gegevens te gebruiken, kosten te besparen en de nauwkeurigheid te verhogen

- Vuistregel: RAG moet uw go-to strategie zijn voor AI die snel veranderende gegevens verwerkt. Populaire toepassingen zijn de analyse van gegevens van sociale media, energieoptimalisatie, detectie van bedreigingen door cyberbeveiliging en het bijhouden van bestellingen

Use Case #2: Gegevenscontroles en naleving van regelgeving

- Scenario: Een juridische AI-assistent helpt advocaten bij het opstellen van contracten en het controleren van de naleving van veranderende wetten door de nieuwste statuten, precedenten en uitspraken op te halen

- Waarom RAG wint: Het verifiëren van juridische en commerciële aspecten vereist geen diepgaande gedragsupdates. RAG doet het werk vrij goed door juridische teksten in realtime uit een centrale dataset te halen

- Vuistregel: RAG blinkt uit in resource- en statistiekgedreven inzichten. Goede manieren om dit te maximaliseren zijn het gebruik van medische AI-assistenten voor behandelaanbevelingen en chatbots voor klanten voor probleemoplossing en beleidsupdates

Vraagt u zich nog steeds af of u RAG nodig hebt in uw LLM? Hier volgt een snelle checklist:

- Hebt u nieuwe gegevens van hoge kwaliteit nodig zonder de LLM zelf te veranderen?

- Verandert uw informatie vaak?

- Moet uw LLM werken met dynamische informatie in plaats van statische trainingsgegevens?

- Wilt u grote kosten en tijdrovende modeltraining vermijden?

Wanneer fijnafstemming effectiever is

Zoals we al eerder vermeldden, is fine-tuning een AI-opleiding. Uw LLM kan zelfs het jargon van de industrie leren. Hier vind je een voorbeeld van de industrie waarin je kunt zien wanneer dit het beste werkt:

Use case #1: Merkstem en tonaliteit toevoegen

- Scenario: Een luxemerk creëert een AI-conciërge voor interactie met klanten op een verfijnde, exclusieve toon. Het moet merkspecifieke toonaarden, formuleringen en emotionele nuances belichamen

- Waarom fine-tuning het wint: Fine-tuning helpt het AI-model de unieke stem en toon van het merk vast te leggen en te reproduceren. Het levert een consistente ervaring bij elke interactie

- Vuistregel: Fijnafstemming is effectiever als uw LLM's zich moeten aanpassen aan een specifieke expertise. Dit is ideaal voor genre-georiënteerde meeslepende games, thematische en empathische verhalen, of zelfs marketingteksten voor merken

🧠 Leuk weetje: LLM's die zijn getraind in dergelijke zachte vaardigheden blinken uit in het analyseren van het sentiment en de tevredenheid van werknemers. Maar slechts 3% van de bedrijven maakt momenteel gebruik van generatieve AI in HR.

Use case #2: Content moderatie en contextgebaseerde inzichten

- Scenario: Een socialemediaplatform gebruikt een AI-model om schadelijke content te detecteren. Het richt zich op het herkennen van platformspecifieke taal, opkomende slang en contextgevoelige overtredingen

- Waarom fijnafstemming wint: Zachte vaardigheden zoals zinsbouw vallen vaak buiten het bereik van RAG-systemen. Fine-tuning verbetert het begrip van een LLM van platformspecifieke nuances en vakjargon, vooral met betrekking tot content moderatie

- Vuistregel: Kiezen voor fijnafstemming is verstandig als u te maken hebt met culturele of regionale verschillen. Dit geldt ook voor het aanpassen aan branchespecifieke termen zoals medisch, juridisch of technisch jargon

Staat u op het punt om uw LLM te fine-tunen? Stel uzelf de volgende sleutelvragen:

- Moet uw LLM voldoen aan een nicheklantensegment of merkthema?

- Wilt u bedrijfseigen of domeinspecifieke gegevens toevoegen aan de logica van de LLM?

- Hebt u snellere reacties nodig zonder aan nauwkeurigheid in te boeten?

- Leveren uw LLM's offline oplossingen?

- Kunt u speciale bronnen en rekenkracht toewijzen aan hertraining?

Het verbeteren van de gebruikerservaring is geweldig. Veel bedrijven hebben AI echter ook nodig als productiviteitsboost om de hoge investeringskosten te rechtvaardigen. Daarom kiezen veel bedrijven vaak voor een vooraf getraind AI-model.

👀 Did You Know? Gen AI heeft de potentie om werk te automatiseren waarmee tot 70 procent van de tijd van werknemers kan worden bespaard. Het effectief vragen van inzichten aan AI speelt hierbij een enorme rol!

Hoe ClickUp gebruik maakt van geavanceerde AI-technieken

De keuze tussen RAG en fine-tuning is een groot debat.

Zelfs het doornemen van een paar threads op Reddit is al genoeg om je te verwarren. Maar wie zegt dat je er maar één hoeft te kiezen?

Stel je voor dat je aanpasbare AI-modellen, automatisering en Taakbeheer op één plek hebt. Dat is ClickUp, de alles-in-één app voor werk. Het brengt projectmanagement, documentatie en teamcommunicatie onder één dak en wordt aangedreven door next-gen AI.

Kortom, het blinkt overal in uit, vooral met zijn uitgebreide AI-oplossing: ClickUp Brain.

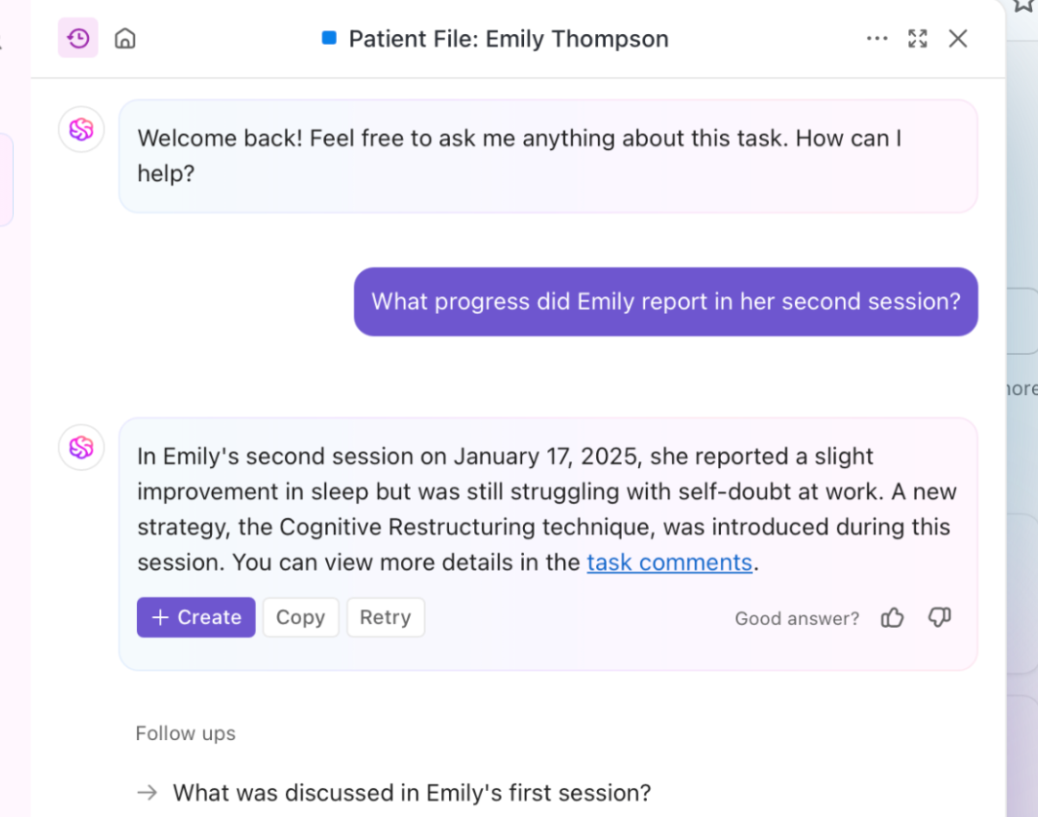

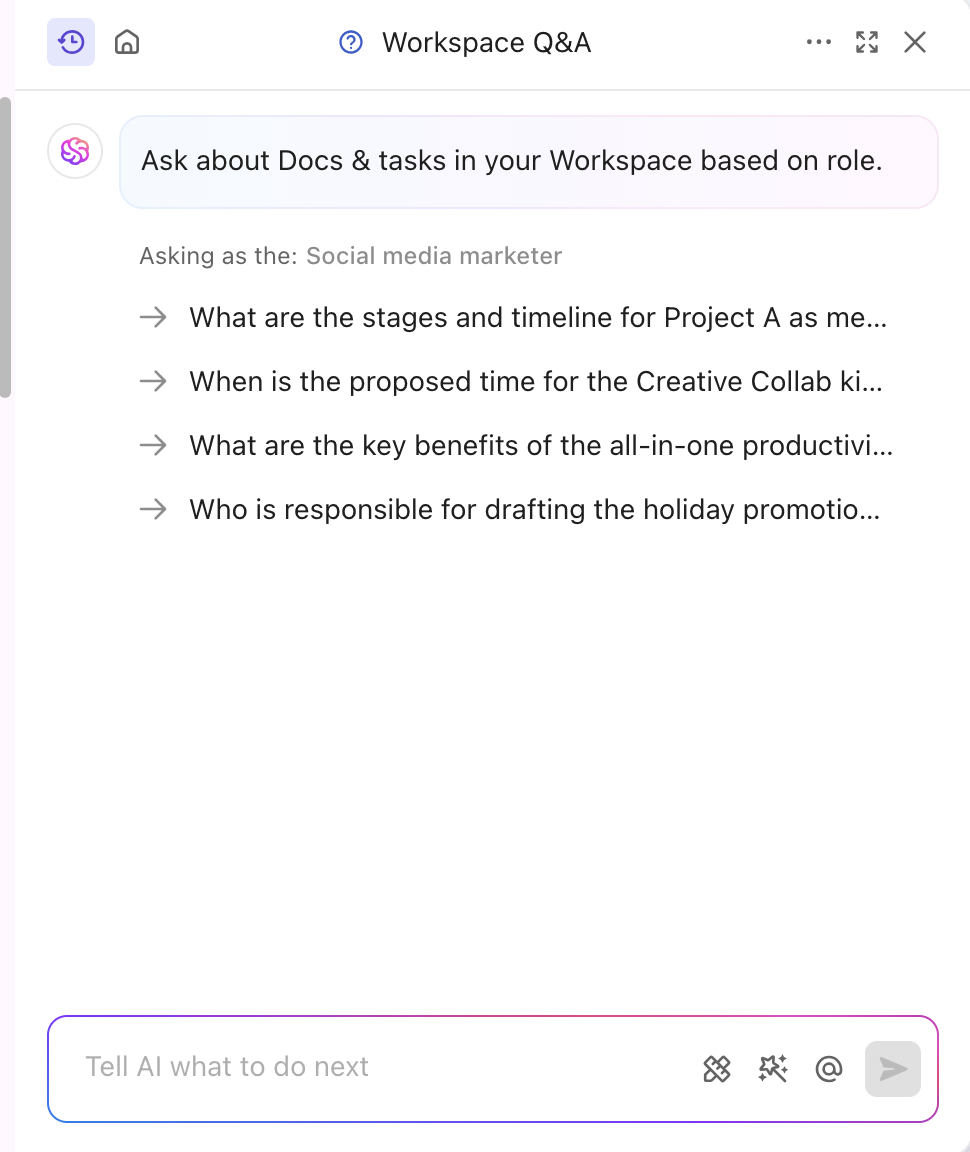

Snel contextbewuste inzichten nodig? Brain haalt realtime informatie uit uw documenten, taken en bronnen. Dat is versterkte RAG in actie. Bovendien kan de basis LLM, Brain, rapportages en routinematige projectupdates genereren.

De AI-tool is ook afgestemd op uw branche en segment en levert professionele en creatieve inzichten. Het personaliseert zelfs content in realtime zonder handmatige training. Brain combineert finetuning en RAG om projectupdates, taaktoewijzingen en notificaties over de werkstroom te automatiseren. Wilt u antwoorden die op uw rol zijn afgestemd? ClickUp Brain kan dat ook!

ClickUp is niet alleen gespecialiseerd in content, maar voorziet zijn platform ook van een krachtige, op kennis gebaseerde ClickUp AI functie.

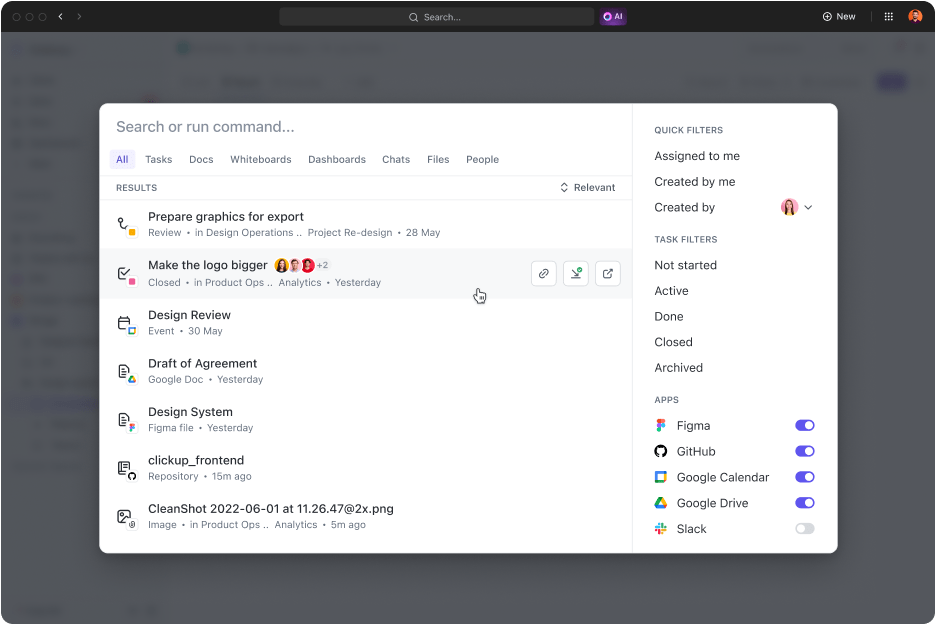

ClickUp Connected Search is een AI-tool waarmee u snel elke bron uit uw geïntegreerde ruimte kunt ophalen. Of u nu documenten nodig hebt voor de stand-up van vandaag of antwoorden op een willekeurige taak, met een eenvoudige query krijgt u bronlinks, citaten en gedetailleerde inzichten.

Het start ook apps op, doorzoekt de geschiedenis van je klembord en maakt knipsels. En het beste? Het is allemaal toegankelijk met één klik vanuit je commandocentrum, actiebalk of desktop.

Digitale marketingexperts, Hum JAM's voorzitter zegt het zelfs,

ClickUp is de meest verbazingwekkende "alles-in-één" tool voor teamautomatisering die het succes van teams bijhoudt, automatiseert en meet. Geloof me als ik zeg dat je team niet zonder deze tool kan.

ClickUp is de meest verbazingwekkende "alles-in-één" tool voor teamautomatisering die het succes van teams bijhoudt, automatiseert en meet. Geloof me als ik zeg dat je team niet zonder deze tool kan.

Gen AI en LLM nauwkeurigheid verbeteren met ClickUp AI

RAG-vermogensresponsies, aangescherpt door verse externe gegevens en fine-tuning, worden gebruikt voor specifieke Taken en gedragingen. Beide verbeteren de AI-prestaties, maar de juiste aanpak bepaalt uw tempo en efficiëntie.

In dynamische industrieën komt de beslissing vaak neer op welke methode het eerst moet worden toegepast. Een krachtige voorgetrainde oplossing is meestal de verstandigste keuze.

Als u de servicekwaliteit en productiviteit wilt verbeteren, is ClickUp een geweldige partner. De AI-mogelijkheden zorgen voor het genereren van content, het ophalen van gegevens en analytische antwoorden. Bovendien wordt het platform geleverd met meer dan 30 tools die alles dekken, van Taakbeheer tot het genereren van verbluffende visuals.

Meld u vandaag nog aan bij ClickUp!