プライバシーは基本的人権である。そしてそのプライバシーは、今日の人工知能のあらゆる側面にも及んでいる。シスコの報告書によると、64%の人がAIツール使用時に機密情報を誤って共有する可能性を懸念している。

オフラインAIツールの人気が高まっている理由の一つがここにある。モデルがローカルで動作すれば、すべてをクラウドにアップロードしたり、Wi-Fiが切れても作業が中断したりすることなく、文章作成、コードを書く、要約する、創作といった作業が可能になるのだ。

このリストでは、オフラインで動作する最高のAIツールを紹介します。その中には、これらのツールが生成する成果物を、統合された超安全なシステムに整理するのを支援するスーパーアプリも含まれています。

オフラインAIツールとは何か?

オフラインAIツールとは、 大規模言語モデル(LLM)をローカルデバイス上で実行するソフトウェアアプリケーションであり、モデルをダウンロード後はインターネット接続を一切必要としません。モデルのデータは直接コンピュータに保存されるため、すべての処理(推論)は自身のCPUまたはGPU上で実行されます。

このデバイス上での処理には、いくつかの重要な利点があります:

- 完全なデータプライバシー: お客様の機密情報はお客様のコンピューターから決して外に出ません

- 定期的な費用なし:ツールとモデルを入手すれば、サブスクリプション費用は一切かかりません

- どこでも使える:飛行機の中、山奥の小屋、インターネットが繋がらない時でも利用可能です

- 完全な制御: 使用するモデルと設定方法を選択できます

オフラインAIツールのベストセレクション

現在利用可能な最高のオフラインAIツールの簡単な要約です。

| ツール名 | 主な機能 | 最適 | 価格設定* |

| ClickUp | タスクとリマインダーのオフラインモード、音声入力機能を含むClickUp Brain MAX、連携アプリ全体でのエンタープライズ検索、ドキュメントとナレッジ管理、自動化、さらに統合機能とAPI | オフラインでのキャプチャに加え、オンラインでの実行、ガバナンス、AIコンテキストを単一のワークスペースで必要とするチーム | Free Forever;企業向けカスタマイズ対応 |

| GPT4All | オープンモデルとのローカルチャット、プライベート文書Q&A用LocalDocs、アプリ内モデル探索・ダウンロード、OpenAI互換のローカルAPIサーバー | プライバシーを重視するユーザー向けに、ローカルドキュメントを備えたシンプルなオフラインデスクトップチャットボットを提供します。 | Freeプランあり;有料プランはユーザーあたり月額40ドルから |

| LMスタジオ | モデルの発見とダウンロード、チャットUIとローカルRAG、OpenAI互換サーバーまたはREST API、プリセットとパフォーマンスチューニング | 洗練されたオフラインモデルワークベンチを求める開発者とユーザー | Free |

| オラマ | 単一コマンドモデル、ストリーミング対応のローカルREST API、再利用可能な設定用モデルファイル、RAGパイプライン用埋め込み | 強力なAPIレイヤーを備えた、CLIファーストのローカルランタイムを求める開発者 | Freeプランあり;有料プランは月額20ドルから |

| 1月 ai | ChatGPTスタイルのオフラインUI、アシスタント、MCPサポート、追加機能のための拡張機能、およびオプションのOpenAI互換プロバイダー | カスタム可能なシンプルなオフラインアシスタントを求める非技術ユーザー | 無料でオープンソース |

| ラマファイル | 単一実行可能モデルパッケージング、OSを跨いだポータブル配布、Web UIとAPIを備えたローカルサーバーモード、最小限の依存関係ランタイム | どこでも実行できるゼロインストール型のポータブルAIファイルを求めるユーザー | 無料でオープンソース |

| プライベートGPT | 自己ホスト型ドキュメント取り込み・インデックス化、オフラインRAG Q&A、文書単位の文脈フィルタリング、モジュール型LLM、ベクターストアスタック | 内部ファイルに関するオフラインQ&Aを必要とするTeams向け、制御可能なRAGパイプラインを備えたソリューション | 無料でオープンソース |

| ささやき.cpp | ローカルテキスト認識、低リソース消費のための量子化モデル、音声活動検出(VAD)サポート、より多くのフォーマットに対応するオプションのFFmpeg処理 | アプリに埋め込める完全オフラインの文字起こしが必要なユーザー | 無料でオープンソース |

| テキスト生成 Web UI | ローカルモデル向けブラウザベースのUI、Jinja2プロンプトテンプレート、生成制御、チャット分岐、メッセージ編集 | ローカルWebインターフェースで最大限のカスタムを求めるユーザー | 無料でオープンソース |

| llama.cpp | 高性能推論エンジン、広範な量子化サポート、OpenAIスタイルのエンドポイントを備えたローカルサーバー、埋め込み、再ランク付けサポート | カスタムオフラインAIアプリやバックエンドを構築する開発者 | 無料でオープンソース |

ClickUpにおけるソフトウェアのレビュー方法

編集チームでは透明性が高く、研究に基づいたベンダー中立のプロセスを採用しているため、当社の推奨事項が実際の製品価値に基づいていることを信頼いただけます。

以下は、ClickUpにおけるソフトウェアのレビュー方法の詳細な流れです。

オフラインで動作する最高のAIツールを選ぶ際のポイント

オフラインAIツールの評価は技術的で混乱を招きやすく、自分のコンピューターで動作しないツールを選んでしまう可能性があります。最も重要なのは、何を達成したいのかを考えることです。AI搭載アプリを開発する開発者と、単に文章作成支援用のプライベートなオフラインAIチャットボットを望む人では、必要とする機能が大きく異なります。

評価すべき主な基準は以下の通りです:

- セットアップの容易さ: 技術的な知識やコマンドライン操作が必要ですか、それともワンクリックで簡単にインストールできますか?

- モデル選択: 幅広いモデルから簡単に選択できますか、それともごく一部のモデルに限定されていますか?

- プライバシー保証: このツールはすべてのデータをローカルで処理しますか、それとも隠れたクラウドコンポーネントが存在しますか?

- ハードウェア要件: 現在のマシンで良好に動作しますか、それともアップグレードが必要ですか?

- 連携機能: 他のツールと接続できますか、それとも完全に独立したアプリケーションですか?

- ユースケース適合性: 一般的なチャット、文書に関する質問、音声文字起こし、コード生成のいずれを目的として設計されていますか?

オフラインで動作するAIツールトップ10

最高のAIオフラインツールの全体像はこちら👇

1. ClickUp(タスク、ドキュメント、AIのコンテキストをオフラインとオンラインの両方で一箇所にまとめて管理するのに最適)

世界初の統合型AIワークスペース「ClickUp」は、単なる回答生成に留まらない「オフラインAI」を基盤としています。なぜなら、その出力を意思決定やタスク、次のステップへと昇華させ、ファイルやチャットの中に埋もれさせない場が依然として必要だからです。

多くのオフラインセットアップでは長時間のインストールやツールの統合が必要ですが、ClickUpではAIが同一ワークスペース環境上で動作する完全な実行レイヤーを単一プラットフォームで提供します。

まず、ClickUpオフラインモードがあります。これはオフライン状態でも自動的に作動し、仕事を継続させます。つまり、タスク、リマインダー、メモはすべてオフライン中でもアクセス可能で、必要に応じて追加もできます。再接続すると、新しいタスクやリマインダーは自動的にワークスペースに同期されます(文脈が失われる心配はもうありません👋)。

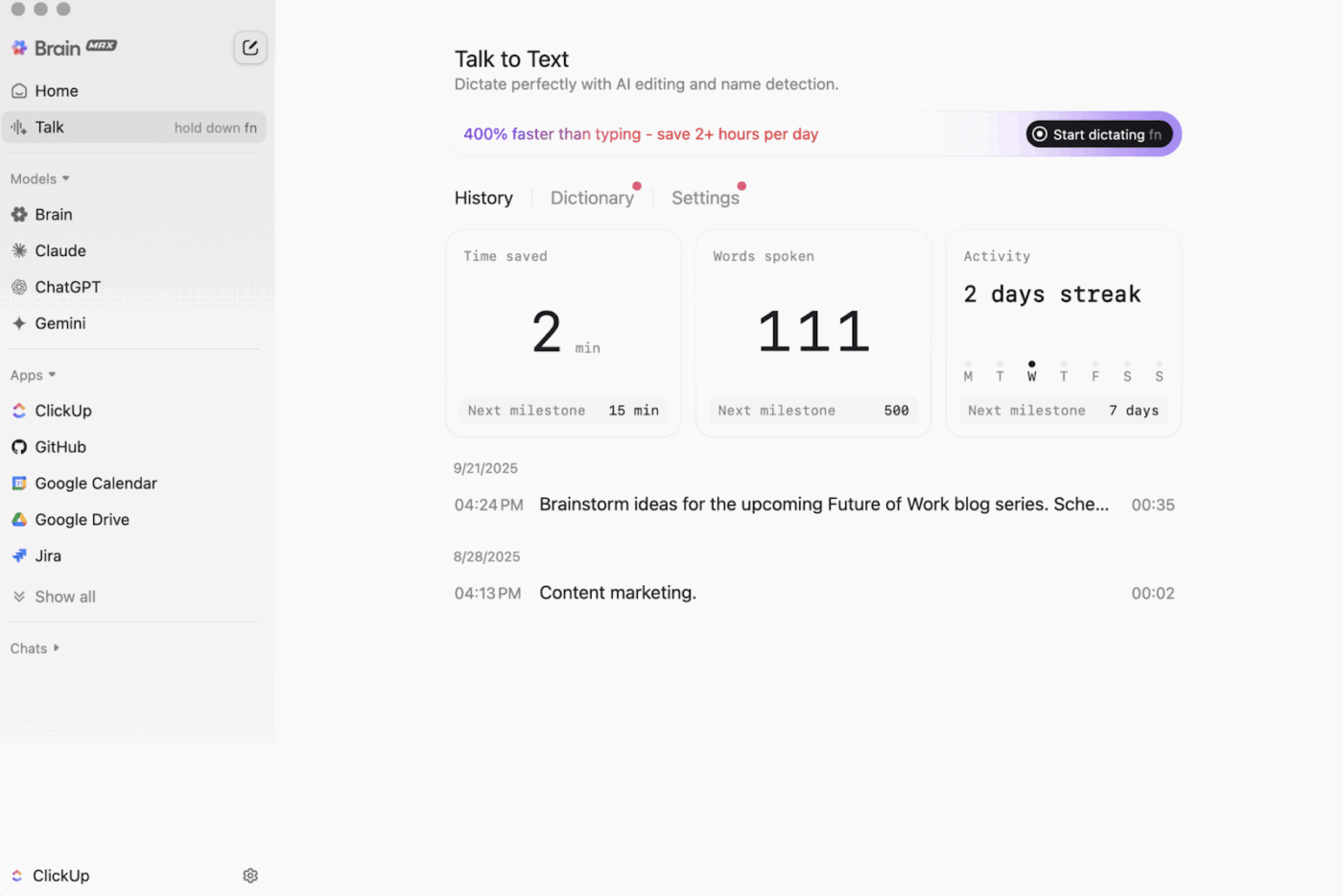

次に、プライバシーを最優先にしたデスクトップAIコンパニオン「ClickUp Brain MAX」があります。これは、ワークスペース全体、連携アプリ、さらにはウェブ上の情報まで保存・検索できます。

Talk-to-Text機能を搭載したBrain MAXは、ハンズフリーで音声をテキストに変換します。電子メールの下書き作成、ドキュメント作成、移動中の簡単な更新記録など、あらゆる場面で活用できます。

Brain MAXはユニバーサルAIも提供します。これはコーディング、ライティング、複雑な推論など、最新のAIモデルとの対話のために構築されています。つまり、ClickUp Brainに加え、OpenAI、Claude、Geminiなどのオプションを含むトップAIモデルに、ツールを切り替える手間なく一箇所で質問できるのです。

さらに、ClickUp Securityはオフラインツールがしばしば省略する安全策を追加します。暗号化、きめ細かい許可設定、SSO(シングルサインオン)、プロビジョニング、監査ログといった管理機能など、すべて企業レベルのセキュリティを必要とするチーム向けに設計されています。

ClickUp AIナレッジマネジメントは「オフラインからオンラインへの引き継ぎ」を大幅に支援します。チームがドキュメントやwikiに様々なリソースを保存するhubを提供し、ClickUp Brainを活用してワークスペース全体から即座に回答を抽出。これにより作業再開時に適切なコンテキストが即座に利用可能になります。

🎬 エージェントの実践:同期された仕事を次のステップに変えるには、スーパーエージェントを活用しましょう!

ClickUpスーパーエージェントは、AIを搭載したチームメイトです。作成・カスタマイズして、ClickUpワークスペース内で多段階ワークフローを実行できます。特定のトリガー、指示、ツールアクセスを設定し、設定した範囲内で動作するよう保証できます。

例えば、オフラインタスクが同期された後、スーパーエージェントは新規アイテムをスキャンし、変更点を要約し、アクションステップを抽出し、更新案を作成し、適切な所有者にレビューのために回すことができます。

スーパーエージェントは管理可能なため、許可でアクセスを制御し、そのやることを監査できます。🔐

ClickUpの主な機能

- ツール全体から何でも検索:ClickUpエンタープライズ検索で、ワークスペース全体と接続アプリを1か所からソート・検索できます

- 真のナレッジベースを構築:ClickUp Docsでwikiやドキュメントを作成。ネストされたページ、テンプレート、AIアシストなどを活用

- スタックを接続し続けよう:ClickUp 統合機能で、ClickUp を離れることなく Slack や GitHub などのツールと仕事を同期できます

- カスタムワークフローの構築:個人トークンまたはOAuth 2.0を使用したClickUp APIで、カスタマイズされた自動化と統合を実現します

- スタックの自動化:ClickUp自動化で、タスクの変更に基づいて所有者の割り当て、ステータスの更新、引き継ぎの開始などのアクションをトリガーします。

ClickUpの制限事項

- 機能の範囲が広いため、一部のユーザーは習得に時間がかかる場合があります

ClickUpの料金プラン

ClickUpの評価とレビュー

- G2: 4.7/5 (10,000件以上のレビュー)

- Capterra: 4.6/5 (4,000件以上のレビュー)

実際のユーザーはClickUpについて何と言っているのでしょうか?

G2のレビュアーはこう言っている:

アジャイルボード、連携機能、カスタマイズ性。また、オフライン状態でもタスク作業を続けられる点が気に入っています。さらに、任意のリスト宛にメールを送信するだけでタスクが自動生成される機能も便利です。テキストエディターは素晴らしく、マークダウンモードとショートカットの両方で動作し、コンテンツをインラインでプレビューできます。

アジャイルボード、連携機能、カスタマイズ性。また、オフライン状態でもタスク作業を続けられる点が気に入っています。さらに、任意のリスト宛てにメールを送信するだけでタスクが自動生成されます。テキストエディターは素晴らしく、マークダウンモードとショートカットの両方で動作し、コンテンツをインラインでプレビュー可能です。

2. GPT4All(ローカルLLMを用いたプライベートなオフラインAIチャットに最適)

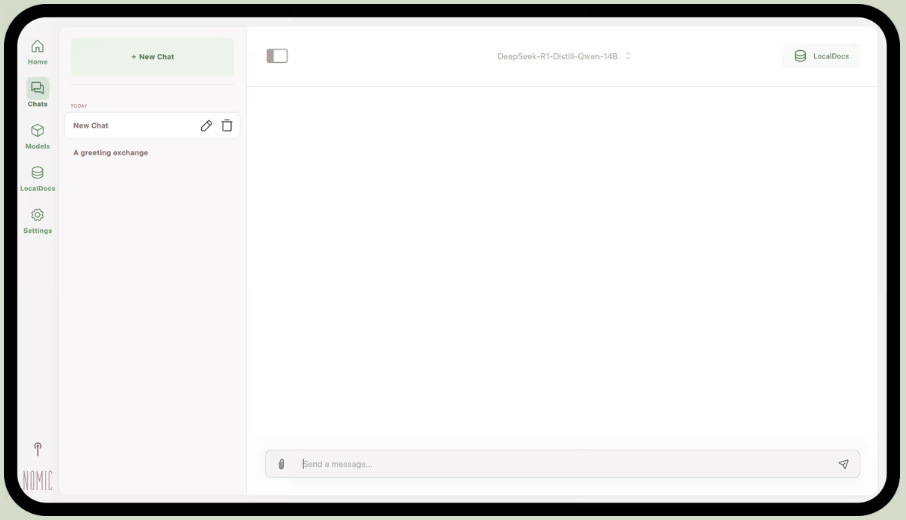

Nomic.aiの一部であるGPT4Allは、オープンソースの大規模言語モデルを直接コンピューター上で実行できるデスクトップアプリです。これにより、インターネット接続やクラウドAPI呼び出しに依存せずにAIアシスタントとチャットできます。プロンプト、応答、ファイルがデバイス内に留まる「ローカルファースト」なセットアップを求めるユーザー向けに設計されています。

その最大の機能はLocalDocsで、 検索拡張生成という手法を用いて、自身の文書とプライベートにチャットできるようにします。PDFやテキストファイルのフォルダをアプリに指定すると、ローカルナレッジベースが作成され、その内容について質問できます。

GPT4Allには、LlamaやMistralなどの人気モデルを厳選したライブラリも含まれており、アプリから直接ダウンロードできます。

GPT4Allの主な機能

- 他のアプリや自動化機能内でGPT4Allモデルを使用するために、ローカルAPIサーバー(OpenAI互換)を起動する

- アプリ内でGGUFモデルを検索、比較、ダウンロード。いいね数、ダウンロード数、アップロード日などの並べ替えオプション付き

- コンテキスト長、最大出力長、top-p、top-k、リピートペナルティ、CPUスレッド数、さらにはGPUレイヤーオフロード(Apple SiliconではMetalサポートも)を調整可能

GPT4Allの制限事項

- パフォーマンスは、お使いのコンピューターのハードウェアとの依存関係に大きく依存します

- 大量の文書コレクションのインデックス付けは時間がかかることがある

GPT4Allの価格設定

- 無料デスクトップアプリ

- Business: ユーザーあたり月額40ドル(Nomic AI)

- 企業: カスタム価格設定 (Nomic AI)

GPT4Allの評価とレビュー

- G2: レビューが不足しています

- Capterra: レビューが不足しています

実際のユーザーはGPT4Allについて何と言っているのでしょうか?

あるRedditユーザーは言う:

RAGで試した中でこれが最高です。他のすべてを凌駕し、LM Studioよりもシンプルです。フォルダにマッピングする方式が気に入っています。変更を自動追跡・処理してくれるのも便利です。他のツール同様、まだ成熟度は低いですが、当面はこれをデフォルトにします。

RAGで試した中で最高のものだ。すべてを凌駕し、LM Studioさえもシンプルさでは上回る。フォルダにマップする方式が気に入っている。変更を追跡・処理してくれるのも便利だ。他のツール同様、まだ成熟度は低いものの、当面はこれをデフォルトとして使うつもりだ。

📮 ClickUpインサイト:アンケート回答者の88%が個人タスクにAIを活用している一方、50%以上が仕事での使用を避けています。主な障壁は?シームレスな統合の欠如、知識不足、セキュリティ懸念の3点です。しかし、もしAIがワークスペースに組み込まれ、既に安全性が確保されていたら?それがClickUp Brainです。

ClickUpの組み込み AIアシスタントがこれを実現します。平易な言語でのプロンプトを理解し、AI導入の3つの懸念事項をすべて解決しながら、ワークスペース全体でチャット、タスク、ドキュメント、ナレッジを接続します。ワンクリックで答えと洞察を見つけましょう!

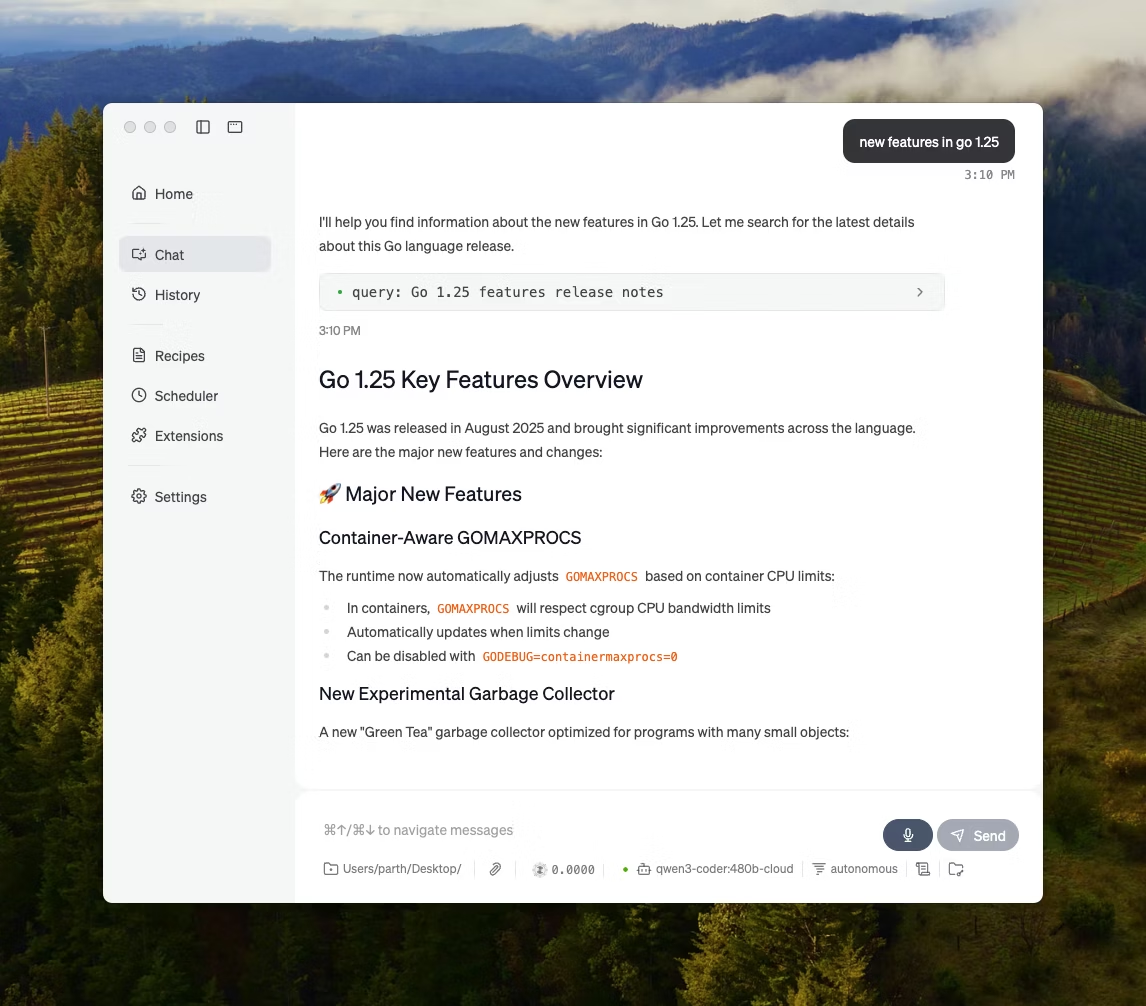

3. LM Studio(洗練されたオフラインモデル作業環境とパフォーマンスチューニングに最適)

LMスタジオ経由

LM Studioは、ターミナルに依存することなく、UI上でオープンソースモデルの検索・テスト・実行を可能にするローカルAIデスクトップアプリです。モデル選択、ローカル実行、プロンプトや設定の反復といった実験を主眼としており、多くのCLI優先セットアップよりも緊密なフィードバックループを実現します。

また、完全にオフライン(ローカルRAG)でのドキュメント付きチャットもサポートしています。会話に添付ファイルを添付し、応答時にそれらを参照できます。これにより、アップロードが不可能な環境でのオフライン調査、学習メモ、内部ドキュメントワークフローに最適です。

LM Studioでは、AIの動作を詳細に制御することも可能です。温度、コンテキスト長、GPU使用率を調整するオプションが用意されています。

LM Studioの主な機能

- アプリが期待する内容に応じて、OpenAI互換モードまたはLM Studio独自のREST APIを使用してください

- LM Studioは、モデル上にローカルワークフローを構築するためのJavaScriptとPythonの両方のSDKオプションを提供します

- システムプロンプトとパラメーターをプリセットとして保存し、複数のチャットで再利用可能(プリセットはファイル/URLからインポートしたり、LM Studio hub経由で公開して共有することもできます)

LM Studioの制限事項

- LM StudioはDeepSeek R1 32Bの実行中にコンピュータをフリーズさせることがあります

- 一部のユーザーは、監査されていないクローズドソースコードを理由に、このアプリをデータセキュリティとプライバシー上の懸念事項として報告している。

LMスタジオの料金体系

- 家庭および仕事での使用は無料です

LMスタジオの評価とレビュー

- G2: レビューが不足しています

- Capterra: レビューが不足しています

実際のユーザーはLM Studioについて何と言っていますか?

あるRedditユーザーは言う:

素晴らしいです。ただ機能するだけでなく、超簡単に起動して始められます。競合他社の中で最も見栄えの良いUIを備えています。

素晴らしいです。ただ機能するだけでなく、超簡単に起動して始められます。競合他社の中で最も見栄えの良いUIを備えています。

⭐ ボーナス:ニューラル検索:AIが情報検索に革命をもたらす方法とは?

4. Ollama(シンプルなCLIとローカルサーバーでローカルLLMを実行するのに最適)

Ollamaはローカルモデルランナーであり、スタンドアロンのチャットアプリというよりLLMランタイムに近い振る舞いをする。ターミナルファースト設計で、オープンモデルを簡単なコマンド(例:`ollama run llama3`)で取得・実行し、ローカルサービスとして公開する。これにより他のインターフェースが上乗せ可能となる。

Ollamaの強みはREST APIにあります。Ollamaがバックグラウンドで動作している状態であれば、あらゆるアプリケーションがシンプルなHTTPリクエストを通じてOllamaと通信できます。これにより、自社ソフトウェアにAI機能を組み込むことが可能になります。

Ollamaはまた、ワンコマンドでダウンロード可能な人気モデルのライブラリを提供しており、AI版Dockerfileとも言えるカスタムモデル構成を作成できます。

オラマの主な機能

- Modelfileを使用して、再利用可能でバージョン管理可能なモデルレシピ(ベースモデルの選択、プロンプトテンプレート、システムメッセージ、パラメーター、アダプター)を作成する

- チャットや生成などのエンドポイントを通じてモデルを実行し、オプションのストリーミング機能によりアプリやスクリプト内でリアルタイムのトークン出力を実現

- Ollamaの埋め込み機能と推奨埋め込みモデルを使用して、意味検索および検索パイプライン向けの埋め込みを生成する

オラマのリミット

- 組み込みのグラフィカルインターフェースがないため、技術的知識のないユーザーは別途フロントエンドツールが必要となる

- OllamaのmacOSデスクトップアプリは、モデルが既にダウンロードされている場合でも、オフライン時に応答しなくなる可能性があります。一方、CLIは引き続き動作します。

オラマの価格設定

- Free

- プロプラン: 月額20ドル

- 上限: 100ドル/月

オラマの評価とレビュー

- G2: レビューが不足しています

- Capterra: レビューが不足しています

実際のユーザーはOllamaについて何と言っているのでしょうか?

Producthuntのレビュアーはこう言っています:

導入と管理が簡単。OllamaはローカルLLMの実行を驚くほど容易にします。究極の体験を得るにはOpenWebUIと組み合わせてください。

導入と管理が簡単。OllamaはローカルLLMの実行を驚くほど容易にします。究極の体験を得るにはOpenWebUIと組み合わせてください。

🧠 豆知識:音声認識技術は当初「数字のみ」から始まりました。ベル研究所のAUDREY(1952年)は0~9の数字を認識し、あるメモによれば、発明者自身が話した時が最も正確に動作したそうです。

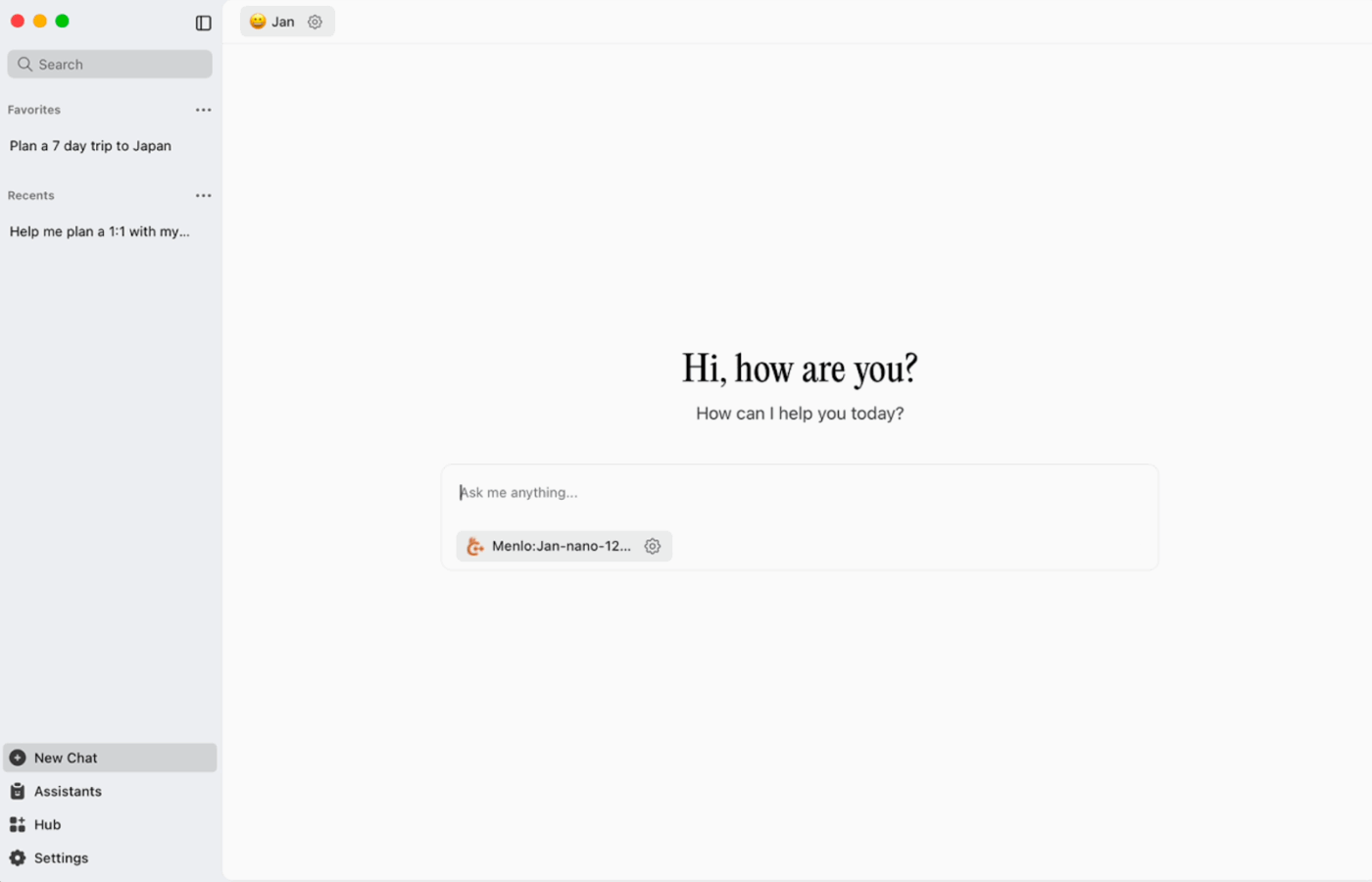

5. Jan. ai(オフライン環境でプライバシーを最優先するChatGPTスタイルのアシスタントに最適)

Jan. aiは、macOS、Windows、Linux向けにChatGPTのようなチャット体験を提供するオープンソースのデスクトップアシスタントです。デフォルトでローカルファースト方式を採用しており、必要な時にデバイス上で動作します。会話履歴や利用データはローカルに保存され、コンピュータ外に流出することはありません。

オープンソースモデルのローカル実行をサポートし、OpenAI互換APIなどのリモートプロバイダーへのオプション接続も可能です。これにより、オフライン利用の優先度が高く、時折クラウドアクセスが必要な場合にも柔軟に対応できます。

1月 AIのベスト機能

- 独自の指示と設定を持つアシスタントを作成し、毎回プロンプトを書き直す代わりに、アシスタントタブから切り替えて使用できます

- オープン標準を用いてJanをMCPツールおよびデータソースに接続し、ツール使用スタイルのワークフローを実現する

- 拡張機能をインストールして、ウェブ検索やコードインタプリタなどの新機能を追加できます。このモジュール式のアプローチにより、シンプルに始め、必要に応じて機能を拡張できます。

1月 AIのリミット

- Janは、まだ完全にダウンロードされていないモデルファイルの読み込みを許可する場合があり、ファイルが完了するまで混乱や不整合な動作を引き起こす可能性があります

- APIを有効にするとスレッド化されたチャットに干渉する可能性があり、「読み込み済みモデルの取得」や「モデルの切り替え」といった基本エンドポイントが正常に動作しない場合があります

1月 AI価格設定

- オープンソース

1月 AI評価とレビュー

- G2: レビューが不足しています

- Capterra: レビューが不足しています

実際のユーザーはJan. aiについて何と言っているのでしょうか?

あるRedditユーザーは言う:

Jan. aiは私がよく使うローカルLLMアプリです。すごくいいです。

Jan. aiは私がよく使うローカルLLMアプリです。すごくいいです。

6. Llamafile(LLMをポータブル実行可能ファイルにパッケージ化するのに最適)

LlamafileはMozilla主導のプロジェクトであり、完全なオープンソースLLMを単一の実行可能ファイルにバンドルします。ランタイムのインストールや依存関係の管理、別個のUIの接続といった手間を省き、1つのファイルをダウンロードしてアプリのように実行できます。

中核となる考え方は配布です。「llamafile」にはモデルの重みとコンパイル済みランタイムが含まれており、最小限のセットアップで複数のオペレーティングシステム上で動作するように構築されています。オフラインツールを、インストールトラブルシューティングを行わないチームメンバー、学生、顧客と共有する必要がある場合に特に便利です。

ラマファイルの主な機能

- Llamafileは、広範なバイナリ移植性をサポートするため、llama.cppとCosmopolitan Libcを組み合わせ、プラットフォーム固有のパッケージング仕事を削減します。

- サーバーモードはWeb GUIに加え、OpenAI API互換の補完エンドポイントを提供します。ローカルアプリ開発やテスト中のクラウド呼び出しの代替に有用です。

- パッケージ化されたラマファイルは、一般的なx86_64およびARM64マシン上で動作するよう設計されており、これにより混合環境での配布が容易になります

ラマファイルの制限事項

- モデル選択は、Llamafileとしてパッケージ化されたものに限定されます

- ファイルのサイズは非常に大きいです。これは、モデル全体が埋め込まれているためです

ラマファイルの価格設定

- 無料でオープンソース

ラマファイルの評価とレビュー

- G2: レビューが不足しています

- Capterra: レビューが不足しています

🧠 豆知識: 最初のウェブサイトは今でも閲覧可能です。CERNは文字通りinfo.cern.chでこれをホストしており、「最初のウェブサイトのホーム」と呼んでいます。

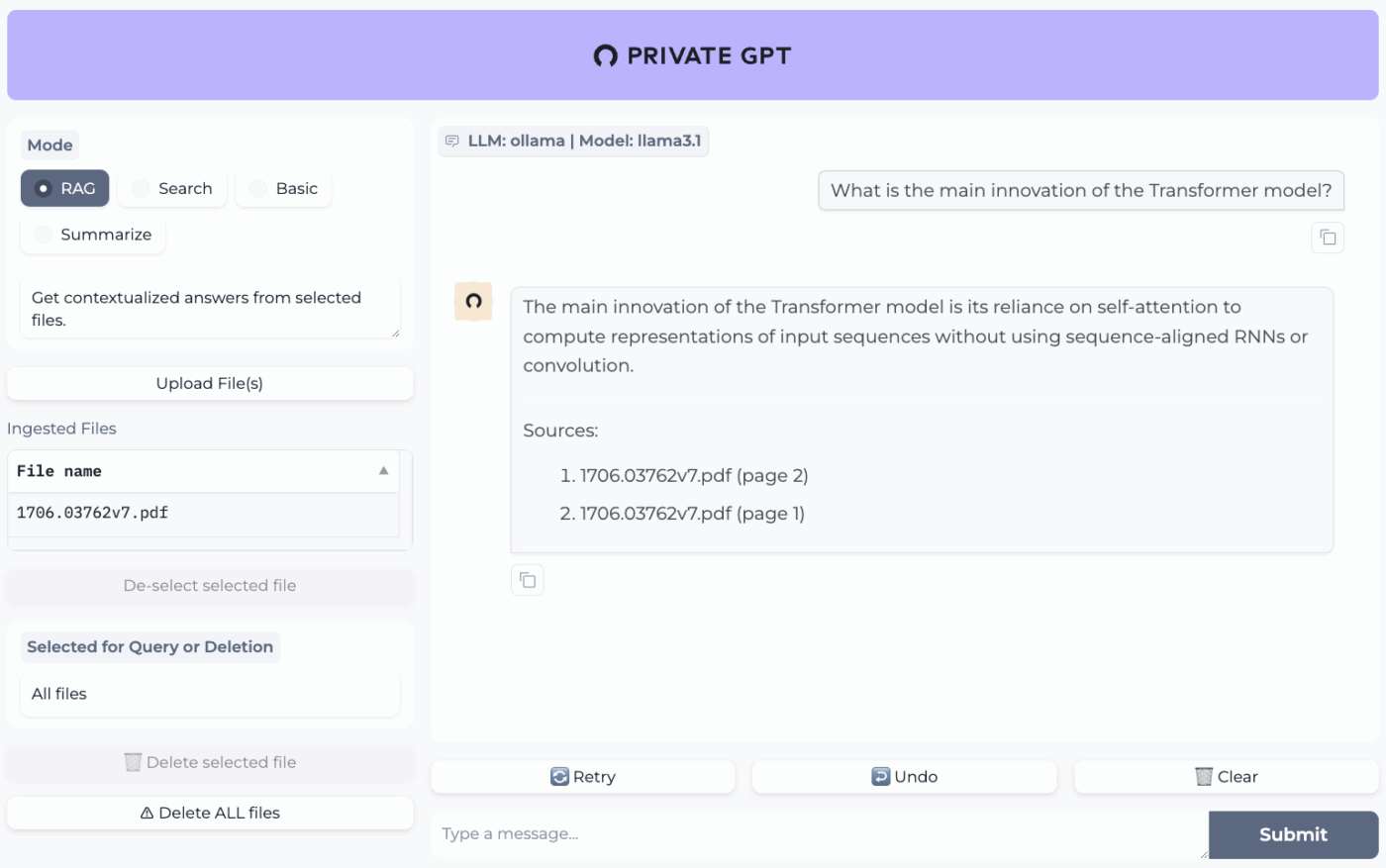

7. PrivateGPT(自己ホスト型RAGスタックによるファイル上のオフラインQ&Aに最適)

PrivateGPTは「文書とチャットする」ワークフロー向けに構築された、本番環境対応のセルフホスティング型プロジェクトです。ローカルファイルを取り込み、インデックス化し、クラウドチャットボットの記憶に依存せず、自身のコンテンツから関連する文脈を抽出して質問に回答します。本プロジェクトは完全なオフライン運用を前提に設計されており、データは実行環境内に留まるとされています。

汎用的なオフラインチャットアプリとの違いは、モジュール式のアーキテクチャにあります。つまり、ハードウェアやプライバシー制約に応じてLLM、埋め込みプロバイダー、ベクトルストアを自由に組み合わせ、ローカルAPIとUIの背後ですべてを実行できるのです。

PrivateGPTの主な機能

- PDF、DOCX、PPT/PPTX/PPTM、CSV、EPUB、Markdown、JSON、MBOX、IPYNB、画像(JPG/PNG/JPEG)、さらにはMP3/MP4まで、組み込みの取り込みパイプラインを使用して取り込むことができます。

- PGPT_PROFILES(例: local,cuda)を使用したレイヤープロフィールにより、複数の設定ファイルをマージし、基本設定を書き換えることなくデプロイメントを切り替えられます

- コンテキスト補完エンドポイントを呼び出す際に、context_filterを使用して取り込まれたドキュメントの特定のサブセットに対する応答をフィルタリングする

PrivateGPTのリミット

- 複数のコンポーネントを同時に実行するため、より高いハードウェア要件を必要とする

- 単一ファイルからの複数ドキュメント取り込み(例:1つのPDFファイルからページごとに1ドキュメントを生成)は、大規模なアップロードを管理する際にインデックス作成の量と複雑さを増加させる可能性があります

PrivateGPTの価格設定

- オープンソース

PrivateGPTの評価とレビュー

- G2: レビューが不足しています

- Capterra: レビューが不足しています

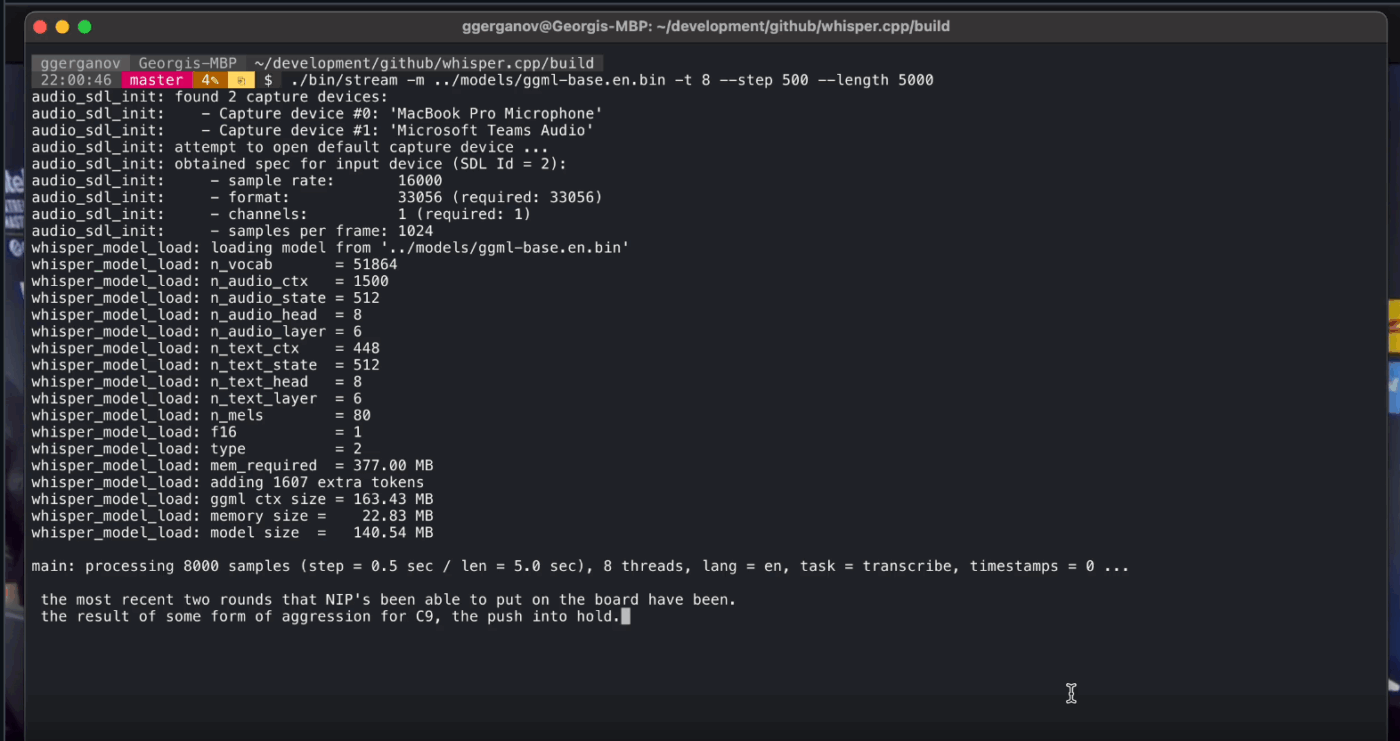

8. Whisper.cpp(アプリに組み込める完全オフラインテキスト認識に最適)

Whisper.cppは、OpenAIの自動音声認識モデル「Whisper」の高性能なC/C++実装であり、重いランタイム依存関係なしでローカル実行できるように構築されています。小型でポータブルなバイナリや、自社製品に組み込めるCスタイルライブラリを必要とするオフライン文字起こしパイプラインで広く利用されています。

また、環境を問わず柔軟に動作し、デスクトップ、モバイル、WebAssembly、Docker、さらにはラズベリーパイクラスのハードウェアまで公式サポート対象となっているため、複数の場所で実行する必要があるオフラインツールに適しています。

その名称の「cpp」は、パフォーマンス重視であることを示しています。この実装はPythonベースの代替手段よりも大幅に高速でメモリ使用量が少なく、高性能GPUを必要とせずに現代のコンピューターでリアルタイム文字起こしを実現します。

Whisper.cpp の主な機能

- 音声活動検出(VAD)をプロジェクトの一環として実行し、ストリーミング形式のワークフローにおいて音声セグメンテーションを行い、ノイズの多い音声や音声のない文字起こしを削減する

- Whisperモデルの量子化によりディスクとメモリ要件を削減。高速なローカル推論向けに設計された複数の量子化オプションを提供

- Linux上でオプションのFFmpegサポートを組み込んでビルドし、基本的なWAVのみのパスを超えてより多くのフォーマットを処理できるようにする

Whisper.cpp のリミット

- Whisper.cppのコマンドラインインターフェースはデフォルトで16ビットWAV入力を想定しているため、MP3、MP4、M4Aなどの一般的なフォーマットを扱う際には追加の変換ステップが必要となります。

- 話者のラベル付け(発話者識別)をネイティブで行わないため、複数話者による録音において発言の帰属を正確に行うことが困難である

Whisper.cppの価格設定

- オープンソース

ささやき。cppの評価とレビュー

- G2: レビューが不足しています

- Capterra: レビューが不足しています

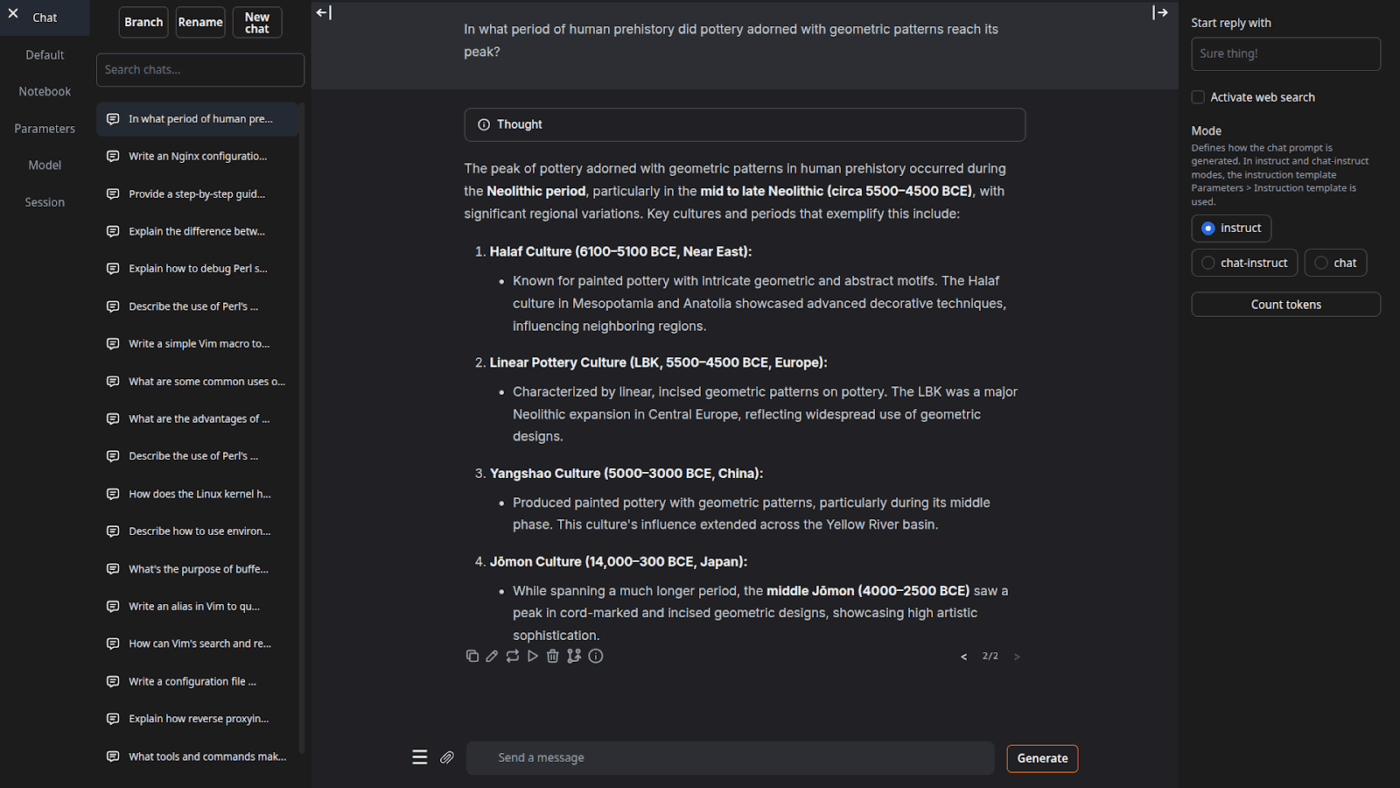

9. テキスト生成Web UI(ローカルLLM用のブラウザベースのコックピットを求めるユーザーに最適)

テキスト生成Web UI(通称「oobabooga」)は、制御と実験を重視したローカルモデル実行用のGradioベースのWebインターフェースです。完全なワークベンチに近い動作を実現しており、複数のモデルバックエンド、複数のインタラクションモード、生成挙動を調整する豊富なパラメータを備えています。

また、オフラインツールでは省略されがちな「ライター/開発者」向けワークフローにも注力しており、プロンプトフォーマットの自動化、ノートブック形式の生成、会話分岐といった機能を備えています。ウェブUIが必要なオフラインセットアップにおいても、このカテゴリーで最も柔軟に設定可能なフロントエンドの一つです。

テキスト生成Web UIの主な機能

- Jinja2テンプレートを用いた自動プロンプトフォーマットにより、異なるモデルファミリー間でのプロンプトフォーマットの誤りを削減

- 数十の設定を調整し、創造的な文章作成、コーディング、ロールプレイなど、特定のニーズに合わせてAIの出力を微調整できます。

- バージョンナビゲーションと会話分岐によるメッセージ編集。同じチャットの複数の方向性を維持しつつ、最初からやり直す必要がない

テキスト生成Web UIの制限事項

- ワンクリックインストーラーは約10GBのディスクスペースを必要とし、PyTorchをダウンロードするため、ストレージスペースが限られたマシンではセットアップが重く感じられる

- OpenAI互換の埋め込みエンドポイントは、768次元の埋め込みを持つsentence-transformers/all-mpnet-base-v2を使用します。これは、OpenAIの1536次元デフォルトを前提に構築されたパイプラインの仮定を破る可能性があります。

テキスト生成Web UIの価格設定

- オープンソース

テキスト生成Web UIの評価とレビュー

- G2: レビューが不足しています

- Capterra: レビューが不足しています

10. Llama.cpp (CPUとGPUを跨いだ高性能なローカルLLM推論に最適)

Llama.cppは、最小限の依存関係と幅広いハードウェアでの強力なパフォーマンスで、ローカル環境でLLMを実行するためのC/C++推論エンジンおよびツールチェーンです。これは「チャットアプリ」というより、CLI、ローカルHTTPサーバー、あるいは自社製品内の組み込みライブラリなど、ワークフローを構築するためのローカルランタイムと言えます。

Llama.cpp自体はユーザー向けアプリケーションではありませんが、GPT4AllやLM Studioを含む本リストの多くのツールを支えるエンジンです。GGUFフォーマットを導入し、大規模モデルのサイズを効率的に縮小することで、コンシューマー向けハードウェアでの実行における標準となっています。

また、PythonやRustなどの人気プログラミング言語向けのバインディングを提供し、サーバーモードではOpenAI互換のAPIを提供できます。

ラマ.cppの優れた機能

- lama-serverを使用して、組み込みのWeb UIと/v1/chat/completionsエンドポイントを備えたOpenAI API互換のローカルサーバーを起動する

- /embedding および /reranking を使用して、オフライン RAG パイプライン向けに同一サーバーから埋め込みモデル(および再ランク付けモデル)を実行する

- モデルを1.5ビットから8ビットまで量子化してメモリ使用量を削減し、ローカル推論を高速化します。その後、利用可能な場合はCUDA/MetalとVulkan/SYCLバックエンドで実行を加速します。

ラマ。cppの制限事項

- Llama.cppは洗練されたデスクトップアシスタントとして提供されていません。そのため、オフライン利用ではCLIコマンドやlama-serverのホスティングが必要になることが多く、多くのユーザーは日常的なチャットにサードパーティ製UIに依存しています。

- Llama.cppのOpenAI互換性は、すべてのOpenAIクライアント機能と必ずしも1対1ではありません。ユーザーからは、/v1/chat/completions内のresponse_formatのような構造化出力パラメーターに関する不一致が報告されています。

ラマ。cppの価格設定

- オープンソース

実際のユーザーはLlama.cppについて何と言っているのでしょうか?

ソースフォージのレビュアーは次のように述べています:

すごい!AIを民主化し、誰もが利用できるように。しかも、すごくうまく機能する!

すごい!AIを誰もが使えるように民主化する。しかもすごくうまく動く!

ClickUpでオフラインAI出力を実際の仕事に変える

適切なオフラインAIツールを選ぶことは、結局のところ、ツールと作業を一致させることなのです。

ここにいるということは、おそらく次の3つのことを最適化しているはずです:プライバシー、インターネット依存関係からの解放、そしてまた別のサブスクリプションに縛られることからの自由。

このリストのツールは、それぞれ異なる方法でその点において優れています。つまり、書き物やコーディングに適したツールもあれば、検索やメモ、創作活動に適したツールもあるということです。

しかしチームにとって、より大きな課題は単にAIをローカルで実行することだけではない。AIの出力を実際のワークフローに変換することだ。

ClickUpのAI機能をタスク、ドキュメント、ナレッジに組み込むことで、仕事が行われる同じ場所で次のステップを簡単に可視化できます(すべて企業レベルのセキュリティで保護されています)。

ClickUpを無料で試して、AIと実行力がついに融合した姿をご覧ください。✨

オフラインAIツールに関するよくある質問

はい、モデルファイルの初期ダウンロード後は、多くのAIツールがインターネット接続なしで端末上で完全に動作します。これにより、機密データの処理や通信環境の悪い場所での仕事に最適です。

ローカルLLMはすべてのデータを個人端末上で処理するため、情報は端末外に流出することはありません。一方、クラウドベースのAIはプロンプトを遠隔サーバーに送信して処理します。ローカルツールはセットアップ後基本的に無料で利用できますが、クラウドAIはサブスクリプション料金が発生する場合が多いものの、より高性能なモデルを提供することがあります。

10億~30億パラメーターの小型モデルは、8GBのRAMを搭載した最新のノートパソコンで動作可能です。70億パラメーター以上の大規模で高性能なモデルは、16GB以上のRAMと専用GPUを搭載した環境で最高のパフォーマンスを発揮し、Apple Silicon搭載MacとNVIDIA GPUは大幅な性能向上をもたらします。

![[年]にオフラインで動作する10のベストAIツール](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)