Sebagian besar proyek implementasi AI gagal bukan karena tim memilih model yang salah, tetapi karena tidak ada yang ingat tiga bulan kemudian mengapa mereka memilihnya atau bagaimana cara mereplikasi pengaturannya, dengan 46% proyek AI dibatalkan antara tahap proof-of-concept dan adopsi luas.

Panduan ini akan memandu Anda dalam menggunakan Hugging Face untuk deployment AI—mulai dari pemilihan dan pengujian model hingga pengelolaan proses deployment—sehingga tim Anda dapat meluncurkan AI lebih cepat tanpa kehilangan keputusan kritis di thread Slack dan spreadsheet yang tersebar.

Apa Itu Hugging Face?

Hugging Face adalah platform sumber terbuka dan pusat komunitas yang menyediakan model AI yang telah dilatih sebelumnya, dataset, dan alat untuk membangun dan mengimplementasikan aplikasi pembelajaran mesin.

Bayangkan Hugging Face sebagai perpustakaan digital besar tempat Anda dapat menemukan model AI siap pakai daripada menghabiskan bulan-bulan dan sumber daya yang signifikan untuk membangunnya dari awal.

Dibuat untuk insinyur pembelajaran mesin dan ilmuwan data, namun alat-alatnya semakin banyak digunakan oleh tim lintas fungsi seperti produk, desain, dan teknik untuk mengintegrasikan AI ke dalam alur kerja mereka.

Tahukah Anda: 63% organisasi tidak memiliki praktik manajemen data yang tepat untuk AI. Hal ini seringkali menyebabkan proyek terhenti dan sumber daya terbuang sia-sia.

Tantangan utama bagi banyak tim adalah kompleksitas yang luar biasa dalam mengimplementasikan AI. Proses ini melibatkan pemilihan model yang tepat dari ribuan opsi, mengelola infrastruktur dasar, mengelola versi eksperimen, dan memastikan semua pemangku kepentingan teknis dan non-teknis sejalan.

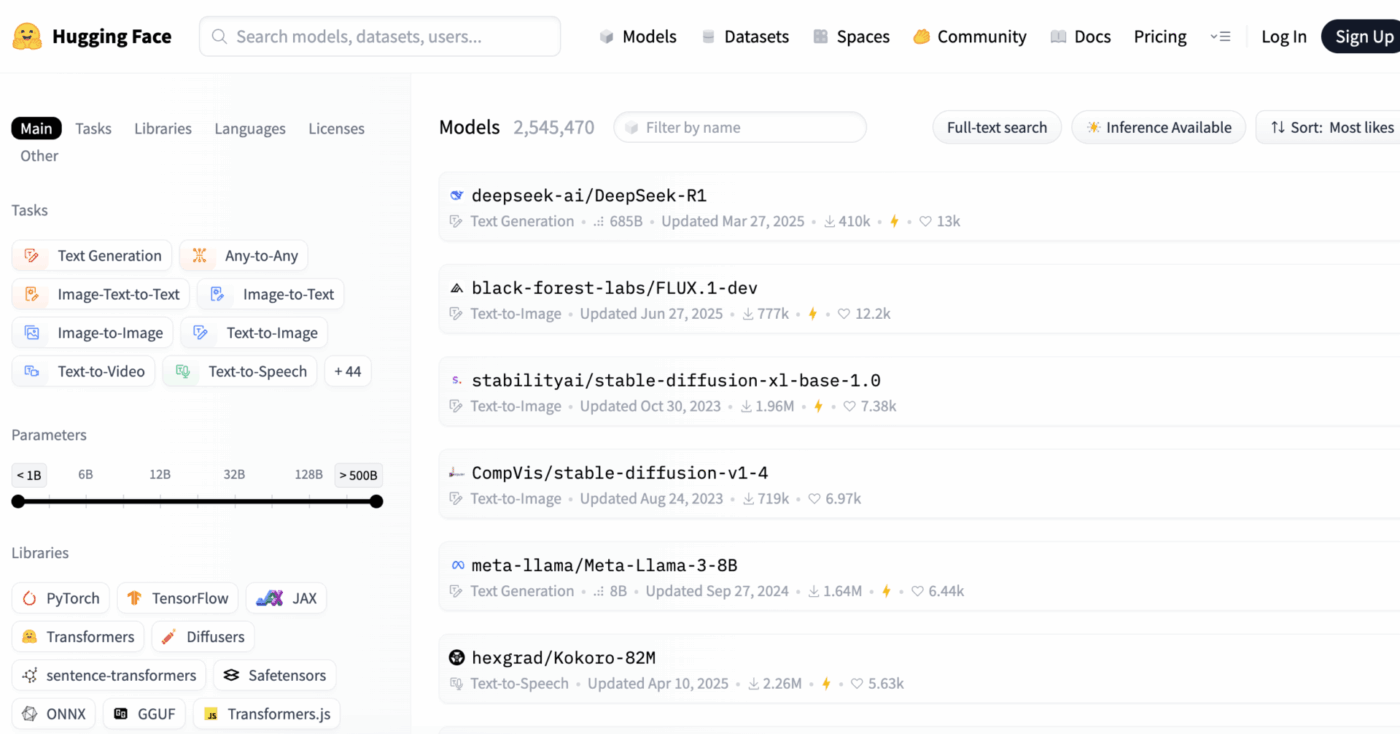

Hugging Face memudahkan hal ini dengan menyediakan Model Hub, repositori pusat yang berisi lebih dari 2 juta model. Perpustakaan transformers platform ini adalah kunci untuk mengakses model-model tersebut, memungkinkan Anda memuat dan menggunakannya dengan hanya beberapa baris kode Python.

Namun, meskipun memiliki alat-alat yang kuat ini, deployment AI tetap menjadi tantangan manajemen proyek, yang memerlukan pemantauan cermat terhadap pemilihan model, pengujian, dan peluncuran untuk memastikan kesuksesan.

📮ClickUp Insight: 92% pekerja pengetahuan berisiko kehilangan keputusan penting yang tersebar di chat, email, dan spreadsheet. Tanpa sistem terpadu untuk mencatat dan melacak keputusan, wawasan bisnis kritis hilang di tengah kebisingan digital.

Dengan fitur Manajemen Tugas ClickUp, Anda tidak perlu khawatir tentang hal ini. Buat tugas dari obrolan, komentar tugas, dokumen, dan email dengan satu klik saja!

Model Hugging Face yang Dapat Anda Deploy

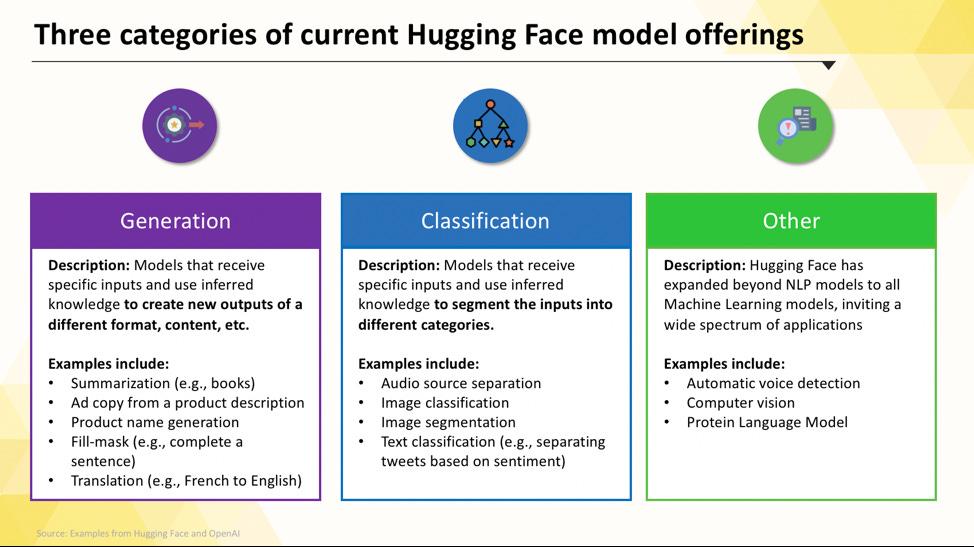

Menavigasi Hugging Face Hub bisa terasa membingungkan saat pertama kali memulai. Dengan ratusan ribu model, kunci utamanya adalah memahami kategori utama untuk menemukan model yang tepat untuk proyek Anda. Model-model tersebut bervariasi mulai dari opsi kecil dan efisien yang dirancang untuk tujuan tunggal hingga model besar dan serbaguna yang dapat menangani pemrosesan kompleks.

Model bahasa khusus tugas

Ketika tim Anda perlu memecahkan masalah tunggal yang jelas, Anda seringkali tidak memerlukan model besar dan serba guna. Waktu dan biaya untuk menjalankan model semacam itu bisa sangat mahal, terutama ketika alat AI yang lebih kecil dan lebih terfokus akan bekerja lebih baik. Di sinilah model khusus tugas berperan.

Ini adalah model yang telah dilatih dan dioptimalkan untuk fungsi tertentu. Karena bersifat khusus, model-model ini umumnya lebih kecil, lebih cepat, dan lebih efisien dalam penggunaan sumber daya dibandingkan dengan model-model yang lebih besar.

Hal ini membuatnya ideal untuk lingkungan produksi di mana kecepatan dan biaya menjadi faktor penting. Banyak di antaranya bahkan dapat berjalan di perangkat keras CPU standar, sehingga dapat diakses tanpa perlu GPU mahal.

Jenis-jenis model khusus tugas yang umum meliputi:

- Klasifikasi teks: Gunakan ini untuk mengkategorikan teks ke dalam label yang telah ditentukan sebelumnya, seperti mengelompokkan umpan balik pelanggan ke dalam kategori “positif” atau “negatif” atau menandai tiket dukungan berdasarkan topik.

- Analisis sentimen: Ini membantu Anda menentukan nada emosional dari sebuah teks, yang berguna untuk pemantauan merek di media sosial.

- Pengenalan entitas bernama: Ekstrak entitas spesifik seperti orang, tempat, dan organisasi dari dokumen untuk membantu mengorganisir data yang tidak terstruktur.

- Ringkasan: Ringkas artikel atau laporan panjang menjadi ringkasan yang ringkas, menghemat waktu membaca tim Anda.

- Terjemahan: Konversi teks dari satu bahasa ke bahasa lain secara otomatis

📚 Baca Juga: Cara Menggunakan Hugging Face untuk Ringkasan Teks

Model bahasa besar

Terkadang, proyek Anda membutuhkan lebih dari sekadar klasifikasi atau ringkasan sederhana. Anda mungkin memerlukan AI yang dapat menghasilkan salinan pemasaran kreatif, menulis kode, atau menjawab pertanyaan pengguna yang kompleks dengan cara yang percakapan. Untuk skenario ini, Anda kemungkinan akan beralih ke Model Bahasa Besar (LLM).

LLMs adalah model dengan miliaran parameter yang dilatih menggunakan jumlah teks dan data yang sangat besar dari internet. Pelatihan yang ekstensif ini memungkinkan mereka untuk memahami nuansa, konteks, dan penalaran yang kompleks. Model LLMs open-source populer yang tersedia di Hugging Face termasuk model dari keluarga Llama, Mistral, dan Falcon.

Tukar menukar untuk kekuatan ini adalah sumber daya komputasi yang signifikan yang mereka butuhkan. Deploying model-model ini hampir selalu memerlukan GPU yang kuat dengan banyak memori (VRAM).

Untuk membuatnya lebih mudah diakses, Anda dapat menggunakan teknik seperti kuantisasi, yang mengurangi ukuran model dengan sedikit penurunan kinerja, sehingga dapat dijalankan pada perangkat keras yang kurang bertenaga.

Model teks-ke-gambar dan model multimodal

Data Anda tidak selalu berupa teks saja. Tim Anda mungkin perlu menghasilkan gambar untuk kampanye pemasaran, menerjemahkan audio dari pertemuan, atau memahami konten video. Di sinilah model multimodal, yang dirancang untuk bekerja di berbagai jenis data, menjadi sangat penting.

Jenis model multimodal yang paling populer adalah model teks-ke-gambar, yang menghasilkan gambar dari deskripsi teks. Model seperti Stable Diffusion menggunakan teknik yang disebut difusi untuk menciptakan visual menakjubkan dari prompt sederhana. Namun, kemungkinan yang ditawarkan jauh melampaui pembangkitan gambar.

Model multimodal lain yang dapat Anda deploy dari Hugging Face meliputi:

- Penjelasan gambar: Secara otomatis menghasilkan teks deskriptif untuk gambar, yang sangat berguna untuk aksesibilitas dan manajemen konten.

- Pengenalan suara: Ubah audio yang diucapkan menjadi teks tertulis menggunakan model seperti OpenAI’s Whisper.

- Pertanyaan visual: Ajukan pertanyaan tentang sebuah gambar dan dapatkan jawaban berbasis teks, seperti “Apa warna mobil dalam foto ini?”

Seperti LLMs, model-model ini membutuhkan daya komputasi yang tinggi dan umumnya memerlukan GPU untuk berjalan dengan efisien.

Untuk melihat bagaimana berbagai jenis model AI diterapkan dalam aplikasi bisnis praktis, tonton ringkasan ini tentang kasus penggunaan AI di dunia nyata di berbagai industri dan fungsi.

Seberapa matangkah tingkat kematangan AI organisasi Anda?

Survei kami terhadap 316 profesional menunjukkan bahwa transformasi AI yang sesungguhnya membutuhkan lebih dari sekadar mengadopsi fitur AI. Ikuti penilaian kematangan AI untuk melihat di mana organisasi Anda berada, dan apa yang dapat Anda lakukan untuk meningkatkan skor Anda.

Cara Mengatur Hugging Face untuk Deploy AI

Sebelum Anda dapat mengimplementasikan model pertama Anda, Anda perlu menyiapkan lingkungan lokal dan akun Hugging Face dengan benar. Masalah umum yang sering dialami tim adalah ketika anggota tim memiliki pengaturan yang tidak konsisten, yang menyebabkan masalah klasik “berfungsi di komputer saya”. Menghabiskan beberapa menit untuk menstandarkan proses ini dapat menghemat berjam-jam waktu pemecahan masalah di kemudian hari.

- Buat akun Hugging Face dan generate token akses. Pertama, daftar untuk akun gratis di situs web Hugging Face. Setelah masuk, navigasi ke profil Anda, klik “Pengaturan,” lalu pilih tab “Token Akses.” Generate token baru dengan izin minimal “baca”; Anda akan membutuhkannya untuk mengunduh model.

- Instal perpustakaan Python yang diperlukan. Buka terminal Anda dan instal perpustakaan inti yang Anda butuhkan. Dua perpustakaan yang paling penting adalah transformers dan huggingface_hub. Anda dapat menginstalnya menggunakan pip: pip install transformers huggingface_hub

- Konfigurasi otentikasi. Untuk menggunakan token akses Anda, Anda dapat masuk melalui baris perintah dengan menjalankan perintah huggingface-cli login dan menempelkan token Anda saat diminta, atau Anda dapat mengaturnya sebagai variabel lingkungan di sistem Anda. Masuk melalui baris perintah seringkali merupakan cara termudah untuk memulai.

- Verifikasi pengaturan. Cara terbaik untuk memastikan semuanya berfungsi adalah dengan menjalankan potongan kode sederhana. Coba muat model dasar menggunakan fungsi pipeline dari perpustakaan transformers. Jika berjalan tanpa kesalahan, Anda siap untuk memulai.

Perlu diingat bahwa beberapa model di Hub bersifat “terbatas”, artinya Anda harus menyetujui syarat lisensi model tersebut di halaman model sebelum dapat mengaksesnya dengan token Anda.

Selain itu, ingatlah bahwa melacak siapa yang memiliki kredensial apa dan konfigurasi lingkungan apa yang digunakan merupakan tugas manajemen proyek itu sendiri, dan hal ini menjadi lebih kritis seiring pertumbuhan tim Anda.

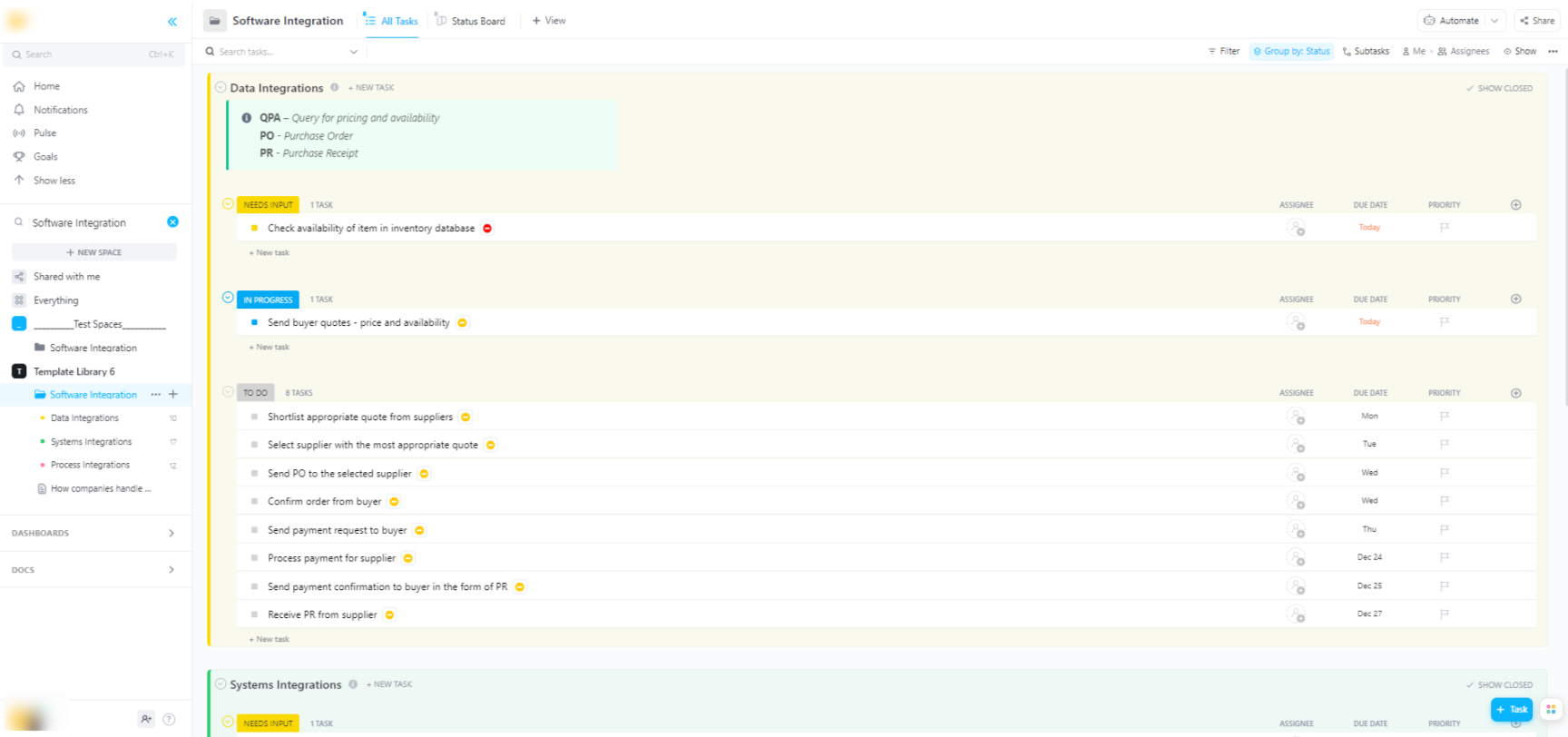

🌟 Jika Anda mengintegrasikan model Hugging Face ke dalam sistem perangkat lunak yang lebih luas, Template Integrasi Perangkat Lunak ClickUp membantu memvisualisasikan alur kerja dan melacak integrasi teknis multi-langkah.

Template ini menyediakan sistem yang mudah diikuti di mana Anda dapat:

- Visualisasikan hubungan antara berbagai solusi perangkat lunak.

- Buat dan tugaskan tugas kepada anggota tim untuk kolaborasi yang lebih lancar.

- Organisir semua tugas terkait integrasi di satu tempat

Opsi Deployment untuk Model Hugging Face

Setelah Anda menguji model secara lokal, pertanyaan selanjutnya adalah: di mana model tersebut akan ditempatkan? Deploying model ke lingkungan produksi di mana model tersebut dapat digunakan oleh orang lain adalah langkah kritis, tetapi opsi yang tersedia bisa membingungkan. Memilih jalur yang salah dapat menyebabkan kinerja lambat, biaya tinggi, atau ketidakmampuan menangani lalu lintas pengguna.

Pilihan Anda akan bergantung pada kebutuhan spesifik Anda, seperti volume lalu lintas yang diharapkan, anggaran, dan apakah Anda sedang membangun prototipe cepat atau aplikasi yang skalabel dan siap produksi.

Hugging Face Spaces

Jika Anda perlu dengan cepat membuat demo atau alat internal, Hugging Face Spaces seringkali menjadi pilihan terbaik. Spaces adalah platform gratis untuk menghosting aplikasi machine learning, dan sangat cocok untuk membangun prototipe yang dapat Anda bagikan dengan tim atau pemangku kepentingan Anda.

Anda dapat membangun antarmuka pengguna aplikasi Anda menggunakan kerangka kerja populer seperti Gradio atau Streamlit, yang memudahkan Anda untuk membuat demo interaktif dengan hanya beberapa baris kode Python.

Membuat Space sesederhana memilih SDK favorit Anda, menghubungkan repositori Git dengan kode Anda, dan memilih perangkat keras. Meskipun Spaces menawarkan tier CPU gratis untuk aplikasi dasar, Anda dapat meng-upgrade ke perangkat keras GPU berbayar untuk model yang lebih kompleks.

Perhatikan batasan-batasan berikut:

- Tidak untuk API dengan lalu lintas tinggi: Spaces dirancang untuk demonstrasi, bukan untuk melayani ribuan permintaan API secara bersamaan.

- Cold starts: Jika Space Anda tidak aktif, sistem mungkin "berhenti sementara" untuk menghemat sumber daya, yang dapat menyebabkan penundaan bagi pengguna pertama yang mengaksesnya kembali.

- Alur kerja berbasis Git: Seluruh kode aplikasi Anda dikelola melalui repositori Git, yang sangat berguna untuk pengendalian versi.

Hugging Face Inference API

Ketika Anda perlu mengintegrasikan model ke dalam aplikasi yang sudah ada, Anda kemungkinan besar akan ingin menggunakan API. API Inference Hugging Face memungkinkan Anda menjalankan model tanpa perlu mengelola infrastruktur dasar apa pun. Anda cukup mengirimkan permintaan HTTP dengan data Anda dan mendapatkan prediksi kembali.

Pendekatan ini ideal jika Anda tidak ingin repot dengan server, skalabilitas, atau pemeliharaan. Hugging Face menawarkan dua tingkatan utama untuk layanan ini:

- API Inference Gratis: Ini adalah opsi infrastruktur bersama dengan batasan penggunaan yang ideal untuk pengembangan dan pengujian. Sangat cocok untuk kasus penggunaan dengan lalu lintas rendah atau saat Anda baru memulai.

- Titik Akhir Inferensi: Untuk aplikasi produksi, Anda disarankan menggunakan Titik Akhir Inferensi. Ini adalah layanan berbayar yang menyediakan infrastruktur khusus dan otomatis menyesuaikan skala, memastikan aplikasi Anda tetap cepat dan andal bahkan saat beban tinggi.

Menggunakan API melibatkan pengiriman payload JSON ke URL endpoint model dengan token otentikasi Anda di header permintaan.

Deploy di platform cloud

Bagi tim yang sudah memiliki kehadiran yang signifikan di penyedia cloud besar seperti Amazon Web Services (AWS), Google Cloud Platform (GCP), atau Microsoft Azure, melakukan deployment di sana dapat menjadi pilihan yang paling logis. Pendekatan ini memberikan Anda kendali penuh dan memungkinkan Anda mengintegrasikan model dengan layanan cloud dan protokol keamanan yang sudah ada.

Alur kerja umum melibatkan "mengemas" model Anda dan ketergantungannya menggunakan Docker, lalu mengimplementasikan kontainer tersebut ke layanan komputasi awan. Setiap penyedia layanan awan memiliki layanan dan integrasi yang mempermudah proses ini:

- AWS SageMaker: Menyediakan integrasi asli untuk melatih dan mengimplementasikan model Hugging Face.

- Google Cloud Vertex AI: Memungkinkan Anda untuk mengimplementasikan model dari Hub ke endpoint yang dikelola.

- Azure Machine Learning: Menyediakan alat untuk mengimpor dan menyajikan model Hugging Face.

Meskipun metode ini memerlukan lebih banyak pengaturan dan keahlian DevOps, ini seringkali menjadi pilihan terbaik untuk deployment skala besar dan tingkat perusahaan di mana Anda memerlukan kendali penuh atas lingkungan.

Cara Menjalankan Model Hugging Face untuk Inferensi

Saat menggunakan Hugging Face untuk deployment AI, “running inference” adalah proses menggunakan model yang telah dilatih untuk membuat prediksi pada data baru yang belum pernah dilihat sebelumnya. Ini adalah saat model Anda melakukan tugas yang Anda deploy untuknya. Memastikan langkah ini dilakukan dengan benar sangat penting untuk membangun aplikasi yang responsif dan efisien.

Masalah terbesar bagi tim adalah menulis kode inferensi yang lambat atau tidak efisien, yang dapat menyebabkan pengalaman pengguna yang buruk dan biaya operasional yang tinggi. Beruntungnya, perpustakaan Transformers menawarkan beberapa cara untuk menjalankan inferensi, masing-masing dengan trade-off antara kemudahan penggunaan dan kontrol.

- Pipeline API: Ini adalah cara termudah dan paling umum untuk memulai. Fungsi pipeline() menyederhanakan sebagian besar kompleksitas, menangani pra-pemrosesan data, pemrosesan model, dan pasca-pemrosesan untuk Anda. Untuk tugas-tugas standar seperti analisis sentimen, Anda dapat mendapatkan prediksi dengan hanya satu baris kode.

- AutoModel + AutoTokenizer: Saat Anda membutuhkan kontrol lebih atas proses inferensi, Anda dapat menggunakan kelas AutoModel dan AutoTokenizer secara langsung. Ini memungkinkan Anda untuk secara manual mengelola cara teks Anda di-tokenize dan cara output mentah model dikonversi menjadi prediksi yang dapat dibaca manusia. Pendekatan ini berguna saat Anda bekerja dengan tugas kustom atau perlu menerapkan logika pra- atau pasca-pemrosesan spesifik.

- Pemrosesan batch: Untuk memaksimalkan efisiensi, terutama pada GPU, sebaiknya memproses input secara batch daripada satu per satu. Mengirimkan batch input melalui model dalam satu kali proses forward pass jauh lebih cepat daripada mengirimkan masing-masing input secara individu.

Memantau kinerja kode inferensi Anda merupakan bagian penting dari siklus hidup deployment. Melacak metrik seperti latensi (seberapa lama waktu yang dibutuhkan untuk melakukan prediksi) dan throughput (seberapa banyak prediksi yang dapat dilakukan per detik) memerlukan koordinasi dan dokumentasi yang jelas, terutama saat anggota tim yang berbeda mencoba versi model baru.

📚 Baca Juga: Alat Kolaborasi Tim AI Terbaik yang Dapat Digunakan

Contoh Langkah demi Langkah: Deploy Model Hugging Face

Mari kita ikuti contoh lengkap deployment model analisis sentimen sederhana. Dengan mengikuti langkah-langkah ini, Anda akan mulai dari pemilihan model hingga memiliki endpoint yang aktif dan dapat diuji.

- Pilih model Anda: Kunjungi Hugging Face Hub dan gunakan filter di sebelah kiri untuk mencari model yang melakukan "Klasifikasi Teks". Titik awal yang baik adalah distilbert-base-uncased-finetuned-sst-2-english. Baca kartu modelnya untuk memahami kinerjanya dan cara menggunakannya.

- Instal dependensi: Pastikan Anda telah menginstal perpustakaan yang diperlukan di lingkungan Python lokal Anda. Untuk model ini, Anda hanya memerlukan transformers dan torch. Jalankan perintah pip install transformers torch.

- Uji secara lokal: Sebelum melakukan deployment, pastikan model berfungsi sesuai harapan di mesin Anda. Tulis skrip Python kecil untuk memuat model menggunakan pipeline dan uji dengan kalimat contoh. Misalnya: classifier = pipeline("sentiment-analysis", model="distilbert-base-uncased-finetuned-sst-2-english") diikuti dengan classifier("ClickUp adalah platform produktivitas terbaik!")

- Buat deployment: Untuk contoh ini, kita akan menggunakan Hugging Face Spaces untuk deployment yang cepat dan mudah. Buat Space baru, pilih Gradio SDK, dan buat berkas app.py yang memuat model Anda dan mendefinisikan antarmuka Gradio sederhana untuk berinteraksi dengannya.

- Verifikasi deployment: Setelah Space Anda berjalan, Anda dapat menggunakan antarmuka interaktif untuk mengujinya. Anda juga dapat melakukan permintaan API langsung ke endpoint Space untuk mendapatkan respons JSON, memastikan bahwa sistem berfungsi secara programatik.

Setelah langkah-langkah ini, Anda memiliki model yang aktif. Fase berikutnya dari proyek ini akan melibatkan pemantauan penggunaannya, perencanaan pembaruan, dan potensi skalabilitas infrastruktur jika model tersebut menjadi populer.

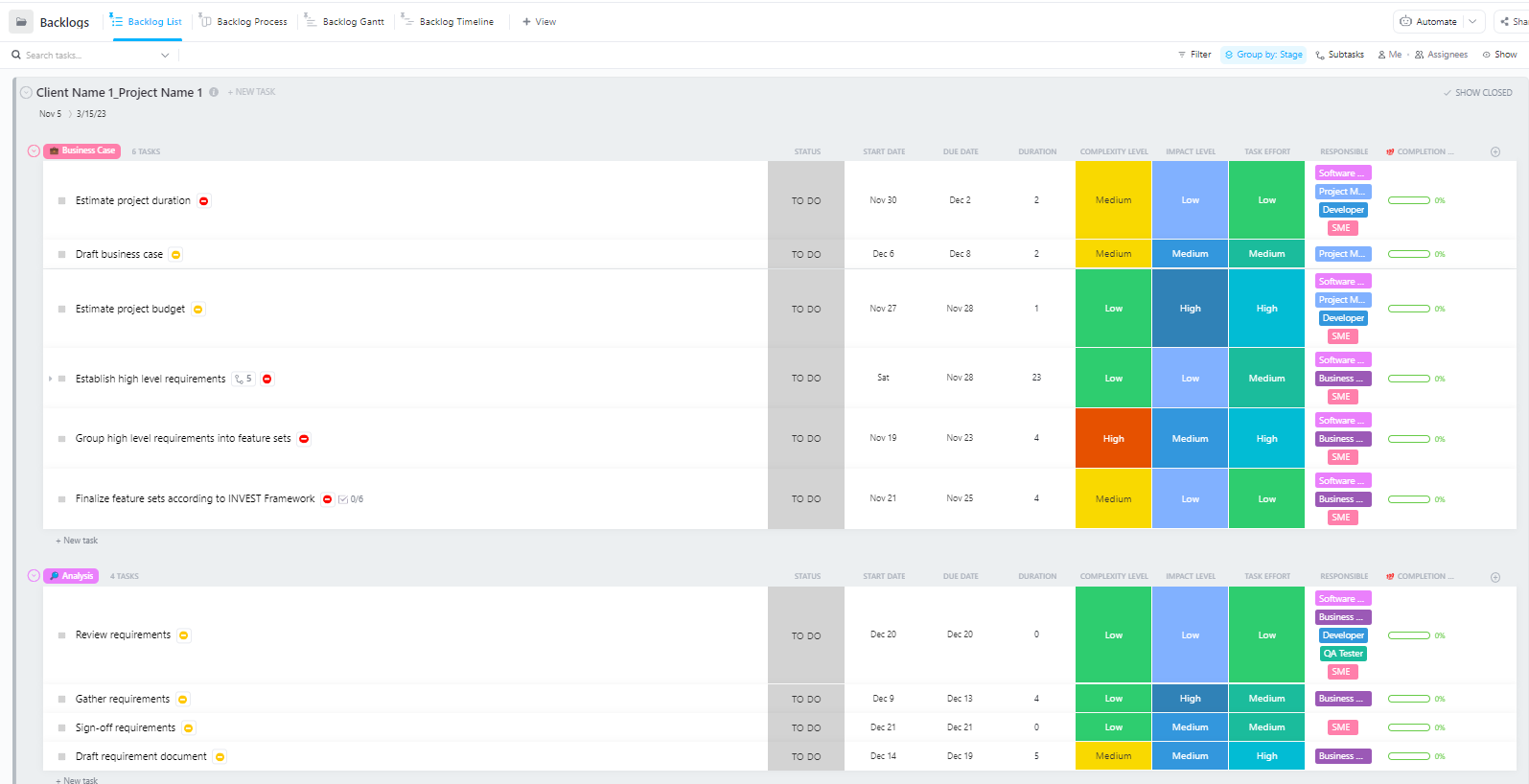

Bagi tim yang mengelola proyek implementasi AI kompleks dengan beberapa fase—mulai dari persiapan data hingga implementasi produksi—Template Manajemen Proyek Perangkat Lunak Lanjutan oleh ClickUp menyediakan struktur yang komprehensif.

Template ini membantu tim:

- Kelola proyek dengan berbagai milestone, tugas, sumber daya, dan ketergantungan.

- Visualisasikan kemajuan proyek dengan diagram Gantt dan garis waktu.

- Bekerja sama dengan tim secara lancar untuk memastikan penyelesaian yang sukses.

Tantangan Umum dalam Deploying Hugging Face dan Cara Mengatasinya

Bahkan dengan rencana yang jelas, Anda kemungkinan akan menemui beberapa hambatan selama deployment. Melihat pesan kesalahan yang sulit dipahami bisa sangat menjengkelkan dan menghentikan kemajuan tim Anda. Berikut adalah beberapa tantangan paling umum dan cara mengatasinya. 🛠️

🚨Masalah: “Model memerlukan otentikasi”

- Penyebab: Anda mencoba mengakses model "terbatas" yang mengharuskan Anda menerima syarat lisensinya.

- Solusi: Kunjungi halaman model di Hub, baca, dan setujui perjanjian lisensi. Pastikan token akses yang Anda gunakan memiliki izin "baca".

🚨Masalah: “CUDA kehabisan memori”

- Penyebab: Model yang Anda coba muat terlalu besar untuk memori GPU (VRAM) Anda.

- Solusi: Solusi tercepat adalah menggunakan versi model yang lebih kecil atau versi yang telah dikuantisasi. Anda juga dapat mencoba mengurangi ukuran batch selama proses inferensi.

🚨Masalah: “trust_remote_code error”

- Penyebab: Beberapa model di Hub memerlukan kode khusus untuk dijalankan, dan karena alasan keamanan, perpustakaan tidak akan menjalankannya secara default.

- Solusi: Anda dapat melewati ini dengan menambahkan trust_remote_code=True saat memuat model. Namun, Anda harus selalu memeriksa kode sumber terlebih dahulu untuk memastikan keamanannya.

🚨Masalah: “Ketidakcocokan tokenizer”

- Penyebab: Tokenizer yang Anda gunakan bukan yang sama persis dengan yang digunakan saat melatih model, menyebabkan masukan yang salah dan kinerja yang buruk.

- Solusi: Selalu muat tokenizer dari checkpoint model yang sama dengan model itu sendiri. Misalnya, AutoTokenizer. from_pretrained("model-name")

🚨Masalah: “Batasan kecepatan terlampaui”

- Penyebab: Anda telah melakukan terlalu banyak permintaan ke API Inference gratis dalam waktu singkat.

- Solusi: Untuk penggunaan produksi, upgrade ke Inference Endpoint khusus. Untuk pengembangan, Anda dapat mengimplementasikan caching untuk menghindari pengiriman permintaan yang sama berulang kali.

Melacak solusi mana yang cocok untuk masalah tertentu sangat penting. Tanpa tempat pusat untuk mendokumentasikan temuan ini, tim sering kali harus menyelesaikan masalah yang sama berulang kali.

📮 ClickUp Insight: 1 dari 4 karyawan menggunakan empat atau lebih alat hanya untuk membangun konteks di tempat kerja. Rincian penting mungkin tersembunyi dalam email, dijelaskan dalam thread Slack, dan didokumentasikan dalam alat terpisah, memaksa tim untuk membuang waktu mencari informasi daripada menyelesaikan pekerjaan.

ClickUp mengintegrasikan seluruh alur kerja Anda ke dalam satu platform terpadu. Dengan fitur seperti ClickUp Email Project Management, ClickUp Chat, ClickUp Docs, dan ClickUp Brain, semua hal tetap terhubung, sinkron, dan dapat diakses secara instan. Ucapkan selamat tinggal pada "bekerja tentang pekerjaan" dan rebut kembali waktu produktif Anda.

💫 Hasil Nyata: Tim dapat menghemat 5+ jam setiap minggu dengan menggunakan ClickUp—itu setara dengan lebih dari 250 jam per tahun per orang—dengan menghilangkan proses manajemen pengetahuan yang usang. Bayangkan apa yang dapat diciptakan tim Anda dengan tambahan satu minggu produktivitas setiap kuartal!

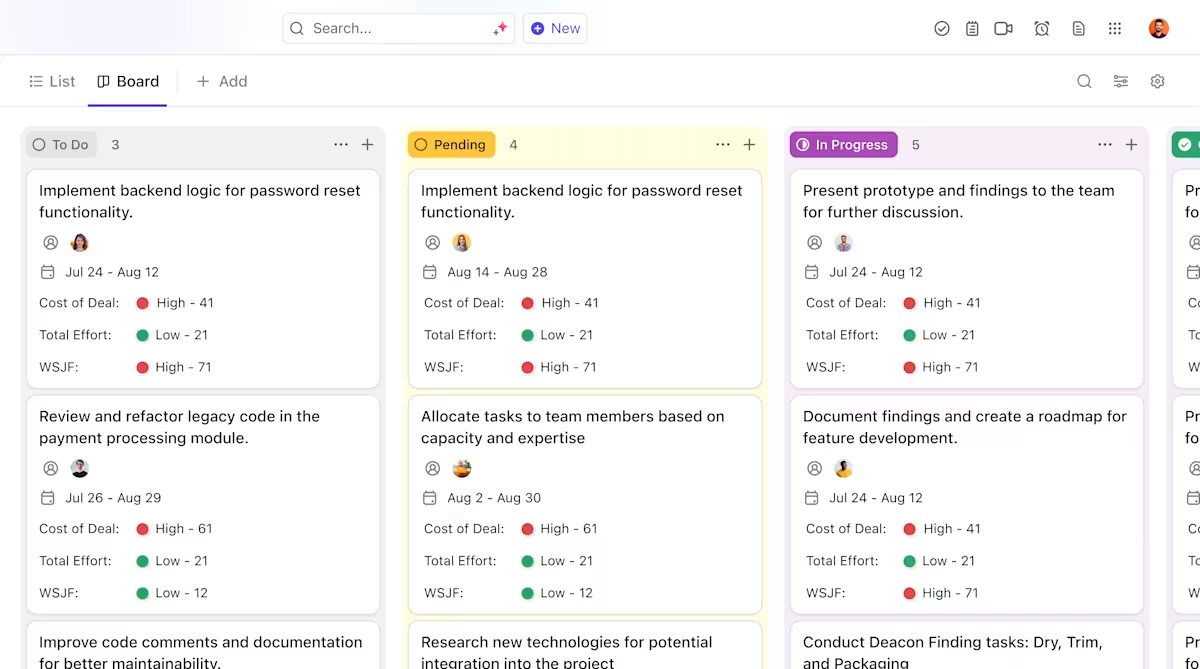

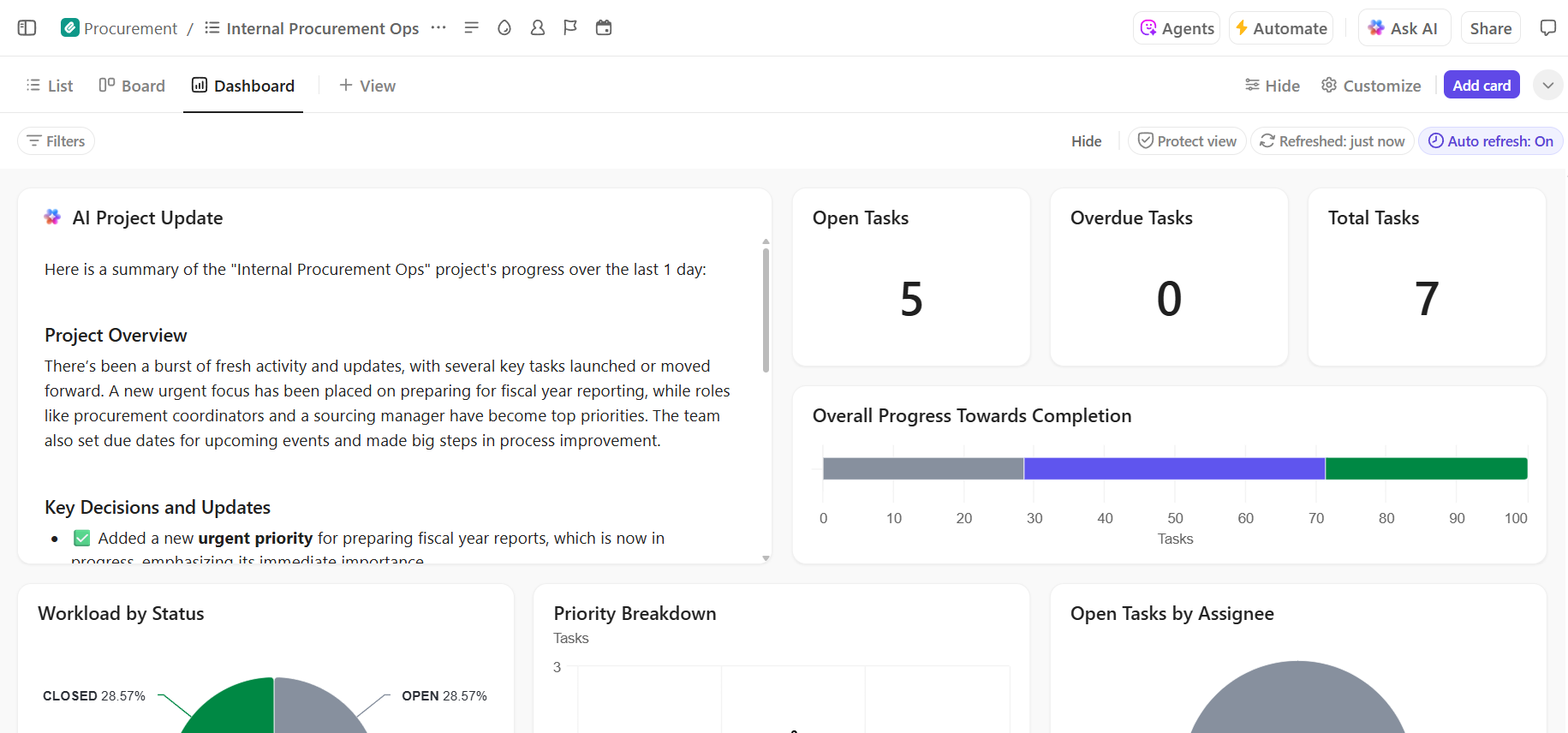

Cara Mengelola Proyek Deploy AI di ClickUp

Menggunakan Hugging Face untuk deployment AI memudahkan dalam mengemas, menghosting, dan menyajikan model—tetapi tidak menghilangkan beban koordinasi dalam deployment dunia nyata. Tim masih perlu melacak model mana yang sedang diuji, menyepakati konfigurasi, mendokumentasikan keputusan, dan memastikan semua pihak—dari insinyur ML hingga tim produk dan operasional—tetap berada di halaman yang sama.

Ketika tim teknik Anda sedang menguji berbagai model, tim produk Anda sedang mendefinisikan persyaratan, dan pemangku kepentingan meminta pembaruan, informasi tersebar di Slack, email, spreadsheet, dan berbagai dokumen.

Pekerjaan yang tersebar — fragmentasi aktivitas kerja di berbagai alat yang terpisah dan tidak terhubung — menyebabkan kebingungan dan memperlambat semua orang.

Di sinilah ClickUp, ruang kerja AI terintegrasi pertama di dunia, memainkan peran kunci dengan menggabungkan manajemen proyek, dokumentasi, dan komunikasi tim ke dalam satu ruang kerja.

Konvergensi ini sangat berharga untuk proyek implementasi AI, di mana pemangku kepentingan teknis dan non-teknis memerlukan visibilitas bersama tanpa harus menggunakan lima alat yang berbeda.

Alih-alih menyebar pembaruan di berbagai tiket, dokumen, dan obrolan, tim dapat mengelola seluruh siklus hidup deployment di satu tempat.

Inilah cara ClickUp dapat mendukung proyek implementasi AI Anda:

- Pengelolaan kepemilikan dan pelacakan yang jelas sepanjang siklus hidup model: Gunakan ClickUp Tasks untuk melacak model Hugging Face melalui tahap evaluasi, pengujian, staging, dan produksi, dengan status kustom, pemilik, dan hambatan yang terlihat oleh seluruh tim.

- Dokumentasi deployment terpusat dan dinamis: Kelola panduan deployment, konfigurasi lingkungan, dan panduan pemecahan masalah di ClickUp Docs, sehingga dokumentasi berkembang seiring dengan model Anda dan tetap mudah dicari dan merujuk. Karena Docs terhubung dengan tugas, dokumentasi Anda berada tepat di samping pekerjaan yang terkait dengannya.

- Kolaborasi dalam konteks tanpa penyebaran pekerjaan: Jaga agar diskusi, keputusan, dan pembaruan tetap terhubung langsung dengan tugas dan dokumen, mengurangi ketergantungan pada thread Slack yang tersebar, email, dan alat proyek yang terputus-putus.

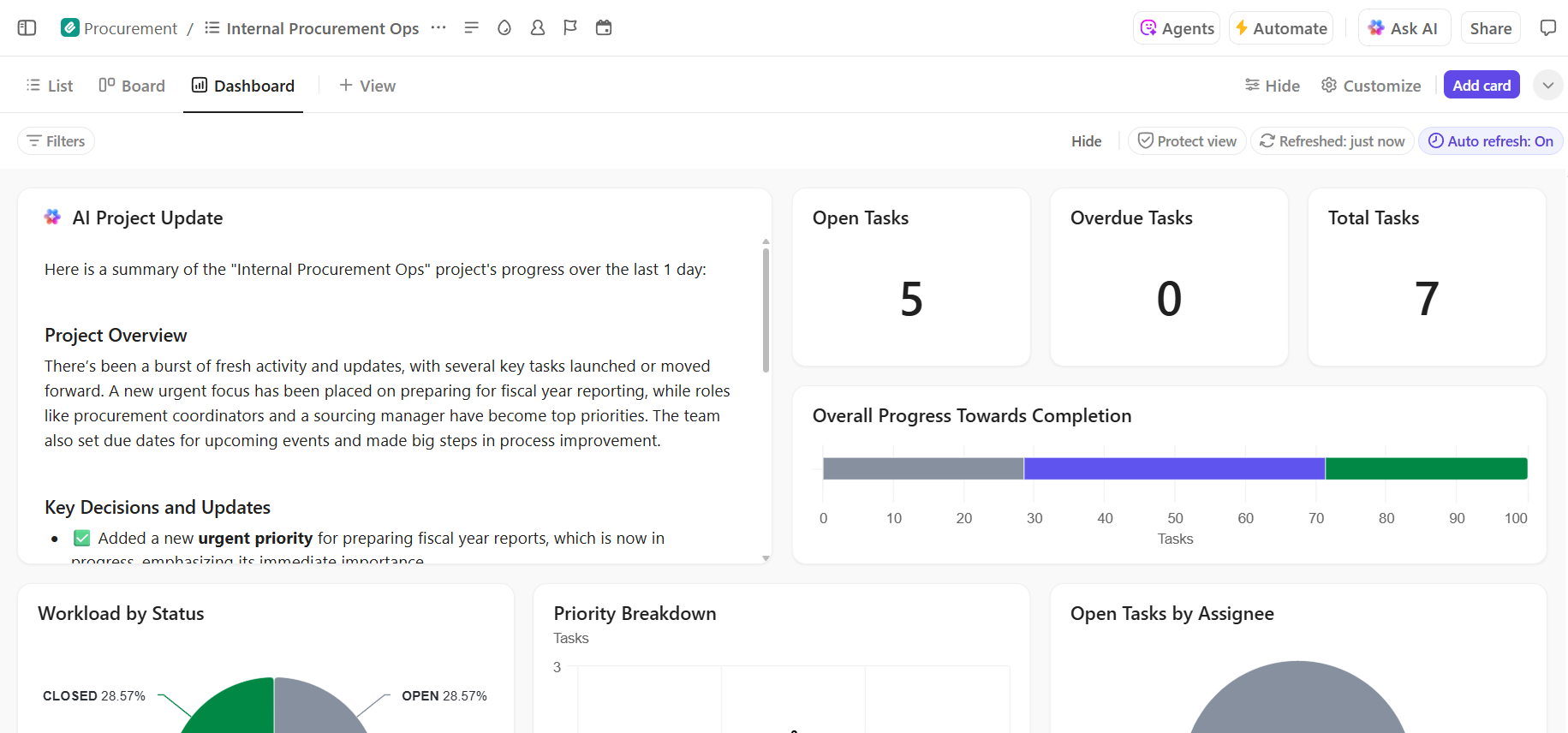

- Visibilitas end-to-end terhadap progres deployment: Pantau pipeline deployment, identifikasi risiko sejak dini, dan seimbangkan kapasitas tim menggunakan ClickUp Dashboards yang menampilkan progres real-time dan bottleneck.

- Onboarding lebih cepat dan pengambilan keputusan yang lebih efisien dengan AI bawaan: Gunakan ClickUp Brain untuk merangkum dokumen deployment yang panjang, mengidentifikasi wawasan relevan dari deployment sebelumnya, dan membantu anggota tim baru memahami proses tanpa harus menggali konteks historis.

Kelola Proyek Deploy AI Anda dengan Mudah di ClickUp

Penerapan Hugging Face yang sukses bergantung pada dasar teknis yang kokoh dan manajemen proyek yang jelas dan terorganisir. Meskipun tantangan teknis dapat diatasi, seringkali kegagalan proyek disebabkan oleh ketidakharmonisan koordinasi dan komunikasi.

Dengan menetapkan alur kerja yang jelas dalam satu platform, tim Anda dapat meluncurkan lebih cepat dan menghindari frustrasi akibat penyebaran konteks — ketika tim menghabiskan berjam-jam mencari informasi, berpindah antar aplikasi, dan mengulang pembaruan di berbagai platform.

ClickUp, aplikasi serba guna untuk kerja, menggabungkan manajemen proyek, dokumentasi, dan komunikasi tim Anda dalam satu tempat untuk memberikan sumber kebenaran tunggal untuk seluruh siklus hidup deployment AI Anda.

Satukan proyek implementasi AI Anda dan hilangkan kekacauan alat. Mulailah secara gratis dengan ClickUp hari ini.

Pertanyaan yang Sering Diajukan (FAQ)

Ya, Hugging Face menyediakan tingkatan gratis yang cukup besar, termasuk akses ke Model Hub, ruang demo yang didukung CPU, dan API Inferensi dengan batasan penggunaan untuk pengujian. Untuk kebutuhan produksi yang memerlukan hardware khusus atau batasan yang lebih tinggi, paket berbayar tersedia.

Spaces dirancang untuk menghosting aplikasi interaktif dengan antarmuka visual, menjadikannya ideal untuk demonstrasi dan alat internal. API Inference menyediakan akses programatik ke model, memungkinkan Anda mengintegrasikannya ke dalam aplikasi Anda melalui permintaan HTTP sederhana.

Tentu saja. Melalui demo interaktif yang dihosting di Hugging Face Spaces, anggota tim non-teknis dapat bereksperimen dengan model dan memberikan umpan balik tanpa perlu menulis satu baris kode pun.

Batasan utama dari tier gratis adalah batasan penggunaan pada API Inference, penggunaan hardware CPU bersama untuk Spaces yang dapat lambat, dan "cold starts" di mana aplikasi yang tidak aktif membutuhkan waktu sejenak untuk aktif kembali. /