Sebagian besar pengembang yang membangun skrip ringkasan Hugging Face menghadapi masalah yang sama: ringkasan berfungsi dengan sempurna di terminal mereka. Namun, ringkasan tersebut jarang terhubung dengan pekerjaan sebenarnya yang seharusnya didukungnya.

Panduan ini akan memandu Anda dalam membangun ringkasan teks menggunakan perpustakaan Transformers dari Hugging Face, lalu menunjukkan mengapa bahkan implementasi yang sempurna pun dapat menimbulkan lebih banyak masalah daripada solusi yang ditawarkan ketika tim Anda membutuhkan ringkasan yang benar-benar terhubung dengan tugas, proyek, dan keputusan.

Apa Itu Ringkasan Teks?

Tim-tim kewalahan dengan informasi. Anda dihadapkan pada dokumen-dokumen panjang, transkrip rapat yang tak berujung, makalah penelitian yang padat, dan laporan kuartalan yang membutuhkan waktu berjam-jam untuk diolah secara manual. Beban informasi yang terus-menerus ini memperlambat pengambilan keputusan dan merusak produktivitas.

Ringkasan teks adalah proses menggunakan Pemrosesan Bahasa Alami (NLP) untuk meringkas konten menjadi versi singkat dan koheren yang mempertahankan informasi paling kritis. Bayangkan ini sebagai ringkasan eksekutif instan untuk dokumen apa pun. Teknologi ringkasan NLP ini umumnya menggunakan salah satu dari dua pendekatan:

Ringkasan ekstraktif: Metode ini bekerja dengan mengidentifikasi dan mengambil kalimat-kalimat paling penting langsung dari teks sumber. Ini seperti memiliki pensil sorot yang secara otomatis menyoroti poin-poin kunci untuk Anda. Ringkasan akhir adalah kumpulan kalimat asli.

Ringkasan abstrak: Metode yang lebih canggih ini menghasilkan kalimat-kalimat baru sepenuhnya untuk menangkap makna inti teks sumber. Metode ini merumuskan ulang informasi, menghasilkan ringkasan yang lebih mengalir dan mirip manusia, seperti cara seseorang menjelaskan cerita panjang dengan kata-katanya sendiri.

Anda dapat melihat hasilnya di mana-mana. Alat ini digunakan untuk meringkas catatan rapat menjadi tindakan, mengidentifikasi tren dari umpan balik pelanggan, dan membuat ringkasan cepat dokumen proyek. Tujuannya selalu sama: mendapatkan informasi esensial tanpa harus membaca setiap kata.

📮 ClickUp Insight: Seorang profesional rata-rata menghabiskan lebih dari 30 menit sehari untuk mencari informasi terkait pekerjaan. Itu berarti lebih dari 120 jam setahun terbuang untuk menggali email, obrolan Slack, dan file yang tersebar. Asisten AI cerdas yang terintegrasi di ruang kerja Anda dapat mengubah hal itu. ClickUp Brain memberikan wawasan dan jawaban instan dengan menampilkan dokumen, percakapan, dan detail tugas yang tepat dalam hitungan detik, sehingga Anda dapat berhenti mencari dan mulai bekerja.

💫 Hasil Nyata: Tim seperti QubicaAMF menghemat lebih dari 5 jam per minggu dengan menggunakan ClickUp, lebih dari 250 jam per tahun per orang, dengan menghilangkan proses manajemen pengetahuan yang usang.

Mengapa Menggunakan Hugging Face untuk Ringkasan Teks?

Membuat model ringkasan teks kustom dari awal adalah tugas yang sangat besar. Hal ini memerlukan dataset yang sangat besar untuk pelatihan, sumber daya komputasi yang kuat dan mahal, serta tim ahli machine learning. Hambatan masuk yang tinggi ini membuat sebagian besar tim teknik dan produk tidak pernah memulai.

Hugging Face adalah platform yang mengatasi masalah ini. Ini adalah platform komunitas sumber terbuka dan ilmu data yang memberikan akses ke ribuan model yang telah dilatih sebelumnya, secara efektif mendemokratisasi ringkasan LLM bagi para pengembang. Alih-alih membangun dari nol, Anda dapat memulai dengan model yang sudah 99% siap.

Inilah mengapa begitu banyak pengembang beralih ke Hugging Face: 🛠️

Akses model yang telah dilatih sebelumnya: Hugging Face Hub adalah repositori besar yang berisi lebih dari 2 juta model publik yang dilatih oleh perusahaan seperti Google, Meta, dan OpenAI. Anda dapat mengunduh dan menggunakan titik pemeriksaan (checkpoint) terbaru ini untuk proyek Anda sendiri.

Antarmuka API yang disederhanakan: Fungsi pipeline adalah antarmuka API tingkat tinggi yang menangani semua langkah kompleks, seperti prapemrosesan teks, inferensi model, dan pembentukan output, hanya dalam beberapa baris kode.

Variasi model: Anda tidak terikat pada satu pilihan. Anda dapat memilih dari berbagai arsitektur seperti BART, T5, dan Pegasus, masing-masing dengan kelebihan, ukuran, dan karakteristik kinerja yang berbeda.

Fleksibilitas kerangka kerja: Perpustakaan Transformers bekerja dengan mulus bersama dua kerangka kerja deep learning paling populer, PyTorch dan TensorFlow. Anda dapat menggunakan salah satu yang sudah familiar bagi tim Anda.

Dukungan komunitas: Dengan dokumentasi yang lengkap, kursus resmi, dan komunitas pengembang yang aktif, mudah untuk menemukan tutorial dan mendapatkan bantuan saat Anda menemui masalah.

Meskipun Hugging Face sangat powerful bagi para pengembang, penting untuk diingat bahwa ini adalah solusi berbasis kode. Implementasi dan pemeliharaannya memerlukan keahlian teknis. Hal ini tidak selalu cocok untuk tim non-teknis yang hanya perlu merangkum pekerjaan mereka.

🧐 Tahukah Anda? Perpustakaan Transformers dari Hugging Face membuat penggunaan model NLP terkini menjadi umum dengan hanya beberapa baris kode, itulah mengapa prototipe ringkasan sering dimulai dari sana.

Apa Itu Transformers Hugging Face?

Jadi Anda telah memutuskan untuk menggunakan Hugging Face, tetapi apa sebenarnya teknologi yang melakukan pekerjaan tersebut? Teknologi inti adalah arsitektur yang disebut Transformer. Ketika diperkenalkan dalam sebuah makalah tahun 2017 berjudul “Attention Is All You Need,” teknologi ini sepenuhnya mengubah bidang NLP.

Sebelum Transformers, model-model kesulitan memahami konteks kalimat yang panjang. Inovasi utama Transformers adalah mekanisme perhatian, yang memungkinkan model untuk menilai pentingnya kata-kata yang berbeda dalam teks masukan saat memproses kata tertentu. Hal ini membantu model menangkap ketergantungan jangka panjang dan memahami konteks, yang sangat penting untuk menciptakan ringkasan yang koheren.

Perpustakaan Hugging Face Transformers adalah paket Python yang memudahkan Anda menggunakan model-model kompleks ini. Anda tidak perlu memiliki gelar Ph.D. dalam machine learning. Perpustakaan ini mengabstraksi bagian yang rumit.

Tiga komponen inti yang perlu Anda ketahui

- Tokenizer: Model tidak memahami kata-kata; mereka memahami angka. Tokenizer mengambil teks masukan Anda dan mengonversinya menjadi urutan token numerik—proses yang disebut tokenisasi —yang dapat diproses oleh model.

- Model: Ini adalah jaringan saraf tiruan yang telah dilatih sebelumnya. Untuk ringkasan, model ini umumnya berupa model sequence-to-sequence dengan struktur encoder-decoder. Encoder membaca teks input untuk menciptakan representasi numerik, dan decoder menggunakan representasi tersebut untuk menghasilkan ringkasan.

- Pipelines: Ini adalah cara termudah untuk menggunakan model. Sebuah pipeline menggabungkan model yang telah dilatih sebelumnya dengan tokenizer yang sesuai dan menangani semua langkah pra-pemrosesan input dan pasca-pemrosesan output untuk Anda.

Dua model paling populer untuk ringkasan adalah BART dan T5. BART (Bidirectional and Auto-Regressive Transformer) sangat unggul dalam ringkasan abstrak, menghasilkan ringkasan yang terdengar sangat alami. T5 (Text-to-Text Transfer Transformer) adalah model serbaguna yang memandang setiap tugas NLP sebagai masalah teks-ke-teks, menjadikannya alat yang sangat powerful untuk berbagai tugas.

🎥 Tonton video ini untuk melihat perbandingan summarizer PDF AI terbaik—dan pelajari alat mana yang memberikan ringkasan tercepat dan paling akurat tanpa kehilangan konteks.

Cara Membuat Summarizer Teks dengan Hugging Face

Siap untuk membuat contoh summarizer Anda sendiri? Yang Anda butuhkan hanyalah pengetahuan dasar Python, editor kode seperti VS Code, dan koneksi internet. Seluruh proses hanya membutuhkan empat langkah. Anda akan memiliki summarizer yang berfungsi dalam hitungan menit.

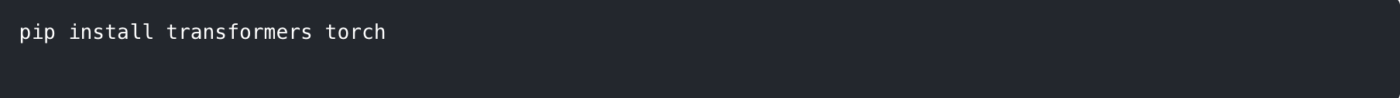

Langkah 1: Instal perpustakaan yang diperlukan

Pertama, Anda perlu menginstal perpustakaan yang diperlukan. Perpustakaan utama adalah transformers. Anda juga memerlukan kerangka kerja deep learning seperti PyTorch atau TensorFlow. Kami akan menggunakan PyTorch untuk contoh ini.

Buka terminal atau prompt perintah Anda dan jalankan perintah berikut:

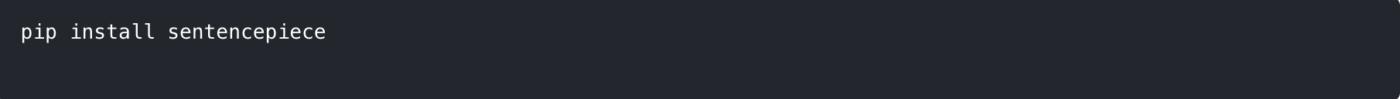

Beberapa model, seperti T5, juga memerlukan perpustakaan sentencepiece untuk tokenizer-nya. Disarankan untuk menginstalnya juga.

💡 Tips Pro: Buat lingkungan virtual Python sebelum menginstal paket-paket ini. Hal ini menjaga dependensi proyek Anda terisolasi dan mencegah konflik dengan proyek lain di mesin Anda.

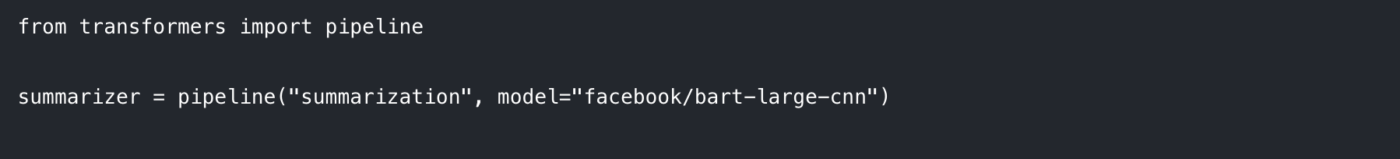

Langkah 2: Muat model dan tokenizer

Cara termudah untuk memulai adalah dengan menggunakan fungsi pipeline. Fungsi ini secara otomatis menangani pemuatan model dan tokenizer yang tepat untuk tugas ringkasan.

Dalam skrip Python Anda, impor pipeline dan inisialisasikan seperti ini:

Di sini, kita menentukan dua hal:

Tugas: Kami memberitahu pipeline bahwa kami ingin melakukan "ringkasan".

Model: Kami memilih checkpoint model pra-latih spesifik dari Hugging Face Hub. facebook/bart-large-cnn adalah pilihan populer yang dilatih pada artikel berita dan bekerja dengan baik untuk ringkasan umum. Untuk pengujian yang lebih cepat, Anda dapat menggunakan model yang lebih kecil seperti t5-small.

Saat pertama kali menjalankan kode ini, model akan mengunduh bobot model dari Hub, yang mungkin memakan waktu beberapa menit. Setelah itu, model akan disimpan di cache pada mesin lokal Anda untuk pemuatan instan.

Langkah 3: Buat fungsi ringkasan

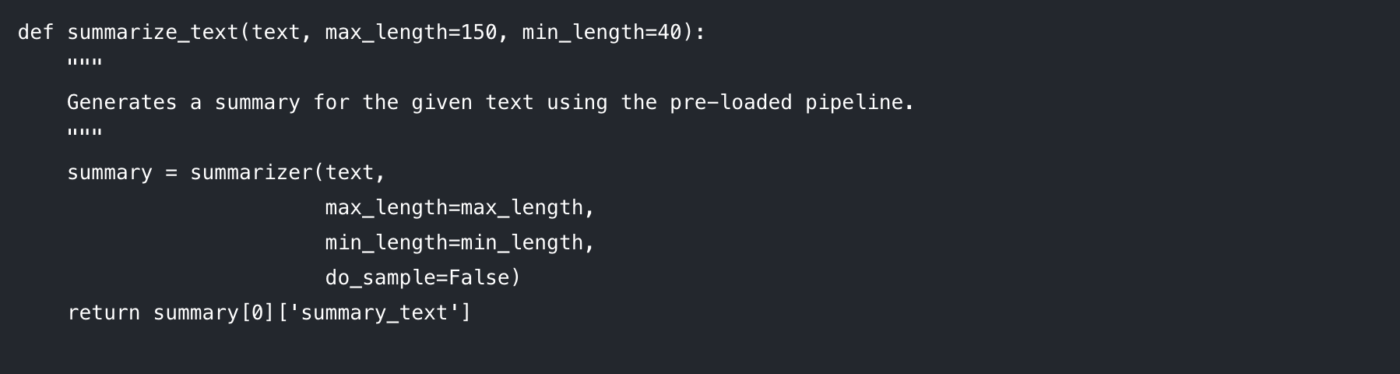

Untuk membuat kode Anda bersih dan dapat digunakan kembali, sebaiknya bungkus logika ringkasan dalam fungsi. Hal ini juga memudahkan untuk bereksperimen dengan parameter yang berbeda.

Mari kita uraikan parameter yang dapat Anda kendalikan:

max_length: Ini menentukan jumlah token maksimum (sekitar kata) untuk ringkasan output.

min_length: Ini menetapkan jumlah token minimum untuk mencegah model menghasilkan ringkasan yang terlalu pendek atau kosong.

do_sample: Saat disetel ke False, model menggunakan metode deterministik (seperti beam search) untuk menghasilkan ringkasan yang paling mungkin. Menyetelnya ke True memperkenalkan unsur acak, yang dapat menghasilkan hasil yang lebih kreatif tetapi kurang dapat diprediksi.

Menyesuaikan parameter-parameter ini adalah kunci untuk mendapatkan kualitas output yang diinginkan.

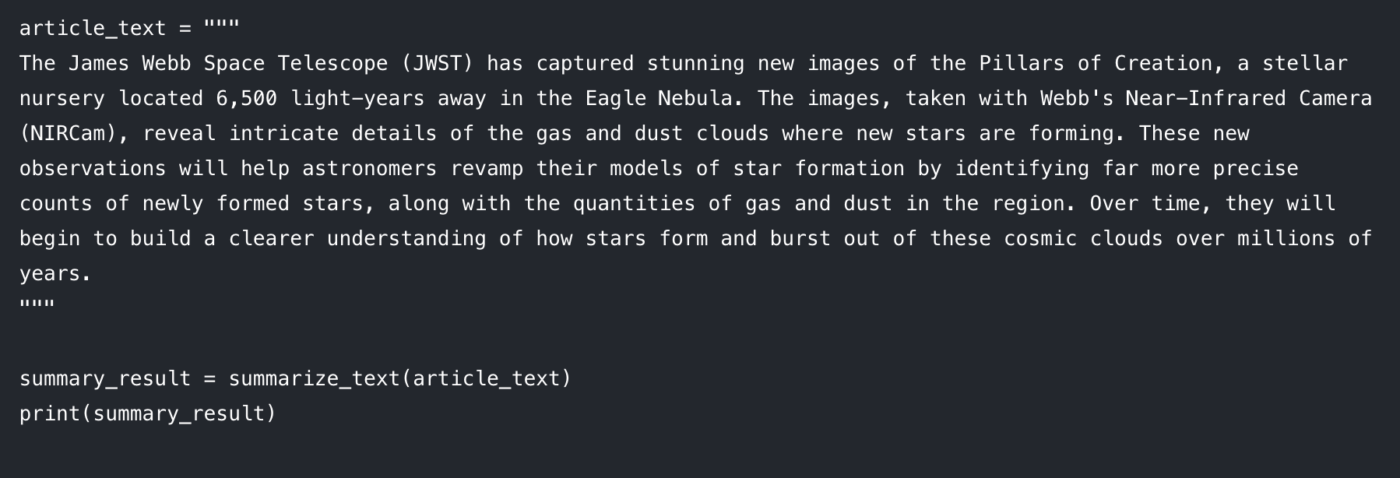

Langkah 4: Buat ringkasan Anda

Sekarang bagian yang seru. Masukkan teks Anda ke dalam fungsi dan cetak hasilnya. 🤩

Anda seharusnya melihat versi ringkas artikel yang ditampilkan di konsol Anda. Jika Anda menemui masalah, berikut beberapa solusi cepat:

Teks masukan terlalu panjang: Model mungkin menampilkan kesalahan jika teks masukan melebihi panjang maksimumnya (seringkali 512 atau 1024 token). Tambahkan truncation=True di dalam panggilan summarizer() untuk secara otomatis memotong teks masukan yang terlalu panjang.

Ringkasan terlalu umum: Coba tingkatkan parameter num_beams (misalnya, num_beams=4). Hal ini membuat model mencari ringkasan yang lebih baik dengan lebih teliti, tetapi dapat sedikit lebih lambat.

Pendekatan berbasis kode ini sangat bagus untuk pengembang yang membangun aplikasi kustom. Namun, apa yang terjadi ketika Anda perlu mengintegrasikan ini ke dalam pekerjaan harian tim? Di situlah batasan-batasan mulai terlihat.

Batasan Hugging Face untuk Ringkasan Teks

Hugging Face adalah pilihan yang bagus jika Anda menginginkan fleksibilitas dan kontrol. Namun, begitu Anda mencoba menggunakannya untuk alur kerja tim yang sebenarnya (bukan hanya notebook demo), beberapa tantangan yang dapat diprediksi muncul dengan cepat.

Batasan token dan masalah dokumen panjang

Sebagian besar model ringkasan memiliki panjang input maksimum yang tetap. Misalnya, facebook/bart-large-cnn dikonfigurasi dengan max_position_embeddings = 1024. Artinya, dokumen yang lebih panjang seringkali memerlukan pemotongan atau pembagian menjadi bagian-bagian.

Jika Anda hanya membutuhkan baseline cepat, Anda dapat mengaktifkan pemotongan dalam pipeline dan melanjutkan. Namun, jika Anda membutuhkan ringkasan dokumen panjang yang akurat, Anda biasanya harus membangun logika pemotongan dan kemudian melakukan putaran kedua, "ringkasan dari ringkasan," untuk menggabungkan hasilnya. Itu adalah pekerjaan tambahan, dan mudah menghasilkan output yang tidak konsisten.

Risiko halusinasi (dan beban verifikasi)

Model abstrak terkadang dapat menghasilkan teks yang terdengar masuk akal tetapi secara faktual salah. Untuk penggunaan kritis dalam bisnis, hal ini menimbulkan masalah: setiap ringkasan memerlukan verifikasi manual. Pada titik itu, Anda sebenarnya tidak menghemat waktu, melainkan hanya memindahkan pekerjaan ke bagian lain dari proses.

Kurangnya kesadaran konteks

Model Hugging Face hanya mengetahui teks yang Anda berikan kepadanya. Ia tidak memahami tujuan proyek Anda, orang-orang yang terlibat, atau bagaimana satu dokumen berhubungan dengan yang lain, sehingga kekurangan kecerdasan konteks yang dimiliki sistem modern. Ia tidak dapat memberitahu Anda jika ringkasan dari panggilan pelanggan bertentangan dengan dokumen persyaratan proyek, karena ia beroperasi secara terisolasi.

Beban integrasi (masalah "last mile")

Membuat ringkasan biasanya bagian yang mudah. Hambatan sebenarnya ada pada langkah selanjutnya.

Ke mana ringkasan itu pergi? Siapa yang melihatnya? Bagaimana ringkasan itu diubah menjadi tugas yang dapat ditindaklanjuti? Bagaimana Anda menghubungkannya dengan pekerjaan yang memicunya?

Menyelesaikan "last mile" berarti membangun integrasi kustom dan kode penghubung. Hal ini menambah beban kerja pengembang di awal, dan seringkali menciptakan alur kerja yang rumit bagi orang lain.

Hambatan teknis dan pemeliharaan berkelanjutan

Pendekatan berbasis Python umumnya hanya dapat diakses oleh orang yang bisa coding. Hal ini menciptakan hambatan praktis bagi tim pemasaran, penjualan, dan operasional, yang berarti adopsi tetap terbatas.

Ini juga disertai dengan pemeliharaan berkelanjutan: mengelola dependensi, memperbarui perpustakaan, dan memastikan semuanya tetap berfungsi seiring perkembangan API dan model. Apa yang awalnya terlihat sebagai solusi cepat bisa perlahan-lahan menjadi sistem lain yang perlu dipantau secara terus-menerus.

📮 ClickUp Insight: 42% gangguan di tempat kerja berasal dari berpindah-pindah platform, mengelola email, dan berpindah-pindah antara rapat. Bagaimana jika Anda dapat menghilangkan gangguan-gangguan yang mahal ini? ClickUp menggabungkan alur kerja Anda (dan obrolan) di bawah satu platform yang terintegrasi. Luncurkan dan kelola tugas Anda dari obrolan, dokumen, papan tulis, dan lainnya, sementara fitur-fitur bertenaga AI menjaga konteks tetap terhubung, dapat dicari, dan terkelola.

Masalah yang lebih besar: Penyebaran konteks

Bahkan jika skrip ringkasan Anda berfungsi dengan sempurna, tim Anda tetap bisa kehilangan waktu karena outputnya terputus dari tempat di mana pekerjaan sebenarnya dilakukan.

Itulah yang disebut " context sprawl", ketika tim menghabiskan berjam-jam mencari informasi, berpindah antar aplikasi, dan mencari berkas di platform yang terputus-putus.

Inilah di mana ruang kerja terintegrasi mengubah permainan. Alih-alih menghasilkan ringkasan di satu tempat dan mencoba "memindahkannya ke pekerjaan" nanti, sistem terintegrasi menjaga proyek, dokumen, dan percakapan tetap bersatu, dengan ClickUp Brain tertanam sebagai lapisan kecerdasan. Ringkasan Anda tetap terhubung dengan tugas dan Dokumen, sehingga langkah selanjutnya jelas, dan serah terima dilakukan secara instan.

Ringkasan yang Berubah Menjadi Tindakan dengan ClickUp

Sebuah skrip ringkasan dapat berfungsi dengan sempurna namun tetap gagal membantu tim Anda dalam satu cara yang mengganggu: ringkasan tersebut akhirnya berada di tempat terpisah dari pekerjaan.

Kesenjangan tersebut menyebabkan penyebaran konteks, di mana informasi tersebar di berbagai dokumen, obrolan, tugas, dan "catatan cepat" dalam alat yang tidak terhubung. Orang-orang menghabiskan lebih banyak waktu mencari ringkasan daripada menggunakannya. Keuntungan sebenarnya bukan hanya menghasilkan ringkasan. Melainkan menjaga agar ringkasan tersebut terkait dengan keputusan, pemilik, dan langkah selanjutnya di mana pekerjaan sebenarnya dilakukan.

Itulah yang membedakan ClickUp Brain. Ia merangkum tugas, dokumen, dan percakapan di dalam ruang kerja yang sama tempat proyek Anda berada, sehingga tim Anda dapat memahami sesuatu dan bertindak tanpa perlu berpindah alat.

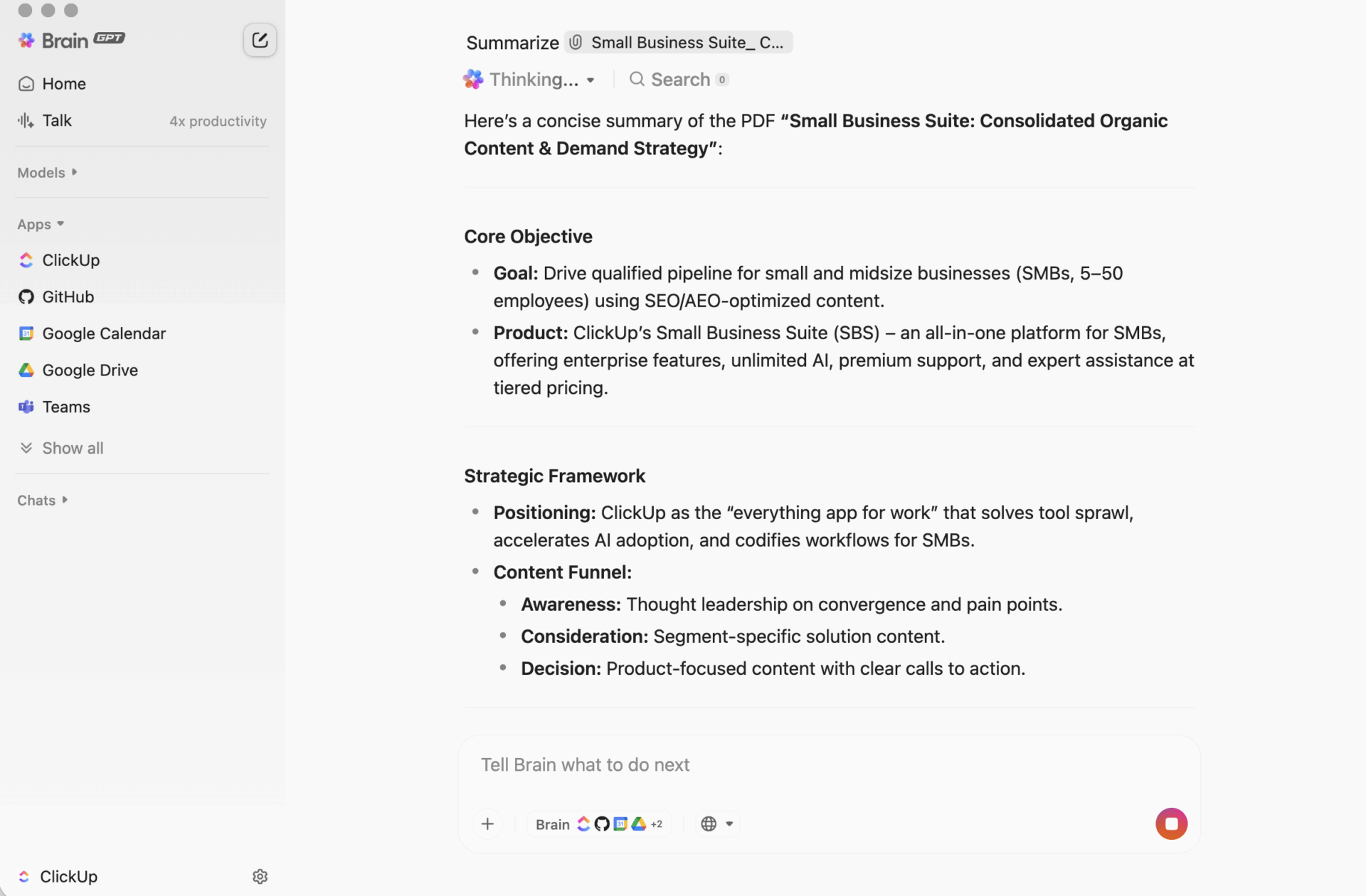

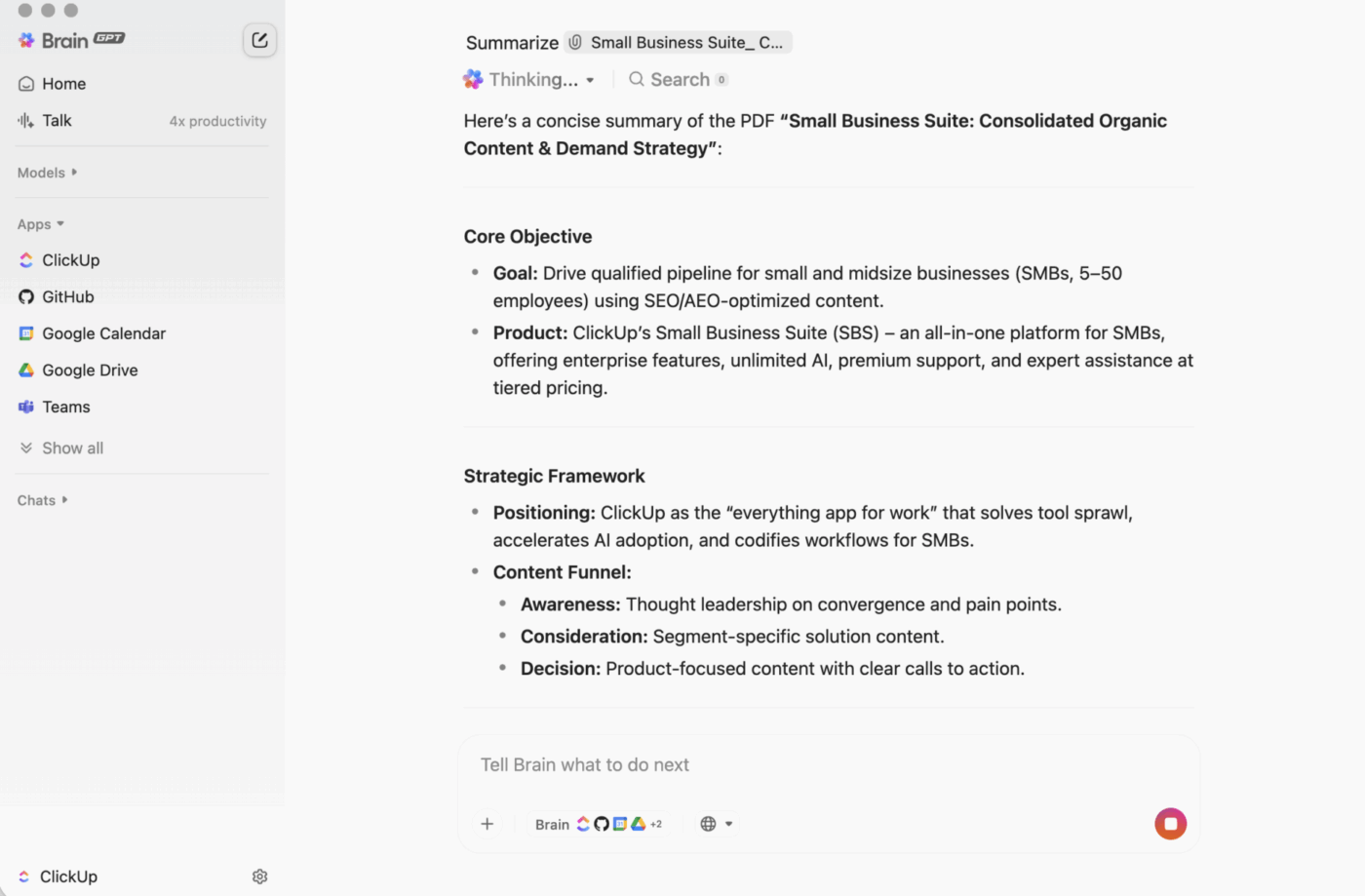

ClickUp BrainGPT: berinteraksi dengan ringkasan menggunakan bahasa alami

Di desktop, BrainGPT adalah antarmuka percakapan untuk ClickUp Brain. Alih-alih membuka skrip, notebook, atau alat AI eksternal, tim Anda dapat meminta apa yang mereka butuhkan dalam bahasa biasa, langsung di ClickUp.

Anda dapat mengetik (atau menggunakan fitur bicara-ke-teks) untuk:

- Ringkas deskripsi tugas yang panjang, thread komentar, atau dokumen.

- Tindak lanjut dengan pertanyaan seperti “Apa langkah selanjutnya?” atau “Siapa yang bertanggung jawab atas ini?”

- Ubah ringkasan menjadi tindakan dengan membuat tugas dari ringkasan tersebut, lengkap dengan pemilik dan tanggal jatuh tempo.

Karena ClickUp Brain beroperasi di dalam ruang kerja Anda, outputnya didasarkan pada konteks langsung: deskripsi tugas, komentar, subtugas, dokumen tertaut, dan struktur proyek. Anda tidak perlu menyalin teks ke alat terpisah dan berharap tidak ada informasi penting yang terlewat.

Mengapa ini lebih unggul daripada alur kerja ringkasan berbasis kode untuk kebanyakan tim

Alur kerja yang dibangun oleh pengembang dapat menghasilkan ringkasan yang kuat. Masalah muncul setelah itu, ketika seseorang harus menyalin output ke tempat di mana pekerjaan dilakukan, lalu menerjemahkannya menjadi tugas, lalu memastikan pelaksanaannya.

ClickUp Brain menutup lingkaran tersebut:

Tidak memerlukan pemrogramanSiapa pun di tim dapat merangkum dokumen, thread tugas, atau kumpulan komentar yang berantakan tanpa perlu menginstal apa pun atau menulis kode.

Ringkasan yang sadar konteksClickUp Brain dapat menyertakan bagian-bagian yang biasanya terlupakan: keputusan yang tersembunyi dalam komentar, hambatan yang disebutkan dalam balasan, dan subtugas yang mengubah arti "selesai".

Ringkasan berada di tempat kerja berlangsungAnda dapat mengejar ketinggalan di dalam tugas, menambahkan ringkasan di bagian atas ClickUp Docs, atau merangkum diskusi dengan cepat tanpa perlu membuat dokumen ringkasan lain yang tidak pernah diperiksa.

Kurangi kerumitan alat Anda tidak memerlukan skrip terpisah, Jupyter notebooks, kunci API, atau alur kerja yang hanya dipahami oleh satu orang. Dokumen, Tugas, dan ringkasan Anda semua tetap berada dalam sistem yang sama.

Inilah keunggulan praktis dari ruang kerja terintegrasi: ringkasan, tindakan, dan kolaborasi terjadi secara bersamaan, bukan disatukan setelahnya.

Inilah keunggulan praktis dari ruang kerja terintegrasi: ringkasan, tindakan, dan kolaborasi terjadi secara bersamaan, bukan disatukan setelahnya.

Bagaimana cara kerjanya dalam kehidupan nyata

Berikut adalah beberapa pola umum yang digunakan oleh tim:

- Ringkas thread komentar: buka tugas dengan diskusi panjang, klik opsi AI, dan dapatkan ringkasan cepat tentang apa yang berubah dan apa yang penting.

- Ringkas Dokumen: Buka dokumen ClickUp dan gunakan "Ask AI" untuk menghasilkan ringkasan halaman sehingga siapa pun dapat memahami isi dokumen dengan cepat.

- Ekstrak tindakan: ambil ringkasan dan segera ubah langkah-langkah berikutnya menjadi tugas dengan penanggung jawab dan batas waktu, sehingga momentum tidak hilang saat serah terima.

| Kemampuan | Hugging Face (berbasis kode) | ClickUp Brain |

|---|---|---|

| Persyaratan pengaturan | Lingkungan Python, perpustakaan, pemrograman | Tidak ada, bawaan |

| Kesadaran konteks | Teks saja (yang Anda masukkan) | Kontekstualisasi ruang kerja penuh (tugas, Dokumen, komentar, subtugas) |

| Integrasi alur kerja | Ekspor/impor manual | Native: ringkasan dapat diubah menjadi tugas dan pembaruan. |

| Keterampilan teknis yang diperlukan | Tingkat pengembang | Siapa pun di tim |

| Pemeliharaan | Pemeliharaan model dan kode yang berkelanjutan | Pembaruan otomatis |

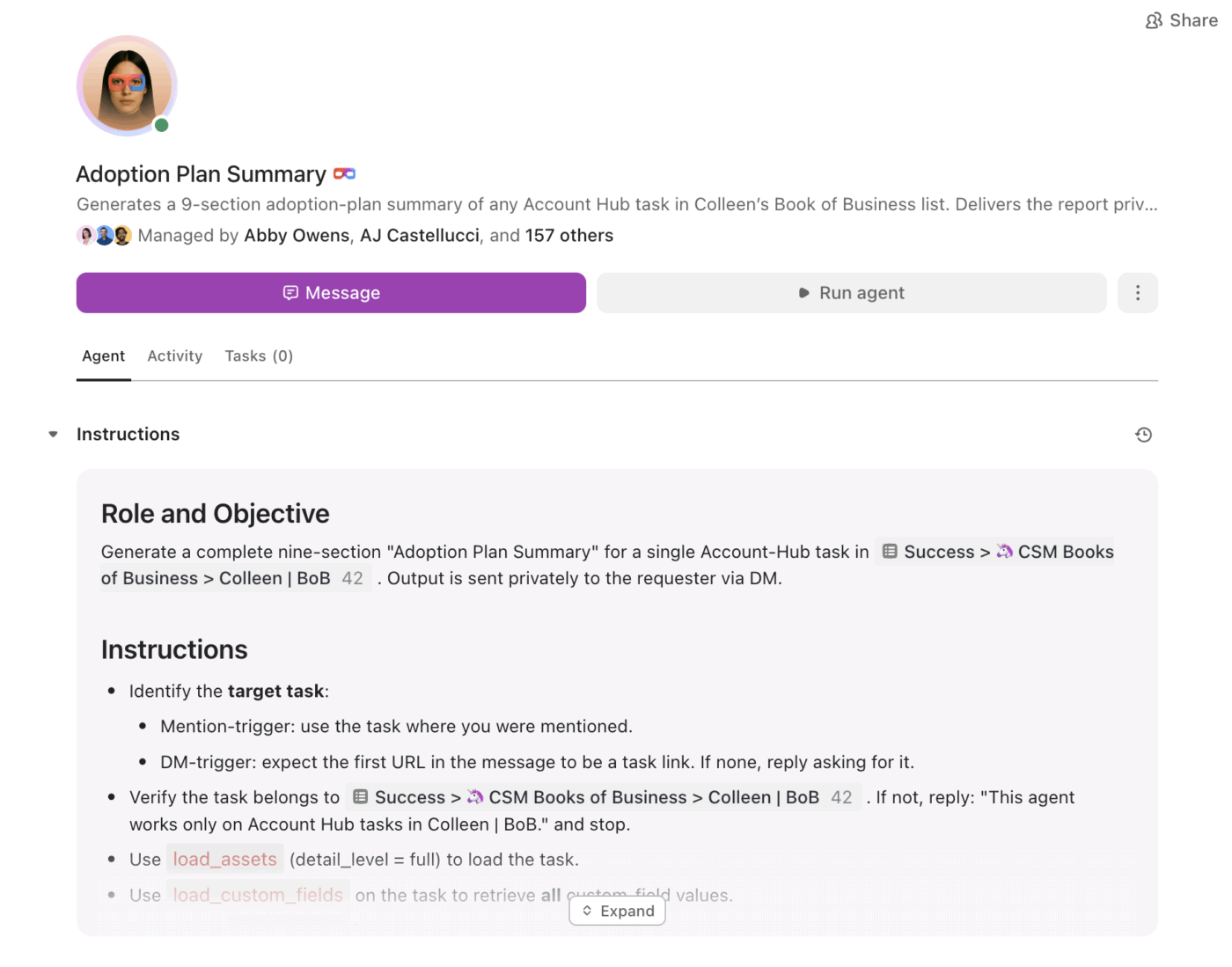

Dari ringkasan hingga eksekusi dengan Super Agents

Ringkasan sangat berguna. Bagian yang sulit adalah memastikan ringkasan tersebut secara konsisten diimplementasikan, terutama saat volume meningkat.

Di situlah ClickUp Super Agents berperan. Mereka dapat menggunakan informasi ringkasan dan melanjutkan pekerjaan berdasarkan pemicu dan kondisi, di dalam ruang kerja yang sama.

Dengan Super Agents, tim dapat:

- Ringkas perubahan sesuai jadwal (ringkasan proyek mingguan, ringkasan status harian)

- Ekstrak item tindakan dan tetapkan pemilik secara otomatis

- Tandai pekerjaan yang terhenti (tugas yang terjebak dalam tinjauan, thread yang belum dijawab, langkah selanjutnya yang terlambat)

- Jaga visibilitas kepemimpinan tetap tinggi tanpa pelaporan manual

Alih-alih ringkasan hanya berupa teks statis, agen membantu memastikan ringkasan menjadi rencana, dan rencana menjadi kemajuan.

Ringkasan yang hadir di tempat kerja berlangsung

Hugging Face Transformers sangat berguna ketika Anda membutuhkan aplikasi kustom, alur kerja khusus, atau kendali penuh atas perilaku model.

Namun, bagi kebanyakan tim, masalah yang lebih besar bukanlah “Bisakah kita merangkum ini?” Melainkan “Bisakah kita merangkum ini dan langsung mengubahnya menjadi pekerjaan, dengan penanggung jawab, batas waktu, dan visibilitas?”

Jika tujuan Anda adalah produktivitas tim dan eksekusi cepat, ClickUp Brain memberikan ringkasan dalam konteks, tepat di tempat kerja berlangsung, dengan jalur yang jelas dari “ini intinya” hingga “ini yang akan kita lakukan selanjutnya.”

Siap untuk melewati proses pengaturan dan mulai merangkum di tempat kerja Anda sebenarnya? Mulailah secara gratis dengan ClickUp dan biarkan Brain menangani pekerjaan beratnya.