La confidentialité est un droit humain fondamental. Et cette confidentialité s'étend également à tous les aspects de l'IA actuelle. Dans un rapport publié par Cisco, 64 % des personnes interrogées craignent de partager accidentellement des informations sensibles lorsqu'elles utilisent des outils d'IA.

C'est l'une des raisons pour lesquelles les outils d'IA hors ligne gagnent en popularité. Lorsque le modèle fonctionne localement, vous pouvez écrire, code, résumer et créer sans tout télécharger sur le cloud ni être bloqué en cas de coupure du Wi-Fi.

Dans cette liste, nous présenterons les meilleurs outils d'IA qui fonctionnent hors ligne, parmi lesquels une super application qui vous aide à organiser ce que ces outils produisent en un système cohérent et ultra sécurisé.

Que sont les outils d'IA hors ligne ?

Les outils d'IA hors ligne sont des applications logicielles qui exécutent des modèles linguistiques volumineux (LLM) sur votre appareil local, sans nécessiter de connexion Internet après avoir téléchargé le modèle. Les données du modèle sont stockées directement sur votre ordinateur, de sorte que tout le traitement, ou l'inférence, s'effectue sur votre propre CPU ou GPU.

Ce traitement sur l'appareil présente plusieurs avantages clés :

- Confidentialité totale des données : vos informations sensibles ne quittent jamais votre ordinateur.

- Pas de frais récurrents : une fois que vous disposez de l'outil et du modèle, il n'y a pas de frais d'abonnement.

- Fonctionne partout : vous pouvez l'utiliser dans un avion, dans une cabane isolée ou pendant une panne d'Internet.

- Contrôle total : vous choisissez les modèles à utiliser et la manière de les configurer.

Les meilleurs outils d'IA hors ligne en un coup d'œil

Voici un bref résumé des meilleurs outils d'IA hors ligne disponibles aujourd'hui.

| Nom de l'outil | Fonctionnalités principales | Idéal pour | Tarification* |

| ClickUp | Mode hors ligne pour les tâches et les rappels, ClickUp Brain MAX qui comprend la fonction Talk-to-Text, la recherche d'entreprise dans les applications connectées, la gestion des documents et des connaissances, les automatisations, ainsi que les intégrations et l'API. | Équipes qui ont besoin d'une capture hors ligne, d'une exécution en ligne, d'une gouvernance et d'un contexte IA dans un seul environnement de travail | Gratuit pour toujours ; personnalisation disponible pour les entreprises |

| GPT4Tous | Discuter localement avec des modèles ouverts, LocalDocs pour les questions-réponses privées sur les documents, découvrir et télécharger des modèles dans l'application, serveur API local compatible avec OpenAI. | Utilisateurs soucieux de la confidentialité qui souhaitent disposer d'un chatbot de bureau hors ligne simple avec des documents locaux. | Forfait Free disponible ; forfaits payants à partir de 40 $ par utilisateur et par mois |

| LM Studio | Découverte et téléchargement de modèles, interface utilisateur de chat et RAG local, serveur compatible OpenAI ou API REST, préréglages et optimisation des performances | Développeurs et utilisateurs expérimentés qui souhaitent disposer d'un atelier de modélisation hors ligne perfectionné | Free |

| Ollama | Modèle de commande unique, API REST locale avec streaming, fichiers Modelfiles pour les configurations réutilisables et intégrations pour les pipelines RAG. | Développeurs qui souhaitent disposer d'un environnement d'exécution local axé sur l'interface CLI avec une couche API robuste | Forfait Free disponible ; forfaits payants à partir de 20 $/mois |

| Janvier / IA | Interface utilisateur hors ligne de type ChatGPT, assistants et assistance MCP, extensions pour des fonctionnalités supplémentaires et fournisseurs compatibles OpenAI en option. | Utilisateurs non techniques qui souhaitent disposer d'un assistant hors ligne épuré et personnalisé. | Gratuit et open source |

| Llamafile | Modèle exécutable unique, distribution portable sur tous les systèmes d'exploitation, mode serveur local avec interface utilisateur Web et API, environnement d'exécution à dépendances minimales. | Les utilisateurs qui souhaitent disposer d'un fichier IA portable sans installation, qu'ils peuvent exécuter n'importe où. | Gratuit et open source |

| PrivateGPT | Ingestion et indexation de documents auto-hébergés, questions-réponses RAG hors ligne, filtrage contextuel par document, LLM modulaire et pile de stockage vectoriel | Teams qui ont besoin d'une fonction de questions-réponses hors ligne sur des fichiers internes avec un pipeline RAG contrôlable | Gratuit et open source |

| Whisper. cpp | Reconnaissance vocale locale, modèles quantifiés pour une utilisation réduite des ressources, assistance VAD, gestion FFmpeg en option pour davantage de formats | Les utilisateurs qui ont besoin d'une transcription entièrement hors ligne qu'ils peuvent intégrer dans des applications | Gratuit et open source |

| Interface utilisateur Web pour la génération de texte | Interface utilisateur basée sur un navigateur pour les modèles locaux, les modèles d'invite Jinja2, les contrôles de génération, les ramifications de chat et la modification en cours des messages. | Les utilisateurs qui souhaitent une personnalisation maximale dans une interface Web locale | Gratuit et open source |

| llama.cpp | Moteur d'inférence haute performance, assistance étendue pour la quantification, serveur local avec points de terminaison de type OpenAI, intégrations et assistance pour le reclassement. | Développeurs créant des applications ou des backends IA hors ligne personnalisés | Gratuit et open source |

Comment nous évaluons les logiciels chez ClickUp

Notre équipe éditoriale suit un processus transparent, fondé sur la recherche et indépendant des fournisseurs, vous pouvez donc être sûr que nos recommandations sont basées sur la valeur réelle des produits.

Voici un aperçu détaillé de la manière dont nous évaluons les logiciels chez ClickUp.

Ce qu'il faut rechercher dans les meilleurs outils d'IA qui fonctionnent hors ligne

Évaluer des outils d'IA hors ligne peut sembler technique et déroutant, ce qui peut vous amener à choisir un outil qui ne fonctionnera peut-être même pas sur votre ordinateur. Le plus important est de déterminer ce que vous souhaitez accomplir. Un développeur qui crée une application basée sur l'IA a des besoins très différents de ceux d'une personne qui souhaite simplement disposer d'un chatbot privé et hors ligne pour l'aider à rédiger des textes.

Voici les clés principales à évaluer :

- Facilité d'installation : nécessite-t-elle des connaissances techniques et du travail sur la ligne de commande, ou s'agit-il d'une simple installation en un clic ?

- Sélection des modèles : Pouvez-vous facilement choisir parmi une grande variété de modèles, ou êtes-vous limité à quelques-uns seulement ?

- Garanties de confidentialité : l'outil traite-t-il toutes les données localement ou existe-t-il des composants cloud cachés ?

- Configuration matérielle requise : Le logiciel fonctionnera-t-il correctement sur votre ordinateur actuel ou devez-vous le mettre à niveau ?

- Capacités d'intégration : Peut-il effectuer une connexion avec vos autres outils ou s'agit-il d'une application totalement autonome ?

- Adéquation avec le cas d'utilisation : Est-il conçu pour discuter, pour poser des questions sur vos documents, pour transcrire des fichiers audio ou pour générer du code ?

Les 10 meilleurs outils d'IA fonctionnant hors ligne

Voici une vue d'ensemble des meilleurs outils d'IA hors ligne 👇

1. ClickUp (idéal pour conserver les tâches, les documents et le contexte IA au même endroit, que ce soit pour le travail en ligne ou hors ligne)

ClickUp, le premier environnement de travail convergent basé sur l'IA au monde, repose sur les blocs de l'« IA hors ligne », qui ne se contente pas de générer une réponse. En effet, vous avez toujours besoin d'un endroit où cette réponse peut être transformée en décision, en tâche et en étape suivante, sans disparaître dans des fichiers et des discussions.

Et contrairement à de nombreuses installations hors ligne qui nécessitent des installations longues et l'assemblage d'outils, ClickUp vous offre une couche d'exécution complète en un seul endroit, avec une IA qui fonctionne dans le même contexte d'espace de travail.

Pour commencer, vous disposez du mode hors ligne ClickUp, qui s'active automatiquement et permet de continuer à travailler lorsque vous êtes hors ligne. Cela signifie que toutes vos tâches, rappels et notes restent accessibles même lorsque vous êtes hors ligne, et que vous pouvez en ajouter d'autres si nécessaire. Une fois reconnecté, les nouvelles tâches et les nouveaux rappels se synchronisent automatiquement avec votre environnement de travail (dites adieu à la perte de contexte 👋).

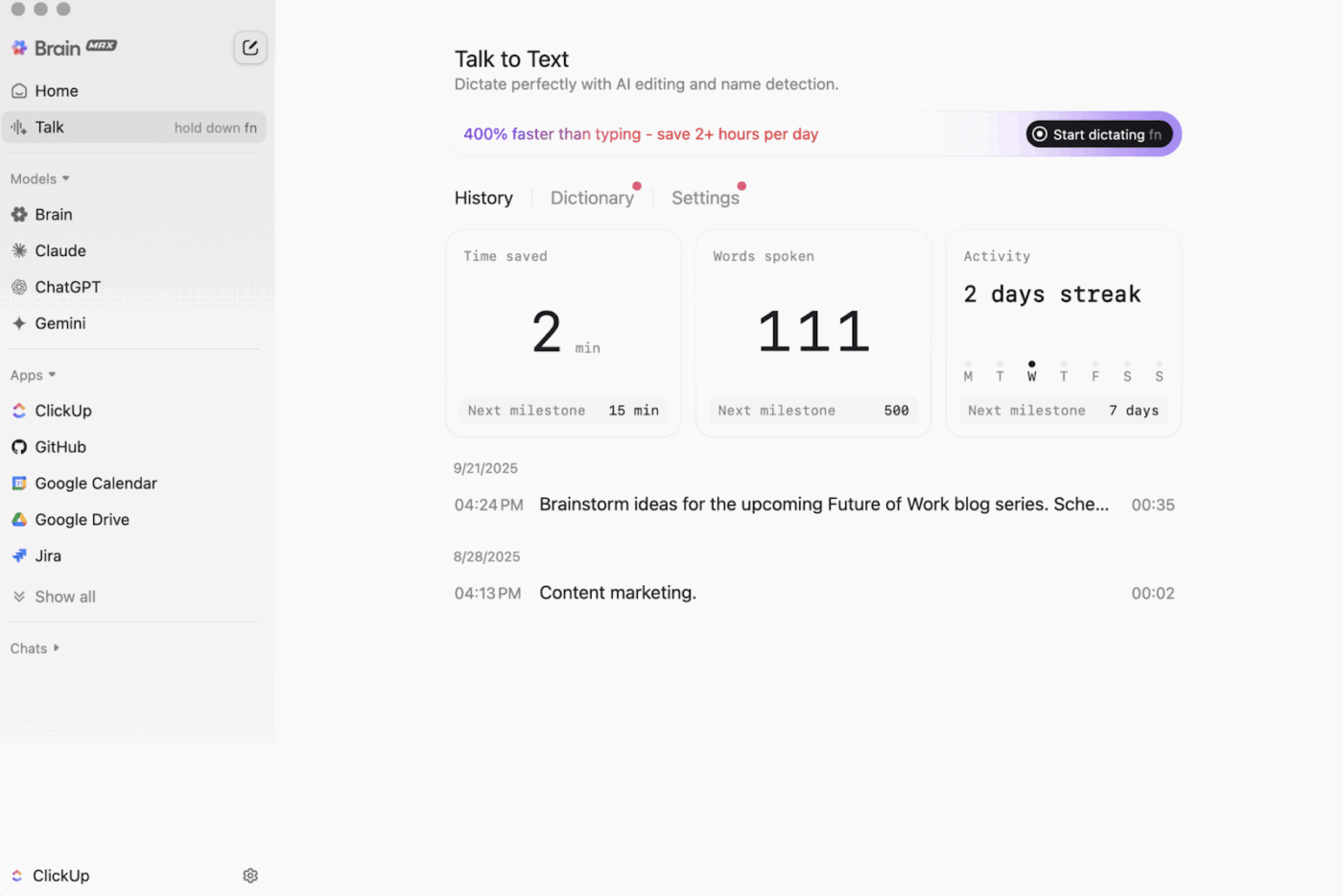

Il y a aussi ClickUp Brain MAX , l'assistant IA pour ordinateur de bureau qui privilégie la confidentialité et qui peut stocker et effectuer des recherches dans l'ensemble de votre espace de travail, vos applications connectées et même sur le Web.

Grâce à la fonction Talk-to-Text , Brain MAX peut convertir votre voix en texte sans que vous ayez à utiliser vos mains. Cela inclut la rédaction d'un e-mail, la création d'un document ou la saisie d'une mise à jour rapide pendant que vous êtes en déplacement.

Brain MAX vous offre également Universal AI, conçu pour discuter avec les derniers modèles d'IA pour le codage, l'écriture, le raisonnement complexe, et plus encore. Cela signifie que vous pouvez poser des questions aux meilleurs modèles d'IA en un seul endroit, y compris ClickUp Brain et des options telles que OpenAI, Claude et Gemini, sans avoir à activer/désactiver les outils.

De plus, ClickUp Security ajoute des garde-fous que les outils hors ligne ignorent souvent. Pensez au chiffrement, aux permissions granulaires et aux contrôles d'administrateurs tels que l'authentification unique (SSO), l'approvisionnement et les journaux d'audit, tous conçus pour les équipes qui ont besoin d'une sécurité de niveau entreprise.

La gestion des connaissances par l'IA ClickUp AI facilite considérablement le transfert « hors ligne vers en ligne ». Elle offre à votre équipe un hub de stockage de différentes ressources dans Docs et wikis, puis utilise ClickUp Brain pour extraire des réponses instantanées de l'ensemble de votre environnement de travail, afin que le contexte approprié soit disponible dès la reprise du travail.

🎬 Agents en action : Utilisez les Super Agents pour transformer le travail synchronisé en étapes suivantes !

Les super agents ClickUp sont des coéquipiers alimentés par l'IA que vous pouvez créer et personnaliser pour exécuter des flux de travail en plusieurs étapes dans votre environnement de travail ClickUp. Vous pouvez configurer des déclencheurs, des instructions et des accès aux outils spécifiques pour vous assurer qu'ils agissent dans les limites que vous avez fixées.

Par exemple, après avoir synchronisé les tâches hors ligne, un super agent peut analyser les nouveaux éléments, résumer les modifications, définir les étapes à suivre, rédiger une mise à jour et la transmettre au propriétaire concerné pour examen.

Et comme les Super Agents sont contrôlables, vous pouvez gérer ce à quoi ils ont accès grâce à des permissions et vérifier ce qu'ils font. 🔐

Les meilleures fonctionnalités de ClickUp

- Trouvez tout ce que vous cherchez dans vos outils : triez et effectuez des recherches dans l'ensemble de votre environnement de travail, ainsi que dans les applications connectées, à partir d'un seul endroit grâce à ClickUp Enterprise Search.

- Construisez une véritable base de connaissances : créez des wikis et de la documentation avec ClickUp Docs à l'aide de pages imbriquées, de modèles, d'une assistance IA, et plus encore.

- Restez connecté : synchronisez votre travail avec des outils tels que Slack et GitHub sans quitter ClickUp grâce aux intégrations ClickUp.

- Créez des flux de travail personnalisés : utilisez l'API ClickUp avec des jetons personnels ou OAuth 2. 0 pour mettre en place des automatisations et des intégrations personnalisées.

- Automatisez votre pile : déclenchez des actions telles que l'attribution de propriétaires, la mise à jour des statuts ou le lancement de transferts en fonction des changements de tâches grâce aux automatisations ClickUp.

Limitations de ClickUp

- En raison du large intervalle de fonctionnalités, certains utilisateurs peuvent rencontrer une courbe d'apprentissage.

Tarifs ClickUp

Évaluations et avis sur ClickUp

- G2 : 4,7/5 (plus de 10 000 avis)

- Capterra : 4,6/5 (plus de 4 000 avis)

Que disent les utilisateurs réels à propos de ClickUp ?

Un critique du G2 déclare :

Tableaux agiles, intégrations et personnalisation. J'apprécie également le fait de pouvoir me déconnecter tout en continuant à travailler sur mes tâches. De plus, je peux envoyer des e-mails à n'importe quelle liste et créer automatiquement des tâches. L'éditeur de texte est fabuleux, il fonctionne à la fois en mode MD et avec des raccourcis, ce qui vous permet de prévisualiser le contenu en ligne.

Tableaux agiles, intégrations et personnalisation. J'apprécie également le fait de pouvoir me déconnecter tout en continuant à travailler sur mes tâches. De plus, je peux envoyer des e-mails à n'importe quelle liste et créer automatiquement des tâches. L'éditeur de texte est fabuleux, il fonctionne à la fois en mode MD et avec des raccourcis, ce qui vous permet de prévisualiser le contenu en ligne.

2. GPT4All (Idéal pour discuter de manière privée hors ligne avec des modèles linguistiques locaux)

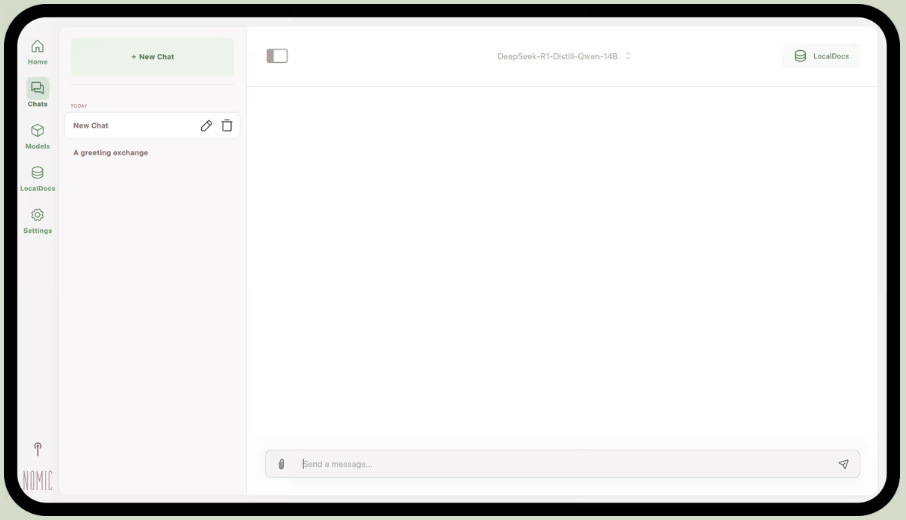

Faisant partie de Nomic.ai, GPT4All est une application de bureau qui vous permet d'exécuter des modèles linguistiques open source directement sur votre ordinateur, afin que vous puissiez discuter avec un assistant IA sans avoir besoin d'une connexion Internet ou d'appels API cloud. Elle est conçue pour les personnes qui souhaitent une installation « local-first », où les invites, les réponses et les fichiers restent sur l'appareil.

Sa meilleure fonctionnalité est LocalDocs, qui utilise une forme de génération augmentée par la récupération pour vous permettre de discuter en privé avec vos propres documents. Vous pouvez pointer l'application vers un dossier contenant des fichiers PDF ou des fichiers texte, et elle créera une base de connaissances locale à laquelle vous pourrez poser des questions.

GPT4All comprend également une bibliothèque sélectionnée de modèles populaires tels que Llama et Mistral, que vous pouvez télécharger directement via l'application.

Les meilleures fonctionnalités de GPT4All

- Démarrez un serveur API local (compatible OpenAI) pour utiliser les modèles GPT4All dans d'autres applications et automatisations.

- Recherchez, comparez et téléchargez des modèles GGUF depuis l'application, avec des options de tri telles que les mentions « J'aime », les téléchargements et la date de mise en ligne.

- Ajustez la longueur du contexte, la longueur maximale de sortie, top-p, top-k, la pénalité de répétition, les fils CPU et même le déchargement de la couche GPU (plus l’assistance Metal sur Apple Silicon).

Limitations de GPT4All

- Les performances sont fortement dépendantes du matériel informatique de votre ordinateur.

- L'indexation de grandes collections de documents peut être lente.

Tarifs GPT4All

- Application de bureau gratuite

- Entreprise : 40 $ par utilisateur et par mois (Nomic IA)

- Enterprise : Tarification personnalisée (Nomic IA)

Évaluations et avis sur GPT4All

- G2 : Pas assez d'avis

- Capterra : pas assez d'avis

Que disent les utilisateurs réels à propos de GPT4All ?

Un utilisateur de Reddit déclare :

C'est le meilleur que j'ai essayé avec RAG, il surpasse tout, même LM Studio, en termes de simplicité. J'aime la façon dont vous le mappez à un dossier, et il suit et gère les changements pour vous. Il est encore à ses débuts, comme les autres, mais ce sera mon choix par défaut à court terme.

C'est le meilleur que j'ai essayé avec RAG, il surpasse tout, même LM Studio, en termes de simplicité. J'aime la façon dont vous le mappez à un dossier, et il suit et gère les changements pour vous. Il est encore à ses débuts, comme les autres, mais ce sera mon choix par défaut à court terme.

📮 Insight ClickUp : 88 % des personnes interrogées dans le cadre de notre sondage utilisent l'IA pour leurs tâches personnelles, mais plus de 50 % hésitent à l'utiliser au travail. Les trois principaux obstacles ? Le manque d'intégration transparente, le manque de connaissances ou les préoccupations en matière de sécurité. Mais que se passerait-il si l'IA était intégrée à votre environnement de travail et était déjà sécurisée ? ClickUp Brain,

L'assistant IA intégré à ClickUp permet de concrétiser cette vision. Il comprend les requêtes formulées en langage naturel, résolvant ainsi les trois préoccupations liées à l'adoption de l'IA tout en assurant la connexion de vos discussions, tâches, documents et connaissances à travers l'environnement de travail. Trouvez des réponses et des informations en un seul clic !

3. LM Studio (idéal pour un environnement de travail hors ligne perfectionné avec optimisation des performances)

via LM Studio

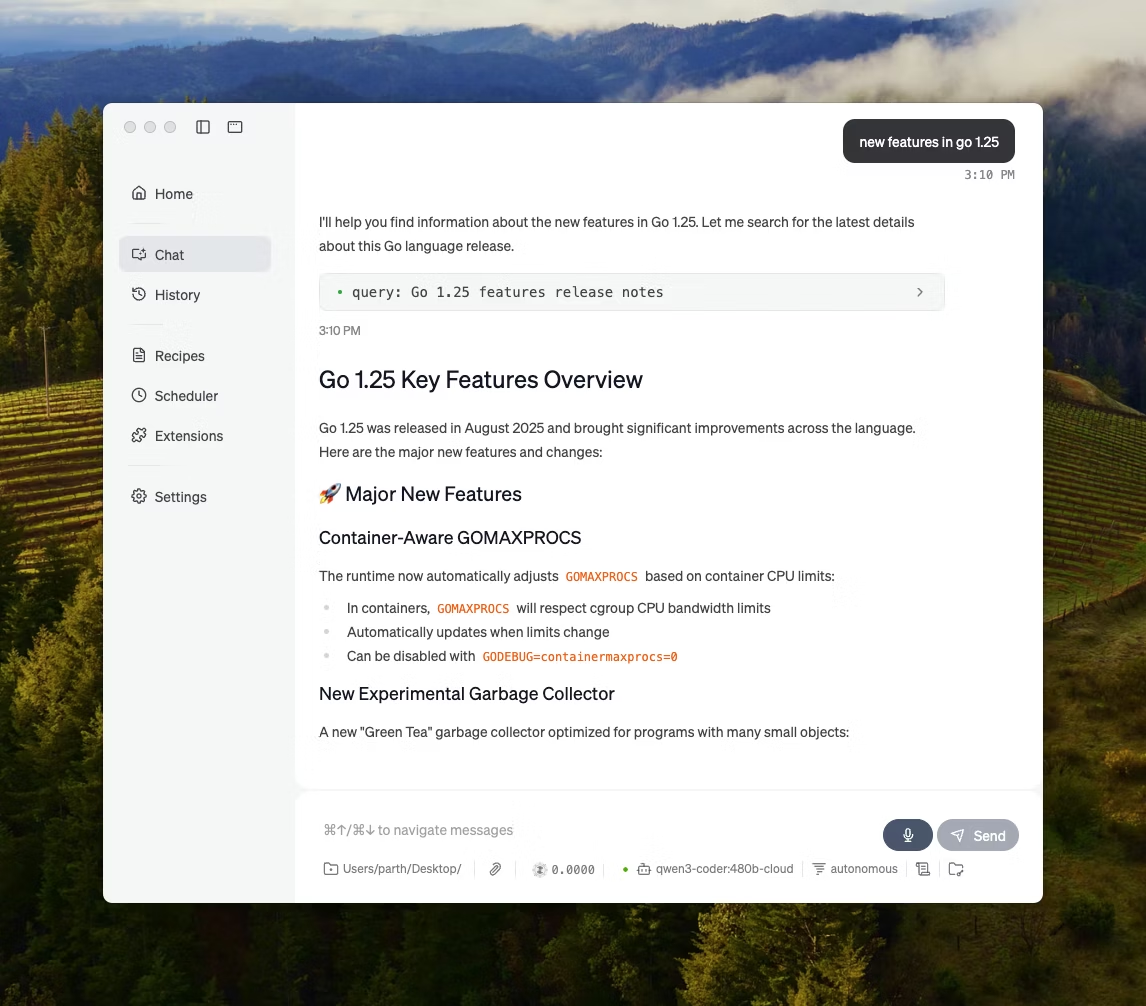

LM Studio est une application de bureau locale basée sur l'IA, conçue pour trouver, tester et exécuter des modèles open source dans une interface utilisateur, sans avoir à passer par un terminal. Elle est destinée à l'expérimentation, par exemple pour choisir un modèle, l'exécuter localement et itérer sur les invites et les paramètres avec une boucle de rétroaction plus étroite que la plupart des installations CLI-first.

Il prend également en charge la discussion avec des documents entièrement hors ligne (RAG local), où vous joignez des fichiers en tant que pièces jointes à une discussion et les référencez dans vos réponses. Cela le rend idéal pour la recherche hors ligne, les notes d'étude ou les flux de travail internes où les téléchargements ne sont pas possibles.

LM Studio vous offre également un contrôle précis sur le fonctionnement de l'IA, avec des options permettant d'ajuster la température, la longueur du contexte et l'utilisation du GPU.

Les meilleures fonctionnalités de LM Studio

- Utilisez le mode de compatibilité OpenAI ou l'API REST propre à LM Studio, selon les attentes de votre application.

- LM Studio est un fournisseur d'options SDK JavaScript et Python pour créer des flux de travail locaux à partir de vos modèles.

- Enregistrez une invite système + des paramètres en tant que préréglage, puis réutilisez-le dans vos discussions (les préréglages peuvent également être importés à partir d'un fichier/d'une URL et publiés pour être partagés via LM Studio Hub).

Limitations de LM Studio

- LM Studio peut bloquer l'ordinateur lors de l'exécution de DeepSeek R1 32B.

- Certains utilisateurs signalent l'application comme présentant un risque pour la sécurité des données et la confidentialité en raison de son code source fermé non audité.

Tarifs LM Studio

- Gratuit pour un usage domestique et professionnel

Évaluations et avis sur LM Studio

- G2 : Pas assez d'avis

- Capterra : pas assez d'avis

Que disent les utilisateurs réels à propos de LM Studio ?

Un utilisateur de Reddit déclare :

C'est génial. Ça fonctionne tout simplement, c'est très facile à mettre en route. L'interface utilisateur est la plus agréable de tous les concurrents.

C'est génial. Ça fonctionne tout simplement, c'est très facile à mettre en route. L'interface utilisateur est la plus agréable de tous les concurrents.

4. Ollama (idéal pour exécuter des LLM locaux avec une interface CLI simple + un serveur local)

Ollama est un modèle local qui se comporte davantage comme un runtime LLM que comme une application de chat autonome. Il s'agit d'un terminal conçu pour extraire et exécuter des modèles ouverts à l'aide de commandes rapides (comme ollama run llama3), puis les exposer via un service local sur lequel d'autres interfaces peuvent s'appuyer.

La force d'Ollama réside dans son API REST. Une fois qu'Ollama est exécuté en arrière-plan, n'importe quelle application peut communiquer avec lui via de simples requêtes HTTP. Cela vous aide à intégrer des fonctionnalités d'IA dans votre propre logiciel.

Ollama propose également une bibliothèque de modèles populaires qui peuvent être téléchargés à l'aide d'une seule commande. Vous pouvez également créer des configurations de modèles personnalisées, qui sont similaires aux fichiers Dockerfiles pour l'IA.

Les meilleures fonctionnalités d'Ollama

- Créer des recettes de modèles réutilisables et versionnables (sélection de modèles de base, modèles d'invites, messages système, paramètres, adaptateurs) à l'aide d'un fichier Modelfile.

- Exécutez des modèles via des points de terminaison tels que discuter/generate avec streaming optionnel pour une sortie de jetons en temps réel dans les applications et les scripts.

- Générez des intégrations pour les pipelines de recherche et de récupération sémantiques à l'aide de la fonctionnalité d'intégration d'Ollama et des modèles d'intégration recommandés.

Limites d'Ollama

- Il ne dispose pas d'interface graphique intégrée, les utilisateurs non techniciens auront donc besoin d'un outil frontal séparé.

- L'application de bureau macOS d'Ollama peut ne pas répondre lorsqu'elle est hors ligne, même lorsque les modèles ont déjà été téléchargés, tandis que l'interface CLI continue de fonctionner.

Tarification Ollama

- Free

- Pro : 20 $/mois

- Max : 100 $/mois

Évaluations et avis sur Ollama

- G2 : Pas assez d'avis

- Capterra : pas assez d'avis

Que disent les utilisateurs réels à propos d'Ollama ?

Un critique de Producthunt déclare :

Facile à déployer et à gérer. Ollama facilite considérablement l'exécution des LLM locaux. Associez-le à OpenWebUI pour une expérience optimale.

Facile à déployer et à gérer. Ollama facilite considérablement l'exécution des LLM locaux. Associez-le à OpenWebUI pour une expérience optimale.

🧠 Anecdote amusante : la conversion de la parole en texte a commencé par la reconnaissance des chiffres uniquement. Le système AUDREY (1952) des Bell Labs reconnaissait les chiffres 0 à 9, et selon un compte, il fonctionnait mieux lorsque c'était son inventeur qui parlait.

5. Jan. ai (Idéal pour un assistant hors ligne de type ChatGPT axé sur la confidentialité)

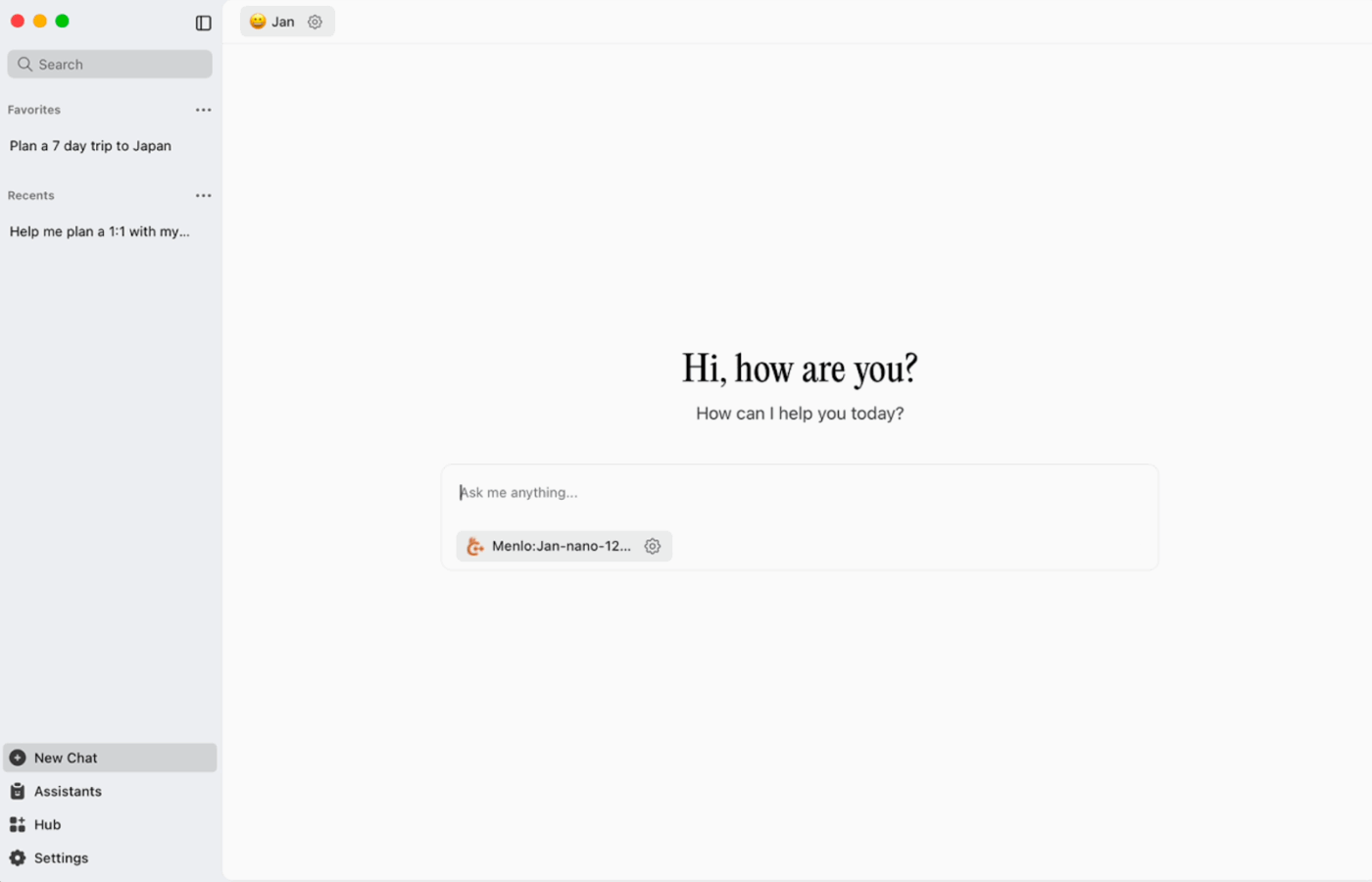

Jan. ai est un assistant de bureau open source qui offre une expérience de chat similaire à ChatGPT sur macOS, Windows et Linux, avec une utilisation locale par défaut. Il s'exécute sur l'appareil lorsque vous le souhaitez, tandis que l'historique des discussions et les données d'utilisation sont stockés localement et ne quittent pas votre ordinateur.

Il prend en charge l'exécution locale de modèles open source et permet également des connexions optionnelles à des fournisseurs distants tels que les API compatibles OpenAI, ce qui le rend flexible lorsque l'utilisation hors ligne a la priorité, mais que l'accès au cloud est parfois nécessaire.

Janvier : les meilleures fonctionnalités de l'IA

- Créez des assistants avec leurs propres instructions et paramètres, puis passez de l'un à l'autre à partir de l'onglet Assistants au lieu de réécrire les invites à chaque fois.

- Connectez Jan aux outils MCP et aux sources de données à l'aide d'une norme ouverte conçue pour les flux de travail de type « utilisation d'outils ».

- Installez des extensions pour ajouter de nouvelles fonctionnalités telles que la recherche sur le Web ou un interpréteur de code. Cette approche modulaire vous permet de commencer simplement et d'ajouter des fonctionnalités au fur et à mesure.

Janvier : limitations de l'IA

- Jan peut autoriser le chargement d'un fichier modèle qui n'a pas encore été entièrement téléchargé, ce qui peut entraîner un comportement confus ou incohérent jusqu'à ce que le fichier soit achevé.

- L'activation de l'API peut interférer avec les discussions en fil de discussion, et les points de terminaison de base tels que « get loaded model » (obtenir le modèle chargé) ou « swap model » (échanger le modèle) peuvent ne pas fonctionner correctement.

Janvier : prix de l'IA

- Code source libre

Janvier : évaluations et avis sur l'IA

- G2 : Pas assez d'avis

- Capterra : pas assez d'avis

Que disent les utilisateurs réels à propos de Jan. IA ?

Un utilisateur de Reddit déclare :

Jan. ai est ma application LLM locale préférée. Elle est géniale.

Jan. ai est mon application LLM locale préférée. Elle est géniale.

6. Llamafile (idéal pour intégrer un LLM dans un fichier exécutable portable)

Llamafile est un projet mené par Mozilla qui regroupe un LLM open source complet dans un seul fichier exécutable. Au lieu d'installer un runtime, de gérer les dépendances ou de connecter une interface utilisateur distincte, vous téléchargez un seul fichier et l'exécutez comme une application.

L'idée centrale est la distribution. Un « lamafile » comprend les poids du modèle ainsi qu'un runtime compilé, conçu pour fonctionner sur plusieurs systèmes d'exploitation avec une installation minimale. Il est particulièrement pratique lorsqu'un outil hors ligne doit être partagé avec des collègues, des étudiants ou des clients qui ne sont pas en mesure de résoudre les problèmes d'installation.

Les meilleures fonctionnalités de Llamafile

- Llamafile combine llama.cpp avec Cosmopolitan Libc pour prendre en charge une large portabilité binaire, réduisant ainsi le travail de packaging spécifique à chaque plateforme.

- Le mode serveur fournit une interface graphique Web ainsi qu'un point de terminaison de complétion compatible avec l'API OpenAI, utile pour le développement d'applications locales et le remplacement des appels cloud pendant les tests.

- Les fichiers lamafiles packagés sont conçus pour fonctionner sur les machines x86_64 et ARM64 courantes, ce qui simplifie la distribution sur des parcs mixtes.

Limitations de Llamafile

- La sélection des modèles est limitée à ce qui a été intégré dans un fichier Llamafile.

- La taille des fichiers est très importante, car le modèle complet est intégré.

Tarifs Llamafile

- Gratuit et open source

Évaluations et avis sur Llamafile

- G2 : Pas assez d'avis

- Capterra : pas assez d'avis

🧠 Anecdote amusante : le premier site web est toujours accessible. Le CERN l'héberge littéralement à l'adresse info.cern.ch, le qualifiant de « Accueil du premier site web ».

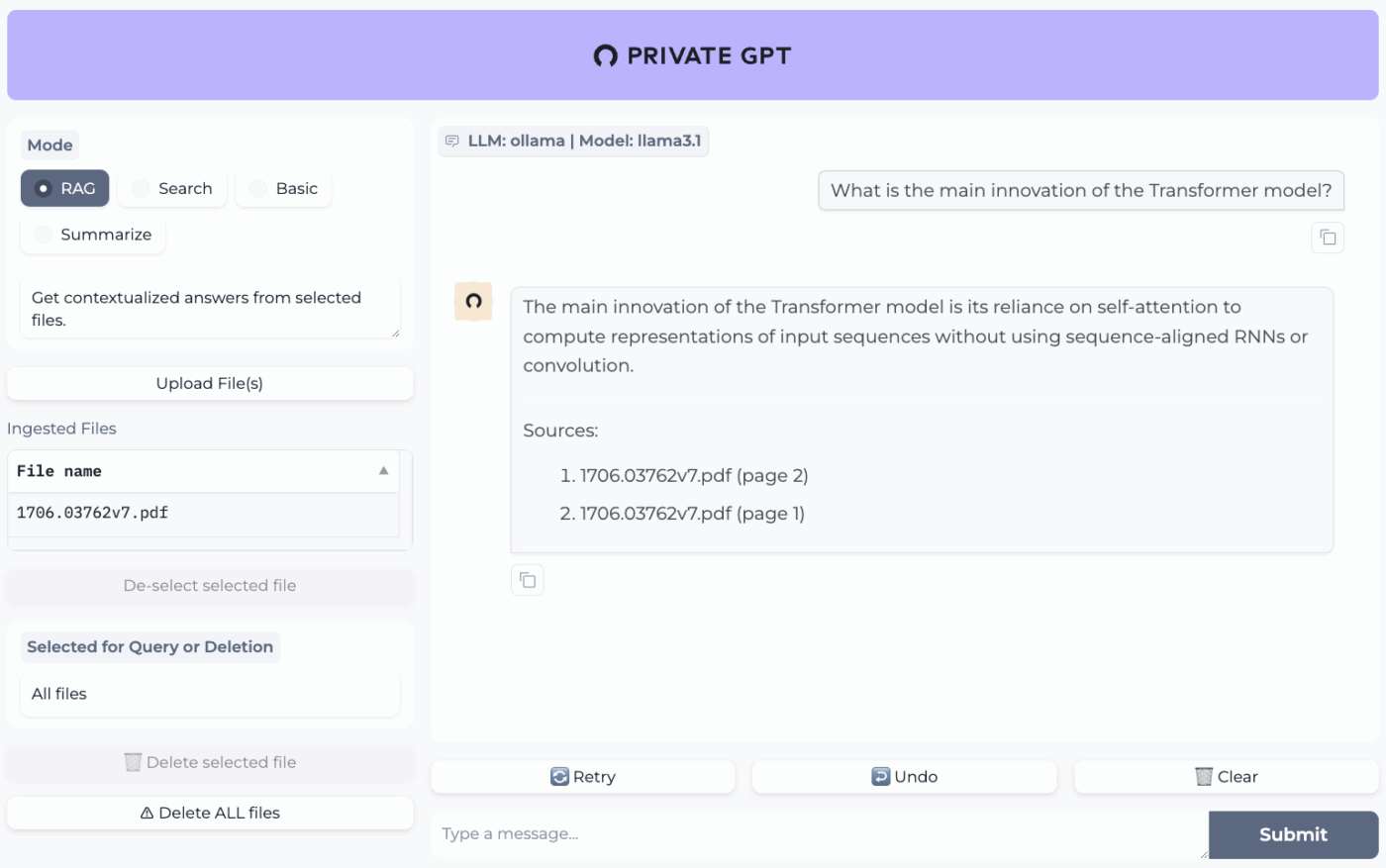

7. PrivateGPT (Idéal pour les questions-réponses hors ligne sur vos fichiers avec une pile RAG auto-hébergée)

PrivateGPT est un projet prêt à l'emploi et auto-hébergé, conçu pour les flux de travail de type « discutez avec vos documents ». Il ingère des fichiers locaux, les indexe et répond aux questions en récupérant le contexte pertinent à partir de votre propre contenu, plutôt que de s'appuyer sur la mémoire d'un chatbot cloud. Le projet est conçu pour fonctionner entièrement hors ligne, avec l'assurance que les données restent dans votre environnement d'exécution.

Ce qui le différencie des applications de chat hors ligne à usage général, c'est son architecture modulaire. En d'autres termes, vous pouvez combiner le LLM, le fournisseur d'intégration et le magasin de vecteurs en fonction de votre matériel et de vos contraintes de confidentialité, puis tout exécuter derrière une API + une interface utilisateur locales.

Les meilleures fonctionnalités de PrivateGPT

- Importez des fichiers PDF, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, des images (JPG/PNG/JPEG) et même des fichiers MP3/MP4 à l'aide du pipeline d'importation intégré.

- Configurez les profils de couche avec PGPT_PROFILES (par exemple, local, cuda) pour fusionner plusieurs fichiers de paramètres et changer de déploiement sans réécrire votre configuration de base.

- Filtrez les réponses à un sous-ensemble spécifique de documents ingérés à l'aide de context_filter lors de l'appel des points de terminaison de complétions contextuelles.

Limitations de PrivateGPT

- Nécessite une configuration matérielle plus puissante en raison de l'exécution simultanée de plusieurs composants.

- L'ingestion de plusieurs documents à partir d'un seul fichier (par exemple, un PDF générant un document par page) peut augmenter le volume et la complexité de l'indexation lors de la gestion de téléchargements volumineux.

Tarifs PrivateGPT

- Code source libre

Évaluations et avis sur PrivateGPT

- G2 : Pas assez d'avis

- Capterra : pas assez d'avis

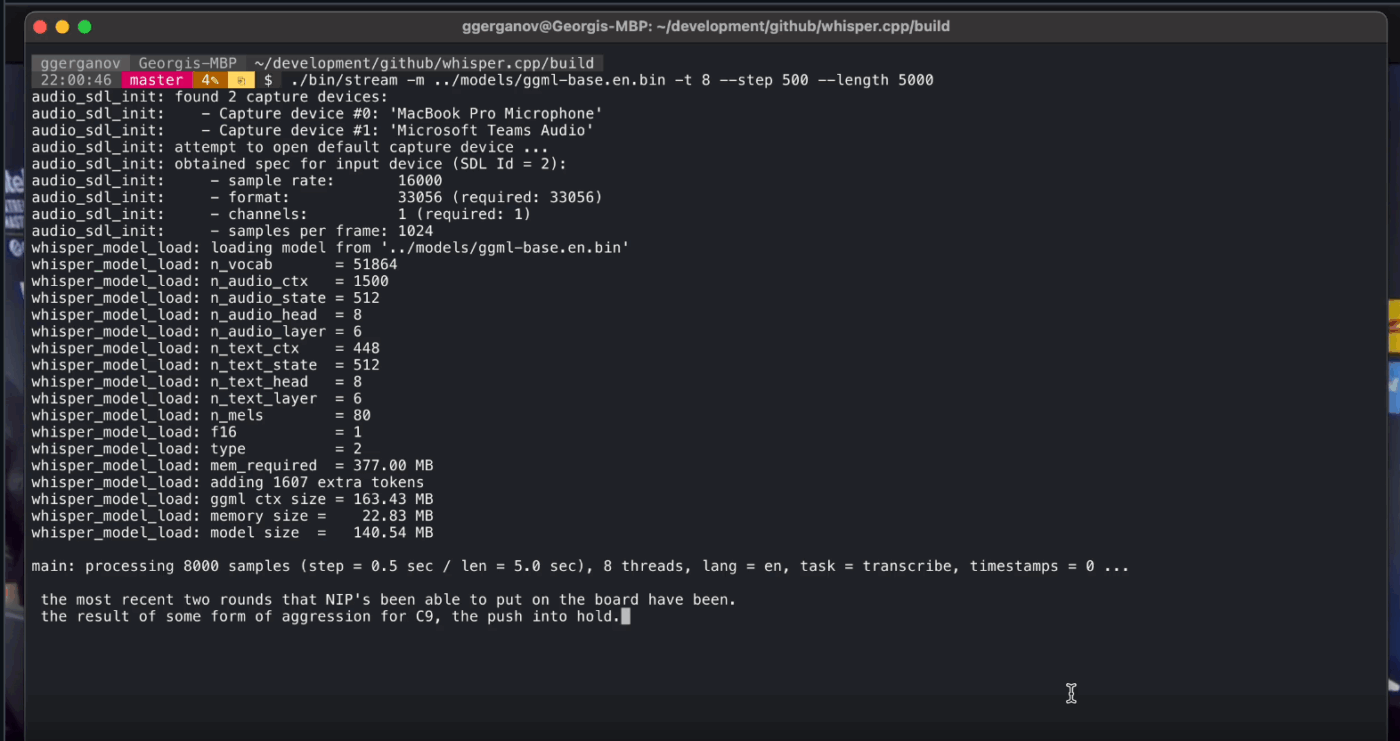

8. Whisper. cpp (Idéal pour la conversion voix-texte entièrement hors ligne que vous pouvez intégrer dans des applications)

Whisper. cpp est une implémentation C/C++ haute performance du modèle de reconnaissance vocale automatique Whisper d'OpenAI, conçue pour fonctionner localement sans dépendances d'exécution lourdes. Elle est très appréciée pour les pipelines de transcription hors ligne qui nécessitent un binaire compact et portable ou une bibliothèque de type C pouvant être intégrée à votre propre produit.

Il est également flexible dans tous les environnements, avec une assistance officielle couvrant les ordinateurs de bureau, les appareils mobiles, WebAssembly, Docker et même le matériel de type Raspberry Pi, ce qui le rend particulièrement adapté aux outils hors ligne qui doivent fonctionner à plusieurs endroits.

Le « cpp » dans son nom indique qu'il est axé sur la performance. Cette implémentation est nettement plus rapide et utilise moins de mémoire que les alternatives basées sur Python, ce qui rend possible la transcription en temps réel sur les ordinateurs modernes sans avoir besoin d'un GPU puissant.

Whisper. cpp meilleures fonctionnalités

- Exécutez la détection d'activité vocale (VAD) dans le cadre du projet afin de segmenter la parole et de réduire les transcriptions audio vides et bruyantes dans les flux de travail de type streaming.

- Modèles Quantize Whisper pour réduire les besoins en disque et en mémoire, avec plusieurs options de quantification conçues pour accélérer l'inférence locale.

- Compiler avec l'assistance FFmpeg optionnelle sous Linux pour prendre en charge davantage de formats d'entrée au-delà du chemin d'accès WAV de base.

Limitations de Whisper.cpp

- Whisper. La CLI de cpp attend par défaut des entrées WAV 16 bits, ce qui ajoute une étape de conversion supplémentaire lorsque vous travaillez avec des formats MP3, MP4, M4A ou d'autres formats courants.

- Il ne permet pas de libeller nativement les locuteurs (diarisation), ce qui rend difficile l'attribution correcte des citations dans les enregistrements à plusieurs locuteurs.

Prix de Whisper. cpp

- Code source libre

Whisper. Évaluations et avis sur cpp

- G2 : Pas assez d'avis

- Capterra : pas assez d'avis

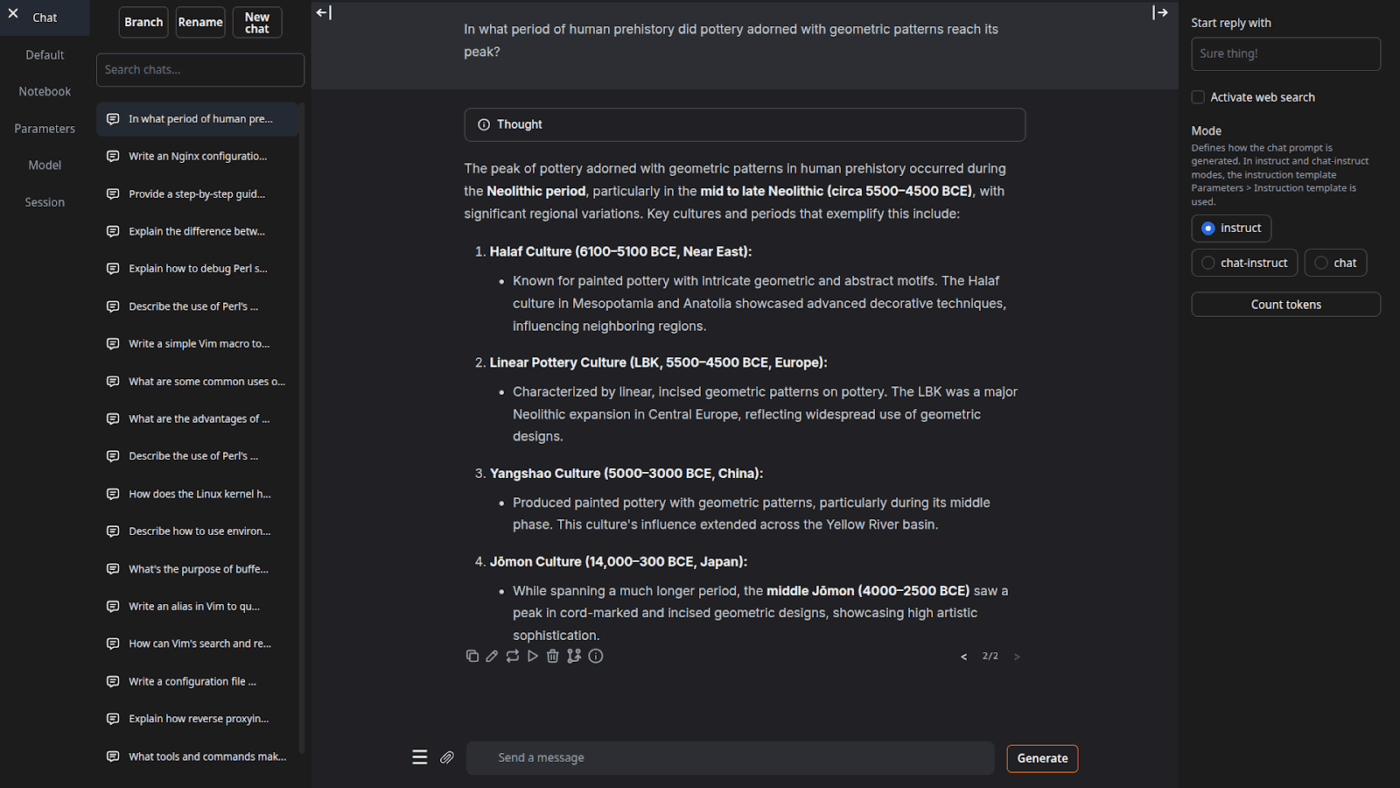

9. Interface utilisateur Web de génération de texte (idéale pour les utilisateurs qui souhaitent disposer d'un cockpit basé sur un navigateur pour les LLM locaux)

Text Generation Web UI (souvent appelé « oobabooga ») est une interface web basée sur Gradio qui permet d'exécuter des modèles locaux en mettant l'accent sur le contrôle et l'expérimentation. Elle se comporte davantage comme un atelier complet : plusieurs backends de modèles, plusieurs modes d'interaction et de nombreux boutons pour contrôler le comportement de génération.

Il s'appuie également sur des flux de travail « rédacteur/développeur » que de nombreux outils hors ligne ignorent, avec des fonctionnalités telles que l'automatisation du format des invites, la génération de style bloc-notes et les ramifications de discussion. Pour les installations hors ligne qui nécessitent encore une interface utilisateur Web, c'est l'un des front-ends les plus configurables de cette catégorie.

Meilleures fonctionnalités de l'interface utilisateur Web de génération de texte

- Formatage automatique des invites à l'aide des modèles Jinja2, réduisant les erreurs de mise en forme des invites entre les différentes familles de modèles.

- Ajustez des dizaines de paramètres pour affiner les résultats de l'IA en fonction de vos besoins spécifiques, que ce soit pour l'écriture créative, le codage ou le jeu de rôle.

- Modification des messages avec navigation entre les versions et ramification des discussions, permettant de conserver plusieurs directions d'une même discussion sans avoir à recommencer depuis le début.

Limitations de l'interface utilisateur Web pour la génération de texte

- Le programme d'installation en un clic nécessite environ 10 Go d'espace disque et télécharge PyTorch, ce qui rend l'installation lourde sur les machines dont le stockage est limité.

- Le point de terminaison des intégrations compatibles avec OpenAI utilise sentence-transformers/all-mpnet-base-v2 avec des intégrations à 768 dimensions, ce qui peut remettre en cause les hypothèses des pipelines construits autour des valeurs par défaut à 1536 dimensions d'OpenAI.

Tarifs de l'interface utilisateur Web pour la génération de texte

- Code source libre

Évaluations et avis sur l'interface utilisateur Web de Text Generation

- G2 : Pas assez d'avis

- Capterra : pas assez d'avis

10. Llama. cpp (Idéal pour une inférence LLM locale haute performance sur CPU et GPU)

Llama. cpp est un moteur d'inférence C/C++ et une chaîne d'outils permettant d'exécuter des LLM localement avec un minimum de dépendances et des performances élevées sur un large intervalle de matériel. Il s'agit moins d'une « application de chat » que d'un environnement d'exécution local autour duquel vous pouvez créer des flux de travail, qu'il s'agisse d'une interface CLI, d'un serveur HTTP local ou d'une bibliothèque intégrée à votre propre produit.

Bien qu'il ne s'agisse pas d'une application destinée aux utilisateurs finaux, Llama. cpp est le moteur qui alimente bon nombre des outils figurant dans cette liste, notamment GPT4All et LM Studio. Il a introduit le format de modèle GGUF, qui est devenu la norme pour l'exécution de modèles volumineux sur du matériel grand public en réduisant efficacement leur taille.

Il propose également des liaisons pour les langages de programmation populaires tels que Python et Rust, et son mode serveur peut fournir une API compatible avec OpenAI.

Llama. cpp meilleures fonctionnalités

- Lancer un serveur local compatible avec l'API OpenAI, doté d'une interface utilisateur web intégrée et d'un point de terminaison /v1/chat/completions à l'aide de llama-server.

- Exécutez un modèle d'intégration (et même un modèle de reclassement) à partir du même serveur pour les pipelines RAG hors ligne à l'aide de /embedding et /reranking.

- Quantifiez les modèles à 1,5 bit à 8 bits pour réduire l'utilisation de la mémoire et accélérer l'inférence locale, puis accélérez les exécutions avec les backends CUDA/Metal et Vulkan/SYCL lorsqu'ils sont disponibles.

Limitations de Llama.cpp

- Llama. cpp n'est pas livré sous forme d'assistant de bureau perfectionné, ce qui signifie que son utilisation hors ligne implique souvent des commandes CLI ou l'hébergement de llama-server, et de nombreux utilisateurs s'appuient sur des interfaces utilisateur tierces pour discuter quotidiennement.

- La compatibilité de Llama.cpp avec OpenAI n'est pas toujours parfaite avec toutes les fonctionnalités du client OpenAI, et les utilisateurs signalent des incompatibilités concernant les paramètres de sortie structurés tels que response_format dans /v1/chat/completions.

Prix de Llama. cpp

- Code source libre

Que disent les utilisateurs réels à propos de Llama. cpp ?

Un critique de Sourceforge déclare :

Génial. Démocratiser l'IA pour tous. Et ça marche très bien !

Génial. Démocratiser l'IA pour tous. Et ça marche très bien !

Transformez les résultats de l'IA hors ligne en travail réel avec ClickUp

Choisir le bon outil d'IA hors ligne, c'est avant tout trouver l'outil qui correspond le mieux à la tâche à accomplir.

Si vous êtes ici, c'est probablement parce que vous recherchez trois choses : la confidentialité, l'indépendance vis-à-vis d'Internet et la liberté de ne pas être lié à un autre abonnement.

Les outils figurant dans cette liste répondent à ces attentes de différentes manières. En d'autres termes, certains sont plus adaptés à l'écriture et au codage, d'autres à la recherche, à la prise de notes ou au travail créatif.

Mais pour les équipes, le plus grand défi n'est pas seulement d'utiliser l'IA localement. Il s'agit de transformer les résultats de l'IA en véritables flux de travail.

Grâce à la fonctionnalité IA de ClickUp intégrée à vos tâches, vos documents et vos connaissances, vous pouvez facilement identifier les prochaines étapes à suivre au même endroit où vous travaillez (le tout avec une sécurité de niveau entreprise).

Essayez ClickUp gratuitement et découvrez ce que donne la combinaison entre l'IA et l'exécution. ✨

Foire aux questions sur les outils d'IA hors ligne

Oui, après avoir téléchargé les fichiers du modèle, de nombreux outils d'IA peuvent fonctionner entièrement sur votre appareil sans connexion Internet. Cela les rend parfaits pour traiter des données sensibles ou travailler dans des emplacements où la connexion Internet est mauvaise.

Les LLM locaux traitent toutes les données sur votre appareil personnel, de sorte que vos informations ne quittent jamais votre machine, tandis que l'IA basée sur le cloud envoie vos invitations à des serveurs distants pour traitement. Les outils locaux sont généralement gratuits après leur installation, tandis que l'IA cloud implique souvent des frais d'abonnement, mais peut offrir des modèles plus puissants.

Les modèles plus petits, avec 1 à 3 milliards de paramètres, peuvent fonctionner sur la plupart des ordinateurs portables modernes équipés de 8 Go de RAM. Les modèles plus grands et plus performants, avec 7 milliards de paramètres ou plus, fonctionnent mieux avec 16 Go de RAM ou plus et un GPU dédié. Les Mac Apple Silicon et les GPU NVIDIA offrent des gains de performances significatifs.

![Les 10 meilleurs outils d'IA fonctionnant hors ligne en [année]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)