Los grandes modelos lingüísticos (LLM) han abierto nuevas y apasionantes posibilidades para las aplicaciones informáticas. Permiten crear sistemas más inteligentes y dinámicos que nunca.

Los expertos predicen que, para 2025, las apps basadas en estos modelos podrían automatizar casi todos los procesos de la vida real la mitad del trabajo digital .

Sin embargo, a medida que desbloqueamos estas capacidades, se nos presenta un reto: ¿cómo medir de forma fiable la calidad de sus resultados a gran escala? Un pequeño ajuste en la configuración y, de repente, el resultado es notablemente diferente. Esta variabilidad puede dificultar la evaluación de su rendimiento, lo que es crucial a la hora de preparar un modelo para su uso en el mundo real.

En este artículo compartiremos las mejores prácticas de evaluación de sistemas LLM, desde las pruebas previas al despliegue hasta la producción. Así que, ¡comencemos!

¿Qué es una evaluación LLM?

Las métricas de evaluación de LLM son una forma de ver si sus indicaciones, ajustes del modelo o flujo de trabajo están alcanzando las metas que se ha fijado. Estas métricas te dan una idea de lo bien que tus Gran modelo lingüístico y si está realmente listo para su uso en el mundo real.

Hoy en día, algunas de las métricas más comunes miden la recuperación del contexto en tareas de generación aumentada de recuperación (RAG), las coincidencias exactas para clasificaciones, la validación JSON para resultados estructurados y la similitud semántica para tareas más creativas.

Cada una de estas métricas garantiza de forma exclusiva que el LLM cumple las normas para su caso de uso específico.

¿Por qué es necesario evaluar un LLM?

Los grandes modelos lingüísticos (LLM) se utilizan actualmente en un amplio intervalo de aplicaciones. Es esencial evaluar el rendimiento de los modelos para asegurarse de que cumplen las normas esperadas y sirven eficazmente a los fines previstos.

Piénselo de este modo: Los LLM lo potencian todo, desde los chatbots de soporte al cliente hasta las herramientas creativas, y a medida que se hacen más avanzados, aparecen en más lugares.

Esto significa que necesitamos mejores formas de supervisarlos y evaluarlos, ya que los métodos tradicionales no pueden seguir el ritmo de todas las tareas que realizan estos modelos.

Unas buenas métricas de evaluación son como un control de calidad para los LLM. Demuestran si el modelo es lo suficientemente fiable, preciso y eficaz para su uso en el mundo real. Sin estas comprobaciones, los errores podrían pasar desapercibidos, dando lugar a experiencias de usuario frustrantes o incluso engañosas.

Cuando se dispone de métricas de evaluación sólidas, es más fácil detectar problemas, mejorar el modelo y asegurarse de que está preparado para satisfacer las necesidades específicas de sus usuarios. De este modo, sabrá que el Plataforma de IA con la que trabajas está a la altura y puede ofrecerte los resultados que necesitas.

📖 Leer más: LLM vs. IA Generativa: Una Guía Detallada

Tipos de evaluaciones LLM

Las evaluaciones proporcionan una lente única para examinar las capacidades del modelo. Cada tipo aborda diversos aspectos de calidad, ayudando a construir un modelo de despliegue fiable, seguro y eficiente.

A continuación se presentan los distintos tipos de métodos de evaluación de LLM:

- La evaluación intrínseca se centra en el rendimiento interno del modelo en tareas lingüísticas o de comprensión específicas sin involucrar aplicaciones del mundo real. Suele llevarse a cabo durante la fase de desarrollo del modelo para comprender sus capacidades básicas

- **La evaluación extrínseca evalúa el rendimiento del modelo en aplicaciones reales. Este tipo de evaluación examina en qué medida el modelo cumple unas metas específicas dentro de un contexto

- La evaluación de la robustez pone a prueba la estabilidad y fiabilidad del modelo en diversos escenarios, incluidas entradas inesperadas y condiciones adversas. Identifica posibles puntos débiles y garantiza que el modelo se comporte de forma predecible

- Las pruebas de eficacia y latencia examinan el uso de recursos, la velocidad y la latencia del modelo. Garantiza que el modelo pueda realizar tareas con rapidez y a un coste computacional razonable, lo que es esencial para la escalabilidad

- **La evaluación ética y de seguridad garantiza que el modelo cumple las normas éticas y las directrices de seguridad, lo que es vital en aplicaciones sensibles

Evaluaciones de modelos LLM frente a evaluaciones de sistemas LLM

La evaluación de grandes modelos lingüísticos (LLM) implica dos enfoques principales: evaluaciones de modelos y evaluaciones de sistemas. Cada uno de ellos se centra en aspectos diferentes del rendimiento del LLM, y conocer la diferencia es esencial para maximizar el potencial de estos modelos.

🧠 Las evaluaciones de modelos se centran en las capacidades generales del LLM. Este tipo de evaluación pone a prueba la capacidad del modelo para comprender, generar y trabajar con el lenguaje con precisión en diversos contextos. Es como ver lo bien que el modelo puede manejar diferentes tareas, casi como una prueba de inteligencia general.

Por ejemplo, en las evaluaciones de modelos se puede preguntar: "¿Hasta qué punto es versátil este modelo?

🎯 Las evaluaciones del sistema LLM miden cómo funciona el LLM dentro de una configuración o propósito específico, como en un chatbot de atención al cliente. En este caso, se trata menos de las capacidades generales del modelo y más de cómo realiza tareas específicas para mejorar la experiencia del usuario.

**Las evaluaciones del sistema, sin embargo, se centran en cuestiones como: "¿Cómo gestiona el modelo esta tarea específica para los usuarios?

Las evaluaciones del modelo ayudan a los desarrolladores a comprender las capacidades y límites generales del LLM, orientando las mejoras. Las evaluaciones del sistema se centran en la medida en que el LLM satisface las necesidades del usuario en contextos específicos, garantizando una experiencia de usuario más fluida.

Juntas, estas evaluaciones proporcionan una imagen completa de los puntos fuertes y las áreas de mejora del LLM, haciéndolo más potente y fácil de usar en aplicaciones reales.

Ahora, exploremos las métricas específicas para la evaluación del LLM.

Métricas para la evaluación del LLM

Algunas métricas de evaluación fiables y de moda son:

1. Perplejidad

La perplejidad mide lo bien que un modelo lingüístico predice una secuencia de palabras. Esencialmente, indica la incertidumbre del modelo sobre la siguiente palabra de una frase. Una puntuación de perplejidad más baja significa que el modelo tiene más confianza en sus predicciones, lo que se traduce en un mejor rendimiento.

📌 Ejemplo: Imagine que un modelo genera texto a partir de la indicación "El gato se sentó en el" Si predice una probabilidad alta para palabras como "alfombrilla" y "suelo", entiende bien el contexto, lo que da como resultado una puntuación de perplejidad baja.

En cambio, si sugiere una palabra no relacionada, como "nave espacial", la puntuación de perplejidad será más alta, lo que indica que el modelo tiene dificultades para predecir un texto sensato.

2. Puntuación BLEU

La puntuación BLEU (Bilingual Evaluation Understudy) se utiliza principalmente para evaluar la traducción automática y valorar la generación de textos.

Mide cuántos n-gramas (secuencias contiguas de n elementos de una muestra de texto dada) en el resultado se solapan con los de uno o más textos de referencia. La puntuación oscila entre 0 y 1, y las puntuaciones más altas indican un mejor rendimiento.

📌 Ejemplo: Si su modelo genera la frase "El rápido zorro marrón salta sobre el perro perezoso" y el texto de referencia es "Un rápido zorro marrón salta sobre un perro perezoso", BLEU comparará los n-gramas compartidos.

Una puntuación alta indica que la frase generada coincide con la referencia, mientras que una puntuación baja podría sugerir que el resultado generado no se alinea bien.

3. Puntuación F1

La métrica de evaluación LLM de la puntuación F1 es principalmente para tareas de clasificación. Mide el equilibrio entre precisión (la exactitud de las predicciones positivas) y recall (la capacidad de identificar todas las instancias relevantes)

Su intervalo va de 0 a 1, donde una puntuación de 1 indica una precisión perfecta.

📌 Ejemplo: En una tarea de respuesta de preguntas, si se pregunta al modelo "¿De qué color es el cielo?" y responde "El cielo es azul" (verdadero positivo) pero también incluye "El cielo es verde" (falso positivo), la puntuación F1 tendrá en cuenta tanto la relevancia de la respuesta correcta como de la incorrecta.

Esta métrica ayuda a garantizar una evaluación equilibrada del rendimiento del modelo.

4. METEOR

METEOR (Metric for Evaluation of Translation with Explicit ORdering) va más allá de la concordancia exacta de palabras. Tiene en cuenta los sinónimos, la raíz y las paráfrasis para evaluar la similitud entre el texto generado y el texto de referencia. Esta métrica pretende acercarse más al juicio humano.

📌 Ejemplo: Si su modelo genera "El felino descansaba sobre la alfombra" y la referencia es "El gato descansaba sobre la alfombra", METEOR le daría una puntuación más alta que BLEU porque reconoce que "felino" es un sinónimo de "gato" y que "alfombra" y "alfombra" tienen significados similares.

Esto hace que METEOR sea especialmente útil para captar los matices del lenguaje.

5. BERTScore

BERTScore evalúa la similitud de textos basándose en incrustaciones contextuales derivadas de modelos como BERT (Bidirectional Encoder Representations from Transformers). Se centra más en el significado que en la coincidencia exacta de palabras, lo que permite una mejor evaluación de la similitud semántica.

📌 Ejemplo: Al comparar las frases "El coche corrió por la carretera" y "El vehículo aceleró por la calle", BERTScore analiza los significados subyacentes en lugar de limitarse a la elección de palabras.

Aunque las palabras difieren, las ideas generales son similares, lo que da lugar a una puntuación BERTScore alta que refleja la eficacia del contenido generado.

6. Evaluación humana

La evaluación humana sigue siendo un aspecto crucial de la evaluación LLM. En ella intervienen jueces humanos que valoran la calidad de resultados del modelo basándose en varios criterios como la fluidez y la relevancia. Para recabar opiniones pueden emplearse técnicas como las escalas de Likert y las pruebas A/B.

📌 Ejemplo: Tras generar las respuestas de un chatbot de atención al cliente, los evaluadores humanos podrían valorar cada respuesta en una escala del 1 al 5. Por ejemplo, si el chatbot proporciona una respuesta clara y útil a una consulta de un cliente, podría recibir un 5, mientras que una respuesta vaga o confusa podría obtener un 2.

7. Métricas específicas de la tarea

Diferentes tareas LLM requieren métricas de evaluación a medida.

**Para los sistemas de diálogo, las métricas podrían evaluar el compromiso del usuario o las tasas de compleción de tareas. En el caso de la generación de código, el intento correcto podría medirse por la frecuencia con la que el código generado compila o supera las pruebas

📌 Ejemplo: En un chatbot de soporte al cliente, los niveles de compromiso podrían medirse por el tiempo que los usuarios permanecen en una conversación o por el número de preguntas de seguimiento que hacen.

Si los usuarios solicitan información adicional con frecuencia, esto indica que el modelo está logrando captar su atención y resolviendo eficazmente sus consultas.

8. Robustez y equidad

Evaluar la robustez de un modelo implica comprobar qué tan bien responde a entradas inesperadas o inusuales. Las métricas de imparcialidad ayudan a identificar sesgos en los resultados del modelo, garantizando un rendimiento equitativo en diferentes demografías y escenarios.

📌 Ejemplo: Cuando se pone a prueba un modelo con una pregunta caprichosa del tipo "¿Qué opina de los unicornios?", el modelo debe responder a la pregunta con elegancia y dar una respuesta pertinente. Si en cambio da una respuesta sin sentido o inapropiada, indica falta de robustez.

Las pruebas de imparcialidad garantizan que el modelo no produzca resultados sesgados o perjudiciales, promoviendo un modelo más inclusivo Sistema de IA .

📖 Leer más: La diferencia entre aprendizaje automático e inteligencia artificial

9. Métricas de eficiencia

A medida que aumenta la complejidad de los modelos lingüísticos, resulta cada vez más importante medir su eficiencia en lo que respecta a la velocidad, el uso de memoria y el consumo de energía. Las métricas de eficiencia ayudan a evaluar el consumo de recursos de un modelo a la hora de generar respuestas.

📌 Ejemplo: Para un modelo lingüístico de gran tamaño, la medición de la eficiencia podría implicar el seguimiento de la rapidez con la que genera respuestas a las consultas de los usuarios y la cantidad de memoria que utiliza durante este proceso.

Si tarda demasiado en responder o consume demasiados recursos, podría ser un problema para las aplicaciones que requieren un rendimiento en tiempo real, como los chatbots o los servicios de traducción.

Ahora ya sabes cómo evaluar un modelo LLM. Pero, ¿qué herramientas puedes utilizar para medirlo? Explorémoslo.

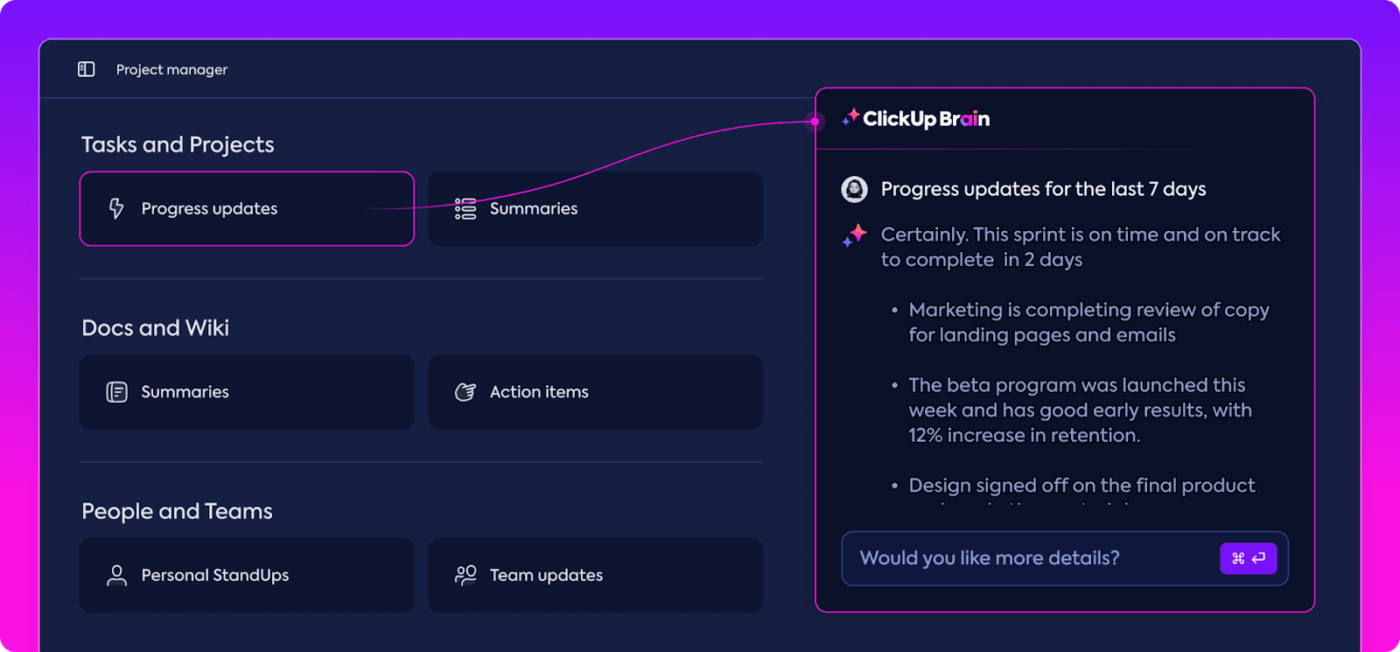

Cómo ClickUp Brain puede mejorar la evaluación del LLM

ClickUp es una app de "todo para el trabajo" con un asistente personal incorporado llamado ClickUp Brain. Cerebro ClickUp es una herramienta revolucionaria para la evaluación del rendimiento en LLM. ¿Y para qué sirve?

Organiza y destaca los datos más relevantes, manteniendo a su equipo en el buen camino. Gracias a sus funciones basadas en IA, ClickUp Brain es una de las mejores herramientas de evaluación del rendimiento de LLM software de redes neuronales que existen. Hace que todo el proceso sea más fluido, eficaz y colaborativo que nunca. Exploremos juntos sus posibilidades.

Gestión inteligente del conocimiento

Cuando se evalúan grandes modelos lingüísticos (LLM), la gestión de grandes cantidades de datos puede resultar abrumadora.

resuma los datos y agilice el seguimiento de las métricas de rendimiento con ClickUp Brain_ Cerebro ClickUp puede organizar y destacar métricas y recursos esenciales adaptados específicamente para la evaluación de LLM. En lugar de rebuscar en hojas de cálculo dispersas y densos informes, ClickUp Brain lo reúne todo en un solo lugar. Las métricas de rendimiento, los datos de evaluación comparativa y los resultados de las pruebas son accesibles desde una interfaz clara y fácil de usar.

Esta organización ayuda a su equipo a eliminar el ruido y a centrarse en lo que realmente importa, facilitando la interpretación de tendencias y patrones de rendimiento.

Con todo lo que necesita en un solo lugar, puede pasar de la mera recopilación de datos a una toma de decisiones impactante y basada en datos, transformando la sobrecarga de información en inteligencia procesable.

Planificación de proyectos y gestión de flujos de trabajo

Las evaluaciones de LLM requieren una cuidadosa planificación y colaboración, y ClickUp facilita la gestión de este proceso.

Puede delegar fácilmente responsabilidades como la recopilación de datos, la formación de modelos y las pruebas de rendimiento, al tiempo que ajusta las prioridades para asegurarse de que las tareas más importantes reciben la máxima atención. Además, los Campos personalizados le permiten adaptar los flujos de trabajo a las necesidades específicas de su proyecto.

cree y asigne tareas y agilice el flujo de trabajo utilizando IA en ClickUp_

Con ClickUp, todo el mundo puede ver quién está haciendo qué y cuándo, lo que ayuda a evitar retrasos y a garantizar que las tareas se realicen sin problemas en todo el equipo. Es una gran manera de mantener todo organizado y en el camino de principio a fin.

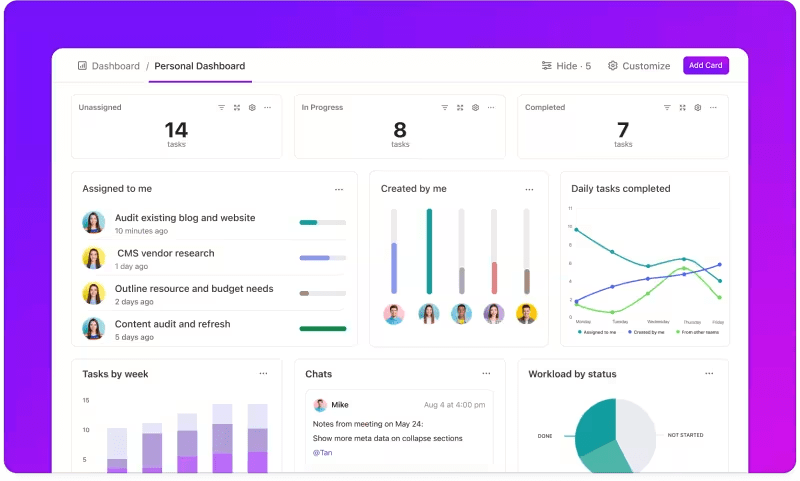

Seguimiento de métricas a través de paneles personalizados

¿Quiere controlar el rendimiento de sus sistemas LLM? Paneles de ClickUp visualizan los indicadores de rendimiento en tiempo real. Le permiten supervisar el progreso de su modelo al instante. Estos paneles son altamente personalizables, lo que le permite crear gráficos y diagramas que presentan exactamente lo que necesita cuando lo necesita.

Puede ver cómo evoluciona la precisión de su modelo a lo largo de las fases de evaluación o desglosar el consumo de recursos en cada fase. Esta información le permite detectar tendencias rápidamente, identificar áreas de mejora y realizar ajustes sobre la marcha.

visualice el progreso de su evaluación de un solo vistazo en los Cuadros de mando de ClickUp_

En lugar de esperar al siguiente informe detallado, Paneles de ClickUp le permiten mantenerse informado y receptivo, y permiten a su equipo tomar decisiones basadas en datos sin demora.

Automatización de la información

El análisis de datos puede llevar mucho tiempo, pero Funciones de ClickUp Brain aligeran la carga proporcionando información valiosa. Destaca las tendencias importantes e incluso sugiere recomendaciones basadas en los datos, lo que facilita la extracción de conclusiones significativas.

Con la información automatizada de ClickUp Brain, no es necesario peinar manualmente los datos sin procesar en busca de patrones, ya que los detecta por usted. Esta automatización libera a su equipo para que pueda centrarse en perfeccionar el rendimiento del modelo en lugar de estancarse en el análisis repetitivo de datos.

obtenga información práctica con ClickUp Brain

La información generada está lista para su uso, lo que permite a su equipo ver inmediatamente lo que está funcionando y dónde se necesitan cambios. Al reducir el tiempo dedicado al análisis, ClickUp ayuda a su equipo a acelerar el proceso de evaluación y a centrarse en la implantación.

Documentación y colaboración

Se acabó rebuscar entre correos electrónicos o múltiples plataformas para encontrar lo que necesita; todo está ahí, listo cuando usted lo esté. Documentos de ClickUp es un hub central que reúne todo lo que su equipo necesita para una evaluación LLM sin fisuras. Organiza la documentación clave del proyecto -como los criterios de evaluación comparativa, los resultados de las pruebas y los registros de rendimiento- en un lugar accesible para que todos puedan acceder rápidamente a la información más reciente.

Lo que realmente diferencia a ClickUp Docs son sus funciones de colaboración en tiempo real. Las funciones integradas de ClickUp Chat integrado y **Comentarios permitir a los miembros del equipo discutir ideas, dar su opinión y sugerir cambios directamente dentro de los documentos.

Esto significa que su equipo puede hablar sobre los hallazgos y hacer ajustes directamente en la plataforma, manteniendo todas las discusiones relevantes y en el punto.

colabore y edite documentos de ClickUp con su equipo en tiempo real

Todo, desde la documentación hasta el trabajo en equipo, sucede dentro de ClickUp Docs, creando un proceso de evaluación racionalizado donde todos pueden ver, compartir y actuar sobre los últimos avances.

¿El resultado? Un flujo de trabajo fluido y unificado que permite a su equipo avanzar hacia sus metas con total claridad.

¿Está listo para probar ClickUp? Antes de eso, hablemos de algunos consejos y trucos para sacar el máximo partido a su Evaluación LLM.

Buenas prácticas en la evaluación LLM

Un enfoque bien estructurado de la evaluación de LLM garantiza que el modelo satisfaga sus necesidades, se ajuste a las expectativas de los usuarios y ofrezca resultados significativos.

El ajuste de objetivos claros, la consideración de los usuarios finales y el uso de diversas métricas ayudan a dar forma a una evaluación exhaustiva que revela los puntos fuertes y las áreas de mejora. A continuación se exponen algunas buenas prácticas para guiar el proceso.

🎯 Defina objetivos claros

Antes de iniciar el proceso de evaluación, es esencial saber exactamente qué quiere que logre su modelo de gran lenguaje (LLM). Dedique tiempo a esbozar las tareas o metas específicas del modelo.

📌 Ejemplo: Si quiere mejorar el rendimiento de la traducción automática, aclare los niveles de calidad que desea alcanzar. Tener objetivos claros te ayuda a centrarte en las métricas más relevantes, asegurando que tu evaluación permanece alineada con estas metas y mide el intento correcto.

👥 Considere su audiencia

Piense en quién utilizará el LLM y cuáles son sus necesidades. Es fundamental adaptar la evaluación a los usuarios previstos.

📌 Ejemplo: Si su modelo está pensado para generar contenidos atractivos, querrá prestar mucha atención a métricas como la fluidez y la coherencia. Entender a tu público te ayudará a afinar tus criterios de evaluación, asegurándote de que el modelo aporta un valor real en aplicaciones prácticas

📊 Utilizar diversas métricas

No confíe en una sola métrica para evaluar su LLM; una mezcla de métricas le ofrece una imagen más completa de su rendimiento. Cada métrica capta aspectos diferentes, por lo que utilizar varias puede ayudarte a identificar tanto los puntos fuertes como los débiles.

📌 Ejemplo: Aunque las puntuaciones BLEU son estupendas para medir la calidad de la traducción, puede que no cubran todos los matices de la escritura creativa. Incorporar métricas como la perplejidad para la precisión predictiva e incluso evaluaciones humanas para el contexto puede llevar a una comprensión mucho más redondeada de lo bien que funciona tu modelo

Puntos de referencia y herramientas LLM

La evaluación de grandes modelos lingüísticos (LLM) a menudo se basa en puntos de referencia estándar y herramientas especializadas que ayudan a medir el rendimiento del modelo en diversas tareas.

A continuación se ofrece un desglose de algunos puntos de referencia y herramientas ampliamente utilizados que aportan estructura y claridad al proceso de evaluación.

Puntos de referencia clave

- GLUE (General Language Understanding Evaluation): GLUE evalúa las capacidades de los modelos en varias tareas lingüísticas, como la clasificación de frases, la similitud y la inferencia. Se trata de un punto de referencia para modelos que deben gestionar la comprensión lingüística general

- SQuAD (Stanford Question Answering Dataset): El marco de evaluación SQuAD es ideal para la comprensión lectora y mide la capacidad de un modelo para responder a preguntas a partir de un pasaje de texto. Se suele utilizar para tareas como el soporte al cliente y la recuperación basada en el conocimiento, donde las respuestas precisas son cruciales

- SuperGLUE: Como versión mejorada de GLUE, SuperGLUE evalúa modelos en tareas más complejas de razonamiento y comprensión contextual. Proporciona información más detallada, especialmente para aplicaciones que requieren una comprensión avanzada del lenguaje

Herramientas de evaluación esenciales

- Hugging Face : Es muy popular por su amplia biblioteca de modelos, conjuntos de datos y funciones de evaluación. Su interfaz altamente intuitiva permite a los usuarios seleccionar fácilmente los puntos de referencia, personalizar las evaluaciones y realizar un seguimiento del rendimiento del modelo, lo que lo hace versátil para muchas aplicaciones LLM

- **SuperAnnotate : Se especializa en la gestión y anotación de datos, lo cual es crucial para tareas de aprendizaje supervisado. Es particularmente útil para refinar la precisión de los modelos, ya que facilita datos de alta calidad anotados por humanos que mejoran el rendimiento de los modelos en tareas complejas

- AllenNLP **Desarrollado por el Instituto Allen de IA, AllenNLP está dirigido a investigadores y desarrolladores que trabajan con modelos de PLN personalizados. Es compatible con un intervalo de puntos de referencia y proporciona herramientas para entrenar, probar y evaluar modelos de lenguaje, ofreciendo flexibilidad para diversas aplicaciones de PLN

El uso de una combinación de estos puntos de referencia y herramientas ofrece un enfoque integral de la evaluación de la PLN. Los puntos de referencia pueden establecer normas para todas las tareas, mientras que las herramientas proporcionan la estructura y la flexibilidad necesarias para el seguimiento, el perfeccionamiento y la mejora eficaz del rendimiento de los modelos.

Juntas, garantizan que los LLM cumplan tanto las normas técnicas como las necesidades de las aplicaciones prácticas.

Retos de la evaluación de modelos LLM

La evaluación de grandes modelos lingüísticos (LLM) requiere un enfoque matizado. Se centra en la calidad de las respuestas y en comprender la adaptabilidad y los límites del modelo en distintos escenarios.

Dado que estos modelos se entrenan en amplios conjuntos de datos, su comportamiento se ve influido por un intervalo de factores, por lo que es esencial evaluar algo más que la precisión.

La verdadera evaluación consiste en examinar la fiabilidad del modelo, su resistencia a situaciones inusuales y su capacidad de adaptación a los cambios indicaciones y la coherencia general de las respuestas. Este proceso ayuda a esbozar una imagen más clara de los puntos fuertes y débiles del modelo, y descubre áreas que necesitan perfeccionarse.

A continuación se describen algunos de los problemas más comunes que surgen durante la evaluación de un LLM.

1. Superposición de datos de entrenamiento

Es difícil saber si el modelo ya ha visto algunos de los datos de prueba. Dado que los LLM se entrenan en conjuntos de datos masivos, existe la posibilidad de que algunas preguntas de prueba se solapen con ejemplos de entrenamiento. Esto puede hacer que el modelo parezca mejor de lo que realmente es, ya que podría estar repitiendo lo que ya sabe en lugar de demostrar una verdadera comprensión.

2. Rendimiento incoherente

Los LLM pueden tener respuestas impredecibles. En un momento dado, ofrecen ideas impresionantes y, al siguiente, cometen errores extraños o presentan información imaginaria como hechos (lo que se conoce como "alucinaciones").

Esta inconsistencia significa que mientras que los resultados del LLM pueden brillar en algunas áreas, pueden quedarse cortos en otras, lo que dificulta juzgar con precisión su fiabilidad y calidad generales.

3. Vulnerabilidades adversarias

Los LLM pueden ser susceptibles de sufrir ataques de adversarios, en los que indicaciones hábilmente elaboradas los engañan para que produzcan respuestas erróneas o perjudiciales. Esta vulnerabilidad expone las debilidades del modelo y puede conducir a resultados inesperados o sesgados. Comprobar estas debilidades es crucial para comprender dónde se encuentran los límites del modelo.

Casos prácticos de evaluación de LLM

Por último, he aquí algunas situaciones comunes en las que la evaluación LLM realmente marca la diferencia:

Chatbots de soporte al cliente

Los LLM se utilizan ampliamente en los chatbots para gestionar las consultas de los clientes. Evaluar la capacidad de respuesta del modelo garantiza que ofrezca respuestas precisas, útiles y contextualmente relevantes.

Es crucial medir su capacidad para comprender la intención del cliente, manejar diversas preguntas y proporcionar respuestas similares a las humanas. Esto permitirá a las empresas garantizar una experiencia de cliente fluida y minimizar la frustración.

Generación de contenidos

Muchas empresas utilizan LLM para generar contenidos para blogs, redes sociales y descripciones de productos. Evaluar la calidad del contenido generado ayuda a garantizar que es gramaticalmente correcto, atractivo y relevante para el público objetivo. Métricas como la creatividad, la coherencia y la relevancia para el tema son importantes aquí para mantener altos estándares de contenido.

Análisis de sentimiento

Los LLM pueden analizar el sentimiento de los comentarios de los clientes, las publicaciones en redes sociales o las reseñas de productos. Es esencial evaluar la precisión con la que el modelo identifica si un fragmento de texto es positivo, negativo o neutro. Esto ayuda a las empresas a comprender las emociones de los clientes, perfeccionar productos o servicios, aumentar la satisfacción de los usuarios y mejorar las estrategias de marketing.

Generación de código

Los desarrolladores suelen utilizar los LLM para ayudar a generar código. Evaluar la capacidad del modelo para producir código funcional y eficiente es crucial.

Es importante comprobar si el código generado es lógico, no contiene errores y cumple los requisitos de la tarea. Esto ayuda a reducir la cantidad de código manual necesario y mejora la productividad.

Optimice su evaluación LLM con ClickUp

La evaluación de los LLM consiste en elegir las métricas adecuadas que se ajusten a sus metas. La clave está en comprender sus metas específicas, ya sea mejorar la calidad de la traducción, mejorar la generación de contenidos o realizar ajustes para tareas especializadas.

La selección de las métricas adecuadas para la evaluación del rendimiento, como las métricas RAG o de ajuste, constituye la base de una evaluación precisa y significativa. Por su parte, los evaluadores avanzados como G-Eval, Prometheus, SelfCheckGPT y QAG proporcionan información precisa gracias a su gran capacidad de razonamiento.

Sin embargo, eso no significa que estas puntuaciones sean perfectas: sigue siendo importante asegurarse de que son fiables.

A medida que avances en la evaluación de tu solicitud de LLM, adapta el proceso a tu caso específico. No existe una métrica universal que funcione en todos los casos. Una combinación de métricas, junto con un enfoque en el contexto, le dará una imagen más precisa del rendimiento de su modelo.

Para agilizar la evaluación de su LLM y mejorar la colaboración en equipo, ClickUp es la solución ideal para gestionar los flujos de trabajo y realizar un seguimiento de las métricas importantes.

¿Quiere mejorar la productividad de su equipo? Inscríbete en ClickUp y descubra cómo puede transformar su flujo de trabajo