Sie haben APIs zusammengeklebt, Slack-Bots manipuliert und ChatGPT angefleht, sich wie ein Teamkollege zu verhalten.

Ohne echten Kontext kann KI jedoch nur Vermutungen anstellen. Sie versagt, wenn sich Ihre Tools ändern, und halluziniert, wenn Ihre Daten nicht klar zugeordnet oder zugänglich sind.

Das Model Context Protocol (MCP) ändert das. Es schafft eine gemeinsame Sprache zwischen Ihrem Modell und Ihrem Stack: strukturiert, kontextbezogen und skalierbar. Mit MCP können Sie aufhören, KI zu liefern, die sich intelligent verhält, und stattdessen KI entwickeln, die intelligent ist.

In diesem Blogbeitrag werden wir MCP im Detail verstehen und erfahren, wie man es implementiert. Darüber hinaus werden wir untersuchen, wie ClickUp als Alternative zu MCP-Protokollen dienen kann. Lassen Sie uns eintauchen! 🤖

Was ist ein Modellkontextprotokoll?

Das Modellkontextprotokoll ist ein Rahmenwerk oder eine Richtlinie, die verwendet wird, um die Schlüsselelemente/den Kontext (Eingabeaufforderungen, Verlauf der Unterhaltung, Tool-Status, Benutzer-Metadaten usw.) für große Sprachmodelle (LLMs) zu definieren, zu strukturieren und zu kommunizieren.

Es werden die externen Faktoren beschrieben, die das Modell beeinflussen, wie z. B.:

- Wer wird das Modell verwenden (Stakeholder)?

- Warum das Modell erstellt wird (Ziele)

- Wo und wie wird es angewendet (Anwendungsfälle, Umgebungen)?

- Welche Einschränkungen gibt es (technischer, ethischer, zeitlicher Art usw.)?

- Welche Annahmen werden über den realen Kontext getroffen?

Einfach ausgedrückt schafft es die Voraussetzungen für einen effektiven Betrieb des Modells und stellt sicher, dass es technisch einwandfrei, relevant und in dem Szenario, für das es entwickelt wurde, einsetzbar ist.

Zu den Schlüsselkomponenten von MCP gehören:

- Validierungskriterien: Beschreibt, wie das Modell auf Genauigkeit und Nützlichkeit getestet oder bewertet wird.

- Zweck: Gibt klar an, was das Modell darstellen oder lösen soll.

- Umfang: Definiert die Grenzen des Modells, z. B. was enthalten ist und was ausgeschlossen wird.

- Schlüsselkonzepte und Variablen: Identifiziert die wichtigsten Komponenten, Entitäten oder Variablen, mit denen sich das Modell befasst.

- Beziehungen und Annahmen: Erläutert, wie Konzepte interagieren und welche Annahmen dem Modell zugrunde liegen.

- Struktur: Beschreibt das Format des Modells (z. B. Diagramm, mathematische Gleichungen, Simulationen).

MCP vs. LangChain

LangChain ist ein entwicklerfreundliches Framework zum Erstellen von Anwendungen, die LLM-Agenten verwenden. MCP hingegen ist ein Protokoll, das die Bereitstellung von Kontext für Modelle systemübergreifend standardisiert.

LangChain hilft Ihnen beim Aufbau, und MCP hilft Systemen dabei, miteinander zu kommunizieren. Lassen Sie uns den Unterschied zwischen den beiden besser verstehen.

| Feature | LangChain | MCP-Modelle |

| Fokus | Anwendungsentwicklung mit LLMs | Standardisierung des LLM-Kontexts und der Interaktionen mit Tools |

| Tools | Ketten, Agenten, Speicher, Retriever | Protokoll für LLMs für den Zugriff auf Tools, Daten und Kontext |

| Skalierbarkeit | Modular, skalierbar über Komponenten | Entwickelt für groß angelegte, agentenübergreifende Bereitstellungen |

| Anwendungsfälle | Chatbots, Retrieval-Augmented-Generation-Systeme (RAG), Automatisierung von Aufgaben | KI-Orchestrierung für Unternehmen, multimodale Systeme |

| Interoperabilität | Beschränkt auf Ökosystem-Tools | Hoch, ermöglicht das Wechseln zwischen Modellen und tools |

Möchten Sie sehen, wie MCP-basierte Automatisierungen in der Praxis aussehen?

Lesen Sie den Leitfaden von ClickUp zur Automatisierung von KI-Workflows, der zeigt, wie verschiedene Teams, vom Marketing bis zur Technik, dynamische, komplexe Workflows einrichten, die die Stärken des Modellkontextprotokolls in Bezug auf Echtzeit-Interaktion widerspiegeln.

MCP vs. RAG

RAG und MCP verbessern beide LLMs mit externem Wissen, unterscheiden sich jedoch in Bezug auf Timing und Interaktion.

Während RAG Informationen abruft, bevor das Modell eine Antwort generiert, ermöglicht MCP dem Modell, während der Generierung über eine standardisierte Schnittstelle Daten anzufordern oder Auslöser zu aktivieren. Vergleichen wir beide.

| Feature | RAG | MCP |

| Fokus | Vorabruf relevanter Info für die Generierung von Antworten | Echtzeit-Interaktion zwischen Tools und Daten während des Prozesses |

| Mechanismus | Ruft zuerst externe Daten ab und generiert dann | Fordert Kontext während der Generierung an |

| Am besten geeignet für | Statische oder halbstrukturierte Wissensdatenbanken, QA-Systeme | Echtzeit-Tools, APIs, toolintegrierte Datenbanken |

| Limit | Eingeschränkt durch Abrufzeitpunkt und Kontextfenster | Latenz durch Protokoll-Hops |

| Integration | Ja, RAG-Ergebnisse können in MCP-Kontext-Ebenen eingebettet werden. | Ja, es kann RAG in MCP einbinden, um reichhaltigere Flows zu ermöglichen. |

Wenn Sie eine Mischung aus RAG + MCP aufbauen, beginnen Sie mit einem sauberen Wissensmanagementsystem innerhalb von ClickUp.

Sie können die Wissensdatenbank-Vorlage von ClickUp verwenden, um Ihre Inhalte konsistent zu organisieren. Dies hilft Ihren KI-Agenten, genaue und aktuelle Informationen abzurufen, ohne sich durch Unmengen von Daten wühlen zu müssen.

MCP vs. KI-Agenten

Während MCP die Schnittstelle ist, fungieren verschiedene Arten von KI-Agenten als Akteure.

MCP-Modelle standardisieren den Zugriff von Agenten auf Tools, Daten und Kontext und fungieren dabei als universeller Konnektor. KI-Agenten nutzen diesen Zugriff, um Entscheidungen zu treffen, Aufgaben auszuführen und autonom zu handeln.

| Feature | MCP | KI-Agenten |

| Rolle | Standardschnittstelle für den Zugriff auf Tools/Daten | Autonome Systeme, die Aufgaben ausführen |

| Funktion | Fungiert als Brücke zwischen Modellen und externen Systemen. | Verwendet MCP-Server, um auf Kontext und tools zuzugreifen und Entscheidungen zu treffen. |

| Anwendungsfall | Verbindung von KI-Systemen, Datenbanken, APIs und Rechnern | Code schreiben, Daten zusammenfassen, Workflows verwalten |

| Abhängigkeit | Unabhängige Protokollschicht | Verlässt sich häufig auf MCP für dynamischen Tool-Zugriff |

| Beziehung | Ermöglicht kontextgesteuerte Funktionen | Führt Aufgaben unter Verwendung des von MCP als Anbieter bereitgestellten Kontexts und der Funktionen aus. |

❗️Wie sieht es aus, wenn Sie einen KI-Agenten haben, der Ihre gesamte Arbeit versteht? Sehen Sie hier. 👇🏼

⚙️ Bonus: Benötigen Sie Hilfe bei der Entscheidung, wann Sie RAG, MCP oder eine Kombination aus beiden verwenden sollten? Dieser ausführliche Vergleich zwischen RAG, MCP und KI-Agenten erläutert alles anhand von Diagrammen und Beispielen.

Warum Kontext in KI-Modellen wichtig ist

Für moderne KI-Systeme ist der Kontext von grundlegender Bedeutung. Der Kontext ermöglicht es generativen KI-Modellen, die Absichten der Benutzer zu interpretieren, Eingaben zu klären und Ergebnisse zu liefern, die genau, relevant und umsetzbar sind. Ohne ihn halluzinieren Modelle, missverstehen Eingaben und generieren unzuverlässige Ergebnisse.

In der realen Welt stammen Kontexte aus verschiedenen Quellen: CRM-Datensätzen, Git-Historien, Chat-Protokollen, API-Ausgaben und mehr.

Vor MCP bedeutete die Integration dieser Daten in KI-Workflows, dass für jedes System benutzerdefinierte Konnektoren geschrieben werden mussten [ein fragmentierter, fehleranfälliger und nicht skalierbarer Ansatz].

MCP löst dieses Problem, indem es KI-Modellen einen strukturierten, maschinenlesbaren Weg zum Zugriff auf Kontextinformationen ermöglicht, unabhängig davon, ob es sich um Benutzereingabehistorien, Code-Schnipsel, Geschäftsdaten oder Tool-Funktionen handelt.

Dieser standardisierte Zugriff ist für das agentenbasierte Denken von entscheidender Bedeutung, da er es KI-Agenten ermöglicht, mit relevanten Echtzeitdaten intelligent zu planen und zu handeln.

Außerdem verbessert sich die KI-Leistung insgesamt, wenn der Kontext effektiv freigegeben wird:

- Relevantere Antworten in Sprache, Code und multimodalen Aufgaben

- Weniger Halluzinationen und Fehler dank Echtzeit-Datenabgleich

- Besseres Gedächtnis und besserer Flow bei langen Unterhaltungen oder komplexen Aufgaben

- Vereinfachte Integration mit tools, wobei Agenten Daten und Aktionen über Standardschnittstellen wiederverwenden können.

Hier ist ein Beispiel dafür, wie die ClickUp AI diese Kontextlücke schließt, ohne dass Sie sich mit umfangreichen MCP-Workflows oder Programmierung auseinandersetzen müssen. Wir kümmern uns darum!

💡 Profi-Tipp: Um noch tiefer in die Materie einzusteigen, lernen Sie, wie Sie wissensbasierte Agenten in der AI einsetzen können, um dynamische Daten abzurufen und zu nutzen.

Wie funktioniert ein Modellkontextprotokoll?

MCP folgt einer Client-Server-Architektur, bei der KI-Anwendungen (Clients) Tools, Daten oder Aktionen von externen Systemen (Servern) anfordern. Hier finden Sie eine detaillierte Übersicht darüber, wie MCP in der Praxis funktioniert. ⚒️

🧩 Verbindung herstellen

Wenn eine KI-Anwendung (wie Claude oder Cursor) gestartet wird, initialisiert sie MCP-Clients, die eine Verbindung zu einem oder mehreren MCP-Servern herstellen. Diese vom Server gesendeten Ereignisse können alles Mögliche darstellen, von einer Wetter-API bis hin zu internen Tools wie CRM-Systemen.

🧠 Wissenswertes: Einige MCP-Server ermöglichen es Agenten, Token-Guthaben zu lesen, NFTs zu überprüfen oder sogar Smart Contracts als Auslöser in über 30 Blockchain-Netzwerken zu nutzen.

👀 Entdecken Sie Tools und Funktionen

Sobald die Verbindung hergestellt ist, führt der Client eine Fähigkeitserkennung durch und fragt jeden Server: Welche Tools, Ressourcen oder Eingabeaufforderungen stellen Sie zur Verfügung?

Der Server antwortet mit einer Liste seiner Fähigkeiten, die registriert und dem KI-Modell bei Bedarf zur Verfügung gestellt werden.

📮 ClickUp Insight: 13 % der Befragten unserer Umfrage möchten KI nutzen, um schwierige Entscheidungen zu treffen und komplexe Probleme zu lösen. Allerdings geben nur 28 % an, KI regelmäßig bei der Arbeit einzusetzen.

Ein möglicher Grund: Sicherheitsbedenken! Benutzer möchten möglicherweise keine sensiblen Entscheidungsdaten mit einer externen KI freigeben. ClickUp löst dieses Problem, indem es KI-gestützte Problemlösungen direkt in Ihren sicheren Workspace bringt. Von SOC 2 bis zu ISO-Standards – ClickUp erfüllt die höchsten Standards der Datensicherheit und hilft Ihnen, generative KI-Technologie sicher in Ihrem gesamten Workspace einzusetzen.

🧠 Erkennen des Bedarfs an externem Kontext

Wenn ein Benutzer eine Eingabe macht (z. B. „Wie ist das Wetter in Chicago?“), analysiert das KI-Modell die Anfrage und erkennt, dass es externe Echtzeitdaten benötigt, die in seinem Trainingssatz nicht verfügbar sind.

Das Modell wählt ein geeignetes tool aus den verfügbaren MCP-Funktionen aus, z. B. einen Wetterdienst, und der Client bereitet eine Anfrage für diesen Server vor.

🔍 Wussten Sie schon? MCP ist vom Language Server Protocol (LSP) inspiriert und erweitert das Konzept auf autonome KI-Workflows. Dieser Ansatz ermöglicht es KI-Agenten, Tools dynamisch zu entdecken und zu verketten, was die Flexibilität und Skalierbarkeit in KI-Systementwicklungsumgebungen fördert.

✅ Ausführen und Verarbeiten von Antworten

Der Client sendet eine Anfrage an den MCP-Server und gibt dabei Folgendes an:

- The tool to invoke

- Parameter (z. B. Speicherort, Datum)

Der MCP-Server verarbeitet die Anfrage, führt die erforderliche Aktion aus (z. B. Abruf der Wetterdaten) und gibt das Ergebnis in einem maschinenlesbaren Format zurück. Der KI-Client integriert diese zurückgegebenen Informationen.

Das Modell generiert dann eine Antwort, die sowohl auf den neuen Daten als auch auf der ursprünglichen Eingabe basiert.

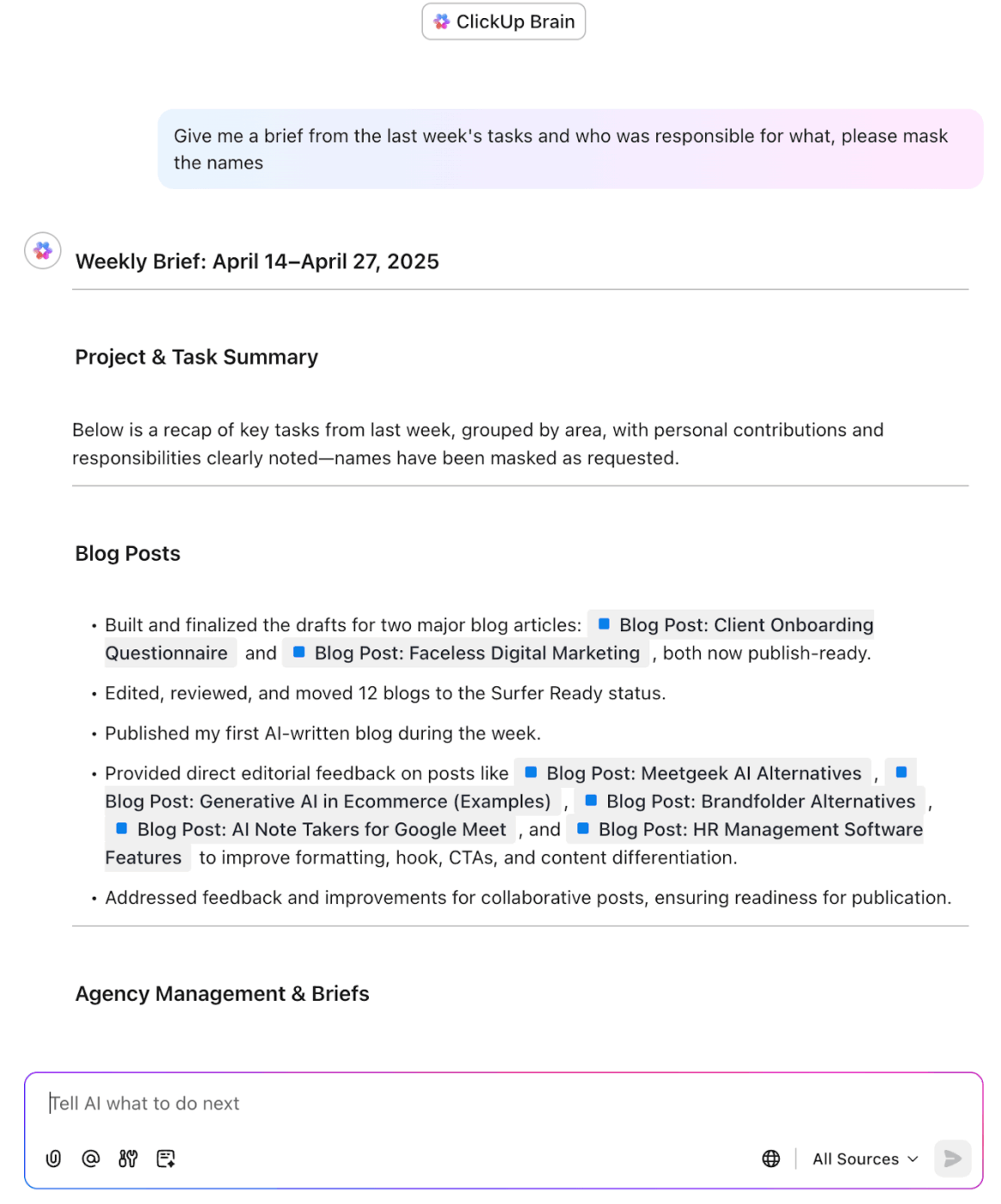

Rufen Sie Informationen aus Ihrem Workspace mit ClickUp Brain ab

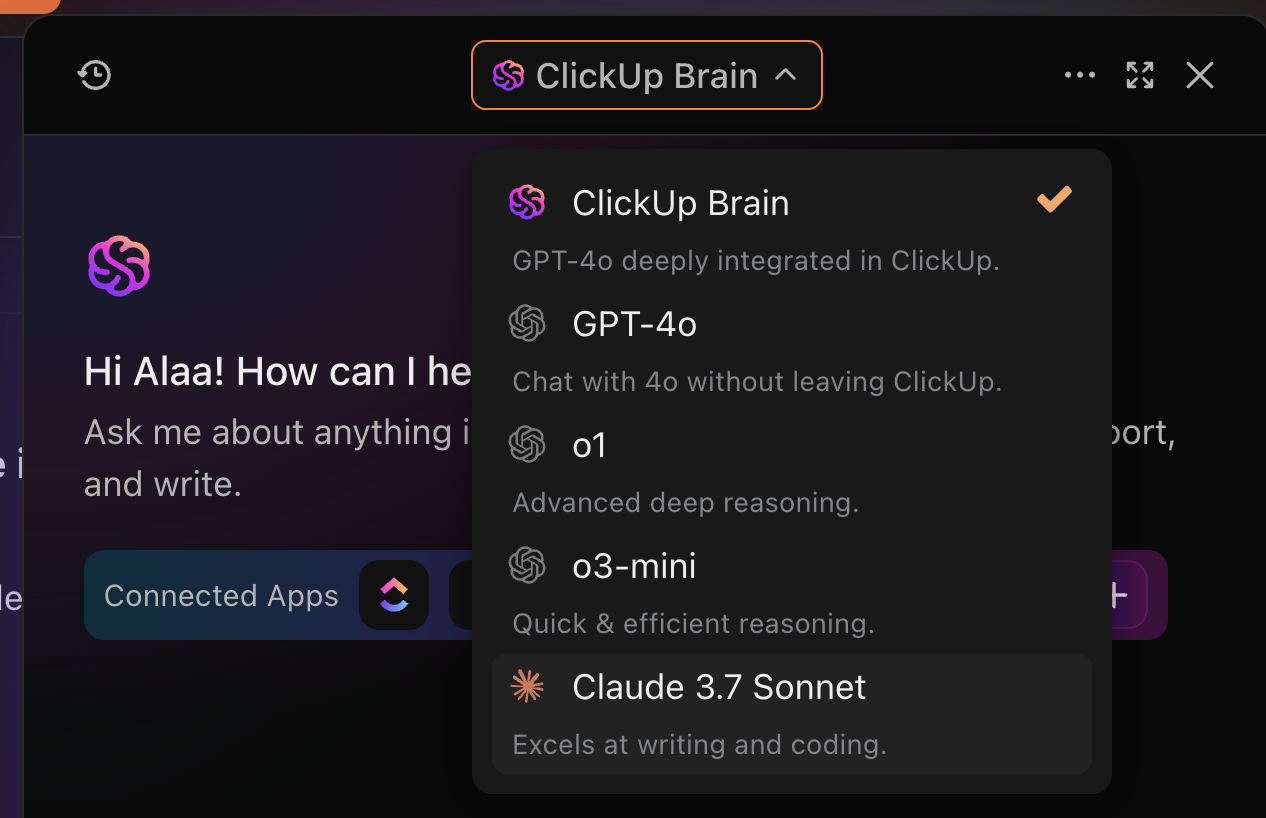

💟 Bonus: Lernen Sie Brain MAX kennen, den eigenständigen KI-Desktop-Begleiter von ClickUp, der Ihnen die mühsame Erstellung benutzerdefinierter MCP-Workflows von Grund auf erspart. Anstatt Dutzende von Tools und Integrationen zusammenzufügen, ist Brain MAX bereits vorinstalliert und einsatzbereit und vereint all Ihre Arbeiten, Apps und KI-Modelle in einer leistungsstarken Plattform.

Mit einer tiefen Integration in den Workspace, Sprach-zu-Text-Funktionen für freihändige Produktivität und hochrelevanten, rollenspezifischen Antworten bietet Ihnen Brain MAX die Kontrolle, Automatisierung und Intelligenz, die Sie von einer benutzerdefinierten Lösung erwarten würden – ohne jeglichen Setup- oder Wartungsaufwand. Es ist alles, was Sie brauchen, um Ihre Arbeit zu verwalten, zu automatisieren und zu beschleunigen, direkt von Ihrem Desktop aus!

Häufige Herausforderungen beim Kontextmanagement in der KI

Die Verwaltung des Kontexts in KI-Systemen ist entscheidend, aber alles andere als einfach.

Die meisten KI-Modelle, unabhängig von ihrer Architektur oder ihren Tools, stehen vor einer Reihe gemeinsamer Hindernisse, die ihre Fähigkeit zu präzisem und konsistentem Denken einschränken. Zu diesen Hindernissen gehören:

- Token-Limits und kurze Kontextfenster schränken die Menge an relevanten Informationen ein, die eine KI auf einmal berücksichtigen kann, was oft zu unvollständigen oder oberflächlichen Antworten führt.

- Fragmentierte Datenquellen erschweren es, den richtigen Kontext zu erfassen, insbesondere wenn Informationen über Datenbanken, Apps und Formate verstreut sind.

- Das Fehlen eines Langzeitgedächtnisses über mehrere Sitzungen hinweg zwingt Benutzer dazu, Informationen zu wiederholen, wodurch die Kontinuität bei mehrstufigen Aufgaben unterbrochen wird.

- Mehrdeutigkeiten in Benutzereingaben, insbesondere in mehrteiligen Unterhaltungen, können die KI ohne einen klaren historischen Kontext verwirren.

- Latenz und Kosten werden zu einem Problem, wenn Echtzeit-Trainingsdaten oder Kontexte aus externen Systemen abgerufen werden.

- Das Fehlen einer Standardmethode zum Freigeben oder Verwalten von Kontexten zwischen Tools und Teams führt häufig zu Doppelarbeit, Inkonsistenzen und eingeschränkter Zusammenarbeit.

Diese Probleme zeigen, dass ein standardisiertes, effizientes Kontextmanagement erforderlich ist, was mit MCP-Protokollen erreicht werden soll.

🔍 Wussten Sie schon? Anstatt Befehle direkt zu senden, abonnieren Module relevante Datenströme. Das bedeutet, dass ein Roboterbein möglicherweise nur passiv auf Gleichgewichtsaktualisierungen wartet und nur bei Bedarf aktiv wird.

Modellkontextprotokoll in Aktion

MCP erleichtert die Integration verschiedener Informationsquellen und stellt sicher, dass die KI präzise und kontextbezogene Antworten liefert.

Im Folgenden finden Sie einige praktische Beispiele, die zeigen, wie MCP in verschiedenen Szenarien angewendet werden kann. 👇

1. KI-gestützte Copiloten

Eine der am weitesten verbreiteten Anwendungen von KI-Copiloten ist GitHub Copilot, ein KI-Assistent, der Entwicklern beim Schreiben und Debuggen von Code hilft.

Wenn ein Entwickler eine Funktion schreibt, benötigt Copilot Zugriff auf:

- Code-Verlauf: Die KI ruft den Kontext des aktuellen Codes ab, um relevante Code-Vervollständigungen vorzuschlagen.

- Externe Bibliotheken: Copilot führt eine Abfrage der neuesten Versionen von Bibliotheken oder Frameworks durch und stellt so sicher, dass der Code mit den neuesten Versionen kompatibel ist.

- Echtzeitdaten: Wenn der Entwickler um eine Aktualisierung einer Codierungskonvention oder einer Praxis zur Fehlerbehandlung bittet, ruft Copilot die neueste Dokumentation ab.

🧠 Wissenswertes: MCP Guardian fungiert als eine Art Türsteher für die Nutzung von KI-Tools. Es überprüft Identitäten, blockiert verdächtige Anfragen und protokolliert Alles. Denn offener Tool-Zugriff = Sicherheitschaos.

2. Virtuelle Assistenten

Virtuelle Assistenten wie Google Assistant oder Amazon Alexa sind auf den Kontext angewiesen, um sinnvolle Antworten zu geben. Beispiel:

- Frühere Unterhaltungen: Google Assistant merkt sich frühere Abfragen, wie z. B. Ihre Reisevorlieben, und passt seine Antworten entsprechend an, wenn Sie nach Flugoptionen oder Hotelbuchungen fragen.

- Externe Tools: Es führt eine Abfrage bei APIs von Drittanbietern (z. B. Flugaggregatoren wie Skyscanner) durch, um Echtzeitinformationen zu verfügbaren Flügen zu erhalten.

📖 Lesen Sie auch: Wie man Chain of Thought Prompting verwendet (mit Beispielen)

3. Wissensmanagementsysteme

KI-gesteuerte Datenmanagement-Tools wie IBM Watson helfen Unternehmen dabei, wichtige Informationen aus riesigen Datenbanken oder Repositorys abzurufen:

- Suchkontext: IBM Watson verwendet MCP-Modelle, um frühere Abfragen zu analysieren und die Ergebnisse basierend auf den Präferenzen der Benutzer und historischen Abfragen anzupassen.

- Externe Repositorys: Watson kann externe Repositorys (z. B. Wissensdatenbanken, Forschungsarbeiten oder Unternehmensdokumentationen) abfragen, um die genauesten und relevantesten Informationen abzurufen.

- Personalisierte Empfehlungen: Basierend auf den Interaktionen der Benutzer kann Watson relevante Dokumente, FAQs oder Schulungsmaterialien vorschlagen, die auf die Rolle des Benutzers oder laufende Projekte zugeschnitten sind.

Organisieren, filtern und durchsuchen Sie das Wissen Ihres Unternehmens mit ClickUp Enterprise Search

🪄 Vorteil von ClickUp: Erstellen Sie eine verifizierte, strukturierte Wissensdatenbank in ClickUp Docs und machen Sie sie über ClickUp Knowledge Management als Kontextquelle für Ihr MCP-Gateway verfügbar. Erweitern Sie Docs mit reichhaltigen Inhalten und Medien, um präzise, personalisierte KI-Empfehlungen aus einer zentralen Quelle zu erhalten.

4. Gesundheitswesen

Im Gesundheitswesen bieten Plattformen wie Babylon Health virtuelle Konsultationen mit Patienten an. Diese KI-Systeme sind stark vom Kontext abhängig:

- Patientengeschichte: Die KI muss auf Patientenakten, Symptome und frühere Konsultationen zugreifen können, um fundierte Entscheidungen zu treffen.

- Externe medizinische Daten: Es kann medizinische Daten in Echtzeit abrufen (z. B. die neuesten Forschungsergebnisse zu Symptomen oder Behandlungen), um genauere Gesundheitsempfehlungen zu geben.

- Dynamische Reaktionen: Wenn sich die Symptome des Patienten verändern, nutzt die KI das MCP, um ihre Wissensdatenbank zu aktualisieren und die Behandlungsvorschläge entsprechend anzupassen.

🔍 Wussten Sie schon? Die meisten MCPs wurden nicht unter Berücksichtigung von Aspekten der Sicherheit entwickelt, was sie in Szenarien, in denen Simulationen oder Robotersysteme vernetzt sind, anfällig macht.

So implementieren Sie ein Modellkontextprotokoll

Durch die Implementierung eines Modellkontextprotokolls kann Ihre KI-Anwendung auf modulare und standardisierte Weise mit externen Tools, Diensten und Datenquellen interagieren.

Hier finden Sie eine Schritt-für-Schritt-Anleitung zur Einstellung. 📋

Schritt 1: Definieren Sie Tools, Ressourcen und Handler

Entscheiden Sie zunächst, welche Tools und Ressourcen Ihr MCP-Server bieten soll:

- Tools sind Aktionen, die der Server ausführen kann (z. B. Aufruf einer Wetter-API, Ausführen einer SQL-Abfrage).

- Ressourcen sind statische oder dynamische Daten (z. B. Dokumente, Konfigurationsdateien, Datenbanken).

- Definieren Sie für jedes Tool: Eingabeschema (z. B. Pflichtfelder wie Stadt, Abfrage usw.) Format für die Ausgabe (z. B. strukturiertes JSON-RPC) Die geeignete Methode zur Datenerfassung, um Eingaben zu sammeln

- Eingabeschema (z. B. Pflichtfelder wie Stadt, Abfrage usw.)

- Ausgabeformat (z. B. strukturiertes JSON-RPC)

- Die geeignete Methode zur Datenerfassung, um Eingaben zu sammeln

- Eingabeschema (z. B. Pflichtfelder wie Stadt, Abfrage usw.)

- Ausgabeformat (z. B. strukturiertes JSON-RPC)

- Die geeignete Methode zur Datenerfassung, um Eingaben zu sammeln

Implementieren Sie anschließend Handler. Dabei handelt es sich um Funktionen, die eingehende Tool-Anfragen vom Client verarbeiten:

- Überprüfen Sie die Eingaben, um sicherzustellen, dass sie dem erwarteten Format entsprechen.

- Führen Sie die Kernlogik aus (z. B. Daten aus einer API abrufen, Daten verarbeiten).

- Formatieren und geben Sie die Ergebnisse für den Client zurück.

📌 Beispiel: Ein tool zum Zusammenfassen von Dokumenten könnte den Dateityp der Eingabe (z. B. PDF oder DOCX) validieren, den Text mit einem Dateiparser extrahieren, den Inhalt durch ein Zusammenfassungsmodell oder einen Zusammenfassungsdienst leiten und eine prägnante Zusammenfassung zusammen mit den wichtigsten Themen zurückgeben.

💡 Profi-Tipp: Richten Sie Ereignis-Listener ein, die bestimmte Tools als Auslöser verwenden, wenn bestimmte Aktionen stattfinden, z. B. wenn ein Benutzer eine Eingabe macht oder eine Datenbank aktualisiert wird. Es ist nicht notwendig, Tools im Hintergrund laufen zu lassen, wenn nichts passiert.

Schritt 2: Erstellen oder konfigurieren Sie den MCP-Server.

Verwenden Sie ein Framework wie FastAPI, Flask oder Express, um Ihre Tools und Ressourcen als HTTP-Endpunkte oder WebSocket-Dienste verfügbar zu machen.

Wichtig ist:

- Befolgen Sie eine einheitliche Endpunktstruktur für alle tools (z. B. /invoke/summarize-document).

- Geben Sie JSON-Antworten mit einer vorhersehbaren Struktur zurück, damit Clients sie problemlos nutzen können.

- Gruppieren Sie Funktionen unter einem /capabilities-Endpunkt, damit Clients verfügbare tools finden können.

💡 Profi-Tipp: Behandeln Sie den Kontext wie Code. Jedes Mal, wenn Sie seine Struktur ändern, erstellen Sie eine neue Version. Verwenden Sie Zeitstempel oder Commit-Hashes, damit Sie ohne Probleme zurückrollen können.

Schritt 3: Richten Sie den MCP-Client ein.

Der MCP-Client ist Teil Ihres KI-Systems (z. B. Claude, Cursor oder ein benutzerdefinierter Agent), das mit Ihrem Server kommuniziert.

Beim Start baut der Client eine Verbindung zum MCP-Server auf und ruft über den Endpunkt /capabilities die verfügbaren Funktionen (Tools/Ressourcen) ab. Anschließend registriert er diese Tools für die interne Verwendung, sodass das Modell entscheiden kann, welches Tool während einer Sitzung aufgerufen werden soll.

💡 Profi-Tipp: Fügen Sie unsichtbare Metadaten in den Kontext ein, z. B. Tool-Vertrauenswerte oder Zeitstempel. Tools können diese Informationen nutzen, um intelligentere Entscheidungen zu treffen, z. B. indem sie veraltete Daten überspringen oder Ergebnisse aus besonders vertrauenswürdigen Quellen hervorheben.

Schritt 4: Testen Sie mit einem MCP-kompatiblen Client.

Testen Sie Ihren Remote-MCP-Server vor der Inbetriebnahme mit einem tatsächlichen KI-Client:

- Verwenden Sie ein tool wie Claude Desktop, das MCP sofort unterstützt.

- Probieren Sie typische Anwendungsfälle aus (z. B. Claude nach dem Wetter für heute fragen), um Folgendes zu überprüfen: Die Eingaben werden korrekt validiert. Das richtige Tool wird aufgerufen. Die Antworten werden im richtigen Format zurückgegeben.

- Die Eingaben werden korrekt validiert.

- The correct tool is invoked.

- Die Antworten werden im richtigen Format zurückgegeben.

- Die Eingaben werden korrekt validiert.

- Das richtige Tool wird aufgerufen.

- Die Antworten werden im richtigen Format zurückgegeben.

Dies trägt zu einer nahtlosen Integration mit Geschäftstools bei und verhindert Laufzeitfehler in der Produktion.

Schritt 5: Fügen Sie Sicherheit, Berechtigungen und Beobachtbarkeit hinzu

Zum Schutz sensibler Tools oder Daten:

- Wenden Sie Berechtigungsabfragen an, bevor Sie auf wichtige Tools oder persönliche Ressourcen zugreifen.

- Fügen Sie Protokollierung, Überwachung und Ratenlimit hinzu, um die Nachverfolgung der Nutzung durchzuführen und Anomalien zu erkennen.

- Verwenden Sie Bereiche oder Benutzerrollen, um einzuschränken, welche Tools von wem verwendet werden können.

- Erstellen Sie eine Speicher- oder Zustandsschicht, um frühere Ergebnisse zu speichern und Kontinuität zu gewährleisten.

- Testen Sie unter Last und überwachen Sie die Metriken (Latenz, Erfolgsquote usw.).

Auf diese Weise können Sie leistungsstarke, flexible KI-Systeme aufbauen, die den Kontextzugriff sauber skalieren, ohne dass Sie für jedes Tool oder jeden Anwendungsfall benutzerdefinierte Integrationen schreiben müssen.

Einschränkungen von MCP-Modellen

Modellkontextprotokolle lösen zwar wichtige Herausforderungen beim Freigeben von Kontextinformationen, bringen jedoch auch einige Nachteile mit sich:

- Tool-Abhängigkeit: MCP erfordert kompatible Server und tools. Legacy-Systeme und nicht standardisierte APIs sind schwer zu integrieren.

- Komplexität des Setups: Die Ersteinrichtung, die Definition von Tools und das Schreiben von Handlern erfordern technischen Aufwand und stellen für neue Teams eine gewisse Lernkurve dar.

- Latenz-Overhead: Jeder externe Aufruf führt zu Verzögerungen bei der Antwort, insbesondere wenn mehrere tools miteinander verkettet sind.

- Sicherheitsbedenken: Die Offenlegung von Tools und Datenquellen erhöht die Angriffsfläche. Fein abgestimmte Zugriffskontrollen und Audit-Protokollierung sind noch nicht ausgereift.

- Eingeschränkte Koordination mehrerer Server: Die Zusammenführung von Kontexten über mehrere Server hinweg ist nicht nahtlos, was zu fragmentierten oder inkonsistenten Ergebnissen führt.

Wie ClickUp AI als Alternative zu Modellkontextprotokollen dient

Modellkontextprotokolle bieten KI-Systemen eine strukturierte Möglichkeit, externen Kontext durch standardisierte Aufrufe abzurufen. Der Aufbau und die Wartung dieser Systeme kann jedoch komplex sein, insbesondere in kollaborativen Teamumgebungen.

ClickUp verfolgt einen anderen Ansatz. Es bettet den Kontext direkt in Ihren Workspace ein, wo die Arbeit tatsächlich stattfindet. Dies macht ClickUp zu einer Erweiterungsschicht und einem tief integrierten, für Teams optimierten agentenbasierten System.

Lassen Sie uns dies besser verstehen. 📝

Speicher in den Workspace integrieren

Das Herzstück der KI-Fähigkeiten von ClickUp ist ClickUp Brain, eine kontextsensitive Engine, die als integriertes Speichersystem fungiert.

Im Gegensatz zu herkömmlichen MCPs, die sich auf eine oberflächliche Prompt-Historie oder externe Datenbanken stützen, versteht Brain die Struktur Ihres Workspaces und speichert wichtige Informationen aus Aufgaben, Kommentaren, Zeitleisten und Dokumenten. Es kann:

- Identifizieren Sie Engpässe auf der Grundlage historischer Verzögerungen und Blockaden.

- Beantworten Sie rollenspezifische Abfragen wie „Wem gehört das?“ oder „Wurde es von der Qualitätssicherung geprüft?“

- Verwandeln Sie Meeting-Notizen in strukturierte Aufgaben, komplett mit Zuweisungen und Fristen.

📌 Beispiel: Bitten Sie Brain, „den Fortschritt der Marketingkampagnen im 2. Quartal zusammenzufassen”, und es verweist auf verwandte Aufgaben, Status und Kommentare in verschiedenen Projekten.

Automatisierung von Antworten, Aufgabenzuweisungen und Aktionen

Während MCP-Implementierungen eine kontinuierliche Modelloptimierung erfordern, vereint ClickUp als Software zur Automatisierung von Aufgaben Entscheidungsfindung und Ausführung in einem System.

Mit ClickUp Automations können Sie Aktionen basierend auf Ereignissen, Bedingungen und Logik als Auslöser verwenden, ohne eine einzige Zeile Code schreiben zu müssen. Sie können auch ClickUp Brain verwenden, um benutzerdefinierte Automatisierungen für Dateneinträge mit natürlicher Sprache zu erstellen, wodurch die Erstellung personalisierter Workflows vereinfacht wird.

Nutzen Sie ClickUp Brain, um mit ClickUp Automatisierungen benutzerdefinierte Auslöser zu erstellen.

📌 Beispiel: Verschieben Sie Aufgaben in den Status „In Bearbeitung“, wenn sich der Status ändert, weisen Sie den Teamleiter zu, wenn „Hohe Priorität“ markiert ist, und benachrichtigen Sie den Eigentümer des Projekts, wenn ein Fälligkeitsdatum überschritten wird.

📖 Lesen Sie auch: Leitfaden zu Automatisierungen in ClickUp (mit Beispielen)

Auf dieser Grundlage bieten ClickUp Autopilot Agents ein neues Maß an intelligenter Autonomie. Diese KI-gestützten Agenten arbeiten auf Basis von:

- Auslöser (z. B. Aktualisierungen von Aufgaben, Erwähnungen im Chat)

- Bedingungen (z. B. enthält die Nachricht dringend)

- Aktionen (z. B. einen Thread zusammenfassen, eine Aufgabe zuweisen, eine Benachrichtigung senden)

- Tools (z. B. Beiträge in Kanälen veröffentlichen, Felder aktualisieren)

- Wissen (z. B. interne Dokumente, Aufgaben, Formulare und Chat-Verlauf)

Informationen in umsetzbaren Kontext verwandeln

ClickUp nutzt als KI-Agent Ihre vorhandenen Workspace-Daten, um ohne Setup intelligenter zu agieren. So können Sie alle Informationen aus Ihrem Workspace in handlungsrelevanten Kontext umwandeln:

- Aufgaben und Unteraufgaben: Weisen Sie innerhalb von ClickUp Aufgaben Folgemaßnahmen zu, erstellen Sie Zusammenfassungen oder passen Sie Prioritäten an. Die KI bezieht sich dabei direkt auf die Mitarbeiter, Fälligkeitsdaten und Kommentare.

- Dokumente und Wikis: Bitten Sie die KI, während des Plans mithilfe von Docs auf das Wissen des Teams zurückzugreifen, Dokumentationen zusammenzufassen oder wichtige Punkte zu extrahieren.

- Benutzerdefinierte Felder: Verwenden Sie Ihre eigenen Tags, Kategorien oder Bewertungen, um Antworten zu personalisieren. Die KI interpretiert Ihre Metadaten, um die Ausgabe an die Sprache Ihres Teams anzupassen.

- Kommentare und Chatten: Setzen Sie Unterhaltungen über mehrere Threads hinweg fort oder generieren Sie Aktionen auf der Grundlage von Diskussionen.

Sehen Sie sich hier die KI-gestützten benutzerdefinierten Felder in Aktion an. 👇🏼

Die Zukunft der Modellkontextprotokolle

Da sich KI zunehmend von statischen Chatbots zu dynamischen Multi-Agent-Systemen entwickelt, wird die Rolle von MCPs immer wichtiger. Mit der Unterstützung von großen Namen wie OpenAI und Anthropic versprechen MCPs Interoperabilität zwischen komplexen Systemen.

Aber dieses Versprechen wirft große Fragen auf. 🙋

Zunächst einmal sind die meisten MCP-Implementierungen heute nur für Demo-Zwecke geeignet, verwenden grundlegende Studio-Transportprotokolle, bieten keinen HTTP-Support und verfügen über keine integrierte Authentifizierung oder Autorisierung. Das ist für den Einsatz in Unternehmen ein No-Go. Anwendungsfälle in der Praxis erfordern Sicherheit, Beobachtbarkeit, Zuverlässigkeit und flexible Skalierbarkeit.

Um diese Lücke zu schließen, wurde das Konzept eines MCP-Mesh entwickelt. Es wendet bewährte Service-Mesh-Muster (wie sie in Microservices verwendet werden) auf die MCP-Infrastruktur an. MCP-Mesh unterstützt außerdem den sicheren Zugriff, die Kommunikation, das Verkehrsmanagement, die Ausfallsicherheit und die Erkennung über mehrere verteilte Server hinweg.

Gleichzeitig zeigen KI-gestützte Plattformen wie ClickUp, dass tief eingebettete In-App-Kontextmodelle eine praktischere Alternative in teamorientierten Umgebungen darstellen können.

In Zukunft werden wir möglicherweise hybride Architekturen sehen, die den Weg für KI-Agenten ebnen, die sowohl bewusst als auch handlungsfähig sind.

Handelsprotokolle für Produktivität mit ClickUp

Das Model Context Protocol standardisiert den Zugriff der KI auf externe Systeme, erfordert jedoch ein komplexes Setup.

Das MCP ist zwar leistungsstark, erfordert jedoch ein technisches Setup, was die Entwicklungszeit, die Kosten und den laufenden Wartungsaufwand erhöht.

ClickUp bietet mit ClickUp Brain und Automatisierungen, die direkt in Ihren Workspace integriert sind, eine praktische Alternative.

Es versteht automatisch den Aufgabenkontext, die Projektdaten und die Absichten der Benutzer. Dies macht ClickUp zu einer idealen Low-Code-Lösung für Teams, die eine skalierbare, kontextbezogene KI ohne technischen Aufwand wünschen.

✅ Melden Sie sich noch heute bei ClickUp an!