تكتشف معظم الفرق التي تستكشف نماذج الذكاء الاصطناعي مفتوحة المصدر أن LLaMA من Meta توفر مزيجًا نادرًا من القوة والمرونة، ولكن الإعداد التقني قد يبدو وكأنه تجميع أثاث بدون تعليمات.

يوجهك هذا الدليل خلال عملية إنشاء روبوت دردشة LLaMA وظيفي من البداية، ويغطي كل شيء بدءًا من متطلبات الأجهزة والوصول إلى النماذج وحتى هندسة المطالبات واستراتيجيات النشر.

لنبدأ!

ما هو LLaMA ولماذا يستخدم في روبوتات الدردشة؟

غالبًا ما يبدو إنشاء روبوت دردشة باستخدام واجهات برمجة تطبيقات خاصة وكأنك محبوس في نظام شخص آخر، وتواجه تكاليف غير متوقعة ومشكلات تتعلق بخصوصية البيانات. هذا التقييد من قبل المورد يعني أنه لا يمكنك تخصيص النموذج حقًا لتلبية الاحتياجات الفريدة لفريقك، مما يؤدي إلى ردود عامة ومشكلات محتملة تتعلق بالامتثال.

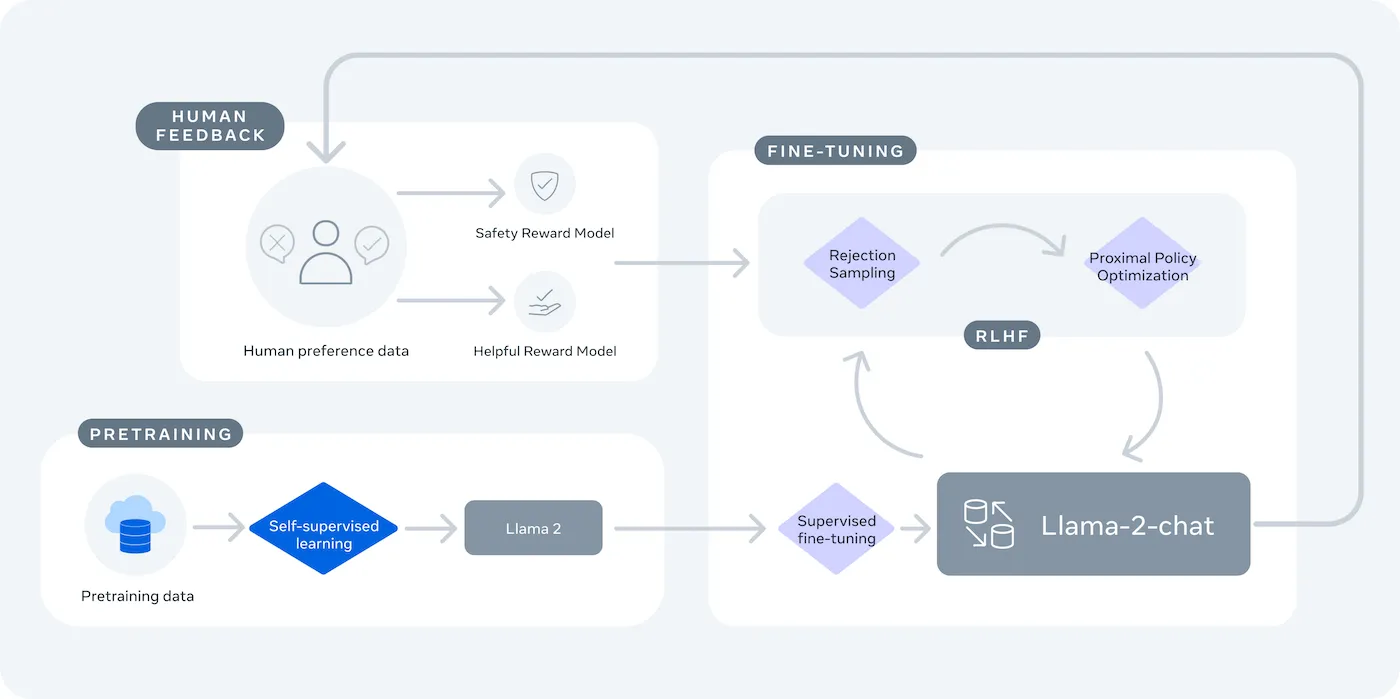

LLaMA (Large Language Model Meta AI) هي مجموعة نماذج لغوية مفتوحة الوزن من Meta، وتقدم بديلاً قوياً. وهي مصممة للاستخدام في الأبحاث والاستخدام التجاري، وتمنحك التحكم الذي لا توفره النماذج المغلقة المصدر.

تأتي نماذج LLaMA بأحجام مختلفة، تقاس بالمعلمات (على سبيل المثال، 7B، 13B، 70B). فكر في المعلمات على أنها مقياس لمدى تعقيد النموذج وقوته — النماذج الأكبر حجمًا تكون أكثر قدرة ولكنها تتطلب موارد حسابية أكثر.

إليك الأسباب التي قد تدفعك إلى استخدام روبوت الدردشة LLaMA:

- خصوصية البيانات: عند تشغيل نموذج على البنية التحتية الخاصة بك، لا تغادر بيانات المحادثات بيئتك أبدًا. وهذا أمر بالغ الأهمية للفرق التي تتعامل مع معلومات حساسة.

- التخصيص: يمكنك ضبط نموذج LLaMA على المستندات أو البيانات الداخلية لشركتك. يساعد ذلك في فهم السياق المحدد الخاص بك وتقديم إجابات أكثر صلة بالموضوع.

- تكلفة قابلة للتنبؤ: بعد الإعداد الأولي للأجهزة، لا داعي للقلق بشأن رسوم API لكل رمز. تصبح تكاليفك ثابتة وقابلة للتنبؤ.

- لا حدود للسرعة: سعة روبوت الدردشة الخاص بك محدودة بقدرات أجهزتك، وليس بحصص المورد. يمكنك التوسع حسب الحاجة.

المفاضلة الرئيسية هي الراحة مقابل التحكم. يتطلب LLaMA إعدادًا تقنيًا أكثر من واجهة برمجة التطبيقات (API) الجاهزة للاستخدام. بالنسبة لروبوتات الدردشة الإنتاجية، تستخدم الفرق عادةً LLaMA 2 أو LLaMA 3 الأحدث، والذي يوفر قدرات استدلال محسنة ويمكنه معالجة المزيد من النصوص في وقت واحد.

ما تحتاجه قبل إنشاء روبوت دردشة LLaMA

الانطلاق في مشروع تطوير بدون الأدوات المناسبة هو وصفة مؤكدة للإحباط. تصل إلى منتصف الطريق، لتدرك أنك تفتقد إلى جزء أساسي من الأجهزة أو البرامج، مما يعرقل تقدمك ويضيع ساعات من وقتك.

لتجنب ذلك، اجمع كل ما تحتاجه مسبقًا. إليك قائمة مرجعية لضمان بداية سلسة. 🛠️

متطلبات الأجهزة

| حجم النموذج | الحد الأدنى من ذاكرة VRAM | خيار بديل |

|---|---|---|

| 7 مليار معلمة | 8 جيجابايت | مثيل GPU السحابي |

| 13 مليار معلمة | 16 جيجابايت | مثيل GPU السحابي |

| 70 مليار معلمة | وحدات معالجة رسومات متعددة | التكمية أو السحابة |

إذا كان جهازك المحلي لا يحتوي على وحدة معالجة رسومات (GPU) قوية بما يكفي، يمكنك استخدام خدمات السحابة مثل AWS أو GCP. توفر منصات الاستدلال مثل Baseten و Replicate أيضًا وصولًا إلى GPU بنظام الدفع الفوري.

متطلبات البرنامج

- Python 3. 8+: هذه هي لغة البرمجة القياسية لمشاريع التعلم الآلي.

- مدير الحزم: ستحتاج إلى pip أو Conda لتثبيت المكتبات اللازمة لمشروعك.

- البيئة الافتراضية: هذه أفضل الممارسات التي تحافظ على عزل تبعيات مشروعك عن مشاريع Python الأخرى على جهازك.

متطلبات الوصول

- حساب Hugging Face: ستحتاج إلى حساب لتنزيل أوزان نموذج LLaMA.

- موافقة Meta: يجب عليك قبول اتفاقية ترخيص Meta للوصول إلى نماذج LLaMA، والتي عادةً ما تتم الموافقة عليها في غضون ساعات قليلة.

- مفاتيح API: هذه المفاتيح ضرورية فقط إذا قررت استخدام نقطة نهاية استدلال مستضافة بدلاً من تشغيل النموذج محليًا.

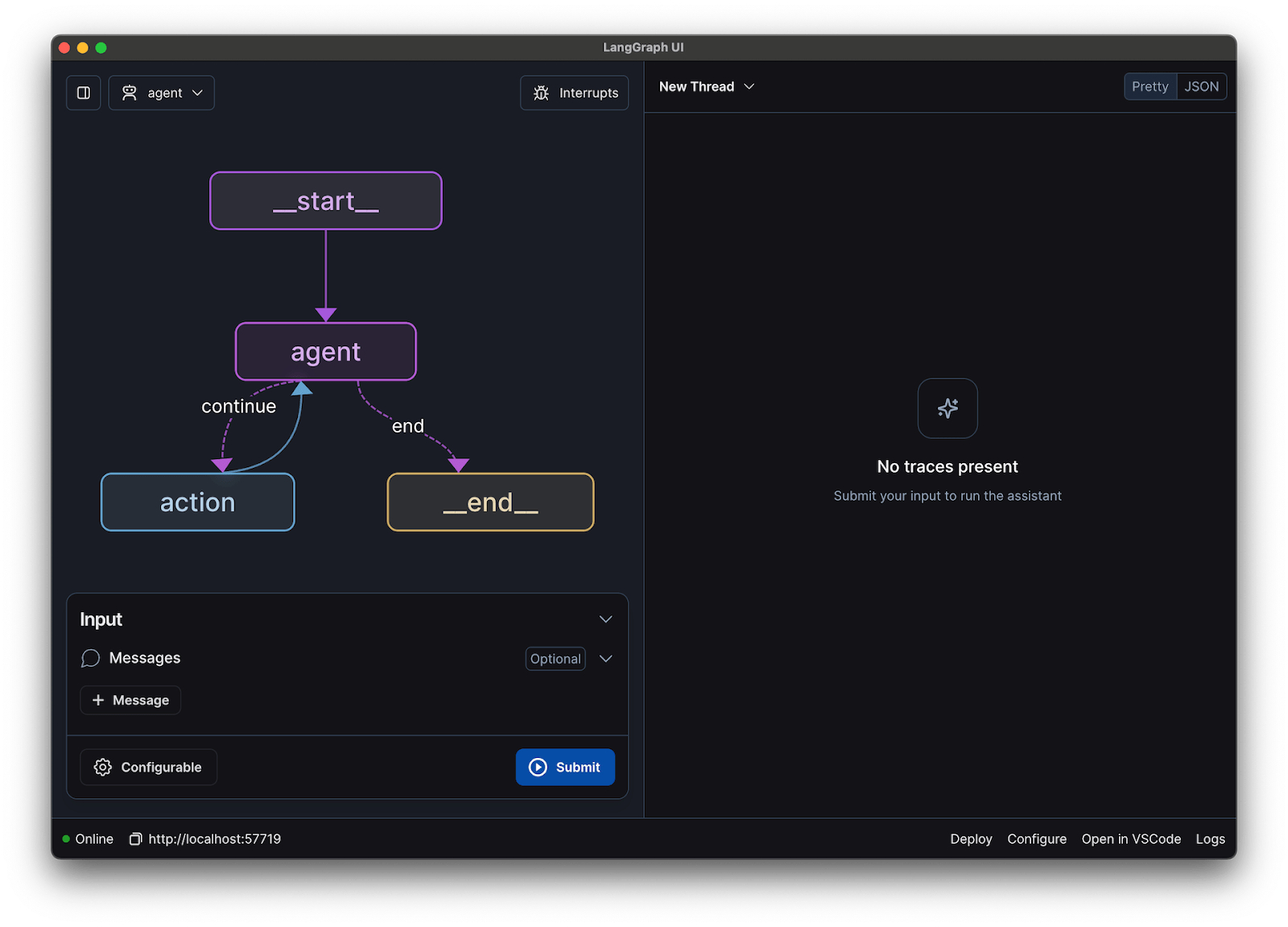

في هذا الدليل، سنستخدم إطار عمل LangChain. فهو يبسط العديد من الأجزاء المعقدة في إنشاء روبوت الدردشة، مثل إدارة المطالبات وسجل المحادثات.

كيفية إنشاء روبوت دردشة باستخدام LLaMA خطوة بخطوة

قد يبدو ربط جميع الأجزاء التقنية لروبوت الدردشة — النموذج، الموجه، الذاكرة — أمرًا صعبًا للغاية. من السهل أن تضيع في الكود، مما يؤدي إلى حدوث أخطاء وروبوت دردشة لا يعمل كما هو متوقع. يقسم هذا الدليل التفصيلي العملية إلى أجزاء بسيطة وسهلة الإدارة.

يعمل هذا النهج سواء كنت تقوم بتشغيل النموذج على جهازك الخاص أو تستخدم خدمة مستضافة.

الخطوة 1: تثبيت الحزم المطلوبة

أولاً، تحتاج إلى تثبيت مكتبات Python الأساسية. افتح جهازك الطرفي وقم بتشغيل هذا الأمر:

pip install langchain transformers accelerate torch

إذا كنت تستخدم خدمة مستضافة مثل Baseten للاستدلال، فستحتاج أيضًا إلى تثبيت مجموعة أدوات تطوير البرامج (SDK) الخاصة بها:

pip install baseten

إليك ما تفعله كل حزمة من هذه الحزم:

- Langchain: إطار عمل يساعد في إنشاء تطبيقات باستخدام نماذج لغوية كبيرة، بما في ذلك إدارة سلاسل المحادثات والذاكرة.

- Transformers: مكتبة Hugging Face لتحميل وتشغيل نموذج LLaMA

- Accelerate: مكتبة تساعد في تحسين طريقة تحميل النموذج على وحدة المعالجة المركزية (CPU) ووحدة معالجة الرسومات (GPU)

- Torch: مكتبة PyTorch، التي توفر القوة الخلفية لحسابات النموذج.

إذا كنت تقوم بتشغيل النموذج محليًا على جهاز مزود بوحدة معالجة رسومات NVIDIA، فتأكد من تثبيت CUDA وتكوينه بشكل صحيح. يتيح ذلك للنموذج استخدام وحدة معالجة الرسومات للحصول على أداء أسرع بكثير.

الخطوة 2: احصل على نماذج LLaMA

قبل أن تتمكن من تنزيل النموذج، تحتاج إلى الحصول على وصول رسمي من Meta عبر Hugging Face.

- أنشئ حسابًا على huggingface.co

- انتقل إلى صفحة النموذج، على سبيل المثال، meta-llama/Llama-2-7b-chat-hf

- انقر على "الوصول إلى المستودع" ووافق على شروط ترخيص Meta.

- في إعدادات حساب Hugging Face الخاص بك، قم بإنشاء رمز وصول جديد

- في جهازك الطرفي، قم بتشغيل huggingface-cli login والصق الرمز المميز الخاص بك لمصادقة جهازك.

عادةً ما تكون الموافقة سريعة. تأكد من اختيار نموذج يحتوي على كلمة "chat" في اسمه، حيث تم تدريب هذه النماذج خصيصًا على مهام المحادثة.

الخطوة 3: قم بتحميل نموذج LLaMA

الآن يمكنك تحميل النموذج في الكود الخاص بك. لديك خياران رئيسيان اعتمادًا على أجهزتك.

إذا كان لديك وحدة معالجة رسومات (GPU) قوية بما يكفي، يمكنك تحميل النموذج محليًا:

إذا كانت أجهزتك محدودة، يمكنك استخدام خدمة استدلال مستضافة:

يخبر الأمر device_map="auto" مكتبة المحولات بتوزيع النموذج تلقائيًا على أي وحدات معالجة رسومات متاحة.

إذا كنت لا تزال تعاني من نقص في الذاكرة، يمكنك استخدام تقنية تسمى التكمية لتقليص حجم النموذج، على الرغم من أن ذلك قد يقلل قليلاً من أدائه.

الخطوة 4: إنشاء قالب موجه

تم تدريب نماذج الدردشة LLaMA على توقع تنسيق معين للمطالبات. يضمن نموذج المطالبة أن تكون مدخلاتك منظمة بشكل صحيح.

دعونا نحلل هذا التنسيق:

- <

>: يحتوي هذا القسم على موجه النظام، الذي يمنح النموذج تعليماته الأساسية ويحدد شخصيته. - [INST]: يشير إلى بداية سؤال أو تعليمات المستخدم

- [/INST]: يشير هذا إلى النموذج بأن الوقت قد حان لتوليد استجابة

ضع في اعتبارك أن الإصدارات المختلفة من LLaMA قد تستخدم قوالب مختلفة قليلاً. تحقق دائمًا من وثائق النموذج على Hugging Face للتأكد من التنسيق الصحيح.

الخطوة 5: إعداد سلسلة روبوتات الدردشة

بعد ذلك، ستقوم بتوصيل نموذجك ونموذج الموجهات بسلسلة محادثات باستخدام LangChain. ستتضمن هذه السلسلة أيضًا ذاكرة لتتبع المحادثة.

تقدم LangChain عدة أنواع من الذاكرة:

- ConversationBufferMemory: هذا هو الخيار الأبسط. فهو يخزن سجل المحادثة بالكامل.

- ConversationSummaryMemory: لتوفير المساحة، تقوم هذه الخيار بتلخيص الأجزاء القديمة من المحادثة بشكل دوري.

- ConversationBufferWindowMemory: يحتفظ هذا فقط بآخر المحادثات في الذاكرة، وهو أمر مفيد لمنع السياق من أن يصبح طويلاً للغاية.

للاختبار، يعد ConversationBufferMemory مكانًا رائعًا للبدء.

الخطوة 6: تشغيل حلقة روبوت الدردشة

أخيرًا، يمكنك إنشاء حلقة بسيطة للتفاعل مع روبوت الدردشة الخاص بك من المحطة الطرفية.

في تطبيق واقعي، يمكنك استبدال هذه الحلقة بنقطة نهاية API باستخدام إطار عمل مثل FastAPI أو Flask. يمكنك أيضًا بث استجابة النموذج إلى المستخدم، مما يجعل روبوت الدردشة يبدو أسرع بكثير.

يمكنك أيضًا ضبط معلمات مثل درجة الحرارة للتحكم في عشوائية الاستجابات. تؤدي درجة الحرارة المنخفضة (على سبيل المثال، 0.2) إلى جعل الناتج أكثر حتمية وواقعية، بينما تشجع درجة الحرارة الأعلى (على سبيل المثال، 0.8) على مزيد من الإبداع.

كيفية اختبار روبوت الدردشة LLaMA الخاص بك

لقد أنشأت روبوت دردشة يقدم إجابات، ولكن هل هو جاهز للمستخدمين الحقيقيين؟ قد يؤدي نشر روبوت لم يتم اختباره إلى فشل محرج، مثل تقديم معلومات غير صحيحة أو إنشاء محتوى غير لائق، مما قد يضر بسمعة شركتك.

خطة الاختبار المنهجية هي الحل لهذه الشكوك. فهي تضمن أن روبوت الدردشة الخاص بك قوي وموثوق وآمن.

اختبار وظيفي:

- الحالات الاستثنائية: اختبر كيفية تعامل الروبوت مع المدخلات الفارغة والرسائل الطويلة جدًا والأحرف الخاصة.

- التحقق من الذاكرة: تأكد من أن روبوت الدردشة يتذكر السياق عبر عدة جولات في المحادثة.

- اتباع التعليمات: تحقق مما إذا كان الروبوت يلتزم بالقواعد التي قمت بتعيينها في موجه النظام

تقييم الجودة:

- الصلة: هل الإجابة تجيب بالفعل على سؤال المستخدم؟

- الدقة: هل المعلومات التي يقدمها صحيحة؟

- الترابط: هل المحادثة تسير بشكل منطقي؟

- الأمان: هل يرفض الروبوت الرد على الطلبات غير اللائقة أو الضارة؟

اختبار الأداء:

- زمن الاستجابة: قم بقياس المدة التي يستغرقها الروبوت لبدء الاستجابة وإنهاء استجابته.

- استخدام الموارد: راقب مقدار ذاكرة GPU التي يستخدمها النموذج أثناء الاستدلال

- التزامن: اختبر أداء النظام عندما يتفاعل معه عدة مستخدمين في نفس الوقت.

كما يجب الانتباه إلى المشكلات الشائعة في LLM مثل الهلوسة (تقديم معلومات خاطئة بثقة)، وانحراف السياق (فقدان مسار الموضوع في محادثة طويلة)، والتكرار. يعد تسجيل جميع المحادثات التجريبية طريقة رائعة لاكتشاف الأنماط وإصلاح المشكلات قبل أن تصل إلى المستخدمين.

📚 اقرأ أيضًا: الفرق بين الاختبار الوظيفي والاختبار غير الوظيفي

حالات استخدام روبوتات الدردشة LLaMA للفرق

بمجرد تجاوز آليات الضبط الدقيق والنشر، يصبح LLaMA أكثر قيمة عند تطبيقه على مشاكل الفريق اليومية — وليس عروض الذكاء الاصطناعي المجردة. لا تحتاج الفرق عادةً إلى "روبوت دردشة"؛ بل تحتاج إلى وصول أسرع إلى المعرفة، وتقليل عمليات التسليم اليدوية، وتقليل الأعمال المتكررة.

مساعد المعرفة الداخلي

من خلال ضبط LLaMA على الوثائق الداخلية والويكي والأسئلة الشائعة — أو إقرانه بقاعدة معرفية قائمة على RAG — يمكن للفرق طرح أسئلة باللغة الطبيعية والحصول على إجابات دقيقة ومراعية للسياق. وهذا يزيل عناء البحث عبر أدوات متفرقة مع الحفاظ على البيانات الحساسة داخل الشركة بالكامل، بدلاً من إرسالها إلى واجهات برمجة تطبيقات تابعة لجهات خارجية.

🌟 يوفر البحث المؤسسي في ClickUp ووكيل Ambient Answers المُعد مسبقًا إجابات سياقية مفصلة لأسئلتك باستخدام المعرفة الموجودة في مساحة عمل ClickUp الخاصة بك.

مساعد مراجعة الكود

عند تدريب LLaMA على قاعدة الكود الخاصة بك وأدلة الأنماط، يمكن أن يعمل كمساعد لمراجعة الكود السياقي. بدلاً من أفضل الممارسات العامة، يحصل المطورون على اقتراحات تتوافق مع اصطلاحات الفريق وقرارات الهندسة المعمارية والأنماط التاريخية.

🌟 يمكن لمساعد مراجعة الكود المستند إلى LLaMA الكشف عن المشكلات واقتراح التحسينات أو شرح الكود غير المألوف. يخطو Codegen من ClickUp خطوة إلى الأمام من خلال العمل داخل سير عمل التطوير — إنشاء طلبات سحب أو تطبيق إعادة هيكلة أو تحديث الملفات مباشرة استجابةً لتلك الأفكار. والنتيجة هي تقليل عمليات النسخ واللصق وتقليل حالات التعطل بين "التفكير" و"التنفيذ".

فرز دعم العملاء

يمكن تدريب LLaMA على تصنيف النوايا لفهم استفسارات العملاء الواردة وتوجيهها إلى الفريق أو سير العمل المناسب. يمكن التعامل مع الأسئلة الشائعة تلقائيًا، بينما يتم رفع الحالات الاستثنائية إلى وكلاء بشريين مع إرفاق السياق، مما يقلل من أوقات الاستجابة دون التضحية بالجودة.

يمكنك أيضًا إنشاء Triage Super Agent باستخدام اللغة الطبيعية داخل مساحة عمل ClickUp الخاصة بك. تعرف على المزيد

تلخيص الاجتماعات ومتابعتها

باستخدام محاضر الاجتماعات كمدخلات، يمكن لـ LLaMA استخراج القرارات وبنود العمل ونقاط المناقشة الرئيسية. تظهر القيمة الحقيقية عندما تتدفق هذه المخرجات مباشرة إلى أدوات إدارة المهام، مما يحول المحادثات إلى عمل يمكن تتبعه.

🌟 لا يقتصر دور AI Meeting Notetaker من ClickUp على تدوين ملاحظات الاجتماعات فحسب، بل إنه يقوم أيضًا بصياغة الملخصات وإنشاء بنود العمل وربط ملاحظات الاجتماعات بوثائقك ومهامك.

صياغة المستندات وتكرارها

يمكن للفرق استخدام LLaMA لإنشاء المسودات الأولى للتقارير أو المقترحات أو الوثائق استنادًا إلى القوالب الحالية والأمثلة السابقة. وهذا يحول الجهد من إنشاء صفحة فارغة إلى المراجعة والتحسين، مما يسرع التسليم دون خفض المعايير.

🌟 يمكن لـ ClickUp Brain إنشاء مسودات للوثائق بسرعة، مع الحفاظ على جميع معارف مكان العمل في سياقها. جربه اليوم.

تكون روبوتات الدردشة التي تعمل بنظام LLaMA أكثر فاعلية عندما يتم دمجها في سير العمل الحالي — التوثيق وإدارة المشاريع والتواصل بين أعضاء الفريق — بدلاً من تشغيلها كأدوات مستقلة.

هنا يكمن الفرق الذي يحدثه دمج الذكاء الاصطناعي مباشرة في مساحة عملك. بدلاً من إنشاء أداة منفصلة، يمكنك جلب الذكاء الاصطناعي التخاطبي إلى المكان الذي يعمل فيه فريقك بالفعل.

على سبيل المثال، يمكنك إنشاء روبوت LLaMA مخصص ليكون بمثابة مساعد معرفي. ولكن إذا كان هذا الروبوت خارج أداة إدارة المشاريع الخاصة بك، فسيتعين على فريقك تغيير السياق لطرح سؤال عليه. وهذا يخلق توتراً ويبطئ عمل الجميع.

تخلص من هذا التبديل في السياق باستخدام الذكاء الاصطناعي الذي يعد بالفعل جزءًا من سير عملك.

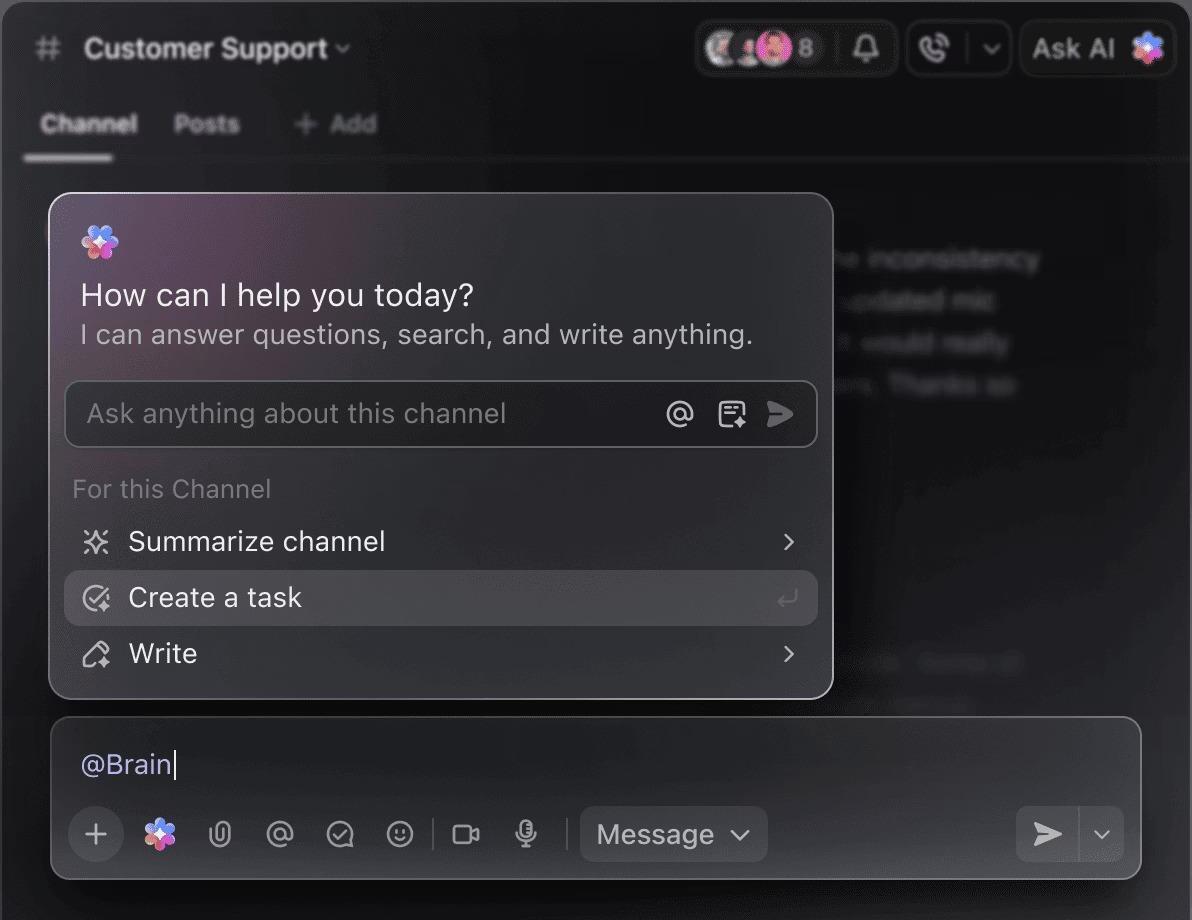

اطرح أسئلة حول مشاريعك ومهامك ووثائقك دون مغادرة ClickUp باستخدام ClickUp Brain. ما عليك سوى كتابة @brain في أي تعليق على المهمة أو في ClickUp Chat للحصول على إجابة فورية ومناسبة للسياق. الأمر أشبه بوجود عضو في الفريق لديه معرفة كاملة بمساحة العمل بأكملها. 🤩

وهذا يحول روبوت الدردشة من مجرد شيء جديد إلى جزء أساسي من محرك إنتاجية فريقك.

قيود استخدام LLaMA لإنشاء روبوتات الدردشة

يمكن أن يكون إنشاء روبوت دردشة LLaMA أمرًا مهمًا، ولكن غالبًا ما تفاجأ الفرق بالتعقيدات الخفية. قد ينتهي الأمر بنموذج المصادر المفتوحة "المجاني" إلى أن يكون أكثر تكلفة وصعوبة في الإدارة مما كان متوقعًا، مما يؤدي إلى تجربة مستخدم سيئة ودورة صيانة مستمرة تستنزف الموارد.

من المهم فهم القيود قبل الالتزام.

- التعقيد التقني: يتطلب إعداد نموذج LLaMA وصيانته معرفة بالبنية التحتية للتعلم الآلي.

- متطلبات الأجهزة: يتطلب تشغيل النماذج الأكبر والأكثر قدرة أجهزة GPU باهظة الثمن، ويمكن أن ترتفع تكاليف السحابة بسرعة.

- قيود نافذة السياق: تتمتع نماذج LLaMA بذاكرة محدودة ( 4K رموز لـ LLaMA 2 ). يتطلب التعامل مع المستندات أو المحادثات الطويلة استراتيجيات تقسيم معقدة.

- لا توجد حواجز أمان مدمجة: أنت مسؤول عن تنفيذ إجراءات تصفية المحتوى وتدابير الأمان الخاصة بك.

- الصيانة المستمرة: مع إصدار نماذج جديدة، ستحتاج إلى تحديث أنظمتك، وقد تتطلب النماذج المعدلة إعادة التدريب.

عادةً ما تتميز النماذج المستضافة ذاتيًا بزمن انتقال أعلى من واجهات برمجة التطبيقات التجارية عالية التحسين. كل هذه أعباء تشغيلية تتولى الحلول المدارة التعامل معها نيابة عنك.

📮ClickUp Insight: 88٪ من المشاركين في استطلاعنا يستخدمون الذكاء الاصطناعي في مهامهم الشخصية، لكن أكثر من 50٪ يتجنبون استخدامه في العمل. ما هي العوائق الثلاثة الرئيسية؟ عدم وجود تكامل سلس، وفجوات في المعرفة، أو مخاوف أمنية.

ولكن ماذا لو كان الذكاء الاصطناعي مدمجًا في مساحة عملك وكان آمنًا بالفعل؟ ClickUp Brain، مساعد الذكاء الاصطناعي المدمج في ClickUp، يجعل هذا حقيقة واقعة. فهو يفهم المطالبات بلغة بسيطة، ويحل جميع المخاوف الثلاثة المتعلقة بتبني الذكاء الاصطناعي بينما يربط الدردشة والمهام والمستندات والمعرفة عبر مساحة العمل. اعثر على الإجابات والرؤى بنقرة واحدة!

بدائل LLaMA لإنشاء روبوتات الدردشة

LLaMA هو مجرد خيار واحد من بين العديد من نماذج الذكاء الاصطناعي، وقد يكون من الصعب تحديد النموذج المناسب لك.

فيما يلي تفصيل لخيارات البدائل المتاحة.

نماذج مفتوحة المصدر أخرى:

- Mistral: معروف بأدائه القوي حتى مع أحجام النماذج الأصغر، مما يجعله فعالاً.

- Falcon: يأتي مع ترخيص متساهل للغاية، وهو أمر رائع للتطبيقات التجارية.

- MPT: مُحسّن للتعامل مع المستندات والمحادثات الطويلة

واجهات برمجة التطبيقات التجارية:

- OpenAI (GPT-4، GPT-3. 5): تعتبر عمومًا أكثر نماذج اللغات الكبيرة قدرةً، وهي سهلة التكامل للغاية.

- Anthropic (Claude): معروف بميزات الأمان القوية ونوافذ السياق الكبيرة جدًا

- Google (Gemini): يوفر إمكانات متعددة الوسائط قوية، مما يتيح له فهم النصوص والصور والصوت.

يمكنك إنشاؤه بنفسك باستخدام نموذج مفتوح المصدر، أو الدفع مقابل واجهة برمجة تطبيقات تجارية، أو استخدام مساحة عمل ذكاء اصطناعي متقاربة توفر حلاً مدمجًا مسبقًا مع أنواع مختلفة من وكلاء الذكاء الاصطناعي.

📚 اقرأ أيضًا: كيفية استخدام روبوت الدردشة في عملك

أنشئ مساعدات ذكاء اصطناعي مدركة للسياق باستخدام ClickUp

يمنحك إنشاء روبوت دردشة باستخدام LLaMA تحكمًا مذهلاً في بياناتك وتكاليفك وتخصيصاتك. لكن هذا التحكم يأتي مع مسؤولية البنية التحتية والصيانة والسلامة — وهي جميعها أمور تتولى API المدارة التعامل معها نيابة عنك. الهدف ليس مجرد إنشاء روبوت — بل هو جعل فريقك أكثر إنتاجية، وقد يؤدي مشروع هندسي معقد في بعض الأحيان إلى تشتيت الانتباه عن هذا الهدف.

يعتمد الاختيار الصحيح على موارد فريقك وأولوياته. إذا كانت لديك خبرة في التعلم الآلي واحتياجات صارمة في مجال الخصوصية، فإن LLaMA هو خيار رائع. إذا كنت تفضل السرعة والبساطة، فقد تكون الأداة المتكاملة هي الخيار الأنسب.

مع ClickUp، تحصل على مساحة عمل ذكاء اصطناعي متكاملة تضم جميع مهامك ووثائقك ومحادثاتك في مكان واحد، مدعومة بذكاء اصطناعي متكامل. تقلل من انتشار السياق وتساعد الفرق على العمل بشكل أسرع وأكثر فعالية، مع توفر المعلومات الصحيحة في متناول أيديهم من خلال Super Agents القابلة للتخصيص والذكاء الاصطناعي السياقي.

توقف عن إضاعة الوقت في البنية التحتية واستفد من مزايا مساعد الذكاء الاصطناعي الذي يدرك السياق اليوم دون الحاجة إلى إنشاء أي شيء من الصفر. ابدأ مجانًا مع ClickUp.

الأسئلة المتداولة (FAQ)

تعتمد التكلفة كليًا على طريقة النشر، ويمكن أن تساعدك توقعات المشروع في تقديرها. إذا كنت تستخدم أجهزتك الخاصة، فستتحمل تكلفة مقدمة لوحدة معالجة الرسومات (GPU) ولكن لن تتحمل رسومًا مستمرة لكل استعلام. يفرض مزودو الخدمات السحابية سعرًا بالساعة بناءً على وحدة معالجة الرسومات (GPU) وحجم النموذج.

نعم، تسمح تراخيص LLaMA 2 و LLaMA 3 بالاستخدام التجاري. ومع ذلك، يجب أن توافق على شروط استخدام Meta وتقدم الإسناد المطلوب في منتجك.

LLaMA 3 هو النموذج الأحدث والأكثر قدرة، ويوفر مهارات استدلال أفضل ونافذة سياق أكبر (8K رموز مقابل 4K لـ LLaMA 2). وهذا يعني أنه يمكنه التعامل مع محادثات ووثائق أطول، ولكنه يتطلب أيضًا موارد حاسوبية أكثر للتشغيل.

على الرغم من أن Python هي اللغة الأكثر شيوعًا للتعلم الآلي نظرًا لمكتباتها الواسعة، إلا أنها ليست مطلوبة بشكل صارم. بدأت بعض المنصات في تقديم حلول بدون كود أو قليلة الكود تسمح لك بنشر روبوت دردشة LLaMA بواجهة رسومية. /