Açık kaynaklı AI modellerini araştıran çoğu takım, Meta'nın LLaMA'sının güç ve esnekliğin nadir bir kombinasyonunu sunduğunu keşfediyor, ancak teknik kurulum, talimatlar olmadan mobilya monte etmek gibi hissettirebilir.

Bu kılavuz, donanım gereksinimleri ve model erişiminden komut mühendisliği ve dağıtım stratejilerine kadar her şeyi kapsayan, işlevsel bir LLaMA sohbet robotunu sıfırdan oluşturma sürecini adım adım anlatır.

Hadi başlayalım!

LLaMA nedir ve neden sohbet robotları için kullanılır?

Özel API'lerle bir chatbot oluşturmak, genellikle başka birinin sistemine bağlı kalmış, öngörülemeyen maliyetler ve veri gizlilik sorunlarıyla karşı karşıya kalmış gibi hissettirir. Bu tedarikçiye bağımlılık, modeli takımınızın benzersiz ihtiyaçlarına göre gerçekten özel hale getiremeyeceğiniz anlamına gelir, bu da genel yanıtlara ve potansiyel uyumluluk sorunlarına yol açar.

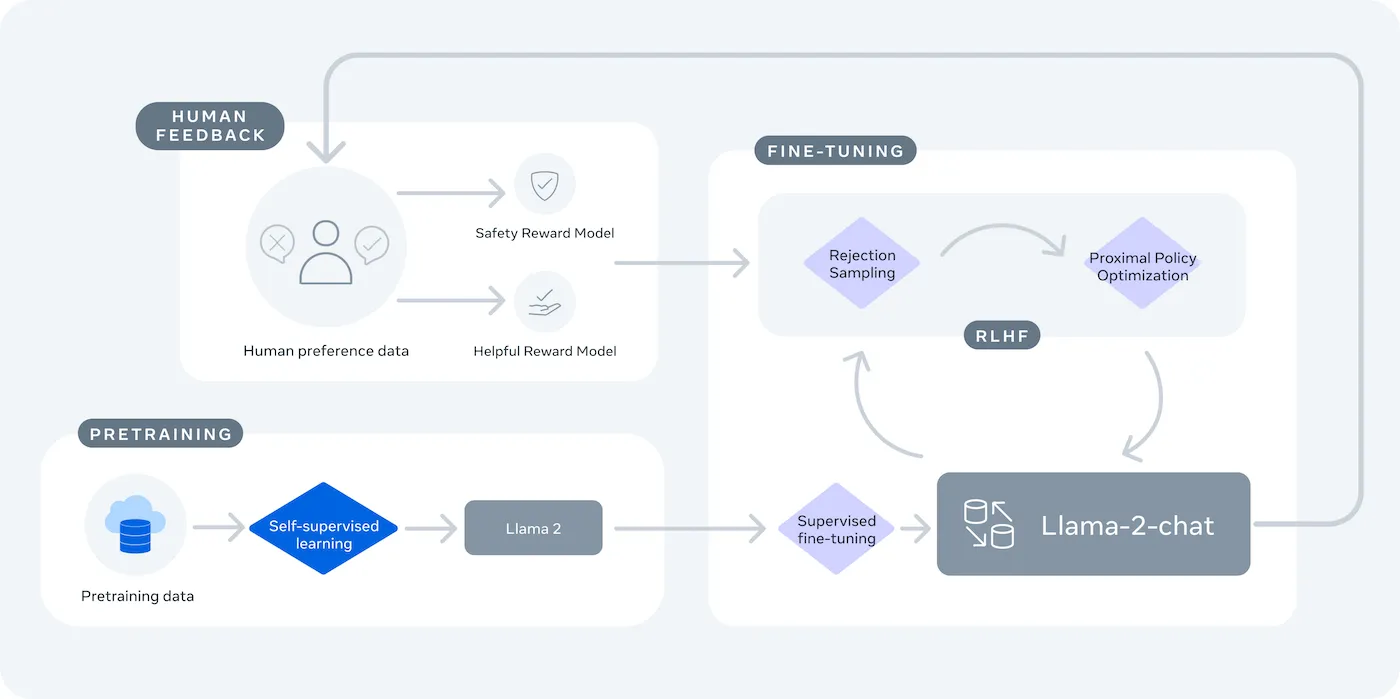

LLaMA (Large Language Model Meta AI), Meta'nın açık ağırlıklı dil modelleri ailesidir ve güçlü bir alternatif sunar. Hem araştırma hem de ticari kullanım için tasarlanmıştır ve kapalı kaynaklı modellerin sunmadığı kontrolü size sağlar.

LLaMA modelleri, parametrelerle ölçülen farklı boyutlarda gelir (ör. 7B, 13B, 70B). Parametreleri, modelin karmaşıklığı ve gücünün bir ölçüsü olarak düşünün; daha büyük modeller daha yeteneklidir, ancak daha fazla hesaplama kaynağı gerektirir.

LLaMA sohbet robotunu kullanmanız için nedenler:

- Veri gizliliği: Modelinizi kendi altyapınızda çalıştırdığınızda, konuşma verileriniz asla ortamınızın dışına çıkmaz. Bu, hassas bilgileri işleyen takımlar için çok önemlidir.

- Özelleştirme: LLaMA modelini şirketinizin iç belgeleri veya verileri üzerinde ince ayar yapabilirsiniz. Bu, modelin sizin özel bağlamınızı anlamasına ve çok daha alakalı yanıtlar vermesine yardımcı olur.

- Maliyet öngörülebilirliği: İlk donanım kurulumundan sonra, belirteç başına API ücretleri konusunda endişelenmenize gerek kalmaz. Maliyetleriniz sabit ve öngörülebilir hale gelir.

- Hız sınırı yok: Chatbotunuzun kapasitesi, satıcının kotası değil, kendi donanımınızla sınırlıdır. İhtiyaç duyduğunuzda ölçeklendirebilirsiniz.

Ana dezavantajı, kontrol kolaylığıdır. LLaMA, tak ve çalıştır API'sinden daha fazla teknik kurulum gerektirir. Üretim amaçlı chatbotlar için takımlar genellikle LLaMA 2 veya daha yeni olan LLaMA 3'ü kullanır. Bu sürümler, gelişmiş akıl yürütme özelliği sunar ve aynı anda daha fazla metin işleyebilir.

LLaMA Sohbet Robotu Oluşturmadan Önce İhtiyacınız Olanlar

Doğru araçlar olmadan bir geliştirme projesine atılmak, hayal kırıklığına yol açar. Projenin yarısına geldiğinizde, anahtar donanım veya yazılım erişiminin eksik olduğunu fark edersiniz, bu da ilerlemenizi engeller ve saatlerce zamanınızı boşa harcamasına neden olur.

Bunu önlemek için, ihtiyacınız olan her şeyi önceden toplayın. Sorunsuz bir başlangıç için bir kontrol listesi. 🛠️

Donanım gereksinimleri

| Model Boyutu | Minimum VRAM | Alternatif Seçenek |

|---|---|---|

| 7B parametres | 8 GB | Bulut GPU örneği |

| 13B parametres | 16 GB | Bulut GPU örneği |

| 70 milyar parametre | Birden fazla GPU | Kuantizasyon veya bulut |

Yerel makinenizde yeterince güçlü bir Grafik İşlem Birimi (GPU) yoksa, AWS veya GCP gibi bulut hizmetlerini kullanabilirsiniz. Baseten ve Replicate gibi çıkarım platformları da kullandıkça öde GPU erişimi sunar.

Yazılım gereksinimleri

- Python 3. 8+: Bu, makine öğrenimi projeleri için standart programlama dilidir.

- Paket yöneticisi: Projeniz için gerekli kütüphaneleri yüklemek için pip veya Conda'ya ihtiyacınız olacak.

- Sanal ortam: Bu, projenizin bağımlılıklarını makinenizdeki diğer Python projelerinden izole eden en iyi uygulamadır.

Erişim gereksinimleri

- Hugging Face hesabı: LLaMA model ağırlıklarını indirmek için bir hesaba ihtiyacınız olacak.

- Meta onayı: LLaMA modellerine erişmek için Meta'nın lisans sözleşmesini kabul etmeniz gerekir. Bu sözleşme genellikle birkaç saat içinde onaylanır.

- API anahtarları: Bunlar, modeli yerel olarak çalıştırmak yerine barındırılan bir çıkarım uç noktası kullanmaya karar verirseniz gereklidir.

Bu kılavuzda LangChain çerçevesini kullanacağız. Bu çerçeve, komut istemlerini ve konuşma geçmişini yönetmek gibi bir sohbet robotu oluşturmanın birçok karmaşık parçasını basitleştirir.

LLaMA ile Adım Adım Sohbet Robotu Oluşturma

Bir chatbotun tüm teknik parçalarını (model, komut istemi, bellek) birbirine bağlamak zorlu bir iş gibi görünebilir. Kodda kaybolmak kolaydır ve bu da hatalara ve chatbotun beklendiği gibi çalışmamasına neden olabilir. Bu adım adım kılavuz, süreci basit ve yönetilebilir parçalara ayırır.

Bu yaklaşım, modeli kendi makinenizde çalıştırıyor veya barındırılan bir hizmet kullanıyor olsanız da işe yarar.

Adım 1: Gerekli paketleri yükleyin

İlk olarak, temel Python kütüphanelerini yüklemeniz gerekir. Terminalinizi açın ve şu komutu çalıştırın:

pip install langchain transformers accelerate torch

Baseten gibi bir barındırma hizmetini çıkarım için kullanıyorsanız, ilgili yazılım geliştirme kitini (SDK) de yüklemeniz gerekir:

pip install baseten

Bu paketlerin her birinin yapacakları şunlardır:

- Langchain: Konuşma zincirlerini ve belleği yönetme dahil olmak üzere büyük dil modelleriyle uygulamalar oluşturmaya yardımcı olan bir çerçeve.

- Transformers: LLaMA modelini yüklemek ve çalıştırmak için Hugging Face kütüphanesi

- Accelerate: Modelin CPU ve GPU'nuzda nasıl yükleneceğini optimize etmeye yardımcı olan bir kütüphane.

- Torch: Modelin hesaplamaları için arka uç gücü sağlayan PyTorch kütüphanesi.

Modeli NVIDIA GPU bulunan bir makinede yerel olarak çalıştırıyorsanız, CUDA'nın doğru şekilde yüklü ve yapılandırılmış olduğundan emin olun. Bu, modelin GPU'yu kullanarak çok daha hızlı performans göstermesini sağlar.

Adım 2: LLaMA modellerine erişin

Modeli indirmeden önce, Hugging Face aracılığıyla Meta'dan resmi erişim izni almanız gerekir.

- huggingface.co'da bir hesap oluşturun

- Modelin sayfasına gidin, örneğin meta-llama/Llama-2-7b-chat-hf

- "Depoya eriş" seçeneğine tıklayın ve Meta'nın lisans koşullarını kabul edin.

- Hugging Face hesap ayarlarınızda yeni bir erişim belirteçi oluşturun.

- Terminalinizde huggingface-cli login komutunu çalıştırın ve makinenizi kimlik doğrulama için belirteçinizi yapıştırın.

Onay genellikle hızlıdır. Adında "sohbet" geçen bir model varyantı seçtiğinizden emin olun, çünkü bunlar özellikle konuşma görevleri için eğitilmiştir.

Adım 3: LLaMA modelini yükleyin

Artık modeli kodunuza yükleyebilirsiniz. Donanımınıza bağlı olarak iki ana seçeneğiniz vardır.

Yeterince güçlü bir GPU'nuz varsa, modeli yerel olarak yükleyebilirsiniz:

Donanımınız sınırlıysa, barındırılan bir çıkarım hizmeti kullanabilirsiniz:

device_map="auto" komutu, transformers kütüphanesine modeli mevcut tüm GPU'lara otomatik olarak dağıtımını yapmasını söyler.

Hala bellek yetersizliği yaşıyorsanız, modelin boyutunu küçültmek için niceleme adı verilen bir teknik kullanabilirsiniz, ancak bu, performansını biraz düşürebilir.

Adım 4: Komut istemi şablonu oluşturun

LLaMA sohbet modelleri, komutlar için belirli bir biçim beklemek üzere eğitilmiştir. Komut şablonu, girdinizin doğru şekilde yapılandırılmasını sağlar.

Bu biçimi inceleyelim:

- <

>: Bu bölüm, modele temel talimatları veren ve kişiliğini tanımlayan sistem istemini içerir. - [INST]: Bu, kullanıcının sorusunun veya talimatının başlangıcını belirtir.

- [/INST]: Bu, modele yanıt oluşturma zamanının geldiğini bildirir.

LLaMA'nın farklı sürümlerinin biraz farklı şablonlar kullanabileceğini unutmayın. Doğru biçim için her zaman Hugging Face'deki modelin belgelerini kontrol edin.

Adım 5: Sohbet robotu zincirini kurun

Ardından, LangChain kullanarak modelinizi ve komut şablonunuzu bir konuşma zincirine bağlayacaksınız. Bu zincir, konuşmayı izlemek için bellek de içerecektir.

LangChain birkaç tür bellek sunar:

- ConversationBufferMemory: Bu en basit seçenektir. Tüm konuşma geçmişini depolar.

- ConversationSummaryMemory: Alanı kazanmak için, bu seçenek konuşmanın eski kısımlarını dönemsel olarak özetler.

- ConversationBufferWindowMemory: Bu, yalnızca son birkaç konuşmayı bellekte tutar ve bağlamın çok uzun olmasını önlemek için kullanışlıdır.

Test etmek için ConversationBufferMemory harika bir başlangıç noktasıdır.

Adım 6: Chatbot döngüsünü çalıştırın

Son olarak, terminalden chatbotunuzla etkileşim kurmak için basit bir döngü oluşturabilirsiniz.

Gerçek dünya uygulamalarında, bu döngüyü FastAPI veya Flask gibi bir çerçeve kullanarak bir API uç noktasıyla değiştirebilirsiniz. Ayrıca, modelin yanıtını kullanıcıya geri aktararak chatbot'un çok daha hızlı çalıştığını hissettirebilirsiniz.

Ayrıca, yanıtların rastgeleliğini kontrol etmek için sıcaklık gibi parametreleri de ayarlayabilirsiniz. Düşük bir sıcaklık (ör. 0,2) çıktıyı daha belirleyici ve gerçekçi hale getirirken, daha yüksek bir sıcaklık (ör. 0,8) daha fazla yaratıcılığı teşvik eder.

LLaMA Sohbet Robotunuzu Test Etme

Cevaplar veren bir chatbot oluşturdunuz, ancak gerçek kullanıcılar için hazır mı? Test edilmemiş bir botun dağıtılması, yanlış bilgi verme veya uygunsuz içerik üretme gibi utanç verici hatalara yol açabilir ve bu da şirketinizin itibarını zedeleyebilir.

Sistematik bir test planı, bu belirsizliğin çözümüdür. Chatbotunuzun sağlam, güvenilir ve güvenli olmasını sağlar.

İşlevsel testler:

- Sınır durumları: Botun boş girdileri, çok uzun mesajları ve özel karakterleri nasıl işlediğini test edin.

- Bellek doğrulama: Chatbot'un bir konuşmadaki birden fazla turda bağlamı hatırladığından emin olun.

- Talimatları izleme: Botun sistem isteminde belirlediğiniz ayarlara uyup uymadığını kontrol edin.

Kalite değerlendirmesi:

- Alaka düzeyi: Yanıt, kullanıcının sorusuna gerçekten cevap veriyor mu?

- Doğruluk: Sağlayıcı tarafından sağlanan bilgiler doğru mu?

- Tutarlılık: Konuşma mantıklı bir şekilde akışını sürdürüyor mu?

- Güvenlik: Bot, uygunsuz veya zararlı istekleri yanıtlamayı reddediyor mu?

Performans testi:

- Gecikme süresi: Botun yanıt vermeye başlaması ve yanıtını tamamlaması için geçen süreyi ölçün.

- Kaynak kullanımı: Model, çıkarım sırasında ne kadar GPU belleği kullandığını izleyin.

- Eşzamanlılık: Birden fazla kullanıcı aynı anda sistemle etkileşimde olduğunda sistemin performansını test edin.

Ayrıca, halüsinasyonlar (yanlış bilgileri kendinden emin bir şekilde belirtme), bağlam kayması (uzun bir konuşmada konuyu kaybetme) ve tekrarlar gibi yaygın LLM sorunlarına da dikkat edin. Tüm test konuşmalarını kaydetmek, kalıpları tespit etmek ve sorunları kullanıcılarınıza ulaşmadan önce düzeltmek için harika bir yoldur.

📚 Ayrıca okuyun: İşlevsel Test ile İşlevsel Olmayan Test Arasındaki Fark

Takımlar için LLaMA Chatbot Kullanım Örnekleri

İnce ayar ve dağıtım mekanizmalarını aştığınızda, LLaMA en değerli halini soyut AI demolarında değil, günlük takım sorunlarına uygulandığında gösterir. Takımlar genellikle "sohbet robotuna" ihtiyaç duymazlar; daha hızlı bilgi erişimi, daha az manuel aktarım ve daha az tekrarlayan işlere ihtiyaç duyarlar.

Dahili bilgi asistanı

LLaMA'yı iç belgeler, wiki'ler ve SSS'ler üzerinde ince ayar yaparak veya RAG tabanlı bir bilgi tabanıyla eşleştirerek, takımlar doğal dilde sorular sorabilir ve bağlamı dikkate alan kesin cevaplar alabilir. Bu, hassas verileri üçüncü taraf API'lere göndermek yerine tamamen şirket içinde tutarken, dağınık araçlarda arama yapma zorluğunu ortadan kaldırır.

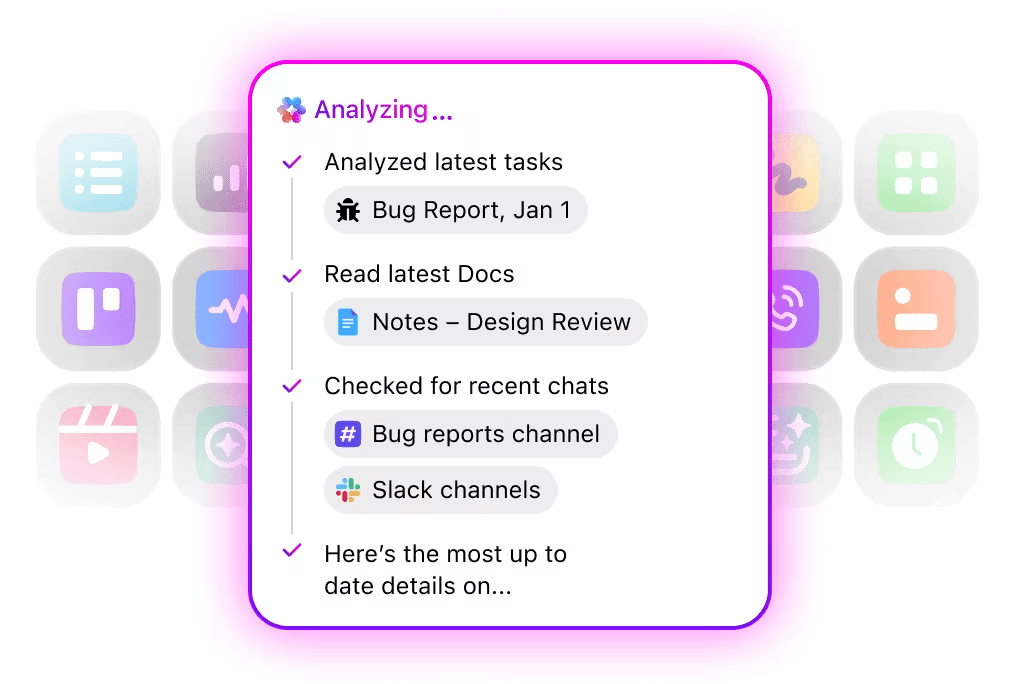

🌟 ClickUp'taki Kurumsal Arama ve önceden oluşturulmuş Ambient Answers ajanı, ClickUp Çalışma Alanı'ndaki bilgileri kullanarak sorularınıza ayrıntılı bağlamsal yanıtlar sağlar.

Kod inceleme yardımcısı

Kendi kod tabanınız ve stil kılavuzlarınızla eğitildiğinde, LLaMA bağlamsal kod inceleme asistanı olarak görev yapabilir. Geliştiriciler, genel en iyi uygulamalar yerine, takım kuralları, mimari kararlar ve geçmişteki kalıplarla uyumlu öneriler alırlar.

🌟 LLaMA tabanlı bir kod inceleme yardımcısı, sorunları ortaya çıkarabilir, iyileştirmeler önerebilir veya tanıdık olmayan kodları açıklayabilir. ClickUp'ın Codegen'i, geliştirme ş akışı içinde hareket ederek bir adım daha ileri gider: bu içgörülere yanıt olarak Çekme Talebleri oluşturur, yeniden düzenlemeler uygular veya dosyaları doğrudan günceller. Sonuç olarak, "düşünme" ve "yapma" arasında daha az kopyalama-yapıştırma ve daha az kesinti olur.

Müşteri desteği triyajı

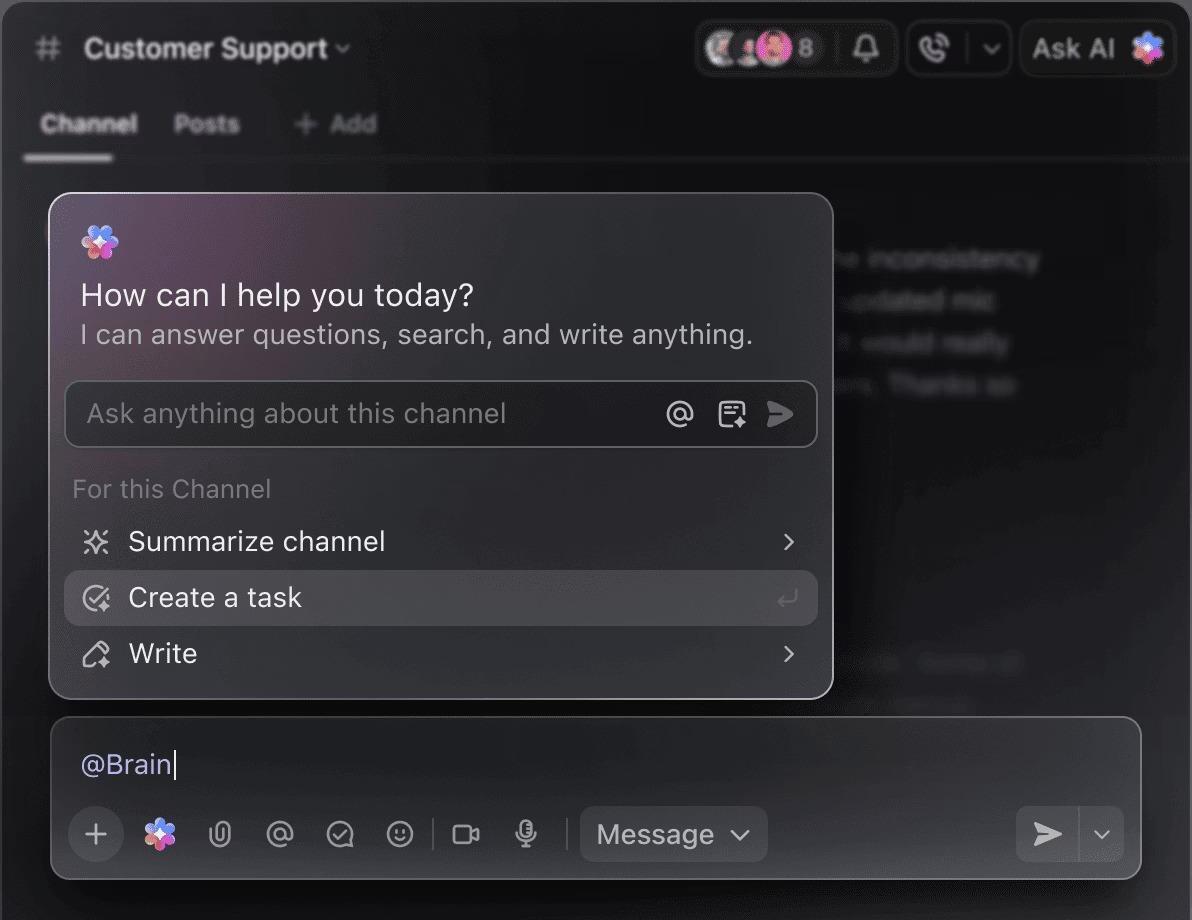

LLaMA, gelen müşteri sorgularını anlamak ve bunları doğru takım veya ş Akışa yönlendirmek için niyet sınıflandırması konusunda eğitilebilir. Sık sorulan sorular otomatik olarak yanıtlanabilirken, istisnai durumlar bağlam bilgisiyle birlikte insan temsilcilere iletilir, böylece kaliteden ödün vermeden yanıt süreleri kısaltılır.

Ayrıca, ClickUp Çalışma Alanınızda doğal dil kullanarak bir Triage Super Agent oluşturabilirsiniz. Daha fazla bilgi edinin

Toplantı özetleme ve takip

Toplantı transkriptlerini girdi olarak kullanan LLaMA, kararları, eylem öğelerini ve önemli tartışma noktalarını çıkarabilir. Bu çıktılar doğrudan görev yönetimi araçlarına akış halinde aktarıldığında, konuşmalar izlenen işlere dönüştürülerek gerçek değer ortaya çıkar.

🌟 ClickUp'ın AI Toplantı Not Alıcı özelliği sadece toplantı notları almakla kalmaz; özetler hazırlar, eylem öğeleri oluşturur ve toplantı notlarını belgeleriniz ve görevlerinizle ilişkilendirir.

Belge taslağı hazırlama ve yineleme

Takımlar, LLaMA'yı kullanarak mevcut şablonlara ve geçmiş örneklere dayalı raporların, tekliflerin veya belgelerin ilk taslaklarını oluşturabilir. Bu, çabayı boş sayfa oluşturmaktan inceleme ve iyileştirmeye kaydırarak, standartları düşürmeden teslimatı hızlandırır.

🌟 ClickUp Brain, tüm işyeri bilgilerinizi bağlam içinde tutarak belgeler için hızlı bir şekilde taslaklar oluşturabilir. Hemen deneyin.

LLaMA destekli sohbet robotları, bağımsız araçlar olarak çalışmak yerine mevcut ş akışlarına (dokümantasyon, proje yönetimi ve takım iletişimi) entegre edildiğinde en etkili olurlar.

Yapay zekayı doğrudan Çalışma Alanınıza entegre etmek, burada büyük bir fark yaratır. Ayrı bir araç oluşturmak yerine, konuşma yapay zekasını takımınızın halihazırda çalıştığı yere getirebilirsiniz.

Örneğin, bilgi asistanı olarak görev yapacak özel bir LLaMA botu oluşturabilirsiniz. Ancak bu bot, proje yönetimi aracınızın dışında çalışıyorsa, takımınızın ona soru sormak için bağlam değiştirmesi gerekir. Bu da sürtüşmelere neden olur ve herkesin işini yavaşlatır.

Ş Akışınızın zaten bir parçası olan bir AI kullanarak bu bağlam geçişini ortadan kaldırın.

ClickUp Brain'i kullanarak ClickUp'tan hiç çıkmadan projeleriniz, görevleriniz ve belgeleriniz hakkında sorular sorun. Herhangi bir görev yorumuna veya ClickUp Sohbetine @brain yazmanız yeterlidir, bağlamı dikkate alan anlık bir yanıt alırsınız. Sanki tüm çalışma alanınızı mükemmel bir şekilde bilen bir takım üyeniz varmış gibi. 🤩

Bu, chatbot'u bir yenilikten takımınızın verimlilik motorunun temel bir parçasına dönüştürür.

Sohbet robotları oluşturmak için LLaMA kullanmanın sınırlamaları

LLaMA sohbet robotu oluşturmak güçlendirici olabilir, ancak takımlar genellikle gizli karmaşıklıklar nedeniyle hazırlıksız yakalanır. "Ücretsiz" açık kaynak modeli, beklenenden daha pahalı ve yönetilmesi zor hale gelebilir, bu da kötü bir kullanıcı deneyimi ve sürekli, kaynak tüketen bir bakım döngüsüne yol açabilir.

Karar vermeden önce sınırları anlamak önemlidir.

- Teknik karmaşıklık: LLaMA modelini kurmak ve sürdürmek için makine öğrenimi altyapısı bilgisi gerekir.

- Donanım gereksinimleri: Daha büyük ve daha yetenekli modelleri çalıştırmak için pahalı GPU donanımı gerekir ve bulut maliyetleri hızla artabilir.

- Bağlam penceresi kısıtlamaları: LLaMA modellerinin bellek kapasitesi sınırlıdır ( LLaMA 2 için 4K belirteç ). Uzun belgeler veya konuşmaların işlenmesi, karmaşık parçalama stratejileri gerektirir.

- Yerleşik güvenlik önlemleri yoktur: Kendi içerik filtreleme ve güvenlik önlemlerinizi uygulamaktan siz sorumlusunuz.

- Sürekli bakım: Yeni modeller piyasaya çıktıkça sistemlerinizi güncellemeniz gerekecek ve ince ayar yapılmış modellerin yeniden eğitilmesi gerekebilir.

Kendi kendine barındırılan modeller de genellikle yüksek düzeyde optimize edilmiş ticari API'lerden daha yüksek gecikme süresine sahiptir. Bunların tümü, yönetilen çözümlerin sizin için üstlendiği operasyonel yüklerdir.

📮ClickUp Insight: Anket katılımcılarımızın %88'i kişisel görevleri için yapay zeka kullanıyor, ancak %50'den fazlası iş yerinde kullanmaktan çekiniyor. Üç ana engel nedir? Sorunsuz entegrasyon eksikliği, bilgi eksikliği veya güvenlik endişeleri.

Peki ya AI çalışma alanınıza entegre edilmiş ve zaten güvenliyse? ClickUp Brain, ClickUp'ın yerleşik AI asistanı, bunu gerçeğe dönüştürüyor. Basit dilde komutları anlar, AI'nın benimsenmesiyle ilgili üç endişeyi de ortadan kaldırırken, sohbetlerinizi, görevlerinizi, belgelerinizi ve bilgilerinizi çalışma alanı genelinde birbirine bağlar. Tek bir tıklama ile cevapları ve içgörüleri bulun!

Sohbet robotları oluşturmak için LLaMA'ya alternatifler

LLaMA, çok sayıda AI modeli arasından sadece bir seçenektir ve hangisinin size uygun olduğunu belirlemek zor olabilir.

Alternatiflerin genel durumu şu şekildedir.

Diğer açık kaynaklı modeller:

- Mistral: Daha küçük model boyutlarında bile güçlü performansı ile bilinen, verimli bir çözümdür.

- Falcon: Ticari uygulamalar için ideal olan, çok esnek bir lisansla birlikte gelir.

- MPT: Uzun belgeler ve konuşmaları işlemek için optimize edilmiştir.

Ticari API'ler:

- OpenAI (GPT-4, GPT-3. 5): Genellikle en yetenekli büyük dil modelleri olarak kabul edilirler ve entegrasyonları çok kolaydır.

- Anthropic (Claude): Güçlü güvenlik özellikleri ve çok geniş bağlam pencereleriyle tanınır.

- Google (Gemini): Güçlü çok modlu yetenekler sunarak metin, görüntü ve sesi anlamasını sağlar.

Açık kaynaklı bir model ile kendiniz oluşturabilir, ticari bir API için ödeme yapabilir veya farklı türde AI ajanları ile önceden entegre edilmiş bir çözüm sunan birleşik bir AI Çalışma Alanı kullanabilirsiniz.

📚 Ayrıca okuyun: İşletmeniz için Chatbot Nasıl Kullanılır?

ClickUp ile bağlam farkında AI asistanları oluşturun

LLaMA ile bir sohbet robotu oluşturmak, verileriniz, maliyetleriniz ve özelleştirme üzerinde inanılmaz bir kontrol sağlar. Ancak bu kontrol, altyapı, bakım ve güvenlik gibi yönetilen API'lerin sizin için hallettiği tüm sorumlulukları da beraberinde getirir. Amaç sadece bir bot oluşturmak değil, takımınızın verimliliğini artırmaktır ve karmaşık bir mühendislik projeği bazen bu hedefe ulaşmanızı engelleyebilir.

Doğru seçim, takımınızın kaynaklarına ve önceliklerine bağlıdır. ML uzmanlığınız ve sıkı gizlilik gereksinimleriniz varsa, LLaMA harika bir seçenektir. Hız ve basitliği öncelikliyorsanız, entegre bir araç daha uygun olabilir.

ClickUp ile, entegre AI tarafından desteklenen, tüm görevlerinizi, belgelerinizi ve konuşmalarınızı tek bir yerde barındıran birleşik bir AI Çalışma Alanı elde edersiniz. Bu, bağlamın yayılmasını önler ve özelleştirilebilir Süper Ajanlar ve bağlamsal AI sayesinde doğru bilgileri parmaklarınızın ucunda bulundurarak takımların daha hızlı ve daha etkili çalışmasına yardımcı olur.

Altyapı için zaman kaybetmeyi bırakın ve sıfırdan bir şey oluşturmadan bağlam farkında AI asistanının avantajlarından bugün yararlanmaya başlayın. ClickUp ile ücretsiz olarak başlayın.

Sık Sorulan Sorular (SSS)

Maliyet tamamen dağıtım yönteminize bağlıdır ve proje tahmini, bunu tahmin etmenize yardımcı olabilir. Kendi donanımınızı kullanıyorsanız, GPU için ön maliyetiniz olur, ancak sorgu başına devam eden ücretler olmaz. Bulut sağlayıcıları, GPU ve model boyutuna göre saatlik ücret alır.

Evet, LLaMA 2 ve LLaMA 3 lisansları ticari kullanıma izin vermektedir. Ancak, Meta'nın kullanım koşullarını kabul etmeniz ve ürününüzde gerekli atıfları sağlamanız gerekir.

LLaMA 3, daha yeni ve daha yetenekli bir modeldir. Daha iyi muhakeme becerileri ve daha geniş bir bağlam penceresi (LLaMA 2 için 4K belirteçe karşılık 8K belirteç) sunar. Bu, daha uzun konuşmaları ve belgeleri işleyebileceği anlamına gelir, ancak çalışması için daha fazla hesaplama kaynağı gerektirir.

Python, kapsamlı kütüphaneleri nedeniyle makine öğrenimi için en yaygın dil olsa da, kesinlikle gerekli değildir. Bazı platformlar, grafik arayüzlü bir LLaMA sohbet robotunu dağıtmanıza olanak tanıyan kodsuz veya az kodlu çözümler sunmaya başlamıştır. /