A maioria das equipes testa as ferramentas de resumo LLM alimentando-as com um documento de amostra e considerando o trabalho concluído. O modelo que acerta seus relatórios trimestrais pode massacrar suas conversas no Slack, e aquele que é perfeito para resumos jurídicos pode distorcer os fatos nos e-mails dos seus clientes.

Este guia apresenta os principais LLMs para resumo de texto, como avaliá-los em relação à sua carga de trabalho real e como conectar esses resumos diretamente às ações em seu fluxo de trabalho.

Visão geral dos modelos de resumo LLM

| Modelo | Ideal para | Melhores recursos | Preços |

|---|---|---|---|

| ClickUp Brain | Equipes que desejam resumos diretamente em seu fluxo de trabalho. Tamanho da equipe: qualquer equipe que utilize o ClickUp para projetos e comunicação. | Resumos com reconhecimento do espaço de trabalho, resumo de reuniões com o AI Notetaker, criação de itens de ação, roteamento multi-LLM, pesquisa em linguagem natural | Gratuito para sempre; personalização disponível para empresas. |

| OpenAI GPT-4o | Resumos refinados e prontos para executivos Tamanho da equipe: equipes pequenas a grandes que precisam de resultados abstratos de alta qualidade | Resumos semelhantes aos humanos, suporte multimodal, forte seguimento de instruções, grande janela de contexto. | API paga por token, ChatGPT Plus US$ 20/mês |

| Claude 3.5 Sonnet | Documentos sensíveis à conformidade ou altamente técnicos. Tamanho da equipe: equipes jurídicas, financeiras e empresariais. | Janela de contexto ampliada, baixa alucinação, excelente controle de formato, raciocínio sólido. | API paga por token, assinatura do Claude Pro |

| Google Gemini 1.5 Pro | Equipes que trabalham intensamente no Google WorkspaceTamanho da equipe: equipes de operações, pesquisa e com muitas reuniões | Janela de contexto de até 1 milhão de tokens, integração com o Google Meet e o Drive, resumo multimodal. | Preços baseados no uso via Google AI Studio ou Vertex AI |

| Meta LLaMA 3 | Pipelines de resumo auto-hospedados e personalizáveis. Tamanho da equipe: equipes lideradas por engenheiros e focadas em privacidade. | Totalmente auto-hospedado, capacidade de ajuste fino, forte qualidade de resumo, controle total dos dados. | Ponderadores de código aberto gratuitos, aplicam-se custos de infraestrutura. |

| Mistral Large | Equipes que precisam de residência de dados na UE e implantação híbrida Tamanho da equipe: empresas da UE ou organizações orientadas para a conformidade | API gerenciada híbrida ou auto-hospedada, forte qualidade de resumo, uso eficiente de tokens | Preços competitivos de API, pesos abertos disponíveis |

Como analisamos softwares na ClickUp

Nossa equipe editorial segue um processo transparente, baseado em pesquisas e neutro em relação aos fornecedores, para que você possa confiar que nossas recomendações são baseadas no valor real do produto.

Aqui está um resumo detalhado de como analisamos softwares na ClickUp.

O que você deve procurar em um LLM para resumo?

Escolher o modelo de resumo errado leva ao desperdício de dinheiro em APIs desajeitadas, dificuldades com configurações complexas ou simplesmente resumos de baixa qualidade que não são úteis. Antes de mergulhar em modelos específicos, entender o que diferencia um resumo eficaz de uma saída genérica ajuda você a fazer uma escolha mais inteligente.

Lida com seus tipos de documentos reais

Um modelo que se destaca na síntese de artigos de pesquisa pode ter dificuldades com conversas no Slack ou transcrições de reuniões. Procure LLMs que tenham sido testados nos tipos de documentos específicos com os quais sua equipe trabalha diariamente, sejam contratos jurídicos, e-mails de clientes, documentação técnica ou notas de reuniões.

Oferece janela de contexto suficiente

A janela de contexto determina a quantidade de texto que o modelo pode processar em uma única passagem. Se você estiver resumindo transcrições de reuniões de uma hora ou relatórios de pesquisa extensos, precisará de um modelo com uma janela de contexto ampliada. Caso contrário, será necessário dividir os documentos em partes e perderá a coerência que advém do processamento de tudo junto.

Equilibre velocidade e qualidade

Alguns modelos priorizam a velocidade de inferência, enquanto outros otimizam a qualidade da saída. Para resumos em tempo real durante reuniões, a velocidade é mais importante. Para gerar briefings executivos, a qualidade tem precedência. Considere onde seus casos de uso se enquadram nesse espectro.

Oferece opções de acesso adequadas

Os recursos técnicos e os requisitos de segurança da sua equipe devem orientar a escolha entre uma API gerenciada, uma implantação auto-hospedada ou uma abordagem híbrida. Equipes empresariais com políticas de dados rígidas podem exigir opções locais, enquanto equipes menores podem preferir a conveniência das APIs na nuvem.

Os 6 melhores LLMs para resumo de texto

O número esmagador de modelos disponíveis torna difícil escolher o modelo certo. Cada modelo abaixo representa um forte candidato, mas o “melhor” depende inteiramente das necessidades específicas da sua equipe. Vamos avaliá-los quanto à precisão, tamanho da janela de contexto, velocidade e opções de acesso.

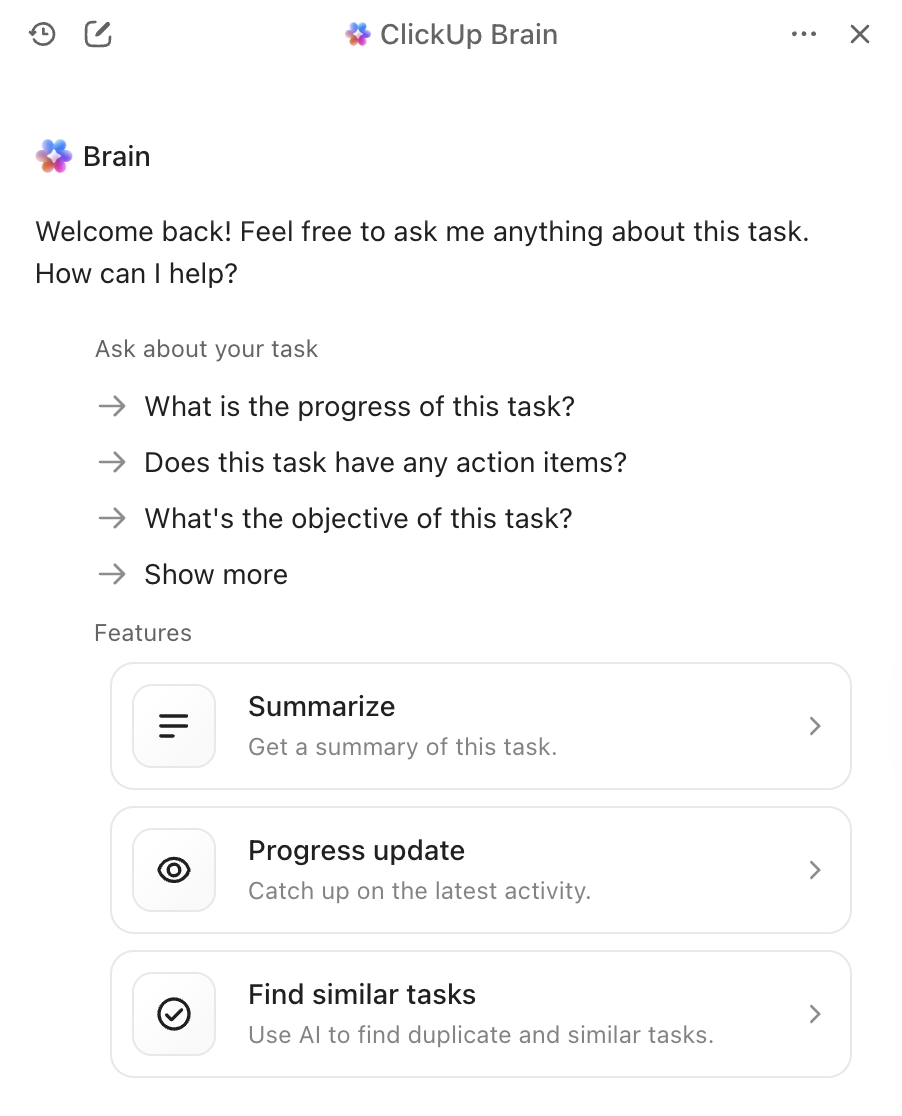

1. ClickUp Brain (ideal para resumos com tecnologia de IA dentro do seu fluxo de trabalho)

O maior problema das ferramentas de resumo independentes não é a qualidade dos resumos, mas o que acontece depois. Você gera um resumo brilhante, depois o copia manualmente para sua ferramenta de gerenciamento de projetos, cria tarefas a partir dele e envia uma mensagem à sua equipe sobre as próximas etapas. O ClickUp Brain elimina esse atrito, trazendo o resumo diretamente para o seu fluxo de trabalho.

Com o ClickUp Brain, basta digitar @brain em qualquer comentário de tarefa ou mensagem do ClickUp Chat e pedir para resumir o contexto. Ele fornece instantaneamente um resumo usando seu conhecimento do seu espaço de trabalho, priorizando a tarefa ou canal específico em que você está. Como o Brain entende seus projetos, documentos e conversas, seus resumos são imediatamente acionáveis, em vez de textos isolados que você precisa processar manualmente.

Melhores recursos do ClickUp Brain

- Resuma tarefas, documentos, conversas de chat e gravações de reuniões sem sair do seu espaço de trabalho.

- Aproveita vários LLMs nos bastidores para que você obtenha resultados ideais sem precisar gerenciar a seleção de modelos.

- Converte resumos diretamente em tarefas com responsáveis e prazos.

- Entenda o contexto do seu espaço de trabalho para obter resumos mais relevantes e acionáveis.

- Integra-se ao ClickUp AI Notetaker para capturar e resumir automaticamente as reuniões.

Limitações do ClickUp Brain

- É necessário trabalhar dentro do ecossistema ClickUp para obter todos os benefícios.

- Mais adequado para fluxos de trabalho em equipe do que para processamento individual de documentos.

Preços do ClickUp Brain

2. OpenAI GPT-4o (ideal para resumos refinados e prontos para executivos)

Quando você precisa de um resumo refinado, cheio de nuances e pronto para ser compartilhado com executivos, o GPT-4o é a melhor escolha. Seu ponto forte é a resumência abstrata de alta qualidade, que produz textos que parecem ter sido escritos por um ser humano. A grande janela de contexto e os recursos multimodais permitem resumir textos a partir de imagens ou transcrições de áudio, e não apenas de documentos.

Você pode acessá-lo por meio de uma API amplamente disponível, facilitando a integração com suas ferramentas de IA existentes para reuniões. A desvantagem é que se trata de um serviço proprietário com preços baseados no uso, e você pode notar um pequeno atraso ao resumir documentos muito longos.

Melhores recursos do GPT-4o

- Produz resumos abstratos com qualidade humana que requerem edição mínima.

- Lida com entradas multimodais, incluindo imagens e transcrições de áudio.

- Oferece documentação API abrangente e suporte à integração.

Limitações do GPT-4o

- O preço baseado no uso pode aumentar para resumos de alto volume.

- A latência de inferência aumenta com documentos muito longos.

- Modelos proprietários significam menos controle sobre o tratamento de dados

Preços do GPT-4o

- Acesso à API com preço por token

- Assinatura do ChatGPT Plus por US$ 20/mês para uso individual

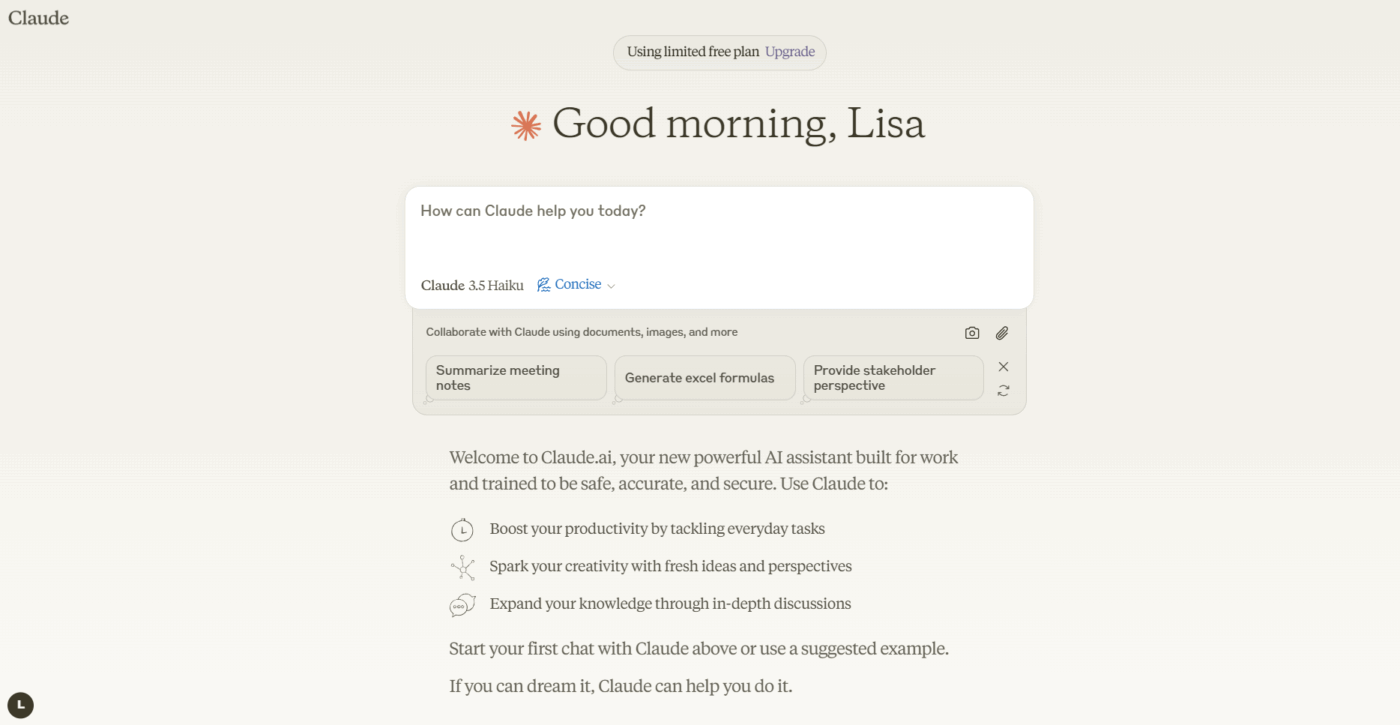

3. Anthropic Claude 3. 5 Sonnet (ideal para documentos sensíveis à conformidade)

Se sua equipe lida com documentos altamente confidenciais ou complexos, o Claude 3.5 Sonnet foi desenvolvido pensando nas suas necessidades. Ele possui uma janela de contexto ampliada, permitindo processar e resumir relatórios longos inteiros em uma única passagem. Onde ele realmente se destaca é em sua capacidade de seguir instruções detalhadas — você pode solicitar um resumo em um formato específico, tom ou com foco em determinados tópicos, e ele entrega com alta precisão.

O forte foco da Anthropic no alinhamento de segurança ajuda a reduzir o risco de o modelo inventar fatos, um recurso crítico para equipes preocupadas com a conformidade que trabalham com documentos jurídicos ou financeiros. Para equipes que já utilizam resumidores de documentos com IA, o Claude se integra bem aos fluxos de trabalho existentes.

Melhores recursos do Claude 3.5 Sonnet

- A janela de contexto estendida processa relatórios inteiros em uma única passagem.

- Excelente seguimento de instruções para requisitos personalizados de formatação e tom.

- Um forte alinhamento de segurança reduz o risco de alucinações.

Limitações do Claude 3.5 Sonnet

- Modelo proprietário com variações de disponibilidade regional.

- O preço da API pode ser significativo para uso em escala empresarial.

Preços do Claude 3.5 Sonnet

- Acesso à API com preço por token

- Assinatura do Claude Pro disponível para uso individual.

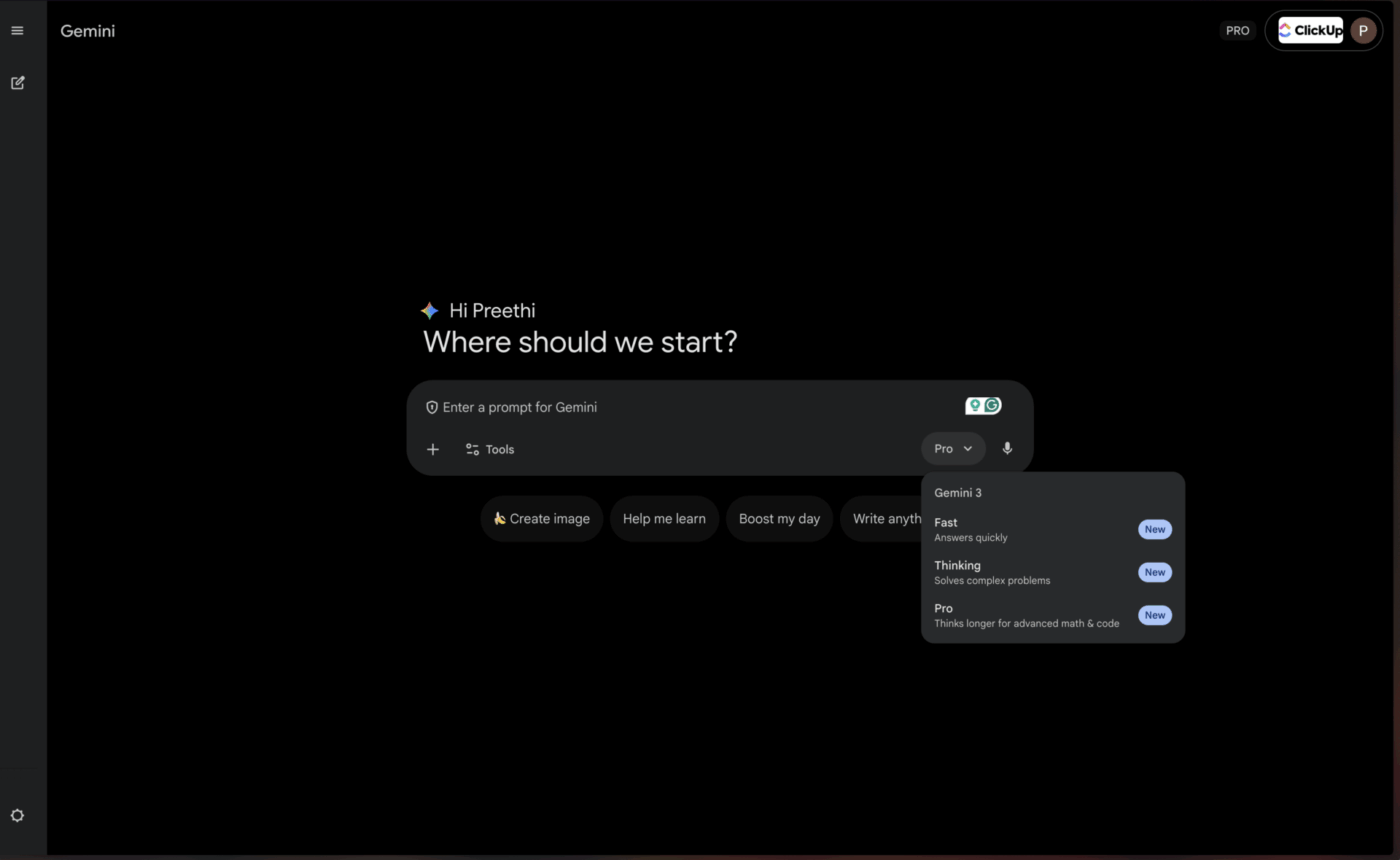

4. Google Gemini 1.5 Pro (ideal para usuários do Google Workspace)

Para equipes que já vivem e respiram no ecossistema do Google, o Gemini 1.5 Pro oferece um nível de conveniência quase imbatível. Ele possui uma das maiores janelas de contexto disponíveis atualmente — até 1 milhão de tokens —, tornando-o perfeito para resumir transcrições extensas de reuniões do Google Meet ou sintetizar informações de vários trabalhos de pesquisa armazenados no Google Drive.

A integração nativa com o Google Workspace significa que você pode obter resumos sem sair das ferramentas que usa todos os dias. Isso torna-o particularmente valioso para equipes que dependem fortemente de resumidores de reuniões com IA dentro do ecossistema do Google.

Melhores recursos do Gemini 1.5 Pro

- Uma janela de contexto massiva de 1 milhão de tokens lida com documentos extremamente longos.

- Integração nativa com o Google Workspace para um fluxo de trabalho contínuo

- Recursos multimodais em texto, imagens e vídeo

Limitações do Gemini 1.5 Pro

- Para aproveitar todos os benefícios, é necessário investir no ecossistema do Google.

- O desempenho fora da integração com o Google pode ficar atrás dos concorrentes.

Preços do Gemini 1.5 Pro

- Disponível através do Google AI Studio e do Vertex AI.

- Os preços variam de acordo com o uso e os contratos empresariais.

📌 ClickUp Insight: O profissional médio passa mais de 30 minutos por dia procurando informações relacionadas ao trabalho — isso significa mais de 120 horas por ano perdidas vasculhando e-mails, threads do Slack e arquivos espalhados. Um assistente de IA inteligente integrado ao seu espaço de trabalho pode mudar isso, exibindo os documentos, conversas e detalhes de tarefas certos em segundos.

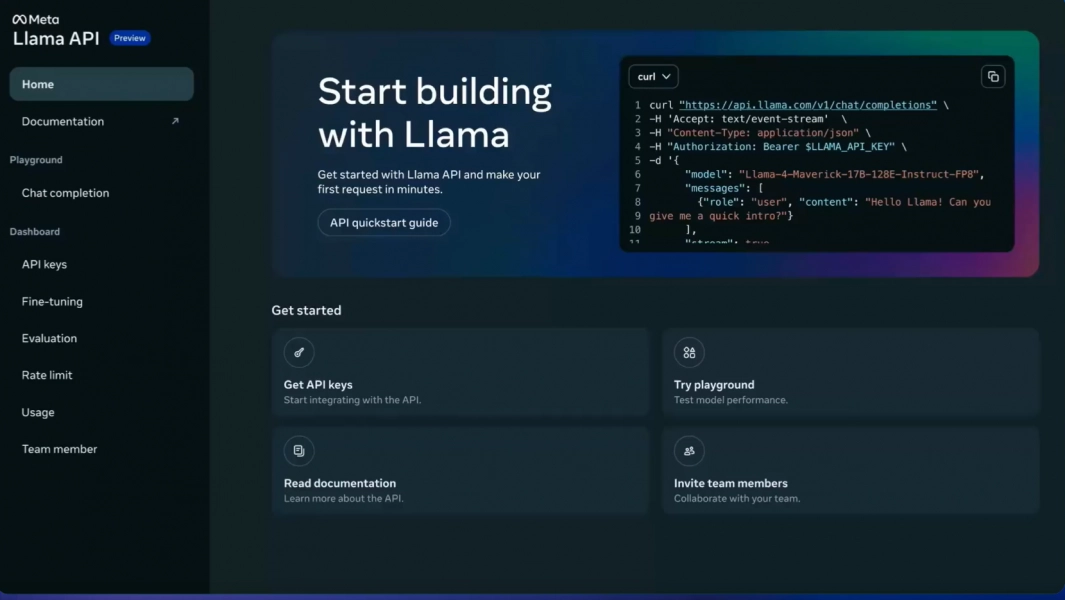

5. Meta LLaMA 3 (ideal para pipelines personalizáveis e auto-hospedados)

Sua equipe precisa ter controle total sobre seus dados e deseja evitar o envio de informações confidenciais para um serviço terceirizado. É aqui que um modelo de código aberto como o LLaMA 3 se destaca. Você pode hospedá-lo em seus próprios servidores, ajustá-lo aos dados específicos da sua empresa para entender melhor seu jargão e personalizá-lo da maneira que achar melhor, tudo sem taxas de licenciamento.

A qualidade da síntese é impressionante e muitas vezes rivaliza com a dos modelos proprietários. O problema é a necessidade de infraestrutura técnica. Sua equipe precisará de recursos de engenharia para implantar e manter o modelo, pois não há API gerenciada disponível pronta para uso. Isso o torna perfeito para organizações lideradas por engenheiros ou focadas em privacidade.

Os melhores recursos do LLaMA 3

- Controle total dos dados com implantação auto-hospedada

- Capacidade de ajuste fino para terminologia específica do domínio

- Sem taxas de licenciamento para uso comercial.

Limitações do LLaMA 3

- Requer infraestrutura técnica significativa para implantação.

- Sem API gerenciada — sua equipe cuida da manutenção

- A complexidade da configuração inicial pode atrasar o tempo de retorno do investimento.

Preços do LLaMA 3

- Uso gratuito com licença de código aberto.

- Os custos de infraestrutura dependem das opções de hospedagem

6. Mistral Large (ideal para os requisitos de residência de dados da UE)

E se você quiser a flexibilidade do código aberto, mas não tiver recursos para gerenciar a infraestrutura sozinho? O Mistral Large oferece um meio-termo atraente. Desenvolvido por uma empresa europeia, ele oferece um desempenho competitivo em resumos, com forte foco na eficiência.

O Mistral oferece uma API gerenciada para fácil acesso e modelos de peso aberto para equipes que desejam mais controle. Essa abordagem híbrida é sua principal vantagem. A desvantagem é um ecossistema menor de integrações de terceiros em comparação com gigantes como OpenAI e Google. É uma excelente opção para equipes que buscam um equilíbrio entre conveniência e controle, especialmente aquelas com requisitos de residência de dados na UE.

Principais recursos do Mistral Large

- Acesso híbrido por meio de API gerenciada ou implantação auto-hospedada

- Desempenho robusto com conformidade com a residência de dados europeia

- Preços competitivos em comparação com os principais modelos proprietários

Limitações do Mistral Large

- Ecossistema de integração menor do que o OpenAI ou o Google.

- Documentação e recursos da comunidade menos extensos

Preços do Mistral Large

- Acesso à API com preços competitivos por token

- Modelos de peso aberto disponíveis para hospedagem própria.

💡 Dica profissional: se o seu objetivo principal é resumir transcrições de reuniões de uma hora de duração de uma só vez, priorize modelos com a maior janela de contexto, como o Gemini 1.5 Pro. Se você precisar ensinar ao modelo a terminologia específica da sua empresa, uma opção de código aberto como o LLaMA 3 é a melhor escolha.

💡 Dica profissional: se seu objetivo principal é resumir transcrições de reuniões de uma hora de duração de uma só vez, priorize modelos com a maior janela de contexto, como o Gemini 1.5 Pro. Se você precisar ensinar ao modelo a terminologia específica da sua empresa, uma opção de código aberto como o LLaMA 3 é a melhor escolha.

Comparação de modelos de resumo LLM

A comparação rápida ajuda você a identificar rapidamente qual modelo se alinha à principal prioridade da sua equipe.

O ClickUp Brain traz a resumização diretamente para o seu fluxo de trabalho como um espaço de trabalho de IA convergente, ideal para transformar resumos em ações imediatas, com a principal vantagem de funcionar de maneira otimizada dentro do ecossistema ClickUp.

O GPT-4o oferece uma grande janela de contexto como modelo proprietário, ideal para resumos refinados e cheios de nuances, com a principal desvantagem sendo o preço baseado no uso.

O Claude 3.5 Sonnet oferece uma janela de contexto ampliada como um modelo proprietário, ideal para documentos sensíveis à conformidade, tendo a disponibilidade regional como principal limitação.

O Gemini 1.5 Pro oferece uma janela de contexto ampla como modelo proprietário, perfeito para usuários do Google Workspace, embora o aprisionamento do ecossistema possa ser uma preocupação.

O LLaMA 3 inclui uma grande janela de contexto como um modelo de código aberto, adequado para pipelines personalizáveis auto-hospedados, mas requer investimento em infraestrutura.

O Mistral Large apresenta uma grande janela de contexto com uma abordagem de acesso híbrido, excelente para as necessidades de residência de dados da UE, embora tenha um ecossistema de integração menor.

📖 Leia também: Os melhores resumidores de transcrições com IA

Como avaliar a qualidade da resumização do LLM

Para saber se os resumos de um modelo são realmente bons, é necessário um quadro de avaliação claro. Confiar em um resumo ruim pode ser pior do que não ter nenhum resumo, podendo levar a decisões erradas com base em informações imprecisas.

Critérios-chave para avaliação

A precisão determina se o resumo captura corretamente os pontos principais do texto original, sem inventar fatos ou cometer erros. Isso é imprescindível para documentos críticos para os negócios.

A coerência mede se o resumo é fácil de ler e flui logicamente, ou se parece um emaranhado de frases desconexas. Bons resumos mantêm a estrutura narrativa.

A concisão avalia se o resumo vai direto ao ponto ou se está cheio de palavras desnecessárias e sem sentido. Os melhores resumos maximizam a densidade da informação.

O seguimento de instruções testa se o modelo consegue seguir com sucesso suas solicitações de tons, formatos ou áreas de foco específicos, como pontos-chave ou briefings executivos.

A consistência avalia se o modelo produz resumos de alta qualidade em diferentes tipos de documentos ou se tem um bom desempenho apenas em determinados tipos.

Uma estrutura de teste simples

Escolha três documentos com os quais sua equipe trabalha regularmente: um resumo de projeto, uma transcrição de reunião e uma sequência de e-mails de clientes. Execute cada documento nos modelos que você está considerando com o mesmo prompt. Em seguida, peça a um membro da equipe para avaliar os resultados com base nos critérios acima. Embora existam métricas automatizadas, nada supera uma revisão humana para detectar erros sutis.

🔍 Você sabia? Equipes como a QubicaAMF recuperaram mais de 5 horas semanais usando o ClickUp — o que representa mais de 250 horas por ano por pessoa — ao eliminar processos desatualizados de gerenciamento de conhecimento. Imagine o que sua equipe poderia criar com uma semana extra de produtividade a cada trimestre.

🔍 Você sabia? Equipes como a QubicaAMF recuperaram mais de 5 horas semanais usando o ClickUp — o que representa mais de 250 horas por ano por pessoa — ao eliminar processos desatualizados de gerenciamento de conhecimento. Imagine o que sua equipe poderia criar com uma semana extra de produtividade a cada trimestre.

Quais são as limitações do uso de LLMs para resumo de documentos?

Essa tecnologia tem limitações reais que vale a pena entender antes de se comprometer com uma abordagem específica.

Riscos de alucinação

O maior risco é a alucinação, em que o modelo afirma com confiança detalhes incorretos que parecem plausíveis. Equipes jurídicas, analistas financeiros e qualquer pessoa que trabalhe com documentos sensíveis à conformidade devem sempre ter uma revisão humana de resumos de alto risco.

Limites da janela de contexto

Mesmo os maiores modelos têm um limite, portanto, documentos extremamente longos podem precisar ser divididos em partes. Essa divisão pode fazer com que o modelo perca conexões entre seções distantes ou perca o arco narrativo geral.

Perda de nuances

Argumentos sutis ou pontos de vista minoritários são frequentemente simplificados nos resumos. Se preservar opiniões divergentes ou casos extremos for importante para o seu caso de uso, você precisará elaborar prompts cuidadosamente ou aceitar alguma perda de informação.

Desafios de especificidade de domínio

Um modelo de uso geral pode não compreender o jargão específico do seu setor sem um ajuste fino. As áreas médica, jurídica e técnica geralmente exigem treinamento adicional ou engenharia cuidadosa de prompts.

Considerações de segurança

O envio de dados confidenciais da empresa para uma API de terceiros sempre acarreta um certo grau de risco. Para documentos altamente confidenciais, podem ser necessários modelos auto-hospedados ou acordos empresariais com termos específicos de tratamento de dados.

Essas não são razões para evitar a tecnologia, mas são considerações importantes. Você pode mitigá-las com práticas inteligentes: sempre peça a um humano para revisar resumos de alto risco, use modelos auto-hospedados para dados altamente confidenciais e use prompts claros para ajudar o modelo a preservar nuances importantes.

📌 ClickUp Insight: 62% dos profissionais do conhecimento confiam em ferramentas de IA conversacionais, como ChatGPT e Claude. Sua interface familiar de chatbot e habilidades versáteis podem explicar sua popularidade em diversas funções e setores. No entanto, alternar para outra guia para fazer uma pergunta à IA todas as vezes aumenta os custos de alternância e mudança de contexto.

📌 ClickUp Insight: 62% dos profissionais do conhecimento confiam em ferramentas de IA conversacionais, como ChatGPT e Claude. Sua interface familiar de chatbot e habilidades versáteis podem explicar sua popularidade em diversas funções e setores. No entanto, alternar para outra guia para fazer uma pergunta à IA todas as vezes aumenta os custos de alternância e mudança de contexto.

Colocando o ClickUp Brain para trabalhar em seu fluxo de trabalho de resumo

Você viu como o ClickUp Brain está entre os melhores LLMs para resumos. Agora, vamos explorar como criar fluxos de trabalho que transformam esses resumos em ganhos reais de produtividade. A diferença entre um resumo útil e um esforço desperdiçado é se ele se conecta à ação — e é aí que o Converged AI Workspace se destaca.

[Espaço reservado para imagem: área de trabalho do ClickUp mostrando a síntese do Brain integrada a tarefas e documentos]

Obtenha resumos diretamente no local onde você está trabalhando.

Elimine a frustrante transferência manual, trazendo a resumização diretamente para seus projetos. Com o ClickUp Brain, basta digitar @brain em qualquer comentário de tarefa ou mensagem do ClickUp Chat e pedir para resumir o contexto. Ele fornece instantaneamente um resumo usando seu conhecimento do seu espaço de trabalho, priorizando a tarefa ou canal específico em que você está.

Transforme gravações de reuniões em itens de ação automaticamente

Para se atualizar após uma reunião perdida, não é mais necessário passar horas lendo notas. Mantenha-se totalmente envolvido nas conversas enquanto o ClickUp AI Notetaker captura as notas da reunião para você. Após a reunião, ele fornece uma transcrição e um resumo. Você pode até mesmo pedir que ele gere automaticamente itens de ação e os transforme em tarefas do ClickUp com responsáveis e prazos.

Aproveite vários LLMs sem precisar gerenciar a seleção de modelos.

Obtenha resultados de alta qualidade sem precisar gerenciar a seleção de modelos, pois o ClickUp Brain utiliza vários LLMs nos bastidores. Veja como esse fluxo de trabalho funciona na prática: uma reunião acontece, o ClickUp AI Notetaker captura tudo, o ClickUp Brain fornece um resumo das principais decisões e as ações a serem tomadas já estão em seu plano de projeto. Você pode até usar o @My Brain para resumir um tópico ou redigir uma resposta em particular antes de compartilhá-la com a equipe.

✨ Resultados reais: O verdadeiro desafio é transformar resumos em ação. O ClickUp Brain se destaca por conectar resumos diretamente às tarefas em seu fluxo de trabalho, eliminando a lacuna entre insight e execução que afeta as ferramentas de resumo independentes.

✨ Resultados reais: O verdadeiro desafio é transformar resumos em ação. O ClickUp Brain se destaca por conectar resumos diretamente às tarefas em seu fluxo de trabalho, eliminando a lacuna entre insight e execução que afeta as ferramentas de resumo independentes.

Conclusão

O melhor LLM para resumos é aquele que atende às necessidades específicas da sua equipe, seja uma janela de contexto ampla para relatórios longos, flexibilidade de código aberto para personalização ou integração perfeita com suas ferramentas existentes. Antes de se comprometer, sempre teste suas principais opções com seus próprios documentos reais para ver como eles se saem.

Mas lembre-se: um resumo só tem valor quando está conectado à ação. A síntese está deixando de ser uma tarefa independente para se tornar um recurso profundamente integrado às plataformas nas quais você já trabalha. O verdadeiro ganho de produtividade vem da redução da lacuna entre obter um insight e agir com base nele.

Comece gratuitamente com o ClickUp e traga a síntese por IA diretamente para o gerenciamento de tarefas, bate-papo e documentos.

Perguntas frequentes

Qual é a diferença entre resumo extrativo e abstrativo de LLM? O resumo extrativo funciona extraindo frases-chave diretamente do texto original, enquanto o resumo abstrativo gera frases totalmente novas para transmitir o significado central. Os LLMs modernos usam principalmente o método abstrativo, que resulta em resumos mais naturais que capturam melhor a essência do material de origem.

Como os LLMs de código aberto se comparam a modelos proprietários como o GPT-4 para resumos? Os modelos de código aberto oferecem controle total sobre seus dados e a capacidade de ajustá-los às suas necessidades específicas, mas exigem recursos técnicos para manutenção. Os modelos proprietários oferecem conveniência e facilidade de uso por meio de uma API, mas têm custos de uso e menos controle sobre os dados. A diferença de qualidade diminuiu significativamente, com opções de código aberto como o LLaMA 3 rivalizando com o desempenho proprietário em muitos casos de uso.

As ferramentas de resumo LLM conseguem lidar com notas de reuniões e atualizações de projetos? Sim, a maioria dos LLMs é muito eficaz no resumo de textos conversacionais, como notas de reuniões. O verdadeiro desafio é transformar esses resumos em ação, e é aí que ferramentas como o ClickUp Brain se destacam, conectando os resumos diretamente às tarefas em seu fluxo de trabalho, em vez de deixá-los como documentos de texto isolados.

Qual o tamanho da janela de contexto necessário para os meus documentos? Para documentos comerciais padrão com menos de 10.000 palavras, a maioria dos LLMs modernos tem janelas de contexto suficientes. Para transcrições de reuniões com mais de uma hora ou relatórios de pesquisa abrangentes, você vai precisar de modelos com janelas de contexto estendidas, como Claude 3.5 Sonnet ou Gemini 1.5 Pro. A janela de 1 milhão de tokens do Gemini 1.5 Pro pode lidar com praticamente qualquer tarefa de resumo de um único documento.

Como posso reduzir o risco de alucinações nos resumos do LLM? Use prompts claros e específicos que solicitem ao modelo que resuma apenas o que está explicitamente declarado na fonte. Solicite citações ou referências a seções específicas quando a precisão for crítica. Para documentos de alto risco, sempre peça a um revisor humano para comparar o resumo com o original. Considere modelos com alinhamento de segurança mais forte, como o Claude, ao trabalhar com conteúdo sensível à conformidade.