L'enthousiasme suscité par un nouveau logiciel s'estompe généralement dès que le flux de travail s'avère décevant. Cela arrive même aux meilleurs d'entre nous : en fait, cela arrive à près de 60 % des équipes, ce qui montre clairement que les évaluations traditionnelles ne donnent pas de résultats.

Vous avez besoin d'un moyen de détecter les risques suffisamment tôt pour pouvoir agir. Dans ce guide, nous explorons comment évaluer un logiciel à l'aide de l'IA afin de mettre en évidence les risques opérationnels et les obstacles à l'adoption avant que vous ne vous engagiez. Nous vous fournirons un cadre pour évaluer les outils et mettre en évidence les risques cachés, tout en vous expliquant comment organiser votre évaluation dans ClickUp. 🔍

Que signifie « évaluer un logiciel à l'aide de l'IA » ?

Évaluer un logiciel à l'aide de l'IA signifie utiliser l'IA comme outil de recherche et d'aide à la décision pendant le processus d'achat. Au lieu de parcourir manuellement les sites des fournisseurs, les avis, la documentation et les démonstrations, votre équipe peut utiliser l'IA pour comparer les options de manière cohérente et tester rapidement les affirmations des fournisseurs.

Cela est important lorsque les évaluations portent sur plusieurs outils et opinions. L'IA consolide ces informations en une seule vue et met en évidence les lacunes ou les incohérences qui sont faciles à manquer lors d'un examen manuel. Elle affine également les questions spécifiques à poser sur l'IA et les capacités générales des logiciels afin d'obtenir une réponse claire de la part du fournisseur.

La différence devient plus claire lorsque vous comparez l'évaluation traditionnelle des logiciels à une approche assistée par l'IA.

Évaluation traditionnelle des logiciels vs évaluation assistée par l'IA

Les évaluations traditionnelles de logiciels vous obligent souvent à établir une liste restreinte à partir de pages de fournisseurs dispersées et d'avis contradictoires. Vous finissez par revenir aux mêmes questions fondamentales, en revérifiant les détails au moment même où vous essayez de prendre une décision.

C'est pourquoi 83 % des acheteurs finissent par modifier leur liste initiale de fournisseurs en cours de route, ce qui montre clairement à quel point vos décisions initiales peuvent sembler instables lorsque vos informations sont fragmentées. Vous pouvez éviter ce travail supplémentaire en utilisant l'IA pour synthétiser les informations dès le départ, ce qui vous permet d'appliquer les mêmes critères rigoureux à tous les outils dès le début.

| Évaluation traditionnelle | Évaluation assistée par l'IA |

|---|---|

| Comparaison des fonctionnalités entre les onglets et les feuilles de calcul | Générer des comparaisons côte à côte à partir d'une seule invitation, de quelques instructions |

| Lire les avis individuellement | Résumer les sentiments et les thèmes récurrents dans différentes sources |

| Rédiger manuellement les questions d'appel d'offres | Création de questionnaires destinés aux fournisseurs sur la base de critères définis |

| Attendre les appels de l'équipe commerciale pour clarifier les bases | Présenter directement des requêtes pour la documentation publique et les bases de connaissances |

En gardant cette distinction à l'esprit, il est plus facile de voir exactement où l'IA apporte le plus de valeur ajoutée tout au long du cycle d'évaluation.

La place de l'IA dans le cycle d'évaluation

L'IA est particulièrement utile lors de la découverte, de la comparaison et de la validation, lorsque les données saisies sont volumineuses et faciles à mal interpréter. Elle est particulièrement utile lors de la découverte et de la comparaison, lorsque vous devez traiter de grands volumes de données et tester vos hypothèses initiales.

Au départ, l'IA aide à clarifier les problèmes et les critères d'évaluation. Par la suite, elle endosse le rôle de stratège, en consolidant les conclusions et en communiquant les décisions aux parties prenantes.

L'IA fonctionne mieux en tant que couche de synthèse initiale. Les décisions finales nécessitent toujours de vérifier les affirmations critiques dans la documentation, les contrats et les essais.

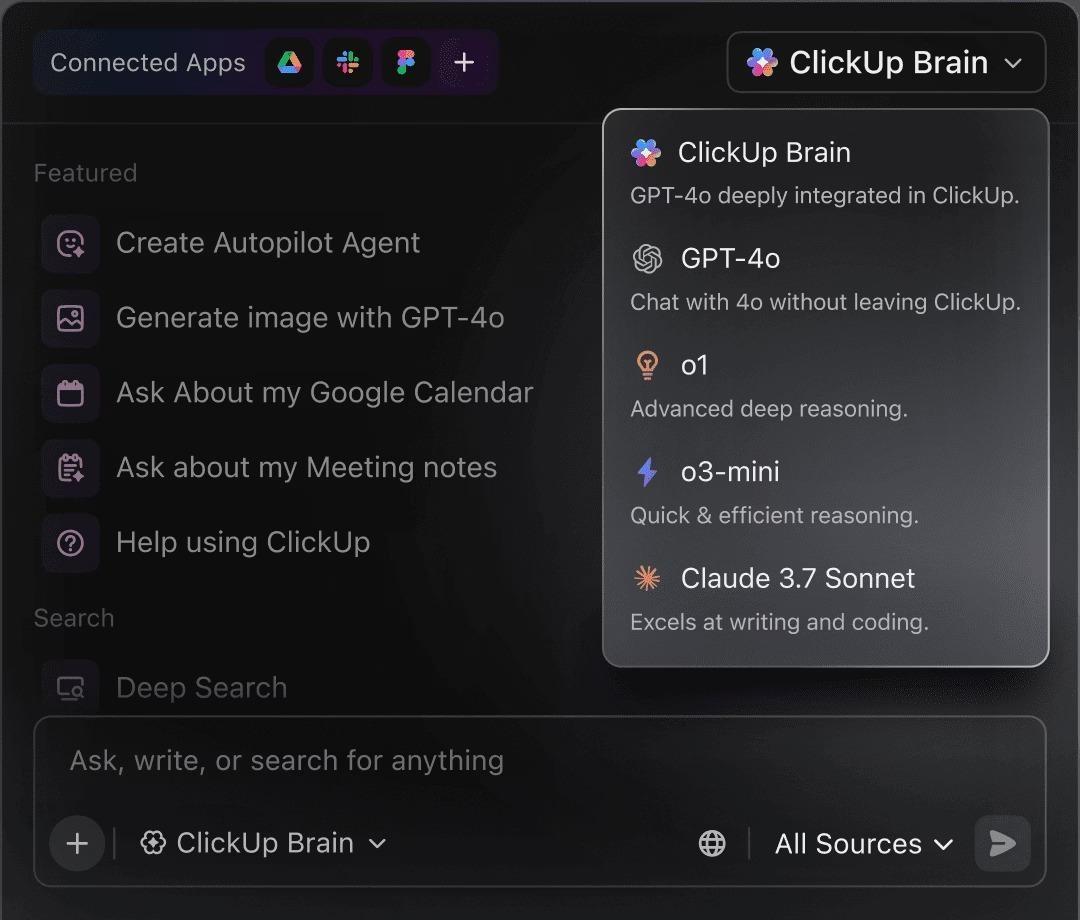

📮 ClickUp Insight : 88 % des personnes interrogées dans le cadre de notre sondage utilisent l'IA pour leurs tâches personnelles, mais plus de 50 % hésitent à l'utiliser au travail. Les trois principaux obstacles ? Le manque d'intégration transparente, les lacunes en matière de connaissances ou les préoccupations en matière de sécurité. Mais que se passerait-il si l'IA était intégrée à votre environnement de travail et était déjà sécurisée ? ClickUp Brain, l'assistant IA intégré à ClickUp, fait de cela une réalité. Il comprend les invites en langage clair, résolvant ainsi les trois préoccupations liées à l'adoption de l'IA tout en effectuant la connexion entre vos discussions, vos tâches, vos documents et vos connaissances dans tout l'environnement de travail. Trouvez des réponses et des informations en un seul clic !

Pourquoi utiliser l'IA pour évaluer les logiciels ?

L'IA réduit les efforts de recherche et applique une approche cohérente à tous les outils, ce qui facilite la comparaison et la justification des évaluations. Son impact se manifeste de plusieurs manières pratiques :

- Rapidité : réduisez de plusieurs jours ou semaines le temps consacré à la recherche manuelle en envoyant des requêtes à plusieurs sources en parallèle.

- Couverture : Découvrez des outils moins connus et des avertissements faciles à manquer lors des examens manuels.

- Cohérence : évaluez chaque option selon les mêmes critères au lieu de changer de normes en cours de processus.

- Documentation : générez des résumés clairs et des comparaisons que les parties prenantes peuvent examiner et remettre en question.

🔍 Le saviez-vous ? Le passage des chatbots aux agents IA (systèmes capables de planifier et d'exécuter des tâches en plusieurs étapes) devrait permettre d'augmenter l'efficacité des achats et des logiciels de 25 % à 40 %.

🔍 Le saviez-vous ? Le passage des chatbots aux agents IA (systèmes capables de planifier et d'exécuter des tâches en plusieurs étapes) devrait permettre d'augmenter l'efficacité des achats et des logiciels de 25 % à 40 %.

Pourquoi l'évaluation des logiciels d'IA nécessite de nouvelles questions

Lorsque vous évaluez des outils basés sur l'IA, les fonctionnalités traditionnelles et les checklists de conformité ne vous donnent qu'une vision partielle. Les critères standard se concentrent généralement sur ce qu'un outil fait, mais l'IA introduit une variabilité et des risques que les cadres traditionnels ne peuvent pas appréhender.

Cela change les questions que vous devez privilégier :

- Opacité des modèles : comprenez comment les résultats sont générés lorsque la visibilité du raisonnement n'est pas totale.

- Traitement des données : clarifiez la manière dont les données de l'entreprise sont stockées, réutilisées ou utilisées à des fins de formation.

- Variabilité des résultats : testez la cohérence lorsque les mêmes instructions produisent des résultats différents.

- Itération rapide : tenez compte des changements de comportement entre les démos, les essais et l'utilisation en production.

- Profondeur d'intégration : vérifiez que les capacités de l'IA prennent en charge des flux de travail réels, et non des fonctionnalités isolées.

En termes simples, l'évaluation d'un logiciel d'IA repose moins sur des vérifications superficielles que sur des questions relatives au comportement, au contrôle et à l'adéquation à long terme.

13 questions à poser lors de l'évaluation d'un logiciel d'IA

Utilisez ces questions comme questionnaire commun à tous les fournisseurs d'IA afin de pouvoir comparer leurs réponses côte à côte, et non après le déploiement.

| Questions à poser | À quoi ressemble une réponse convaincante ? |

|---|---|

| 1) Quelles données l'IA traite-t-elle et où se trouvent-elles ? | « Voici les données auxquelles nous avons accès, où nous les stockons (options régionales), comment nous les cryptons et combien de temps nous les conservons. » |

| 2) Certaines de nos données sont-elles utilisées pour l'entraînement, maintenant ou plus tard ? | « Non par défaut. La formation est facultative, et le contrat/l'accord de traitement des données (DPA) le stipule. » |

| 3) Qui, chez le fournisseur, a accès à nos données ? | « L'accès est basé sur les rôles, audité et limité à des fonctions spécifiques. Voici comment nous enregistrons et examinons les accès. » |

| 4) Quels modèles alimentent la fonctionnalité et les versions changent-elles silencieusement ? | « Voici les modèles que nous utilisons, comment nous les versionnons et comment nous vous informons en cas de changement de comportement. » |

| 5) Que se passe-t-il lorsque l'IA n'est pas sûre ? | « Nous mettons en évidence les signaux de confiance, demandons des éclaircissements ou nous rabattons sur des solutions sûres plutôt que de faire des suppositions. » |

| 6) Si nous exécutons deux fois la même invite, devons-nous nous attendre au même résultat ? | « Voici ce qui est déterministe par opposition à variable, et comment configurer la cohérence lorsque cela est important. » |

| 7) Quelles sont les limites réelles du contexte ? | « Ce sont les limites pratiques (taille du document/profondeur de l'historique). Voici ce que nous faisons lorsque le contexte est tronqué. » |

| 8) Pouvons-nous comprendre pourquoi l'IA a fait une recommandation ou pris une mesure ? | « Vous pouvez inspecter les entrées, les sorties et la trace expliquant pourquoi le logiciel a recommandé X. Les actions sont accompagnées d'une piste d'audit. » |

| 9) Quelles sont les autorisations requises avant qu'il n'agisse ? | « Les actions à haut risque doivent être examinées, les approbations peuvent être basées sur les rôles et il existe une procédure d'escalade. » |

| 10) Dans quelle mesure cela est-il personnalisable selon les équipes et les rôles ? | « Vous pouvez standardiser les invites/modèles, restreindre les personnes autorisées à les modifier et adapter les résultats en fonction du rôle. » |

| 11) S'intègre-t-il dans les flux de travail réels ou se contente-t-il de « faire une connexion » ? | « Nous offrons l’assistance pour la synchronisation bidirectionnelle et les déclencheurs/actions réels. Voici comment nous gérons les pannes et comment nous les surveillons. » |

| 12) Si nous passons à une version inférieure ou annulons notre abonnement, qu'est-ce qui ne fonctionnera plus et que pouvons-nous exporter ? | « Voici exactement ce que vous conservez, ce que vous pouvez exporter et comment nous supprimons les données sur demande. » |

| 13) Comment surveillez-vous la qualité au fil du temps ? | « Nous suivons les dérives et les incidents, effectuons des évaluations, publions des notes de mise à jour et disposons d'un processus d'escalade et d'assistance clair. » |

💡 Conseil de pro : pensez à centraliser les réponses à ces questions dans un questionnaire partagé destiné aux fournisseurs d'IA afin d'identifier les tendances et les compromis. Votre équipe pourra ainsi les réutiliser pour différentes évaluations au lieu de repartir de zéro à chaque fois, ce qui améliorera la gestion du flux de travail.

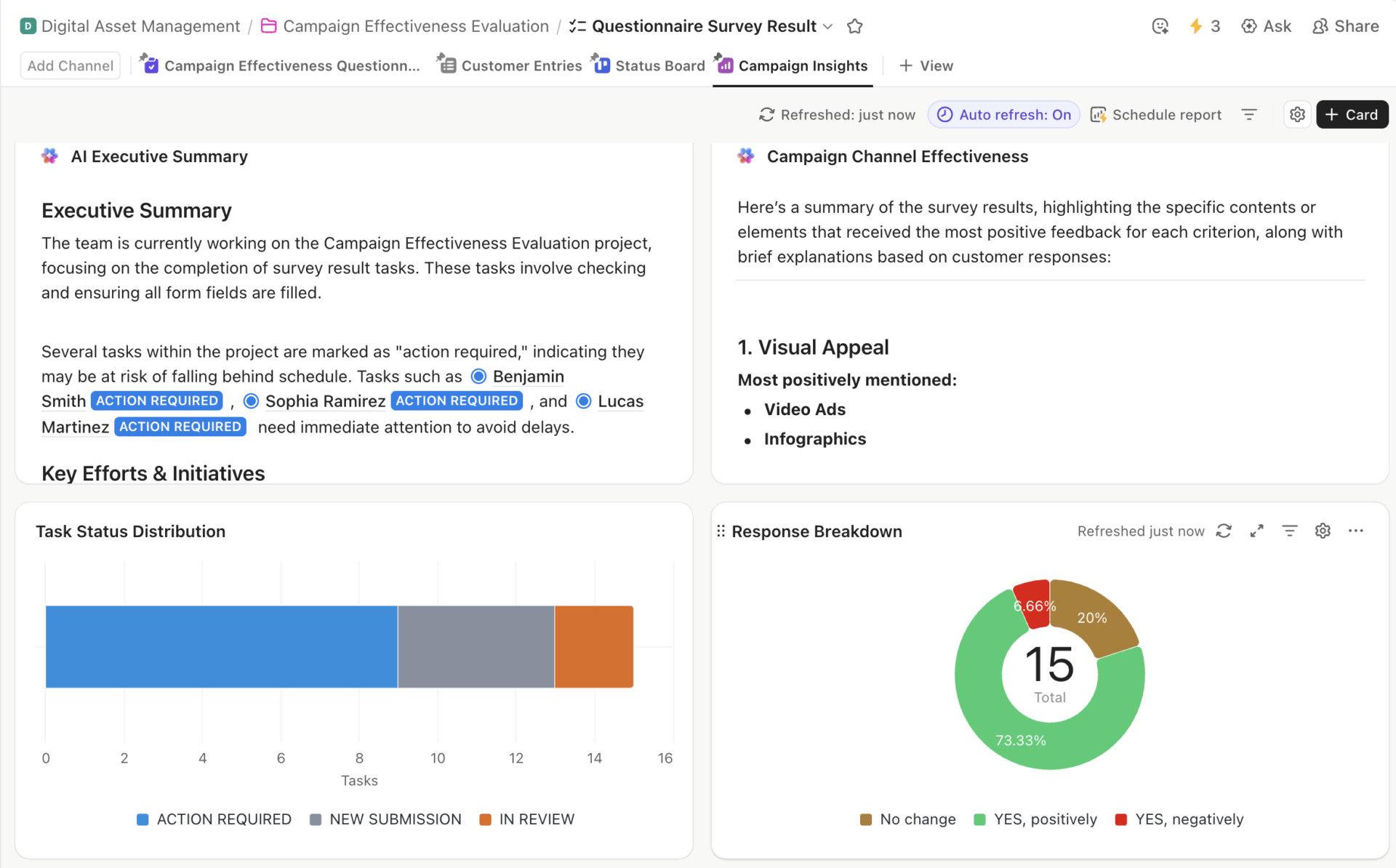

Tableau de bord du modèle de questionnaire ClickUp présentant un résumé exécutif de l'IA, la distribution des tâches, l'efficacité des canaux et la ventilation des réponses.

Vous pouvez utiliser le modèle de questionnaire ClickUp pour fournir à votre équipe un espace unique et structuré où enregistrer les réponses des fournisseurs et comparer les outils côte à côte. Il vous permet également de personnaliser les champs et d'attribuer des propriétaires, afin que vous puissiez réutiliser le même cadre pour vos futurs achats sans avoir à reconstruire votre processus à partir de zéro.

Étape par étape : comment évaluer un logiciel avec l'IA

Les étapes ci-dessous montrent comment votre équipe peut utiliser l'IA pour structurer l'évaluation des logiciels, afin que les décisions restent traçables et faciles à examiner ultérieurement.

Étape 1 : Définir vos besoins en matière de logiciels à l'aide de l'IA (prise de conscience du problème)

La plupart des évaluations échouent avant même que vous ayez vu une démonstration. C'est un piège courant : vous vous lancez directement dans des comparaisons sans vous être préalablement mis d'accord sur le problème que vous essayez réellement de résoudre. L'IA est particulièrement utile dans ce cas, car elle oblige à clarifier les choses dès le début.

Imaginons, par exemple, que vous travailliez dans une agence de marketing et que vous recherchiez un outil de gestion de projet avec un objectif vague, comme une meilleure collaboration. L'IA vous aide à préciser cette intention en vous demandant des détails sur vos flux de travail, la taille de votre équipe et les technologies existantes, transformant ainsi des idées vagues en exigences concrètes.

Essayez d'utiliser l'IA pour approfondir des questions telles que :

- Quels sont les obstacles spécifiques auxquels mon équipe est actuellement confrontée ?

- Quelles sont les fonctionnalités « indispensables » et « souhaitables » pour notre secteur ?

- Quels sont les outils généralement utilisés par les équipes de notre taille à cette fin ?

- Quel intervalle de budget est réaliste pour ces exigences ?

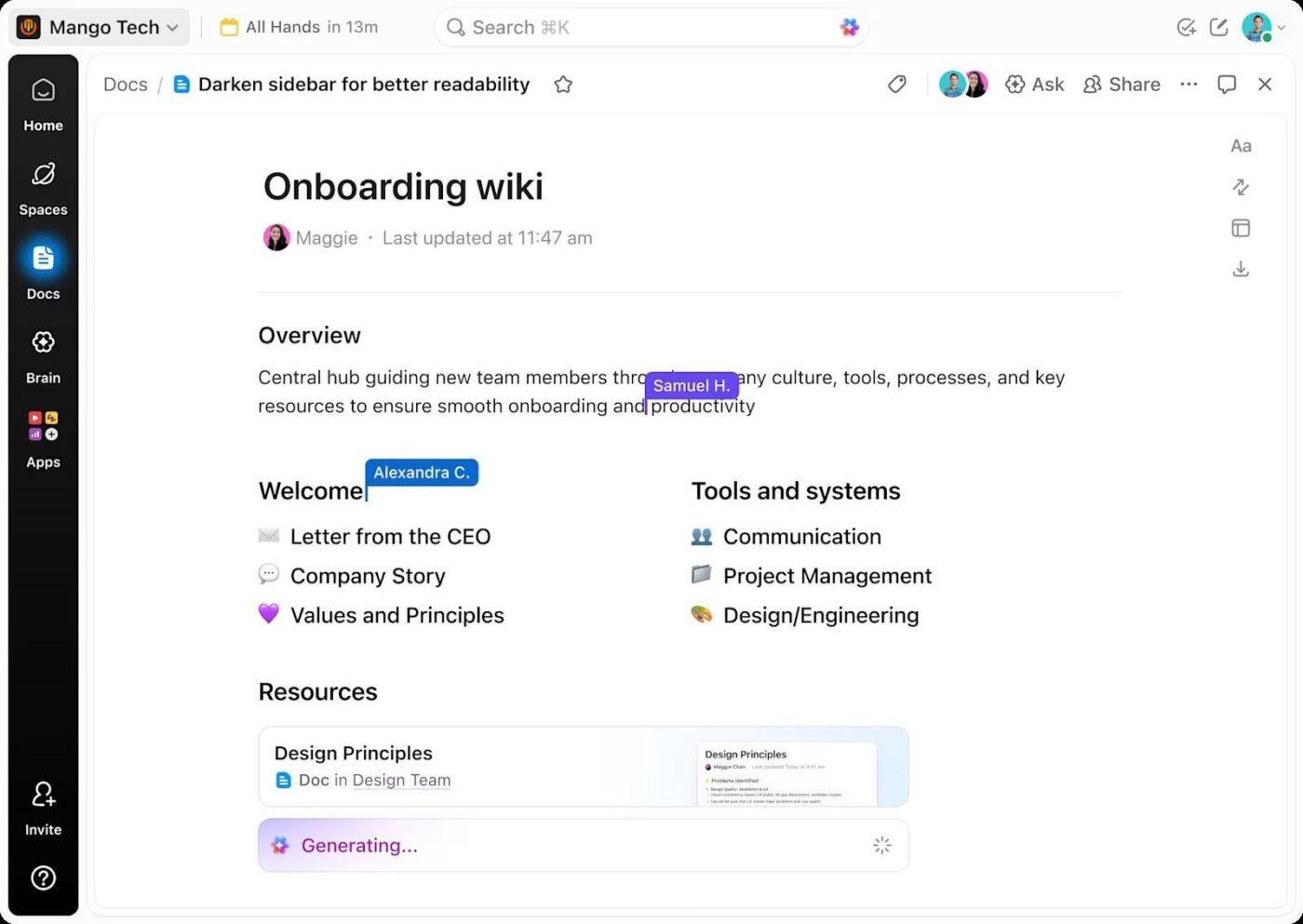

À mesure que ces réponses prennent forme, vous serez moins enclin à rechercher des fonctionnalités impressionnantes qui ne répondent pas à vos besoins réels. Vous pouvez consigner tout cela dans ClickUp Docs, où les exigences sont conservées sous forme de référence partagée plutôt que de checklist ponctuelle.

Au fur et à mesure que de nouvelles informations sont ajoutées, le document évolue :

- Les préoccupations des parties prenantes deviennent des contraintes explicites

- Les nouvelles catégories de logiciels identifiées sont enregistrées avant le début des comparaisons.

Comme les documents se trouvent dans le même environnement de travail que les tâches d'évaluation, le contexte ne change pas. Lorsque vous passez à la phase de recherche ou de démonstration, vous pouvez lier vos activités directement aux exigences que vous avez déjà validées.

📌 Résultat : le processus d'évaluation est clairement défini, ce qui rend l'étape suivante beaucoup plus ciblée.

Étape 2 : Découvrir les options logicielles avec l'IA (connaissance des solutions)

Une fois les exigences définies, le problème change. La question passe de « ce dont nous avons besoin » à « ce qui convient réellement ». L'évaluation ralentit également à ce stade, tout en élargissant la recherche et en brouillant les options.

L'IA limite cette prolifération en mappant directement les options à des critères tels que le secteur d'activité, la taille de l'équipe, le budget dans l'intervalle et les principaux flux de travail, avant d'approfondir la recherche.

À cette étape, vos invitations pourraient ressembler à ceci :

- Quels outils logiciels répondent à ces exigences ?

- Quelles sont les alternatives crédibles à [nom de l'outil] pour une équipe de notre taille ?

- Quels outils conviennent aux agences et aux équipes d'entreprise ?

- Quelles options peuvent fournir l'assistance nécessaire à la croissance sans nécessiter de modifications importantes ?

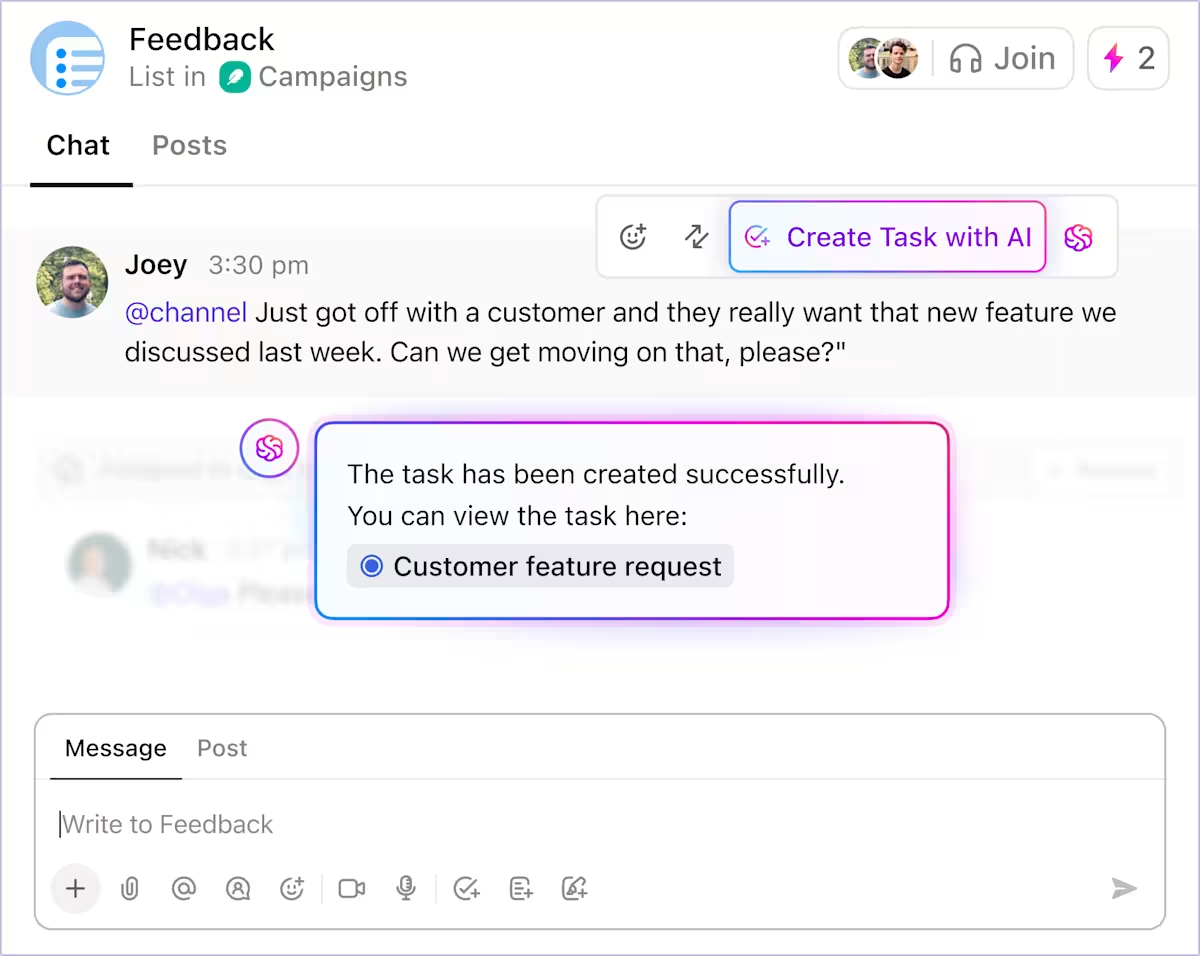

Pour faciliter la gestion, vous pouvez suivre chaque candidat comme un élément distinct dans ClickUp Tasks. Chaque outil fait l'objet d'une tâche unique avec un propriétaire, des liens vers des recherches, des notes issues des résultats de l'IA et des étapes suivantes claires. À mesure que les options avancent ou sont abandonnées, la liste est mise à jour en un seul endroit, sans qu'il soit nécessaire de rechercher le contexte dans les différentes discussions.

📌 Résultat : Vous obtenez une liste restreinte d'options viables, chacune avec sa propre propriété et son historique, prêtes à être comparées de manière beaucoup plus approfondie.

Étape 3 : Comparer les fonctionnalités et les prix à l'aide de l'IA (étape de réflexion)

Les listes restreintes créent un nouveau problème : la fatigue de la comparaison. Les fonctionnalités ne s'alignent pas clairement, les niveaux de prix masquent les contraintes et les catégories de fournisseurs ne correspondent pas au mode de fonctionnement des équipes.

Vous pouvez utiliser l'IA pour normaliser les différences entre les outils en mappant les fonctionnalités à leurs propres exigences, en résumant les niveaux de prix en termes simples et en mettant en évidence les contraintes qui n'apparaissent qu'à grande échelle. Elle met en évidence des problèmes tels que les automatisations plafonnées ou les prix des modules complémentaires, ce qui vous fait gagner du temps.

À ce stade, vous voudrez poser les questions suivantes :

- Quelles sont les fonctionnalités incluses dans chaque niveau de prix ?

- Quelles sont les limites des forfaits gratuits ou d'entrée de gamme ?

- Quelles fonctionnalités entraînent des coûts supplémentaires ou sont peu évolutives ?

- En quoi ces outils se recoupent-ils et en quoi diffèrent-ils de manière significative ?

Une fois ces informations disponibles, créez des tableaux comparatifs dans ClickUp Docs, avec la forme des exigences initiales plutôt que des catégories marketing des fournisseurs.

Grâce à ClickUp Brain, vous pouvez générer des résumés concis des avantages et des inconvénients directement à partir de la comparaison. Cela permet de garder l'interprétation ancrée dans le matériel source afin d'éviter de dériver vers des notes ou des discussions séparées.

📌 Résultat : vos décisions sont affinées sur la base de compromis documentés, et non sur des intuitions. Il devient plus facile d'identifier précisément pourquoi une option est retenue et une autre rejetée, le raisonnement étant conservé parallèlement à la comparaison elle-même.

Étape 4 : Évaluer les intégrations et l'adéquation des flux de travail avec l'IA

Deux outils peuvent sembler similaires sur le papier, mais se comporter très différemment dans votre infrastructure existante. Il est donc essentiel de déterminer si le nouvel outil simplifie le travail ou impose une charge supplémentaire.

L'IA mappe chaque outil présélectionné dans votre installation actuelle. Au-delà de la simple question « quelles intégrations existent », vous pouvez tester « comment le flux de travail s'effectue réellement ». Par exemple, que se passe-t-il lorsqu'un prospect est transféré dans votre CRM ou qu'un ticket d'assistance est créé ?

À cette étape, les questions ressemblent à celles-ci :

- Quels sont les dysfonctionnements lorsque cet outil interagit avec nos systèmes existants ?

- Quels transferts nécessitent une intervention humaine ?

- Où les automatisations échouent-elles silencieusement ou ne se synchronisent-elles que dans un seul sens ?

- Cet outil réduit-il la coordination ou la redistribue-t-il ?

Il met en évidence des problèmes tels que les déclencheurs manquants ou les intégrations qui semblent achevées mais qui causent tout de même des retombées. ClickUp est un choix judicieux dans ce cas, car les intégrations et l'automatisation fonctionnent au sein du même système.

ClickUp Integrations connecte plus de 1 000 outils, dont Slack, HubSpot et GitHub, pour améliorer la visibilité. Il permet également de créer des tâches, de mettre à jour des statuts, d'acheminer des travaux et de déclencher des suivis dans l'environnement de travail où l'exécution a déjà lieu.

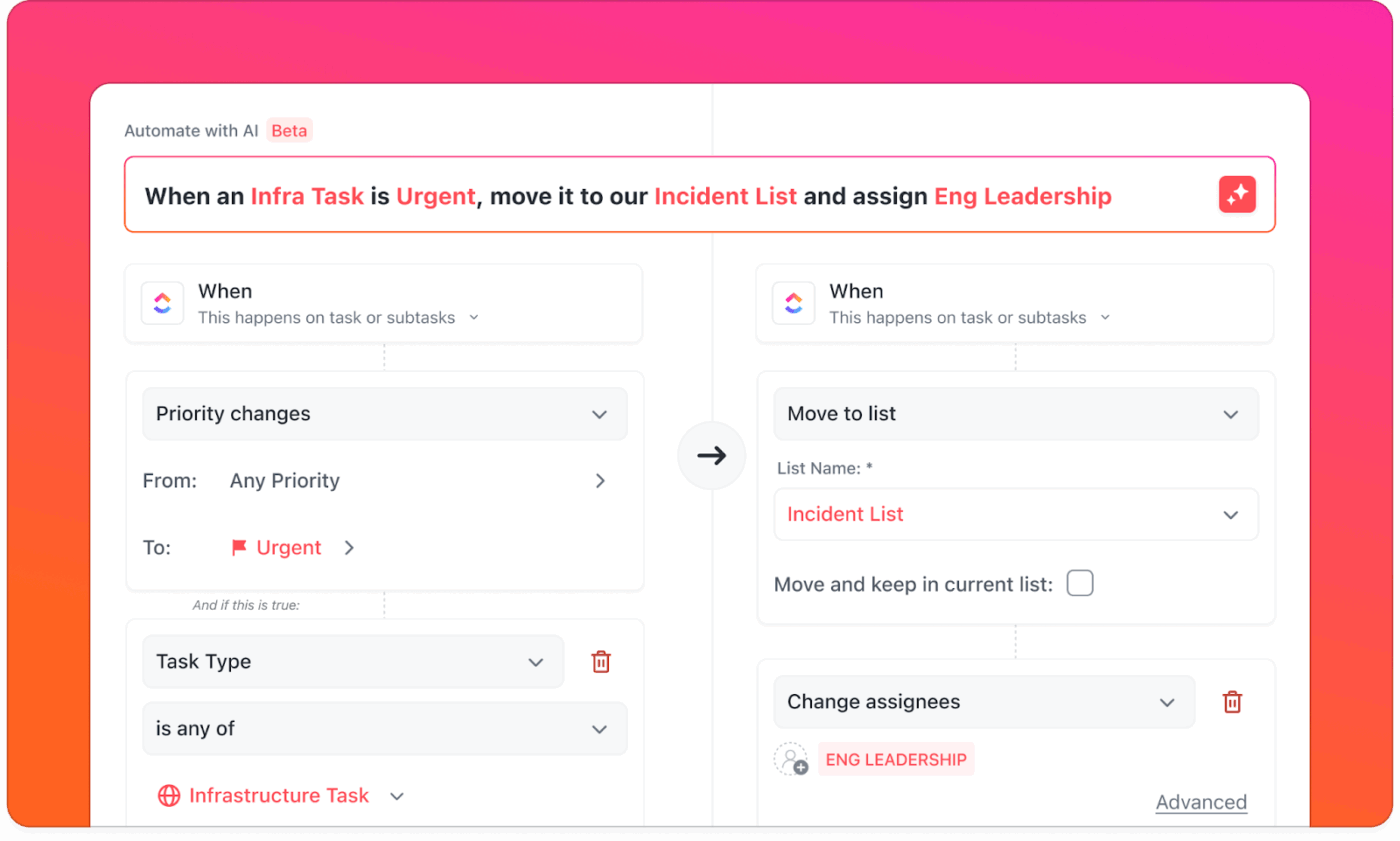

Grâce aux automatisations ClickUp, vous pouvez vérifier si les transitions de routine s'exécutent de manière cohérente sans supervision. Elles permettent d'éviter de connecter des outils externes entre eux et de définir le comportement une seule fois, pour qu'il s'applique à tous les espaces, listes et flux de travail.

📌 Résultat : À la fin de cette étape, la différence devient plus claire.

- Certains outils offrent une grande connexion, mais nécessitent tout de même une coordination humaine pour le travail.

- D'autres intègrent cette coordination dans le flux de travail lui-même.

Cette compréhension tend à l'emporter sur la parité des fonctionnalités lorsque la décision finale est prise.

Étape 5 : Valider l'utilisation dans le monde réel à l'aide de l'IA (étape de décision)

Aujourd'hui, la décision repose rarement sur des fonctionnalités manquantes ou des tarifs peu clairs. Il est plus difficile de savoir si l'outil continuera à fonctionner une fois que la nouveauté aura disparu et que son utilisation réelle aura commencé.

L'IA est ici utile en tant que détecteur de modèles plutôt qu'en tant que chercheur. L'IA peut résumer les thèmes récurrents dans les sources d'évaluation que vous fournissez (G2, documentation, forums), puis vous aider à vérifier si les problèmes sont regroupés par taille d'équipe ou par cas d'utilisation.

Les questions courantes à cette étape sont les suivantes :

- Quels problèmes les utilisateurs signalent-ils après les premiers mois d'utilisation ?

- Quels sont les flux de travail qui posent problème à mesure que l'utilisation augmente ?

- Quels sont les thèmes récurrents sur les sites d'avis tels que G2 et Reddit ?

- Quels types d'équipes regrettent d'avoir choisi cet outil ?

L'IA permet de faire la distinction entre les frictions liées à l'intégration et les limites structurelles, ou de montrer si les plaintes se concentrent autour de certaines tailles d'équipes, certains secteurs d'activité ou certains cas d'utilisation. Ce contexte aide à déterminer si un problème est un compromis acceptable ou une incompatibilité fondamentale.

Au fur et à mesure que les informations s'accumulent, vous pouvez rendre les données visibles dans les tableaux de bord ClickUp, qui permettent le suivi des risques, des questions en suspens, des préoccupations liées au déploiement et des habitudes des évaluateurs en un seul endroit. Vos parties prenantes peuvent voir les mêmes signes : plaintes récurrentes, risques liés à l'adoption, dépendances et lacunes non résolues.

📌 Résultat : Cette étape permet de clarifier les points de friction potentiels, d'identifier les personnes qui en seront les premières victimes et de déterminer si votre organisation est prête à les absorber.

Étape 6 : Décision finale et adoption avec l'IA

À ce stade, le travail d'évaluation est en grande partie terminé, mais même lorsque la bonne option est claire, les décisions peuvent rester en suspens si votre équipe n'est pas en mesure de montrer comment le déploiement fonctionnera dans la pratique.

Vous pouvez utiliser l'IA pour consolider tout ce que vous avez appris jusqu'à présent en résultats prêts à être utilisés pour la prise de décision. Cela inclut des résumés exécutifs comparant les options finales, des déclarations claires sur les compromis acceptés et des plans de déploiement anticipant les frictions.

Vous pouvez vous attendre à ce que l'IA réponde à des questions telles que :

- Quelle option correspond le mieux à nos objectifs et à notre budget, compte tenu de tout ce que nous avons appris ?

- Quels compromis acceptons-nous en toute connaissance de cause ?

- À quoi ressemble un déploiement réaliste au cours des 30, 60 ou 90 premiers jours ?

- Comment expliquer cette décision à la direction de manière à ce qu'elle résiste à un examen minutieux ?

Comme ClickUp Brain a accès à l'ensemble du contexte d'évaluation (documents, comparaisons, tâches, commentaires et risques), il peut générer des résumés et des checklists de déploiement, éliminant ainsi le besoin de modèles d'évaluation génériques. Vous pouvez l'utiliser pour rédiger des notes à l'intention des dirigeants, créer des plans d'intégration et aligner les propriétaires sur les indicateurs de réussite sans avoir à exporter le contexte vers des outils distincts.

📌 Résultat : une fois ces documents partagés, la discussion change. Vos parties prenantes examinent les mêmes preuves, hypothèses et risques en un seul endroit. Les questions deviennent plus ciblées et l'adhésion suit généralement de manière plus naturelle.

Ce qu'il faut tester pendant l'essai pour ne pas se laisser berner par les démos

Lors des essais, testez les flux de travail, pas les fonctionnalités :

- Exécutez un flux de travail réel de bout en bout (réception → transfert → approbation → rapports).

- Testez les permissions avec des rôles réels (administrateur, responsable, collaborateur, invité).

- Mesurez le temps d'installation et les points de défaillance (là où les utilisateurs rencontrent des difficultés).

- Forcer les exceptions (rupture de transfert, champ manquant, approbation retardée)

- Demandez : qu'est-ce qui ne fonctionne plus lorsque vous augmentez le nombre d'utilisateurs, de projets ou d'automatisations ?

Erreurs courantes lors de l'évaluation d'un logiciel avec l'IA

L'IA peut renforcer l'évaluation des logiciels, mais uniquement lorsqu'elle est utilisée avec rigueur. Évitez ces erreurs :

- Ne pas vérifier les résultats de l'IA : l'IA peut mal interpréter les fonctionnalités, les prix ou les limitations, ce qui rend la vérification essentielle.

- Sauter l'étape des exigences : comparer des outils sans avoir défini clairement vos besoins conduit à rechercher des fonctionnalités plutôt qu'à résoudre des problèmes.

- Ignorer le niveau d'intégration : les intégrations annoncées peuvent se limiter à la synchronisation des données, sans prendre en charge la gestion continue des flux de travail.

- Négliger les questions relatives à la confidentialité des données : des politiques peu claires en matière d'accès, de stockage ou de réutilisation des données créent un risque de non-conformité en aval.

- Évaluation isolée : exclure les utilisateurs finaux dès le début entraîne souvent des frictions lors de l'adoption ultérieure.

- Confondre les fonctionnalités de l'IA avec les capacités de l'IA : un chatbot ajouté après coup n'offre pas la même valeur qu'une IA intégrée aux flux de travail principaux.

Bonnes pratiques pour l'évaluation des logiciels basés sur l'IA

L'évaluation des logiciels basée sur l'IA fonctionne mieux lorsque vous l'appliquez de manière systématique à toutes vos décisions en suivant les pratiques ci-dessous :

Ces bonnes pratiques sont faciles à mettre en œuvre lorsque vous disposez d'une plateforme centrale telle que ClickUp pour les gérer.

- Posez des questions de plus en plus spécifiques : commencez par définir le problème, puis affinez vos questions à mesure que les exigences, les contraintes et les compromis deviennent plus clairs.

- Vérifiez les résultats de l'IA à l'aide de données réelles : validez les fonctionnalités, les prix et les limites à l'aide de la documentation du fournisseur et de sources d'évaluation fiables.

- Centralisez les notes, les décisions et les approbations : conservez les exigences, les conclusions, les risques et les validations dans un environnement de travail partagé afin d'éviter toute fragmentation du contexte.

- Évaluez les outils en fonction des flux de travail : concentrez-vous sur le déroulement du travail de bout en bout plutôt que de comparer des fonctionnalités isolées.

Utilisez ClickUp pour opérationnaliser vos décisions en matière de logiciels

L'évaluation des logiciels échoue non pas parce que vous manquez d'informations, mais parce que vos décisions sont dispersées entre des outils, des discussions et des documents qui ne sont pas conçus pour travailler ensemble.

ClickUp regroupe l'évaluation dans un seul environnement de travail, où les exigences, les recherches, les comparaisons et les approbations restent connectées. Vous pouvez documenter vos besoins dans ClickUp Docs, suivre les fournisseurs sous forme de tâches, résumer vos conclusions dans ClickUp Brain et offrir à la direction une visibilité en temps réel grâce aux tableaux de bord, sans créer de prolifération de SaaS.

Comme l'évaluation va de pair avec l'exécution, le raisonnement qui la sous-tend reste également visible et vérifiable, à mesure que votre équipe évolue ou que les outils doivent être réévalués. Ce qui commence comme un processus d'achat devient partie intégrante du processus décisionnel de votre organisation.

Si votre équipe utilise déjà l'IA pour évaluer les logiciels, ClickUp vous aide à mettre ces informations en pratique sans avoir à gérer un autre système.

Commencez à utiliser ClickUp gratuitement et centralisez vos décisions en matière de logiciels. ✨

Foire aux questions

Oui, lorsque la précision consiste à repérer des modèles, des incohérences et des informations manquantes dans de nombreuses sources, l'IA peut aider à évaluer les logiciels. Elle peut comparer les fonctionnalités, résumer les avis et tester de manière approfondie les affirmations des fournisseurs à grande échelle, ce qui rend l'évaluation à l'étape précoce et intermédiaire plus fiable.

Des biais peuvent apparaître en raison d'instructions vagues ou de résultats incorrects. Utilisez des exigences clairement définies, posez des questions comparatives et vérifiez les affirmations à l'aide de sources primaires telles que la documentation et les essais.

Non, l'IA peut réduire les options et préparer des questions de démonstration plus pertinentes, mais elle ne peut pas reproduire l'utilisation pratique. Les démonstrations et les essais restent nécessaires pour tester les flux de travail, la facilité d'utilisation et l'adoption par l'équipe dans des conditions réelles.

Les équipes efficaces documentent leurs décisions en matière de logiciels en centralisant les exigences, les comparaisons et les justifications finales dans un environnement de travail partagé. Cela permet de conserver le contexte et d'éviter les débats répétitifs lors de la réévaluation ultérieure des outils.

Lorsque vous évaluez les réponses d'un logiciel IA, méfiez-vous des affirmations vagues, des explications incohérentes et des détails manquants concernant le traitement des données ou le comportement du modèle.