La mayoría de los equipos prueban las herramientas de resumen de LLM alimentándolas con un documento de muestra y dando por terminado el proceso. El modelo que funciona a la perfección con sus informes trimestrales podría destrozar sus hilos de Slack, y el que es perfecto para los informes legales podría distorsionar los datos de los correos electrónicos de sus clientes.

Esta guía le muestra los mejores LLM para resumir textos, cómo evaluarlos en función de su carga de trabajo real y cómo conectar esos resúmenes directamente con la acción en su flujo de trabajo.

Modelos de resumen LLM de un vistazo

| Modelo | Ideal para | Mejores funciones | Precios |

|---|---|---|---|

| ClickUp Brain | Equipos que desean resumir directamente dentro de su flujo de trabajo. Tamaño del equipo: cualquier equipo que utilice ClickUp para proyectos y comunicación. | Resúmenes adaptados al entorno de trabajo, resumen de reuniones con AI Notetaker, creación de elementos de acción, enrutamiento multi-LLM, búsqueda en lenguaje natural. | Gratis para siempre; personalización disponible para corporaciones. |

| OpenAI GPT-4o | Resúmenes pulidos y listos para ejecutivos Tamaño del equipo: equipos pequeños a grandes que necesitan resultados abstractivos de alta calidad. | Resúmenes similares a los humanos, compatibilidad multimodal, gran capacidad para seguir instrucciones, amplia ventana de contexto. | API de pago por token, ChatGPT Plus 20 $ al mes. |

| Claude 3. 5 Sonnet | Documentos sensibles en materia de cumplimiento normativo o altamente técnicos. Tamaño del equipo: equipos jurídicos, financieros y de corporación. | Ventana de contexto ampliada, baja alucinación, gran control del formato, razonamiento sólido. | API de pago por token, suscripción a Claude Pro. |

| Google Gemini 1. 5 Pro | Equipos que trabajan intensamente en Google WorkspaceTamaño del equipo: equipos de operaciones, investigación y con muchas reuniones. | Ventana de contexto de hasta 1 millón de tokens, integración con Google Meet y Drive, resumen multimodal. | Precios basados en el uso a través de Google AI Studio o Vertex AI. |

| Meta LLaMA 3 | Canales de resumen autohospedados y personalizables Tamaño del equipo: equipos dirigidos por ingenieros y centrados en la privacidad. | Totalmente autohospedado, capacidad de ajuste fino, gran calidad para resumir, control total de los datos. | Ponderaciones de código abierto gratuitas, se aplican costes de infraestructura. |

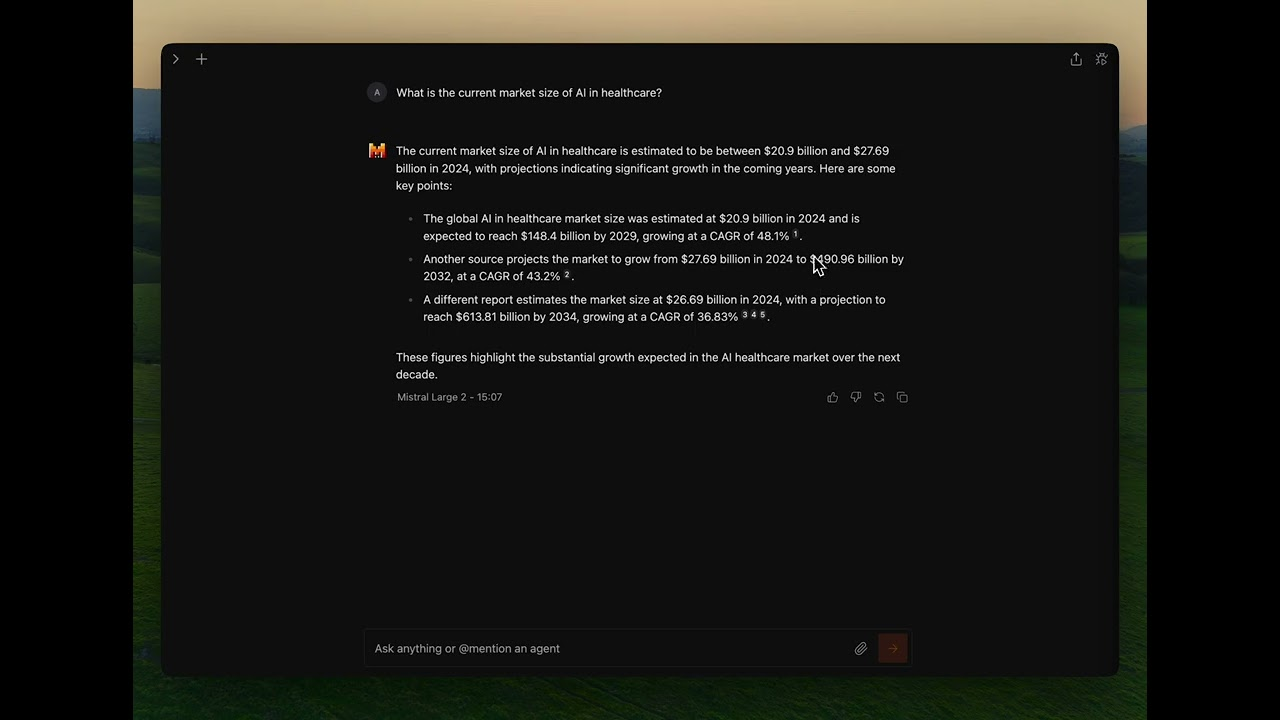

| Mistral Large | Equipos que necesitan residencia de datos en la UE e implementación híbrida. Tamaño del equipo: corporaciones de la UE u organizaciones orientadas al cumplimiento normativo. | API híbrida gestionada o autohospedada, gran calidad para resumir, uso eficiente de tokens. | Precios competitivos de API, pesos abiertos disponibles. |

Cómo evaluamos el software en ClickUp

Nuestro equipo editorial sigue un proceso transparente, respaldado por investigaciones y neutral con respecto a los proveedores, por lo que puede confiar en que nuestras recomendaciones se basan en el valor real del producto.

Aquí tienes un resumen detallado de cómo evaluamos el software en ClickUp.

¿Qué debe buscar en un LLM para resumir?

Elegir el modelo de resumen incorrecto conlleva malgastar dinero en API poco prácticas, lidiar con configuraciones complejas o, simplemente, obtener resúmenes de baja calidad que no resultan útiles. Antes de profundizar en modelos específicos, comprender qué diferencia a un resumen eficaz de un resultado genérico le ayudará a tomar una decisión más inteligente.

Maneja sus tipos de documentos reales.

Un modelo que destaca en el resumen de artículos de investigación puede tener dificultades con hilos de conversación de Slack o transcripciones de reuniones. Busque LLM que hayan sido probados en los tipos de documentos específicos con los que trabaja su equipo a diario, ya sean contratos legales, correos electrónicos de clientes, documentación técnica o notas de reuniones.

Ofrece una ventana de contexto suficiente.

La ventana de contexto determina la cantidad de texto que el modelo puede procesar en una sola pasada. Si está resumiendo transcripciones de reuniones de una hora de duración o informes de investigación extensos, necesitará un modelo con una ventana de contexto ampliada. De lo contrario, tendrá que dividir los documentos en fragmentos y perderá la coherencia que se obtiene al procesar todo junto.

Equilibra velocidad y calidad.

Algunos modelos dan prioridad a la velocidad de inferencia, mientras que otros optimizan la calidad de los resultados. Para resumir en tiempo real durante las reuniones, la velocidad es más importante. Para generar informes ejecutivos, la calidad es lo más importante. Considere dónde se encuentran sus casos de uso en este espectro.

Proporciona opciones de acceso adecuadas.

Los recursos técnicos y los requisitos de seguridad de su equipo deben determinar si necesita una API gestionada, una implementación autohospedada o un enfoque híbrido. Los equipos de corporación con políticas de datos estrictas pueden necesitar opciones locales, mientras que los equipos más pequeños pueden preferir la comodidad de las API en la nube.

Los 6 mejores LLM para resumir textos

El abrumador número de modelos disponibles hace que elegir el adecuado sea todo un reto. Cada uno de los modelos que se muestran a continuación es un firme candidato, pero el «mejor» depende totalmente de las necesidades específicas de su equipo. Los evaluaremos en función de su precisión, el tamaño de la ventana de contexto, la velocidad y las opciones de acceso.

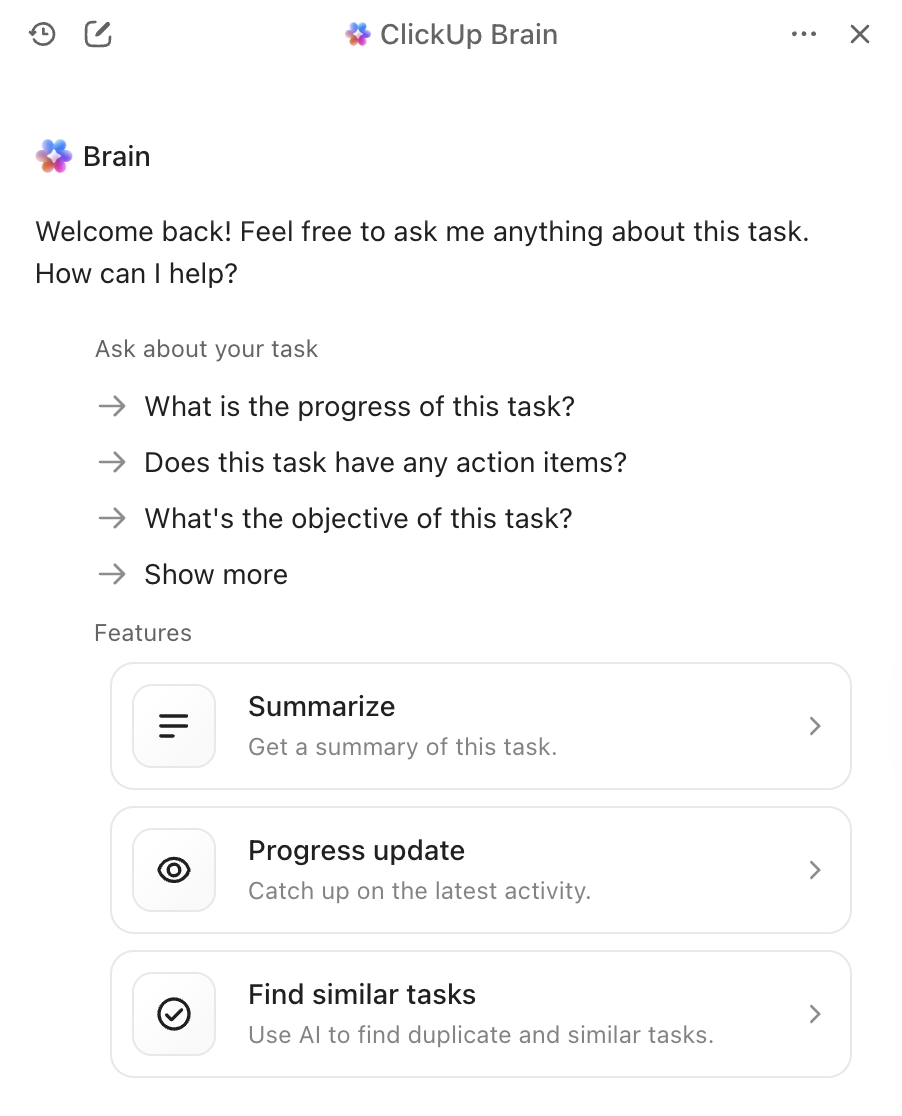

1. ClickUp Brain (el mejor para resumir utilizando IA dentro de su flujo de trabajo)

El mayor problema de las herramientas de resumen independientes no es la calidad de sus resúmenes, sino lo que ocurre después. Se genera un resumen brillante, luego se copia manualmente a la herramienta de gestión de proyectos, se crean tareas a partir de él y se envía un mensaje al equipo sobre los siguientes pasos. ClickUp Brain elimina esta fricción al incorporar el resumen directamente en el flujo de trabajo.

Con ClickUp Brain, solo tienes que escribir @brain en cualquier comentario de tarea o mensaje de chat de ClickUp y pedirle que resuma el contexto. Al instante, te proporcionará un resumen utilizando su conocimiento de tu entorno de trabajo, dando prioridad a la tarea o canal específico en el que te encuentras. Como Brain entiende tus proyectos, documentos y conversaciones, sus resúmenes son inmediatamente aplicables, en lugar de texto aislado que tienes que procesar manualmente.

Las mejores funciones de ClickUp Brain

- Resumir tareas, documentos, hilos de chat y grabaciones de reuniones sin salir de su entorno de trabajo.

- Aprovecha múltiples LLM en segundo plano para que obtengas resultados óptimos sin tener que gestionar la selección de modelos.

- Convierte los resúmenes directamente en tareas con personas asignadas y fechas límite.

- Comprende el contexto de su entorno de trabajo para obtener resúmenes más relevantes y prácticos.

- Se integra con ClickUp AI Notetaker para capturar y resumir automáticamente las reuniones.

Limitaciones de ClickUp Brain

- Requiere trabajar dentro del ecosistema ClickUp para obtener todos los beneficios.

- Más adecuado para flujos de trabajo en equipo que para el procesamiento de documentos individuales.

Precios de ClickUp Brain

2. OpenAI GPT-4o (el mejor para resúmenes pulidos y listos para ejecutivos)

Cuando necesite un resumen pulido, matizado y listo para el uso compartido con los ejecutivos, GPT-4o es la mejor opción. Su punto fuerte es la síntesis abstractiva de alta calidad, que produce un texto que parece escrito por un humano. La gran ventana de contexto y las capacidades multimodales permiten resumir texto a partir de imágenes o transcripciones de audio, no solo de documentos.

Puede acceder a él a través de una API ampliamente disponible, lo que facilita su integración en sus herramientas de IA existentes para reuniones. La contrapartida es que se trata de un servicio propietario con precios basados en el uso, y es posible que note un ligero retraso al resumir documentos muy largos.

Las mejores funciones de GPT-4o

- Produce resúmenes abstractivos con calidad humana que requieren una edición mínima.

- Maneja entradas multimodales, incluyendo imágenes y transcripciones de audio.

- Ofrece una amplia documentación sobre la API y soporte para la integración.

Limitaciones de GPT-4o

- Los precios basados en el uso pueden suponer un coste adicional para resumir grandes volúmenes.

- La latencia de inferencia aumenta con documentos muy largos.

- Los modelos patentados implican un menor control sobre el manejo de los datos.

Precios de GPT-4o

- Acceso a la API con precios de pago por token.

- Suscripción a ChatGPT Plus por 20 $ al mes para uso individual.

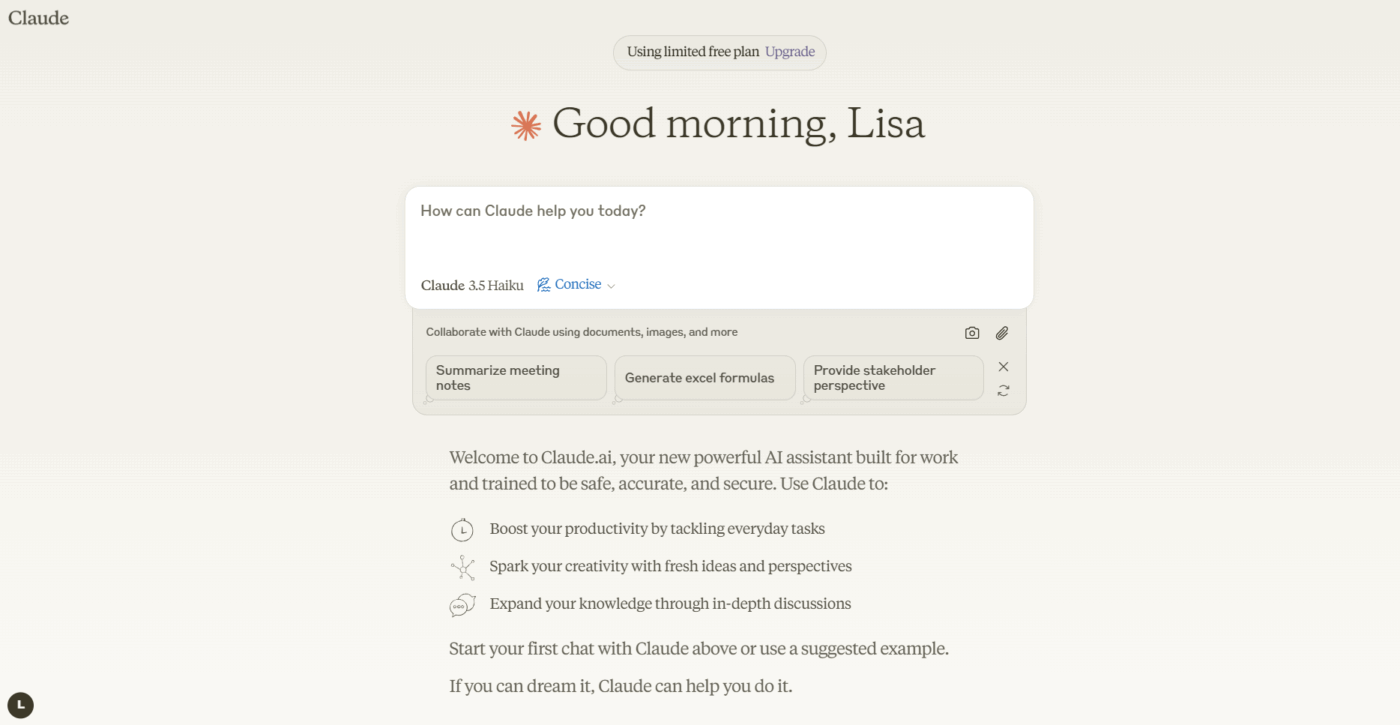

3. Anthropic Claude 3. 5 Sonnet (el mejor para documentos sensibles al cumplimiento normativo)

Si su equipo maneja documentos altamente confidenciales o complejos, Claude 3. 5 Sonnet se ha diseñado pensando en sus necesidades. Cuenta con una ventana de contexto ampliada, lo que le permite procesar y resumir informes completos y extensos de una sola vez. Donde realmente destaca es en su capacidad para seguir instrucciones matizadas: puede solicitar un resumen en un formato específico, con un tono concreto o centrado en determinados temas, y lo entrega con gran precisión.

El fuerte enfoque de Anthropic en la alineación de la seguridad ayuda a reducir el riesgo de que el modelo invente hechos, una función fundamental para los equipos preocupados por el cumplimiento normativo que trabajan con documentos legales o financieros. Para los equipos que ya utilizan resumidores de documentos con IA, Claude se integra bien en los flujos de trabajo existentes.

Las mejores funciones de Claude 3. 5 Sonnet

- La ventana de contexto ampliada procesa informes completos en una sola pasada.

- Excelente seguimiento de instrucciones para requisitos personalizados de formato y tono.

- Una sólida alineación de seguridad reduce el riesgo de alucinaciones.

Límites de Claude 3. 5 Sonnet

- Modelo patentado con variaciones de disponibilidad regional.

- El precio de la API puede ser significativo para el uso a escala de corporación.

Precios de Claude 3. 5 Sonnet

- Acceso a la API con precios de pago por token.

- Suscripción a Claude Pro disponible para uso individual.

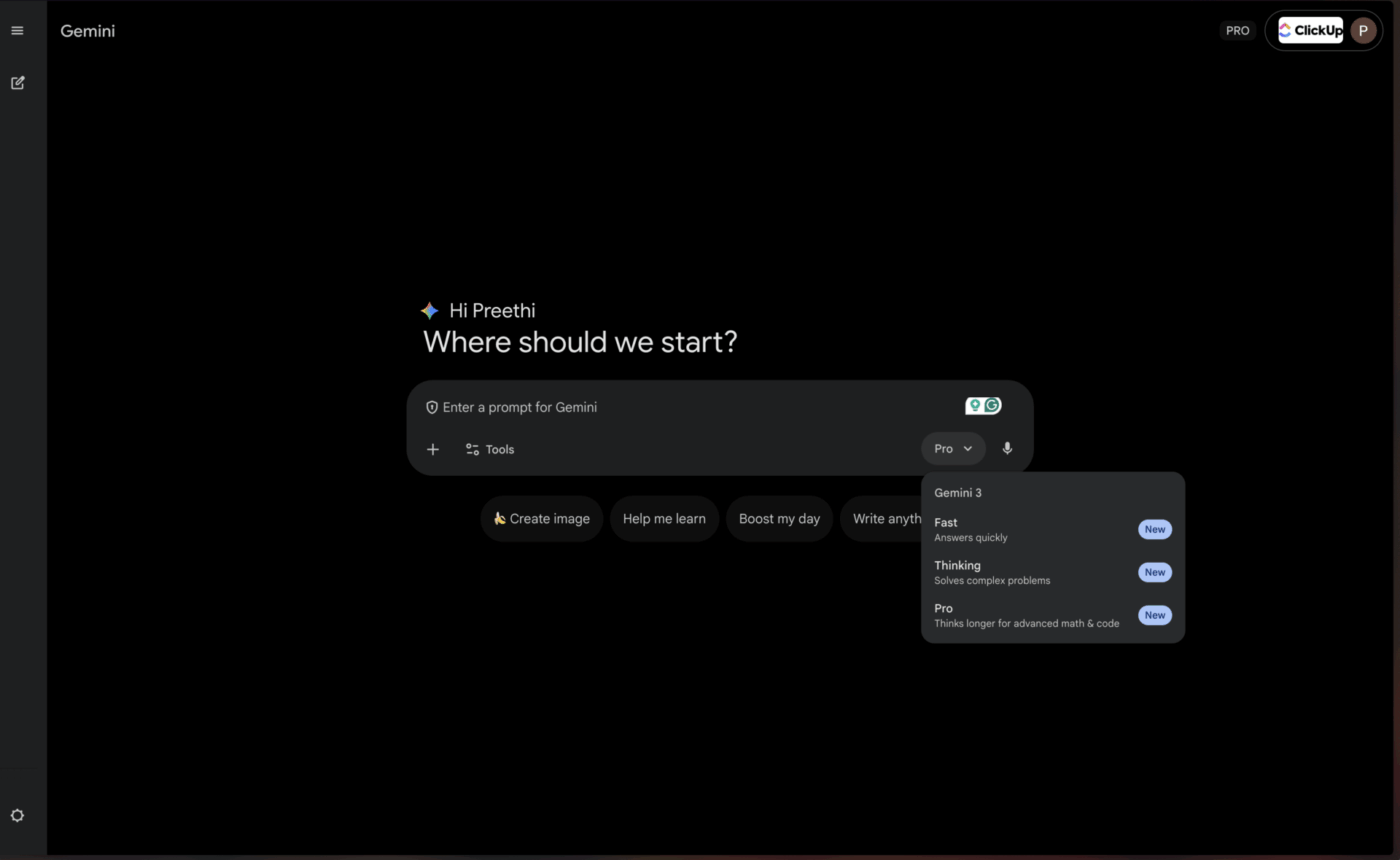

4. Google Gemini 1. 5 Pro (el mejor para usuarios de Google Workspace)

Para los equipos que ya viven y respiran en el ecosistema de Google, Gemini 1. 5 Pro ofrece un nivel de comodidad casi inigualable. Cuenta con una de las ventanas de contexto más grandes disponibles actualmente, con hasta 1 millón de tokens, lo que lo hace perfecto para resumir transcripciones de reuniones extensas de Google Meet o sintetizar información de múltiples artículos de investigación almacenados en Google Drive.

La integración nativa con Google Workspace le permite obtener resúmenes sin tener que salir de las herramientas que utiliza a diario. Esto lo hace especialmente valioso para los equipos que dependen en gran medida de los resumidores de reuniones basados en IA dentro del ecosistema de Google.

Las mejores funciones de Gemini 1. 5 Pro

- Una ventana de contexto masiva de 1 millón de tokens maneja documentos extremadamente largos.

- Integración nativa con Google Workspace para un flujo de trabajo fluido.

- Capacidades multimodales en texto, imágenes y vídeo.

Limitaciones de Gemini 1. 5 Pro

- Para aprovechar todas las ventajas es necesario invertir en el ecosistema de Google.

- El rendimiento fuera de la integración con Google puede quedar por detrás del de la competencia.

Precios de Gemini 1. 5 Pro

- Disponible a través de Google IA Studio y Vertex AI.

- Los precios varían según el uso y los acuerdos de corporación.

📌 ClickUp Insight: El profesional medio dedica más de 30 minutos al día a buscar información relacionada con el trabajo, lo que supone más de 120 horas al año perdidas en buscar entre correos electrónicos, hilos de Slack y archivos dispersos. Un asistente de IA inteligente integrado en su entorno de trabajo puede cambiar eso al mostrar los documentos, conversaciones y detalles de tareas adecuados en cuestión de segundos.

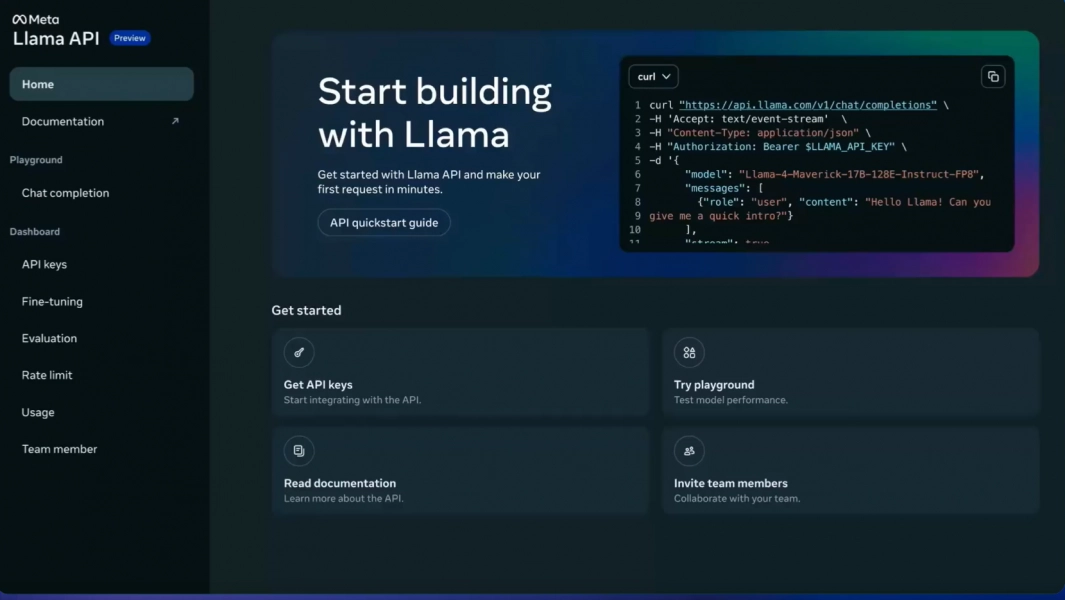

5. Meta LLaMA 3 (ideal para procesos personalizables y autohospedados)

Su equipo necesita tener un control total sobre sus datos y quiere evitar enviar información confidencial a un servicio externo. Aquí es donde destaca un modelo de código abierto como LLaMA 3. Puede alojarlo en sus propios servidores, ajustarlo a los datos específicos de su empresa para que comprenda mejor su jerga y personalizarlo de manera personalizada, todo ello sin tener que pagar derechos de licencia.

La calidad de la síntesis es impresionante y, a menudo, rivaliza con la de los modelos propietarios. El inconveniente es la necesidad de infraestructura técnica. Su equipo necesitará los recursos de ingeniería para implementar y mantener el modelo, ya que no hay ninguna API gestionada disponible lista para usar. Esto lo convierte en la opción perfecta para organizaciones dirigidas por ingenieros o centradas en la privacidad.

Las 3 mejores funciones de LLaMA 3

- Control total de los datos con implementación autohospedada.

- Capacidad de ajuste fino para terminología específica del dominio.

- Sin cuotas de licencia para uso comercial.

Limitaciones de LLaMA 3

- Requiere una infraestructura técnica significativa para su implementación.

- Sin API gestionada: su equipo se encarga del mantenimiento.

- La complejidad de la configuración inicial puede retrasar el tiempo de valorización.

Precios de LLaMA 3

- Gratis, gratuito/a con licencia de código abierto.

- Los costes de infraestructura dependen de las opciones de alojamiento.

6. Mistral Large (el mejor para los requisitos de residencia de datos de la UE)

¿Qué pasa si desea la flexibilidad del código abierto, pero no tiene los recursos para gestionar la infraestructura por su cuenta? Mistral Large ofrece un término medio muy atractivo. Desarrollado por una empresa europea, ofrece un rendimiento competitivo en materia de resumir, con un fuerte enfoque en la eficiencia.

Mistral ofrece tanto una API gestionada para facilitar el acceso como modelos de peso abierto para los equipos que desean un mayor control. Este enfoque híbrido es su principal ventaja. La contrapartida es un ecosistema más reducido de integraciones de terceros en comparación con gigantes como OpenAI y Google. Es una excelente opción para los equipos que buscan un equilibrio entre comodidad y control, especialmente aquellos con requisitos de residencia de datos en la UE.

Las mejores funciones de Mistral Large

- Acceso híbrido a través de API gestionada o implementación autohospedada.

- Sólido rendimiento con cumplimiento de la normativa europea sobre residencia de datos.

- Precios competitivos en comparación con los principales modelos propietarios.

Limitaciones de Mistral Large

- Ecosistema de integración más pequeño que OpenAI o Google.

- Documentación y recursos comunitarios con una extensión menor.

Precios de Mistral Large

- Acceso a la API con precios competitivos por token.

- Modelos de peso abierto disponibles para autoalojamiento.

💡 Consejo profesional: si su meta principal es resumir transcripciones de reuniones de una hora de duración de una sola vez, dé prioridad a los modelos con la ventana de contexto más grande, como Gemini 1. 5 Pro. Si necesita enseñar al modelo la terminología específica de su empresa, lo mejor es optar por una opción de código abierto como LLaMA 3.

💡 Consejo profesional: si su meta principal es resumir transcripciones de reuniones de una hora de duración de una sola vez, dé prioridad a los modelos con la ventana de contexto más grande, como Gemini 1. 5 Pro. Si necesita enseñar al modelo la terminología específica de su empresa, lo mejor es optar por una opción de código abierto como LLaMA 3.

Comparación de modelos de resumen LLM

La comparación rápida le ayuda a identificar de un vistazo qué modelo se ajusta mejor a las prioridades de su equipo.

ClickUp Brain incorpora el resumen directamente en su flujo de trabajo como un entorno de trabajo de IA convergente, ideal para convertir los resúmenes en acciones inmediatas, con la ventaja clave de que funciona de manera óptima dentro del ecosistema ClickUp.

GPT-4o ofrece una amplia ventana de contexto como modelo patentado, ideal para resúmenes pulidos y matizados, con la contrapartida clave de que su precio se basa en el uso.

Claude 3. 5 Sonnet ofrece una ventana de contexto ampliada como modelo propio, ideal para documentos sensibles al cumplimiento normativo, cuya principal limitación es la disponibilidad regional.

Gemini 1. 5 Pro ofrece una ventana de contexto masiva como modelo propio, perfecto para los usuarios de Google Workspace, aunque el bloqueo del ecosistema puede ser motivo de preocupación.

LLaMA 3 incluye una gran ventana de contexto como modelo de código abierto, adecuado para canalizaciones personalizables autohospedadas, pero requiere una inversión en infraestructura.

Mistral Large cuenta con una gran ventana de contexto con un enfoque de acceso híbrido, excelente para las necesidades de residencia de datos de la UE, aunque tiene un ecosistema de integración más pequeño.

📖 Lea también: Los mejores resumidores de transcripciones con IA

Cómo evaluar la calidad de la tarea de resumir de los LLM

Para saber si los resúmenes de un modelo son realmente buenos, se necesita un marco de evaluación claro. Basarse en un resumen deficiente puede ser peor que no tener ningún resumen, ya que puede llevar a tomar decisiones erróneas basadas en información inexacta.

Criterios clave para la evaluación

La precisión determina si el resumen capta correctamente los puntos principales del texto original sin inventar datos ni cometer errores. Esto es imprescindible en el caso de los documentos críticos para la empresa.

La coherencia mide si el resumen es fácil de leer y tiene un flujo lógico, o si parece un batiburrillo de frases inconexas. Los buenos resúmenes mantienen la estructura narrativa.

La concisa evalúa si el resumen va directo al grano o está lleno de palabras superfluas e innecesarias. Los mejores resúmenes maximizan la densidad de la información.

El seguimiento de instrucciones comprueba si el modelo puede seguir correctamente sus solicitudes de tonos, formatos o áreas de interés específicos, como viñetas o resúmenes de estilo ejecutivo.

La coherencia evalúa si el modelo produce resúmenes de alta calidad en diferentes tipos de documentos o si solo funciona bien en algunos de ellos.

Un marco de pruebas sencillo

Elija tres documentos con los que su equipo trabaje habitualmente: un resumen de proyecto, una transcripción de reunión y un hilo de correo electrónico de un cliente. Procese cada documento con los modelos que esté considerando utilizando la misma indicación. A continuación, pida a un miembro del equipo que evalúe los resultados según los criterios anteriores. Aunque existen métricas automatizadas, nada supera a la revisión humana a la hora de detectar errores sutiles.

🔍 ¿Sabías que... equipos como QubicaAMF recuperaron más de 5 horas semanales utilizando ClickUp (lo que supone más de 250 horas anuales por persona) al eliminar procesos obsoletos de gestión del conocimiento? Imagina lo que tu equipo podría crear con una semana extra de productividad cada trimestre.

🔍 ¿Sabías que... equipos como QubicaAMF recuperaron más de 5 horas semanales utilizando ClickUp (lo que supone más de 250 horas anuales por persona) al eliminar procesos obsoletos de gestión del conocimiento? Imagina lo que tu equipo podría crear con una semana extra de productividad cada trimestre.

¿Cuáles son los límites del uso de LLM para el resumen de documentos?

Esta tecnología tiene límites reales que vale la pena comprender antes de confirmar un enfoque concreto.

Riesgos de alucinación

El mayor riesgo es la alucinación, es decir, que el modelo afirme con seguridad detalles incorrectos que suenan plausibles. Los equipos jurídicos, los analistas financieros y cualquier persona que trabaje con documentos sensibles en materia de cumplimiento normativo deben someter siempre a revisión humana los resúmenes de alto riesgo.

Límites de la ventana de contexto

Incluso los modelos más grandes tienen un límite, por lo que es posible que los documentos extremadamente largos deban dividirse en fragmentos. Esta división puede hacer que el modelo pierda conexiones entre secciones distantes o que pierda el arco narrativo general.

Pérdida de matices

Los argumentos sutiles o los puntos de vista minoritarios suelen quedar diluidos en los resúmenes. Si para su caso de uso es importante conservar las opiniones discrepantes o los casos extremos, deberá redactar las indicaciones con cuidado o aceptar cierta pérdida de información.

Desafíos de la especificidad del dominio

Es posible que un modelo de uso general no comprenda la jerga específica de su sector sin un ajuste previo. Los campos médicos, jurídicos y técnicos suelen requerir una formación adicional o indicaciones cuidadosas.

Consideraciones de seguridad

El envío de datos confidenciales de la empresa a una API de terceros siempre conlleva un cierto riesgo. Para documentos altamente confidenciales, puede ser necesario utilizar modelos autohospedados o acuerdos de corporación con condiciones específicas para el tratamiento de datos.

Estas no son razones para evitar la tecnología, pero son consideraciones importantes. Puede mitigarlas con prácticas inteligentes: haga que un humano revise siempre los resúmenes de alto riesgo, utilice modelos autohospedados para datos altamente confidenciales y utilice indicaciones claras para ayudar al modelo a preservar los matices importantes.

📌 ClickUp Insight: El 62 % de los trabajadores del conocimiento confían en herramientas de IA conversacional como ChatGPT y Claude. Su interfaz de chatbot familiar y sus versátiles capacidades podrían explicar su popularidad en diversos roles y sectores. Sin embargo, cambiar a otra pestaña para hacer una pregunta a la IA cada vez supone un coste adicional en términos de cambio de contexto.

📌 ClickUp Insight: El 62 % de los trabajadores del conocimiento confían en herramientas de IA conversacional como ChatGPT y Claude. Su interfaz de chatbot familiar y sus versátiles capacidades podrían explicar su popularidad en diversos roles y sectores. Sin embargo, cambiar a otra pestaña para hacer una pregunta a la IA cada vez supone un coste adicional en términos de cambio de contexto.

Poner ClickUp Brain a trabajar en su flujo de trabajo de resumen

Ya ha visto cómo ClickUp Brain se encuentra entre los mejores LLM para la síntesis. Ahora exploremos cómo crear flujos de trabajo que conviertan esos resúmenes en ganancias reales de productividad. La diferencia entre un resumen útil y un esfuerzo inútil es si se conecta con la acción, y ahí es donde destaca el entorno de trabajo Converged AI.

[Imagen de marcador de posición: entorno de trabajo de ClickUp que muestra la síntesis de Brain integrada con tareas y documentos].

Obtenga resúmenes directamente en su lugar de trabajo.

Elimine la frustrante transferencia manual incorporando el resumen directamente en sus proyectos. Con ClickUp Brain, solo tiene que escribir @brain en cualquier comentario de tarea o mensaje de ClickUp Chat y pedirle que resuma el contexto. Al instante, le proporcionará un resumen utilizando su conocimiento de su entorno de trabajo, dando prioridad a la tarea o canal específico en el que se encuentre.

Convierta automáticamente las grabaciones de las reuniones en elementos pendientes.

Ponerse al día después de una reunión perdida ya no requiere horas de lectura de notas. Manténgase totalmente involucrado en las conversaciones mientras ClickUp AI Notetaker captura las notas de la reunión por usted. Después de la reunión, le proporciona una transcripción y un resumen. Incluso puede pedirle que genere automáticamente elementos de acción y los convierta en tareas de ClickUp con personas asignadas y fechas límite.

Aproveche múltiples LLM sin tener que gestionar la selección de modelos.

Obtenga resultados de alta calidad sin tener que gestionar usted mismo la selección de modelos, ya que ClickUp Brain aprovecha múltiples LLM entre bastidores. Así es como funciona este flujo de trabajo en la práctica: se celebra una reunión, ClickUp AI Notetaker lo captura todo, ClickUp Brain proporciona un resumen de las decisiones clave y las acciones a realizar ya están en su plan de proyecto. Incluso puede utilizar @My Brain para resumir de forma privada un hilo o redactar una respuesta antes del uso compartido con el equipo.

✨ Resultados reales: El verdadero reto es convertir los resúmenes en acciones. ClickUp Brain destaca por conectar los resúmenes directamente con las tareas de su flujo de trabajo, eliminando la brecha entre la información y la ejecución que afecta a las herramientas de resumen independientes.

✨ Resultados reales: El verdadero reto es convertir los resúmenes en acciones. ClickUp Brain destaca por conectar los resúmenes directamente con las tareas de su flujo de trabajo, eliminando la brecha entre la información y la ejecución que afecta a las herramientas de resumen independientes.

Conclusión

El mejor LLM para resumir es aquel que se adapta a las necesidades específicas de su equipo, ya sea una ventana de contexto masiva para informes largos, flexibilidad de código abierto para la personalización o una integración perfecta con sus herramientas existentes. Antes de realizar la confirmación, pruebe siempre sus opciones principales con sus propios documentos reales para ver cómo funcionan.

Pero recuerde, un resumen solo tiene valor cuando está vinculado a la acción. La síntesis está pasando de ser una tarea independiente a una capacidad profundamente integrada en las plataformas en las que ya trabaja. El verdadero aumento de la productividad proviene de reducir la brecha entre obtener una idea y actuar en consecuencia.

Empieza gratis con ClickUp e incorpora el resumen mediante IA directamente en tu gestión de tareas, chat y documentos.

Preguntas frecuentes

¿Cuál es la diferencia entre la síntesis extractiva y abstractiva de los LLM? La síntesis extractiva funciona extrayendo frases clave directamente del texto original, mientras que la síntesis abstractiva genera frases completamente nuevas para transmitir el significado principal. Los LLM modernos utilizan principalmente el método abstractivo, lo que da como resultado resúmenes más naturales que captan mejor la esencia del material original.

¿Cómo se comparan los LLM de código abierto con los modelos propietarios como GPT-4 para resumir? Los modelos de código abierto ofrecen un control total sobre sus datos y la posibilidad de ajustarlos a sus necesidades específicas, pero requieren recursos técnicos para su mantenimiento. Los modelos propietarios ofrecen comodidad y facilidad de uso a través de una API, pero conllevan costes de uso y un menor control sobre los datos. La diferencia de calidad se ha reducido significativamente, y las opciones de código abierto como LLaMA 3 rivalizan con el rendimiento de los modelos propietarios en muchos casos de uso.

¿Pueden las herramientas de resumen de LLM manejar notas de reuniones y actualizaciones de proyectos? Sí, la mayoría de los LLM son muy eficaces a la hora de resumir textos conversacionales, como las notas de reuniones. El verdadero reto es convertir esos resúmenes en acciones, y ahí es donde herramientas como ClickUp Brain destacan, al conectar los resúmenes directamente con las tareas de su flujo de trabajo, en lugar de dejarlos como documentos de texto aislados.

¿Qué tamaño de ventana de contexto necesito para mis documentos? Para documentos comerciales estándar de menos de 10 000 palabras, la mayoría de los LLM modernos tienen ventanas de contexto suficientes. Para transcripciones de reuniones de más de una hora o informes de investigación exhaustivos, necesitará modelos con ventanas de contexto ampliadas, como Claude 3. 5 Sonnet o Gemini 1. 5 Pro. La ventana de 1 millón de tokens de Gemini 1. 5 Pro puede manejar prácticamente cualquier tarea de resumen de un solo documento.

¿Cómo puedo reducir el riesgo de alucinaciones en los resúmenes de LLM? Utilice indicaciones claras y específicas que pidan al modelo que resuma solo lo que se indica explícitamente en la fuente. Solicite citas o referencias a secciones específicas cuando la precisión sea fundamental. En el caso de documentos de alto riesgo, haga siempre que un revisor humano compare el resumen con el original. Considere modelos con una alineación de seguridad más sólida, como Claude, cuando trabaje con contenido sensible en materia de cumplimiento.