Hầu hết các nhóm nghiên cứu mô hình AI mã nguồn mở đều nhận ra rằng LLaMA của Meta cung cấp sự kết hợp hiếm có giữa sức mạnh và tính linh hoạt, nhưng quá trình thiết lập kỹ thuật có thể giống như lắp ráp đồ nội thất mà không có hướng dẫn.

Hướng dẫn này sẽ hướng dẫn bạn cách xây dựng một chatbot LLaMA hoạt động từ đầu, bao gồm tất cả các bước từ yêu cầu phần cứng và truy cập mô hình đến kỹ thuật tạo prompt và chiến lược triển khai.

Hãy bắt đầu ngay!

LLaMA là gì và tại sao nên sử dụng nó cho chatbot?

Việc xây dựng chatbot bằng các API độc quyền thường khiến bạn cảm thấy bị ràng buộc vào hệ thống của bên thứ ba, đối mặt với chi phí không thể dự đoán và các vấn đề về bảo mật dữ liệu. Sự ràng buộc này khiến bạn không thể tùy chỉnh mô hình theo nhu cầu riêng của nhóm, dẫn đến các phản hồi chung chung và tiềm ẩn rủi ro tuân thủ.

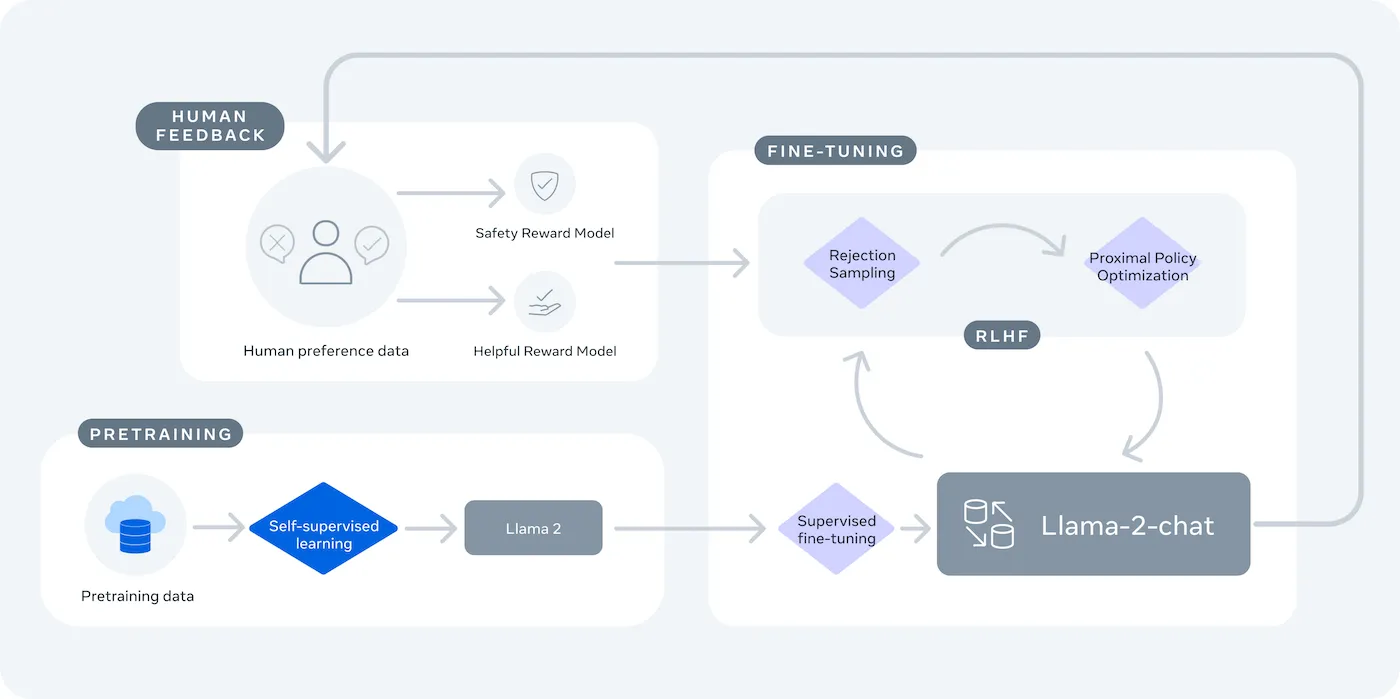

LLaMA (Large Language Model Meta AI) là gia đình các mô hình ngôn ngữ nguồn mở của Meta, cung cấp một giải pháp mạnh mẽ. Nó được thiết kế cho cả mục đích nghiên cứu và thương mại, mang lại cho bạn quyền kiểm soát mà các mô hình đã đóng không có.

Các mô hình LLaMA có nhiều kích thước khác nhau, được đo bằng số tham số (ví dụ: 7B, 13B, 70B). Hãy xem số tham số như một thước đo độ phức tạp và sức mạnh của mô hình – các mô hình lớn hơn có khả năng cao hơn nhưng yêu cầu nhiều tài nguyên tính toán hơn.

Dưới đây là lý do tại sao bạn có thể sử dụng chatbot LLaMA:

- Bảo mật dữ liệu: Khi chạy mô hình trên hạ tầng của riêng bạn, dữ liệu của cuộc hội thoại của bạn sẽ không bao giờ rời khỏi môi trường của bạn. Điều này đặc biệt quan trọng đối với các nhóm xử lý thông tin nhạy cảm.

- Tùy chỉnh: Bạn có thể tinh chỉnh mô hình LLaMA dựa trên tài liệu hoặc dữ liệu nội bộ của công ty. Điều này giúp mô hình hiểu rõ bối cảnh cụ thể của bạn và cung cấp các câu trả lời phù hợp hơn.

- Dự đoán chi phí: Sau khi thiết lập phần cứng ban đầu, bạn không cần lo lắng về phí API theo token. Chi phí của bạn sẽ trở nên cố định và có thể dự đoán được.

- Không giới hạn tốc độ: Sức chứa của chatbot của bạn chỉ bị giới hạn bởi phần cứng của chính bạn, không phải bởi giới hạn của nhà cung cấp. Bạn có thể mở rộng quy mô theo nhu cầu.

Điểm mấu chốt là sự tiện lợi so với khả năng kiểm soát. LLaMA yêu cầu thiết lập kỹ thuật phức tạp hơn so với API cắm và chạy. Đối với chatbot sản xuất, các nhóm thường sử dụng LLaMA 2 hoặc phiên bản mới hơn LLaMA 3, cung cấp khả năng suy luận tốt hơn và có thể xử lý lượng văn bản lớn hơn cùng lúc.

Những điều bạn cần chuẩn bị trước khi xây dựng chatbot LLaMA

Bắt đầu một dự án phát triển mà không có công cụ phù hợp là công thức dẫn đến thất vọng. Bạn có thể tiến được một nửa chặng đường, chỉ để nhận ra mình thiếu một thành phần phần cứng hoặc quyền truy cập phần mềm quan trọng, làm gián đoạn tiến độ và lãng phí hàng giờ đồng hồ của bạn.

Để tránh điều này, hãy chuẩn bị đầy đủ mọi thứ cần thiết từ đầu. Dưới đây là danh sách kiểm tra để đảm bảo khởi đầu suôn sẻ. 🛠️

Yêu cầu phần cứng

| Kích thước mô hình | VRAM tối thiểu | Tùy chọn thay thế |

|---|---|---|

| 7 tỷ tham số | 8GB | Máy chủ GPU trên đám mây |

| 13 tỷ tham số | 16GB | Máy chủ GPU trên đám mây |

| 70 tỷ tham số | Hỗ trợ nhiều GPU | Lượng tử hóa hoặc đám mây |

Nếu máy tính cục bộ của bạn không có GPU đủ mạnh, bạn có thể sử dụng các dịch vụ đám mây như AWS hoặc GCP. Các nền tảng suy luận như Baseten và Replicate cũng cung cấp quyền truy cập GPU theo mô hình trả tiền theo sử dụng.

Yêu cầu phần mềm

- Python 3.8+: Đây là ngôn ngữ lập trình tiêu chuẩn cho các dự án học máy.

- Quản lý gói: Bạn cần sử dụng pip hoặc Conda để cài đặt các thư viện cần thiết cho dự án của mình.

- Môi trường ảo: Đây là phương pháp tốt nhất giúp cách ly các phụ thuộc của dự án khỏi các dự án Python khác trên máy tính của bạn.

Yêu cầu truy cập

- Tài khoản Hugging Face: Bạn cần có tài khoản để tải xuống trọng số mô hình LLaMA.

- Phê duyệt của Meta: Bạn phải chấp nhận thỏa thuận cấp phép của Meta để truy cập các mô hình LLaMA, thường được phê duyệt trong vòng vài giờ.

- Khóa API: Những khóa này chỉ cần thiết nếu bạn quyết định sử dụng điểm cuối suy luận được lưu trữ thay vì chạy mô hình trên máy cục bộ.

Trong hướng dẫn này, chúng ta sẽ sử dụng khung LangChain. Nó đơn giản hóa nhiều phần phức tạp trong việc xây dựng chatbot, như quản lý prompt và lịch sử cuộc hội thoại.

Cách xây dựng chatbot với LLaMA từng bước một

Kết nối các thành phần kỹ thuật của một chatbot—mô hình, lời nhắc, bộ nhớ—có thể khiến bạn cảm thấy choáng ngợp. Dễ dàng bị lạc trong mã, dẫn đến lỗi và chatbot không hoạt động như mong đợi. Hướng dẫn từng bước này chia quá trình thành các phần đơn giản, dễ quản lý.

Phương pháp này hoạt động cho dù bạn chạy mô hình trên máy tính của mình hay sử dụng dịch vụ lưu trữ.

Bước 1: Cài đặt các gói phần mềm cần thiết

Đầu tiên, bạn cần cài đặt các thư viện Python cơ bản. Mở terminal và chạy lệnh sau:

pip install langchain transformers accelerate torch

Nếu bạn đang sử dụng dịch vụ lưu trữ như Baseten cho việc suy luận, bạn cũng cần cài đặt bộ công cụ phát triển phần mềm (SDK) cụ thể của nó:

pip install baseten

Dưới đây là những việc cần làm với mỗi gói này:

- Langchain: Một khung làm việc giúp xây dựng ứng dụng sử dụng mô hình ngôn ngữ lớn, bao gồm quản lý chuỗi cuộc hội thoại và bộ nhớ.

- Transformers: Thư viện Hugging Face để tải và chạy mô hình LLaMA.

- Accelerate: Thư viện giúp tối ưu hóa cách mô hình được tải lên CPU và GPU của bạn.

- Torch: Thư viện PyTorch, cung cấp sức mạnh xử lý phía sau cho các tính toán của mô hình.

Nếu bạn đang chạy mô hình trên máy tính cục bộ có GPU NVIDIA, hãy đảm bảo đã cài đặt và cấu hình CUDA đúng cách. Điều này cho phép mô hình sử dụng GPU để đạt hiệu suất nhanh hơn nhiều.

Bước 2: Truy cập các mô hình LLaMA

Trước khi có thể tải xuống mô hình, bạn cần nhận quyền truy cập chính thức từ Meta thông qua Hugging Face.

- Tạo tài khoản trên huggingface.co

- Truy cập trang mô hình, ví dụ: meta-llama/Llama-2-7b-trò chuyện-hf

- Nhấp vào “Truy cập kho lưu trữ” và đồng ý với các điều khoản cấp phép của Meta.

- Trong cài đặt tài khoản Hugging Face của bạn, tạo một token truy cập mới.

- Trong terminal của bạn, chạy lệnh huggingface-cli login và dán token của bạn để xác thực máy tính.

Quá trình phê duyệt thường diễn ra nhanh chóng. Hãy đảm bảo bạn chọn biến thể mô hình có từ “trò chuyện” trong tên, vì những mô hình này đã được đào tạo chuyên biệt cho các công việc trò chuyện.

Bước 3: Tải mô hình LLaMA

Bây giờ bạn có thể tải mô hình vào mã của mình. Bạn có hai tùy chọn chính tùy thuộc vào phần cứng của bạn.

Nếu bạn có GPU đủ mạnh, bạn có thể tải mô hình cục bộ:

Nếu phần cứng của bạn có giới hạn, bạn có thể sử dụng dịch vụ suy luận được lưu trữ:

Lệnh `device_map="auto"` thông báo cho thư viện Transformers tự động phân phối mô hình trên các GPU có sẵn.

Nếu bạn vẫn gặp vấn đề về bộ nhớ, bạn có thể sử dụng kỹ thuật gọi là lượng tử hóa để giảm kích thước mô hình, mặc dù điều này có thể làm giảm nhẹ hiệu suất của nó.

Bước 4: Tạo mẫu prompt

Các mô hình trò chuyện LLaMA được đào tạo để mong đợi một định dạng cụ thể cho các prompt. Mẫu prompt đảm bảo đầu vào của bạn được cấu trúc chính xác.

Hãy phân tích định dạng này:

- <

>: Phần này chứa lời nhắc hệ thống, cung cấp cho mô hình các hướng dẫn cốt lõi và định nghĩa tính cách của nó. - [INST]: Đây là dấu hiệu bắt đầu câu hỏi hoặc hướng dẫn của người dùng.

- [/INST]: Điều này thông báo cho mô hình rằng đã đến lúc tạo ra phản hồi.

Lưu ý rằng các phiên bản khác nhau của LLaMA có thể sử dụng các mẫu khác nhau. Luôn kiểm tra tài liệu của mô hình trên Hugging Face để đảm bảo định dạng chính xác.

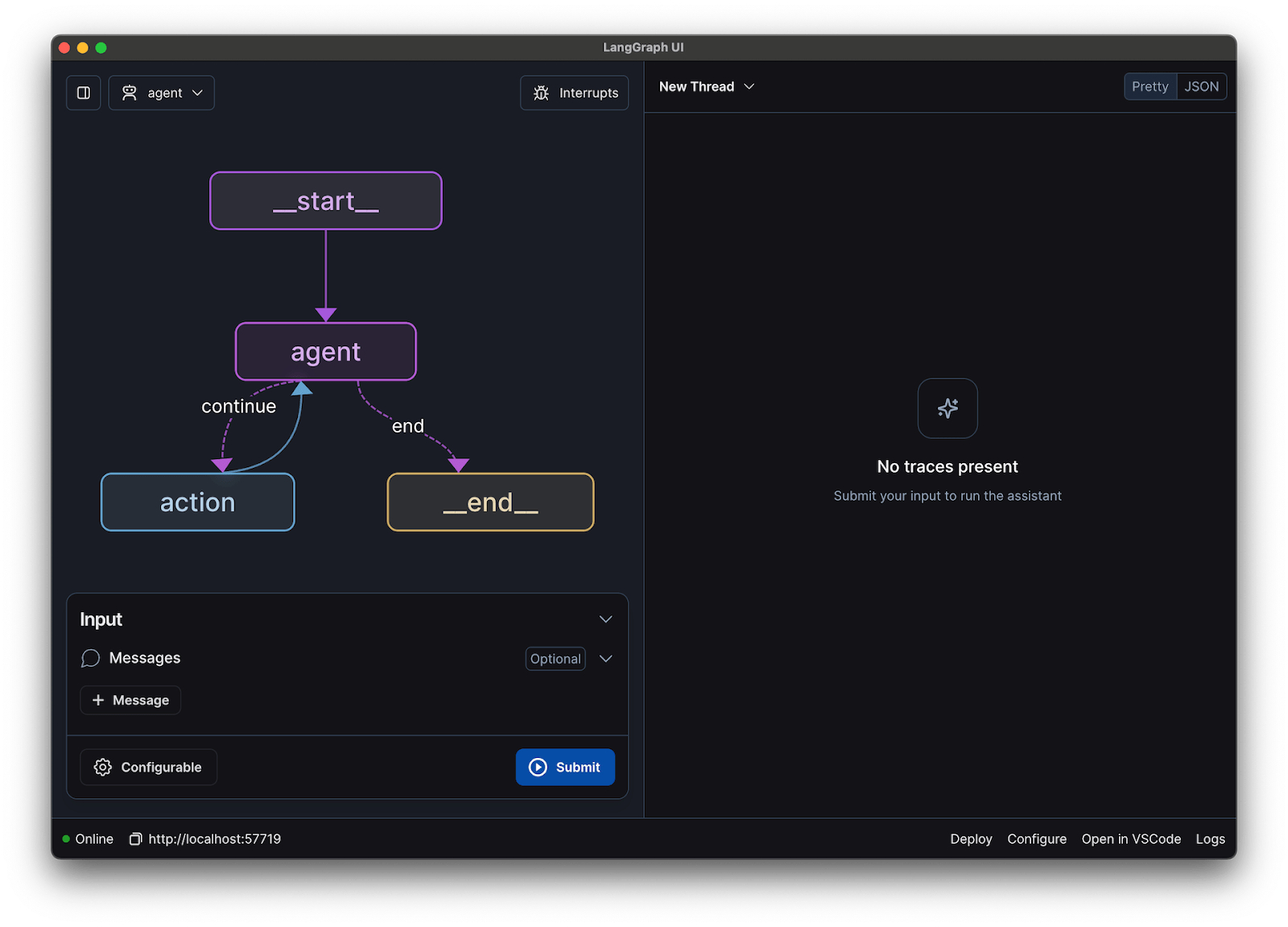

Bước 5: Cài đặt chuỗi chatbot

Tiếp theo, bạn sẽ kết nối mô hình và mẫu prompt của mình vào một chuỗi hội thoại sử dụng LangChain. Chuỗi này cũng sẽ bao gồm bộ nhớ để theo dõi cuộc hội thoại.

LangChain cung cấp nhiều loại bộ nhớ:

- ConversationBufferMemory: Đây là tùy chọn đơn giản nhất. Nó lưu trữ toàn bộ lịch sử cuộc hội thoại.

- ConversationSummaryMemory: Để tiết kiệm không gian, tùy chọn này sẽ định kỳ tóm tắt các phần cũ của cuộc hội thoại.

- ConversationBufferWindowMemory: Tính năng này chỉ lưu trữ một số cuộc trò chuyện gần đây nhất trong bộ nhớ, giúp ngăn chặn bối cảnh trở nên quá dài.

Để thử nghiệm, ConversationBufferMemory là một điểm khởi đầu tuyệt vời.

Bước 6: Chạy vòng lặp chatbot

Cuối cùng, bạn có thể tạo một vòng lặp đơn giản để tương tác với chatbot của mình từ terminal.

Trong ứng dụng thực tế, bạn sẽ thay thế vòng lặp này bằng một điểm cuối API sử dụng khung làm việc như FastAPI hoặc Flask. Bạn cũng có thể truyền phản hồi của mô hình trở lại người dùng, điều này giúp chatbot hoạt động nhanh hơn đáng kể.

Bạn cũng có thể điều chỉnh các tham số như nhiệt độ để kiểm soát độ ngẫu nhiên của các phản hồi. Một nhiệt độ thấp (ví dụ: 0.2) sẽ làm cho kết quả đầu ra trở nên xác định và thực tế hơn, trong khi một nhiệt độ cao hơn (ví dụ: 0.8) khuyến khích sự sáng tạo nhiều hơn.

Cách kiểm tra chatbot LLaMA của bạn

Bạn đã xây dựng một chatbot có thể trả lời câu hỏi, nhưng liệu nó đã sẵn sàng cho người dùng thực tế? Việc triển khai một chatbot chưa được kiểm thử có thể dẫn đến những thất bại đáng xấu hổ, như cung cấp thông tin sai lệch hoặc tạo ra nội dung không phù hợp, điều này có thể gây tổn hại đến uy tín của công ty bạn.

Một kế hoạch kiểm thử hệ thống là giải pháp cho sự không chắc chắn này. Nó đảm bảo chatbot của bạn mạnh mẽ, đáng tin cậy và an toàn.

Kiểm thử chức năng:

- Trường hợp đặc biệt: Kiểm tra cách bot xử lý các đầu vào trống, tin nhắn rất dài và ký tự đặc biệt.

- Xác minh bộ nhớ: Đảm bảo chatbot ghi nhớ ngữ cảnh qua nhiều lượt trao đổi trong cuộc hội thoại.

- Tuân thủ hướng dẫn: Kiểm tra xem bot có tuân thủ các quy tắc bạn đã cài đặt trong lời nhắc hệ thống hay không.

Đánh giá chất lượng:

- Mức độ liên quan: Phản hồi có thực sự trả lời câu hỏi của người dùng không?

- Độ chính xác: Thông tin mà nó cung cấp có chính xác không?

- Sự nhất quán: Cuộc hội thoại có diễn ra một cách logic không?

- An toàn: Chatbot có từ chối trả lời các yêu cầu không phù hợp hoặc gây hại không?

Kiểm thử hiệu năng:

- Độ trễ: Đo lường thời gian mà bot mất để bắt đầu phản hồi và hoàn thành phản hồi của mình.

- Sử dụng tài nguyên: Theo dõi lượng bộ nhớ GPU mà mô hình sử dụng trong quá trình suy luận.

- Đồng thời: Kiểm tra hiệu suất của hệ thống khi nhiều người dùng tương tác cùng lúc.

Ngoài ra, hãy lưu ý các vấn đề phổ biến của mô hình ngôn ngữ lớn (LLM) như ảo giác (cung cấp thông tin sai lệch một cách tự tin), mất ngữ cảnh (mất dấu chủ đề trong cuộc hội thoại dài) và lặp lại. Ghi lại tất cả cuộc hội thoại thử nghiệm là cách tuyệt vời để phát hiện các mẫu và khắc phục sự cố trước khi chúng ảnh hưởng đến người dùng của bạn.

Các trường hợp sử dụng chatbot LLaMA cho nhóm

Khi bạn vượt qua các bước tinh chỉnh và triển khai, LLaMA trở nên hữu ích nhất khi được áp dụng vào các vấn đề hàng ngày của nhóm – chứ không phải các demo AI trừu tượng. Các nhóm thường không cần “một chatbot”; họ cần truy cập nhanh hơn vào kiến thức, ít chuyển giao thủ công hơn và giảm bớt công việc lặp đi lặp lại.

Trợ lý kiến thức nội bộ

Bằng cách tinh chỉnh LLaMA trên tài liệu nội bộ, wiki và FAQ—hoặc kết hợp với cơ sở kiến thức dựa trên RAG—các nhóm có thể đặt câu hỏi bằng ngôn ngữ tự nhiên và nhận được câu trả lời chính xác, phù hợp với ngữ cảnh. Điều này loại bỏ sự phiền phức khi tìm kiếm qua các công cụ phân tán đồng thời giữ dữ liệu nhạy cảm hoàn toàn bên trong, thay vì gửi nó đến các API của bên thứ ba.

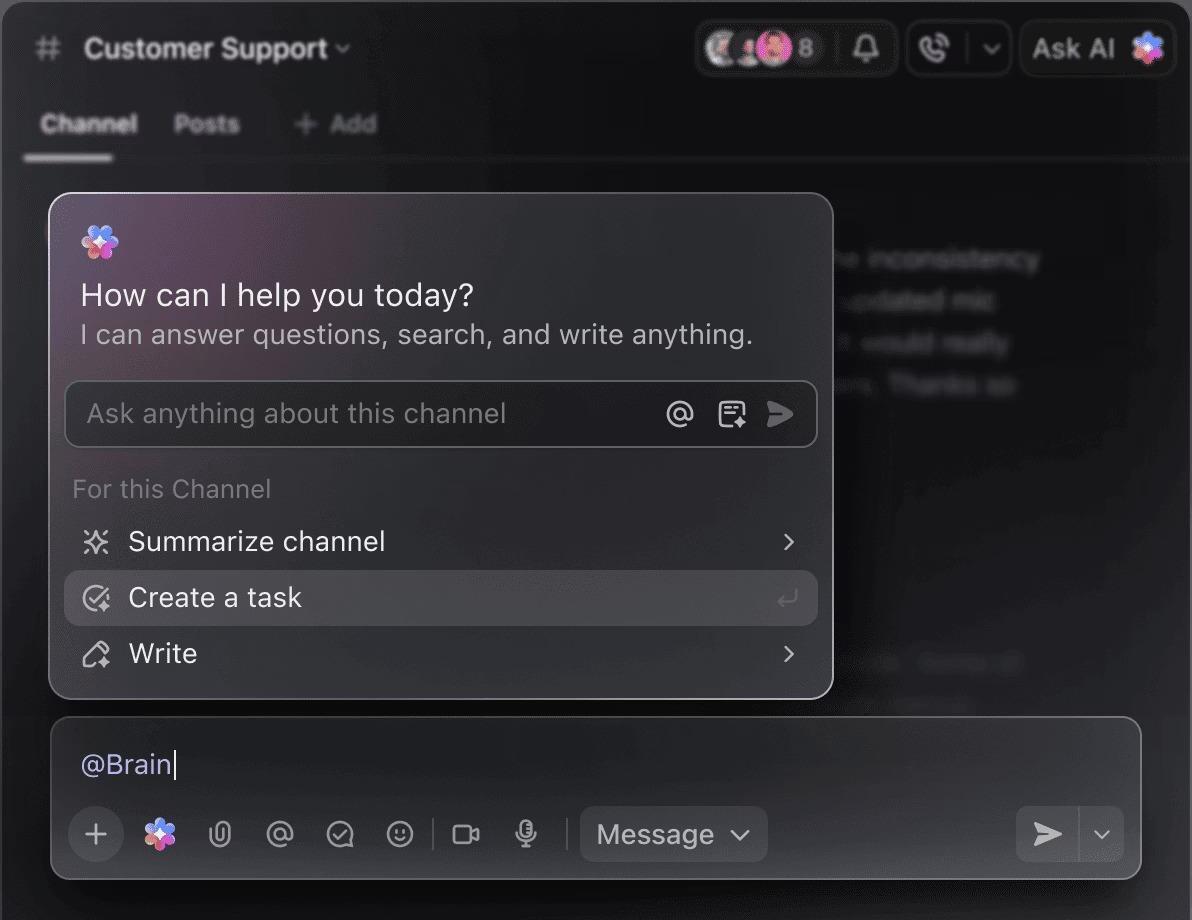

🌟 Tìm kiếm doanh nghiệp trong ClickUp và trợ lý Ambient Answers được tích hợp sẵn cung cấp các câu trả lời chi tiết, có ngữ cảnh cho các câu hỏi của bạn bằng cách sử dụng kiến thức trong Không gian Làm việc ClickUp của bạn.

Trợ lý kiểm tra mã nguồn

Khi được đào tạo trên cơ sở mã nguồn và hướng dẫn phong cách của riêng bạn, LLaMA có thể hoạt động như một trợ lý kiểm tra mã nguồn có ngữ cảnh. Thay vì các nguyên tắc chung chung, các nhà phát triển sẽ nhận được các đề xuất phù hợp với quy ước của nhóm, quyết định kiến trúc và các mẫu lịch sử.

🌟 Trợ lý kiểm tra mã nguồn dựa trên LLaMA có thể phát hiện vấn đề, đề xuất cải tiến hoặc giải thích mã nguồn không quen thuộc. ClickUp’s Codegen đi xa hơn bằng cách hoạt động trực tiếp trong quy trình phát triển — tạo Yêu cầu Hợp nhất, áp dụng các thay đổi mã nguồn hoặc cập nhật tệp trực tiếp dựa trên những thông tin đó. Kết quả là giảm thiểu việc sao chép-dán và ít sự gián đoạn hơn giữa giai đoạn “nghĩ” và “làm”.

Phân loại hỗ trợ khách hàng

LLaMA có thể được đào tạo để phân loại ý định, giúp hiểu các truy vấn của khách hàng và định hướng chúng đến nhóm hoặc quy trình phù hợp. Các truy vấn phổ biến có thể được xử lý tự động, trong khi các trường hợp đặc biệt sẽ được chuyển tiếp đến nhân viên hỗ trợ con người kèm theo bối cảnh, giúp giảm thời gian phản hồi mà không làm giảm chất lượng.

Bạn cũng có thể tạo một Triage Super Agent sử dụng ngôn ngữ tự nhiên trong Không gian Làm việc ClickUp của mình. Tìm hiểu thêm

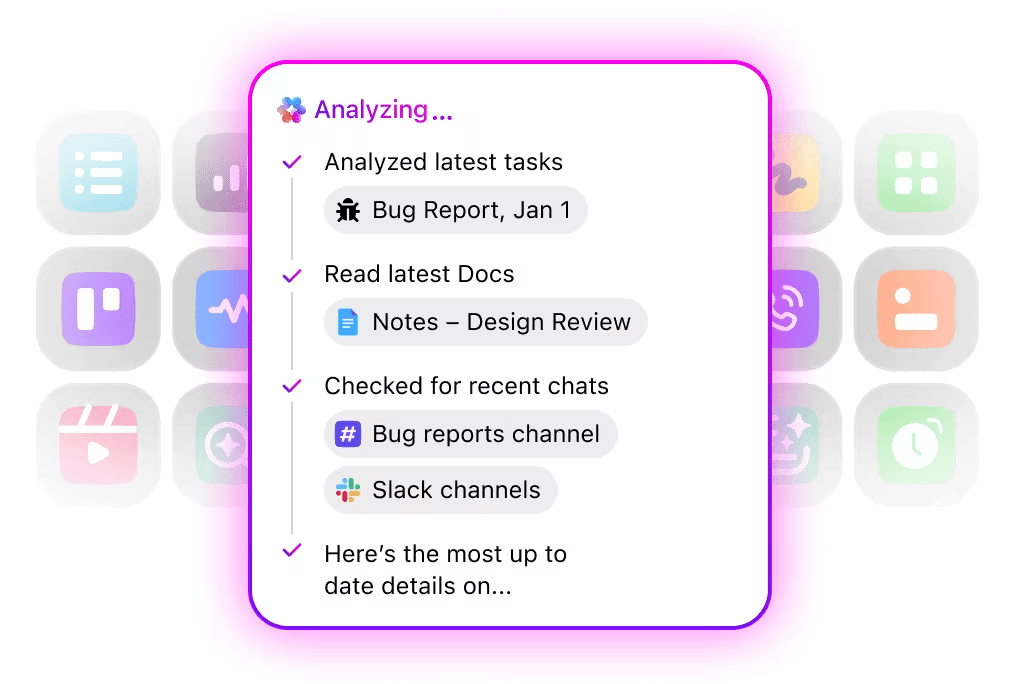

Tóm tắt cuộc họp và theo dõi tiến độ

Sử dụng bản ghi cuộc họp làm đầu vào, LLaMA có thể trích xuất các quyết định, mục cần thực hiện và các điểm thảo luận quan trọng. Giá trị thực sự được thể hiện khi các kết quả này được tích hợp trực tiếp vào các công cụ quản lý công việc, biến các cuộc hội thoại thành công việc đang được theo dõi.

🌟 Trợ lý ghi chú cuộc họp AI của ClickUp không chỉ ghi chú cuộc họp; nó còn soạn thảo tóm tắt, tạo danh sách công việc và liên kết ghi chú cuộc họp với tài liệu và công việc của bạn.

Soạn thảo và chỉnh sửa tài liệu

Các nhóm có thể sử dụng LLaMA để tạo bản nháp đầu tiên của báo cáo, đề xuất hoặc tài liệu dựa trên các mẫu có sẵn và ví dụ trước đó. Điều này giúp chuyển đổi nỗ lực từ việc tạo/lập nội dung từ đầu sang việc xem xét và hoàn thiện, giúp đẩy nhanh quá trình hoàn thành mà không làm giảm chất lượng.

🌟 ClickUp Brain có thể nhanh chóng tạo bản nháp cho tài liệu, giữ tất cả kiến thức làm việc của bạn trong bối cảnh. Hãy thử ngay hôm nay.

Chatbot được hỗ trợ bởi LLaMA hoạt động hiệu quả nhất khi được tích hợp vào các quy trình làm việc hiện có—hướng dẫn sử dụng, quản lý dự án và giao tiếp nhóm—thay vì hoạt động như các công cụ độc lập.

Đây chính là nơi việc tích hợp AI trực tiếp vào không gian làm việc của bạn tạo ra sự khác biệt. Thay vì xây dựng một công cụ riêng biệt, bạn có thể mang AI trò chuyện đến nơi nhóm của bạn đã hoạt động.

Ví dụ, bạn có thể tạo một chatbot LLaMA tùy chỉnh để hoạt động như một trợ lý kiến thức. Tuy nhiên, nếu chatbot này nằm ngoài công cụ quản lý dự án của bạn, nhóm của bạn phải chuyển đổi ngữ cảnh để đặt câu hỏi cho nó. Điều này gây ra sự bất tiện và làm chậm tiến độ của mọi người.

Loại bỏ việc chuyển đổi ngữ cảnh bằng cách sử dụng AI đã là một phần của quy trình làm việc của bạn.

Hỏi đáp về các dự án, công việc và tài liệu của bạn mà không cần rời khỏi ClickUp bằng ClickUp Brain. Chỉ cần nhập @brain vào bất kỳ bình luận công việc hoặc ClickUp Chat để nhận câu trả lời tức thì, hiểu rõ ngữ cảnh. Nó giống như có một thành viên trong nhóm có kiến thức hoàn hảo về toàn bộ không gian làm việc của bạn. 🤩

Điều này biến chatbot từ một tính năng mới lạ thành một phần cốt lõi của động cơ năng suất của nhóm bạn.

Giới hạn khi sử dụng LLaMA để xây dựng chatbot

Việc xây dựng chatbot LLaMA có thể mang lại nhiều lợi ích, nhưng các nhóm thường gặp phải những phức tạp ẩn giấu. Mô hình mã nguồn mở "miễn phí" có thể trở nên đắt đỏ và khó quản lý hơn dự kiến, dẫn đến trải nghiệm người dùng kém và chu kỳ bảo trì liên tục, tiêu tốn nhiều tài nguyên.

Điều quan trọng là phải hiểu rõ các giới hạn trước khi quyết định commit.

- Độ phức tạp kỹ thuật: Việc cài đặt và duy trì mô hình LLaMA yêu cầu kiến thức về hạ tầng học máy.

- Yêu cầu phần cứng: Việc chạy các mô hình lớn và mạnh mẽ hơn đòi hỏi phần cứng GPU đắt tiền, và chi phí đám mây có thể tăng nhanh chóng.

- Hạn chế của cửa sổ ngữ cảnh: Các mô hình LLaMA có bộ nhớ giới hạn ( 4K token cho LLaMA 2 ). Xử lý các tài liệu hoặc cuộc hội thoại dài đòi hỏi các chiến lược chia nhỏ phức tạp.

- Không có các biện pháp bảo vệ an toàn tích hợp sẵn: Bạn chịu trách nhiệm triển khai các biện pháp lọc nội dung và an toàn của riêng mình.

- Bảo trì liên tục: Khi các mô hình mới được phát hành, bạn sẽ cần cập nhật hệ thống của mình, và các mô hình được tinh chỉnh có thể yêu cầu đào tạo lại.

Các mô hình tự lưu trữ thường có độ trễ cao hơn so với các API thương mại được tối ưu hóa cao. Đây đều là những gánh nặng vận hành mà các giải pháp quản lý sẽ xử lý giúp bạn.

📮ClickUp Insight: 88% số người tham gia khảo sát của chúng tôi sử dụng AI cho các công việc cá nhân, nhưng hơn 50% lại e ngại sử dụng nó trong công việc. Ba rào cản chính? Thiếu tích hợp mượt mà, khoảng trống kiến thức hoặc lo ngại về bảo mật.

Nhưng nếu AI đã được tích hợp sẵn vào không gian làm việc của bạn và đã có tính năng bảo mật tốt thì sao? ClickUp Brain, trợ lý AI tích hợp sẵn của ClickUp, biến điều này thành hiện thực. Nó hiểu các lệnh bằng ngôn ngữ thông thường, giải quyết cả ba vấn đề chính trong việc áp dụng AI đồng thời kết nối các cuộc trò chuyện, công việc, tài liệu và kiến thức trong toàn bộ không gian làm việc. Tìm câu trả lời và thông tin chi tiết chỉ với một cú nhấp chuột!

Các lựa chọn thay thế cho LLaMA trong việc xây dựng chatbot

LLaMA chỉ là một trong số rất nhiều mô hình AI có sẵn, và việc lựa chọn mô hình phù hợp với nhu cầu của bạn có thể gây bối rối.

Dưới đây là cách phân tích các lựa chọn thay thế.

Các mô hình nguồn mở khác:

- Mistral: Nổi tiếng với hiệu suất mạnh mẽ ngay cả với các mô hình có kích thước nhỏ, giúp tối ưu hóa hiệu quả.

- Falcon: Đi kèm với giấy phép có quyền truy cập rất linh hoạt, rất phù hợp cho các ứng dụng thương mại.

- MPT: Được tối ưu hóa để xử lý các tài liệu và cuộc hội thoại dài.

API thương mại:

- OpenAI (GPT-4, GPT-3.5): Được coi là các mô hình ngôn ngữ lớn mạnh mẽ nhất hiện nay và rất dễ tích hợp.

- Anthropic (Claude): Nổi tiếng với các tính năng an toàn mạnh mẽ và cửa sổ ngữ cảnh rất lớn.

- Google (Gemini): Cung cấp khả năng đa phương thức mạnh mẽ, cho phép nó hiểu văn bản, hình ảnh và âm thanh.

Bạn có thể tự xây dựng với mô hình nguồn mở, trả phí cho API thương mại hoặc sử dụng không gian làm việc AI tích hợp sẵn cung cấp giải pháp đã được tích hợp sẵn với các loại trợ lý AI khác nhau.

📚 Đọc thêm: Cách sử dụng chatbot cho kinh doanh của bạn

Xây dựng trợ lý AI nhận thức ngữ cảnh với ClickUp

Xây dựng chatbot với LLaMA mang lại cho bạn quyền kiểm soát tuyệt vời đối với dữ liệu, chi phí và tùy chỉnh. Tuy nhiên, quyền kiểm soát đó đi kèm với trách nhiệm về hạ tầng, bảo trì và an toàn—tất cả những điều mà các API được quản lý sẽ xử lý giúp bạn. Mục tiêu không chỉ là xây dựng một chatbot—mà còn là tăng năng suất cho nhóm của bạn, và một dự án kỹ thuật phức tạp đôi khi có thể làm phân tâm khỏi mục tiêu đó.

Lựa chọn phù hợp phụ thuộc vào nguồn lực và ưu tiên của nhóm của bạn. Nếu bạn có chuyên môn về machine learning và yêu cầu bảo mật nghiêm ngặt, LLaMA là một lựa chọn tuyệt vời. Nếu bạn ưu tiên tốc độ và sự đơn giản, một công cụ tích hợp có thể là lựa chọn phù hợp hơn.

Với ClickUp, bạn có một không gian Làm việc AI tích hợp, nơi tất cả công việc, tài liệu và cuộc hội thoại của bạn được tập trung tại một nơi, được hỗ trợ bởi AI tích hợp. Nó giúp giảm thiểu sự phân tán thông tin và hỗ trợ các nhóm làm việc nhanh hơn và hiệu quả hơn, với thông tin cần thiết luôn sẵn sàng thông qua các Super Agents tùy chỉnh và AI bối cảnh.

Đừng lãng phí thời gian vào hạ tầng và tận hưởng lợi ích của trợ lý AI nhận biết ngữ cảnh ngay hôm nay mà không cần xây dựng từ đầu. Bắt đầu miễn phí với ClickUp.

Câu hỏi thường gặp (FAQ)

Chi phí hoàn toàn phụ thuộc vào phương thức triển khai của bạn, và dự báo dự án có thể giúp bạn ước tính chi phí. Nếu bạn sử dụng phần cứng của riêng mình, bạn sẽ phải trả chi phí ban đầu cho GPU nhưng không có phí theo từng truy vấn. Các nhà cung cấp đám mây tính phí theo giờ dựa trên GPU và kích thước mô hình.

Có, giấy phép cho LLaMA 2 và LLaMA 3 cho phép sử dụng thương mại. Tuy nhiên, bạn phải đồng ý với điều khoản sử dụng của Meta và cung cấp thông tin ghi công cần thiết trong sản phẩm của mình.

LLaMA 3 là mô hình mới hơn và mạnh mẽ hơn, cung cấp khả năng suy luận tốt hơn và cửa sổ ngữ cảnh lớn hơn (8K token so với 4K của LLaMA 2). Điều này có nghĩa là nó có thể xử lý các cuộc hội thoại và tài liệu dài hơn, nhưng cũng yêu cầu nhiều tài nguyên tính toán hơn để vận hành.

Mặc dù Python là ngôn ngữ phổ biến nhất cho học máy nhờ vào các thư viện phong phú, nó không phải là yêu cầu bắt buộc. Một số nền tảng đang bắt đầu cung cấp các giải pháp không cần mã hoặc ít mã, cho phép bạn triển khai chatbot LLaMA thông qua giao diện đồ họa. /