Os modelos de linguagem ampla (LLMs) abriram novas e empolgantes possibilidades para aplicativos de software. Eles permitem sistemas mais inteligentes e dinâmicos do que nunca.

Os especialistas preveem que, até 2025, os aplicativos alimentados por esses modelos poderão automatizar quase metade de todo o trabalho digital .

No entanto, à medida que desbloqueamos esses recursos, surge um desafio: como podemos medir de forma confiável a qualidade de seus resultados em grande escala? Um pequeno ajuste nas configurações e, de repente, você está vendo um resultado visivelmente diferente. Essa variabilidade pode dificultar a avaliação de seu desempenho, o que é crucial ao preparar um modelo para uso no mundo real.

Este artigo compartilhará percepções sobre as melhores práticas de avaliação do sistema LLM, desde os testes de pré-implantação até a produção. Então, vamos começar!

O que é uma avaliação de LLM?

As métricas de avaliação do LLM são uma forma de verificar se os prompts, as configurações do modelo ou o fluxo de trabalho estão atingindo as metas que você definiu. Essas métricas lhe dão insights sobre a eficácia de seus Modelo de linguagem grande está funcionando e se está realmente pronto para uso no mundo real.

Atualmente, algumas das métricas mais comuns medem recuperação de contexto em tarefas de geração aumentada de recuperação (RAG), correspondências exatas para classificações, validação de JSON para saídas estruturadas e similaridade semântica para tarefas mais criativas.

Cada uma dessas métricas garante de forma exclusiva que o LLM atenda aos padrões de seu caso de uso específico.

Por que você precisa avaliar um LLM?

Os modelos de linguagem grande (LLMs) estão sendo usados em uma ampla gama de aplicativos. É essencial avaliar o desempenho dos modelos para garantir que eles atendam aos padrões esperados e sirvam efetivamente aos objetivos pretendidos.

Pense da seguinte forma: Os LLMs estão alimentando tudo, desde chatbots de suporte ao cliente até ferramentas criativas e, à medida que se tornam mais avançados, estão aparecendo em mais lugares.

Isso significa que precisamos de melhores maneiras de monitorá-los e avaliá-los - os métodos tradicionais simplesmente não conseguem acompanhar todas as tarefas que esses modelos estão realizando.

Boas métricas de avaliação são como um controle de qualidade para LLMs. Elas mostram se o modelo é confiável, preciso e eficiente o suficiente para o uso no mundo real. Sem essas verificações, os erros podem passar despercebidos, levando a experiências de usuário frustrantes ou até mesmo enganosas.

Quando se tem métricas de avaliação sólidas, é mais fácil identificar problemas, aprimorar o modelo e garantir que ele esteja pronto para atender às necessidades específicas dos usuários. Dessa forma, você sabe que o Plataforma de IA com a qual você está trabalhando está de acordo com o padrão e pode fornecer os resultados de que você precisa.

📖 Leia mais: LLM vs. IA generativa: um guia detalhado

Tipos de avaliações de LLM

As avaliações fornecem uma lente exclusiva para examinar os recursos do modelo. Cada tipo aborda vários aspectos de qualidade, ajudando a criar um modelo de implementação confiável, seguro e eficiente.

Veja a seguir os diferentes tipos de métodos de avaliação de LLM:

- Avaliação intrínseca concentra-se no desempenho interno do modelo em tarefas específicas de linguística ou compreensão, sem envolver aplicativos do mundo real. Normalmente, é realizada durante o estágio de desenvolvimento do modelo para entender os principais recursos

- A avaliação extrínseca avalia o desempenho do modelo em aplicativos do mundo real. Esse tipo de avaliação examina como o modelo atende a objetivos específicos em um contexto

- Avaliação de robustez testa a estabilidade e a confiabilidade do modelo em diversos cenários, incluindo entradas inesperadas e condições adversas. Ela identifica os possíveis pontos fracos, garantindo que o modelo se comporte de forma previsível

- O teste de eficiência e latência examina o uso de recursos, a velocidade e a latência do modelo. Ele garante que o modelo possa executar tarefas rapidamente e a um custo computacional razoável, o que é essencial para a escalabilidade

- A avaliação de ética e segurança garante que o modelo se alinhe aos padrões éticos e às diretrizes de segurança, o que é vital em aplicativos sensíveis

Avaliações de modelos LLM vs. avaliações de sistemas LLM

A avaliação de grandes modelos de linguagem (LLMs) envolve duas abordagens principais: avaliações de modelos e avaliações de sistemas. Cada uma delas se concentra em diferentes aspectos do desempenho do LLM, e saber a diferença é essencial para maximizar o potencial desses modelos

as avaliações de modelo analisam as habilidades gerais do LLM. Esse tipo de avaliação testa o modelo em sua capacidade de entender, gerar e trabalhar com a linguagem de forma precisa em vários contextos. É como ver se o modelo consegue lidar com diferentes tarefas, quase como um teste de inteligência geral.

**Por exemplo, as avaliações de modelos podem perguntar: "Quão versátil é esse modelo?

as avaliações do sistema do LLM medem o desempenho do LLM em uma configuração ou finalidade específica, como em um chatbot de atendimento ao cliente. Aqui, trata-se menos das habilidades amplas do modelo e mais de como ele executa tarefas específicas para melhorar a experiência do usuário.

As avaliações do sistema, no entanto, concentram-se em perguntas como: "Até que ponto o modelo lida bem com essa tarefa específica para os usuários? "

As avaliações de modelos ajudam os desenvolvedores a entender as capacidades e limitações gerais do LLM, orientando melhorias. As avaliações do sistema concentram-se em como o LLM atende às necessidades do usuário em contextos específicos, garantindo uma experiência de usuário mais tranquila.

Juntas, essas avaliações fornecem um quadro completo dos pontos fortes e das áreas de melhoria do LLM, tornando-o mais avançado e fácil de usar em aplicativos reais.

Agora, vamos explorar as métricas específicas da Avaliação do LLM.

Métricas para avaliação do LLM

Algumas métricas de avaliação confiáveis e modernas incluem:

1. Perplexidade

A perplexidade mede quão bem um modelo de linguagem prevê uma sequência de palavras. Essencialmente, ela indica a incerteza do modelo sobre a próxima palavra em uma frase. Uma pontuação de perplexidade mais baixa significa que o modelo está mais confiante em suas previsões, o que leva a um melhor desempenho.

exemplo: Imagine que um modelo gere texto a partir do prompt "The cat sat on the" Se ele prevê uma alta probabilidade para palavras como "tapete" e "chão", ele entende bem o contexto, resultando em uma baixa pontuação de perplexidade.

Por outro lado, se ele sugerir uma palavra não relacionada, como "nave espacial", a pontuação de perplexidade será maior, indicando que o modelo tem dificuldade para prever um texto sensato.

2. Pontuação BLEU

A pontuação BLEU (Bilingual Evaluation Understudy) é usada principalmente para avaliar a tradução automática e a geração de texto.

Ela mede quantos n-gramas (sequências contíguas de n itens de uma determinada amostra de texto) no resultado se sobrepõem aos de um ou mais textos de referência. A pontuação varia de 0 a 1, sendo que pontuações mais altas indicam melhor desempenho.

exemplo: Se o seu modelo gerar a frase "The quick brown fox jumps over the lazy dog" (A rápida raposa marrom pula sobre o cachorro preguiçoso) e o texto de referência for "A fast brown fox leaps over a lazy dog" (A rápida raposa marrom pula sobre o cachorro preguiçoso), o BLEU comparará os n-gramas compartilhados.

Uma pontuação alta indica que a frase gerada corresponde muito bem à referência, enquanto uma pontuação mais baixa pode sugerir que a saída gerada não está bem alinhada.

3. Pontuação F1

A métrica de avaliação LLM de pontuação F1 é principalmente para tarefas de classificação. Ela mede o equilíbrio entre a precisão (a exatidão das previsões positivas) e a recuperação (a capacidade de identificar todas as instâncias relevantes).

Ela varia de 0 a 1, sendo que uma pontuação de 1 indica precisão perfeita.

em uma tarefa de resposta a perguntas, se for perguntado ao modelo "Qual é a cor do céu?" e ele responder "O céu é azul" (verdadeiro positivo), mas também incluir "O céu é verde" (falso positivo), a pontuação F1 considerará a relevância da resposta correta e da incorreta.

Essa métrica ajuda a garantir uma avaliação equilibrada do desempenho do modelo.

4. METEOR

O METEOR (Metric for Evaluation of Translation with Explicit ORdering) vai além da correspondência exata de palavras. Ele considera sinônimos, stemming e paráfrases para avaliar a semelhança entre o texto gerado e o texto de referência. Essa métrica tem como objetivo se alinhar mais de perto com o julgamento humano.

📌 Exemplo: Se o seu modelo gerar "The feline rested on the rug" (O felino descansou no tapete) e a referência for "The cat lay on the carpet" (O gato deitou no tapete), o METEOR atribuiria uma pontuação mais alta do que o BLEU, pois reconhece que "feline" é sinônimo de "cat" (gato) e que "rug" (tapete) e "carpet" (tapete) têm significados semelhantes.

Isso torna o METEOR particularmente útil para captar as nuances da linguagem.

5. BERTScore

O BERTScore avalia a similaridade de texto com base em incorporações contextuais derivadas de modelos como o BERT (Bidirectional Encoder Representations from Transformers). Ele se concentra mais no significado do que nas correspondências exatas de palavras, permitindo uma melhor avaliação da similaridade semântica

📌 Exemplo: Ao comparar as frases "The car raced down the road" e "The vehicle sped along the street", o BERTScore analisa os significados subjacentes em vez de apenas a escolha de palavras.

Embora as palavras sejam diferentes, as ideias gerais são semelhantes, levando a um BERTScore alto que reflete a eficácia do conteúdo gerado.

6. Avaliação humana

A avaliação humana continua sendo um aspecto crucial da avaliação do LLM. Ela envolve juízes humanos que classificam a qualidade de resultados do modelo com base em vários critérios, como fluência e relevância. Técnicas como escalas Likert e testes A/B podem ser empregadas para obter feedback.

Exemplo: Depois de gerar respostas de um chatbot de atendimento ao cliente, os avaliadores humanos podem classificar cada resposta em uma escala de 1 a 5. Por exemplo, se o chatbot fornecer uma resposta clara e útil a uma consulta do cliente, ele poderá receber uma nota 5, enquanto uma resposta vaga ou confusa poderá receber uma nota 2.

7. Métricas específicas da tarefa

Diferentes tarefas de LLM exigem métricas de avaliação personalizadas.

**Para sistemas de diálogo, as métricas podem avaliar o envolvimento do usuário ou as taxas de conclusão de tarefas. Para a geração de código, o sucesso pode ser medido pela frequência com que o código gerado compila ou passa nos testes

exemplo: Em um chatbot de suporte ao cliente, os níveis de envolvimento podem ser medidos pelo tempo que os usuários permanecem em uma conversa ou por quantas perguntas de acompanhamento eles fazem.

Se os usuários solicitarem informações adicionais com frequência, isso indica que o modelo está conseguindo engajá-los e responder às suas perguntas de forma eficaz.

8. Robustez e imparcialidade

A avaliação da robustez de um modelo envolve testar como ele responde bem a entradas inesperadas ou incomuns. As métricas de imparcialidade ajudam a identificar vieses nos resultados do modelo, garantindo que ele funcione de forma equitativa em diferentes demografias e cenários.

Exemplo: Ao testar um modelo com uma pergunta extravagante como "O que você acha de unicórnios?", ele deve lidar com a pergunta de forma graciosa e fornecer uma resposta relevante. Se, em vez disso, ele der uma resposta sem sentido ou inadequada, isso indica falta de robustez.

O teste de imparcialidade garante que o modelo não produza resultados tendenciosos ou prejudiciais, promovendo um ambiente mais inclusivo Sistema de IA .

📖 Leia mais: A diferença entre aprendizado de máquina e inteligência artificial

9. Métricas de eficiência

À medida que os modelos de linguagem aumentam em complexidade, torna-se cada vez mais importante medir sua eficiência **em relação à velocidade, ao uso da memória e ao consumo de energia. As métricas de eficiência ajudam a avaliar o uso intensivo de recursos de um modelo ao gerar respostas

📌 Exemplo: Para um modelo de linguagem grande, a medição da eficiência pode envolver o rastreamento da rapidez com que ele gera respostas às consultas do usuário e da quantidade de memória usada durante esse processo.

Se ele demorar muito para responder ou consumir recursos excessivos, isso pode ser uma preocupação para aplicativos que exigem desempenho em tempo real, como chatbots ou serviços de tradução.

Agora, você sabe como avaliar um modelo de LLM. Mas quais ferramentas você pode usar para medir isso? Vamos explorar.

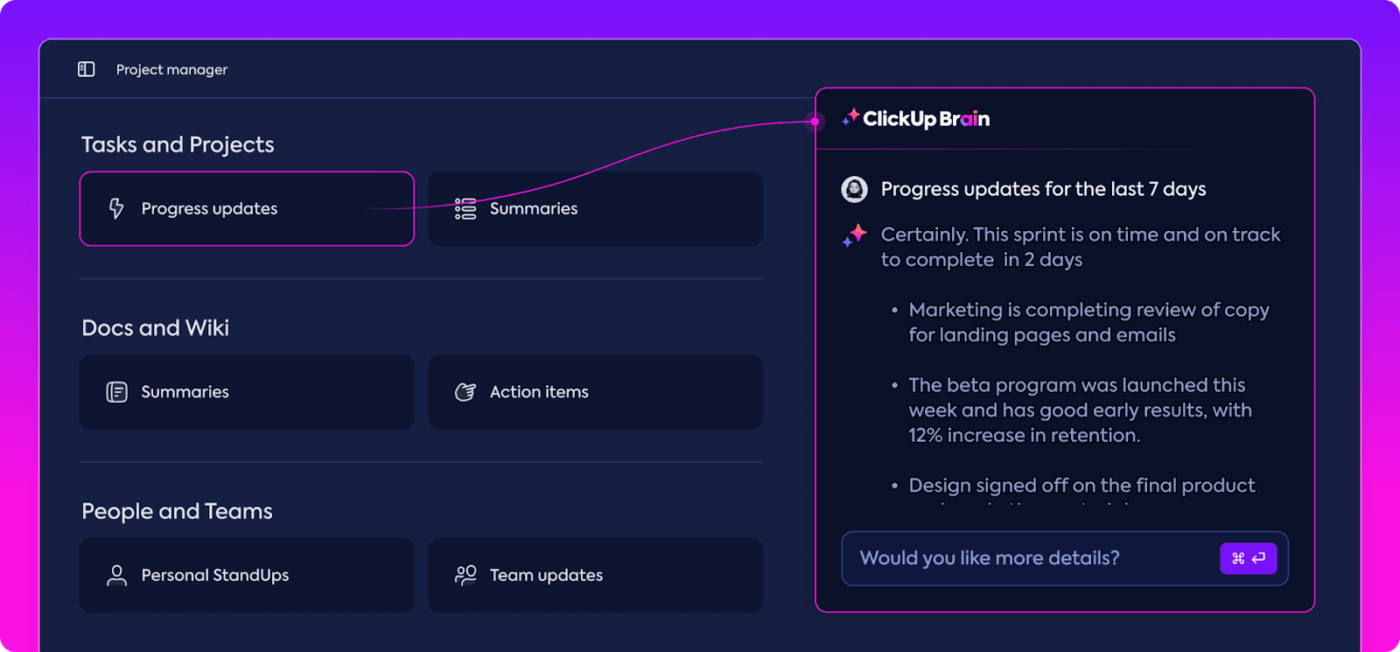

Como o ClickUp Brain pode aprimorar a avaliação do LLM

O ClickUp é um aplicativo de tudo para o trabalho com um assistente pessoal embutido chamado ClickUp Brain. Cérebro ClickUp é um divisor de águas na avaliação de desempenho do LLM. Então, o que ele faz?

Ele organiza e destaca os dados mais relevantes, mantendo sua equipe no caminho certo. Com seus recursos baseados em IA, o ClickUp Brain é um dos melhores software de rede neural existentes. Ele torna todo o processo mais suave, mais eficiente e mais colaborativo do que nunca. Vamos explorar seus recursos juntos.

Gerenciamento inteligente do conhecimento

Ao avaliar grandes modelos de linguagem (LLMs), o gerenciamento de grandes quantidades de dados pode ser esmagador.

Resuma os dados e simplifique o rastreamento das métricas de desempenho com o ClickUp Brain ClickUp Brain pode organizar e destacar métricas e recursos essenciais adaptados especificamente para a avaliação de LLM. Em vez de vasculhar planilhas dispersas e relatórios densos, o ClickUp Brain reúne tudo em um só lugar. Métricas de desempenho, dados de benchmarking e resultados de testes podem ser acessados em uma interface clara e fácil de usar.

Essa organização ajuda a sua equipe a eliminar o ruído e a se concentrar nos insights que realmente importam, facilitando a interpretação de tendências e padrões de desempenho.

Com tudo o que precisa em um só lugar, você pode passar da mera coleta de dados para a tomada de decisões impactantes e orientadas por dados, transformando a sobrecarga de informações em inteligência acionável.

Planejamento de projetos e gerenciamento de fluxo de trabalho

As avaliações de LLM exigem planejamento e colaboração cuidadosos, e o ClickUp facilita o gerenciamento desse processo.

Você pode delegar facilmente responsabilidades como coleta de dados, treinamento de modelos e testes de desempenho e, ao mesmo tempo, definir prioridades para garantir que as tarefas mais críticas recebam atenção primeiro. Além disso, os campos personalizados permitem que você adapte os fluxos de trabalho às necessidades específicas do seu projeto.

Crie e atribua tarefas e agilize o fluxo de trabalho usando IA no ClickUp

Com o ClickUp, todos podem ver quem está fazendo o quê e quando, ajudando a evitar atrasos e garantindo que as tarefas sejam executadas sem problemas por toda a equipe. É uma ótima maneira de manter tudo organizado e sob controle do início ao fim.

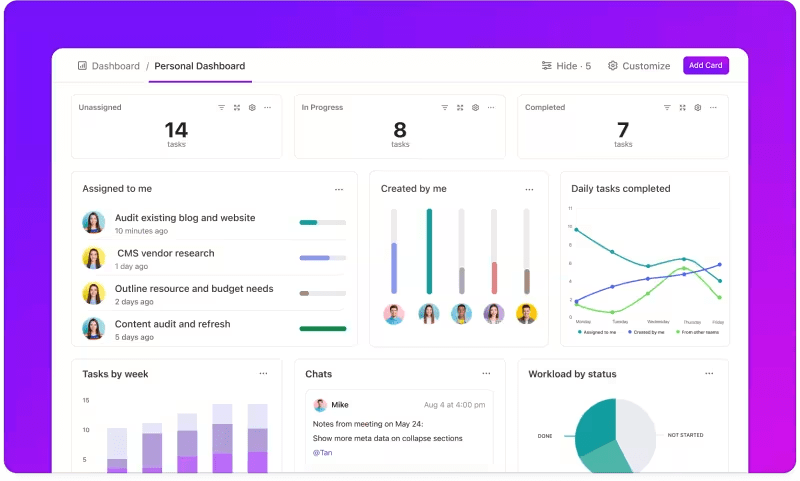

Rastreamento de métricas por meio de painéis personalizados

Deseja acompanhar de perto o desempenho dos seus sistemas de LLM? Painéis do ClickUp visualizam os indicadores de desempenho em tempo real. Isso permite que você monitore o progresso do seu modelo instantaneamente. Esses painéis são altamente personalizáveis, permitindo que você crie gráficos e tabelas que apresentem exatamente o que você precisa, quando você precisa.

Você pode observar a evolução da precisão do seu modelo nos estágios de avaliação ou detalhar o consumo de recursos em cada fase. Essas informações permitem que você identifique tendências rapidamente, identifique áreas de melhoria e faça ajustes imediatamente.

Veja o progresso de sua avaliação em uma única olhada no ClickUp Dashboards

Em vez de esperar pelo próximo relatório detalhado, Painéis do ClickUp permitem que você se mantenha informado e responsivo, capacitando sua equipe a tomar decisões baseadas em dados sem demora.

Insights automatizados

A análise de dados pode consumir muito tempo, mas Recursos do ClickUp Brain aliviam a carga fornecendo insights valiosos. Ele destaca tendências importantes e até sugere recomendações com base nos dados, facilitando a obtenção de conclusões significativas.

Com os insights automatizados do ClickUp Brain, não há necessidade de vasculhar manualmente os dados brutos em busca de padrões - ele os identifica para você. Essa automação libera sua equipe para se concentrar no refinamento do desempenho do modelo, em vez de ficar atolada em análises repetitivas de dados.

Obtenha insights acionáveis com o ClickUp Brain

Os insights gerados estão prontos para serem usados, permitindo que sua equipe veja imediatamente o que está funcionando e onde podem ser necessárias mudanças. Ao reduzir o tempo gasto na análise, o ClickUp ajuda sua equipe a acelerar o processo de avaliação e a se concentrar na implementação.

Documentação e colaboração

Não é mais necessário vasculhar e-mails ou várias plataformas para encontrar o que você precisa; tudo está ali, pronto quando você estiver. Documentos do ClickUp é um hub central que reúne tudo o que sua equipe precisa para uma avaliação perfeita do LLM. Ele organiza a documentação principal do projeto - como critérios de benchmarking, resultados de testes e registros de desempenho - em um local acessível para que todos possam acessar rapidamente as informações mais recentes.

O que realmente diferencia o ClickUp Docs são seus recursos de colaboração em tempo real. O recurso integrado Chat do ClickUp e **Comentários **Permita que os membros da equipe discutam ideias, deem feedback e sugiram alterações diretamente nos documentos

Isso significa que sua equipe pode conversar sobre as descobertas e fazer ajustes diretamente na plataforma, mantendo todas as discussões relevantes e pontuais.

Colabore e edite documentos do ClickUp com sua equipe em tempo real

Tudo, desde a documentação até o trabalho em equipe, acontece no ClickUp Docs, criando um processo de avaliação simplificado em que todos podem ver, compartilhar e agir de acordo com os últimos desenvolvimentos.

O resultado? Um fluxo de trabalho suave e unificado que permite que sua equipe atinja suas metas com total clareza.

Está pronto para dar uma olhada no ClickUp? Antes disso, vamos discutir algumas dicas e truques para obter o máximo de sua Avaliação LLM.

Melhores práticas na avaliação do LLM

Uma abordagem bem estruturada da avaliação do LLM garante que o modelo atenda às suas necessidades, alinhe-se às expectativas do usuário e forneça resultados significativos.

A definição de objetivos claros, a consideração dos usuários finais e o uso de uma variedade de métricas ajudam a moldar uma avaliação completa que revela os pontos fortes e as áreas de melhoria. Veja abaixo algumas práticas recomendadas para orientar seu processo.

🎯 Definir objetivos claros

Antes de iniciar o processo de avaliação, é essencial saber exatamente o que você deseja que o seu modelo de linguagem grande (LLM) alcance. Reserve um tempo para delinear as tarefas ou metas específicas do modelo.

Exemplo: Se você quiser melhorar o desempenho da tradução automática, esclareça os níveis de qualidade que deseja alcançar. Ter objetivos claros ajuda você a se concentrar nas métricas mais relevantes, garantindo que sua avaliação permaneça alinhada com essas metas e meça com precisão o sucesso.

Considere seu público

Pense em quem usará o LLM e quais são suas necessidades. É fundamental adaptar a avaliação aos usuários pretendidos.

exemplo: Se o seu modelo se destina a gerar conteúdo envolvente, você deverá prestar muita atenção a métricas como fluência e coerência. Entender o público-alvo ajuda a refinar os critérios de avaliação, garantindo que o modelo ofereça valor real em aplicações práticas

Utilize diversas métricas

Não se baseie em apenas uma métrica para avaliar seu LLM; uma combinação de métricas lhe dá uma visão mais completa do desempenho dele. Cada métrica capta aspectos diferentes, portanto, o uso de várias pode ajudá-lo a identificar os pontos fortes e fracos.

Exemplo: Embora as pontuações BLEU sejam ótimas para medir a qualidade da tradução, elas podem não abranger todas as nuances da escrita criativa. Incorporar métricas como perplexidade para precisão preditiva e até mesmo avaliações humanas para contexto pode levar a uma compreensão muito mais completa do desempenho de seu modelo

Benchmarks e ferramentas de LLM

A avaliação de grandes modelos de linguagem (LLMs) geralmente se baseia em benchmarks padrão do setor e ferramentas especializadas que ajudam a medir o desempenho do modelo em várias tarefas.

Aqui está um detalhamento de alguns benchmarks e ferramentas amplamente usados que trazem estrutura e clareza ao processo de avaliação.

Principais parâmetros de referência

- GLUE (General Language Understanding Evaluation): O GLUE avalia os recursos do modelo em várias tarefas de linguagem, incluindo classificação de frases, similaridade e inferência. É um benchmark de referência para modelos que precisam lidar com a compreensão de linguagem de uso geral

- SQuAD (Stanford Question Answering Dataset): A estrutura de avaliação do SQuAD é ideal para compreensão de leitura e mede a capacidade de um modelo de responder a perguntas com base em uma passagem de texto. É comumente usado para tarefas como suporte ao cliente e recuperação baseada em conhecimento, em que respostas precisas são cruciais

- SuperGLUE: Como uma versão aprimorada do GLUE, o SuperGLUE avalia modelos em tarefas mais complexas de raciocínio e compreensão contextual. Ele fornece percepções mais profundas, especialmente para aplicativos que exigem compreensão avançada de linguagem

Ferramentas essenciais de avaliação

- Hugging Face : Ele é muito popular por sua extensa biblioteca de modelos, conjuntos de dados e recursos de avaliação. Sua interface altamente intuitiva permite que os usuários selecionem facilmente benchmarks, personalizem avaliações e acompanhem o desempenho do modelo, tornando-o versátil para muitos aplicativos LLM

- SuperAnnotate : É especializado em gerenciar e anotar dados, o que é crucial para tarefas de aprendizado supervisionado. É particularmente útil para refinar a precisão do modelo, pois facilita a obtenção de dados de alta qualidade anotados por humanos, o que melhora o desempenho do modelo em tarefas complexas

- AllenNLP : Desenvolvido pelo Allen Institute for AI, o AllenNLP é voltado para pesquisadores e desenvolvedores que trabalham com modelos personalizados de NLP. Ele oferece suporte a uma série de benchmarks e fornece ferramentas para treinar, testar e avaliar modelos de linguagem, oferecendo flexibilidade para diversos aplicativos de NLP

O uso de uma combinação desses benchmarks e ferramentas oferece uma abordagem abrangente para a avaliação de LLM. Os benchmarks podem definir padrões entre as tarefas, enquanto as ferramentas fornecem a estrutura e a flexibilidade necessárias para rastrear, refinar e melhorar o desempenho do modelo de forma eficaz.

Juntas, elas garantem que os LLMs atendam aos padrões técnicos e às necessidades práticas dos aplicativos.

Desafios da avaliação de modelos de LLM

A avaliação de grandes modelos de linguagem (LLMs) requer uma abordagem diferenciada. Ela se concentra na qualidade das respostas e na compreensão da adaptabilidade e das limitações do modelo em cenários variados.

Como esses modelos são treinados em conjuntos de dados extensos, seu comportamento é influenciado por uma série de fatores, o que torna essencial avaliar mais do que apenas a precisão.

Uma verdadeira avaliação significa examinar a confiabilidade do modelo, a resiliência a cenários incomuns e a capacidade de adaptação incomuns e consistência geral das respostas. Esse processo ajuda a obter uma visão mais clara dos pontos fortes e fracos do modelo e revela as áreas que precisam ser aprimoradas.

Veja a seguir alguns desafios comuns que surgem durante a avaliação do LLM.

1. Sobreposição de dados de treinamento

É difícil saber se o modelo já viu alguns dos dados de teste. Como os LLMs são treinados em conjuntos de dados maciços, há uma chance de que algumas perguntas de teste se sobreponham aos exemplos de treinamento. Isso pode fazer com que o modelo pareça melhor do que realmente é, pois ele pode estar apenas repetindo o que já sabe, em vez de demonstrar uma verdadeira compreensão.

2. Desempenho inconsistente

Os LLMs podem ter respostas imprevisíveis. Em um momento, eles apresentam percepções impressionantes e, no momento seguinte, cometem erros estranhos ou apresentam informações imaginárias como fatos (conhecidas como "alucinações").

Essa inconsistência significa que, embora os resultados do LLM possam brilhar em algumas áreas, eles podem ficar aquém em outras, dificultando o julgamento preciso de sua confiabilidade e qualidade gerais.

3. Vulnerabilidades adversárias

Os LLMs podem ser suscetíveis a ataques de adversários, em que prompts habilmente elaborados os induzem a produzir respostas falhas ou prejudiciais. Essa vulnerabilidade expõe os pontos fracos do modelo e pode levar a resultados inesperados ou tendenciosos. Testar esses pontos fracos do adversário é fundamental para entender onde estão os limites do modelo.

Casos práticos de uso de avaliação do LLM

Por fim, aqui estão algumas situações comuns em que a avaliação do LLM realmente faz a diferença:

Chatbots de suporte ao cliente

Os LLMs são amplamente usados em chatbots para lidar com as consultas dos clientes. A avaliação da qualidade da resposta do modelo garante que ele forneça respostas precisas, úteis e contextualmente relevantes.

É fundamental medir sua capacidade de entender a intenção do cliente, lidar com diversas perguntas e fornecer respostas semelhantes às humanas. Isso permitirá que as empresas garantam uma experiência tranquila para o cliente e minimizem a frustração.

Geração de conteúdo

Muitas empresas usam LLMs para gerar conteúdo de blog, mídia social e descrições de produtos. A avaliação da qualidade do conteúdo gerado ajuda a garantir que ele seja gramaticalmente correto, envolvente e relevante para o público-alvo. Métricas como criatividade, coerência e relevância para o tópico são importantes aqui para manter altos padrões de conteúdo.

Análise de sentimento

Os LLMs podem analisar o sentimento do feedback do cliente, publicações em mídias sociais ou avaliações de produtos. É essencial avaliar a precisão com que o modelo identifica se um trecho de texto é positivo, negativo ou neutro. Isso ajuda as empresas a entender as emoções dos clientes, refinar produtos ou serviços, aumentar a satisfação do usuário e melhorar as estratégias de marketing.

Geração de código

Os desenvolvedores geralmente usam LLMs para ajudar na geração de código. É fundamental avaliar a capacidade do modelo de produzir um código funcional e eficiente.

É importante verificar se o código gerado é logicamente sólido, livre de erros e atende aos requisitos da tarefa. Isso ajuda a reduzir a quantidade de codificação manual necessária e melhora a produtividade.

Otimize sua avaliação de LLM com o ClickUp

Avaliar os LLMs tem tudo a ver com a escolha das métricas certas que se alinham com suas metas. A chave é entender seus objetivos específicos, seja melhorar a qualidade da tradução, aprimorar a geração de conteúdo ou fazer o ajuste fino para tarefas especializadas.

A seleção das métricas corretas para a avaliação de desempenho, como as métricas RAG ou de ajuste fino, forma a base de uma avaliação precisa e significativa. Enquanto isso, os avaliadores avançados, como G-Eval, Prometheus, SelfCheckGPT e QAG, fornecem percepções precisas graças às suas fortes habilidades de raciocínio.

No entanto, isso não significa que essas pontuações sejam perfeitas - ainda é importante garantir que sejam confiáveis.

À medida que avança na avaliação de sua candidatura ao LLM, adapte o processo para que se ajuste ao seu caso de uso específico. Não existe uma métrica universal que funcione para todos os cenários. Uma combinação de métricas, juntamente com o foco no contexto, lhe dará uma visão mais precisa do desempenho do seu modelo.

Para agilizar a avaliação do LLM e melhorar a colaboração da equipe, o ClickUp é a solução ideal para gerenciar fluxos de trabalho e acompanhar métricas importantes.

Deseja aumentar a produtividade da sua equipe? Registre-se no ClickUp hoje mesmo e veja como ele pode transformar seu fluxo de trabalho!