Czym jest MCP?

MCP, czyli Model Context Protocol, to standard open source, który umożliwia każdemu zgodnemu modelowi AI żądanie danych, funkcji lub podpowiedzi z dowolnego zgodnego serwera za pośrednictwem wspólnego interfejsu JSON-RPC 2. 0

Dzięki standaryzacji sposobu opisywania możliwości narzędzi, MCP zastępuje indywidualnie dostosowane, jednorazowe złącza, redukując integracje z wykładniczej złożoności (N×M) do liniowego wysiłku (N+M).

W listopadzie 2024 r. firma Anthropic ogłosiła wprowadzenie MCP jako rozwiązania pozwalającego przełamać bariery informacyjne, które izolują modele AI od danych rzeczywistych.

Zamiast tworzyć oddzielne łączniki dla każdej kombinacji modelu i narzędzia, programiści tworzą teraz jeden serwer MCP, który współpracuje z Claude, GPT lub innym zgodnym systemem sztucznej inteligencji.

VentureBeat porównał to do „portu USB-C dla AI”, umożliwiającego modelom wysyłanie zapytań do baz danych i interakcję z systemami CRM bez konieczności stosowania niestandardowych złączy.

Najważniejsze informacje (klucz)

- MCP upraszcza integrację AI, zastępując niestandardowe złącza jednym standardem udostępnianym wspólnie.

- Umożliwia agentom AI dostęp do danych w czasie rzeczywistym, ograniczając halucynacje i domysły.

- Organizacje dokonują raportu o znacznym wzroście wydajności dzięki szybszemu opracowywaniu i dokładnym wynikom.

- Uniwersalny protokół MCP zapewnia wsparcie dla narzędzi, danych i podpowiedzi we wszystkich modelach AI.

Dlaczego MCP ma znaczenie dla wydajności agentów

MCP przekształca AI z izolowanych procesorów językowych w agenty rozpoznające kontekst, które dostarczają dokładnych informacji w czasie rzeczywistym bez halucynacji.

Protokół rozwiązuje fundamentalny limit obecnych systemów AI: modele doskonale radzą sobie z wnioskowaniem, ale mają trudności z dostępem do danych na żywo.

Przed wprowadzeniem MCP połączenie asystenta AI z firmowymi aplikacjami Slack, GitHub i bazą danych klientów wymagało trzech oddzielnych integracji, z których każda wiązała się z innym uwierzytelnianiem, obsługą błędów i nakładami na konserwację.

Prawdziwe organizacje dokonują raportu o ogromnym wzroście wydajności. Agent Block's Goose pokazuje, że tysiące pracowników oszczędzają 50–75% czasu na typowych zadaniach, a niektóre procesy zajmują teraz godziny zamiast dni.

Kluczową różnicą jest dokładność kontekstowa. Gdy agenci AI uzyskują dostęp do danych na żywo za pośrednictwem znormalizowanych serwerów MCP, udzielają konkretnych odpowiedzi zamiast ogólnych sugestii, co ogranicza wymianę informacji, która zazwyczaj spowalnia cykl pracy.

Korzyści i wzrost wydajności MCP odblokowuje

MCP zapewnia wymierne ulepszenia w trzech kluczowych obszarach, które mają bezpośredni wpływ na wydajność i dokładność:

1. Poprawa dokładności

Dostarczając modelom kontekst w czasie rzeczywistym, MCP ogranicza halucynacje i eliminuje domysły, które prowadzą do ogólnych odpowiedzi. Gdy agent AI może zadawać pytania do rzeczywistej bazy danych klientów zamiast polegać na danych szkoleniowych, dostarcza konkretnych informacji zamiast ogólnych rekomendacji.

2. Szybkość rozwoju

Monte Carlo Data raportują, że wdrożenie MCP zmniejsza nakłady pracy związane z integracją i konserwacją, jednocześnie przyspieszając cykle wdrażania. Zamiast tworzyć złącza niestandardowe dla każdego dostawcy AI, zespoły tworzą jeden serwer MCP, który działa uniwersalnie.

3. Efektywność operacyjna

Reakcja firmy Blok na incydent pokazuje ten wpływ. Inżynierowie mogą teraz wyszukiwać zestawy danych, śledzić pochodzenie, pobierać dane dotyczące incydentów i kontaktować się z właścicielami usług za pomocą zapytań w języku naturalnym, skracając czas rozwiązywania problemów z kilku godzin do kilku minut.

Efekt łączny zmienia zarówno tempo rozwoju, jak i doświadczenia użytkowników końcowych, tworząc podstawę dla bardziej zaawansowanych cykli pracy AI.

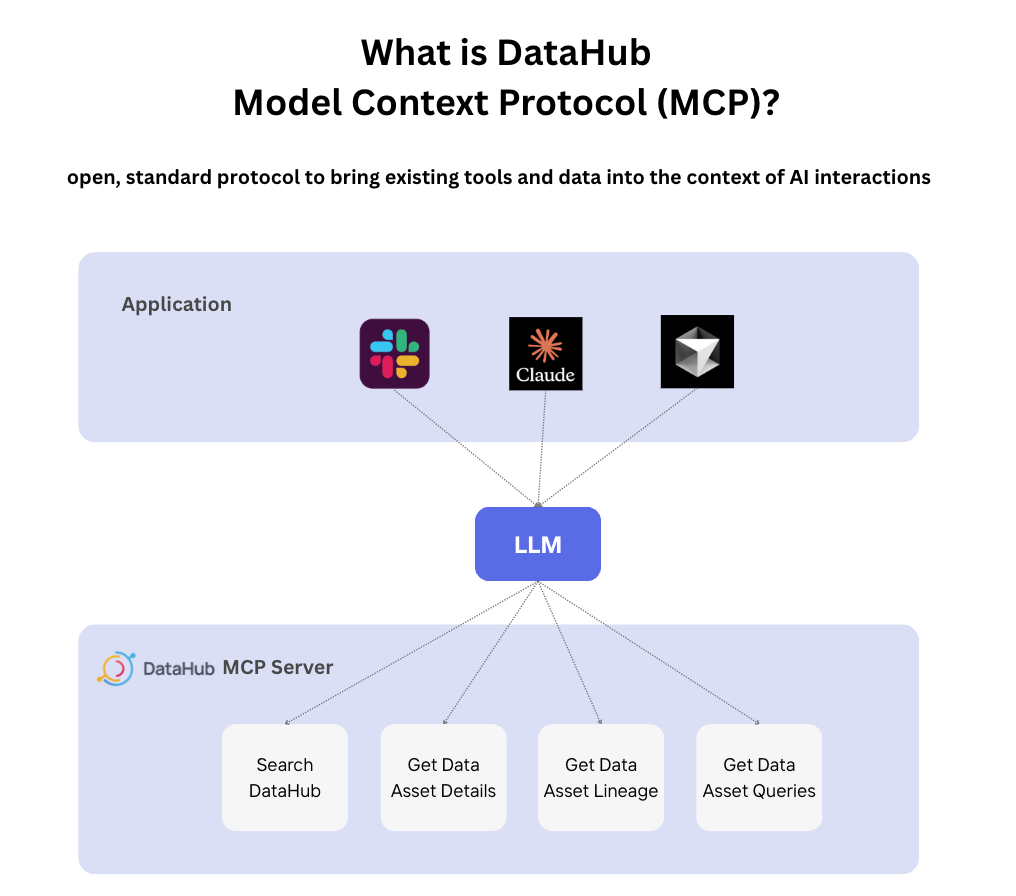

Ogólna architektura MCP

MCP działa w oparciu o prosty model host-klient-serwer, w którym aplikacje AI (hosti) łączą się z serwerami MCP poprzez znormalizowany interfejs klienta. Architektura ta umożliwia funkcjonalność typu plug-and-play, która eliminuje uzależnienie od jednego dostawcy.

Protokół definiuje trzy podstawowe funkcje:

- Narzędzia: Funkcje wykonywalne, takie jak wysyłanie wiadomości e-mail, zapisywanie plików lub wyzwalacz wywołań API

- Zasoby: Źródła danych, w tym pliki, bazy danych i kanały na żywo

- Podpowiedzi: Wstępnie zdefiniowane instrukcje, które kierują zachowaniem modelu w przypadku określonych zadań

- transport:* Metody komunikacji, w tym STDIO dla serwerów lokalnych i HTTP dla dostępu zdalnego

Serwer MCP firmy DataHub ilustruje tę architekturę w praktyce, ujednolicając metadane na ponad 50 platformach i zapewniając agentom AI kontekst na żywo.

Serwer udostępnia wyszukiwanie encji, przechodzenie przez linię pochodzenia i powiązania zapytań jako znormalizowane narzędzia, umożliwiając każdemu zgodnemu modelowi sztucznej inteligencji wykrywanie cykli pracy związanych z zarządzaniem danymi i interakcję z nimi.

Skuteczne zastosowania MCP i ich wpływ

Wszechstronność MCP obejmuje różne branże i stosy technologiczne, potwierdzając swoją wartość wykraczającą poza proste integracje zwiększające wydajność:

| Domena | Aplikacja | Wskaźnik wpływu |

|---|---|---|

| Tworzenie oprogramowania | Integracja Cursor + GitHub | 40% skrócenie czasu przeglądu PR |

| Zarządzanie danymi | Dostęp do metadanych DataHub | Z zapytań dotyczących pochodzenia danych, które trwały godziny, pozostały tylko minuty |

| Produkcja | Zarządzanie jakością Tulip | Automatyzowana analiza trendów dotyczących defektów |

| Zarządzanie interfejsami API | Ekspozycja Apollo GraphQL | Ujednolicony dostęp AI do mikrousług |

| Wydajność | Google Drive, łączniki Slack | Płynna automatyzacja międzyplatformowa |

Przykłady zastosowań w produkcji szczególnie podkreślają potencjał MCP wykraczający poza oprogramowanie.

Wdrożenie Tulip łączy agenty AI z statusem maszyn, raportami o usterkach i harmonogramami produkcji, umożliwiając zapytania w języku naturalnym, takie jak „podsumuj problemy jakościowe we wszystkich liniach w tym tygodniu”, które automatycznie agregują dane z wielu systemów.

Perspektywy na przyszłość MCP

W ciągu najbliższych 2–5 lat MCP przekształci się z nowopowstałego standardu w podstawową warstwę dla AI w przedsiębiorstwach:

| Obecny stan | Kierunek na przyszłość |

|---|---|

| Lokalne serwery, narzędzia tylko do odczytu | Zdalne rynki, możliwości zapisu |

| Ręczne zarządzanie serwerami | Dynamiczna alokacja, konteneryzacja |

| Podstawowe uwierzytelnianie | Szczegółowe uprawnienia, ramy zaufania |

| Proste wywoływanie narzędzi | Koordynacja wielu agentów, automatyzacja cyklu pracy |

Wdrożenie OpenAI w marcu 2025 r. sygnalizuje szerszy rozmach w branży. Analitycy spodziewają się, że główni dostawcy zgodzą się na MCP jako standardowy protokół dla platform agencyjnych, a wraz z nim pojawią się ulepszone narzędzia bezpieczeństwa i ramy regulacyjne, które pozwolą zaradzić obecnym słabościom.

Plan działania DataHub wskazuje na zoptymalizowane pod kątem AIO zestawy SDK z danymi wejściowymi typu Pydantic i transportem strumieniowym, podczas gdy trwają badania nad dynamicznym zarządzaniem kontekstem w celu obsługi większych katalogów narzędzi bez pogorszenia wydajności modelu.

Często zadawane pytania

MCP opiera się na koncepcjach wywoływania funkcji, ale standaryzuje wykrywanie narzędzi, wymianę metadanych i semantykę transportu między dostawcami. Bardziej przypomina protokół Language Server Protocol dla agentów AI niż API pojedynczego dostawcy.

Większość programistów może skonfigurować podstawowe serwery MCP w ciągu kilku godzin, korzystając z istniejących szablonów Replit lub DataHub. Protokół wykorzystuje znane wzorce JSON-RPC, a kompleksowe zestawy SDK są dostępne dla języków Python, TypeScript, Java i Rust.

Zacznij od Uwierzytelniania OA 2.1 do autoryzacji, wdroż potwierdzenie użytkownika dla operacji destrukcyjnych i sprawdź wszystkie opisy narzędzi pod kątem ukrytych instrukcji. Rozważ rozwiązania bramkowe, które centralizują uwierzytelnianie i sprawdzanie ładunku.

MCP zapewnia wsparcie dla Claude Desktop firmy Anthropic, ChatGPT i klientów API firmy OpenAI oraz różnych implementacji open source. Standard został zaprojektowany z myślą o uniwersalnej kompatybilności między zgodnymi dostawcami.

![What Is MCP? Model Context Protocol Explained [In Simple Terms]](https://clickup.com/blog/wp-content/uploads/2025/06/MCP-Tools-Featured-Image.png)