La mayoría de nosotros hemos tenido alguna experiencia «hablando» con las últimas herramientas de IA del mercado. Si ha pasado suficiente tiempo con la IA, ya sabrá que es como ese amigo brillante pero olvidadizo que tiene grandes ideas, pero a veces olvida lo que han hablado. O ese compañero de trabajo que siempre está al teléfono compartiendo noticias dudosas de hilos de chats aleatorios y difundiendo información errónea.

Eso es solo la punta del iceberg cuando hablamos de los retos de la inteligencia artificial.

Investigadores de la Universidad Estatal de Oregón y Adobe están desarrollando una nueva técnica de entrenamiento para reducir los sesgos sociales en los sistemas de IA. Si esta técnica demuestra ser fiable, podría hacer que la IA fuera más justa para todos.

Pero no nos adelantemos. Esta es solo una de las muchas soluciones necesarias para abordar los numerosos retos de la IA a los que nos enfrentamos hoy en día. Desde problemas técnicos hasta dilemas éticos, el camino hacia una IA fiable está plagado de problemas complejos.

Analicemos juntos estos retos de la IA y veamos qué se necesita para superarlos.

10 retos y soluciones de la IA

A medida que avanza la tecnología de IA, se enfrenta a una serie de problemas. Esta lista explora diez retos urgentes de la IA y describe soluciones prácticas para una implementación responsable y eficiente de la IA.

1. Sesgo algorítmico

El sesgo algorítmico se refiere a la tendencia de los sistemas de IA a mostrar resultados sesgados, a menudo debido a la naturaleza de sus datos de entrenamiento o su diseño. Estos sesgos pueden manifestarse de numerosas formas, perpetuando y amplificando a menudo los sesgos sociales existentes.

Soluciones

- Datos diversos y representativos: utilice conjuntos de datos de entrenamiento que reflejen verdaderamente la diversidad de todos los grupos para evitar sesgos relacionados con el género, la etnia o la edad.

- Detección y supervisión de sesgos: compruebe periódicamente si sus sistemas de IA presentan sesgos. Para ello, combine la supervisión automatizada con sus propias revisiones manuales, a fin de garantizar que no se le escape nada.

- Ajustes algorítmicos: Asuma un rol activo en el ajuste de los algoritmos de IA para combatir los sesgos. Esto podría significar reequilibrar las ponderaciones de los datos o añadir restricciones de equidad a sus modelos.

- Directrices éticas para la IA: contribuya a configurar prácticas éticas en materia de IA adoptando y aplicando directrices que aborden la equidad y los sesgos, y garantizando que estos principios se integren en todas las fases de su proyecto de IA.

2. La falta de transparencia de la IA genera desconfianza

La transparencia en la IA significa ser abierto sobre cómo funcionan los sistemas de IA, incluyendo su diseño, los datos que utilizan y sus procesos de toma de decisiones. La explicabilidad va un paso más allá al garantizar que cualquier persona, independientemente de sus conocimientos tecnológicos, pueda comprender qué decisiones toma la IA y por qué. Estos conceptos ayudan a abordar los temores sobre la IA, como los sesgos, los problemas de privacidad o incluso riesgos como los usos militares autónomos.

Soluciones

- Desarrolle documentación clara: proporcione detalles exhaustivos sobre los modelos de IA, su proceso de desarrollo, las entradas de datos y los procesos de toma de decisiones. Esto fomenta una mejor comprensión y sienta las bases para la confianza.

- Implementación de modelos de IA que sean explicables: utilice modelos que proporcionen más transparencia, como árboles de decisión o sistemas basados en reglas, para que los usuarios vean exactamente cómo se convierten las entradas en salidas.

- Utilice herramientas de interpretabilidad: aplique herramientas como LIME (Local Interpretable Model-agnostic Explanations) o SHAP (SHapley Additive exPlanations) para desglosar las contribuciones de diversas funciones en el proceso de toma de decisiones del modelo.

3. Escalar la IA es más difícil de lo que parece

La escalabilidad de la tecnología de IA es fundamental para las organizaciones que desean aprovechar su potencial en diversas unidades de negocio. Sin embargo, lograr esta escalabilidad de la infraestructura de IA conlleva numerosas complejidades.

A pesar del potencial de alto retorno de la inversión, a muchas empresas les resulta difícil pasar de los proyectos piloto a la implementación a gran escala.

El fiasco de Zillow con la compraventa de viviendas es un claro recordatorio de los retos que plantea la escalabilidad de la IA. Su IA, destinada a predecir los precios de las viviendas con fines lucrativos, tenía unas tasas de error de hasta el 6,9 %, lo que provocó graves pérdidas financieras y una amortización de inventario de 304 millones de dólares.

El reto de la escalabilidad es más evidente fuera de los gigantes tecnológicos como Google y Amazon, que cuentan con los recursos necesarios para aprovechar la IA de forma eficaz. Para la mayoría de los demás, especialmente las empresas no tecnológicas que están empezando a explorar la IA, las barreras incluyen la falta de infraestructura, potencia informática, experiencia y aplicación estratégica.

Soluciones

- Infraestructura mejorada: desarrolle una infraestructura digital robusta que pueda gestionar implementaciones de IA a gran escala. Por ejemplo, los servicios en la nube y los centros de datos localizados reducen la latencia y mejoran el rendimiento.

- Equipos interdisciplinarios: fomente un entorno colaborativo en el que las unidades tecnológicas y empresariales trabajen juntas para integrar a la perfección las soluciones de IA en los modelos de negocio existentes.

- Herramientas de desarrollo automatizado de IA: utilice plataformas como evoML de TurinTech para automatizar el desarrollo de códigos de aprendizaje automático, lo que permite una creación y un despliegue más rápidos de los modelos.

- Aprendizaje y adaptación continuos: implemente mecanismos para el aprendizaje y la actualización continuos de los modelos de IA con el fin de adaptarse a los datos del mundo real y a las condiciones cambiantes del mercado, garantizando la relevancia y la eficiencia a largo plazo.

- Invierta en el desarrollo del talento: Desarrolle conocimientos internos sobre IA mediante prácticas de formación y contratación centradas en las tecnologías emergentes de IA, reduciendo la dependencia excesiva del talento externo en este ámbito.

Lea también: Estadísticas esenciales sobre la IA que debe conocer hoy

4. Deepfake y fraude generativo con IA

La IA generativa y las tecnologías deepfake están transformando el panorama del fraude, especialmente en el sector de los servicios financieros. Hacen que sea más fácil y barato crear falsificaciones convincentes.

Por ejemplo, en enero de 2024, un deepfake que se hacía pasar por un director financiero ordenó a un empleado que transfiriera 25 millones de dólares, lo que puso de manifiesto las graves consecuencias de este tipo de tecnologías.

Esta tendencia al alza pone de relieve los retos a los que se enfrentan los bancos, que luchan por adaptar sus sistemas de gestión de datos y detección de fraudes para contrarrestar estafas cada vez más sofisticadas que no solo engañan a las personas, sino también a los sistemas de seguridad basados en máquinas.

Soluciones

- Tecnologías de detección avanzadas: los bancos deben invertir en tecnologías más novedosas que puedan detectar anomalías de deepfake y de IA generativa de forma más eficaz.

- Supervisión humana: la integración del análisis humano cualificado con las respuestas de la IA mejora las tasas de detección y ayuda a verificar y comprender la identificación de fraudes impulsada por la IA.

- Esfuerzos colaborativos para la prevención del fraude: establecer alianzas dentro de los sectores y entre ellos puede ayudar a desarrollar mecanismos más sólidos para identificar y prevenir el fraude.

5. Retos de interoperabilidad e interacción entre humanos y IA

Cuando diferentes organizaciones o países utilizan conjuntamente la IA, deben asegurarse de que esta se comporte de forma ética según las normas de todos. Esto se denomina interoperabilidad ética y es especialmente importante en ámbitos como la defensa y la seguridad.

En la actualidad, los gobiernos y las organizaciones tienen su propio conjunto de normas y valores. Por ejemplo, consulte las Directrices para la interacción entre humanos y IA de Microsoft:

Sin embargo, existe una falta de estandarización en esta filosofía y en las normas en todo el mundo.

En la actualidad, los sistemas de IA vienen con su propio conjunto de reglas éticas, que pueden ser adecuadas en un lugar, pero problemáticas en otro. Cuando estos sistemas interactúan con los seres humanos, si no se comportan como se espera, pueden dar lugar a malentendidos o desconfianza.

Soluciones

- Establezca normas éticas universales: acuerde unas reglas éticas básicas que todos los sistemas de IA deben seguir, independientemente de su procedencia. Céntrese en la equidad, la responsabilidad y la transparencia.

- Utilice un sistema de certificación sólido: antes de utilizar cualquier sistema de IA, este debe superar una prueba rigurosa para confirmar que cumple con estos estándares éticos. Esto podría incluir comprobaciones por parte de los creadores y también de grupos independientes.

- Asegúrate de que todo el mundo esté al tanto: Sé siempre claro sobre cómo la IA toma decisiones y utiliza los datos. Esta transparencia ayuda a generar confianza y facilita la integración de diferentes sistemas de IA.

- Manténgase al tanto: Compruebe periódicamente los sistemas de IA para asegurarse de que siguen cumpliendo las normas éticas. Actualícelos según sea necesario para mantenerse al día con las nuevas normas o tecnologías.

6. La ética de la IA es algo más que buenas intenciones

La inteligencia artificial (IA) se está introduciendo rápidamente en casi todos los aspectos de nuestras vidas, desde los coches autónomos hasta los asistentes virtuales, ¡y es fantástico! Pero aquí está el problema: la forma en que utilizamos la IA a veces puede plantear serios dilemas éticos. Existen problemas éticos espinosos en torno a la privacidad, los prejuicios, la sustitución de puestos de trabajo y mucho más.

Dado que la IA es capaz de realizar tareas que antes hacían los humanos, existe todo un debate sobre si debería realizar algunas de ellas.

Por ejemplo, ¿debería la IA escribir guiones de películas? Suena genial, pero provocó un gran revuelo en el mundo del entretenimiento con huelgas en Estados Unidos y Europa. Y no se trata solo de qué trabajos puede asumir la IA, sino también de cómo utiliza nuestros datos, toma decisiones y, a veces, incluso se equivoca. Esto ha hecho que todo el mundo, desde los creadores de tecnología hasta los expertos legales, se apresuren a averiguar cómo manejar la IA de forma responsable.

Soluciones

- Aclare las reglas: Desarrolle directrices claras sobre cómo se debe utilizar la IA. Esto significa establecer límites para evitar el uso indebido y comprender las implicaciones legales de las acciones de la IA.

- Respete la privacidad: para entrenar a la IA se utilizan enormes cantidades de datos, incluida información personal. Debemos tener mucho cuidado con la forma en que se recopilan, utilizan y protegen estos datos. Se trata de garantizar que la IA respete nuestra privacidad.

- Combata los sesgos: la IA es tan buena como los datos de los que aprende, y a veces estos datos tienen sesgos. Debemos eliminar estos sesgos de los sistemas de IA para asegurarnos de que sean justos y no discriminen.

- Proteja la propiedad intelectual: la IA puede producir trabajos basados en lo que ha aprendido de las obras creativas de otros. Esto puede infringir los derechos de autor y privar a los creadores de lo que les corresponde, a menos que estemos atentos.

- Ética frente a velocidad: en la loca carrera por llevar las últimas tecnologías de IA al mercado, la ética puede quedar relegada a un segundo plano. Tenemos que encontrar el equilibrio entre la necesidad de velocidad y hacer las cosas bien.

7. Mezclar conjuntos de datos de IA podría ser desastroso

Al desarrollar modelos de aprendizaje automático de IA, puede resultar difícil distinguir correctamente entre los conjuntos de datos de entrenamiento, validación y prueba. El conjunto de datos de entrenamiento del modelo de IA enseña al modelo, el conjunto de datos de validación lo ajusta y el conjunto de datos de prueba evalúa su rendimiento.

Este error puede obstaculizar gravemente la capacidad del modelo para funcionar eficazmente en aplicaciones de IA del mundo real, donde la adaptabilidad y la precisión en datos estandarizados son claves.

Soluciones

- División estructurada de datos: Adopte un enfoque sistemático para dividir los datos en conjuntos de entrenamiento, validación y prueba.

- Técnicas de validación cruzada: utilice métodos de validación cruzada, especialmente en escenarios con datos limitados. Técnicas como la validación cruzada K-fold ayudan a maximizar el uso del entrenamiento y proporcionan una estimación más sólida del rendimiento del modelo en datos no vistos.

- Aleatorización de datos: asegúrese de que la división de datos sea aleatoria para evitar que el orden de los datos introduzca sesgos en la IA. Esto ayuda a crear conjuntos de entrenamiento y validación que sean representativos del conjunto de datos global.

8. Riesgos y preocupaciones relacionados con la toma de decisiones por automatización

Cuando la IA toma decisiones, las cosas pueden complicarse, especialmente en áreas críticas como la sanidad y la banca. Un gran problema es que no siempre podemos ver cómo los sistemas de IA llegan a sus decisiones.

Esto puede dar lugar a decisiones injustas que nadie puede explicar. Además, estos sistemas son objetivos para los piratas informáticos que, si logran entrar, podrían robar una gran cantidad de datos importantes.

Soluciones

- Desarrolle protocolos de seguridad robustos: asegúrese de que los sistemas de IA estén bien protegidos contra los piratas informáticos. Mantenga la seguridad actualizada para cerrar cualquier nueva brecha que pueda surgir.

- Mejora la transparencia: utiliza tecnología que ayude a la IA a explicar sus decisiones en términos sencillos. Si todo el mundo entiende cómo se toman las decisiones, confiarán más en la IA.

- Proteja la información privada: proteja todos los datos personales que maneja la IA. Siga leyes como el RGPD para asegurarse de que no se comprometa la privacidad de nadie.

- Fomente la colaboración multidisciplinar: Reúna a expertos de todos los campos (tecnología, derecho, ética) para que trabajen juntos. Ellos pueden ayudar a garantizar que las decisiones de la IA sean justas y seguras.

Lea también: Las herramientas de IA más populares para estudiantes

9. Falta de normas y regulaciones claras sobre la IA

En la actualidad, no existe un organismo regulador global para la IA; la normativa varía según el país e incluso según el sector. Por ejemplo, en Estados Unidos no existe un organismo central específico para la IA.

Este enfoque descentralizado puede dar lugar a inconsistencias y confusión; pueden aplicarse diferentes normas en función de dónde y cómo se implemente la IA. Esto dificulta a los desarrolladores y usuarios de IA garantizar el pleno cumplimiento de la normativa en todas las jurisdicciones.

Soluciones

- Establecer un organismo regulador dedicado a la IA: los países podrían beneficiarse de la creación de una agencia específica centrada en la IA. Este organismo podría supervisar todos los problemas relacionados con la IA, manteniéndose al día con el rápido ritmo de desarrollo de la IA y garantizando el cumplimiento de las normas de seguridad y ética.

- Cooperación internacional: la IA no se detiene en las fronteras. Los países deben trabajar juntos para crear normas y acuerdos internacionales sobre el uso de la IA, de forma similar a cómo funcionan los tratados globales para la protección del medio ambiente.

- Legislación clara y adaptable: las leyes deben ser claras (para que las empresas sepan cómo cumplirlas), pero también lo suficientemente flexibles como para adaptarse a los nuevos avances en IA. Las actualizaciones y revisiones periódicas de las leyes sobre IA podrían ayudar a mantener su relevancia.

- Participación del público y las partes interesadas: Las regulaciones deben desarrollarse con la participación de una amplia gama de partes interesadas, incluidas las empresas tecnológicas, los especialistas en ética y el público en general. Esto puede ayudar a garantizar que se tengan en cuenta diversos puntos de vista y que el público confíe más en los sistemas de IA.

Lea también: Herramientas de IA para abogados

10. Desinformación procedente de la IA

Imagina disponer de una tecnología capaz de pensar como un ser humano. Esa es la promesa de la inteligencia artificial general (AGI), pero conlleva grandes riesgos. La desinformación es uno de los principales problemas en este ámbito.

Con la IGA, se pueden crear fácilmente noticias falsas o información falsa convincente, lo que dificulta a todo el mundo distinguir entre lo que es verdad y lo que no.

Además, si la IGA toma decisiones basadas en esta información falsa, puede dar lugar a resultados desastrosos, que afecten a todo, desde la política hasta la vida personal.

Soluciones

- Establezca controles rigurosos: compruebe siempre los datos antes de permitir que la IGA difunda información. Utilice fuentes fiables y confirme los detalles antes de hacer nada público.

- Enseñe ética a la AGI: al igual que enseñamos a los niños a distinguir el bien del mal, debemos enseñar a la AGI el comportamiento ético. Esto incluye comprender el impacto de difundir información falsa y tomar decisiones justas y equitativas.

- Mantenga a los humanos al tanto: por muy inteligente que sea la IGA, mantenga a los humanos involucrados en el proceso de toma de decisiones. Esto ayuda a detectar errores y garantiza que las acciones de la IGA reflejen nuestros valores y nuestra ética.

- Cree reglas claras: establezca directrices estrictas sobre lo que la IGA puede y no puede hacer, especialmente en lo que respecta a la creación y difusión de información. Asegúrese de que estas reglas se cumplan al pie de la letra.

Lea también: El glosario completo de IA

Herramientas para afrontar los retos de la IA

Cuando se está inmerso en la IA, elegir las herramientas adecuadas no es solo algo deseable, sino imprescindible para garantizar que su viaje por la IA no se convierta en un desastre. Se trata de simplificar lo complejo, garantizar la seguridad de sus datos y obtener el soporte que necesita para resolver los retos de la IA sin arruinarse.

La clave está en elegir un software de IA personalizado que mejore la productividad y, al mismo tiempo, proteja tu privacidad y la seguridad de tus datos.

Entra en ClickUp Brain, la navaja suiza para la IA en tu lugar de trabajo.

ClickUp Brain: eficiencia, seguridad e innovación, todo en uno.

ClickUp Brain está diseñado para gestionar todo lo relacionado con la IA, desde la gestión de sus proyectos y documentos hasta la mejora de la comunicación del equipo. Con las capacidades de IA de ClickUp Brain, puede abordar los retos relacionados con los datos, mejorar la gestión de proyectos y aumentar la productividad, todo ello manteniendo la simplicidad y la seguridad. ClickUp Brain es una solución integral que:

- Se integra perfectamente en su trabajo diario.

- Asegúrate de que tus datos sigan siendo tuyos.

- Ahorra dinero y recursos.

ClickUp Brain se integra de forma inteligente en su flujo de trabajo para ahorrarle tiempo y esfuerzo, al tiempo que protege sus datos. Al igual que el resto de la plataforma ClickUp, cumple con el RGPD y no utiliza sus datos para fines de formación.

Así es como funciona el trabajo:

- AI Knowledge Manager: ¿Alguna vez ha deseado obtener respuestas instantáneas y precisas de sus documentos de trabajo o chats? ClickUp Brain lo hace posible. Se acabó buscar durante horas en los archivos. Solo tiene que preguntar y recibirá la respuesta, ya sean detalles de un documento del proyecto o información de actualizaciones anteriores del equipo.

- AI Project Manager: imagina tener un compañero de IA que mantenga tus proyectos por buen camino. Desde automatizar las actualizaciones de tareas hasta resumir el progreso del proyecto, ClickUp Brain se encarga de las partes tediosas para que puedas centrarte en el panorama general.

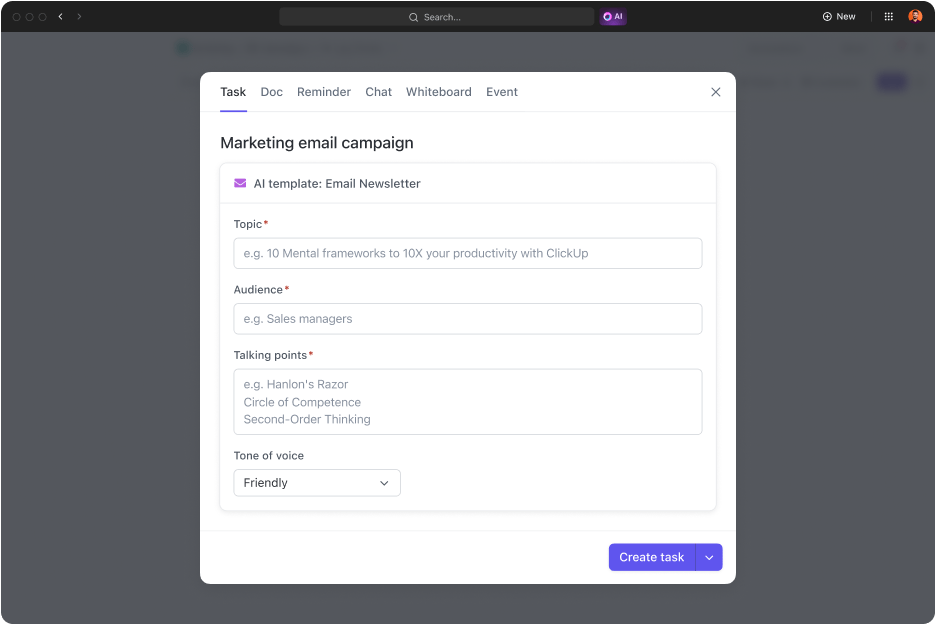

- AI Writer for Work: esta herramienta supone un gran cambio para cualquiera que le tenga miedo a escribir. Tanto si estás redactando un correo electrónico rápido como si estás elaborando un informe exhaustivo, ClickUp Brain te ayuda a perfeccionar tu prosa, revisar la ortografía y ajustar el tono a la perfección.

Afrontar los retos de la IA con las herramientas adecuadas

A pesar de los retos de la IA que hemos comentado, podemos estar de acuerdo en que la inteligencia artificial ha avanzado mucho. Ha evolucionado desde la automatización básica hasta sistemas sofisticados que pueden aprender, adaptarse y predecir resultados. Muchos de nosotros hemos integrado la IA en diversos aspectos de nuestras vidas, desde asistentes virtuales hasta herramientas avanzadas de recopilación y análisis de datos.

A medida que avanza la IA, podemos esperar aún más innovaciones, trucos y herramientas de IA para mejorar la productividad, optimizar la toma de decisiones y revolucionar las industrias. Este progreso abre nuevas posibilidades y nos impulsa hacia un futuro en el que la IA desempeñará un rol crucial tanto en el ámbito personal como en el profesional.

Con herramientas de IA como ClickUp Brain, puede sacar el máximo partido a las tecnologías de IA y, al mismo tiempo, protegerse contra los retos que plantea la IA en materia de privacidad y seguridad de los datos. ClickUp es su herramienta de gestión de tareas basada en IA para todo, desde proyectos de software hasta marketing. Elija ClickUp para transformar de forma segura su organización en una entidad basada en datos e IA, al tiempo que aumenta la productividad de su equipo.

¿Listo para transformar tus flujos de trabajo con la IA? ¡Regístrate ahora en ClickUp!