Hat Ihr KI-Modell jemals eine sichere Antwort geliefert, die Ihre Benutzer als veraltet bezeichnet haben? Das ist die Art von Erfahrung, die dazu führt, dass Ihr Team jede Antwort in Frage stellt.

Das klingt wie der Albtraum eines jeden Entwicklers und KI-Enthusiasten, oder?

Große Sprachmodelle (LLMs) basieren auf Trainingsdaten, aber mit zunehmendem Alter der Daten schleichen sich Ungenauigkeiten ein. Da eine Neuausbildung Millionen kostet, ist eine Optimierung die intelligentere Lösung.

Retrieval Augmented Generation (RAG) und Fine-Tuning sind die wichtigsten Frameworks zur Steigerung der Genauigkeit. Aufgrund der Unterschiede zwischen den beiden Ansätzen eignen sie sich jedoch für unterschiedliche Anwendungen. Das richtige Framework ist der Schlüssel zur effektiven Verbesserung Ihres LLM.

Aber welche ist die richtige für Sie?

Dieser Artikel behandelt das Dilemma in diesem Leitfaden zu RAG vs. Fine-Tuning. Egal, ob Sie mit domänenspezifischen Daten arbeiten oder hochwertige Lösungen für die Datenabfrage entwickeln möchten, hier finden Sie die Antworten!

⏰60-Sekunden-Zusammenfassung

- Die Verbesserung der Leistung von LLMs und KI-Modellen ist ein Schlüsselelement jeder Geschäfts- und Entwicklungsfunktion. RAG und Fine-Tuning sind zwar beliebte Ansätze, aber es ist wichtig, ihre Nuancen und Auswirkungen zu verstehen.

- RAG stattet LLMs mit Echtzeit-Funktionen zum Abrufen externer Daten aus und reduziert so die Kosten für Nachschulungen.

- Fine-Tuning optimiert LLMs durch Training mit speziellen Datensätzen und verbessert so die Genauigkeit für domänenspezifische Aufgaben.

- RAG eignet sich am besten für sich schnell verändernde Datenumgebungen wie Finanzen, rechtliche Aktualisierungen und Kundensupport.

- Fine-Tuning eignet sich ideal für markenspezifische KI, Branchen mit hohen Compliance-Anforderungen und Stimmungsanalysen.

- ClickUp Brain kombiniert beides und nutzt RAG für kontextbezogene Erkenntnisse und Fine-Tuning für maßgeschneiderte Automatisierung und Inhaltserstellung.

- Die KI-gestützten Tools von ClickUp optimieren die Wissensgewinnung, Workflow-Automatisierung und Projektmanagement für maximale Effizienz.

Was ist Retrieval-Augmented Generation (RAG)?

Sie sehen sich neue Berichte und Umfragen an, die Ihr LLM übersehen hat? Dann brauchen Sie RAG. Um dies besser zu verstehen, lassen Sie uns zunächst die Grundlagen dieses Ansatzes betrachten.

Definition von RAG

RAG ist ein KI-Framework, das zusätzliche Informationen für Ihr LLM abruft, um die Genauigkeit der Antworten zu verbessern. Vor der Generierung der LLM-Antworten werden die relevantesten Daten aus externen Quellen wie Wissensquellen oder Datenbanken abgerufen.

Betrachten Sie es als Forschungsassistent innerhalb des LLM- oder generativen KI-Modells.

👀 Wussten Sie schon? LLMs, insbesondere Textgeneratoren, können Halluzinationen erzeugen, indem sie falsche, aber plausible Informationen generieren. Der Grund dafür sind Lücken in den Trainingsdaten.

Die wichtigsten Schlüsselvorteile von RAG

Mittlerweile dürfte klar sein, dass RAG eine zusätzliche Ebene vernetzter KI ist, die Ihr Geschäftsprozess benötigt. Um sein Potenzial zu verdeutlichen, hier einige seiner Vorteile:

- Reduzierte Schulungskosten: Durch die dynamische Informationsgewinnung entfällt die Notwendigkeit häufiger Modell-Nachschulungen. Dies führt zu einer kostengünstigeren /AI-Bereitstellung, insbesondere für Bereiche mit sich schnell ändernden Daten.

- Skalierbarkeit: Erweitert das Wissen des LLM, ohne die Größe des Primärsystems zu erhöhen. Sie helfen Unternehmen dabei, zu skalieren, große Datensätze zu verwalten und mehr Abfragen ohne hohe Rechenkosten durchzuführen.

- Echtzeit-Updates: Spiegelt die neuesten Informationen in jeder Antwort wider und hält das Modell relevant. Die Priorisierung der Genauigkeit durch Echtzeit-Updates ist in vielen Bereichen von entscheidender Bedeutung, darunter Finanzanalyse, Gesundheitswesen und Compliance-Audits.

📮 ClickUp Insight: Die Hälfte unserer Befragten hat Schwierigkeiten mit der Einführung von KI; 23 % wissen einfach nicht, wo sie anfangen sollen, während 27 % mehr Schulungen benötigen, um fortgeschrittene Aufgaben zu erledigen.

ClickUp löst dieses Problem mit einer vertrauten Chat-Oberfläche, die sich wie eine SMS anfühlt. Teams können direkt mit einfachen Fragen und Anfragen loslegen und dann ganz natürlich leistungsstärkere Features für die Automatisierung und Workflows entdecken, ohne sich durch eine abschreckende Lernkurve kämpfen zu müssen, die so viele Menschen zurückhält.

Anwendungsfälle für RAG

Sie fragen sich, wo RAG seine Stärken ausspielt? Betrachten Sie diese Schlüssel-Anwendungsfälle:

Chatbots und Kundensupport

Abfragen erfordern oft aktuelle und kontextbezogene Antworten. RAG verbessert die Fähigkeiten von Chatbots, indem es die neuesten Support-Artikel, Richtlinien und Schritte zur Fehlerbehebung abruft.

Dies ermöglicht eine genauere Echtzeit-Unterstützung ohne umfangreiches Vortraining.

Dynamische Dokumentenabfrage

RAG optimiert die Dokumentensuche, indem es die relevantesten Abschnitte aus umfangreichen Repositorys extrahiert. Anstelle von allgemeinen Zusammenfassungen können LLMs präzise Antworten aus aktualisierten Handbüchern, Forschungsarbeiten oder Rechtsdokumenten liefern.

Der Einsatz von RAG-gestützten LLMs macht die Informationsbeschaffung schneller und präziser.

🧠 Wissenswertes: Meta, Eigentümer von Facebook, Instagram, Threads und WhatsApp, hat RAG im Jahr 2020 in die LLM-Entwicklung eingeführt.

Was ist Fine-Tuning?

Schauen wir uns einmal an, was Fine-Tuning bewirkt.

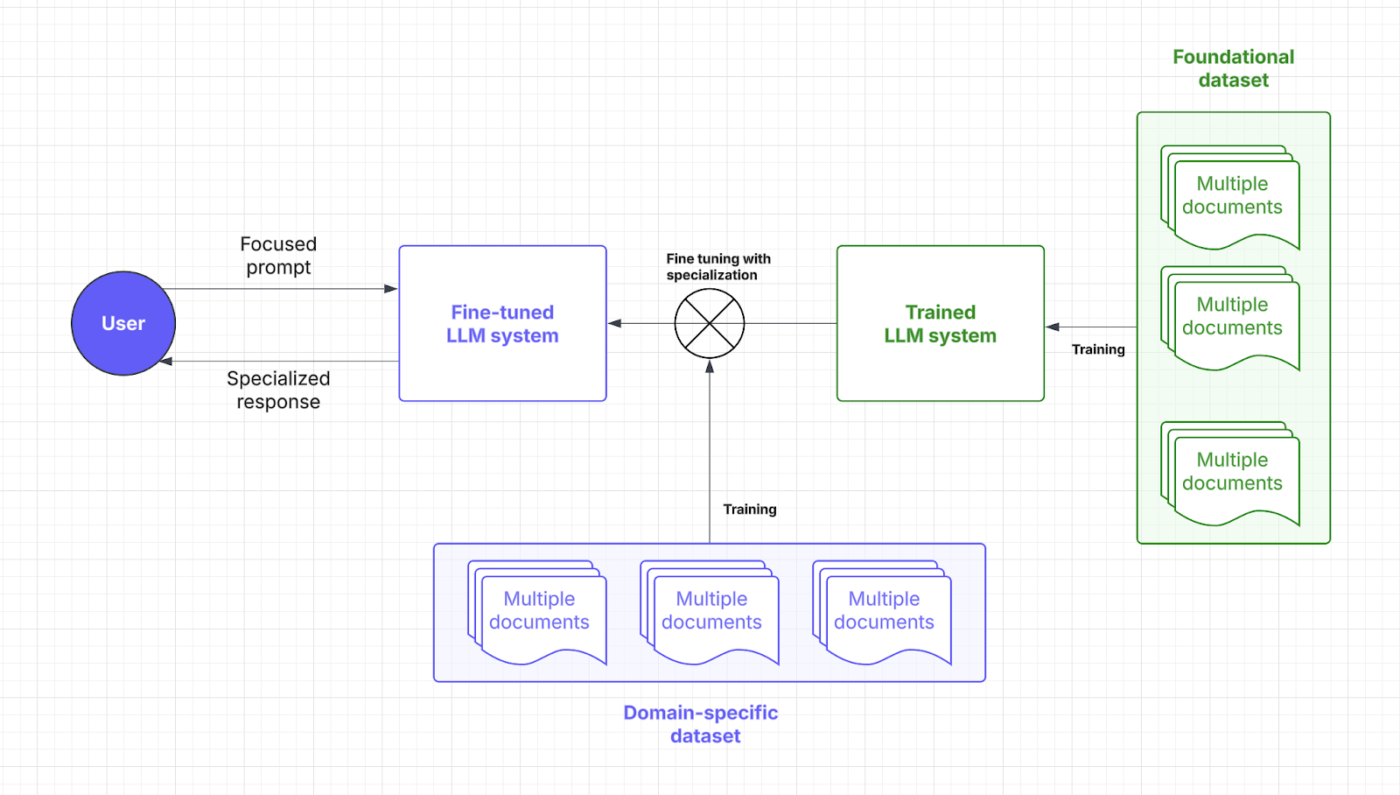

Definition von Fine-Tuning

Fine-Tuning umfasst das Training eines vortrainierten Sprachmodells. Ja, viel Training, was sich anhand von Punkt und Fokus erklären lässt.

🧠 Wussten Sie schon: Beim Training von Large Language Models (LLM) sind „Gewichte” die einstellbaren Parameter innerhalb des neuronalen Netzwerks, die die Stärke der Verbindungen zwischen Neuronen bestimmen und im Wesentlichen die gelernten Informationen speichern. Der Trainingsprozess optimiert diese Gewichte, um Fehler bei der Vorhersage zu minimieren.

„Fokus“ umfasst hingegen mehrere Aspekte: Dazu gehören eine sorgfältige Datenkuratierung, um Qualität und Relevanz sicherzustellen, die Verwendung von Aufmerksamkeitsmechanismen, um relevante Eingabesegmente zu priorisieren, und die gezielte Feinabstimmung, um das Modell auf bestimmte Aufgaben zu spezialisieren.

Durch spezialisierte Datensätze ermöglicht Fine-Tuning KI-Modellen, sich auf die Ausführung domänenspezifischer Aufgaben zu konzentrieren. Durch die Anpassung der Modellgewichte und des Fokus gewinnt Ihr LLM mehr Kontextverständnis und Genauigkeit.

Stellen Sie sich Fine-Tuning als einen Master-Abschluss vor, den Ihr LLM benötigt, um die Sprache Ihrer Branche zu sprechen. Sehen wir uns an, wo diese /AI-Strategie in den Prozess der schnellen Antwort einfließt:

Vorteile von Fine-Tuning

Fine-Tuning-Techniken sind lediglich Anpassungen der /AI. Es handelt sich eher um eine Art Zoomfunktion für vordefinierte Details. Hier sind die damit verbundenen Vorteile:

- Aufgabenspezifische Optimierung: Spezielle Datensätze schärfen die LLM-Antworten für bestimmte Aufgaben. Möchten Sie Benutzern helfen, komplexe Eingabeaufforderungen zu umgehen? Fine-Tuning hilft Entwicklern, maßgeschneiderte KI-Lösungen zu erhalten.

- Verbesserte Genauigkeit für Nischenanwendungen: Domänenwissen reduziert Fehler und erhöht die Präzision jeder Antwort. Fine-Tuning erhöht auch die Zuverlässigkeit eines LLM, sodass Geschäfte weniger Mikromanagement und manuelle Überwachung betreiben müssen.

- Benutzerdefinierte Anpassung an die Markenstimme und Compliance: Durch Fine-Tuning werden LLMs mit den Begriffen, dem Stil und den Vorschriften des Unternehmens vertraut gemacht. So werden eine konsistente Markenstimme und die branchenspezifische Compliance gewährleistet.

➡️ Lesen Sie auch: KI-Techniken: Machine Learning, Deep Learning und NLP meistern

Anwendungsfälle für Fine-Tuning

Ihr Fine-Tuning-Prozess sorgt für Effizienz mit Einzelzielen. Hier sind seine Vorteile:

Domänenspezifische QA-Systeme

Branchen wie Recht, Gesundheitswesen und Finanzen sind auf präzise, domänenbezogene KI-Antworten angewiesen. Durch Fine-Tuning werden LLMs mit Fachwissen ausgestattet, wodurch eine genaue Beantwortung von Fragen (QA) gewährleistet wird.

Ein juristischer KI-Assistent kann beispielsweise Verträge präziser interpretieren, während ein medizinischer Chatbot anhand vertrauenswürdiger Datensätze symptombezogene Ratschläge geben kann.

Sentimentanalyse und benutzerdefinierte Workflows

Unternehmen verwenden ein fein abgestimmtes Modell, um Marken zu überwachen, Kundenfeedback zu analysieren und Workflows zu automatisieren, die auf ihre individuellen betrieblichen Anforderungen zugeschnitten sind. Ein KI-gestütztes Tool kann nuancierte Stimmungen in Produktbewertungen erkennen und Unternehmen dabei helfen, ihre Angebote zu verfeinern.

Im Personalwesen hilft die Kombination von Fine-Tuning und natürlicher Sprachverarbeitung der KI dabei, Mitarbeiterbefragungen zu analysieren und Probleme am Arbeitsplatz mit größerem Kontextbewusstsein zu erkennen.

💡 Profi-Tipp: Beim Fine-Tuning können vielfältigere Daten hinzugefügt werden, um potenzielle Verzerrungen zu beseitigen. Es ist nicht unbedingt domänenspezifisch, aber dennoch eine wichtige Anwendung.

Vergleich: RAG vs. Fine-Tuning

Es ist unbestreitbar, dass beide KI-Strategien darauf abzielen, die Leistung zu steigern.

Aber die Entscheidung scheint immer noch ziemlich schwierig zu sein, oder? Hier finden Sie eine Übersicht über Fine-Tuning und RAG, die Ihnen helfen soll, die richtige Entscheidung für Ihre LLM-Investitionen zu treffen.

| Aspekt | RAG (Retrieval-augmented generation) | Fine-Tuning |

| Definition | Ermöglicht es LLM, mit seinem speziellen System relevante Daten in Echtzeit aus externen Quellen abzurufen. | Trainiert ein vortrainiertes Modell mit speziellen Datensätzen für domänenspezifische Aufgaben. |

| Leistung und Genauigkeit | Ideal für die Echtzeit-Datenabfrage, aber die Genauigkeit ist von der Qualität der externen Daten abhängig. | Verbessert die kontextbezogene Genauigkeit und aufgabenspezifische Antworten. |

| Kosten und Ressourcenanforderungen | Kostengünstigere Vorabinvestitionen konzentrieren sich auf den Echtzeit-Datenzugriff. | Erfordert mehr Ressourcen für das anfängliche Training, ist aber langfristig kostengünstig. |

| Wartung und Skalierbarkeit | Hoch skalierbar und flexibel, aber es besteht eine Abhängigkeit von der Häufigkeit der Aktualisierungen externer Quellen. | Erfordert häufige Updates und Wartungsarbeiten, bietet jedoch langfristig eine stabile Leistung. |

| Anwendungsfälle | Chatbots, dynamische Dokumentenabfrage, Echtzeitanalyse | Domänenspezifische QA-Systeme, Stimmungsanalyse und benutzerdefinierte Anpassung der Markenstimme |

| Wann sollte man sich dafür entscheiden? | Schnell wechselnde Daten, Echtzeit-Updates und Priorisierung der Ressourcenkosten | Nischenkundensegmente, domänenspezifische Logik, benutzerdefinierte Anpassung |

| Ideal für | Branchen benötigen genaue Informationen in Echtzeit (Finanzen, Recht, Kundensupport). | Branchen, die spezifische Sprache, Compliance oder Kontext erfordern (Gesundheitswesen, Rechtswesen, Personalwesen) |

Benötigen Sie etwas mehr Klarheit, um Ihre Zweifel auszuräumen? Hier finden Sie einen direkten Vergleich der Schlüsselaspekte, die sich auf Ihre Anforderungen auswirken.

Leistung und Genauigkeit

In Bezug auf die Leistung spielt RAG eine wichtige Rolle, indem es neue Daten aus externen Quellen einbezieht. Seine Genauigkeit und Reaktionszeiten hängen von der Qualität dieser Daten ab. Diese Abhängigkeit von externen Datenbanken ermöglicht es RAG, aktuelle Informationen effektiv bereitzustellen.

Fine-Tuning hingegen verbessert die Art und Weise, wie das Modell durch spezielles Retraining verarbeitet und reagiert. Dieser Prozess führt zu kontextuell genaueren Antworten, insbesondere für Nischenanwendungen. Fein abgestimmte LLMs sind ideal, um die Konsistenz in Branchen mit strengen Anforderungen, wie dem Gesundheitswesen oder dem Finanzwesen, aufrechtzuerhalten.

Fazit: RAG eignet sich hervorragend für Echtzeitdaten und Fine-Tuning für kontextgenaue Antworten.

Ein Reddit-Benutzer sagt:

Wenn Sie ein kleines Modell und eine gute Datenbank in der RAG-Pipeline verwenden, können Sie hochwertige Datensätze generieren, die besser sind als die Ergebnisse einer hochwertigen KI.

Wenn Sie ein kleines Modell und eine gute Datenbank in der RAG-Pipeline verwenden, können Sie hochwertige Datensätze generieren, die besser sind als die Ergebnisse einer hochwertigen KI.

💡 Profi-Tipp: Um Ihr LLM zu einer bestimmten Ausgabe zu führen, konzentrieren Sie sich auf effektives Prompt Engineering.

Kosten und Ressourcenanforderungen

RAG ist in der Regel kostengünstiger, da es nur eine Ebene für den Abruf externer Daten hinzufügt. Da das gesamte Modell nicht neu trainiert werden muss, ist es eine wesentlich budgetfreundlichere Option, insbesondere in dynamischen Umgebungen. Allerdings können die Betriebskosten für den Echtzeit-Datenzugriff und den Speicher hoch sein.

Fine-Tuning erfordert mehr Aufwand für die Vorbereitung der Datensätze und mehr Trainingsressourcen, ist jedoch eine langfristige Investition. Nach dem Fine-Tuning benötigen LLMs weniger Updates, was zu einer vorhersehbaren Leistung und Kosteneinsparungen führt. Entwickler sollten die Anfangsinvestition gegen die laufenden Betriebskosten abwägen.

Fazit: RAG ist kostengünstig, einfach zu implementieren und bietet schnelle Vorteile. Fine-Tuning ist zunächst ressourcenintensiv, verbessert jedoch die LLM-Qualität und spart langfristig Betriebskosten.

💡 Profi-Tipp: Ihr RAG-System ist nur so intelligent wie die Daten, aus denen es schöpft. Halten Sie Ihre Datenquellen sauber und füllen Sie sie mit genauen, aktuellen Daten!

Wartung und Skalierbarkeit

RAG bietet eine hervorragende Skalierbarkeit, da der Schwerpunkt hauptsächlich auf der Erweiterung der externen Quelle liegt. Dank seiner Flexibilität und Anpassungsfähigkeit eignet es sich perfekt für schnelllebige Branchen. Die Wartung ist jedoch von der Häufigkeit der Aktualisierungen externer Datenbanken abhängig.

Fine-Tuning erfordert relativ häufige Wartungsarbeiten, insbesondere wenn sich domänenspezifische Informationen ändern. Es erfordert zwar mehr Ressourcen, bietet jedoch im Laufe der Zeit eine größere Konsistenz und erfordert nach und nach weniger Anpassungen. Allerdings ist die Skalierbarkeit für Fine-Tuning wesentlich komplexer und erfordert umfangreichere und vielfältigere Datensätze.

Fazit: RAG eignet sich am besten für eine schnelle Skalierung und Feinabstimmung bei minimalem Wartungsaufwand und stabiler Leistung.

Ein Reddit-Benutzer fügt hinzu:

Bei kleinen Aufgaben ist es oft effizienter, einfach ein größeres Modell zu verwenden, anstatt ein kleineres Modell feinabzustimmen.

Bei kleinen Aufgaben ist es oft effizienter, einfach ein größeres Modell zu verwenden, anstatt ein kleineres Modell feinabzustimmen.

👀 Wussten Sie schon? Es gibt KI-Lösungen, die jetzt riechen können. Angesichts der Komplexität von Düften erfordert dies viel regelmäßiges Fine-Tuning und komplexe Datenabrufe.

Welcher Ansatz ist für Ihren Anwendungsfall der richtige?

Auch wenn Sie die Feinheiten verstehen, kann die Entscheidung ohne offensichtliche Referenz oder Kontext schwer fallen. Lassen Sie uns einige Geschäftsszenarien durchspielen, um zu verdeutlichen, wie jedes KI-Modell besser funktioniert.

Wann sollte man sich für RAG entscheiden?

RAG hilft Ihnen dabei, Ihr LLM mit den richtigen Fakten und Informationen zu füttern, darunter technische Standards, Verkaufszahlen, Kundenfeedback und vieles mehr.

Wie können Sie dies nutzen? Betrachten Sie diese Szenarien, um RAG in Ihren Betrieb zu integrieren:

Anwendungsfall Nr. 1: Echtzeitanalyse

- Szenario: Ein Fintech-Unternehmen ist Anbieter von KI-gestützten Marktinformationen für Händler. Benutzer fragen nach Aktienkursentwicklungen, und das System muss die neuesten Marktberichte, SEC-Unterlagen und Nachrichten abrufen.

- Warum RAG gewinnt: Die Aktienmärkte bewegen sich schnell, daher ist das ständige Nachschulen von KI-Modellen teuer und ineffizient. RAG sorgt für Präzision, indem es nur die aktuellsten Finanzdaten heranzieht, Kosten senkt und die Genauigkeit erhöht.

- Faustregel: RAG sollte Ihre bevorzugte Strategie für den Umgang mit sich schnell ändernden Daten durch KI sein. Beliebte Anwendungsbereiche sind die Analyse von Social-Media-Daten, Energieoptimierung, Erkennung von Cybersicherheitsbedrohungen und Nachverfolgung von Aufträgen.

Anwendungsfall Nr. 2: Datenprüfungen und Einhaltung gesetzlicher Vorschriften

- Szenario: Ein juristischer AI-Assistent hilft Anwälten beim Entwerfen von Verträgen und überprüft die Einhaltung sich ändernder Gesetze, indem er die neuesten Gesetze, Präzedenzfälle und Urteile heranzieht.

- Warum RAG gewinnt: Die Überprüfung rechtlicher und kommerzieller Aspekte erfordert keine tiefgreifenden Verhaltensaktualisierungen. RAG erfüllt diese Aufgabe sehr gut, indem es Rechtstexte in Echtzeit aus einem zentralen Datensatz abruft.

- Faustregel: RAG eignet sich hervorragend für ressourcen- und statistikbasierte Erkenntnisse. Eine gute Möglichkeit, dies optimal zu nutzen, wäre der Einsatz von medizinischen KI-Assistenten für Behandlungsempfehlungen und Kunden-Chatbots für die Fehlerbehebung und Aktualisierung von Richtlinien.

Sie fragen sich immer noch, ob Sie RAG in Ihrem LLM benötigen? Hier ist eine kurze Checkliste:

- Benötigen Sie neue, hochwertige Daten, ohne das LLM selbst zu ändern?

- Ändern sich Ihre Informationen häufig?

- Muss Ihr LLM mit dynamischen Informationen statt mit statischen Trainingsdaten arbeiten?

- Möchten Sie hohe Kosten und zeitaufwändiges Modell-Retraining vermeiden?

➡️ Lesen Sie auch: Die besten Prompt-Engineering-Tools für generative KI

Wann ist Fine-Tuning effektiver?

Wie bereits erwähnt, ist Fine-Tuning die Graduiertenschule der KI. Ihr LLM kann sogar Fachjargon lernen. Hier ist ein branchenbezogener Blick darauf, wann es wirklich glänzt:

Anwendungsfall Nr. 1: Hinzufügen von Markenstimme und Tonalität

- Szenario: Eine Luxusmarke entwickelt einen KI-Concierge, der mit Kunden in einem eleganten, exklusiven Ton interagiert. Er muss markenspezifische Tonalitäten, Formulierungen und emotionale Nuancen verkörpern.

- Warum Fine-Tuning besser ist: Fine-Tuning hilft dem KI-Modell, die einzigartige Stimme und den Tonfall der Marke zu erfassen und zu reproduzieren. Es sorgt für ein einheitliches Erlebnis bei jeder Interaktion.

- Faustregel: Fine-Tuning ist effektiver, wenn sich Ihre LLMs an ein bestimmtes Fachgebiet anpassen müssen. Dies ist ideal für genreorientierte immersive Spiele, thematisches und einfühlsames Storytelling oder sogar Marketingtexte für Marken.

🧠 Wissenswertes: LLMs, die in solchen Soft Skills geschult sind, eignen sich hervorragend für die Analyse der Stimmung und Zufriedenheit von Mitarbeitern. Derzeit nutzen jedoch nur 3 % der Unternehmen generative KI im Personalwesen.

Anwendungsfall Nr. 2: Moderation von Inhalten und kontextbasierte Erkenntnisse

- Szenario: Eine Social-Media-Plattform nutzt ein KI-Modell, um schädliche Inhalte zu erkennen. Der Fokus liegt dabei auf der Erkennung plattformspezifischer Sprache, neuer Slang-Ausdrücke und kontextsensitiver Verstöße.

- Warum Fine-Tuning gewinnt: Soft Skills wie die Formulierung von Sätzen liegen oft außerhalb des Anwendungsbereichs von RAG-Systemen. Fine-Tuning verbessert das Verständnis eines LLM für plattformspezifische Nuancen und Fachjargon, insbesondere für die Moderation relevanter Inhalte.

- Faustregel: Fine-Tuning ist eine gute Wahl, wenn es um kulturelle oder regionale Unterschiede geht. Dies gilt auch für die Anpassung an branchenspezifische Begriffe wie medizinische, juristische oder technische Fachsprache.

Möchten Sie Ihr LLM feinabstimmen? Stellen Sie sich dabei folgende Schlüssel-Fragen:

- Muss Ihr LLM auf ein Nischenkundensegment oder ein Markenthema zugeschnitten sein?

- Möchten Sie proprietäre oder domänenspezifische Daten zur Logik des LLM hinzufügen?

- Benötigen Sie schnellere Antworten, ohne an Genauigkeit einzubüßen?

- Liefern Ihre LLMs Offline-Lösungen?

- Können Sie dedizierte Ressourcen und Rechenleistung für das Retraining bereitstellen?

Die Verbesserung der Benutzererfahrung ist großartig. Viele Geschäfte benötigen jedoch auch KI als Steigerung der Produktivität, um hohe Investitionskosten zu rechtfertigen. Aus diesem Grund ist die Einführung eines vortrainierten KI-Modells für viele oft die erste Wahl.

👀 Wussten Sie schon? Gen AI hat das Potenzial, Arbeitsabläufe zu automatisieren, wodurch Mitarbeiter bis zu 70 Prozent ihrer Zeit einsparen können. Dabei spielt es eine große Rolle, die KI effektiv um Erkenntnisse zu bitten!

Wie ClickUp fortschrittliche KI-Techniken nutzt

Die Wahl zwischen RAG und Fine-Tuning ist eine ziemlich große Debatte.

Schon beim Durchlesen einiger Reddit-Threads kann man leicht verwirrt werden. Aber wer sagt, dass Sie sich für nur eine Methode entscheiden müssen?

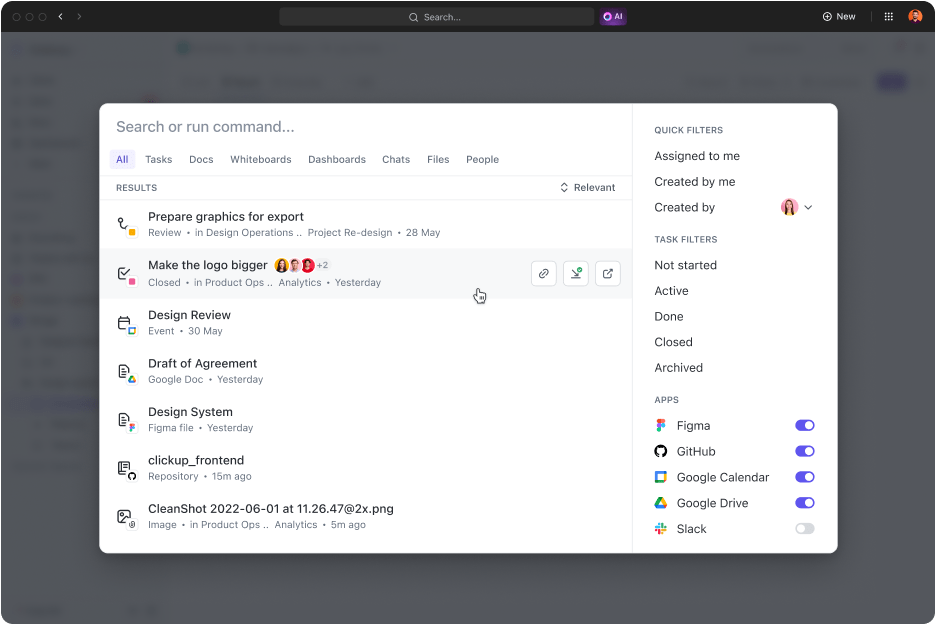

Stellen Sie sich vor, Sie hätten anpassbare KI-Modelle, Automatisierung und Aufgabenmanagement an einem Ort. Das ist ClickUp, die Allround-App für die Arbeit. Sie vereint Projektmanagement, Dokumentation und Teamkommunikation unter einem Dach und wird von KI der nächsten Generation unterstützt.

Kurz gesagt, es zeichnet sich in allen Bereichen aus, insbesondere mit seiner umfassenden KI-Lösung: ClickUp Brain.

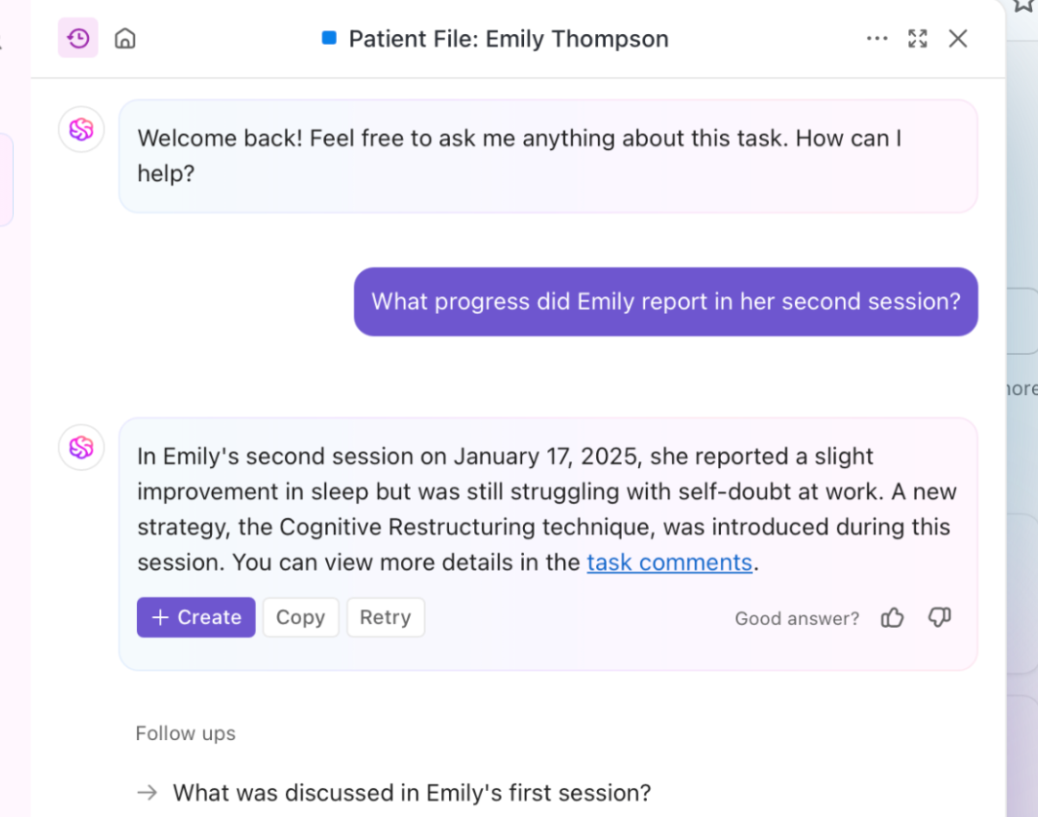

Benötigen Sie schnelle, kontextbezogene Einblicke? Brain ruft Echtzeitinformationen aus Ihren Dokumenten, Aufgaben und Ressourcen ab. Das ist RAG in Aktion. Darüber hinaus kann das zugrunde liegende LLM, Brain, Berichte und routinemäßige Aktualisierungen für Projekte erstellen.

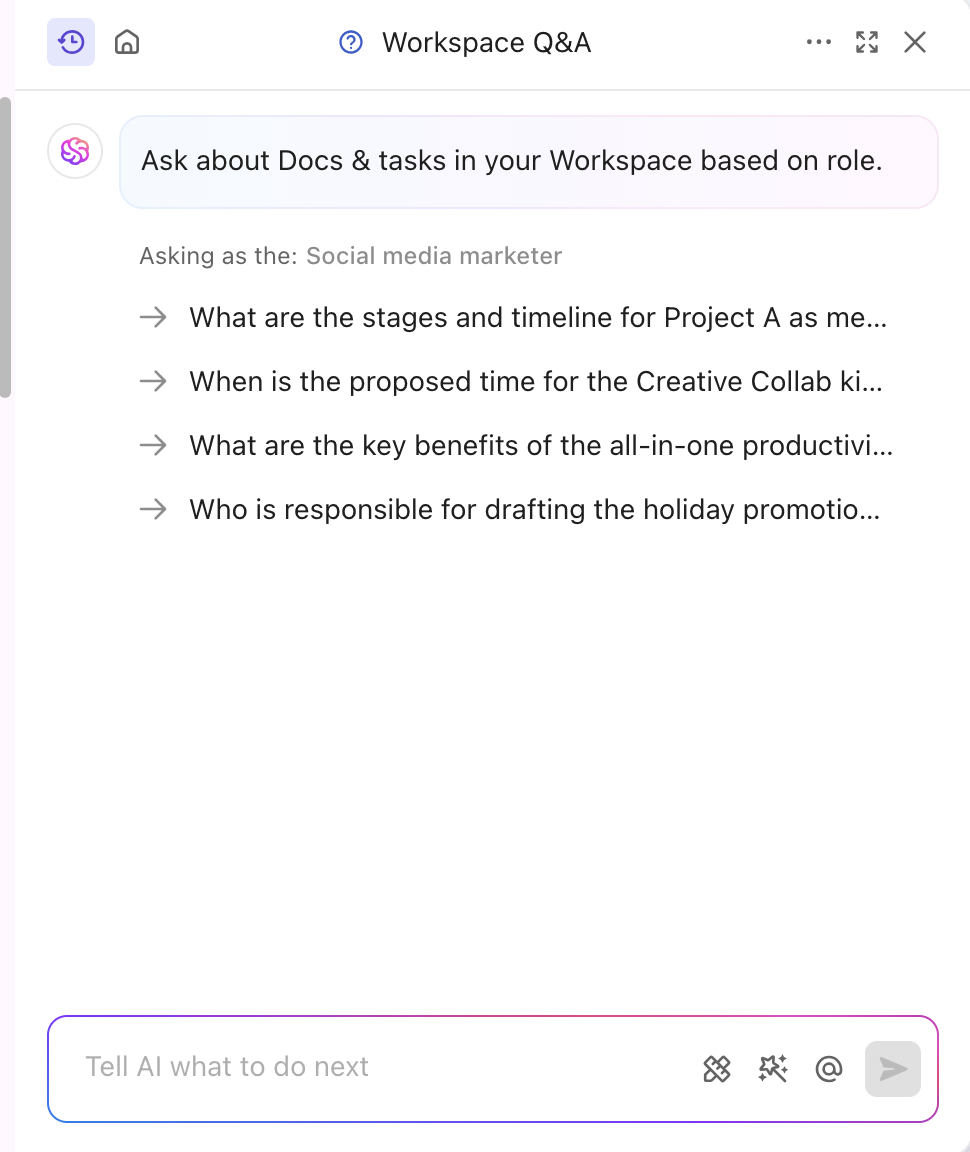

Das KI-Tool ist außerdem auf Ihre Branche und Ihr Segment abgestimmt und liefert professionelle und kreative Einblicke. Es personalisiert Inhalte sogar in Echtzeit, ohne dass eine manuelle Schulung erforderlich ist. Brain kombiniert Fine-Tuning und RAG, um Projektaktualisierungen, Aufgabenzuweisungen und Workflow-Benachrichtigungen zu automatisieren. Möchten Sie Antworten, die auf Ihre Rolle zugeschnitten sind? ClickUp Brain kann auch das!

Neben der Spezialisierung auf Inhalte verfügt ClickUp auch über ein leistungsstarkes wissensbasiertes KI-Feature.

Die ClickUp Connected Search ist ein KI-gestütztes Tool, das schnell alle Ressourcen aus Ihrem integrierten Space abruft. Ganz gleich, ob Sie Dokumente für das heutige StandUp-Meeting oder Antworten auf eine Aufgabe benötigen, eine einfache Abfrage liefert Ihnen Quellenlinks, Zitate und detaillierte Einblicke.

Außerdem startet es Apps, durchsucht Ihre Zwischenablage und erstellt Snippets. Und das Beste daran? All dies ist mit einem Klick von Ihrem Command-Center, Ihrer Aktionsleiste oder Ihrem Desktop aus zugänglich.

Der Präsident von Hum JAM, ein Experte für digitales Marketing, sagt sogar:

ClickUp ist das beeindruckendste „All-in-One”-Tool für die Automatisierung der Teamautomatisierung, mit dem Sie den Erfolg Ihres Teams verfolgen, automatisieren und messen können. Glauben Sie mir, wenn ich sage, dass Ihr Team ohne dieses tool nicht mehr auskommen wird.

ClickUp ist das beeindruckendste „All-in-One”-Tool für die Teamautomatisierung, mit dem Sie den Erfolg Ihres Teams nachverfolgen, automatisieren und messen können. Glauben Sie mir, wenn ich sage, dass Ihr Team ohne dieses Tool nicht mehr auskommen wird.

➡️ Lesen Sie auch: Der Unterschied zwischen maschinellem Lernen und künstlicher Intelligenz

Verbessern Sie die Genauigkeit von KI und LLM mit ClickUp

RAG-Power-Antworten, die durch neue externe Daten und Fine-Tuning optimiert wurden, werden für bestimmte Aufgaben und Verhaltensweisen verwendet. Beide verbessern die KI-Leistung, aber der richtige Ansatz bestimmt Ihr Tempo und Ihre Effizienz.

In dynamischen Branchen hängt die Entscheidung oft davon ab, welche Methode zuerst angewendet werden soll. Eine leistungsstarke, vorab trainierte Lösung ist in der Regel die klügere Wahl.

Wenn Sie die Servicequalität und Produktivität verbessern möchten, ist ClickUp ein hervorragender Partner. Seine KI-Fähigkeiten treiben die Generierung von Inhalten, den Abruf von Daten und analytische Antworten voran. Darüber hinaus verfügt die Plattform über mehr als 30 Tools, die alles von der Aufgabenverwaltung bis zur Erstellung beeindruckender Grafiken abdecken.

Melden Sie sich noch heute bei ClickUp an!