「新しさが感じられる」という感覚は、ワークフローが期待外れだった瞬間に消え去ります。これは誰にでも起こり得ることです。実際、チームの約60%が経験しており、従来の評価方法では結果が得られていないことが明らかです。

リスクを早期に発見し、適切な対応を取る方法が必要です。本ガイドでは、/AIを活用したソフトウェア評価手法を通じて、導入決定後に発生する運用リスクや導入障壁を事前に見極める方法を解説します。ツールの検証と潜在リスクの可視化を実現するフレームワークを提供するとともに、ClickUpを活用した評価プロセスの体系化手法についても説明します。🔍

AIを用いたソフトウェア評価とは何か?

AIを活用したソフトウェア評価とは、購入プロセスにおいてAIを調査・意思決定の基盤として活用することです。ベンダーサイトやレビュー、ドキュメント、デモを手動で確認する代わりに、AIを活用して選択肢を一貫して比較し、ベンダーの主張を早期に検証できます。

評価対象が複数のツールや意見に分散している場合に特に重要です。AIはそれらの情報を単一のビューに統合し、手動レビューでは見落としがちなギャップや矛盾を可視化します。さらに、AIおよび一般的なソフトウェア機能についてベンダーから明確な回答を得るための具体的な質問項目を洗練させます。

従来のソフトウェア評価とAI支援型アプローチを比較すると、その違いがより明確になります。

従来のソフトウェア評価 vs. AI支援評価

従来のソフトウェア評価では、散在するベンダーページや矛盾するレビューから候補を寄せ集めることが多く、結局は同じ基本質問に戻り、決断を急ぐまさにそのタイミングで詳細を再確認することになります。

これが、購入者の83%が途中で当初のベンダーリストを変更する理由です。これは、入力情報が断片化されていると初期判断がいかに不安定になり得るかを示す明確な兆候です。AIを活用して事前に情報を統合し、最初から全てのツールに同じ厳格な基準を適用することで、この手戻りを回避できます。

| 従来型評価 | AIを活用した評価手法 |

|---|---|

| タブやスプレッドシート間で機能を比較する | 単一のプロンプトから並列比較を生成する |

| レビューを個別に読む | 複数の情報源にわたる感情と繰り返し現れるテーマを要約する |

| RFP質問を手動で作成する | 定義された基準に基づくベンダー質問票の作成 |

| 基本的な事項を明確にする営業電話を待つ | 公開ドキュメントやナレッジベースに対するクエリを直接実行する |

この区別を念頭に置けば、評価ライフサイクル全体を通じてAIが最も重要性を増す箇所を明確に把握しやすくなります。

評価ライフサイクルにおけるAIの位置付け

AIは、大量の入力データが容易に誤解されがちな発見・比較・検証段階で最も有用です。特に大量データの中から初期仮説を検証する発見・比較段階において、その真価を発揮します。

初期段階では、AIは問題定義と評価基準の明確化を支援します。その後、戦略立案者の役割へと移行し、調査結果を統合し、ステークホルダーへの意思決定伝達を担います。

AIは一次的な統合レイヤーとして最も効果を発揮します。最終的な判断には、文書・契約書・試用版における重要な主張の検証が依然として必要です。

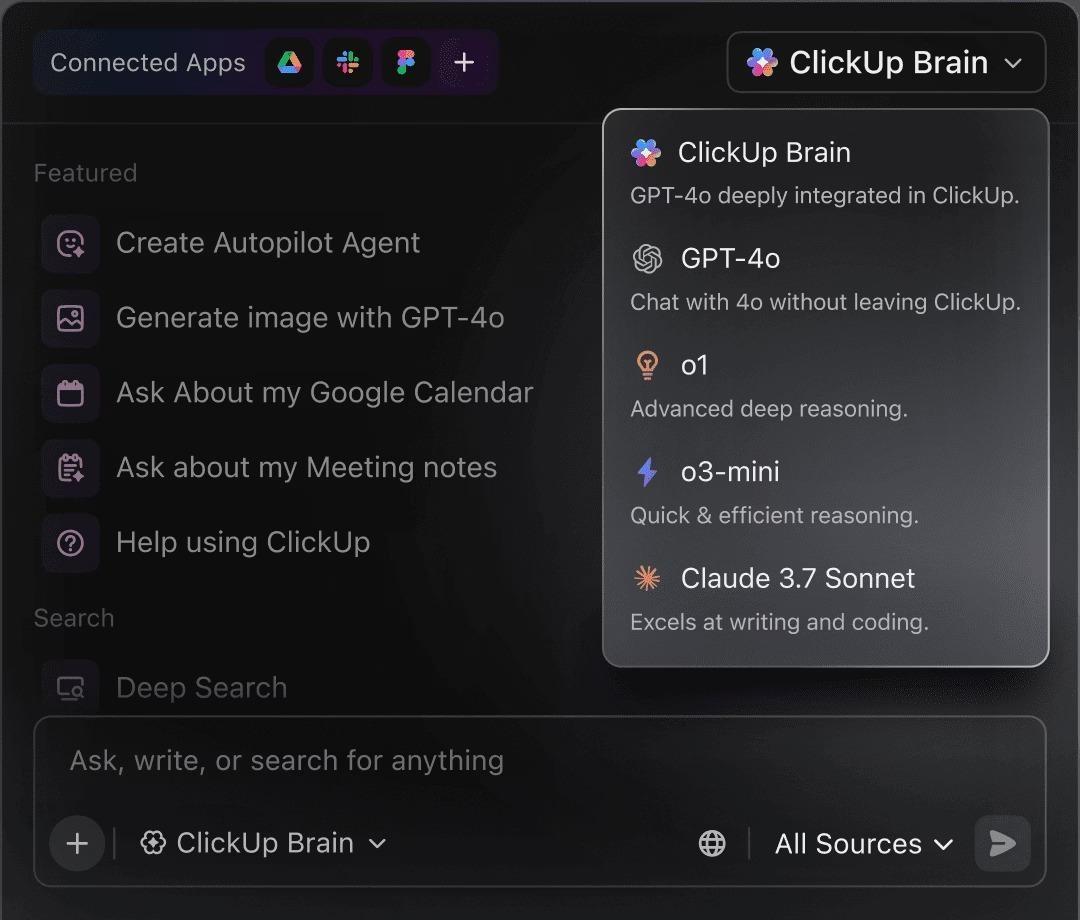

📮 ClickUpインサイト:アンケート回答者の88%が個人タスクにAIを活用している一方、50%以上が仕事での使用を避けています。 主な障壁は?シームレスな統合の欠如、知識不足、セキュリティ懸念の3点です。しかし、AIがワークスペースに組み込まれ、既に安全性が確保されていたら?ClickUp Brain(ClickUp内蔵AIアシスタント)がこれを実現します。平易な言語でのプロンプトを理解し、AI導入の3大懸念を解決。さらにチャット・タスク・ドキュメント・ナレッジをワークスペース全体で接続させます。ワンクリックで答えと洞察を見つけましょう!

ソフトウェア評価にAIを活用する理由

AIは調査の負担を軽減し、ツール全体に一貫した視点をもたらすため、評価結果の比較や説明が容易になります。その効果は主に以下の形で現れます:

- スピード:複数の情報源に対して並行してクエリを投げることで、手動調査に要する数日~数週間を短縮

- 対象範囲: 手動レビューでは見落としがちな、あまり知られていないツールや早期警告サインを明らかにします

- 一貫性:プロセス途中で基準を変えず、すべての選択肢を同じ基準で評価する

- ドキュメント: ステークホルダーが確認・検証できる明確な要約と比較ビューを生成

🔍 ご存知ですか?チャットボットからAIエージェント(複数ステップのタスクを計画・実行できるシステム)への移行により、調達とソフトウェアの効率が25%から40%向上すると予測されています。

🔍 ご存知ですか?チャットボットからAIエージェント(複数ステップのタスクをプランニング・実行できるシステム)への移行により、調達とソフトウェアの効率が25%から40%向上すると予測されています。

AIソフトウェア評価に新たな質問が必要な理由

AI駆動型ツールを審査する際、従来の機能やコンプライアンスチェックリストだけでは不十分です。標準的な評価基準は通常、ツールの「機能」に焦点を当てますが、AIはレガシーフレームワークでは捉えきれない変動性とリスクをもたらします。

優先すべき質問の在り方を変える:

- モデルの非透明性:推論プロセスの可視性が完全ではない場合、出力結果が生成される仕組みを理解する

- データ取り扱い:企業データの保存方法、再利用方法、またはトレーニングへの使用方法を明確にする

- 出力のばらつき:同じプロンプトで異なる結果が生成される場合の一貫性をテストする

- 迅速な反復: デモ、試用版、本番環境での使用における動作の変化を考慮する

- 統合の深さ: AI機能が単体の機能ではなく、実際のワークフローをサポートしていることを確認する

端的に言えば、AIソフトウェアの評価は表面的なチェックよりも、動作・制御・長期的な適合性に関する質問に重点を置くべきです。

AIソフトウェア評価時に確認すべき13の質問

これらの質問をAIベンダーの共有質問票として活用し、導入前に回答を並べて比較できるようにしてください。導入後ではなく、導入前に回答を並べて比較できるようにしてください。

| 確認すべき質問 | 強力な回答の具体例 |

|---|---|

| 1) AIが扱うデータの種類と保存場所は? | 「当社がアクセスする入力データ、その保存場所(リージョンオプション)、暗号化方法、および保持期間についてご説明します。」 |

| 2) 現在または将来的に、当社のデータがトレーニングに使用されることはありますか? | 「デフォルトで無効。トレーニングはオプトインのみであり、契約書/DPAにもその旨が明記されています。」 |

| 3) ベンダー側で誰が当社データにアクセスできますか? | 「アクセス権限は役割ベースで監査され、特定の機能に限定されています。アクセス記録と確認方法はこちらです。」 |

| 4) 機能を支えるモデルはどれか?バージョンは黙って変更されるのか? | 「当社が使用するモデル、そのバージョン管理方法、および動作変更時の通知方法について」 |

| 5) AIが判断に迷った場合、どうなりますか? | 「推測する代わりに、確信の兆候を見極め、説明を求め、安全に後退する」 |

| 6) 同じプロンプトを2回実行した場合、同じ結果が得られるでしょうか? | 「決定論的と可変的なものの違い、そして重要な場面で一貫性を確保するための設定方法」 |

| 7) 実際のコンテキストリミットは何か? | 「実用上のリミット(ドキュメントサイズ/履歴深度)は以下の通りです。文脈が途切れた場合の対応策はこちらです。」 |

| 8) AIが推奨や行動を取った理由を確認できますか? | 「入力値、出力値、そしてなぜXを推奨したかの経緯を確認できます。アクションには監査証跡が残ります。」 |

| 9) 動作前にどのような承認プロセスが存在するのか? | 「高リスクな行動には審査が必要であり、承認は役割ベースで行われ、エスカレーション手順が設けられている。」 |

| 10) チームや役割ごとにどの程度カスタマイズ可能ですか? | 「プロンプトやテンプレートを標準化し、変更権限を制限し、役割ごとに出力を調整できます。」 |

| 11) 実際のワークフローに統合されるのか、それとも単に「接続」するだけなのか? | 「双方向同期とリアルタイムトリガー/アクションをサポートしています。障害処理と監視方法はこちらです。」 |

| 12) ダウングレードまたは解約した場合、何が機能しなくなり、何をエクスポートできますか? | 「お客様が保持できる情報、エクスポート可能な情報、およびご要望に応じたデータ削除方法について、以下に詳細を明記します。」 |

| 13) 品質を長期的にどのように監視しますか? | 「ドリフトとインシデントを追跡し、評価を実施し、リリースノートを公開し、明確なエスカレーションとサポートプロセスを確立しています。」 |

💡 プロの秘訣: これらの質問への回答を共有AIベンダー質問票に集約し、傾向やトレードオフを把握しましょう。チームは毎回一から始める代わりに、評価ごとに質問票を再利用でき、ワークフロー管理が改善されます。

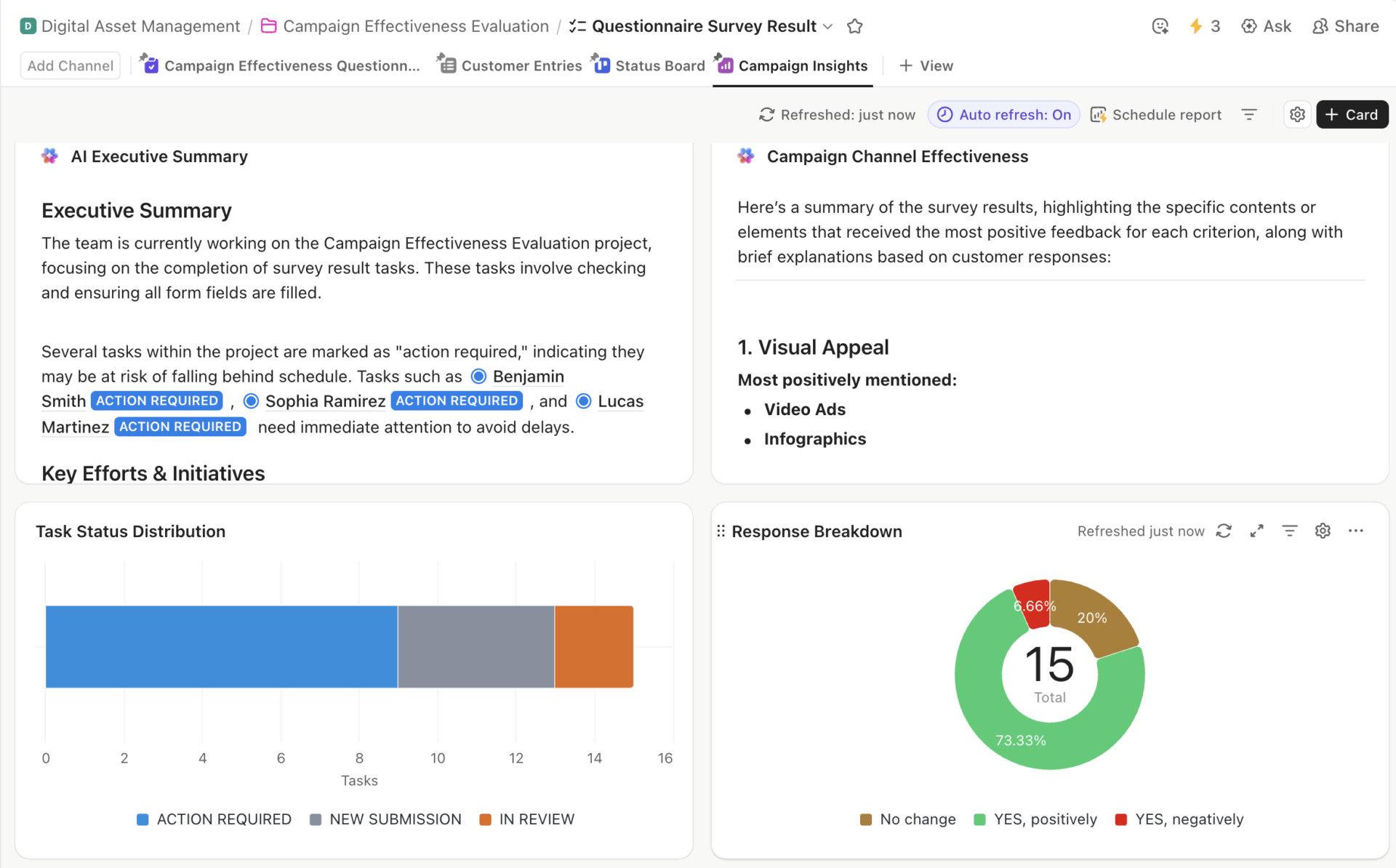

ClickUp質問票テンプレートダッシュボード(AIによるエグゼクティブ要約、タスク配布、チャネル効果、応答内訳を表示)

ClickUpの質問票テンプレートを活用すれば、ベンダーからの回答を一元的に収集し、ツールを並べて比較できる構造化された場所をチームに提供できます。フィールドのカスタマイズや所有者の割り当ても可能なため、プロセスを一から構築し直すことなく、将来の購入時にも同じフレームワークを再利用できます。

ステップバイステップ:AIを活用したソフトウェア評価の方法

以下のフェーズでは、チームがAIを活用してソフトウェア評価を体系化する方法を示します。これにより意思決定の追跡可能性が確保され、後日の検証も容易になります。

フェーズ1:AIを用いたソフトウェア要件の定義(問題認識)

多くの評価はデモを見る前に頓挫します。よくある落とし穴:解決すべき問題自体を明確にしないまま、いきなり比較検討に飛びつくことです。AIがここで最も有用なのは、早い段階で明確化を促すからです。

例えば、マーケティング代理店で「より良いコラボレーション」といった漠然とした目標のもとプロジェクト管理ツールを探していると想像してください。AIはワークフロー、チーム規模、既存の技術スタックに関する具体的な情報をプロンプトすることでその意図を絞り込み、漠然としたアイデアを具体的な要件へと効果的に変換します。

AIを活用して以下のような疑問を掘り下げてみましょう:

- 私のチームが現在直面している具体的なボトルネックは何ですか?

- 当社業界において、どの機能が「必須」で、どの機能が「あれば尚良し」なのか?

- 当社サイズのチームは通常、この目的でどのようなツールを利用していますか?

- これらの要件に対して現実的な予算範囲はどの程度ですか?

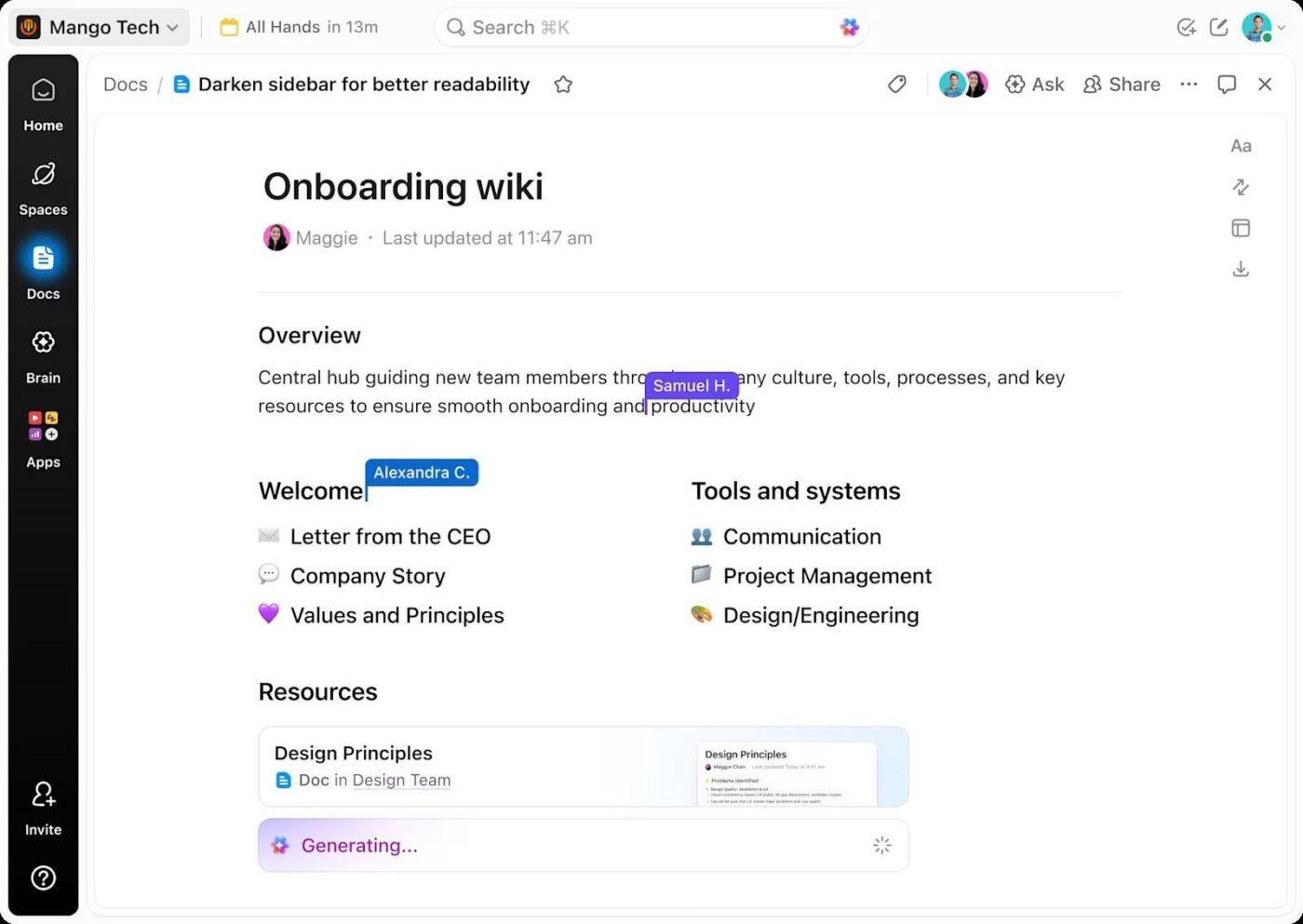

これらの回答の形が具体化するにつれ、実際のニーズに対応しない印象的な機能に惑わされる可能性は低くなります。こうした要件はすべてClickUp Docsに記録でき、単発のチェックリストではなく共有リファレンスとして活用できます。

新しい入力が入ると、文書は進化します:

- ステークホルダーの懸念が明確な制約となる

- 比較開始前に新たに特定されたソフトウェアカテゴリを捕捉

ドキュメントが評価タスクと同じワークスペースに存在するため、文脈がずれることはありません。調査やデモ段階に移行する際、既に検証済みの要件に直接活動をリンクすることが可能です。

📌 成果: 評価プロセスが明確に定義され、次のステップがはるかに焦点化されます。

フェーズ2:AIを活用したソフトウェア選択肢の発見(ソリューション認知)

要件が確定すると、問題の本質が変わる。焦点が「必要なもの」から「現実的に適合するもの」へ移行する。この段階で評価は遅延し、選択肢が広がりつつも曖昧になる。

AIは業界・チームサイズ・予算範囲・主要ワークフローといった基準に選択肢を直接対応させることで、詳細調査前に選択肢の広がりを抑制します。

このフェーズでは、プロンプトは以下のような形になるかもしれません:

- これらの要件に合致するソフトウェアツールはどれですか?

- 当社サイズのチームにとって、[ツール名]に代わる信頼できる代替案は何ですか?

- 代理店向けと企業チーム向けのツールの違いは?

- どの選択肢が大幅な手直しなしで成長をサポートできるか?

管理を容易にするため、ClickUpタスクで各候補ツールを個別アイテムとして追跡できます。各ツールには単一のタスクを設定し、所有者、調査資料へのリンク、AI出力からのメモ、明確な次ステップを記載します。候補ツールの選考状況が前進または除外されるたびに、一箇所でリストが更新されるため、複数の会話記録を追い回す必要がありません。

📌 結果: 実行可能な選択肢を絞り込んだ候補リストが得られます。各候補には所有権と履歴が明確化され、より詳細な比較分析の準備が整います。

フェーズ3:AIを用いた機能と価格の比較(検討段階)

候補リストは新たな問題を生む:比較疲労。機能は明確に一致せず、価格帯は制約を曖昧にし、ベンダーの分類はチームの働き方に合致しない。

AIを活用すれば、各ツールの機能を固有の要件にマッピングし、価格帯を平易な言葉で要約し、大規模運用時のみ顕在化する制約を可視化することで、ツール間の差異を平準化できます。自動化機能の上限やアドオン価格設定といった問題を浮き彫りにし、時間を節約します。

ここで確認すべき質問:

- 各価格帯にはどのような機能が含まれていますか?

- Freeプランやエントリープランではどこにリミットが設けられていますか?

- どの機能が追加費用が発生するか、または拡張性に劣るか?

- ツールの機能はどの部分で重複し、どの部分で意味のある差異があるか?

入力データが揃ったら、ベンダーのマーケティング分類ではなく、本来の要件に沿ってClickUpドキュメントで並列比較テーブルを作成しましょう。

ClickUp Brainを使用すれば、比較結果から直接簡潔な長所・短所の要約を生成できます。これにより解釈がソース資料に紐付けられ、別々のメモや会話に逸れるのを防ぎます。

📌成果:直感ではなく、文書化されたトレードオフに基づいて意思決定範囲を絞り込めます。比較内容と共に論理的根拠が保存されるため、ある選択肢が採用され別の選択肢が除外される理由を明確に指摘しやすくなります。

フェーズ4:AIとの連携性とワークフロー適合性の評価

二つのツールは仕様書上は似ていても、既存のシステム環境では全く異なる挙動を示すことがあります。そのため、新ツールが仕事を簡素化するのか、それとも追加負担を強いるのかを判断することが極めて重要です。

AIが候補ツールを現在のセットアップにマッピング。単なる「連携機能の有無」だけでなく、「実際の業務フロー」を厳密に検証可能。例:CRMでリードが移動した時、サポートチケットが到着した時はどう動作するか?

このフェーズでの質問例は以下の通りです:

- このツールが既存システムと連携した際に、何が問題となるか?

- どの引き継ぎに人間の介入が必要か?

- 自動化はどこで静かに失敗するのか、あるいは片方向のみ同期するのか?

- このツールは調整作業を削減するのか、それとも再配分するのか?

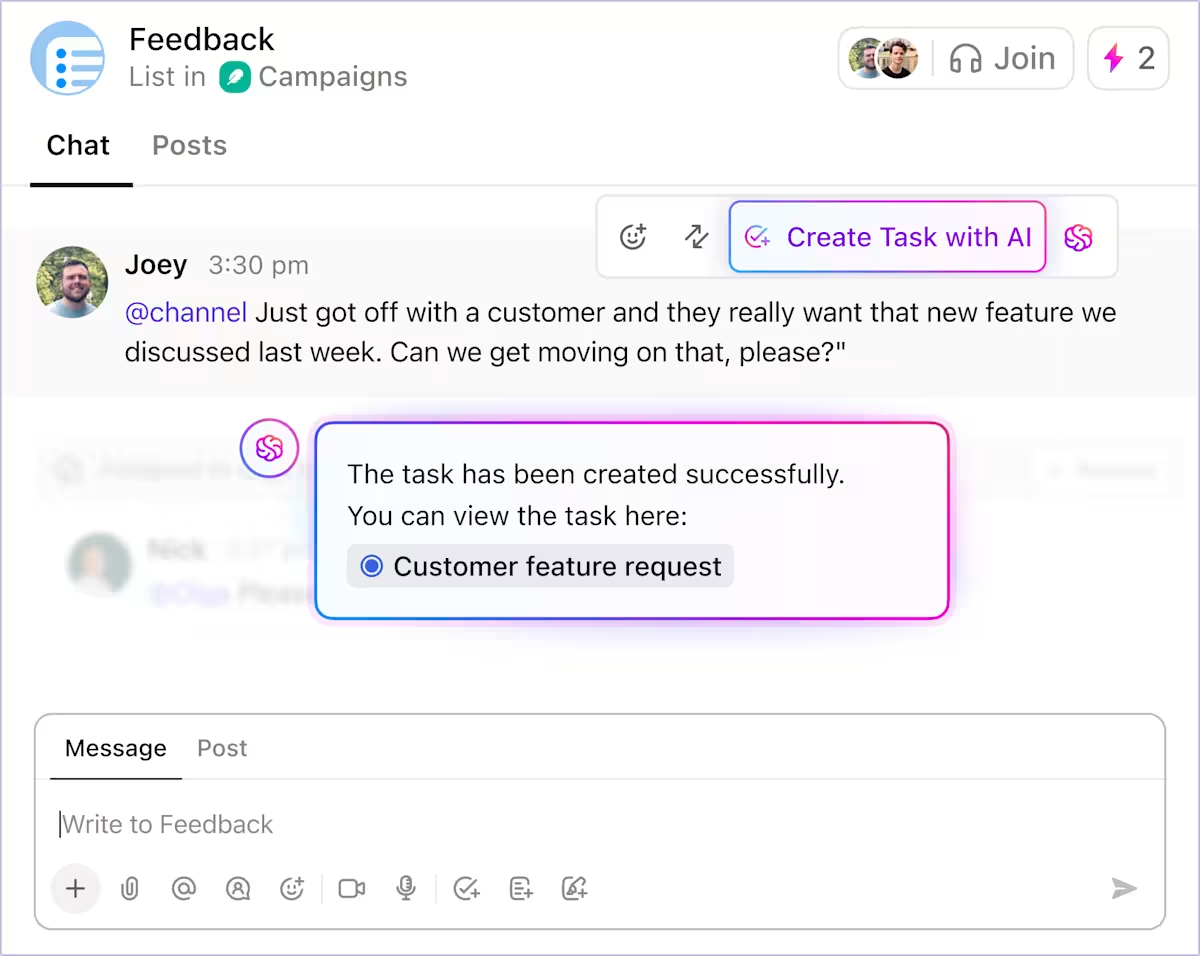

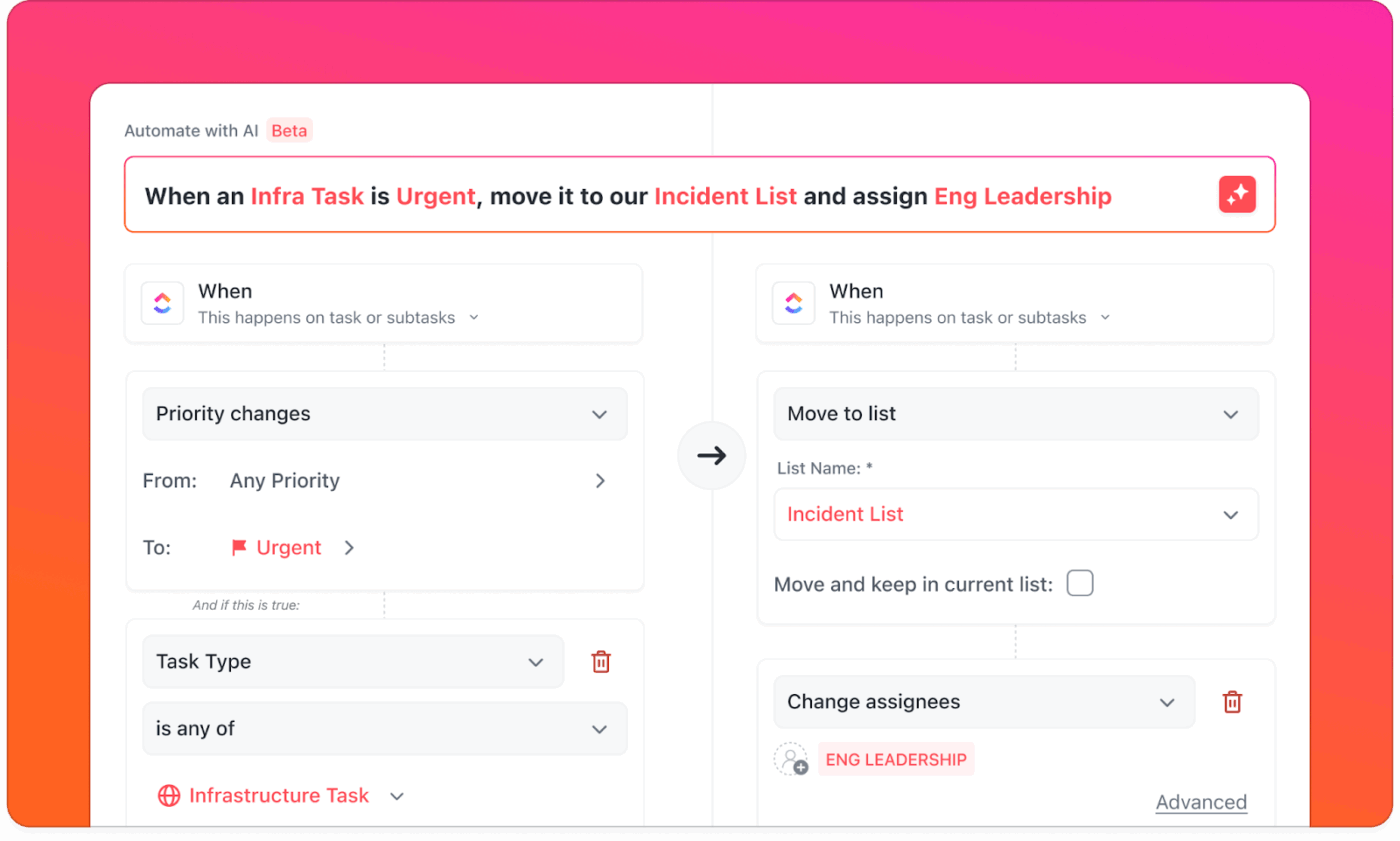

トリガーの欠落や、一見完了しているように見えるが依然として問題を引き起こす統合など、問題が浮き彫りになります。この点においてClickUpは有力な選択肢です。統合と自動化が同一システム内で機能するためです。

ClickUp Integrationsは、Slack、HubSpot、GitHubなど1,000以上のツールと連携し、可視性を拡張します。また、タスク作成、ステータス更新、作業のルーティング、フォローアップのトリガーを、実行が既に発生しているワークスペース内でサポートします。

ClickUp自動化を活用すれば、日常的な移行が監視なしで一貫して実行されるか確認できます。外部ツールの連携設定を省略し、動作を一度定義するだけで、スペース、リスト、ワークフロー全体に適用できます。

📌 成果:このフェーズの終わりまでに、その違いがより明確になります。

- 一部のツールは広範に接続するが、仕事の調整には依然として人的介入が必要

- 他のツールは、その連携機能をワークフロー自体に組み込んでいる

最終的な意思決定においては、この理解が機能の同等性を上回る傾向があります。

フェーズ5:AIによる実環境での使用検証(意思決定段階)

現在、意思決定が機能不足や不明瞭な価格設定に左右されることは稀です。より答えにくいのは、ツールが新鮮さが薄れ実際の使用が始まった後も機能し続けるかどうかです。

AIはここで研究者ではなくパターン発見者として有用です。AIは提供されたレビューソース(G2、ドキュメント、フォーラム)から反復するテーマを要約し、問題がチームのサイズやユースケースごとに集約されるかどうかを検証する手助けをします。

このフェーズでよくある質問には以下が含まれます:

- 導入後数ヶ月でユーザーから報告される問題点は何ですか?

- 使用量が増えるにつれてどのワークフローが問題を抱えるか?

- G2やRedditなどのレビューサイトで繰り返し登場するテーマは何か?

- どのタイプのチームがツール選択を後悔するのか?

AIは導入時の摩擦と構造的なリミットを区別したり、苦情が特定のチームサイズ・業界・ユースケースに集中しているかを可視化できます。こうした文脈分析により、問題が許容範囲のトレードオフか根本的なミスマッチかを判断する手がかりとなります。

インサイトが蓄積されるにつれ、ClickUpダッシュボードでデータを可視化できます。リスク、未解決の質問、導入上の懸念、レビュー担当者の傾向を一元的に追跡。関係者は同じ兆候を確認可能:繰り返される苦情、導入リスク、依存関係、未解決のギャップ。

📌 成果:このフェーズでは、摩擦が生じやすい箇所、最初に影響を受ける関係者、組織がそれを吸収する準備ができているかどうかが明確になります。

フェーズ6:AIによる最終決定と合意形成

現時点では評価作業はほぼ完了していますが、適切な選択肢が明らかであっても、導入後の実践的な運用方法をチームが示せない場合、意思決定は保留状態のままとなる可能性があります。

AIを活用すれば、これまでに学んだすべてを意思決定可能な成果物に集約できます。これには最終候補を比較したエグゼクティブ要約、受け入れられたトレードオフの明確な表明、摩擦を予測した導入プランが含まれます。

AIが以下のような質問に答えることが期待できます:

- これまでの検討を踏まえ、目標と予算に最も適合する選択肢はどれか?

- 私たちは知っててどんな妥協を受け入れているのか?

- 導入後30日、60日、90日という現実的な期間における展開の具体的な流れは?

- この決定を、精査に耐える形で経営陣にどう説明すればよいでしょうか?

ClickUp Brainは、ドキュメント、比較資料、タスク、フィードバック、リスクといった評価の全コンテキストにアクセスできるため、要約やロールアウトチェックリストを生成し、汎用評価テンプレートの必要性を排除します。別ツールへコンテキストをエクスポートすることなく、経営陣向けメモの起草、オンボーディングプランの作成、成功メトリクスに基づく所有者の連携調整に活用できます。

📌 成果:資料を共有すると会話の質が変わります。関係者が同じ証拠・前提・リスクを一箇所で確認できるため、質問は的を射たものとなり、合意形成がより自然に促進されます。

デモに惑わされないための試用版テスト項目

試用版では機能ではなくワークフローをテストせよ:

- 実際のワークフローを1つ、最初から最後まで実行する(受付→引き継ぎ→承認→レポート作成)

- 実際の役割(管理者、マネージャー、貢献者、ゲスト)で許可をテスト

- セットアップ時間と失敗ポイント(ユーザーが詰まる箇所)を測定する

- 例外処理を強制(引継ぎ中断、必須フィールド未入力、承認遅延)

- 質問:ユーザー数、プロジェクト数、自動化を拡大した際に何が機能しなくなるか?

AIを用いたソフトウェア評価におけるよくある失敗

AIはソフトウェア評価を強化できますが、それは規律を持って使用された場合に限ります。以下の失敗を避けましょう:

- AI出力の検証を怠らない:AIは機能・価格・制限事項を誤解釈する可能性があるため、検証が極めて重要

- 要件定義フェーズの省略: 明確なニーズなしにツールを比較すると、問題解決ではなく機能の追及に陥る

- 連携の深さを軽視する: 主張されている連携機能はデータ同期のみに対応し、継続的なワークフロー管理をサポートしていない可能性がある

- データプライバシーに関する質問の軽視: 不明確なデータアクセス・ストレージ・再利用ポリシーは、下流工程におけるコンプライアンスリスクを生む

- 孤立した評価:ユーザーを早期に除外すると、後々導入時の摩擦が生じやすい

- AI機能とAI能力の混同:後付けのチャットボットは、中核ワークフローに組み込まれたAIと同等の価値を提供しない

AIを活用したソフトウェア評価のベストプラクティス

AIを活用したソフトウェア評価は、以下の実践方法を意思決定プロセス全体に体系的に適用することで最大の効果を発揮します:

ClickUpのような一元管理プラットフォームがあれば、これらのベストプラクティスは簡単に導入できます。

- 段階的に具体的な質問を投げかける: 問題定義から始め、要件・制約・トレードオフが明確になるにつれて質問を絞り込んでいく

- AIの出力を実データで照合:機能・価格・制限事項をベンダー文書や信頼できるレビュー情報源と照合して検証する

- メモ、決定事項、承認を集中管理:要件、調査結果、リスク、承認を1つの共有ワークスペースに集約し、断片化したコンテキストを回避

- ワークフローに基づくツール評価: 孤立した機能の比較ではなく、仕事がエンドツーエンドでどのように進むかに焦点を当てる

ClickUpでソフトウェア決定を運用化する

ソフトウェア評価が失敗するのは、情報が不足しているからではありません。決定が、連携を前提に設計されていないツールや会話、文書に分散してしまうからです。

ClickUpは評価プロセスを一元化。要件定義・調査・比較・承認がシームレスに接続します。ClickUp Docsで要件をドキュメント化し、ベンダーをタスクとして管理。ClickUp Brainで調査結果を要約し、ダッシュボードで経営陣にリアルタイム可視性を提供。SaaSの乱立を招くことなく、効率的な評価を実現します。

評価は実行と並行して行われるため、チームが変更されたりツールの再評価が必要になったりしても、その根拠は可視性を持って監査可能な状態を維持します。購入プロセスとして始まったものが、組織の意思決定プロセスの一部へと発展していくのです。

チームが既にAIでソフトウェア評価を行っている場合、ClickUpはその知見を新たな管理システムを追加することなく、即座にアクションに変換します。

ClickUpを無料で始め、ソフトウェア選択を集中管理しましょう。✨

よくある質問

はい、精度が複数の情報源にわたるパターン、矛盾、欠落情報の発見を意味する場合、AIはソフトウェア評価を支援できます。AIは機能比較、レビュー要約、ベンダー主張のストレステストを大規模に実施でき、これにより初期フェーズから中期フェーズの評価の信頼性が向上します。

曖昧なプロンプトや誤った出力によりバイアスが生じます。明確に定義された要件を用い、比較質問を行い、ドキュメントや試用版などの一次情報源で主張を検証しましょう。

いいえ、AIは選択肢を絞り込み、より鋭いデモ質問を準備することはできますが、実際の操作を再現することはできません。ワークフロー、使いやすさ、チームでの導入状況を実環境でテストするには、デモと試用版が依然として必要です。

効果的なチームは、要件・比較・最終的な判断理由を1つの共有ワークスペースに集約することでソフトウェア決定を文書化します。これにより文脈が保持され、後でツールを見直す際の議論の重複を防ぎます。

AIソフトウェアの回答を評価する際は、曖昧な主張、矛盾した説明、データ処理やモデル動作に関する詳細情報の欠如に注意を払うこと。