Votre modèle IA a-t-il déjà fourni une réponse fiable que vos utilisateurs ont jugée obsolète ? C'est le genre d'expérience qui conduit votre équipe à remettre en question chacune de ses réponses.

Cela ressemble au cauchemar de tout développeur et passionné d'IA, n'est-ce pas ?

Les grands modèles linguistiques (LLM) fonctionnent à partir de données d'entraînement, mais à mesure que les données vieillissent, des inexactitudes s'y glissent. Étant donné que le réentraînement coûte des millions, l'optimisation est la solution la plus judicieuse.

La génération augmentée par la récupération (RAG) et le réglage fin sont les principaux cadres permettant d'améliorer la précision. Cependant, compte tenu des différences entre chaque approche, elles sont idéales pour différentes applications. Le cadre approprié est la clé pour améliorer efficacement votre LLM.

Mais laquelle vous convient le mieux ?

Cet article traite du dilemme entre RAG et Fine-Tuning. Que vous travailliez avec des données spécifiques à un domaine ou que vous cherchiez à créer des solutions de récupération de données de haute qualité, vous trouverez ici les réponses à vos questions !

⏰Résumé en 60 secondes

- L'amélioration des performances des LLM et des modèles d'IA est un élément clé de toutes les fonctions de l'entreprise et de développement. Si le RAG et le fine-tuning sont des approches courantes, il est important de comprendre leurs nuances et leur impact.

- Le RAG permet aux LLM de récupérer des données externes en temps réel, ce qui réduit les coûts de réentraînement.

- Le Fine-Tuning optimise les LLM en les entraînant sur des ensembles de données spécialisés, améliorant ainsi la précision pour les tâches spécifiques à un domaine.

- Le RAG est idéal pour les environnements de données en constante évolution, tels que la finance, les mises à jour juridiques et le service client.

- Le Fine-Tuning est idéal pour l'IA spécifique à une marque, les secteurs soumis à des contraintes de conformité strictes et l'analyse des sentiments.

- ClickUp Brain combine les deux, en utilisant le RAG pour les informations contextuelles et le Fine-Tuning pour l'automatisation et la génération de contenu sur mesure.

- Les outils alimentés par l'IA de ClickUp optimisent la recherche de connaissances, l'automatisation des flux de travail et la gestion de projet pour une efficacité maximale.

Qu'est-ce que la génération augmentée par la récupération (RAG) ?

Vous examinez de nouveaux rapports et sondages que votre LLM n'a pas pris en compte ? C'est là que vous avez besoin du RAG. Pour mieux comprendre, voyons les principes de base de cette approche.

Définition du RAG

Le RAG est un cadre d'IA qui implique la recherche d'informations supplémentaires pour votre LLM afin d'améliorer la précision des réponses. Avant la génération de réponses LLM, il extrait les données les plus pertinentes à partir de sources externes, telles que des sources de connaissances ou des bases de données.

Considérez-le comme l'assistant de recherche au sein du LLM ou du modèle d'IA générative.

👀 Le saviez-vous ? Les LLM, en particulier les générateurs de texte, peuvent générer des informations fausses mais plausibles. Tout cela à cause de lacunes dans les données d'entraînement.

Principaux avantages du RAG

Cela semble désormais clair. Le RAG est une couche supplémentaire d'IA connectée dont votre processus d'entreprise a besoin. Pour mettre en lumière son potentiel, voici les avantages qu'il offre :

- Réduction des coûts de formation : élimine le besoin de reformer fréquemment les modèles grâce à sa récupération dynamique d'informations. Cela permet un déploiement plus rentable de l'IA, en particulier pour les domaines où les données évoluent rapidement.

- Évolutivité : élargit les connaissances du LLM sans augmenter la taille du système principal. Cela aide les entreprises à évoluer, à gérer de grands ensembles de données et à exécuter davantage de requêtes sans coûts informatiques élevés.

- Mises à jour en temps réel : reflète les dernières informations dans chaque réponse et maintient la pertinence du modèle. La priorité accordée à la précision grâce aux mises à jour en temps réel est essentielle dans de nombreuses opérations, notamment l'analyse financière, les soins de santé et les audits de conformité.

📮 ClickUp Insight : La moitié de nos répondants ont des difficultés à adopter l'IA ; 23 % ne savent tout simplement pas par où commencer, tandis que 27 % ont besoin de plus de formation pour pouvoir faire des tâches avancées.

ClickUp résout ce problème grâce à une interface de chat familière qui ressemble à celle d'une messagerie instantanée. Les équipes peuvent se lancer directement avec des questions et des demandes simples, puis découvrir naturellement des fonctionnalités d'automatisation et des flux de travail plus puissants au fur et à mesure, sans la courbe d'apprentissage intimidante qui freine tant de personnes.

Cas d'utilisation du RAG

Vous vous demandez dans quels cas le RAG est particulièrement efficace ? Voici quelques cas d'utilisation clés :

Chatbots et service client

Les requêtes des clients nécessitent souvent des réponses actualisées et adaptées au contexte. Le RAG améliore les capacités des chatbots en récupérant les derniers articles d'assistance, politiques et étapes de dépannage.

Cela permet une assistance plus précise et en temps réel sans formation préalable approfondie.

Récupération dynamique de documents

Le RAG optimise la recherche de documents en extrayant les sections les plus pertinentes de vastes référentiels. Au lieu de résumés génériques, les LLM peuvent fournir des réponses précises à partir de manuels, d'articles de recherche ou de documents juridiques mis à jour.

L'adoption de LLM basés sur la technologie RAG rend la recherche d'informations plus rapide et plus précise.

🧠 Anecdote : Meta, propriétaire de Facebook, Instagram, Threads et WhatsApp, a introduit le RAG dans le développement des LLM en 2020.

Qu'est-ce que le Fine-Tuning ?

Voyons ce que fait le Fine-Tuning.

Définition du fine-tuning

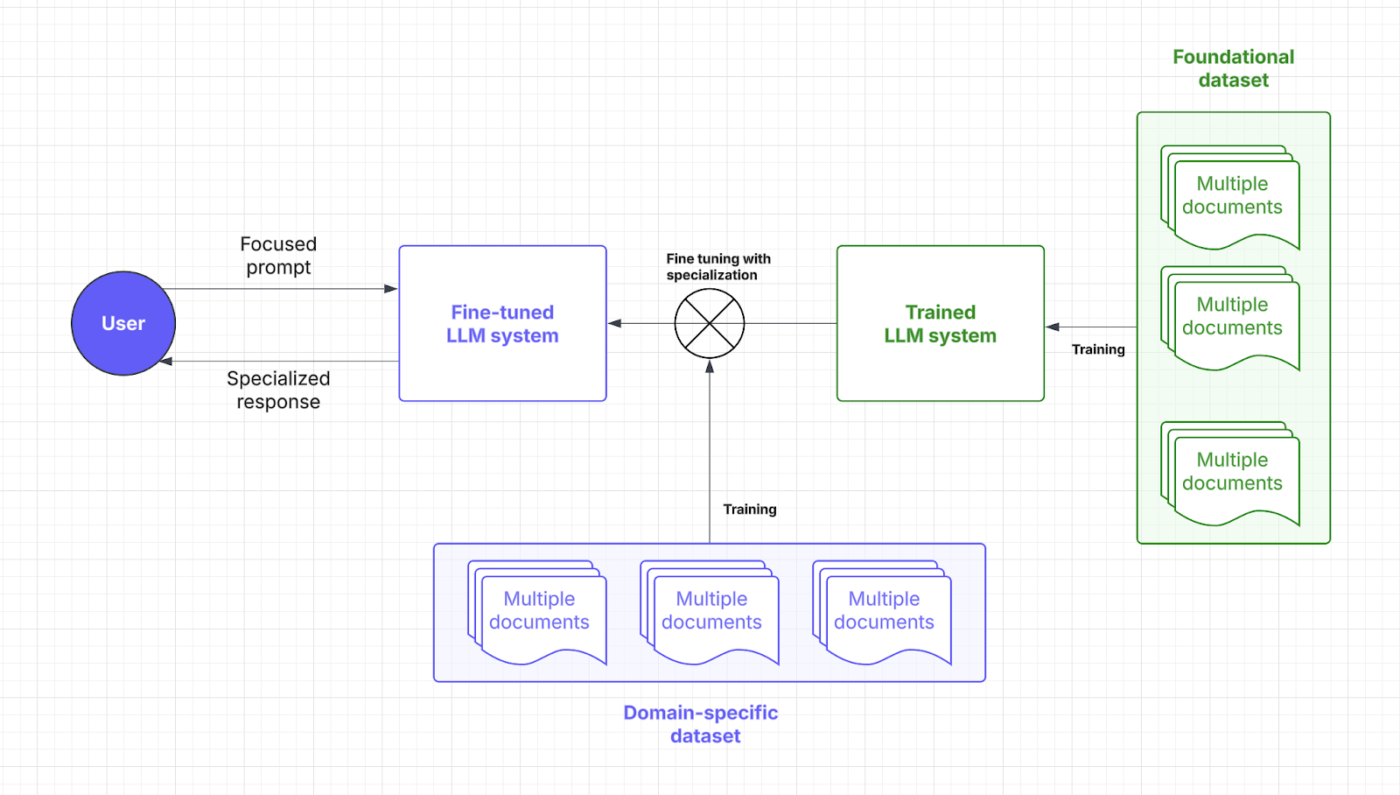

Le Fine-Tuning consiste à entraîner un modèle linguistique pré-entraîné. Oui, cela nécessite beaucoup d'entraînement, ce qui peut s'expliquer par le point et le focus.

🧠 Le saviez-vous ? Dans l'entraînement des modèles linguistiques à grande échelle (LLM), les « poids » sont les paramètres ajustables au sein du réseau neuronal qui déterminent la force des connexions entre les neurones, stockant essentiellement les informations apprises ; le processus d'entraînement optimise ces poids afin de minimiser les erreurs de prédiction.

Le « focus », quant à lui, englobe plusieurs aspects : il implique une curation minutieuse des données afin d'en garantir la qualité et la pertinence, l'utilisation de mécanismes d'attention pour hiérarchiser les segments d'entrée pertinents, et le fine-tuning ciblé afin de spécialiser le modèle pour des tâches spécifiques.

Grâce à des ensembles de données spécialisés, le Fine-Tuning permet aux modèles d'IA de se concentrer sur l'exécution de tâches spécifiques à un domaine. En ajustant les pondérations et l'orientation du modèle, votre LLM gagne en compréhension contextuelle et en précision.

Considérez le Fine-Tuning comme le master dont votre LLM a besoin pour parler le langage de votre secteur. Voyons à quel moment cette stratégie d'IA intervient dans le processus de réponse rapide :

Avantages du Fine-Tuning

Les techniques de réglage fin ne sont que des ajustements de l'IA. Elles permettent plutôt de zoomer sur des détails prédéfinis. Voici les avantages qu'elles offrent :

- Optimisation spécifique à une tâche : des ensembles de données spécialisés affinent les réponses du LLM pour des tâches spécifiques. Vous souhaitez aider les utilisateurs à éviter les difficultés liées aux invites complexes ? Le Fine-Tuning aide les développeurs à obtenir des solutions d'IA sur mesure.

- Précision améliorée pour les applications de niche : la connaissance du domaine réduit les erreurs et améliore la précision de chaque réponse. Le Fine-Tuning augmente également la fiabilité d'un LLM, permettant aux entreprises de se détendre en matière de microgestion et de supervision manuelle.

- Personnalisation pour la voix de la marque et la conformité : le Fine-Tuning enseigne aux LLM les termes, le style et les réglementations de l'entreprise. Cela permet de maintenir une voix de marque cohérente et une conformité spécifique à l'industrie.

➡️ À lire également : Techniques d'IA : maîtriser le machine learning, le deep learning et le NLP

Cas d'utilisation du Fine-Tuning

Votre processus de réglage fin débloque une efficacité ciblée. Voici ses points forts :

Systèmes de contrôle qualité spécifiques à un domaine

Des secteurs tels que le droit, la santé et la finance s'appuient sur des réponses IA précises et adaptées à leur domaine. Le Fine-Tuning dote les LLM de connaissances spécialisées, garantissant ainsi la précision des réponses aux questions (QA).

Un assistant juridique basé sur l'IA, par exemple, peut interpréter les contrats avec plus de précision, tandis qu'un chatbot médical peut fournir des conseils basés sur les symptômes à l'aide de jeux de données fiables.

Analyse des sentiments et flux de travail personnalisés

Les entreprises utilisent un modèle affiné pour surveiller les marques, analyser les commentaires des clients et automatiser les flux de travail adaptés à leurs besoins opérationnels spécifiques. Un outil alimenté par l'IA peut détecter les nuances dans les avis sur les produits, aidant ainsi les entreprises à affiner leurs offres.

Dans le domaine des ressources humaines, la combinaison du Fine-Tuning et du traitement du langage naturel aide l'IA à analyser les sondages auprès des employés et à signaler les problèmes sur le lieu de travail avec une meilleure compréhension du contexte.

💡 Conseil de pro : le Fine-Tuning peut impliquer l'ajout de données plus diversifiées afin d'éliminer les biais potentiels. Il ne s'agit pas exactement d'une application spécifique à un domaine, mais elle n'en reste pas moins cruciale.

Comparaison : RAG ou Fine-Tuning

Il est indéniable que ces deux stratégies d'IA visent à améliorer les performances.

Mais le choix semble encore assez difficile, n'est-ce pas ? Voici une analyse comparative entre le Fine-Tuning et le RAG pour vous aider à prendre la bonne décision pour vos investissements LLM.

| Aspect | RAG (génération augmentée par la récupération) | Fine-tuning |

| Définition | Permet au LLM de récupérer en temps réel des données pertinentes provenant de sources externes grâce à son système dédié. | Entraîne un modèle pré-entraîné avec des ensembles de données spécialisés pour des tâches spécifiques à un domaine. |

| Performances et précision | Idéal pour la récupération de données en temps réel, mais la précision dépend de la qualité des données externes. | Améliore la précision contextuelle et les réponses spécifiques à une tâche. |

| Coût et ressources nécessaires | Une approche plus rentable dès le départ se concentre sur l'accès aux données en temps réel. | Nécessite davantage de ressources pour la formation initiale, mais est rentable à long terme. |

| Maintenance et évolutivité | Très évolutif et flexible, mais a une dépendance vis-à-vis de la fréquence des mises à jour des sources externes. | Nécessite des mises à jour et une maintenance fréquentes, mais offre des performances stables à long terme. |

| Cas d'utilisation | Chatbots, recherche dynamique de documents, analyse en temps réel | Systèmes de contrôle qualité spécifiques à un domaine, analyse des sentiments et personnalisation de la voix de la marque |

| Quand choisir | Données en constante évolution, mises à jour en temps réel et priorité accordée aux coûts des ressources | Segments de clientèle de niche, logique spécifique à un domaine, personnalisation personnalisée pour une marque |

| Idéal pour | Les industries ont besoin d'informations précises en temps réel (finance, juridique, service client). | Secteurs nécessitant un langage, une conformité ou un contexte spécifiques (santé, droit, ressources humaines) |

Vous avez besoin d'un peu plus de clarté pour dissiper vos doutes ? Voici une comparaison directe des aspects clés qui ont un impact sur vos besoins.

Performances et précision

En termes de performances, le RAG joue un rôle clé en récupérant de nouvelles données provenant de sources de données externes. Sa précision et ses temps de réponse dépendent de la qualité de ces données. Cette dépendance vis-à-vis de bases de données externes permet au RAG de fournir efficacement des informations à jour.

Le Fine-Tuning, quant à lui, améliore la manière dont le modèle traite et répond grâce à un réentraînement spécialisé. Ce processus permet d'obtenir des réponses plus précises sur le plan contextuel, en particulier pour les applications de niche. Les LLM optimisés sont idéaux pour assurer la maintenance de la cohérence dans les secteurs soumis à des exigences strictes, tels que la santé ou la finance.

Conclusion : le RAG est idéal pour les données en temps réel et le Fine-Tuning pour des réponses contextuellement précises.

Un utilisateur de Reddit déclare :

Si vous utilisez un petit modèle et une bonne base de données dans le pipeline RAG, vous pouvez générer des ensembles de données de haute qualité, supérieurs à ceux obtenus à partir d'une IA de haute qualité.

Si vous utilisez un petit modèle et une bonne base de données dans le pipeline RAG, vous pouvez générer des ensembles de données de haute qualité, supérieurs à ceux obtenus à partir d'une IA de haute qualité.

💡 Conseil de pro : pour orienter votre LLM vers un résultat spécifique, concentrez-vous sur une ingénierie efficace et rapide en ce qui concerne les invites et les instructions.

Coût et ressources nécessaires

Le RAG est généralement plus rentable au départ, car il ajoute uniquement une couche pour la récupération de données externes. En évitant de devoir réentraîner l'ensemble du modèle, il s'avère être une option beaucoup plus économique, en particulier dans les environnements dynamiques. Cependant, les coûts opérationnels liés à l'accès et au stockage des données en temps réel peuvent s'accumuler.

Le Fine-Tuning nécessite davantage de préparation des ensembles de données et de ressources de formation, mais constitue un investissement à long terme. Une fois optimisés, les LLM nécessitent moins de mises à jour, ce qui permet d'obtenir des performances prévisibles et de réaliser des économies. Les développeurs doivent mettre en balance l'investissement initial et les dépenses opérationnelles courantes.

Conclusion : le RAG est rentable, simple à mettre en œuvre et offre des avantages rapides. Le Fine-Tuning nécessite beaucoup de ressources au départ, mais améliore la qualité du LLM et permet de réduire les coûts opérationnels à long terme.

💡 Conseil de pro : votre système RAG n'est aussi intelligent que les données qu'il utilise. Veillez à ce que vos sources de données soient fiables et contenaient des données précises et à jour !

Maintenance et évolutivité

Le RAG offre une excellente évolutivité, car il se concentre principalement sur l'expansion de la source externe. Sa flexibilité et son adaptabilité le rendent parfait pour les secteurs en constante évolution. Cependant, sa maintenance dépend de la fréquence des mises à jour des bases de données externes.

Le Fine-Tuning nécessite une maintenance assez fréquente, en particulier lorsque les informations spécifiques au domaine changent. Bien qu'il exige davantage de ressources, il offre une plus grande cohérence dans le temps et nécessite progressivement moins d'ajustements. Cela dit, l'évolutivité du Fine-Tuning est beaucoup plus complexe, car elle implique des ensembles de données plus volumineux et plus diversifiés.

Conclusion : le RAG est idéal pour une mise à l'échelle rapide et un réglage fin, pour une maintenance minimale et des performances stables.

Un utilisateur de Reddit ajoute :

Lorsque la tâche est de petite envergure, il est souvent plus efficace d'utiliser un modèle plus grand plutôt que d'affiner un modèle plus petit.

Lorsque la tâche est de petite envergure, il est souvent plus efficace d'utiliser un modèle plus grand plutôt que d'affiner un modèle plus petit.

👀 Le saviez-vous ? Il existe désormais des solutions d'IA capables de sentir les odeurs. Compte tenu de la complexité des parfums, cela nécessite un réglage fin régulier et une récupération de données complexe.

Quelle approche convient le mieux à votre cas d'utilisation ?

Même si vous comprenez les nuances, prendre une décision peut sembler vain sans référence ou contexte apparent. Examinons quelques scénarios d'entreprise mettant en évidence les avantages de chaque modèle d'IA.

Quand choisir le RAG ?

Le RAG aide à alimenter votre LLM avec les faits et informations pertinents, notamment les normes techniques, les registres de ventes, les commentaires des clients, etc.

Comment mettre cela en pratique ? Envisagez les scénarios suivants pour adopter le RAG dans vos opérations :

Cas d'utilisation n° 1 : analyse en temps réel

- Scénario : une entreprise de technologie financière est le fournisseur d'informations sur le marché basées sur l'IA pour les traders. Les utilisateurs posent des questions sur les tendances boursières et le système doit récupérer les derniers rapports de marché, les documents déposés auprès de la SEC et les actualités.

- Pourquoi le RAG l'emporte : les marchés boursiers évoluent rapidement, ce qui rend le réentraînement constant des modèles d'IA coûteux et inefficace. Le RAG garantit la précision des données en ne sélectionnant que les données financières les plus récentes, ce qui réduit les coûts et améliore la précision.

- Règle générale : le RAG devrait être votre stratégie de prédilection pour l'IA traitant des données en évolution rapide. Les applications populaires sont l'analyse des données des réseaux sociaux, l'optimisation énergétique, la détection des menaces de cybersécurité et le suivi des commandes.

Cas d'utilisation n° 2 : vérification des données et conformité réglementaire

- Scénario : un assistant juridique IA aide les avocats à rédiger des contrats et à vérifier leur conformité avec les lois en constante évolution en consultant les derniers textes législatifs, précédents et décisions judiciaires.

- Pourquoi le RAG l'emporte : la vérification des aspects juridiques et commerciaux ne nécessite pas de mises à jour comportementales approfondies. Le RAG fait très bien son travail en extrayant des textes juridiques d'un ensemble de données centralisé en temps réel.

- Règle générale : le RAG excelle dans les analyses basées sur les ressources et les statistiques. Pour en tirer le meilleur parti, vous pouvez utiliser des assistants médicaux basés sur l'IA pour les recommandations de traitement et des chatbots personnalisés pour le dépannage et les mises à jour des politiques.

Vous vous demandez encore si vous avez besoin du RAG dans votre LLM ? Voici une checklist rapide :

- Avez-vous besoin de nouvelles données de haute qualité sans modifier le LLM lui-même ?

- Vos informations changent-elles souvent ?

- Votre LLM doit-il fonctionner avec des informations dynamiques plutôt qu'avec des données d'entraînement statiques ?

- Souhaitez-vous éviter les dépenses importantes et le réentraînement fastidieux des modèles ?

➡️ À lire également : Les meilleurs outils d'ingénierie de prompt pour l'IA générative

Quand le Fine-Tuning est plus efficace

Comme nous l'avons mentionné précédemment, le Fine-Tuning est l'équivalent d'une formation supérieure en IA. Votre LLM peut même apprendre le jargon de votre secteur. Voici un aperçu des domaines dans lesquels il excelle particulièrement :

Cas d'utilisation n° 1 : ajouter la voix et la tonalité de la marque

- Scénario : une marque de luxe crée un concierge IA pour interagir avec ses clients dans un ton raffiné et exclusif. Il doit incarner les tonalités, les tournures de phrases et les nuances émotionnelles spécifiques à la marque.

- Pourquoi le Fine-Tuning l'emporte : le Fine-Tuning aide le modèle d'IA à capturer et à reproduire la voix et le ton uniques de la marque. Il offre une expérience cohérente à chaque interaction.

- Règle générale : le Fine-Tuning est plus efficace si vos LLM doivent s'adapter à une expertise spécifique. Il est idéal pour les jeux immersifs axés sur un genre particulier, les récits thématiques et empathiques, ou même les textes marketing de marque.

🧠 Anecdote : les LLM formés à ces compétences relationnelles excellent dans l'analyse du sentiment et de la satisfaction des employés. Mais seulement 3 % des entreprises utilisent actuellement l'IA générative dans les ressources humaines.

Cas d'utilisation n° 2 : modération du contenu et informations contextuelles

- Scénario : une plateforme de réseaux sociaux utilise un modèle IA pour détecter les contenus préjudiciables. Elle se concentre sur la reconnaissance du langage spécifique à la plateforme, des expressions argotiques émergentes et des violations contextuelles.

- Pourquoi le Fine-Tuning l'emporte : les compétences relationnelles telles que la formulation des phrases dépassent souvent le champ d'application des systèmes RAG. Le Fine-Tuning améliore la compréhension par le LLM des nuances spécifiques à la plateforme et du jargon du secteur, en particulier en matière de modération de contenu.

- Règle générale : il est judicieux de choisir le Fine-Tuning lorsqu'il s'agit de différences culturelles ou régionales. Cela s'étend également à l'adaptation à des termes spécifiques à un secteur, tels que le jargon médical, juridique ou technique.

Vous êtes sur le point d'affiner votre LLM ? Posez-vous les clés suivantes :

- Votre LLM doit-il s'adresser à un segment de clientèle niche ou à un thème de marque particulier ?

- Souhaitez-vous ajouter des données propriétaires ou spécifiques à un domaine à la logique du LLM ?

- Avez-vous besoin de réponses plus rapides sans perdre en précision ?

- Vos LLM fournissent-ils des solutions hors ligne ?

- Pouvez-vous allouer des ressources et une puissance de calcul dédiées au réentraînement ?

Améliorer l'expérience utilisateur est une excellente chose. Cependant, de nombreuses entreprises ont également besoin de l'IA pour augmenter leur productivité afin de justifier des coûts d'investissement élevés. C'est pourquoi l'adoption d'un modèle d'IA pré-entraîné est souvent le choix privilégié par beaucoup.

👀 Le saviez-vous ? L'IA générique a le potentiel d'automatiser le travail, permettant ainsi aux employés de gagner jusqu'à 70 % de temps. Le rôle que joue la demande efficace d'informations à l'IA est donc important !

Comment ClickUp exploite les techniques avancées d'IA

Le choix entre RAG et Fine-Tuning fait l'objet d'un débat assez intense.

Il suffit de parcourir quelques fils de discussion sur Reddit pour être perdu. Mais qui a dit qu'il fallait choisir entre les deux ?

Imaginez disposer de modèles d'IA personnalisables, d'automatisation et de gestion des tâches en un seul endroit. C'est ClickUp, l'application tout-en-un pour le travail. Elle regroupe la gestion de projet, la documentation et la communication d'équipe sous un même toit et est alimentée par une IA de nouvelle génération.

En bref, il excelle dans tous les domaines, en particulier grâce à sa solution d'IA complète : ClickUp Brain.

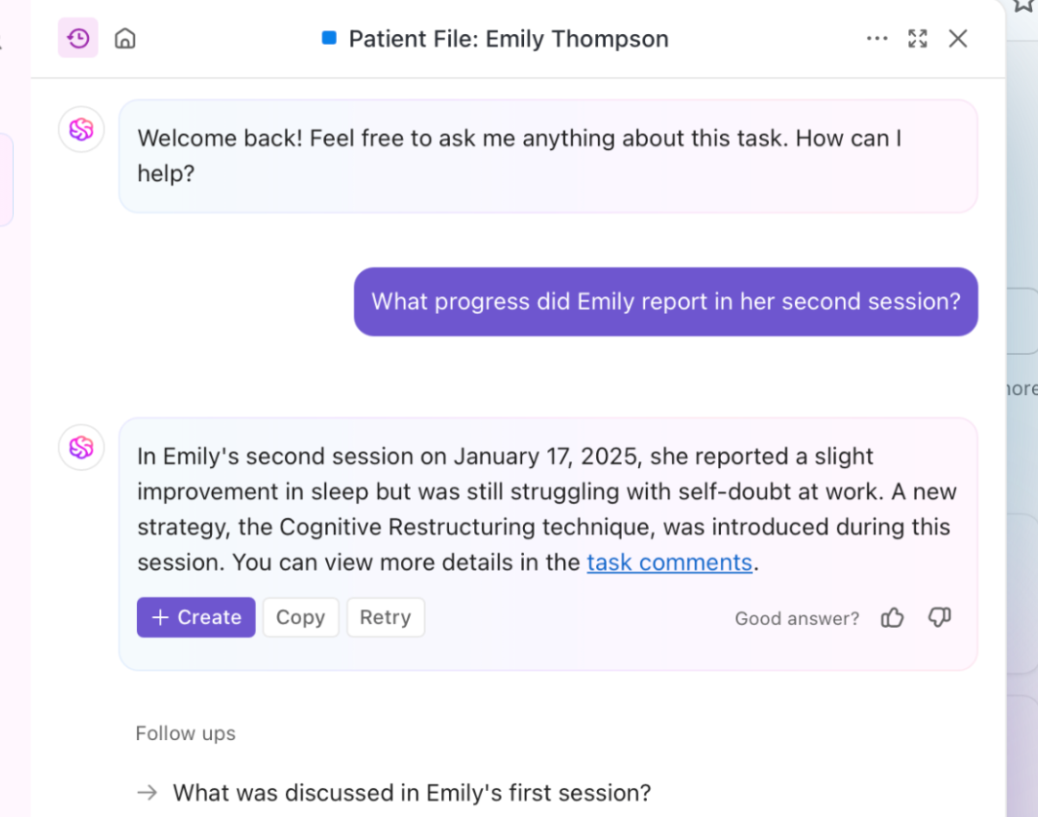

Vous avez besoin d'informations rapides et contextuelles ? Brain extrait des informations en temps réel de vos documents, tâches et ressources. C'est le RAG amélioré en action. De plus, son LLM fondamental, Brain, peut générer des rapports et des mises à jour régulières sur les projets.

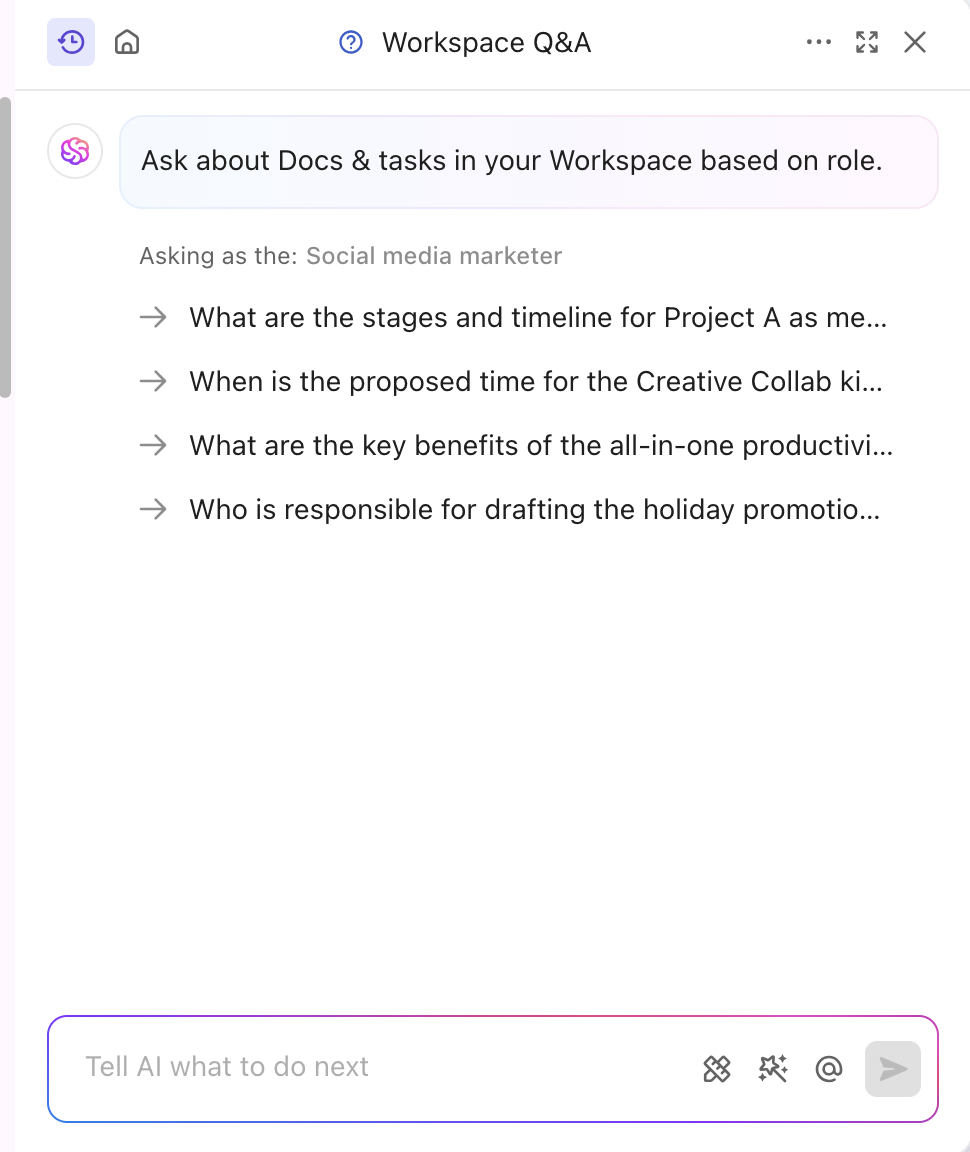

L'outil d'IA est également ajusté pour correspondre à votre secteur et à votre segment, offrant ainsi des informations professionnelles et créatives. Il personnalise même le contenu en temps réel sans aucune formation manuelle. Brain combine le réglage fin et le RAG pour automatiser les mises à jour de projet, l'attribution des tâches et les notifications de flux de travail. Vous souhaitez obtenir des réponses adaptées à votre rôle ? ClickUp Brain peut également le faire !

Outre sa spécialisation dans le contenu, ClickUp dote également sa plateforme d'une puissante fonctionnalité d'IA basée sur la connaissance.

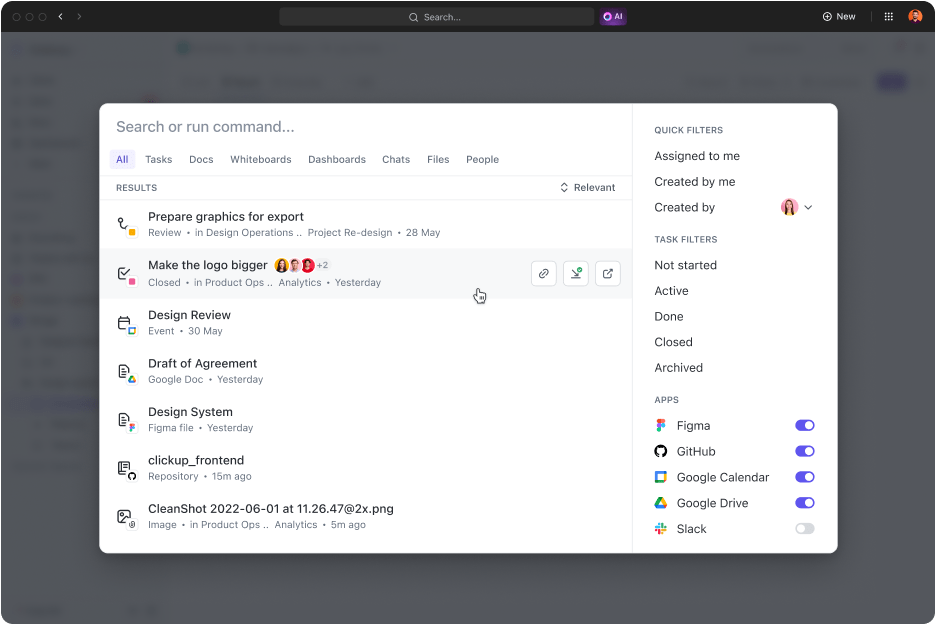

ClickUp Connected Search est un outil alimenté par l'IA qui récupère rapidement toutes les ressources de votre espace intégré. Que vous ayez besoin de documents pour la réunion quotidienne ou de réponses à une tâche, une simple requête vous permet d'obtenir des liens sources, des citations et des informations détaillées.

Il lance également des applications, recherche l'historique de votre bloc-notes et crée des extraits. Le meilleur dans tout ça ? Tout cela est accessible en un seul clic depuis votre centre de commande, votre barre d'actions ou votre bureau.

Les experts en marketing numérique, le président de Hum JAM, affirment même que

ClickUp est l'outil d'automatisation « tout-en-un » le plus incroyable qui soit pour suivre, automatiser et mesurer la réussite de votre équipe. Croyez-moi quand je vous dis que votre équipe ne pourra plus se passer de cet outil.

ClickUp est l'outil d'automatisation « tout-en-un » le plus incroyable qui soit pour suivre, automatiser et mesurer la réussite de votre équipe. Croyez-moi, votre équipe ne pourra plus se passer de cet outil.

➡️ À lire également : La différence entre l'apprentissage automatique et l'intelligence artificielle

Améliorez la précision de l'IA générique et des LLM avec ClickUp

Les réponses puissantes du RAG, affinées par des données externes récentes et le Fine-Tuning, sont utilisées pour des tâches et des comportements spécifiques. Les deux améliorent les performances de l'IA, mais c'est l'approche adéquate qui définit votre rythme et votre efficacité.

Dans les secteurs dynamiques, la décision repose souvent sur la méthode à adopter en premier. Une solution pré-entraînée puissante est généralement le choix le plus judicieux.

Si vous souhaitez améliorer la qualité de vos services et votre productivité, ClickUp est un excellent partenaire. Ses capacités d'IA favorisent la génération de contenu, la récupération de données et les réponses analytiques. De plus, la plateforme est dotée de plus de 30 outils qui couvrent tout, de la gestion des tâches à la création de visuels époustouflants.

Inscrivez-vous dès aujourd'hui sur ClickUp!