O seu modelo de IA já forneceu uma resposta confiável que seus usuários consideraram desatualizada? Esse é o tipo de experiência que faz com que sua equipe questione todas as respostas.

Parece o pesadelo de todo desenvolvedor e entusiasta de IA, certo?

Os grandes modelos de linguagem (LLMs) funcionam com dados de treinamento, mas, à medida que os dados envelhecem, imprecisões começam a surgir. Como o retreinamento custa milhões, a otimização é a opção mais inteligente.

A Retrieval Augmented Generation (RAG) e o ajuste fino são as principais estruturas para aumentar a precisão. No entanto, dadas as diferenças entre cada abordagem, elas são ideais para diferentes aplicações. A estrutura certa é fundamental para melhorar seu LLM de forma eficaz.

Mas qual é o mais adequado para você?

Este artigo aborda o dilema neste guia RAG vs. Fine-Tuning. Quer você esteja trabalhando com dados específicos de um domínio ou procurando construir soluções de recuperação de dados de alta qualidade, você encontrará as respostas aqui!

⏰Resumo de 60 segundos

- Melhorar o desempenho dos LLMs e dos modelos de IA é uma parte fundamental de todas as funções comerciais e de desenvolvimento. Embora o RAG e o ajuste fino sejam abordagens populares, é importante compreender suas nuances e seu impacto.

- O RAG equipa os LLMs com recuperação de dados externos em tempo real, reduzindo os custos de retreinamento.

- O ajuste fino otimiza os LLMs por meio do treinamento em conjuntos de dados especializados, melhorando a precisão para tarefas específicas do domínio.

- O RAG é ideal para ambientes de dados em rápida mudança, como finanças, atualizações jurídicas e suporte ao cliente.

- O ajuste fino é ideal para IA específica da marca, setores com alta exigência de conformidade e análise de sentimentos.

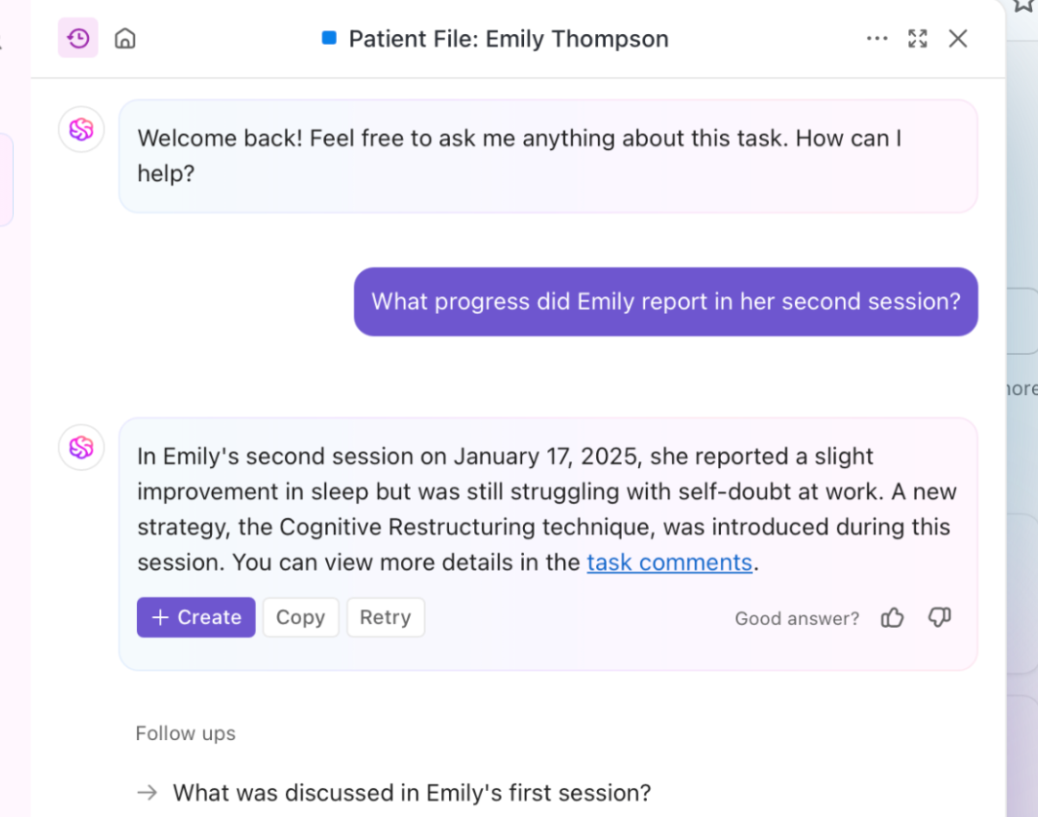

- O ClickUp Brain combina os dois, usando RAG para insights contextuais e ajuste fino para automação personalizada e geração de conteúdo.

- As ferramentas com tecnologia de IA da ClickUp otimizam a recuperação de conhecimento, a automação do fluxo de trabalho e o gerenciamento de projetos para obter a máxima eficiência.

O que é geração aumentada por recuperação (RAG)?

Está analisando relatórios e pesquisas recentes que seu LLM não utilizou? É aí que você precisa do RAG. Para entender melhor isso, vamos abordar os fundamentos dessa abordagem.

Definição de RAG

O RAG é uma estrutura de IA que envolve a recuperação de informações adicionais para o seu LLM, a fim de melhorar a precisão da resposta. Antes da geração da resposta do LLM, ele extrai os dados mais relevantes de fontes externas, como fontes de conhecimento ou bancos de dados.

Pense nisso como o assistente de pesquisa dentro do LLM ou modelo de IA generativa.

👀 Você sabia? Os LLMs, especialmente os geradores de texto, podem ter alucinações, gerando informações falsas, mas plausíveis. Tudo isso devido a lacunas nos dados de treinamento.

Principais vantagens do RAG

Provavelmente já ficou claro. O RAG é uma camada adicional de IA conectada de que seu processo de negócios precisa. Para destacar seu potencial, aqui estão as vantagens que ele oferece:

- Custos de treinamento reduzidos: elimina a necessidade de retreinamento frequente do modelo com sua recuperação dinâmica de informações. Isso leva a uma implantação de IA mais econômica, especialmente para domínios com dados em rápida mudança.

- Escalabilidade: expande o conhecimento do LLM sem aumentar o tamanho do sistema primário. Eles ajudam as empresas a escalar, gerenciar grandes conjuntos de dados e executar mais consultas sem altos custos de computação.

- Atualizações em tempo real: refletem as informações mais recentes em cada resposta e mantêm o modelo relevante. Priorizar a precisão por meio de atualizações em tempo real é vital em muitas operações, incluindo análises financeiras, saúde e auditorias de conformidade.

📮 ClickUp Insight: Metade dos nossos entrevistados tem dificuldade em adotar a IA; 23% simplesmente não sabem por onde começar, enquanto 27% precisam de mais treinamento para fazer qualquer coisa avançada.

O ClickUp resolve esse problema com uma interface de chat familiar que funciona como uma mensagem de texto. As equipes podem começar com perguntas e solicitações simples e, à medida que avançam, descobrir naturalmente recursos de automação e fluxos de trabalho mais poderosos, sem a curva de aprendizado intimidante que impede tantas pessoas.

Casos de uso do RAG

Quer saber onde o RAG se destaca? Considere estes casos de uso importantes:

Chatbots e suporte ao cliente

As consultas dos clientes geralmente exigem respostas atualizadas e contextualizadas. O RAG aumenta os recursos do chatbot, recuperando os artigos de suporte, políticas e etapas de solução de problemas mais recentes.

Isso permite uma assistência mais precisa e em tempo real, sem a necessidade de um pré-treinamento extenso.

Recuperação dinâmica de documentos

O RAG otimiza a pesquisa de documentos, extraindo as seções mais relevantes de vastos repositórios. Em vez de resumos genéricos, os LLMs podem fornecer respostas precisas a partir de manuais atualizados, trabalhos de pesquisa ou documentos jurídicos.

A adoção de LLMs com tecnologia RAG torna a recuperação de informações mais rápida e precisa.

🧠 Curiosidade: a Meta, proprietária do Facebook, Instagram, Threads e WhatsApp, introduziu o RAG no desenvolvimento do LLM em 2020.

O que é o ajuste fino?

Vamos ver o que o ajuste fino faz.

Definição de ajuste fino

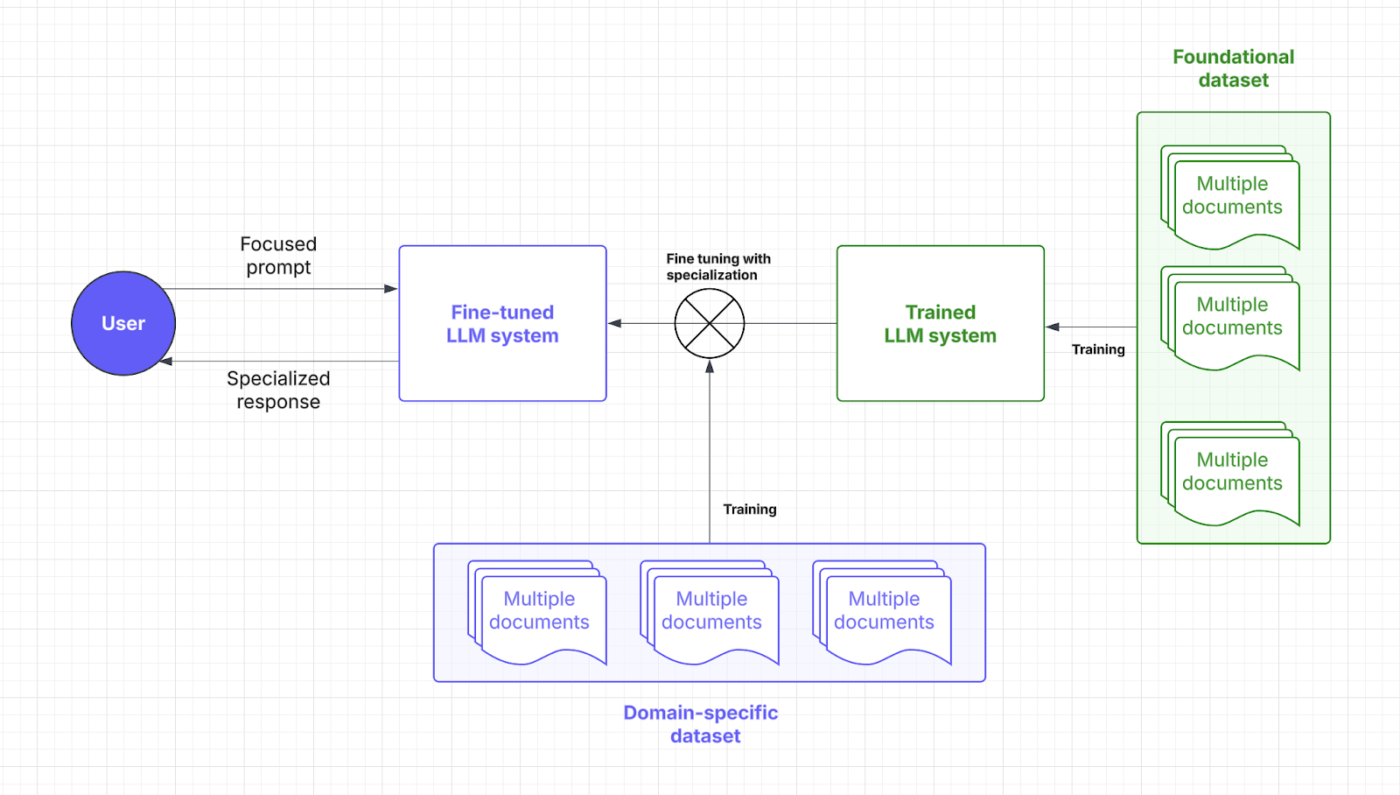

O ajuste fino envolve o treinamento de um modelo de linguagem pré-treinado. Sim, muito treinamento, o que pode ser explicado por meio de pontos e foco.

🧠 Você sabia? No treinamento do Large Language Model (LLM), os “pesos” são os parâmetros ajustáveis dentro da rede neural que determinam a força das conexões entre os neurônios, essencialmente armazenando as informações aprendidas; o processo de treinamento otimiza esses pesos para minimizar os erros de previsão.

Por outro lado, o “foco” abrange vários aspectos: envolve uma curadoria cuidadosa dos dados para garantir qualidade e relevância, a utilização de mecanismos de atenção para priorizar segmentos de entrada relevantes e o ajuste fino direcionado para especializar o modelo para tarefas específicas.

Por meio de conjuntos de dados especializados, o ajuste fino permite que os modelos de IA se concentrem na execução de tarefas específicas do domínio. Ao ajustar os pesos e o foco do modelo, seu LLM ganha mais compreensão contextual e precisão.

Pense no ajuste fino como o mestrado de que o LLM precisa para falar a linguagem do seu setor. Vamos revisar onde essa estratégia de IA entra no processo de resposta imediata:

Benefícios do ajuste fino

As técnicas de ajuste fino são apenas ajustes na IA. É mais como poder ampliar detalhes predefinidos. Aqui estão as vantagens que isso traz:

- Otimização específica para tarefas: conjuntos de dados especializados aprimoram as respostas do LLM para tarefas específicas. Quer ajudar os usuários a evitar o incômodo de prompts complexos? O ajuste fino ajuda os desenvolvedores a obter soluções de IA personalizadas.

- Maior precisão para aplicações de nicho: o conhecimento do domínio reduz erros e aumenta a precisão de cada resposta. O ajuste fino também aumenta a confiabilidade do LLM, permitindo que as empresas relaxem na microgestão e na supervisão manual.

- Personalização para a voz da marca e conformidade: o ajuste fino ensina aos LLMs os termos, o estilo e os regulamentos da empresa. Isso mantém uma voz de marca consistente e a conformidade específica do setor.

Casos de uso do ajuste fino

Seu processo de ajuste fino libera a eficiência direcionada. Veja onde ele se destaca:

Sistemas de controle de qualidade específicos para cada domínio

Setores como o jurídico, de saúde e financeiro dependem de respostas precisas e específicas da IA. O ajuste fino equipa os LLMs com conhecimento especializado, garantindo respostas precisas às perguntas (QA).

Um assistente jurídico de IA, por exemplo, pode interpretar contratos com mais precisão, enquanto um chatbot médico pode fornecer orientações baseadas em sintomas usando conjuntos de dados confiáveis.

Análise de sentimentos e fluxos de trabalho personalizados

As empresas utilizam um modelo ajustado para monitorar marcas, analisar o feedback dos clientes e automatizar fluxos de trabalho adaptados às necessidades operacionais específicas. Uma ferramenta alimentada por IA pode detectar nuances de opinião em avaliações de produtos, ajudando as empresas a refinar suas ofertas.

Em RH, combinar o ajuste fino com o processamento de linguagem natural ajuda a IA a analisar pesquisas com funcionários e sinalizar preocupações no local de trabalho com maior consciência contextual.

💡 Dica profissional: o ajuste fino pode envolver a adição de dados mais diversificados para remover possíveis vieses. Não é exatamente específico do domínio, mas ainda assim é uma aplicação crucial.

Comparação: RAG vs. Ajuste fino

Não há como negar que ambas as estratégias de IA visam aumentar o desempenho.

Mas a escolha ainda parece bastante complicada, certo? Aqui está uma análise detalhada do ajuste fino versus RAG para ajudá-lo a tomar a decisão certa para seus investimentos em LLM.

| Aspecto | RAG (geração aumentada por recuperação) | Ajuste fino |

| Definição | Permite que o LLM recupere dados relevantes em tempo real de fontes externas com seu sistema dedicado. | Treina um modelo pré-treinado com conjuntos de dados especializados para tarefas específicas do domínio. |

| Desempenho e precisão | Ótimo para recuperação de dados em tempo real, mas a precisão depende da qualidade dos dados externos. | Melhora a precisão contextual e as respostas específicas para cada tarefa. |

| Custos e requisitos de recursos | Mais econômico inicialmente, com foco no acesso a dados em tempo real | Requer mais recursos para o treinamento inicial, mas é econômico a longo prazo. |

| Manutenção e escalabilidade | Altamente escalável e flexível, mas depende da frequência das atualizações de fontes externas. | Requer atualizações e manutenção frequentes, mas oferece desempenho estável a longo prazo. |

| Casos de uso | Chatbots, recuperação dinâmica de documentos, análise em tempo real | Sistemas de controle de qualidade específicos para cada domínio, análise de sentimentos e personalização da voz da marca. |

| Quando escolher | Dados em rápida mudança, atualizações em tempo real e priorização dos custos de recursos | Segmentos de clientes de nicho, lógica específica do domínio, personalização específica da marca |

| Ideal para | Os setores precisam de informações precisas em tempo real (finanças, jurídico, suporte ao cliente). | Setores que exigem linguagem, conformidade ou contexto específicos (saúde, jurídico, RH) |

Precisa de um pouco mais de clareza para esclarecer suas dúvidas? Aqui está uma comparação direta dos principais aspectos que afetam suas necessidades.

Desempenho e precisão

Quando se trata de desempenho, o RAG desempenha um papel fundamental ao extrair novos dados de fontes externas. Sua precisão e tempos de resposta dependem da qualidade desses dados. Essa dependência de bancos de dados externos permite que o RAG forneça informações atualizadas de maneira eficaz.

O ajuste fino, por outro lado, melhora a forma como o modelo processa e responde por meio de um retreinamento especializado. Esse processo produz respostas mais precisas contextualmente, especialmente para aplicações de nicho. LLMs ajustados são ideais para manter a consistência em setores com requisitos rigorosos, como saúde ou finanças.

Conclusão: o RAG é ótimo para dados em tempo real e o ajuste fino para respostas contextualmente precisas.

Um usuário do Reddit diz:

Se você estiver usando um modelo pequeno e um bom banco de dados no pipeline RAG, poderá gerar conjuntos de dados de alta qualidade, melhores do que usar resultados de uma IA de alta qualidade.

Se você estiver usando um modelo pequeno e um bom banco de dados no pipeline RAG, poderá gerar conjuntos de dados de alta qualidade, melhores do que usar resultados de uma IA de alta qualidade.

💡 Dica profissional: para orientar seu LLM em direção a um resultado específico, concentre-se em uma engenharia eficaz e rápida.

Custos e requisitos de recursos

O RAG é normalmente mais econômico inicialmente, pois adiciona apenas uma camada para recuperação de dados externos. Ao evitar a necessidade de retreinar todo o modelo, ele surge como uma opção muito mais econômica, especialmente em ambientes dinâmicos. No entanto, os custos operacionais para acesso e armazenamento de dados em tempo real podem aumentar.

O ajuste fino requer mais preparação de conjuntos de dados e recursos de treinamento, mas é um investimento de longo prazo. Uma vez ajustados, os LLMs precisam de menos atualizações, levando a um desempenho previsível e economia de custos. Os desenvolvedores devem ponderar o investimento inicial em relação às despesas operacionais contínuas.

Conclusão: o RAG é econômico, simples de implementar e traz benefícios rápidos. O ajuste fino exige muitos recursos inicialmente, mas melhora a qualidade do LLM e economiza custos operacionais a longo prazo.

💡 Dica profissional: seu sistema RAG é tão inteligente quanto os dados que ele extrai. Mantenha suas fontes limpas e preencha-as com dados precisos e atualizados!

Manutenção e escalabilidade

O RAG oferece excelente escalabilidade, pois o foco é principalmente na expansão da fonte externa. Sua flexibilidade e adaptabilidade o tornam perfeito para setores em rápida evolução. No entanto, a manutenção depende da frequência das atualizações dos bancos de dados externos.

O ajuste fino requer manutenção bastante frequente, especialmente quando as informações específicas do domínio mudam. Embora exija mais recursos, ele oferece maior consistência ao longo do tempo e gradualmente requer menos ajustes. Dito isso, a escalabilidade para o ajuste fino é muito mais complexa, envolvendo conjuntos de dados mais extensos e diversificados.

Conclusão: o RAG é ideal para dimensionamento rápido e ajuste fino, proporcionando manutenção mínima e desempenho estável.

Um usuário do Reddit acrescenta:

Quando a tarefa é pequena, muitas vezes é mais eficiente simplesmente obter um modelo maior do que fazer o ajuste fino de um modelo menor.

Quando a tarefa é pequena, muitas vezes é mais eficiente simplesmente obter um modelo maior do que fazer o ajuste fino de um modelo menor.

👀 Você sabia? Existem soluções de IA que agora podem cheirar. Com a complexidade das fragrâncias, isso envolve muito ajuste fino regular e recuperação de dados complexos.

Qual abordagem é a mais adequada para o seu caso de uso?

Apesar de compreender as nuances, tomar a decisão pode parecer vazio sem uma referência ou contexto aparente. Vamos analisar alguns cenários de negócios destacando como cada modelo de IA funciona melhor.

Quando escolher o RAG

O RAG ajuda a alimentar seu LLM com os fatos e informações corretos, incluindo padrões técnicos, registros de vendas, feedback dos clientes e muito mais.

Como você pode colocar isso em prática? Considere estes cenários para adotar o RAG em suas operações:

Caso de uso nº 1: análise em tempo real

- Cenário: Uma empresa de fintech fornece insights de mercado baseados em IA para traders. Os usuários perguntam sobre as tendências das ações, e o sistema deve buscar os últimos relatórios de mercado, registros da SEC e notícias.

- Por que o RAG é melhor: os mercados de ações se movem rapidamente, portanto, retreinar constantemente os modelos de IA é caro e ineficiente. O RAG mantém as coisas precisas, extraindo apenas os dados financeiros mais recentes, reduzindo custos e aumentando a precisão.

- Regra geral: o RAG deve ser sua estratégia preferencial para IA que lida com dados em rápida mudança. Aplicações populares são análise de dados de mídias sociais, otimização de energia, detecção de ameaças à segurança cibernética e rastreamento de pedidos.

Caso de uso nº 2: verificações de dados e conformidade regulatória

- Cenário: Um assistente jurídico de IA ajuda advogados a redigir contratos e verificar a conformidade com leis em evolução, consultando os estatutos, precedentes e decisões judiciais mais recentes.

- Por que o RAG é melhor: a verificação de aspectos legais e comerciais não requer atualizações comportamentais aprofundadas. O RAG faz esse trabalho muito bem, extraindo textos jurídicos de um conjunto de dados central em tempo real.

- Regra geral: o RAG se destaca em insights baseados em recursos e estatísticas. Ótimas maneiras de maximizar isso seriam usar assistentes de IA médica para recomendações de tratamento e chatbots de atendimento ao cliente para solução de problemas e atualizações de políticas.

Ainda está se perguntando se precisa do RAG no seu LLM? Aqui está uma lista de verificação rápida:

- Você precisa de dados novos e de alta qualidade sem alterar o LLM em si?

- Suas informações mudam com frequência?

- Seu LLM precisa trabalhar com informações dinâmicas em vez de dados de treinamento estáticos?

- Gostaria de evitar grandes despesas e o retreinamento demorado do modelo?

Quando o ajuste fino é mais eficaz

Como mencionamos anteriormente, o ajuste fino é a pós-graduação da IA. Seu LLM pode até aprender o jargão do setor. Aqui está um destaque do setor sobre quando ele realmente se destaca:

Caso de uso nº 1: adicionar voz e tonalidade da marca

- Cenário: Uma marca de luxo cria um concierge de IA para interagir com os clientes em um tom refinado e exclusivo. Ele deve incorporar tonalidades, frases e nuances emocionais específicas da marca.

- Por que o ajuste fino é melhor: o ajuste fino ajuda o modelo de IA a capturar e replicar a voz e o tom exclusivos da marca. Ele oferece uma experiência consistente em todas as interações.

- Regra geral: o ajuste fino é mais eficaz se seus LLMs precisarem se adaptar a um conhecimento específico. Isso é ideal para jogos imersivos orientados por gênero, narrativas temáticas e empáticas ou até mesmo textos de marketing de marca.

🧠 Curiosidade: LLMs treinados nessas habilidades sociais se destacam na análise do sentimento e da satisfação dos funcionários. Mas apenas 3% das empresas atualmente usam IA generativa em RH.

Caso de uso nº 2: moderação de conteúdo e insights baseados no contexto

- Cenário: uma plataforma de mídia social usa um modelo de IA para detectar conteúdo prejudicial. Ele se concentra em reconhecer linguagem específica da plataforma, gírias emergentes e violações sensíveis ao contexto.

- Por que o ajuste fino é melhor: habilidades sociais, como a formulação de frases, muitas vezes estão fora do escopo dos sistemas RAG. O ajuste fino melhora a compreensão do LLM sobre nuances específicas da plataforma e jargões do setor, especialmente relevantes para a moderação de conteúdo.

- Regra geral: escolher o ajuste fino é sensato quando se lida com diferenças culturais ou regionais. Isso também se estende à adaptação a termos específicos do setor, como jargões médicos, jurídicos ou técnicos.

Está prestes a fazer o ajuste fino do seu LLM? Pergunte a si mesmo estas questões importantes:

- Seu LLM precisa atender a um segmento de clientes específico ou tema de marca?

- Você gostaria de adicionar dados proprietários ou específicos do domínio à lógica do LLM?

- Você precisa de respostas mais rápidas sem perder a precisão?

- Seus LLMs estão oferecendo soluções offline?

- Você pode alocar recursos dedicados e poder de computação para o retreinamento?

Melhorar a experiência do usuário é ótimo. No entanto, muitas empresas também precisam da IA como um impulso à produtividade para justificar os altos custos de investimento. É por isso que adotar um modelo de IA pré-treinado é frequentemente a escolha preferida de muitos.

👀 Você sabia? A IA genérica tem o potencial de automatizar atividades de trabalho que economizam até 70% do tempo dos funcionários. Solicitar insights à IA de maneira eficaz desempenha um papel importante aqui!

Como o ClickUp aproveita técnicas avançadas de IA

A escolha entre RAG e ajuste fino é um debate bastante acalorado.

Mesmo ler algumas discussões no Reddit é suficiente para deixá-lo confuso. Mas quem disse que você precisa escolher apenas um?

Imagine ter modelos de IA personalizáveis, automação e gerenciamento de tarefas, tudo em um só lugar. Esse é o ClickUp, o aplicativo completo para o trabalho. Ele reúne gerenciamento de projetos, documentação e comunicação da equipe em um só lugar e é alimentado por IA de última geração.

Em resumo, ele se destaca em tudo, especialmente com sua solução abrangente de IA: ClickUp Brain.

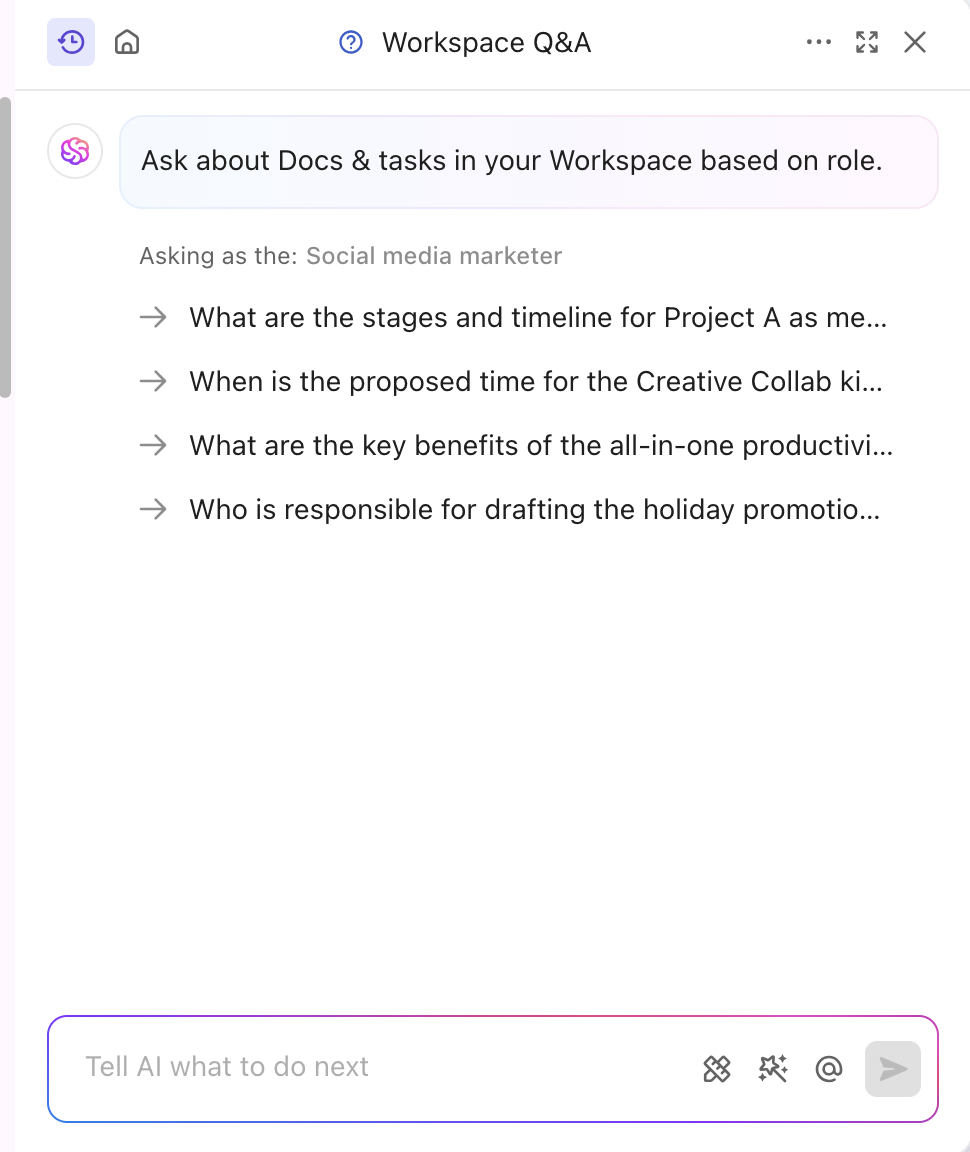

Precisa de insights rápidos e contextuais? O Brain extrai informações em tempo real de seus documentos, tarefas e recursos. Isso é o RAG aprimorado em ação. Além disso, seu LLM fundamental, o Brain, pode gerar relatórios e atualizações de projetos de rotina.

A ferramenta de IA também é ajustada para se adequar ao seu setor e segmento, oferecendo insights profissionais e criativos. Ela ainda personaliza o conteúdo em tempo real, sem qualquer treinamento manual. O Brain combina ajuste fino e RAG para automatizar atualizações de projetos, atribuições de tarefas e notificações de fluxo de trabalho. Quer respostas personalizadas para sua função? O ClickUp Brain também pode fazer isso!

Além de se especializar em conteúdo, o ClickUp também equipa sua plataforma com um poderoso recurso de IA baseado em conhecimento.

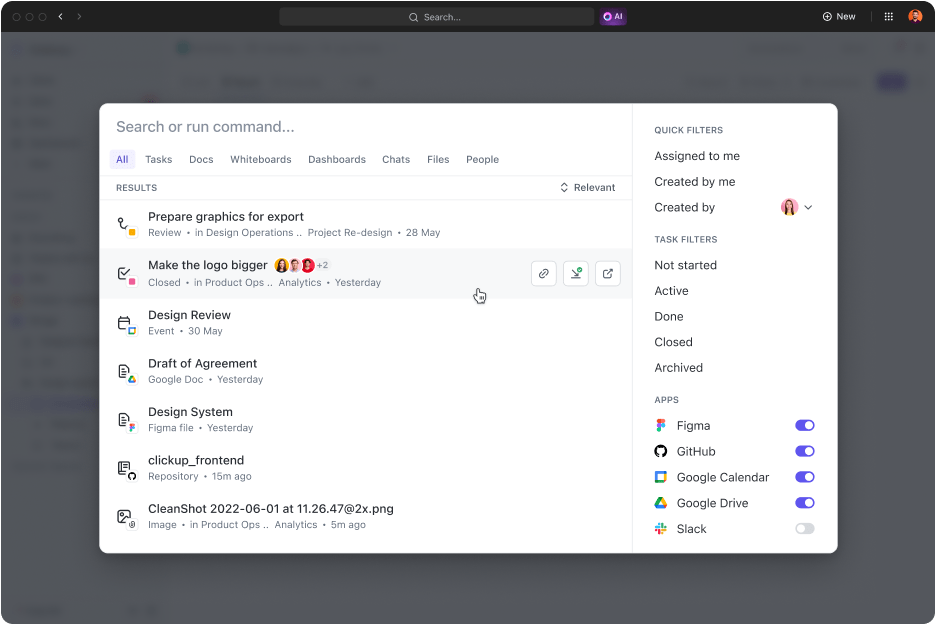

A Pesquisa Conectada do ClickUp é uma ferramenta alimentada por IA que recupera rapidamente qualquer recurso do seu espaço integrado. Se você precisa de documentos para a reunião de hoje ou respostas para qualquer tarefa, uma simples consulta exibe links de fontes, citações e informações detalhadas.

Ele também inicia aplicativos, pesquisa o histórico da área de transferência e cria trechos. A melhor parte? Tudo isso pode ser acessado com um clique a partir do seu centro de comando, barra de ação ou área de trabalho.

Especialistas em marketing digital, o presidente da Hum JAM afirma que:

O ClickUp é a mais incrível ferramenta “tudo em um” de automação de equipes, que rastreia, automatiza e mede o sucesso da equipe. Acredite quando digo que sua equipe não pode viver sem essa ferramenta.

O ClickUp é a mais incrível ferramenta “tudo em um” de automação de equipes, que rastreia, automatiza e mede o sucesso da equipe. Acredite quando digo que sua equipe não pode viver sem essa ferramenta.

Aumentando a precisão da IA genérica e do LLM com o ClickUp

As respostas poderosas do RAG, aprimoradas por dados externos atualizados e ajuste fino, são usadas para tarefas e comportamentos específicos. Ambos melhoram o desempenho da IA, mas a abordagem certa define seu ritmo e eficiência.

Em setores dinâmicos, a decisão geralmente se resume a qual método adotar primeiro. Uma solução pré-treinada poderosa geralmente é a escolha mais sensata.

Se você deseja melhorar a qualidade do serviço e a produtividade, o ClickUp é um ótimo parceiro. Seus recursos de IA impulsionam a geração de conteúdo, a recuperação de dados e as respostas analíticas. Além disso, a plataforma vem com mais de 30 ferramentas que abrangem tudo, desde o gerenciamento de tarefas até a geração de visuais impressionantes.

Inscreva-se hoje mesmo no ClickUp!