Privasi adalah hak asasi manusia yang fundamental. Dan privasi juga berlaku dalam semua aspek kecerdasan buatan (AI) saat ini. Menurut laporan Cisco, 64% orang khawatir mereka dapat secara tidak sengaja membagikan informasi sensitif saat menggunakan alat AI.

Itulah salah satu alasan mengapa alat AI offline semakin populer. Ketika model dijalankan secara lokal, Anda dapat menulis, mengkodekan, merangkum, dan membuat—tanpa perlu mengunggah semuanya ke cloud atau terjebak saat koneksi Wi-Fi terputus.

Dalam daftar ini, kami akan membahas alat AI terbaik yang dapat digunakan secara offline, di antaranya terdapat sebuah aplikasi super yang membantu Anda mengorganisir hasil yang dihasilkan oleh alat-alat tersebut menjadi satu sistem yang terintegrasi dan sangat aman.

Apa Itu Alat AI Offline?

Alat AI offline adalah aplikasi perangkat lunak yang menjalankan model bahasa besar (LLMs) di perangkat lokal Anda, tanpa memerlukan koneksi internet setelah Anda mengunduh model tersebut. Data model disimpan langsung di komputer Anda, sehingga semua pemrosesan atau inferensi dilakukan di CPU atau GPU Anda sendiri.

Pemrosesan di perangkat ini memiliki beberapa manfaat utama:

- Privasi data yang lengkap: Informasi sensitif Anda tidak pernah meninggalkan komputer Anda.

- Tidak ada biaya berlangganan: Setelah Anda memiliki alat dan modelnya, tidak ada biaya berlangganan.

- Bisa digunakan di mana saja: Anda dapat menggunakannya di pesawat, di kabin terpencil, atau saat terjadi gangguan internet.

- Kontrol penuh: Anda dapat memilih model mana yang akan digunakan dan cara mengonfigurasinya.

Alat AI Offline Terbaik Sekilas

Berikut ini ringkasan singkat tentang alat AI offline terbaik yang tersedia saat ini.

| Nama alat | Fitur utama | Terbaik untuk | Penetapan Harga* |

| KlikUp | Mode Offline untuk tugas dan pengingat, ClickUp Brain MAX yang mencakup Talk-to-Text, Pencarian Perusahaan di seluruh aplikasi terhubung, Dokumen dan Manajemen Pengetahuan, Otomatisasi, serta Integrasi dan API. | Tim yang membutuhkan penangkapan data offline ditambah eksekusi online, tata kelola, dan konteks AI dalam satu ruang kerja. | Gratis selamanya; Kustomisasi tersedia untuk perusahaan. |

| GPT untuk Semua | Obrolan lokal dengan model terbuka, LocalDocs untuk tanya jawab dokumen pribadi, penemuan dan unduhan model dalam aplikasi, server API lokal yang kompatibel dengan OpenAI. | Pengguna yang mengutamakan privasi yang menginginkan chatbot desktop offline sederhana dengan dokumen lokal. | Rencana gratis tersedia; Rencana berbayar mulai dari $40 per pengguna per bulan. |

| LM Studio | Penemuan dan unduhan model, antarmuka obrolan plus RAG lokal, server yang kompatibel dengan OpenAI atau REST API, preset, dan penyesuaian kinerja. | Pengembang dan pengguna tingkat lanjut yang menginginkan lingkungan kerja model offline yang terpolish. | Gratis |

| Ollama | Satu model perintah, API REST lokal dengan streaming, berkas model untuk konfigurasi yang dapat digunakan ulang, dan embeddings untuk pipa RAG. | Pengembang yang menginginkan runtime lokal berbasis CLI dengan lapisan API yang kuat. | Rencana gratis tersedia; Rencana berbayar mulai dari $20 per bulan. |

| Jan. AI | Antarmuka pengguna offline bergaya ChatGPT, asisten, dan dukungan MCP, ekstensi untuk fitur tambahan, serta penyedia yang kompatibel dengan OpenAI (opsional). | Pengguna non-teknis yang menginginkan asisten offline yang bersih dengan opsi penyesuaian. | Gratis dan sumber terbuka |

| Llamafile | Pengemasan model eksekusi tunggal, distribusi portabel di berbagai sistem operasi, mode server lokal dengan antarmuka web dan API, runtime dengan ketergantungan minimal. | Pengguna yang ingin memiliki file AI portabel tanpa instalasi yang dapat dijalankan di mana saja. | Gratis dan sumber terbuka |

| GPT Pribadi | Pengelolaan dan pengindeksan dokumen yang dihosting sendiri, tanya jawab RAG offline, penyaringan konteks berdasarkan dokumen, LLM modular, dan tumpukan penyimpanan vektor. | Tim yang membutuhkan sesi tanya jawab offline mengenai berkas internal dengan alur kerja RAG yang dapat dikendalikan. | Gratis dan sumber terbuka |

| Bisik. cpp | Penerjemahan suara ke teks lokal, model terkuantisasi untuk penggunaan sumber daya yang lebih rendah, dukungan VAD, penanganan FFmpeg opsional untuk format yang lebih banyak. | Pengguna yang membutuhkan transkripsi offline penuh yang dapat diintegrasikan ke dalam aplikasi. | Gratis dan sumber terbuka |

| Antarmuka Pengguna Web untuk Pembangkitan Teks | Antarmuka pengguna berbasis browser untuk model lokal, templat prompt Jinja2, pengaturan generasi, cabang percakapan, dan pengeditan pesan. | Pengguna yang menginginkan kustomisasi maksimal pada antarmuka web lokal. | Gratis dan sumber terbuka |

| llama. cpp | Mesin inferensi berkemampuan tinggi, dukungan kuantisasi luas, server lokal dengan endpoint bergaya OpenAI, dukungan embedding, dan dukungan reranking. | Pengembang yang membangun aplikasi AI offline kustom atau backend | Gratis dan sumber terbuka |

Bagaimana kami meninjau perangkat lunak di ClickUp

Tim editorial kami mengikuti proses yang transparan, didukung oleh riset, dan netral terhadap vendor, sehingga Anda dapat mempercayai bahwa rekomendasi kami didasarkan pada nilai produk yang sebenarnya.

Berikut ini adalah penjelasan rinci tentang cara kami meninjau perangkat lunak di ClickUp.

Hal-hal yang Perlu Diperhatikan dalam Memilih Alat AI Terbaik yang Dapat Digunakan Secara Offline

Menilai alat AI offline bisa terasa rumit dan membingungkan, sehingga Anda mungkin memilih alat yang bahkan tidak kompatibel dengan komputer Anda. Hal terpenting yang perlu dipertimbangkan adalah tujuan yang ingin Anda capai. Seorang pengembang yang membangun aplikasi bertenaga AI memiliki kebutuhan yang sangat berbeda dengan seseorang yang hanya ingin memiliki chatbot AI offline pribadi untuk bantuan penulisan.

Berikut adalah kriteria utama yang perlu dievaluasi:

- Kemudahan pengaturan: Apakah memerlukan pengetahuan teknis dan pekerjaan baris perintah, ataukah ini adalah instalasi satu klik yang sederhana?

- Pemilihan model: Apakah Anda dapat dengan mudah memilih dari berbagai macam model, ataukah Anda terikat pada hanya beberapa model saja?

- Jaminan privasi: Apakah alat ini memproses semua data secara lokal, atau apakah ada komponen cloud yang tersembunyi?

- Persyaratan perangkat keras: Apakah perangkat keras Anda saat ini dapat menjalankan program ini dengan baik, atau apakah Anda perlu melakukan upgrade?

- Kemampuan integrasi: Apakah dapat terhubung dengan alat-alat lain Anda, ataukah ini merupakan aplikasi yang sepenuhnya berdiri sendiri?

- Kesesuaian kasus penggunaan: Apakah dirancang untuk obrolan umum, menanyakan pertanyaan tentang dokumen Anda, menerjemahkan audio, atau menghasilkan kode?

10 Alat AI Terbaik yang Dapat Digunakan Secara Offline

Berikut ini adalah gambaran umum tentang alat AI offline terbaik 👇

1. ClickUp (Pilihan terbaik untuk mengelola tugas, dokumen, dan konteks AI dalam satu tempat, baik saat bekerja offline maupun online)

ClickUp, ruang kerja AI terintegrasi pertama di dunia, dibangun berdasarkan konsep 'AI offline' yang tidak hanya berhenti pada menghasilkan jawaban. Hal ini karena Anda masih membutuhkan tempat di mana output tersebut menjadi keputusan, tugas, dan langkah selanjutnya yang tidak hilang di antara berkas dan obrolan.

Dan berbeda dengan banyak pengaturan offline yang memerlukan instalasi yang memakan waktu dan integrasi alat, ClickUp menyediakan lapisan eksekusi lengkap dalam satu tempat, dengan AI yang beroperasi di atas konteks ruang kerja yang sama.

Untuk permulaan, Anda memiliki Mode Offline ClickUp, yang secara otomatis aktif dan memastikan pekerjaan tetap berjalan saat Anda offline. Artinya, semua Tugas, pengingat, dan catatan Anda tetap dapat diakses saat offline, dengan opsi untuk menambahkan lebih banyak jika diperlukan. Setelah Anda terhubung kembali, tugas dan pengingat baru akan disinkronkan kembali ke Workspace Anda secara otomatis (selamat tinggal kehilangan konteks 👋).

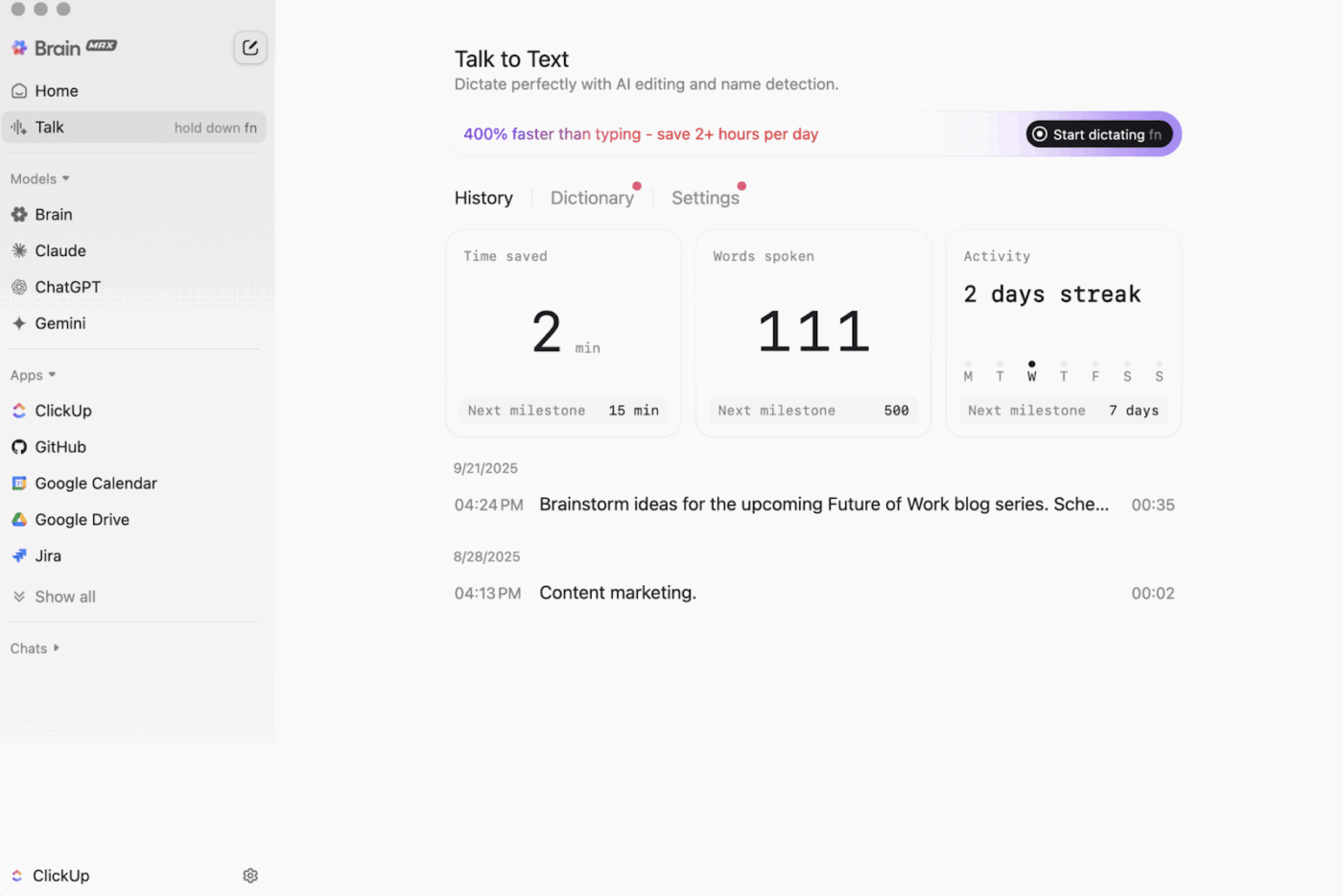

Kemudian ada ClickUp Brain MAX , asisten AI desktop yang mengutamakan privasi, yang dapat menyimpan dan mencari di seluruh ruang kerja Anda, aplikasi terhubung, dan bahkan di web.

Dengan fitur Talk-to-Text , Brain MAX dapat mengubah suara Anda menjadi teks tanpa perlu menggunakan tangan. Fitur ini memungkinkan Anda untuk menyusun email, menulis dokumen, atau mencatat pembaruan cepat saat Anda sedang sibuk.

Brain MAX juga menyediakan Universal AI, yang dirancang untuk berinteraksi dengan model AI terbaru dalam bidang pemrograman, penulisan, penalaran kompleks, dan lainnya. Artinya, Anda dapat mengajukan pertanyaan ke model AI teratas di satu tempat, termasuk ClickUp Brain serta opsi seperti OpenAI, Claude, dan Gemini, tanpa perlu berganti-ganti alat.

Lebih dari itu, ClickUp Security menyediakan fitur keamanan yang sering diabaikan oleh alat offline. Fitur-fitur seperti enkripsi, izin akses yang detail, dan kontrol admin seperti SSO, provisioning, dan log audit, semuanya dirancang untuk tim yang membutuhkan keamanan tingkat perusahaan.

ClickUp AI Knowledge Management sangat membantu dalam proses transisi dari offline ke online. Platform ini menyediakan pusat penyimpanan bagi tim Anda untuk menyimpan berbagai sumber daya di Docs dan wiki, lalu menggunakan ClickUp Brain untuk mendapatkan jawaban instan dari seluruh ruang kerja Anda, sehingga konteks yang tepat tersedia begitu pekerjaan dilanjutkan.

🎬 Agen dalam aksi: Gunakan Super Agents untuk mengubah pekerjaan yang disinkronkan menjadi langkah selanjutnya!

ClickUp Super Agents adalah rekan kerja yang didukung oleh kecerdasan buatan (AI) yang dapat Anda buat dan sesuaikan untuk menjalankan alur kerja multi-langkah di dalam ruang kerja ClickUp Anda. Anda dapat mengonfigurasi pemicu spesifik, instruksi, dan akses alat untuk memastikan mereka beroperasi sesuai dengan batasan yang Anda tetapkan.

Misalnya, setelah tugas-tugas offline disinkronkan kembali, seorang Super Agent dapat memindai item-item baru, merangkum perubahan yang terjadi, mengidentifikasi langkah-langkah tindakan, menyusun draf pembaruan, dan meneruskannya ke pemilik yang tepat untuk direview.

Dan karena Super Agents dapat dikendalikan, Anda dapat mengontrol akses yang mereka miliki melalui izin dan memantau aktivitas yang mereka lakukan. 🔐

Fitur terbaik ClickUp

- Temukan apa pun di seluruh alat Anda: Sortir dan cari di seluruh ruang kerja Anda, serta aplikasi terhubung, dari satu tempat dengan ClickUp Enterprise Search.

- Bangun basis pengetahuan yang sesungguhnya: Buat wiki dan dokumentasi dengan ClickUp Docs menggunakan halaman bersarang, templat, bantuan AI, dan fitur lainnya.

- Jaga koneksi stack Anda: Sinkronkan pekerjaan Anda dengan alat seperti Slack dan GitHub tanpa meninggalkan ClickUp menggunakan ClickUp Integrations.

- Buat alur kerja kustom: Gunakan API ClickUp dengan token pribadi atau OAuth 2.0 untuk mengaktifkan otomatisasi dan integrasi yang disesuaikan.

- Otomatiskan alur kerja Anda: Aktifkan tindakan seperti menugaskan pemilik, memperbarui status, atau memulai proses serah terima berdasarkan perubahan tugas dengan ClickUp Automations.

Batasan ClickUp

- Karena banyaknya fitur yang tersedia, beberapa pengguna mungkin mengalami kurva pembelajaran.

Harga ClickUp

Ulasan dan penilaian ClickUp

- G2: 4. 7/5 (lebih dari 10.000 ulasan)

- Capterra: 4.6/5 (lebih dari 4.000 ulasan)

Apa yang dikatakan pengguna nyata tentang ClickUp?

Seorang pengulas G2 mengatakan:

Papan Agile, integrasi, dan penyesuaian. Selain itu, saya suka fakta bahwa saya bisa bekerja offline dan tetap mengerjakan tugas. Selain itu, saya bisa mengirim email ke daftar mana pun dan tugas akan dibuat secara otomatis. Editor teksnya luar biasa, berfungsi dalam mode MD dan dengan pintasan, memungkinkan Anda melihat pratinjau konten secara langsung.

Papan Agile, integrasi, dan penyesuaian. Selain itu, saya suka fakta bahwa saya bisa bekerja offline dan tetap mengerjakan tugas. Selain itu, saya bisa mengirim email ke daftar mana pun dan tugas akan dibuat secara otomatis. Editor teksnya luar biasa, berfungsi dalam mode MD dan dengan pintasan, memungkinkan Anda melihat pratinjau konten secara langsung.

2. GPT4All (Pilihan terbaik untuk obrolan AI pribadi dan offline dengan model bahasa lokal)

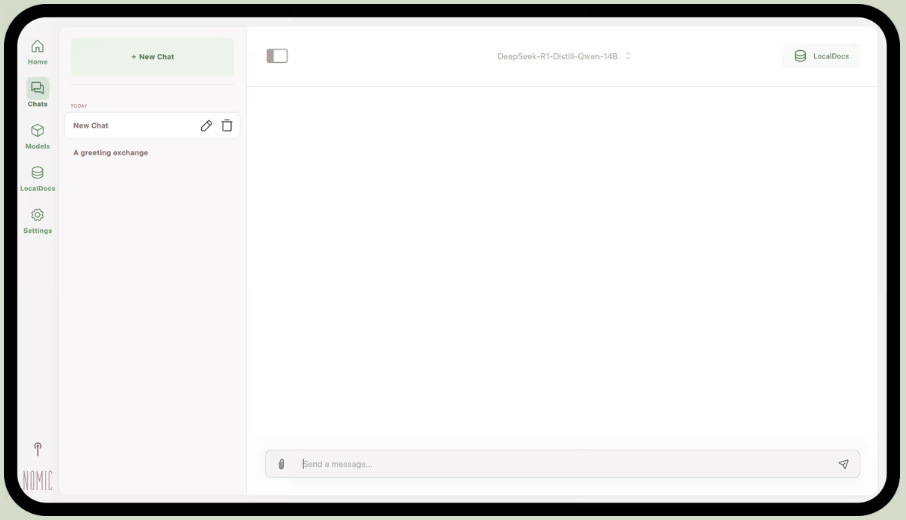

Sebagai bagian dari Nomic.ai, GPT4All adalah aplikasi desktop yang memungkinkan Anda menjalankan model bahasa besar sumber terbuka langsung di komputer Anda, sehingga Anda dapat berinteraksi dengan asisten AI tanpa bergantung pada koneksi internet atau panggilan API cloud. Aplikasi ini dirancang untuk orang-orang yang menginginkan pengaturan 'local-first', di mana perintah, respons, dan file tetap disimpan di perangkat.

Fitur terbaiknya adalah LocalDocs, yang menggunakan metode retrieval-augmented generation untuk memungkinkan Anda berinteraksi dengan dokumen Anda sendiri secara pribadi. Anda dapat mengarahkan aplikasi ke folder berisi file PDF atau teks, dan aplikasi akan membuat basis pengetahuan lokal yang dapat Anda tanyakan pertanyaan tentangnya.

GPT4All juga mencakup perpustakaan terkurasi dari model-model populer seperti Llama dan Mistral, yang dapat Anda unduh langsung melalui aplikasi.

Fitur terbaik GPT4All

- Mulai server API lokal (kompatibel dengan OpenAI) untuk menggunakan model GPT4All di dalam aplikasi dan otomatisasi lainnya.

- Cari, bandingkan, dan unduh model GGUF langsung dari dalam aplikasi, dengan opsi penyortiran seperti jumlah suka, jumlah unduhan, dan tanggal unggahan.

- Sesuaikan panjang konteks, panjang keluaran maksimum, top-p, top-k, penalti pengulangan, benang CPU, dan bahkan pemindahan lapisan GPU (ditambah dukungan Metal pada Apple Silicon)

Batasan GPT4All

- Kinerja sangat bergantung pada hardware komputer Anda.

- Pengkodean koleksi dokumen yang besar dapat memakan waktu.

Harga GPT4All

- Aplikasi desktop gratis

- Bisnis: $40 per pengguna per bulan (Nomic AI)

- Enterprise: Harga khusus (Nomic AI)

Ulasan dan penilaian GPT4All

- G2: Tidak cukup ulasan

- Capterra: Tidak cukup ulasan

Apa yang dikatakan pengguna nyata tentang GPT4All?

Seorang pengguna Reddit mengatakan:

Ini adalah yang terbaik yang pernah saya coba dengan RAG, mengungguli semuanya, bahkan LM Studio dalam hal kemudahan penggunaan. Saya suka cara Anda memetakan ke folder, dan sistem ini melacak serta mengelola perubahan untuk Anda. Meskipun masih dalam tahap awal kematangannya, seperti yang lain, tetapi ini akan menjadi pilihan default saya untuk jangka pendek.

Ini adalah yang terbaik yang pernah saya coba dengan RAG, mengungguli semuanya, bahkan LM Studio dalam hal kemudahan penggunaan. Saya suka cara Anda memetakan ke folder, dan ia melacak serta mengelola perubahan untuk Anda. Masih dalam tahap awal kematangannya, seperti yang lain, tetapi ini akan menjadi pilihan default saya untuk jangka pendek.

📮 ClickUp Insight: 88% responden survei kami menggunakan AI untuk tugas pribadi mereka, namun lebih dari 50% enggan menggunakannya di tempat kerja. Tiga hambatan utama? Kurangnya integrasi yang mulus, kesenjangan pengetahuan, atau kekhawatiran keamanan. Tapi bagaimana jika AI sudah terintegrasi ke dalam ruang kerja Anda dan sudah aman? ClickUp Brain,

Asisten AI bawaan ClickUp membuat hal ini menjadi kenyataan. Asisten ini memahami perintah dalam bahasa sehari-hari, mengatasi ketiga kekhawatiran adopsi AI sambil menghubungkan obrolan, tugas, dokumen, dan pengetahuan Anda di seluruh ruang kerja. Temukan jawaban dan wawasan dengan satu klik!

3. LM Studio (Pilihan terbaik untuk lingkungan kerja offline yang terpolish dengan penyesuaian kinerja)

melalui LM Studio

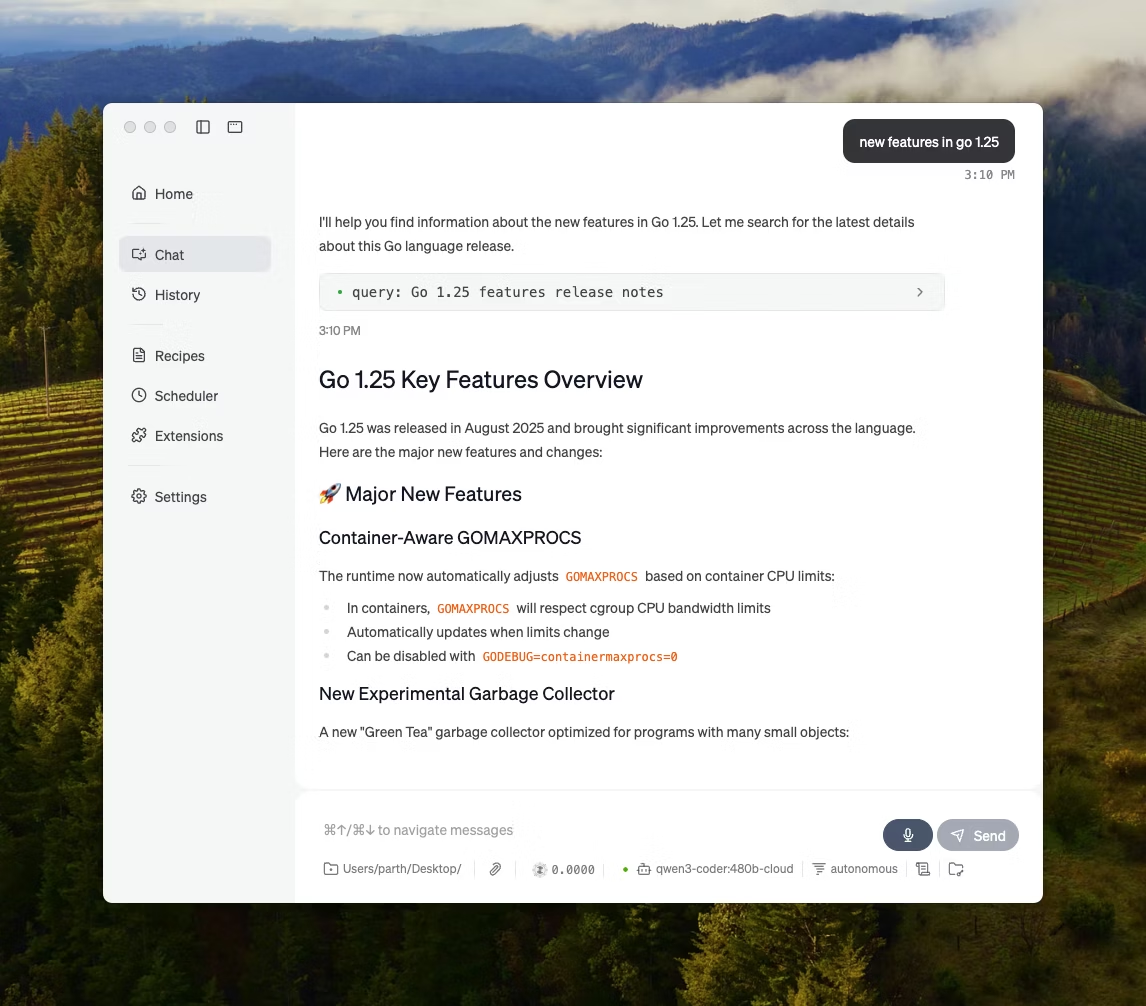

LM Studio adalah aplikasi desktop AI lokal yang dirancang untuk menemukan, menguji, dan menjalankan model open-source dalam antarmuka pengguna (UI), tanpa perlu bergantung pada terminal. Aplikasi ini difokuskan pada eksperimen, seperti memilih model, menjalankannya secara lokal, dan mengulang pengaturan prompt dan parameter dengan siklus umpan balik yang lebih cepat dibandingkan dengan pengaturan berbasis CLI konvensional.

Fitur ini juga mendukung obrolan dengan dokumen secara sepenuhnya offline (RAG lokal), di mana Anda dapat melampirkan file ke percakapan dan merujuknya selama respons. Hal ini menjadikannya ideal untuk penelitian offline, catatan belajar, atau alur kerja dokumen internal di mana unggahan file tidak memungkinkan.

LM Studio juga memberikan kontrol yang detail atas cara AI beroperasi, dengan opsi untuk menyesuaikan suhu, panjang konteks, dan penggunaan GPU.

Fitur terbaik LM Studio

- Gunakan mode kompatibilitas OpenAI atau REST API milik LM Studio, tergantung pada apa yang diharapkan oleh aplikasi Anda.

- LM Studio menyediakan opsi SDK JavaScript dan Python untuk membangun alur kerja lokal di atas model Anda.

- Simpan prompt sistem + parameter sebagai preset, lalu gunakan kembali di berbagai obrolan (preset juga dapat diimpor dari file/URL dan dipublikasikan untuk dibagikan melalui LM Studio Hub)

Batasan LM Studio

- LM Studio dapat menyebabkan komputer macet saat menjalankan DeepSeek R1 32B.

- Beberapa pengguna melaporkan aplikasi ini sebagai masalah keamanan data dan privasi karena kode sumber tertutup yang belum diaudit.

Harga LM Studio

- Gratis untuk penggunaan di rumah dan di tempat kerja

Peringkat dan ulasan LM Studio

- G2: Tidak cukup ulasan

- Capterra: Tidak cukup ulasan

Apa yang dikatakan pengguna nyata tentang LM Studio?

Seorang pengguna Reddit mengatakan:

Ini hebat. Ini hanya berfungsi, sangat mudah untuk mulai menggunakannya. Memiliki antarmuka pengguna (UI) yang paling menarik di antara semua pesaing.

Ini hebat. Ini hanya berfungsi, sangat mudah untuk mulai menggunakannya. Memiliki antarmuka pengguna (UI) yang paling menarik di antara semua pesaing.

4. Ollama (Pilihan terbaik untuk menjalankan model bahasa besar (LLM) lokal dengan antarmuka baris perintah (CLI) sederhana dan server lokal)

Ollama adalah model runner lokal yang berperilaku lebih mirip runtime LLM daripada aplikasi obrolan mandiri. Ini berorientasi terminal, dirancang untuk menarik dan menjalankan model terbuka dengan perintah cepat (seperti, ollama run llama3), lalu mengeksposnya melalui layanan lokal yang dapat diintegrasikan oleh antarmuka lain.

Keunggulan Ollama terletak pada REST API-nya. Setelah Ollama berjalan di latar belakang, aplikasi apa pun dapat berkomunikasi dengannya melalui permintaan HTTP sederhana. Hal ini memudahkan Anda untuk mengintegrasikan fitur kecerdasan buatan (AI) ke dalam perangkat lunak Anda sendiri.

Ollama juga menyediakan perpustakaan model populer yang dapat diunduh dengan satu perintah, dan Anda dapat membuat konfigurasi model kustom, yang mirip dengan Dockerfiles untuk AI.

Fitur terbaik Ollama

- Buat resep model yang dapat digunakan ulang dan dapat di-versi (pemilihan model dasar, templat prompt, pesan sistem, parameter, adaptor) menggunakan Modelfile.

- Jalankan model melalui endpoint seperti chat/generate dengan opsi streaming untuk output token secara real-time dalam aplikasi dan skrip.

- Generate embeddings untuk pipeline pencarian dan pengambilan data semantik menggunakan kemampuan embeddings Ollama dan model embeddings yang direkomendasikan.

Batasan Ollama

- Tidak memiliki antarmuka grafis bawaan, sehingga pengguna non-teknis memerlukan alat antarmuka terpisah.

- Aplikasi desktop macOS Ollama mungkin tidak merespons saat offline, bahkan jika model-model sudah diunduh, sementara CLI tetap berfungsi.

Penetapan Harga Ollama

- Gratis

- Keuntungan: $20 per bulan

- Max: $100 per bulan

Ulasan dan penilaian Ollama

- G2: Tidak cukup ulasan

- Capterra: Tidak cukup ulasan

Apa yang dikatakan pengguna nyata tentang Ollama?

Seorang pengulas Producthunt mengatakan:

Mudah diimplementasikan dan dikelola. Ollama memudahkan pengoperasian model bahasa besar (LLM) lokal. Padukan dengan OpenWebUI untuk pengalaman terbaik.

Mudah diimplementasikan dan dikelola. Ollama memudahkan pengoperasian model bahasa besar (LLM) lokal. Padukan dengan OpenWebUI untuk pengalaman terbaik.

🧠 Fakta menarik: Teknologi pengenalan suara ke teks awalnya hanya mengenali angka. AUDREY (1952) dari Bell Labs dapat mengenali angka 0–9, dan sebuah catatan menyebutkan bahwa sistem ini bekerja paling baik saat diucapkan oleh penciptanya.

5. Jan. ai (Pilihan terbaik untuk asisten gaya ChatGPT yang offline dan mengutamakan privasi)

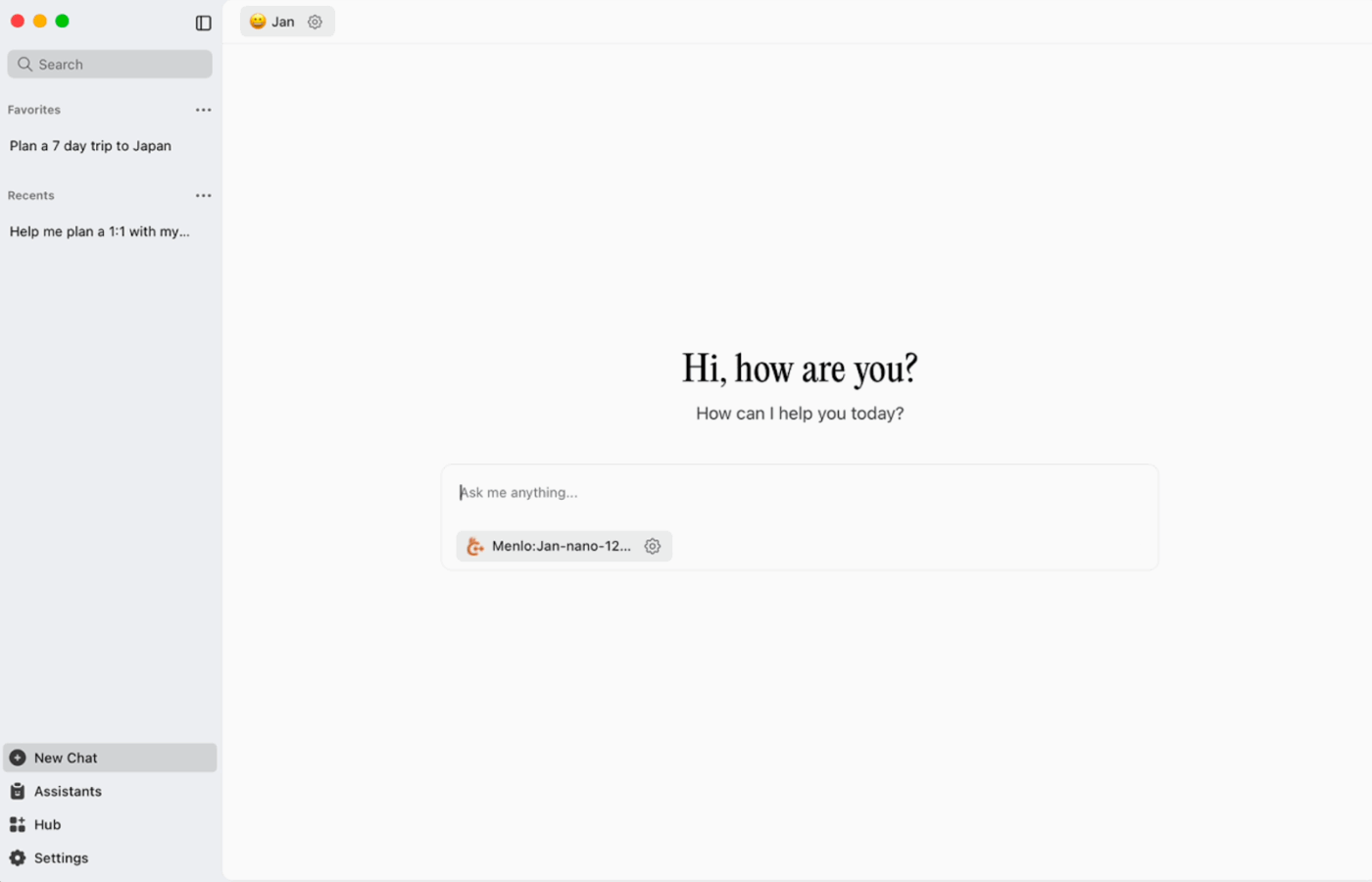

Jan. ai adalah asisten desktop sumber terbuka yang menghadirkan pengalaman obrolan serupa ChatGPT di macOS, Windows, dan Linux, dengan penggunaan lokal sebagai default. Aplikasi ini berjalan secara lokal di perangkat Anda saat Anda membutuhkannya, sementara riwayat percakapan dan data penggunaan disimpan secara lokal dan tidak meninggalkan komputer Anda.

Ini mendukung eksekusi model open-source secara lokal dan juga memungkinkan koneksi opsional ke penyedia jarak jauh seperti API yang kompatibel dengan OpenAI, yang membuatnya fleksibel saat penggunaan offline menjadi prioritas, tetapi akses ke cloud terkadang diperlukan.

Jan. Fitur Terbaik AI

- Buat asisten dengan instruksi dan pengaturan masing-masing, lalu beralih di antara mereka dari tab Asisten daripada harus menulis ulang prompt setiap kali.

- Hubungkan Jan dengan alat MCP dan sumber data menggunakan standar terbuka yang dirancang untuk alur kerja yang berfokus pada penggunaan alat.

- Pasang ekstensi untuk menambahkan fitur baru seperti pencarian web atau interpreter kode. Pendekatan modular ini memungkinkan Anda memulai dengan sederhana dan menambahkan lebih banyak fitur seiring berjalannya waktu.

Jan. Batasan AI

- Jan mungkin mengizinkan pemuatan berkas model yang belum sepenuhnya diunduh, yang dapat menyebabkan perilaku yang membingungkan atau tidak konsisten hingga berkas tersebut selesai diunduh.

- Mengaktifkan API dapat mengganggu obrolan berurutan, dan endpoint dasar seperti ‘get loaded model’ atau ‘swap model’ mungkin tidak berfungsi dengan lancar.

Jan. Harga AI

- Sumber terbuka

Januari. Ulasan dan penilaian AI

- G2: Tidak cukup ulasan

- Capterra: Tidak cukup ulasan

Apa yang dikatakan pengguna nyata tentang Jan. ai?

Seorang pengguna Reddit mengatakan:

Jan. ai adalah aplikasi LLM lokal favorit saya. Sangat bagus.

Jan. ai adalah aplikasi LLM lokal favorit saya. Sangat bagus.

6. Llamafile (Pilihan terbaik untuk mengemas model bahasa besar (LLM) menjadi berkas eksekusi portabel)

Llamafile adalah proyek yang dipimpin oleh Mozilla yang menggabungkan model bahasa besar (LLM) sumber terbuka lengkap ke dalam satu berkas executable. Alih-alih menginstal runtime, mengelola dependensi, atau mengintegrasikan antarmuka pengguna terpisah, Anda cukup mengunduh satu berkas dan menjalankannya seperti aplikasi.

Ide dasarnya adalah distribusi. Sebuah 'llamafile' mencakup bobot model beserta runtime yang telah dikompilasi, dirancang untuk dijalankan di berbagai sistem operasi dengan pengaturan minimal. Ini sangat berguna ketika alat offline perlu dibagikan kepada rekan tim, mahasiswa, atau pelanggan yang tidak akan repot-repot menginstal atau memperbaiki masalah instalasi.

Fitur terbaik Llamafile

- Llamafile menggabungkan llama.cpp dengan Cosmopolitan Libc untuk mendukung portabilitas biner yang luas, sehingga mengurangi pekerjaan pengemasan yang spesifik platform.

- Mode server menyediakan antarmuka web (GUI) beserta titik akhir penyelesaian yang kompatibel dengan API OpenAI, berguna untuk pengembangan aplikasi lokal dan mengganti panggilan cloud selama pengujian.

- Berkas llama yang dikemas dirancang untuk berjalan pada mesin x86_64 dan ARM64 yang umum, yang memudahkan distribusi di lingkungan campuran.

Batasan Llamafile

- Pemilihan model dibatasi pada apa yang telah dikemas sebagai Llamafile.

- Ukuran file sangat besar karena seluruh model telah tertanam di dalamnya.

Harga Llamafile

- Gratis dan sumber terbuka

Ulasan dan penilaian Llamafile

- G2: Tidak cukup ulasan

- Capterra: Tidak cukup ulasan

🧠 Fakta menarik: Situs web pertama masih dapat diakses. CERN secara harfiah menghostingnya di info.cern.ch, menyebutnya sebagai 'rumah dari situs web pertama.'

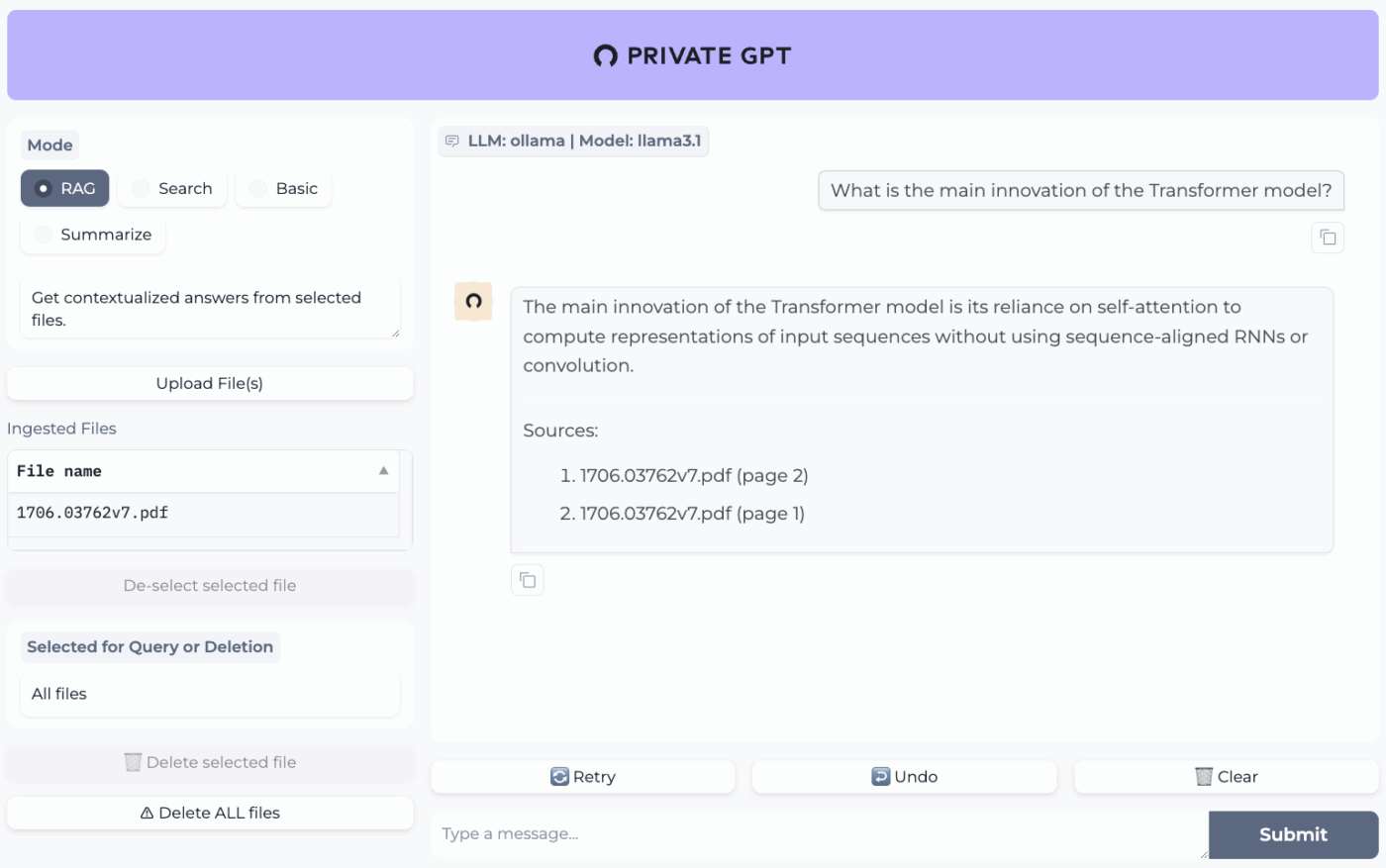

7. PrivateGPT (Pilihan terbaik untuk tanya jawab offline atas file Anda dengan stack RAG yang dihosting sendiri)

PrivateGPT adalah proyek yang siap digunakan dan dapat dihosting sendiri, dirancang untuk alur kerja "bercakap-cakap dengan dokumen Anda". Proyek ini memproses file lokal, mengindeksnya, dan menjawab pertanyaan dengan mengambil konteks relevan dari konten Anda sendiri, bukan mengandalkan memori chatbot cloud. Proyek ini dirancang untuk berjalan sepenuhnya offline, dengan klaim bahwa data tetap berada di lingkungan eksekusi Anda.

Yang membedakannya dari aplikasi obrolan offline umum adalah arsitektur modularnya. Dengan kata lain, Anda dapat menggabungkan dan menyesuaikan LLM, penyedia embedding, dan penyimpanan vektor sesuai dengan batasan hardware dan privasi Anda, lalu menjalankan semuanya melalui API lokal + antarmuka pengguna.

Fitur terbaik PrivateGPT

- Impor berkas PDF, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, gambar (JPG/PNG/JPEG), dan bahkan MP3/MP4 menggunakan pipa impor bawaan.

- Konfigurasi profil lapisan dengan PGPT_PROFILES (misalnya, local,cuda) untuk menggabungkan beberapa berkas pengaturan dan beralih antara deployment tanpa perlu menulis ulang konfigurasi dasar Anda.

- Filter respons terhadap subset tertentu dari dokumen yang diproses menggunakan context_filter saat memanggil endpoint penyelesaian kontekstual.

Batasan PrivateGPT

- Memiliki persyaratan hardware yang lebih tinggi karena menjalankan beberapa komponen secara bersamaan.

- Pengimporan dokumen multi-dokumen dari satu file (misalnya, satu file PDF yang menghasilkan satu dokumen per halaman) dapat meningkatkan volume dan kompleksitas pengindeksan saat mengelola unggahan berukuran besar.

Harga PrivateGPT

- Sumber terbuka

Peringkat dan ulasan PrivateGPT

- G2: Tidak cukup ulasan

- Capterra: Tidak cukup ulasan

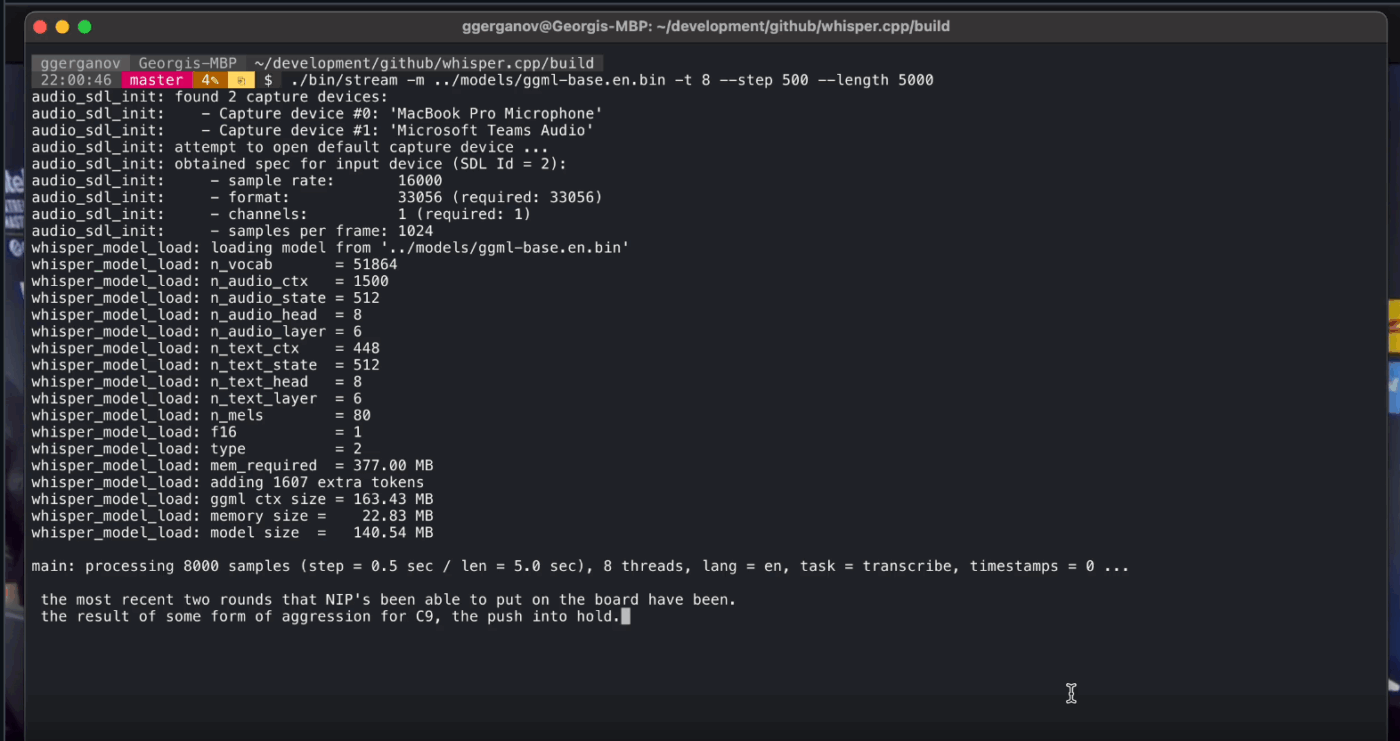

8. Whisper. cpp (Pilihan terbaik untuk konversi suara ke teks sepenuhnya offline yang dapat diintegrasikan ke dalam aplikasi)

Whisper.cpp adalah implementasi C/C++ berperforma tinggi dari model pengenalan ucapan otomatis Whisper milik OpenAI, dirancang untuk dijalankan secara lokal tanpa ketergantungan runtime yang berat. Model ini populer untuk alur kerja transkripsi offline di mana Anda membutuhkan biner kecil dan portabel atau perpustakaan gaya C yang dapat disertakan dalam produk Anda sendiri.

Ini juga fleksibel di berbagai lingkungan, dengan dukungan resmi yang mencakup desktop, mobile, WebAssembly, Docker, dan bahkan perangkat keras sekelas Raspberry Pi, yang menjadikannya pilihan yang cocok untuk alat offline yang perlu dijalankan di lebih dari satu tempat.

Huruf 'cpp' dalam namanya menandakan fokusnya pada performa. Implementasi ini jauh lebih cepat dan menggunakan memori lebih sedikit dibandingkan alternatif berbasis Python, sehingga memungkinkan transkripsi real-time pada komputer modern tanpa memerlukan GPU yang kuat.

Whisper. cpp fitur terbaik

- Jalankan Deteksi Aktivitas Suara (VAD) sebagai bagian dari proyek untuk memisahkan ucapan dan mengurangi transkripsi audio berisik atau kosong dalam alur kerja streaming.

- Mengkuantisasi model Whisper untuk mengurangi kebutuhan ruang disk dan memori, dengan berbagai opsi kuantisasi yang dirancang untuk inferensi lokal yang lebih cepat.

- Bangun dengan dukungan FFmpeg opsional di Linux untuk menangani lebih banyak format input di luar jalur WAV saja.

Whisper. Batasan cpp

- Whisper. cpp's CLI secara default mengharapkan masukan WAV 16-bit, yang menambahkan langkah konversi tambahan saat bekerja dengan MP3, MP4, M4A, atau format umum lainnya.

- Sistem ini tidak secara otomatis mengidentifikasi pembicara (diarization), yang membuatnya sulit untuk mengaitkan kutipan dengan benar dalam rekaman yang melibatkan beberapa pembicara.

Whisper. cpp penetapan harga

- Sumber terbuka

Whisper. Ulasan dan penilaian cpp

- G2: Tidak cukup ulasan

- Capterra: Tidak cukup ulasan

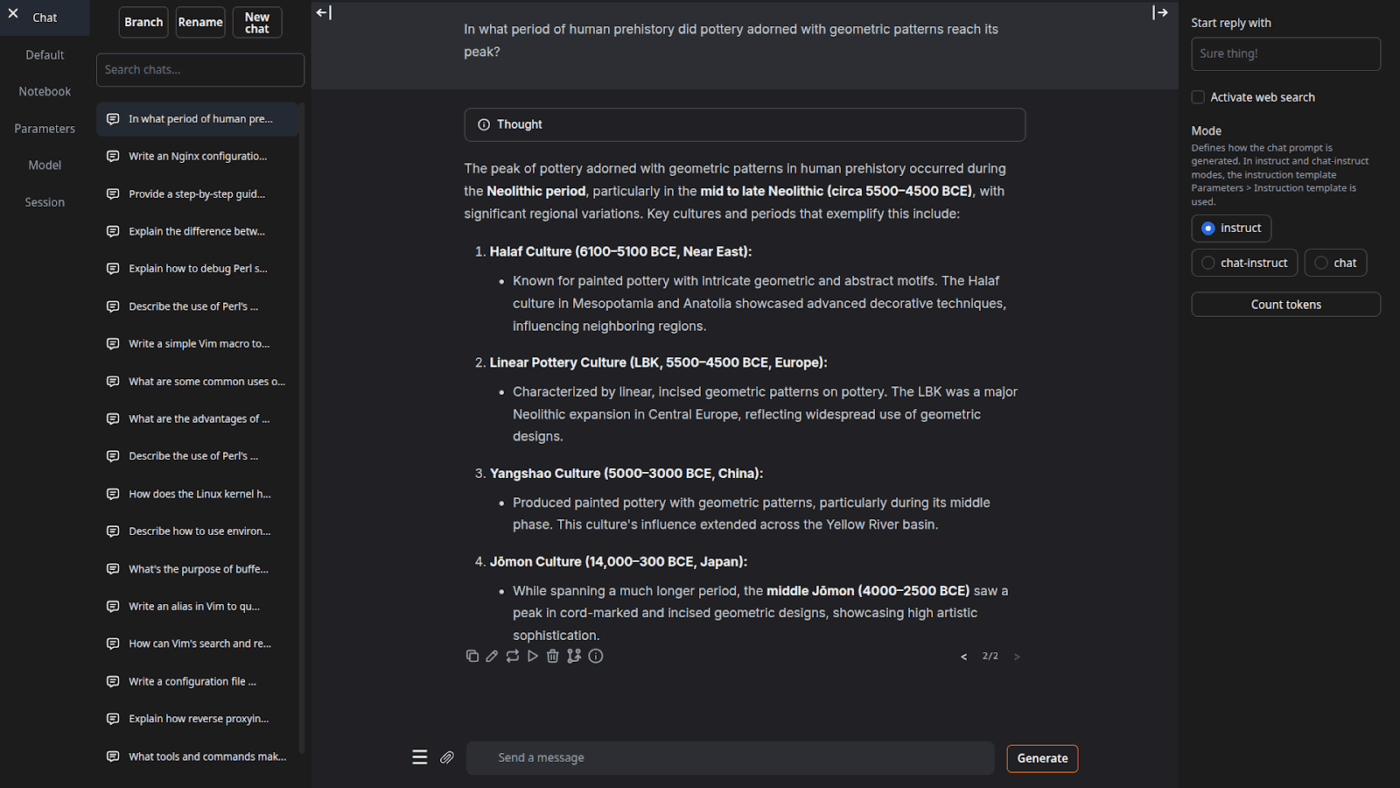

9. Antarmuka Pengguna Web untuk Generasi Teks (Pilihan terbaik untuk pengguna yang menginginkan antarmuka berbasis browser untuk model bahasa lokal)

Antarmuka Web Generasi Teks (sering disebut 'oobabooga') adalah antarmuka web berbasis Gradio untuk menjalankan model lokal dengan penekanan kuat pada kontrol dan eksperimen. Antarmuka ini berfungsi lebih seperti sebuah workbench lengkap: mendukung berbagai backend model, mode interaksi yang beragam, dan banyak pengaturan untuk perilaku generasi.

Ini juga mendukung alur kerja 'penulis/pengembang' yang sering diabaikan oleh banyak alat offline, dengan fitur seperti otomatisasi format prompt, pembangkitan gaya notebook, dan cabang percakapan. Untuk pengaturan offline yang masih memerlukan antarmuka web, ini merupakan salah satu antarmuka depan yang paling dapat dikonfigurasi dalam kategori ini.

Fitur Terbaik Antarmuka Pengguna Web untuk Generasi Teks

- Pengkondisian otomatis format prompt menggunakan templat Jinja2, mengurangi kesalahan format prompt di berbagai keluarga model.

- Sesuaikan puluhan pengaturan untuk mengoptimalkan output AI sesuai dengan kebutuhan spesifik Anda, baik untuk penulisan kreatif, pemrograman, atau peran bermain.

- Pengeditan pesan dengan navigasi versi dan cabang percakapan, memungkinkan untuk mempertahankan beberapa arah percakapan yang sama tanpa perlu memulai dari awal.

Batasan Antarmuka Pengguna Web untuk Pembangkitan Teks

- Penginstal satu klik memerlukan sekitar 10GB ruang disk dan mengunduh PyTorch, yang membuat proses pengaturan terasa berat pada mesin dengan ruang penyimpanan terbatas.

- Endpoint embeddings yang kompatibel dengan OpenAI menggunakan model sentence-transformers/all-mpnet-base-v2 dengan embeddings berdimensi 768, yang dapat melanggar asumsi dalam pipeline yang dibangun berdasarkan default OpenAI berdimensi 1536.

Harga Antarmuka Pengguna Web untuk Pembangkitan Teks

- Sumber terbuka

Peringkat dan ulasan antarmuka pengguna web untuk pembangkitan teks

- G2: Tidak cukup ulasan

- Capterra: Tidak cukup ulasan

10. Llama. cpp (Pilihan terbaik untuk inferensi LLM berperforma tinggi di CPU dan GPU)

Llama.cpp adalah mesin inferensi dan rangkaian alat C/C++ untuk menjalankan model bahasa besar (LLM) secara lokal dengan ketergantungan minimal dan kinerja yang kuat di berbagai jenis perangkat keras. Ini lebih merupakan lingkungan runtime lokal di mana Anda dapat membangun alur kerja di sekitarnya, baik itu antarmuka baris perintah (CLI), server HTTP lokal, atau perpustakaan tertanam di dalam produk Anda sendiri.

Meskipun bukan aplikasi untuk pengguna akhir, Llama.cpp adalah mesin yang menggerakkan banyak alat dalam daftar ini, termasuk GPT4All dan LM Studio. Ia memperkenalkan format model GGUF, yang telah menjadi standar untuk menjalankan model besar pada perangkat keras konsumen dengan efisien mengurangi ukurannya.

Selain itu, platform ini juga menyediakan bindings untuk bahasa pemrograman populer seperti Python dan Rust, dan mode servernya dapat menyediakan API yang kompatibel dengan OpenAI.

Llama. cpp fitur terbaik

- Jalankan server lokal yang kompatibel dengan API OpenAI, dilengkapi dengan antarmuka web bawaan dan titik akhir /v1/chat/completions menggunakan llama-server.

- Jalankan model embedding (dan bahkan model reranking) dari server yang sama untuk pipeline RAG offline menggunakan /embedding dan /reranking.

- Mengurangi resolusi model menjadi 1,5-bit hingga 8-bit untuk mengurangi penggunaan memori dan mempercepat inferensi lokal, kemudian mempercepat eksekusi dengan CUDA/Metal plus Vulkan/SYCL sebagai backend jika tersedia.

Batasan Llama.cpp

- Llama.cpp tidak dirancang sebagai asisten desktop yang siap pakai, artinya penggunaan offline seringkali memerlukan perintah baris perintah (CLI) atau menjalankan llama-server, dan banyak pengguna mengandalkan antarmuka pengguna pihak ketiga untuk obrolan sehari-hari.

- Kompatibilitas Llama.cpp dengan OpenAI tidak selalu 1:1 dengan setiap fitur klien OpenAI, dan pengguna melaporkan ketidaksesuaian seputar parameter output terstruktur seperti response_format di /v1/chat/completions.

Llama. cpp penetapan harga

- Sumber terbuka

Apa yang dikatakan pengguna nyata tentang Llama.cpp?

Seorang pengulas Sourceforge mengatakan:

Hebat. Membuat AI lebih terjangkau bagi semua orang. Dan ini bekerja dengan sangat baik!

Hebat. Membuat AI lebih terjangkau bagi semua orang. Dan ini bekerja dengan sangat baik!

Ubah Output AI Offline Menjadi Pekerjaan Nyata dengan ClickUp

Memilih alat AI offline yang tepat sebenarnya tentang mencocokkan alat dengan tugas yang akan dilakukan.

Jika Anda berada di sini, kemungkinan besar Anda sedang mengoptimalkan tiga hal: privasi, tidak bergantung pada internet, dan kebebasan dari keterikatan pada langganan lain.

Alat-alat dalam daftar ini memenuhi kebutuhan tersebut dengan cara yang berbeda-beda. Artinya, beberapa lebih cocok untuk menulis dan pemrograman, sementara yang lain lebih cocok untuk pencarian, catatan, atau pekerjaan kreatif.

Namun, bagi tim, tantangan yang lebih besar bukan hanya menjalankan AI secara lokal. Tantangannya adalah mengubah output AI menjadi alur kerja yang nyata.

Dengan kemampuan AI ClickUp yang terintegrasi ke dalam tugas, dokumen, dan pengetahuan Anda, Anda dapat dengan mudah mengidentifikasi langkah selanjutnya di tempat yang sama di mana pekerjaan dilakukan (semua dengan keamanan tingkat perusahaan).

Coba ClickUp secara gratis dan lihat bagaimana AI dan eksekusi akhirnya bekerja sama. ✨

Pertanyaan yang Sering Diajukan tentang Alat AI Offline

Ya, setelah mengunduh file model secara awal, banyak alat AI dapat dijalankan sepenuhnya di perangkat Anda tanpa memerlukan koneksi internet. Hal ini membuatnya ideal untuk menangani data sensitif atau bekerja di lokasi dengan koneksi internet yang buruk.

Model Bahasa Lokal (LLM) memproses semua data di perangkat pribadi Anda, sehingga informasi Anda tidak pernah meninggalkan perangkat Anda, sementara AI berbasis cloud mengirimkan perintah Anda ke server jarak jauh untuk diproses. Alat lokal umumnya gratis untuk digunakan setelah pengaturan, sedangkan AI berbasis cloud seringkali melibatkan biaya langganan tetapi mungkin menawarkan model yang lebih powerful.

Model-model yang lebih kecil dengan 1-3 miliar parameter dapat dijalankan pada sebagian besar laptop modern dengan 8GB RAM. Model-model yang lebih besar dan lebih canggih dengan 7 miliar atau lebih parameter bekerja optimal dengan 16GB atau lebih RAM dan GPU khusus, dengan Mac Apple Silicon dan GPU NVIDIA memberikan peningkatan kinerja yang signifikan.

![10 Alat AI Terbaik yang Dapat Digunakan Secara Offline pada [tahun]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)