La plupart des équipes testent les outils de résumé LLM en leur fournissant un échantillon de document et en considérant que le travail est terminé. Le modèle qui excelle dans vos rapports trimestriels pourrait massacrer vos fils de discussion Slack, et celui qui est parfait pour les mémoires juridiques pourrait déformer les faits dans vos e-mails clients.

Ce guide vous présente les meilleurs LLM pour la résumation de texte, vous explique comment les évaluer par rapport à votre charge de travail réelle et comment établir directement des connexions entre ces résumés et des actions dans votre flux de travail.

Aperçu des modèles de résumation LLM

| Modèle | Idéal pour | Meilleures fonctionnalités | Tarifs |

|---|---|---|---|

| ClickUp Brain | Équipes souhaitant résumer directement dans leur flux de travailTaille de l'équipe : toute équipe utilisant ClickUp pour ses projets et sa communication | Résumés adaptés à l'environnement de travail, résumé des réunions avec IA Notetaker, création d'actions à mener, routage multi-LLM, recherche en langage naturel. | Free Forever ; personnalisation disponible pour les entreprises. |

| OpenAI GPT-4o | Résumés soignés et prêts à être présentés à la directionTaille de l'équipe : petites et grandes équipes ayant besoin de résultats abstraits de haute qualité | Résumés de qualité humaine, assistance multimodale, respect rigoureux des instructions, grande fenêtre contextuelle. | API payante par jeton, ChatGPT Plus 20 $/mois |

| Claude 3. 5 Sonnet | Documents sensibles en matière de conformité ou hautement techniquesTaille de l'équipe : équipes juridiques, financières et d'entreprise | Fenêtre contextuelle étendue, faible hallucination, excellent contrôle de la mise en forme, raisonnement solide. | API payante par jeton, abonnement Claude Pro |

| Google Gemini 1. 5 Pro | Équipes travaillant intensivement dans Google WorkspaceTaille de l'équipe : équipes chargées des opérations, de la recherche et ayant de nombreuses réunions | Fenêtre contextuelle pouvant contenir jusqu'à 1 million de jetons, intégration de Google Meet et Drive, résumé multimodal. | Tarification basée sur l'utilisation via Google AI Studio ou Vertex AI. |

| Meta LLaMA 3 | Pipelines de résumé auto-hébergés et personnalisables Taille de l'équipe : équipes dirigées par des ingénieurs et axées sur la confidentialité | Entièrement auto-hébergé, capacité de réglage fin, excellente qualité pour résumer, contrôle total des données. | Poids open source gratuits, frais d'infrastructure applicables. |

| Mistral Large | Équipes ayant besoin d'une résidence des données dans l'UE et d'un déploiement hybrideTaille de l'équipe : entreprises de l'UE ou organisations soucieuses de la conformité | API hybride gérée ou auto-hébergée, excellente qualité de résumé, utilisation efficace des jetons | Tarification API compétitive, pondérations ouvertes disponibles |

Comment nous évaluons les logiciels chez ClickUp

Notre équipe éditoriale suit un processus transparent, fondé sur la recherche et indépendant des fournisseurs, vous pouvez donc être sûr que nos recommandations sont basées sur la valeur réelle des produits.

Voici un aperçu détaillé de la manière dont nous évaluons les logiciels chez ClickUp.

Que faut-il rechercher dans un LLM pour résumer ?

Choisir le mauvais modèle de résumé conduit à gaspiller de l'argent dans des API peu pratiques, à se débattre avec des installations complexes ou simplement à obtenir des résumés de mauvaise qualité qui ne sont d'aucune utilité. Avant de vous plonger dans des modèles spécifiques, comprendre ce qui distingue un résumé efficace d'un résultat générique vous aidera à faire un choix plus judicieux.

Gère vos types de documents réels

Un modèle qui excelle dans la résumation d'articles de recherche peut avoir des difficultés avec les fils de discussion Slack ou les transcriptions de réunions. Recherchez des LLM qui ont été testés sur les types de documents spécifiques avec lesquels votre équipe travaille quotidiennement, qu'il s'agisse de contrats juridiques, d'e-mails de clients, de documentation technique ou de notes de réunion.

Offre une fenêtre contextuelle suffisante

La fenêtre contextuelle détermine la quantité de texte que le modèle peut traiter en un seul passage. Si vous résumez des transcriptions de réunions d'une heure ou de longs rapports de recherche, vous avez besoin d'un modèle avec une fenêtre contextuelle étendue. Sinon, vous devrez diviser les documents en morceaux et perdre la cohérence qui résulte du traitement de l'ensemble.

Équilibre entre vitesse et qualité

Certains modèles privilégient la vitesse d'inférence, tandis que d'autres optimisent la qualité du résultat. Pour la résumation en temps réel pendant les réunions, la vitesse est plus importante. Pour la génération de briefings exécutifs, la qualité prime. Déterminez où se situent vos cas d'utilisation dans ce spectre.

Fournit des options d'accès appropriées.

Les ressources techniques et les exigences de sécurité de votre équipe doivent vous aider à déterminer si vous avez besoin d'une API gérée, d'un déploiement auto-hébergé ou d'une approche hybride. Les équipes d'entreprise ayant des politiques strictes en matière de données peuvent avoir besoin d'options sur site, tandis que les équipes plus petites peuvent préférer la commodité des API cloud.

Les 6 meilleurs LLM pour la résumation de texte

Le nombre impressionnant de modèles disponibles rend le choix du modèle adéquat particulièrement difficile. Chaque modèle présenté ci-dessous est un candidat sérieux, mais le « meilleur » dépend entièrement des besoins spécifiques de votre équipe. Nous les évaluerons en fonction de leur précision, de la taille de la fenêtre contextuelle, de leur vitesse et des options d'accès.

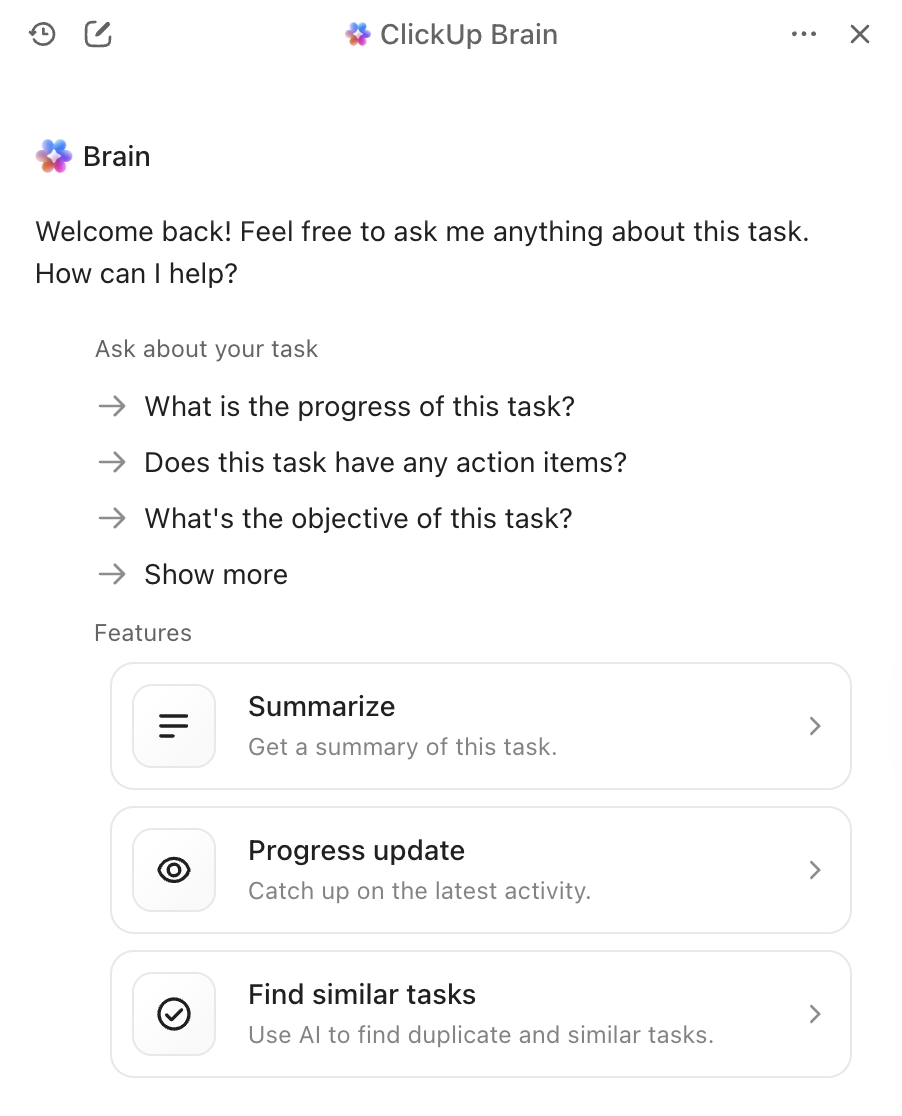

1. ClickUp Brain (le meilleur pour résumer avec l'IA dans votre flux de travail)

Le plus gros problème des outils de synthèse autonomes n'est pas la qualité de leurs résumés, mais ce qui se passe ensuite. Vous générez un résumé brillant, puis vous le copiez manuellement dans votre outil de gestion de projet, vous créez des tâches à partir de celui-ci et vous envoyez un message à votre équipe pour lui indiquer les prochaines étapes. ClickUp Brain élimine cette friction en intégrant le résumé directement dans votre flux de travail.

Avec ClickUp Brain, il suffit de taper @brain dans n'importe quel commentaire de tâche ou message ClickUp Chat et de lui demander de résumer le contexte. Il fournit instantanément un résumé en utilisant sa connaissance de votre environnement de travail, en donnant la priorité à la tâche ou au canal spécifique dans lequel vous vous trouvez. Comme Brain comprend vos projets, vos documents et vos discussions, ses résumés sont immédiatement exploitables, contrairement aux textes isolés que vous devez traiter manuellement.

Les meilleures fonctionnalités de ClickUp Brain

- Résumez des tâches, des documents, des fils de discussion et des enregistrements de réunions sans quitter votre environnement de travail.

- Exploite plusieurs LLM en arrière-plan afin que vous obteniez des résultats optimaux sans avoir à gérer la sélection des modèles.

- Convertit les résumés directement en tâches avec des personnes assignées et des dates d'échéance.

- Comprenez le contexte de votre environnement de travail pour obtenir des résumés plus pertinents et exploitables.

- S'intègre à ClickUp AI Notetaker pour capturer et résumer automatiquement les réunions.

Limites de ClickUp Brain

- Nécessite du travail dans l'écosystème ClickUp pour profiter pleinement des avantages.

- Convient mieux aux flux de travail en équipe qu'au traitement individuel de documents.

Tarifs ClickUp Brain

2. OpenAI GPT-4o (idéal pour des résumés soignés et prêts à être présentés à la direction)

Lorsque vous avez besoin d'un résumé soigné, nuancé et prêt à être partagé avec des cadres supérieurs, GPT-4o est le choix idéal. Sa force réside dans sa capacité à produire des résumés abstraits de haute qualité, qui se lisent comme s'ils avaient été rédigés par un humain. Grâce à sa large fenêtre contextuelle et à ses capacités multimodales, il peut résumer des textes à partir d'images ou de transcriptions audio, et pas seulement à partir de documents.

Vous pouvez y accéder via une API largement disponible, ce qui facilite son intégration dans vos outils d'IA existants pour les réunions. En contrepartie, il s'agit d'un service propriétaire dont le prix est basé sur l'utilisation, et vous remarquerez peut-être un léger retard lors du résumé de documents très longs.

Les meilleures fonctionnalités de GPT-4o

- Produit des résumés abstraits de qualité humaine qui ne nécessitent qu'un minimum de modifications en cours.

- Gère les entrées multimodales, y compris les images et les transcriptions audio.

- Offre une documentation API complète et une assistance à l'intégration.

Limites du GPT-4o

- La tarification basée sur l'utilisation peut s'avérer coûteuse pour les résumés volumineux.

- La latence d'inférence augmente avec les documents très longs.

- Un modèle propriétaire signifie moins de contrôle sur le traitement des données.

Tarifs GPT-4o

- Accès à l'API avec tarification à l'unité par jeton

- Abonnement ChatGPT Plus à 20 $/mois pour un usage individuel

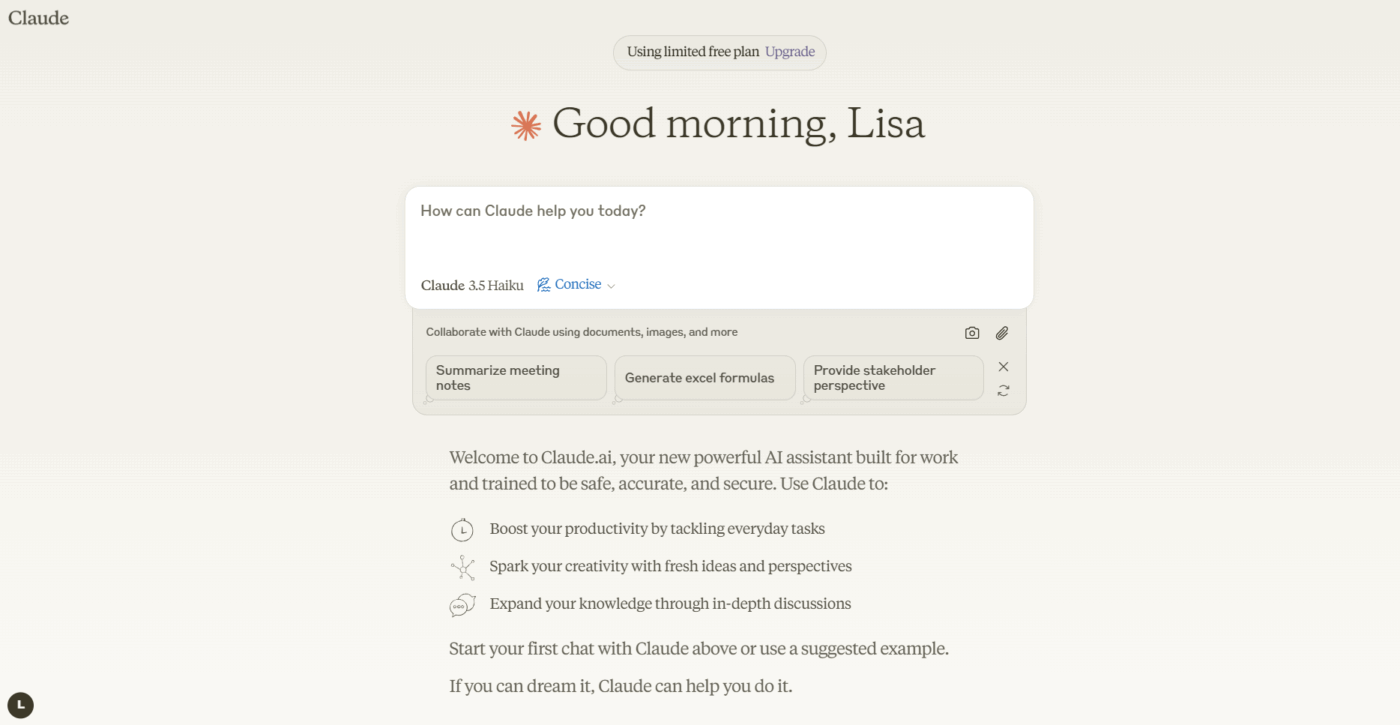

3. Anthropic Claude 3. 5 Sonnet (idéal pour les documents sensibles en matière de conformité)

Si votre équipe traite des documents hautement sensibles ou complexes, Claude 3. 5 Sonnet est conçu pour répondre à vos besoins. Il dispose d'une fenêtre contextuelle étendue, ce qui lui permet de traiter et de résumer des rapports volumineux en une seule fois. Ce qui le distingue vraiment, c'est sa capacité à suivre des instructions nuancées : vous pouvez demander un résumé dans un format ou un ton spécifique, ou axé sur certains sujets, et il vous le fournit avec une grande précision.

L'accent mis par Anthropic sur l'alignement en matière de sécurité contribue à réduire le risque que le modèle invente des faits, une fonctionnalité essentielle pour les équipes soucieuses de la conformité qui travaillent avec des documents juridiques ou financiers. Pour les équipes qui utilisent déjà des résumeurs de documents basés sur l'IA, Claude s'intègre parfaitement dans les flux de travail existants.

Les meilleures fonctionnalités de Claude 3. 5 Sonnet

- La fenêtre de contexte étendue traite l'intégralité des rapports en une seule fois.

- Excellente capacité à suivre les instructions pour les exigences de formatage et de ton personnalisées.

- Un alignement sécuritaire solide réduit le risque d'hallucinations.

Limites de Claude 3. 5 Sonnet

- Modèle propriétaire avec variations de disponibilité selon les régions.

- Le prix des API peut être important pour une utilisation à l'échelle de l'entreprise.

Tarifs de Claude 3. 5 Sonnet

- Accès à l'API avec tarification à l'unité par jeton

- Abonnement Claude Pro disponible pour un usage individuel.

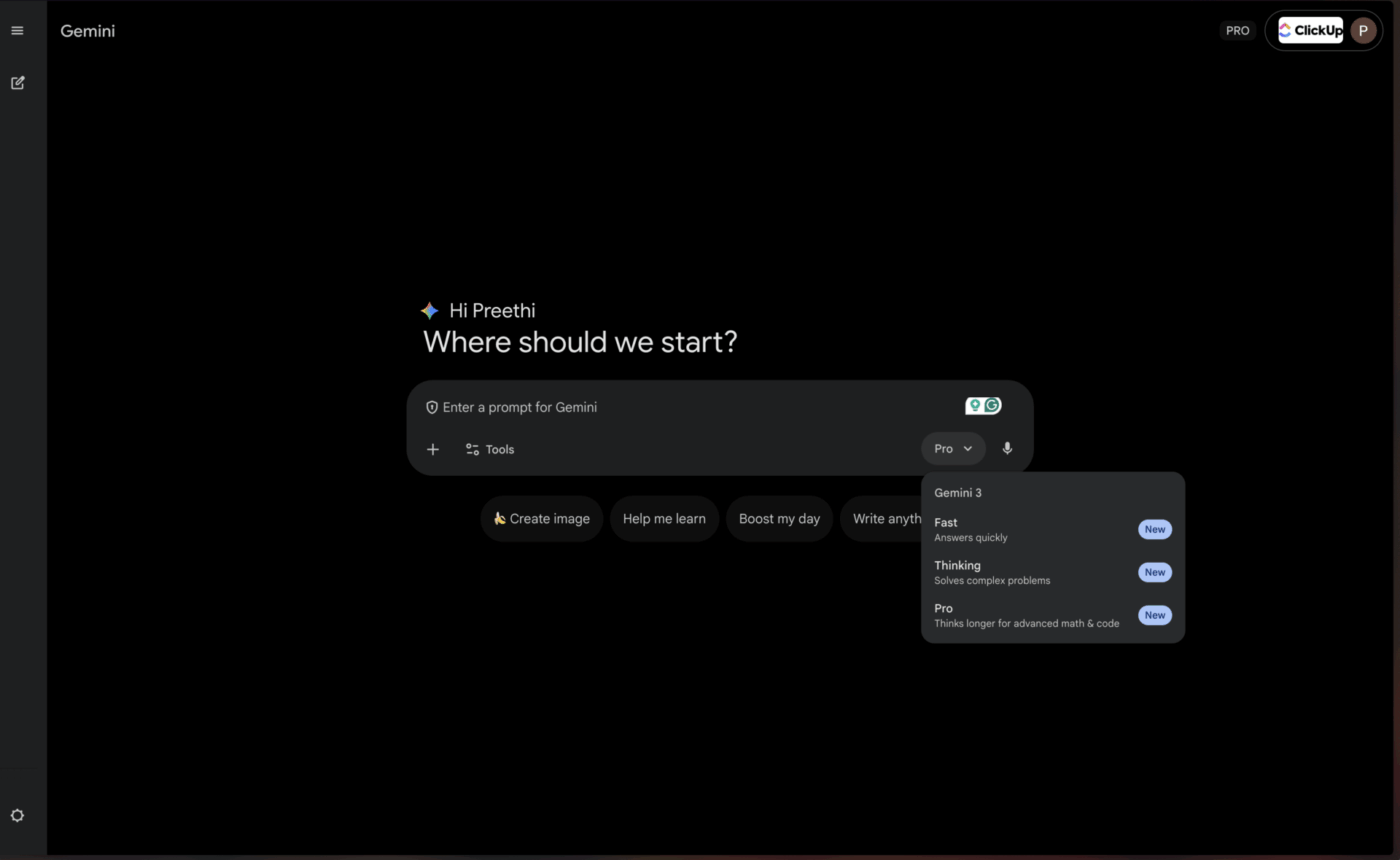

4. Google Gemini 1. 5 Pro (idéal pour les utilisateurs de Google Workspace)

Pour les équipes qui vivent et respirent déjà dans l'écosystème Google, Gemini 1. 5 Pro offre un niveau de commodité presque imbattable. Il dispose d'une fonctionnalité permettant de présenter la plus grande fenêtre contextuelle actuellement disponible (jusqu'à 1 million de tokens), ce qui le rend parfait pour résumer les transcriptions de réunions interminables de Google Meet ou pour synthétiser les informations provenant de plusieurs articles de recherche stockés dans Google Drive.

Grâce à l'intégration native avec Google Workspace, vous pouvez obtenir des résumés sans jamais quitter les outils que vous utilisez quotidiennement. Cela rend cette fonctionnalité particulièrement utile pour les équipes qui s'appuient fortement sur les résumeurs de réunions basés sur l'IA au sein de l'écosystème Google.

Les meilleures fonctionnalités de Gemini 1. 5 Pro

- Une fenêtre contextuelle massive de un million de jetons permet de traiter des documents extrêmement longs.

- Intégration native à Google Workspace pour un flux de travail fluide

- Capacités multimodales pour le texte, les images et la vidéo

Limitations de Gemini 1. 5 Pro

- Pour profiter pleinement des avantages, il faut investir dans l'écosystème Google.

- Les performances en dehors de l'intégration Google peuvent être inférieures à celles des concurrents.

Tarifs Gemini 1. 5 Pro

- Disponible via Google IA Studio et Vertex AI.

- Les tarifs varient en fonction de l'utilisation et des accords d'entreprise.

📌 ClickUp Insight : En moyenne, un professionnel passe plus de 30 minutes par jour à rechercher des informations liées à son travail, soit plus de 120 heures par an perdues à fouiller dans ses e-mails, ses fils de discussion Slack et ses fichiers éparpillés. Un assistant IA intelligent intégré à votre environnement de travail peut changer cela en faisant apparaître les bons documents, les bonnes discussions et les bons détails de tâches en quelques secondes.

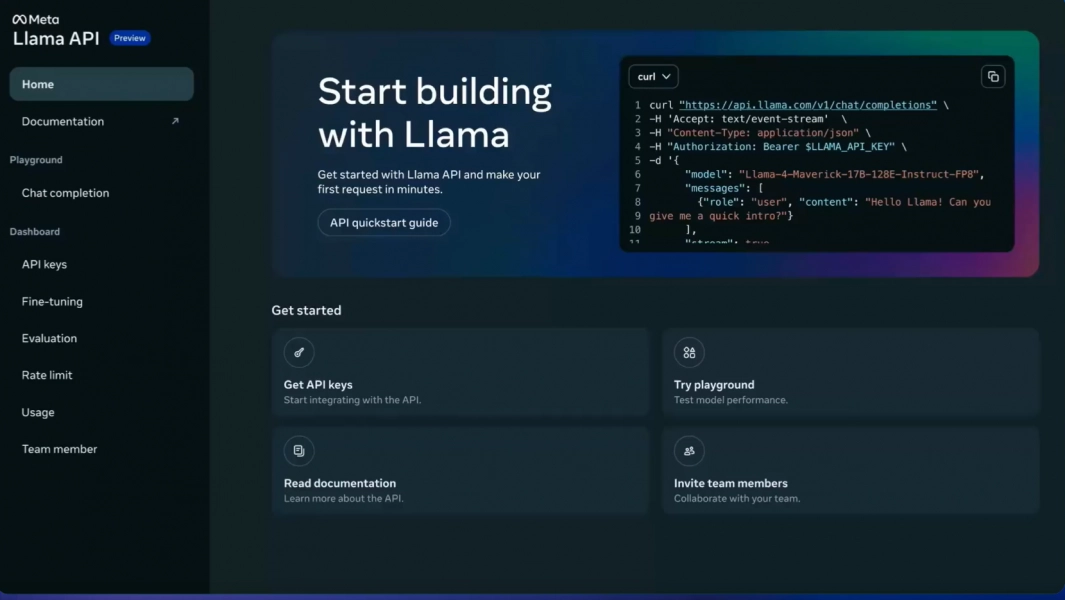

5. Meta LLaMA 3 (idéal pour les pipelines auto-hébergés et personnalisables)

Votre équipe a besoin d'un contrôle total sur ses données et souhaite éviter d'envoyer des informations sensibles à un service tiers. C'est là qu'un modèle open source comme LLaMA 3 prend tout son sens. Vous pouvez l'héberger sur vos propres serveurs, l'ajuster aux données spécifiques de votre entreprise afin de mieux comprendre votre jargon, et le personnaliser de manière personnalisée, le tout sans frais de licence.

La qualité de la résumation est impressionnante et rivalise souvent avec celle des modèles propriétaires. Le hic, c'est qu'il faut disposer d'une infrastructure technique. Votre équipe aura besoin de ressources d'ingénierie pour déployer et assurer la maintenance du modèle, car il n'existe pas d'API gérée prête à l'emploi. Cela en fait un outil idéal pour les organisations axées sur l'ingénierie ou la confidentialité.

Les 3 meilleures fonctionnalités de LLaMA 3

- Contrôle total des données grâce à un déploiement auto-hébergé

- Capacité d'ajustement pour la terminologie spécifique à un domaine

- Aucun frais de licence pour une utilisation commerciale.

Limites de LLaMA 3

- Nécessite une infrastructure technique importante pour le déploiement.

- Pas d'API gérée : votre équipe se charge de la maintenance.

- La complexité de l'installation initiale peut retarder le retour sur investissement.

Tarifs LLaMA 3

- Utilisation gratuite avec licence open source.

- Les coûts d'infrastructure dépendent des choix d'hébergement.

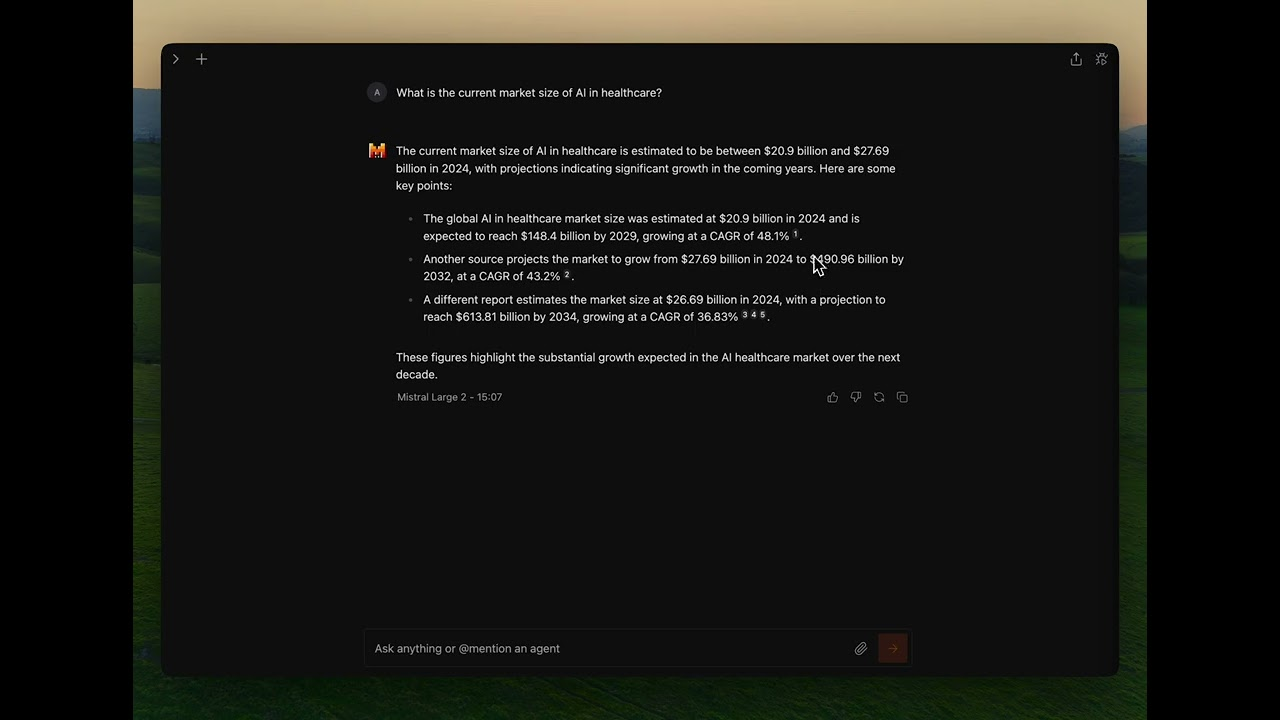

6. Mistral Large (le meilleur pour les exigences de résidence des données de l'UE)

Que faire si vous souhaitez bénéficier de la flexibilité de l'open source, mais que vous ne disposez pas des ressources nécessaires pour gérer vous-même l'infrastructure ? Mistral Large offre un compromis intéressant. Développé par une entreprise européenne, il offre des performances de résumation compétitives en mettant l'accent sur l'efficacité.

Mistral fournit à la fois une API gérée pour un accès facile et des modèles ouverts pour les équipes qui souhaitent davantage de contrôle. Cette approche hybride est son principal avantage. En contrepartie, son écosystème d'intégrations tierces est plus restreint que celui de géants tels qu'OpenAI et Google. C'est un excellent choix pour les équipes qui recherchent un équilibre entre commodité et contrôle, en particulier celles qui sont soumises à des exigences de résidence des données dans l'UE.

Les meilleures fonctionnalités de Mistral Large

- Accès hybride via une API gérée ou un déploiement auto-hébergé.

- Performances élevées et conformité aux exigences européennes en matière de résidence des données

- Prix compétitifs par rapport aux principaux modèles propriétaires

Limitations de Mistral Large

- Écosystème d'intégration plus petit que celui d'OpenAI ou de Google.

- Documentation et ressources communautaires moins exhaustives

Tarifs Mistral Large

- Accès à l'API avec une tarification compétitive par jeton

- Modèles à poids ouvert disponibles pour l'auto-hébergement

💡 Conseil de pro : si votre objectif principal est de résumer en une seule fois les transcriptions d'une réunion d'une heure, privilégiez les modèles offrant la plus grande fenêtre contextuelle, comme Gemini 1. 5 Pro. Si vous devez enseigner au modèle la terminologie spécifique à votre entreprise, optez pour une option open source comme LLaMA 3.

💡 Conseil de pro : si votre objectif principal est de résumer en une seule fois les transcriptions d'une réunion d'une heure, privilégiez les modèles offrant la plus grande fenêtre contextuelle, comme Gemini 1. 5 Pro. Si vous devez enseigner au modèle la terminologie spécifique à votre entreprise, optez pour une option open source comme LLaMA 3.

Comparaison des modèles de résumé LLM

Une comparaison rapide vous aide à identifier en un coup d'œil le modèle qui correspond le mieux aux priorités de votre équipe.

ClickUp Brain intègre la résumation directement dans votre flux de travail sous la forme d'un espace de travail IA convergent, idéal pour transformer les résumés en actions immédiates, avec pour principal compromis le fait qu'il fonctionne de manière optimale au sein de l'écosystème ClickUp.

GPT-4o offre une large fenêtre contextuelle en tant que modèle propriétaire, idéal pour des résumés raffinés et nuancés, avec pour principal compromis une tarification basée sur l'utilisation.

Claude 3. 5 Sonnet offre une fenêtre contextuelle étendue en tant que modèle propriétaire, idéal pour les documents sensibles en matière de conformité dont la disponibilité régionale constitue la principale limite.

Gemini 1. 5 Pro offre une fenêtre contextuelle massive en tant que modèle propriétaire, parfait pour les utilisateurs de Google Workspace, même si le verrouillage de l'écosystème peut être un sujet de préoccupation.

LLaMA 3 comprend une grande fenêtre contextuelle en tant que modèle open source, adapté aux pipelines personnalisables auto-hébergés, mais nécessite un investissement en infrastructure.

Mistral Large dispose d'une fonctionnalité de grande fenêtre contextuelle avec une approche d'accès hybride, excellente pour les besoins de résidence des données dans l'UE, bien qu'il dispose d'un écosystème d'intégration plus restreint.

📖 À lire également : Les meilleurs résumeurs de transcriptions basés sur l'IA

Comment évaluer la qualité de la résumation des LLM

Pour savoir si les résumés d'un modèle sont réellement bons, il faut disposer d'un cadre d'évaluation clair. Se fier à un mauvais résumé peut être pire que de ne pas avoir de résumé du tout, car cela peut conduire à prendre de mauvaises décisions sur la base d'informations inexactes.

Critères clés d'évaluation

La précision détermine si le résumé reprend correctement les points principaux du texte original sans inventer de faits ni commettre d'erreurs. Ce critère est incontournable pour les documents critiques pour l'entreprise.

La cohérence mesure si le résumé est facile à lire et s'il suit un flux logique, ou s'il donne l'impression d'être un mélange de phrases décousues. Les bons résumés conservent une structure narrative.

La concisité évalue si le résumé va droit au but ou s'il est rempli de mots superflus et inutiles. Les meilleurs résumés maximisent la densité d'informations.

Le respect des instructions permet de vérifier si le modèle est capable de suivre vos demandes concernant des tons, des formats ou des domaines d'intérêt spécifiques, tels que les listes à puces ou les briefings de type exécutif.

La cohérence évalue si le modèle produit des résumés de haute qualité pour différents types de documents ou s'il ne fonctionne bien que pour certains d'entre eux.

Un cadre de test simple

Choisissez trois documents que votre équipe utilise régulièrement : un brief de projet, un compte rendu de réunion et un fil d'e-mails avec un client. Traitez chaque document à l'aide des modèles que vous envisagez d'utiliser, en utilisant les mêmes instructions. Demandez ensuite à un membre de l'équipe d'évaluer les résultats par rapport aux critères ci-dessus. Bien qu'il existe des indicateurs automatisés, rien ne vaut une évaluation humaine pour détecter les erreurs subtiles.

🔍 Le saviez-vous ? Des équipes telles que QubicaAMF ont gagné plus de 5 heures par semaine grâce à ClickUp, soit plus de 250 heures par an et par personne, en éliminant les processus de gestion des connaissances obsolètes. Imaginez ce que votre équipe pourrait accomplir avec une semaine supplémentaire de productivité chaque trimestre.

🔍 Le saviez-vous ? Des équipes telles que QubicaAMF ont gagné plus de 5 heures par semaine grâce à ClickUp, soit plus de 250 heures par an et par personne, en éliminant les processus de gestion des connaissances obsolètes. Imaginez ce que votre équipe pourrait accomplir avec une semaine supplémentaire de productivité chaque trimestre.

Quelles sont les limites de l'utilisation des LLM pour la résumation de documents ?

Cette technologie présente des limites réelles qu'il convient de comprendre avant de procéder à la validation d'une approche particulière.

Risques d'hallucination

Le plus grand risque est l'hallucination, c'est-à-dire lorsque le modèle affirme avec certitude des détails incorrects qui semblent plausibles. Les équipes juridiques, les analystes financiers et toute personne travaillant avec des documents sensibles en matière de conformité doivent toujours faire vérifier par un humain les résumés à fort enjeu.

Limites de la fenêtre contextuelle

Même les modèles les plus volumineux ont leurs limites, de sorte que les documents extrêmement longs peuvent devoir être divisés en plusieurs parties. Ce découpage peut empêcher le modèle de faire les connexions entre des sections éloignées ou lui faire perdre le fil narratif global.

Perte de nuance

Les arguments subtils ou les points de vue minoritaires sont souvent aplatis dans les résumés. Si la préservation des opinions divergentes ou des cas limites est importante pour votre cas d'utilisation, vous devrez rédiger soigneusement vos invitations ou accepter une certaine perte d'informations.

Défis liés à la spécificité du domaine

Un modèle polyvalent peut ne pas comprendre le jargon spécifique à votre secteur d'activité sans un ajustement précis. Les champs médical, juridique et technique nécessitent souvent une formation supplémentaire ou une ingénierie minutieuse.

Considérations relatives à la sécurité

L'envoi de données sensibles de l'entreprise à une API tierce comporte toujours un certain degré de risque. Pour les documents hautement confidentiels, des modèles auto-hébergés ou des accords d'entreprise avec des conditions spécifiques de traitement des données peuvent être nécessaires.

Ce ne sont pas des raisons pour éviter cette technologie, mais ce sont des considérations importantes. Vous pouvez les atténuer grâce à des pratiques intelligentes : faites toujours vérifier les résumés importants par un humain, utilisez des modèles auto-hébergés pour les données hautement sensibles et utilisez des invitations claires pour aider le modèle à préserver les nuances importantes.

📌 ClickUp Insight : 62 % des travailleurs du savoir s'appuient sur des outils d'IA conversationnelle tels que ChatGPT et Claude. Leur interface de chatbot familière et leurs capacités polyvalentes pourraient expliquer leur popularité dans divers rôles et secteurs. Cependant, le fait de passer à un autre onglet pour poser une question à l'IA à chaque fois augmente les coûts liés au changement de contexte et à la commutation entre les onglets.

📌 ClickUp Insight : 62 % des travailleurs du savoir s'appuient sur des outils d'IA conversationnelle tels que ChatGPT et Claude. Leur interface familière de chatbot et leurs capacités polyvalentes pourraient expliquer leur popularité dans divers rôles et secteurs. Cependant, le fait de passer à un autre onglet pour poser une question à l'IA à chaque fois augmente les coûts liés au changement de contexte et à la commutation entre les onglets.

Utilisez ClickUp Brain dans votre flux de travail de résumé

Vous avez vu comment ClickUp Brain se classe parmi les meilleurs LLM pour la synthèse. Voyons maintenant comment créer des flux de travail qui transforment ces résumés en gains de productivité réels. La différence entre un résumé utile et un effort inutile réside dans sa capacité à établir une connexion avec une action, et c'est là que l'environnement de travail IA convergé prend tout son sens.

[Image d'illustration : environnement de travail ClickUp montrant la synthèse Brain intégrée aux tâches et aux documents]

Obtenez des résumés directement sur votre lieu de travail.

Éliminez les transferts manuels fastidieux en intégrant directement la synthèse à vos projets. Avec ClickUp Brain, il vous suffit de taper @brain dans n'importe quel commentaire de tâche ou message ClickUp Chat et de lui demander de résumer le contexte. Il fournit instantanément un résumé en utilisant sa connaissance de votre espace de travail, en donnant la priorité à la tâche ou au canal spécifique dans lequel vous vous trouvez.

Transformez automatiquement les enregistrements de réunions en éléments à mener.

Pour rattraper votre retard après avoir manqué une réunion, vous n'avez plus besoin de passer des heures à lire vos notes. Restez pleinement concentré sur les discussions pendant que ClickUp AI Notetaker prend des notes pour vous. Après la réunion, il vous fournit une transcription et un résumé. Vous pouvez même lui demander de générer automatiquement des actions à entreprendre et de les transformer en tâches ClickUp avec des personnes assignées et des dates d'échéance.

Tirez parti de plusieurs LLM sans avoir à gérer la sélection des modèles.

Obtenez des résultats de haute qualité sans jamais avoir à gérer vous-même la sélection des modèles, car ClickUp Brain exploite plusieurs LLM en arrière-plan. Voici à quoi ressemble ce flux de travail dans la pratique : une réunion a lieu, le ClickUp AI Notetaker capture tout, ClickUp Brain fournit un résumé des décisions clés et les mesures à prendre sont déjà intégrées à votre plan de projet. Vous pouvez même utiliser @My Brain pour résumer en privé un fil de discussion ou rédiger une réponse avant de la partager avec l'équipe.

✨ Résultats concrets : le véritable défi consiste à transformer les résumés en actions. ClickUp Brain excelle dans la connexion directe des résumés aux tâches de votre flux de travail, éliminant ainsi le fossé entre la compréhension et l'exécution qui affecte les outils de synthèse autonomes.

✨ Résultats concrets : le véritable défi consiste à transformer les résumés en actions. ClickUp Brain excelle dans la connexion directe des résumés aux tâches de votre flux de travail, éliminant ainsi le fossé entre la compréhension et l'exécution qui affecte les outils de synthèse autonomes.

Conclusion

Le meilleur LLM pour la résumation est celui qui répond aux besoins spécifiques de votre équipe, qu'il s'agisse d'une fenêtre contextuelle massive pour les rapports longs, d'une flexibilité open source pour la personnalisation ou d'une intégration transparente avec vos outils existants. Avant la validation, testez toujours vos meilleurs choix avec vos propres documents réels pour voir comment ils fonctionnent.

Mais n'oubliez pas qu'un résumé n'a de valeur que s'il est lié à une action. La synthèse est en train de passer d'une tâche autonome à une fonctionnalité profondément intégrée aux plateformes sur lesquelles vous travaillez déjà. Le véritable gain de productivité provient de la réduction de l'écart entre l'obtention d'une information et son exploitation.

Commencez gratuitement avec ClickUp et intégrez la synthèse par IA directement dans votre gestion des tâches, vos discussions et vos documents.

FAQ

Quelle est la différence entre le résumé extractif et le résumé abstrait des LLM ? Le résumé extractif consiste à extraire les phrases clés directement du texte original, tandis que le résumé abstrait génère des phrases entièrement nouvelles pour transmettre le sens essentiel. Les LLM modernes utilisent principalement la méthode abstraite, qui permet d'obtenir des résumés plus naturels qui reflètent mieux l'essence du document source.

Comment les LLM open source se comparent-ils aux modèles propriétaires tels que GPT-4 en matière de résumation ? Les modèles open source offrent un contrôle total sur vos données et la possibilité de les adapter à vos besoins spécifiques, mais leur maintenance nécessite des ressources techniques. Les modèles propriétaires offrent commodité et facilité d'utilisation grâce à une API, mais ils entraînent des coûts d'utilisation et offrent moins de contrôle sur les données. L'écart de qualité s'est considérablement réduit, les options open source telles que LLaMA 3 rivalisant avec les performances des modèles propriétaires dans de nombreux cas d'utilisation.

Les outils de résumé LLM peuvent-ils traiter les notes de réunion et les mises à jour de projet ? Oui, la plupart des LLM sont très efficaces pour résumer des textes de discussion tels que des notes de réunion. Le véritable défi consiste à transformer ces résumés en actions, et c'est là que des outils tels que ClickUp Brain excellent en reliant directement les résumés aux tâches de votre flux de travail plutôt que de les laisser sous forme de documents texte isolés.

Quelle taille de fenêtre contextuelle dois-je utiliser pour mes documents ? Pour les documents d'entreprise standard de moins de 10 000 mots, la plupart des LLM modernes disposent de fenêtres contextuelles suffisantes. Pour les transcriptions de réunions de plus d'une heure ou les rapports de recherche complets, vous aurez besoin de modèles avec des fenêtres contextuelles étendues, tels que Claude 3. 5 Sonnet ou Gemini 1. 5 Pro. La fenêtre d'un million de tokens de Gemini 1. 5 Pro peut traiter pratiquement toutes les tâches de résumé de documents uniques.

Comment réduire le risque d'hallucination dans les résumés LLM ? Utilisez des invites claires et spécifiques qui demandent au modèle de ne résumer que ce qui est explicitement mentionné dans la source. Demandez des citations ou des références à des sections spécifiques lorsque la précision est essentielle. Pour les documents à enjeux élevés, faites toujours comparer le résumé à l'original par un réviseur humain. Envisagez des modèles avec un alignement de sécurité plus fort comme Claude lorsque vous travaillez avec du contenu sensible en matière de conformité.