Wichtige Erkenntnisse

- Die agentenbasierte KI von OpenAI automatisiert mehrstufige Aufgaben mithilfe integrierter Tools.

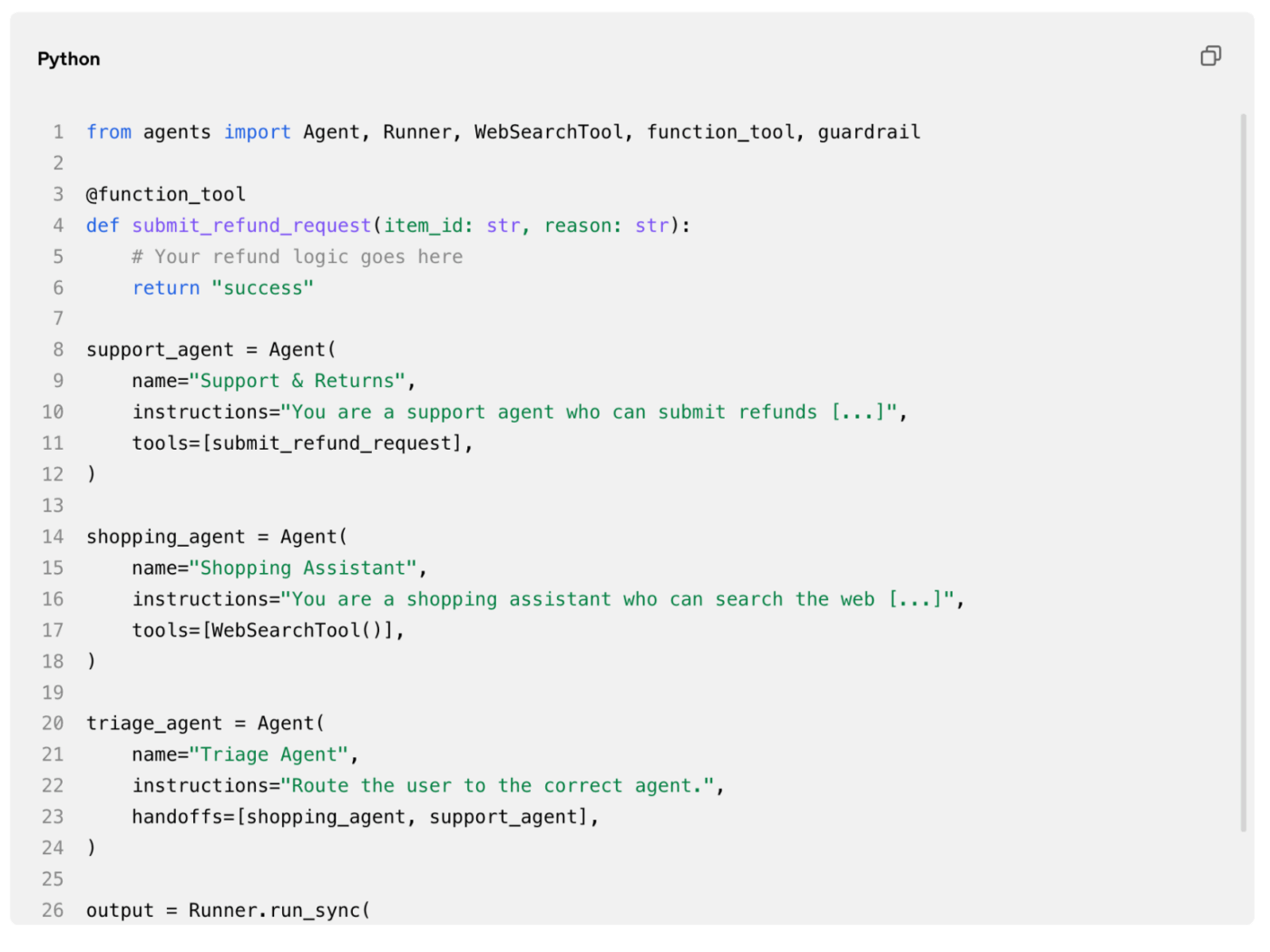

- Mit AgentKit können Entwickler benutzerdefinierte Agenten mit Low-Code-Orchestrierung erstellen.

- Agenten greifen mit Benutzerberechtigungen und Sicherheitsvorkehrungen sicher auf Apps von Drittanbietern zu.

- Rollouts funktionieren am besten, wenn sie zunächst mit engen, hochwertigen Aufgaben getestet werden.

Bietet OpenAI Agentic KI an?

Ja, OpenAI bietet ein voll funktionsfähiges agentenbasiertes KI-Produkt an.

Das Unternehmen hat am 17. Juli 2025 den ChatGPT-Agentenmodus eingeführt, mit dem die Plattform mithilfe integrierter Tools wie Webbrowsing und Codeausführung mehrstufige Aufgaben autonom abschließen kann.

Drei Monate später veröffentlichte OpenAI AgentKit, eine umfassende Suite von Entwicklertools, die für die End-to-End-Erstellung, Bereitstellung und Optimierung von KI-Agenten entwickelt wurde.

Mit diesen Veröffentlichungen positioniert sich OpenAI als Vorreiter auf dem Markt für agentische KI. Das Unternehmen richtet sich an Führungskräfte aus dem Geschäft und der Produktentwicklung, die intelligente Automatisierung wünschen, ohne ihre gesamte Technologieinfrastruktur umbauen zu müssen.

Nachdem ich die Plattform in den letzten Monaten selbst getestet habe, fand ich das Setup überraschend einfach, obwohl der Agent manchmal mit nuancierten Aufgaben zu kämpfen hatte, die domänenspezifisches Urteilsvermögen erforderten.

Wie funktioniert das eigentlich?

Die agentenbasierte KI von OpenAI arbeitet mit einem einheitlichen System, das die Schlussfolgerungsfähigkeiten von ChatGPT mit der Möglichkeit kombiniert, Websites zu durchsuchen, Code auszuführen und APIs auf einem virtuellen Computer aufzurufen.

Wenn Sie eine Aufgabe zuweisen, bewertet der Agent das Ziel, führt eine Auswahl der geeigneten Tools durch und führt eine Reihe von Aktionen aus, bis das Ziel abgeschlossen ist oder eine Hürde auftritt.

Der Agent kann Konnektoren zu Gmail, GitHub, Slack und anderen Anwendungen nutzen und greift erst nach Einholung der Berechtigung sicher auf Benutzerdaten zu. Diese Berechtigungsebene stellt sicher, dass keine sensiblen Aktionen ohne ausdrückliche Genehmigung erfolgen.

| Komponente | Geschäftsfunktion |

|---|---|

| Webbrowsing | Marktforschung, Wettbewerbsanalyse, Echtzeit-Datenabruf |

| Codeausführung | Datentransformation, Automatisierung der Skripte, Berichterstellung |

| API-Aufrufe | CRM-Aktualisierungen, Auftragsabwicklung, Integration von Drittanbieterdiensten |

| Zugriff auf Konnektoren | E-Mail-Entwürfe, Kalenderplanung, Dokumentenabruf |

Bei meinen eigenen Tests habe ich festgestellt, dass der Agent vor dem Versenden von E-Mails oder dem Ändern von Dateien eine Pause einlegte, was Vertrauen in seinen Entscheidungsprozess schuf.

Dank dieser Architektur kann der Agent Aufgaben übernehmen, für die zuvor mehrere Tools und manuelle Übergaben erforderlich waren. So kann er beispielsweise Verkaufsdaten aus einem CRM abrufen, Trends in einer Tabellenkalkulation analysieren und eine zusammenfassende E-Mail verfassen, ohne den Kontext wechseln zu müssen.

Dieser Unterschied ist wichtig, da die Geschwindigkeit der Bearbeitung von Aufgaben steigt, wenn ein einziges System den gesamten Workflow koordiniert. Wie sieht das nun aus, wenn ein echter Benutzer es einsetzt?

Wie sieht das in der Praxis aus?

Stellen Sie sich einen Produktmanager vor, der Wettbewerbsinformationen für eine bevorstehende Sitzung zur Sprint-Planung zusammenstellen muss.

Anstatt manuell die Websites der Mitbewerber zu besuchen, Listen mit Features zu kopieren und Notizen zu erstellen, aktiviert sie den ChatGPT-Agentenmodus mit einer einzigen Eingabeaufforderung: „Recherchiere die drei besten CRM-Plattformen, vergleiche ihre KI-Funktionen und fasse die Ergebnisse in einer Tabelle zusammen. “

Der Agent verfolgt einen klaren Weg vom Problem zum Ergebnis:

- Identifiziert den Umfang der Aufgabe und bestätigt die drei CRM-Plattformen, die recherchiert werden sollen.

- Durchsucht die Websites und Dokumentationen der einzelnen Anbieter, um Details zu den KI-Features zu extrahieren.

- Erstellt aus den Ergebnissen eine übersichtliche Vergleichstabelle.

- Überprüft die Ergebnisse auf Genauigkeit und kennzeichnet fehlende Informationen.

Innerhalb von 10 Minuten hat der Produktmanager ein Dokument, das er sofort freigeben kann. Diese Geschwindigkeit und Autonomie stehen in starkem Kontrast zu herkömmlichen Forschungsassistenten, die Schritt-für-Schritt-Anweisungen oder manuelle Überprüfungen in jeder Phase erfordern.

Konkurrierenden Lösungen fehlt oft die enge Integration zwischen Schlussfolgerungen, Browsing und Datenbearbeitung, die OpenAI in einer einzigen Schnittstelle bündelt. Das bringt uns zu der allgemeineren Frage, was OpenAI in einem umkämpften Feld auszeichnet.

Was macht OpenAI so besonders?

OpenAI hat sich eine einzigartige Position unter den führenden Unternehmen im Bereich der Agentenentwicklung erarbeitet, indem es innerhalb desselben Jahres einen verbraucherorientierten Agentenmodus und ein vollständiges Entwickler-Toolkit entwickelt hat.

Während andere Anbieter sich auf eine begrenzte Automatisierung konzentrieren oder umfangreiche benutzerdefinierte Programmierungen erfordern, bietet OpenAI eine Plug-and-Play-Lösung für nicht-technische Benutzer sowie umfassende Anpassungsoptionen für Ingenieurteams.

Das Unternehmen hat außerdem Sicherheit und Governance in den Vordergrund gestellt. OpenAI hat Guardrails veröffentlicht, eine modulare Open-Source-Sicherheitsschicht, die automatisch personenbezogene Daten maskieren, Jailbreak-Versuche erkennen und die Einhaltung von Richtlinien durchsetzen kann.

Dadurch wird sichergestellt, dass eingesetzte Agenten innerhalb vertrauenswürdiger Grenzen arbeiten, was für Unternehmen, die mit sensiblen Informationen umgehen, von entscheidender Bedeutung ist.

Hier sind die Schlüssel-Stärken und -Nachteile der Plattform:

- AgentKit bietet eine visuelle Drag-and-Drop-Oberfläche für die Orchestrierung von Multi-Agent-Workflows, ohne dass Sie dafür Code für die Orchestrierung schreiben müssen.

- Integrierte Tools wie Websuche, Dateisuche und Computersteuerung reduzieren den Bedarf an benutzerdefinierten Integrationen.

- Frühe Benutzer berichten von gelegentlichen Genauigkeitsproblemen und langsamer Leistung bei komplexen, mehrstufigen Aufgaben.

- Aufgrund des Limits beim Zugriff auf reale Dienste müssen einige Aufgaben weiterhin manuell nachverfolgt werden.

Ein Reddit-Benutzer fasste die gemischten Gefühle gut zusammen: „Ich habe in einer Woche komplexe Anwendungen entwickelt, für die ich früher Monate gebraucht hätte“, während ein anderer bemerkte, dass der Agent „regelmäßig grundlegende Aufgaben nicht erfüllt“ und es ihm an der für die robotergestützte Automatisierung der Prozessautomatisierung in Unternehmen erforderlichen Transparenz mangelt.

Diese gegensätzlichen Erfahrungen zeigen, dass die Plattform zwar noch in der Entwicklung ist, aber bereits ihr transformatives Potenzial erkennen lässt.

Vor diesem Hintergrund wollen wir nun untersuchen, wie sich die Agenten von OpenAI in bestehende Technologie-Ökosysteme von Unternehmen einfügen.

Integration und Anpassung an das Ökosystem

Die agentenbasierte KI von OpenAI lässt sich über eine zentralisierte Connector Registry in umgebende Systeme einbinden, die sofort einsatzbereite Integrationen für gängige Anwendungen im Bereich des Unternehmens bieten.

Administratoren verwalten diese Konnektoren über eine einzige Konsole und gewähren oder beschränken den Zugriff basierend auf Rollen und Compliance-Anforderungen.

Das Agents SDK und die Responses API bieten integrierte Tools wie Websuche, Dateisuche und Computersteuerung, mit denen Entwickler Agenten erstellen können, die Live-Informationen abrufen und Aktionen ausführen, ohne dass benutzerdefinierter Code erforderlich ist. Dies reduziert Reibungsverluste bei der Implementierung und beschleunigt den Wert.

So fügen sich die wichtigsten Plattformen in das OpenAI-Agenten-Ökosystem ein:

| Plattform | Integrationsrolle |

|---|---|

| Dropbox, Google Drive, SharePoint | Sicherheit beim Zugriff auf Dokumente und deren Abruf für Recherche und Berichterstellung |

| Microsoft Teams, Slack | Echtzeit-Messaging, Benachrichtigungen und Workflow-Koordination |

| Gmail, Outlook | E-Mail-Entwürfe, Terminplanung und Verwaltung des Posteingangs |

| GitHub | Zugriff auf Code-Repositorys, Automatisierung von Pull Requests, Versionskontrolle |

Die Integration von Modellen von Drittanbietern wird ebenfalls unterstützt. Die Plattform ist nicht auf OpenAI-Modelle beschränkt. Entwickler können andere Modelle innerhalb der Plattform evaluieren und externe APIs über standardisierte Schnittstellen aufrufen.

Dank dieser Erweiterungen lassen sich OpenAI-Agenten in heterogenen Tech-Stacks einsetzen, in denen mehrere KI-Anbieter nebeneinander existieren.

Implementierungszeitleiste und Änderungsmanagement

Die Einführung von Agentic KI funktioniert am besten, wenn Unternehmen die Einführung in Phasen vornehmen, anstatt sie unternehmensweit auf einen Schlag durchzuführen.

Beginnen Sie mit einem kleinen Pilotprojekt, das auf einen hochwertigen, risikoarmen Workflow abzielt, z. B. die Automatisierung der Triage von Kundensupport-Tickets oder die Erstellung wöchentlicher Umsatzzusammenfassungen. So können Teams die Stärken und Grenzen der Plattform in einer kontrollierten Umgebung kennenlernen.

Hier ist eine bewährte Rollout-Sequenz:

- Starten Sie ein Pilotprojekt mit einem Team und einer einzigen, klar definierten Aufgabe.

- Bewerten Sie Metriken wie die Rate des Abschlusses von Aufgaben und die Benutzerzufriedenheit.

- Verfeinern Sie Eingabeaufforderungen, Konnektoren und Schutzvorrichtungen auf der Grundlage von Pilot-Feedback.

- Erweitern Sie die Nutzung auf benachbarte Teams mit ähnlichen Workflows.

- Skalieren Sie auf die vollständige Bereitstellung, sobald Governance und Schulungen abgeschlossen sind.

Zu den Stakeholdern sollten IT-Sicherheitsexperten gehören, um die Richtlinien für den Datenzugriff zu überprüfen, Compliance-Beauftragte, um die Einhaltung der Vorschriften sicherzustellen, und Benutzer, um praktisches Feedback zu sammeln. Generische Beschreibungen der Rollen sorgen für Flexibilität, da sich die Organisationsstrukturen unterscheiden.

Change Management ist hier wichtig, da die agentische KI die Entscheidungsfindung in bestimmten Kontexten vom Menschen auf Algorithmen verlagert.

Transparente Kommunikation darüber, was der Agent zu erledigen hat und was nicht, verhindert unrealistische Erwartungen und schafft Vertrauen in die Technologie.

Hören wir uns nun an, was frühe Benutzer über ihre praktischen Erfahrungen sagen.

Community Buzz & Meinung der ersten Benutzer

Die ersten Reaktionen sind sehr geteilt. Einige Entwickler sind von den Geschwindigkeitsvorteilen begeistert, während andere die aktuellen Funktionen für den produktiven Einsatz als enttäuschend empfinden.

- „Ich habe in einer Woche komplexe Anwendungen entwickelt, für die ich früher Monate gebraucht hätte“ ( Reddit-Benutzer, r/aipromptprogramming ).

- „Der Agent von OpenAI ist derzeit ein netter Partytrick ... mehr nicht“ ( Reddit-Benutzer, r/ChatGPT ).

- „Das wird den RPA-Markt komplett auslöschen“ ( Reddit-Benutzer, r/produktivität ).

- „Es scheitert regelmäßig bei grundlegenden Aufgaben und kann auf die meisten realen Dienste nicht zugreifen“ ( Reddit-Benutzer, r/ChatGPT ).

Wenn Sie interessiert sind, können Sie hier alle über 500 Kommentare zu diesem Feature lesen, um zu sehen, was ich meine:

Die Einführung von AgentKit löste auch eine Diskussion darüber aus, dass Drittanbieter von KI-Agenten-Builders möglicherweise Schwierigkeiten haben werden, sich im Wettbewerb zu behaupten, wenn sie sich nicht spezialisieren oder einen einzigartigen Wert bieten.

Ein Beobachter machte die Notiz, dass „die meisten Startups, die No-Code-KI-Workflows anbieten, plötzlich überflüssig erscheinen“, da OpenAI nun einen nativen Agent Builder bereitstellt.

Trotz der derzeitigen Einschränkungen bleibt ein Teil der Community optimistisch. Die Meinung ist, dass agentische KI die Automatisierung revolutionieren könnte, sobald die Lücken in Bezug auf Zuverlässigkeit und Compliance geschlossen sind.

Die Erledigung alltäglicher Aufgaben wie das Ausfüllen von Formularen, Einkaufen oder Datenüberwachung stellt das dar, was manche als „den größten technologischen Paradigmenwechsel unserer Zeit“ bezeichnen.

Diese polarisierten Ansichten bilden die Grundlage für das Verständnis, wohin OpenAI die Plattform als Nächstes führen will.

Roadmap und Outlook auf das Ökosystem

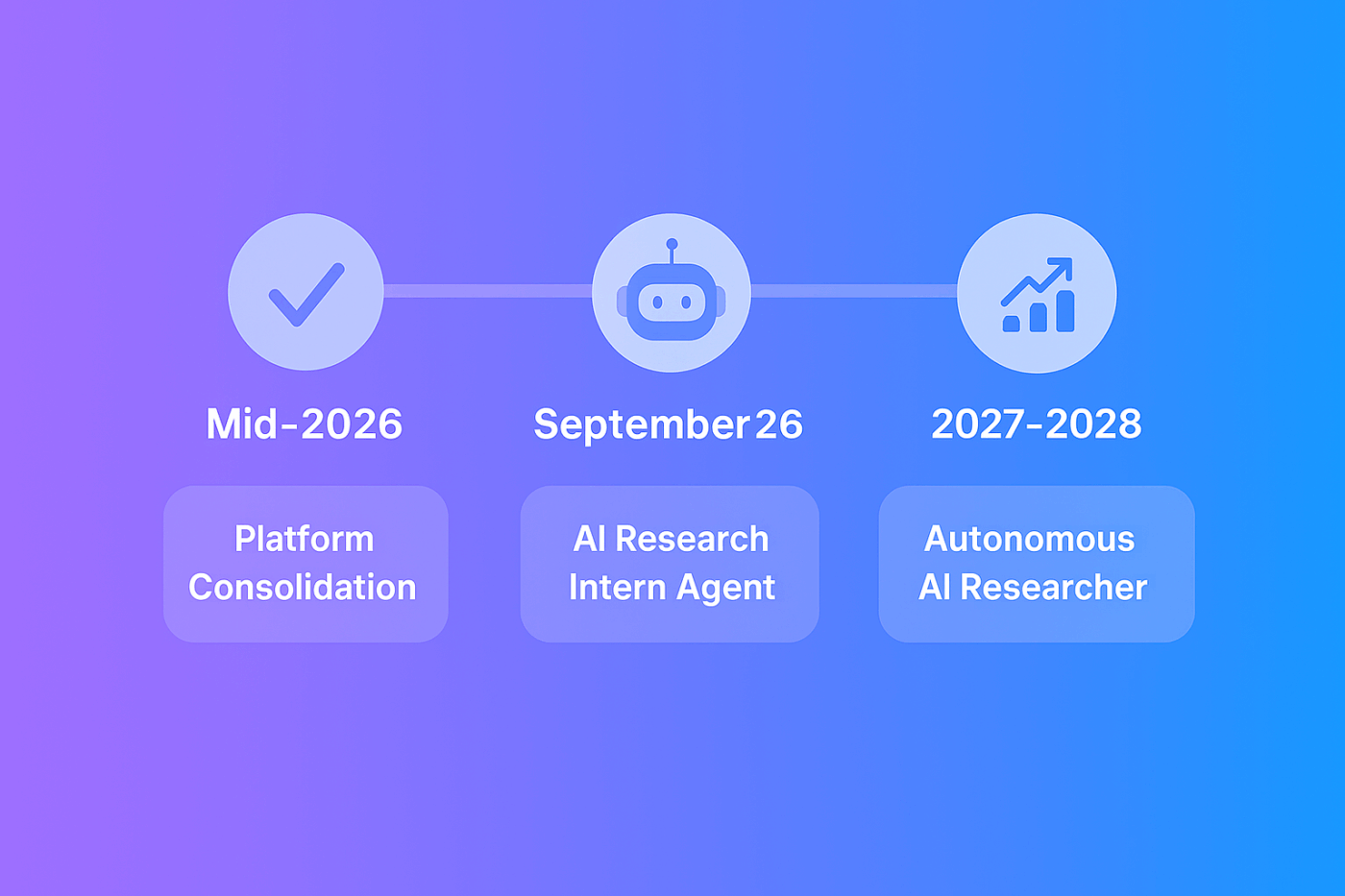

OpenAI hat eine ehrgeizige Zeitleiste aufgestellt, die von der Plattformkonsolidierung bis hin zu autonomen Forschungsfunktionen reicht.

Bis Mitte 2026 hat OpenAI den Plan, die Legacy-Assistants-API auslaufen zu lassen, sobald die Responses-API und das Agent SDK die volle Funktionsparität erreicht haben.

Dadurch werden Entwickler auf einer einzigen, verbesserten Agentenplattform vereint. Mit dem Näherrücken des Übergangsdatums sind formelle Ankündigungen zur Abkündigung und Migration-Tools zu erwarten.

Ende 2026 will OpenAI einen KI-Agenten auf den Markt bringen, der in der Lage ist, selbstständig Recherchen auf „Praktikanten”-Niveau durchzuführen. CEO Sam Altman beschrieb dieses Ziel als die Schaffung eines Systems, das Literatur lesen, Hypothesen aufstellen, Experimente durchführen und Ergebnisse mit minimaler menschlicher Anleitung analysieren kann.

Mit Blick auf die Zukunft ist das Einzelziel von OpenAI für 2028 ein „legitimer KI-Forscher”, der komplexe wissenschaftliche Probleme von Anfang bis Ende lösen kann.

Um diesen Meilenstein zu erreichen, müssten die Recheninfrastruktur skaliert, die Kontextfenster über das derzeitige Limit von fünf Stunden hinaus erweitert und algorithmische Innovationen im Bereich des Denkens vorangetrieben werden.

Zu den kurzfristigen Verbesserungen gehören eine Workflows-API zur programmgesteuerten Bereitstellung und Verwaltung von Agenten-Workflows sowie die Erweiterung der ChatGPT-Consumer-App um weitere Agentenfunktionen. Regelmäßige Modellverbesserungen werden die Argumentationsfähigkeit der Agenten weiter steigern und Fehler reduzieren.

Mit einer zukunftsorientierten Roadmap müssen Führungskräfte verstehen, welche finanziellen Verpflichtungen mit der Einführung dieser Technologie verbunden sind.

Wie viel kostet OpenAI Agentic KI?

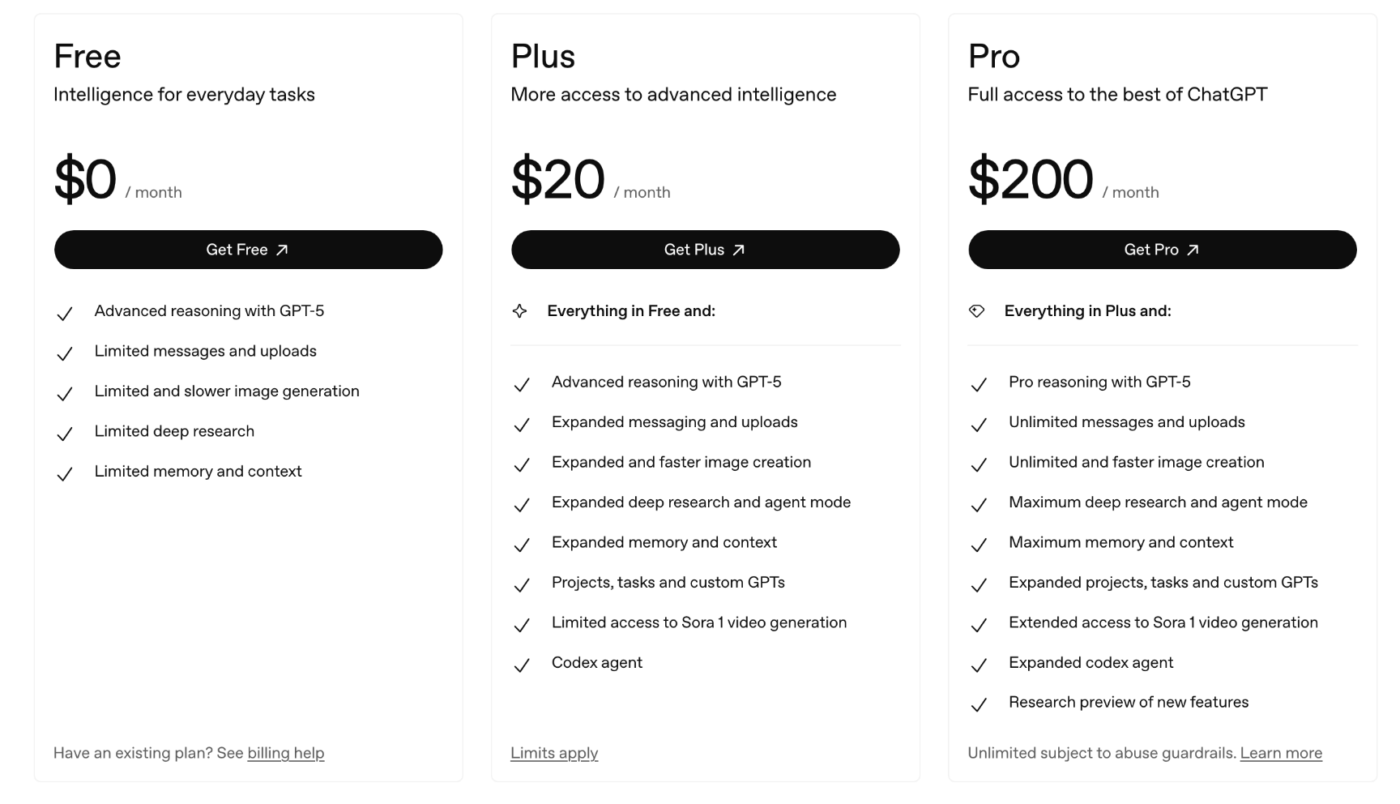

OpenAI verwendet ein gestaffeltes Abonnementmodell für den Zugriff auf ChatGPT-Agenten und berechnet API-Tools separat.

ChatGPT Plus kostet 20 US-Dollar pro Monat für einen Benutzer und umfasst etwa 40 Agentenaktionen pro Monat, wobei für zusätzliche Nutzung Pay-as-you-go-Guthaben verfügbar sind.

ChatGPT Pro kostet 200 US-Dollar pro Monat und bietet Priorität sowie eine im Wesentlichen unbegrenzte Nutzung von Agenten, wobei als Standard zunächst etwa 400 Agentenaktionen pro Monat zur Verfügung stehen.

Für Teams kostet ChatGPT Team 25 US-Dollar pro Benutzer und Monat bei einem Jahresvertrag oder 30 US-Dollar pro Benutzer und Monat. Diese Stufe umfasst alle Plus-Features für jeden Benutzer, eine gemeinsame Administrator-Konsole und höhere kombinierte Limite.

Entwickler, die die API nutzen, zahlen nur für die zugrunde liegenden Modell-Token und etwaige Add-On-API-Aufrufe. Für die Nutzung des Agents SDK, der AgentKit-Tools oder der integrierten Funktionen fallen keine separaten Gebühren an.

Für Web-Abfragen fallen jedoch zusätzliche Kosten an: 30 USD pro 1.000 Abfragen für GPT-4o Search Preview und 25 USD pro 1.000 Abfragen für GPT-4o-mini. Andere integrierte Tools wie die Dateisuche oder die Codeausführung werden ausschließlich über die verbrauchten Modell-Token abgerechnet.

Versteckte Kosten können durch rechenintensive Aufgaben oder groß angelegte Integrationen entstehen, die umfangreiche API-Aufrufe erfordern. Unternehmen sollten die Nutzung während der Pilotphase genau überwachen, um die monatlichen Ausgaben genau vorherzusagen. Wenn für ein bestimmtes Feature keine öffentlichen Preise verfügbar sind, konsultieren Sie die Geschäftsseite von OpenAI oder wenden Sie sich direkt an das Vertriebsteam.

Abschließende Gedanken

Der Agentenmodus von OpenAI ist vielversprechend, aber noch nicht für alle Anwendungsfälle produktionsreif. Ich habe gesehen, dass er sich hervorragend für Recherche und Synthese eignet, während er bei Workflows, die ein differenziertes Urteilsvermögen erfordern, noch Probleme hat.

Es ist ratsam, dies als experimentelles tool zu betrachten und nicht als vollständigen Ersatz für die Automatisierung. Beginnen Sie mit einer wiederholbaren Aufgabe mit klaren Erfolgskriterien, beobachten Sie diese genau und passen Sie dann die Eingabeaufforderungen und Berechtigungen an, bis die Ergebnisse konsistent sind.

Frühe Anwender, die sorgfältig iterieren, werden mit zunehmender Reife der Plattform wertvolles institutionelles Wissen aufbauen. Diejenigen, die auf Perfektion warten, werden zusehen müssen, wie ihre Konkurrenten den Vorteil der Lernkurve für sich nutzen.