Wenn Ihr Team Stunden damit verbringt, Prompts zu schreiben, Modelle zu optimieren und Datenpipelines zusammenzustellen, nur um einen KI-Agenten zu implementieren, kommt die Produktivität zum Erliegen.

Databricks hat Agent Bricks eingeführt, um diesen Engpass zu beseitigen, indem der gesamte Build- und Optimierungs-Workflow für Unternehmen automatisiert wird.

Dieser Leitfaden führt Sie durch die Funktionen, die Funktionsweise und die Eignung für Ihren Stack.

Wichtige Erkenntnisse

- Databricks Agent Bricks übernimmt die Automatisierung der Erstellung von Agenten mithilfe synthetischer Daten und Benchmarks.

- Sie macht manuelles Prompt-Tuning überflüssig und lässt sich direkt in Unity Catalog integrieren.

- Frühe Anwender berichten von hohen Optimierungskosten, aber einer starken Leistung in großem Maßstab.

- Regionaler Zugriff und benutzerdefinierte Anpassungsmöglichkeiten bleiben während der Beta-Phase die größten Risiken.

Bietet Databricks agentische KI?

Ja, Databricks hat Agent Bricks am 11. Juni 2025 auf seinem Data+KI Summit in San Francisco vorgestellt.

Die Plattform automatisiert die Erstellung von KI-Agenten, indem sie domänenspezifische synthetische Daten und aufgabenbezogene Benchmarks generiert und anschließend Modelle hinsichtlich Kosten und Qualität optimiert, ohne dass manuelles Prompt Engineering erforderlich ist.

Aufbauend auf der Übernahme von MosaicML durch Databricks im Jahr 2023 positioniert das Produkt Databricks sowohl als Data-Lakehouse-Anbieter als auch als agentenbasierte KI-Plattform.

Sie richtet sich an Teams, die große Mengen interner Dokumente, Aufzeichnungen zu Transaktionen oder unstrukturierte Inhalte verwalten und Agenten benötigen, die Erkenntnisse gewinnen, Fragen beantworten oder mehrstufige Workflows mit Sicherheit koordinieren können.

Agent Bricks wurde Mitte 2025 als öffentliche Beta-Version eingeführt und ist zunächst in den US-Regionen von AWS verfügbar. Ein Plan für eine Ausweitung auf Europa besteht bis Jahresende.

Wie funktioniert sie eigentlich?

Agent Bricks reduziert den traditionellen Trial-and-Error-Zyklus auf eine geführte Pipeline. Sie beschreiben die Aufgabe in einfacher Sprache, erstellen eine Verbindung zu Ihren Datenquellen über Unity Catalog und das System generiert automatisch synthetische Trainingsbeispiele, die Ihre Domäne widerspiegeln.

Diese Beispiele fließen in eine Benchmark-Suite ein, die Kandidatenmodelle hinsichtlich Genauigkeit, Latenz und Kosten bewertet. Die Plattform führt dann eine Auswahl der Konfigurationen durch, die Ihre Qualitätsanforderungen zum niedrigsten Preis pro Inferenz erfüllt.

Dieser Workflow erspart Teams die wochenlange Arbeit, die normalerweise für die Beschreibung von Daten, die Optimierung von Eingabeaufforderungen und die Durchführung von A/B-Tests erforderlich ist.

Hinter den Kulissen protokolliert MLflow 3.0 jeden Bewertungslauf, sodass Sie Modellentscheidungen bis zu den zugrunde liegenden Daten und Parametern zurückverfolgen können. Die Sicherheit bleibt gewahrt, da Agenten niemals Daten außerhalb des Databricks Lakehouse-Perimeters abrufen.

Diese architektonische Übersicht ist besonders wichtig, wenn Sie sehen, wie sie ein echtes Problem löst.

Wie sieht das in der Praxis aus?

Das Datenteam von AstraZeneca stand vor einem Rückstand von 400.000 PDF-Dateien aus klinischen Studien, die für behördliche Einreichungen strukturiert extrahiert werden mussten. Eine manuelle Überprüfung hätte Monate gedauert.

Sie konfigurierten einen Information Extraction Agent in Agent Bricks, richteten ihn auf das Dokumenten-Repository aus und ließen das System synthetische Beispiele auf Basis von Versuchsprotokoll-Schemas generieren. Der Agent analysierte alle 400.000 Dateien in weniger als 60 Minuten ohne Code.

- Das Team identifiziert den Engpass bei der Datenextraktion und die gesetzliche Frist.

- Erstellt eine Verbindung zwischen Agent Bricks und dem internen Dokumentenspeicher über Unity Catalog.

- Die Plattform führt Optimierungen durch, generiert aufgabenbezogene Benchmarks und führt eine Auswahl des fein abgestimmten Modells durch.

- Stellen Sie den Agenten in der Produktion bereit und reduzieren Sie wochenlange manuelle Arbeit auf weniger als eine Stunde.

Hawaiian Electric erzielte ähnliche Vorteile, als das Unternehmen eine anfällige LangChain-basierte Lösung durch Agent Bricks für die Abfrage von Rechtsdokumenten ersetzte.

Der neue Agent übertraf das ursprüngliche tool sowohl bei automatisierten als auch bei manuellen Bewertungen deutlich in Bezug auf die Genauigkeit der Antworten, sodass die Mitarbeiter sich bei Compliance-Abfragen darauf verlassen können.

Integration und Eignung für das Ökosystem

Agent Bricks übernimmt die Integrationsschicht von Databricks und lässt sich daher direkt in die Plattformen einbinden, die Ihre Daten- und ML-Teams bereits verwenden.

Unity Catalog fungiert als zentrale Governance-Hub und verwaltet den Zugriff auf Data Lakes, Warehouses und Vektorspeicher in einem einzigen Richtlinien-Framework.

Agenten führen Abfragen auf Delta-Tabellen, Parquet-Dateien oder Dokumente durch, die im Lakehouse gespeichert sind, ohne Daten in externe Dienste zu kopieren.

| Plattform/Partner | Art der Integration |

|---|---|

| Unity-Katalog | Einheitliche Governance für Daten, Modelle und Agent-Ausgaben |

| Neon | Serverloses Postgres für Workflows mit Transaktionen für Agenten |

| Tecton | Echtzeit-Feature-Serving mit einer Latenz von unter 100 ms |

| OpenAI | Nativer Zugriff auf GPT-5 für Daten des Unternehmens |

Entwickler interagieren mit Agent Bricks über Standard-Databricks-APIs und SDKs. Mit der SQL-Funktion „ai_query“ können Analysten LLMs direkt in Abfragen aufrufen, und REST-Endpunkte bedienen Agenten über die Model Serving-Infrastruktur.

IDE-Integrationen unterstützen CI/CD-Pipelines, sodass Ingenieure die Konfigurationen des Agenten zusammen mit dem Code der Anwendung versionskontrollieren können.

Durch die bevorstehende Übernahme von Tecton wird ein Online-Feature-Store in Agent Bricks integriert, der Streaming-Daten mit einer Latenz von unter 10 ms an Agenten liefert.

Diese Fähigkeit ermöglicht Betrugserkennung, Personalisierung und andere Anwendungsfälle, die von sekundengenauen Informationen abhängen.

Derzeit können Teams Prototypen mit Batch-Features erstellen und planen, diese nach der Integration Mitte 2026 durch Echtzeitdaten zu ersetzen.

Community Buzz & Meinung der ersten Benutzer

Die ersten Rückmeldungen sind geteilt zwischen Begeisterung für die Benutzerfreundlichkeit und Vorsicht hinsichtlich der Limite der Beta-Version.

Ein Reddit-Benutzer lobte den No-Code-Agenten-Builder und die enge Integration mit Unity Catalog und machte eine Notiz dazu, dass Agenten automatisch Datenberechtigungen übernehmen.

Der gleiche Benutzer wies darauf hin, dass ein vollständiger Optimierungslauf in der Regel mehr als eine Stunde dauert und über 100 US-Dollar an Rechenkosten verursacht, was sich während der Experimentierphase summieren kann.

- „Es vereinfacht unseren Workflow erheblich und reduziert manuelle Anpassungen.“ Reddit

- „Die Kosten pro Optimierungslauf können in der Beta-Phase hoch sein. “ Reddit

- „Der sichere Zugriff auf interne Inhalte schafft Vertrauen in die Plattform.“ Databricks-Community

Die regionale Verfügbarkeit sorgte für Reibereien bei den europäischen Teams. Ein Databricks-Konto-Betreuer bestätigte Mitte 2025, dass Agent Bricks während der ersten Vorschauphase nur in den USA verfügbar war, was einige Kunden dazu veranlasste, Sandbox-Workspaces in US-Regionen einzurichten, um das Produkt zu testen.

In Forenbeiträgen wird auch die Instabilität der Vorschau und häufige Änderungen der Features erwähnt, was für Beta-Software typisch ist, aber bei der Planung berücksichtigt werden sollte, wenn Ihr Anwendungsfall eine hohe Verfügbarkeit erfordert.

Insgesamt sehen Early Adopters, die mit den Macken der Beta-Version und den Rechenkosten leben können, einen Wert in der Automatisierung, die Agent Bricks bietet. Die Analyse von 400.000 Dokumenten durch AstraZeneca und die Genauigkeitssteigerungen bei Hawaiian Electric finden in der gesamten Community großen Anklang und sind ein Beweis dafür, dass die Plattform Aufgaben im Produktionsmaßstab bewältigen kann.

Diese Validierung aus der Praxis ist wichtig, wenn Sie entscheiden, ob Sie jetzt Entwicklungszeit investieren oder warten möchten, bis das Produkt ausgereift ist.

Roadmap und Outlook auf das Ökosystem

Databricks wird Agent Bricks in den nächsten 18 Monaten geografisch und in Bezug auf seine Funktionen erweitern. Bis zum vierten Quartal 2025 wird die Vorschau in europäischen Regionen eingeführt, beginnend mit Azure-Bereitstellungen in Westeuropa.

Durch diese Phase der schrittweisen Einführung kann das Unternehmen vielfältiges Feedback der Benutzer sammeln und die Einhaltung regionaler Datenschutzbestimmungen sicherstellen, bevor es die allgemeine Verfügbarkeit bekannt gibt.

Die Tecton-Integration Mitte 2026 ermöglicht es Agenten, Echtzeit-Features aus Streams, APIs und Warehouses mit einer Verfügbarkeit von 99,99 % abzurufen, wodurch Anwendungsfälle wie Betrugserkennung und Personalisierung möglich werden, die sekundengenaue Daten erfordern.

Neon und Mooncake werden zu einer einheitlichen „Lakehouse DB”-Erfahrung zusammengeführt, die Agenten ACID-konforme Schreibvorgänge und sofortige analytische Lesevorgänge ohne ETL-Pipelines ermöglicht.

„Agent Bricks signalisiert einen bedeutenden Wandel in der KI für Unternehmen“, bemerkte ein Analyst bei VentureBeat und verwies dabei auf die 10- bis 100-fache Leistungssteigerung durch den Wegfall traditioneller Datenpipelines.

Es werden neue Agent-Vorlagen über die ursprünglichen vier Typen hinaus erwartet (Informationsextraktion, Wissensassistent, Multi-Agent-Supervisor, benutzerdefinierter LLM-Agent).

Databricks Research untersucht Code-Assistenten, Planungsagenten und Konnektoren zu externen APIs. Die Partnerschaft mit OpenAI stellt sicher, dass GPT-5 und zukünftige Modelle von OpenAI nativ in Agent Bricks verfügbar sind und von OpenAI selbst unterstützt und verwaltet werden.

Langfristig sieht Databricks die agentische KI als neue Benutzerrolle auf der Plattform, die neben Dateningenieuren und Analysten eine wichtige Rolle einnimmt. Diese Vision umfasst kontinuierliche Investitionen in Features für verantwortungsbewusste KI wie Audit-Protokolle, Bias-Erkennung und detaillierte Richtlinienkontrollen, da die Akzeptanz von Agenten in regulierten Branchen zunimmt.

Wie viel kostet die agentische KI von Databricks?

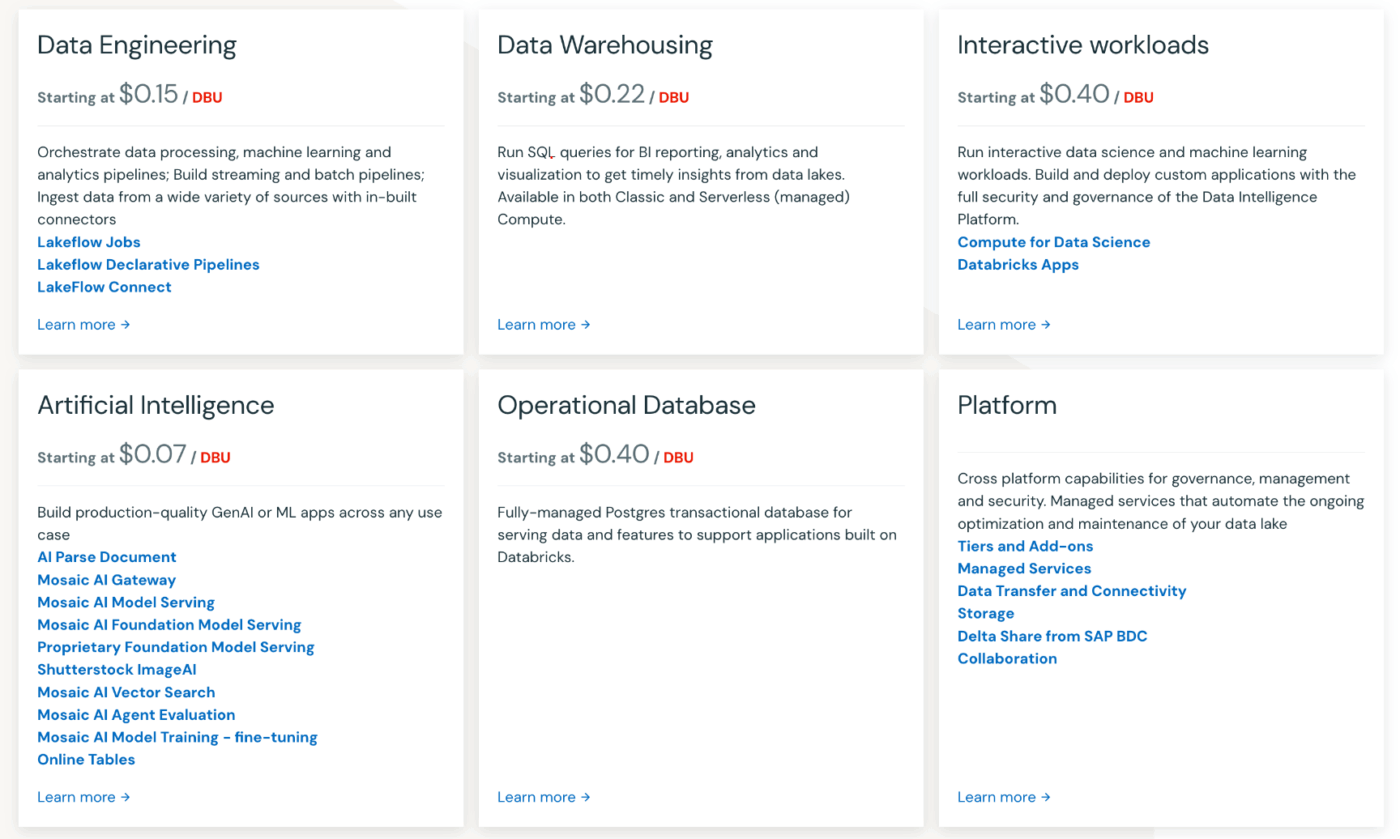

Agent Bricks folgt dem nutzungsbasierten Preismodell von Databricks ohne Vorab-Lizenzgebühren. Sie zahlen pro Sekunde Rechenleistung und Modellinferenz, abgerechnet in Databricks Units (DBUs).

Model Serving- und Feature Serving-Workloads kosten im Premium-Plan etwa 0,07 US-Dollar pro DBU-Sekunde, wobei die Kosten für die zugrunde liegende Cloud-Instanz enthalten sind. Die GPU-beschleunigte Inferenz für Basismodelle kostet ebenfalls etwa 0,07 US-Dollar pro DBU-Sekunde.

Der aufwendigste Teil ist der anfängliche Optimierungslauf. Ein früher Benutzer berichtete, dass er über 100 US-Dollar für Cloud-Rechenleistung für einen einzigen einstündigen Trainingszyklus ausgegeben habe, in dem synthetische Daten generiert und der Agent optimiert wurden.

Nach der Optimierung wird der Einsatz des Agenten wesentlich kostengünstiger, da das System eine kosteneffiziente Modellkonfiguration identifiziert hat, die die Qualität mit weniger Tokens pro Abfrage aufrechterhält. Teams können über die Budgetrichtlinie von Databricks Budgetlimits festlegen, um die Ausgaben während der Experimentierphase zu begrenzen.

Unternehmen können Commitment-Pakete (vorausbezahlte DBU-Stunden) erwerben, um Rabatte auf die Menge zu erhalten und so den Preis pro Sekunde im Vergleich zur On-Demand-Abrechnung effektiv zu senken. Die genauen Preise richten sich nach Ihrem Cloud-Anbieter (AWS, Azure, GCP) und Ihrer Region, wobei einige Regionen etwas höhere Preise als die USA Ost oder West haben.

Zu den versteckten Kosten, die Sie beachten sollten, gehören die Rechenleistung für die Vektorsuche, die Datenerfassung und das regelmäßige Nachschulen, wenn sich Ihre Verteilung ändert. Berücksichtigen Sie bei der Berechnung der Gesamtbetriebskosten die eingesparte Entwicklungszeit, die durch den Wegfall der manuellen Prompt-Optimierung und der Beschreibung der Daten entsteht.

Frühe Anwender berichten, dass die Wochen manueller Arbeit, die Agent Bricks einspart, oft die Rechenkosten ausgleichen, insbesondere wenn man die Opportunitätskosten einer verzögerten Agentenbereitstellung berücksichtigt.