لقد مر معظمنا ببعض الخبرة في "التحدث" مع أحدث أدوات الذكاء الاصطناعي الموجودة على الساحة. إذا كنت قد قضيت وقتًا كافيًا مع الذكاء الاصطناعي، فأنت تعلم بالفعل أنه مثل ذلك الصديق اللامع ولكن كثير النسيان الذي لديه أفكار رائعة ولكنه ينسى أحيانًا ما تحدثتما عنه. أو ذلك الزميل دائم الاتصال الذي يشارك تقارير إخبارية مشكوك في صحتها من سلاسل دردشة عشوائية، وينشر معلومات خاطئة.

هذا مجرد غيض من فيض عندما نتحدث عن تحديات الذكاء الاصطناعي. الباحثون من جامعة ولاية أوريغون وشركة Adobe تقنية تدريب جديدة للحد من التحيز الاجتماعي في أنظمة الذكاء الاصطناعي. إذا أثبتت هذه التقنية موثوقيتها، فقد تجعل الذكاء الاصطناعي أكثر عدلاً للجميع.

ولكن دعونا لا نستبق الأحداث. هذا مجرد حل واحد من بين العديد من الحلول اللازمة لمعالجة تحديات الذكاء الاصطناعي العديدة التي نواجهها اليوم. من العقبات التقنية إلى المآزق الأخلاقية، فإن الطريق إلى ذكاء اصطناعي موثوق به مرصوف بالمشاكل المعقدة.

دعونا نتناول معاً تحديات الذكاء الاصطناعي هذه ونرى ما يلزم للتغلب عليها.

10 تحديات الذكاء الاصطناعي وحلولها

مع تقدم تكنولوجيا الذكاء الاصطناعي، فإنها تواجه مجموعة من المشكلات. تستكشف هذه القائمة عشرة تحديات ملحة للذكاء الاصطناعي وتحدد الحلول العملية لنشر الذكاء الاصطناعي بشكل مسؤول وفعال.

1. التحيز الخوارزمي

يشير مصطلح التحيز الخوارزمي إلى ميل أنظمة الذكاء الاصطناعي إلى إظهار مخرجات متحيزة، وغالباً ما يكون ذلك بسبب طبيعة بيانات التدريب أو التصميم. يمكن أن تظهر هذه التحيزات بأشكال عديدة، وغالباً ما تؤدي إلى إدامة وتضخيم التحيزات المجتمعية القائمة.

وقد لوحظ مثال على ذلك في دراسة أكاديمية شملت تطبيق توليد الفن التوليدي للذكاء الاصطناعي Midjourney. كشفت الدراسة أنه عند توليد صور لأشخاص في مختلف المهن، صوّر الذكاء الاصطناعي بشكل غير متناسب المهنيين الأكبر سنًا من ذوي المسميات الوظيفية المتخصصة (مثل المحلل)، مما يسلط الضوء على التحيز الجنسي في مخرجاته.

الحلول

- بيانات متنوعة وتمثيلية: استخدام مجموعات بيانات التدريب التي تعكس حقًا تنوع جميع المجموعات لتجنب التحيزات المتعلقة بالجنس أو العرق أو العمر

- اكتشاف التحيزات ومراقبتها: تحقق بانتظام من أنظمة الذكاء الاصطناعي الخاصة بك بحثًا عن التحيزات. يجب أن يكون هذا مزيجًا من المراقبة الآلية والمراجعات اليدوية الخاصة بك لضمان عدم وجود أي شيء ينزلق من خلالها

- التعديلات الخوارزمية: القيام بدور نشط في تعديل خوارزميات الذكاء الاصطناعي لمكافحة التحيز. قد يعني هذا إعادة موازنة أوزان البيانات أو إضافة قيود الإنصاف إلى نماذجك

- المبادئ التوجيهية الأخلاقية للذكاء الاصطناعي: ساعد في تشكيل ممارسات الذكاء الاصطناعي الأخلاقية من خلال اعتماد وتنفيذ المبادئ التوجيهية التي تعالج الإنصاف والتحيز، مع ضمان إدراج هذه المبادئ في كل مرحلة من مراحل مشروع الذكاء الاصطناعي الخاص بك

2. الافتقار إلى شفافية الذكاء الاصطناعي يسبب عدم الثقة

تعني الشفافية في مجال الذكاء الاصطناعي الانفتاح حول كيفية عمل أنظمة الذكاء الاصطناعي، بما في ذلك تصميمها والبيانات التي تستخدمها وعمليات اتخاذ القرار فيها. الشفافية تذهب إلى أبعد من ذلك من خلال ضمان أن أي شخص، بغض النظر عن مهاراته التقنية، يمكنه فهم القرارات التي يتخذها الذكاء الاصطناعي ولماذا. تساعد هذه المفاهيم في معالجة المخاوف المتعلقة بالذكاء الاصطناعي، مثل التحيزات أو مشاكل الخصوصية أو حتى المخاطر مثل الاستخدامات العسكرية المستقلة.

_القابلية للتفسير في الذكاء الاصطناعي عبر

_ / href/ _https://www.unite.ai/the-black-box-problem-in-llms-challenges-and-emerging-solutions/ Unite.ai /%href/

يعد فهم قرارات الذكاء الاصطناعي أمرًا بالغ الأهمية في مجالات مثل التمويل والرعاية الصحية والسيارات، حيث يكون لها تأثيرات كبيرة. وهذا أمر صعب لأن الذكاء الاصطناعي غالبًا ما يعمل كـ "صندوق أسود" - حتى مبتكروه قد يجدون صعوبة في تحديد كيفية اتخاذه لقراراته.

الحلول

- تطوير وثائق واضحة: تقديم تفاصيل شاملة حول نماذج الذكاء الاصطناعي وعملية تطويرها ومدخلات البيانات وعمليات اتخاذ القرار. هذا يعزز فهمًا أفضل ويضع أساسًا للثقة

- تطبيق نماذج الذكاء الاصطناعي القابلة للتفسير: استخدام النماذج التي توفر المزيد من الشفافية، مثل أشجار القرار أو الأنظمة القائمة على القواعد، بحيث يرى المستخدمون بالضبط كيف يتم تحويل المدخلات إلى مخرجات

- استخدام أدوات قابلة للتفسير: تطبيق أدوات مثل LIME (التفسيرات المحلية القابلة للتفسير في النموذج القابل للتفسير) أو SHAP (SHAP) لتحليل مساهمات الميزات المختلفة في عملية اتخاذ القرار في النموذج

3. إن توسيع نطاق الذكاء الاصطناعي أصعب مما يبدو عليه

يعد توسيع نطاق تكنولوجيا الذكاء الاصطناعي أمرًا محوريًا للمؤسسات التي تهدف إلى الاستفادة من إمكاناتها عبر وحدات الأعمال المختلفة. ومع ذلك، فإن تحقيق هذا التوسع في البنية التحتية للذكاء الاصطناعي محفوف بالتعقيدات.

وفقًا لشركة Accenture, 75% من قادة الأعمال يشعرون أنهم سيصبحون خارج نطاق العمل في غضون خمس سنوات إذا لم يتمكنوا من معرفة كيفية توسيع نطاق الذكاء الاصطناعي.

على الرغم من إمكانية تحقيق عائد مرتفع على الاستثمار، تجد العديد من الشركات صعوبة في تجاوز المشاريع التجريبية إلى النشر على نطاق واسع.

ويُعد إخفاق Zillow في بيع المنازل تذكيراً صارخاً بتحديات قابلية التوسع في الذكاء الاصطناعي. فالذكاء الاصطناعي الذي يهدف إلى التنبؤ بأسعار المنازل من أجل الربح، وصلت معدلات الخطأ فيه إلى 6.9% مما أدى إلى خسائر مالية فادحة وشطب مخزون بقيمة 304 مليون دولار.

يتجلى تحدي قابلية التوسع بشكل أكبر خارج شركات التكنولوجيا العملاقة مثل Google وAmazon، التي تمتلك الموارد اللازمة للاستفادة من الذكاء الاصطناعي بفعالية. أما بالنسبة لمعظم الشركات الأخرى، وخاصة الشركات غير التكنولوجية التي بدأت للتو في استكشاف الذكاء الاصطناعي، فإن العوائق تشمل الافتقار إلى البنية التحتية وقوة الحوسبة والخبرة والتنفيذ الاستراتيجي.

الحلول

- بنية تحتية معززة: تطوير بنية تحتية رقمية قوية يمكنها التعامل مع عمليات نشر الذكاء الاصطناعي على نطاق واسع. على سبيل المثال، تعمل الخدمات السحابية ومراكز البيانات المحلية على تقليل زمن الاستجابة وتحسين الأداء

- فرق متعددة التخصصات: تعزيز بيئة تعاونية تعمل فيها وحدات التكنولوجيا والأعمال معًا لدمج حلول الذكاء الاصطناعي بسلاسة في نماذج الأعمال الحالية

- أدوات تطوير الذكاء الاصطناعي الآلي: استخدام منصات مثل evoML من تورينتك لأتمتة تطوير أكواد التعلم الآلي، مما يتيح إنشاء النماذج ونشرها بشكل أسرع

- التعلم المستمر والتكيف: تنفيذ آليات للتعلم المستمر وتحديث نماذج الذكاء الاصطناعي للتكيف مع بيانات العالم الحقيقي وظروف السوق المتغيرة، مما يضمن الملاءمة والكفاءة على المدى الطويل

- الاستثمار في تنمية المواهب: بناء خبرات داخلية في مجال الذكاء الاصطناعي من خلال ممارسات التدريب والتوظيف التي تركز على تقنيات الذكاء الاصطناعي الناشئة، وتقليل الاعتماد المفرط على مواهب الذكاء الاصطناعي الخارجية

اقرأ أيضًا: إحصائيات الذكاء الاصطناعي الأساسية _لمعرفة اليوم

4. التزييف العميق والاحتيال التوليدي للذكاء الاصطناعي

حالة سوق الذكاء الاصطناعي التوليدي العالمي عبر Marketresearch.biz تعمل تقنيات الذكاء الاصطناعي التوليدي وتقنيات التزييف العميق على تغيير مشهد الاحتيال، خاصة في قطاع الخدمات المالية. فهي تجعل من الأسهل والأرخص إنشاء عمليات تزوير مقنعة.

على سبيل المثال، في يناير 2024، على سبيل المثال، في يناير 2024، قام أحد المزيفين بانتحال شخصية مدير مالي بإصدار تعليمات لموظف بتحويل 25 مليون دولار مما يوضح الآثار الخطيرة المترتبة على هذه التقنيات.

يسلط هذا الاتجاه المتزايد الضوء على التحديات التي تواجهها البنوك في الوقت الذي تكافح فيه لتكييف أنظمة إدارة البيانات والكشف عن الاحتيال لمواجهة عمليات الاحتيال المتطورة بشكل متزايد والتي لا تخدع الأفراد فحسب، بل أيضًا أنظمة الأمن القائمة على الآلات.

تتوسع احتمالات حدوث مثل هذا الاحتيال بسرعة، حيث تشير التوقعات إلى أن الذكاء الاصطناعي التوليدي يمكن أن يدفع الخسائر المالية ذات الصلة في الولايات المتحدة إلى ما يصل إلى 40 مليار دولار بحلول عام 2027، وهي قفزة كبيرة من 12.3 مليار دولار في عام 2023.

الحلول

- تقنيات الكشف المتطورة: يجب أن تستثمر البنوك في التقنيات الحديثة التي يمكنها اكتشاف حالات التزييف العميق والذكاء الاصطناعي التوليدي بشكل أكثر فعالية

- الإشراف البشري: إن دمج التحليل البشري الماهر مع استجابات الذكاء الاصطناعي يعزز معدلات الكشف ويساعد على التحقق من الاحتيال القائم على الذكاء الاصطناعي وفهمه

- الجهود التعاونية لمنع الاحتيال: يمكن أن تساعد إقامة شراكات داخل الصناعات وعبرها في تطوير آليات أكثر قوة لتحديد الاحتيال ومنعه

5. قابلية التشغيل البيني وتحديات التفاعل بين الإنسان والذكاء الاصطناعي

عندما تستخدم منظمات أو دول مختلفة الذكاء الاصطناعي معًا، يجب أن تضمن أن يتصرف الذكاء الاصطناعي بشكل أخلاقي وفقًا لقواعد الجميع. وهذا ما يسمى قابلية التشغيل البيني الأخلاقي، وهو مهم بشكل خاص في مجالات مثل الدفاع والأمن.

في الوقت الحالي، لدى الحكومات والمنظمات مجموعة من القواعد والأخلاقيات الخاصة بها. على سبيل المثال، راجع إرشادات مايكروسوفت للتفاعل بين الإنسان والذكاء الاصطناعي:

إرشادات مايكروسوفت للتفاعل بين الإنسان والذكاء الاصطناعي عبر Microsoft ومع ذلك، هناك نقص في توحيد هذه الأخلاقيات والقواعد في جميع أنحاء العالم.

في الوقت الحالي، تأتي أنظمة الذكاء الاصطناعي بمجموعة من القواعد الأخلاقية الخاصة بها، والتي قد تكون مقبولة في مكان ما ولكنها قد تكون إشكالية في مكان آخر. عندما تتفاعل هذه الأنظمة مع البشر، إذا لم تتصرف كما هو متوقع، فقد يؤدي ذلك إلى سوء فهم أو عدم ثقة

الحلول

- وضع معايير أخلاقية عالمية: الاتفاق على القواعد الأخلاقية الأساسية التي يجب على جميع أنظمة الذكاء الاصطناعي اتباعها، بغض النظر عن مصدرها. التركيز على الإنصاف والمساءلة والشفافية

- استخدم نظام اعتماد قوي: قبل استخدام أي نظام ذكاء اصطناعي، يجب أن يجتاز اختبارًا صارمًا للتأكد من أنه يفي بهذه المعايير الأخلاقية. ويمكن أن يشمل ذلك إجراء فحوصات من قبل المبدعين وكذلك من قبل مجموعات مستقلة

- تأكد من أن الجميع على اطلاع: كن واضحًا دائمًا بشأن كيفية اتخاذ الذكاء الاصطناعي للقرارات واستخدام البيانات. تساعد هذه الشفافية على بناء الثقة وتسهل دمج أنظمة الذكاء الاصطناعي المختلفة

- إبقاء العين على الأشياء: تحقق بانتظام من أنظمة الذكاء الاصطناعي للتأكد من استمرارها في تلبية المعايير الأخلاقية. قم بتحديثها حسب الحاجة لمواكبة القواعد أو التقنيات الجديدة

6. أخلاقيات الذكاء الاصطناعي هي أكثر من مجرد نوايا حسنة

يتغلغل الذكاء الاصطناعي (AI) في كل جزء من حياتنا تقريبًا - من السيارات ذاتية القيادة إلى المساعدين الافتراضيين، وهو أمر رائع! ولكن هنا تكمن المشكلة: قد تؤدي طريقة استخدامنا للذكاء الاصطناعي في بعض الأحيان إلى مشاكل أخلاقية خطيرة. هناك قضايا أخلاقية شائكة حول الخصوصية والتحيز والإزاحة الوظيفية وغيرها.

فمع قدرة الذكاء الاصطناعي على القيام بالمهام التي اعتاد البشر القيام بها، هناك جدل كامل حول ما إذا كان ينبغي أن يقوم ببعضها.

على سبيل المثال، هل يجب على الذكاء الاصطناعي كتابة سيناريوهات الأفلام؟ يبدو الأمر رائعاً، ولكنه أثار ضجة كبيرة في عالم الترفيه مع إضرابات في جميع أنحاء الولايات المتحدة الأمريكية وأوروبا. والأمر لا يتعلق فقط بالوظائف التي يمكن للذكاء الاصطناعي توليها، بل يتعلق أيضاً بكيفية استخدامه لبياناتنا واتخاذه للقرارات، بل وأحياناً يخطئ في بعض الأحيان. وهذا ما يجعل الجميع من صانعي التكنولوجيا إلى النسور القانونية يسعون جاهدين لمعرفة كيفية التعامل مع الذكاء الاصطناعي بمسؤولية.

الحلول

- توضيح القواعد: وضع مبادئ توجيهية واضحة وضوح الشمس حول كيفية استخدام الذكاء الاصطناعي. وهذا يعني وضع حدود لمنع إساءة الاستخدام وفهم الآثار القانونية المترتبة على إجراءات الذكاء الاصطناعي

- احترام الخصوصية: استخدام كميات هائلة من البيانات، بما في ذلك المعلومات الشخصية، لتدريب الذكاء الاصطناعي. يجب أن نكون حذرين للغاية بشأن كيفية جمع هذه البيانات واستخدامها وحمايتها. هذا يتعلق بالتأكد من احترام الذكاء الاصطناعي لخصوصيتنا

- مكافحة التحيز: الذكاء الاصطناعي جيد فقط بقدر جودة البيانات التي يتعلم منها، وأحيانًا ما يكون لهذه البيانات تحيزات. يجب أن نتخلص من هذه التحيزات من أنظمة الذكاء الاصطناعي للتأكد من أنها عادلة ولا تميز

- حماية الملكية الفكرية: يمكن للذكاء الاصطناعي أن ينتج عملاً يعتمد على ما تعلمه من أعمال الآخرين الإبداعية. وهذا يمكن أن يدوس على حقوق التأليف والنشر ويسلب المبدعين حقهم ما لم ننتبه

- الأخلاقيات مقابل السرعة: في خضم الاندفاع الجنوني لطرح أحدث تقنيات الذكاء الاصطناعي في السوق، يمكن أن يتم تهميش الأخلاقيات. علينا أن نوازن بين الحاجة إلى السرعة والقيام بالأمور بشكل صحيح

7. الخلط بين مجموعات بيانات الذكاء الاصطناعي قد يؤدي إلى كارثة###7

كيف يتم تقسيم البيانات لتطوير الذكاء الاصطناعي عبر

/ href/ https://www.researchgate.net/figure/Typical-data-sets-used-for-development-and-testing-of-an-artificial-intelligence\_fig1\_346915862 بوابة البحث %href/_

عند تطوير التعلم الآلي للذكاء الاصطناعي النماذج، قد يكون من الصعب التمييز بشكل صحيح بين مجموعات بيانات التدريب والتحقق من الصحة والاختبار. حيث تقوم مجموعة بيانات تدريب نموذج الذكاء الاصطناعي بتعليم النموذج، بينما تقوم مجموعة بيانات التحقق من الصحة بضبطه، وتقوم مجموعة بيانات الاختبار بتقييم أدائه.

يمكن أن يؤدي سوء الإدارة في تقسيم مجموعات البيانات هذه إلى نماذج إما أن تفشل في الأداء بشكل كافٍ بسبب عدم الضبط أو تؤدي أداءً جيدًا جدًا على بيانات التدريب ولكن أداءها ضعيف على البيانات الجديدة غير المرئية بسبب الإفراط في الضبط.

هذا الخطأ يمكن أن يعيق بشدة قدرة النموذج على العمل بفعالية في تطبيقات الذكاء الاصطناعي في العالم الحقيقي، حيث تكون القدرة على التكيف والدقة على البيانات الموحدة أمرًا أساسيًا.

الحلول

- تقسيم البيانات المنظمة: اعتماد نهج منظم لتقسيم البيانات إلى مجموعات تدريب وتحقق واختبار

- أساليب التحقق المتقاطع: استخدام أساليب التحقق المتقاطع، خاصةً في السيناريوهات ذات البيانات المحدودة. تساعد تقنيات مثل التحقق التبادلي K-fold cross-validation على زيادة استخدام التدريب إلى أقصى حد وتوفير تقدير أكثر قوة لأداء النموذج على البيانات غير المرئية

- التوزيع العشوائي للبيانات: التأكد من أن تقسيم البيانات عشوائيًا لمنع أي تحيز للذكاء الاصطناعي من أن يتم إدخاله من خلال ترتيب البيانات. يساعد ذلك في إنشاء مجموعات التدريب والتحقق من صحة البيانات التي تمثل مجموعة البيانات الإجمالية

8. المخاطر والمخاوف المتعلقة باتخاذ القرارات آليًا

عندما يتخذ الذكاء الاصطناعي القرارات، يمكن أن تصبح الأمور صعبة، خاصةً في المجالات الحرجة مثل الرعاية الصحية والمصارف. إحدى المشاكل الكبيرة هي أننا لا نستطيع دائماً أن نرى كيف تتوصل أنظمة الذكاء الاصطناعي إلى قراراتها.

وقد يؤدي ذلك إلى قرارات غير عادلة لا يستطيع أحد تفسيرها. بالإضافة إلى ذلك، تُعد هذه الأنظمة أهدافاً للقراصنة الذين إذا تمكنوا من الدخول إليها، يمكنهم سرقة الكثير من البيانات المهمة.

الحلول

- تطوير بروتوكولات أمنية قوية: تأكد من أن أنظمة الذكاء الاصطناعي مُحكمة الإغلاق ضد المخترقين. استمر في تحديث الأمن لإغلاق أي ثغرات جديدة تظهر

- تعزيز الشفافية: استخدم تقنية تساعد الذكاء الاصطناعي على شرح خياراته بعبارات بسيطة. إذا فهم الجميع كيفية اتخاذ القرارات، فسوف يثقون أكثر في الذكاء الاصطناعي

- حماية المعلومات الخاصة: تأمين جميع البيانات الشخصية التي يتعامل معها الذكاء الاصطناعي. اتبع قوانين مثل اللائحة العامة لحماية البيانات للتأكد من عدم المساس بخصوصية أي شخص

- تعزيز التعاون متعدد التخصصات: احصل على خبراء من جميع المجالات - التكنولوجيا والقانون والأخلاق - للعمل معًا. يمكنهم المساعدة في التأكد من أن قرارات الذكاء الاصطناعي عادلة وآمنة

اقرأ أيضًا: الأكثر شيوعًا

_/مرجع/ https://clickup.com/blog/ai-tools/-for-students// أدوات الذكاء الاصطناعي للطلاب %/%href/_

9. عدم وجود قواعد ولوائح واضحة للذكاء الاصطناعي

في الوقت الحالي، لا توجد هيئة رقابية عالمية واحدة للذكاء الاصطناعي؛ حيث تختلف اللوائح التنظيمية حسب البلد وحتى حسب القطاع. على سبيل المثال، لا توجد هيئة مركزية خاصة بالذكاء الاصطناعي في الولايات المتحدة.

ما نراه اليوم هو خليط من حوكمة الذكاء الاصطناعي واللوائح التي تفرضها الوكالات المختلفة بناءً على مجالها - مثل حماية المستهلك أو خصوصية البيانات.

يمكن أن يؤدي هذا النهج اللامركزي إلى تناقضات وارتباك؛ فقد يتم تطبيق معايير مختلفة اعتمادًا على مكان وكيفية نشر الذكاء الاصطناعي. وهذا يجعل من الصعب على مطوري ومستخدمي الذكاء الاصطناعي ضمان امتثالهم الكامل في جميع الولايات القضائية.

الحلول

- إنشاء هيئة تنظيمية مخصصة للذكاء الاصطناعي: يمكن أن تستفيد البلدان من إنشاء وكالة محددة تركز على الذكاء الاصطناعي. يمكن لهذه الهيئة الإشراف على جميع القضايا المتعلقة بالذكاء الاصطناعي، ومواكبة الوتيرة السريعة لتطور الذكاء الاصطناعي وضمان الامتثال لمعايير السلامة والمعايير الأخلاقية

- التعاون الدولي: لا يتوقف الذكاء الاصطناعي عند الحدود. تحتاج البلدان إلى العمل معًا لوضع معايير واتفاقيات دولية بشأن استخدام الذكاء الاصطناعي، على غرار كيفية عمل المعاهدات العالمية لحماية البيئة

- تشريعات واضحة وقابلة للتكيف: يجب أن تكون القوانين واضحة (حتى تعرف الشركات كيفية الامتثال) ولكن أيضًا مرنة بما يكفي للتكيف مع التطورات الجديدة في مجال الذكاء الاصطناعي. ويمكن أن تساعد التحديثات والمراجعات المنتظمة لقوانين الذكاء الاصطناعي على إبقائها ملائمة

- مشاركة الجمهور وأصحاب المصلحة: يجب تطوير اللوائح التنظيمية بمساهمة مجموعة واسعة من أصحاب المصلحة، بما في ذلك شركات التكنولوجيا وعلماء الأخلاق وعامة الناس. يمكن أن يساعد ذلك في ضمان مراعاة وجهات النظر المتنوعة وزيادة ثقة الجمهور في أنظمة الذكاء الاصطناعي

اقرأ أيضًا:_

_مراجع/ https://clickup.com/blog/ai-tools-for-lawyers// أدوات الذكاء الاصطناعي للمحامين %/%href/_

10. معلومات خاطئة من الذكاء الاصطناعي

تخيل وجود تكنولوجيا يمكنها التفكير مثل الإنسان. هذا هو الوعد الذي يحمله الذكاء الاصطناعي العام (AGI)، ولكنه يأتي مع مخاطر كبيرة. المعلومات المضللة هي إحدى المشكلات الرئيسية هنا.

فمع الذكاء الاصطناعي العام الاصطناعي، يمكن للمرء بسهولة إنشاء أخبار كاذبة أو معلومات كاذبة مقنعة، مما يجعل من الصعب على الجميع معرفة ما هو صحيح وما هو غير صحيح.

بالإضافة إلى ذلك، إذا اتخذ الذكاء الاصطناعي الآلي المُخصَّص للذكاء الاصطناعي قرارات بناءً على هذه المعلومات الخاطئة، فقد يؤدي ذلك إلى نتائج كارثية، مما يؤثر على كل شيء من السياسة إلى الحياة الشخصية.

الحلول

- قم بإعداد عمليات تحقق قوية: تحقق دائمًا من الحقائق مرتين قبل السماح لـ AGI بنشر المعلومات. استخدم مصادر موثوقة وتأكد من التفاصيل قبل نشر أي شيء على الملأ

- تعليم الذكاء الاصطناعي المُخصَّص عن الأخلاقيات: تماماً كما نعلم الأطفال الصواب من الخطأ، نحتاج إلى تعليم الذكاء الاصطناعي المُخصَّص عن السلوك الأخلاقي. وهذا يشمل فهم تأثير نشر المعلومات الخاطئة واتخاذ قرارات منصفة وعادلة

- إبقاء البشر في الحلقة: بغض النظر عن مدى ذكاء الذكاء الاصطناعي للذكاء الاصطناعي، حافظ على مشاركة البشر في عملية اتخاذ القرار. فهذا يساعد على اكتشاف الأخطاء ويضمن أن تعكس تصرفات الذكاء الاصطناعي الآلي المُعزز قيمنا وأخلاقياتنا

- ضع قواعد واضحة: ضع مبادئ توجيهية صارمة لما يمكن للذكاء الاصطناعي الآلي أن يفعله وما لا يمكن أن يفعله، خاصة عندما يتعلق الأمر بإنشاء المعلومات ونشرها. تأكد من اتباع هذه القواعد حرفياً

اقرأ أيضًا: الكامل مسرد مصطلحات الذكاء الاصطناعي

أدوات للتعامل مع تحديات الذكاء الاصطناعي

عندما تكون منغمسًا في الذكاء الاصطناعي، فإن اختيار الأدوات المناسبة ليس مجرد أمر لطيف؛ بل هو أمر لا بد منه لضمان عدم تحول رحلة الذكاء الاصطناعي إلى كارثة. يتعلق الأمر بتبسيط الأمور المعقدة، وتأمين بياناتك، والحصول على الدعم الذي تحتاجه لحل تحديات الذكاء الاصطناعي دون أن تكلفك الكثير.

المفتاح هو اختيار برنامج ذكاء اصطناعي مخصص يعزز الإنتاجية مع حماية خصوصيتك وأمان بياناتك.

أدخل انقر فوق الدماغ سكين الجيش السويسري للذكاء الاصطناعي في مكان عملك.

ClickUp Brain: الكفاءة، والأمان، والابتكار - كل ذلك في جهاز واحد

صُمم ClickUp Brain للتعامل مع كل ما يتعلق بالذكاء الاصطناعي - بدءًا من إدارة مشاريعك ومستنداتك إلى تعزيز التواصل بين فريق العمل. بفضل إمكانات الذكاء الاصطناعي التي يوفرها ClickUp Brain، يمكنك التعامل مع التحديات المتعلقة بالبيانات، وتحسين إدارة المشاريع، وتعزيز الإنتاجية، كل ذلك مع الحفاظ على بساطة وأمان الأمور. ClickUp Brain هو حل شامل:

- يندمج بسلاسة في عملك اليومي

- يضمن بقاء بياناتك ملكاً لك

- يوفر أموالك ومواردك

يندمج ClickUp Brain بذكاء في سير عملك لتوفير وقتك وجهدك مع حماية بياناتك في الوقت نفسه. إنه (مثل بقية منصة ClickUp) متوافق مع اللائحة العامة لحماية البيانات، ولا يستخدم بياناتك في التدريب.

إليك طريقة عمله:

- مدير المعرفة بالذكاء الاصطناعي: هل تمنيت يومًا أن تحصل على إجابات فورية ودقيقة من مستندات عملك أو محادثاتك؟ يتيح لك ClickUp Brain ذلك. لا مزيد من البحث في الملفات لساعات. فقط اسأل، وستتلقى - سواء كانت تفاصيل من مستند مشروع أو رؤى من تحديثات الفريق السابقة

- مدير مشروع الذكاء الاصطناعي: تخيل أن يكون لديك مساعد ذكاء اصطناعي يبقي مشاريعك على المسار الصحيح. بدءًا من أتمتة تحديثات المهام إلى تلخيص التقدم المحرز في المشروع، يتعامل ClickUp Brain مع الأجزاء المملة حتى تتمكن من التركيز على الصورة الكبيرة

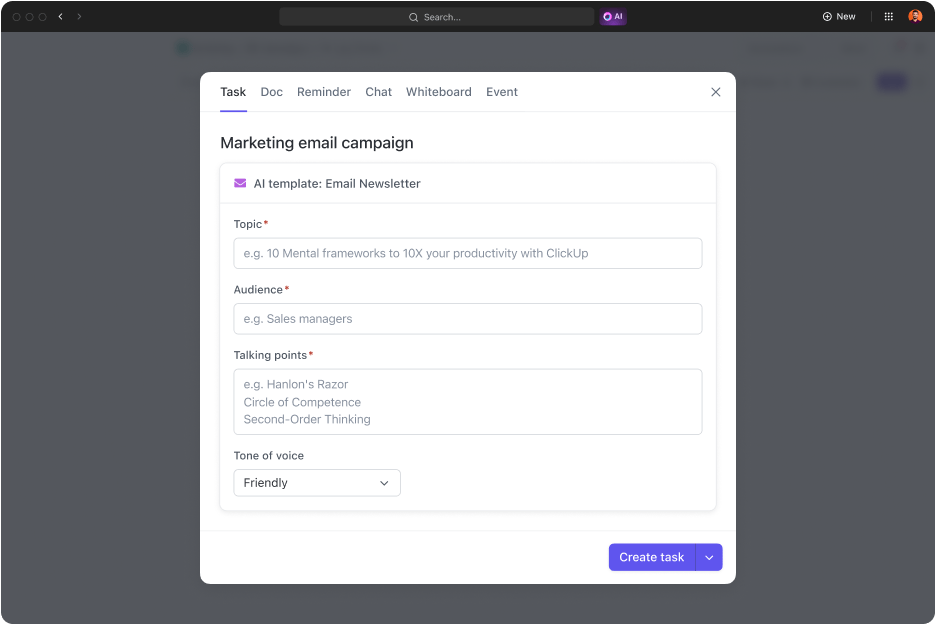

إنشاء قوالب في ClickUp لتبسيط سير عمل مشروعك في غضون دقائق

- كاتب ذكاء اصطناعي للعمل: هذه الأداة ستغير قواعد اللعبة لأي شخص يخشى الكتابة. سواء أكنت تقوم بصياغة رسالة بريد إلكتروني سريعة أو صياغة تقرير شامل، يساعدك ClickUp Brain على تنقيح نثرك، وتدقيقك الإملائي، وضبط نبرة صوتك إلى حد الكمال

اكتب كل شيء من نسخ البريد الإلكتروني إلى جداول أعمال الاجتماعات بشكل أسرع وأكثر دقة باستخدام ClickUp Brain

## مواجهة تحديات الذكاء الاصطناعي بالأدوات المناسبة

على الرغم من تحديات الذكاء الاصطناعي التي ناقشناها، يمكننا أن نتفق على أن الذكاء الاصطناعي قد قطع شوطاً طويلاً. فقد تطور من الأتمتة الأساسية إلى أنظمة متطورة يمكنها التعلم والتكيف والتنبؤ بالنتائج. لقد قام الكثير منا الآن بدمج الذكاء الاصطناعي في جوانب مختلفة من حياتنا، بدءًا من المساعدين الافتراضيين إلى أدوات جمع البيانات وتحليلها المتقدمة.

ومع تقدم الذكاء الاصطناعي، يمكننا أن نتوقع المزيد من الابتكارات, اختراقات الذكاء الاصطناعي وأدوات الذكاء الاصطناعي لتعزيز الإنتاجية وتحسين عملية اتخاذ القرار وإحداث ثورة في الصناعات. يفتح هذا التقدم إمكانيات جديدة، ويدفعنا نحو مستقبل يلعب فيه الذكاء الاصطناعي دورًا حاسمًا في المجالين الشخصي والمهني.

مع أدوات الذكاء الاصطناعي مثل ClickUp Brain، يمكنك تحقيق أقصى استفادة من تقنيات الذكاء الاصطناعي مع تأمين نفسك ضد تحديات الذكاء الاصطناعي للخصوصية وأمن البيانات. ClickUp هي أداة إدارة المهام المدعومة بالذكاء الاصطناعي لكل شيء بدءًا من مشاريع البرمجيات وحتى التسويق. اختر ClickUp لتحويل مؤسستك بأمان إلى كيان مدعوم بالبيانات والذكاء الاصطناعي بينما تعمل على زيادة إنتاجية فريقك.

هل أنت مستعد لتحويل سير عملك باستخدام الذكاء الاصطناعي؟ اشترك في ClickUp الآن!