Lorsque votre équipe passe des heures à rédiger des invitations, à ajuster des modèles et à assembler des pipelines de données juste pour déployer un agent IA, la productivité est au point mort.

Databricks a lancé Agent Bricks pour résoudre ce problème en automatisant l'ensemble du flux de travail de création et d'optimisation des données de l'entreprise.

Ce guide vous présente ses fonctionnalités, son fonctionnement et vous aide à déterminer si elle convient à votre infrastructure.

Points clés à retenir

- Databricks Agent Bricks automatise la création d'agents à l'aide de données synthétiques et de benchmarks.

- Elle élimine le réglage manuel des invitations et s'intègre directement à Unity Catalog.

- Les premiers utilisateurs signalent des coûts d'optimisation élevés, mais des performances solides à grande échelle.

- L'accès régional et la personnalisation limitée restent des risques majeurs pendant la phase bêta.

Databricks propose-t-il une IA agentique ?

Oui, Databricks a lancé Agent Bricks le 11 juin 2025 lors de son sommet Data+IA à San Francisco.

La plateforme automatise la création d'agents IA en générant des données synthétiques spécifiques au domaine et des benchmarks adaptés aux tâches, puis en optimisant les modèles en termes de coût et de qualité sans ingénierie manuelle.

S'appuyant sur l'acquisition de MosaicML par Databricks en 2023, ce produit positionne Databricks à la fois comme fournisseur de data lakehouse et plateforme d'IA agentique.

Elle s'adresse aux équipes qui gèrent de grands volumes de documents internes, d'enregistrements transactionnels ou de contenu non structuré et qui ont besoin d'agents capables d'extraire des informations, de répondre à des questions ou de coordonner des flux de travail en plusieurs étapes avec une sécurité maximale.

Agent Bricks est entré en phase bêta publique mi-2025. Initialement disponible sur AWS dans les régions américaines, son expansion en Europe est prévue d'ici la fin de l'année.

Comment fonctionne-t-elle concrètement ?

Agent Bricks réduit le cycle traditionnel d'essais et d'erreurs à un pipeline guidé. Vous décrivez la tâche en langage clair, établissez les connexions entre vos sources de données via Unity Catalog, et le système génère automatiquement des exemples d'entraînement synthétiques qui reflètent votre domaine.

Ces exemples alimentent une suite de tests de référence qui évalue les modèles candidats en fonction de leur précision, de leur latence et de leur coût. La plateforme effectue ensuite une sélection de la configuration qui répond à vos critères de qualité au prix le plus bas par inférence.

Ce flux de travail élimine les semaines que les équipes passent généralement à libeller les données, à ajuster les invitations et à effectuer des tests A/B.

En coulisses, MLflow 3.0 enregistre chaque exécution d'évaluation, ce qui vous permet de remonter jusqu'aux données et paramètres sous-jacents pour comprendre les décisions du modèle. La sécurité reste intacte, car les agents ne sortent jamais les données du périmètre du lakehouse Databricks.

Cet aperçu architectural prend tout son sens lorsque vous constatez qu'il permet de résoudre un problème concret.

À quoi cela ressemble-t-il dans la pratique ?

L'équipe chargée des données chez AstraZeneca était confrontée à un arriéré de 400 000 PDF issus d'essais cliniques qui devaient être extraits de manière structurée pour être soumis aux autorités réglementaires. Une révision manuelle aurait pris des mois.

Ils ont configuré un agent d'extraction d'informations dans Agent Bricks, l'ont dirigé vers le référentiel de documents et ont laissé le système générer des échantillons synthétiques basés sur des schémas de protocole d'essai. L'agent a analysé les 400 000 fichiers en moins de 60 minutes, sans aucun code.

- L'équipe identifie le goulot d'étranglement de l'extraction des données et la date limite réglementaire.

- Effectue la connexion des Agent Bricks au lac de documents interne via Unity Catalog.

- La plateforme exécute l'optimisation, génère des benchmarks spécifiques à la tâche et effectue la sélection d'un modèle ajusté.

- Déployez l'agent en production et réduisez ainsi plusieurs semaines de travail manuel à moins d'une heure.

Hawaiian Electric a constaté des gains similaires lorsqu'elle a remplacé une solution fragile basée sur LangChain par Agent Bricks pour les requêtes de documents juridiques.

Le nouvel agent a largement surpassé l'outil d'origine en termes de précision des réponses, tant dans les évaluations par automatisation que humaines, ce qui a donné aux employés la confiance nécessaire pour s'y fier pour leurs recherches en matière de conformité.

Intégration et compatibilité avec l'écosystème

Agent Bricks hérite de la couche d'intégration de Databricks, il se connecte donc directement aux plateformes que vos équipes de données et de ML utilisent déjà.

Unity Catalog agit comme un hub de gouvernance centralisé, gérant l'accès aux lacs de données, aux entrepôts et aux magasins vectoriels dans un cadre politique unique.

Les agents effectuent des requêtes sur les tables Delta, les fichiers Parquet ou les documents stockés dans le lakehouse sans copier les données vers des services externes.

| Plateforme/Partenaire | Nature de l'intégration |

|---|---|

| Catalogue Unity | Gouvernance unifiée pour les données, les modèles et les résultats des agents |

| Neon | Postgres sans serveur pour les flux de travail transactionnels des agents |

| Tecton | Fonctionnalité en temps réel avec une latence inférieure à 100 ms |

| OpenAI | Accès natif à GPT-5 sur les données de l'entreprise |

Les développeurs interagissent avec Agent Bricks via les API et SDK Databricks standard. La fonction SQL ai_query permet aux analystes d'appeler directement les LLM dans les requêtes, et les points de terminaison REST servent les agents via l'infrastructure Model Serving.

Les intégrations IDE fournissent l'assistance pour les pipelines CI/CD, ce qui permet aux ingénieurs de contrôler les versions des configurations des agents parallèlement au code des applications.

L'acquisition prochaine de Tecton permettra d'intégrer une boutique de fonctionnalités en ligne dans Agent Bricks, fournissant des données en streaming aux agents avec une latence inférieure à 10 ms.

Cette fonctionnalité débloque la détection des fraudes, la personnalisation et d'autres cas d'utilisation qui dépendent d'informations actualisées à la seconde près.

Pour l'instant, les équipes peuvent créer des prototypes à l'aide de fonctionnalités par lots et prévoir de passer aux données en temps réel une fois que l'intégration sera effective, mi-2026.

Avis de la communauté et impressions des premiers utilisateurs

Les premiers retours sont partagés entre l'enthousiasme pour sa facilité d'utilisation et la prudence quant aux limites de la version bêta.

Un utilisateur de Reddit a salué le générateur d'agents sans code et l'intégration étroite avec Unity Catalog, notant que les agents héritent automatiquement des permissions d'accès aux données.

Le même utilisateur a signalé qu'une optimisation complète prend généralement plus d'une heure et coûte plus de 100 dollars en calcul, ce qui peut représenter une somme importante pendant la phase d'expérimentation.

- « Elle simplifie considérablement notre flux de travail et réduit les réglages manuels. » Reddit

- « Le coût par optimisation peut être élevé en version bêta. » Reddit

- « L'accès sécurisé au contenu interne renforce la confiance dans la plateforme. » Communauté Databricks

La disponibilité régionale a créé des frictions pour les équipes européennes. Un représentant commercial de Databricks a confirmé mi-2025 que l'Agent Bricks n'était disponible qu'aux États-Unis pendant la phase de prévisualisation initiale, ce qui a incité certains clients à créer des environnements de travail sandbox dans des régions américaines pour tester le produit.

Les messages sur les forums mentionnent également une instabilité de la préversion et des changements fréquents de fonctionnalités, ce qui est typique des logiciels en version bêta, mais qui mérite d'être pris en compte si votre cas d'utilisation exige une disponibilité élevée.

Dans l'ensemble, les premiers utilisateurs qui peuvent s'adapter aux particularités de la version bêta et aux coûts de calcul voient la valeur de l'automatisation offerte par Agent Bricks. L'analyse de 400 000 documents par AstraZeneca et les gains de précision réalisés par Hawaiian Electric trouvent un écho dans toute la communauté, prouvant que la plateforme est capable de gérer des tâches à l'échelle de la production.

Cette validation concrète est importante lorsque vous devez décider d'investir du temps en ingénierie dès maintenant ou d'attendre que le produit arrive à maturité.

Feuille de route et Outlook de l'écosystème

Databricks prévoit d'étendre la couverture géographique et les fonctions d'Agent Bricks au cours des 18 prochains mois. D'ici le quatrième trimestre 2025, la préversion sera déployée dans les régions européennes, à commencer par les déploiements Azure en Europe occidentale.

Cette étape du déploiement permet à l'entreprise de recueillir divers commentaires des utilisateurs et de garantir la conformité avec les réglementations régionales en matière de données avant d'annoncer sa disponibilité générale.

L'intégration de Tecton prévue mi-2026 permettra aux agents d'extraire des fonctionnalités en temps réel à partir de flux, d'API et d'entrepôts avec une disponibilité de 99,99 %, ce qui facilitera la détection des fraudes et les cas d'utilisation de personnalisation qui nécessitent des données actualisées à la seconde près.

Neon et Mooncake fusionneront pour offrir une expérience « Lakehouse DB » unifiée, permettant aux agents d'effectuer des écritures conformes à ACID et des lectures analytiques instantanées sans pipelines ETL.

« Agent Bricks marque un tournant majeur dans l'IA de l'entreprise », a souligné un analyste de VentureBeat, en mettant en avant les gains de performance de 10 à 100 fois supérieurs obtenus grâce à l'élimination des pipelines de données traditionnels.

Attendez-vous à de nouveaux modèles d'agents au-delà des quatre types initiaux (extraction d'informations, assistant de connaissances, superviseur multi-agents, agent LLM personnalisé).

Les recherches de Databricks portent sur les assistants de code, les agents de planification et les connecteurs vers des API externes. Le partenariat avec OpenAI garantit que lorsque OpenAI commercialisera GPT-5 et ses futurs modèles, ceux-ci seront disponibles en natif dans Agent Bricks avec une assistance et une gouvernance de première partie.

À long terme, Databricks envisage l'IA agentique comme un nouveau profil d'utilisateur sur la plateforme, aux côtés des ingénieurs et analystes de données. Cette vision inclut un investissement continu dans des fonctionnalités d'IA responsable telles que les journaux d'audit, la détection des biais et les contrôles de politique granulaires, à mesure que l'adoption des agents se développe dans les secteurs réglementés.

Combien coûte l'IA agentique de Databricks ?

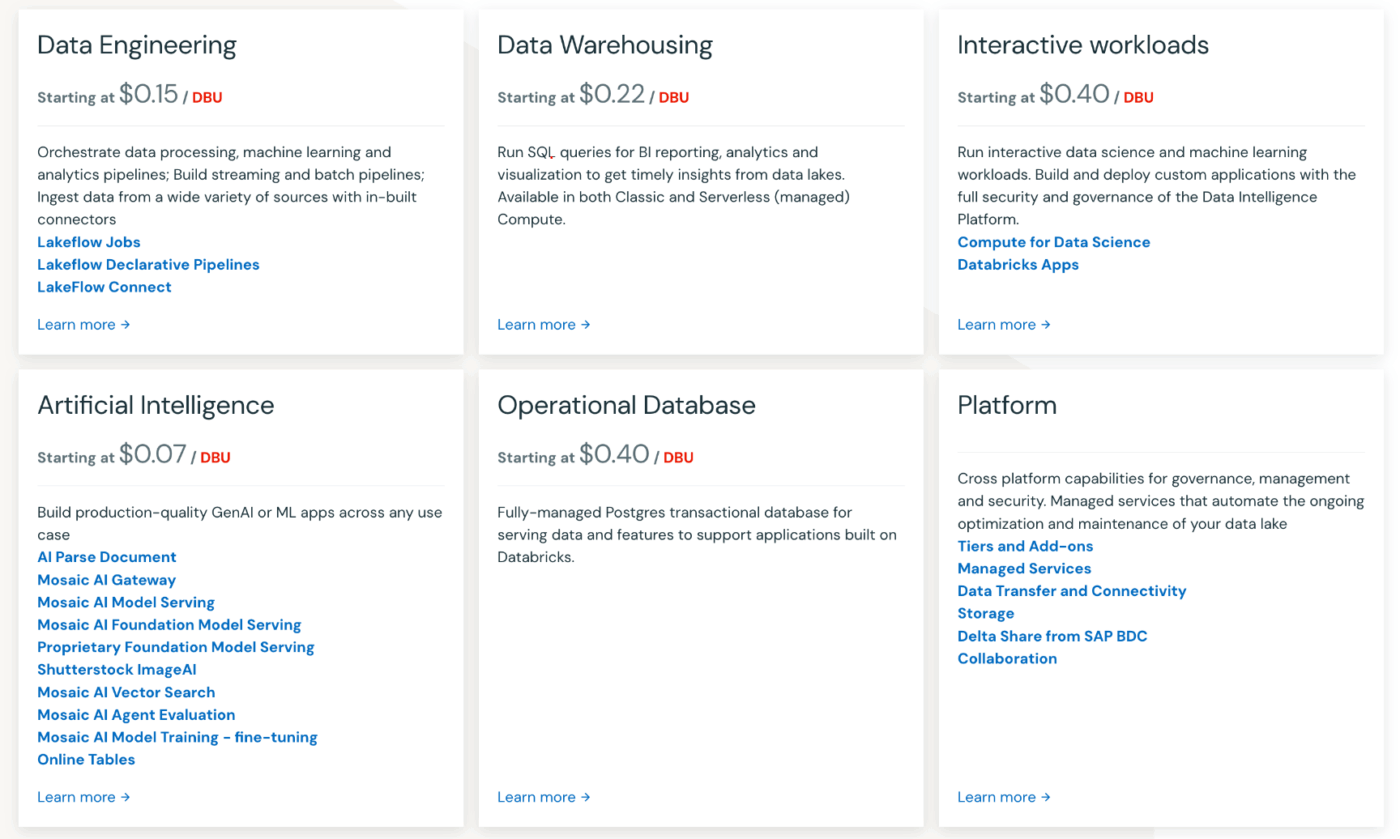

Agent Bricks est abonné au modèle de tarification basé sur l'utilisation de Databricks, sans frais de licence initiaux. Vous payez à la seconde pour le calcul et l'inférence du modèle, facturés en unités Databricks (DBU).

Les charges de travail Model Serving et Feature Serving coûtent environ 0,07 $ par DBU-seconde dans le cadre du forfait Premium, qui inclut le coût de l'instance cloud sous-jacente. L'inférence accélérée par GPU pour les modèles de base coûte également près de 0,07 $ par DBU-seconde.

La partie intensive est l'exécution initiale de l'optimisation. L'un des premiers utilisateurs a déclaré avoir dépensé plus de 100 dollars en calcul cloud pour un cycle de formation d'une heure qui a généré des données synthétiques et réglé l'agent.

Après optimisation, l'utilisation de l'agent devient beaucoup moins coûteuse, car le système a identifié une configuration de modèle rentable qui maintient la qualité avec moins de jetons par requête. Les équipes peuvent fixer des limites budgétaires via la politique budgétaire de Databricks afin de plafonner les dépenses pendant la phase d'expérimentation.

Les entreprises peuvent acheter des packs d'engagement (heures DBU prépayées) afin de bénéficier de réductions sur volume, ce qui réduit efficacement le tarif à la seconde par rapport à la facturation à la demande. Le prix exact varie en fonction de votre fournisseur de cloud (AWS, Azure, GCP) et de votre région, certaines régions affichant des tarifs légèrement supérieurs à ceux de l'est ou de l'ouest des États-Unis.

Les coûts cachés à prendre en compte comprennent le calcul pour la recherche vectorielle, l'ingestion de données et le réentraînement périodique à mesure que la distribution de vos données évolue. Tenez compte du temps d'ingénierie économisé en évitant le réglage manuel des invites et le libellage des données lorsque vous calculez le coût total de propriété.

Les premiers utilisateurs rapportent que les semaines de travail manuel économisées grâce à Agent Bricks compensent souvent les frais informatiques, en particulier si l'on tient compte du coût d'opportunité lié au retard dans le déploiement de l'agent.