هل لديك شعور بأن أحداً لم يتحدث عن الذكاء الاصطناعي حتى وقت قريب؟ على الرغم من أن هذه التكنولوجيا كانت موجودة منذ عقود، إلا أن استخدامها وشعبيتها ارتفعت بشكل كبير في السنوات القليلة الماضية. واليوم، أصبح للذكاء الاصطناعي التوليدي تطبيقات متعددة، من الزراعة إلى تطوير البرمجيات والرعاية الصحية

يستمر التوسع الهائل للذكاء الاصطناعي، ولا يمكن لأحد أن يتنبأ بالآفاق التي سيصل إليها. ومع هذا النمو السريع جاءت الحاجة إلى كبح جماح تطوير الذكاء الاصطناعي ونشره بطريقة أو بأخرى - ففي نهاية المطاف، قد تُستغل قوته الهائلة لأغراض غير أخلاقية أو حتى غير قانونية.

احتاجت الحكومات والمنظمات والباحثون إلى وضع لوائح ومعايير لضمان التطوير والتطبيق السليم والمسؤول للذكاء الاصطناعي - وهكذا جاءت حوكمة الذكاء الاصطناعي.

في هذه المقالة، سنناقش حوكمة الذكاء الاصطناعي بشكل متعمق، وسنتحدث أكثر عن أهميتها، وسنستعرض أفضل الممارسات لتطوير إطار عمل لحوكمة الذكاء الاصطناعي لمؤسستك. 💪

ما هي حوكمة الذكاء الاصطناعي؟

حوكمة الذكاء الاصطناعي هي مجموعة من المعايير والمبادئ والأطر التي تحدد التطوير والنشر الأخلاقي والمسؤول والآمن لتقنيات الذكاء الاصطناعي.

فمن ناحية، تعالج التحديات والمخاطر المحتملة لتطوير الذكاء الاصطناعي واستخدامه. ومن ناحية أخرى، تعزز التأثيرات الإيجابية التي يمكن أن يحدثها الذكاء الاصطناعي على المجتمع وتضمن عدم استخدام أي شخص للتكنولوجيا لأغراض غير أخلاقية أو غير قانونية أو خبيثة.

من خلال الخوض في طبيعة أنظمة الذكاء الاصطناعي، تؤدي حوكمة الذكاء الاصطناعي دورًا حاسمًا في تعزيز الثقة. فهي تضمن أن تتسم تكنولوجيا الذكاء الاصطناعي بالشفافية والنزاهة والتنظيم الجيد، مع إعطاء الأولوية للخصوصية واحترام حقوق الإنسان وحرياته.

ما أهمية حوكمة الذكاء الاصطناعي؟

تزداد أهمية حوكمة الذكاء الاصطناعي مع كل تطور جديد في مجال الذكاء الاصطناعي. دعونا نرى ما الذي يجعلها حيوية للغاية في هذا اليوم وهذا العصر.

الاعتبارات الأخلاقية

الغرض الأساسي من الذكاء الاصطناعي هو إفادة المجتمع بشكل عام والأفراد على حد سواء. ويصبح السؤال حول ما إذا كان يفعل ذلك حقًا أمرًا بالغ الأهمية مع تغلغل تكنولوجيا الذكاء الاصطناعي في كل جانب من جوانب حياتنا تقريبًا.

تعالج حوكمة الذكاء الاصطناعي الاعتبارات الأخلاقية بهدف واحد هو ضمان تطور التكنولوجيا القائمة على الذكاء الاصطناعي في اتجاه يتماشى مع المبادئ والقيم المجتمعية. وتشمل بعض المفاهيم الأساسية ما يلي:

- التحيز: يضمن منع النتائج المتحيزة أو غير العادلة أو التمييزية عدم محاباة نماذج الذكاء الاصطناعي لأي شخص أو أي شيء. على سبيل المثال، تتمثل إحدى طرق تقليل التحيز في تدريب أنظمة الذكاء الاصطناعي على مجموعات بيانات متنوعة

- الخصوصية: تعمل حوكمة الذكاء الاصطناعي على حل مشكلة الخصوصية من خلال القواعد واللوائح التي تتطلب من أنظمة الذكاء الاصطناعي ومنشئيها ضمان حماية الخصوصية والتعامل مع البيانات الخاصة بمسؤولية. يحتاج كل نظام ذكاء اصطناعي إلى تحديد سياسات الخصوصية الخاصة به وطلب موافقة المستخدمين

- الشفافية: إن جعل خوارزميات الذكاء الاصطناعي مفهومة للأفراد والمؤسسات أمر بالغ الأهمية لمنح المستخدمين راحة البال، والتعرف على الأخطاء المحتملة والإبلاغ عنها، والحفاظ على كفاءة النظام ودقته

الامتثال القانوني

في الوقت الذي يجتاح فيه الذكاء الاصطناعي العالم، قررت العديد من الحكومات والمنظمات في جميع أنحاء العالم اتخاذ خطوات ملموسة لتحديد ما يجب فعله وما لا يجب فعله عند استخدامه. كان هذا رد فعل طبيعي للمخاوف المتزايدة بشأن إمكانية التلاعب بالذكاء الاصطناعي والمراقبة والهجمات الإلكترونية وغيرها من الأغراض غير الأخلاقية أو غير القانونية.

قام المشرعون والمنظمون بتنفيذ أو يستعدون لـ تنفيذ القوانين واللوائح المتعلقة بالذكاء الاصطناعي التي تتناول

- الخصوصية

- الاعتبارات الأخلاقية

- إدارة المخاطر

- الجوانب الأخرى لحوكمة الذكاء الاصطناعي

على سبيل المثال، في الولايات المتحدة الأمريكية، نشر البيت الأبيض مخطط لوثيقة حقوق الذكاء الاصطناعي يحدد كيفية تطوير تكنولوجيا الذكاء الاصطناعي واستخدامها وحماية الناس من التهديدات المتعلقة بالذكاء الاصطناعي.

يعمل الاتحاد الأوروبي على وضع قانون الذكاء الاصطناعي الأكثر شمولاً في العالم - وهو قانون الذكاء الاصطناعي الذي سيحدد المخاطر المحتملة لأنظمة الذكاء الاصطناعي المختلفة ويضع قواعد لتطوير التكنولوجيا واستخدامها.

إدارة المخاطر

يمكن للذكاء الاصطناعي أن يحقق المعجزات للأفراد والشركات، ولكنه ينطوي على مخاطر مثل التحيز، والاعتماد المفرط على التكنولوجيا، والانتهاكات المحتملة للخصوصية.

توفر حوكمة الذكاء الاصطناعي الأساس لاستراتيجيات إدارة المخاطر. وبذلك، تساعدك على تعظيم قوة الذكاء الاصطناعي ضمن الحدود الأخلاقية والقانونية.

قابلية التدقيق

نشهد جميعاً تقدماً هائلاً وسريعاً في تكنولوجيا الذكاء الاصطناعي. وعلى الرغم من أنه قد يبدو أن التكنولوجيا تتطور بشكل مستقل دون أي مراقبة، إلا أن الأمر ليس كذلك. في الواقع، فإن أحد المجالات الرئيسية التي تعالجها حوكمة الذكاء الاصطناعي هو التدقيق في أنظمة الذكاء الاصطناعي.

عمليات التدقيق المنتظمة والشاملة تفحص كفاءة أنظمة الذكاء الاصطناعي. فهم يتعمقون في التكنولوجيا لفحص ما إذا كان كل شيء يرقى إلى المعايير الأخلاقية ويتماشى مع أحدث اللوائح.

إلى جانب المساعدة في الحفاظ على وظائف الأنظمة، فإن عمليات التدقيق ضرورية لتعزيز ثقة الجمهور في التكنولوجيا.

التوعية

من المجالات الأخرى التي تغطيها حوكمة الذكاء الاصطناعي رفع مستوى الوعي و تثقيف المجتمع حول التكنولوجيا. فهو يسلط الضوء على الإمكانات المذهلة للذكاء الاصطناعي وتطبيقاته المختلفة مع شرح المخاطر والتحديات المرتبطة به بوضوح. وهذا يعزز فهم أفضل لـ

- الاستخدام المسؤول

- المراقبة المنتظمة

- التدريب المناسب

كما أنه يساعد الأفراد والشركات على فهم كيفية استغلال قوة الذكاء الاصطناعي لحل التحديات المختلفة التي تواجههم.

من المسؤول عن حوكمة الذكاء الاصطناعي؟

على نطاق أوسع، الهيئات الحكومية والتنظيمية هي المسؤولة عن وضع السياسات والمبادئ التوجيهية في نطاق اختصاصها. وعلى مستوى المؤسسات الفردية، تعتمد الإجابة على هياكلها وتوزيع أعباء العمل فيها.

على سبيل المثال، قد يكون لديك فريق مخصص لوضع إطار عمل لحوكمة الذكاء الاصطناعي. يمكن أن يضم هذا الفريق خبراء الذكاء الاصطناعي وعلماء البيانات والمطورين والمتخصصين القانونيين وموظفي الموارد البشرية. بدلاً من ذلك، يمكن أن يكون لديك فرق لإدارة المخاطر وقادة تنفيذيون يتعاملون مع تنظيم الذكاء الاصطناعي.

من المهم التأكيد على أن الحوكمة الفعالة لحوكمة الذكاء الاصطناعي هي جهد جماعي. يلعب الجميع دورًا، ويعد الالتزام الجماعي بالمبادئ التوجيهية المقررة أمرًا ضروريًا للحفاظ على الامتثال وضمان الاستخدام المسؤول والأخلاقي. في حين أن صانعي القرار (أي أصحاب المناصب والمسؤولين التنفيذيين في الشركة) يتحملون مسؤولية أكبر، فإن المساءلة تمتد إلى جميع المستخدمين بدرجة معينة.

إذا كنت تنشئ نظام حوكمة للذكاء الاصطناعي لشركتك، فتأكد من أن الجميع يفهمون كيف يتناسبون مع الصورة الأكبر لتجنب الأخطاء وسوء الفهم.

إنشاء ممارسات حوكمة الذكاء الاصطناعي لشركتك: أفضل الممارسات

كما رأينا، فإن حوكمة استخدام الذكاء الاصطناعي تقلل من المخاطر الأخلاقية ومخاطر الامتثال وتزيد من كفاءة التكنولوجيا. وفي نهاية المطاف، يمكن لإطار عمل قوي لحوكمة الذكاء الاصطناعي أن يرفع أداء أعمالك إلى أعلى المستويات. دعنا نستكشف بعضًا من أفضل الممارسات لإنشائها.

1. حدد أهداف حوكمة الذكاء الاصطناعي لديك

قبل تنفيذ حوكمة الذكاء الاصطناعي، عليك أن تفهم سبب قيامك بذلك. ما فائدة ذلك لمؤسستك؟

حدد أهدافك وتأكد من توافقها مع القيم الأساسية لشركتك. على سبيل المثال، يمكنك أن تقول أن هدفك هو تعزيز خدمة العملاء من خلال الاستخدام المسؤول والأخلاقي للذكاء الاصطناعي وتحقيق أقصى قدر من الشفافية. أو يمكنك التركيز على تثقيف فريقك حول المخاطر والآثار المحتملة للذكاء الاصطناعي.

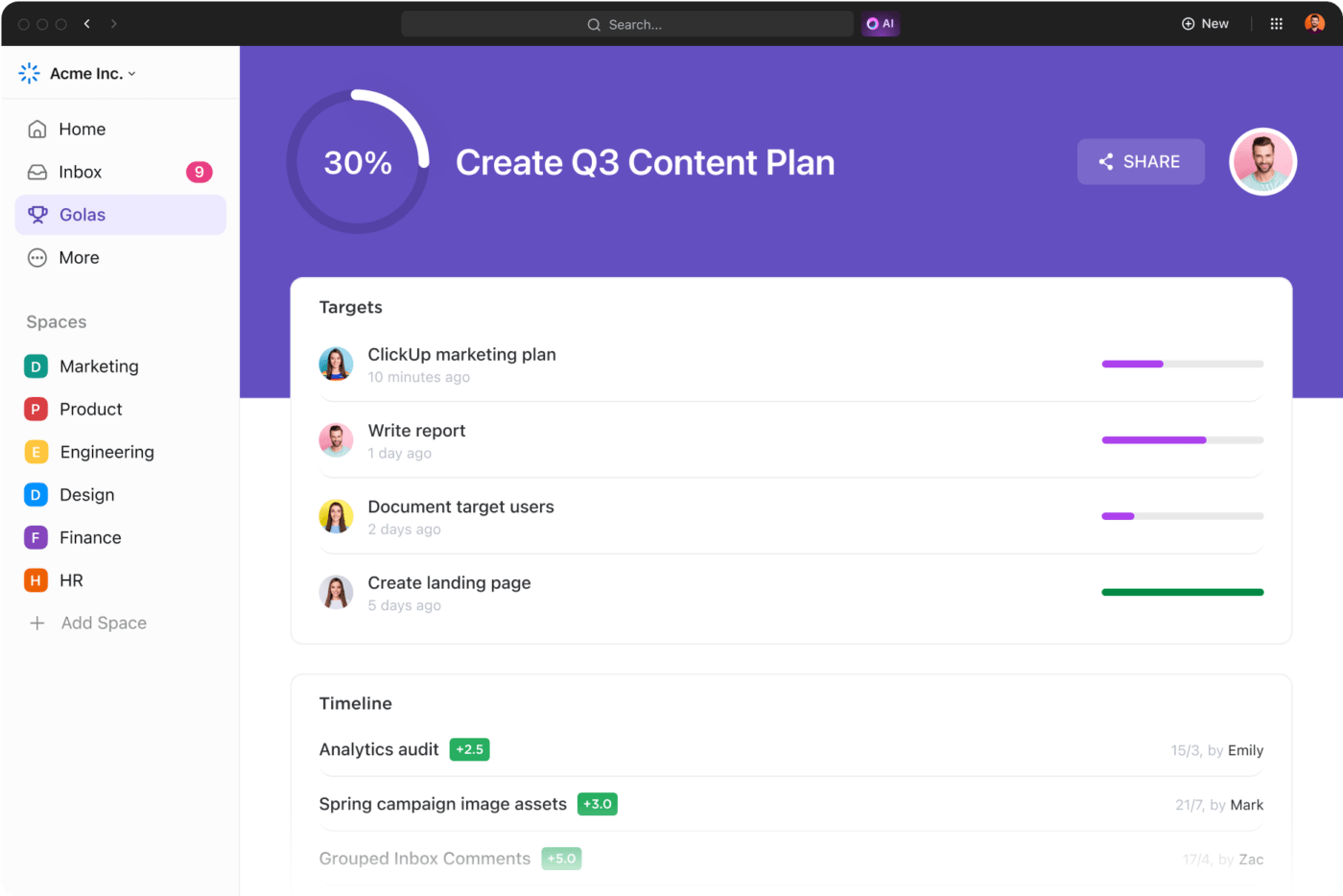

لحسن الحظ، لست مضطراً لكتابة أهدافك على سبورة المكتب أو في ملاحظاتك. يمكنك استخدام انقر فوق وهي منصة إنتاجية شاملة، تحديد أهداف وغايات واضحة وقابلة للقياس.

تحتوي المنصة على ميزة فريدة تسمى أهداف النقر -استخدمه لتحديد الأهداف والجداول الزمنية والاستراتيجيات وتتبع التقدم المحرز. أضف أعضاء الفريق المعنيين إلى الأهداف واحتفظ بكل شيء موثقًا. قم بمراجعة أهدافك في المستقبل ومعرفة ما إذا كانت بحاجة إلى تعديلات.

وضع أهداف قابلة للقياس للمهام والمشروعات مع التقدم التلقائي لتحقيق الأهداف بفعالية أكبر مع جداول زمنية محددة وأهداف قابلة للقياس الكمي

2. بناء فريق أحلامك لحوكمة الذكاء الاصطناعي

لا يمكنك تنفيذ إطار عمل تنظيمي للذكاء الاصطناعي دون وجود خبراء يوجهون العملية ويراقبونها. لهذا السبب يجب أن يكون من أول الأشياء على جدول أعمالك تجميع فريق مسؤول عن حوكمة الذكاء الاصطناعي في مؤسستك. يجب أن يتمتع الأشخاص في الفريق بالمهارات والخبرات والسلطة اللازمة لصياغة السياسات والإشراف على تنفيذها.

يجب أن يكون فريق عمل حوكمة الذكاء الاصطناعي لديك قادرًا على التعاون والتواصل دون عوائق.

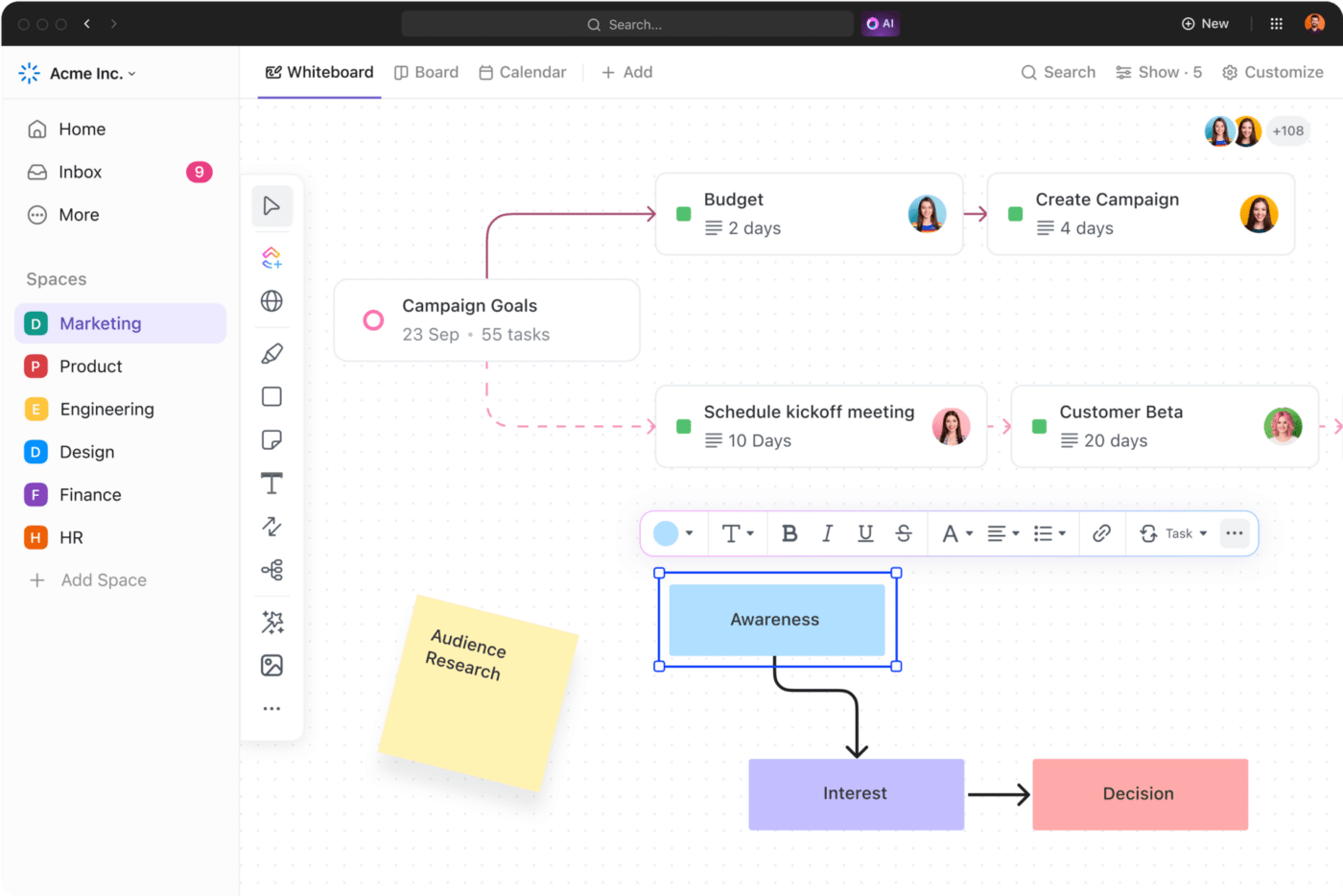

يوفر ClickUp ميزات تضمن انسيابية التواصل وتشجيع العمل الجماعي. يمكن لفريقك استخدام ClickUp Whiteboards لتبادل الأفكار ووضع الاستراتيجيات والخطط. اللوحات البيضاء عبارة عن لوحات رقمية تتيح للفرق التعاون في الوقت الفعلي والانتقال بسرعة من الأفكار إلى إجراءات ملموسة.

قم بالعصف الذهني أو وضع الاستراتيجيات أو تخطيط سير العمل باستخدام لوحات ClickUp Whiteboards التعاونية المرئية عرض ClickUp Chat هو خيار رائع آخر للتواصل الواضح وغير المنقطع والمناقشات البناءة. وفي الوقت نفسه انقر فوق الخرائط الذهنية للفرق بتصور سير العمل وتقسيمه إلى خطوات ومهام محددة.

3. اختر أداة الذكاء الاصطناعي المناسبة

إذا كانت شركتك ترغب في جني فوائد الذكاء الاصطناعي المسؤول، فمن الضروري البحث عن أداة موثوقة توفر وظائف مذهلة دون التعرض لخطر التحيز وانتهاك الخصوصية.

تقدم ClickUp أداة رائعة مدعومة بالذكاء الاصطناعي مساعد الكتابة يمكن أن يحفز إنتاجيتك ويوفر عليك الكثير من الوقت- ClickUp AI .

استخدم ClickUp AI للكتابة بشكل أسرع، وتلخيص النص وصقله، وإنشاء ردود على البريد الإلكتروني، والمزيد

يتيح لك ClickUp AI إنشاء جميع أنواع المحتوى في غمضة عين. لنفترض أنك تريد كتابة بريد إلكتروني احترافي لعميل مهم ولكنك لا تعرف من أين تبدأ. يمكن ل ClickUp إنشاء البريد الإلكتروني لك بناءً على التعليمات التي تقدمها. ما عليك سوى مراجعة المحتوى والنقر على إرسال! ✉️

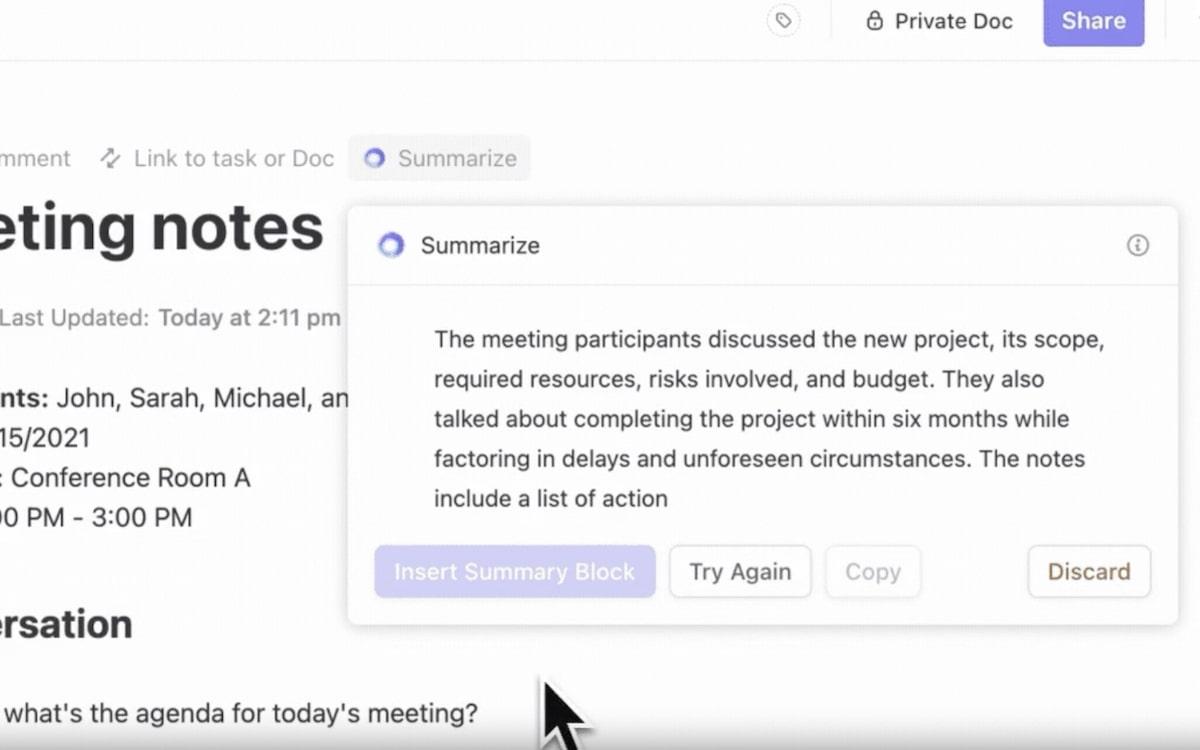

بالطبع، يمكن ل ClickUp AI القيام بأكثر من مجرد إنشاء رسائل البريد الإلكتروني. يمكنه تلخيص ملاحظات الاجتماع وإنشاء جداول الأعمال والعروض التقديمية وموجزات المشاريع, الخرائط الذهنية والجداول الزمنية. استخدمه لتنسيق النص وتحريره لتحقيق أقصى قدر من الوضوح والتأثير.

لخص ملاحظات الاجتماع في ثوانٍ باستخدام ClickUp AI

الميزة الإضافية هي خيار إنشاء عناصر العمل والمهام الفرعية بناءً على سياق النص الخاص بك. كل ما عليك القيام به هو تحديد الجزء المطلوب، والضغط على AI، واختيار إنشاء عناصر الإجراء، وشاهد ClickUp AI يقوم بسحره. ✨

بفضل خياراته المتنوعة، يمكن استخدام ClickUp AI في مجالات مثل:

- الاستشارات

- المبيعات

- خدمة العملاء

- هندسة

- إدارة المشاريع

- التصنيع

أفضل ما في الأمر أن ClickUp يعمل على الهواتف المحمولة وويندوز و أجهزة ماك ، بحيث يمكنك استخدامه بسلاسة بغض النظر عن نظام التشغيل أو موقعك.

ClickUp AI هو استنادًا إلى مجموعة متنوعة من النماذج لتمنحك أفضل تجربة ممكنة، بما في ذلك نظام ChatGPT-4 من Open AI، وهو النظام الأكثر تقدماً مع التركيز على السلامة.

إذا كنت قلقاً بشأن الخصوصية، فسوف يسعدك أن تعرف أن ClickUp قد حصلت على ترخيص يضمن عدم استخدام بياناتك لتدريب نماذج الذكاء الاصطناعي.

إلى جانب ClickUp AI، تقدم المنصة طريقة للتواصل بكفاءة مع روبوتات الدردشة مثل ChatGPT- قوالب موجهات الذكاء الاصطناعي . ابحث عن موجه يتوافق مع مقصدك، وعدّله قليلاً إذا لزم الأمر، واحصل على النتائج المطلوبة في ثوانٍ.

4. توثيق أطر الحوكمة وتدريب موظفيك

لقد حان الوقت الآن لصياغة معايير وسياسات حوكمة الذكاء الاصطناعي الخاصة بمؤسستك. اعتمادًا على مجال عملك، ستستخدم السياسات كمبادئ توجيهية لتطوير أو استخدام تكنولوجيا الذكاء الاصطناعي في شركتك. تأكد من توافقها مع قيم الشركة ورسالتها ورؤيتها واتباع أحدث معايير الأمان والخصوصية.

يجب أن تغطي هذه السياسات أيضًا المخاطر المحتملة وطرق تقليلها.

لا تنسَ توصيل كل سياسة إلى موظفيك والتأكد من فهمهم لكل شيء. استخدم مستندات ClickUp محرر نصوص ClickUp، محرر نصوص ClickUp القادر على توثيق الإجراءات والإرشادات ومشاركتها بسهولة مع فريقك.

تعاون مع أعضاء الفريق في مستندات ClickUp Docs لتخصيص الخطوط أو إضافة علاقات المهام أو الارتباط بالمهام مباشرة في المستند

5. تسهيل المراقبة المستمرة

مع تطور مشهد الذكاء الاصطناعي باستمرار، ستتطلب سياسات ومعايير حوكمة الذكاء الاصطناعي لديك مراجعات عرضية للتأكد من ملاءمتها وفعاليتها. قم بمراجعتها بانتظام لمعرفة ما إذا كانت هناك أجزاء معينة تتطلب تحديثات وضمان الأداء الأمثل. ✨

عواقب الذكاء الاصطناعي غير المنظم

من دون ذكاء اصطناعي منظم، ربما ينحدر العالم الحديث بسرعة إلى سيناريو الغرب المتوحش - فغياب الضوابط والسياسات والقوانين قد يكون له عواقب لا حصر لها على المجتمع. دعونا نناقش بعضًا منها. 👇

التمييز

يمكن أن تكون أنظمة الذكاء الاصطناعي غير المنظمة متحيزة وتمييزية. لماذا؟ لأن هذه الأنظمة يتم تدريبها على بيانات مليئة بالتحيز والتمييز، فلا يمكن أن تكون مخرجاتها مختلفة.

لنفترض أنك تستخدم نظام ذكاء اصطناعي لتوظيف موظف جديد. إذا كان النظام يحتوي على خوارزميات متحيزة أو تم تدريبه على بيانات متحيزة، فقد يفضل نظاماً معيناً:

- الديموغرافية

- الفئة العمرية

- الجنس

يمكنك أن تتخيل تداعيات عملية التوظيف هذه - فالنظام سيستبعد، حسب التصميم، مرشحين معينين، على الرغم من أنهم قد يكونون أكثر خبرة أو أكثر ملاءمة للوظيفة.

والآن تخيل مئات الشركات التي تستخدم نفس النظام الذي تستخدمه. إن حوكمة الذكاء الاصطناعي تحمي من مثل هذه السيناريوهات من خلال فحص أداء أنظمة الذكاء الاصطناعي ووضع قواعد لتقليل التحيز.

انتهاكات الخصوصية

يتم "تغذية" أنظمة الذكاء الاصطناعي بأكوام من البيانات الشخصية والحساسة. ولولا حوكمة البيانات، لما كانت هناك قواعد خصوصية وأمان للبيانات تحمي المستخدمين من سرقة الهوية والوصول غير المصرح به والانتهاكات الأمنية.

التلاعب الاجتماعي

مع تقدم تكنولوجيا الذكاء الاصطناعي وزيادة دقّتها، أصبح من الصعب على الأفراد التمييز بين المحتوى البشري والمحتوى الذي يتم إنشاؤه بواسطة الذكاء الاصطناعي.

التزييف العميق مثال ممتاز على ذلك. وهي عبارة عن صور ومقاطع فيديو مزيفة تم إنشاؤها باستخدام تقنيات التعلم العميق (ومن هنا جاءت التسمية). وغالباً ما تتميز بتبديل الوجوه وتوليف الصوت لخلق تأثير واقعي والتلاعب بالمشاهدين.

تتضمن الطرق الأخرى للتلاعب الاجتماعي "دفع" نوع معين من المحتوى على وسائل التواصل الاجتماعي باستخدام خوارزميات متحيزة.

انعدام الشفافية

تسلط حوكمة الذكاء الاصطناعي الضوء على الشفافية في أنظمة الذكاء الاصطناعي لضمان فهم المستخدمين لمبادئها الأساسية ومخاطرها المحتملة.

إذا لم تكن الشفافية مطلوبة، فلن يضطر مطورو الذكاء الاصطناعي إلى الإفصاح عن كيفية عمل أنظمتهم واتخاذ القرارات والاستنتاجات. ومن المحتمل أن يؤدي ذلك إلى انعدام الثقة في التكنولوجيا القائمة على الذكاء الاصطناعي وزيادة المخاوف المتعلقة بالخصوصية.

إزاحة الوظائف

أحد أكثر المواضيع الشائعة في الوقت الحاضر هو ما إذا كان الذكاء الاصطناعي سيأخذ وظائفنا. فالتطوير والنشر بسرعة البرق بدون تنظيم مناسب يمكن أن يترك ملايين الأشخاص بدون وظائف. وقد يؤدي ذلك إلى انهيار اجتماعي واقتصادي وسياسي محتمل جداً على نطاق عالمي.

من أجل الابتعاد عن مثل هذه السيناريوهات البائسة، تشجع حوكمة الذكاء الاصطناعي على تطوير الذكاء الاصطناعي الذي يضع مصالح الناس في الاعتبار.

تنفيذ حوكمة الذكاء الاصطناعي باستخدام ClickUp

يعد إعداد إطار عمل لحوكمة الذكاء الاصطناعي أمرًا حيويًا لضمان أن يكون استخدامك للتكنولوجيا القائمة على الذكاء الاصطناعي أخلاقيًا وقانونيًا ومسؤولًا. فهو يحافظ على سلامة شركتك ويساعدك على بناء علاقة جديرة بالثقة مع المستثمرين والعملاء.

يوفر ClickUp كل ما تحتاجه لصياغة السياسات ومراقبة تنفيذها وأدائها. فهو يوفر التواصل , تعاون الفريق ،التنظيم تحسين العملية و إدارة المشاريع والمهام .

يتميز ClickUp أيضًا بأحدث ما توصلت إليه تكنولوجيا أداة الذكاء الاصطناعي تساعدك على تسخير قوة الذكاء الاصطناعي دون مخاطر. اشترك في ClickUp ومهد الطريق للتطبيق المسؤول لتقنيات الذكاء الاصطناعي!