โครงการนำ AI ไปใช้ส่วนใหญ่ล้มเหลวไม่ใช่เพราะทีมเลือกโมเดลผิด แต่เป็นเพราะไม่มีใครจำได้อีกหลังจากสามเดือนว่าทำไมพวกเขาถึงเลือกโมเดลนั้นหรือจะตั้งค่าใหม่ได้อย่างไร โดยมี46% ของโครงการ AIถูกยกเลิกระหว่างขั้นตอนการพิสูจน์แนวคิดและการนำไปใช้ในวงกว้าง

คู่มือนี้จะแนะนำคุณในการใช้ Hugging Face สำหรับการปรับใช้ AI ตั้งแต่การเลือกและทดสอบโมเดลไปจนถึงการจัดการกระบวนการปรับใช้ เพื่อให้ทีมของคุณสามารถส่งมอบได้เร็วขึ้นโดยไม่สูญเสียการตัดสินใจที่สำคัญในกระทู้ Slack และสเปรดชีตที่กระจัดกระจาย

Hugging Face คืออะไร?

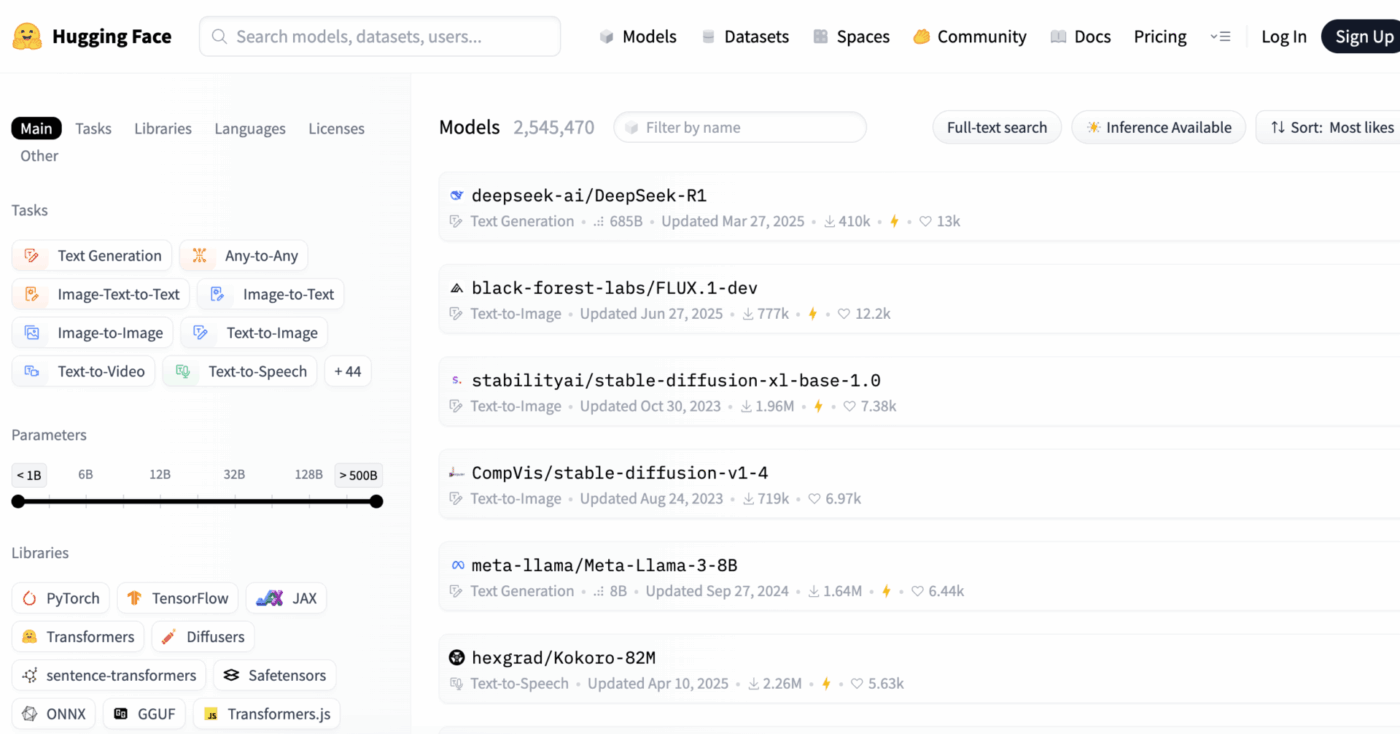

Hugging Face เป็น แพลตฟอร์มโอเพนซอร์ส และศูนย์กลางชุมชนที่ให้บริการโมเดล AI ที่ผ่านการฝึกอบรมไว้ล่วงหน้า ชุดข้อมูล และเครื่องมือสำหรับการสร้างและปรับใช้แอปพลิเคชันการเรียนรู้ของเครื่อง

คิดเสียว่ามันเป็นห้องสมุดดิจิทัลขนาดใหญ่ที่คุณสามารถค้นหา โมเดล AI ที่พร้อมใช้งาน ได้แทนที่จะต้องใช้เวลาหลายเดือนและทรัพยากรจำนวนมากในการสร้างขึ้นมาใหม่ตั้งแต่ต้น

มันถูกออกแบบมาสำหรับวิศวกรแมชชีนเลิร์นนิงและนักวิทยาศาสตร์ข้อมูล แต่เครื่องมือของมันถูกใช้มากขึ้นโดยทีมผลิตภัณฑ์ ทีมออกแบบ และทีมวิศวกรรมข้ามสายงานเพื่อผสาน AI เข้ากับกระบวนการทำงานของพวกเขา

คุณทราบหรือไม่:63% ขององค์กรขาดการปฏิบัติด้านการจัดการข้อมูลที่เหมาะสมสำหรับ AI ซึ่งมักนำไปสู่โครงการที่หยุดชะงักและทรัพยากรที่สูญเปล่า

ความท้าทายหลักสำหรับหลายทีมคือความซับซ้อนอย่างมากในการปรับใช้ AIกระบวนการนี้เกี่ยวข้องกับการเลือกโมเดลที่เหมาะสมจากตัวเลือกนับพัน การจัดการโครงสร้างพื้นฐานพื้นฐาน การควบคุมเวอร์ชันของการทดลอง และการทำให้มั่นใจว่าผู้มีส่วนได้ส่วนเสียทั้งทางเทคนิคและไม่ใช่ทางเทคนิคมีความสอดคล้องกัน

Hugging Face ทำให้สิ่งนี้ง่ายขึ้นด้วยการให้บริการ Model Hub ซึ่งเป็นคลังกลางที่มีโมเดลมากกว่า 2 ล้านโมเดล ห้องสมุด transformers ของแพลตฟอร์มนี้เป็นกุญแจสำคัญที่ปลดล็อกโมเดลเหล่านี้ ทำให้คุณสามารถโหลดและใช้งานได้เพียงแค่ไม่กี่บรรทัดของโค้ด Python

อย่างไรก็ตาม แม้จะมีเครื่องมือที่ทรงพลังเหล่านี้ การนำ AIไปใช้งานยังคงเป็นความท้าทายในการบริหารโครงการซึ่งต้องมีการติดตามอย่างรอบคอบในกระบวนการเลือกแบบจำลอง การทดสอบ และการเปิดตัว เพื่อให้มั่นใจในความสำเร็จ

📮ClickUp Insight: 92% ของพนักงานที่ใช้ความรู้เสี่ยงต่อการสูญเสียการตัดสินใจที่สำคัญซึ่งกระจัดกระจายอยู่ในแชท อีเมล และสเปรดชีต หากไม่มีระบบรวมศูนย์สำหรับการบันทึกและติดตามการตัดสินใจ ข้อมูลเชิงลึกทางธุรกิจที่สำคัญจะสูญหายไปในความวุ่นวายของข้อมูลดิจิทัล

ด้วยความสามารถในการจัดการงานของ ClickUp คุณไม่ต้องกังวลเกี่ยวกับเรื่องนี้อีกต่อไป สร้างงานจากแชท ความคิดเห็นของงาน เอกสาร และอีเมลได้ด้วยการคลิกเพียงครั้งเดียว!

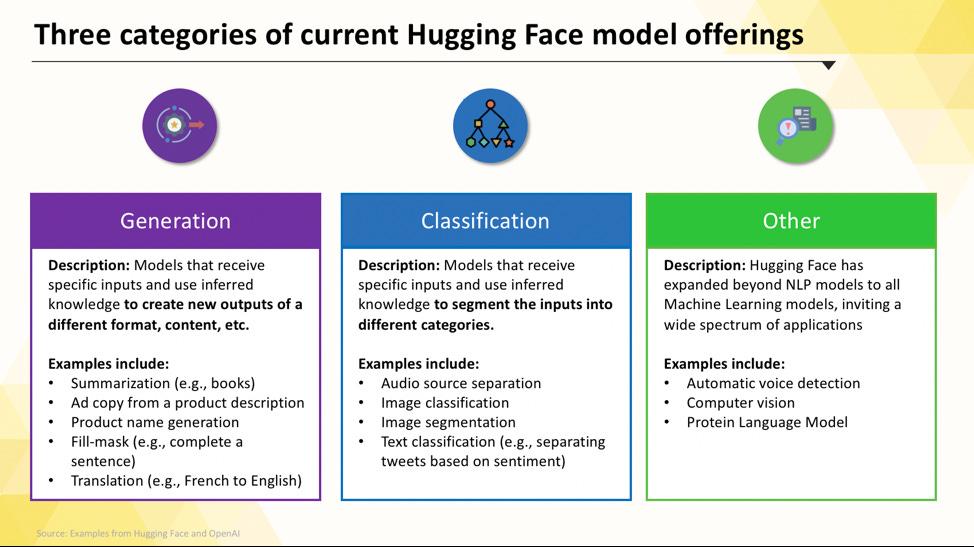

โมเดล Hugging Face ที่คุณสามารถนำไปใช้งานได้

การนำทางใน Hugging Face Hub อาจรู้สึกท่วมท้นเมื่อคุณเริ่มต้นเป็นครั้งแรก ด้วยจำนวนโมเดลหลายแสนตัว กุญแจสำคัญคือการเข้าใจหมวดหมู่หลักเพื่อค้นหาสิ่งที่เหมาะกับโครงการของคุณ โมเดลมีให้เลือกตั้งแต่ตัวเลือกขนาดเล็กและมีประสิทธิภาพที่ออกแบบมาเพื่อวัตถุประสงค์เดียวไปจนถึงโมเดลขนาดใหญ่ที่มีวัตถุประสงค์ทั่วไปซึ่งสามารถจัดการกับการคิดวิเคราะห์ที่ซับซ้อนได้

แบบจำลองภาษาเฉพาะงาน

เมื่อทีมของคุณต้องการ แก้ปัญหาที่ชัดเจนและเฉพาะเจาะจง คุณมักไม่จำเป็นต้องใช้โมเดลขนาดใหญ่ที่ครอบคลุมทุกด้าน เวลาและค่าใช้จ่ายในการใช้งานโมเดลดังกล่าวอาจสูงเกินไป โดยเฉพาะเมื่อเครื่องมือ AI ที่เล็กกว่าและเน้นเฉพาะด้านสามารถทำงานได้ดีกว่า นี่คือจุดที่โมเดลเฉพาะงานเข้ามามีบทบาท

นี่คือแบบจำลองที่ได้รับการฝึกฝนและปรับให้เหมาะสมสำหรับฟังก์ชันเฉพาะอย่างหนึ่ง เนื่องจากมีความเชี่ยวชาญเฉพาะทาง แบบจำลองเหล่านี้จึงมักมีขนาดเล็กกว่า เร็วกว่า และใช้ทรัพยากรน้อยกว่าแบบจำลองที่มีขนาดใหญ่กว่า

สิ่งนี้ทำให้พวกมันเหมาะอย่างยิ่งสำหรับสภาพแวดล้อมการผลิตที่ความเร็วและต้นทุนเป็นปัจจัยสำคัญ หลายรุ่นสามารถทำงานบนฮาร์ดแวร์ CPU มาตรฐานได้ ทำให้สามารถเข้าถึงได้โดยไม่ต้องใช้ GPU ที่มีราคาแพง

ประเภททั่วไปของแบบจำลองเฉพาะงาน ได้แก่:

- การจัดหมวดหมู่ข้อความ: ใช้เพื่อจัดประเภทข้อความให้เป็นหมวดหมู่ที่กำหนดไว้ล่วงหน้า เช่น การจัดเรียงความคิดเห็นของลูกค้าเป็น "เชิงบวก" หรือ "เชิงลบ" หรือการติดแท็กตั๋วสนับสนุนตามหัวข้อ

- การวิเคราะห์ความรู้สึก: ช่วยคุณกำหนดโทนอารมณ์ของข้อความ ซึ่งเหมาะสำหรับการติดตามแบรนด์บนสื่อสังคมออนไลน์

- การจดจำชื่อเฉพาะ: สกัดชื่อเฉพาะ เช่น บุคคล สถานที่ และองค์กร จากเอกสาร เพื่อช่วยในการจัดโครงสร้างข้อมูลที่ไม่มีรูปแบบ

- สรุปเนื้อหา: สรุปบทความหรือรายงานที่ยาวให้กระชับ ช่วยประหยัดเวลาในการอ่านของทีมคุณ

- Translation: แปลงข้อความจากภาษาหนึ่งเป็นอีกภาษาหนึ่งโดยอัตโนมัติ

📚 อ่านเพิ่มเติม:วิธีใช้ Hugging Face สำหรับการสรุปข้อความ

โมเดลภาษาขนาดใหญ่

บางครั้ง โครงการของคุณอาจต้องการมากกว่าการจำแนกประเภทหรือสรุปข้อมูลอย่างง่าย คุณอาจต้องการ AI ที่สามารถสร้างข้อความทางการตลาดที่สร้างสรรค์ เขียนโค้ด หรือตอบคำถามที่ซับซ้อนของผู้ใช้ในรูปแบบการสนทนา สำหรับสถานการณ์เหล่านี้ คุณอาจต้องหันมาใช้Large Language Model (LLM)

LLMs เป็นโมเดลที่มีพารามิเตอร์หลายพันล้านตัว ซึ่งได้รับการฝึกฝนจากข้อมูลและข้อความจำนวนมหาศาลจากอินเทอร์เน็ต การฝึกฝนอย่างกว้างขวางนี้ทำให้โมเดลสามารถ เข้าใจความหมายที่ละเอียดอ่อน บริบท และการให้เหตุผลที่ซับซ้อน ได้ โมเดล LLM แบบโอเพนซอร์สยอดนิยมที่มีอยู่บน Hugging Face ได้แก่ โมเดลจากตระกูล Llama, Mistral และ Falcon

การแลกเปลี่ยนสำหรับพลังนี้คือทรัพยากรการคำนวณที่สำคัญซึ่งพวกเขาต้องการ การนำโมเดลเหล่านี้ไปใช้เกือบจะจำเป็นต้องใช้ GPU ที่ทรงพลังพร้อมหน่วยความจำจำนวนมาก (VRAM)

เพื่อให้เข้าถึงได้มากขึ้น คุณสามารถใช้เทคนิคเช่นการควอนไทเซชัน ซึ่งลดขนาดของโมเดลโดยมีค่าใช้จ่ายเพียงเล็กน้อยในด้านประสิทธิภาพ ทำให้สามารถทำงานบนฮาร์ดแวร์ที่มีประสิทธิภาพน้อยลงได้

📚 อ่านเพิ่มเติม:ตัวแทน LLM ใน AI คืออะไรและทำงานอย่างไร?

โมเดลแปลงข้อความเป็นภาพและโมเดลหลายรูปแบบ

ข้อมูลของคุณไม่ได้เป็นเพียงข้อความเสมอไป ทีมของคุณอาจจำเป็นต้องสร้างภาพสำหรับแคมเปญการตลาด ถอดเสียงจากเสียงการประชุม หรือเข้าใจเนื้อหาของวิดีโอ นี่คือจุดที่โมเดลหลายรูปแบบ ซึ่งถูกออกแบบมาเพื่อทำงานกับข้อมูลประเภทต่างๆ กลายเป็นสิ่งจำเป็น

ประเภทของแบบจำลองมัลติโมดัลที่ได้รับความนิยมมากที่สุดคือแบบจำลองข้อความเป็นภาพ ซึ่งสร้างภาพจากคำอธิบายข้อความ แบบจำลองเช่นStable Diffusionใช้เทคนิคที่เรียกว่าการกระจายตัวเพื่อสร้างภาพที่น่าทึ่งจากคำสั่งที่เรียบง่าย แต่ความเป็นไปได้นั้นขยายไปไกลกว่าการสร้างภาพเพียงอย่างเดียว

โมเดลมัลติโมดัลทั่วไปอื่น ๆ ที่คุณสามารถนำไปใช้ได้จาก Hugging Face ได้แก่:

- คำบรรยายภาพ: สร้างข้อความบรรยายภาพโดยอัตโนมัติ ซึ่งเหมาะสำหรับการเข้าถึงและการจัดการเนื้อหา

- การรู้จำเสียงพูด: แปลงเสียงพูดเป็นข้อความที่เขียนด้วยโมเดลเช่นWhisper ของ OpenAI

- การตอบคำถามจากภาพ: ถามคำถามเกี่ยวกับภาพและรับคำตอบในรูปแบบข้อความ เช่น "รถในภาพนี้สีอะไร?"

เช่นเดียวกับ LLMs โมเดลเหล่านี้ต้องการการประมวลผลที่เข้มข้นและโดยทั่วไปจำเป็นต้องใช้ GPU เพื่อให้ทำงานได้อย่างมีประสิทธิภาพ

📚 อ่านเพิ่มเติม:คำสั่งสำหรับ AI เพื่อสร้างภาพที่น่าทึ่งกว่า 50 รายการ

เพื่อดูว่าโมเดล AI ประเภทต่าง ๆ เหล่านี้ถูกนำไปใช้ในธุรกิจจริงอย่างไร ชมภาพรวมกรณีศึกษาการใช้งาน AIในโลกจริงจากหลากหลายอุตสาหกรรมและฟังก์ชันต่าง ๆ

องค์กรของคุณมีความพร้อมด้าน AI อยู่ในระดับใด?

การสำรวจของเราซึ่งครอบคลุมผู้เชี่ยวชาญ 316 คน เปิดเผยว่าการเปลี่ยนแปลงด้วย AI อย่างแท้จริง ต้องการมากกว่าการนำคุณสมบัติของ AI มาใช้เพียงอย่างเดียว ทำแบบประเมินความพร้อมด้าน AI เพื่อดูว่าองค์กรของคุณอยู่ในระดับใด และสิ่งที่คุณสามารถทำได้เพื่อปรับปรุงคะแนนของคุณ

วิธีตั้งค่า Hugging Face สำหรับการปรับใช้ AI

ก่อนที่คุณจะสามารถปรับใช้โมเดลแรกของคุณได้ คุณจำเป็นต้องตั้งค่าสภาพแวดล้อมในเครื่องและบัญชี Hugging Face ให้ถูกต้องเสียก่อน นี่เป็นปัญหาที่พบได้บ่อยในทีมเมื่อสมาชิกแต่ละคนมีการตั้งค่าที่ไม่สอดคล้องกัน ส่งผลให้เกิดปัญหาคลาสสิกอย่าง "มันทำงานบนเครื่องของฉัน" การสละเวลาเพียงไม่กี่นาทีเพื่อทำให้กระบวนการนี้เป็นมาตรฐาน จะช่วยประหยัดเวลาในการแก้ไขปัญหาในภายหลังได้หลายชั่วโมง

- สร้างบัญชี Hugging Face และสร้างโทเค็นการเข้าถึง ก่อนอื่น ลงทะเบียนบัญชีฟรีบนเว็บไซต์ Hugging Face เมื่อคุณเข้าสู่ระบบแล้ว ให้ไปที่โปรไฟล์ของคุณ คลิก "การตั้งค่า" จากนั้นไปที่แท็บ "โทเค็นการเข้าถึง" สร้างโทเค็นใหม่ที่มีสิทธิ์อย่างน้อย "อ่าน" คุณจะต้องใช้โทเค็นนี้เพื่อดาวน์โหลดโมเดล

- ติดตั้งไลบรารี Python ที่จำเป็น เปิดเทอร์มินัลของคุณและติดตั้งไลบรารีหลักที่คุณจะต้องใช้ สองตัวที่สำคัญคือ transformers และ huggingface_hub คุณสามารถติดตั้งได้โดยใช้ pip: pip install transformers huggingface_hub

- กำหนดค่าการตรวจสอบสิทธิ์ เพื่อใช้โทเค็นการเข้าถึงของคุณ คุณสามารถเข้าสู่ระบบผ่านบรรทัดคำสั่งโดยรัน huggingface-cli login และวางโทเค็นของคุณเมื่อระบบขอ หรือคุณสามารถตั้งค่าเป็นตัวแปรสภาพแวดล้อมในระบบของคุณได้ การเข้าสู่ระบบผ่านบรรทัดคำสั่งมักเป็นวิธีที่ง่ายที่สุดในการเริ่มต้น

- ตรวจสอบการตั้งค่า วิธีที่ดีที่สุดในการยืนยันว่าทุกอย่างทำงานได้คือการรันโค้ดง่าย ๆ ลองโหลดโมเดลพื้นฐานโดยใช้ฟังก์ชัน pipeline จากไลบรารี transformers หากรันได้โดยไม่มีข้อผิดพลาด คุณก็พร้อมที่จะเริ่มใช้งานแล้ว

โปรดทราบว่าโมเดลบางตัวบน Hub เป็นแบบ "จำกัดการเข้าถึง" ซึ่งหมายความว่าคุณต้องยอมรับข้อกำหนดการใช้งานในหน้าของโมเดลนั้นก่อนจึงจะสามารถเข้าถึงโมเดลด้วยโทเค็นของคุณได้

นอกจากนี้ อย่าลืมว่าการติดตามว่าใครมีข้อมูลประจำตัวใดบ้างและการกำหนดค่าสภาพแวดล้อมใดที่กำลังใช้งานอยู่นั้นเป็นงานการจัดการโครงการในตัวเอง และจะยิ่งมีความสำคัญมากขึ้นเมื่อทีมของคุณเติบโตขึ้น

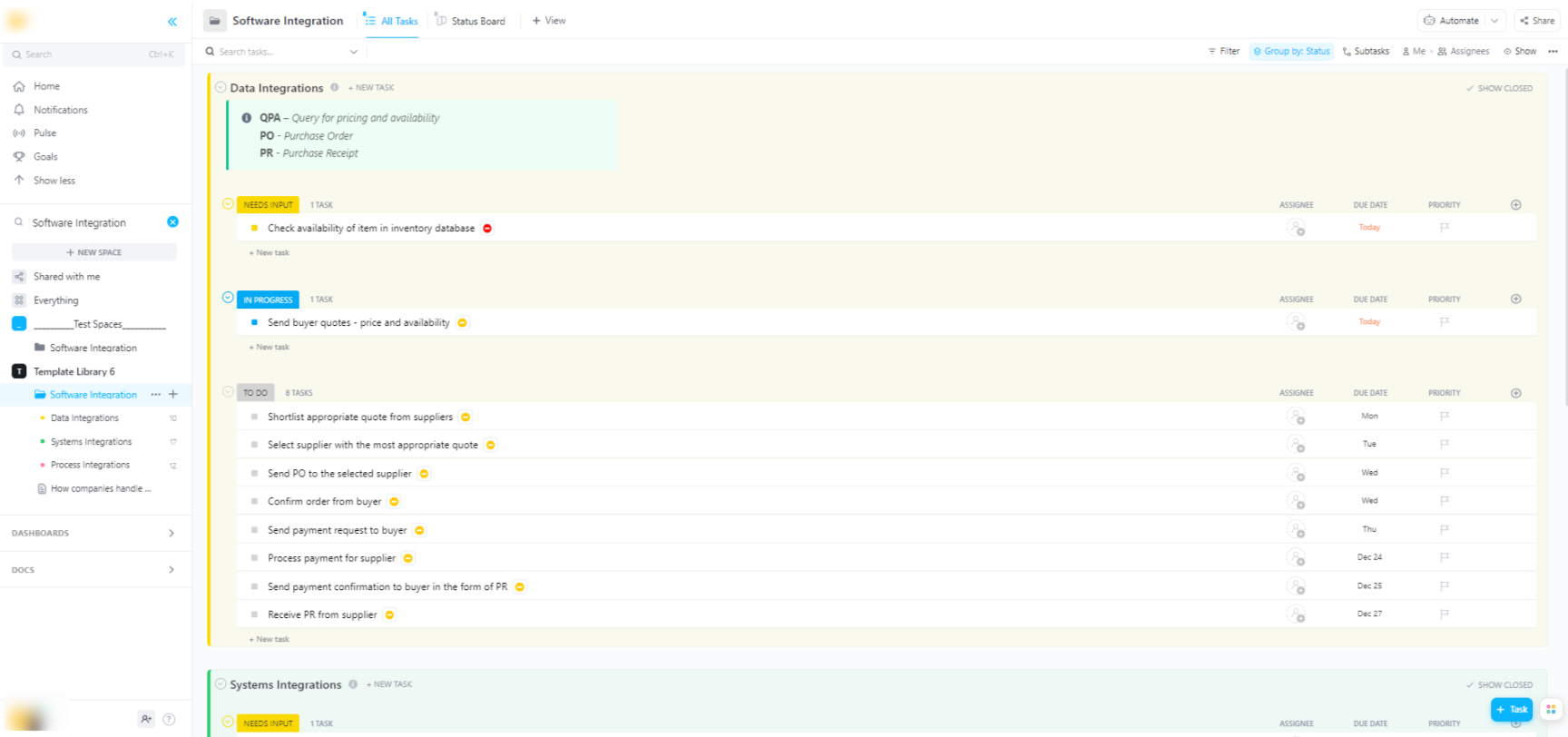

🌟 หากคุณกำลังผสานรวมโมเดล Hugging Face เข้ากับระบบซอฟต์แวร์ที่กว้างขึ้นแม่แบบการผสานรวมซอฟต์แวร์ของ ClickUpจะช่วยในการมองเห็นขั้นตอนการทำงานและติดตามการผสานรวมทางเทคนิคหลายขั้นตอน

เทมเพลตนี้มอบระบบที่ง่ายต่อการติดตามให้คุณ ซึ่งคุณสามารถทำได้:

- มองเห็นการเชื่อมโยงระหว่างโซลูชันซอฟต์แวร์ต่างๆ

- สร้างและมอบหมายงานให้กับสมาชิกในทีมเพื่อการร่วมมือที่ราบรื่นยิ่งขึ้น

- จัดระเบียบงานทั้งหมดที่เกี่ยวข้องกับการรวมระบบไว้ในที่เดียว

ตัวเลือกการนำไปใช้สำหรับแบบจำลอง Hugging Face

เมื่อคุณทดสอบโมเดลในเครื่องแล้ว คำถามต่อไปคือ: โมเดลนี้จะถูกนำไปใช้งานที่ไหน?การนำโมเดลไปใช้งานในสภาพแวดล้อมการผลิตซึ่งผู้อื่นสามารถใช้งานได้เป็นขั้นตอนสำคัญ แต่ตัวเลือกอาจมีหลายอย่างจนทำให้สับสนได้ การเลือกเส้นทางที่ไม่ถูกต้องอาจนำไปสู่ประสิทธิภาพที่ช้า ค่าใช้จ่ายสูง หรือไม่สามารถรองรับปริมาณการใช้งานของผู้ใช้ได้

การเลือกของคุณจะขึ้นอยู่กับความต้องการเฉพาะของคุณ เช่น ปริมาณการเข้าชมที่คาดไว้ งบประมาณ และว่าคุณกำลังสร้างต้นแบบอย่างรวดเร็วหรือแอปพลิเคชันที่สามารถปรับขนาดได้และพร้อมสำหรับการผลิต

การกอดพื้นที่ของเฟซ

หากคุณต้องการสร้างเดโมหรือเครื่องมือภายในอย่างรวดเร็ว Hugging Face Spaces มักจะเป็นตัวเลือกที่ดีที่สุด Spaces เป็นแพลตฟอร์มฟรีสำหรับโฮสต์แอปพลิเคชันการเรียนรู้ของเครื่อง และเหมาะอย่างยิ่งสำหรับการสร้างต้นแบบที่คุณสามารถแชร์กับทีมหรือผู้มีส่วนได้ส่วนเสียของคุณ

คุณสามารถสร้างส่วนติดต่อผู้ใช้ของแอปของคุณโดยใช้เฟรมเวิร์กยอดนิยมอย่าง Gradio หรือ Streamlit ซึ่งช่วยให้การสร้างเดโมแบบโต้ตอบเป็นเรื่องง่ายด้วยโค้ด Python เพียงไม่กี่บรรทัด

การสร้างพื้นที่นั้นง่ายเพียงแค่เลือก SDK ที่คุณต้องการ เชื่อมต่อ Git repository ที่มีโค้ดของคุณ และเลือกฮาร์ดแวร์ที่คุณต้องการ แม้ว่า Spaces จะมีระดับ CPU ฟรีสำหรับแอปพื้นฐาน แต่คุณสามารถอัปเกรดเป็นฮาร์ดแวร์ GPU แบบเสียค่าใช้จ่ายสำหรับโมเดลที่ต้องการประสิทธิภาพสูงขึ้นได้

โปรดคำนึงถึงข้อจำกัด:

- ไม่เหมาะสำหรับ API ที่มีปริมาณการใช้งานสูง: Spaces ถูกออกแบบมาสำหรับการสาธิตเท่านั้น ไม่เหมาะสำหรับการให้บริการคำขอ API พร้อมกันจำนวนมาก

- การเริ่มต้นใช้งานเมื่อเครื่องเย็น: หาก Space ของคุณไม่มีการใช้งาน อาจเข้าสู่โหมด "พักการทำงาน" เพื่อประหยัดทรัพยากร ซึ่งอาจทำให้เกิดความล่าช้าสำหรับผู้ใช้คนแรกที่เข้าถึง Space อีกครั้ง

- กระบวนการทำงานแบบ Git-based: โค้ดแอปพลิเคชันทั้งหมดของคุณจะถูกจัดการผ่านGit repository ซึ่งเหมาะอย่างยิ่งสำหรับการควบคุมเวอร์ชัน

Hugging Face Inference API

เมื่อคุณต้องการผสานรวมโมเดลเข้ากับแอปพลิเคชันที่มีอยู่แล้ว คุณอาจต้องการใช้ API. Hugging Face Inference API ช่วยให้คุณสามารถรันโมเดลได้โดยไม่ต้องจัดการกับโครงสร้างพื้นฐานที่อยู่เบื้องหลังเอง. คุณเพียงแค่ส่งคำขอ HTTP พร้อมข้อมูลของคุณ และรับการคาดการณ์กลับมา.

แนวทางนี้เหมาะอย่างยิ่งเมื่อคุณไม่ต้องการจัดการกับเซิร์ฟเวอร์ การปรับขนาด หรือการบำรุงรักษา Hugging Face มีสองระดับหลักสำหรับบริการนี้:

- API การอนุมานฟรี: นี่คือตัวเลือกโครงสร้างพื้นฐานแบบแชร์ที่มีข้อจำกัดด้านอัตรา เหมาะสำหรับการพัฒนาและการทดสอบ เหมาะอย่างยิ่งสำหรับกรณีการใช้งานที่มีปริมาณการใช้งานต่ำหรือเมื่อคุณเพิ่งเริ่มต้น

- จุดสิ้นสุดการอนุมาน: สำหรับการใช้งานในเชิงการผลิต คุณควรใช้จุดสิ้นสุดการอนุมาน (Inference Endpoints) ซึ่งเป็นบริการที่ต้องเสียค่าใช้จ่าย โดยบริการนี้จะมอบโครงสร้างพื้นฐานที่เฉพาะเจาะจงและสามารถปรับขนาดได้โดยอัตโนมัติ เพื่อให้มั่นใจว่าแอปพลิเคชันของคุณทำงานได้อย่างรวดเร็วและเชื่อถือได้ แม้ในสถานการณ์ที่มีการใช้งานหนัก

การใช้ API จำเป็นต้องส่งข้อมูล JSON ไปยัง URL ของจุดสิ้นสุดของโมเดล โดยใส่โทเค็นการยืนยันตัวตนของคุณไว้ในส่วนหัวของคำขอ

การปรับใช้แพลตฟอร์มคลาวด์

สำหรับทีมที่มีการใช้งานบนผู้ให้บริการคลาวด์รายใหญ่ เช่น Amazon Web Services (AWS), Google Cloud Platform (GCP) หรือ Microsoft Azure อยู่แล้ว การปรับใช้บนแพลตฟอร์มเหล่านี้อาจเป็นทางเลือกที่สมเหตุสมผลที่สุด วิธีการนี้ช่วยให้คุณควบคุมได้มากที่สุดและสามารถผสานรวมโมเดลเข้ากับบริการคลาวด์และโปรโตคอลความปลอดภัยที่มีอยู่เดิมของคุณได้อย่างราบรื่น

ขั้นตอนการทำงานทั่วไปเกี่ยวข้องกับการ "บรรจุ" โมเดลของคุณและสิ่งที่ต้องพึ่งพาโดยใช้ Docker จากนั้นจึงปรับใช้คอนเทนเนอร์นั้นกับบริการประมวลผลบนคลาวด์ ผู้ให้บริการคลาวด์แต่ละรายมีบริการและการผสานรวมที่ช่วยให้กระบวนการนี้ง่ายขึ้น:

- AWS SageMaker: มีการผสานรวมแบบเนทีฟสำหรับการฝึกฝนและปรับใช้โมเดล Hugging Face

- Google Cloud Vertex AI: ช่วยให้คุณปรับใช้โมเดลจาก Hub ไปยังจุดสิ้นสุดที่จัดการได้

- Azure Machine Learning: ให้เครื่องมือในการนำเข้าและให้บริการโมเดล Hugging Face

แม้ว่าวิธีนี้จะต้องการการตั้งค่าและความเชี่ยวชาญด้าน DevOps มากกว่า แต่ก็มักจะเป็นตัวเลือกที่ดีที่สุดสำหรับการปรับใช้ในระดับองค์กรขนาดใหญ่ที่ต้องการควบคุมสภาพแวดล้อมได้อย่างสมบูรณ์

📚 อ่านเพิ่มเติม:การทำงานอัตโนมัติ: อัตโนมัติการทำงานเพื่อเพิ่มผลผลิต

วิธีรันโมเดล Hugging Face สำหรับการอนุมาน

เมื่อใช้ Hugging Face สำหรับการPLOY AI, "การรันอินเฟอร์เรนซ์" คือกระบวนการที่ใช้แบบจำลองที่ผ่านการฝึกอบรมของคุณเพื่อทำนายข้อมูลใหม่ที่ไม่เคยเห็นมาก่อน นี่คือช่วงเวลาที่แบบจำลองของคุณทำหน้าที่ที่คุณPLOYมันไว้ การทำให้ขั้นตอนนี้ถูกต้องเป็นสิ่งสำคัญอย่างยิ่งสำหรับการสร้างแอปพลิเคชันที่ตอบสนองและมีประสิทธิภาพ

ความหงุดหงิดใจที่ใหญ่ที่สุดสำหรับทีมคือการเขียนโค้ดการอนุมานที่ช้าหรือไม่มีประสิทธิภาพ ซึ่งอาจนำไปสู่ประสบการณ์ผู้ใช้ที่ไม่ดีและต้นทุนการดำเนินงานที่สูง โชคดีที่ไลบรารี transformers มีหลายวิธีในการรันการอนุมาน แต่ละวิธีมีข้อดีข้อเสียระหว่างความเรียบง่ายและการควบคุม

- Pipeline API: นี่เป็นวิธีที่ง่ายที่สุดและเป็นที่นิยมมากที่สุดในการเริ่มต้น ฟังก์ชัน pipeline() จะช่วยซ่อนความซับซ้อนส่วนใหญ่ไว้ โดยจัดการการเตรียมข้อมูล การส่งต่อโมเดล และการประมวลผลหลังการคำนวณให้คุณ สำหรับงานมาตรฐานหลายอย่าง เช่นการวิเคราะห์ความรู้สึก คุณสามารถรับการคาดการณ์ได้ด้วยโค้ดเพียงบรรทัดเดียว

- AutoModel + AutoTokenizer: เมื่อคุณต้องการควบคุมกระบวนการอนุมานมากขึ้น คุณสามารถใช้คลาส AutoModel และ AutoTokenizer ได้โดยตรง วิธีนี้ช่วยให้คุณจัดการการแบ่งข้อความออกเป็นโทเค็นและการแปลงผลลัพธ์ดิบของโมเดลให้เป็นการคาดการณ์ที่มนุษย์อ่านได้อย่างละเอียดด้วยตนเอง วิธีนี้มีประโยชน์เมื่อคุณทำงานกับงานที่กำหนดเองหรือจำเป็นต้องใช้ตรรกะการประมวลผลก่อนหรือหลังเฉพาะ

- การประมวลผลแบบกลุ่ม: เพื่อเพิ่มประสิทธิภาพสูงสุด โดยเฉพาะบน GPU คุณควรประมวลผลข้อมูลเข้าเป็นกลุ่มแทนที่จะทำทีละรายการ การส่งข้อมูลเข้าเป็นกลุ่มผ่านโมเดลในครั้งเดียว (forward pass) จะเร็วกว่าการส่งทีละรายการอย่างมาก

การติดตามประสิทธิภาพของโค้ดการอนุมานของคุณเป็นส่วนสำคัญของวงจรการPLOYMENT การติดตามตัวชี้วัดเช่นความล่าช้า (ระยะเวลาที่ใช้ในการทำนาย) และปริมาณการประมวลผล (จำนวนการทำนายที่คุณสามารถทำได้ต่อวินาที) ต้องการการประสานงานและการจัดทำเอกสารที่ชัดเจน โดยเฉพาะอย่างยิ่งเมื่อสมาชิกทีมต่าง ๆ ทดลองใช้เวอร์ชันของแบบจำลองใหม่ ๆ

📚 อ่านเพิ่มเติม:เครื่องมือการทำงานร่วมกันของทีม AI ที่ดีที่สุดที่ควรใช้

ตัวอย่างทีละขั้นตอน: การปรับใช้โมเดล Hugging Face

มาดูตัวอย่างการปรับใช้โมเดลวิเคราะห์ความรู้สึกอย่างง่ายอย่างครบถ้วนกันเถอะ การทำตามขั้นตอนเหล่านี้จะพาคุณตั้งแต่การเลือกโมเดลไปจนถึงการมีจุดสิ้นสุดที่สามารถทดสอบและใช้งานได้จริง

- เลือกโมเดลของคุณ: ไปที่ Hugging Face Hub และใช้ตัวกรองทางด้านซ้ายเพื่อค้นหาโมเดลที่ทำงาน "การจำแนกประเภทข้อความ" จุดเริ่มต้นที่ดีคือ distilbert-base-uncased-finetuned-sst-2-english อ่านการ์ดโมเดลเพื่อทำความเข้าใจประสิทธิภาพและวิธีการใช้งาน

- ติดตั้งไลบรารีที่จำเป็น: ในสภาพแวดล้อม Python ของคุณ ให้ตรวจสอบให้แน่ใจว่าคุณได้ติดตั้งไลบรารีที่จำเป็นแล้ว สำหรับโมเดลนี้ คุณจะต้องใช้ transformers และ torch เท่านั้น รันคำสั่ง pip install transformers torch

- ทดสอบในเครื่อง: ก่อนนำไปใช้งานจริง ควรตรวจสอบให้แน่ใจว่าโมเดลทำงานได้ตามที่คาดหวังบนเครื่องของคุณเสมอ เขียนสคริปต์ Python ขนาดเล็กเพื่อโหลดโมเดลโดยใช้ pipeline และทดสอบกับประโยคตัวอย่าง เช่น: classifier = pipeline("sentiment-analysis", model="distilbert-base-uncased-finetuned-sst-2-english") ตามด้วย classifier("ClickUp is the best productivity platform!")

- สร้างการปรับใช้: สำหรับตัวอย่างนี้ เราจะใช้บริการ Hugging Face Spaces สำหรับการปรับใช้ที่รวดเร็วและง่ายดาย สร้าง Space ใหม่ เลือก Gradio SDK และสร้างไฟล์ app.py ที่โหลดโมเดลของคุณและกำหนดอินเทอร์เฟซ Gradio แบบง่ายเพื่อโต้ตอบกับมัน

- ตรวจสอบการปรับใช้: เมื่อ Space ของคุณทำงานแล้ว คุณสามารถใช้ส่วนติดต่อแบบโต้ตอบเพื่อทดสอบได้ คุณยังสามารถส่งคำขอ API โดยตรงไปยังจุดสิ้นสุดของ Space เพื่อรับการตอบกลับในรูปแบบ JSON เพื่อยืนยันว่ามันทำงานตามโปรแกรม

หลังจากขั้นตอนเหล่านี้ คุณจะมีโมเดลที่ใช้งานได้จริงแล้ว ขั้นตอนต่อไปของโครงการจะเกี่ยวข้องกับการติดตามการใช้งานการวางแผนสำหรับการอัปเดต และอาจขยายโครงสร้างพื้นฐานหากได้รับความนิยม

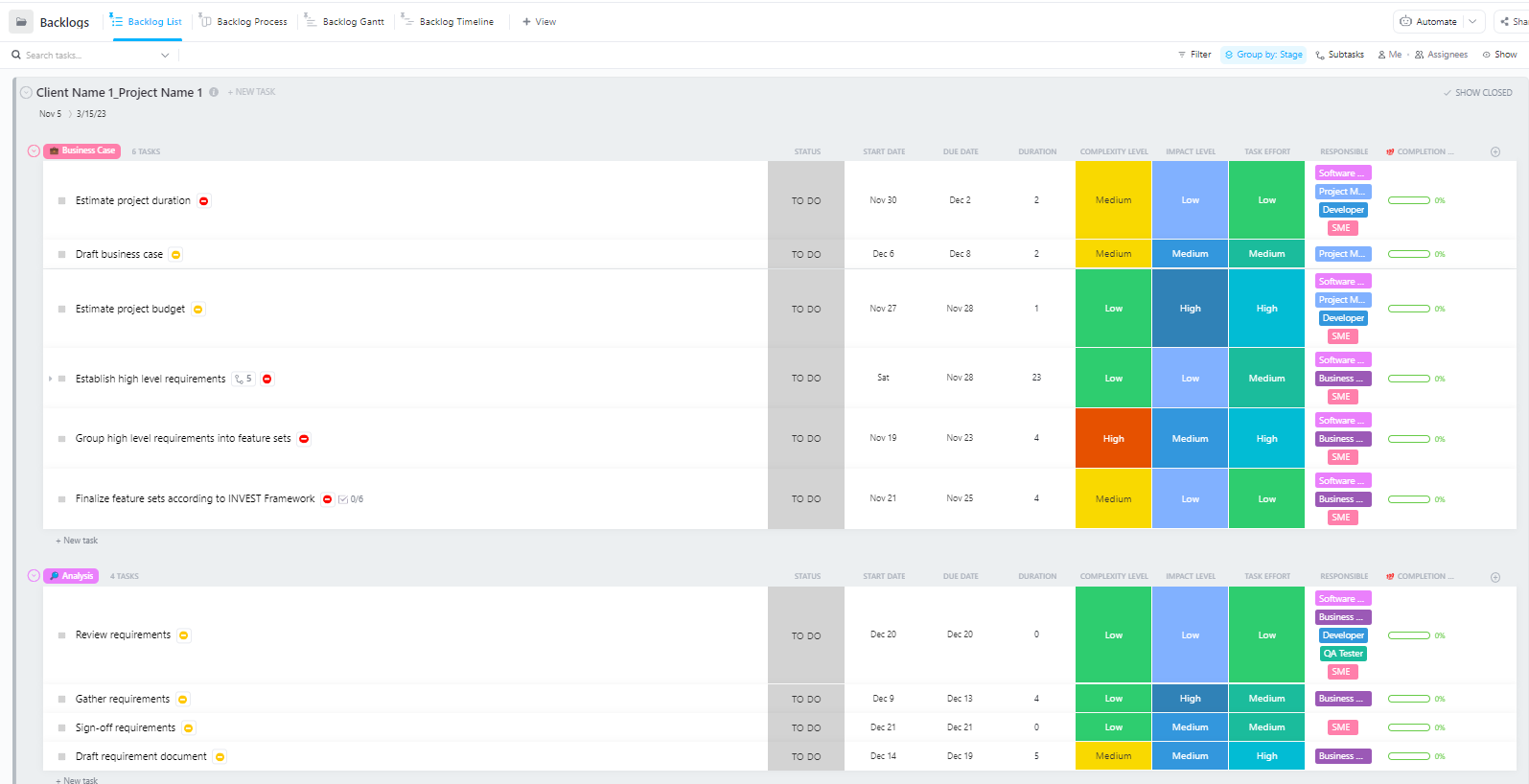

สำหรับทีมที่บริหารจัดการโครงการการปรับใช้ AI ที่ซับซ้อนซึ่งมีหลายขั้นตอน ตั้งแต่การเตรียมข้อมูลไปจนถึงการปรับใช้ในขั้นตอนการผลิตเทมเพลตการจัดการโครงการซอฟต์แวร์ขั้นสูงโดย ClickUpมอบโครงสร้างที่ครอบคลุม

เทมเพลตนี้ช่วยให้ทีม:

- จัดการโครงการที่มีหลายเป้าหมาย, งาน, ทรัพยากร, และการพึ่งพา

- สร้างภาพความคืบหน้าของโครงการด้วยแผนภูมิแกนต์และไทม์ไลน์

- ร่วมมือกับเพื่อนร่วมทีมอย่างราบรื่นเพื่อให้งานสำเร็จลุล่วง

ปัญหาทั่วไปในการปรับใช้ Hugging Face และวิธีแก้ไข

แม้จะมีแผนที่ชัดเจน คุณก็อาจเจออุปสรรคบางอย่างระหว่างการนำไปใช้งาน การจ้องมองข้อความแสดงข้อผิดพลาดที่เข้าใจยากอาจทำให้รู้สึกหงุดหงิดและหยุดความก้าวหน้าของทีมได้ นี่คือความท้าทายที่พบบ่อยที่สุดและวิธีแก้ไข 🛠️

🚨ปัญหา: "โมเดลต้องการการยืนยันตัวตน"

- สาเหตุ: คุณกำลังพยายามเข้าถึงโมเดลที่ "จำกัดการเข้าถึง" ซึ่งต้องยอมรับข้อกำหนดการใช้งานของมันก่อน

- วิธีแก้ไข: ไปที่หน้าของโมเดลบน Hub อ่านและยอมรับข้อตกลงการใช้งานใบอนุญาต ตรวจสอบให้แน่ใจว่าโทเค็นการเข้าถึงที่คุณใช้อยู่มีสิทธิ์ "อ่าน"

🚨ปัญหา: "CUDA หน่วยความจำไม่เพียงพอ"

- สาเหตุ: โมเดลที่คุณพยายามโหลดมีขนาดใหญ่เกินไปสำหรับหน่วยความจำของ GPU (VRAM)

- วิธีแก้ไข: วิธีแก้ไขที่รวดเร็วที่สุดคือการใช้รุ่นที่มีขนาดเล็กกว่าหรือรุ่นที่ถูกควอนไทซ์ คุณยังสามารถลองลดขนาดของชุดข้อมูลที่ใช้ในการอนุมานได้

🚨ปัญหา: "trust_remote_code error"

- สาเหตุ: โมเดลบางรุ่นบนฮับต้องใช้โค้ดที่กำหนดเองในการทำงาน และด้วยเหตุผลด้านความปลอดภัย ไลบรารีจะไม่ดำเนินการโค้ดดังกล่าวโดยอัตโนมัติ

- วิธีแก้ไข: คุณสามารถข้ามข้อจำกัดนี้ได้โดยเพิ่ม trust_remote_code=True เมื่อโหลดโมเดล อย่างไรก็ตาม คุณควรตรวจสอบซอร์สโค้ดก่อนเสมอเพื่อให้แน่ใจว่าปลอดภัย

🚨ปัญหา: "การไม่ตรงกันของตัวแยกโทเค็น"

- สาเหตุ: ตัวแยกโทเค็นที่คุณใช้ไม่ตรงกับตัวที่โมเดลถูกฝึกมา ทำให้เกิดข้อมูลนำเข้าที่ไม่ถูกต้องและประสิทธิภาพต่ำ

- วิธีแก้ไข: ควรโหลดตัวแยกโทเค็นจากจุดตรวจสอบโมเดลเดียวกันกับโมเดลเองเสมอ ตัวอย่างเช่น AutoTokenizer. from_pretrained("model-name")

🚨ปัญหา: "เกินขีดจำกัดอัตรา"

- สาเหตุ: คุณได้ส่งคำขอไปยัง Inference API ฟรีมากเกินไปในช่วงเวลาสั้น ๆ

- วิธีแก้ไข: สำหรับการใช้งานในเชิงการผลิต ให้อัปเกรดเป็น Inference Endpoint ที่เฉพาะเจาะจง สำหรับการพัฒนา คุณสามารถใช้การแคชเพื่อหลีกเลี่ยงการส่งคำขอซ้ำหลายครั้ง

การติดตามว่าวิธีแก้ปัญหาใดใช้ได้ผลกับปัญหาใดนั้นเป็นสิ่งสำคัญอย่างยิ่ง หากไม่มีศูนย์กลางสำหรับบันทึกข้อมูลเหล่านี้ ทีมต่างๆ มักจะแก้ปัญหาเดิมซ้ำแล้วซ้ำอีก

📮 ClickUp Insight: พนักงาน 1 ใน 4 คนใช้เครื่องมือสี่ตัวหรือมากกว่าเพื่อสร้างบริบทในการทำงาน รายละเอียดสำคัญอาจถูกฝังอยู่ในอีเมล ขยายความในกระทู้ Slack และบันทึกไว้ในเครื่องมือแยกต่างหาก ทำให้ทีมต้องเสียเวลาในการค้นหาข้อมูลแทนที่จะทำงานให้เสร็จ

ClickUp รวมเวิร์กโฟลว์ทั้งหมดของคุณไว้ในแพลตฟอร์มเดียว ด้วยฟีเจอร์ต่างๆ เช่น การจัดการโครงการผ่านอีเมล ClickUp, ClickUp Chat, ClickUp Docs และ ClickUp Brain ทุกอย่างจะเชื่อมต่อ ซิงค์ และเข้าถึงได้ทันที บอกลา "งานเกี่ยวกับงาน" และใช้เวลาที่มีประสิทธิภาพของคุณให้คุ้มค่า

💫 ผลลัพธ์ที่แท้จริง: ทีมสามารถกู้คืนเวลาได้มากกว่า 5 ชั่วโมงทุกสัปดาห์โดยใช้ ClickUp—นั่นคือมากกว่า 250 ชั่วโมงต่อปีต่อคน—โดยการกำจัดกระบวนการจัดการความรู้ที่ล้าสมัย ลองจินตนาการดูว่าทีมของคุณจะสามารถสร้างอะไรได้บ้างหากมีเวลาเพิ่มอีกหนึ่งสัปดาห์ในแต่ละไตรมาส!

วิธีจัดการโครงการการPLOYMENT AI ใน ClickUp

การใช้ Hugging Face สำหรับการPLOYMENTระบบ AI ช่วยให้การแพ็กเกจ, โฮสต์, และให้บริการโมเดลง่ายขึ้น—แต่ไม่ได้กำจัดภาระการประสานงานที่เกิดขึ้นจริงในPLOYMENTในโลกจริง ทีมงานยังต้องติดตามว่าโมเดลใดกำลังถูกทดสอบ, ปรับให้สอดคล้องกับการตั้งค่า, จัดทำเอกสารการตัดสินใจ, และให้ทุกคน—ตั้งแต่ ML Engineers ไปจนถึงทีมผลิตภัณฑ์และทีมปฏิบัติการ—อยู่ในหน้าเดียวกัน

เมื่อทีมวิศวกรรมของคุณกำลังทดสอบโมเดลต่างๆ ทีมผลิตภัณฑ์ของคุณกำลังกำหนดข้อกำหนด และผู้มีส่วนได้ส่วนเสียกำลังขอข้อมูลอัปเดต ข้อมูลต่างๆ จะกระจัดกระจายไปทั่ว Slack, อีเมล, สเปรดชีต และเอกสารต่างๆ

การขยายตัวของงาน—การแยกกิจกรรมการทำงานออกเป็นชิ้นส่วนผ่านเครื่องมือหลายอย่างที่เชื่อมต่อกันไม่ได้และไม่สื่อสารกัน—ก่อให้เกิดความสับสนและทำให้ทุกคนทำงานช้าลง

นี่คือจุดที่ ClickUp ซึ่งเป็นConverged AI Workspace แห่งแรกของโลก มีบทบาทสำคัญในการรวมการจัดการโครงการ เอกสาร และการสื่อสารของทีมไว้ในพื้นที่ทำงานเดียว

การบรรจบกันนี้มีคุณค่าอย่างยิ่งสำหรับโครงการนำ AI ไปใช้ ซึ่งผู้มีส่วนได้ส่วนเสียทั้งทางเทคนิคและไม่ใช่ทางเทคนิคต้องการการมองเห็นร่วมกันโดยไม่ต้องใช้เครื่องมือถึงห้าตัว

แทนที่จะกระจายการอัปเดตไปทั่วตั๋ว เอกสาร และกระทู้แชท ทีมงานสามารถจัดการวงจรการปรับใช้ทั้งหมดได้ในที่เดียว

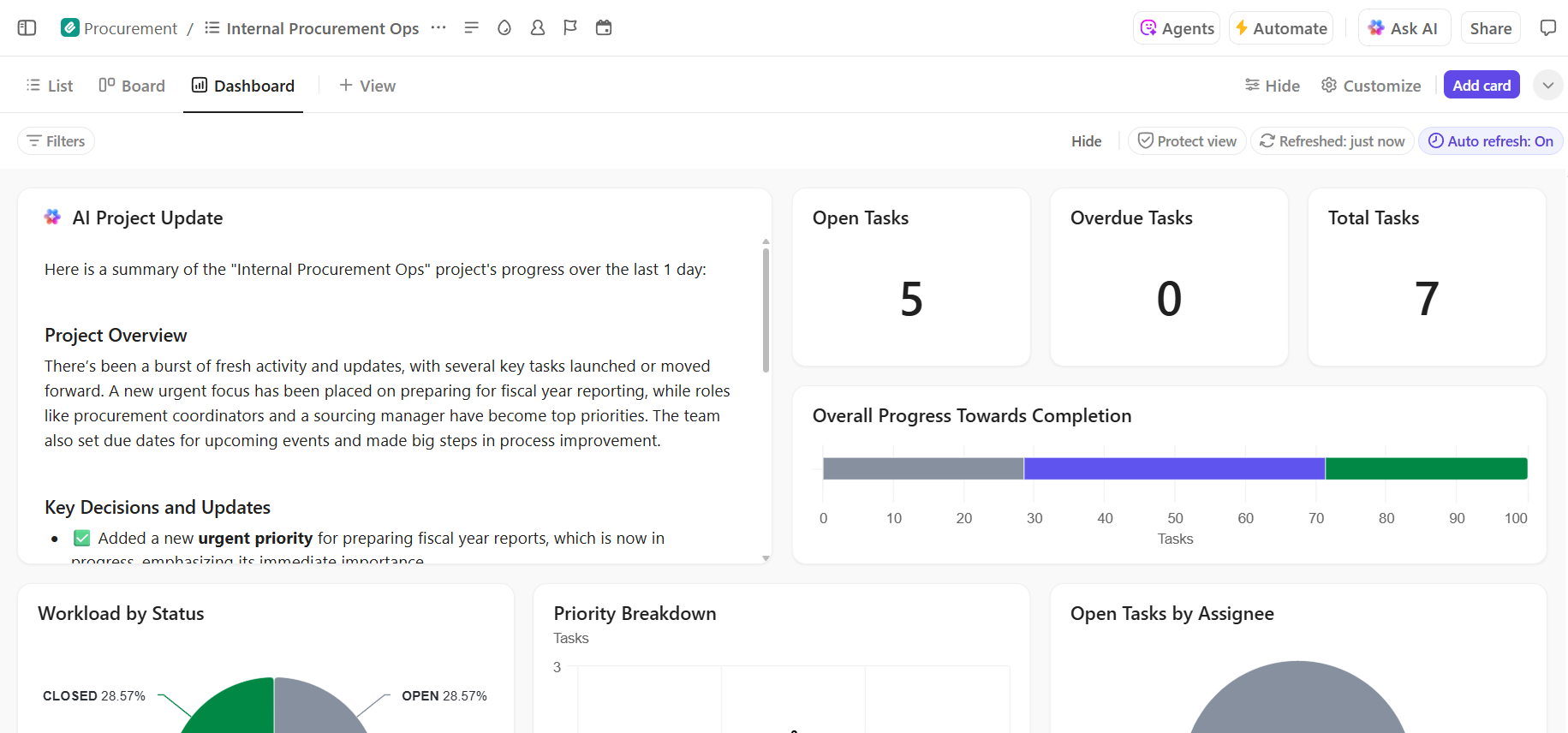

นี่คือวิธีที่ ClickUp สามารถสนับสนุนโครงการการปรับใช้ AI ของคุณ:

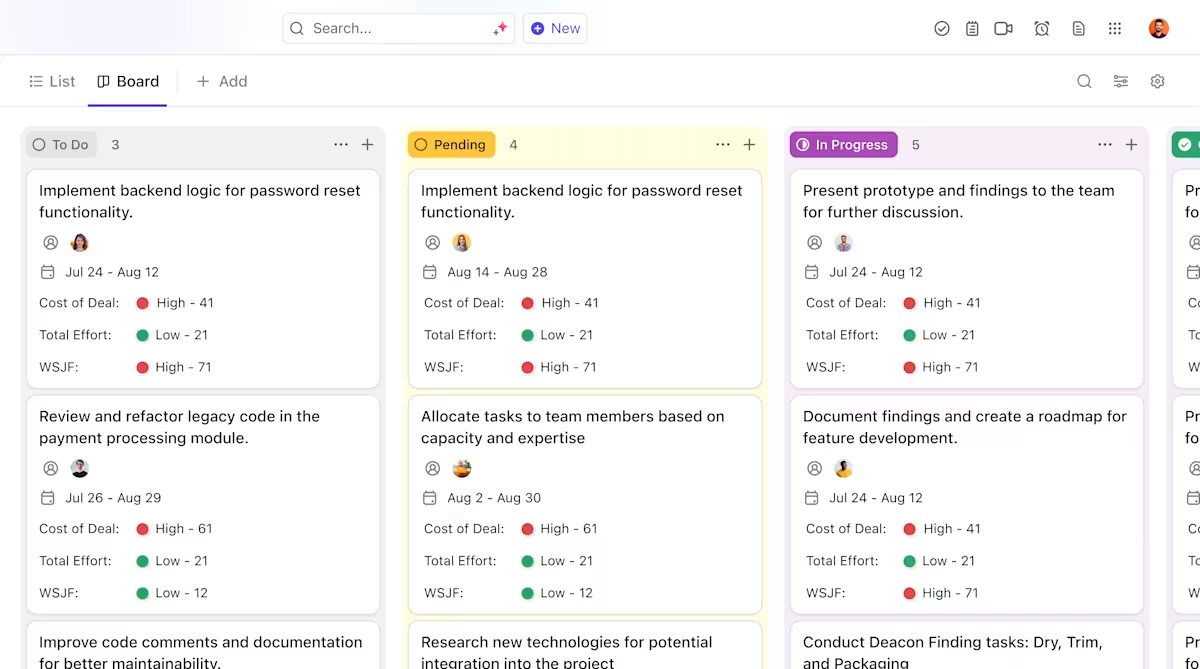

- ความเป็นเจ้าของที่ชัดเจนและการติดตามตลอดวงจรชีวิตของโมเดล: ใช้ClickUp Tasksเพื่อติดตามโมเดล Hugging Face ตั้งแต่การประเมินผล การทดสอบ การเตรียมการ และการผลิต พร้อมสถานะที่กำหนดเอง เจ้าของ และผู้ขัดขวางที่มองเห็นได้ทั่วทั้งทีม

- เอกสารการปรับใช้แบบรวมศูนย์และใช้งานได้จริง: จัดเก็บคู่มือการปรับใช้ การกำหนดค่าสภาพแวดล้อม และคู่มือการแก้ไขปัญหาไว้ในClickUp Docs เพื่อให้เอกสารพัฒนาไปพร้อมกับโมเดลของคุณและยังคงค้นหาและอ้างอิงได้ง่าย เนื่องจากเอกสารเชื่อมโยงกับงานต่างๆ เอกสารของคุณจึงอยู่เคียงข้างงานที่เกี่ยวข้องโดยตรง

- การทำงานร่วมกันในบริบทเดียวกันโดยไม่ทำให้งานกระจาย: รักษาการสนทนา การตัดสินใจ และการอัปเดตให้เชื่อมโยงโดยตรงกับงานและเอกสาร ลดการพึ่งพาเธรด Slack ที่กระจัดกระจาย อีเมล และเครื่องมือโครงการที่ไม่เชื่อมโยงกัน

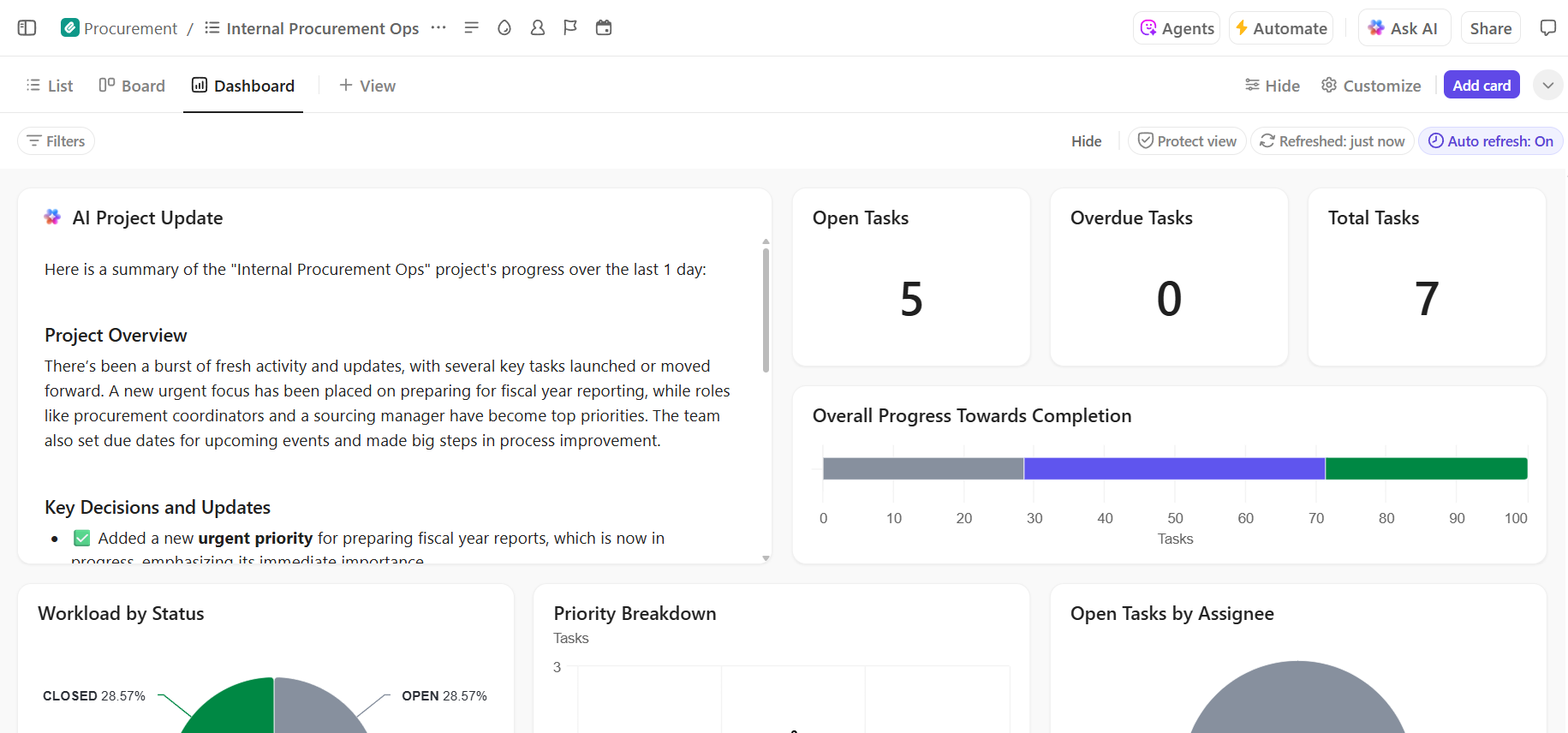

- การมองเห็นแบบครบวงจรในความคืบหน้าของการปรับใช้: ตรวจสอบกระบวนการปรับใช้, ระบุความเสี่ยงตั้งแต่เนิ่นๆ และปรับสมดุลความสามารถของทีมโดยใช้แดชบอร์ด ClickUpที่แสดงความคืบหน้าและจุดติดขัดแบบเรียลไทม์

- การเริ่มต้นใช้งานและการเรียกคืนการตัดสินใจที่รวดเร็วขึ้นด้วย AI ในตัว: ใช้ClickUp Brainเพื่อสรุปเอกสารการปรับใช้ที่ยาว, แสดงข้อมูลเชิงลึกที่เกี่ยวข้องจากการปรับใช้ในอดีต, และช่วยให้สมาชิกใหม่ของทีมเข้าใจงานได้อย่างรวดเร็วโดยไม่ต้องค้นหาข้อมูลในอดีต

📚 อ่านเพิ่มเติม:วิธีทำให้กระบวนการทำงานเป็นอัตโนมัติด้วย AI เพื่อเวิร์กโฟลว์ที่รวดเร็วและชาญฉลาดยิ่งขึ้น

จัดการโครงการการปรับใช้ AI ของคุณอย่างไร้รอยต่อใน ClickUp

การปรับใช้ Hugging Face ที่ประสบความสำเร็จขึ้นอยู่กับการมีพื้นฐานทางเทคนิคที่มั่นคงและการจัดการโครงการที่ชัดเจนและเป็นระบบ แม้ว่าความท้าทายทางเทคนิคจะสามารถแก้ไขได้ แต่บ่อยครั้งที่การประสานงานและการสื่อสารที่ไม่ดีเป็นสาเหตุที่ทำให้โครงการล้มเหลว

ด้วยการกำหนดขั้นตอนการทำงานที่ชัดเจนในแพลตฟอร์มเดียว ทีมงานของคุณจะสามารถส่งมอบงานได้เร็วขึ้นและหลีกเลี่ยงความยุ่งยากจากการสลับบริบท— เมื่อทีมต้องเสียเวลาหลายชั่วโมงไปกับการค้นหาข้อมูล การสลับระหว่างแอปพลิเคชัน และการอัปเดตข้อมูลซ้ำในหลายแพลตฟอร์ม

ClickUp แอปเดียวสำหรับทุกงานในที่เดียวรวบรวมการจัดการโครงการ เอกสาร และการสื่อสารของทีมไว้ในที่เดียว เพื่อให้คุณมีแหล่งข้อมูลที่ถูกต้องเพียงแหล่งเดียวสำหรับวงจรการใช้งาน AI ของคุณทั้งหมด

รวบรวมโครงการการใช้งาน AI ของคุณให้เป็นหนึ่งเดียวและขจัดความสับสนจากเครื่องมือต่างๆเริ่มต้นฟรีกับ ClickUpวันนี้

คำถามที่พบบ่อย (FAQ)

ใช่ Hugging Face มีบริการฟรีที่ครอบคลุมมาก ซึ่งรวมถึงการเข้าถึง Model Hub, Spaces ที่ใช้ CPU สำหรับการสาธิต และ Inference API ที่มีข้อจำกัดด้านอัตราสำหรับการทดสอบ สำหรับความต้องการในการผลิตที่ต้องการฮาร์ดแวร์เฉพาะหรือข้อจำกัดที่สูงกว่า มีแผนชำระเงินให้เลือก

Spaces ได้รับการออกแบบมาเพื่อรองรับแอปพลิเคชันเชิงโต้ตอบที่มีส่วนติดต่อผู้ใช้แบบกราฟิก ทำให้เหมาะสำหรับการสาธิตและเครื่องมือภายในองค์กร Inference API มอบการเข้าถึงโมเดลผ่านโปรแกรม ช่วยให้คุณสามารถผสานโมเดลเข้ากับแอปพลิเคชันของคุณได้อย่างง่ายดายด้วยคำขอ HTTP เพียงไม่กี่ขั้นตอน

แน่นอน ผ่านการสาธิตแบบโต้ตอบที่จัดขึ้นบน Hugging Face Spaces สมาชิกในทีมที่ไม่มีความเชี่ยวชาญทางเทคนิคสามารถทดลองใช้และให้ข้อเสนอแนะเกี่ยวกับโมเดลได้โดยไม่ต้องเขียนโค้ดแม้แต่บรรทัดเดียว

ข้อจำกัดหลักของแพ็กเกจฟรีคือขีดจำกัดอัตราการใช้งานของ Inference API, การใช้ฮาร์ดแวร์ CPU ร่วมกันสำหรับ Spaces ซึ่งอาจทำให้ช้าลง, และ "cold starts" ที่แอปไม่ใช้งานต้องใช้เวลาสักครู่เพื่อตื่นขึ้นมาทำงาน