Quando sua equipe passa horas escrevendo prompts, ajustando modelos e montando pipelines de dados apenas para implantar um agente de IA, a produtividade fica paralisada.

A Databricks introduziu o Agent Bricks para resolver esse gargalo, automatizando todo o fluxo de trabalho de construção e otimização dos dados empresariais.

Este guia mostra o que ela oferece, como funciona e se ela se encaixa na sua pilha.

Principais conclusões

- O Databricks Agent Bricks automatiza a criação de agentes usando dados sintéticos e benchmarks.

- Ela elimina o ajuste manual de prompts e se integra diretamente ao Unity Catalog.

- Os primeiros usuários relatam altos custos de otimização, mas um forte desempenho em escala.

- O acesso regional e a personalização limitada continuam sendo os principais riscos durante a fase beta.

A Databricks oferece IA agênica?

Sim, a Databricks lançou o Agent Bricks em 11 de junho de 2025 em sua Data+AI Summit em São Francisco.

A plataforma automatiza a criação de agentes de IA gerando dados sintéticos específicos do domínio e benchmarks sensíveis às tarefas e, em seguida, otimizando modelos em termos de custo e qualidade sem a necessidade de engenharia manual.

Desenvolvido com base na aquisição da MosaicML pela Databricks em 2023, o produto posiciona a Databricks como fornecedora de data lakehouse e plataforma de IA agênica.

Ela é voltada para equipes que gerenciam grandes volumes de documentos internos, registros transacionais ou conteúdo não estruturado e precisam de agentes que possam extrair insights, responder a perguntas ou coordenar fluxos de trabalho de várias etapas com segurança.

O Agent Bricks entrou em beta público em meados de 2025, inicialmente disponível na AWS em regiões dos EUA, com expansão planejada para a Europa até o final do ano.

Como ela realmente funciona?

O Agent Bricks reduz o ciclo tradicional de tentativa e erro a um pipeline guiado. Você descreve a tarefa em linguagem simples, conecta suas fontes de dados por meio do Unity Catalog e o sistema gera automaticamente exemplos de treinamento sintéticos que refletem seu domínio.

Esses exemplos alimentam um conjunto de benchmarks que pontua os modelos candidatos em termos de precisão, latência e custo. A plataforma então seleciona a configuração que atinge seu padrão de qualidade com o menor preço por inferência.

Esse fluxo de trabalho elimina as semanas que as equipes normalmente gastam rotulando dados, ajustando prompts e executando testes A/B.

Nos bastidores, o MLflow 3.0 registra todas as avaliações realizadas, para que você possa rastrear as decisões do modelo até os dados e parâmetros subjacentes. A segurança permanece intacta porque os agentes nunca extraem dados fora do perímetro do Databricks Lakehouse.

Essa visão geral da arquitetura é mais importante quando você vê que ela resolve um problema real.

Como isso funciona na prática?

A equipe de dados da AstraZeneca enfrentou um acúmulo de 400.000 PDFs de ensaios clínicos que precisavam de extração estruturada para registros regulatórios. A revisão manual levaria meses.

Eles configuraram um agente de extração de informações no Agent Bricks, apontaram-no para o repositório de documentos e deixaram o sistema gerar amostras sintéticas com base em esquemas de protocolo de teste. O agente analisou todos os 400.000 arquivos em menos de 60 minutos, sem código.

- A equipe identifica o gargalo na extração de dados e o prazo regulatório.

- Conecta o Agent Bricks ao lago de documentos interno por meio do Unity Catalog.

- A plataforma executa otimização, gerando benchmarks específicos para cada tarefa e selecionando um modelo ajustado.

- Implante o agente na produção, reduzindo semanas de trabalho manual para menos de uma hora.

A Hawaiian Electric obteve ganhos semelhantes quando substituiu uma solução frágil baseada em LangChain pelo Agent Bricks para consultas de documentos jurídicos.

O novo agente superou significativamente a ferramenta original em precisão de respostas, tanto em avaliações automatizadas quanto humanas, dando aos funcionários confiança para utilizá-lo em pesquisas de conformidade.

Integração e adequação ao ecossistema

O Agent Bricks herda a camada de integração da Databricks, portanto, ele se conecta diretamente às plataformas que suas equipes de dados e ML já utilizam.

O Unity Catalog atua como um hub central de governança, gerenciando o acesso a data lakes, armazéns e lojas vetoriais em uma única estrutura de políticas.

Os agentes consultam tabelas Delta, arquivos Parquet ou documentos armazenados no lakehouse sem copiar dados para serviços externos.

| Plataforma/Parceiro | Natureza da integração |

|---|---|

| Catálogo Unity | Governança unificada para dados, modelos e resultados do agente |

| Neon | Postgres sem servidor para fluxos de trabalho transacionais de agentes |

| Tecton | Serviço de recursos em tempo real com latência inferior a 100 ms |

| OpenAI | Acesso nativo ao GPT-5 em dados empresariais |

Os desenvolvedores interagem com o Agent Bricks por meio de APIs e SDKs padrão da Databricks. A função SQL ai_query permite que os analistas chamem LLMs diretamente nas consultas, e os endpoints REST atendem aos agentes por meio da infraestrutura Model Serving.

As integrações IDE oferecem suporte a pipelines de CI/CD, para que os engenheiros possam controlar as versões das configurações do agente juntamente com o código do aplicativo.

A próxima aquisição da Tecton incorporará uma loja de recursos online ao Agent Bricks, fornecendo dados de streaming aos agentes com latência inferior a 10 ms.

Essa capacidade permite a detecção de fraudes, personalização e outros casos de uso que dependem de informações atualizadas a cada segundo.

Por enquanto, as equipes podem criar protótipos com recursos em lote e planejar a troca de dados em tempo real assim que a integração entrar em operação, em meados de 2026.

Comentários da comunidade e opinião dos primeiros usuários

Os primeiros comentários dividem-se entre o entusiasmo pela facilidade de uso e a cautela em relação às limitações da versão beta.

Um usuário do Reddit elogiou o criador de agentes sem código e a integração perfeita com o Unity Catalog, observando que os agentes herdam automaticamente as permissões de dados.

O mesmo usuário sinalizou que uma execução completa da otimização normalmente leva mais de uma hora e custa mais de US$ 100 em computação, o que pode aumentar os custos durante a experimentação.

- “Simplifica significativamente nosso fluxo de trabalho e reduz o ajuste manual.” Reddit

- “O custo por execução de otimização pode ser alto na versão beta.” Reddit

- “O acesso seguro ao conteúdo interno gera confiança na plataforma.” Comunidade Databricks

A disponibilidade regional criou atrito para as equipes europeias. Um representante de contas da Databricks confirmou em meados de 2025 que o Agent Bricks estava disponível apenas nos EUA durante a prévia inicial, levando alguns clientes a criar espaços de trabalho sandbox nas regiões dos EUA para testar o produto.

As publicações no fórum também mencionam a instabilidade da versão prévia e as frequentes alterações nas funcionalidades, o que é típico do software beta, mas vale a pena planear com antecedência se o seu caso de uso exigir um tempo de atividade elevado.

No geral, os primeiros usuários que conseguem absorver as peculiaridades da versão beta e calcular os custos reconhecem o valor da automação oferecida pelo Agent Bricks. A análise de 400.000 documentos da AstraZeneca e os ganhos de precisão da Hawaiian Electric ressoam em toda a comunidade como prova de que a plataforma pode lidar com tarefas em escala de produção.

Essa validação do mundo real é importante quando você está decidindo se deve investir tempo de engenharia agora ou esperar que o produto amadureça.

Roteiro e perspectivas do ecossistema

A Databricks está expandindo o Agent Bricks geograficamente e funcionalmente nos próximos 18 meses. Até o quarto trimestre de 2025, a prévia será lançada nas regiões europeias, começando com implantações do Azure na Europa Ocidental.

Essa implementação gradual permite que a empresa colete diversos feedbacks dos usuários e garanta a conformidade com as regulamentações regionais de dados antes de declarar a disponibilidade geral.

A integração do Tecton em meados de 2026 permitirá que os agentes extraiam recursos em tempo real de fluxos, APIs e armazéns com 99,99% de tempo de atividade, possibilitando casos de uso de detecção de fraudes e personalização que exigem dados atualizados a cada segundo.

O Neon e o Mooncake se fundirão em uma experiência unificada de “Lakehouse DB”, oferecendo aos agentes gravações em conformidade com ACID e leituras analíticas instantâneas sem pipelines ETL.

“O Agent Bricks sinaliza uma grande mudança na IA empresarial”, observou um analista da VentureBeat, apontando para ganhos de desempenho de 10 a 100 vezes maiores com a eliminação dos pipelines de dados tradicionais.

Espere novos modelos de agentes além dos quatro tipos iniciais (Extração de Informações, Assistente de Conhecimento, Supervisor Multiagente, Agente LLM Personalizado).

A pesquisa da Databricks está explorando assistentes de código, agentes de planejamento e conectores para APIs externas. A parceria com a OpenAI garante que, à medida que a OpenAI lança o GPT-5 e modelos futuros, eles estarão disponíveis nativamente no Agent Bricks com suporte e governança próprios.

A longo prazo, a Databricks prevê a IA agênica como uma nova persona de usuário na plataforma, ao lado de engenheiros e analistas de dados. Essa visão inclui investimento contínuo em recursos de IA responsável, como logs de auditoria, detecção de viés e controles de política refinados, à medida que a adoção de agentes cresce em setores regulamentados.

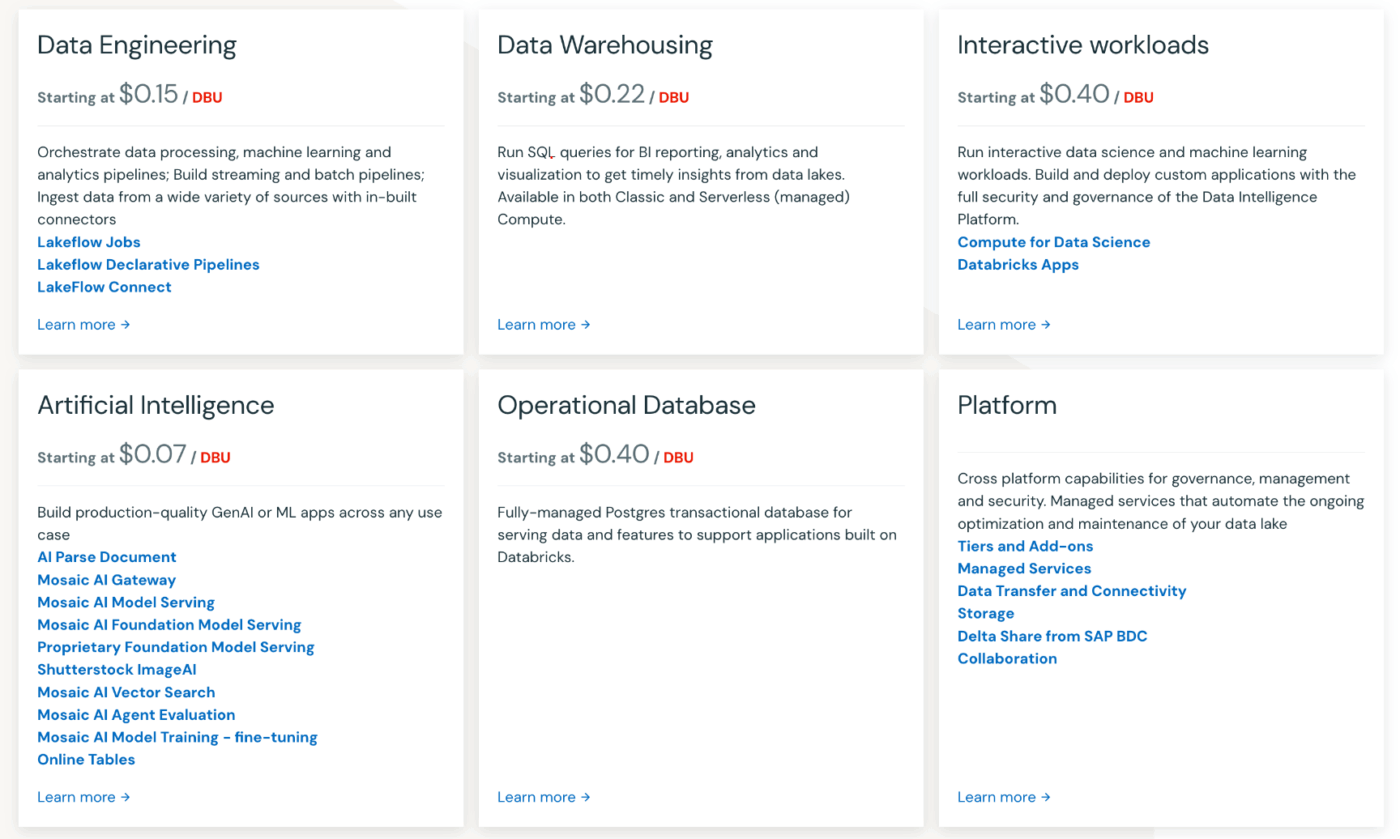

Quanto custa a IA agênica da Databricks?

O Agent Bricks segue o modelo de preços baseado no uso da Databricks, sem taxa de licença inicial. Você paga por segundo de computação e inferência de modelo, cobrado em Unidades Databricks (DBUs).

As cargas de trabalho de Model Serving e Feature Serving custam cerca de US$ 0,07 por DBU-segundo no plano Premium, que inclui o custo da instância de nuvem subjacente. A inferência acelerada por GPU para modelos básicos também custa cerca de US$ 0,07 por DBU-segundo.

A parte mais intensa é a execução inicial da otimização. Um dos primeiros usuários relatou ter gasto mais de US$ 100 em computação em nuvem para um único ciclo de treinamento de uma hora que gerou dados sintéticos e ajustou o agente.

Após a otimização, o serviço do agente se torna muito mais barato, pois o sistema identificou uma configuração de modelo econômica que mantém a qualidade com menos tokens por consulta. As equipes podem definir limites de orçamento por meio da política de orçamento da Databricks para limitar os gastos durante a experimentação.

Os clientes empresariais podem adquirir pacotes de compromisso (horas DBU pré-pagas) para garantir descontos por volume, reduzindo efetivamente a taxa por segundo em comparação com o faturamento sob demanda. O preço exato varia de acordo com o seu provedor de nuvem (AWS, Azure, GCP) e região, com algumas regiões apresentando preços ligeiramente mais altos do que o leste ou oeste dos EUA.

Os custos ocultos a serem observados incluem computação para pesquisa vetorial, ingestão de dados e retreinamento periódico à medida que sua distribuição de dados muda. Leve em consideração o tempo de engenharia economizado ao pular o ajuste manual de prompts e a rotulagem de dados ao calcular o custo total de propriedade.

Os primeiros usuários relatam que as semanas de trabalho manual que o Agent Bricks elimina muitas vezes compensam os custos de computação, especialmente quando se considera o custo de oportunidade da implantação atrasada do agente.