Повечето проекти за внедряване на AI се провалят не защото екипите са избрали грешен модел, а защото три месеца по-късно никой не може да си спомни защо са го избрали или как да възпроизведат настройките, като 46% от AI проектите се отхвърлят между доказателството на концепцията и широкото внедряване.

Това ръководство ви води през използването на Hugging Face за внедряване на изкуствен интелект – от избора и тестването на модели до управлението на процеса на внедряване – така че вашият екип да може да работи по-бързо, без да губи важни решения в Slack нишки и разпръснати таблици.

Какво е Hugging Face?

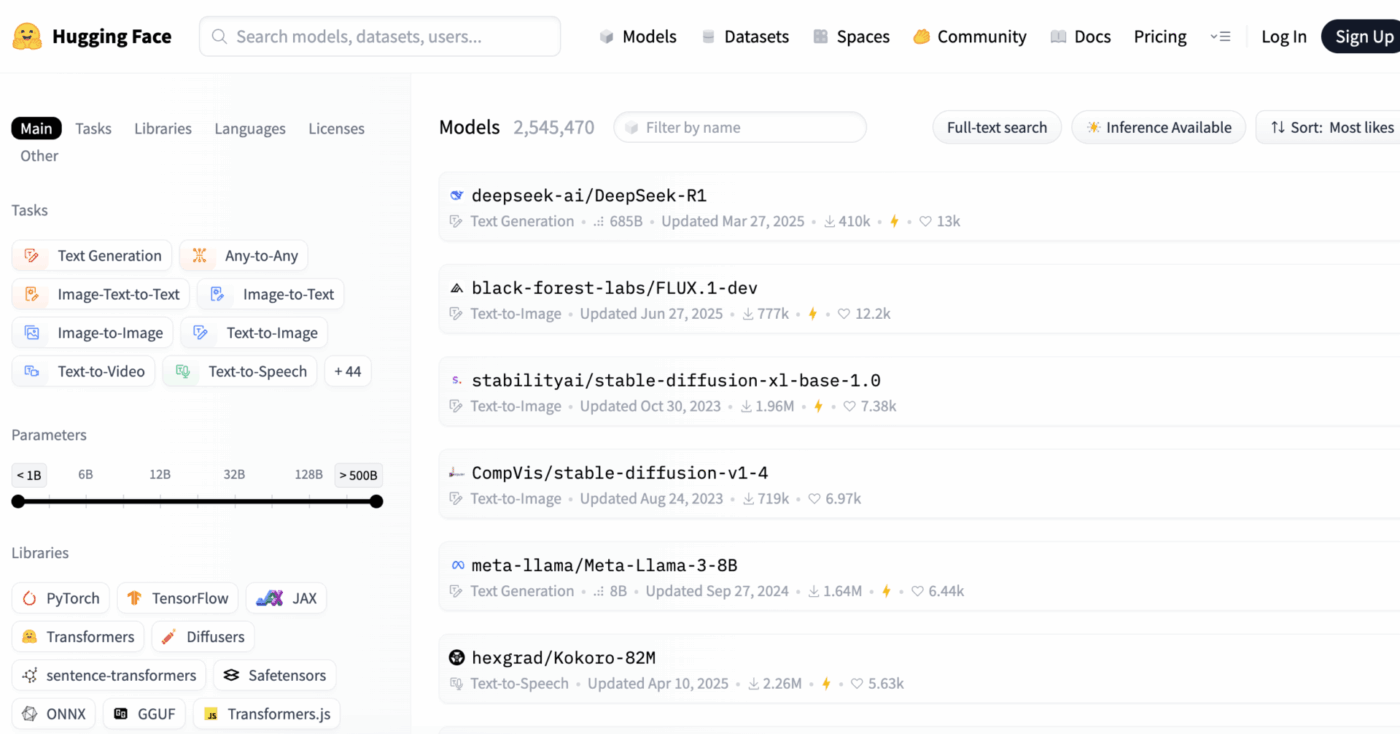

Hugging Face е отворена платформа и общностен център, който предоставя предварително обучени AI модели, набори от данни и инструменти за създаване и внедряване на приложения за машинно обучение.

Представете си го като огромна цифрова библиотека, в която можете да намерите готови за употреба AI модели, вместо да губите месеци и значителни ресурси за създаването им от нулата.

Той е предназначен за инженери по машинно обучение и научни работници в областта на данните, но неговите инструменти все по-често се използват от мултифункционални екипи по продукти, дизайн и инженеринг за интегриране на AI в работните им процеси.

Знаете ли, че: 63% от организациите нямат подходящи практики за управление на данни за изкуствен интелект. Това често води до забавяне на проекти и загуба на ресурси.

Основното предизвикателство за много екипи е огромната сложност на внедряването на AI. Процесът включва избор на подходящия модел от хиляди опции, управление на основната инфраструктура, версиониране на експерименти и осигуряване на съгласуваност между техническите и нетехническите заинтересовани страни.

Hugging Face опростява този процес, като предоставя Model Hub – централно хранилище с над 2 милиона модели. Библиотеката с трансформатори на платформата е ключът, който отключва тези модели, позволявайки ви да ги зареждате и използвате само с няколко реда Python код.

Въпреки това, дори и с тези мощни инструменти, внедряването на изкуствен интелект остава предизвикателство за управлението на проекти, което изисква внимателно проследяване на избора, тестването и внедряването на модели, за да се гарантира успехът.

📮ClickUp Insight: 92% от специалистите рискуват да загубят важни решения, разпръснати в чатове, имейли и таблици. Без унифицирана система за записване и проследяване на решения, критични бизнес прозрения се губят в цифровия шум.

С функциите за управление на задачи на ClickUp никога няма да се налага да се притеснявате за това. Създавайте задачи от чат, коментари към задачи, документи и имейли с едно кликване!

📚 Прочетете също: Най-добрите алтернативи на Hugging Face за LLM, NLP и AI работни потоци

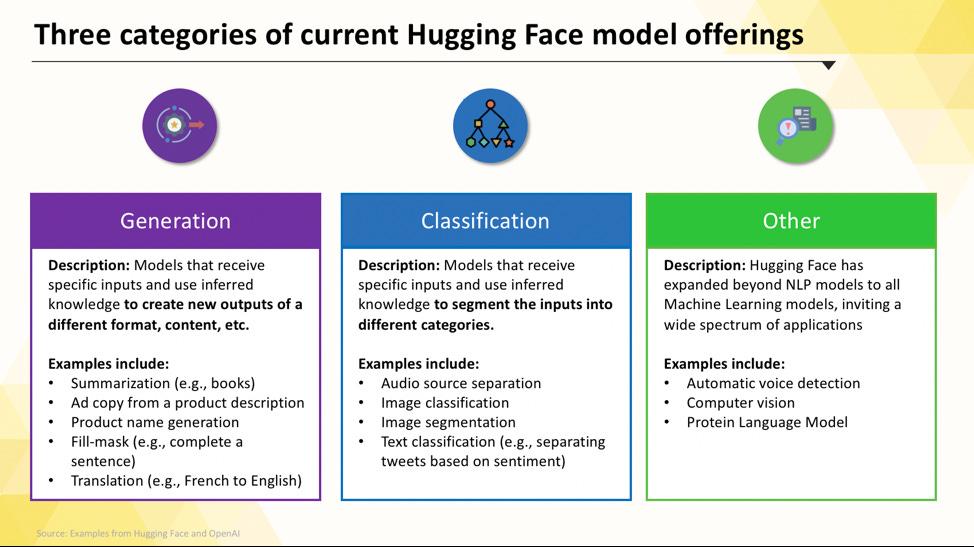

Модели на Hugging Face, които можете да внедрите

Навигацията в Hugging Face Hub може да ви се стори трудна, когато започвате за първи път. С стотици хиляди модели, ключът е да разберете основните категории, за да намерите подходящата за вашия проект. Моделите варират от малки, ефективни опции, предназначени за една цел, до масивни модели за общо предназначение, които могат да се справят със сложни разсъждения.

Езикови модели за конкретни задачи

Когато вашият екип трябва да реши един-единствен, добре дефиниран проблем, често не се нуждаете от масивен модел за общо предназначение. Времето и разходите за изпълнение на такъв модел могат да бъдат непосилни, особено когато по-малък, по-фокусиран AI инструмент би работил по-добре. Тук на помощ идват моделите, специфични за дадена задача.

Това са модели, които са обучени и оптимизирани за една конкретна функция. Тъй като са специализирани, те обикновено са по-малки, по-бързи и по-ефективни от гледна точка на ресурсите в сравнение с по-големите си колеги.

Това ги прави идеални за производствени среди, където скоростта и цената са важни фактори. Много от тях могат да работят дори на стандартен CPU хардуер, което ги прави достъпни без скъпи GPU.

Общите типове модели, специфични за задачи, включват:

- Класификация на текст: Използвайте това, за да категоризирате текст в предварително дефинирани етикети, като например сортиране на обратната връзка от клиенти в „положителни“ или „отрицателни“ групи или маркиране на билетите за поддръжка по тема.

- Анализ на настроенията: Това ви помага да определите емоционалния тон на даден текст, което е полезно за наблюдение на марката в социалните медии.

- Разпознаване на именовани обекти: Извличайте конкретни обекти като хора, места и организации от документи, за да структурирате неструктурирани данни.

- Обобщение: Обобщете дълги статии или доклади в кратки резюмета, спестявайки на екипа ви ценно време за четене.

- Превод: Преобразувайте текст от един език на друг автоматично

📚 Прочетете също: Как да използвате Hugging Face за обобщаване на текст

Големи езикови модели

Понякога вашият проект изисква нещо повече от просто класифициране или обобщаване. Може да се наложи да използвате AI, която може да генерира креативни маркетингови текстове, да пише код или да отговаря на сложни въпроси на потребителите по разговорно-общителен начин. В такива случаи вероятно ще се обърнете към Large Language Model (LLM).

LLM са модели с милиарди параметри, обучени на огромни количества текст и данни от интернет. Това обширно обучение им позволява да разбират нюансите, контекста и сложните разсъждения. Популярните LLM с отворен код, достъпни в Hugging Face, включват модели от семействата Llama, Mistral и Falcon.

Компромисът за тази мощност е значителните изчислителни ресурси, които изискват. Разгръщането на тези модели почти винаги изисква мощни графични процесори с голям обем памет (VRAM).

За да ги направите по-достъпни, можете да използвате техники като квантизация, която намалява размера на модела с малка загуба на производителност, което позволява той да работи на по-малко мощен хардуер.

📚 Прочетете също: Какво представляват LLM агентите в изкуствения интелект и как работят?

Модели за преобразуване на текст в изображение и мултимодални модели

Вашите данни не винаги са само текст. Вашият екип може да се наложи да генерира изображения за маркетингова кампания, да транскрибира аудиозапис от среща или да разбере съдържанието на видеоклип. Тук мултимодалните модели, които са проектирани да работят с различни типове данни, стават незаменими.

Най-популярният тип мултимодален модел е моделът „текст към изображение“, който генерира изображения от текстово описание. Модели като Stable Diffusion използват техника, наречена дифузия, за да създават впечатляващи визуализации от прости команди. Но възможностите се простират далеч отвъд генерирането на изображения.

Други често използвани мултимодални модели, които можете да внедрите от Hugging Face, включват:

- Описание на изображения: Автоматично генерирайте описателен текст за изображенията, което е чудесно за достъпност и управление на съдържанието.

- Разпознаване на реч: Преобразувайте говореното аудио в писмен текст с модели като Whisper на OpenAI.

- Визуално отговаряне на въпроси: Задавайте въпроси за изображение и получавайте текстови отговори, като например „Какъв цвят е колата на тази снимка?“

Подобно на LLM, тези модели са изчислително интензивни и обикновено изискват GPU, за да работят ефективно.

📚 Прочетете също: 50+ AI изображения за създаване на впечатляващи визуализации

За да видите как тези различни типове AI модели се превръщат в практични бизнес приложения, гледайте този обзор на реални примери за използване на AI в различни индустрии и функции.

Каква е степента на зрялост на изкуствения интелект във вашата организация?

Нашето проучване сред 316 професионалисти показва, че истинската AI трансформация изисква повече от просто внедряване на AI функции. Направете оценка на AI зрелостта, за да видите къде се намира вашата организация и какво можете да направите, за да подобрите резултата си.

Как да настроите Hugging Face за внедряване на изкуствен интелект

Преди да можете да внедрите първия си модел, трябва да настроите правилно локалната си среда и акаунта си в Hugging Face. Често срещано разочарование за екипите е, когато различните членове имат несъвместими настройки, което води до класическия проблем „на моя компютър работи“. Отделянето на няколко минути за стандартизиране на този процес спестява часове на отстраняване на проблеми по-късно.

- Създайте акаунт в Hugging Face и генерирайте токен за достъп. Първо, регистрирайте се за безплатен акаунт на уебсайта на Hugging Face. След като влезете в акаунта си, отидете в профила си, кликнете върху „Настройки“ и след това отидете в раздела „Токени за достъп“. Генерирайте нов токен с поне „права за четене“; ще ви е необходим, за да изтеглите модели.

- Инсталирайте необходимите библиотеки на Python. Отворете терминала си и инсталирайте основните библиотеки, от които ще се нуждаете. Двете най-важни са transformers и huggingface_hub. Можете да ги инсталирате с помощта на pip: pip install transformers huggingface_hub

- Конфигурирайте удостоверяването. За да използвате своя токен за достъп, можете да влезете чрез командния ред, като изпълните huggingface-cli login и поставите своя токен, когато ви бъде поискано, или можете да го зададете като променлива на средата във вашата система. Влизането през командния ред често е най-лесният начин да започнете.

- Проверете настройките. Най-добрият начин да се уверите, че всичко работи, е да изпълните прост код. Опитайте да заредите основен модел, използвайки функцията pipeline от библиотеката transformers. Ако работи без грешки, сте готови да продължите.

Имайте предвид, че някои модели в Hub са „затворени“, което означава, че трябва да се съгласите с лицензионните им условия на страницата на модела, преди да можете да получите достъп до тях с вашия токен.

Не забравяйте също, че проследяването на това кой разполага с какви права за достъп и какви конфигурации на средата се използват е задача по управление на проекти сама по себе си и става все по-важна с разрастването на екипа ви.

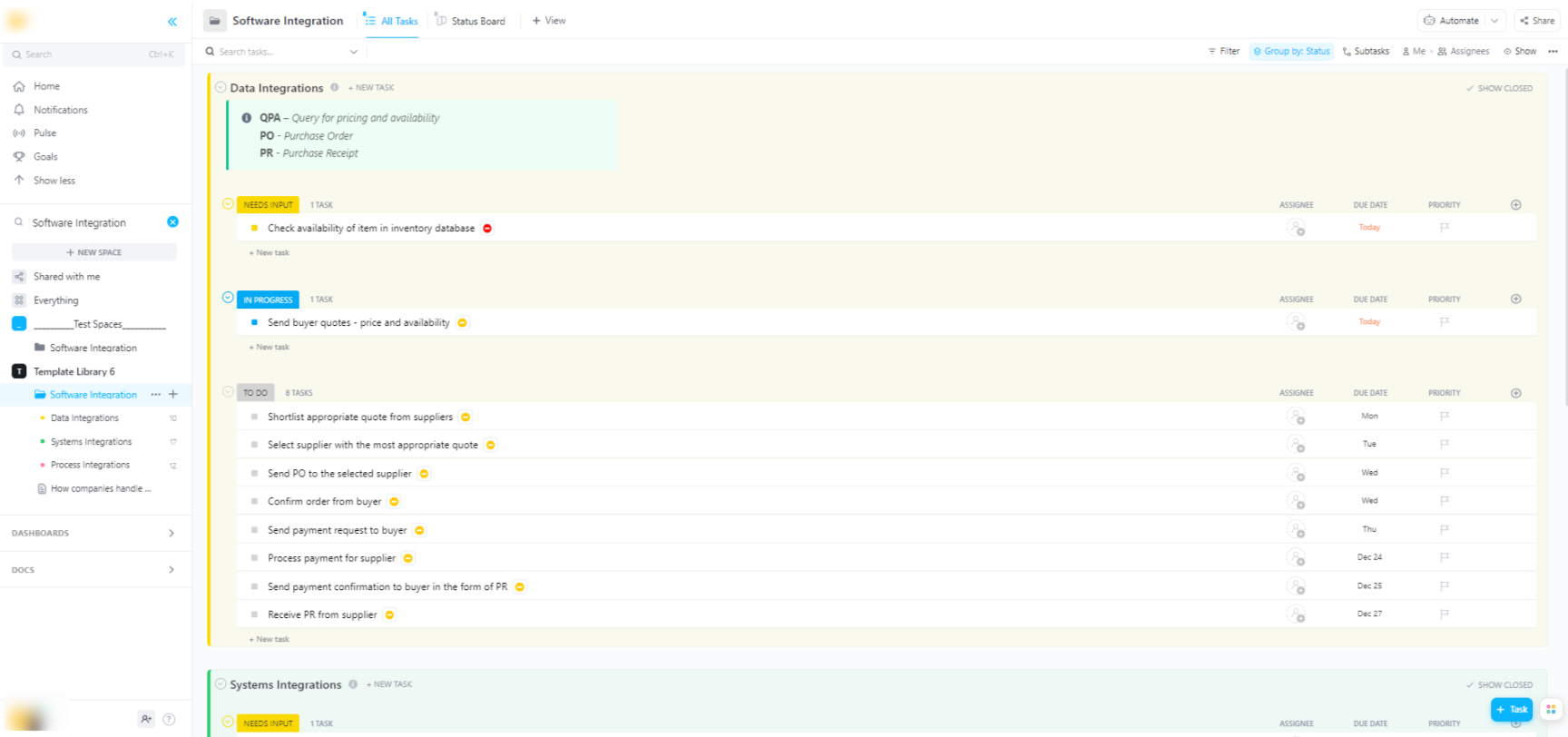

🌟 Ако интегрирате моделите на Hugging Face в по-широки софтуерни системи, шаблонът за софтуерна интеграция на ClickUp ви помага да визуализирате работните процеси и да проследявате многоетапните технически интеграции.

Шаблонът ви предоставя лесна за следване система, в която можете:

- Визуализирайте връзките между различните софтуерни решения

- Създавайте и възлагайте задачи на членовете на екипа за по-гладко сътрудничество.

- Организирайте всички задачи, свързани с интеграцията, на едно място.

Опции за внедряване на модели Hugging Face

След като сте тествали модела локално, следващият въпрос е: къде ще бъде разположен? Разгръщането на модел в производствена среда, където може да бъде използван от други, е критична стъпка, но опциите могат да бъдат объркващи. Изборът на грешен път може да доведе до бавна работа, високи разходи или невъзможност да се справи с трафика на потребителите.

Вашият избор ще зависи от конкретните ви нужди, като очакван трафик, бюджет и дали създавате бърз прототип или мащабируемо приложение, готово за производство.

Hugging Face Spaces

Ако имате нужда да създадете бързо демо версия или вътрешен инструмент, Hugging Face Spaces често е най-добрият избор. Spaces е безплатна платформа за хостинг на приложения за машинно обучение и е идеална за създаване на прототипи, които можете да споделите с екипа си или заинтересованите страни.

Можете да създадете потребителския интерфейс на приложението си, използвайки популярни рамки като Gradio или Streamlit, което улеснява създаването на интерактивни демонстрации с само няколко реда Python.

Създаването на пространство е толкова просто, колкото избора на предпочитания SDK, свързването на Git хранилище с вашия код и избора на хардуер. Макар Spaces да предлага безплатен CPU слой за основни приложения, можете да преминете към платен GPU хардуер за по-взискателни модели.

Имайте предвид ограниченията:

- Не е подходящо за API с голям трафик: Spaces е предназначено за демонстрации, а не за обслужване на хиляди едновременни API заявки.

- Студен старт: Ако вашето пространство е неактивно, то може да „заспи“, за да спести ресурси, което да доведе до забавяне за първия потребител, който отново го отвори.

- Работен процес на базата на Git: Целият код на вашето приложение се управлява чрез Git хранилище, което е чудесно за контрол на версиите.

Hugging Face Inference API

Когато трябва да интегрирате модел в съществуващо приложение, вероятно ще искате да използвате API. Hugging Face Inference API ви позволява да изпълнявате модели, без да се налага да управлявате сами основната инфраструктура. Просто изпращате HTTP заявка с вашите данни и получавате прогноза в отговор.

Този подход е идеален, когато не искате да се занимавате със сървъри, мащабиране или поддръжка. Hugging Face предлага две основни нива за тази услуга:

- Безплатен API за изводи: Това е опция за споделена инфраструктура с ограничена скорост, която е идеална за разработка и тестване. Тя е перфектна за случаи с нисък трафик или когато тепърва започвате.

- Inference Endpoints: За производствени приложения ще искате да използвате Inference Endpoints. Това е платена услуга, която ви предоставя специална инфраструктура с автоматично мащабиране, гарантираща, че вашето приложение е бързо и надеждно дори при голямо натоварване.

Използването на API включва изпращане на JSON payload към URL адреса на крайната точка на модела с вашия токен за удостоверяване в заглавката на заявката.

Разгръщане на облачна платформа

За екипи, които вече имат значително присъствие при голям доставчик на облачни услуги като Amazon Web Services (AWS), Google Cloud Platform (GCP) или Microsoft Azure, внедряването там може да бъде най-логичният избор. Този подход ви дава най-голям контрол и ви позволява да интегрирате модела с вашите съществуващи облачни услуги и протоколи за сигурност.

Общият работен процес включва „контейнеризиране“ на вашия модел и неговите зависимости с помощта на Docker, а след това внедряване на този контейнер в облачна изчислителна услуга. Всеки доставчик на облачни услуги разполага с услуги и интеграции, които опростяват този процес:

- AWS SageMaker: Предлага вградена интеграция за обучение и внедряване на модели Hugging Face.

- Google Cloud Vertex AI: Позволява ви да внедрявате модели от Hub в управлявани крайни точки.

- Azure Machine Learning: Предоставя инструменти за импортиране и обслужване на модели Hugging Face.

Макар този метод да изисква повече настройки и DevOps експертиза, той често е най-добрият вариант за мащабни внедрявания на корпоративно ниво, при които се нуждаете от пълен контрол над средата.

📚 Прочетете също: Автоматизация на работния процес: автоматизирайте работните процеси, за да повишите производителността

Как да изпълнявате модели на Hugging Face за извличане на заключения

Когато използвате Hugging Face за внедряване на AI, „изпълнение на инференция“ е процесът на използване на обучения модел за правене на прогнози за нови, невиждани данни. Това е моментът, в който моделът ви изпълнява задачата, за която сте го внедрили. Правилното изпълнение на тази стъпка е от решаващо значение за създаването на отзивчиво и ефективно приложение.

Най-голямото разочарование за екипите е писането на код за изводи, който е бавен или неефективен, което може да доведе до лошо потребителско преживяване и високи оперативни разходи. За щастие, библиотеката transformers предлага няколко начина за изпълнение на изводи, всеки от които с свои компромиси между простота и контрол.

- Pipeline API: Това е най-лесният и най-често използван начин да започнете. Функцията pipeline() абстрахира по-голямата част от сложността, като се занимава с предварителната обработка на данните, препращането на моделите и последващата обработка вместо вас. За много стандартни задачи, като анализ на настроенията, можете да получите прогноза само с един ред код.

- AutoModel + AutoTokenizer: Когато се нуждаете от по-голям контрол върху процеса на извличане на заключения, можете да използвате директно класовете AutoModel и AutoTokenizer. Това ви позволява ръчно да управлявате начина, по който текстът ви се токенизира, и начина, по който суровият изход на модела се преобразува в предсказание, което може да се чете от човека. Този подход е полезен, когато работите с персонализирана задача или се налага да приложите специфична логика за предварителна или последваща обработка.

- Обработка на партиди: За да постигнете максимална ефективност, особено на GPU, трябва да обработвате входните данни на партиди, а не една по една. Изпращането на партида от входни данни през модела в еднократно предаване е значително по-бързо, отколкото изпращането на всяка една поотделно.

Наблюдението на производителността на вашия код за извличане на заключения е ключова част от жизнения цикъл на внедряването. Проследяването на показатели като латентност (колко време отнема прогнозата) и пропускателна способност (колко прогнози можете да направите за секунда) изисква координация и ясна документация, особено когато различни членове на екипа експериментират с нови версии на моделите.

📚 Прочетете също: Най-добрите инструменти за сътрудничество в екип за изкуствен интелект

Пример стъпка по стъпка: Разгръщане на модел Hugging Face

Нека разгледаме един пълен пример за внедряване на прост модел за анализ на настроенията. Следвайте тези стъпки, за да преминете от избора на модел до създаването на тествана крайна точка.

- Изберете модел: Отидете в Hugging Face Hub и използвайте филтрите вляво, за да търсите модели, които изпълняват „Класификация на текст“. Добро начало е distilbert-base-uncased-finetuned-sst-2-english. Прочетете картата на модела, за да разберете неговата производителност и как да го използвате.

- Инсталирайте зависимости: Уверете се, че в локалната си Python среда имате инсталирани необходимите библиотеки. За този модел ще ви трябват само transformers и torch. Изпълнете pip install transformers torch

- Тествайте локално: Преди внедряването винаги се уверявайте, че моделът работи както очаквате на вашата машина. Напишете малък Python скрипт, за да заредите модела, използвайки тръбопровода, и го тествайте с примерно изречение. Например: classifier = pipeline("sentiment-analysis", model="distilbert-base-uncased-finetuned-sst-2-english") последвано от classifier("ClickUp е най-добрата платформа за продуктивност!")

- Създаване на внедряване: За този пример ще използваме Hugging Face Spaces за бързо и лесно внедряване. Създайте ново пространство, изберете Gradio SDK и създайте файл app.py, който зарежда вашия модел и дефинира прост Gradio интерфейс за взаимодействие с него.

- Проверете внедряването: След като Space започне да работи, можете да използвате интерактивния интерфейс, за да го тествате. Можете също да направите директно API запитване към крайната точка на Space, за да получите JSON отговор, потвърждаващ, че работи програмно.

След тези стъпки ще разполагате с действащ модел. Следващата фаза на проекта ще включва наблюдение на неговото използване, планиране на актуализации и евентуално мащабиране на инфраструктурата, ако той стане популярен.

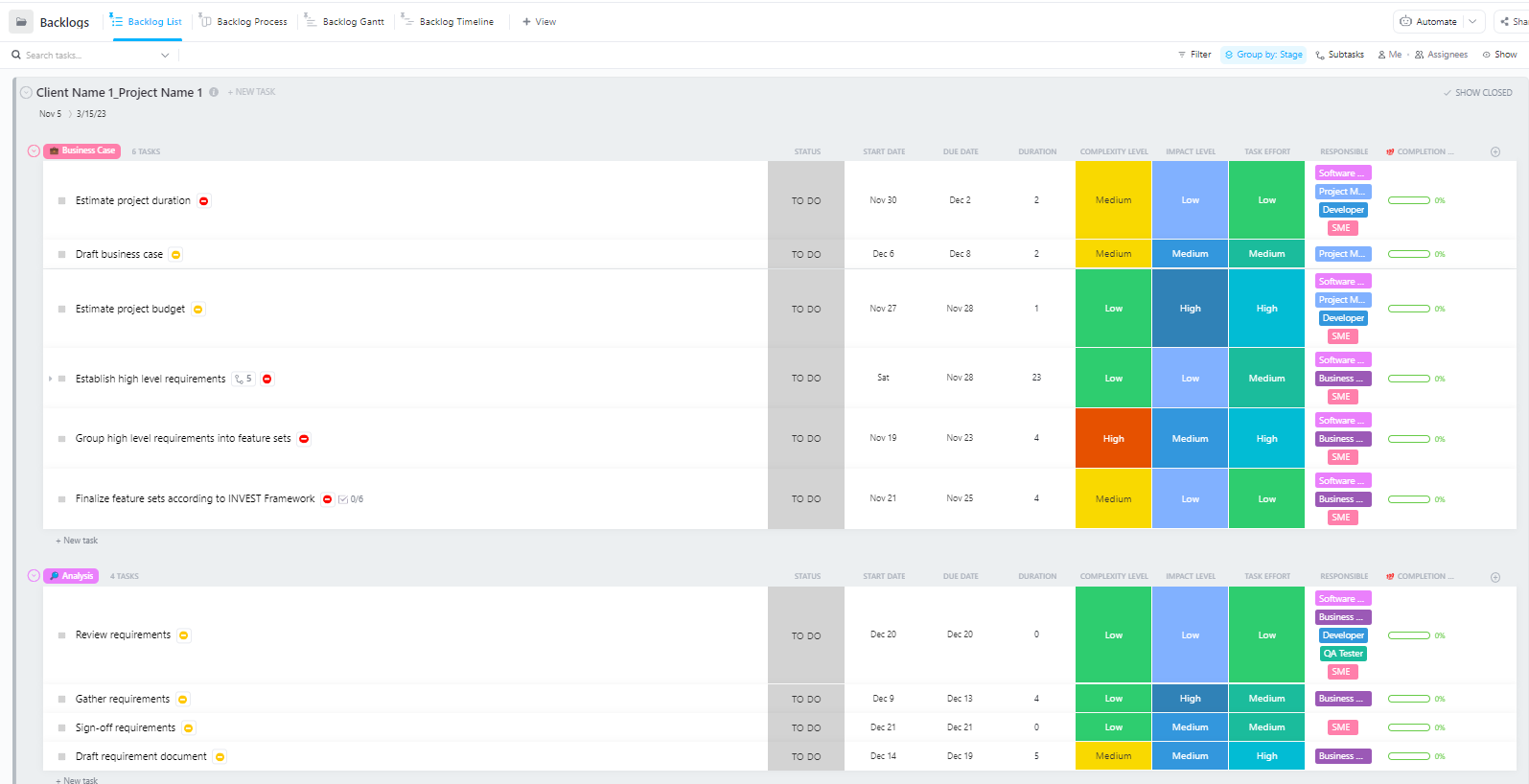

За екипи, които управляват сложни проекти за внедряване на AI с няколко фази – от подготовката на данните до внедряването в производството – Software Project Management Advanced Template от ClickUp предоставя цялостна структура.

Този шаблон помага на екипите:

- Управлявайте проекти с множество етапи, задачи, ресурси и зависимости

- Визуализирайте напредъка на проекта с диаграми на Гант и времеви графики.

- Сътрудничество с колегите за успешно завършване на проекта

Чести предизвикателства при внедряването на Hugging Face и как да ги преодолеете

Дори и с ясен план, вероятно ще срещнете няколко препятствия по време на внедряването. Да се взирате в загадъчно съобщение за грешка може да бъде изключително разочароващо и да спре напредъка на вашия екип. Ето някои от най-често срещаните предизвикателства и как да ги разрешите. 🛠️

🚨Проблем: „Моделът изисква удостоверяване“

- Причина: Опитвате се да получите достъп до „затворен“ модел, който изисква да приемете лицензионните му условия.

- Решение: Отидете на страницата на модела в Hub, прочетете и приемете лицензионното споразумение. Уверете се, че токенът за достъп, който използвате, има разрешения за „четене“.

🚨Проблем: „CUDA изчерпа паметта“

- Причина: Моделът, който се опитвате да заредите, е прекалено голям за паметта на вашия GPU (VRAM).

- Решение: Най-бързото решение е да използвате по-малка версия на модела или квантизирана версия. Можете също да опитате да намалите размера на партидата по време на извличането на заключения.

🚨Проблем: „trust_remote_code error”

- Причина: Някои модели в Hub изискват персонализиран код за изпълнение и по съображения за сигурност библиотеката не го изпълнява по подразбиране.

- Решение: Можете да заобиколите този проблем, като добавите trust_remote_code=True при зареждането на модела. Въпреки това, винаги трябва да преглеждате първо изходния код, за да се уверите, че е безопасен.

🚨Проблем: „Несъответствие на токенизатора”

- Причина: Токенизаторът, който използвате, не е същият, с който е обучен моделът, което води до неточни входни данни и лоша производителност.

- Решение: Винаги зареждайте токенизатора от същия контролен пункт на модела, както и самия модел. Например, AutoTokenizer. from_pretrained("model-name")

🚨Проблем: „Превишена граница на скоростта”

- Причина: Извършили сте прекалено много заявки към безплатния Inference API за кратък период от време.

- Решение: За производствена употреба, надстройте до специален Inference Endpoint. За разработка можете да имплементирате кеширане, за да избегнете изпращането на едно и също заявка многократно.

От решаващо значение е да се проследява кои решения работят за кои проблеми. Без централизирано място за документиране на тези констатации, екипите често се оказват в ситуация, в която решават един и същ проблем отново и отново.

📮 ClickUp Insight: 1 от 4 служители използва четири или повече инструмента само за да създаде контекст на работното място. Ключова информация може да бъде скрита в имейл, разширена в Slack нишка и документирана в отделен инструмент, което принуждава екипите да губят време в търсене на информация, вместо да вършат работата си.

ClickUp обединява целия ви работен процес в една унифицирана платформа. С функции като ClickUp Email Project Management, ClickUp Chat, ClickUp Docs и ClickUp Brain всичко остава свързано, синхронизирано и незабавно достъпно. Кажете сбогом на „работата за работата“ и си върнете продуктивното време.

💫 Реални резултати: Екипите могат да спестят над 5 часа всяка седмица, използвайки ClickUp – това са над 250 часа годишно на човек – като елиминират остарелите процеси за управление на знанията. Представете си какво би могъл да създаде вашият екип с една допълнителна седмица продуктивност на тримесечие!

Как да управлявате проекти за внедряване на изкуствен интелект в ClickUp

Използването на Hugging Face за внедряване на AI улеснява пакетирането, хостинга и обслужването на модели, но не елиминира координационните разходи при внедряването в реалния свят. Екипите все още трябва да проследяват кои модели се тестват, да съгласуват конфигурациите, да документират решенията и да поддържат всички – от ML инженерите до продуктовите и оперативните екипи – на една и съща страница.

Когато вашият инженерен екип тества различни модели, вашият продуктов екип определя изискванията, а заинтересованите страни искат актуализации, информацията се разпръсква в Slack, имейли, таблици и различни документи.

Това разпръскване на работата – фрагментирането на работните дейности между множество несвързани инструменти, които не комуникират помежду си – създава объркване и забавя всички.

Тук ClickUp, първото в света конвергентно AI работно пространство, играе ключова роля, като обединява управлението на проекти, документацията и комуникацията в екипа в едно работно пространство.

Тази конвергенция е особено ценна за проекти за внедряване на изкуствен интелект, където техническите и нетехническите заинтересовани страни се нуждаят от споделена видимост, без да използват пет различни инструмента.

Вместо да разпръскват актуализациите в билети, документи и чат низове, екипите могат да управляват целия цикъл на внедряване на едно място.

Ето как ClickUp може да подкрепи вашия проект за внедряване на AI:

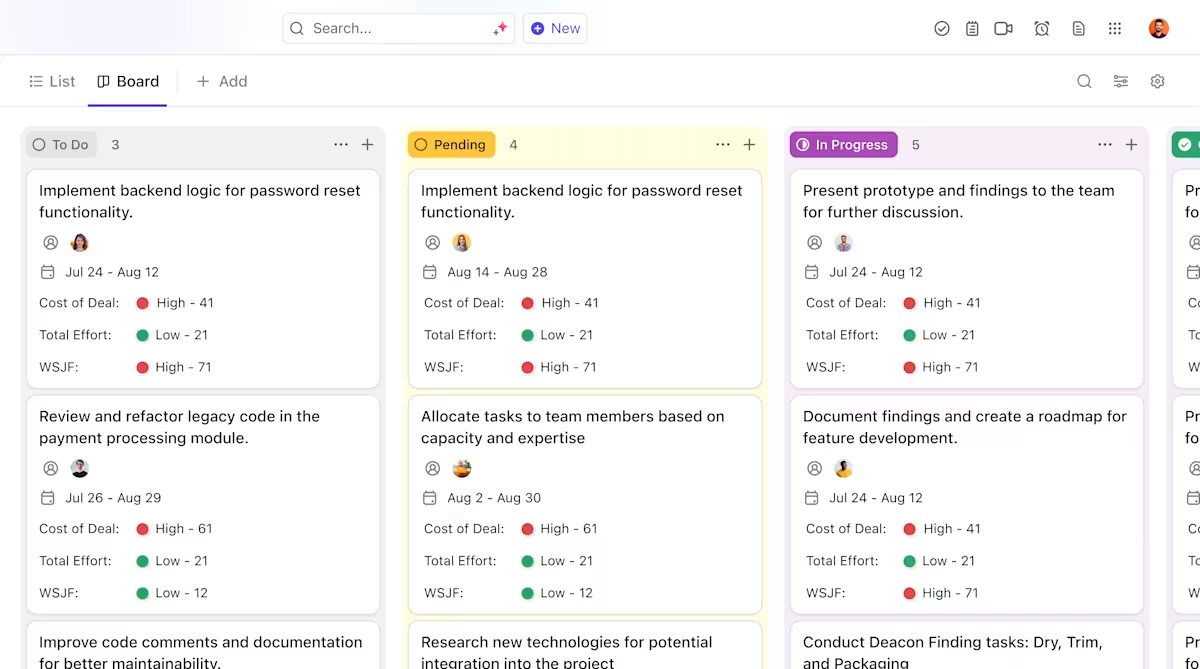

- Ясно разпределение на отговорностите и проследяване през целия жизнен цикъл на моделите: Използвайте ClickUp Tasks, за да проследявате моделите на Hugging Face през етапите на оценка, тестване, подготовка и производство, с персонализирани статуси, отговорни лица и пречки, видими за целия екип.

- Централизирана, актуална документация за внедряване: Поддържайте ръководства за внедряване, конфигурации на средата и ръководства за отстраняване на проблеми в ClickUp Docs, така че документацията да се развива заедно с вашите модели и да остава лесна за търсене и справка. Тъй като Docs са свързани със задачите, вашата документация се намира точно до работата, с която е свързана.

- Сътрудничество в контекста без разширяване на работата: Поддържайте дискусии, решения и актуализации, свързани директно с задачите и документите, като намалите зависимостта от разпръснати Slack низове, имейли и несвързани инструменти за проекти.

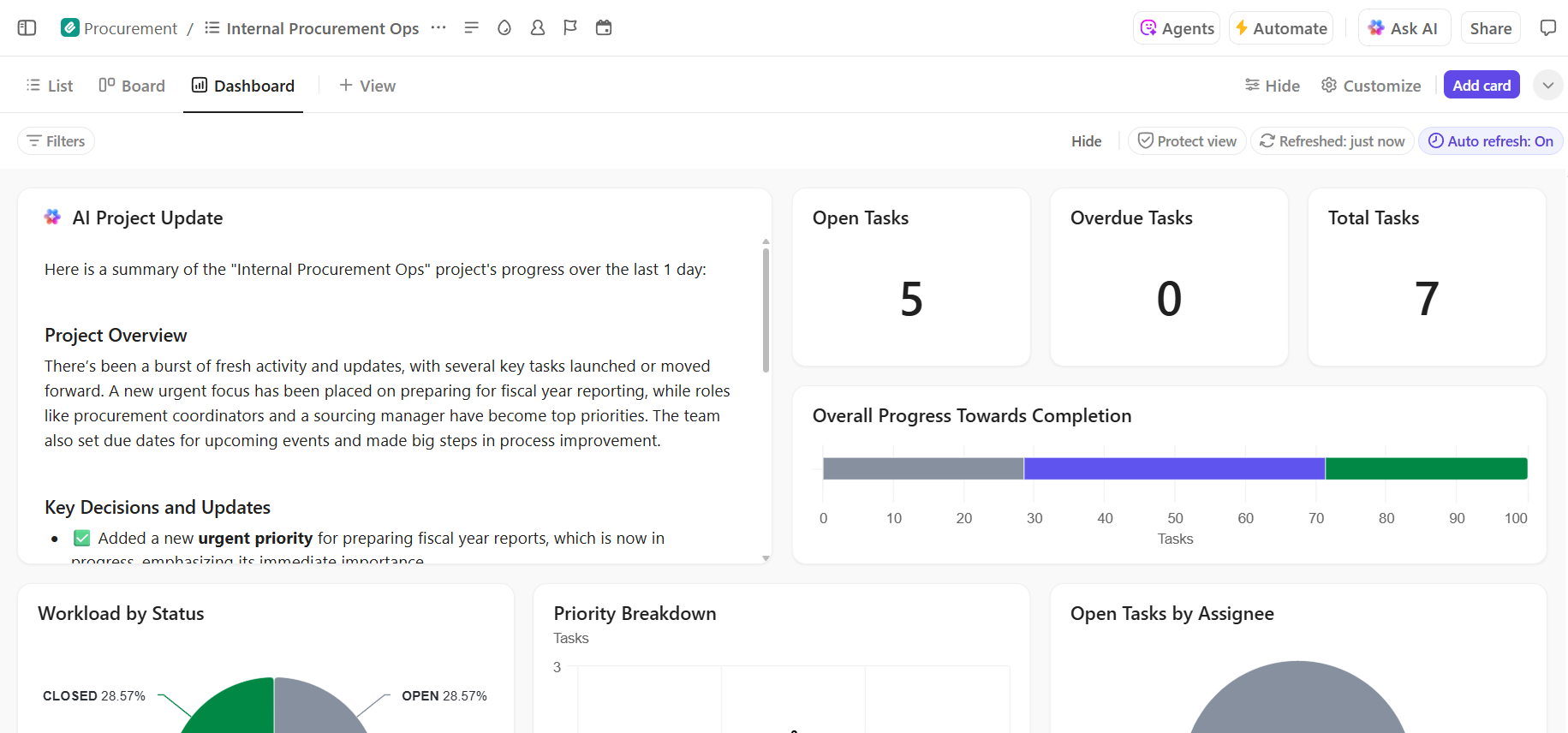

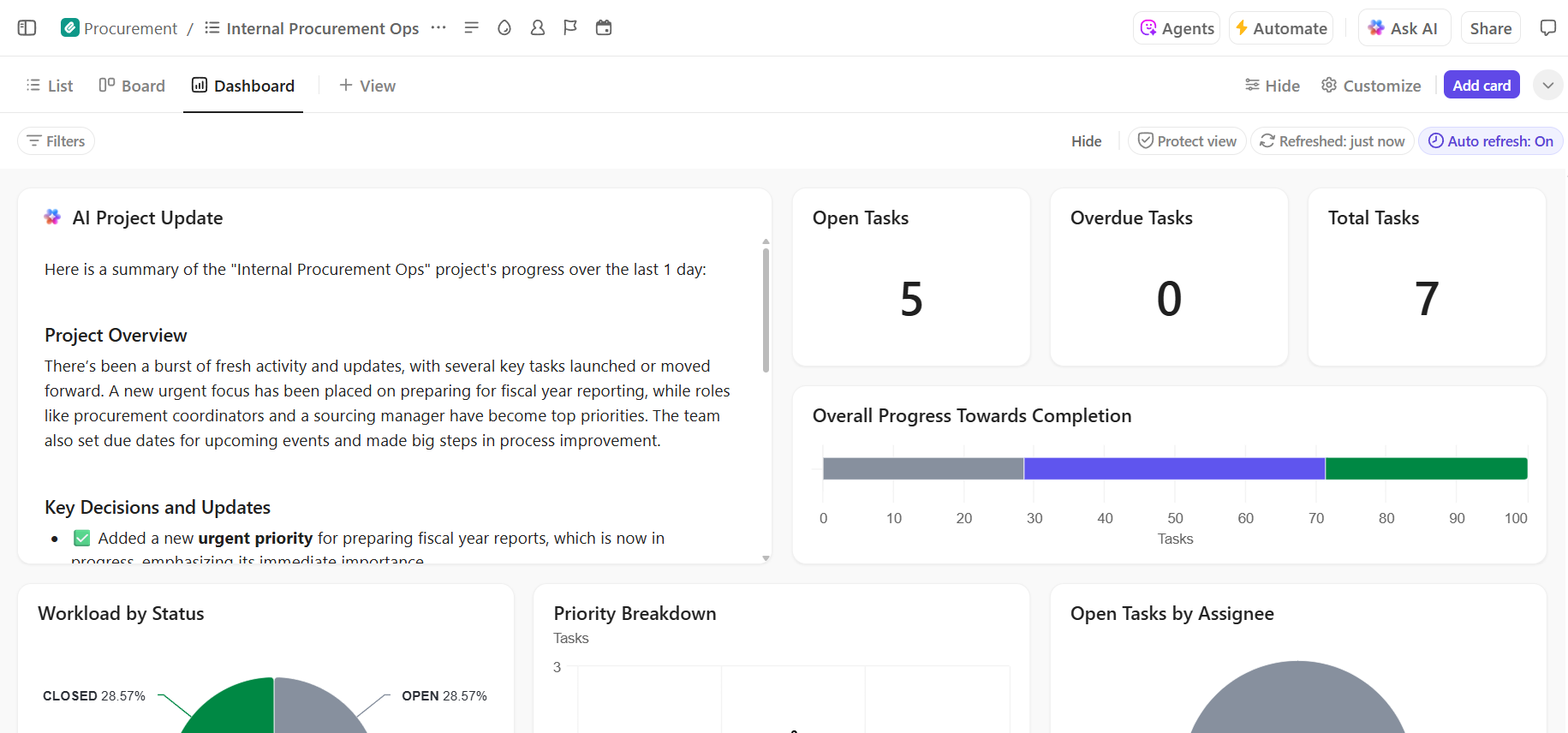

- Пълна видимост на напредъка на внедряването: Следете процеса на внедряване, идентифицирайте рисковете навреме и балансирайте капацитета на екипа с помощта на ClickUp Dashboards, които показват напредъка и пречките в реално време.

- По-бързо въвеждане и извличане на решения с вграден AI: Използвайте ClickUp Brain, за да обобщите дълги документи за внедряване, да извлечете релевантни заключения от минали внедрявания и да помогнете на новите членове на екипа да се ориентират, без да се налага да ровят в историческия контекст.

📚 Прочетете също: Как да автоматизирате процесите с изкуствен интелект за по-бързи и по-умни работни потоци

Управлявайте безпроблемно проекта си за внедряване на AI в ClickUp

Успешното внедряване на Hugging Face зависи от солидна техническа основа и ясно, организирано управление на проекта. Макар техническите предизвикателства да са разрешими, често именно координацията и комуникационните проблеми са причината за провала на проектите.

Чрез установяване на ясен работен процес в една платформа, вашият екип може да работи по-бързо и да избегне неудобството от разпръскването на контекста – когато екипите губят часове в търсене на информация, превключване между приложения и повтаряне на актуализации в различни платформи.

ClickUp, приложението за всичко, свързано с работата, обединява управлението на проекти, документацията и комуникацията в екипа на едно място, за да ви предостави единен източник на информация за целия цикъл на внедряване на AI.

Обединете проектите си за внедряване на AI и елиминирайте хаоса с инструментите. Започнете безплатно с ClickUp още днес.

Често задавани въпроси (FAQ)

Да, Hugging Face предлага щедър безплатен пакет, който включва достъп до Model Hub, Spaces с CPU за демонстрации и API за изчисления с ограничена скорост за тестване. За производствени нужди, изискващи специален хардуер или по-високи лимити, са налични платени планове.

Spaces е проектиран за хостинг на интерактивни приложения с визуален интерфейс, което го прави идеален за демонстрации и вътрешни инструменти. Inference API предоставя програмно достъп до модели, което ви позволява да ги интегрирате в приложенията си чрез прости HTTP заявки.

Разбира се. Чрез интерактивни демонстрации, хоствани в Hugging Face Spaces, членовете на екипа, които не са технически подготвени, могат да експериментират с моделите и да дават обратна връзка, без да пишат нито една реда код.

Основните ограничения на безплатния план са ограниченията на скоростта на Inference API, използването на споделен CPU хардуер за Spaces, което може да бъде бавно, и „студените стартирания“, при които неактивните приложения отнемат малко време, за да се събудят. /