GitHub Copilot สามารถสร้างกรณีทดสอบได้หลายร้อยกรณีในเวลาเพียงไม่กี่นาที—พร้อมการทดลองควบคุมที่แสดงให้เห็นว่านักพัฒนาทำงานเสร็จเร็วขึ้น 35%—แต่มีข้อแม้อยู่: กรณีทดสอบที่สร้างโดย AI เหล่านั้นจะมีประโยชน์ได้เท่ากับระดับความสามารถของคุณในการติดตาม จัดระเบียบ และเชื่อมโยงเข้ากับกระบวนการพัฒนาที่เหลือของคุณเท่านั้น

คู่มือนี้จะแนะนำคุณในการใช้ GitHub Copilot เพื่อสร้างกรณีทดสอบอย่างรวดเร็ว จากนั้นจะแสดงวิธีการจัดการอย่างมีประสิทธิภาพเพื่อไม่ให้กลายเป็นเพียงกองไฟล์โค้ดที่ถูกทิ้งร้าง

ทำไมการทดสอบหน่วยจึงมีความสำคัญต่อคุณภาพซอฟต์แวร์

การเขียนหน่วยทดสอบมักถูกมองว่าเป็นงานที่น่าเบื่อ แต่การข้ามมันไปจะทำให้โค้ดไม่เสถียร

เมื่อคุณไม่มีตาข่ายนิรภัยของการทดสอบ การปรับโครงสร้างเล็กน้อยอาจทำให้เกิดข้อบกพร่องจากการถดถอย—ข้อผิดพลาดที่ทำให้ฟังก์ชันการทำงานที่มีอยู่เสียหายและลดความไว้วางใจของผู้ใช้ งานวิจัยของ IBM แสดงให้เห็นว่าข้อบกพร่องที่พบหลังการเปิดตัวมีค่าใช้จ่ายในการแก้ไขสูงกว่าถึง 15 เท่า

สิ่งนี้สร้างวงจรที่นักพัฒนาหลีกเลี่ยงการปรับปรุงโค้ดเพราะกลัวว่าอะไรอาจเสียหายนำไปสู่หนี้ทางเทคนิคที่สะสมเพิ่มขึ้น

การสร้างแบบทดสอบโดยใช้ AIช่วยลดวงจรนี้ลง โดย89% ขององค์กรกำลังทดลองหรือใช้งานเวิร์กโฟลว์ AI เชิงสร้างสรรค์ในด้านวิศวกรรมคุณภาพและการทดสอบ ด้วยการใช้เครื่องมือเช่น GitHub Copilot ในการสร้างโครงสร้างกรณีทดสอบ คุณสามารถมุ่งเน้นไปที่สิ่งที่สำคัญได้: การออกแบบการทดสอบที่มีความหมายและการปรับปรุงการครอบคลุมกรณีขอบเขต

นี่คือเหตุผลที่การทดสอบหน่วยอย่างสม่ำเสมอให้ผลตอบแทน:

- การป้องกันการถดถอย: การทดสอบที่ดีทำหน้าที่เป็นราวกันตก ช่วยให้มั่นใจว่าฟีเจอร์ใหม่หรือการแก้ไขข้อบกพร่องจะไม่ทำให้ส่วนอื่นเสียหายโดยไม่ตั้งใจ

- เอกสารที่มีชีวิต: ต่างจากเอกสารแบบคงที่ที่อาจล้าสมัยได้ การทดสอบหน่วยทำหน้าที่เป็นตัวอย่างที่สามารถดำเนินการได้ของวิธีที่โค้ดของคุณควรทำงาน

- ความมั่นใจในการปรับโครงสร้างโค้ด: เมื่อคุณมีการทดสอบที่ครอบคลุมอย่างครบถ้วน คุณสามารถปรับโครงสร้างและปรับปรุงโค้ดของคุณด้วยความมั่นใจว่า คุณจะทราบได้ทันทีหากการเปลี่ยนแปลงใดมีผลกระทบที่ไม่คาดคิด

เพื่อทำความเข้าใจเพิ่มเติมเกี่ยวกับวิธีที่ตัวแทน AI กำลังเปลี่ยนแปลงภูมิทัศน์ของการเขียนโค้ดให้มากกว่าการสร้างทดสอบเพียงอย่างเดียว ชมภาพรวมของเครื่องมือช่วยเหลือการเขียนโค้ดที่ใช้ AI และความสามารถของพวกมัน:

วิธีตั้งค่า GitHub Copilot สำหรับการสร้างกรณีทดสอบ

ก่อนที่คุณจะเริ่มสร้างการทดสอบได้ คุณจำเป็นต้องติดตั้งและกำหนดค่า GitHub Copilot ในสภาพแวดล้อมการพัฒนาแบบบูรณาการ (IDE) ของคุณเสียก่อน กระบวนการติดตั้งนั้นง่ายและใช้เวลาเพียงไม่กี่นาที แต่การตั้งค่าให้ถูกต้องจะช่วยให้ Copilot มีบริบทที่จำเป็นในการให้คำแนะนำที่เกี่ยวข้อง

คุณจะต้องมีบางสิ่งบางอย่างก่อนที่คุณจะเริ่ม:

- การสมัครสมาชิก GitHub Copilot ที่ใช้งานอยู่ (บุคคล, ธุรกิจ, หรือองค์กร)

- IDE ที่รองรับ เช่น VS Code, IDE ของ JetBrains (เช่น IntelliJ หรือ PyCharm) หรือ Neovim

- เฟรมเวิร์กสำหรับการทดสอบเช่น pytest, Jest หรือ JUnit ที่ได้ติดตั้งไว้ในโปรเจกต์ของคุณแล้ว

ติดตั้งส่วนขยาย GitHub Copilot

ก่อนอื่น คุณต้องติดตั้งส่วนขยาย Copilot ลงใน IDE ของคุณ ขั้นตอนนี้คล้ายกันในโปรแกรมแก้ไขส่วนใหญ่ที่รองรับ

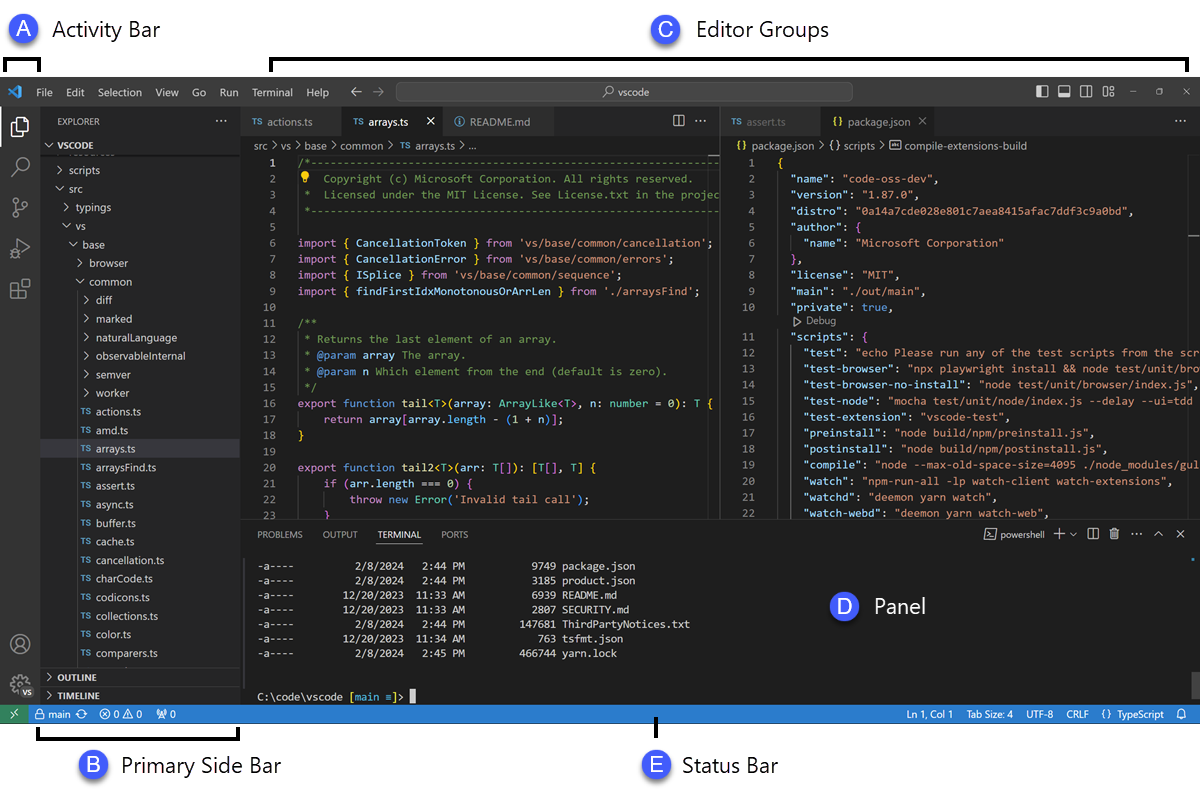

- เปิดตลาดส่วนขยายของ IDE ของคุณ ใน VS Code ให้มองหาไอคอนส่วนขยายในแถบด้านข้าง ส่วนใน IDE ของ JetBrains คุณจะพบได้ที่ การตั้งค่า → ปลั๊กอิน

- ค้นหา "GitHub Copilot"

- ติดตั้งทั้งส่วนขยายหลักของ GitHub Copilot และส่วนขยาย GitHub Copilot Chat เพื่อประสบการณ์การใช้งานที่สมบูรณ์

- คุณจะได้รับแจ้งให้รีสตาร์ท IDE ของคุณเพื่อดำเนินการติดตั้งให้เสร็จสมบูรณ์

หลังจากรีสตาร์ท คุณจะถูกขอให้ลงชื่อเข้าใช้ด้วยบัญชี GitHub ของคุณ ขั้นตอนนี้เป็นการยืนยันการสมัครสมาชิกของคุณ เมื่อคุณลงชื่อเข้าใช้แล้ว คุณจะเห็นไอคอน Copilot ขนาดเล็กในแถบสถานะของ IDE ของคุณ ซึ่งยืนยันว่ามันเปิดใช้งานและพร้อมใช้งานแล้ว

กำหนดค่าเฟรมเวิร์กการทดสอบของคุณ

GitHub Copilot สร้างการทดสอบที่เกี่ยวข้องมากขึ้นเมื่อเข้าใจการตั้งค่าการทดสอบเฉพาะของโครงการของคุณ มันทำเช่นนี้โดยการวิเคราะห์ไฟล์ทดสอบและการตั้งค่าที่มีอยู่ของคุณเพื่อเรียนรู้และจับคู่รูปแบบของทีมคุณ

- สำหรับโปรเจกต์ Python ที่ใช้ pytest: ตรวจสอบให้แน่ใจว่าคุณได้ติดตั้ง pytest แล้ว (pip install pytest) หากคุณมีไฟล์ conftest.py หรือไฟล์ทดสอบที่มีอยู่แล้ว (แม้เพียงไฟล์เดียว) Copilot จะใช้ไฟล์เหล่านั้นเป็นข้อมูลอ้างอิงในการสร้างการทดสอบใหม่

- สำหรับโปรเจ็กต์ที่ใช้ JavaScript/TypeScript กับ Jest: Copilot จะค้นหาไฟล์ jest.config.js และ dependency ของ Jest ใน package.json ของคุณเพื่อทำความเข้าใจการตั้งค่าของคุณ

- สำหรับโปรเจกต์ Java ที่ใช้ JUnit: ตรวจสอบให้แน่ใจว่ามีการกำหนดการพึ่งพา JUnit อย่างถูกต้องในไฟล์ pom.xml (สำหรับ Maven) หรือ build.gradle (สำหรับ Gradle)

การมีไฟล์ทดสอบที่เขียนอย่างดีอย่างน้อยหนึ่งไฟล์ในโปรเจกต์ของคุณเป็นหนึ่งในวิธีที่ดีที่สุดในการแนะนำ Copilot มันจะเรียนรู้รูปแบบการตั้งชื่อ, รูปแบบการยืนยัน, และวิธีการจัดโครงสร้างการทดสอบของคุณ ซึ่งจะนำไปสู่ผลลัพธ์ที่สอดคล้องกันมากขึ้น

ผสาน Copilot เข้ากับ IDE ของคุณ

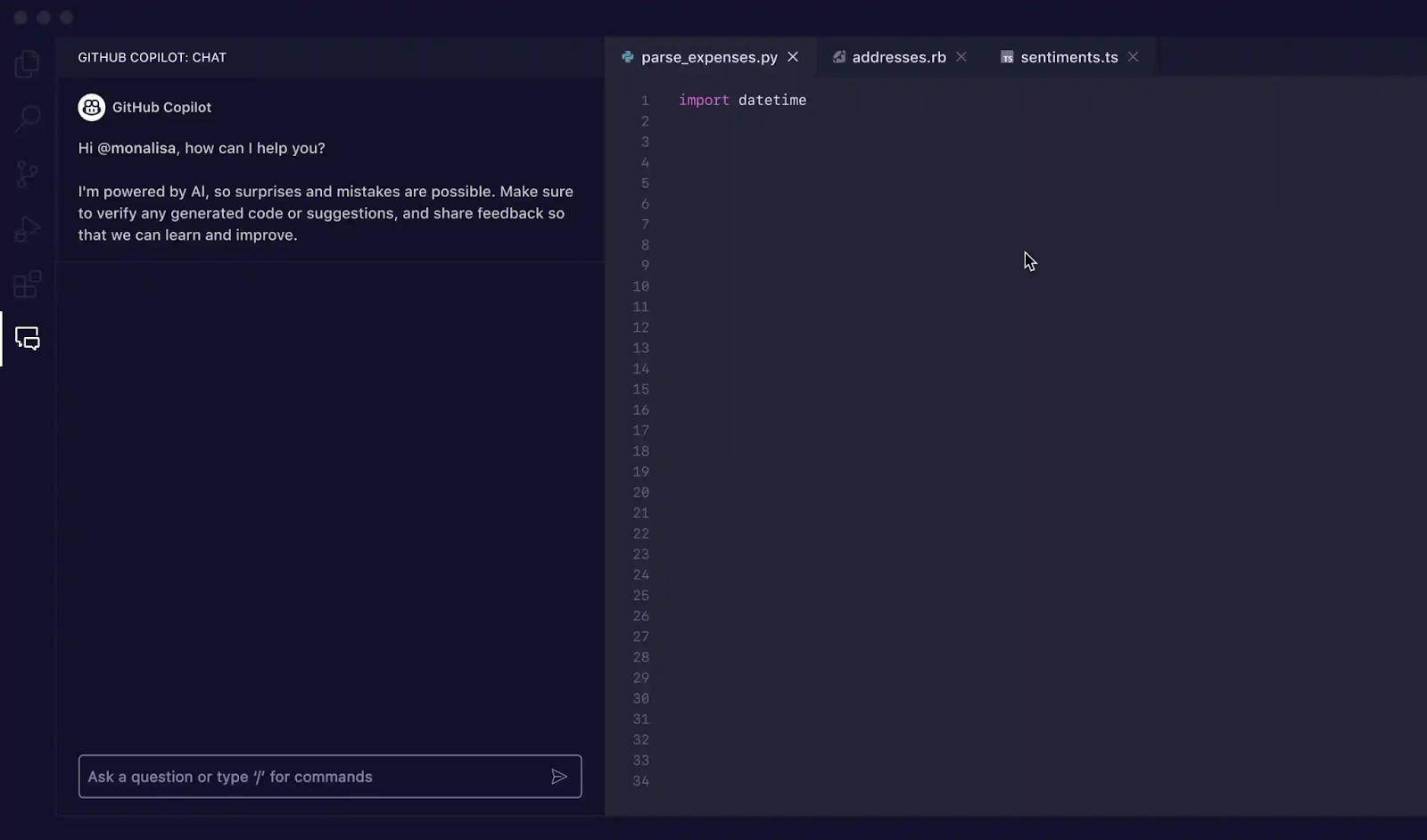

เมื่อติดตั้งส่วนขยายเรียบร้อยแล้ว ถึงเวลาทำความคุ้นเคยกับอินเทอร์เฟซ Copilot ใน IDE ของคุณ วิธีหลักที่คุณจะโต้ตอบกับ Copilot สำหรับการสร้างการทดสอบคือผ่านแผง Copilot Chat

คุณสามารถเปิดหน้าต่างแชทได้โดยใช้คีย์ลัด Ctrl+Cmd+I (บน Mac) หรือ Ctrl+Alt+I (บน Windows/Linux) หรือโดยการคลิกที่ไอคอน Copilot Chat ในแถบกิจกรรมของ IDE ของคุณ แผงแชทนี้เป็นศูนย์ควบคุมสำหรับการสร้างการทดสอบ

Copilot มีความสามารถในการรับรู้บริบท ซึ่งหมายความว่ามันจะอ่านไฟล์ที่คุณเปิดอยู่ โครงสร้างไฟล์ของโปรเจกต์ของคุณ และโค้ดที่คุณเลือกไว้ เพื่อให้ได้ผลลัพธ์ที่ดีที่สุด ควรเปิดไฟล์ที่มีฟังก์ชันหรือคลาสที่คุณต้องการทดสอบไว้และมองเห็นได้ในโปรแกรมแก้ไขของคุณเสมอ

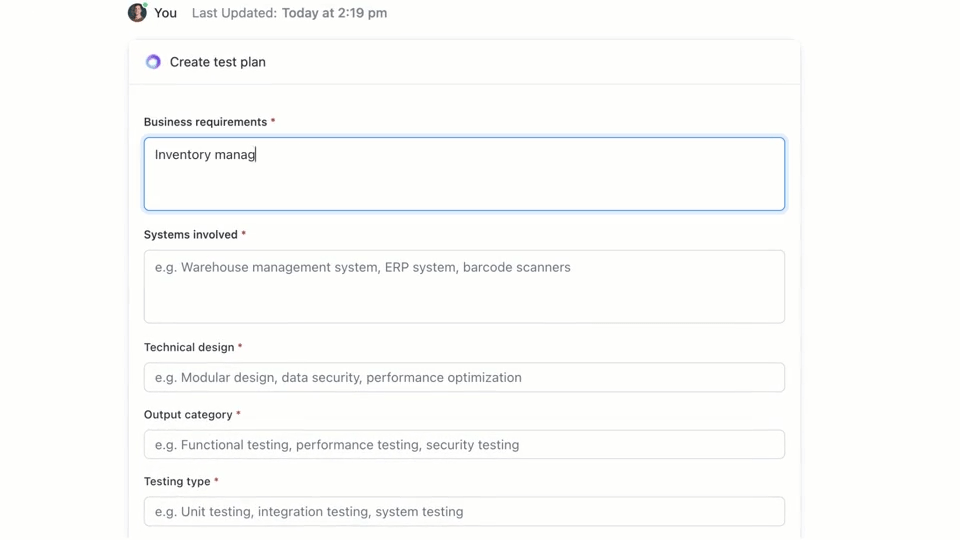

🌟ClickUp Brain, ระบบ AI ที่ผสานเข้ากับบริบทของงานใน ClickUp สามารถสร้างแผนการทดสอบให้คุณได้อย่างรวดเร็ว ลองใช้ได้เลยวันนี้

วิธีเขียนกรณีทดสอบด้วย GitHub Copilot

GitHub Copilot มอบวิธีการหลักสามวิธีในการสร้างกรณีทดสอบ: การใช้แผงแชทพร้อมคำแนะนำที่ละเอียด, การใช้คำสั่งสั้น ๆ ผ่านสัญลักษณ์ /, และการใช้การกระทำอัจฉริยะโดยตรงในตัวแก้ไขของคุณ. แต่ละวิธีเหมาะสำหรับสถานการณ์ต่าง ๆ ภายในกระบวนการพัฒนาของคุณ ขึ้นอยู่กับความต้องการของคุณว่าต้องการความรวดเร็วหรือการควบคุมอย่างละเอียด.

ใช้คำสั่ง Copilot Chat

การใช้ Copilot Chat พร้อมคำแนะนำเฉพาะเป็นวิธีที่มีประสิทธิภาพมากที่สุดสำหรับการสร้างกรณีทดสอบ เหมาะอย่างยิ่งสำหรับฟังก์ชันหรือคลาสที่ซับซ้อน ซึ่งคุณจำเป็นต้องกำหนดสถานการณ์เฉพาะ จำลองการพึ่งพา หรือจัดการกับกรณีขอบเขตที่ยุ่งยาก

นี่คือขั้นตอนการทำงานพื้นฐาน:

- เปิดแผงสนทนา Copilot

- ในโปรแกรมแก้ไขของคุณ ให้เลือกฟังก์ชัน คลาส หรือบล็อกโค้ดที่คุณต้องการทดสอบ

- เขียนคำแนะนำที่ชัดเจนและเฉพาะเจาะจงในช่องแชทเพื่ออธิบายการทดสอบที่คุณต้องการ

ตัวอย่างเช่น คุณสามารถเขียนคำแนะนำเช่นนี้ได้:

- "เขียนการทดสอบหน่วยสำหรับฟังก์ชันที่เลือก โดยครอบคลุมเส้นทางปกติ กรณีขอบเขต เช่น ข้อมูลว่างเปล่า และการจัดการข้อผิดพลาดสำหรับข้อมูลที่ไม่ถูกต้อง"

- "สร้างการทดสอบ pytest สำหรับคลาสนี้ และสร้างฟิกซ์เจอร์เพื่อจำลองการเชื่อมต่อฐานข้อมูล"

- สร้างการทดสอบ Jest สำหรับคอมโพเนนต์ React นี้ที่จำลองการคลิกของผู้ใช้และตรวจสอบการเปลี่ยนแปลงสถานะ

ยิ่งคุณให้รายละเอียดในคำสั่งมากเท่าไร การทดสอบที่สร้างขึ้นก็จะยิ่งมีคุณภาพดีขึ้นเท่านั้น

ใช้คำสั่งแบบสแลช เช่น /tests

เมื่อคุณต้องการสร้างการทดสอบอย่างรวดเร็วและไม่ต้องการสถานการณ์ที่เฉพาะเจาะจงมาก คำสั่ง /tests slash คือเพื่อนที่ดีที่สุดของคุณ นี่คือวิธีที่รวดเร็วที่สุดในการได้มาซึ่งฐานที่มั่นคงของความครอบคลุมการทดสอบ

วิธีใช้:

- เปิดแผงสนทนา Copilot

- เลือกโค้ดที่คุณต้องการทดสอบในโปรแกรมแก้ไขของคุณ

- ในช่องแชท ให้พิมพ์ /tests แล้วกด Enter

Copilot จะสร้างชุดการทดสอบหน่วยโดยทันทีตามโครงสร้างและตรรกะของโค้ดที่คุณเลือก มันจะพยายามครอบคลุมฟังก์ชันหลักและอินพุตทั่วไปบางส่วน หากผลลัพธ์ยังไม่ถูกต้อง คุณสามารถปรับปรุงได้เสมอด้วยคำสั่งเพิ่มเติม เช่น "ตอนนี้เพิ่มการทดสอบเมื่ออินพุตเป็น null"

ใช้การกระทำอัจฉริยะของโปรแกรมแก้ไข

สำหรับช่วงเวลาที่คุณต้องการสร้างการทดสอบโดยไม่ขัดจังหวะการทำงานของคุณ คุณสามารถใช้การกระทำอัจฉริยะได้โดยตรงจากตัวแก้ไขโค้ดของคุณ ซึ่งช่วยให้คุณไม่ต้องสลับไปยังแผงแชท

- ไฮไลต์ฟังก์ชันหรือคลาสที่คุณต้องการทดสอบ

- คลิกขวาที่การเลือกเพื่อเปิดเมนูบริบท

- ไปที่สร้างโค้ดในเมนูบริบทและเลือกสร้างการทดสอบ

Copilot จะสร้างการทดสอบและโดยปกติจะแสดงในแท็บตัวแก้ไขชั่วคราวใหม่ คุณสามารถตรวจสอบโค้ดที่นั่นและเลือกที่จะสร้างไฟล์ทดสอบใหม่หรือเพิ่มการทดสอบลงในไฟล์ที่มีอยู่แล้ว

📚 อ่านเพิ่มเติม:แม่แบบกรณีทดสอบสำหรับการทดสอบซอฟต์แวร์

คำแนะนำสำหรับ GitHub Copilot ในการสร้างกรณีทดสอบ

คำแนะนำของคุณคือพวงมาลัยสำหรับ GitHub Copilot คำแนะนำทั่วไปจะนำไปสู่การทดสอบทั่วไป แต่คำแนะนำที่ออกแบบมาอย่างดีซึ่งให้คำแนะนำเฉพาะกับ AI จะส่งผลให้เกิดกรณีทดสอบที่ครอบคลุมและมีประโยชน์ กุญแจสำคัญคือการบอก Copilot ไม่เพียงแค่ อะไร ที่จะทดสอบ แต่ อย่างไร ที่จะทดสอบมัน

นี่คือแม่แบบบางส่วนที่คุณสามารถปรับใช้กับสถานการณ์ต่าง ๆ ได้:

| สถานการณ์ | แม่แบบข้อความ |

|---|---|

| การทดสอบหน่วยพื้นฐาน | เขียนการทดสอบหน่วยสำหรับฟังก์ชัน [function_name] โดยใช้ [framework] ตรวจสอบให้แน่ใจว่าได้ครอบคลุมข้อมูลนำเข้าปกติ ค่าขอบเขตเช่นศูนย์หรือตัวเลขลบ และข้อมูลนำเข้าที่ไม่ถูกต้องเช่น null หรือ undefined |

| คลาสที่มีส่วนที่ต้องพึ่งพา | สร้างการทดสอบสำหรับคลาส [ClassName] ใช้ [mocking_library] เพื่อสร้าง mock สำหรับการพึ่งพา [DependencyName] และ [AnotherDependencyName] |

| ฟังก์ชันแบบอะซิงโครนัส | "สร้างการทดสอบสำหรับฟังก์ชันแบบอะซิงโครนัสนี้ รวมถึงการทดสอบสำหรับกรณีสำเร็จ กรณีที่พรอมิสถูกปฏิเสธ และสถานการณ์ที่เกิดการหมดเวลาของการร้องขอ" |

| จุดเชื่อมต่อ API | "เขียนการทดสอบการรวมสำหรับจุดสิ้นสุด API นี้ ครอบคลุมการร้องขอ GET ที่สำเร็จ, การร้องขอ POST ที่มีข้อมูลถูกต้อง, การร้องขอที่ไม่มีโทเค็นการตรวจสอบสิทธิ์, และการร้องขอที่มีข้อมูลไม่ถูกต้องซึ่งควรคืนค่าข้อผิดพลาด 400" |

| การตรวจสอบความถูกต้องของข้อมูล | "สร้างการทดสอบสำหรับฟังก์ชันการตรวจสอบนี้ รวมถึงการทดสอบสำหรับวัตถุที่ถูกต้อง และเพิ่มการทดสอบแยกต่างหากสำหรับแต่ละกฎการตรวจสอบที่ล้มเหลวเพื่อให้แน่ใจว่าข้อความแสดงข้อผิดพลาดที่ถูกต้องถูกส่งคืน" |

เคล็ดลับการปรับปรุงคำแนะนำ:

- ระบุกรอบการทำงานให้ชัดเจน: ให้ระบุกรอบการทดสอบเสมอ (เช่น pytest, Jest, JUnit) เพื่อให้แน่ใจว่าไวยากรณ์ถูกต้อง

- กำหนดเป้าหมายการครอบคลุมของคุณ:ใช้เทคนิคการกระตุ้น AIขั้นสูงเพื่อขอการครอบคลุมประเภทเฉพาะ เช่น "กรณีขอบเขต," "การจัดการข้อผิดพลาด," หรือ "การทดสอบขอบเขต"

- อ้างอิงรูปแบบของคุณเอง: หากคุณมีไฟล์ตัวอย่างที่ดี คุณสามารถบอก Copilot ให้ "ทำตามรูปแบบการทดสอบใน tests/test_user.py"

- ขอการยืนยันที่เฉพาะเจาะจง: แทนที่จะปล่อยให้ Copilot เดา คุณสามารถขอให้มัน "ยืนยันว่ามีการยกข้อผิดพลาด ValueError สำหรับข้อมูลนำเข้าที่ไม่ถูกต้อง"

ตัวอย่างการสร้างตัวอย่างทดสอบของ GitHub Copilot

นี่คือวิธีการทำงานในทางปฏิบัติ

สร้างการทดสอบหน่วยใน Python

จินตนาการว่าคุณมีฟังก์ชัน Python ที่คำนวณราคาทั้งหมดของสินค้าในรถเข็นช้อปปิ้ง รวมถึงส่วนลด

ตัวอย่างฟังก์ชันที่ต้องการทดสอบ:

ข้อความที่ใช้: "เขียนการทดสอบ pytest สำหรับ calculate_total ให้ครอบคลุมกรณีรายการว่าง รายการเดียว หลายรายการ การลดราคา การลดราคา 0% การลดราคา 100% และเปอร์เซ็นต์ส่วนลดที่ไม่ถูกต้องซึ่งควรทำให้เกิด ValueError"

ผลลัพธ์การทดสอบที่สร้างขึ้น:

Copilot ใช้ pytest ได้อย่างถูกต้อง ใช้ raises เพื่อตรวจสอบข้อยกเว้นและครอบคลุมสถานการณ์หลักแล้ว คุณอาจต้องการเพิ่มการทดสอบสำหรับราคาหรือปริมาณที่เป็นลบเป็นการปรับปรุงเพิ่มเติมด้วยตนเอง

สร้างการทดสอบหน่วยใน TypeScript ด้วย Jest

ตอนนี้ มาลองใช้ฟังก์ชัน TypeScript ที่จัดรูปแบบชื่อผู้ใช้กัน

ตัวอย่างฟังก์ชันที่ต้องการทดสอบ:

ข้อความที่ใช้: "สร้าง Jest tests สำหรับ formatDisplayName. ครอบคลุมผู้ใช้ที่มีชื่อและนามสกุล, ผู้ใช้ที่มีชื่อเล่น, ผู้ใช้ที่มีชื่อแรกว่างเปล่า, และผู้ใช้ที่มีเพียงชื่อเล่นเท่านั้น"

ผลลัพธ์การทดสอบที่สร้างขึ้น:

การทดสอบที่สร้างขึ้นใช้การอธิบายมาตรฐานและบล็อกจาก Jest และจัดการเส้นทางตรรกะที่แตกต่างกันได้อย่างถูกต้อง

แนวทางปฏิบัติที่ดีที่สุดสำหรับการสร้างการทดสอบด้วย GitHub Copilot

การใช้ Copilot สำหรับการสร้างแบบทดสอบช่วยเพิ่มประสิทธิภาพการทำงานอย่างมาก แต่จำเป็นต้องมีการตรวจสอบอย่างรอบคอบเพื่อให้มั่นใจในคุณภาพ

- ตรวจสอบทุกการทดสอบ: นี่คือกฎทอง Copilot ไม่เข้าใจตรรกะทางธุรกิจของคุณ ดังนั้นมันอาจสร้างการทดสอบที่ผ่านแต่ยืนยันสิ่งที่ผิดได้เสมอ อ่านโค้ดที่สร้างขึ้นทุกครั้งและถามตัวเองว่า "นี่เป็นการตรวจสอบพฤติกรรมที่ถูกต้องจริงหรือไม่?"

- ตรวจสอบความครอบคลุมของกรณีขอบเขตด้วยตนเอง: Copilot มีความสามารถในการตรวจจับกรณีขอบเขตทั่วไป เช่น ข้อมูลนำเข้าที่เป็นค่าว่างหรือสตริงว่าง แต่บางครั้งอาจพลาดกรณีเฉพาะของโดเมน สำหรับแอปอีคอมเมิร์ซ Copilot ได้ทดสอบหรือไม่ว่าเกิดอะไรขึ้นเมื่อยอดรวมในรถเข็นเท่ากับขั้นต่ำสำหรับการจัดส่งฟรีพอดี? คุณยังคงเป็นผู้เชี่ยวชาญ

- รักษาความสอดคล้องของรูปแบบการตั้งชื่อ: ชื่อการทดสอบที่สร้างโดย AI อาจเป็นชื่อทั่วไปได้ ให้ใช้เวลาสักครู่เพื่อเปลี่ยนชื่อให้ตรงกับสไตล์ของทีมคุณ ชื่อที่อธิบายได้ชัดเจน เช่น test_login_fails_with_incorrect_password มีประโยชน์มากกว่า test_login_2

- รันการทดสอบทันที: อย่าปล่อยให้การทดสอบที่สร้างไว้ไม่ได้รับการรันดำเนินการทดสอบทันทีเพื่อตรวจจับข้อผิดพลาดทางไวยากรณ์หรือการยืนยันที่ล้มเหลวอย่างชัดเจนก่อนที่คุณจะทำการคอมมิตโค้ด

- ผสานรวมกับ CI/CD: เพิ่มการทดสอบที่สร้างขึ้นไปยังกระบวนการรวมต่อเนื่องของคุณ การทดสอบที่รันเฉพาะในเครื่องเท่านั้นจะมีคุณค่าจำกัด

- ระวังการทดสอบที่ไม่เสถียร: บางครั้ง AI อาจสร้างการทดสอบที่ "ไม่เสถียร" ได้—บางครั้งผ่านการทดสอบแต่บางครั้งก็ล้มเหลว ปัญหานี้มักเกิดขึ้นกับการทดสอบที่เกี่ยวข้องกับเวลาหรือข้อมูลสุ่ม ควรแทนที่ค่าเหล่านี้ด้วยค่าที่แน่นอนและสามารถคาดการณ์ได้เสมอ

📮ClickUp Insight: แบบสำรวจของเราแสดงให้เห็นว่าในขณะที่ 34% ของผู้ใช้มีความมั่นใจอย่างเต็มที่ในระบบ AI แต่กลุ่มที่ใหญ่กว่าเล็กน้อย (38%) ยังคงใช้แนวทาง "เชื่อแต่ต้องตรวจสอบ" เครื่องมือที่ทำงานแบบเดี่ยวและไม่คุ้นเคยกับบริบทการทำงานของคุณ มักมีความเสี่ยงสูงที่จะให้ผลลัพธ์ที่ไม่ถูกต้องหรือไม่เป็นที่น่าพอใจ

นี่คือเหตุผลที่เราสร้าง ClickUp Brain, AI ที่เชื่อมต่อการจัดการโครงการ, การจัดการความรู้, และการร่วมมือของคุณผ่านพื้นที่ทำงานและเครื่องมือของบุคคลที่สามที่ผสานรวมไว้. รับคำตอบตามบริบทโดยไม่ต้องสลับไปมา และเพิ่มประสิทธิภาพการทำงานของคุณได้ถึง 2-3 เท่า เช่นเดียวกับลูกค้าของเราที่ Seequent.

ข้อจำกัดของการใช้ GitHub Copilot สำหรับการสร้างกรณีทดสอบ

แม้ว่า GitHub Copilot จะเป็นเครื่องมือที่ช่วยเพิ่มประสิทธิภาพการทำงานอย่างมาก แต่ก็ไม่ใช่ทางออกที่สมบูรณ์แบบสำหรับการทดสอบซอฟต์แวร์ การเข้าใจข้อจำกัดของมันเป็นสิ่งสำคัญในการใช้งานอย่างมีประสิทธิภาพและหลีกเลี่ยงข้อผิดพลาดที่พบบ่อย มันเป็นเพียง "ผู้ช่วย" ไม่ใช่ "นักบิน"—คุณยังคงเป็นผู้ควบคุมแผนการบินอยู่

ข้อจำกัดที่ใหญ่ที่สุดคือการขาดบริบททางธุรกิจ Copilot วิเคราะห์โครงสร้างของโค้ดของคุณ แต่ไม่มีความเข้าใจว่าแอปพลิเคชันของคุณควรทำอะไรให้กับผู้ใช้ของคุณจริงๆ มันไม่สามารถรู้ได้ว่าผู้ใช้ "พรีเมียม" ควรเข้าถึงฟีเจอร์บางอย่างในขณะที่ผู้ใช้ "พื้นฐาน" ไม่ควรเข้าถึง เว้นแต่ตรรกะนั้นจะชัดเจนในโค้ดที่มันกำลังอ่าน

นี่คือข้อจำกัดสำคัญอื่น ๆ ที่ควรคำนึงถึง:

- อาจพลาดกรณีขอบเขตที่สำคัญเฉพาะด้าน: Copilot มีความสามารถในการค้นหาขอบเขตทั่วไปได้ดี แต่จะไม่รู้จักกรณีแปลกๆ ที่เฉพาะเจาะจงกับอุตสาหกรรมของคุณ เช่น การคำนวณทางการเงินที่ต้องจัดการกับปีอธิกสุรทินแตกต่างออกไป

- ไม่มีการเข้าถึงระบบภายนอก: Copilot ไม่สามารถสร้างการทดสอบการผสานรวมที่มีความหมายสำหรับฐานข้อมูลของคุณหรือ API ของบุคคลที่สามได้ เนื่องจากไม่สามารถเชื่อมต่อกับระบบเหล่านั้นได้ Copilot สามารถสร้างโครงสร้างโค้ดเบื้องต้นได้ แต่คุณจะต้องกรอกรายละเอียดเพิ่มเติมเอง

- มันอาจสร้างความมั่นใจที่ผิดพลาด: การเห็นการครอบคลุมการทดสอบ 100% อาจรู้สึกดี แต่หากการทดสอบกำลังยืนยันสิ่งที่ผิด ตัวเลขการครอบคลุมนั้นก็ไร้ความหมาย นี่คือเหตุผลที่การตรวจสอบโดยมนุษย์มีความสำคัญมาก

- ข้อจำกัดของหน้าต่างบริบท: ไฟล์ขนาดใหญ่มากหรือลำดับชั้นของคลาสที่ซับซ้อนอาจเกินขอบเขตของหน้าต่างบริบทของ Copilot ส่งผลให้คำแนะนำไม่สมบูรณ์หรือเป็นแบบทั่วไป

📚 อ่านเพิ่มเติม:วิธีใช้ GitHub Copilot สำหรับการพัฒนาแบ็กเอนด์

วิธีสร้างและจัดการกรณีทดสอบใน ClickUp

การสร้างกรณีทดสอบด้วย GitHub Copilot เป็นเพียงครึ่งหนึ่งของกระบวนการทำงานเท่านั้น เมื่อมีกรณีทดสอบแล้ว ทีมงานยังคงต้องติดตาม ติดตามกลับไปยังข้อกำหนด และจัดการการดำเนินการข้ามสปรินต์และการเผยแพร่

ClickUp มอบพื้นที่ทำงานแบบรวมศูนย์ที่กรณีทดสอบที่สร้างโดย AI สามารถอยู่ร่วมกับงานพัฒนา, ข้อบกพร่อง, และแผนสปรินต์ได้—ทำให้การทดสอบไม่ถูกจำกัดอยู่ภายใน IDE ของแต่ละบุคคล

ClickUpทำหน้าที่เป็นพื้นที่ทำงาน AI แบบรวมศูนย์ นำการจัดการโครงการ เอกสาร และการสื่อสารของทีมมารวมไว้ในระบบเดียว สำหรับทีมซอฟต์แวร์ นี่หมายความว่าการจัดการกรณีทดสอบไม่จำเป็นต้องเป็นเครื่องมือหรือสเปรดชีตแยกอีกต่อไป

การทดสอบ ข้อกำหนด คำขอการดึง และการสนทนาเกี่ยวกับการปล่อยเวอร์ชันทั้งหมดยังคงเชื่อมโยงกันลดการกระจายของบริบทและทำให้ QA เป็นส่วนสำคัญของกระบวนการส่งมอบ

เทมเพลตกรณีทดสอบของ ClickUpถูกออกแบบมาเพื่อช่วยให้คุณติดตามความคืบหน้าของกรณีทดสอบได้อย่างง่ายดาย:

- ตรวจสอบผลการทดสอบและตัดสินใจเกี่ยวกับการแก้ไขข้อบกพร่องโดยใช้ข้อมูลเป็นพื้นฐาน

- พัฒนาแผนการทดสอบที่กำหนดเองสำหรับแต่ละโครงการ

- จัดระเบียบและจัดลำดับความสำคัญของกรณีทดสอบเพื่อประสิทธิภาพสูงสุด

เริ่มต้นด้วยการสร้างรายการ ClickUpที่เฉพาะเจาะจงเพื่อใช้เป็นคลังกรณีทดสอบของคุณ แต่ละกรณีทดสอบ ไม่ว่าจะสร้างโดย AI หรือเขียนด้วยตนเอง จะกลายเป็นงานหนึ่ง

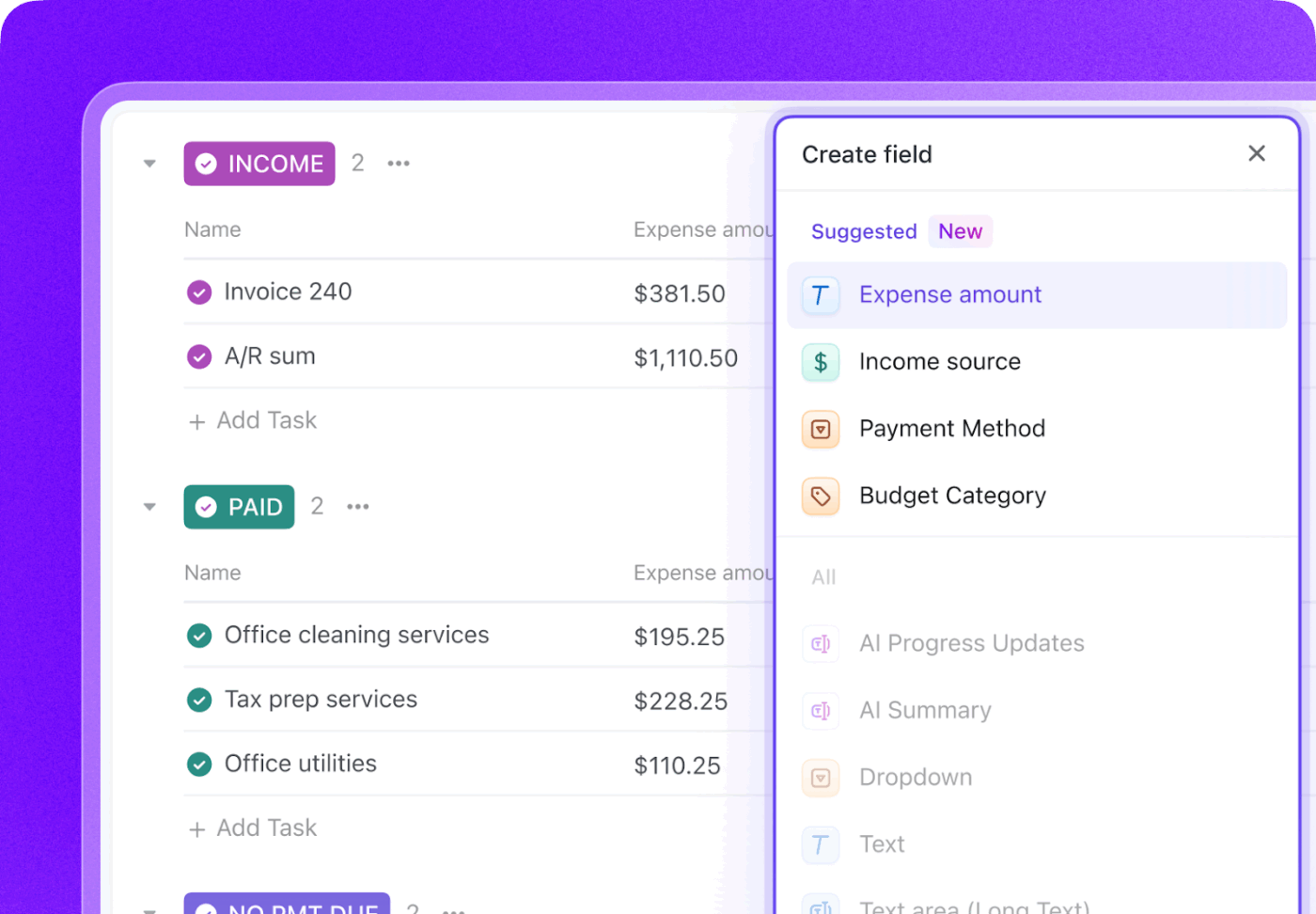

เพิ่มข้อมูลเมตาที่สำคัญในแต่ละกรณีทดสอบโดยใช้ฟิลด์กำหนดเองของ ClickUpเพื่อติดตามสิ่งที่สำคัญต่อทีมของคุณอย่างแม่นยำ

- ประเภทการทดสอบ: แบบดรอปดาวน์สำหรับ หน่วย, การผสาน, ปลายทางถึงปลายทาง, หรือด้วยตนเอง

- สถานะการทำงานอัตโนมัติ: สถานะที่แสดงว่าการทดสอบเป็นแบบอัตโนมัติหรือไม่

- ลำดับความสำคัญ: สูง, ปานกลาง, หรือ ต่ำ

- วันที่รันครั้งล่าสุด: ช่องวันที่สำหรับติดตามวันที่ทดสอบครั้งล่าสุด

ติดตามวงจรการทดสอบทั้งหมดของคุณด้วยสถานะที่กำหนดเองใน ClickUpโดยการสร้างเวิร์กโฟลว์ที่ทดสอบจากสถานะ "ยังไม่ได้ดำเนินการ" ไปยัง "ผ่าน" "ไม่ผ่าน" หรือ "ถูกบล็อก" ซึ่งจะทำให้ทุกคนในทีม ตั้งแต่ผู้พัฒนาไปจนถึงผู้จัดการผลิตภัณฑ์ สามารถมองเห็นความคืบหน้าของการทดสอบได้ทันที

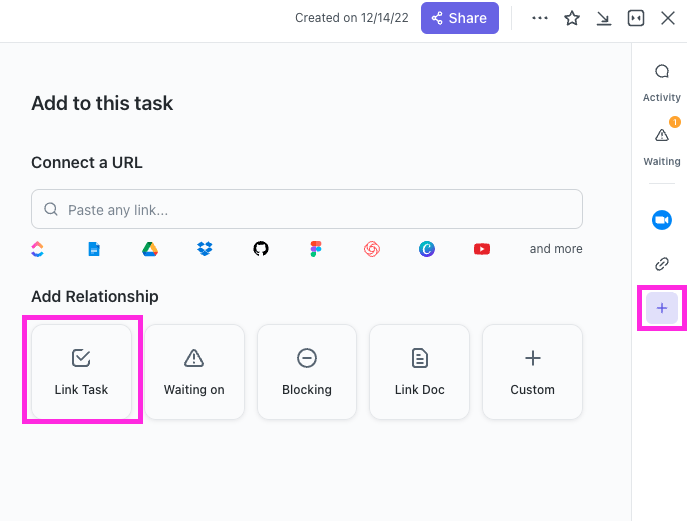

ด้วยClickUp Relationships คุณสามารถเชื่อมโยงงานทดสอบเคสโดยตรงกับเรื่องราวผู้ใช้ ฟีเจอร์ หรืออีปิคได้ หากการทดสอบล้มเหลวคุณสามารถสร้างงานรายงานข้อบกพร่องและเชื่อมโยงกลับไปยังทั้งการทดสอบที่ล้มเหลวและเรื่องราวต้นฉบับได้ สร้างห่วงโซ่การติดตามที่สมบูรณ์

ร่างรายงานข้อบกพร่องได้ในไม่กี่วินาทีโดยชี้ไปที่งานกรณีทดสอบที่ล้มเหลวในClickUp Brainเนื่องจากมันมีบริบทของทั้งพื้นที่ทำงานของคุณ มันจึงสามารถดึงรายละเอียดจากเรื่องราวผู้ใช้ที่เชื่อมโยงและกรณีทดสอบเองได้

🌟แม่แบบรายงานการทดสอบของ ClickUpช่วยให้คุณสามารถสร้างรายงานได้รวดเร็วยิ่งขึ้น พร้อมทั้งมั่นใจว่าคุณสามารถระบุและแก้ไขปัญหาที่ต้องปรับปรุงได้อย่างครบถ้วน

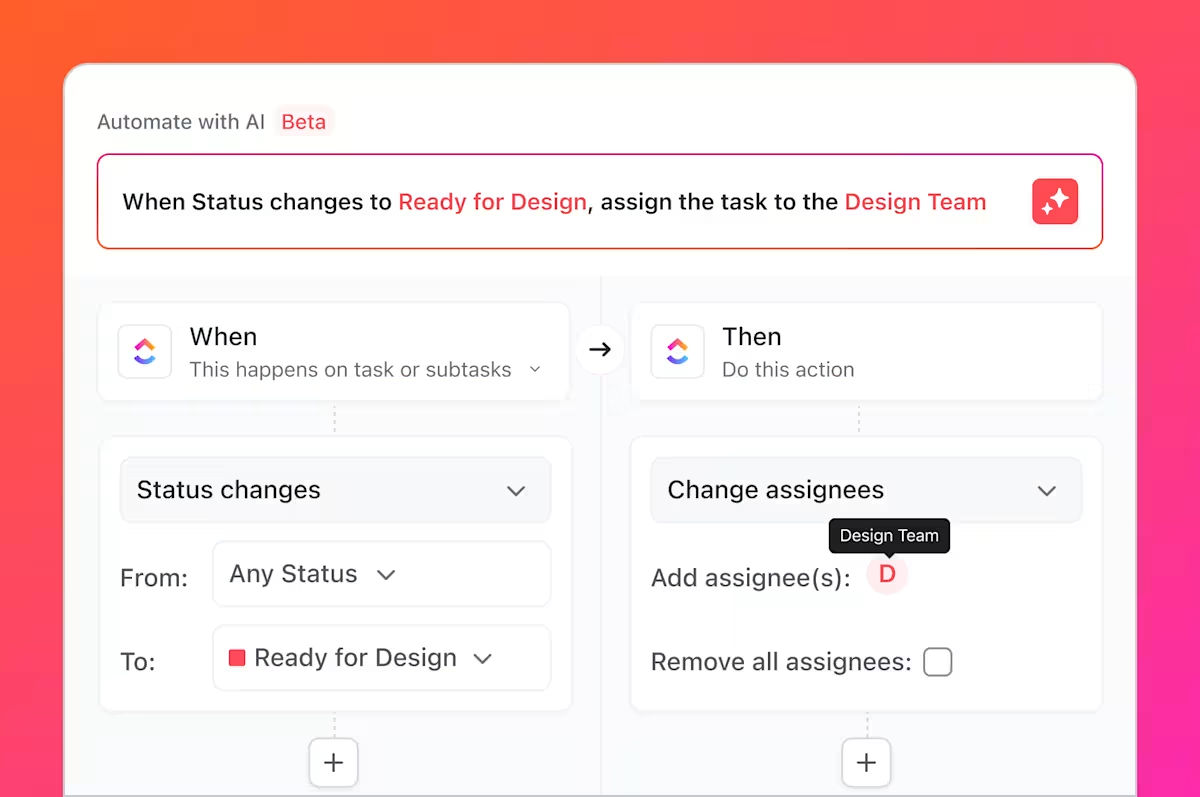

แต่นั่นไม่ใช่ทั้งหมดที่คุณทำได้ คุณรู้ไหมว่างานยุ่งๆ ทั้งหมดที่เราพูดถึง งานที่น่าเบื่อและซ้ำซากที่การทดสอบมักเกี่ยวข้องอยู่เสมอ? คุณสามารถทำให้สิ่งเหล่านี้เป็นอัตโนมัติได้โดยใช้ClickUp Automations

ตั้งกฎเช่น "เมื่อสถานะของกรณีทดสอบถูกเปลี่ยนเป็นล้มเหลว ให้สร้างงานใหม่ในรายการข้อบกพร่องโดยอัตโนมัติและมอบหมายให้กับนักพัฒนาหลัก"

โดยการผสานGitHub เข้ากับ ClickUp งานทดสอบกรณีต่างๆ สามารถเชื่อมโยงกับการเปลี่ยนแปลงและการขอดึงโค้ดได้ เมื่อมีการผสานการเปลี่ยนแปลงโค้ด งานทดสอบที่เกี่ยวข้องจะอัปเดตโดยอัตโนมัติ ทำให้ทีม QA นักพัฒนา และผู้จัดการการปล่อยเวอร์ชันสามารถติดตามการเปลี่ยนแปลงและสิ่งที่ต้องทดสอบซ้ำได้อย่างสอดคล้องกัน

แดชบอร์ดของ ClickUpช่วยให้คุณสามารถติดตามความคืบหน้าของการทดสอบแบบเรียลไทม์, แสดงจำนวนข้อบกพร่อง, การดำเนินการทดสอบกรณี, และอื่น ๆ ได้

เวิร์กโฟลว์นี้ร่วมกันเชื่อมช่องว่างระหว่าง การทดสอบที่สร้างโดย AI ใน GitHub Copilot และ การจัดการกรณีทดสอบทั่วทั้งทีม ใน ClickUp—มอบระบบเดียวให้กับทีมในการวางแผน ติดตาม อัตโนมัติ และปรับปรุงกระบวนการ QA โดยไม่ต้องประสานงานด้วยตนเองอย่างต่อเนื่อง

ชมวิดีโอนี้เพื่อรับคำแนะนำเกี่ยวกับการสร้างกระบวนการบริหารการปล่อยเวอร์ชันที่มีประสิทธิภาพ:

ทำให้การจัดการกรณีทดสอบง่ายขึ้นด้วย ClickUp

แบบทดสอบที่สร้างโดย AI ไม่ใช่เพียงแค่องค์ประกอบแยกส่วนอีกต่อไป แต่เป็นส่วนประกอบที่ผสานรวมเข้ากับกระบวนการพัฒนาของคุณอย่างสมบูรณ์ สามารถมองเห็น ติดตาม และนำไปปฏิบัติได้สำหรับทุกคนในทีม

GitHub Copilot สร้างกรณีทดสอบได้อย่างรวดเร็ว แต่ความเร็วเพียงอย่างเดียวไม่ได้รับประกันคุณภาพ หากไม่มีการเป็นเจ้าของที่ชัดเจน การติดตามข้อกำหนด และการมองเห็นที่ครอบคลุมทุกสปรินต์ แม้แต่การทดสอบที่เขียนมาอย่างดีก็อาจล้าสมัยหรือถูกมองข้ามได้ นั่นคือเหตุผลที่ระบบบันทึกข้อมูลมีความสำคัญ

ด้วยการจัดการกรณีทดสอบใน ClickUp ทีมงานสามารถเปลี่ยนผลลัพธ์ที่สร้างโดย AI ให้เป็นกระบวนการ QA ที่ทำซ้ำได้ ซึ่งเชื่อมโยงการทดสอบกับข้อกำหนด การเปลี่ยนแปลงโค้ด และกำหนดการปล่อยเวอร์ชัน แทนที่จะต้องจัดการกับเครื่องมือหลายอย่างและอัปเดตด้วยตนเอง ทีมงาน QA และวิศวกรรมสามารถทำงานจากพื้นที่ทำงานร่วมกันที่มีบริบทครบถ้วน ผลลัพธ์ที่ได้ไม่ใช่แค่การทดสอบที่มากขึ้นเท่านั้น แต่ยังรวมถึงความมั่นใจในสิ่งที่กำลังส่งมอบและเหตุผลเบื้องหลังอีกด้วย

พร้อมที่จะจัดการกรณีทดสอบของคุณควบคู่ไปกับสปรินต์และการปล่อยเวอร์ชันของคุณหรือยัง?เริ่มต้นใช้งานฟรีกับ ClickUpวันนี้

คำถามที่พบบ่อย

ใช่ Copilot สามารถวิเคราะห์โครงสร้างและตรรกะของโค้ดเก่าเพื่อสร้างพื้นฐานของการทดสอบได้ อย่างไรก็ตาม การทดสอบเหล่านี้อาจต้องการการตรวจสอบและปรับปรุงด้วยมืออย่างมาก เนื่องจาก AI จะไม่มีบริบทเกี่ยวกับพฤติกรรมที่ไม่มีการบันทึกหรือกฎทางธุรกิจในอดีต

ความถูกต้องทางไวยากรณ์นั้นสูงมาก แต่ความถูกต้องทางตรรกะขึ้นอยู่กับ ความชัดเจนของโค้ดของคุณ และความเฉพาะเจาะจงของคำสั่งของคุณเสมอ ตรวจสอบการยืนยันเพื่อให้แน่ใจว่าพวกมันกำลังตรวจสอบความต้องการทางธุรกิจที่มีความหมาย ไม่ใช่เพียงแค่ยืนยันการนำไปใช้ในปัจจุบัน (ซึ่งอาจมีความผิดพลาด)

ใช่ Copilot มีการสนับสนุนที่ยอดเยี่ยมสำหรับ pytest, unittest และเฟรมเวิร์กการทดสอบ Python ยอดนิยมอื่นๆ มันมีความสามารถในการจดจำและทำซ้ำรูปแบบที่มีอยู่ในโปรเจกต์ของคุณ เช่น การใช้ fixtures หรือการทดสอบแบบพารามิเตอร์

ทีมที่มีประสิทธิภาพใช้แพลตฟอร์มการจัดการโครงการแบบรวมศูนย์เพื่อจัดการชุดทดสอบของพวกเขา โดยการติดตามแต่ละกรณีทดสอบเป็นงานที่มีข้อมูลเมตาที่กำหนดเองสำหรับสถานะและความสำคัญ พวกเขาจะได้รับความชัดเจนในความครอบคลุมและผลลัพธ์ของการดำเนินการ ซึ่งเชื่อมโยงกระบวนการ QA เข้ากับการวางแผนสปรินต์และการติดตามข้อบกพร่องโดยตรง