ทีมองค์กรส่วนใหญ่ที่กำลังสำรวจ LLaMA มักจะติดอยู่ที่จุดเดียวกัน: พวกเขาดาวน์โหลดน้ำหนักของโมเดล, จ้องมองที่หน้าต่างเทอร์มินัล, และตระหนักว่าพวกเขาไม่มีความคิดว่าจะทำอะไรต่อไป

ความท้าทายนี้แพร่หลายอย่างกว้างขวาง—ในขณะที่ 88% ของบริษัทใช้ AI ในอย่างน้อยหนึ่งฟังก์ชันแต่มีเพียง 7% เท่านั้นที่ได้ขยายการใช้งานไปทั่วทั้งองค์กร

คู่มือนี้จะนำคุณผ่านกระบวนการทั้งหมด ตั้งแต่การเลือกขนาดโมเดลที่เหมาะสมกับกรณีการใช้งานของคุณ ไปจนถึงการปรับแต่งโมเดลบนข้อมูลของบริษัทคุณ เพื่อให้คุณสามารถนำไปใช้เป็นโซลูชัน AI ที่ทำงานได้จริงและเข้าใจบริบททางธุรกิจของคุณอย่างแท้จริง

LLaMA คืออะไรและทำไมจึงมีความสำคัญต่อ AI สำหรับองค์กร?

LLaMA (ย่อมาจาก Large Language Model Meta AI) เป็นตระกูลของโมเดลภาษาแบบน้ำหนักเปิดที่สร้างโดย Meta ในระดับสูง มันทำสิ่งหลักๆเหมือนกับโมเดลอย่าง GPTหรือ Gemini: มันเข้าใจภาษา สร้างข้อความ และสามารถให้เหตุผลข้ามข้อมูลได้ ความแตกต่างใหญ่คือ วิธีการ ที่องค์กรสามารถใช้มันได้

เนื่องจาก LLaMA เป็นแบบเปิดน้ำหนัก บริษัทต่างๆ จึงไม่จำเป็นต้องโต้ตอบกับมันผ่าน API แบบกล่องดำเท่านั้น พวกเขาสามารถรันมันบนโครงสร้างพื้นฐานของตนเอง ปรับแต่งให้เหมาะสมกับข้อมูลภายใน และควบคุมวิธีการและสถานที่ที่นำไปใช้งานได้

สำหรับองค์กร นั่นเป็นเรื่องใหญ่มาก—โดยเฉพาะอย่างยิ่งเมื่อความเป็นส่วนตัวของข้อมูล การปฏิบัติตามกฎระเบียบ และความคาดการณ์ได้ของต้นทุนมีความสำคัญมากกว่าความแปลกใหม่

ความยืดหยุ่นนี้ทำให้ LLaMA เป็นตัวเลือกที่น่าสนใจเป็นพิเศษสำหรับทีมที่ต้องการฝัง AI เข้าไปในกระบวนการทำงานอย่างลึกซึ้ง ไม่ใช่แค่ติดตั้งเป็นแชทบอทแยกต่างหาก ลองนึกถึงผู้ช่วยความรู้ภายในองค์กร ระบบอัตโนมัติสำหรับการสนับสนุนลูกค้า เครื่องมือสำหรับนักพัฒนา หรือฟีเจอร์ AI ที่ผสานเข้ากับผลิตภัณฑ์โดยตรง—โดยไม่ต้องส่งข้อมูลสำคัญออกนอกองค์กร

โดยสรุป LLaMA มีความสำคัญต่อ AI ในองค์กรเพราะมันมอบ ทางเลือก ให้กับทีมในการปรับใช้, ปรับแต่ง, และผสานรวม AI เข้ากับระบบธุรกิจจริง และเมื่อ AI เคลื่อนจากการทดลองไปสู่การดำเนินงานประจำวัน ระดับการควบคุมนี้จะไม่เป็นเพียง "สิ่งที่ดีหากมี" แต่จะกลายเป็นข้อกำหนดที่จำเป็น

วิธีเริ่มต้นใช้งาน LLaMA สำหรับแอปพลิเคชันองค์กร

1. กำหนดกรณีการใช้งานขององค์กรของคุณ

ก่อนที่คุณจะดาวน์โหลดอะไร ให้ระบุขั้นตอนการทำงานที่ AI สามารถสร้างผลกระทบได้จริง จับคู่กรณีการใช้งาน AIกับขนาดของโมเดลให้เหมาะสม—โมเดลขนาดเล็ก 8B เหมาะสำหรับงานง่าย ๆ ในขณะที่โมเดลขนาดใหญ่ 70B+ เหมาะสำหรับการให้เหตุผลที่ซับซ้อน

เพื่อช่วยให้คุณระบุแอปพลิเคชัน AIที่เหมาะสมสำหรับธุรกิจของคุณ โปรดชมภาพรวมกรณีศึกษาการใช้งาน AI ในทางปฏิบัติที่ครอบคลุมหลากหลายฟังก์ชันขององค์กรและอุตสาหกรรมต่างๆ:

จุดเริ่มต้นทั่วไปได้แก่:

- การประมวลผลเอกสาร: สรุปรายงานยาวหรือสกัดข้อมูลสำคัญจากสัญญา

- ความช่วยเหลือด้านโค้ด:สร้างโค้ดมาตรฐานทั่วไป อธิบายระบบเดิม หรือแนะนำวิธีการปรับปรุงประสิทธิภาพ

- การเรียกคืนความรู้: การตอบคำถามของพนักงานโดยการค้นหาเอกสารภายในองค์กรด้วยเทคนิคที่เรียกว่าการเสริมสร้างการเรียกคืนข้อมูล (Retrieval-Augmented Generation - RAG)

- การสร้างเนื้อหา: การร่างข้อความสื่อสารเบื้องต้นหรือข้อความทางการตลาด

2. ตั้งค่าข้อกำหนดเบื้องต้นและสิ่งที่ต้องพึ่งพา

ต่อไป จัดเตรียมฮาร์ดแวร์และซอฟต์แวร์ให้พร้อม ขนาดของโมเดลจะเป็นตัวกำหนดความต้องการของคุณ โมเดล LLaMA 8B ต้องการ GPU ที่มี VRAM ประมาณ 15GB ในขณะที่โมเดล 70B ต้องการ 131GB หรือมากกว่า

ซอฟต์แวร์ของคุณควรประกอบด้วย Python 3. 8+, PyTorch, ไดรเวอร์ CUDA และระบบนิเวศของ Hugging Face (transformers, accelerate และ bitsandbytes)

3. เข้าถึงและดาวน์โหลดน้ำหนักของโมเดล LLaMA

คุณสามารถรับค่าพารามิเตอร์ของโมเดลได้จากหน้าดาวน์โหลด Llamaอย่างเป็นทางการของ Meta หรือศูนย์รวมโมเดลของHugging Faceคุณจะต้องยอมรับใบอนุญาต Llama 3 Community License ซึ่งอนุญาตให้ใช้งานในเชิงพาณิชย์ได้ ขึ้นอยู่กับการตั้งค่าของคุณ คุณจะต้องดาวน์โหลดค่าพารามิเตอร์ในรูปแบบ safetensors หรือ GGUF

4. กำหนดค่าสภาพแวดล้อมการพัฒนาของคุณ

เมื่อดาวน์โหลดน้ำหนักเสร็จแล้ว ก็ถึงเวลาที่จะตั้งค่าสภาพแวดล้อมของคุณ ติดตั้งไลบรารี Python ที่จำเป็น รวมถึง transformers, accelerate และ bitsandbytes สำหรับการควอนไทซ์—กระบวนการที่ช่วยลดการใช้หน่วยความจำของโมเดล

โหลดโมเดลพร้อมการตั้งค่าที่ถูกต้อง และรันคำสั่งทดสอบง่าย ๆ เพื่อให้แน่ใจว่าทุกอย่างทำงานอย่างถูกต้อง ก่อนที่คุณจะดำเนินการปรับแต่งต่อไป

💡หากคุณไม่มีทีมโครงสร้างพื้นฐานเฉพาะสำหรับ ML กระบวนการทั้งหมดนี้อาจไม่สามารถเริ่มต้นได้เลย ข้ามความซับซ้อนในการปรับใช้ทั้งหมดด้วยClickUp Brain ซึ่งมอบความสามารถของ AI เช่นการช่วยเขียนและการทำงานอัตโนมัติของงานโดยตรงภายในพื้นที่ทำงานที่ทีมของคุณใช้งานอยู่แล้ว—ไม่ต้องดาวน์โหลดโมเดลหรือจัดเตรียม GPU แต่อย่างใด

วิธีปรับแต่ง LLaMA สำหรับข้อมูลองค์กรของคุณ

การใช้โมเดล LLaMA พื้นฐานเป็นจุดเริ่มต้นที่ดี แต่โมเดลนี้จะไม่สามารถเข้าใจคำย่อเฉพาะของบริษัท ชื่อโครงการ หรือกระบวนการภายในของคุณได้ ส่งผลให้คำตอบที่ได้เป็นแบบทั่วไป ไม่เป็นประโยชน์ และไม่สามารถแก้ไขปัญหาทางธุรกิจที่แท้จริงได้

ปัญญาประดิษฐ์สำหรับองค์กรกลายเป็นประโยชน์ผ่านการปรับแต่ง—การฝึกฝนโมเดลให้เข้าใจคำศัพท์เฉพาะและฐานความรู้ของคุณ

เตรียมข้อมูลการฝึกอบรมเฉพาะทางของคุณ

ความสำเร็จของ AI ที่คุณปรับแต่งเองขึ้นอยู่กับความคุณภาพของข้อมูลการฝึกอบรมมากกว่าขนาดของแบบจำลองหรือกำลังการคำนวณ. ให้เริ่มต้นด้วยการรวบรวมและทำความสะอาดข้อมูลภายในของคุณ.

- เอกสารภายใน: รวบรวมข้อมูลจำเพาะของผลิตภัณฑ์, คู่มือกระบวนการ, และเอกสารนโยบาย

- การสื่อสารทางประวัติศาสตร์: รวบรวมเทมเพลตอีเมล, คำตอบของตั๋วสนับสนุน, และสรุปการประชุม

- คำศัพท์เฉพาะทางโดเมน: รวบรวมอภิธานศัพท์ คำย่อ และภาษาเฉพาะทางอุตสาหกรรม

เมื่อรวบรวมข้อมูลแล้ว ให้จัดรูปแบบข้อมูลนี้เป็นคู่ของคำสั่งและการตอบสนองสำหรับการปรับแต่งอย่างใกล้ชิดภายใต้การดูแล ตัวอย่างเช่น คำสั่งอาจเป็น "สรุปตั๋วสนับสนุนนี้" และการตอบสนองจะเป็นบทสรุปที่ชัดเจนและกระชับ ขั้นตอนนี้มีความสำคัญอย่างยิ่งในการสอนโมเดลให้ทำงานเฉพาะเจาะจงกับข้อมูลของคุณ

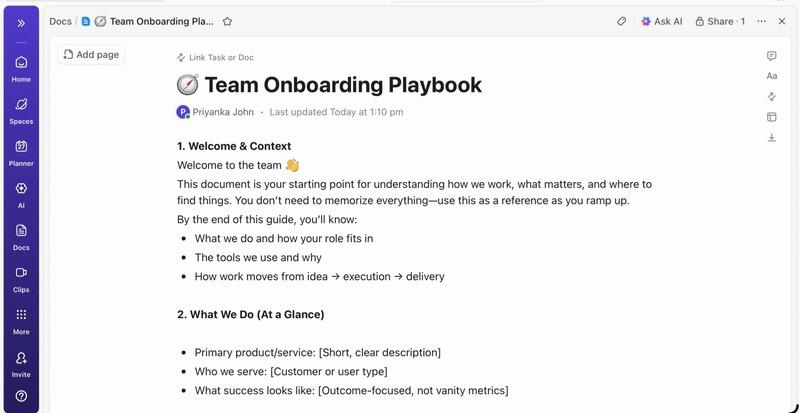

📮 ClickUp Insight: มืออาชีพโดยเฉลี่ยใช้เวลา 30 นาทีขึ้นไปต่อวันในการค้นหาข้อมูลที่เกี่ยวข้องกับงาน—นั่นคือมากกว่า 120 ชั่วโมงต่อปีที่สูญเสียไปกับการค้นหาอีเมล, กระทู้ใน Slack และไฟล์ที่กระจัดกระจาย ผู้ช่วย AI ที่ชาญฉลาดซึ่งฝังอยู่ในพื้นที่ทำงานของคุณสามารถเปลี่ยนแปลงสิ่งนี้ได้

เข้าสู่ ClickUp Brain. มอบข้อมูลเชิงลึกและคำตอบทันทีโดยการค้นหาเอกสาร, การสนทนา, และรายละเอียดของงานที่เหมาะสมในไม่กี่วินาที—เพื่อให้คุณสามารถหยุดการค้นหาและเริ่มทำงานได้ทันที

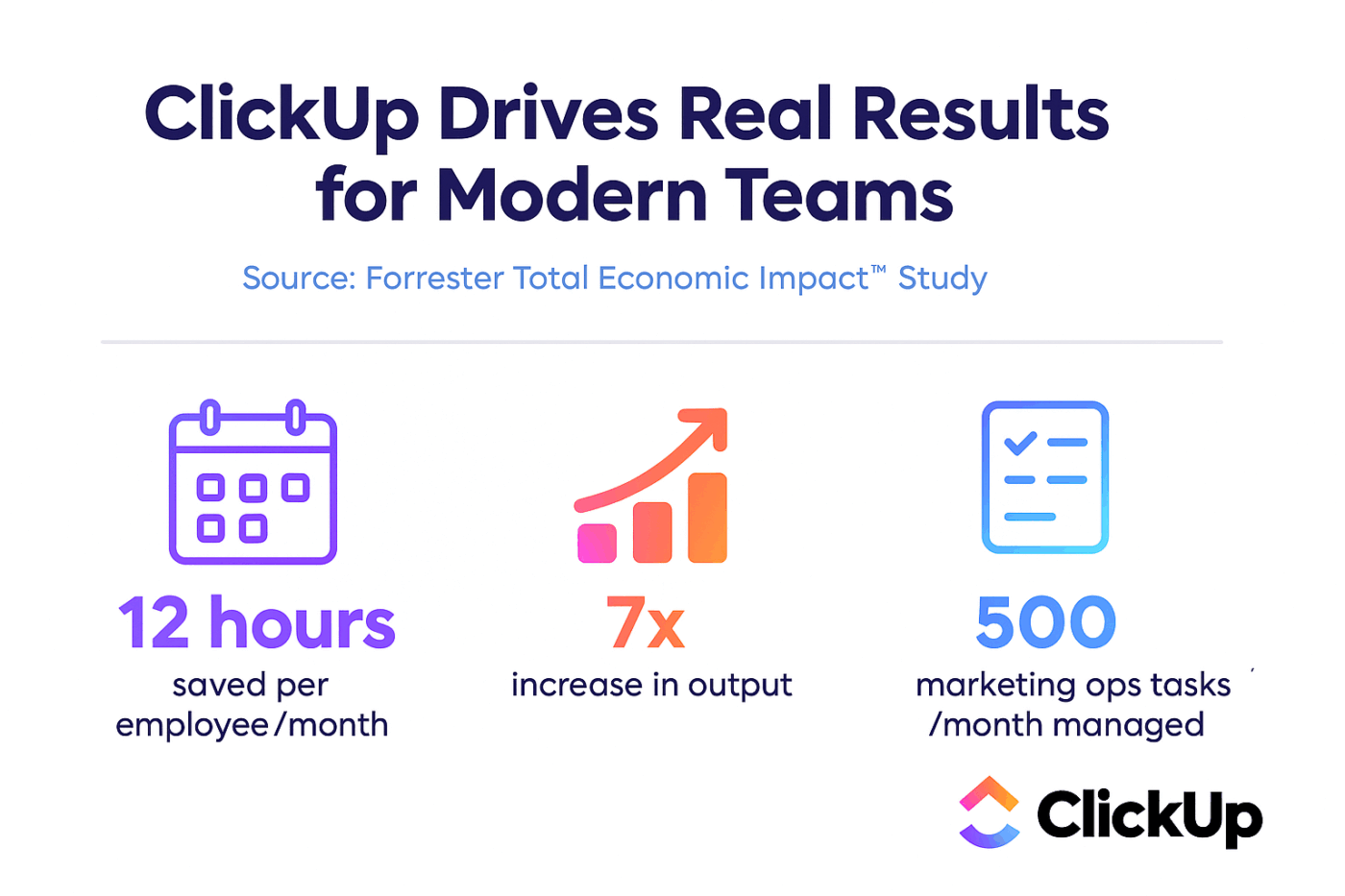

💫 ผลลัพธ์ที่แท้จริง: ทีมอย่าง QubicaAMF สามารถประหยัดเวลาได้มากกว่า 5 ชั่วโมงต่อสัปดาห์โดยใช้ ClickUp—นั่นคือมากกว่า 250 ชั่วโมงต่อปีต่อคน—ด้วยการกำจัดกระบวนการจัดการความรู้ที่ล้าสมัย ลองจินตนาการดูว่าทีมของคุณจะสามารถสร้างอะไรได้บ้างหากมีเวลาเพิ่มอีกหนึ่งสัปดาห์ในแต่ละไตรมาส!

ปรับแต่ง LLaMA ให้เหมาะสมกับบริบทธุรกิจของคุณ

การปรับแต่งให้เหมาะสม (Fine-tuning)คือกระบวนการปรับความรู้ที่มีอยู่ของ LLaMA ให้เข้ากับกรณีการใช้งานเฉพาะของคุณ ซึ่งช่วยปรับปรุงความแม่นยำในการทำงานเฉพาะด้านได้อย่างมาก แทนที่จะฝึกฝนโมเดลใหม่ทั้งหมด คุณสามารถใช้วิธีการที่มีประสิทธิภาพด้านพารามิเตอร์ซึ่งจะอัปเดตเฉพาะพารามิเตอร์บางส่วนของโมเดลเท่านั้น ช่วยประหยัดเวลาและทรัพยากรการคำนวณ

วิธีการปรับแต่งที่ได้รับความนิยม ได้แก่:

- LoRA (การปรับใช้แบบอันดับต่ำ): วิธีนี้ฝึกฝนเมทริกซ์ "ตัวปรับ" ขนาดเล็กแทนที่จะเป็นโมเดลทั้งหมด ทำให้มีประสิทธิภาพสูงมาก

- QLoRA: นี่เป็นการรวม LoRA กับการคำนวณเชิงปริมาณเพื่อให้สามารถปรับแต่งได้อย่างละเอียดบนGPU ขนาด 48GB เพียงตัวเดียวในขณะที่ยังคงประสิทธิภาพการปรับแต่งเต็มรูปแบบ

- การปรับแต่งอย่างละเอียด: การอัปเดตพารามิเตอร์ทั้งหมดของโมเดล มอบระดับการปรับแต่งที่ลึกที่สุด แต่ต้องการกำลังการคำนวณที่มาก

📚 อ่านเพิ่มเติม:เครื่องมือ AI สร้างสรรค์สำหรับองค์กรที่เปลี่ยนแปลงการทำงาน

ประเมินและปรับปรุงประสิทธิภาพของโมเดล

คุณจะรู้ได้อย่างไรว่าโมเดลที่คุณปรับแต่งนั้นทำงานได้จริง?การประเมินผล AIไม่ควรหยุดอยู่แค่คะแนนความแม่นยำเพียงอย่างเดียว แต่ต้องวัดประโยชน์การใช้งานจริงในโลกจริงด้วย สร้างชุดข้อมูลสำหรับการประเมินที่สะท้อนถึงกรณีการใช้งานจริงในกระบวนการผลิตของคุณ และติดตามตัวชี้วัดที่สำคัญต่อธุรกิจของคุณ เช่น คุณภาพของคำตอบ ความถูกต้องของข้อมูล และความล่าช้า

- การประเมินเชิงคุณภาพ: ให้ผู้ตรวจสอบที่เป็นมนุษย์ประเมินผลลัพธ์ในด้านน้ำเสียง ความเป็นประโยชน์ และความถูกต้อง

- ตัวชี้วัดเชิงปริมาณ: ใช้คะแนนอัตโนมัติ เช่น BLEU หรือค่าความซับซ้อน เพื่อติดตามประสิทธิภาพในระดับใหญ่

- การติดตามการผลิต: เมื่อนำไปใช้งานแล้ว ให้ติดตามความคิดเห็นของผู้ใช้และอัตราการเกิดข้อผิดพลาดเพื่อระบุพื้นที่ที่ต้องปรับปรุง

💡กระบวนการฝึกอบรมและประเมินผลแบบวนซ้ำนี้สามารถกลายเป็นโครงการในตัวเองได้ จัดการวงจรการพัฒนา AI ของคุณโดยตรงใน ClickUp แทนที่จะหลงทางในสเปรดชีต

รวมตัวชี้วัดประสิทธิภาพและผลการประเมินไว้ในมุมมองเดียวด้วยClickUp Dashboards ติดตามเวอร์ชันของโมเดล, พารามิเตอร์การฝึกอบรม, และคะแนนการประเมินควบคู่ไปกับงานผลิตภัณฑ์อื่น ๆ ของคุณด้วยClickUp Custom Fields ทำให้ทุกอย่างเป็นระเบียบและมองเห็นได้ชัดเจน 🛠️

กรณีการใช้งานชั้นนำสำหรับองค์กรของ LLaMA

ทีมมักติดอยู่ในภาวะวิเคราะห์จนไม่สามารถดำเนินการได้ ไม่สามารถก้าวจากความตื่นเต้นในเชิงนามธรรมเกี่ยวกับ AI ไปสู่การนำไปใช้ในเชิงปฏิบัติได้ ความยืดหยุ่นของ LLaMA ทำให้เหมาะสำหรับกระบวนการทำงานขององค์กรที่หลากหลาย ช่วยให้คุณสามารถทำงานอัตโนมัติและทำงานได้อย่างมีประสิทธิภาพมากขึ้น

นี่คือตัวอย่างการใช้งานชั้นนำสำหรับโมเดล LLaMA ที่ปรับแต่งเฉพาะ:

- ผู้ช่วยความรู้ภายใน: หยุดเสียเวลาค้นหาข้อมูลที่ไม่จำเป็นใช้ LLaMA ร่วมกับ RAGเพื่อสร้างแชทบอทที่สามารถตอบคำถามของพนักงานได้ทันที โดยการค้นหาจากวิกิภายใน เอกสารนโยบาย และการสื่อสารของโครงการที่ผ่านมา

- ระบบอัตโนมัติสำหรับการสนับสนุนลูกค้า: ปรับแต่งโมเดลจากประวัติการติดต่อของลูกค้าเพื่อสร้างคำตอบโดยอัตโนมัติ จัดหมวดหมู่คำถาม และส่งต่อปัญหาที่ซับซ้อนไปยังเจ้าหน้าที่ที่เหมาะสม

- การสร้างและตรวจสอบโค้ด: ช่วยให้ทีมวิศวกรรมของคุณทำงานได้อย่างมีประสิทธิภาพมากขึ้น ใช้ LLaMA เพื่อสร้างโค้ดมาตรฐาน อธิบายระบบเก่าที่ซับซ้อน และแม้กระทั่งระบุข้อบกพร่องที่อาจเกิดขึ้นใน pull requests ก่อนที่จะกลายเป็นปัญหา

- การประมวลผลเอกสาร: เปลี่ยนข้อความจำนวนมากให้กลายเป็นข้อมูลที่มีประโยชน์ สรุปรายงานยาว ๆ, แยกคำสำคัญจากสัญญาทางกฎหมาย, หรือสร้างบันทึกการประชุมที่กระชับจากเอกสารต้นฉบับได้ในไม่กี่วินาที

- กระบวนการทำงานในการสร้างเนื้อหา: เอาชนะภาวะตันทางความคิด เขียนร่างข้อความทางการตลาด คำอธิบายสินค้า และการประกาศภายในองค์กรที่บรรณาธิการมนุษย์ของคุณสามารถนำไปปรับปรุงและทำให้สมบูรณ์แบบได้

💡เข้าถึงกรณีการใช้งานมากมายเหล่านี้ได้ทันทีด้วย ClickUp Brain

- สรุปหัวข้อการทำงาน, ร่างการอัปเดตโครงการ, และสร้างเนื้อหาด้วยเครื่องมือช่วยเหลือการเขียนที่ขับเคลื่อนด้วย AI ของ ClickUp

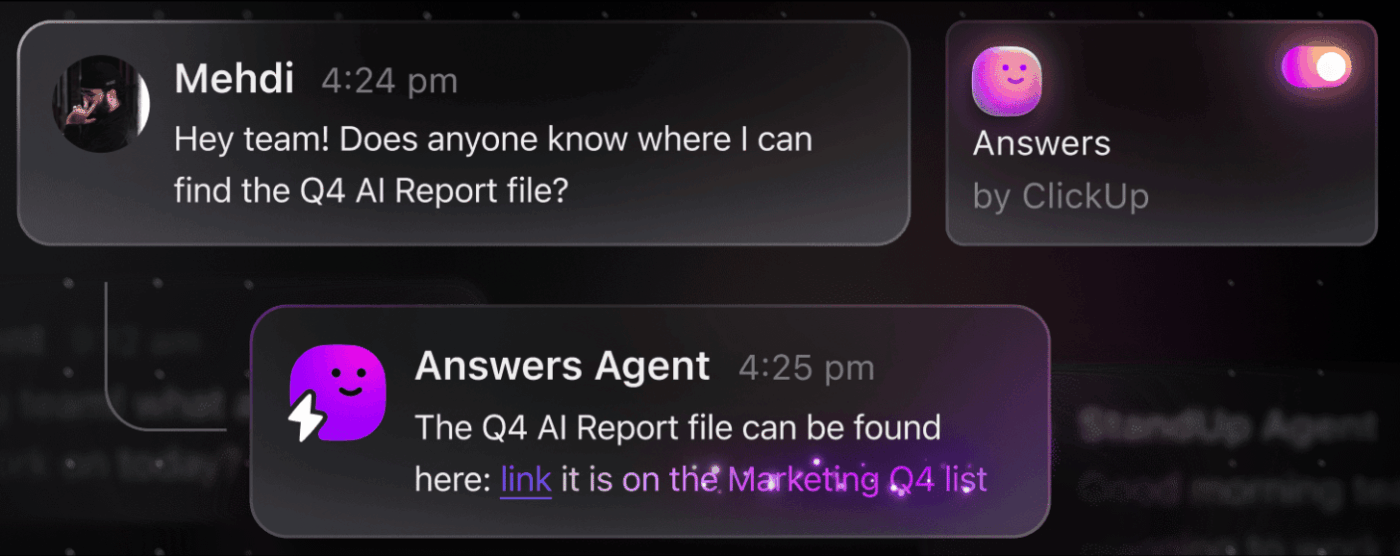

- ค้นหาคำตอบจากทั่วทั้งพื้นที่ทำงานของคุณได้ทันทีด้วยClickUp's Enterprise SearchและตัวแทนAmbient Answersที่สร้างไว้ล่วงหน้า

- สร้างกระบวนการทำงานอัจฉริยะที่จัดการงานประจำแทนคุณด้วยClickUp Automations

ข้อจำกัดของการใช้ LLaMA สำหรับปัญญาประดิษฐ์ในองค์กร

แม้ว่าการโฮสต์ LLaMA ด้วยตนเองจะมอบการควบคุมที่มาก แต่ก็ไม่ได้ปราศจากความท้าทาย ทีมมักประเมินภาระงานในการดำเนินงานต่ำเกินไป ทำให้ติดขัดอยู่กับการบำรุงรักษาแทนที่จะมุ่งเน้นนวัตกรรม ก่อนที่จะตัดสินใจเลือกเส้นทาง "สร้าง" ด้วยตนเอง สิ่งสำคัญคือต้องเข้าใจอุปสรรคที่อาจเกิดขึ้น

นี่คือข้อจำกัดสำคัญบางประการที่ควรพิจารณา:

- ข้อกำหนดด้านโครงสร้างพื้นฐาน: การใช้งานโมเดลขนาดใหญ่มีค่าใช้จ่ายสูงและต้องการ GPU ที่ทรงพลังระดับองค์กร ซึ่งองค์กรหลายแห่งไม่มีอยู่ในปัจจุบัน

- ความเชี่ยวชาญทางเทคนิคที่ต้องการ: การPLOY, ปรับแต่ง, และบำรุงรักษาแบบจำลองภาษาขนาดใหญ่ต้องการทักษะทางวิศวกรรม ML ที่มีความเชี่ยวชาญซึ่งมีความต้องการสูง

- ภาระการบำรุงรักษาอย่างต่อเนื่อง: นี่ไม่ใช่โซลูชันแบบ "ตั้งค่าแล้วลืมไป" โมเดลต้องการการตรวจสอบอย่างต่อเนื่อง การอัปเดตความปลอดภัย และการฝึกฝนใหม่เมื่อธุรกิจของคุณมีการพัฒนา

- ความเสี่ยงในการเกิดภาพหลอน: เช่นเดียวกับ LLM ทั้งหมด LLaMA อาจสร้างข้อมูลที่ฟังดูน่าเชื่อถือแต่ไม่ถูกต้องได้ในบางครั้ง การใช้งานในองค์กรจำเป็นต้องมีมาตรการป้องกันที่เข้มงวดและการตรวจสอบโดยมนุษย์เพื่อลดความเสี่ยงนี้

- ไม่มีคุณสมบัติสำหรับองค์กรในตัว:คุณสมบัติสำคัญเช่นการควบคุมการเข้าถึง, การบันทึกการตรวจสอบ, และเครื่องมือการปฏิบัติตามข้อกำหนดต้องถูกสร้างและจัดการแยกต่างหาก, ทำให้มีความซับซ้อนเพิ่มขึ้น

💡คุณสามารถหลีกเลี่ยงข้อจำกัดเหล่านี้ได้โดยใช้ ClickUp Brain ซึ่งให้บริการAI ที่จัดการภายในพื้นที่ทำงานของคุณอยู่แล้ว มอบความสามารถของ AI ระดับองค์กรโดยไม่ต้องมีภาระในการดำเนินงาน รับความปลอดภัยระดับองค์กรและกำจัดงานบำรุงรักษาโครงสร้างพื้นฐานด้วย ClickUp ทำให้ทีมของคุณมีเวลาไปมุ่งเน้นที่งานหลักของพวกเขา

📮ClickUp Insight: 88% ของผู้ตอบแบบสำรวจของเราใช้ AI สำหรับงานส่วนตัว แต่กว่า 50% ยังลังเลที่จะใช้ในที่ทำงาน อุปสรรคหลักสามประการคือ? การขาดการผสานรวมที่ราบรื่น ช่องว่างทางความรู้ หรือความกังวลด้านความปลอดภัย

แต่ถ้า AI ถูกฝังอยู่ในพื้นที่ทำงานของคุณแล้วและมีความปลอดภัยล่ะ? ClickUp Brain ผู้ช่วย AI ในตัวจาก ClickUp ทำให้สิ่งนี้เป็นจริงได้ มันเข้าใจคำสั่งในภาษาที่เข้าใจง่าย แก้ไขปัญหาการนำ AI มาใช้ทั้งสามข้อ พร้อมเชื่อมต่อแชท งาน เอกสาร และความรู้ของคุณทั่วทั้งพื้นที่ทำงาน ค้นหาคำตอบและข้อมูลเชิงลึกได้เพียงคลิกเดียว!

เครื่องมือ AI ทางเลือกสำหรับกรณีการใช้งานในองค์กร

การเลือกเครื่องมือ AI ที่เหมาะสมจากตัวเลือกมากมายที่มีอยู่เป็นความท้าทายสำหรับทุกทีม คุณกำลังพยายามหาจุดสมดุลระหว่างโมเดลต่างๆ แต่คุณกังวลว่าจะเลือกผิดและทำให้ทรัพยากรสูญเปล่า

สิ่งนี้มักนำไปสู่การขยายตัวของ AI อย่างไม่ควบคุม—การเพิ่มขึ้นอย่างไม่มีการวางแผนของเครื่องมือและแพลตฟอร์ม AI ที่ไม่มีการกำกับดูแลหรือกลยุทธ์—ซึ่งทีมต่างๆ สมัครใช้บริการหลายอย่างที่แยกจากกัน ทำให้เกิดงานมากขึ้นแทนที่จะน้อยลง

นี่คือการสรุปอย่างรวดเร็วของผู้เล่นหลักและตำแหน่งที่พวกเขาอยู่:

| เครื่องมือ | เหมาะที่สุดสำหรับ | ข้อพิจารณาหลัก |

|---|---|---|

| LLaMA (โฮสต์เอง) | การควบคุมสูงสุด, ความเป็นเจ้าของข้อมูล | ต้องการโครงสร้างพื้นฐานและทักษะด้าน ML |

| OpenAI GPT-4 | ศักยภาพสูงสุด การตั้งค่าต่ำสุด | ข้อมูลออกจากสภาพแวดล้อมของคุณ, การกำหนดราคาตามการใช้งาน |

| โคลด (แอนโทรปิก) | งานที่ต้องใช้บริบทยาว,เน้นความปลอดภัย | การแลกเปลี่ยนที่คล้ายกันกับ GPT-4 |

| มิสทรัล | การเก็บข้อมูลในยุโรป, ประสิทธิภาพ | ระบบนิเวศที่เล็กกว่า LLaMA |

| คลิกอัพ เบรน | ระบบ AI สำหรับพื้นที่ทำงานแบบบูรณาการ ไม่ต้องติดตั้ง | เหมาะที่สุดสำหรับทีมที่ต้องการ AI ภายในกระบวนการทำงานที่มีอยู่แล้ว |

แทนที่จะเชื่อมต่อเครื่องมือหลายตัวเพื่อตอบสนองความต้องการของคุณ ทำไมไม่ลองเข้าถึง AI ที่ฝังตัวอยู่ตรงจุดที่คุณทำงานล่ะ? นี่คือหัวใจสำคัญของสิ่งที่ ClickUp นำเสนอในฐานะConverged AI Workspaceแห่งแรกของโลก — แพลตฟอร์มเดียวที่ปลอดภัยซึ่งโครงการ เอกสาร การสนทนา และการวิเคราะห์ข้อมูลอยู่ร่วมกัน

มันรวมเครื่องมือของคุณเข้าด้วยกันเพื่อขจัดปัญหาการกระจัดกระจายของบริบท ซึ่งเกิดขึ้นเมื่อทีมต้องเสียเวลาหลายชั่วโมงในการสลับระหว่างแอปพลิเคชันและค้นหาข้อมูลที่จำเป็นสำหรับการทำงาน

ClickUp + ปัญญาประดิษฐ์เชิงบริบท = การเปลี่ยนแปลงที่วัดผลได้

ตามการศึกษาผลกระทบทางเศรษฐกิจของ Forrester Economic Impact™ ทีมที่ใช้ ClickUp ได้รับผลตอบแทนจากการลงทุน (ROI) ถึง 384% และประหยัดเวลาได้ 92,400 ชั่วโมงภายในปีที่ 3.

เมื่อบริบท, กระบวนการทำงาน, และข้อมูลเชิงลึกอยู่ในที่เดียว ทีมไม่เพียงแค่ทำงาน แต่พวกเขาชนะ

ClickUpยังมอบความสามารถด้านความปลอดภัยและการบริหารจัดการที่จำเป็นสำหรับการใช้งานในระดับองค์กร พร้อมด้วยการรับรองมาตรฐาน SOC 2 Type II การผสานระบบ SSO การจัดเตรียมข้อมูลแบบ SCIM และการควบคุมสิทธิ์การเข้าถึงในระดับละเอียด

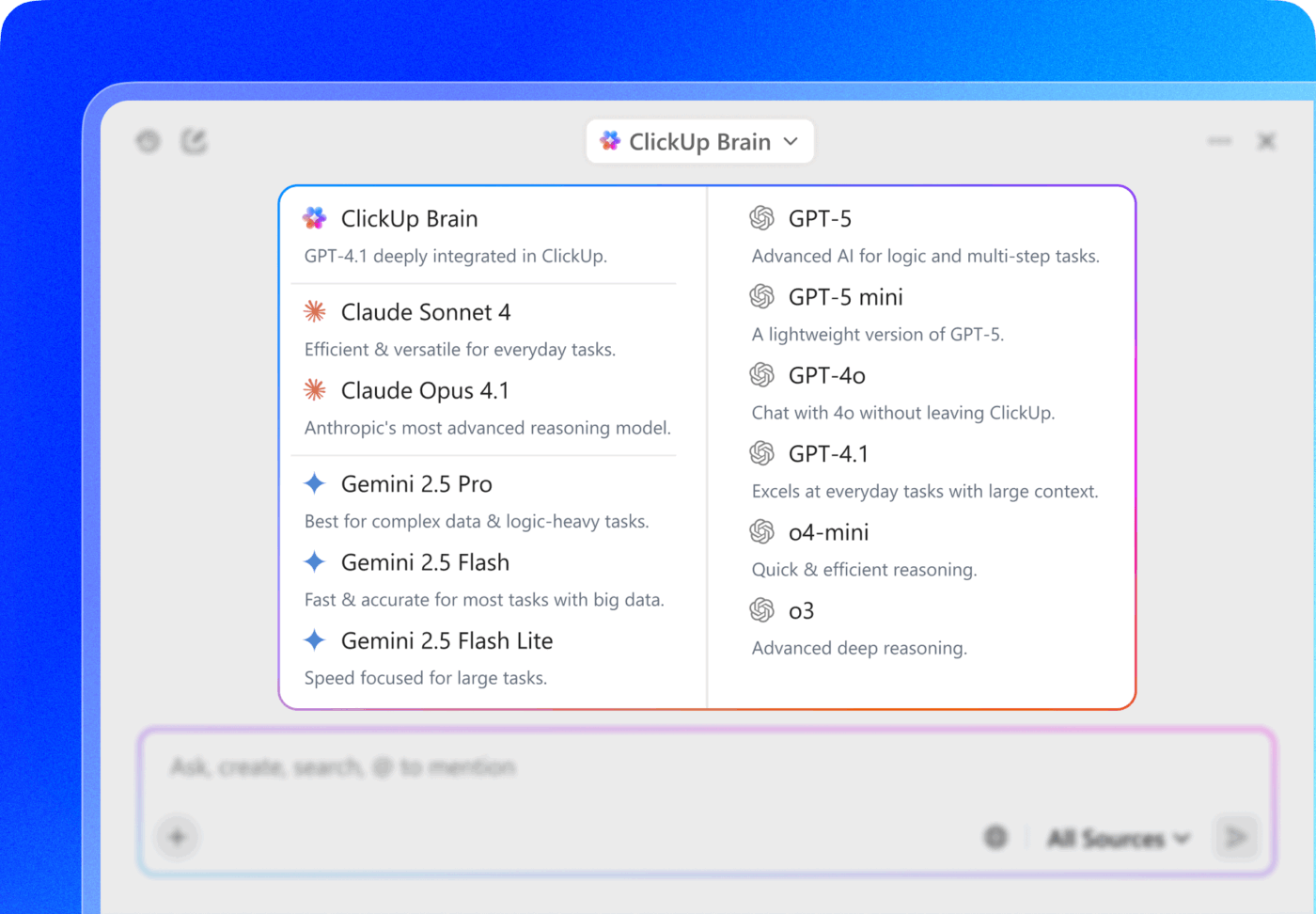

ClickUp Brain MAX ให้คุณเข้าถึงโมเดล LLM หลายตัวได้โดยตรงจากอินเทอร์เฟซการค้นหา คุณสามารถเลือกใช้โมเดลพรีเมียมอย่าง ChatGPT, Claude และ Gemini ได้ตามต้องการ แพลตฟอร์มจะส่งคำถามของคุณไปยังโมเดลที่เหมาะสมที่สุดโดยอัตโนมัติ เพื่อให้คุณได้รับผลลัพธ์ที่ดีที่สุดโดยไม่ต้องจัดการกับการสมัครสมาชิกหลายรายการ

รับทุกสิ่งที่คุณต้องการในที่เดียว—ความสามารถของ AI, การจัดการโครงการ, เอกสาร, และการสื่อสาร—ทั้งหมดใน ClickUp แทนที่จะสร้างชั้น AI ขึ้นมาใหม่จากศูนย์ด้วย LLaMA

ก้าวไปข้างหน้าด้วย AI สำหรับองค์กร ด้วย ClickUp

LLaMA มอบทางเลือกแบบเปิดน้ำหนักให้กับทีมองค์กรแทนการใช้ API ของ AI แบบปิด โดยให้ควบคุมได้มากขึ้น คาดการณ์ค่าใช้จ่ายได้ และปรับแต่งได้ตามต้องการ แต่ความสำเร็จไม่ได้ขึ้นอยู่กับเทคโนโลยีเพียงอย่างเดียว แต่ยังต้องเลือกแบบจำลองให้เหมาะกับกรณีการใช้งานที่เหมาะสม ลงทุนในข้อมูลการฝึกอบรมคุณภาพสูง และสร้างกระบวนการประเมินผลที่แข็งแกร่ง

การตัดสินใจระหว่าง "สร้างเองหรือซื้อ" สุดท้ายแล้วขึ้นอยู่กับขีดความสามารถทางเทคนิคของทีมคุณ แม้ว่าการสร้างโซลูชันแบบกำหนดเองจะให้ความยืดหยุ่นสูงสุด แต่ก็มาพร้อมกับค่าใช้จ่ายแฝงที่สำคัญ ความท้าทายที่แท้จริงไม่ใช่แค่การเข้าถึง AI เท่านั้น แต่คือการบูรณาการมันเข้ากับกระบวนการทำงานประจำวันของคุณโดยไม่ทำให้เกิดการขยายตัวของ AI ที่ไม่จำเป็นและไซโลข้อมูล

นำความสามารถของ LLM มาสู่การจัดการโครงการ การจัดทำเอกสาร และการสื่อสารในทีมของคุณโดยตรงด้วย ClickUp Brain—โดยไม่ต้องมีความซับซ้อนในการสร้างและบำรุงรักษาโครงสร้างพื้นฐานเริ่มต้นฟรีกับ ClickUpและนำความสามารถของ AI มาสู่กระบวนการทำงานที่มีอยู่ของคุณโดยตรง 🙌

คำถามที่พบบ่อย (FAQ)

ใช่, ใบอนุญาตชุมชน Llama 3 อนุญาตให้ใช้เพื่อการค้าสำหรับองค์กรส่วนใหญ่ บริษัทที่มีผู้ใช้รายเดือนมากกว่า 700 ล้านคนเท่านั้นที่ต้องขอใบอนุญาตแยกต่างหากจาก Meta

LLaMA ให้การควบคุมข้อมูลที่มากขึ้นและค่าใช้จ่ายที่คาดการณ์ได้ผ่านการโฮสต์ด้วยตนเอง ในขณะที่ GPT-4 ให้ประสิทธิภาพที่สูงกว่าโดยไม่ต้องตั้งค่ามากนัก อย่างไรก็ตาม สำหรับประสิทธิภาพในการทำงาน ให้รับความช่วยเหลือจาก AI โดยไม่ต้องจัดการกับโมเดลพื้นฐานผ่านเครื่องมือที่ผสานรวมอย่าง ClickUp Brain

การโฮสต์ LLaMA เองจะเก็บข้อมูลไว้บนโครงสร้างพื้นฐานของคุณเอง ซึ่งเหมาะอย่างยิ่งสำหรับการจัดเก็บข้อมูลภายในประเทศ อย่างไรก็ตาม คุณจะต้องรับผิดชอบในการติดตั้งระบบควบคุมการเข้าถึง บันทึกการตรวจสอบ และตัวกรองเนื้อหาด้วยตนเอง ซึ่งเป็นคุณสมบัติด้านความปลอดภัยที่โดยปกติแล้วจะรวมอยู่ในบริการ AI แบบจัดการ

การปรับใช้และปรับแต่ง LLaMA โดยตรงนั้นต้องใช้ทักษะด้านวิศวกรรม ML อย่างมาก ทีมที่ไม่มีความเชี่ยวชาญนี้สามารถเข้าถึงความสามารถที่ใช้ LLaMA ได้ผ่านแพลตฟอร์มที่มีการจัดการ เช่น ClickUp Brain ซึ่งให้บริการฟีเจอร์ AI โดยไม่ต้องมีการปรับใช้โมเดลหรือการกำหนดค่าทางเทคนิคใดๆ