GitHub Copilot kan generera hundratals testfall på några minuter – kontrollerade experiment visar att utvecklare blir färdiga 35 % snabbare – men här är haken: dessa AI-genererade tester är bara så användbara som din förmåga att spåra, organisera och koppla dem till resten av ditt utvecklingsflöde.

Den här guiden visar dig hur du använder GitHub Copilot för att snabbt skapa testfall och hur du hanterar dem effektivt så att de inte bara blir ännu en hög med övergivna kodfiler.

Varför enhetstester är viktiga för mjukvarukvaliteten

Att skriva enhetstester ses ofta som en tråkig syssla, men att hoppa över dem leder till bräcklig kod.

När du inte har ett säkerhetsnät i form av tester kan en liten omstrukturering leda till regressionsfel – buggar som förstör befintlig funktionalitet och undergräver användarnas förtroende. IBM:s forskning visar att fel som upptäcks efter lanseringen kostar 15 gånger mer att åtgärda.

Detta skapar en cykel där utvecklare undviker att förbättra koden eftersom de är rädda för vad som kan gå sönder, vilket leder till ökande teknisk skuld.

AI-assisterad testgenerering hjälper till att bryta denna cykel, och 89 % av organisationerna testar eller implementerar nu generativa AI-arbetsflöden inom kvalitetsteknik och testning. Genom att använda ett verktyg som GitHub Copilot för att skapa testfall kan du fokusera på det som är viktigt: att utforma meningsfulla tester och förfina täckningen av gränsfall.

Här är varför konsekventa enhetstester lönar sig:

- Regressionsförebyggande: Bra tester fungerar som ett skyddsräcke och säkerställer att nya funktioner eller buggfixar inte oavsiktligt förstör något annat.

- Levande dokumentation: Till skillnad från statisk dokumentation som kan bli föråldrad fungerar enhetstester som exekverbara exempel på hur din kod ska fungera.

- Säkerhet vid refaktorisering: När du har omfattande testtäckning kan du refaktorisera och förbättra din kodbas med säkerheten att du omedelbart får reda på om en ändring får oönskade konsekvenser.

För att bättre förstå hur AI-agenter förändrar kodningslandskapet utöver bara testgenerering, titta på denna översikt över AI-drivna kodningsassistenter och deras funktioner:

Hur man konfigurerar GitHub Copilot för generering av testfall

Innan du kan börja generera tester måste du installera och konfigurera GitHub Copilot i din integrerade utvecklingsmiljö (IDE). Installationsprocessen är enkel och tar bara några minuter, men om du gör det rätt säkerställer du att Copilot har den kontext som behövs för att ge relevanta förslag.

Du behöver några saker innan du börjar:

- Ett aktivt GitHub Copilot-abonnemang (Individual, Business eller Enterprise)

- En IDE som stöds, till exempel VS Code, en JetBrains IDE (som IntelliJ eller PyCharm) eller Neovim.

- Ett testramverk som pytest, Jest eller JUnit som redan är installerat i ditt projekt.

Installera GitHub Copilot-tillägget

Först måste du installera Copilot-tillägget i din IDE. Denna process är likartad för de flesta redigerare som stöds.

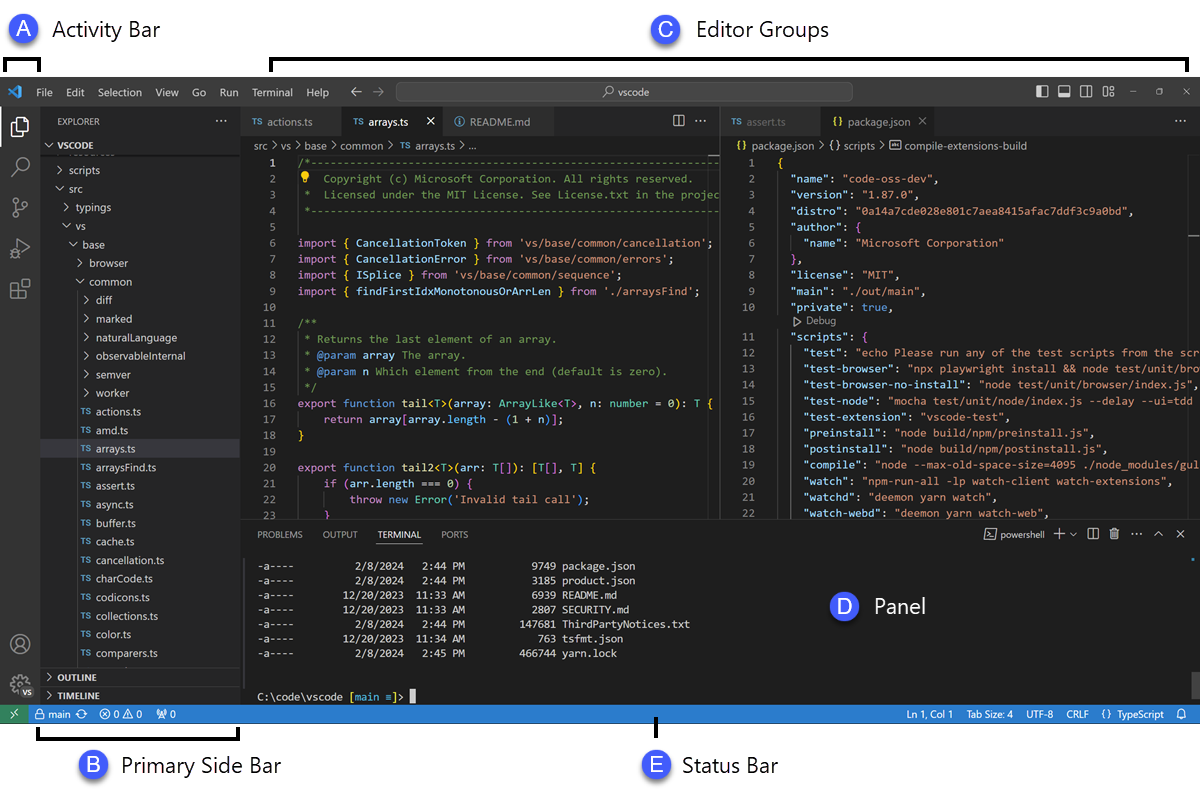

- Öppna din IDE:s tilläggsmarknad. I VS Code är detta ikonen Extensions i sidofältet; i JetBrains IDE:er hittar du den under Settings → Plugins.

- Sök efter ”GitHub Copilot”

- Installera både huvudtillägget GitHub Copilot och tillägget GitHub Copilot Chat för att få full nytta av funktionen.

- Du kommer att uppmanas att starta om din IDE för att slutföra installationen.

Efter omstarten ombeds du logga in med ditt GitHub-konto. Detta steg verifierar din prenumeration. När du har loggat in bör du se en liten Copilot-ikon i statusfältet i din IDE, som bekräftar att den är aktiv och redo att användas.

Konfigurera ditt testramverk

GitHub Copilot genererar mer relevanta tester när det förstår ditt projekts specifika testuppsättning. Det gör det genom att analysera dina befintliga testfiler och konfigurationer för att lära sig och anpassa sig efter ditt teams mönster.

- För Python-projekt som använder pytest: Se till att du har pytest installerat (pip install pytest). Om du har en conftest.py-fil eller några befintliga testfiler (även om det bara är en) kommer Copilot att använda dem som referens för att generera nya tester.

- För JavaScript/TypeScript-projekt som använder Jest: Copilot letar efter en jest.config.js-fil och din Jest-beroende i din package.json för att förstå din konfiguration.

- För Java-projekt som använder JUnit: Se till att dina JUnit-beroenden är korrekt definierade i din pom.xml-fil (för Maven) eller build.gradle-fil (för Gradle).

Att ha minst en välskriven testfil i ditt projekt är ett av de bästa sätten att styra Copilot. Det kommer att ta upp dina namngivningskonventioner, assertionsstilar och hur du strukturerar dina tester, vilket leder till mer konsekventa resultat.

Integrera Copilot med din IDE

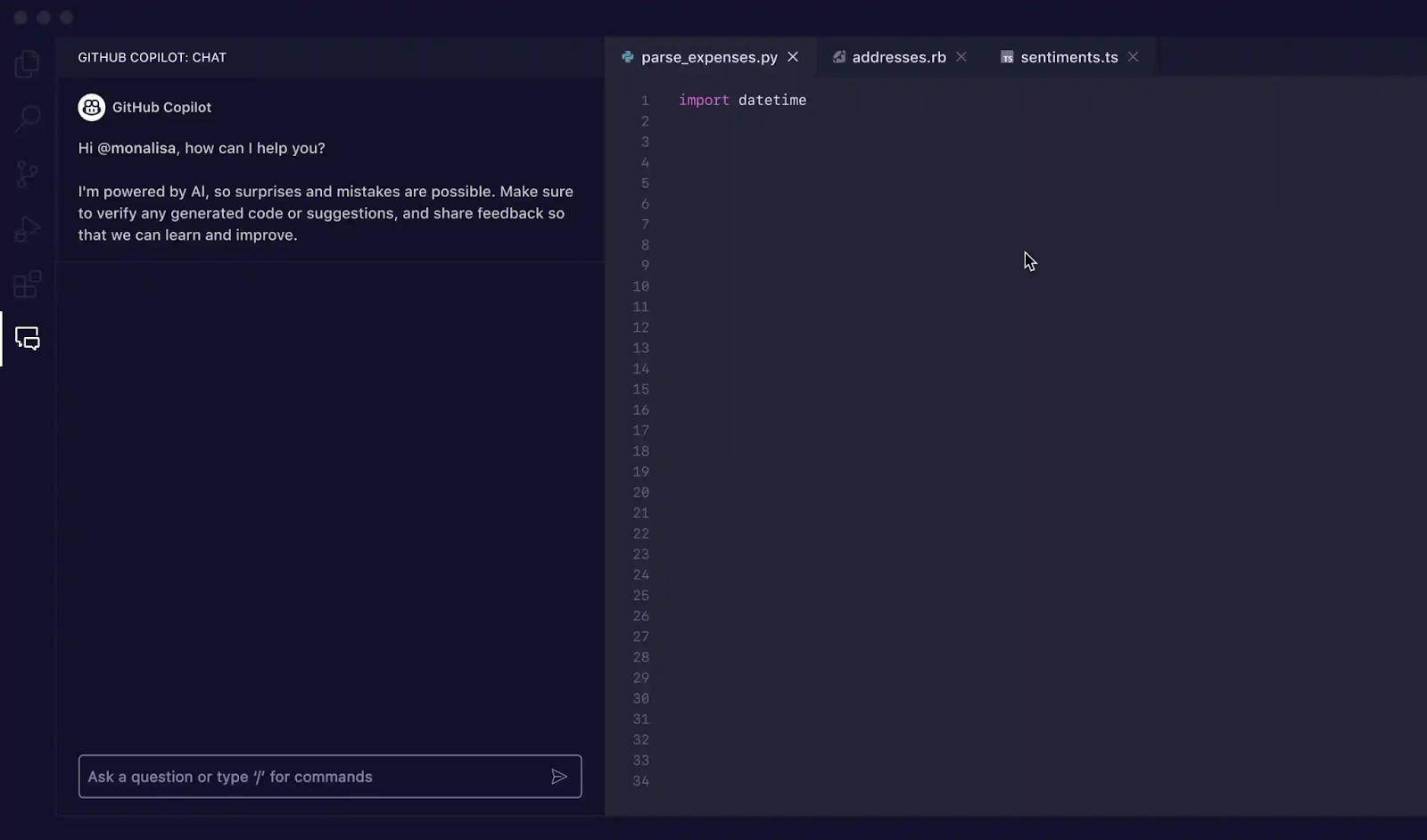

När tilläggen är installerade är det dags att bekanta sig med Copilot-gränssnittet i din IDE. Det huvudsakliga sättet att interagera med det för testgenerering är via Copilot Chat-panelen.

Du kan öppna chattvyn med kortkommandot Ctrl+Cmd+I (på Mac) eller Ctrl+Alt+I (på Windows/Linux), eller genom att klicka på Copilot Chat-ikonen i aktivitetsfältet i din IDE. Denna chattpanel är ditt kommandocenter för att generera tester.

Copilot är kontextmedveten, vilket innebär att den läser dina öppna filer, projektets filstruktur och all kod du har valt. För bästa resultat bör du alltid ha filen som innehåller den funktion eller klass du vill testa öppen och synlig i din editor.

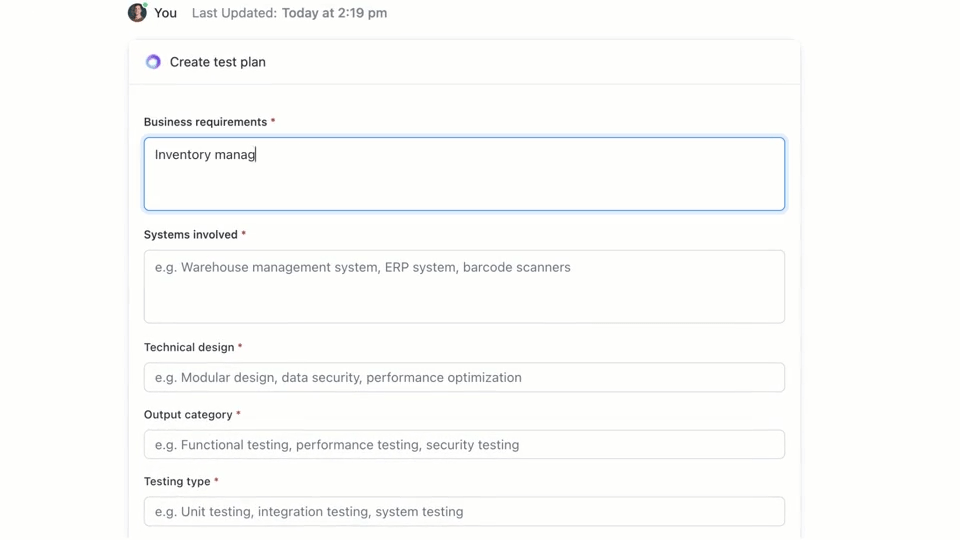

🌟 ClickUp Brain, den kontextuella AI som är integrerad i hela ClickUp, kan snabbt skapa en testplan åt dig. Prova det idag.

Hur man skriver testfall med GitHub Copilot

GitHub Copilot ger dig tre huvudsakliga sätt att generera testfall: genom att använda chattpanelen med detaljerade uppmaningar, genom att använda snabba slash-kommandon och genom att använda smarta åtgärder direkt i din editor. Varje metod är lämplig för olika situationer inom ditt utvecklingsarbetsflöde, beroende på om du behöver snabbhet eller finjusterad kontroll.

Använd Copilot Chat-prompter

Att använda Copilot Chat med en specifik prompt är den mest effektiva metoden för att generera testfall. Det är bäst för komplexa funktioner eller klasser där du behöver definiera specifika scenarier, simulera beroenden eller hantera svåra gränsfall.

Här är det grundläggande arbetsflödet:

- Öppna Copilot Chat-panelen

- Markera den funktion, klass eller kodblock som du vill testa i din editor.

- Skriv en tydlig, specifik prompt i chattpanelen som beskriver de tester du behöver.

Du kan till exempel skriva uppmaningar som:

- ”Skriv enhetstester för den valda funktionen som täcker den lyckliga vägen, gränsfall som tomma inmatningar och felhantering för ogiltiga data”.

- ”Generera pytest-tester för denna klass och skapa fixturer för att simulera databasanslutningen.”

- ”Skapa Jest-tester för denna React-komponent som simulerar användarklick och verifierar statusändringar”.

Ju mer detaljerad information du anger i din prompt, desto bättre blir de genererade testerna.

Använd slash-kommandon som /tests

När du behöver generera tester snabbt och inte behöver särskilt specifika scenarier är kommandot /tests din bästa vän. Det är det snabbaste sättet att få en solid bas för testtäckningen.

Så här använder du det:

- Öppna Copilot Chat-panelen

- Välj den kod du vill testa i din editor.

- I chattfältet skriver du bara /tests och trycker på Enter.

Copilot genererar omedelbart en uppsättning enhetstester baserat på strukturen och logiken i den kod du valt. Det försöker täcka den primära funktionaliteten och några vanliga inmatningar. Om resultaten inte är helt korrekta kan du alltid förfina dem med en uppföljningsprompt som ”Lägg nu till ett test för när inmatningen är null”.

Använd smarta åtgärder i redigeraren

När du vill generera tester utan att bryta ditt flöde kan du använda smarta åtgärder direkt från din kodredigerare. På så sätt slipper du byta till chattpanelen.

- Markera den funktion eller klass du vill testa.

- Högerklicka på valet för att öppna snabbmenyn.

- Navigera till Generera kod i snabbmenyn och välj Generera tester.

Copilot genererar testerna och visar dem vanligtvis i en ny, tillfällig redigeringsflik. Du kan granska koden där och sedan välja att skapa en ny testfil eller lägga till testerna i en befintlig fil.

📚 Läs också: Testfallmallar för mjukvarutestning

GitHub Copilot-prompter för generering av testfall

Dina uppmaningar är styrhjulet för GitHub Copilot. Generiska uppmaningar leder till generiska tester, men väl utformade uppmaningar som ger AI specifika instruktioner resulterar i omfattande och användbara testfall. Nyckeln är att tala om för Copilot inte bara vad som ska testas, utan hur det ska testas.

Här är några mallar som du kan anpassa för olika scenarier:

| Scenario | Mall för prompt |

|---|---|

| Grundläggande enhetstest | ”Skriv enhetstester för funktionen [function_name] med hjälp av [framework]. Se till att täcka normala indata, gränsvärden som noll eller negativa tal och ogiltiga indata som null eller odefinierade.” |

| Klass med beroenden | ”Generera tester för klassen [ClassName]. Använd [mocking_library] för att skapa mockar för beroendena [DependencyName] och [AnotherDependencyName].” |

| Asynkrona funktioner | ”Skapa tester för denna asynkrona funktion. Inkludera tester för framgångsfall, fall där löftet avvisas och ett scenario för tidsgränser för förfrågningar.” |

| API-slutpunkt | ”Skriv integrationstester för denna API-ändpunkt. Täck en lyckad GET-begäran, en POST-begäran med giltiga data, en begäran med saknad autentiseringstoken och en begäran med ogiltiga data som ska returnera ett 400-fel.” |

| Datavalidering | ”Generera tester för denna valideringsfunktion. Inkludera ett test för ett giltigt objekt och lägg sedan till separata tester för varje valideringsregel som misslyckas för att säkerställa att korrekta felmeddelanden returneras.” |

Tips för snabb förbättring:

- Var tydlig med ramverket: Ange alltid testramverket (t.ex. pytest, Jest, JUnit) för att säkerställa att syntaxen är korrekt.

- Definiera dina täckningsmål: Använd avancerade AI-prompttekniker för att begära specifika typer av täckning, såsom ”gränsfall”, ”felhantering” eller ”gränstestning”.

- Referera till dina egna mönster: Om du har en bra exempelfil kan du be Copilot att ”följa testmönstret i tests/test_user. py”.

- Begär specifika påståenden: Istället för att låta Copilot gissa kan du be det att ”påstå att ett ValueError genereras för ogiltig inmatning”.

📚 Läs också: De bästa kvalitetsverktygen för mjukvarutestning

Exempel på testgenerering med GitHub Copilot

Så här fungerar det i praktiken.

Skapa enhetstester i Python

Tänk dig att du har en Python-funktion som beräknar det totala priset för varorna i en kundvagn, inklusive rabatt.

Exempel på funktion att testa:

Använd prompt: ”Skriv pytest-tester för calculate_total. Täck en tom lista med objekt, ett enda objekt, flera objekt, tillämpa en rabatt, en rabatt på 0 %, en rabatt på 100 % och en ogiltig rabattprocent som bör ge upphov till ett ValueError. ”

Genererat testresultat:

Copilot använde pytest. raises korrekt för att kontrollera undantaget och täckte de viktigaste scenarierna. Du kanske fortfarande vill lägga till tester för negativa priser eller kvantiteter som en manuell förfining.

Skapa enhetstester i TypeScript med Jest

Nu ska vi prova en TypeScript-funktion som formaterar användarens namn.

Exempel på funktion att testa:

Använd prompt: ”Generera Jest-tester för formatDisplayName. Täck en användare med för- och efternamn, en användare med smeknamn, en användare med tomt förnamn och en användare med endast smeknamn.”

Genererat testresultat:

De genererade testerna använder standardbeskrivningen och blocken från Jest och hanterar de olika logiska vägarna korrekt.

Bästa praxis för testgenerering med GitHub Copilot

Att använda Copilot för att generera testfall ökar produktiviteten avsevärt, men det kräver noggrann övervakning för att säkerställa kvaliteten.

- Granska varje enskilt test: Detta är den gyllene regeln. Copilot förstår inte din affärslogik, så det kan hända att det genererar ett test som godkänns men som hävdar fel sak. Läs alltid den genererade koden och fråga dig: ”Verifierar detta verkligen rätt beteende?”

- Verifiera manuellt täckningen av gränsfall: Copilot är bra på att upptäcka vanliga gränsfall som nollinmatningar eller tomma strängar, men det kan missa domänspecifika fall. För en e-handelsapp, testade den vad som händer när varukorgens totalsumma är exakt minimibeloppet för fri frakt? Du är fortfarande experten

- Håll namngivningskonventionerna konsekventa: AI-genererade testnamn kan ibland vara generiska. Ta dig tid att byta namn på dem så att de passar ditt teams stil. Ett beskrivande namn som test_login_fails_with_incorrect_password är mycket mer användbart än test_login_2.

- Kör testerna omedelbart: Låt inte genererade tester ligga oanvända. Kör dem direkt för att upptäcka eventuella syntaxfel eller uppenbara felaktiga påståenden innan du bekräftar koden.

- Integrera med CI/CD: Lägg till genererade tester i din kontinuerliga integrationspipeline. Tester som endast körs lokalt ger begränsat värde.

- Se upp för opålitliga tester: Ibland kan AI generera tester som är ”opålitliga” – de klarar sig ibland och misslyckas andra gånger. Detta händer ofta med tester som involverar tidsstämplar eller slumpmässiga data. Ersätt alltid dessa med deterministiska, förutsägbara värden.

📮ClickUp Insight: Våra undersökningar visar att medan 34 % av användarna har fullt förtroende för AI-system, har en något större grupp (38 %) en inställning som kan beskrivas som ”lita men verifiera”. Ett fristående verktyg som inte är anpassat till din arbetsmiljö medför ofta en högre risk för felaktiga eller otillfredsställande svar.

Det är därför vi har utvecklat ClickUp Brain, AI-tekniken som kopplar samman din projektledning, kunskapshantering och samverkan i din arbetsmiljö och integrerade verktyg från tredje part. Få kontextuella svar utan att behöva växla mellan olika verktyg och upplev en 2–3 gånger högre arbetseffektivitet, precis som våra kunder på Seequent.

Begränsningar vid användning av GitHub Copilot för generering av testfall

GitHub Copilot är ett kraftfullt verktyg för att öka produktiviteten, men det är ingen mirakelkur för mjukvarutestning. För att kunna använda det effektivt och undvika vanliga fallgropar är det viktigt att känna till dess begränsningar. Det är en ”copilot”, inte piloten – du har fortfarande ansvaret för flygplanen.

Den största begränsningen är bristen på affärssammanhang. Copilot analyserar din kods struktur, men har ingen aning om vad din applikation egentligen ska göra för dina användare. Den kan inte veta att en ”premium”-användare ska ha tillgång till vissa funktioner medan en ”grundläggande” användare inte ska ha det, såvida inte den logiken är tydligt angiven i koden den läser.

Här är några andra viktiga begränsningar att tänka på:

- Det kan missa kritiska, domänspecifika gränsfall: Copilot är bra på att hitta allmänna gränsfall, men det känner inte till de udda fall som är specifika för din bransch, till exempel en finansiell beräkning som måste hantera skottår på ett annat sätt.

- Det har ingen åtkomst till externa system: Copilot kan inte generera meningsfulla integrationstester för din databas eller en tredjeparts API eftersom det inte kan ansluta till dem. Det kan skapa koden, men du måste fylla i detaljerna.

- Det kan ge en falsk känsla av trygghet: Det kan kännas bra att se 100 % testtäckning, men om testerna hävdar fel saker är täckningssiffran meningslös. Det är därför mänsklig granskning är så viktig.

- Begränsningar för kontextfönstret: Mycket stora filer eller komplexa klasstrukturhierarkier kan överskrida Copilots kontextfönster, vilket kan resultera i ofullständiga eller generiska förslag.

Hur man skapar och hanterar testfall i ClickUp

Att generera testfall med GitHub Copilot är bara halva arbetsflödet. När testerna väl finns måste teamen fortfarande spåra dem, koppla dem till kraven och hantera genomförandet över sprints och releaser.

ClickUp tillhandahåller en centraliserad arbetsyta där AI-genererade testfall kan samlas tillsammans med utvecklingsuppgifter, buggar och sprintplaner – så att testningen inte fastnar i enskilda IDE:er.

ClickUp fungerar som en konvergerad AI-arbetsplats som samlar projektledning, dokumentation och teamkommunikation i ett enda system. För mjukvaruteam innebär detta att testfallshantering inte längre är ett separat verktyg eller kalkylblad.

Tester, krav, pull-förfrågningar och diskussioner om releaser förblir sammankopplade, vilket minskar kontextförvirringen och gör QA till en viktig del av leveransarbetsflödet.

ClickUps testfallsmall är utformad för att hjälpa dig att spåra testfallens framsteg. Den gör det enkelt att:

- Granska testresultaten och fatta datadrivna beslut om buggfixar.

- Utveckla anpassade testplaner för varje projekt

- Organisera och prioritera testfall för maximal effektivitet.

Börja med att skapa en dedikerad ClickUp-lista som fungerar som ditt testfallsarkiv. Varje testfall, oavsett om det genereras av AI eller skrivs manuellt, blir en uppgift.

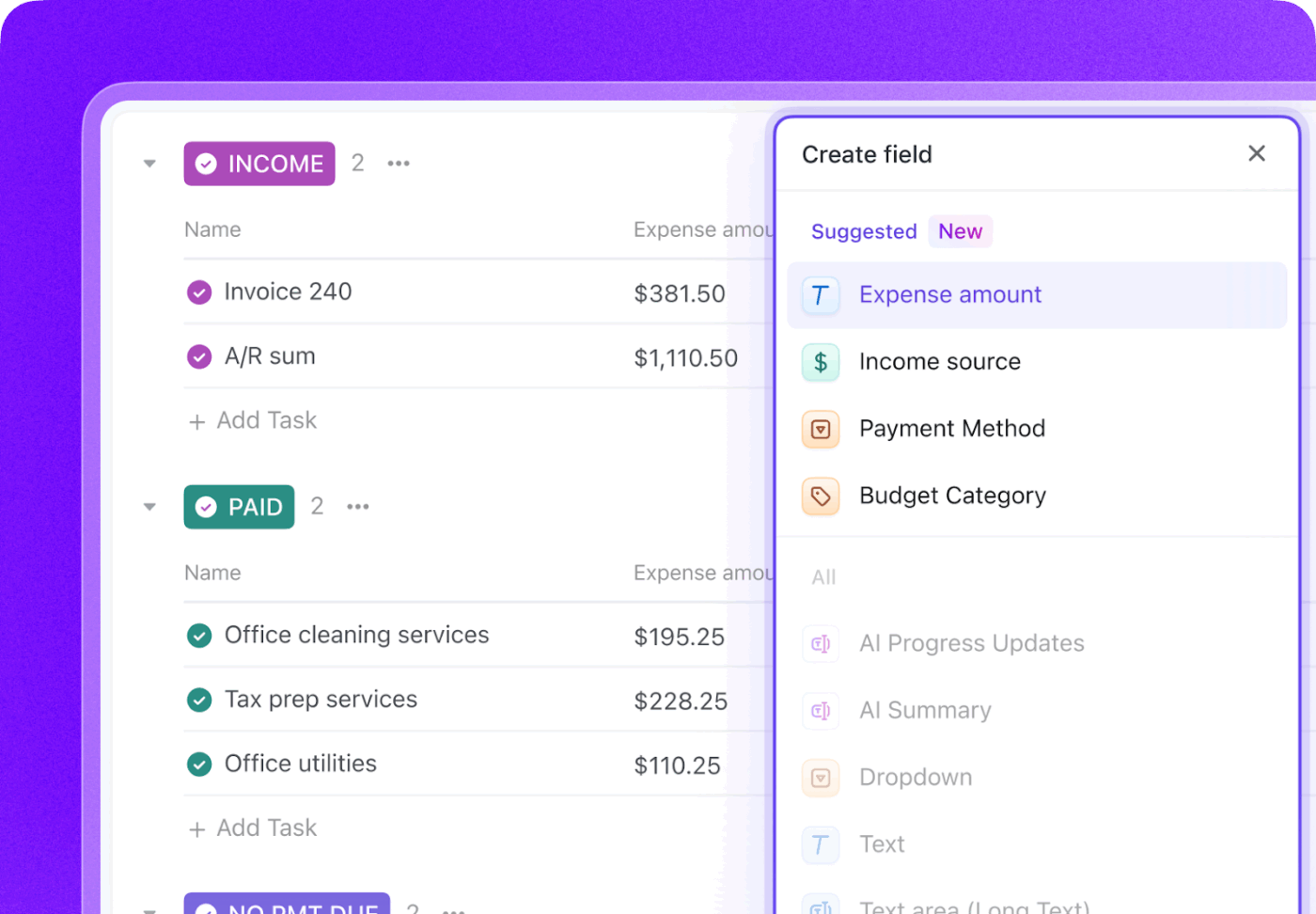

Berika varje testfall med viktig metadata med hjälp av ClickUp Custom Fields för att spåra exakt vad som är viktigt för ditt team.

- Testtyp: Rullgardinsmeny för enhet, integration, end-to-end eller manuell

- Automatiseringsstatus: En status som visar om testet är automatiserat eller inte automatiserat.

- Prioritet: Hög, medelhög eller låg

- Senaste körningsdatum: Ett datumfält för att spåra när testet senast kördes.

Spåra hela testcykeln med ClickUp Custom Statuses genom att skapa ett arbetsflöde som flyttar tester från Not Run till Passed, Failed eller Blocked. Detta ger alla i teamet, från utvecklare till produktchefer, omedelbar insyn i testets genomförande.

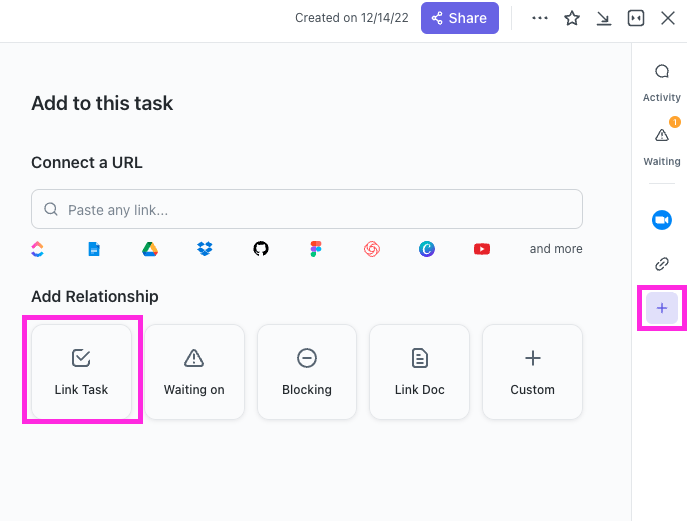

Med ClickUp Relationships kan testfallsuppgifter kopplas direkt till användarberättelser, funktioner eller epics. Om ett test misslyckas kan du skapa en felrapportuppgift och koppla den tillbaka till både det misslyckade testet och den ursprungliga berättelsen, vilket skapar en komplett spårbarhetskedja.

Skapa utkast till felrapporter på några sekunder genom att peka ClickUp Brain på en misslyckad testfallsuppgift. Eftersom det har kontexten för hela ditt arbetsområde kan det hämta detaljer från den länkade användarberättelsen och själva testfallet.

🌟 Med ClickUps mall för testrapporter kan du skapa rapporter snabbare och samtidigt säkerställa att du identifierar och åtgärdar problem som behöver förbättras.

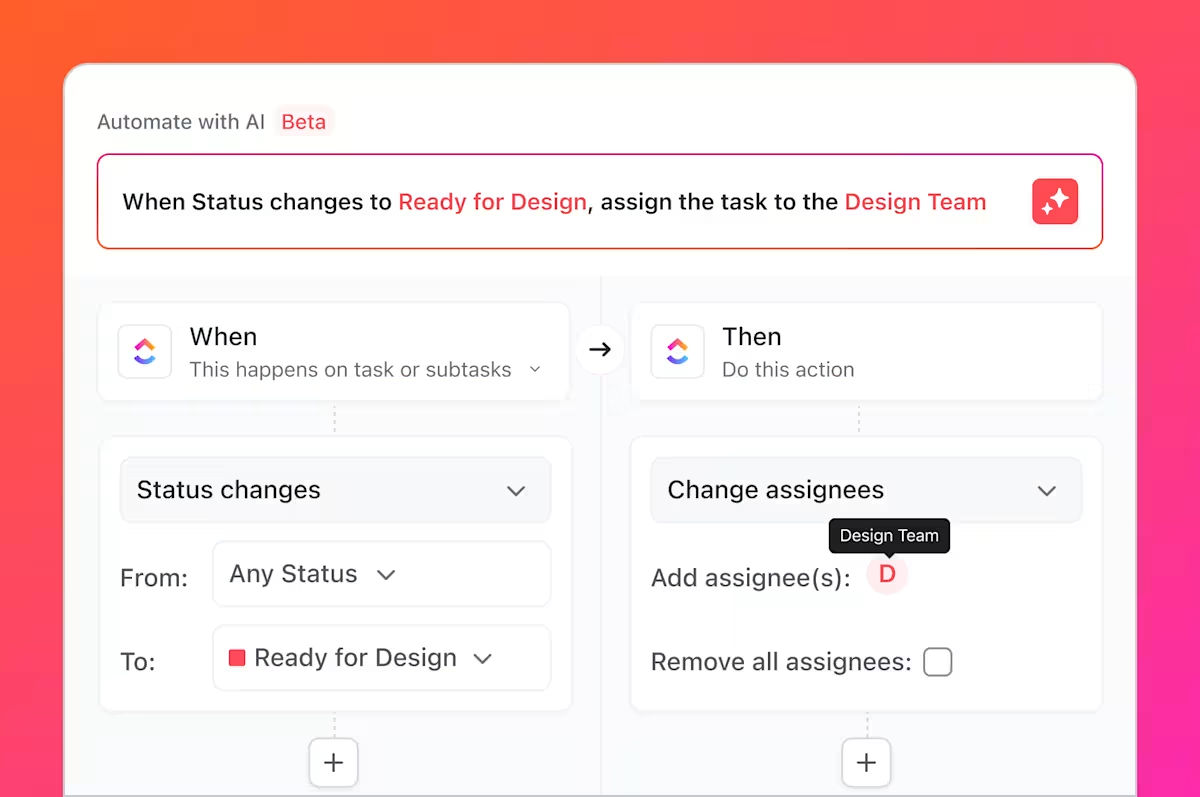

Men det är inte allt du kan göra. Du vet alla de tidskrävande uppgifter vi pratade om, de tråkiga och repetitiva uppgifterna som alltid ingår i testning? Du kan automatisera dessa med hjälp av ClickUp Automations.

Ställ in regler som ”När statusen för ett testfall ändras till Misslyckat, skapa automatiskt en ny uppgift i felregistret och tilldela den till huvudutvecklaren. ”

Genom att integrera GitHub med ClickUp kan testfallsuppgifter kopplas till commit och pull-förfrågningar. När kodändringar slås samman uppdateras relaterade testuppgifter automatiskt, vilket gör att QA, utvecklare och release managers kan hålla sig uppdaterade om vad som har ändrats och vad som behöver testas om.

Med ClickUp Dashboards kan du spåra testförloppet i realtid, visualisera antalet buggar, testfallets utförande och mycket mer.

Tillsammans överbryggar detta arbetsflöde klyftan mellan AI-genererade tester i GitHub Copilot och teamomfattande testfallshantering i ClickUp, vilket ger teamen ett enda system för att planera, spåra, automatisera och förbättra sin QA-process utan ständig manuell samordning.

Titta på detta för tips om hur du skapar ett effektivt arbetsflöde för releasehantering:

Förenkla hanteringen av testfall med ClickUp

AI-genererade tester är inte längre isolerade artefakter, utan integrerade komponenter i din utvecklingsprocess som är synliga, spårbara och användbara för hela teamet.

GitHub Copilot genererar testfall snabbt, men hastighet i sig garanterar inte kvalitet. Utan tydligt ägarskap, spårbarhet av krav och synlighet över sprints kan även välskrivna tester bli inaktuella eller förbises. Det är där ett registreringssystem spelar roll.

Genom att hantera testfall i ClickUp omvandlar teamen AI-genererade resultat till ett repeterbart QA-arbetsflöde – ett som kopplar samman tester med krav, kodändringar och release-tidsplaner. Istället för att jonglera med verktyg och manuella uppdateringar arbetar QA- och teknikteam från en gemensam, kontextuell arbetsyta. Resultatet blir inte bara fler tester, utan också större förtroende för vad som levereras och varför.

Är du redo att hantera dina testfall tillsammans med dina sprintar och releaser? Kom igång gratis med ClickUp idag.

Vanliga frågor

Ja, Copilot kan analysera strukturen och logiken i äldre kod för att generera en baslinje för tester. Dessa tester kommer dock sannolikt att kräva betydande manuell granskning och förfining, eftersom AI inte har någon kontext om odokumenterade beteenden eller historiska affärsregler.

Den syntaktiska noggrannheten är mycket hög, men den logiska noggrannheten beror på hur tydlig din kod är och hur specifika dina uppmaningar är. Granska alltid påståendena för att säkerställa att de verifierar meningsfulla affärskrav, inte bara bekräftar den aktuella (och eventuellt felaktiga) implementeringen.

Ja, Copilot har utmärkt stöd för pytest, unittest och andra populära testramverk för Python. Det är skickligt på att känna igen och replikera befintliga mönster i ditt projekt, till exempel användningen av fixturer eller parametriserade tester.

Effektiva team använder en centraliserad projektledningsplattform för att hantera sina testsuiter. Genom att spåra varje testfall som en uppgift med anpassade metadata för status och prioritet får de insyn i täckning och exekveringsresultat, vilket kopplar QA-processen direkt till sprintplanering och felspårning.