De flesta företagsteam som utforskar LLaMA fastnar på samma punkt: de laddar ner modellvikterna, stirrar på ett terminalfönster och inser att de inte har en aning om vad som ska hända härnäst.

Denna utmaning är utbredd – medan 88 % av företagen använder AI i minst en funktion, har endast 7 % skalat upp det till hela organisationen.

Denna guide leder dig genom hela processen, från att välja rätt modellstorlek för ditt användningsfall till att finjustera den utifrån ditt företags data, så att du kan implementera en fungerande AI-lösning som verkligen förstår din affärskontext.

Vad är LLaMA och varför är det viktigt för företags-AI?

LLaMA (förkortning för Large Language Model Meta AI) är en familj av öppna språkmodeller som skapats av Meta. På en hög nivå gör den samma grundläggande saker som modeller som GPT eller Gemini: den förstår språk, genererar text och kan resonera utifrån information. Den stora skillnaden är hur företag kan använda den.

Eftersom LLaMA är öppenviktig är företag inte tvungna att interagera med den endast via en black-box-API. De kan köra den på sin egen infrastruktur, finjustera den på interna data och kontrollera hur och var den distribueras.

För företag är det en stor sak – särskilt när dataintegritet, efterlevnad och kostnadsförutsägbarhet är viktigare än nyhetens behag.

Denna flexibilitet gör LLaMA särskilt attraktivt för team som vill ha AI djupt integrerat i sina arbetsflöden, inte bara som en fristående chattbot. Tänk på interna kunskapsassistenter, automatisering av kundsupport, utvecklingsverktyg eller AI-funktioner som är direkt integrerade i produkterna – utan att känslig data skickas utanför organisationen.

Kort sagt är LLaMA viktigt för företags-AI eftersom det ger teamen valmöjligheter när det gäller implementering, anpassning och AI-integration i verkliga affärssystem. Och när AI går från experiment till daglig drift blir den nivån av kontroll mindre av en ”trevlig extrafunktion” och mer av ett krav.

Så här kommer du igång med LLaMA för företagsapplikationer

1. Definiera ditt användningsfall för företaget

Innan du laddar ner något, identifiera exakt vilka arbetsflöden där AI kan ha en verklig inverkan. Det är viktigt att matcha AI-användningsfallet med modellstorleken – mindre 8B-modeller är effektiva för enkla uppgifter, medan större 70B+-modeller är bättre för komplexa resonemang.

För att hjälpa dig att identifiera rätt AI-applikationer för ditt företag, titta på denna översikt över praktiska AI-användningsfall inom olika företagsfunktioner och branscher:

Vanliga utgångspunkter är:

- Dokumenthantering: Sammanfatta långa rapporter eller extrahera viktig information från kontrakt.

- Kodassistans: Generera standardkod, förklara äldre system eller föreslå optimeringar.

- Kunskapsåtervinning: Svara på medarbetarnas frågor genom att söka i interna dokument med hjälp av en teknik som kallas Retrieval-Augmented Generation (RAG).

- Innehållsgenerering: Utarbeta första utkast till kommunikation eller marknadsföringstexter

2. Ställ in förkunskaper och beroenden

Därefter ordnar du din hårdvara och mjukvara. Modellens storlek avgör dina behov; en LLaMA 8B-modell kräver en GPU med ungefär 15 GB VRAM, medan en 70B-modell behöver 131 GB eller mer.

Din programvarustack bör inkludera Python 3. 8+, PyTorch, CUDA-drivrutiner och Hugging Face-ekosystemet (transformers, accelerate och bitsandbytes).

3. Öppna och ladda ner LLaMA-modellvikter

Du kan hämta modellvikterna från Metas officiella Llama-nedladdningssida eller Hugging Face -modellhubben. Du måste acceptera Llama 3 Community License, som tillåter kommersiell användning. Beroende på din konfiguration laddar du ner vikterna i antingen safetensors- eller GGUF-format.

4. Konfigurera din utvecklingsmiljö

När vikterna har laddats ner är det dags att konfigurera din miljö. Installera nödvändiga Python-bibliotek, inklusive transformers, accelerate och bitsandbytes för kvantisering – en process som minskar modellens minnesavtryck.

Ladda modellen med rätt inställningar och kör ett enkelt test för att säkerställa att allt fungerar korrekt innan du går vidare till anpassningen.

💡Om du inte har ett dedikerat ML-infrastrukturteam kan hela processen vara omöjlig att genomföra. Undvik helt komplexiteten med implementeringen med ClickUp Brain. Det levererar AI-funktioner som skrivhjälp och automatisering av uppgifter direkt i den arbetsmiljö där ditt team redan arbetar – utan att du behöver ladda ner modeller eller skaffa GPU.

Hur du anpassar LLaMA för dina företagsdata

Att använda en basmodell från LLaMA är en bra början, men den kommer inte att förstå ditt företags unika akronymer, projektnamn eller interna processer. Detta leder till generiska, oanvändbara svar som inte löser verkliga affärsproblem.

Företags-AI blir användbart genom anpassning – genom att träna modellen på din specifika terminologi och kunskapsbas.

Förbered dina domänspecifika träningsdata

Framgången för din anpassade AI beror mer på kvaliteten på dina träningsdata än på modellens storlek eller datorkraft. Börja med att samla in och rensa din interna information.

- Intern dokumentation: Samla in produktspecifikationer, processguider och policydokument.

- Historisk kommunikation: Samla e-postmallar, svar på supportärenden och mötesreferat.

- Domänterminologi: Sammanställ ordlistor, förkortningsdefinitioner och branschspecifikt språk.

När informationen har samlats in formaterar du den till par av instruktioner och svar för övervakad finjustering. En instruktion kan till exempel vara ”Sammanfatta detta supportärende” och svaret skulle vara en tydlig och koncis sammanfattning. Detta steg är avgörande för att lära modellen hur den ska utföra specifika uppgifter med dina data.

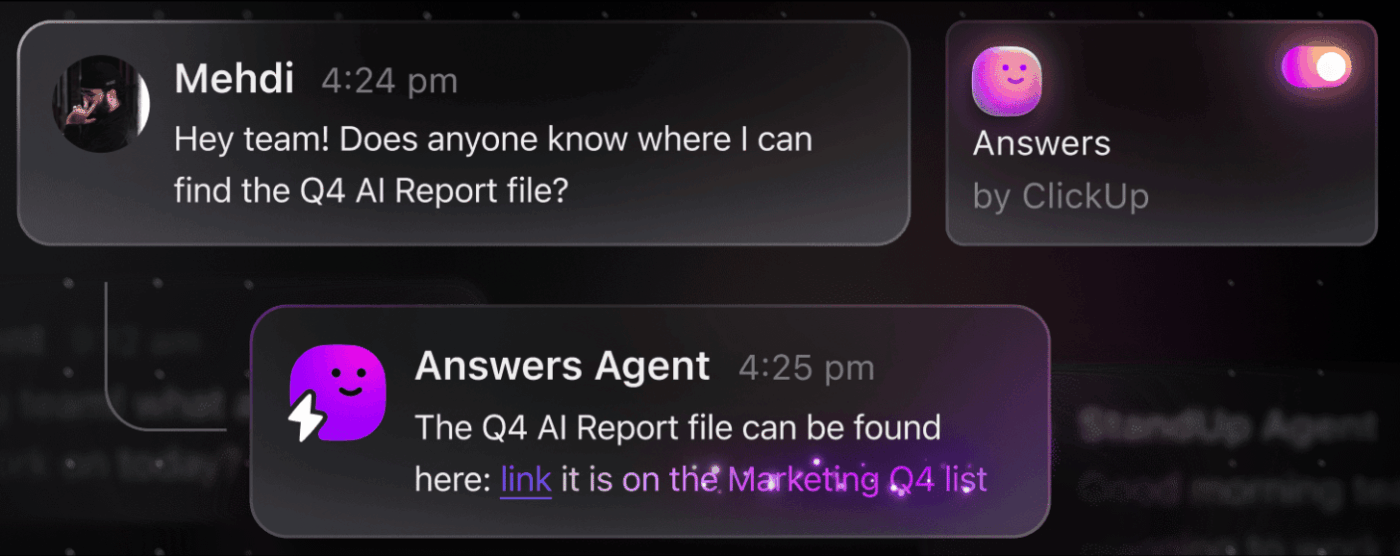

📮 ClickUp Insight: Den genomsnittliga yrkesverksamma spenderar mer än 30 minuter om dagen på att söka efter arbetsrelaterad information – det är över 120 timmar om året som går förlorade på att leta igenom e-postmeddelanden, Slack-trådar och spridda filer. En intelligent AI-assistent inbyggd i din arbetsyta kan ändra på det.

Enter ClickUp Brain. Det ger omedelbara insikter och svar genom att visa rätt dokument, konversationer och uppgiftsdetaljer på några sekunder – så att du kan sluta söka och börja arbeta.

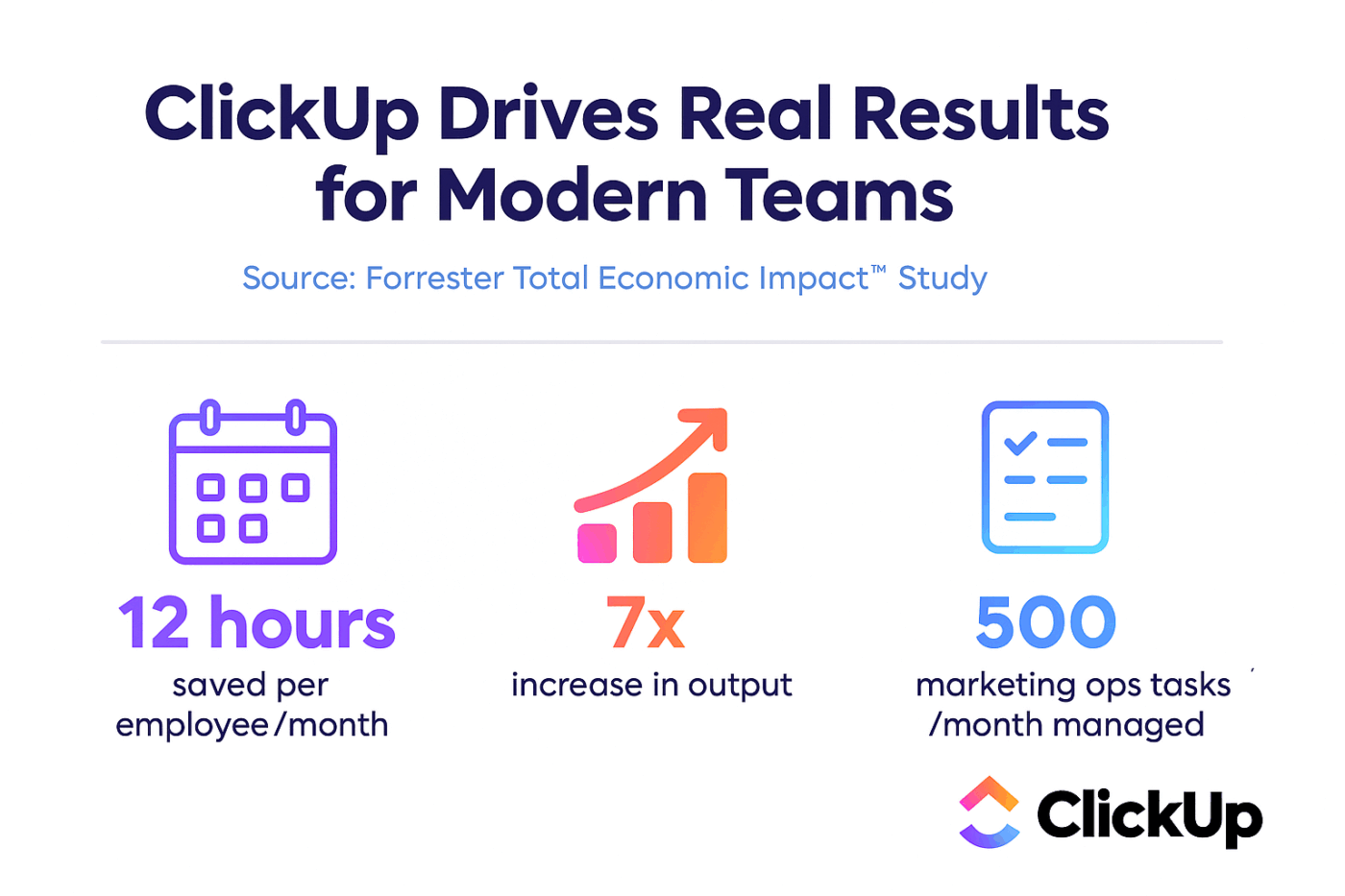

💫 Verkliga resultat: Team som QubicaAMF har sparat över 5 timmar per vecka med hjälp av ClickUp – det är över 250 timmar per person och år – genom att eliminera föråldrade processer för kunskapshantering. Tänk vad ditt team skulle kunna åstadkomma med en extra produktiv vecka varje kvartal!

Finjustera LLaMA efter ditt företags kontext

Finjustering är processen att anpassa LLaMAs befintliga kunskap till ditt specifika användningsfall, vilket dramatiskt förbättrar dess noggrannhet för domänspecifika uppgifter. Istället för att träna en modell från grunden kan du använda parametereffektiva metoder som endast uppdaterar en liten delmängd av modellens parametrar, vilket sparar tid och beräkningsresurser.

Populära finjusteringsmetoder inkluderar:

- LoRA (Low-Rank Adaptation): Denna metod tränar små ”adapter”-matriser istället för hela modellen, vilket gör den mycket effektiv.

- QLoRA: Detta kombinerar LoRA med kvantisering för att möjliggöra finjustering på en enda 48 GB GPU samtidigt som full finjusteringsprestanda uppnås.

- Fullständig finjustering: Detta uppdaterar alla modellens parametrar och erbjuder den djupaste nivån av anpassning, men kräver betydande datorkraft.

Utvärdera och iterera modellprestanda

Hur vet du om din anpassade modell faktiskt fungerar? AI-utvärdering måste gå utöver enkla noggrannhetspoäng och mäta användbarheten i verkligheten. Skapa utvärderingsdatauppsättningar som speglar dina produktionsanvändningsfall och spåra mätvärden som är viktiga för ditt företag, såsom svarskvalitet, faktamässig noggrannhet och latens.

- Kvalitativ utvärdering: Låt mänskliga granskare bedöma resultaten utifrån ton, användbarhet och korrekthet.

- Kvantitativa mått: Använd automatiserade poäng som BLEU eller perplexity för att spåra prestanda i stor skala.

- Produktionsövervakning: När modellen har implementerats kan du spåra användarfeedback och felfrekvenser för att identifiera områden som kan förbättras.

💡Denna iterativa process med träning och utvärdering kan bli ett projekt i sig. Hantera din AI-utvecklingscykel direkt i ClickUp istället för att gå vilse i kalkylblad.

Centralisera prestandamätvärden och utvärderingsresultat i en vy med ClickUp Dashboards. Spåra modellversioner, träningsparametrar och utvärderingspoäng tillsammans med ditt övriga produktarbete med ClickUp Custom Fields, så att allt hålls organiserat och synligt. 🛠️

De bästa användningsfallen för LLaMA inom företag

Team fastnar ofta i analysförlamning och kan inte gå från abstrakt entusiasm över AI till konkreta tillämpningar. LLaMA:s flexibilitet gör det lämpligt för ett brett spektrum av företagsarbetsflöden och hjälper dig att automatisera uppgifter och arbeta mer effektivt.

Här är några av de bästa användningsområdena för en anpassad LLaMA-modell:

- Interna kunskapsassistenter: Sluta slösa tid på att leta efter information. Implementera LLaMA med RAG för att skapa en chattbot som direkt kan svara på anställdas frågor genom att söka i dina interna wikis, policydokument och tidigare projektkommunikation.

- Automatisering av kundsupport: Finjustera en modell baserad på din biljettlogg för att automatiskt skapa svar, kategorisera förfrågningar och eskalera komplexa ärenden till rätt kundtjänstmedarbetare.

- Kodgenerering och granskning: Hjälp ditt teknikteam att arbeta mer effektivt. Använd LLaMA för att generera standardkod, förklara komplexa äldre system och till och med identifiera potentiella buggar i pull-förfrågningar innan de blir problem.

- Dokumenthantering: Omvandla stora mängder text till användbar information. Sammanfatta långa rapporter, extrahera nyckeltermer från juridiska avtal eller generera koncisa mötesanteckningar från råa transkriptioner på några sekunder.

- Arbetsflöden för innehållsskapande: Övervinna skrivkramp. Skriv utkast till marknadsföringstexter, produktbeskrivningar och interna meddelanden som dina redaktörer sedan kan förfina och finslipa.

💡Få tillgång till många av dessa användningsfall direkt med ClickUp Brain.

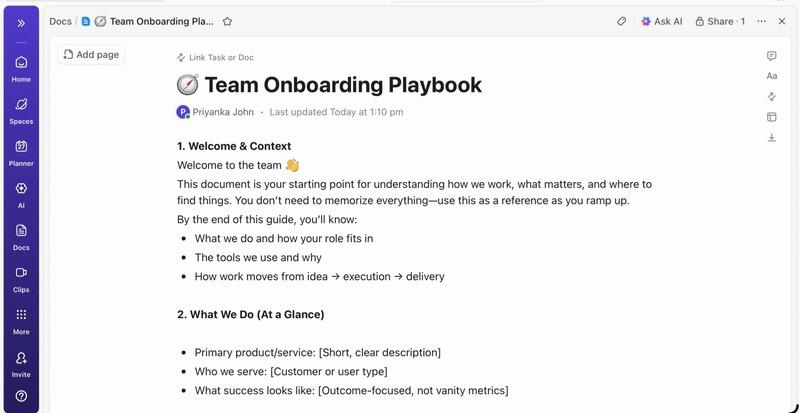

- Sammanfatta uppgiftstrådar, utarbeta projektuppdateringar och generera innehåll med ClickUps AI-drivna skrivhjälp.

- Hitta svar från hela ditt arbetsområde direkt med ClickUps Enterprise Search och den förinstallerade agenten Ambient Answers.

- Skapa intelligenta arbetsflöden som hanterar rutinuppgifter åt dig med ClickUp Automations.

Begränsningar vid användning av LLaMA för företags-AI

Att själv vara värd för LLaMA ger visserligen betydande kontroll, men det är inte utan utmaningar. Team underskattar ofta den operativa overheadkostnaden och fastnar i underhåll istället för innovation. Innan man bestämmer sig för att gå vägen att ”bygga” är det viktigt att förstå de potentiella hindren.

Här är några av de viktigaste begränsningarna att tänka på:

- Infrastrukturkrav: Att köra stora modeller är dyrt och kräver kraftfulla GPU:er av företagsstandard som många organisationer inte har tillgång till.

- Teknisk expertis som krävs: Implementering, finjustering och underhåll av en stor språkmodell kräver specialiserade ML-tekniska färdigheter som är mycket efterfrågade.

- Löpande underhållsbörda: Detta är inte en lösning som du kan installera och sedan glömma bort. Modellerna kräver ständig övervakning, säkerhetsuppdateringar och omskolning i takt med att ditt företag utvecklas.

- Risk för hallucinationer: Liksom alla LLM kan LLaMA ibland generera information som låter trovärdig men är felaktig. Företagsapplikationer kräver robusta skyddsåtgärder och mänsklig övervakning för att minska denna risk.

- Inga inbyggda företagsfunktioner: Viktiga funktioner som åtkomstkontroll, revisionsloggning och efterlevnadsverktyg måste byggas och hanteras separat, vilket lägger till ytterligare ett lager av komplexitet.

💡Du kan kringgå dessa begränsningar genom att använda ClickUp Brain. Det tillhandahåller hanterad AI inom din befintliga arbetsyta, vilket ger dig AI-funktioner för företag utan driftskostnader. Få säkerhet i företagsklass och slipp underhåll av infrastruktur med ClickUp, så att ditt team kan fokusera på sitt kärnuppdrag.

📮ClickUp Insight: 88 % av våra undersökningsdeltagare använder AI för sina personliga uppgifter, men över 50 % drar sig för att använda det på jobbet. De tre största hindren? Brist på sömlös integration, kunskapsluckor eller säkerhetsproblem.

Men vad händer om AI är inbyggt i din arbetsyta och redan är säkert? ClickUp Brain, ClickUps inbyggda AI-assistent, gör detta till verklighet. Den förstår kommandon i klartext och löser alla tre problem med AI-implementering samtidigt som den kopplar samman din chatt, dina uppgifter, dokument och kunskap i hela arbetsytan. Hitta svar och insikter med ett enda klick!

Alternativa AI-verktyg för användningsfall inom företag

Att välja rätt AI-verktyg bland de många tillgängliga alternativen är en utmaning för alla team. Du försöker ta reda på fördelarna och nackdelarna med olika modeller, men är orolig för att välja fel och slösa bort resurser.

Detta leder ofta till AI-spridning – en oplanerad spridning av AI-verktyg och plattformar utan övervakning eller strategi – där team prenumererar på flera oberoende tjänster, vilket skapar mer arbete istället för mindre.

Här är en kort sammanfattning av de viktigaste aktörerna och var de passar in:

| Verktyg | Bäst för | Viktiga överväganden |

|---|---|---|

| LLaMA (självhostad) | Maximal kontroll, datasuveränitet | Kräver ML-infrastruktur och expertis. |

| OpenAI GPT-4 | Högsta kapacitet, minimal installation | Data lämnar din miljö, användningsbaserad prissättning |

| Claude (Anthropic) | Uppgifter med lång kontext, fokus på säkerhet | Liknande avvägningar som för GPT-4 |

| Mistral | Europeisk datalagring, effektivitet | Mindre ekosystem än LLaMA |

| ClickUp Brain | Integrerad arbetsplats-AI, ingen implementering | Bäst för team som vill ha AI inom befintliga arbetsflöden |

Istället för att koppla ihop flera verktyg för att tillgodose dina behov, varför inte använda AI direkt där du arbetar? Detta är kärnan i vad ClickUp erbjuder som världens första konvergerade AI-arbetsplats – en enda säker plattform där projekt, dokument, konversationer och analyser samlas.

Det förenar dina verktyg för att eliminera kontextförspridning, den fragmentering som uppstår när team slösar timmar på att växla mellan appar och söka efter den information de behöver för att utföra sitt arbete.

ClickUp + kontextuell AI = mätbar transformation

Enligt en studie från Forrester Economic Impact™ uppnådde team som använde ClickUp en avkastning på 384 % och sparade 92 400 timmar under det tredje året.

När sammanhang, arbetsflöden och intelligens finns på ett och samma ställe, arbetar teamen inte bara. De vinner.

ClickUp erbjuder också den säkerhet och de administrativa funktioner som krävs för företagsimplementeringar, med SOC 2 Type II-kompatibilitet, SSO-integration, SCIM-provisionering och detaljerade behörighetskontroller.

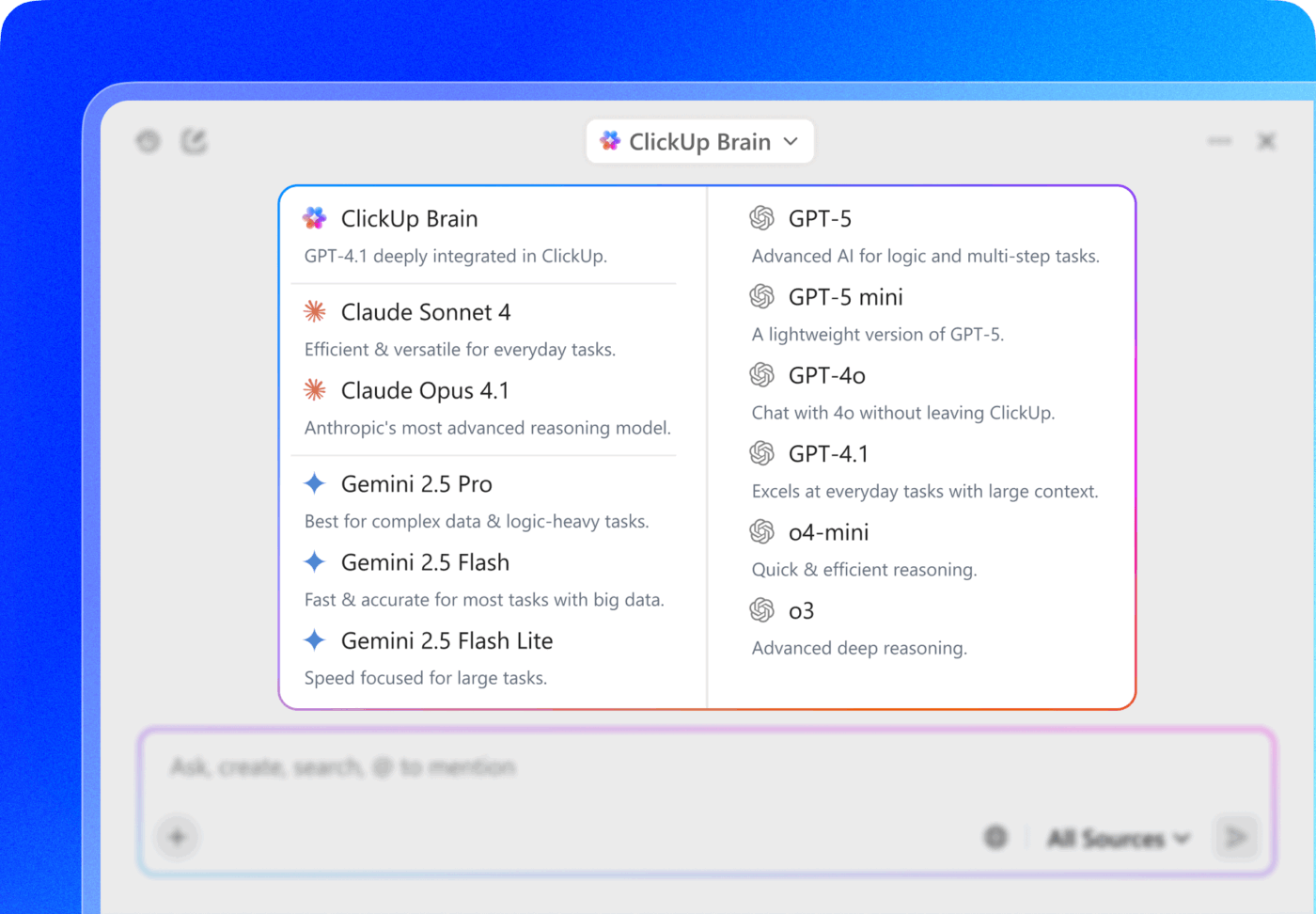

ClickUp Brain MAX:s multi-LLM-åtkomst låter dig välja mellan premiummodeller som ChatGPT, Claude och Gemini direkt från söksnittet. Plattformen dirigerar automatiskt din förfrågan till den bästa modellen för uppgiften, så att du får det bästa av alla världar utan att behöva hantera flera prenumerationer.

Få hela paketet – AI-funktioner, projektledning, dokumentation och kommunikation – på ett och samma ställe med ClickUp, istället för att bygga AI-lagret från grunden med LLaMA.

Gå vidare med AI för företag med ClickUp

LLaMA ger företagsteam ett öppet alternativ till slutna AI-API:er, vilket ger betydande kontroll, kostnadsförutsägbarhet och anpassningsmöjligheter. Men framgång beror på mer än bara teknik. Det kräver att man matchar rätt modell med rätt användningsfall, investerar i högkvalitativa träningsdata och bygger robusta utvärderingsprocesser.

Beslutet om att bygga eller köpa beror i slutändan på ditt teams tekniska kapacitet. Att bygga en anpassad lösning ger maximal flexibilitet, men medför också betydande omkostnader. Den verkliga utmaningen är inte bara att få tillgång till AI, utan att integrera den i dina dagliga arbetsflöden utan att skapa mer AI-spridning och datasilos.

Integrera LLM-funktioner direkt i din projektledning, dokumentation och teamkommunikation med ClickUp Brain – utan komplexiteten med att bygga och underhålla infrastruktur. Kom igång gratis med ClickUp och integrera AI-funktioner direkt i dina befintliga arbetsflöden. 🙌

Vanliga frågor (FAQ)

Ja, Llama 3 Community License tillåter kommersiell användning för de flesta organisationer. Endast företag med över 700 miljoner aktiva användare per månad behöver skaffa en separat licens från Meta.

LLaMA ger bättre datakontroll och förutsägbara kostnader genom självhosting, medan GPT-4 erbjuder högre prestanda direkt ur lådan med mindre installation. För produktivitet kan du dock få AI-assistans utan att behöva hantera de underliggande modellerna genom integrerade verktyg som ClickUp Brain.

Genom att själv vara värd för LLaMA förvaras data på din infrastruktur, vilket är utmärkt för datalagring. Du ansvarar dock själv för att implementera dina egna åtkomstkontroller, granskningsloggar och innehållsfilter – säkerhetsfunktioner som vanligtvis ingår i hanterade AI-tjänster.

Att implementera och finjustera LLaMA direkt kräver betydande kunskaper inom maskininlärning. Team som saknar denna expertis kan få tillgång till LLaMA-baserade funktioner via hanterade plattformar som ClickUp Brain, som tillhandahåller AI-funktioner utan någon modellimplementering eller teknisk konfiguration.