A legtöbb LLaMA-t kipróbáló vállalati csapat ugyanazon a ponton akad el: letöltik a modell súlyait, bámulják a terminál ablakot, és rájönnek, hogy fogalmuk sincs, mi legyen a következő lépés.

Ez a kihívás széles körben elterjedt: míg a vállalatok 88%-a legalább egy funkcióban használja az AI-t, csak 7% alkalmazza azt a szervezet egészében.

Ez az útmutató végigvezeti Önt a teljes folyamaton, a felhasználási esethez megfelelő modellméret kiválasztásától kezdve a vállalat adataihoz való finomhangolásig, így olyan működő AI-megoldást telepíthet, amely valóban megérti az üzleti kontextust.

Mi az a LLaMA, és miért fontos a vállalati mesterséges intelligencia számára?

Az LLaMA (a Large Language Model Meta AI rövidítése) a Meta által létrehozott nyílt súlyú nyelvi modellek családja. Magas szinten ugyanazokat az alapvető feladatokat látja el, mint a GPT vagy a Gemini modellek: megérti a nyelvet, szöveget generál és képes az információk között következtetéseket levonni. A nagy különbség abban rejlik, hogy hogyan használhatják a vállalatok.

Mivel a LLaMA nyílt súlyú, a vállalatok nem kénytelenek csak egy fekete doboz API-n keresztül kommunikálni vele. Saját infrastruktúrájukon futtathatják, belső adatok alapján finomhangolhatják, és ellenőrizhetik, hogyan és hol alkalmazzák.

A vállalatok számára ez óriási jelentőségű, különösen akkor, ha az adatvédelem, a szabályoknak való megfelelés és a költségek előre jelezhetősége fontosabb, mint az újdonság.

Ez a rugalmasság különösen vonzóvá teszi a LLaMA-t azoknak a csapatoknak, amelyek az AI-t mélyen be akarják ágyazni a munkafolyamatukba, és nem csak önálló csevegőrobotként szeretnék használni. Gondoljon például a belső tudásasszisztensekre, az ügyfélszolgálat automatizálására, a fejlesztői eszközökre vagy a termékekbe közvetlenül beépített AI-funkciókra – anélkül, hogy érzékeny adatokat küldene a szervezeten kívülre.

Röviden: a LLaMA azért fontos a vállalati AI számára, mert a csapatoknak választási lehetőséget biztosít a telepítés, a testreszabás és az AI integrálása terén a valódi üzleti rendszerekbe. És ahogy az AI a kísérleti stádiumból a mindennapi működésbe kerül, ez a szintű ellenőrzés egyre kevésbé lesz „jó, ha van”, és egyre inkább követelmény lesz.

Hogyan kezdjünk el a LLaMA használatával vállalati alkalmazásokhoz

1. Határozza meg vállalati felhasználási esetét

Mielőtt bármit letöltene, határozza meg pontosan azokat a munkafolyamatokat, ahol az AI valódi hatást gyakorolhat. Az AI felhasználási esetének és a modell méretének összehangolása kulcsfontosságú – a kisebb, 8B-es modellek egyszerű feladatokhoz hatékonyak, míg a nagyobb, 70B+-os modellek komplex érveléshez alkalmasabbak.

Hogy segítsünk Önnek megtalálni a vállalkozásához legmegfelelőbb AI-alkalmazásokat, nézze meg ezt az áttekintést a gyakorlati AI-alkalmazásokról különböző vállalati funkciókban és iparágakban:

A leggyakoribb kiindulási pontok a következők:

- Dokumentumfeldolgozás: Hosszú jelentések összefoglalása vagy kulcsfontosságú információk kivonása szerződésekből

- Kódsegítség: sablonkód generálása, a régi rendszerek magyarázata vagy optimalizálási javaslatok

- Tudás visszakeresés: A munkavállalók kérdéseinek megválaszolása a belső dokumentációkban történő kereséssel, a Retrieval-Augmented Generation (RAG) nevű technika segítségével.

- Tartalomgenerálás: Első lépésként kommunikációs vagy marketing szövegek megfogalmazása

2. A előfeltételek és függőségek beállítása

Ezután rendezze el a hardvert és a szoftvert. A modell mérete határozza meg az igényeket: a LLaMA 8B modellhez körülbelül 15 GB VRAM-mal rendelkező GPU szükséges, míg a 70B modellhez 131 GB vagy annál több.

A szoftvercsomagjának tartalmaznia kell a Python 3. 8+ verziót, a PyTorch-ot, a CUDA illesztőprogramokat és a Hugging Face ökoszisztémát (transzformátorok, gyorsítók és bitsandbytes).

3. A LLaMA modell súlyainak elérése és letöltése

A modell súlyait a Meta hivatalos Llama letöltési oldaláról vagy a Hugging Face modellközpontból szerezheti be. El kell fogadnia a Llama 3 közösségi licencet, amely lehetővé teszi a kereskedelmi felhasználást. A beállításaitól függően a súlyokat safetensors vagy GGUF formátumban töltheti le.

4. Konfigurálja fejlesztői környezetét

A súlyok letöltése után itt az ideje beállítani a környezetet. Telepítse a szükséges Python könyvtárakat, beleértve a transzformátorokat, az accelerate-et és a bitsandbytes-t a kvantáláshoz – ez egy olyan folyamat, amely csökkenti a modell memóriaigényét.

Töltse be a modellt a megfelelő beállításokkal, és futtasson egy egyszerű tesztparancsot, hogy megbizonyosodjon arról, hogy minden megfelelően működik, mielőtt továbblépne a testreszabásra.

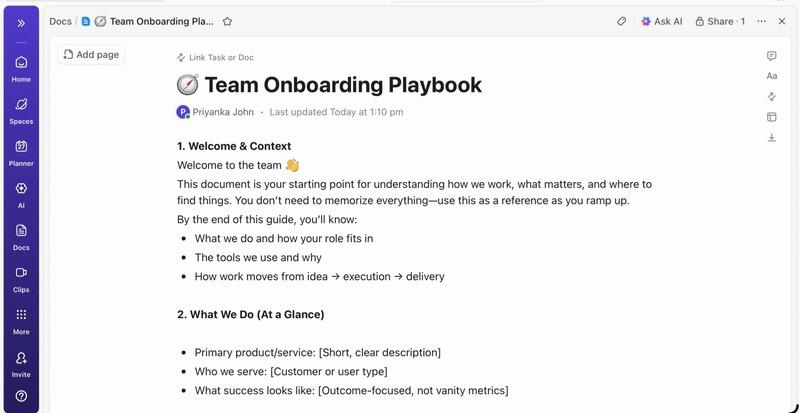

💡Ha nincs dedikált ML-infrastruktúra csapata, ez az egész folyamat lehetetlennek bizonyulhat. A ClickUp Brain segítségével teljesen elkerülheti a telepítés bonyolultságát. Az AI-képességeket, például az írási segítséget és a feladatok automatizálását közvetlenül a csapat már meglévő munkaterületén biztosítja – nincs szükség modell letöltésre vagy GPU-provisioningra.

Hogyan testreszabhatja a LLaMA-t vállalati adataihoz?

Az alap LLaMA modell használata jó kezdet, de nem fogja érteni a vállalat egyedi rövidítéseit, projektneveit vagy belső folyamatait. Ez általános, haszontalan válaszokhoz vezet, amelyek nem oldják meg a valódi üzleti problémákat.

A vállalati mesterséges intelligencia testreszabás révén válik hasznossá – a modell képzése az Ön specifikus terminológiájára és tudásbázisára.

Készítse elő a domain-specifikus képzési adatait

Az egyedi AI sikere inkább a képzési adatok minőségétől függ, mint a modell méretétől vagy a számítási teljesítménytől. Kezdje a belső információk összegyűjtésével és tisztításával.

- Belső dokumentáció: Gyűjtse össze a termék specifikációit, a folyamatok útmutatóit és a szabályzati dokumentumokat.

- Korábbi kommunikáció: E-mail sablonok, ügyfélszolgálati válaszok és értekezletek összefoglalói gyűjtése

- Domén terminológia: Összeállíthat szótárakat, rövidítések meghatározásait és iparág-specifikus nyelvet.

Az összegyűjtött információkat formázza utasítás-válasz párokká a felügyelt finomhangoláshoz. Például egy utasítás lehet „Összefoglalja ezt a támogatási jegyet”, és a válasz egy tiszta, tömör összefoglalás lenne. Ez a lépés elengedhetetlen ahhoz, hogy a modell megtanulja, hogyan kell elvégezni bizonyos feladatokat az Ön adataival.

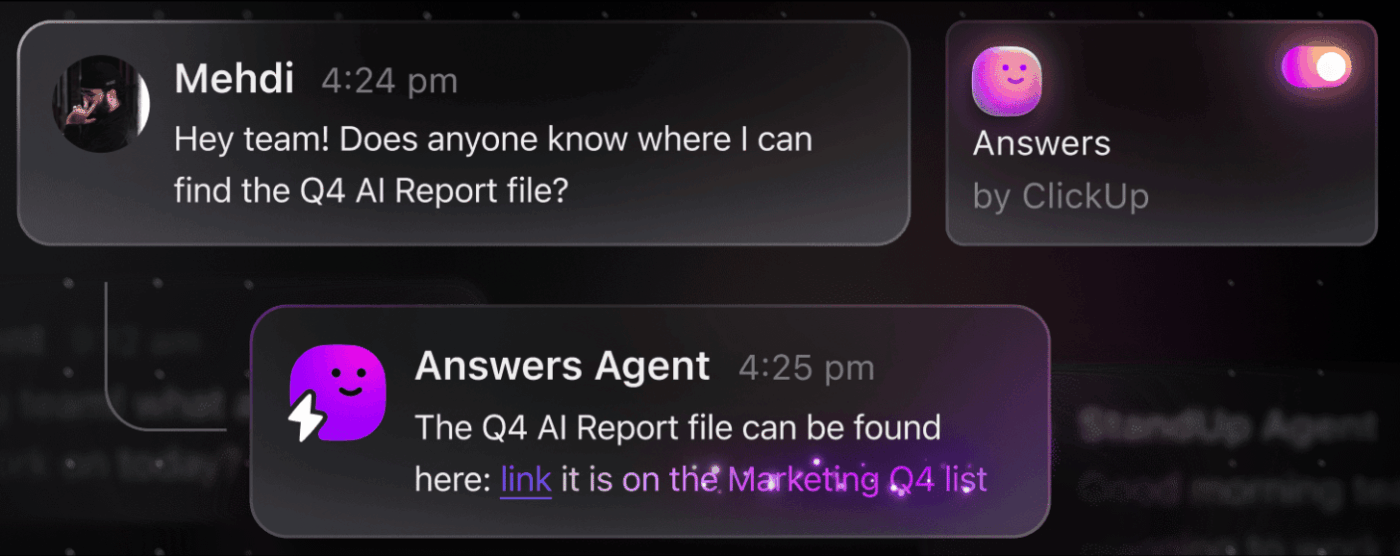

📮 ClickUp Insight: Az átlagos szakember naponta több mint 30 percet tölt munkával kapcsolatos információk keresésével – ez évente több mint 120 óra, amelyet e-mailek, Slack-szálak és szétszórt fájlok átkutatásával veszteget el. A munkaterületébe beágyazott intelligens AI asszisztens megváltoztathatja ezt.

Ismerje meg a ClickUp Brain szolgáltatást. Azonnali betekintést és válaszokat nyújt azáltal, hogy másodpercek alatt felkutatja a megfelelő dokumentumokat, beszélgetéseket és feladatokat, így Ön abbahagyhatja a keresést és elkezdheti a munkát.

💫 Valós eredmények: A QubicaAMF-hez hasonló csapatok a ClickUp használatával hetente több mint 5 órát spóroltak meg – ez évente több mint 250 óra fejenként –, mivel megszüntették az elavult tudásmenedzsment-folyamatokat. Képzelje el, mit tudna létrehozni a csapata egy negyedévente egy plusz hétnyi termelékenységgel!

Finomítsa a LLaMA-t az üzleti környezetéhez igazítva

A finomhangolás az a folyamat, amelynek során a LLaMA meglévő tudását az Ön konkrét felhasználási esetéhez igazítják, ami jelentősen javítja a modell pontosságát a domain-specifikus feladatokban. Ahelyett, hogy a modellt a nulláról képezné, paraméterhatékony módszereket alkalmazhat, amelyek csak a modell paramétereinek egy kis részét frissítik, így időt és számítási erőforrásokat takaríthat meg.

Népszerű finomhangolási módszerek:

- LoRA (Low-Rank Adaptation): Ez a módszer a teljes modell helyett kis „adapter” mátrixokat képez, ami rendkívül hatékonnyá teszi.

- QLoRA: Ez a LoRA-t kvantálással kombinálja, hogy egyetlen 48 GB-os GPU- n is finomhangolás legyen lehetséges, miközben a teljes finomhangolási teljesítményt is biztosítja.

- Teljes finomhangolás: Ez a modell összes paraméterét frissíti, a legmélyebb szintű testreszabást kínálja, de jelentős számítási teljesítményt igényel.

📚 Olvassa el még: Vállalati generatív AI eszközök, amelyek átalakítják a munkát

A modell teljesítményének értékelése és iterálása

Honnan tudja, hogy az egyedi modellje valóban működik? Az AI értékelésének túl kell lépnie az egyszerű pontossági pontszámokon, és a valós világban való hasznosságot kell mérnie. Hozzon létre olyan értékelési adatkészleteket, amelyek tükrözik a termelési felhasználási eseteit, és kövesse nyomon az üzleti tevékenységéhez fontos mutatókat, például a válaszok minőségét, a tényszerű pontosságot és a késleltetést.

- Minőségi értékelés: Emberi értékelőkkel értékelje a kimeneteket hangnem, hasznosság és helyesség szempontjából.

- Kvantitatív mutatók: Használjon automatizált pontszámokat, például BLEU-t vagy perplexity-t a teljesítmény nagyságrendű nyomon követéséhez.

- Termelésfigyelés: A bevezetés után kövesse nyomon a felhasználói visszajelzéseket és a hibaarányokat, hogy azonosítsa a fejlesztésre szoruló területeket.

💡Ez az iteratív képzési és értékelési folyamat önmagában is egy projekt lehet. Kezelje AI fejlesztési életciklusát közvetlenül a ClickUp-ban, ahelyett, hogy eltévedne a táblázatokban.

A ClickUp Dashboards segítségével központosíthatja a teljesítménymutatókat és az értékelési eredményeket egy nézetben. A ClickUp Custom Fields segítségével nyomon követheti a modellverziókat, a képzési paramétereket és az értékelési pontszámokat a többi termékkel együtt, így minden rendezett és áttekinthető marad. 🛠️

A LLaMA legfontosabb vállalati felhasználási esetei

A csapatok gyakran elakadnak az elemzési bénulásban, és képtelenek átlépni az AI-vel kapcsolatos elvont lelkesedésről a konkrét alkalmazásokra. A LLaMA rugalmassága alkalmassá teszi a vállalati munkafolyamatok széles körére, segítve a feladatok automatizálását és a hatékonyabb munkavégzést.

Íme néhány példa a testreszabott LLaMA-modell legfontosabb felhasználási területeire:

- Belső tudásasszisztensek: Ne pazarolja az idejét információk keresésével. Telepítse a LLaMA-t a RAG-gal, hogy létrehozzon egy chatbotot, amely azonnali választ ad a munkavállalók kérdéseire a belső wikik, irányelv-dokumentumok és korábbi projektkommunikációk átkutatása révén.

- Ügyfélszolgálati automatizálás: Finomítsa a modellt a jegyelőzmények alapján, hogy automatikusan válaszokat fogalmazzon meg, kategorizálja a kérdéseket, és a bonyolult problémákat a megfelelő ügyintézőhöz továbbítsa.

- Kódgenerálás és felülvizsgálat: Segítsen mérnöki csapatának hatékonyabban dolgozni. Használja a LLaMA-t sablonkódok generálásához, komplex örökölt rendszerek magyarázatához, sőt, a pull requestekben rejlő potenciális hibák azonosításához is, mielőtt azok problémává válnának.

- Dokumentumfeldolgozás: alakítson nagy mennyiségű szöveget hasznos információkká. Összefoglaljon hosszú jelentéseket, vonjon ki kulcsszavakat jogi szerződésekből, vagy készítsen tömör értekezési jegyzeteket nyers átiratokból másodpercek alatt.

- Tartalomkészítési munkafolyamatok: Legyőzze az írói blokkot. Készítsen marketing szövegeket, termékleírásokat és belső közleményeket, amelyeket az emberi szerkesztők finomíthatnak és tökéletesíthetnek.

💡A ClickUp Brain segítségével számos ilyen felhasználási esetet azonnal elérhet.

- Összegezze a feladat szálakat, készítsen projektfrissítéseket és generáljon tartalmat a ClickUp AI-alapú írási segítségével.

- A ClickUp Enterprise Search és az előre elkészített Ambient Answers ügynök segítségével azonnal megtalálhatja a válaszokat az egész munkaterületén.

- Készítsen intelligens munkafolyamatokat, amelyek elvégzik a rutinmunkát az Ön helyett a ClickUp Automations segítségével.

A LLaMA vállalati mesterséges intelligencia céljára történő használatának korlátai

Bár a LLaMA saját hosztolása jelentős ellenőrzést biztosít, ez nem jár kihívások nélkül. A csapatok gyakran alábecsülik a működési költségeket, és az innováció helyett a karbantartásba merülnek bele. Mielőtt elköteleződne a „fejlesztés” útján, fontos megérteni a lehetséges akadályokat.

Íme néhány fontos korlátozás, amelyet figyelembe kell venni:

- Infrastruktúra követelmények: A nagy modellek futtatása drága, és nagy teljesítményű, vállalati szintű GPU-kat igényel, amelyekkel sok szervezet nem rendelkezik.

- Szükséges technikai szakértelem: A nagy nyelvi modellek telepítése, finomhangolása és karbantartása speciális gépi tanulási mérnöki ismereteket igényel, amelyek iránt nagy a kereslet.

- Folyamatos karbantartási terhek: Ez nem egy „beállít és elfelejti” típusú megoldás. A modelleket folyamatosan figyelni kell, biztonsági frissítéseket kell végrehajtani, és az üzleti tevékenység fejlődésével újra kell képezni őket.

- Hallucinációs kockázat: Mint minden LLM, az LLaMA is néha hihetőnek tűnő, de helytelen információkat generálhat. A vállalati alkalmazásokhoz szilárd korlátok és emberi felügyelet szükségesek ennek a kockázatnak a csökkentése érdekében.

- Nincsenek beépített vállalati funkciók: A kritikus funkciókat, mint például a hozzáférés-vezérlés, az auditnaplózás és a megfelelőségi eszközök, külön kell megépíteni és kezelni, ami további bonyolultságot jelent.

💡A ClickUp Brain használatával elkerülheti ezeket a korlátozásokat. A ClickUp Brain a meglévő munkaterületén belül kezelt mesterséges intelligenciát biztosít, így a vállalati mesterséges intelligencia képességeit operatív többletköltségek nélkül veheti igénybe. A ClickUp segítségével vállalati szintű biztonságot érhet el és megszüntetheti az infrastruktúra karbantartását, így csapata szabadon összpontosíthat alapvető feladataikra.

📮ClickUp Insight: A felmérésünkben résztvevők 88%-a használja az AI-t személyes feladatokhoz, de több mint 50% nem meri használni a munkahelyén. A három fő akadály? A zökkenőmentes integráció hiánya, a tudáshiány vagy a biztonsági aggályok.

De mi van akkor, ha az AI be van építve a munkaterületébe, és már biztonságos? A ClickUp Brain, a ClickUp beépített AI asszisztense ezt valósággá teszi. Megérti a közönséges nyelvű utasításokat, megoldva mindhárom AI-bevezetési problémát, miközben összekapcsolja a csevegést, a feladatokat, a dokumentumokat és a tudást a munkaterületen. Találjon válaszokat és betekintést egyetlen kattintással!

Alternatív AI-eszközök vállalati felhasználási esetekhez

A sok rendelkezésre álló lehetőség közül a megfelelő AI-eszköz kiválasztása minden csapat számára kihívást jelent. Megpróbálja kitalálni a különböző modellek közötti kompromisszumokat, de attól tart, hogy rosszat választ és pazarolja az erőforrásokat.

Ez gyakran vezet AI-terjedéshez – az AI-eszközök és platformok nem tervezett, felügyelet és stratégia nélküli elterjedéséhez –, amikor a csapatok több, egymástól független szolgáltatást vesznek igénybe, ami több munkát eredményez, ahelyett, hogy kevesebbet.

Íme egy rövid áttekintés a főbb szereplőkről és azok helyéről:

| Eszköz | Legalkalmasabb | Fontos szempontok |

|---|---|---|

| LLaMA (saját szerveren futó) | Maximális ellenőrzés, adatfelügyelet | ML-infrastruktúra és szakértelem szükséges |

| OpenAI GPT-4 | Legmagasabb teljesítmény, minimális beállítás | Az adatok elhagyják a környezetet, használat alapú árazás |

| Claude (Anthropic) | Hosszú kontextusú feladatok, biztonsági fókusz | Hasonló kompromisszumok, mint a GPT-4 esetében |

| Mistral | Európai adatkezelés, hatékonyság | Kisebb ökoszisztéma, mint az LLaMA |

| ClickUp Brain | Integrált munkaterületi AI, telepítés nélkül | A legjobb megoldás azoknak a csapatoknak, amelyek a meglévő munkafolyamatokba szeretnék beépíteni az AI-t. |

Ahelyett, hogy több eszközt kapcsolna össze az igényeinek kielégítése érdekében, miért ne használná a munkahelyén közvetlenül beépített mesterséges intelligenciát? Ez a ClickUp által kínált világ első konvergens mesterséges intelligencia munkaterületének lényege – egy egyetlen, biztonságos platform, ahol a projektek, dokumentumok, beszélgetések és elemzések együtt léteznek.

Egységesíti az eszközöket, hogy megszüntesse a kontextus széttagoltságát, azaz azt a fragmentációt, amely akkor jelentkezik, amikor a csapatok órákat pazarolnak az alkalmazások közötti váltogatásra és a munkájukhoz szükséges információk keresésére.

ClickUp + kontextusfüggő mesterséges intelligencia = mérhető átalakulás

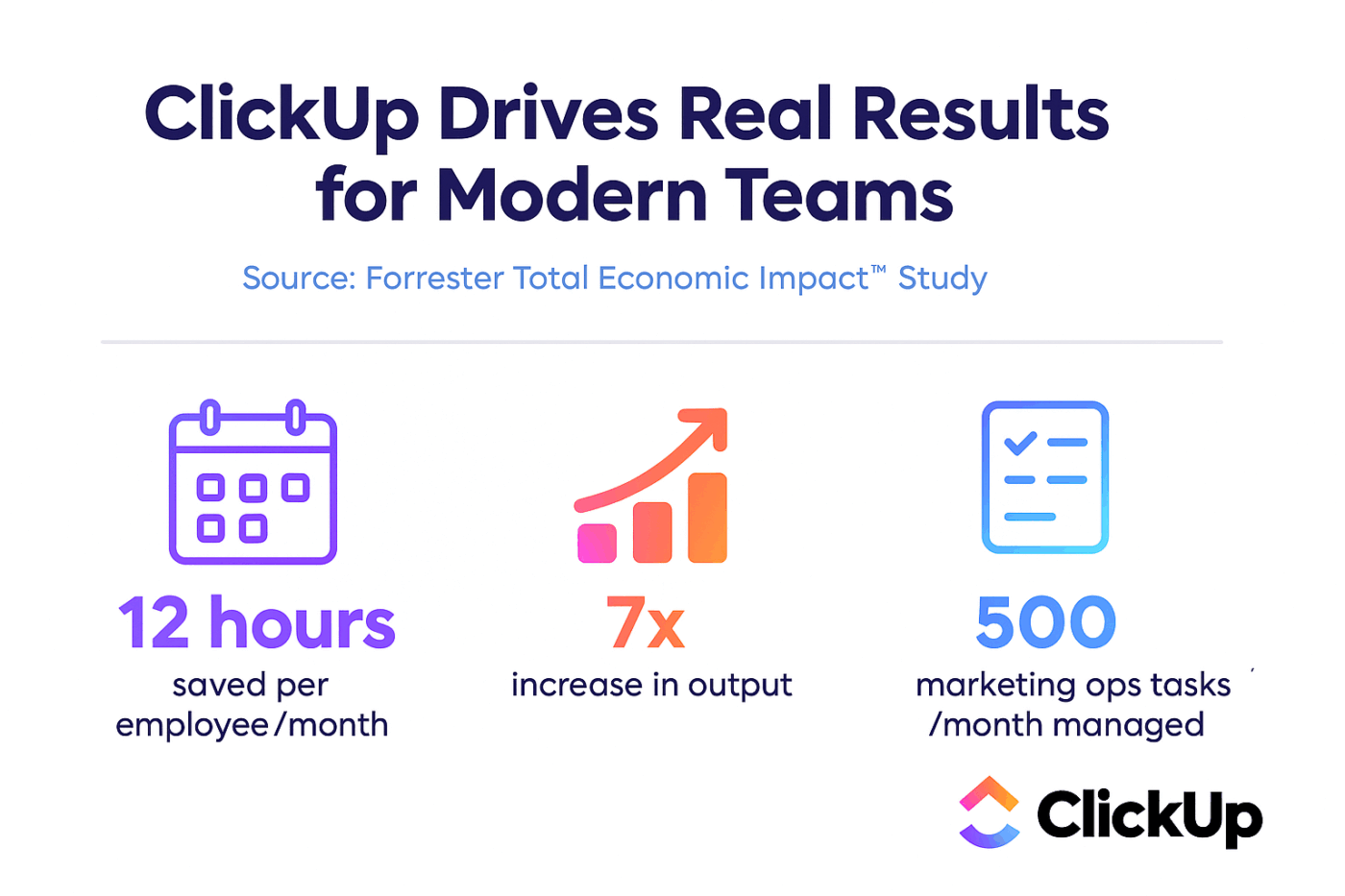

A Forrester Economic Impact™ tanulmánya szerint a ClickUp-ot használó csapatok 384%-os ROI-t értek el és 92 400 órát spóroltak meg a harmadik évre.

Ha a kontextus, a munkafolyamatok és az intelligencia egy helyen található, a csapatok nem csak dolgoznak. Hanem nyernek.

A ClickUp emellett biztosítja a vállalati telepítésekhez szükséges biztonsági és adminisztrációs funkciókat is, SOC 2 Type II megfelelőséggel, SSO integrációval, SCIM provisioninggel és részletes jogosultság-vezérléssel.

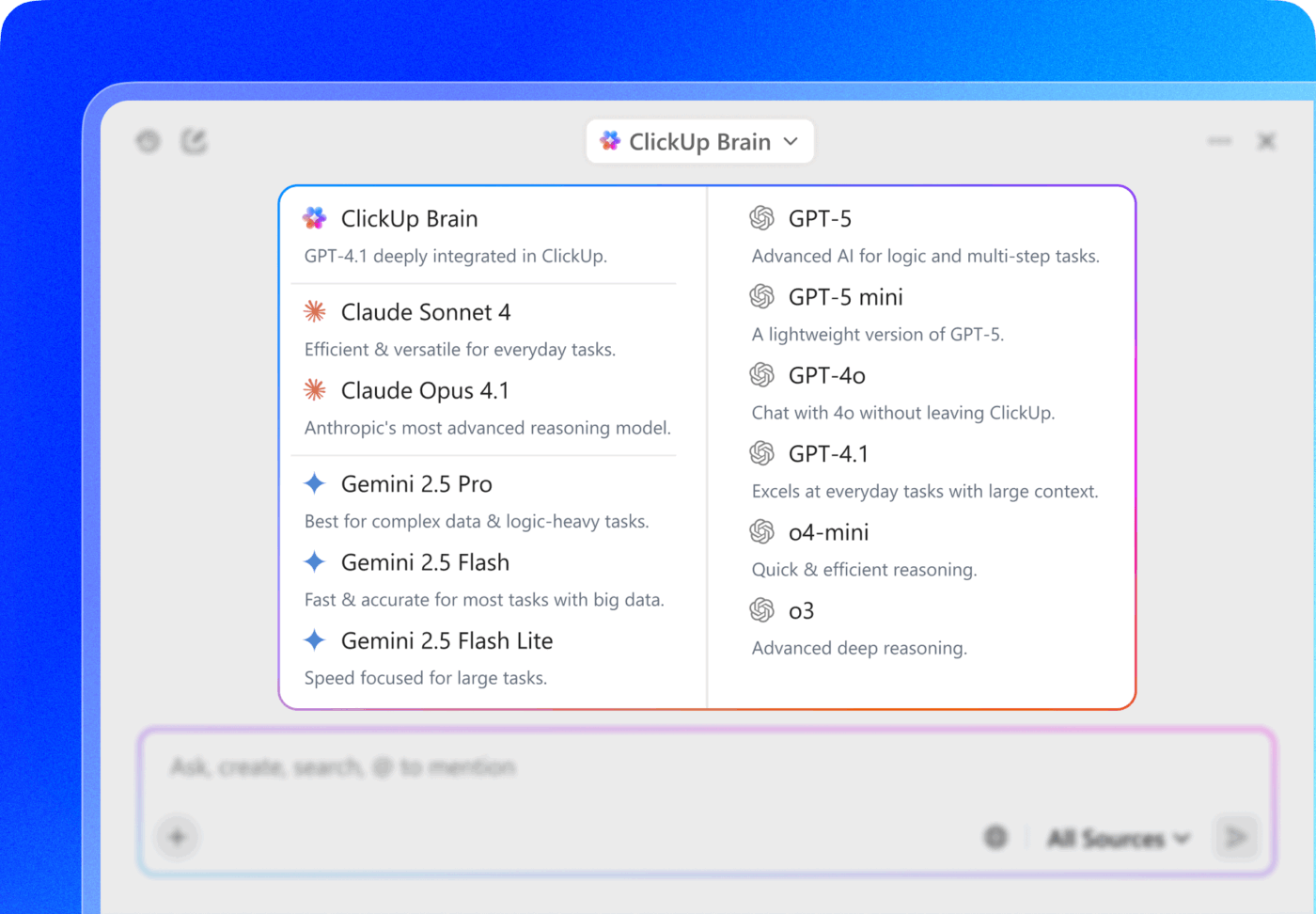

A ClickUp Brain MAX több LLM-hez való hozzáférésével közvetlenül a keresőfelületről választhat prémium modellek közül, mint például a ChatGPT, a Claude és a Gemini. A platform automatikusan a feladatra legalkalmasabb modellhez irányítja a lekérdezést, így több előfizetés kezelése nélkül is a legjobb eredményt kapja.

Szerezze be a teljes csomagot – AI-képességek, projektmenedzsment, dokumentáció és kommunikáció – egy helyen a ClickUp segítségével, ahelyett, hogy a LLaMA segítségével a nulláról építené fel az AI-réteget.

Haladjon előre a vállalati mesterséges intelligenciával a ClickUp segítségével

Az LLaMA a vállalati csapatoknak egy nyitott súlyú alternatívát kínál a zárt AI API-k helyett, jelentős ellenőrzést, költségelőrejelzhetőséget és testreszabhatóságot biztosítva. A siker azonban nem csak a technológiától függ. Megfelelő modellt kell találni a megfelelő felhasználási esethez, befektetni kell a magas minőségű képzési adatokba, és robusztus értékelési folyamatokat kell kiépíteni.

A „fejlesztés vagy vásárlás” döntés végső soron a csapat technikai kapacitásától függ. Az egyedi megoldás fejlesztése maximális rugalmasságot kínál, de jelentős többletköltségekkel is jár. Az igazi kihívás nem csak az AI-hez való hozzáférés, hanem annak integrálása a napi munkafolyamatokba anélkül, hogy további AI-terjeszkedést és adatsilókat hozna létre.

A ClickUp Brain segítségével közvetlenül beépítheti az LLM képességeit a projektmenedzsmentbe, a dokumentációba és a csapatkommunikációba, anélkül, hogy bonyolult infrastruktúrát kellene kiépítenie és karbantartania. Kezdje el ingyenesen a ClickUp használatát, és építse be az AI képességeit a meglévő munkafolyamatokba. 🙌

Gyakran ismételt kérdések (GYIK)

Igen, a Llama 3 közösségi licenc a legtöbb szervezet számára engedélyezi a kereskedelmi felhasználást. Csak azoknak a vállalatoknak kell külön licencet szerezniük a Metától, amelyek havi aktív felhasználóinak száma meghaladja a 700 milliót.

Az LLaMA önálló tárolás révén nagyobb adatellenőrzést és kiszámíthatóbb költségeket biztosít, míg a GPT-4 kevesebb beállítással magasabb teljesítményt nyújt. A termelékenység érdekében azonban integrált eszközök, például a ClickUp Brain segítségével AI-támogatást kaphat anélkül, hogy az alapul szolgáló modelleket kezelnie kellene.

A saját szerveren futó LLaMA az adatokat az Ön infrastruktúráján tárolja, ami kiváló megoldás az adatok tárolási helye szempontjából. Ugyanakkor Ön felelős a saját hozzáférés-vezérlőinek, auditnaplóinak és tartalomszűrőinek megvalósításáért – ezek olyan biztonsági funkciók, amelyek általában a kezelt AI-szolgáltatások részét képezik.

A LLaMA közvetlen telepítése és finomhangolása jelentős gépi tanulási mérnöki ismereteket igényel. Az ilyen szakértelemmel nem rendelkező csapatok a ClickUp Brainhez hasonló felügyelt platformokon keresztül férhetnek hozzá a LLaMA-alapú funkciókhoz, amelyek modelltelepítés vagy technikai konfiguráció nélkül biztosítják a mesterséges intelligencia funkciókat.