Velké jazykové modely (LLM) otevřely nové vzrušující možnosti pro softwarové aplikace. Umožňují vytvořit inteligentnější a dynamičtější systémy než kdykoli předtím.

Odborníci předpovídají, že do roku 2025 by aplikace založené na těchto modelech mohly automatizovat téměř polovinu veškeré digitální práce.

Jakmile však tyto možnosti odemkneme, vyvstává výzva: jak spolehlivě měřit kvalitu jejich výstupů ve velkém měřítku? Stačí malá změna v nastavení a najednou se díváte na výrazně odlišný výstup. Tato variabilita může ztěžovat měření jejich výkonu, což je při přípravě modelu pro použití v reálném světě zásadní.

Tento článek přináší informace o nejlepších postupech při hodnocení systému LLM, od testování před nasazením až po produkci. Tak pojďme na to!

Co je hodnocení LLM?

Metriky hodnocení LLM jsou způsob, jak zjistit, zda vaše pokyny, nastavení modelu nebo pracovní postupy splňují stanovené cíle. Tyto metriky vám poskytnou přehled o tom, jak dobře funguje váš velký jazykový model a zda je skutečně připraven pro použití v reálném světě.

V současné době se nejčastěji používají metriky, které měří vybavení kontextu v úkolech generování rozšířeného vyhledávání (RAG), přesné shody pro klasifikace, ověření JSON pro strukturované výstupy a sémantickou podobnost pro kreativnější úkoly.

Každá z těchto metrik jedinečným způsobem zajišťuje, že LLM splňuje standardy pro váš konkrétní případ použití.

Proč je třeba LLM hodnotit?

Velké jazykové modely (LLM) se dnes používají v celé řadě aplikací. Je nezbytné hodnotit výkonnost modelů, aby bylo zajištěno, že splňují očekávané standardy a účinně slouží zamýšleným účelům.

Přemýšlejte o tom takto: LLM pohánějí vše od chatbotů zákaznické podpory až po kreativní nástroje a s tím, jak se stávají pokročilejšími, objevují se na stále více místech.

To znamená, že potřebujeme lepší způsoby jejich monitorování a hodnocení – tradiční metody prostě nestačí na všechny úkoly, které tyto modely zpracovávají.

Dobré hodnotící metriky jsou jako kontrola kvality pro LLM. Ukazují, zda je model spolehlivý, přesný a dostatečně efektivní pro použití v reálném světě. Bez těchto kontrol by mohly uniknout chyby, které by vedly k frustrujícím nebo dokonce zavádějícím uživatelským zkušenostem.

Pokud máte silné hodnotící metriky, je snazší odhalit problémy, vylepšit model a zajistit, aby byl připraven splnit konkrétní potřeby svých uživatelů. Tímto způsobem víte, že platforma AI, se kterou pracujete, splňuje standardy a může poskytovat výsledky, které potřebujete.

📖 Číst více: LLM vs. generativní AI: podrobný průvodce

Typy hodnocení LLM

Hodnocení poskytuje jedinečný pohled na schopnosti modelu. Každý typ se zabývá různými aspekty kvality a pomáhá vytvořit spolehlivý, bezpečný a efektivní model nasazení.

Zde jsou různé typy metod hodnocení LLM:

- Intrinsické hodnocení se zaměřuje na vnitřní výkon modelu při konkrétních jazykových nebo porozuměních úkolech bez zapojení reálných aplikací. Obvykle se provádí během vývojové fáze modelu, aby se pochopily jeho základní schopnosti.

- Extrinsické hodnocení posuzuje výkon modelu v reálných aplikacích. Tento typ hodnocení zkoumá, jak dobře model splňuje konkrétní cíle v daném kontextu.

- Hodnocení robustnosti testuje stabilitu a spolehlivost modelu v různých scénářích, včetně neočekávaných vstupů a nepříznivých podmínek. Identifikuje potenciální slabiny a zajišťuje, že se model chová předvídatelně.

- Testování efektivity a latence zkoumá využití zdrojů, rychlost a latenci modelu. Zajišťuje, že model může provádět úkoly rychle a za rozumnou výpočetní cenu, což je nezbytné pro škálovatelnost.

- Hodnocení etiky a bezpečnosti zajišťuje, že model je v souladu s etickými standardy a bezpečnostními pokyny, což je v citlivých aplikacích zásadní.

Hodnocení modelů LLM vs. hodnocení systémů LLM

Hodnocení velkých jazykových modelů (LLM) zahrnuje dva hlavní přístupy: hodnocení modelů a hodnocení systémů. Každý z nich se zaměřuje na jiné aspekty výkonu LLM a znalost rozdílu mezi nimi je nezbytná pro maximalizaci potenciálu těchto modelů.

🧠 Hodnocení modelů se zaměřuje na obecné dovednosti LLM. Tento typ hodnocení testuje schopnost modelu porozumět jazyku, generovat jej a pracovat s ním přesně v různých kontextech. Je to jako sledovat, jak dobře model zvládá různé úkoly, téměř jako test obecné inteligence.

Například při hodnocení modelů se může objevit otázka: „Jak univerzální je tento model?“

🎯 Hodnocení systému LLM měří, jak LLM funguje v rámci konkrétního nastavení nebo účelu, například v chatbotu zákaznického servisu. Zde nejde tolik o široké schopnosti modelu, ale spíše o to, jak plní konkrétní úkoly za účelem zlepšení uživatelské zkušenosti.

Hodnocení systému se však zaměřuje na otázky typu: „Jak dobře model zvládá tento konkrétní úkol pro uživatele?“

Hodnocení modelů pomáhá vývojářům porozumět celkovým schopnostem a omezením LLM a nasměrovat vylepšení. Hodnocení systému se zaměřuje na to, jak dobře LLM splňuje potřeby uživatelů v konkrétních kontextech, a zajišťuje tak plynulejší uživatelský zážitek.

Společně tyto hodnocení poskytují ucelený obraz o silných stránkách a oblastech, které je třeba v LLM vylepšit, čímž se stává výkonnějším a uživatelsky přívětivějším v reálných aplikacích.

Nyní se podívejme na konkrétní metriky pro hodnocení LLM.

Metriky pro hodnocení LLM

Mezi spolehlivé a moderní metriky hodnocení patří:

1. Zmatek

Perplexita měří, jak dobře jazykový model předpovídá posloupnost slov. V podstatě udává nejistotu modelu ohledně dalšího slova ve větě. Nižší skóre perplexity znamená, že model je si svými předpověďmi jistější, což vede k lepšímu výkonu.

📌 Příklad: Představte si, že model generuje text z podnětu „Kočka seděla na...“. Pokud předpovídá vysokou pravděpodobnost slov jako „rohožka“ a „podlaha“, dobře rozumí kontextu, což vede k nízkému skóre perplexity.

Na druhou stranu, pokud navrhne nesouvisející slovo, jako je „vesmírná loď“, skóre zmatenosti bude vyšší, což naznačuje, že model má potíže s předpovědí smysluplného textu.

2. Skóre BLEU

Skóre BLEU (Bilingual Evaluation Understudy) se používá především k hodnocení strojového překladu a generování textu.

Měří, kolik n-gramů (sousedících sekvencí n položek z daného textového vzorku) ve výstupu se překrývá s těmi v jednom nebo více referenčních textech. Skóre se pohybuje od 0 do 1, přičemž vyšší skóre znamená lepší výkon.

📌 Příklad: Pokud váš model generuje větu „The quick brown fox jumps over the lazy dog“ (Rychlá hnědá liška skáče přes líného psa) a referenční text je „A fast brown fox leaps over a lazy dog“ (Rychlá hnědá liška skáče přes líného psa), BLEU porovná sdílené n-gramy.

Vysoké skóre znamená, že generovaná věta se velmi podobá referenčnímu textu, zatímco nižší skóre může naznačovat, že generovaný výstup není zcela v souladu.

3. Skóre F1

Metrika hodnocení LLM F1 skóre slouží především pro klasifikační úkoly. Měří rovnováhu mezi přesností (správnost pozitivních předpovědí) a recall (schopnost identifikovat všechny relevantní případy).

Hodnocení se pohybuje v rozmezí od 0 do 1, přičemž skóre 1 znamená dokonalou přesnost.

📌 Příklad: V úkolu odpovídání na otázky, pokud je model dotázán „Jakou barvu má obloha?“ a odpoví „Obloha je modrá“ (pravdivá pozitivní odpověď), ale také „Obloha je zelená“ (falešná pozitivní odpověď), skóre F1 zohlední jak relevanci správné odpovědi, tak i nesprávné odpovědi.

Tato metrika pomáhá zajistit vyvážené hodnocení výkonu modelu.

4. METEOR

METEOR (Metric for Evaluation of Translation with Explicit ORdering) jde nad rámec přesného porovnání slov. Zohledňuje synonyma, odvozování slov a parafráze, aby vyhodnotil podobnost mezi generovaným textem a referenčním textem. Tato metrika se snaží více přiblížit lidskému úsudku.

📌 Příklad: Pokud váš model generuje „Kočka odpočívala na koberci“ a referenční text je „Kočka ležela na koberci“, METEOR by tomuto výsledku dal vyšší skóre než BLEU, protože rozpozná, že „kočka“ je synonymum pro „kočku“ a „koberce“ a „koberec“ mají podobný význam.

Díky tomu je METEOR obzvláště užitečný pro zachycení jazykových nuancí.

5. BERTScore

BERTScore hodnotí podobnost textu na základě kontextových vnoření odvozených z modelů jako BERT (Bidirectional Encoder Representations from Transformers). Zaměřuje se spíše na význam než na přesnou shodu slov, což umožňuje lepší posouzení sémantické podobnosti.

📌 Příklad: Při porovnání vět „Auto uhánělo po silnici“ a „Vozidlo se řítilo po ulici“ analyzuje BERTScore spíše skrytý význam než pouze výběr slov.

I když se slova liší, celkové myšlenky jsou podobné, což vede k vysokému skóre BERTScore, které odráží účinnost generovaného obsahu.

6. Lidské hodnocení

Lidské hodnocení zůstává klíčovým aspektem hodnocení LLM. Zahrnuje hodnocení kvality výstupů modelu lidskými hodnotiteli na základě různých kritérií, jako je plynulost a relevance. K získání zpětné vazby lze použít techniky jako Likertova stupnice a A/B testování.

📌 Příklad: Po vygenerování odpovědí od chatbota zákaznického servisu mohou lidští hodnotitelé ohodnotit každou odpověď na stupnici od 1 do 5. Pokud chatbot poskytne jasnou a užitečnou odpověď na dotaz zákazníka, může například získat 5, zatímco vágní nebo matoucí odpověď může získat 2.

7. Metriky specifické pro danou úlohu

Různé úkoly LLM vyžadují přizpůsobené metriky hodnocení.

U dialogových systémů mohou metriky hodnotit míru zapojení uživatelů nebo míru dokončení úkolů. U generování kódu lze úspěch měřit podle toho, jak často se generovaný kód kompiluje nebo prochází testy.

📌 Příklad: V chatbotu zákaznické podpory lze úroveň zapojení měřit podle toho, jak dlouho uživatelé zůstávají v konverzaci nebo kolik následných otázek kladou.

Pokud uživatelé často žádají o další informace, znamená to, že model je úspěšně zapojuje a efektivně řeší jejich dotazy.

8. Robustnost a spravedlnost

Hodnocení robustnosti modelu zahrnuje testování toho, jak dobře reaguje na neočekávané nebo neobvyklé vstupy. Metriky spravedlnosti pomáhají identifikovat zaujatost ve výstupech modelu a zajišťují, že funguje spravedlivě napříč různými demografickými skupinami a scénáři.

📌 Příklad: Při testování modelu s neobvyklou otázkou, jako je „Co si myslíte o jednorožcích?“, by měl model otázku elegantně zpracovat a poskytnout relevantní odpověď. Pokud místo toho poskytne nesmyslnou nebo nevhodnou odpověď, znamená to, že není dostatečně robustní.

Testování spravedlnosti zajišťuje, že model nevytváří zaujaté nebo škodlivé výstupy, a podporuje tak inkluzivnější systém AI.

📖 Číst více: Rozdíl mezi strojovým učením a umělou inteligencí

9. Metriky efektivity

S rostoucí složitostí jazykových modelů je stále důležitější měřit jejich efektivitu z hlediska rychlosti, využití paměti a spotřeby energie. Metriky efektivity pomáhají vyhodnotit, jak náročný na zdroje je model při generování odpovědí.

📌 Příklad: U velkého jazykového modelu může měření efektivity zahrnovat sledování rychlosti, s jakou generuje odpovědi na dotazy uživatelů, a množství paměti, které při tomto procesu využívá.

Pokud trvá odpověď příliš dlouho nebo spotřebovává nadměrné množství zdrojů, může to být problém pro aplikace vyžadující výkon v reálném čase, jako jsou chatboty nebo překladatelské služby.

Nyní víte, jak hodnotit model LLM. Ale jaké nástroje můžete k měření použít? Pojďme to prozkoumat.

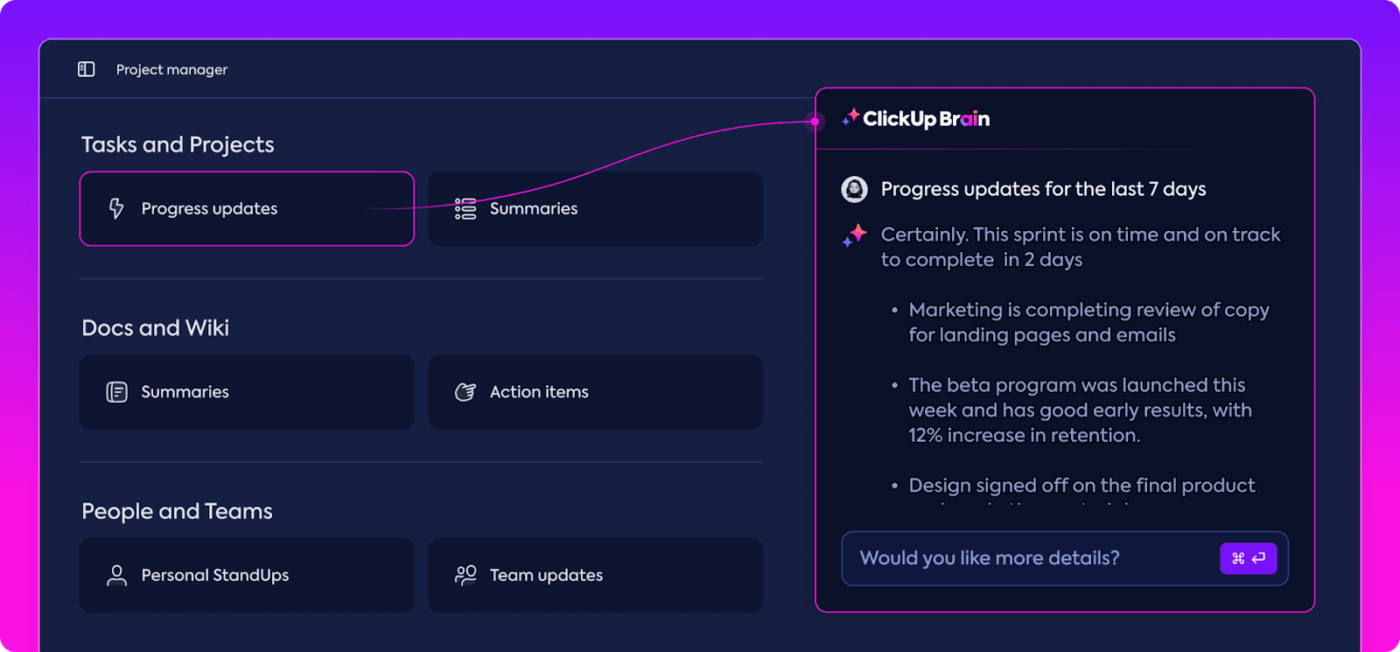

Jak ClickUp Brain může vylepšit hodnocení LLM

ClickUp je aplikace pro vše, co souvisí s prací, s vestavěným osobním asistentem nazvaným ClickUp Brain.

ClickUp Brain je revoluční nástroj pro hodnocení výkonu LLM. Co tedy umí?

Organizuje a zvýrazňuje nejrelevantnější data, takže váš tým zůstane na správné cestě. Díky funkcím založeným na umělé inteligenci je ClickUp Brain jedním z nejlepších softwarů pro neuronové sítě na trhu. Celý proces je díky němu plynulejší, efektivnější a spolupracující než kdykoli předtím. Pojďme společně prozkoumat jeho možnosti.

Inteligentní správa znalostí

Při hodnocení velkých jazykových modelů (LLM) může být správa obrovského množství dat velmi náročná.

ClickUp Brain dokáže organizovat a zdůrazňovat důležité metriky a zdroje přizpůsobené speciálně pro hodnocení LLM. Namísto prohledávání roztroušených tabulek a obsáhlých zpráv ClickUp Brain shromažďuje vše na jednom místě. Metriky výkonu, srovnávací data a výsledky testů jsou přístupné v přehledném a uživatelsky přívětivém rozhraní.

Tato organizace pomáhá vašemu týmu zbavit se rušivých vlivů a soustředit se na skutečně důležité informace, což usnadňuje interpretaci trendů a výkonnostních vzorců.

Díky tomu, že máte vše, co potřebujete, na jednom místě, můžete přejít od pouhého sběru dat k efektivnímu rozhodování založenému na datech a přeměnit tak nadbytek informací na využitelné informace.

Plánování projektů a řízení pracovních postupů

Hodnocení LLM vyžaduje pečlivé plánování a spolupráci, a ClickUp usnadňuje správu tohoto procesu.

Můžete snadno delegovat odpovědnosti, jako je sběr dat, školení modelů a testování výkonu, a zároveň nastavit priority, aby se nejdůležitější úkoly dostaly do popředí. Kromě toho vám vlastní pole umožňují přizpůsobit pracovní postupy konkrétním potřebám vašeho projektu.

Díky ClickUp může každý vidět, kdo co dělá a kdy, což pomáhá předcházet zpožděním a zajišťuje hladký průběh úkolů v rámci celého týmu. Je to skvělý způsob, jak mít vše od začátku do konce organizované a pod kontrolou.

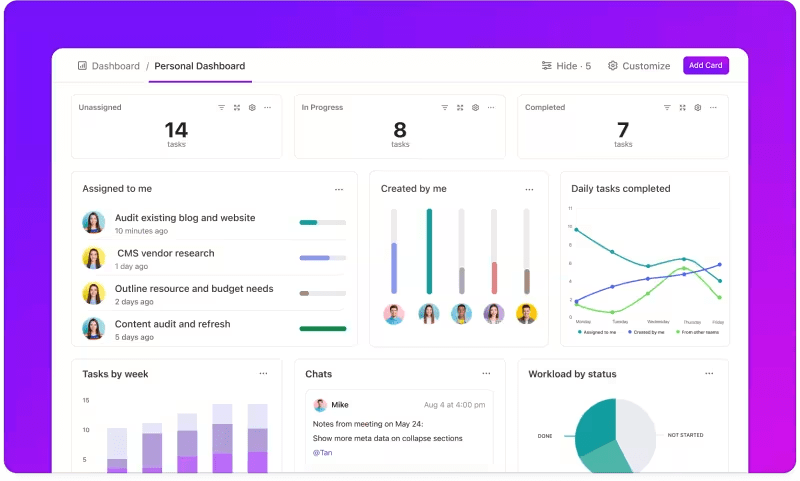

Sledování metrik prostřednictvím přizpůsobených dashboardů

Chcete pečlivě sledovat výkonnost svých systémů LLM?

Dashboardy ClickUp vizualizují výkonnostní ukazatele v reálném čase. Umožňují vám okamžitě sledovat pokrok vašeho modelu. Tyto dashboardy jsou vysoce přizpůsobitelné, takže můžete vytvářet grafy a tabulky, které přesně zobrazují to, co potřebujete, když to potřebujete.

Můžete sledovat, jak se přesnost vašeho modelu vyvíjí v jednotlivých fázích hodnocení, nebo rozebrat spotřebu zdrojů v každé fázi. Tyto informace vám umožní rychle odhalit trendy, identifikovat oblasti, které je třeba zlepšit, a provádět úpravy za běhu.

Místo čekání na další podrobnou zprávu vám ClickUp Dashboards umožní zůstat informovaní a pohotoví, což vašemu týmu umožní bez prodlení přijímat rozhodnutí založená na datech.

Automatizované přehledy

Analýza dat může být časově náročná, ale funkce ClickUp Brain vám ulehčí práci tím, že vám poskytne cenné informace. Zvýrazní důležité trendy a dokonce navrhne doporučení na základě dat, což usnadňuje vyvozování smysluplných závěrů.

Díky automatizovaným analýzám ClickUp Brain není nutné ručně prohledávat surová data a hledat v nich vzorce – ClickUp Brain je najde za vás. Tato automatizace uvolní váš tým, který se tak může soustředit na vylepšování výkonu modelu, místo aby se zabýval opakovanou analýzou dat.

Získané poznatky jsou připraveny k použití, takže váš tým může okamžitě zjistit, co funguje a kde by mohly být nutné změny. Díky zkrácení času stráveného analýzou pomáhá ClickUp vašemu týmu urychlit proces hodnocení a soustředit se na implementaci.

Dokumentace a spolupráce

Už nemusíte prohledávat e-maily nebo více platforem, abyste našli to, co potřebujete; vše je přímo před vámi, připravené, kdykoli budete potřebovat.

ClickUp Docs je centrální hub, který shromažďuje vše, co váš tým potřebuje pro hladké hodnocení LLM. Organizuje klíčovou projektovou dokumentaci, jako jsou kritéria benchmarkingu, výsledky testování a protokoly výkonu, na jednom přístupném místě, aby všichni měli rychlý přístup k nejnovějším informacím.

Co skutečně odlišuje ClickUp Docs, jsou jeho funkce pro spolupráci v reálném čase. Integrovaný ClickUp Chat a Komentáře umožňují členům týmu diskutovat o postřezích, poskytovat zpětnou vazbu a navrhovat změny přímo v dokumentech.

To znamená, že váš tým může diskutovat o zjištěních a provádět úpravy přímo na platformě, přičemž všechny diskuse zůstanou relevantní a věcné.

Vše od dokumentace po týmovou práci se odehrává v ClickUp Docs, což vytváří efektivní proces hodnocení, kde každý může vidět, sdílet a reagovat na nejnovější vývoj.

Výsledek? Plynulý, jednotný pracovní postup, který vašemu týmu umožní jasně směřovat k dosažení cílů.

Jste připraveni vyzkoušet ClickUp? Než tak učiníte, pojďme si projít několik tipů a triků, jak co nejlépe využít hodnocení LLM.

Osvědčené postupy při hodnocení LLM

Dobře strukturovaný přístup k hodnocení LLM zajišťuje, že model splňuje vaše potřeby, odpovídá očekáváním uživatelů a poskytuje smysluplné výsledky.

Stanovení jasných cílů, zohlednění koncových uživatelů a použití různých metrik pomáhá vytvořit důkladné hodnocení, které odhalí silné stránky a oblasti, které je třeba zlepšit. Níže uvádíme několik osvědčených postupů, které vám pomohou v tomto procesu.

🎯 Definujte jasné cíle

Před zahájením procesu hodnocení je důležité přesně vědět, čeho chcete pomocí velkého jazykového modelu (LLM) dosáhnout. Věnujte čas nastínění konkrétních úkolů nebo cílů modelu.

📌 Příklad: Pokud chcete zlepšit výkon strojového překladu, ujasněte si, jaké úrovně kvality chcete dosáhnout. Jasné cíle vám pomohou soustředit se na nejrelevantnější metriky, zajistí, že vaše hodnocení bude v souladu s těmito cíli, a přesně změří úspěch.

👥 Zvažte své publikum

Zamyslete se nad tím, kdo bude LLM používat a jaké jsou jeho potřeby. Je velmi důležité přizpůsobit hodnocení vašim zamýšleným uživatelům.

📌 Příklad: Pokud má váš model generovat poutavý obsah, budete se chtít zaměřit na metriky jako plynulost a soudržnost. Porozumění vašemu publiku vám pomůže zpřesnit kritéria hodnocení a zajistit, že model přinese skutečnou hodnotu v praktických aplikacích.

📊 Využijte různé metriky

Při hodnocení LLM se nespoléhejte pouze na jeden metrický ukazatel; kombinace více metrických ukazatelů vám poskytne ucelenější obraz o jeho výkonu. Každý metrický ukazatel zachycuje jiné aspekty, takže použití více ukazatelů vám pomůže identifikovat jak silné, tak slabé stránky.

📌 Příklad: Skóre BLEU je sice skvělé pro měření kvality překladu, ale nemusí pokrývat všechny nuance kreativního psaní. Začlenění metrik, jako je perplexita pro prediktivní přesnost, a dokonce i lidská hodnocení kontextu, může vést k mnohem komplexnějšímu pochopení toho, jak dobře váš model funguje.

Benchmarky a nástroje LLM

Hodnocení velkých jazykových modelů (LLM) se často opírá o standardní benchmarky a specializované nástroje, které pomáhají měřit výkon modelu v různých úkolech.

Zde je přehled některých široce používaných měřítek a nástrojů, které vnášejí strukturu a přehlednost do procesu hodnocení.

Klíčové benchmarky

- GLUE (General Language Understanding Evaluation): GLUE hodnotí schopnosti modelu v rámci několika jazykových úkolů, včetně klasifikace vět, podobnosti a dedukce. Jedná se o základní měřítko pro modely, které musí zvládat obecné porozumění jazyku.

- SQuAD (Stanford Question Answering Dataset): Hodnotící rámec SQuAD je ideální pro čtení s porozuměním a měří, jak dobře model odpovídá na otázky na základě textové pasáže. Běžně se používá pro úkoly, jako je zákaznická podpora a vyhledávání na základě znalostí, kde jsou přesné odpovědi zásadní.

- SuperGLUE: Jako vylepšená verze GLUE hodnotí SuperGLUE modely na základě složitějších úkolů v oblasti uvažování a kontextového porozumění. Poskytuje hlubší vhled, zejména pro aplikace vyžadující pokročilé porozumění jazyku.

Základní hodnotící nástroje

- Hugging Face : Je velmi populární díky své rozsáhlé knihovně modelů, datovým sadám a funkcím hodnocení. Jeho vysoce intuitivní rozhraní umožňuje uživatelům snadno vybírat benchmarky, přizpůsobovat hodnocení a sledovat výkon modelů, což jej činí univerzálním pro mnoho aplikací LLM.

- SuperAnnotate: Specializuje se na správu a anotování dat, což je zásadní pro úkoly řízeného učení. Je obzvláště užitečný pro zdokonalení přesnosti modelu, protože usnadňuje získávání vysoce kvalitních, lidmi anotovaných dat, která zlepšují výkon modelu při složitých úkolech.

- AllenNLP: AllenNLP, vyvinutý Allenovým institutem pro umělou inteligenci, je určen pro výzkumníky a vývojáře pracující na vlastních modelech NLP. Podporuje řadu benchmarků a poskytuje nástroje pro trénování, testování a hodnocení jazykových modelů, čímž nabízí flexibilitu pro různé aplikace NLP.

Kombinace těchto benchmarků a nástrojů nabízí komplexní přístup k hodnocení LLM. Benchmarky mohou stanovit standardy pro různé úkoly, zatímco nástroje poskytují strukturu a flexibilitu potřebnou k efektivnímu sledování, zdokonalování a zlepšování výkonu modelu.

Společně zajišťují, že LLM splňují jak technické standardy, tak praktické potřeby aplikace.

Výzvy při hodnocení modelu LLM

Hodnocení velkých jazykových modelů (LLM) vyžaduje nuancovaný přístup. Zaměřuje se na kvalitu odpovědí a pochopení přizpůsobivosti a omezení modelu v různých scénářích.

Vzhledem k tomu, že tyto modely jsou trénovány na rozsáhlých datových sadách, je jejich chování ovlivněno řadou faktorů, proto je nezbytné hodnotit více než jen přesnost.

Skutečné hodnocení znamená prověření spolehlivosti modelu, jeho odolnosti vůči neobvyklým zadáním a celkové konzistence odpovědí. Tento proces pomáhá vytvořit jasnější obraz o silných a slabých stránkách modelu a odhaluje oblasti, které je třeba vylepšit.

Zde se blíže podíváme na některé běžné výzvy, které se vyskytují během hodnocení LLM.

1. Překrývání trénovacích dat

Je těžké zjistit, zda model již viděl některé z testovacích dat. Vzhledem k tomu, že LLM jsou trénovány na obrovských datových souborech, existuje možnost, že se některé testovací otázky překrývají s trénovacími příklady. To může způsobit, že model vypadá lépe, než ve skutečnosti je, protože může pouze opakovat to, co již zná, místo aby prokázal skutečné porozumění.

2. Nekonstantní výkon

LLM mohou mít nepředvídatelné reakce. V jednu chvíli poskytují působivé postřehy a v další chvíli dělají podivné chyby nebo prezentují smyšlené informace jako fakta (známé jako „halucinace“).

Tato nejednotnost znamená, že zatímco výstupy LLM mohou v některých oblastech vynikat, v jiných mohou zaostávat, což ztěžuje přesné posouzení jejich celkové spolehlivosti a kvality.

3. Zranitelnosti v rámci soupeření

LLM mohou být náchylné k nepřátelským útokům, kdy je chytře vytvořené výzvy přimějí k vytvoření chybných nebo škodlivých odpovědí. Tato zranitelnost odhaluje slabiny modelu a může vést k neočekávaným nebo zaujatým výstupům. Testování těchto nepřátelských slabostí je zásadní pro pochopení hranic modelu.

Praktické příklady použití hodnocení LLM

Na závěr uvádíme několik běžných situací, ve kterých hodnocení LLM skutečně hraje důležitou roli:

Chatboty pro zákaznickou podporu

LLM se široce používají v chatbotech k vyřizování dotazů zákazníků. Vyhodnocení toho, jak dobře model reaguje, zajišťuje, že poskytuje přesné, užitečné a kontextově relevantní odpovědi.

Je zásadní měřit jeho schopnost porozumět záměru zákazníka, zpracovat různé otázky a poskytovat odpovědi podobné lidským. To umožní podnikům zajistit plynulý zákaznický zážitek a minimalizovat frustraci.

Generování obsahu

Mnoho firem používá LLM k vytváření obsahu blogů, sociálních médií a popisů produktů. Hodnocení kvality generovaného obsahu pomáhá zajistit, že je gramaticky správný, poutavý a relevantní pro cílové publikum. Metriky jako kreativita, soudržnost a relevance k tématu jsou zde důležité pro udržení vysokých standardů obsahu.

Analýza sentimentu

LLM mohou analyzovat sentiment zákaznických recenzí, příspěvků na sociálních sítích nebo recenzí produktů. Je důležité vyhodnotit, jak přesně model identifikuje, zda je text pozitivní, negativní nebo neutrální. To pomáhá firmám porozumět emocím zákazníků, vylepšovat produkty nebo služby, zvyšovat spokojenost uživatelů a zlepšovat marketingové strategie.

Generování kódu

Vývojáři často používají LLM jako pomoc při generování kódu. Je velmi důležité vyhodnotit schopnost modelu vytvářet funkční a efektivní kód.

Je důležité zkontrolovat, zda je generovaný kód logicky správný, bez chyb a splňuje požadavky úkolu. To pomáhá snížit množství ručního kódování a zvyšuje produktivitu.

Optimalizujte své hodnocení LLM pomocí ClickUp

Při hodnocení LLM jde především o výběr správných metrik, které odpovídají vašim cílům. Klíčem je pochopit vaše konkrétní cíle, ať už se jedná o zlepšení kvality překladu, vylepšení generování obsahu nebo doladění specializovaných úkolů.

Výběr správných metrik pro hodnocení výkonu, jako jsou RAG nebo metriky jemného doladění, tvoří základ přesného a smysluplného hodnocení. Pokročilé hodnotící nástroje jako G-Eval, Prometheus, SelfCheckGPT a QAG meanwhile poskytují přesné informace díky svým silným schopnostem uvažování.

To však neznamená, že tato skóre jsou dokonalá – stále je důležité zajistit jejich spolehlivost.

V průběhu hodnocení aplikace LLM přizpůsobte proces konkrétnímu případu použití. Neexistuje univerzální metrika, která by fungovala pro všechny scénáře. Kombinace metrik spolu se zaměřením na kontext vám poskytne přesnější obraz o výkonu vašeho modelu.

Chcete-li zefektivnit hodnocení LLM a zlepšit spolupráci týmu, ClickUp je ideálním řešením pro správu pracovních postupů a sledování důležitých metrik.

Chcete zvýšit produktivitu svého týmu? Zaregistrujte se ještě dnes na ClickUp a vyzkoušejte, jak může změnit váš pracovní postup!