Повечето корпоративни екипи, които проучват LLaMA, зациклят на едно и също място: изтеглят теглата на модела, зяпат терминалния прозорец и осъзнават, че нямат представа какво да правят по-нататък.

Това предизвикателство е широко разпространено – докато 88% от компаниите използват AI в поне една функция, само 7% са го разширили в цялата организация.

Това ръководство ви води през целия процес, от избора на подходящия размер на модела за вашия случай на употреба до фино настройването му според данните на вашата компания, за да можете да внедрите работещо AI решение, което наистина разбира контекста на вашия бизнес.

Какво е LLaMA и защо е важно за изкуствения интелект в предприятията?

LLaMA (съкращение от Large Language Model Meta AI) е семейство от езикови модели с отворен код, създадени от Meta. На високо ниво, той изпълнява същите основни функции като моделите GPT или Gemini: разбира езика, генерира текст и може да разсъждава въз основа на информация. Голямата разлика е в начина, по който предприятията могат да го използват.

Тъй като LLaMA е с отворен код, компаниите не са принудени да взаимодействат с него само чрез API тип „черна кутия”. Те могат да го изпълняват на собствената си инфраструктура, да го настройват въз основа на вътрешни данни и да контролират как и къде се внедрява.

За предприятията това е много важно, особено когато поверителността на данните, съответствието с нормативните изисквания и предвидимостта на разходите са по-важни от новостта.

Тази гъвкавост прави LLaMA особено привлекателен за екипи, които искат AI да бъде дълбоко интегриран в работните им процеси, а не просто добавен като самостоятелен чатбот. Помислете за вътрешни асистенти за знания, автоматизация на обслужването на клиенти, инструменти за разработчици или AI функции, вградени директно в продуктите – без да изпращате чувствителни данни извън организацията.

Накратко, LLaMA е важен за корпоративния AI, защото дава на екипите избор по отношение на внедряването, персонализирането и интегрирането на AI в реални бизнес системи. И тъй като AI преминава от експериментиране към ежедневни операции, това ниво на контрол става по-малко „хубаво да се има“ и повече изискване.

Как да започнете да използвате LLaMA за корпоративни приложения

1. Определете вашия случай на употреба в предприятието

Преди да изтеглите нещо, определете точно работните процеси, в които изкуственият интелект може да има реално въздействие. Съответствието между случая на използване на изкуствен интелект и размера на модела е от ключово значение – по-малките модели от 8B са ефективни за прости задачи, докато по-големите модели от 70B+ са по-подходящи за сложни разсъждения.

За да ви помогнем да определите подходящите AI приложения за вашия бизнес, гледайте този обзор на практически примери за използване на AI в различни корпоративни функции и индустрии:

Общите отправни точки включват:

- Обработка на документи: обобщаване на дълги доклади или извличане на ключова информация от договори

- Помощ при кодиране: генериране на шаблонни кодове, обясняване на стари системи или предлагане на оптимизации.

- Извличане на знания: Отговаряне на въпроси на служители чрез търсене във вътрешна документация, като се използва техника, наречена Retrieval-Augmented Generation (RAG)

- Създаване на съдържание: Изготвяне на първоначални комуникации или маркетингови текстове

2. Настройте предварителните условия и зависимостите

След това подгответе хардуера и софтуера си. Размерът на модела определя вашите нужди; моделът LLaMA 8B изисква GPU с около 15 GB VRAM, докато моделът 70B се нуждае от 131 GB или повече.

Вашият софтуерен стек трябва да включва Python 3. 8+, PyTorch, CUDA драйвери и екосистемата Hugging Face (трансформатори, ускорители и bitsandbytes).

3. Достъп и изтегляне на теглата на модела LLaMA

Можете да получите теглата на моделите от официалната страница за изтегляне на Llama на Meta или от моделния център Hugging Face. Трябва да приемете лиценза Llama 3 Community License, който позволява търговска употреба. В зависимост от вашата настройка, ще изтеглите теглата във формат safetensors или GGUF.

4. Конфигурирайте вашата среда за разработка

След като сте изтеглили теглата, е време да настроите средата си. Инсталирайте необходимите библиотеки на Python, включително transformers, accelerate и bitsandbytes за квантизация – процес, който намалява заеманото място в паметта от модела.

Заредете модела с правилните настройки и изпълнете прост тестов прозорец, за да се уверите, че всичко работи правилно, преди да преминете към персонализиране.

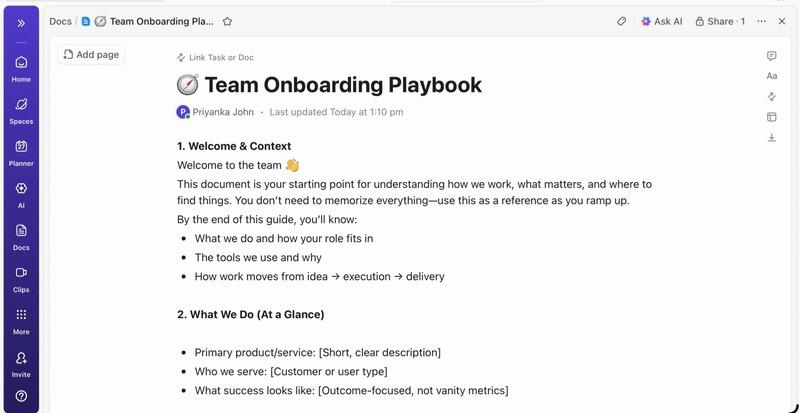

💡Ако нямате специален екип за ML инфраструктура, целият този процес може да се окаже невъзможен. Избягвайте изцяло сложността на внедряването с ClickUp Brain. Той предоставя AI възможности като помощ при писане и автоматизация на задачи директно в работната среда, в която вече работи вашият екип – без да е необходимо изтегляне на модели или предоставяне на GPU.

Как да персонализирате LLaMA за данните на вашето предприятие

Използването на базов LLaMA модел е добро начало, но той няма да разбере уникалните акроними, имена на проекти или вътрешни процеси на вашата компания. Това води до общи, безполезни отговори, които не решават реалните бизнес проблеми.

Изкуственият интелект за предприятия става полезен чрез персонализиране – обучение на модела въз основа на вашата специфична терминология и база от знания.

Подгответе вашите специфични за домейна данни за обучение

Успехът на вашия персонализиран AI зависи повече от качеството на вашите тренировъчни данни, отколкото от размера на модела или изчислителната мощност. Започнете със събиране и почистване на вашата вътрешна информация.

- Вътрешна документация: Събиране на спецификации на продукти, ръководства за процеси и документи с политики

- Исторически комуникации: Съберете шаблони за имейли, отговори на билети за поддръжка и резюмета от срещи.

- Терминология на домейна: Съставете речници, определения на акроними и специфичен за индустрията език.

След като съберете информацията, форматирайте я в двойки инструкции-отговори за контролирана настройка. Например, инструкцията може да бъде „Обобщете този билет за поддръжка“, а отговорът ще бъде ясно и кратко обобщение. Тази стъпка е от решаващо значение за обучението на модела как да изпълнява конкретни задачи с вашите данни.

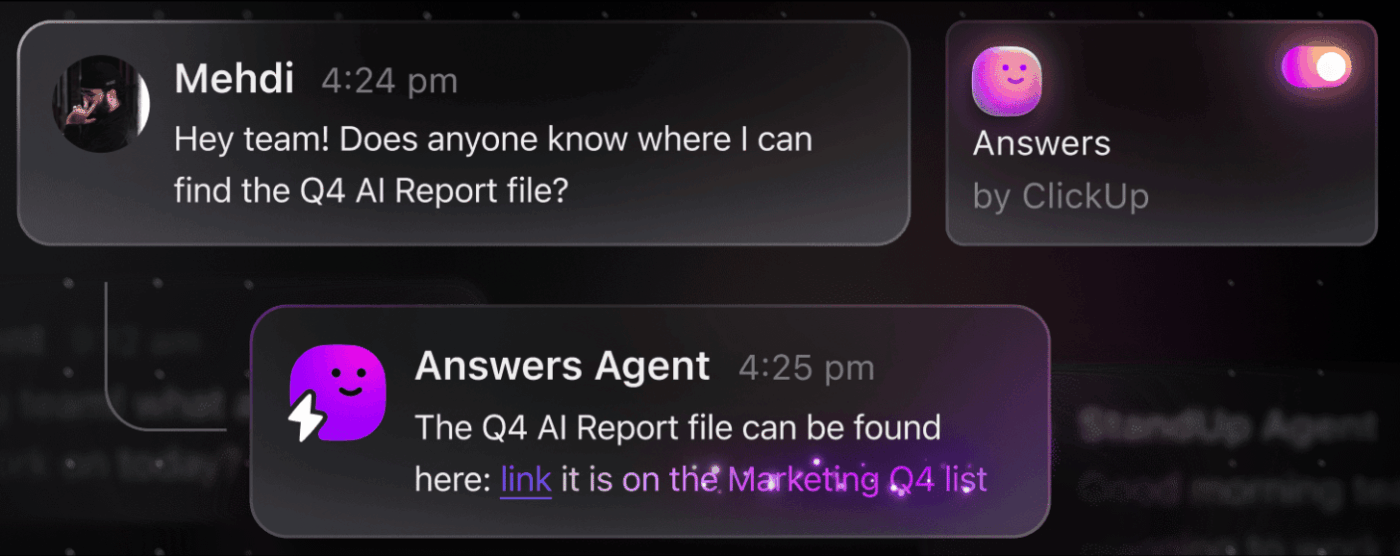

📮 ClickUp Insight: Средностатистическият професионалист прекарва над 30 минути на ден в търсене на информация, свързана с работата си – това са над 120 часа годишно, загубени в претърсване на имейли, Slack низове и разпръснати файлове. Интелигентен AI асистент, вграден във вашето работно пространство, може да промени това.

Въведете ClickUp Brain. Той предоставя незабавни прозрения и отговори, като извежда на преден план подходящите документи, разговори и подробности за задачите за секунди – така че можете да спрете да търсите и да започнете да работите.

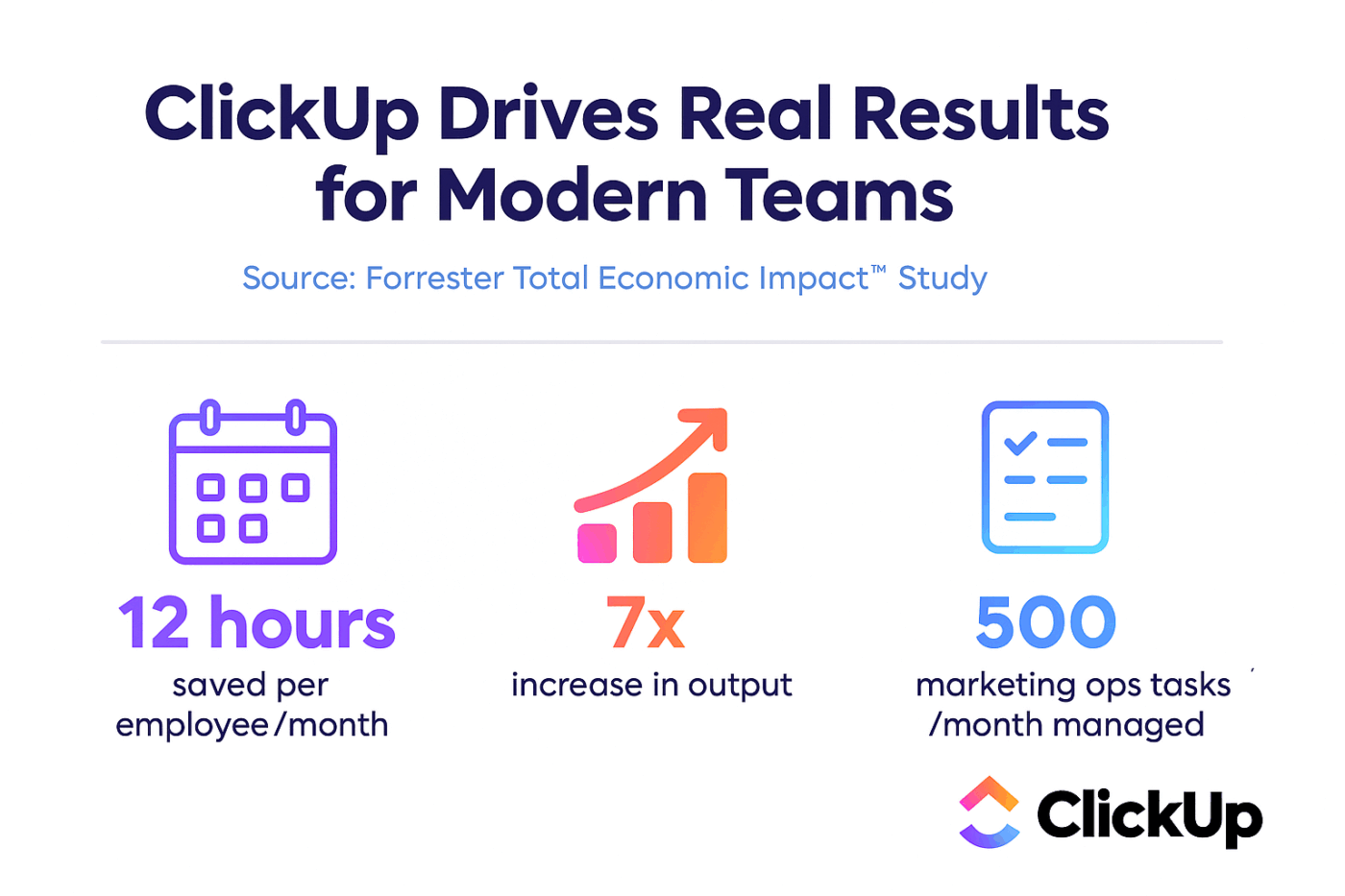

💫 Реални резултати: Екипи като QubicaAMF спестиха над 5 часа седмично с помощта на ClickUp – това са над 250 часа годишно на човек – като премахнаха остарелите процеси за управление на знанията. Представете си какво би могъл да създаде вашият екип с една допълнителна седмица продуктивност на тримесечие!

Настройте LLaMA според контекста на вашия бизнес

Настройването е процесът на адаптиране на съществуващите знания на LLaMA към вашия конкретен случай на употреба, което значително подобрява неговата точност при задачи, специфични за дадена област. Вместо да обучавате модел от нулата, можете да използвате методи, ефективни по отношение на параметрите, които актуализират само малка част от параметрите на модела, спестявайки време и изчислителни ресурси.

Популярни методи за фина настройка включват:

- LoRA (Low-Rank Adaptation): Този метод обучава малки „адаптерни“ матрици вместо целия модел, което го прави изключително ефективен.

- QLoRA: Комбинира LoRA с квантизация, за да позволи фино настройване на един 48 GB GPU, като същевременно осигурява пълна производителност при фино настройване.

- Пълна настройка: Това актуализира всички параметри на модела, предлагайки най-дълбоко ниво на персонализация, но изисква значителна изчислителна мощност.

📚 Прочетете също: Инструменти за генериране на изкуствен интелект за предприятия, които променят работата

Оценяване и итерация на производителността на модела

Как да разберете дали персонализираният ви модел наистина работи? Оценката на изкуствения интелект трябва да надхвърля простите оценки за точност и да измерва полезността в реалния свят. Създайте набори от данни за оценка, които отразяват вашите производствени случаи на употреба, и проследявайте показателите, които са важни за вашия бизнес, като качество на отговора, фактическа точност и латентност.

- Качествена оценка: Помолете човешки рецензенти да оценят резултатите по отношение на тон, полезност и коректност.

- Количествени показатели: Използвайте автоматизирани оценки като BLEU или perplexity, за да проследявате производителността в мащаб.

- Мониторинг на производството: След внедряването проследявайте обратната връзка от потребителите и процента на грешки, за да идентифицирате областите, които се нуждаят от подобрение.

💡Този повтарящ се процес на обучение и оценка може да се превърне в проект сам по себе си. Управлявайте цикъла на развитие на изкуствения интелект директно в ClickUp, вместо да се губите в таблици.

Централизирайте показателите за производителност и резултатите от оценката в един изглед с ClickUp Dashboards. Проследявайте версиите на моделите, параметрите на обучението и резултатите от оценката заедно с останалата част от работата си по продукта с ClickUp Custom Fields, като поддържате всичко организирано и видимо. 🛠️

Най-добри примери за използване на LLaMA в предприятията

Екипите често зациклят в аналитична парализа, неспособни да преминат от абстрактния ентусиазъм за изкуствения интелект към конкретни приложения. Гъвкавостта на LLaMA го прави подходящ за широк спектър от корпоративни работни процеси, като ви помага да автоматизирате задачите и да работите по-ефективно.

Ето някои от най-добрите примери за използване на персонализиран LLaMA модел:

- Вътрешни асистенти за знания: Спрете да губите време в търсене на информация. Внедрете LLaMA с RAG, за да създадете чатбот, който може незабавно да отговаря на въпросите на служителите, като търси във вашите вътрешни уикита, документи с политики и комуникации по минали проекти.

- Автоматизация на обслужването на клиенти: Настройте модел въз основа на историята на вашите билети, за да изготвяте автоматично отговори, да категоризирате запитвания и да препращате сложни проблеми към подходящия оператор.

- Генериране и преглед на код: Помогнете на инженерния си екип да работи по-ефективно. Използвайте LLaMA, за да генерирате шаблонни кодове, да обясните сложни стари системи и дори да идентифицирате потенциални бъгове в pull заявките, преди те да се превърнат в проблеми.

- Обработка на документи: Превърнете големи обеми текст в полезна информация. Обобщете дълги доклади, извлечете ключови термини от правни договори или генерирайте кратки бележки от срещи от необработени транскрипти за секунди.

- Работни процеси за създаване на съдържание: Преодолейте блокадата на писателя. Напишете чернови на маркетингови текстове, описания на продукти и вътрешни съобщения, които вашите редактори могат да доусъвършенстват и усъвършенстват.

💡Достъп до много от тези примери за употреба с ClickUp Brain.

- Обобщавайте низове от задачи, изготвяйте чернови на актуализации на проекти и генерирайте съдържание с помощта на AI-базираната помощ за писане на ClickUp.

- Намерете отговори от цялото си работно пространство мигновено с Enterprise Search на ClickUp и предварително създадения агент Ambient Answers.

- Създайте интелигентни работни процеси, които да се занимават с рутинната работа вместо вас с ClickUp Automations.

Ограничения при използването на LLaMA за корпоративна изкуствена интелигентност

Макар че самохостингът на LLaMA предлага значителен контрол, той не е без предизвикателства. Екипите често подценяват оперативните разходи и се затрудняват с поддръжката, вместо да се фокусират върху иновациите. Преди да се ангажирате с пътя на „изграждането“, е от решаващо значение да разберете потенциалните препятствия.

Ето някои от основните ограничения, които трябва да имате предвид:

- Изисквания към инфраструктурата: Използването на големи модели е скъпо и изисква мощни графични процесори от корпоративно ниво, с които много организации не разполагат.

- Необходими технически познания: Разгръщането, финото настройване и поддържането на голям езиков модел изисква специализирани инженерни умения в областта на машинно обучението, които са много търсени.

- Тежест на текущата поддръжка: Това не е решение от типа „настрой и забрави“. Моделите се нуждаят от постоянно наблюдение, актуализации на сигурността и преобучение, тъй като вашият бизнес се развива.

- Риск от халюцинации: Както всички LLM, LLaMA понякога може да генерира правдоподобно звучаща, но невярна информация. Приложенията за предприятия изискват надеждни предпазни мерки и човешки надзор, за да се намали този риск.

- Без вградени корпоративни функции: Критични функции като контрол на достъпа, регистриране на одити и инструменти за съответствие трябва да се създават и управляват отделно, което добавя още едно ниво на сложност.

💡Можете да заобиколите тези ограничения, като използвате ClickUp Brain. Той предоставя управлявана изкуствена интелигентност в рамките на съществуващото ви работно пространство, като ви дава възможности за изкуствена интелигентност за предприятия без оперативни разходи. Получете сигурност на ниво предприятие и елиминирайте поддръжката на инфраструктурата с ClickUp, като освободите екипа си да се съсредоточи върху основната си работа.

📮ClickUp Insight: 88% от участниците в нашето проучване използват изкуствен интелект за лични задачи, но над 50% се въздържат да го използват на работа. Трите основни пречки? Липса на безпроблемна интеграция, пропуски в знанията или опасения за сигурността.

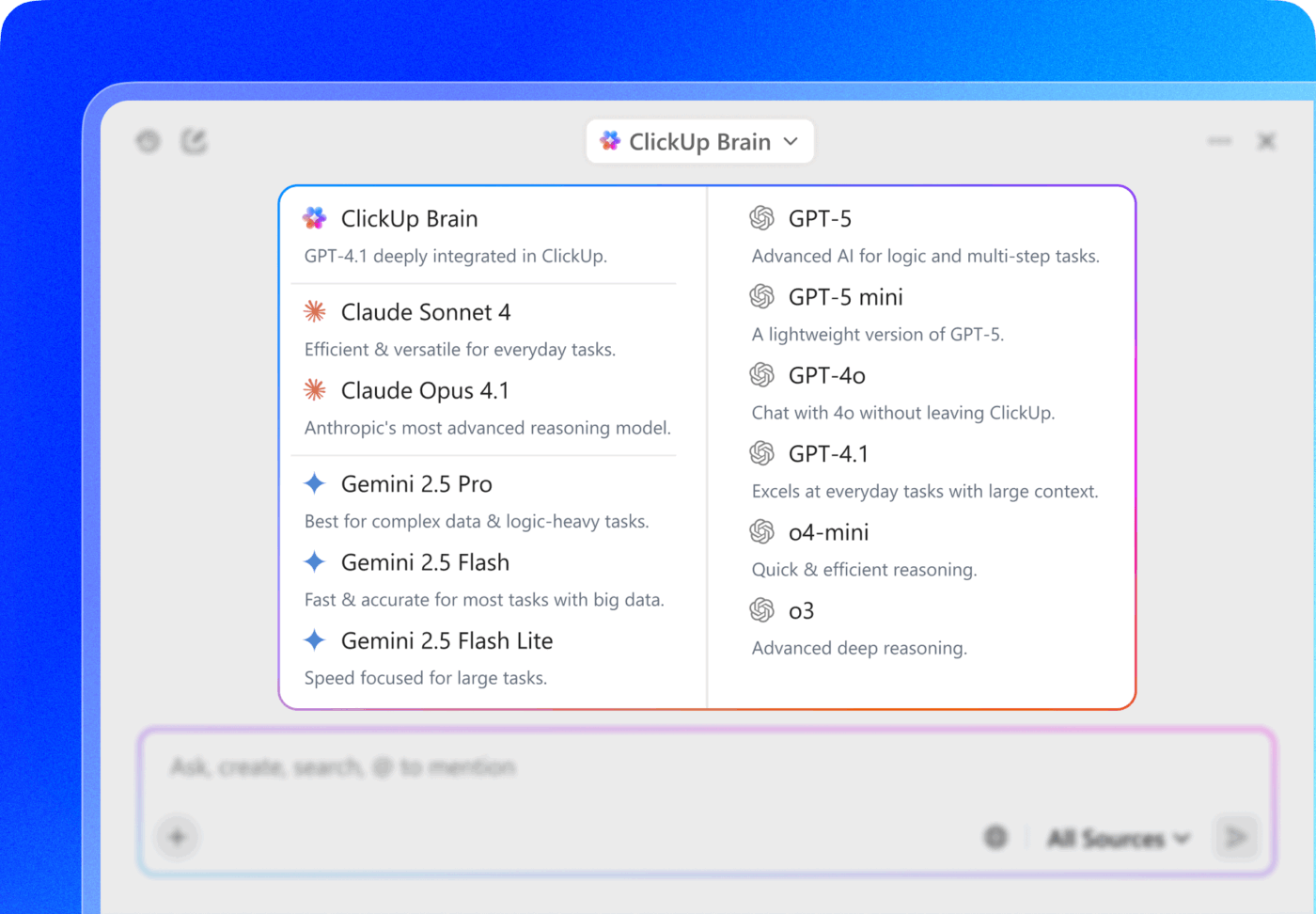

Ами ако AI е вграден във вашето работно пространство и вече е защитен? ClickUp Brain, вграденият AI асистент на ClickUp, прави това реалност. Той разбира команди на обикновен език, решавайки и трите проблема, свързани с внедряването на AI, като същевременно свързва вашия чат, задачи, документи и знания в цялото работно пространство. Намерете отговори и информация с едно кликване!

Алтернативни AI инструменти за корпоративни приложения

Изборът на подходящия AI инструмент от множеството налични опции е предизвикателство за всеки екип. Опитвате се да разберете компромисите между различните модели, но се притеснявате, че ще изберете грешния и ще загубите ресурси.

Това често води до AI Sprawl — непланирано разпространение на AI инструменти и платформи без надзор или стратегия — при което екипите се абонират за множество несвързани услуги, създавайки повече работа, вместо по-малко.

Ето кратко представяне на основните участници и тяхното място:

| Инструмент | Най-подходящо за | Ключови съображения |

|---|---|---|

| LLaMA (самостоятелно хоствано) | Максимален контрол, суверенитет на данните | Изисква ML инфраструктура и експертиза |

| OpenAI GPT-4 | Най-висока производителност, минимална настройка | Данните напускат вашата среда, ценообразуване на базата на употребата |

| Claude (Anthropic) | Задачи с дълъг контекст, фокус върху безопасността | Подобни компромиси като при GPT-4 |

| Mistral | Европейско съхранение на данни, ефективност | По-малка екосистема от LLaMA |

| ClickUp Brain | Интегрирана изкуствена интелигентност в работната среда, без внедряване | Най-подходящо за екипи, които искат да внедрят AI в съществуващите работни процеси. |

Вместо да свързвате няколко инструмента, за да отговорите на нуждите си, защо не използвате AI, вградена директно в мястото, където работите? Това е същността на това, което предлага ClickUp като първото в света конвергентно AI работно пространство – единна, сигурна платформа, където проекти, документи, разговори и анализи съществуват заедно.

Той обединява вашите инструменти, за да елиминира разпръскването на контекста, фрагментацията, която възниква, когато екипите губят часове в превключване между приложения и търсене на информацията, от която се нуждаят, за да вършат работата си.

ClickUp + контекстуална изкуствена интелигентност = измерима трансформация

Според проучване на Forrester Economic Impact™, екипите, които използват ClickUp, са постигнали 384% възвръщаемост на инвестициите и са спестили 92 400 часа до третата година.

Когато контекстът, работните процеси и интелигентността са на едно място, екипите не просто работят. Те печелят.

ClickUp също така осигурява сигурността и административните възможности, необходими за корпоративни внедрявания, с SOC 2 Type II съответствие, SSO интеграция, SCIM провижининг и гранулирани контроли на разрешенията.

Достъпът до множество LLM на ClickUp Brain MAX ви позволява да избирате между премиум модели като ChatGPT, Claude и Gemini директно от интерфейса за търсене. Платформата автоматично пренасочва заявката ви към най-подходящия модел за задачата, така че получавате най-доброто от всички светове, без да се налага да управлявате множество абонаменти.

Получете целия набор от AI възможности, управление на проекти, документация и комуникация на едно място с ClickUp, вместо да изграждате AI слоя от нулата с LLaMA.

Напред с изкуствен интелект за предприятия с ClickUp

LLaMA предоставя на корпоративните екипи отворена алтернатива на затворените AI API, предлагайки значителен контрол, предвидимост на разходите и персонализация. Но успехът зависи от повече от само технологията. Необходимо е да се съпостави правилният модел с правилния случай на употреба, да се инвестира в висококачествени данни за обучение и да се изградят стабилни процеси за оценка.

Решението „да създадем или да купим“ в крайна сметка зависи от техническите възможности на вашия екип. Макар че създаването на персонализирано решение предлага максимална гъвкавост, то е свързано и със значителни разходи. Истинското предизвикателство не е само достъпът до изкуствен интелект, а интегрирането му в ежедневните ви работни процеси, без да се създават още повече разрастване на изкуствения интелект и изолирани масиви от данни.

Въведете LLM възможностите директно в управлението на проекти, документацията и комуникацията в екипа с ClickUp Brain – без сложността на изграждането и поддържането на инфраструктура. Започнете безплатно с ClickUp и въведете AI възможностите директно в съществуващите си работни процеси. 🙌

Често задавани въпроси (FAQ)

Да, лицензът Llama 3 Community License позволява търговско използване за повечето организации. Само компании с над 700 милиона активни потребители месечно трябва да получат отделен лиценз от Meta.

LLaMA осигурява по-голям контрол над данните и предвидими разходи чрез самохостинг, докато GPT-4 предлага по-висока производителност веднага след инсталирането с по-малко настройки. За по-голяма продуктивност обаче, ползвайте AI помощ, без да управлявате основните модели, чрез интегрирани инструменти като ClickUp Brain.

Самостоятелното хостинг на LLaMA съхранява данните във вашата инфраструктура, което е чудесно за съхранението на данни. Въпреки това, вие носите отговорност за внедряването на свои собствени контроли за достъп, аудит логове и филтри за съдържание – функции за сигурност, които обикновено са включени в управляваните AI услуги.

Внедряването и фината настройка на LLaMA изисква значителни умения в областта на машинно обучение. Екипите, които не разполагат с такава експертиза, могат да получат достъп до функциите на LLaMA чрез управлявани платформи като ClickUp Brain, която предоставя AI функции без необходимост от внедряване на модели или техническа конфигурация.