Du har tejpat ihop API:er, riggat Slack-bots och bett ChatGPT att bete sig som en lagkamrat.

Men utan verklig kontext är AI bara gissningar. Det slutar fungera när dina verktyg ändras och hallucinerar när dina data inte är tydligt kartlagda eller tillgängliga.

Model Context Protocol (MCP) förändrar detta. Det skapar ett gemensamt språk mellan din modell och din stack: strukturerat, kontextuellt och byggt för att skalas. MCP gör det möjligt för dig att sluta leverera AI som agerar smart och börja bygga AI som är smart.

I det här blogginlägget kommer vi att gå igenom MCP i detalj och hur man implementerar det. Dessutom kommer vi att undersöka hur ClickUp fungerar som ett alternativ till MCP-protokoll. Låt oss dyka in! 🤖

Vad är ett modellkontextprotokoll?

Modellkontextprotokoll är ett ramverk eller riktlinjer som används för att definiera, strukturera och kommunicera nyckelelement/kontext (promptar, konversationshistorik, verktygsstatus, användarmetadata etc.) till stora språkmodeller (LLM).

Det beskriver de externa faktorer som påverkar modellen, såsom:

- Vem kommer att använda modellen (intressenter)

- Varför modellen skapas (mål)

- Var och hur det kommer att tillämpas (användningsfall, miljöer)

- Vilka begränsningar finns (tekniska, etiska, tidsbaserade osv.)?

- Vilka antaganden görs om den verkliga kontexten?

Enkelt uttryckt skapar det förutsättningar för modellen att fungera effektivt och säkerställer att den är tekniskt sund, relevant och användbar i det scenario den är byggd för.

Viktiga komponenter i MCP inkluderar:

- Valideringskriterier: Beskriver hur modellen kommer att testas eller utvärderas med avseende på noggrannhet och användbarhet.

- Syfte: Ange tydligt vad modellen är avsedd att representera eller lösa.

- Omfattning: Definierar modellens gränser, till exempel vad som ingår och vad som utesluts.

- Viktiga begrepp och variabler: Identifierar de viktigaste komponenterna, enheterna eller variablerna som modellen behandlar.

- Relationer och antaganden: Förklarar hur begrepp interagerar och vilka antaganden som ligger till grund för modellen.

- Struktur: Beskriver modellens format (t.ex. diagram, matematiska ekvationer, simuleringar)

MCP vs. LangChain

LangChain är ett utvecklarvänligt ramverk för att bygga applikationer som använder LLM-agenter. MCP är däremot ett protokoll som standardiserar hur kontext levereras till modeller över olika system.

LangChain hjälper dig att bygga, och MCP hjälper system att kommunicera med varandra. Låt oss förstå skillnaden mellan de två bättre.

| Funktion | LangChain | MCP-modeller |

| Fokus | Applikationsutveckling med LLM | Standardisering av LLM-kontext och verktygsinteraktioner |

| Verktyg | Kedjor, agenter, minne, hämtare | Protokoll för LLM:er för åtkomst till verktyg, data och kontext |

| Skalbarhet | Modulärt, skalbart via komponenter | Byggt för storskaliga, agentöverskridande distributioner |

| Användningsfall | Chatbots, RAG-system (Retrieval-Augmented Generation) och automatisering av uppgifter | AI-orkestrering för företag, multimodella system |

| Interoperabilitet | Begränsat till ekosystemverktyg | Hög, möjliggör byte av modeller och verktyg |

Vill du se hur MCP-baserade automatiseringar fungerar i praktiken?

Kolla in ClickUps guide om AI-arbetsflödesautomatisering som visar hur olika team, från marknadsföring till teknik, sätter upp dynamiska, komplexa arbetsflöden som speglar modellkontextprotokollets styrkor när det gäller interaktion i realtid.

MCP vs. RAG

Både RAG och MCP förbättrar LLM med extern kunskap, men skiljer sig åt i fråga om timing och interaktion.

Medan RAG hämtar information innan modellen genererar ett svar, gör MCP det möjligt för modellen att begära data eller aktivera verktyg under genereringen via ett standardiserat gränssnitt. Låt oss jämföra de båda.

| Funktion | RAG | MCP |

| Fokus | Förhämta relevant information för att generera svar | Verktyg/data-interaktion i realtid under pågående process |

| Mekanism | Hämtar först extern data och genererar sedan | Begär kontext under generering |

| Bäst för | Statiska eller semistrukturerade kunskapsbaser, QA-system | Verktyg i realtid, API:er, verktygsintegrerade databaser |

| Begränsning | Begränsad av hämtningstidpunkt och kontextfönster | Fördröjning från protokollhopp |

| Integration | Ja, RAG-resultat kan bäddas in i MCP-kontextlager. | Ja, det kan integrera RAG i MCP för rikare flöden. |

Om du bygger en hybrid av RAG + MCP, börja med ett rent kunskapshanteringssystem inuti ClickUp.

Du kan använda ClickUps kunskapsbasmall för att organisera ditt innehåll på ett konsekvent sätt. Detta hjälper dina AI-agenter att hämta korrekt och aktuell information utan att behöva söka igenom en massa onödig information.

MCP vs. AI-agenter

MCP är gränssnittet, men olika typer av AI-agenter fungerar som aktörer.

MCP-modeller standardiserar hur agenter får tillgång till verktyg, data och kontext och fungerar som en universell koppling. AI-agenter använder den tillgången för att fatta beslut, utföra uppgifter och agera autonomt.

| Funktion | MCP | AI-agenter |

| Roll | Standardgränssnitt för åtkomst till verktyg/data | Autonoma system som utför uppgifter |

| Funktion | Fungerar som en bro mellan modeller och externa system. | Använder MCP-servrar för att få tillgång till kontext, verktyg och fatta beslut. |

| Användningsfall | Ansluta AI-system, databaser, API:er, kalkylatorer | Skriva kod, sammanfatta data, hantera arbetsflöden |

| Beroende | Oberoende protokollskikt | Förlitar sig ofta på MCP för dynamisk tillgång till verktyg |

| Relation | Möjliggör kontextdriven funktionalitet | Utför uppgifter med hjälp av kontext och funktioner som tillhandahålls av MCP. |

❗️Hur ser det ut att ha en AI-agent som förstår allt ditt arbete? Se här. 👇🏼

⚙️ Bonus: Behöver du hjälp med att avgöra när du ska använda RAG, MCP eller en kombination av båda? Denna djupgående jämförelse mellan RAG, MCP och AI-agenter förklarar allt med diagram och exempel.

Varför kontext är viktigt i AI-modeller

För moderna AI-system är kontexten grundläggande. Kontexten gör det möjligt för generativa AI-modeller att tolka användarens avsikt, förtydliga indata och leverera resultat som är korrekta, relevanta och användbara. Utan kontexten hallucinerar modellerna, missförstår uppmaningar och genererar opålitliga resultat.

I verkligheten kommer kontexten från olika källor: CRM-poster, Git-historik, chattloggar, API-utdata och mycket mer.

Innan MCP innebar integrering av dessa data i AI-arbetsflöden att man måste skriva anpassade kopplingar för varje system [en fragmenterad, felbenägen och icke-skalbar metod].

MCP löser detta genom att möjliggöra ett strukturerat, maskinläsbart sätt för AI-modeller att få tillgång till kontextuell information, oavsett om det är användarens inmatningshistorik, kodsnuttar, affärsdata eller verktygsfunktionalitet.

Denna standardiserade åtkomst är avgörande för agentiskt resonemang, vilket gör det möjligt för AI-agenter att planera och agera intelligent med relevanta data i realtid.

Dessutom förbättras AI-prestandan överlag när kontexten delas effektivt:

- Mer relevanta svar i språk, kod och multimodala uppgifter

- Färre hallucinationer och misstag tack vare realtidsdata.

- Bättre minne och flöde i långa konversationer eller komplexa uppgifter

- Förenklad integration med verktyg, där agenter kan återanvända data och åtgärder via standardgränssnitt.

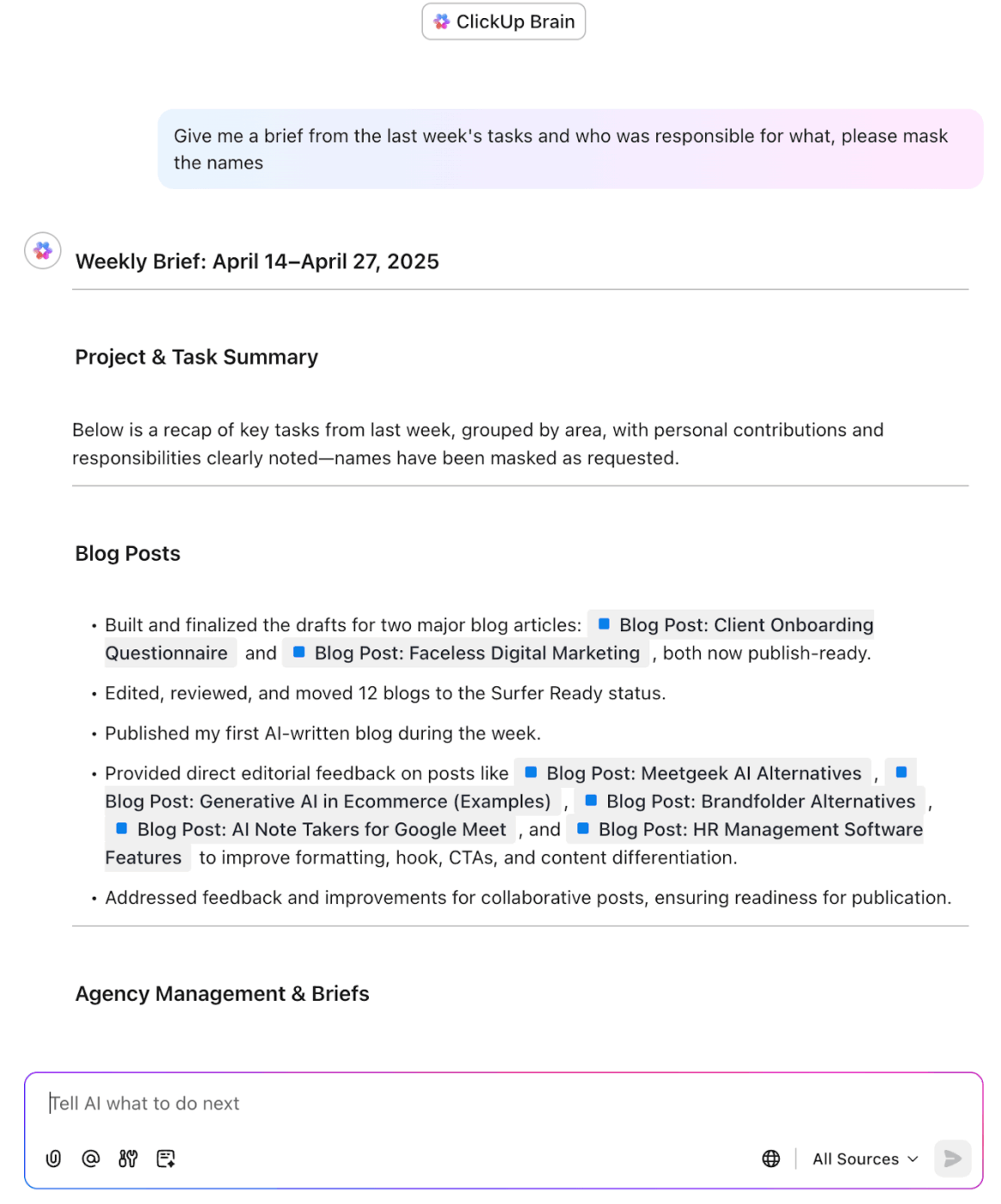

Här är ett exempel på hur ClickUps AI löser detta kontextgap utan att du behöver hantera omfattande MCP-arbetsflöden eller kodning. Vi har allt under kontroll!

💡 Proffstips: För att fördjupa dig, lär dig hur du använder kunskapsbaserade agenter i AI för att hämta och använda dynamiska data.

Hur fungerar ett modellkontextprotokoll?

MCP följer en klient-serverarkitektur, där AI-applikationer (klienter) begär verktyg, data eller åtgärder från externa system (servrar). Här är en detaljerad beskrivning av hur MCP fungerar i praktiken. ⚒️

🧩 Upprätta anslutning

När en AI-applikation (som Claude eller Cursor) startar initialiserar den MCP-klienter som ansluter till en eller flera MCP-servrar. Dessa server-sända händelser kan representera allt från ett väder-API till interna verktyg som CRM-system.

🧠 Kul fakta: Vissa MCP-servrar låter agenter läsa tokenbalanser, kontrollera NFT:er eller till och med utlösa smarta kontrakt över 30+ blockkedjenätverk.

👀 Upptäck verktyg och funktioner

När anslutningen är upprättad utför klienten en kapacitetsupptäckt och frågar varje server: Vilka verktyg, resurser eller uppmaningar tillhandahåller du?

Servern svarar med en lista över sina funktioner, som registreras och görs tillgängliga för AI-modellen att använda vid behov.

📮 ClickUp Insight: 13 % av våra undersökningsdeltagare vill använda AI för att fatta svåra beslut och lösa komplexa problem. Men endast 28 % uppger att de använder AI regelbundet i sitt arbete.

En möjlig orsak: säkerhetsproblem! Användare kanske inte vill dela känslig beslutsinformation med en extern AI. ClickUp löser detta genom att föra AI-driven problemlösning direkt till din säkra arbetsyta. Från SOC 2 till ISO-standarder uppfyller ClickUp de högsta datasäkerhetsstandarderna och hjälper dig att säkert använda generativ AI-teknik i hela din arbetsyta.

🧠 Identifiera behovet av extern kontext

När en användare ger en inmatning (t.ex. Hur är vädret i Chicago?), analyserar AI-modellen förfrågan och inser att den kräver extern realtidsdata som inte finns tillgänglig i dess träningsuppsättning.

Modellen väljer ett lämpligt verktyg från de tillgängliga MCP-funktionerna, till exempel en vädertjänst, och klienten förbereder en begäran till den servern.

🔍 Visste du att? MCP är inspirerat av Language Server Protocol (LSP) och utvidgar konceptet till autonoma AI-arbetsflöden. Detta tillvägagångssätt gör det möjligt för AI-agenter att dynamiskt upptäcka och kedja verktyg, vilket främjar flexibilitet och skalbarhet i utvecklingsmiljöer för AI-system.

✅ Utförande och hantering av svar

Klienten skickar en begäran till MCP-servern och anger:

- Verktyget att använda

- Parametrar (t.ex. plats, datum)

MCP-servern bearbetar begäran, utför den nödvändiga åtgärden (som att hämta väderinformation) och returnerar resultatet i ett maskinläsbart format. AI-klienten integrerar den returnerade informationen.

Modellen genererar sedan ett svar baserat på både den nya informationen och den ursprungliga uppmaningen.

Hämta information från din arbetsyta med hjälp av ClickUp Brain

💟 Bonus: Möt Brain MAX, den fristående AI-datorassistenten från ClickUp som sparar dig besväret med att bygga egna anpassade MCP-arbetsflöden från grunden. Istället för att sätta ihop dussintals verktyg och integrationer kommer Brain MAX färdigmonterad och redo att användas, och förenar allt ditt arbete, alla dina appar och AI-modeller i en kraftfull plattform.

Med djup integration i arbetsytan, röst-till-text för handsfree-produktivitet och högst relevanta, rollspecifika svar ger Brain MAX dig den kontroll, automatisering och intelligens du förväntar dig av en skräddarsydd lösning – utan någon installation eller underhåll. Det är allt du behöver för att hantera, automatisera och påskynda ditt arbete, direkt från din dator!

Vanliga utmaningar med kontext hantering i AI

Att hantera kontext i AI-system är avgörande men långt ifrån enkelt.

De flesta AI-modeller, oavsett arkitektur eller verktyg, står inför en rad gemensamma hinder som begränsar deras förmåga att resonera korrekt och konsekvent. Dessa hinder inkluderar:

- Tokenbegränsningar och korta kontextfönster begränsar hur mycket relevant information en AI kan ta hänsyn till samtidigt, vilket ofta leder till ofullständiga eller ytliga svar.

- Fragmenterade datakällor gör det svårt att samla in rätt kontext, särskilt när informationen är spridd över olika databaser, appar och format.

- Brist på långtidsminne mellan sessioner tvingar användarna att upprepa information, vilket bryter kontinuiteten i flerstegsuppgifter.

- Tvetydighet i användarinmatningen, särskilt i samtal med flera turer, kan förvirra AI utan ett tydligt historiskt sammanhang.

- Latens och kostnad blir ett problem när man hämtar realtidsutbildningsdata eller kontext från externa system.

- Avsaknaden av ett standardiserat sätt att dela eller upprätthålla kontext mellan verktyg och team leder ofta till dubbelarbete, inkonsekvens och begränsad samverkan.

Dessa problem visar på behovet av standardiserad, effektiv kontextadministration, något som MCP-protokoll syftar till att åtgärda.

🔍 Visste du att? Istället för att skicka kommandon direkt prenumererar modulerna på relevanta dataströmmar. Det innebär att ett robotben kanske bara passivt lyssnar efter balansuppdateringar och bara aktiveras när det behövs.

Modellkontextprotokoll i praktiken

MCP gör det enkelt att integrera olika informationskällor, vilket säkerställer att AI:n ger precisa och kontextuellt lämpliga svar.

Nedan följer några praktiska exempel som visar hur MCP kan tillämpas i olika scenarier. 👇

1. AI-drivna copilots

En av de mest använda applikationerna för AI-copiloter är GitHub Copilot, en AI-assistent som hjälper utvecklare att skriva och felsöka kod.

När en utvecklare skriver en funktion behöver Copilot tillgång till:

- Kodhistorik: AI hämtar kontexten för den aktuella koden för att föreslå relevanta kodkompletteringar.

- Externa bibliotek: Copilot söker efter de senaste versionerna av bibliotek eller ramverk, vilket säkerställer att koden är kompatibel med de senaste versionerna.

- Realtidsdata: Om utvecklaren ber om en uppdatering av en kodningskonvention eller felhanteringspraxis hämtar Copilot den senaste dokumentationen.

🧠 Kul fakta: MCP Guardian fungerar som en dörrvakt för användningen av AI-verktyg. Det kontrollerar identiteter, blockerar tvivelaktiga förfrågningar och loggar allt. Eftersom öppen tillgång till verktyg = säkerhetskaos.

2. Virtuella assistenter

Virtuella assistenter som Google Assistant eller Amazon Alexa förlitar sig på kontext för att ge meningsfulla svar. Till exempel:

- Tidigare konversationer: Google Assistant kommer ihåg tidigare frågor, till exempel dina resepreferenser, och anpassar sina svar därefter när du frågar om flygalternativ eller hotellbokningar.

- Externa verktyg: Det söker efter tredjeparts-API:er (t.ex. flygsökmotorer som Skyscanner) för att få realtidsinformation om tillgängliga flyg.

3. Kunskapshanteringssystem

AI-drivna datahanteringsverktyg, såsom IBM Watson, hjälper organisationer att hämta viktig information från stora databaser eller dokumentarkiv:

- Sökkontext: IBM Watson använder MCP-modeller för att analysera tidigare sökfrågor och justera resultaten baserat på användarens preferenser och tidigare sökningar.

- Externa arkiv: Watson kan söka i externa arkiv (t.ex. kunskapsbaser, forskningsrapporter eller företagsdokumentation) för att hämta den mest exakta och relevanta informationen.

- Personliga rekommendationer: Baserat på användarinteraktioner kan Watson föreslå relevanta dokument, vanliga frågor eller utbildningsmaterial som är anpassade efter användarens roll eller pågående projekt.

Organisera, filtrera och sök i hela företagets kunskap med ClickUp Enterprise Search

🪄 Fördelar med ClickUp: Skapa en verifierad, strukturerad kunskapsbas i ClickUp Docs och visa den via ClickUp Knowledge Management som en kontextkälla för din MCP Gateway. Förbättra Docs med rikt innehåll och media för att få precisa, personliga AI-rekommendationer från en centraliserad källa.

4. Hälso- och sjukvård

Inom hälso- och sjukvården erbjuder plattformar som Babylon Health virtuella konsultationer med patienter. Dessa AI-system är starkt beroende av kontext:

- Patienthistorik: AI behöver tillgång till patientjournaler, symtom och tidigare konsultationer för att kunna fatta välgrundade beslut.

- Externa medicinska data: Det kan hämta medicinska data i realtid (t.ex. den senaste forskningen om symtom eller behandlingar) för att ge mer exakta hälsoråd.

- Dynamiska svar: Om patientens symtom utvecklas använder AI MCP för att uppdatera sin kunskapsbas och justera behandlingsförslagen därefter.

🔍 Visste du att? De flesta MCP:er har inte utformats med säkerhet i åtanke, vilket gör dem sårbara i scenarier där simuleringar eller robotsystem är nätverksanslutna.

Hur man implementerar ett modellkontextprotokoll

Genom att implementera ett modellkontextprotokoll kan din AI-applikation interagera med externa verktyg, tjänster och datakällor på ett modulärt och standardiserat sätt.

Här är en steg-för-steg-guide för att konfigurera det. 📋

Steg 1: Definiera verktyg, resurser och hanterare

Börja med att bestämma vilka verktyg och resurser din MCP-server ska erbjuda:

- Verktyg är åtgärder som servern kan utföra (t.ex. anropa ett väder-API, köra en SQL-fråga).

- Resurser är statiska eller dynamiska data (t.ex. dokument, konfigurationsfiler, databaser).

- För varje verktyg, definiera: Inmatningsschema (t.ex. obligatoriska fält som stad, sökfråga etc.) Utdataformat (t.ex. strukturerad JSON-RPC) Lämplig metod för datainsamling för att samla in inmatningar

- Inmatningsschema (t.ex. obligatoriska fält som stad, sökfråga etc.)

- Utmatningsformat (t.ex. strukturerad JSON-RPC)

- Lämplig metod för datainsamling för att samla in input

- Inmatningsschema (t.ex. obligatoriska fält som stad, sökfråga etc.)

- Utmatningsformat (t.ex. strukturerad JSON-RPC)

- Lämplig metod för datainsamling för att samla in input

Implementera sedan handlers. Det är funktioner som bearbetar inkommande verktygsförfrågningar från klienten:

- Validera inmatningar för att säkerställa att de följer det förväntade formatet.

- Kör kärnlogiken (t.ex. hämta data från ett API, bearbeta data)

- Formatera och returnera utdata som kunden kan använda.

📌 Exempel: Ett verktyg för att sammanfatta dokument kan validera filtypen (t.ex. PDF eller DOCX), extrahera texten med hjälp av en filparser, skicka innehållet genom en sammanfattningsmodell eller -tjänst och returnera en kortfattad sammanfattning tillsammans med viktiga ämnen.

💡 Proffstips: Konfigurera händelselyssnare som aktiverar specifika verktyg när vissa åtgärder utförs, till exempel när en användare skickar in data eller när en databas uppdateras. Du behöver inte ha verktygen igång i bakgrunden när ingenting händer.

Steg 2: Bygg eller konfigurera MCP-servern

Använd ett ramverk som FastAPI, Flask eller Express för att exponera dina verktyg och resurser som HTTP-slutpunkter eller WebSocket-tjänster.

Det är viktigt att:

- Följ en konsekvent slutpunktsstruktur för alla verktyg (t.ex. /invoke/summarize-document).

- Returnera JSON-svar med en förutsägbar struktur så att kunderna enkelt kan använda dem.

- Gruppera funktioner under en /capabilities-slutpunkt så att kunderna kan upptäcka tillgängliga verktyg.

💡 Proffstips: Behandla kontext som kod. Varje gång du ändrar strukturen, skapa en ny version. Använd tidsstämplar eller commit-hashar så att du kan återställa utan att behöva kämpa.

Steg 3: Konfigurera MCP-klienten

MCP-klienten är en del av ditt AI-system (t.ex. Claude, Cursor eller en anpassad agent) som kommunicerar med din server.

Vid start ansluter klienten till MCP-servern och hämtar tillgängliga funktioner (verktyg/resurser) via slutpunkten /capabilities. Därefter registrerar den dessa verktyg för internt bruk, så att modellen kan bestämma vilket verktyg som ska anropas under en session.

💡 Proffstips: Infoga osynliga metadata i kontexten, till exempel verktygets tillförlitlighetspoäng eller tidsstämplar. Verktygen kan använda detta för att fatta smartare beslut, till exempel genom att hoppa över inaktuella data eller förstärka resultat som kommer från källor med hög tillförlitlighet.

Steg 4: Testa med en MCP-kompatibel klient

Innan du går live, testa din fjärrstyrda MCP-server med en faktisk AI-klient:

- Använd ett verktyg som Claude Desktop, som stöder MCP direkt.

- Prova typiska användningsfall (t.ex. fråga Claude om dagens väder) för att bekräfta att: Inmatningarna valideras korrekt Rätt verktyg anropas Svaren returneras i rätt format

- Inmatningarna valideras korrekt

- Rätt verktyg används

- Svaren returneras i rätt format.

- Inmatningarna valideras korrekt

- Rätt verktyg används

- Svaren returneras i rätt format.

Detta hjälper till att säkerställa en smidig integration med affärsverktyg och förhindrar runtime-fel i produktionen.

Steg 5: Lägg till säkerhet, behörigheter och observerbarhet

För att skydda känsliga verktyg eller data:

- Använd behörighetsfrågor innan du får åtkomst till kritiska verktyg eller personliga resurser.

- Lägg till loggning, övervakning och hastighetsbegränsning för att spåra användning och upptäcka avvikelser.

- Använd omfattningar eller användarroller för att begränsa vilka verktyg som kan användas av vem.

- Bygg ett minnes- eller tillståndslager för att lagra tidigare resultat och upprätthålla kontinuiteten.

- Testa under belastning och övervaka prestandamätvärden (latens, framgångsfrekvens etc.).

På så sätt kan du bygga kraftfulla, flexibla AI-system som skalar kontextåtkomst på ett smidigt sätt utan att behöva skriva anpassade integrationer för varje verktyg eller användningsfall.

Begränsningar för MCP-modeller

Modellkontextprotokoll löser viktiga utmaningar när det gäller delning av kontext, men de har också sina nackdelar:

- Verktygsberoende: MCP kräver kompatibla servrar och verktyg. Äldre system och icke-standardiserade API:er är svåra att integrera.

- Komplexitet vid installation: Den initiala installationen, definitionen av verktyg och skrivandet av hanterare kräver tekniska insatser, vilket innebär en inlärningskurva för nya team.

- Fördröjning: Varje externt samtal medför fördröjningar i svaren, särskilt när flera verktyg kopplas ihop.

- Säkerhetsrisker: Att exponera verktyg och datakällor ökar risken för attacker. Finjusterade åtkomstkontroller och revisionsloggning är fortfarande underutvecklade.

- Begränsad samordning mellan flera servrar: Det är inte helt smidigt att sammanfoga kontext mellan servrar, vilket leder till fragmenterade eller inkonsekventa resultat.

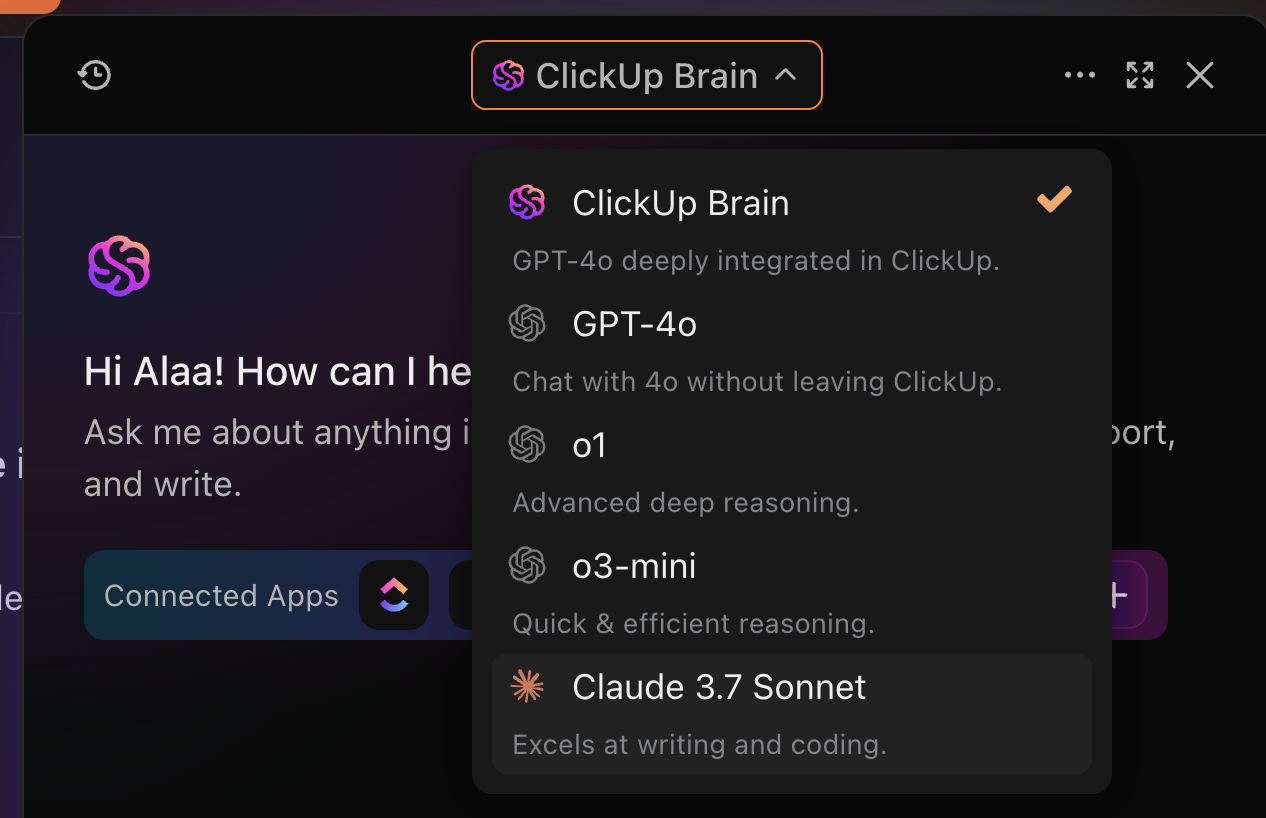

Hur ClickUp AI fungerar som ett alternativ till modellkontextprotokoll

Modellkontextprotokoll ger AI-system ett strukturerat sätt att hämta extern kontext genom standardiserade anrop. Det kan dock vara komplicerat att bygga och underhålla dessa system, särskilt i samarbetsinriktade teammiljöer.

ClickUp har en annan approach. Det integrerar kontexten direkt i din arbetsyta där arbetet faktiskt utförs. Detta gör ClickUp till ett förbättringslager och ett djupt integrerat agenssystem som är optimerat för team.

Låt oss förstå detta bättre. 📝

Bygga in minne i arbetsytan

Kärnan i ClickUps AI-funktioner är ClickUp Brain, en kontextmedveten motor som fungerar som ett inbyggt minnessystem.

Till skillnad från traditionella MCP:er som förlitar sig på ytlig prompt-historik eller externa databaser, förstår Brain strukturen i din arbetsyta och kommer ihåg viktig information från olika uppgifter, kommentarer, tidslinjer och dokument. Det kan:

- Identifiera flaskhalsar baserat på historiska förseningar och hinder

- Svara på rollspecifika frågor som "Vem äger detta?" eller "Har QA granskat det?"

- Omvandla mötesanteckningar till strukturerade uppgifter, komplett med tilldelningar och deadlines.

📌 Exempel: Be Brain att "sammanfatta framstegen för marknadsföringskampanjerna under andra kvartalet" så refererar det till relaterade uppgifter, statusar och kommentarer i olika projekt.

Automatisera svar, uppgiftsfördelning och åtgärder

Medan MCP-implementeringar kräver kontinuerlig modelljustering, förenar ClickUp, som en programvara för automatisering av uppgifter, beslutsfattande och utförande i samma system.

Med ClickUp Automations kan du utlösa åtgärder baserat på händelser, villkor och logik utan att skriva en enda rad kod. Du kan också använda ClickUp Brain för att skapa anpassade automatiseringar för datainmatning med naturligt språk, vilket gör det enklare att skapa personliga arbetsflöden.

Utnyttja ClickUp Brain för att skapa anpassade triggers med ClickUp Automations

📌 Exempel: Flytta uppgifter till Pågående när statusen ändras, tilldela teamledaren när Hög prioritet markeras och varna projektägaren om ett förfallodatum missas.

Med denna grund som utgångspunkt introducerar ClickUp Autopilot Agents en ny nivå av intelligent autonomi. Dessa AI-drivna agenter fungerar på följande sätt:

- Triggers (t.ex. uppdateringar av uppgifter, omnämnanden i chatt)

- Villkor (t.ex. meddelandet innehåller brådskande)

- Åtgärder (t.ex. sammanfatta en tråd, tilldela en uppgift, skicka en avisering)

- Verktyg (t.ex. publicera i kanaler, uppdatera fält)

- Kunskap (t.ex. interna dokument, uppgifter, formulär och chattlogg)

Omvandla information till användbar kontext

ClickUp, som AI-agent, använder dina befintliga arbetsytedata för att agera smartare utan installation. Så här kan du omvandla all information från din arbetsyta till handlingsbar kontext:

- Uppgifter och deluppgifter: Tilldela uppföljningar, skapa sammanfattningar eller justera prioriteringar i ClickUp Tasks. AI hämtar information direkt från tilldelade personer, förfallodatum och kommentarer.

- Dokument och wikis: Be AI att hänvisa till teamets kunskap, sammanfatta dokumentation eller extrahera viktiga punkter under planeringen med hjälp av Docs.

- Anpassade fält: Använd dina egna taggar, kategorier eller poäng för att anpassa svaren. AI tolkar dina metadata för att skräddarsy resultatet efter ditt teams språk.

- Kommentarer och chatt: Fortsätt konversationer över olika trådar eller generera åtgärder baserat på diskussioner.

Se AI-drivna anpassade fält i aktion här. 👇🏼

Framtiden för modellkontextprotokoll

I takt med att AI fortsätter att utvecklas från statiska chattbottar till dynamiska system med flera agenter kommer MCP:s roll att bli allt mer central. Med stöd från stora namn som OpenAI och Anthropic lovar MCP interoperabilitet mellan komplexa system.

Men det löftet väcker stora frågor. 🙋

Till att börja med är de flesta MCP-implementeringar idag av demokvalitet, använder grundläggande studiotransport, saknar HTTP-stöd och erbjuder ingen inbyggd autentisering eller auktorisering. Det är ett hinder för företag att införa dem. Verkliga användningsfall kräver säkerhet, observerbarhet, tillförlitlighet och flexibel skalning.

För att överbrygga denna klyfta har konceptet MCP Mesh utvecklats. Det tillämpar beprövade servicemesh-mönster (som de som används i mikrotjänster) på MCP-infrastrukturen. MCP Mesh hjälper också till med säker åtkomst, kommunikation, trafikhantering, motståndskraft och upptäckt över flera distribuerade servrar.

Samtidigt visar AI-drivna plattformar som ClickUp att djupt inbäddade kontextmodeller i appar kan erbjuda ett mer praktiskt alternativ i teamorienterade miljöer.

I framtiden kan vi komma att se hybridarkitekturer som banar väg för AI-agenter som både är medvetna och handlingskraftiga.

Handla protokoll för produktivitet med ClickUp

Modellkontextprotokollet standardiserar hur AI kan komma åt externa system, men kräver en komplex teknisk installation.

MCP är kraftfullt, men kräver teknisk installation, vilket ökar utvecklingstiden, kostnaderna och utmaningarna med löpande underhåll.

ClickUp erbjuder ett praktiskt alternativ med ClickUp Brain och Automations inbyggt i din arbetsyta.

Det förstår automatiskt uppgiftskontext, projektdata och användarens avsikt. Detta gör ClickUp till en idealisk low-code-lösning för team som vill ha skalbar, kontextmedveten AI utan tekniska omkostnader.

✅ Registrera dig på ClickUp idag!