ปัญญาประดิษฐ์กำลังขยายตัวเร็วกว่ามาตรการควบคุมที่ล้อมรอบมัน

การวิจัย AI at the Core ของ IBMพบว่าเกือบ 74% ขององค์กรที่สำรวจรายงานว่ามีการครอบคลุมในระดับปานกลางหรือจำกัดในกรอบการบริหารความเสี่ยงและการกำกับดูแล AI ของตนในเทคโนโลยี, ผู้ให้บริการภายนอก, และความเสี่ยงของแบบจำลอง

กล่าวอีกนัยหนึ่ง มีหลายทีมที่กำลังส่งมอบโมเดล แต่มีเพียงไม่กี่ทีมที่สามารถตอบคำถามที่เกิดขึ้นตามมาได้อย่างมั่นใจ

🤔 ใครเป็นผู้อนุมัติสิ่งนี้ บนพื้นฐานอะไร มีหลักฐานอะไร และจะเกิดอะไรขึ้นเมื่อโมเดลเบี่ยงเบนในระหว่างการใช้งานจริง?

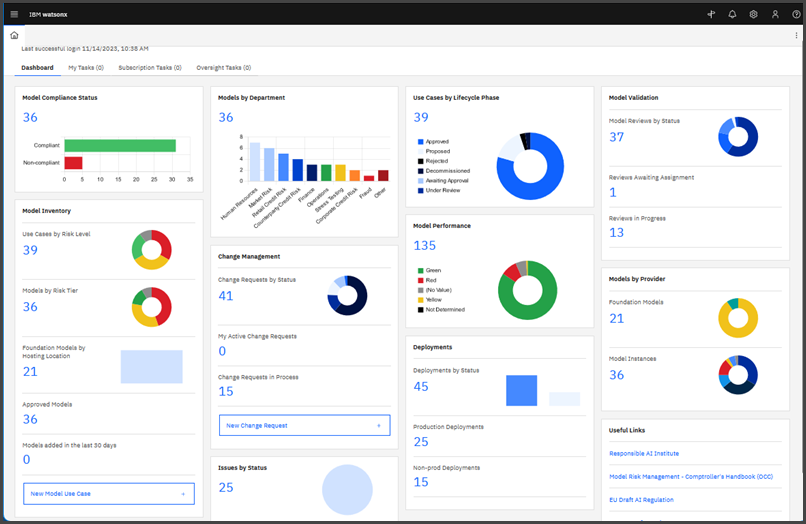

นี่คือสิ่งที่ IBM watsonx. governance ช่วยตอบคำถามได้เป็นส่วนใหญ่ มันช่วยให้คุณบริหารจัดการ, รักษาความปลอดภัย, และติดตาม AI ตลอดวงจรชีวิต ด้วยเวิร์กโฟลว์, การติดตาม, และการจัดการความเสี่ยงที่ออกแบบมาเพื่อสนับสนุนการขยายตัวอย่างรับผิดชอบ

ในคู่มือนี้ เราจะพาคุณไปดูวิธีการใช้ watsonx. governance เพื่อจัดทำเอกสารกรณีการใช้งาน, มาตรฐานการตรวจสอบและการอนุมัติ, บันทึกข้อมูลที่ถูกต้องของแบบจำลอง, และติดตามแบบจำลองในระหว่างการใช้งานเมื่อคุณขยายระบบ

IBM watsonx. governance คืออะไร?

IBM watsonx. governance เป็นแพลตฟอร์มการกำกับดูแล AI ระดับองค์กรที่พัฒนาโดย IBM ซึ่งเป็นส่วนหนึ่งของแพลตฟอร์ม AI และข้อมูล watsonx ของบริษัท ช่วยให้องค์กรสามารถกำหนดทิศทาง จัดการ ติดตาม และขยายกิจกรรม AI อย่างมีความรับผิดชอบตลอดวงจรชีวิตของ AI ทั้งหมด

มันทำหน้าที่เป็นโซลูชันแบบรวมศูนย์สำหรับการบริหารจัดการทั้งแบบจำลองการเรียนรู้ของเครื่อง (ML) แบบดั้งเดิมและแบบจำลองปัญญาประดิษฐ์เชิงสร้างสรรค์ (gen AI) รวมถึงแบบจำลองภาษาขนาดใหญ่และแอปพลิเคชันต่าง ๆ ไม่ว่าจะสร้างขึ้นบน IBM watsonx. ai หรือนำไปใช้บนแพลตฟอร์มของบุคคลที่สามที่รองรับ

IBM watsonx. การกำกับดูแลทำงานอย่างไร

watsonx. governance ถูกบรรจุเป็นชุดความสามารถที่บูรณาการซึ่ง IBM อธิบายว่าเป็นการรวมกันของ:

OpenPages สำหรับการบริหารความเสี่ยงและการปฏิบัติตามข้อกำหนด

OpenPages เป็นส่วนประกอบภายใน watsonx. governance ที่ทำหน้าที่เป็นเครื่องมือหลักในการจัดการความเสี่ยงและการปฏิบัติตามกฎระเบียบของคุณ ออกแบบมาเพื่อแปลงนโยบายของบริษัทของคุณให้เป็นตัวชี้วัดที่ชัดเจนและสามารถติดตามได้สำหรับทุกโมเดล AI

มันมอบเครื่องมือให้คุณเพื่อจัดการ การประเมินความเสี่ยงอย่างเป็นทางการ, แผนผังแบบจำลองตามข้อบังคับที่เฉพาะเจาะจง, และสร้างเส้นทางตรวจสอบที่ไม่สามารถเปลี่ยนแปลงได้สำหรับผู้กำกับดูแล

- การให้คะแนนความเสี่ยง: คุณสามารถกำหนดและติดตามระดับความเสี่ยงสำหรับทุกกรณีการใช้งาน AIโดยพิจารณาจากปัจจัยต่างๆ เช่น ความอ่อนไหวของข้อมูลที่ใช้หรือผลกระทบจากการตัดสินใจของ AI

- การวางแผนการปฏิบัติตามข้อกำหนด: สิ่งนี้ช่วยให้คุณสามารถเชื่อมโยงแบบจำลองกับกรอบการกำกับดูแล เช่น พระราชบัญญัติ AI ของสหภาพยุโรป หรือกรอบการจัดการความเสี่ยง AI ของ NIST และติดตามหลักฐานและสถานะการปฏิบัติตามข้อกำหนดตลอดการตรวจสอบ

- เส้นทางการตรวจสอบ: OpenPages บันทึกข้อมูลถาวรเกี่ยวกับผู้ที่อนุมัติอะไรและเมื่อใด ซึ่งมีความ สำคัญอย่างยิ่งในการพิสูจน์การปฏิบัติตามข้อกำหนดระหว่างการตรวจสอบ

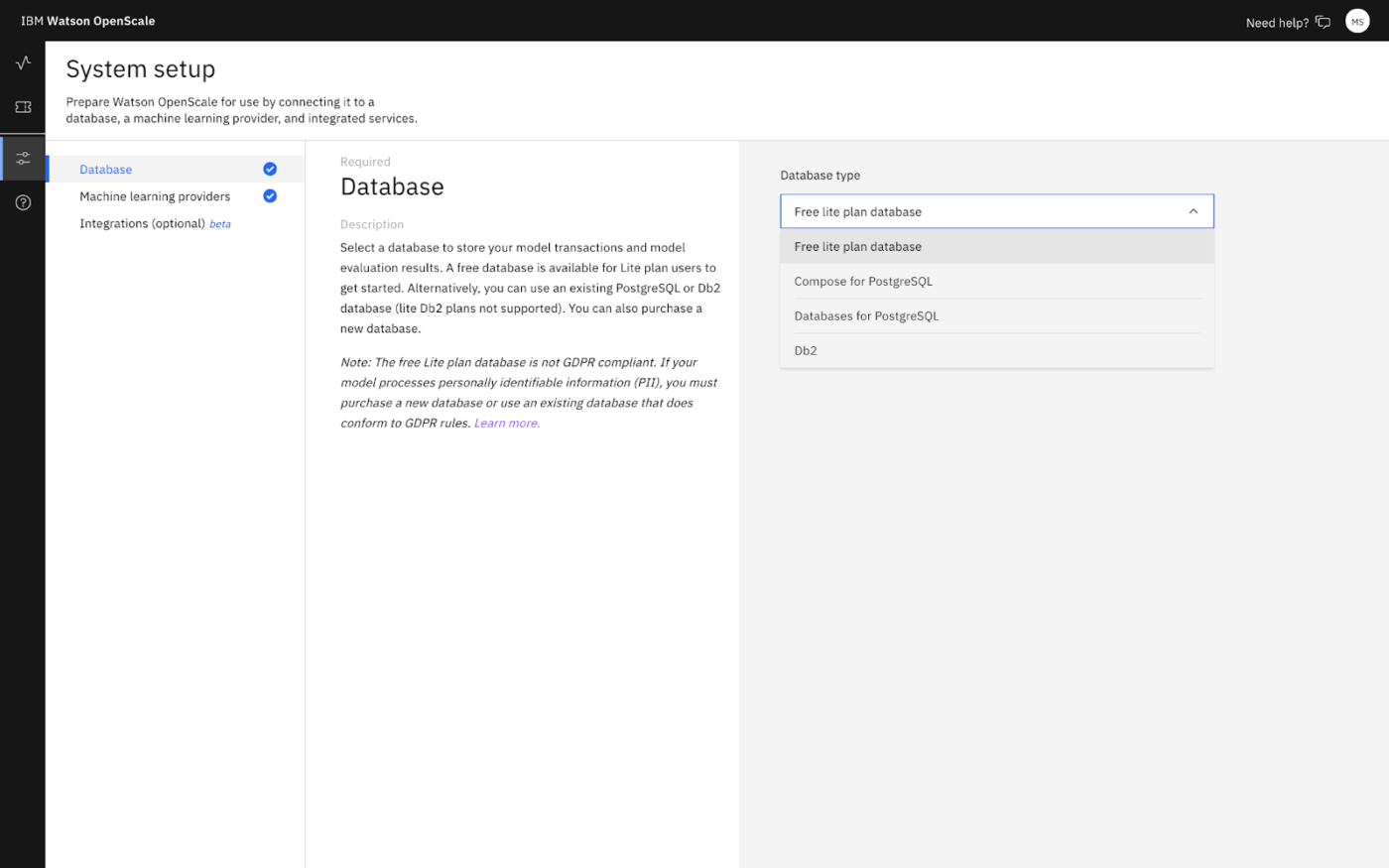

OpenScale สำหรับการตรวจสอบโมเดล

OpenScale คือเครื่องมือตรวจสอบแบบเรียลไทม์ที่เฝ้าดูแลโมเดลของคุณหลังจากนำไปใช้งานจริงแล้ว เป็นระบบเตือนภัยล่วงหน้าสำหรับปัญหาที่อาจเกิดขึ้นเมื่อโมเดลมีปฏิสัมพันธ์กับข้อมูลที่ไม่เป็นระเบียบและคาดเดาไม่ได้ในโลกแห่งความเป็นจริง

- การตรวจจับการเบี่ยงเบน: ระบุเมื่อข้อมูลนำเข้าหรือข้อมูลส่งออกของโมเดลเริ่มดูแตกต่างจากข้อมูลที่ใช้ในการฝึกฝน ซึ่งเป็นสัญญาณว่าประสิทธิภาพของโมเดลอาจลดลง

- การตรวจสอบความเป็นธรรม: ติดตามการคาดการณ์ในกลุ่มที่มีความอ่อนไหว (เช่น อายุหรือเพศ) เพื่อตรวจจับอคติของ AIที่อาจเกิดขึ้นก่อนที่มันจะกลายเป็นปัญหาเชิงระบบ

- ความสามารถในการอธิบายได้: สามารถสร้างคำอธิบายที่มนุษย์อ่านเข้าใจได้สำหรับพฤติกรรมและการทำนายของแบบจำลอง ขึ้นอยู่กับประเภทและการตั้งค่าของแบบจำลอง ซึ่งมีความสำคัญอย่างยิ่งสำหรับการตรวจสอบและการสอบถามจากลูกค้า

- ตัวชี้วัดประสิทธิภาพ: ติดตามตัวชี้วัดประสิทธิภาพหลัก เช่น ความถูกต้องและเวลาตอบสนอง เพื่อให้แน่ใจว่าโมเดลยังคงตอบสนองต่อความต้องการทางธุรกิจ

เอกสารข้อมูล AI สำหรับการติดตามวงจรชีวิต

เอกสารข้อมูล AI เป็นส่วนหนึ่งของการจัดการวงจรชีวิตเอกสารสำหรับทุกโมเดล เอกสารข้อมูลจะติดตามรายละเอียดสำคัญโดยอัตโนมัติในทุกขั้นตอนของวงจรชีวิต AI ซึ่งรวมถึง:

- ข้อมูลเมตาการพัฒนา เช่น แหล่งข้อมูลการฝึกอบรมและการเลือกใช้อัลกอริทึม

- ผลการประเมิน เช่น ตัวชี้วัดการทดสอบและการประเมินความลำเอียง

- รายละเอียดการPLOYMENT รวมถึงที่ที่แบบจำลองกำลังทำงานอยู่ และใครสามารถเข้าถึงได้

- ประวัติการดำเนินงาน เช่น แนวโน้มประสิทธิภาพและเหตุการณ์ในอดีต

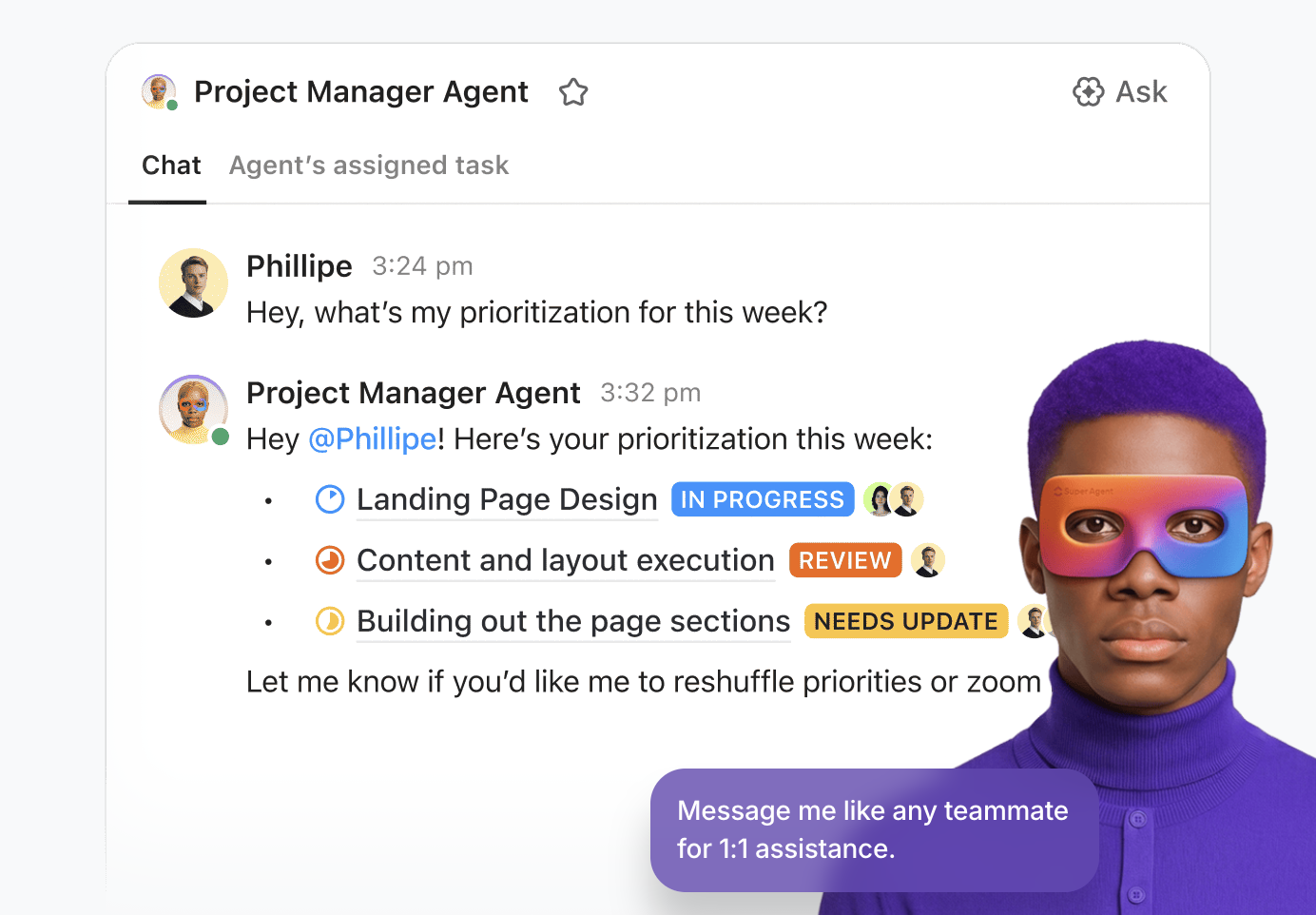

🔍 ClickUp Brain MAX: ทดสอบหลายโมเดลได้เร็วขึ้น ก่อน ถึงขั้นตอนการกำกับดูแล

ก่อนที่โมเดล คำสั่ง หรือเอเจนต์จะไปถึง IBM watsonx. governance ทีมต่างๆ มักต้องการสถานที่สำหรับ คิด ทดสอบ และเปรียบเทียบ โดยปราศจากอุปสรรค

นั่นคือจุดที่ClickUp Brain MAX โดดเด่น

Brain MAX เป็นแอปพลิเคชัน AI บนเดสก์ท็อปแบบสแตนด์อโลนที่ช่วยให้ทีมสามารถสลับระหว่างโมเดลชั้นนำหลายตัว (เช่น GPT, Claude, Gemini) ในบริบทของพื้นที่ทำงานเดียวกันได้ คุณสามารถรัน คำสั่งเดียวกัน, ตรรกะการตัดสินใจ, หรือร่างผลลัพธ์ บนโมเดลต่างๆ ข้างกัน เปรียบเทียบคำตอบได้ทันที และเก็บเส้นทางเหตุผลทั้งหมดไว้กับงานที่ทำอยู่

สิ่งนี้ทำให้ Brain MAX มีประสิทธิภาพเป็นพิเศษสำหรับ:

- การเปรียบเทียบโมเดลและคำสั่งเริ่มต้นในระยะเริ่มต้น ก่อนการประเมินอย่างเป็นทางการ

- การทดสอบความเครียดผลลัพธ์ สำหรับโทน, คุณภาพการให้เหตุผล, หรือกรณีขอบเขตที่ซับซ้อนในหลากหลายโมเดล

- การบันทึกและเก็บรักษา "เหตุผลที่เราเลือกวิธีนี้" ไว้โดยตรงข้างๆ งานและเอกสาร

เมื่อทีมต่าง ๆ สามารถรวมตัวกันได้ในพฤติกรรมที่ถูกต้อง, คำสั่ง, หรือการเลือกรูปแบบที่เหมาะสม, ระบบการกำกับดูแลของ watsonx จะกลายเป็นระบบบันทึกข้อมูลหลัก. เอกสารสรุป, การอนุมัติ, และการติดตามตรวจสอบจะสะท้อนถึงการตัดสินใจที่ได้รับการทดสอบภายใต้แรงกดดัน, ได้รับการบันทึกไว้, และได้รับการตกลงกันไว้แล้ว.

👉 ในทางปฏิบัติ Brain MAX เร่ง การเรียนรู้และการทำซ้ำ ในขณะที่ watsonx. governance รับประกัน การควบคุมและความรับผิดชอบ เมื่อทำงานร่วมกัน พวกเขาป้องกันไม่ให้การกำกับดูแลชะลอการนวัตกรรม—หรือนวัตกรรมหลีกเลี่ยงการกำกับดูแล

วิธีตั้งค่าการกำกับดูแล watsonx. สำหรับทีมของคุณ

ตอนนี้เรามาตั้งค่าการกำกับดูแล watsonx. สำหรับทีมของคุณทีละขั้นตอนกัน 👇

1. เชื่อมต่อฐานข้อมูล (ดาต้ามาร์ท)

เปิด URL ของ watsonx. governance สำหรับภูมิภาคของคุณ จากนั้นไปที่ กำหนดค่า → ฐานข้อมูล และเลือกประเภทฐานข้อมูล (Lite หรือฐานข้อมูล DB2/PostgreSQL ของคุณเอง)

2. กำหนดกรณีการใช้งาน AI

- ไปที่ กรณีการใช้งาน AI → ตั้งค่าให้สมบูรณ์

- นี่สร้าง ID บริการ: watsonx. governance_DO_NOT_DELETE

- หากคุณไม่มีสินค้าคงคลังเริ่มต้น ระบบจะแจ้งให้คุณสร้างหนึ่งรายการ ซึ่งจำเป็นสำหรับการจัดการโมเดลภายนอก ไฟล์แนบ และรายงานการกำกับดูแล

3. สร้างนโยบายการเข้าถึง (เชิญทีมของคุณ)

ใน IBM Cloud, จัดการ → การเข้าถึง (IAM) → ผู้ใช้ → เชิญผู้ใช้ → กำหนด นโยบายการเข้าถึง สำหรับบริการ watsonx. กำหนดขอบเขตและขอบเขต (บัญชี/กลุ่มทรัพยากร/อินสแตนซ์เฉพาะ)

📌 ผู้ใช้จำเป็นต้องมีสิทธิ์ Reader/Writer+ เพื่อเข้าถึงบริการ Writer+ สามารถดูข้อมูลข้ามโปรเจกต์และพื้นที่การปรับใช้ได้

4. จัดการผู้ใช้และบทบาทในระบบ watsonx. governance

กำหนดบทบาทการร่วมมือสำหรับการดำเนินการที่เกี่ยวข้องกับการประเมิน (ผู้ดูแลระบบ/ผู้แก้ไข/ผู้ชม/ผู้ปฏิบัติการ) ตามหน้าที่ที่แต่ละบุคคลควรทำ

👀 คุณรู้หรือไม่? การละเมิดข้อมูลเพียงครั้งเดียวในยุคปัจจุบันอาจมีขนาดใหญ่เท่ากับสนามกีฬา!การละเมิดข้อมูลของ Under Armourที่เพิ่มเข้ามาในเดือนมกราคม 2026 มีบัญชีที่ได้รับผลกระทบถึง 72.7 ล้านบัญชี

วิธีดำเนินการวงจรชีวิตการกำกับดูแล AI ด้วย ClickUp

IBM watsonx. governance ทำหน้าที่เป็นระบบกำกับดูแลหลักสำหรับ AI ซึ่งมีการติดตามโมเดล คำสั่งประเมิน และการอนุมัติอย่างเป็นทางการด้วยโครงสร้างและความสามารถในการตรวจสอบย้อนกลับ

แต่การบริหารจัดการยังคงต้องดำเนินการข้ามแผนกต่าง ๆ อยู่ดี ซึ่งก็ต้องมีใครสักคนรับผิดชอบในการจับบริบทเบื้องต้น ติดตามการตัดสินใจ จัดการหลักฐานให้สอดคล้องกัน และขับเคลื่อนงานให้เดินหน้าต่อไป โดยไม่ให้กระบวนการกลายเป็นเขาวงกตแห่งการส่งต่องานงานที่ขยายตัวมหาศาลกำลังเกิดขึ้น!

เข้าสู่ClickUp ในฐานะพื้นที่ทำงาน AI แบบรวมศูนย์แห่งแรกของโลก มันเชื่อมต่อชั้นการดำเนินงาน—เอกสาร, งาน, แชท, กระบวนการทำงาน, ความรู้, AI และการมองเห็นของผู้นำ—เพื่อให้ทีมของคุณสามารถดำเนินวงจรการกำกับดูแลได้อย่างราบรื่นไร้รอยต่อ

มาดูกันว่าจะทำอย่างไร 👇

สร้างและบันทึกกรณีการใช้งาน AI

กรณีการใช้งานสามารถบันทึกได้ง่ายเพียงครั้งเดียว ส่วนที่ยากกว่าคือการรักษาเอกสารนั้นให้สอดคล้องกันเมื่อแนวคิดถูกทดสอบภายใต้แรงกดดันจากทีมความเสี่ยง ทีมกฎหมาย ทีมความปลอดภัย และทีมส่งมอบ

แก้ไขปัญหานั้นด้วยClickUp Docs ตัวอย่างเช่นใช้แม่แบบเอกสาร ClickUp Docสำหรับทุกกรณีการใช้งาน AI ใหม่ เพื่อให้แต่ละโครงการเริ่มต้นด้วยข้อมูลนำเข้าที่เป็นมาตรฐานเดียวกัน:

- วัตถุประสงค์

- ผู้มีส่วนได้เสีย

- บริบทของข้อมูล

- ผลลัพธ์ที่คาดหวัง

- ข้อจำกัด

- เกณฑ์ความสำเร็จ

นอกจากนี้ ให้เก็บการอภิปรายกรณีการใช้งานและการตัดสินใจไว้ในเอกสารโดยใช้ @mentionsและความคิดเห็นที่มอบหมายใน ClickUp เมื่อการตรวจสอบดำเนินไป ให้เปลี่ยนขั้นตอนถัดไปเป็นงานใน ClickUpโดยตรงจากเอกสาร

หากเหมาะสมกับขั้นตอนการทำงานของคุณ ให้เพิ่มClickUp Brainเข้าไปเพื่อเร่งความเร็วในส่วนที่มักจะล่าช้า ใช้เพื่อย่อสรุปสำหรับผู้บริหาร ระบุสมมติฐานที่ต้องการการตรวจสอบ หรือร่างข้อพิจารณาเบื้องต้นเกี่ยวกับการกำกับดูแล (เช่น จุดตรวจสอบด้านความเป็นธรรมหรือความเป็นส่วนตัว) โดยอ้างอิงจากสิ่งที่ทีมของคุณได้เขียนไว้แล้ว

เมื่อกรณีการใช้งานเสร็จสิ้นแล้ว ให้จัดทำอย่างเป็นทางการใน IBM watsonx. governance เพื่อให้กลายเป็นจุดยึดที่ควบคุมสำหรับการติดตามวงจรชีวิตและการจัดทำเอกสารข้อเท็จจริง

ในการกำกับดูแล watsonx. ให้สร้างกรณีการใช้งาน AI ในคลังข้อมูล:

- ไปที่ แคตตาล็อก → กรณีการใช้งาน AI

- คลิก กรณีการใช้งาน AI ใหม่

- กรอก ชื่อ และเลือก สินค้าคงคลัง

- กรอกข้อมูลในช่องที่จำเป็น เช่น: คำอธิบาย (ปัญหาทางธุรกิจ + บริบท) ระดับความเสี่ยง ข้อมูลสนับสนุน เจ้าของ สถานะ แท็ก

- คำอธิบาย (ปัญหาทางธุรกิจ + บริบท)

- ระดับความเสี่ยง

- ข้อมูลสนับสนุน

- เจ้าของ

- สถานะ

- แท็ก

- คำอธิบาย (ปัญหาทางธุรกิจ + บริบท)

- ระดับความเสี่ยง

- ข้อมูลสนับสนุน

- เจ้าของ

- สถานะ

- แท็ก

จากนั้น กรณีการใช้งานจะกลายเป็นสถานที่สำหรับดูการติดตามวงจรชีวิต (ภาพรวม/วงจรชีวิต/การเข้าถึง) และเชื่อมต่อสินทรัพย์ที่อยู่ภายใต้การกำกับดูแลกับแผ่นข้อมูลของพวกเขา

เอกสารข้อมูลสรุป (Factsheets) ช่วยในการรวบรวมข้อมูลเมตาดาตาเกี่ยวกับการกำกับดูแลและการปฏิบัติตามข้อกำหนดตลอดวงจรชีวิต รวมถึงวัตถุประสงค์/ความสำคัญ และลำดับการดำเนินการที่เกิดขึ้นระหว่างการพัฒนาและการนำไปใช้งาน

📮 ClickUp Insight: 53% ขององค์กรไม่มีการกำกับดูแล AI หรือมีเพียงแนวทางไม่เป็นทางการเท่านั้น และเมื่อผู้คนไม่ทราบว่าข้อมูลของพวกเขาไปที่ไหน—หรือว่าเครื่องมืออาจสร้างความเสี่ยงด้านความสอดคล้องหรือไม่—พวกเขาก็ลังเล หากเครื่องมือ AI อยู่ภายนอกระบบที่เชื่อถือได้หรือมีแนวปฏิบัติด้านข้อมูลที่ไม่ชัดเจน ความกลัวว่า "ถ้าสิ่งนี้ไม่ปลอดภัยล่ะ?" ก็เพียงพอที่จะหยุดการนำไปใช้ได้ทันที

นั่นไม่ใช่กรณี ของสภาพแวดล้อมที่ได้รับการควบคุมอย่างสมบูรณ์ และปลอดภัยของ ClickUp. ClickUp AIเป็นไปตามข้อกำหนดของ GDPR, HIPAA, และ SOC 2, และได้รับการรับรองมาตรฐาน ISO 42001, ทำให้ข้อมูลของคุณเป็นส่วนตัว, ได้รับการคุ้มครอง, และได้รับการจัดการอย่างรับผิดชอบ.

ผู้ให้บริการ AI ภายนอกไม่ได้รับอนุญาตให้ฝึกอบรมหรือเก็บรักษาข้อมูลลูกค้าของ ClickUp แต่อย่างใด และการรองรับหลายโมเดลจะดำเนินการภายใต้สิทธิ์ การควบคุมความเป็นส่วนตัว และมาตรฐานความปลอดภัยที่เข้มงวดแบบเดียวกัน ที่นี่ การกำกับดูแล AI กลายเป็นส่วนหนึ่งของพื้นที่ทำงานเอง ทำให้ทีมสามารถใช้ AI ได้อย่างมั่นใจ โดยไม่มีความเสี่ยงเพิ่มเติม

ประเมินโมเดลและคำสั่งของปัญญาประดิษฐ์

การประเมินแบบจำลองเป็นขั้นตอนที่สำคัญแต่ซับซ้อนซึ่งมีหลายส่วนที่ต้องดำเนินการ คุณต้องทำการทดสอบประสิทธิภาพ ตรวจสอบอคติ และทดสอบโหมดความล้มเหลว ทั้งหมดนี้ต้องทำไปพร้อมกับการแจ้งให้ผู้มีส่วนได้ส่วนเสียหลายฝ่ายทราบ

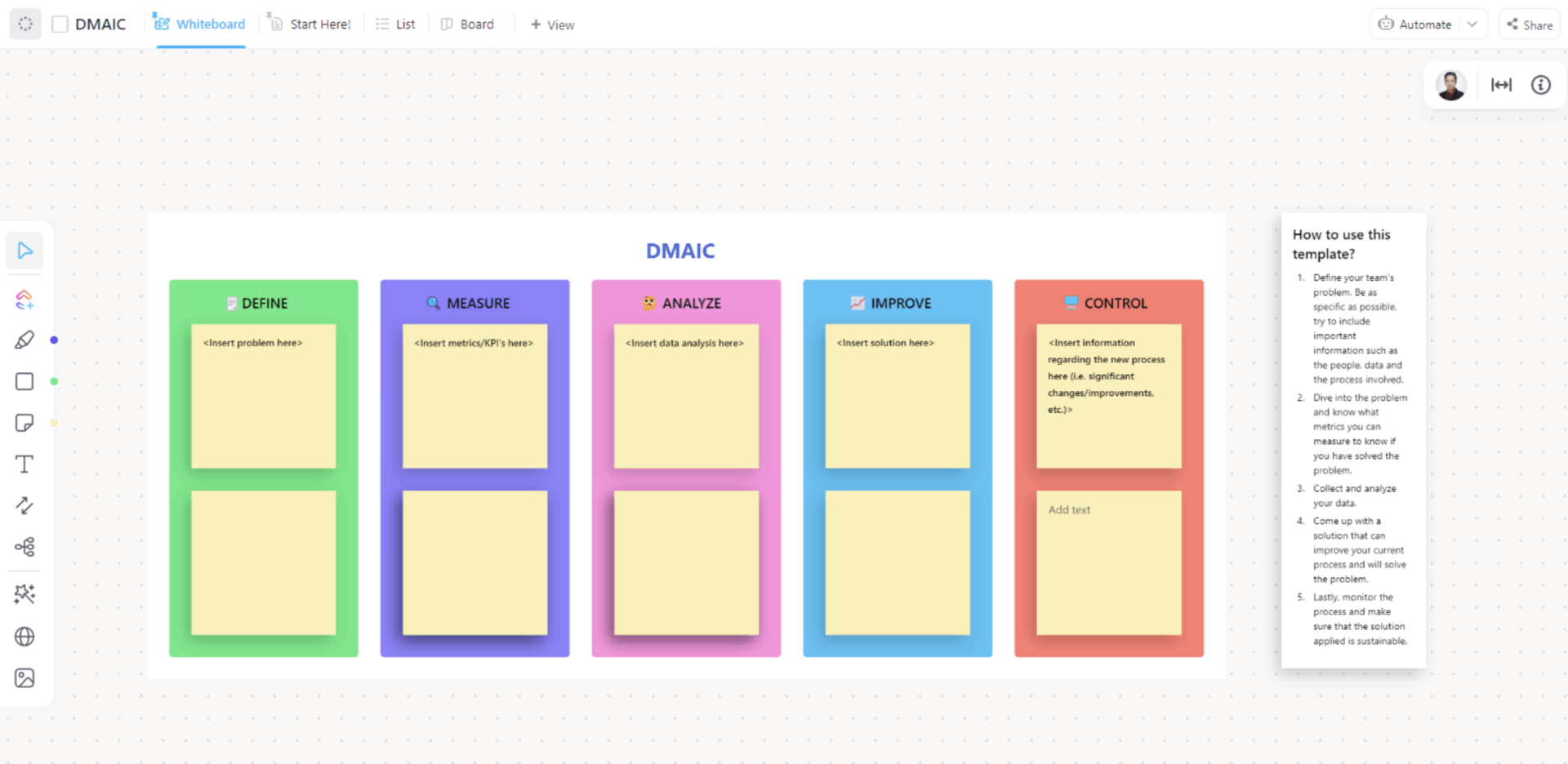

เพื่อสร้างกระบวนการทำงานที่สามารถทำซ้ำได้ ให้ใช้ เทมเพลต DMAIC ของ ClickUp

สร้างกระบวนการประเมินผลด้วยสถานะที่กำหนดเองตามขั้นตอนโดยใช้เทมเพลต DMAIC ของ ClickUp

ภายในเทมเพลตนี้ คุณสามารถสร้างกระบวนการประเมินผลโดยใช้สถานะที่กำหนดเองของ ClickUp ได้ ซึ่งหมายความว่าสถานะต่างๆ สามารถสะท้อนขั้นตอนของการประเมินของคุณได้ เช่น รอดำเนินการประเมิน, ทดสอบอคติ, ทบทวนประสิทธิภาพ, และพร้อมสำหรับการอนุมัติ

คุณยังสามารถลบการส่งต่องานด้วยตนเองได้ด้วยClickUp Automations ตัวอย่างเช่น เมื่องานย้ายไปยัง การทดสอบอคติ ระบบอัตโนมัติที่คุณตั้งค่าไว้สามารถมอบหมายงานให้กับผู้ตรวจสอบด้านการปฏิบัติตามข้อกำหนดของคุณ และเพิ่มความคิดเห็นพร้อมรายการตรวจสอบการทดสอบและลิงก์ที่เกี่ยวข้อง

เมื่อกระบวนการทำงานของคุณได้รับการจัดตั้งขึ้นแล้ว คุณสามารถดำเนินการประเมินทางเทคนิคได้ใน watsonx:

- สำหรับเทมเพลตคำสั่งและ genAI: ดำเนินการประเมินคำสั่งจากสินทรัพย์เทมเพลตคำสั่ง ตรวจสอบคะแนนเมตริก และใช้สรุปการประเมินเพื่อตรวจหาการละเมิดเกณฑ์

- สำหรับโมเดลที่ไม่ได้โฮสต์โดย IBM หรือภายนอก: คุณสามารถประเมินเทมเพลตคำสั่งแบบ 'แยก' ได้ในประเภทงานที่รองรับ เช่น การสรุป การจำแนกประเภท การตอบคำถาม การสกัดข้อมูล การสร้างเนื้อหา และ RAG โดยมีตัวชี้วัดที่แตกต่างกันตามโมเดลและงาน

อนุมัติและปรับใช้โมเดล AI

ใช้ClickUp Super Agentsเพื่อดำเนินการในช่องทางอนุมัติตั้งแต่ต้นจนจบ

พวกเขาคือเพื่อนร่วมทีมที่ขับเคลื่อนด้วย AI ซึ่งทำงานร่วมกับบริบทของ Workspace อย่างสมบูรณ์ และสามารถดำเนินการเวิร์กโฟลว์หลายขั้นตอนได้อย่างปลอดภัย ยิ่งไปกว่านั้น คุณยังสามารถกำหนดวิธีการทำงานของพวกเขาได้ผ่านคำแนะนำ ตัวกระตุ้น เครื่องมือ และองค์ความรู้ เพื่อให้มั่นใจว่าพวกเขาดำเนินงานภายในขอบเขตที่กำหนดไว้

ตัวอย่างเช่น เมื่อการประเมินกำลังจะสิ้นสุดลง ซูเปอร์เอเจนต์สามารถรวบรวมสิ่งที่ผู้ตรวจสอบต้องการไว้ในที่เดียว (เช่น บริบทกรณีการใช้งานปัจจุบัน บันทึกการตัดสินใจ และลิงก์ไปยังหลักฐานที่เกี่ยวข้อง)

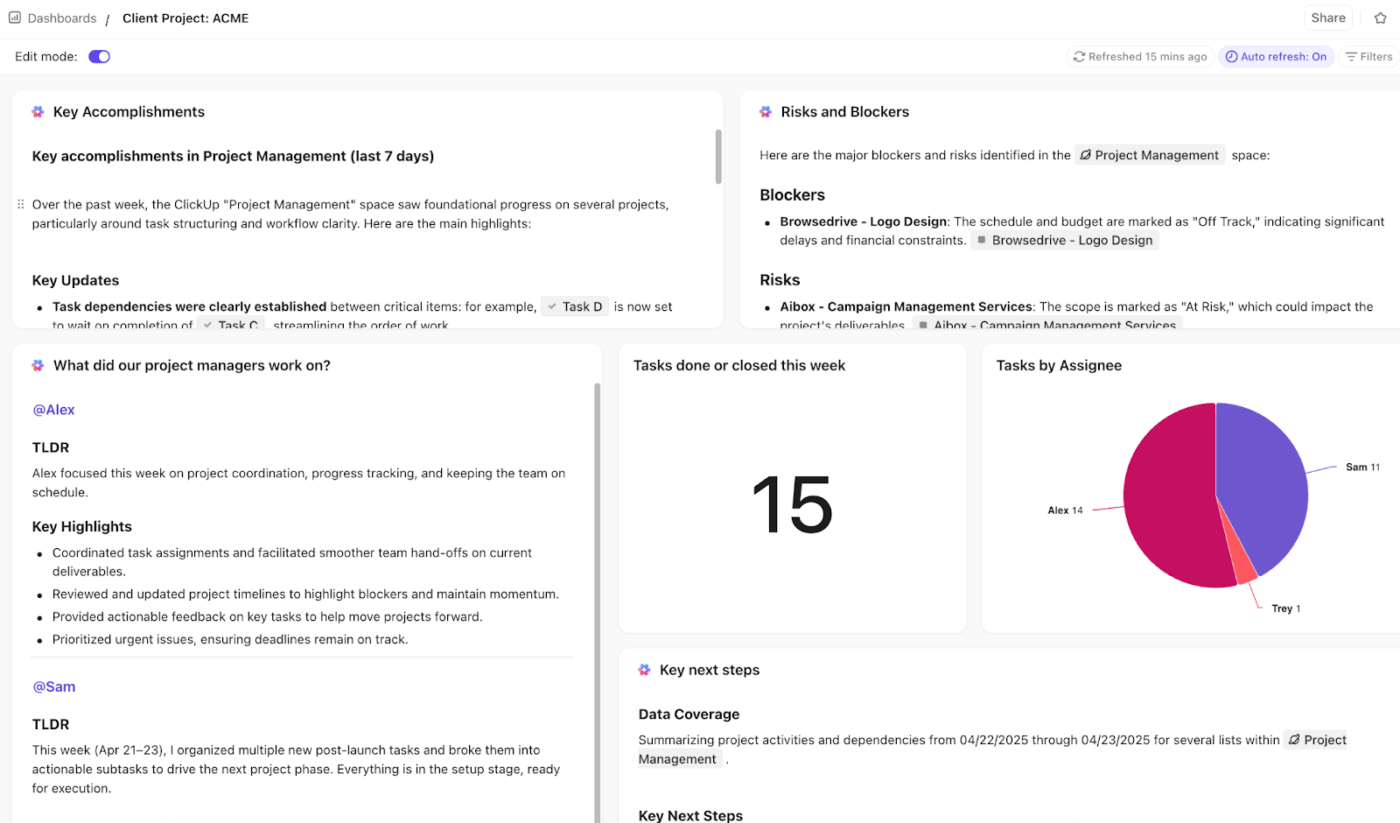

ต่อไป,แดชบอร์ดของ ClickUpสามารถแปลงข้อมูลงานจาก Workspace ให้เป็นมุมมองภาพรวมระดับสูงของความคืบหน้า เพื่อให้ผู้นำสามารถเห็นได้ว่ามีโมเดลจำนวนเท่าใดที่รอการตรวจสอบ, ขั้นตอนใดที่ค้างอยู่, และอะไรที่กำลังจะหมดอายุ

สร้างแดชบอร์ดการจัดการโครงการของคุณเองบน ClickUp ⬇️

จากนั้นคุณสามารถผูกกระบวนการทำงานที่ใช้งานอยู่กลับไปยัง watsonx ได้

- ในระบบ watsonx. governance ของ IBM ได้จัดเตรียมกระบวนการทำงานตามวงจรชีวิตของแบบจำลอง (Model Lifecycle workflow) ซึ่งนำแบบจำลอง AI ผ่านขั้นตอนต่าง ๆ และผู้มีส่วนได้ส่วนเสียต่าง ๆ ไปจนถึง การอนุมัติสำหรับการPLOYMENT ทั้งนี้เพื่อให้ระบบที่ได้รับการกำกับดูแลเป็นระบบบันทึกข้อมูลที่ถูกต้องและสอดคล้องกับขั้นตอนที่คุณทีมของคุณดำเนินการอยู่ในระบบ ClickUp

- หลังจากได้รับการอนุมัติแล้ว การติดตามตรวจสอบจะตามมา Watson OpenScale สามารถกำหนดค่าให้ใช้ตัวติดตามที่ประเมินสินทรัพย์ที่ใช้งานอยู่ตามเกณฑ์ที่คุณกำหนด (เช่น เกณฑ์ความยุติธรรมหรือเกณฑ์ความแม่นยำ/การเบี่ยงเบน)

🚀 ข้อได้เปรียบของ ClickUp: สร้างแดชบอร์ดสำหรับผู้นำและเพิ่มบัตร ClickUp AIที่สรุปสิ่งที่ขัดขวางการอนุมัติ (เช่น 'อะไรที่รอการตรวจสอบจากฝ่ายกฎหมาย?' หรือ 'โมเดลใดที่อยู่ในขั้นตอนการตรวจสอบนานที่สุด?').

ข้อจำกัดของการใช้ Watsonx สำหรับการกำกับดูแลและการขยายขนาด AI

ไม่มีเครื่องมือใดที่แก้ปัญหาได้ทุกอย่าง และสิ่งสำคัญคือต้องเข้าใจข้อจำกัดของแพลตฟอร์มก่อนที่คุณจะตัดสินใจใช้งาน

นี่คือบางสิ่งที่ควรพิจารณาเกี่ยวกับการกำกับดูแล watsonx 👀

| ข้อจำกัด | ผลกระทบ |

| การเปลี่ยนแปลงของระบบนิเวศ IBM | แม้ว่าจะรองรับโมเดลของบุคคลที่สาม แต่การผสานรวมที่ลึกที่สุดคือกับเครื่องมือของ IBM เอง ทีมงานที่ลงทุนอย่างมากในแพลตฟอร์มคลาวด์อื่นอาจพบกับความขัดแย้ง |

| ความซับซ้อนสำหรับทีมขนาดเล็ก | แพลตฟอร์มนี้ถูกสร้างขึ้นสำหรับการดำเนินงานในระดับองค์กร ทีมขนาดเล็กอาจพบว่าค่าใช้จ่ายและความซับซ้อนมีมากกว่าที่พวกเขาต้องการ |

| เส้นโค้งการเรียนรู้ของ OpenPages | โมดูลการจัดการความเสี่ยงถูกออกแบบมาในตอนแรกเพื่อการเงิน ดังนั้นแนวคิดและอินเตอร์เฟซอาจไม่รู้สึกเป็นธรรมชาติสำหรับทีมที่คุ้นเคยกับ AI |

| ข้อจำกัดในการปรับแต่ง | เทมเพลตการปฏิบัติตามข้อกำหนดที่สร้างไว้ล่วงหน้าเป็นจุดเริ่มต้นที่ดี แต่พวกเขาอาจไม่ตรงกับความต้องการด้านกฎระเบียบที่เป็นเอกลักษณ์หรือเฉพาะของบริษัทคุณอย่างสมบูรณ์ |

| การกำกับดูแล AI เชิงสร้างสรรค์ยังอยู่ในช่วงพัฒนา | เครื่องมือสำหรับการบริหารจัดการโมเดลภาษาขนาดใหญ่(LLMs) กำลังพัฒนาอย่างรวดเร็วทั่วทั้งอุตสาหกรรม และความสามารถในการกำกับดูแลยังคงเติบโตควบคู่ไปกับแนวปฏิบัติที่ดีที่สุดที่เกิดขึ้นใหม่ |

เครื่องมือทางเลือกอื่น ๆ ที่สามารถใช้ได้

หากการกำกับดูแล IBM watsonx. ไม่ตรงกับความต้องการของคุณ คุณมีทางเลือกอื่น ๆ ขึ้นอยู่กับว่าคุณต้องการชุดการกำกับดูแลแบบคลาวด์เนทีฟหรือชั้นการตรวจสอบที่ไม่ผูกกับคลาวด์

- Amazon SageMaker Model Monitor + Amazon SageMaker Model Cards: เป็นตัวเลือกที่แข็งแกร่งหากคุณลงทุนใน AWS อยู่แล้ว Model Monitor มุ่งเน้นการตรวจสอบการผลิต (เช่น การตรวจจับปัญหาคุณภาพ เช่น การเบี่ยงเบน/ความผิดปกติ และการแจ้งเตือนคุณ) ในขณะที่ Model Cards ช่วยคุณบันทึกข้อมูลรายละเอียดของโมเดลสำหรับการตรวจสอบและการรายงานการกำกับดูแลในรูปแบบมาตรฐาน

- Azure Machine Learning Responsible AI: เหมาะที่สุดเมื่อเวิร์กโฟลว์ของคุณอยู่ใน Azure อยู่แล้ว และคุณต้องการวิธีในตัวเพื่อประเมินโมเดลในด้านความเป็นธรรม การวิเคราะห์ข้อผิดพลาด และการอธิบายได้ (รวมถึงการวิเคราะห์ 'สมมติว่า'/การวิเคราะห์ทางเลือก) ในอินเทอร์เฟซเดียว

- การตรวจสอบโมเดล Google Vertex AI: เทียบเท่าของ Google Cloud สำหรับทีมที่ใช้งานบน GCP โดยเน้นการรันงานตรวจสอบตามกำหนดเวลาหรือตามความต้องการ ติดตามสัญญาณคุณภาพของโมเดล/ข้อมูล (เช่น การเบี่ยงเบน/ความไม่สมดุลของฟีเจอร์) และแจ้งเตือนเมื่อค่าเกินเกณฑ์ที่กำหนด

- Fiddler AI + Arthur AI: เหมาะสำหรับเมื่อคุณต้องการชั้นการสังเกตการณ์ที่เป็นกลางต่อผู้ขายระหว่างโมเดลต่างๆ—มักถูกเลือกใช้เพื่อความเข้าใจเชิงลึกที่มากขึ้น การวิเคราะห์สาเหตุที่แท้จริงที่รวดเร็วขึ้น และการตรวจสอบความสอดคล้องกันระหว่างทีมและสภาพแวดล้อม

- MLflow: เหมาะที่สุดสำหรับทีมที่ต้องการความยืดหยุ่นแบบโอเพ่นซอร์ส MLflow มอบรากฐานที่แข็งแกร่ง (การติดตาม + รีจิสทรีของโมเดลพร้อมเมตาดาต้า/แท็กและขั้นตอนของวงจรชีวิต) แต่โดยทั่วไปแล้วคุณจะต้องใช้ความพยายามทางวิศวกรรมในการเพิ่มการบังคับใช้นโยบาย การตรวจสอบ/อนุมัติ และเวิร์กโฟลว์การกำกับดูแลในลักษณะที่สอดคล้องกับองค์กรของคุณ

ทำให้การกำกับดูแล AI เป็นรูปธรรมด้วย ClickUp

แพลตฟอร์มเช่น IBM Watsonx Governance สามารถมอบรากฐานทางเทคนิคสำหรับการควบคุมความเสี่ยงและการปฏิบัติตามข้อกำหนดให้แก่คุณได้ แต่การกำกับดูแลจะทำงานได้เพียงเมื่อทีมที่อยู่เบื้องหลังยังคงสอดคล้องและรับผิดชอบร่วมกัน

ClickUp เชื่อมโยงชั้นการดำเนินการนั้น เอกสารมาตรฐานนโยบายและบันทึกแบบจำลอง แดชบอร์ดทำให้การตรวจสอบและคอขวดมองเห็นได้ และตัวแทน AI ทำให้การอนุมัติและการส่งต่อเคลื่อนที่ไปข้างหน้า ดังนั้นการกำกับดูแลจึงยังคงปฏิบัติการได้แทนที่จะเป็นเพียงทฤษฎี

ที่สำคัญที่สุด การเปลี่ยนแปลงนี้ทำให้การกำกับดูแล AI กลายจากการตรวจสอบเป็นระยะๆ เป็นระบบที่มีชีวิต หนึ่งที่มีการบันทึกการตัดสินใจ การติดตามการดำเนินการ และความรับผิดชอบที่ชัดเจนในทุกขั้นตอนของวงจรชีวิต

เริ่มต้นใช้งานฟรีกับ ClickUpและดำเนินกระบวนการกำกับดูแลของคุณอย่างชัดเจนตั้งแต่ต้นจนจบ ✅

คำถามที่พบบ่อย

การกำกับดูแล AI ทั่วไปหมายถึงหลักการและนโยบายที่กว้างขวางซึ่งองค์กรนำมาใช้ ขณะที่การกำกับดูแล watsonx. เป็นแพลตฟอร์มซอฟต์แวร์เฉพาะที่ช่วยให้คุณนำไปใช้และทำให้การปฏิบัติเหล่านั้นเป็นอัตโนมัติ

ใช่ แพลตฟอร์มสามารถตรวจสอบและควบคุมโมเดลที่นำไปใช้บนคลาวด์อื่น ๆ เช่น AWS SageMaker และ Azure ML ได้ อย่างไรก็ตาม การผสานรวมอาจต้องมีการตั้งค่าด้วยตนเองมากกว่าเมื่อเทียบกับโมเดลที่เป็นของ IBM โดยตรง

การบริหารจัดการที่มีประสิทธิภาพเป็นงานที่ต้องอาศัยการทำงานเป็นทีม โดยทั่วไปจะเกี่ยวข้องกับนักวิทยาศาสตร์ข้อมูล วิศวกร ML เจ้าหน้าที่กำกับดูแลการปฏิบัติตามข้อกำหนด ผู้จัดการความเสี่ยง ผู้มีส่วนได้ส่วนเสียทางธุรกิจ และฝ่ายความปลอดภัยด้านไอที เพื่อครอบคลุมวงจรชีวิตทั้งหมด