AI växer snabbare än de skyddsräcken som omger den.

IBMs forskning AI at the Core visade att nästan 74 % av de tillfrågade organisationerna uppger att de endast har måttlig eller begränsad täckning i sina ramverk för AI-risker och styrning när det gäller teknik-, tredjeparts- och modellrisker.

Med andra ord levererar många team modeller, men långt färre kan med säkerhet svara på de frågor som dyker upp direkt efteråt:

🤔 Vem godkände detta, på vilken grund, med vilka bevis, och vad händer när modellen avviker i produktionen?

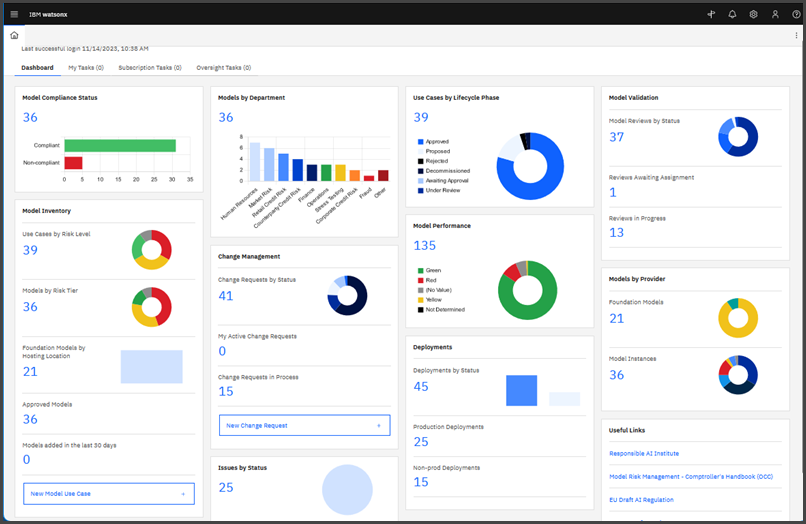

Det är vad IBM Watsonx Governance i stort sett svarar på. Det hjälper dig att styra, säkra och övervaka AI under hela livscykeln, med arbetsflöden, övervakning och riskhantering utformade för att stödja ansvarsfull skalning.

I den här guiden går vi igenom hur du använder watsonx. governance för att dokumentera användningsfall, standardisera granskningar och godkännanden, samla in rätt modellfakta och övervaka modeller i produktion när du skalar upp.

Vad är IBM watsonx. governance?

IBM Watsonx Governance är en AI-styrningsplattform för företag som utvecklats av IBM som en del av dess Watsonx AI- och dataplattform. Den hjälper organisationer att styra, hantera, övervaka och skala AI-aktiviteter på ett ansvarsfullt sätt under hela AI-livscykeln.

Det fungerar som en enhetlig lösning för styrning av både traditionella maskininlärningsmodeller (ML) och moderna generativa AI-modeller (gen AI), inklusive stora språkmodeller och applikationer, oavsett om de är byggda på IBM watsonx. ai eller distribuerade på stödda tredjepartsplattformar.

Hur IBM Watsonx Governance fungerar

watsonx. governance är ett integrerat paket med funktioner som IBM beskriver som en kombination av:

OpenPages för risk och efterlevnad

OpenPages är den komponent inom watsonx. governance som fungerar som din centrala risk- och efterlevnadsmotor. Den är utformad för att översätta ditt företags policyer till konkreta, spårbara mätvärden för varje AI-modell.

Det ger dig verktygen för att hantera formella riskbedömningar, koppla modeller till specifika regler och skapa oföränderliga revisionsspår för tillsynsmyndigheter.

- Riskbedömning: Du kan tilldela och spåra en risknivå för varje AI-användningsfall baserat på faktorer som känsligheten hos de data som används eller effekten av dess beslut.

- Kartläggning av efterlevnad: Detta gör att du kan kartlägga modeller mot regelverk som EU:s AI-lag eller NIST:s ramverk för riskhantering av AI, samt spåra bevis på efterlevnad och status i olika granskningar.

- Revisionsspår: OpenPages för en permanent journal över vem som godkänt vad och när, vilket är viktigt för att bevisa efterlevnad vid en revision.

OpenScale för modellövervakning

OpenScale är en realtidsövervakningsmotor som övervakar dina modeller efter att de har tagits i drift. Det är ditt varningssystem för problem som uppstår när en modell interagerar med oorganiserade, oförutsägbara data från den verkliga världen.

- Avvikelsedetektering: Identifierar när en modells in- eller utdata börjar avvika från den data som den tränats på, vilket kan vara ett tecken på att dess prestanda försämras.

- Övervakning av rättvisa: Spårar förutsägelser inom känsliga grupper (som ålder eller kön) för att upptäcka nya AI-fördomar innan de blir systemiska problem.

- Förklarbarhet: Det kan generera läsbara förklaringar för modellbeteende och förutsägelser, beroende på modelltyp och konfiguration, vilket är avgörande för revisioner och kundförfrågningar.

- Prestandamätvärden: Håller koll på viktiga prestandamätvärden som noggrannhet och svarstid, så att modellen fortsätter att uppfylla affärskraven.

AI-faktablad för livscykelspårning

AI-faktablad är en del av dokumentlivscykelhanteringen för varje modell. Faktablad spårar automatiskt viktiga detaljer i varje steg av AI-livscykeln, inklusive:

- Utvecklingsmetadata, såsom träningsdatakällor och algoritmval

- Utvärderingsresultat, såsom testmått och bedömningar av partiskhet

- Detaljer om distributionen, inklusive var modellen körs och vem som har åtkomst till den.

- Driftshistorik, såsom prestandatrender och tidigare incidenter

🔍 ClickUp Brain MAX: Snabbare testning av flera modeller före styrningsgränser

Innan en modell, prompt eller agent någonsin når IBM Watsonx Governance behöver teamen vanligtvis en plats där de kan tänka, testa och jämföra utan friktion.

Det är där ClickUp Brain MAX kommer till sin rätt .

Brain MAX är en fristående AI-app för stationära datorer som gör det möjligt för team att växla mellan flera ledande modeller (t.ex. GPT, Claude, Gemini) i samma arbetsmiljö. Du kan köra samma prompt, beslutslogik eller utkast till resultat i olika modeller parallellt, jämföra svaren direkt och spara hela resonemangskedjan tillsammans med själva arbetet.

Detta gör Brain MAX särskilt kraftfullt för:

- Jämförelse av tidiga modeller och promptar före formell utvärdering

- Stresstesta resultaten med avseende på tonfall, resonemangskvalitet eller gränsfall i olika modeller.

- Registrera och spara ”varför vi valde denna metod” direkt tillsammans med uppgifter och dokument.

När teamen enats om rätt beteende, uppmaning eller modellval blir watsonx. governance det officiella systemet. Faktablad, godkännanden och övervakning återspeglar då beslut som redan har testats, dokumenterats och godkänts.

👉 I praktiken accelererar Brain MAX inlärning och iteration, medan watsonx. governance säkerställer kontroll och ansvarsskyldighet. Tillsammans förhindrar de att styrningen bromsar innovationen – eller att innovationen kringgår styrningen.

Så här konfigurerar du watsonx. governance för ditt team

Nu ska vi steg för steg konfigurera watsonx. governance för ditt team 👇

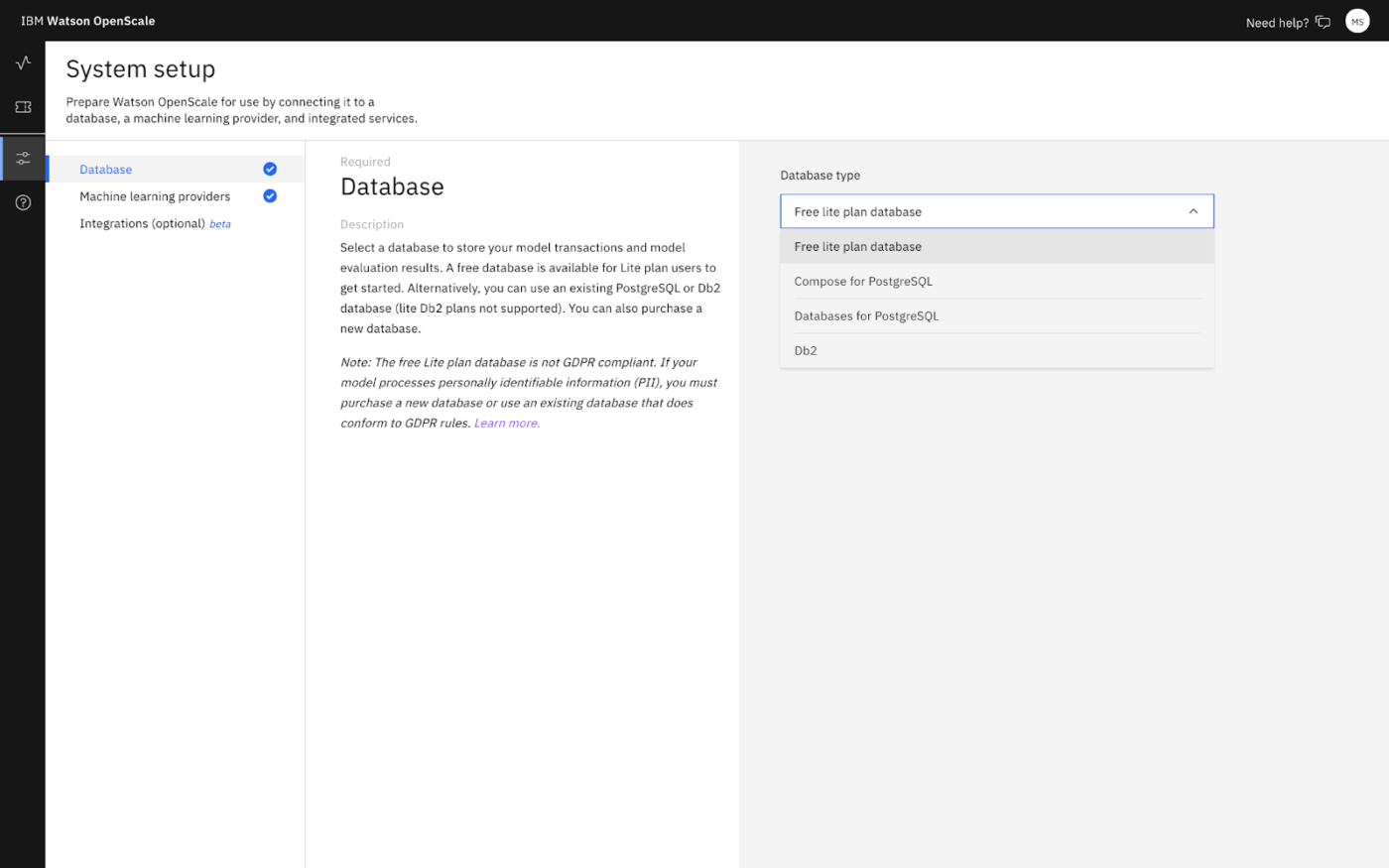

1. Anslut en databas (datamart)

Öppna watsonx. governance-URL:en för din region, gå sedan till Konfigurera → Databas och välj en databastyp (Lite eller din egen DB2/PostgreSQL).

2. Konfigurera användningsfall för AI

- Gå till Användningsfall för AI → Komplett konfiguration

- Detta skapar ett tjänste-ID: watsonx. governance_DO_NOT_DELETE

- Om du inte har en standardinventering kommer du att uppmanas att skapa en, vilket krävs för att hantera externa modeller, bilagor och styrningsrapporter.

3. Skapa åtkomstpolicyer (bjud in ditt team)

I IBM Cloud, Hantera → Åtkomst (IAM) → Användare → Bjud in användare → tilldela en åtkomstpolicy för tjänsten watsonx. governance och ange dess omfattning (konto/resursgrupp/specifik instans)

📌 Användare behöver Reader/Writer+ för åtkomst till tjänsten. Writer+ kan se information över projekt och distributionsutrymmen.

4. Hantera användare och roller i watsonx. governance

Tilldela samarbetsroller för utvärderingsrelaterade åtgärder (administratör/redaktör/visare/operatör) baserat på vad varje person ska göra.

👀 Visste du att? En enda modern säkerhetsöverträdelse kan vara stor som en fotbollsstadion! Under Armours säkerhetsöverträdelse som lades till i januari 2026 omfattar 72,7 miljoner drabbade konton.

Hur man kör AI-styrningslivscykler med ClickUp

IBM Watsonx Governance fungerar som ett styrsystem för AI, där modeller, uppmaningar, utvärderingar och godkännanden spåras formellt med struktur och spårbarhet.

Men styrningen måste fortfarande ske över avdelningsgränserna. Någon måste registrera den initiala kontexten, spåra beslut, hålla bevisningen samordnad och driva arbetet framåt utan att processen förvandlas till en labyrint av överlämningar. Massiv arbetsutbredning i praktiken!

Välkommen till ClickUp. Som världens första konvergerade AI-arbetsyta kopplar den samman det operativa lagret – dokument, uppgifter, chatt, arbetsflöden, kunskap, AI och ledarskapssynlighet – så att dina team kan genomföra styrningscykeln på ett smidigt sätt.

Låt oss se hur. 👇

Skapa och dokumentera användningsfall för AI

Användningsfall är lätta att dokumentera en gång. Det svåra är att hålla dokumentationen sammanhängande när idén testas av risk-, juridik-, säkerhets- och leveransteam.

Åtgärda det med ClickUp Docs. Använd till exempel en ClickUp Doc-mall för varje nytt AI-användningsfall så att varje projekt börjar med standardiserad input:

- Mål

- Intressenter

- Datakontext

- Förväntade resultat

- Begränsningar

- Kriterier för framgång

Dessutom kan du diskutera användningsfall och beslut i dokumentet med hjälp av @mentions och ClickUp Assigned Comments. Allteftersom granskningen fortskrider kan du omvandla nästa steg till ClickUp-uppgifter direkt från dokumentet.

Om det passar ditt arbetsflöde kan du lägga till ClickUp Brain för att påskynda de delar som vanligtvis tar lång tid. Använd det för att skärpa en sammanfattning, identifiera antaganden som behöver valideras eller utarbeta ett första utkast till styrningsöverväganden (t.ex. kontrollpunkter för rättvisa eller integritet) baserat på vad ditt team redan har skrivit.

När användningsfallet är klart formaliserar du det i IBM Watsonx Governance, så att det blir den styrande anknytningen för livscykelspårning och faktadokumentation.

I watsonx. governance skapar du ett AI-användningsfall i en inventering:

- Gå till Kataloger → Användningsfall för AI

- Klicka på Nytt AI-användningsfall

- Ange ett namn och välj en inventering

- Fyll i de fält du behöver, till exempel: Beskrivning (affärsproblem + sammanhang) Risknivå Stödjande data Ägare Status Taggar

- Beskrivning (affärsproblem + sammanhang)

- Risknivå

- Stödjande data

- Ägare

- Status

- Taggar

- Beskrivning (affärsproblem + sammanhang)

- Risknivå

- Stödjande data

- Ägare

- Status

- Taggar

Därifrån blir användningsfallet platsen där du kan se livscykelspårning (Översikt/Livscykel/Åtkomst) och koppla styrda tillgångar till deras faktablad.

Faktablad hjälper sedan till att samla in metadata om styrning och efterlevnad under hela livscykeln, inklusive syfte/kritikalitet och härkomst för åtgärder som vidtagits under utveckling och distribution.

📮 ClickUp Insight: 53 % av organisationerna har ingen AI-styrning eller endast informella riktlinjer. Och när människor inte vet vart deras data hamnar – eller om ett verktyg kan skapa en efterlevnadsrisk – tvekar de. Om ett AI-verktyg ligger utanför betrodda system eller har oklara datapraxis är rädslan för ”Tänk om det inte är säkert?” tillräcklig för att stoppa införandet.

Så är inte fallet med ClickUps helt styrda, säkra miljö. ClickUp AI uppfyller kraven i GDPR, HIPAA och SOC 2 och har ISO 42001-certifiering, vilket garanterar att dina data är privata, skyddade och hanteras på ett ansvarsfullt sätt.

Tredjepartsleverantörer av AI får inte träna på eller behålla några ClickUp-kunddata, och stöd för flera modeller fungerar under enhetliga behörigheter, sekretesskontroller och strikta säkerhetsstandarder. Här blir AI-styrning en del av själva arbetsytan, så att teamen kan använda AI med förtroende, utan extra risk.

Utvärdera AI-modeller och uppmaningar

Modellutvärdering är ett viktigt men komplext steg med många rörliga delar. Du måste köra prestandatester, kontrollera för partiskhet och testa för felmodeller, samtidigt som du håller flera intressenter informerade.

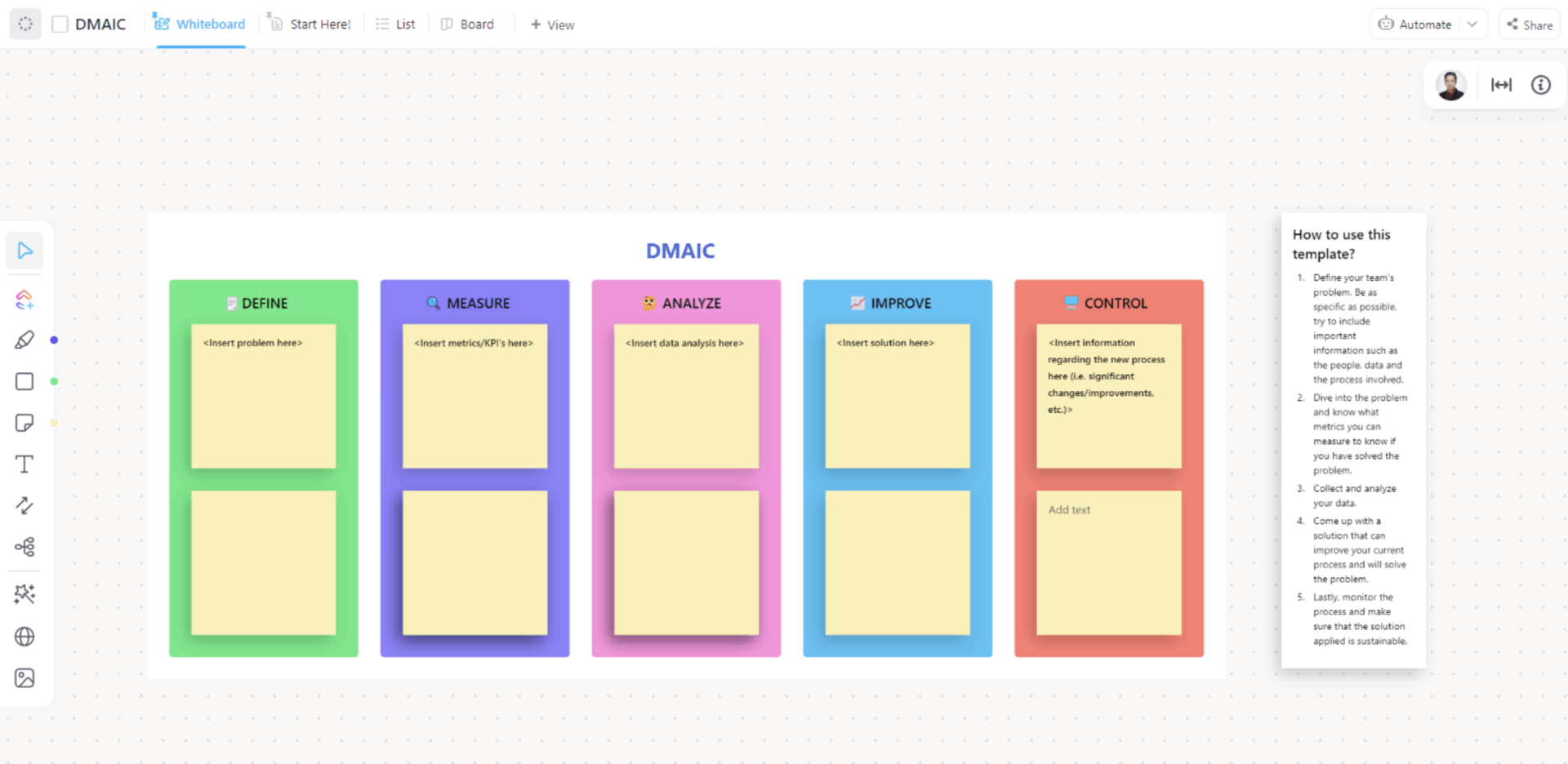

Använd ClickUp DMAIC-mallen för att skapa repeterbara arbetsflöden.

Skapa utvärderingspipelines med stegbaserade anpassade statusar med hjälp av ClickUp DMAIC-mallen

I den här mallen kan du skapa utvärderingspipelines med hjälp av ClickUp Custom Statuses. Det innebär att statusarna kan spegla dina utvärderingsstadier, till exempel Väntande utvärdering, Bias-testning, Prestationsgranskning och Redo för godkännande.

Du kan också ta bort manuella överlämningar med ClickUp Automations. När uppgiften flyttas till Bias Testing kan den automatisering du har ställt in till exempel tilldela arbetet till din efterlevnadsgranskare och lägga till en kommentar med testchecklistan och länkar.

När ditt arbetsflöde är etablerat kan du utföra den tekniska utvärderingen i watsonx:

- För promptmallar och genAI: Kör promptutvärderingar från promptmallresursen, granska mätvärden och använd utvärderingssammanfattningen för att upptäcka gränsöverskridningar.

- För externa modeller eller modeller som inte hostas av IBM: Du kan utvärdera ”fristående” promptmallar för alla typer av uppgifter som stöds, såsom sammanfattning, klassificering, frågesvar, entitetsutvinning, innehållsgenerering och RAG, med mått som varierar beroende på modell och uppgift.

Godkänn och distribuera AI-modeller

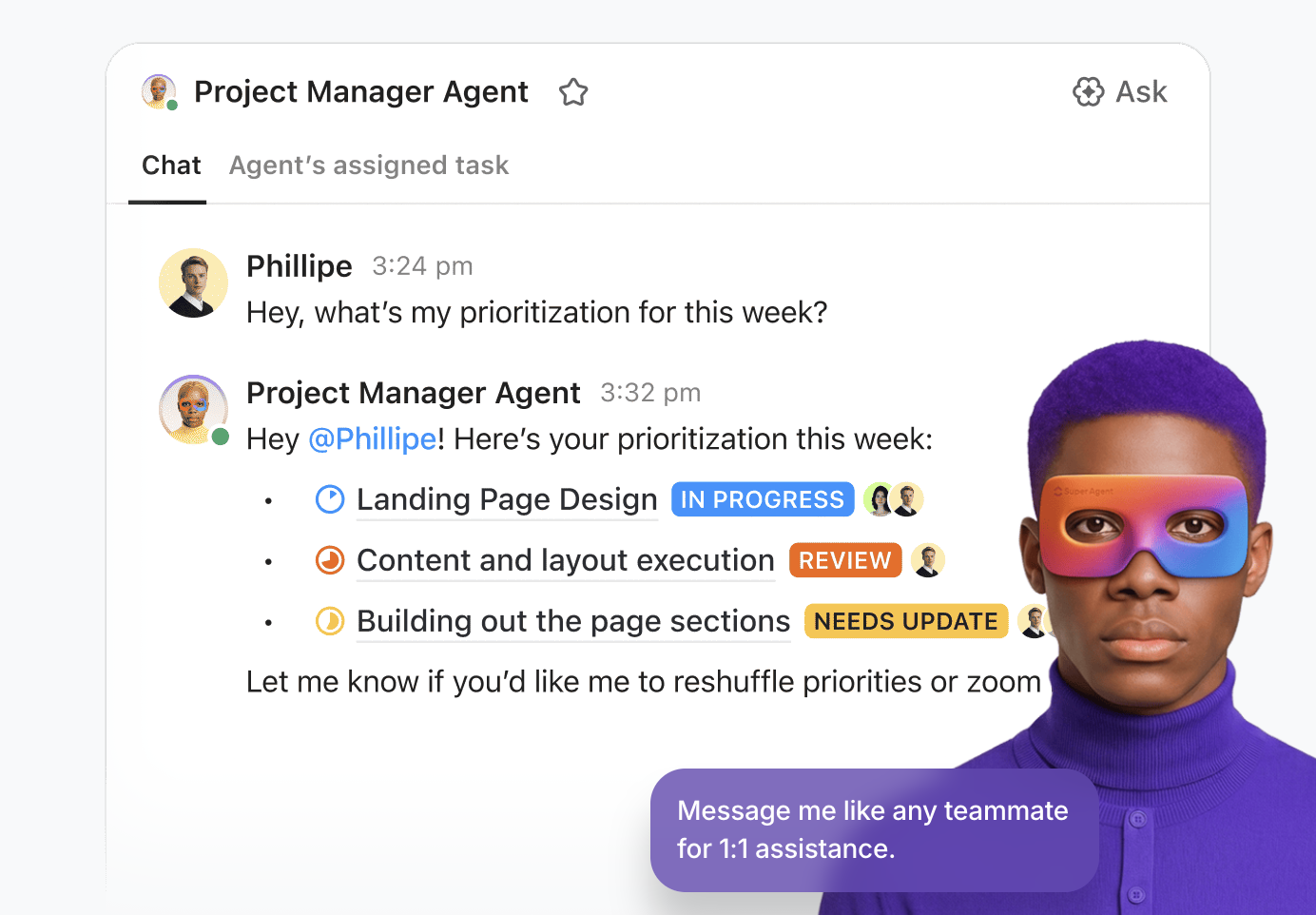

Använd ClickUp Super Agents för att hantera godkännandeprocessen från början till slut.

De är AI-drivna teammedlemmar som arbetar med fullständig Workspace-kontext och kan köra flerstegsarbetsflöden på ett säkert sätt. Dessutom kan du konfigurera hur de ska bete sig genom instruktioner, triggers, verktyg och kunskap för att säkerställa att de fungerar inom ramen för säkerhetsgränserna.

När en utvärdering avslutas kan en superagent till exempel sammanställa allt som granskarna behöver på ett ställe (till exempel det aktuella användningsfallet, beslutanteckningar och länkar till styrda bevis).

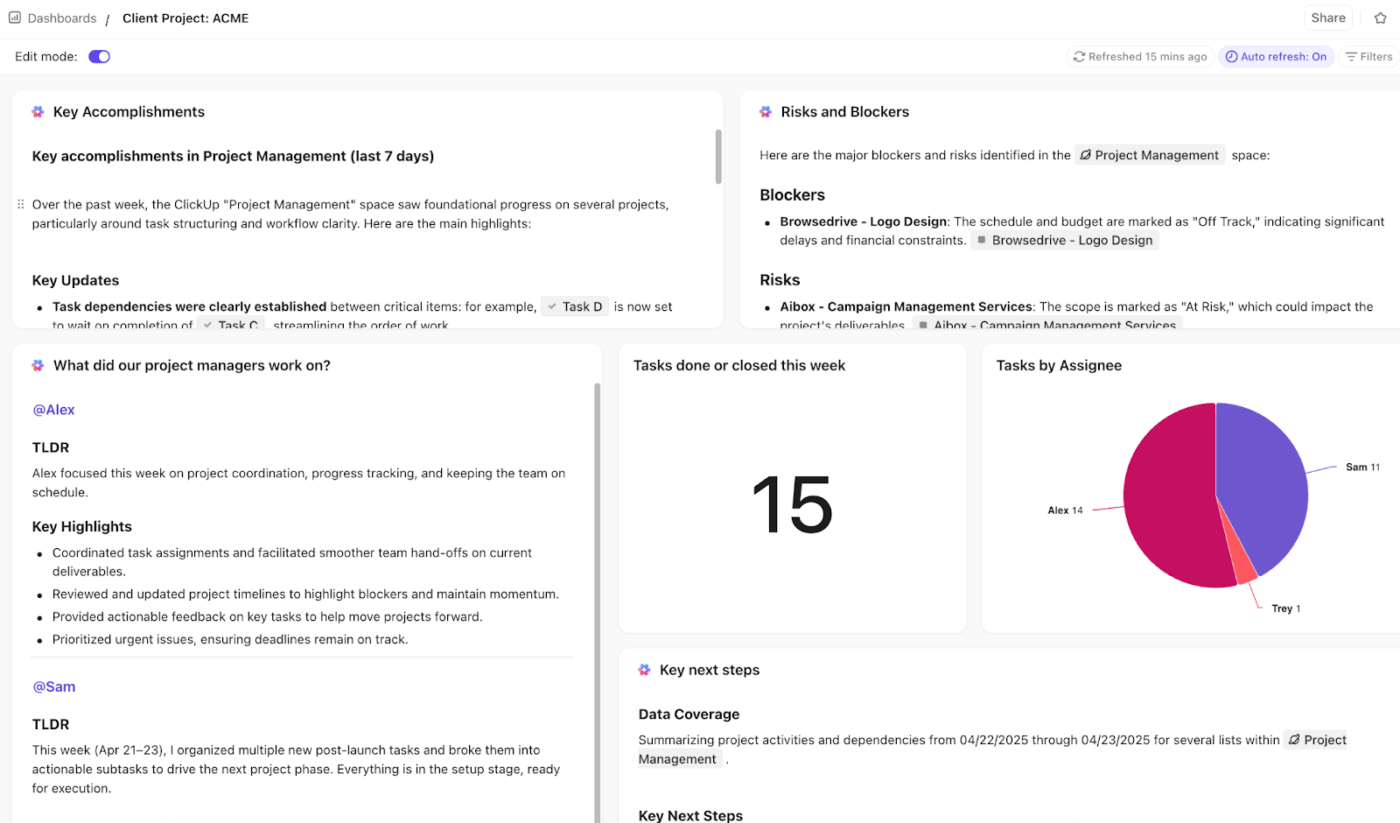

ClickUp Dashboards kan omvandla arbetsuppgiftsdata till en överskådlig bild av framstegen, så att ledningen kan se hur många modeller som väntar på granskning, vilka steg som ligger efter i schemat och vilka som håller på att föråldras.

Skapa din egen projektledningspanel på ClickUp ⬇️

Du kan sedan koppla det operativa arbetsflödet tillbaka till watsonx:

- I watsonx. governance tillhandahåller IBM ett arbetsflöde för modellens livscykel som tar en AI-modell genom flera steg och intressenter fram till godkännande för distribution. Detta för att säkerställa att det styrda registersystemet återspeglar samma grindar som ditt team använder operativt i ClickUp.

- Efter godkännandet följer övervakning. Watson OpenScale kan konfigureras med övervakningsfunktioner som utvärderar distribuerade tillgångar mot tröskelvärden som du anger (till exempel tröskelvärden för rättvisa eller noggrannhet/avvikelse).

🚀 Fördel med ClickUp: Skapa en ledningsdashboard och lägg till ClickUp AI-kort som sammanfattar vad som hindrar godkännanden (t.ex. ”Vad väntar på juridisk granskning?” eller ”Vilka modeller har varit under granskning längst?”).

Begränsningar vid användning av Watsonx för AI-styrning och skalbarhet

Inget verktyg är en mirakelkur, och det är viktigt att förstå en plattforms begränsningar innan du bestämmer dig.

Här är några saker att tänka på med watsonx. governance 👀

| Begränsning | Effekt |

| IBM-ekosystemets lutning | Även om det stöder tredjepartsmodeller är den djupaste integrationen med IBM:s egna verktyg. Team som har investerat mycket i andra molnplattformar kan stöta på problem. |

| Komplexitet för mindre team | Plattformen är byggd för verksamhet i företagsstorlek. Mindre team kan uppleva att omkostnaderna och komplexiteten är större än vad de behöver. |

| OpenPages inlärningskurva | Riskhanteringsmodulen var ursprungligen utformad för finanssektorn, så dess koncept och gränssnitt kanske inte känns intuitiva för AI-inriktade team. |

| Anpassningsbegränsningar | De fördefinierade mallarna för efterlevnad är en bra utgångspunkt, men de kanske inte passar perfekt för ditt företags unika eller nischade regelverksbehov. |

| Generativ AI-styrning är fortfarande under utveckling | Verktygen för styrning av stora språkmodeller (LLM) utvecklas snabbt inom branschen, och styrningsfunktionerna fortsätter att mognas parallellt med nya bästa praxis. |

Andra alternativa verktyg att använda

Om IBM Watsonx Governance inte känns som rätt lösning finns det några alternativ, beroende på om du vill ha en molnbaserad styrningsstack eller ett molnoberoende övervakningslager.

- Amazon SageMaker Model Monitor + Amazon SageMaker Model Cards: Ett bra alternativ om du redan har investerat i AWS. Model Monitor fokuserar på produktionsövervakning (t.ex. upptäcka kvalitetsproblem som avvikelser/anomalier och varna dig), medan Model Cards hjälper dig att dokumentera modelldetaljer för revisioner och styrningsrapportering på ett standardiserat sätt.

- Azure Machine Learning Responsible AI: Bäst när dina arbetsflöden redan finns i Azure och du vill ha ett inbyggt sätt att utvärdera modeller för rättvisa, felanalys och förklarbarhet (plus ”vad händer om”-analys/kontrafaktisk analys) i ett enda gränssnitt.

- Google Vertex AI Model Monitoring: Googles motsvarighet för team som använder GCP. Den är inriktad på att köra övervakningsjobb enligt schema eller på begäran, spåra signaler om modell-/datakvalitet (som avvikelser/skevhet) och varna när tröskelvärden överskrids.

- Fiddler AI + Arthur AI: Bra när du vill ha ett leverantörsneutralt observationslager över modeller – väljs ofta för djupare förklarbarhet, snabbare analys av grundorsaker och övervakning av konsistens mellan team och miljöer.

- MLflow: Bäst för team som vill ha öppen källkods flexibilitet. MLflow ger dig en stark grund (spårning + modellregister med metadata/taggar och livscykelstadier), men du behöver vanligtvis tekniska insatser för att lägga till policygenomförande, granskningar/godkännanden och styrningsarbetsflöden på ett sätt som passar din organisation.

Gör AI-styrning konkret med ClickUp

En plattform som IBM Watsonx Governance kan ge dig den tekniska grunden för riskkontroll och efterlevnad, men styrning fungerar bara när teamen bakom den är samordnade och ansvariga.

ClickUp kopplar samman det här genomförande-lagret. Dokument standardiserar policyer och modellregister. Dashboards synliggör granskningar och flaskhalsar. Och AI-agenter ser till att godkännanden och överlämningar fortsätter att fungera, så att styrningen förblir operativ snarare än teoretisk.

Det viktigaste är att detta förvandlar AI-styrning från en periodisk granskningsövning till ett levande system. Ett system där beslut dokumenteras, åtgärder spåras och ansvaret är tydligt i varje steg av livscykeln.

Kom igång gratis med ClickUp och kör din styrningsprocess med tydlighet från början till slut. ✅

Vanliga frågor

Allmän AI-styrning avser de övergripande principer och policyer som en organisation antar, medan watsonx. governance är en specifik mjukvaruplattform som hjälper dig att implementera och automatisera dessa rutiner.

Ja, plattformen kan övervaka och styra modeller som distribueras på andra moln som AWS SageMaker och Azure ML, även om integrationen kan kräva mer manuell konfiguration än med IBM-inbyggda modeller.

Effektiv styrning är ett lagarbete som vanligtvis involverar dataforskare, ML-ingenjörer, efterlevnadsansvariga, riskhanterare, affärsintressenter och IT-säkerhet för att täcka hela livscykeln.