Integritet är en grundläggande mänsklig rättighet. Och den integriteten genomsyrar också alla aspekter av dagens artificiella intelligens. I en rapport från Cisco uppger 64 % av människor att de oroar sig för att de av misstag kan dela känslig information när de använder AI-verktyg.

Det är en av anledningarna till att offline-AI-verktyg blir allt populärare. När modellen körs lokalt kan du skriva, koda, sammanfatta och skapa – utan att behöva ladda upp allt till molnet eller fastna när Wi-Fi-anslutningen bryts.

I denna lista presenterar vi de bästa AI-verktygen som fungerar offline, däribland en superapp som hjälper dig att organisera det som dessa verktyg producerar i ett sammanhängande, supersäkert system.

Vad är offline-AI-verktyg?

Offline-AI-verktyg är programvaruapplikationer som kör stora språkmodeller (LLM) på din lokala enhet, utan att någon internetanslutning behövs efter att du har laddat ner modellen. Modellens data lagras direkt på din dator, så all bearbetning, eller inferens, sker på din egen CPU eller GPU.

Denna bearbetning på enheten har flera viktiga fördelar:

- Fullständig dataintegritet: Din känsliga information lämnar aldrig din dator.

- Inga återkommande avgifter: När du väl har verktyget och modellen finns det inga prenumerationskostnader.

- Fungerar överallt: Du kan använda den på ett flygplan, i en avlägsen stuga eller när internet är nere.

- Full kontroll: Du väljer vilka modeller du vill använda och hur du vill konfigurera dem.

De bästa offline-AI-verktygen i korthet

Här är en kort sammanfattning av de bästa offline-AI-verktygen som finns tillgängliga idag.

| Verktygets namn | Viktiga funktioner | Bäst för | Prissättning* |

| ClickUp | Offline-läge för uppgifter och påminnelser, ClickUp Brain MAX som inkluderar Talk-to-Text, Enterprise Search över anslutna appar, Docs och Knowledge Management, automatiseringar samt integrationer och API. | Team som behöver offline-insamling samt online-utförande, styrning och AI-kontext i ett arbetsutrymme | Gratis för alltid; Anpassning tillgänglig för företag |

| GPT4All | Lokal chatt med öppna modeller, LocalDocs för privata dokumentfrågor, upptäckt och nedladdning av modeller i appen, OpenAI-kompatibel lokal API-server | Sekretessmedvetna användare som vill ha en enkel offline-chattbot för datorer med lokala dokument. | Gratis plan tillgänglig; Betalda planer börjar på 40 $/användare/månad |

| LM Studio | Modellupptäckt och nedladdningar, chattgränssnitt plus lokal RAG, OpenAI-kompatibel server eller REST API, förinställningar och prestandajustering | Utvecklare och avancerade användare som vill ha en polerad offline-modellarbetsbänk | Gratis |

| Ollama | En kommandomodell, lokal REST API med streaming, modellfiler för återanvändbara konfigurationer och inbäddningar för RAG-pipelines | Utvecklare som vill ha en CLI-först lokal runtime med ett starkt API-lager | Gratis plan tillgänglig; Betalda planer börjar på 20 $/månad |

| Jan. ai | Offline-gränssnitt i ChatGPT-stil, assistenter och MCP-stöd, tillägg för extra funktioner och valfria OpenAI-kompatibla leverantörer. | Icke-tekniska användare som vill ha en ren offlineassistent med anpassningsmöjligheter | Gratis och öppen källkod |

| Llamafile | Enkel körbar modellpaketering, portabel distribution över olika operativsystem, lokalt serverläge med webbgränssnitt och API, minimalt beroende av runtime. | Användare som vill ha en portabel AI-fil utan installation som de kan köra var som helst. | Gratis och öppen källkod |

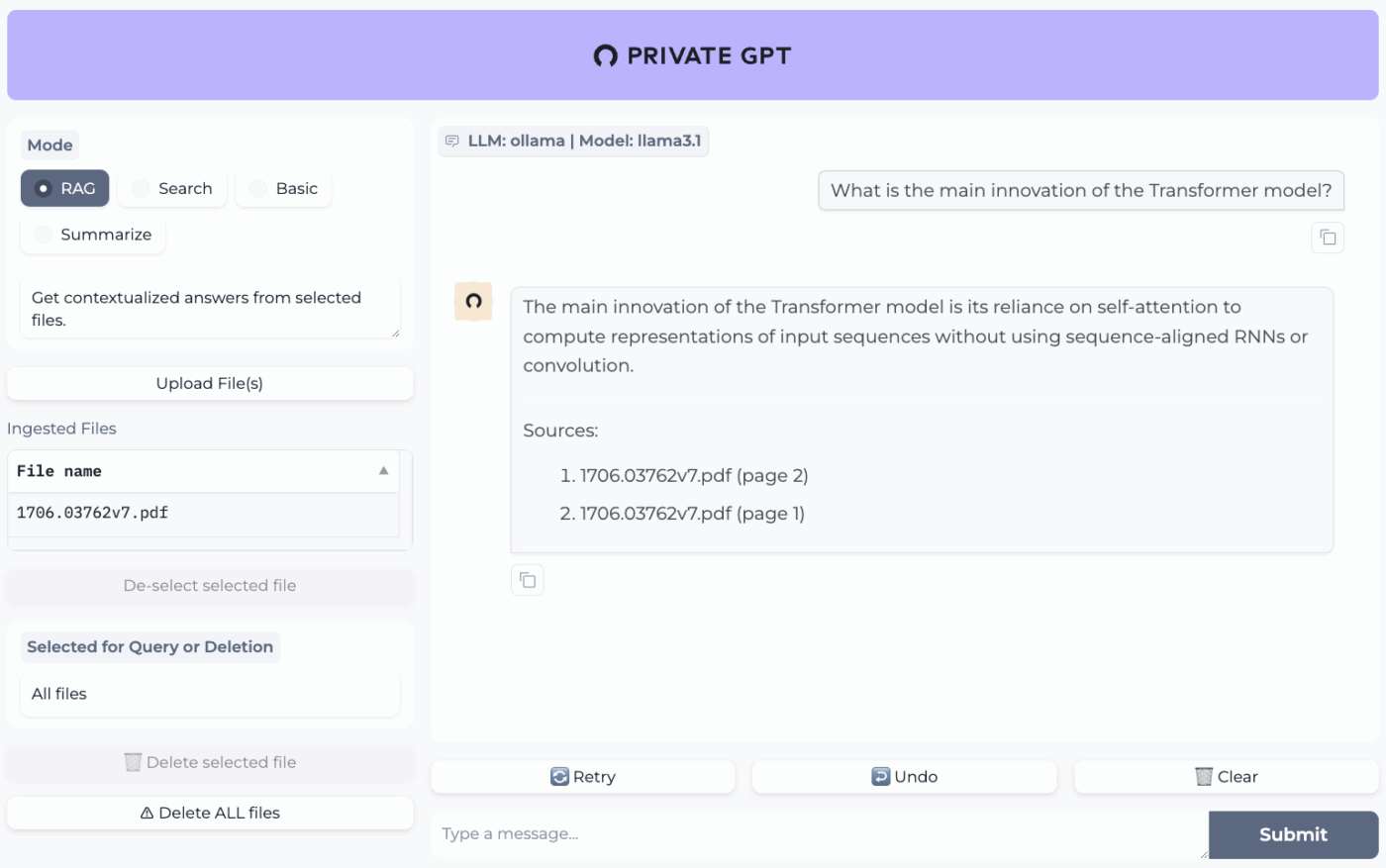

| PrivateGPT | Självhostad dokumentinläsning och indexering, offline RAG Q&A, kontextfiltrering efter dokument, modulär LLM och vektorlagringsstack | Team som behöver offline-frågor och svar om interna filer med en kontrollerbar RAG-pipeline | Gratis och öppen källkod |

| Whisper.cpp | Lokal tal-till-text, kvantiserade modeller för lägre resursanvändning, VAD-stöd, valfri FFmpeg-hantering för fler format | Användare som behöver en helt offline-transkription som de kan bädda in i appar | Gratis och öppen källkod |

| Textgenerering Web UI | Webbläsarbaserad användargränssnitt för lokala modeller, Jinja2-promptmallar, genereringskontroller, chattförgreningar och meddelanderedigering | Användare som vill ha maximal anpassning i ett lokalt webbgränssnitt | Gratis och öppen källkod |

| llama.cpp | Högpresterande inferensmotor, bred kvantiseringstöd, lokal server med OpenAI-liknande slutpunkter, inbäddningar och omrankningstöd | Utvecklare som bygger anpassade offline-AI-appar eller backend-system | Gratis och öppen källkod |

Hur vi granskar programvara på ClickUp

Vår redaktion följer en transparent, forskningsbaserad och leverantörsneutral process, så du kan lita på att våra rekommendationer baseras på produktens verkliga värde.

Här är en detaljerad beskrivning av hur vi granskar programvara på ClickUp.

Vad man ska leta efter i de bästa AI-verktygen som fungerar offline

Att utvärdera offline-AI-verktyg kan kännas tekniskt och förvirrande, vilket kan leda till att du väljer ett verktyg som kanske inte ens fungerar på din dator. Det viktigaste att tänka på är vad du vill uppnå. En utvecklare som bygger en AI-driven app har helt andra behov än någon som bara vill ha en privat, offline AI-chattbot som skrivhjälp.

Här är de viktigaste kriterierna att utvärdera:

- Enkel installation: Krävs det tekniska kunskaper och kommandoradsarbete, eller är det en enkel installation med ett enda klick?

- Modellval: Kan du enkelt välja mellan ett brett utbud av modeller, eller är du begränsad till endast några få?

- Sekretessgarantier: Bearbetar verktyget all data lokalt, eller finns det dolda molnkomponenter?

- Hårdvarukrav: Kommer det att fungera bra på din nuvarande dator, eller behöver du uppgradera?

- Integrationsmöjligheter: Kan den anslutas till dina andra verktyg, eller är det en helt fristående applikation?

- Användningsfall: Är den utformad för allmän chatt, frågor om dina dokument, transkribering av ljud eller generering av kod?

De 10 bästa AI-verktygen som fungerar offline

Här är en översikt över de bästa offlineverktygen för AI 👇

1. ClickUp (Bäst för att samla uppgifter, dokument och AI-kontext på ett ställe för både offline- och onlinearbete)

ClickUp, världens första konvergerade AI-arbetsyta, bygger på ”offline-AI” som inte nöjer sig med att generera ett svar. Det beror på att du fortfarande behöver en plats där resultatet blir ett beslut, en uppgift och ett nästa steg som inte försvinner i filer och chattar.

Och till skillnad från många offline-installationer som kräver långa installationer och verktygssömnad, ger ClickUp dig ett komplett exekveringslager på ett ställe, med AI som arbetar ovanpå samma arbetsytakontext.

Till att börja med har du ClickUp Offline Mode, som automatiskt aktiveras och håller arbetet igång när du är offline. Det innebär att alla dina uppgifter, påminnelser och anteckningar förblir tillgängliga när du är offline, med möjlighet att lägga till fler om det behövs. När du ansluter igen synkroniseras nya uppgifter och påminnelser automatiskt tillbaka till din arbetsyta (säg adjö till förlorad kontext 👋).

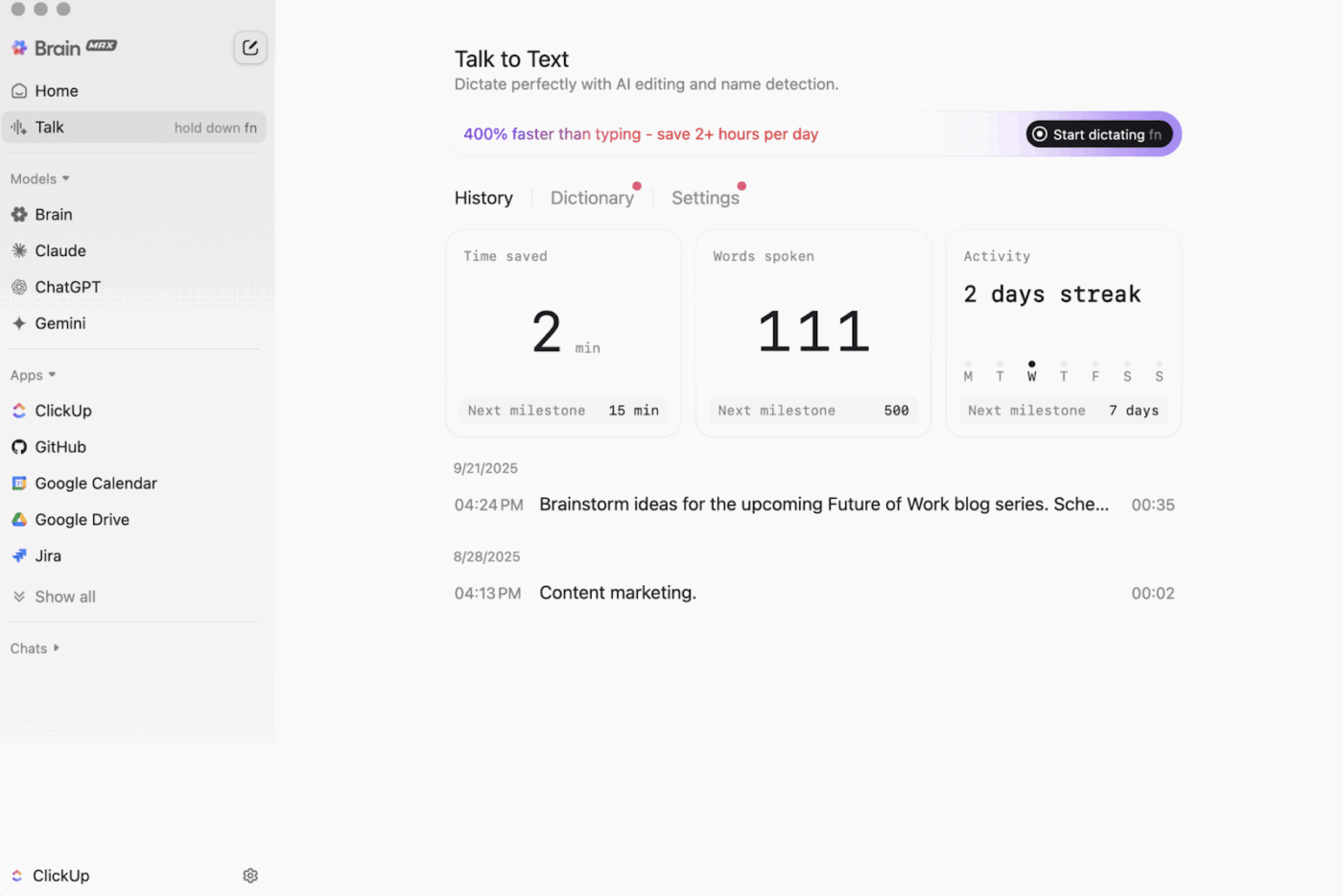

Sedan finns ClickUp Brain MAX , den integritetsfokuserade AI-kompanjonen för datorer, som kan lagra och söka igenom hela ditt arbetsområde, anslutna appar och till och med webben.

Med Talk-to-Text i mixen kan Brain MAX omvandla din röst till text utan att du behöver använda händerna. Det inkluderar att skriva ett utkast till ett e-postmeddelande, skriva ett dokument eller göra en snabb uppdatering när du är på språng.

Brain MAX ger dig också Universal AI, som är utvecklat för att chatta med de senaste AI-modellerna för kodning, skrivande, komplexa resonemang och mycket mer. Det innebär att du kan ställa frågor till de bästa AI-modellerna på ett och samma ställe, inklusive ClickUp Brain plus alternativ som OpenAI, Claude och Gemini, utan att behöva växla mellan olika verktyg.

Dessutom lägger ClickUp Security till säkerhetsfunktioner som offlineverktyg ofta saknar. Tänk på kryptering, detaljerade behörigheter och administratörskontroller som SSO, provisionering och granskningsloggar, allt utformat för team som behöver säkerhet i företagsklass.

ClickUp AI Knowledge Management är till stor hjälp vid övergången från offline till online. Det ger ditt team en central plats att lagra olika resurser i dokument och wikis, och använder sedan ClickUp Brain för att hämta omedelbara svar från hela ditt arbetsområde, så att rätt sammanhang finns tillgängligt när arbetet återupptas.

🎬 Agenter i aktion: Använd Super Agents för att omvandla synkroniserat arbete till nästa steg!

ClickUp Super Agents är AI-drivna teammedlemmar som du kan skapa och anpassa för att köra flerstegsarbetsflöden i ditt ClickUp-arbetsområde. Du kan konfigurera specifika utlösare, instruktioner och verktygsåtkomst för att säkerställa att de agerar inom de gränser du har ställt in.

Efter att offlineuppgifter har synkroniserats kan en Super Agent till exempel skanna de nya objekten, sammanfatta vad som har ändrats, ta fram åtgärdssteg, utarbeta en uppdatering och vidarebefordra den till rätt ägare för granskning.

Och eftersom Super Agents är styrbara kan du kontrollera vad de har åtkomst till med behörigheter och granska vad de gör. 🔐

ClickUps bästa funktioner

- Hitta vad som helst i dina verktyg: Sortera och sök igenom hela ditt arbetsområde, plus anslutna appar, från ett och samma ställe med ClickUp Enterprise Search.

- Bygg upp en verklig kunskapsbas: Skapa wikis och dokumentation med ClickUp Docs med hjälp av kapslade sidor, mallar, AI-assistans och mycket mer.

- Håll din stack ansluten: Synkronisera arbetet med verktyg som Slack och GitHub utan att lämna ClickUp med ClickUp Integrations.

- Skapa anpassade arbetsflöden: Använd ClickUp API med personliga tokens eller OAuth 2. 0 för att driva skräddarsydda automatiseringar och integrationer.

- Automatisera din stack: Utlös åtgärder som att tilldela ägare, uppdatera status eller starta överlämningar baserat på uppgiftsändringar med ClickUp Automations.

Begränsningar för ClickUp

- På grund av det stora utbudet av funktioner kan vissa användare behöva lära sig hur man använder programmet.

ClickUp-priser

ClickUp-betyg och recensioner

- G2: 4,7/5 (över 10 000 recensioner)

- Capterra: 4,6/5 (över 4 000 recensioner)

Vad säger verkliga användare om ClickUp?

En G2-recensent säger:

Agila tavlor, integrationer och anpassningsmöjligheter. Jag gillar också att jag kan koppla bort mig från internet och ändå fortsätta arbeta med mina uppgifter. Dessutom kan jag skicka e-post till valfri lista och få uppgifter skapade automatiskt. Textredigeraren är fantastisk, den fungerar både i MD-läge och med kortkommandon, så att du kan förhandsgranska innehållet direkt.

Agila tavlor, integrationer och anpassning. Jag gillar också att jag kan gå offline och ändå fortsätta arbeta med mina uppgifter. Dessutom kan jag skicka e-post till valfri lista och få uppgifter skapade automatiskt. Textredigeraren är fantastisk, den fungerar både i MD-läge och med kortkommandon, så att du kan förhandsgranska innehållet direkt.

2. GPT4All (Bäst för privat, offline AI-chatt med lokala LLM:er)

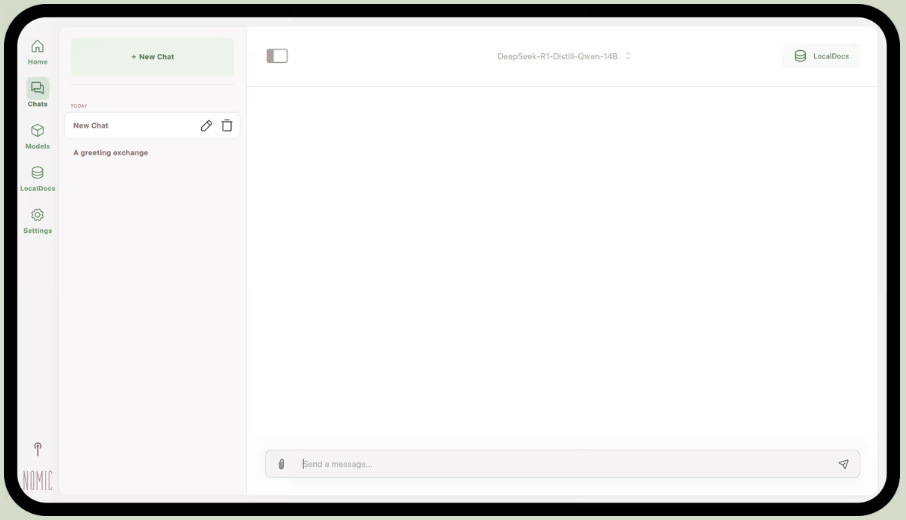

GPT4All är en del av Nomic.ai och är en desktop-app som låter dig köra öppna källkodsbaserade stora språkmodeller direkt på din dator, så att du kan chatta med en AI-assistent utan att behöva internetuppkoppling eller moln-API-anrop. Den är utvecklad för personer som vill ha en "local-first"-konfiguration, där frågor, svar och filer stannar på enheten.

Den bästa funktionen är LocalDocs, som använder en form av återvinningsförstärkt generering för att låta dig chatta privat med dina egna dokument. Du kan peka appen mot en mapp med PDF-filer eller textfiler, och den skapar en lokal kunskapsbas som du kan ställa frågor till.

GPT4All innehåller också ett kuraterat bibliotek med populära modeller som Llama och Mistral, som du kan ladda ner direkt via appen.

GPT4All bästa funktioner

- Starta en lokal API-server (OpenAI-kompatibel) för att använda GPT4All-modeller i andra appar och automatiseringar.

- Sök, jämför och ladda ner GGUF-modeller från appen, med sorteringsalternativ som gillanden, nedladdningar och uppladdningsdatum.

- Justera kontextlängd, maximal utgångslängd, top-p, top-k, upprepningsstraff, CPU-trådar och till och med GPU-lageravlastning (plus Metal-stöd på Apple Silicon)

GPT4All-begränsningar

- Prestandan är i hög grad beroende av datorns hårdvara.

- Indexering av stora dokumentsamlingar kan vara långsam

Priser för GPT4All

- Gratis skrivbordsapp

- Företag: 40 dollar per användare och månad (Nomic AI)

- Företag: Anpassad prissättning (Nomic AI)

GPT4All betyg och recensioner

- G2: Inte tillräckligt med recensioner

- Capterra: Inte tillräckligt med recensioner

Vad säger verkliga användare om GPT4All?

En Reddit-användare säger:

Det här är det bästa jag har provat med RAG, slår allt annat, till och med LM Studio, när det gäller enkelhet. Jag gillar sättet man mappar det till en mapp, och att det spårar och hanterar ändringarna åt en. Det är fortfarande i ett tidigt skede, precis som resten, men det här kommer att bli mitt standardval på kort sikt.

Det här är det bästa jag har provat med RAG, det slår allt annat, till och med LM Studio, när det gäller enkelhet. Jag gillar sättet man mappar det till en mapp, och att det spårar och hanterar ändringarna åt en. Det är fortfarande i ett tidigt skede, precis som resten, men det här kommer att bli mitt standardval på kort sikt.

📮 ClickUp Insight: 88 % av våra undersökningsdeltagare använder AI för sina personliga uppgifter, men över 50 % drar sig för att använda det på jobbet. De tre största hindren? Brist på smidig integration, kunskapsluckor eller säkerhetsproblem. Men vad händer om AI är inbyggt i din arbetsmiljö och redan är säkert? ClickUp Brain,

ClickUps inbyggda AI-assistent gör detta möjligt. Den förstår kommandon i klarspråk och löser alla tre problem som kan uppstå vid införandet av AI, samtidigt som den kopplar samman din chatt, dina uppgifter, dokument och kunskap över hela arbetsytan. Hitta svar och insikter med ett enda klick!

3. LM Studio (Bäst för en polerad offline-modellarbetsbänk med prestandajustering)

via LM Studio

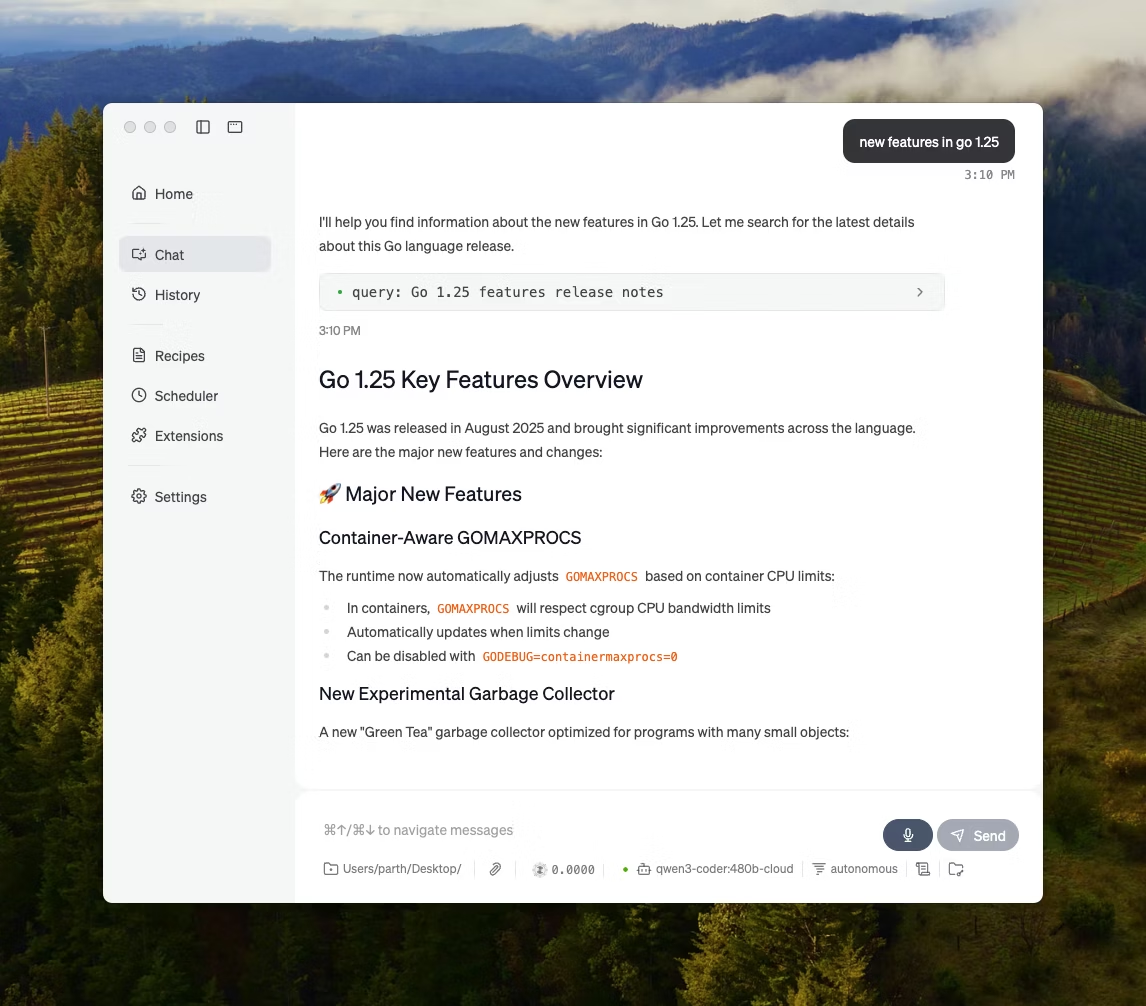

LM Studio är en lokal AI-datorprogram som är utvecklad för att hitta, testa och köra öppen källkodsmodeller i ett användargränssnitt, utan att behöva använda en terminal. Den är inriktad på experimentering, som att välja en modell, köra den lokalt och iterera på uppmaningar och inställningar med en snävare återkopplingsloop än de flesta CLI-först-konfigurationer.

Det stöder även chatt med dokument helt offline (lokal RAG), där du bifogar filer till en konversation och refererar till dem i dina svar. Det gör det idealiskt för offline-forskning, studienoter eller interna dokumentflöden där uppladdningar inte är ett alternativ.

LM Studio ger dig också detaljerad kontroll över hur AI:n fungerar, med alternativ för att justera temperatur, kontextlängd och GPU-användning.

LM Studios bästa funktioner

- Använd OpenAI-kompatibilitetsläge eller LM Studios egen REST API, beroende på vad din app förväntar sig.

- LM Studio erbjuder både JavaScript- och Python SDK-alternativ för att bygga lokala arbetsflöden ovanpå dina modeller.

- Spara en systemprompt + parametrar som en förinställning och återanvänd den sedan i olika chattar (förinställningar kan också importeras från en fil/URL och publiceras för delning via LM Studio Hub).

Begränsningar för LM Studio

- LM Studio kan frysa datorn när DeepSeek R1 32B körs.

- Vissa användare flaggar appen som ett problem för datasäkerhet och integritet på grund av oreviderad sluten källkod.

LM Studios priser

- Gratis för hemmabruk och arbetsbruk

LM Studio betyg och recensioner

- G2: Inte tillräckligt med recensioner

- Capterra: Inte tillräckligt med recensioner

Vad säger verkliga användare om LM Studio?

En Reddit-användare säger:

Det är fantastiskt. Det fungerar helt enkelt, superenkelt att komma igång. Har den snyggaste användargränssnittet av alla konkurrenter.

Det är fantastiskt. Det fungerar helt enkelt, superenkelt att komma igång. Har den snyggaste användargränssnittet av alla konkurrenter.

4. Ollama (Bäst för att köra lokala LLM:er med ett enkelt CLI + lokal server)

Ollama är en lokal modellkörare som fungerar mer som en LLM-runtime än en fristående chattapp. Den är terminalbaserad och utformad för att hämta och köra öppna modeller med snabba kommandon (som ollama run llama3) och sedan exponera dem via en lokal tjänst som andra gränssnitt kan byggas på.

Ollamas styrka ligger i dess REST API. När Ollama körs i bakgrunden kan alla applikationer kommunicera med den via enkla HTTP-förfrågningar. Detta hjälper dig att bygga in AI-funktioner i din egen programvara.

Ollama erbjuder också ett bibliotek med populära modeller som kan laddas ner med ett enda kommando, och du kan skapa anpassade modellkonfigurationer, som liknar Dockerfiles för AI.

Ollamas bästa funktioner

- Skapa återanvändbara, versionerbara modellrecept (val av basmodell, promptmallar, systemmeddelanden, parametrar, adaptrar) med hjälp av en Modelfile.

- Kör modeller genom slutpunkter som chatt/generera med valfri strömning för realtidsutmatning av token i appar och skript.

- Skapa inbäddningar för semantisk sökning och återhämtningspipelines med hjälp av Ollamas inbäddningsfunktion och rekommenderade inbäddningsmodeller.

Ollamas begränsningar

- Det har inget inbyggt grafiskt gränssnitt, så icke-tekniska användare behöver ett separat frontend-verktyg.

- Ollamas macOS-skrivbordsapp kan sluta svara när du är offline, även om modellerna redan har laddats ner, medan CLI fortsätter att fungera.

Ollama-prissättning

- Gratis

- Fördel: 20 dollar/månad

- Max: 100 dollar/månad

Ollama betyg och recensioner

- G2: Inte tillräckligt med recensioner

- Capterra: Inte tillräckligt med recensioner

Vad säger verkliga användare om Ollama?

En recensent på Producthunt säger:

Enkel att implementera och hantera. Ollama gör det så enkelt att köra lokala LLM:er. Kombinera den med OpenWebUI för den ultimata upplevelsen.

Enkel att implementera och hantera. Ollama gör det så enkelt att köra lokala LLM:er. Kombinera den med OpenWebUI för den ultimata upplevelsen.

🧠 Rolig fakta: Tal-till-text började som "endast siffror". Bell Labs AUDREY (1952) kände igen siffrorna 0–9, och enligt en källa fungerade det bäst när det var uppfinnaren själv som talade.

5. Jan. ai (Bäst för en offline-assistent i ChatGPT-stil som prioriterar integritet)

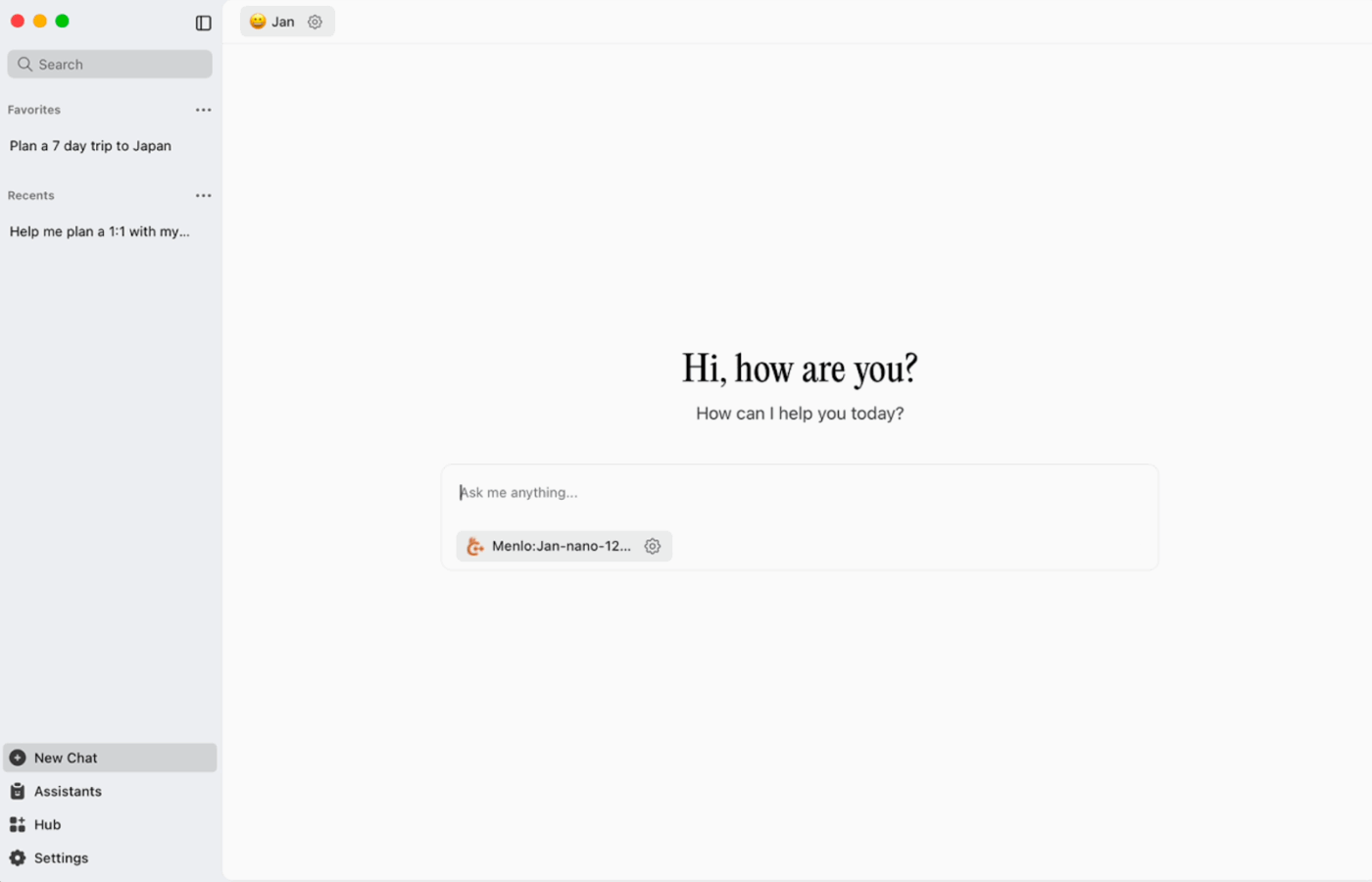

Jan. ai är en öppen källkodsbaserad skrivbordsassistent som ger en ChatGPT-liknande chattupplevelse till macOS, Windows och Linux, med lokal användning som standard. Den körs på enheten när du vill, medan konversationshistorik och användningsdata lagras lokalt och inte lämnar din dator.

Den stöder körning av öppen källkodsmodeller lokalt och möjliggör även valfria anslutningar till fjärrleverantörer som OpenAI-kompatibla API:er, vilket gör den flexibel när offlineanvändning är prioriterad, men molntillgång ibland behövs.

Jan. ai bästa funktioner

- Skapa assistenter med egna instruktioner och inställningar, och växla sedan mellan dem från fliken Assistenter istället för att skriva om uppmaningar varje gång.

- Anslut Jan till MCP-verktyg och datakällor med hjälp av en öppen standard som är utvecklad för arbetsflöden där verktyg används.

- Installera tillägg för att lägga till nya funktioner som webbsökning eller en kodtolkar. Denna modulära metod gör att du kan börja enkelt och lägga till mer kraft efterhand.

Jan. ai-begränsningar

- Jan kan tillåta att en modellfil som ännu inte har laddats ner helt laddas, vilket kan skapa förvirrande eller inkonsekvent beteende tills filen är komplett.

- Att aktivera API:et kan störa trådade chattar, och grundläggande slutpunkter som "hämta laddad modell" eller "byta modell" kanske inte fungerar smidigt.

Jan. ai-prissättning

- Öppen källkod

Januari ai betyg och recensioner

- G2: Inte tillräckligt med recensioner

- Capterra: Inte tillräckligt med recensioner

Vad säger verkliga användare om Jan. ai?

En Reddit-användare säger:

Jan. ai är min favoritapp för LLM. Den är fantastisk.

Jan. ai är min favoritapp för LLM. Den är fantastisk.

6. Llamafile (Bäst för att packa en LLM i en bärbar körbar fil)

Llamafile är ett Mozilla-lett projekt som samlar en komplett öppen källkods-LLM i en enda körbar fil. Istället för att installera en runtime, hantera beroenden eller koppla ihop en separat användargränssnitt, laddar du ner en fil och kör den som en app.

Kärnidén är distribution. En ”llamafile” innehåller modellvikterna plus en kompilerad runtime, byggd för att köras på flera operativsystem med minimal installation. Det är särskilt praktiskt när ett offlineverktyg behöver delas med teammedlemmar, studenter eller kunder som inte kan felsöka installationer.

Llamafiles bästa funktioner

- Llamafile kombinerar llama.cpp med Cosmopolitan Libc för att stödja bred binär portabilitet, vilket minskar plattformsspecifikt paketeringsarbete.

- Serverläget tillhandahåller ett webbgränssnitt samt en OpenAI API-kompatibel slutpunkt för kompletteringar, vilket är användbart för lokal apputveckling och byte av molnanrop under testning.

- Paketerade llamafiles är utformade för att köras på vanliga x86_64- och ARM64-maskiner, vilket förenklar distributionen över blandade maskinparker.

Begränsningar för Llamafile

- Modellvalet är begränsat till det som har paketerats som en Llamafile.

- Filstorlekarna är mycket stora eftersom hela modellen är inbäddad.

Llamafile-priser

- Gratis och öppen källkod

Llamafile betyg och recensioner

- G2: Inte tillräckligt med recensioner

- Capterra: Inte tillräckligt med recensioner

🧠 Rolig fakta: Den första webbplatsen kan fortfarande besökas. CERN är värd för den på info.cern.ch och kallar den för ”den första webbplatsens hem”.

7. PrivateGPT (Bäst för offlinefrågor och svar om dina filer med en självhostad RAG-stack)

PrivateGPT är ett produktionsklart, självhostat projekt som skapats för arbetsflöden av typen ”chatta med dina dokument”. Det läser in lokala filer, indexerar dem och svarar på frågor genom att hämta relevant kontext från ditt eget innehåll istället för att förlita sig på en molnchattbots minne. Projektet är utformat för att köras helt offline, med kravet att data stannar inom din exekveringsmiljö.

Det som skiljer den från vanliga offlinechattappar är den modulära arkitekturen. Med andra ord kan du kombinera LLM, inbäddningsleverantör och vektorlagring utifrån din hårdvara och dina sekretessbegränsningar, och sedan köra allt bakom en lokal API + UI.

PrivateGPT:s bästa funktioner

- Importera PDF-filer, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, bilder (JPG/PNG/JPEG) och till och med MP3/MP4 med den inbyggda importpipeline.

- Lagerkonfigurationsprofiler med PGPT_PROFILES (till exempel local,cuda) för att slå samman flera inställningsfiler och byta distributioner utan att skriva om din baskonfiguration.

- Filtrera svar till en specifik delmängd av inlästa dokument med hjälp av context_filter när du anropar slutpunkter för kontextuella kompletteringar.

Begränsningar för PrivateGPT

- Har högre hårdvarukrav på grund av att flera komponenter körs samtidigt.

- Inläsning av flera dokument från en enda fil (till exempel en PDF-fil som genererar ett dokument per sida) kan öka indexeringsvolymen och komplexiteten vid hantering av stora uppladdningar.

Priser för PrivateGPT

- Öppen källkod

PrivateGPT-betyg och recensioner

- G2: Inte tillräckligt med recensioner

- Capterra: Inte tillräckligt med recensioner

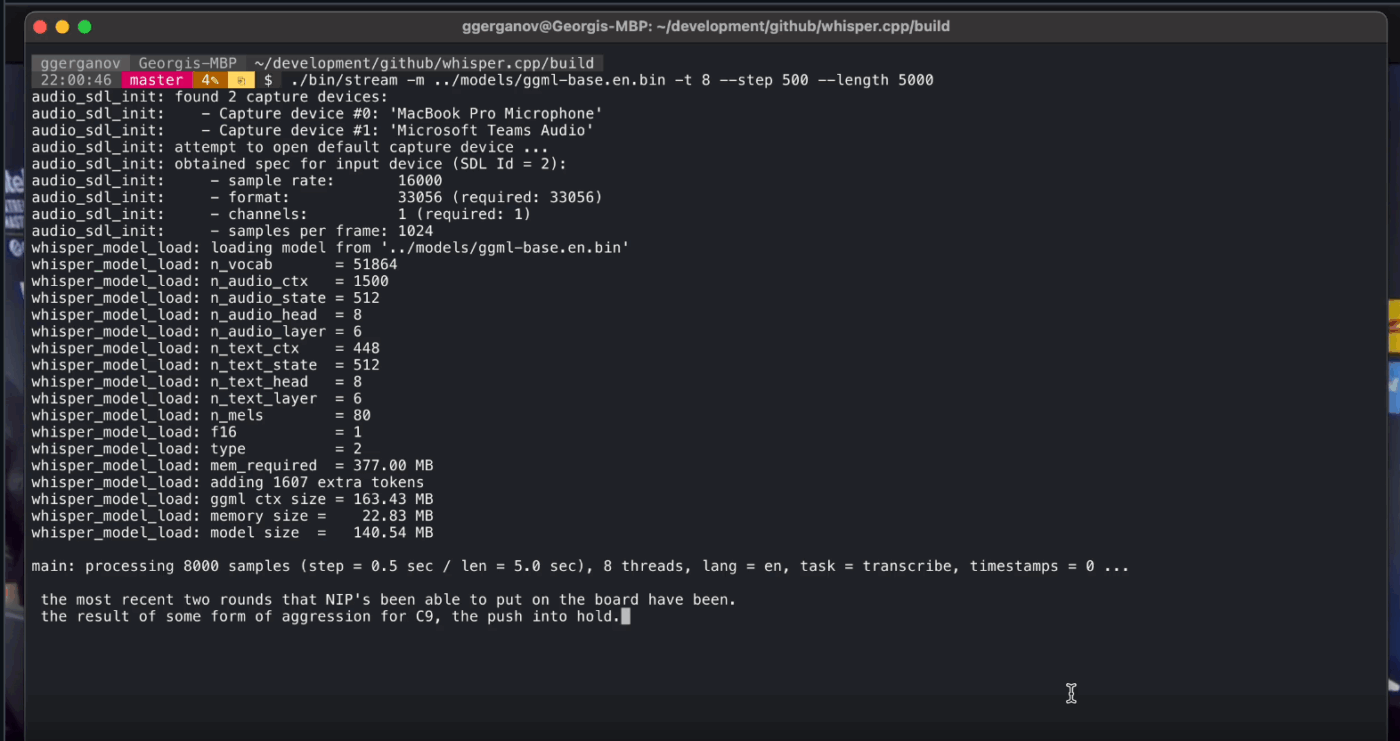

8. Whisper. cpp (Bäst för helt offline tal-till-text som du kan bädda in i appar)

Whisper.cpp är en högpresterande C/C++-implementering av OpenAI:s automatiska taligenkänningsmodell Whisper, utvecklad för att köras lokalt utan tunga runtime-beroenden. Den är populär för offline-transkriptionspipelines där man vill ha en liten, portabel binärfil eller ett C-bibliotek som man kan leverera tillsammans med sin egen produkt.

Det är också flexibelt i olika miljöer, med officiellt stöd för stationära datorer, mobila enheter, WebAssembly, Docker och till och med hårdvara av Raspberry Pi-klass, vilket gör det lämpligt för offlineverktyg som behöver köras på mer än en plats.

"Cpp" i namnet står för dess fokus på prestanda. Denna implementering är betydligt snabbare och använder mindre minne än Python-baserade alternativ, vilket gör realtidstranskription möjlig på moderna datorer utan behov av en kraftfull GPU.

Whisper. cpp bästa funktioner

- Kör röstaktivitetsdetektering (VAD) som en del av projektet för att segmentera tal och minska bullriga, tomma ljudtranskriptioner i strömmande arbetsflöden.

- Kvantisera Whisper-modeller för att minska disk- och minneskraven, med flera kvantiseringsalternativ utformade för snabbare lokal inferens.

- Bygg med valfritt FFmpeg-stöd på Linux för att hantera fler inmatningsformat än bara det grundläggande WAV-formatet.

Whisper. cpp-begränsningar

- Whisper. cpp:s CLI förväntar sig som standard 16-bitars WAV-inmatningar, vilket innebär ett extra konverteringssteg när man arbetar med MP3, MP4, M4A eller andra vanliga format.

- Det märker inte talare (diarisering) på ett naturligt sätt, vilket gör det svårt att korrekt tillskriva citat i inspelningar med flera talare.

Whisper. cpp prissättning

- Öppen källkod

Whisper. cpp betyg och recensioner

- G2: Inte tillräckligt med recensioner

- Capterra: Inte tillräckligt med recensioner

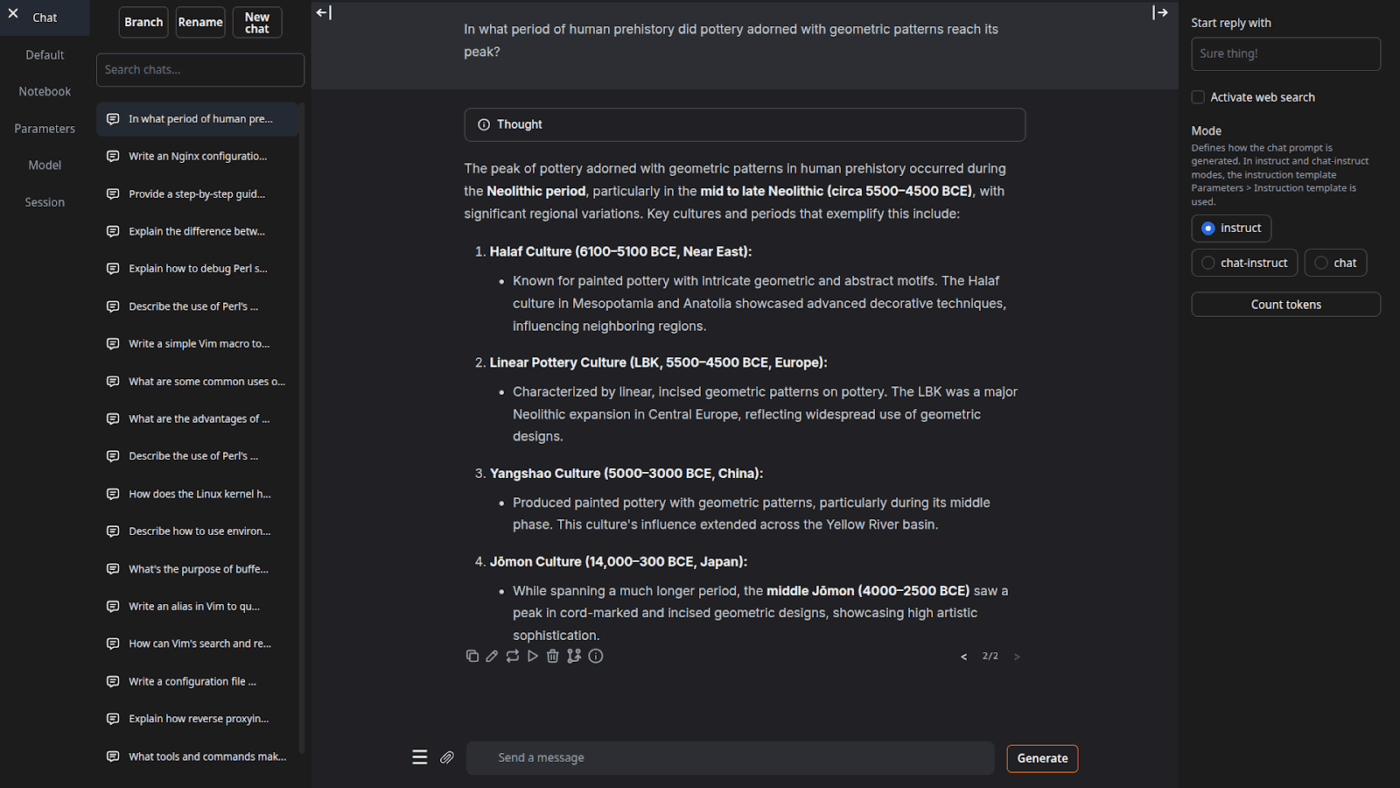

9. Text Generation Web UI (Bäst för användare som vill ha en webbläsarbaserad cockpit för lokala LLM:er)

Text Generation Web UI (ofta kallat ”oobabooga”) är ett Gradio-baserat webbgränssnitt för att köra lokala modeller med stort fokus på kontroll och experimentering. Det fungerar mer som en komplett arbetsbänk: flera modellbackends, flera interaktionslägen och många reglage för genereringsbeteende.

Det lutar också åt "writer/dev"-arbetsflöden som många offlineverktyg hoppar över, med funktioner som automatisering av promptformat, generering i anteckningsboksstil och konversationsförgrening. För offlineinstallationer som fortfarande behöver ett webbgränssnitt är det ett av de mest konfigurerbara frontend-verktygen i denna kategori.

Textgenerering Web UI bästa funktioner

- Automatisk formatering av promptar med hjälp av Jinja2-mallar, vilket minskar formateringsfel i promptar mellan olika modellfamiljer.

- Justera dussintals inställningar för att finjustera AI:ns resultat efter dina specifika behov, oavsett om det gäller kreativt skrivande, kodning eller rollspel.

- Meddelanderedigering med versionsnavigering och konversationsförgrening, vilket gör det möjligt att behålla flera riktningar i samma chatt utan att behöva börja om från början.

Begränsningar för textgenerering i webbgränssnittet

- Installationsprogrammet kräver cirka 10 GB diskutrymme och laddar ner PyTorch, vilket gör installationen tung för datorer med begränsat lagringsutrymme.

- Den OpenAI-kompatibla inbäddningsändpunkten använder sentence-transformers/all-mpnet-base-v2 med 768-dimensionella inbäddningar, vilket kan bryta antaganden i pipelines som är byggda kring OpenAI:s 1536-dimensionella standardvärden.

Priser för Text Generation Web UI

- Öppen källkod

Textgenerering Web UI-betyg och recensioner

- G2: Inte tillräckligt med recensioner

- Capterra: Inte tillräckligt med recensioner

10. Llama. cpp (Bäst för högpresterande lokal LLM-inferens över CPU och GPU)

Llama. cpp är en C/C++-inferensmotor och verktygskedja för att köra LLM lokalt med minimala beroenden och stark prestanda på en rad olika hårdvaror. Det är mindre en "chattapp" och mer en lokal runtime där du bygger arbetsflöden, oavsett om det är en CLI, en lokal HTTP-server eller ett inbäddat bibliotek i din egen produkt.

Llama.cpp är inte en slutanvändarapplikation i sig, men är den motor som driver många av verktygen på denna lista, inklusive GPT4All och LM Studio. Den introducerade GGUF-modellformatet, som har blivit standard för att köra stora modeller på konsumenthårdvara genom att effektivt minska deras storlek.

Det erbjuder också bindningar för populära programmeringsspråk som Python och Rust, och dess serverläge kan tillhandahålla ett OpenAI-kompatibelt API.

Llama. cpp bästa funktioner

- Starta en OpenAI API-kompatibel lokal server med ett inbyggt webbgränssnitt och en /v1/chat/completions-slutpunkt med hjälp av llama-server.

- Kör en inbäddningsmodell (och till och med en omrankingsmodell) från samma server för offline-RAG-pipelines med hjälp av /embedding och /reranking.

- Kvantisera modeller till 1,5-bitars till 8-bitars för att minska minnesanvändningen och påskynda lokal inferens, och accelerera sedan körningar med CUDA/Metal plus Vulkan/SYCL-backends när sådana finns tillgängliga.

Llama. cpp-begränsningar

- Llama. cpp levereras inte som en färdig desktop-assistent, vilket innebär att offlineanvändning ofta innebär CLI-kommandon eller hosting av llama-server, och många användare förlitar sig på tredjepartsgränssnitt för daglig chattning.

- Llama. cpp:s OpenAI-kompatibilitet är inte alltid 1:1 med alla OpenAI-klientfunktioner, och användare rapporterar om avvikelser kring strukturerade utdataparametrar som response_format i /v1/chat/completions.

Llama. cpp prissättning

- Öppen källkod

Vad säger verkliga användare om Llama.cpp?

En recensent på Sourceforge säger:

Fantastiskt. Demokratisering av AI för alla. Och det fungerar utmärkt!

Fantastiskt. Demokratisering av AI för alla. Och det fungerar utmärkt!

Förvandla offline-AI-resultat till verkligt arbete med ClickUp

Att välja rätt offline-AI-verktyg handlar egentligen om att matcha verktyget till uppgiften.

Om du är här är det troligtvis för att du vill optimera tre saker: integritet, ingen internetberoende och frihet från att vara bunden till ännu ett abonnemang.

Verktygen på denna lista uppfyller dessa krav på olika sätt. Det innebär att vissa är bättre för skrivande och kodning, medan andra är bättre för sökning, anteckningar eller kreativt arbete.

Men för team är den största utmaningen inte bara att köra AI lokalt. Det är att omvandla AI-resultat till verkliga arbetsflöden.

Med ClickUps AI-funktioner integrerade i dina uppgifter, dokument och kunskaper kan du enkelt se nästa steg på samma plats där arbetet utförs (allt med säkerhet i företagsklass).

Prova ClickUp gratis och se hur det ser ut när AI och genomförande äntligen samverkar. ✨

Vanliga frågor om offline-AI-verktyg

Ja, efter en initial nedladdning av modellfilerna kan många AI-verktyg köras helt på din enhet utan att internet behövs. Detta gör dem perfekta för hantering av känslig data eller arbete på platser med dålig uppkoppling.

Lokala LLM-system bearbetar all data på din personliga enhet, så din information lämnar aldrig din maskin, medan molnbaserad AI skickar dina kommandon till fjärrservrar för bearbetning. Lokala verktyg är i allmänhet gratis att använda efter installationen, medan molnbaserad AI ofta innebär abonnemangsavgifter men kan erbjuda mer kraftfulla modeller.

Mindre modeller med 1–3 miljarder parametrar kan köras på de flesta moderna bärbara datorer med 8 GB RAM-minne. Större, mer kapabla modeller med 7 miljarder eller fler parametrar fungerar bäst med 16 GB eller mer RAM-minne och ett dedikerat grafikkort, där Apple Silicon Mac-datorer och NVIDIA-grafikkort ger betydande prestandaförbättringar.

![De 10 bästa AI-verktygen som fungerar offline under [år]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)