Sökmotorer har alltid varit viktiga för att hitta information, men användarnas beteende har förändrats. Istället för enkla sökningar på nyckelord som ”smartphones” ställer människor nu mer specifika, personliga frågor som ”bästa budgetmobiler för gaming”.

Samtidigt förändrar stora språkmodeller (LLM) som ChatGPT sökningen genom att fungera som intelligenta frågesvarssystem.

Genom att integreras med traditionella sökmotorer förbättrar de informationshämtningen genom RAG (retrieval-augmented generation), vilket gör resultaten mer precisa och kontextmedvetna.

I stället för att konkurrera med varandra samarbetar LLM och sökmotorer för att hantera komplexa sökningar på ett mer effektivt sätt. I den här artikeln undersöker vi hur denna integration formar framtidens sökning.

⏰ 60-sekunders sammanfattning

- Traditionella sökmotorer har ofta svårt att hantera stora datamängder, upprätthålla datakvaliteten och bryta ner silos.

- De står också inför utmaningar när det gäller säkerhet, skalbarhet och att tillhandahålla kontextuellt relevanta resultat.

- Stora språkmodeller, som ChatGPT, ökar sökprecisionen, möjliggör semantisk sökning och stöder sökningar med naturligt språk.

- LLM förbättrar också multimodala sökfunktioner och gör kunskapsupptäckten mer personlig och effektiv.

- ClickUps funktioner för ansluten sökning och AI bygger vidare på dessa framsteg genom att centralisera dina data, vilket möjliggör snabb och korrekt informationshämtning.

- ClickUp integreras sömlöst med olika plattformar, ger tillgång till ditt innehåll i realtid, effektiviserar arbetsflöden och förbättrar den totala produktiviteten.

Utan vidare, låt oss dyka rätt in!

Vad är LLM?

Stora språkmodeller (LLM) är avancerade artificiella intelligenssystem som bearbetar och genererar mänskligt språk. De tränas på omfattande textdatauppsättningar, vilket gör dem kapabla att hantera uppgifter som översättning, sammanfattning och konversationer.

Några av de mest populära exemplen på LLM är GPT-3 och GPT-4, som är allmänt erkända för sin förmåga att hantera komplexa språkrelaterade frågor.

Till skillnad från traditionella sökmotorer som är beroende av nyckelord går en LLM-baserad sökmotor längre än ytliga sökningar. Den förstår sammanhanget och avsikten bakom frågorna och ger direkta och detaljerade svar.

👀 Visste du att? 71 % av användarna föredrar personalisering från de varumärken och företag de väljer.

Funktioner hos LLM-sökmotorer

LLM-sökmotorer erbjuder avancerade funktioner som omdefinierar hur internetanvändare får tillgång till och interagerar med information. Låt oss undersöka deras viktigaste funktioner:

- Semantisk förståelse av sökfrågor: LLM-sökmotorer tolkar innebörden bakom sökfrågor och går bortom nyckelord för att förstå användarens avsikt och sammanhang.

- Naturlig språkbehandling (NLP): Användare kan formulera frågor på ett konversationsliknande sätt utan att behöva använda exakta nyckelord, vilket gör sökningarna mer intuitiva.

- Kontextuell relevans: Sökresultaten anpassas utifrån tidigare sökningar och interaktioner, vilket garanterar mer relevant och aktuell information.

- Svarsgenerering: Dessa system ger omfattande svar direkt i sökresultaten, inklusive sammanfattningar, förklaringar och till och med kreativa format som berättelser eller steg-för-steg-guider.

- Integration av kunskapsgrafer: LLM-sökmotorer använder kunskapsgrafer för att koppla samman relaterade begrepp och enheter, vilket ger djupare insikter.

- Konversationssökning: Användare kan delta i en dialog, ställa följdfrågor och förfina sina sökningar för en mer interaktiv upplevelse.

- Anpassningsbara resultat: Resultaten anpassas dynamiskt utifrån plats, intressen och tidigare sökningar, vilket ger en mer personlig upplevelse.

- Informationssyntes: Istället för att förlita sig på en enda källa samlar LLM-sökmotorer data från flera källor, vilket ger ett bredare perspektiv.

👀 Visste du att? Med den ökande användningen av smarta högtalare och röstassistenter är nu 50 % av alla sökningar röstbaserade. När stora språkmodeller integreras i dessa system kommer röstsökningar att bli ännu mer exakta och ge snabbare tillgång till information på flera plattformar – oavsett om det gäller filer, uppgifter eller mötesanteckningar.

Avancerade söktekniker med LLM

I takt med att söktekniken utvecklas förändrar LLM-modeller som GPT-4, BERT och T5 hur sökmotorer bearbetar sökfrågor, anpassar resultaten och förfinar rankningen. Låt oss utforska hur dessa modeller omdefinierar framtiden för sökning.

Hur LLM skickar sökfrågor

Sökningen har utvecklats från enkla sökningar på nyckelord till semantiska vektorsökningar. Istället för att söka efter ett specifikt begrepp som ”Mount Fuji” kan användarna söka efter ”berg i Japan”, och systemet hämtar resultat baserade på betydelsen.

Genom att omformulera sökfrågor till frågor – till exempel ”Vilka är de mest kända bergen i Japan?” – kan sökresultaten bli mer precisa. Stora språkmodeller (LLM) förbättrar också sökresultaten genom att trigga ytterligare sökfrågor om säkerheten är låg, med hjälp av tekniker som FLARE.

Kedjetänkande förbättrar sökningarna ytterligare genom att dela upp uppgifterna i logiska steg, som i AutoGPT. Dessutom gör konversationssökning det möjligt för LLM-drivna assistenter att förfina sökfrågor i realtid, vilket garanterar mer precisa resultat under hela interaktionen.

Personlig sökning och kontextmedvetenhet

Kontextuell medvetenhet är en av LLM:s mest kraftfulla funktioner. Till skillnad från traditionella sökmotorer, som rangordnar resultaten efter nyckelordsmatchningar, tar LLM hänsyn till användarens avsikt, plats, sökhistorik och tidigare interaktioner.

Genom att finjustera med domänspecifika data anpassar LLM:er sökresultaten för att känna igen mönster och prioritera relevant innehåll. Till exempel kommer en användare som ofta söker efter veganska recept att se växtbaserade alternativ när hen söker efter ”bästa middagsrecept”.

LLM tolkar också multimodala sökfrågor och förstår både text och bilder för mer exakta resultat. Dessutom bygger de upp ett longitudinellt sammanhang och lär sig av pågående interaktioner för att proaktivt föreslå relevanta sökfrågor.

LLM i omrankning och förbättring av sökmotorresultat

LLM förbättrar sökmotorer genom att dynamiskt omrangordna resultaten för att bättre återspegla användarens avsikt. Till skillnad från traditionell nyckelordsbaserad rangordning använder LLM uppmärksamhetsmekanismer för att analysera hela sammanhanget för en sökfråga och prioritera relevant innehåll.

Googles BERT-uppdatering (Bidirectional Encoder Representations from Transformers) revolutionerade till exempel sökningen genom att förstå sammanhanget bakom ord som ”apple” (frukt) kontra ”Apple” (teknikföretag).

LLM bidrar också till förbättrad SERP-effektivitet (Search Engine Results Page). Genom att analysera faktorer som klickfrekvens (CTR), avvisningsfrekvens och vistelsetid kan LLM justera rankningen i realtid och förbättra resultaten som ger hög användarengagemang.

📖 Läs också: Hur man snabbt söker i PDF-filer

Populära LLM-sökmotorverktyg

I takt med att AI-driven sökning utvecklas vinner flera stora språkmodellsökmotorer mark tack vare sina avancerade funktioner. Perplexity AI ger direkta svar med citerade källor, vilket gör sökningarna mer interaktiva och informativa.

You. com erbjuder en anpassningsbar upplevelse som gör det möjligt för användare att prioritera källor, integrera AI-genererade sammanfattningar och interagera med AI-assistenter.

Vi vet alla att vi kan använda dessa sökmotorer för att hämta information och få snabba svar. Men hur är det med att hitta den där viktiga filen på jobbet? Eller att ta fram en konversation full av datapunkter till din nästa stora presentation?

Det är här ClickUp, appen för allt som rör arbete, kommer in i bilden!

📮 ClickUp Insight: 46 % av kunskapsarbetare förlitar sig på en blandning av chatt, anteckningar, projektledningsverktyg och teamdokumentation bara för att hålla reda på sitt arbete. För dem är arbetet utspritt över olika plattformar, vilket gör det svårare att hålla ordning. Som den ultimata appen för arbete samlar ClickUp allt på ett ställe. Med funktioner som ClickUp Email Project Management, ClickUp Notes, ClickUp Chat och ClickUp Brain samlas allt ditt arbete på ett ställe, där det är sökbart och smidigt sammankopplat. Säg adjö till överbelastning av verktyg – välkomna enkel produktivitet.

ClickUp Brain kombinerar avancerade sökfunktioner med omfattande projektledningsfunktioner och kopplar samman uppgifter, filer, teammedlemmar och projekt på ett och samma ställe. Nu behöver du inte längre växla mellan appar eller hantera fragmenterade verktyg och informationssilos!

Kostnaderna för ineffektivitet på grund av isolerade verktyg är enorma:

- 2,5 timmar/dag: Kunskapsarbetare lägger cirka 30 % av sin arbetsdag på att söka efter information.

- 3 600 appväxlingar per dag: Anställda växlar mellan appar och fönster över 3 600 gånger per dag, vilket innebär att de förlorar 4 timmar per vecka på att omorientera sig.

- 23 minuter förlorade: Varje byte av app stör koncentrationen, och det tar nästan 23 minuter att komma tillbaka på rätt spår.

420 000 dollar per år: Organisationer med 100 anställda förlorar detta belopp varje år på grund av missförstånd och isolerade verktyg.

Dessa ineffektiviteter leder till förlorad tid, försämrad arbetsmoral och ökade driftskostnader. Lyckligtvis förvandlar Connected AI dessa utmaningar till möjligheter för smartare beslutsfattande, snabbare informationshämtning och smidig genomförande.

Så här förändrar ClickUps Connected Search samarbetet:

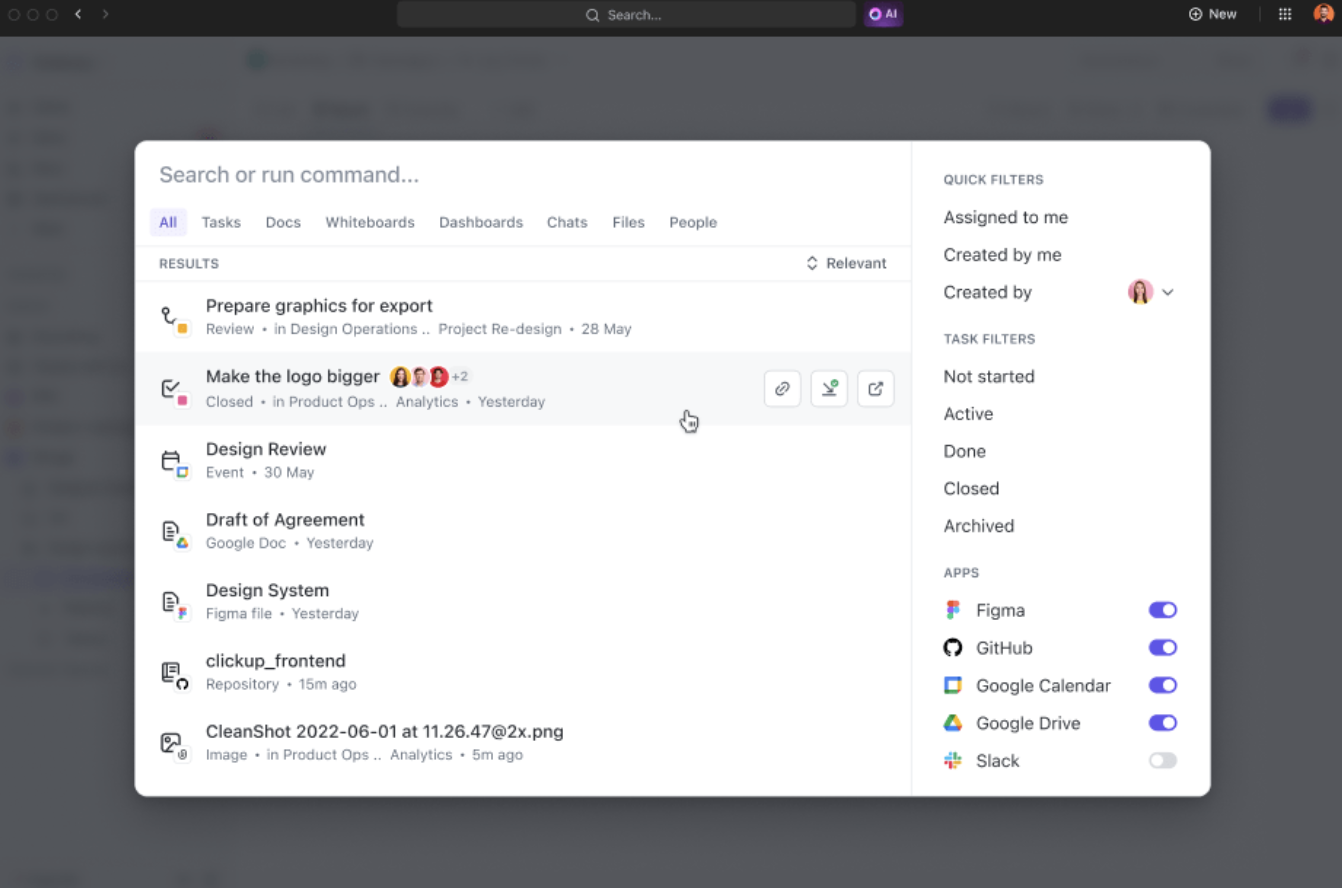

- Enhetlig sökning: Få tillgång till all din företagsinformation från en enda plattform och spara nästan fyra timmar per vecka genom att minska behovet av att växla mellan olika appar.

- AI-driven relevans: Få personliga, kontextmedvetna sökresultat som är skräddarsydda för dina projekt, vilket förbättrar beslutsfattandet med omedelbar tillgång till de mest relevanta insikterna.

- Enkel verktygsintegration: Anslut smidigt till befintliga verktyg som Google Drive, SharePoint, Figma och Slack utan behov av komplexa inställningar.

När du till exempel återvänder från ledighet kan du helt enkelt be ClickUp Brain om uppdateringar om dina projekt. Det kommer att ge dig överskådliga punktlistor med viktiga åtgärder och diskussioner som ägt rum medan du var borta.

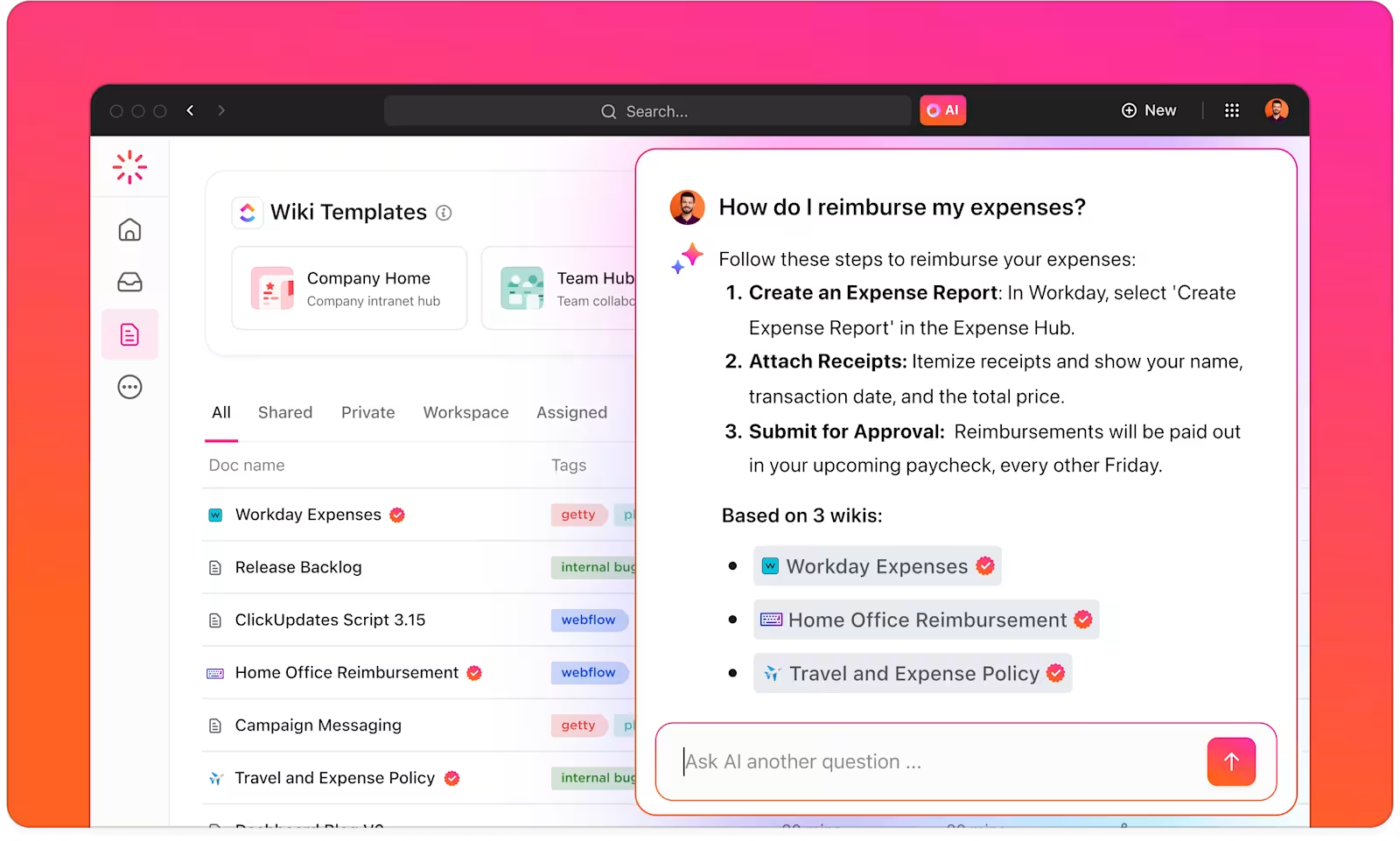

Med ClickUp Brain får du en intelligent kunskapshanterare som hjälper dig att hitta allt inom din arbetsyta och anslutna appar.

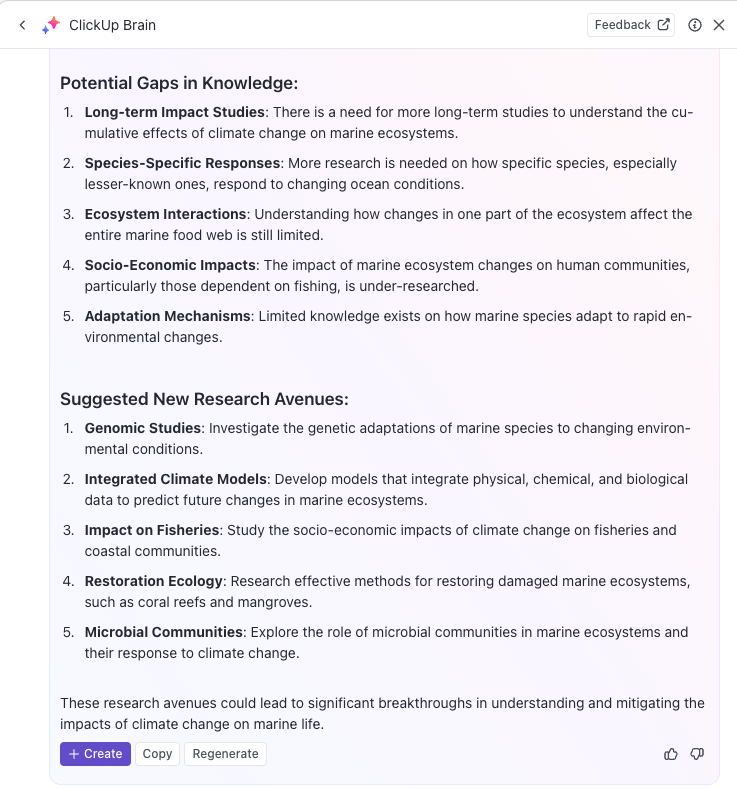

ClickUp Brain förstår sammanhanget för dina uppgifter och erbjuder relevanta förslag baserat på dina arbetspreferenser eller primära aktiviteter. För innehållsskapare ger det till exempel förslag för innehållsskapande, brainstorming och relaterade uppgifter.

Du kan till och med använda AI för att automatisera repetitiva uppgifter eller uppdatera uppgiftsstatus med enkla kommandon, så att du kan fokusera på djupare arbete. Om du letar efter en kraftfull AI-sökmotor för att öka produktiviteten är ClickUp Brain rätt val för dig.

Med ClickUp Brain kan du optimera din kunskapsbas genom att automatiskt kategorisera, tagga och organisera all relevant information.

Forskningsteam kan till exempel använda ClickUp för att skapa ett centraliserat kunskapshanteringssystem där alla insikter, dokument och forskningsresultat lagras i ett lättillgängligt format.

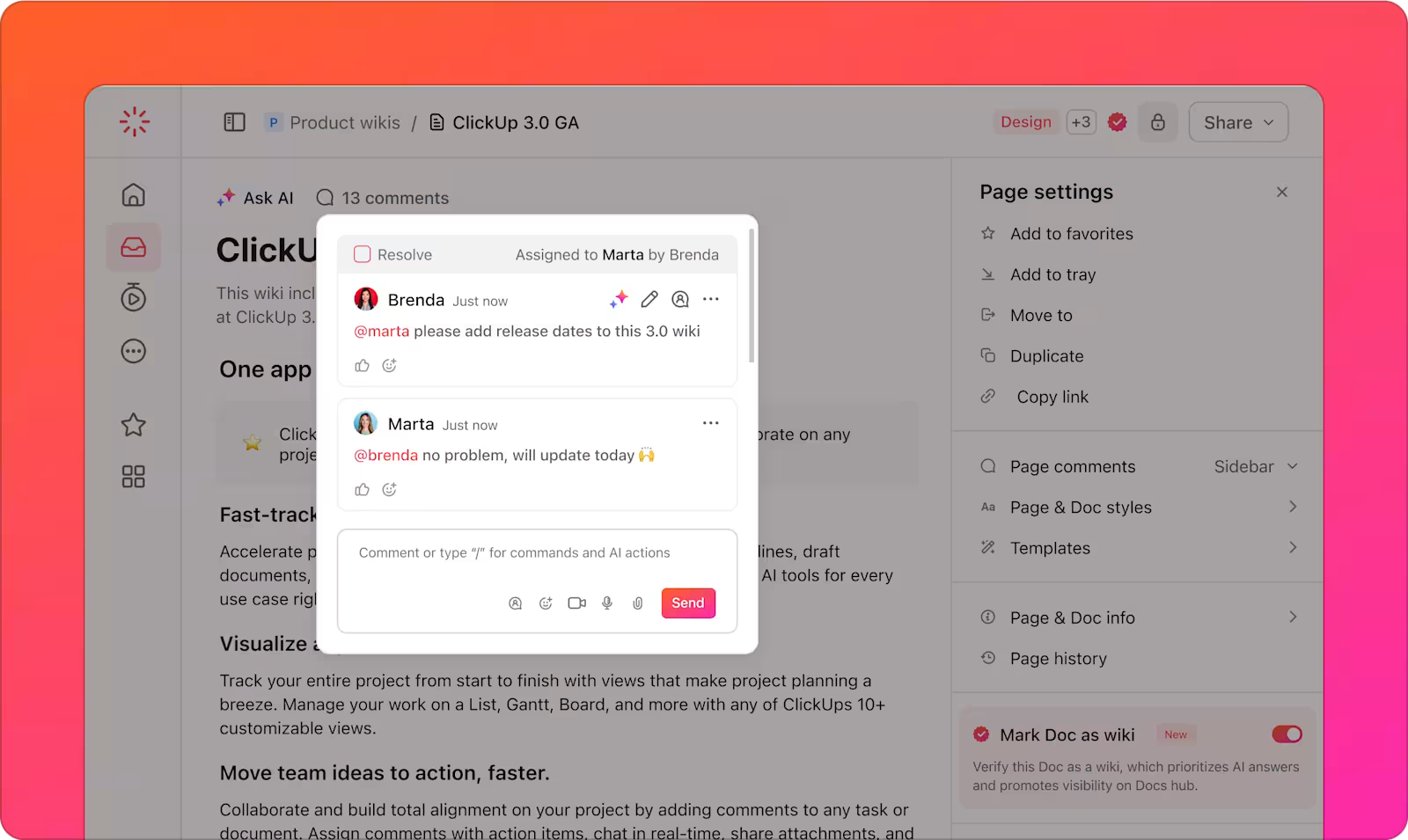

Dessutom stödjer ClickUp Docs mångsidighet skapandet av wikis, dokumentarkiv och kunskapsrelaterad uppgiftshantering.

Du kan också organisera information på olika sätt med hjälp av ClickUp Spaces, mappar och listor för att strukturera innehållet för snabb återvinning. Ditt team kan enkelt hitta och komma åt rätt data när det behövs utan att slösa tid på att söka igenom flera plattformar.

Dessutom hjälper plattformen till att spåra uppgifter och projekt via ClickUp Tasks baserat på insikter från LLM-sökmotorer. Du kan integrera AI-drivna sökresultat direkt i dina arbetsflöden för uppgifts- och projektspårning, vilket gör det enklare att implementera den kunskap du har upptäckt.

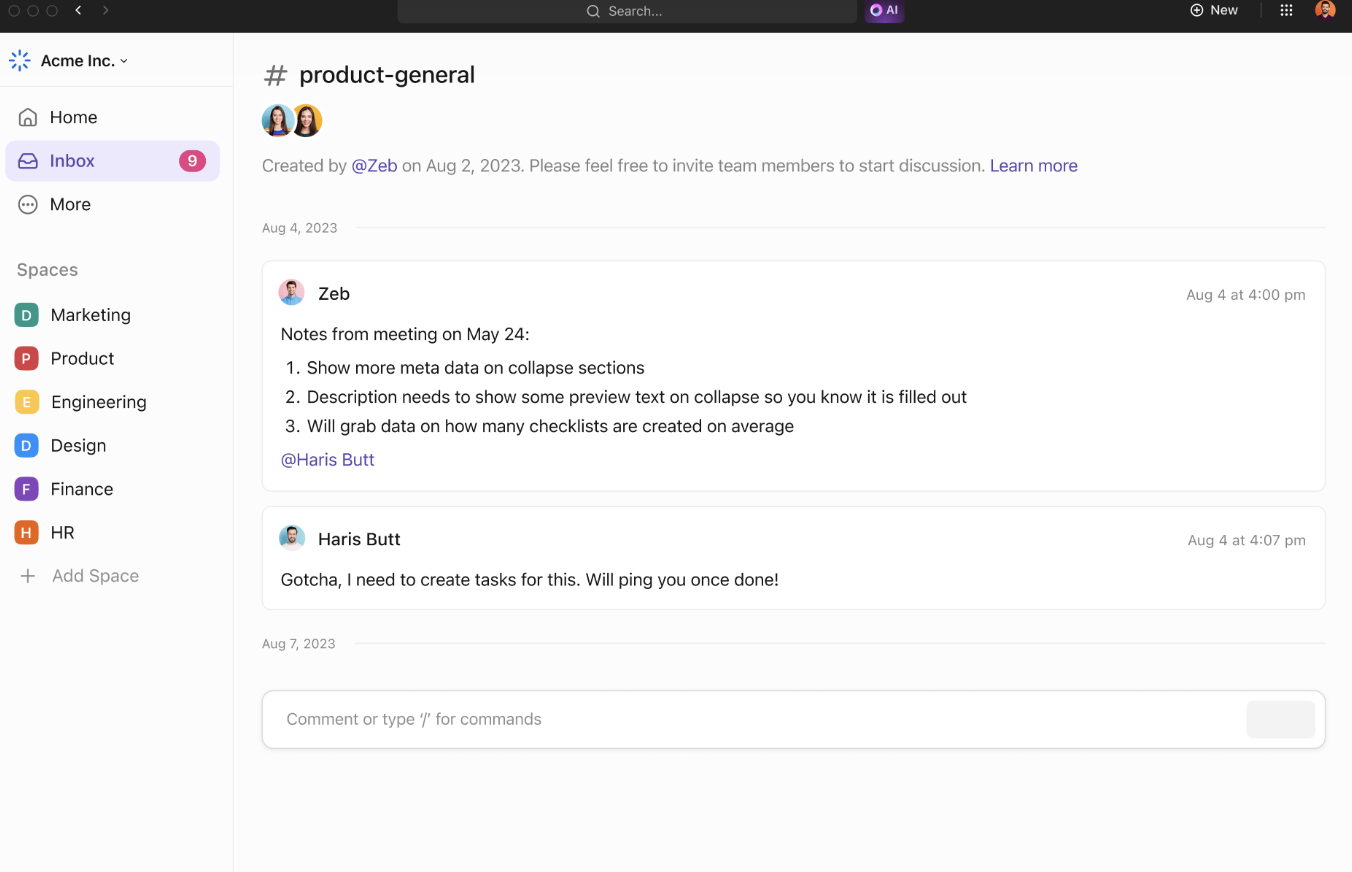

ClickUps samarbetsverktyg stödjer ytterligare teamets effektivitet och informationsdelning. ClickUp Chat gör det möjligt för teammedlemmar att diskutera projekt, dela insikter och ställa frågor i realtid.

Tilldelade kommentarer ger ett tydligt sätt att kommunicera om specifika dokument eller uppgifter, vilket säkerställer att alla hålls informerade om projektuppdateringar.

Team kan samarbeta genom att dela idéer och visualisera koncept. Lägg till anteckningar, ladda upp bilder och bädda in länkar för bättre sammanhang. Använd kopplingar för att länka idéer och markera deras relationer.

När dina idéer är klara kan du omvandla dem till spårbara uppgifter från ClickUp Whiteboards för att hålla allt enligt schemat.

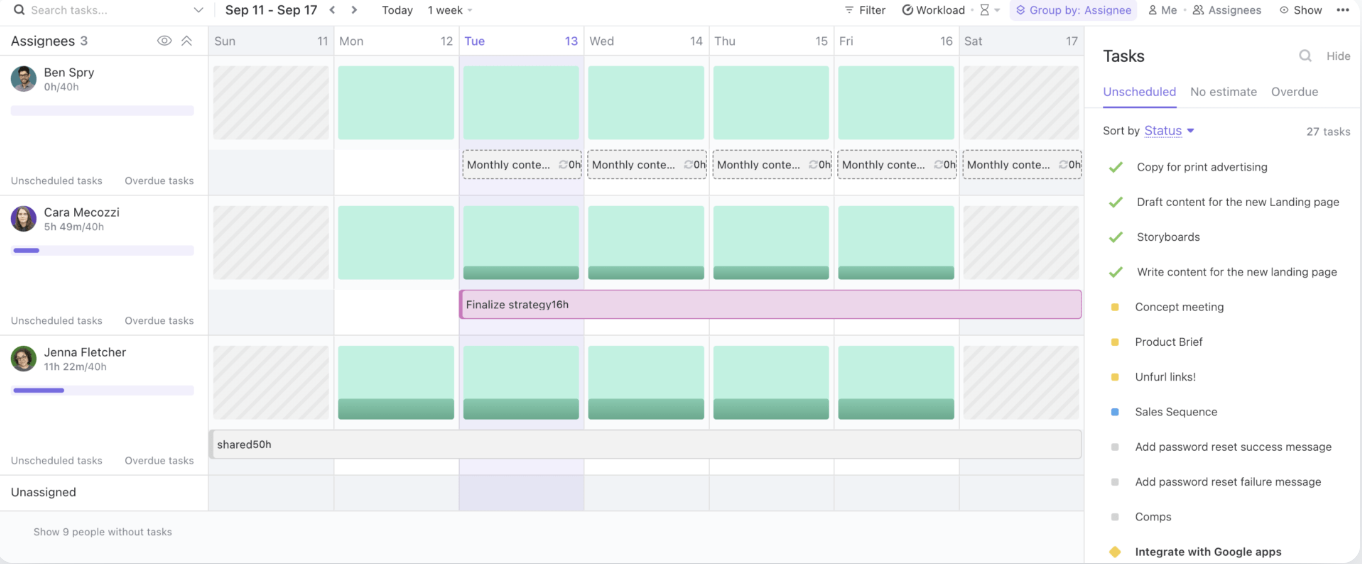

Slutligen kan du med ClickUp Workload View hantera teamets kapacitet, spåra pågående uppgifter och fördela resurser effektivt.

Genom att tillhandahålla en centraliserad plattform för kunskapsdelning och samarbete effektiviserar ClickUp arbetsflöden och förbättrar teamets effektivitet.

Bästa praxis för användning av LLM-sökmotorer

När du använder LLM-sökmotorer är det viktigt att följa bästa praxis för att maximera deras potential och samtidigt hantera riskerna.

Dessa strategier hjälper dig att få ut mesta möjliga av dina AI-drivna verktyg och säkerställer en smidig implementering och långsiktig framgång:

- Definiera tydliga användningsfall: Samarbeta tidigt mellan affärs- och teknikteam för att fastställa specifika, mätbara användningsfall. Anpassa målen för att säkerställa att lösningen uppfyller rätt behov och gör det enkelt att utvärdera framstegen.

- Upprätta genomtänkta intagsprocesser: Beakta datakänslighet, potentiella risker och avsedda användare när du prioriterar användningsfall. Använd en riskbaserad metod för att bedöma vilka projekt som ger mest värde med minsta möjliga skada.

- Fokusera på datainsamling, testning och validering: Säkerställ tillförlitliga, faktabaserade data genom att förbättra insamling, märkning, lagring och bearbetning.

- Implementera standardiserade testprocedurer: Skapa repeterbara testprocesser som stöds av playbooks och fördefinierade metoder. Säkerställ konsekventa resultat, systemtillförlitlighet och väl testade AI-modeller före distribution.

- Ställ in kontinuerlig övervakning: Övervaka systemets prestanda över tid och anpassa dig till förändrade data, användarbeteende och teknik.

- Genomför utbildnings- och kommunikationskampanjer: Förse ditt team med kunskap om hur man använder AI-verktyg på ett ansvarsfullt och effektivt sätt. Starta utbildnings- och kommunikationsprogram som täcker både tekniska och etiska aspekter av AI.

Utmaningar och lösningar inom LLM-driven sökning

LLM-drivna sökmotorer erbjuder en enorm potential, men de medför också en rad utmaningar. Nedan följer några vanliga AI-utmaningar och praktiska lösningar för att övervinna dem:

Datakvalitet och relevans

LLM-drivna sökmotorer är starkt beroende av kvaliteten och relevansen hos den data de bearbetar. Dålig eller föråldrad data kan leda till felaktiga eller irrelevanta sökresultat, vilket påverkar användarupplevelsen.

✨ Genom att fokusera på högkvalitativa, uppdaterade data kan organisationer säkerställa att deras LLM-drivna sökmotor ger relevanta och tillförlitliga resultat.

Bristande transparens

LLM-modeller betraktas ofta som ”svarta lådor”, där resonemanget bakom deras resultat inte är omedelbart uppenbart för användarna. Denna brist på transparens kan göra det svårt för användarna att lita på de resultat de får.

✨ Genom att integrera förklaringsfunktioner i sökmotorn kan organisationer ge användarna insikt i varför specifika resultat returnerades.

Partiskhet och etiska frågor

LLM kan ärva fördomar från den data de tränas på, vilket kan leda till snedvridna eller oetiska resultat. Om träningsdata inte är mångsidig eller representativ kan sökmotorn återspegla dessa fördomar, vilket påverkar beslutsfattandet och rättvisan.

✨ Det är viktigt att regelbundet granska och uppdatera träningsdata för att identifiera och minska dessa fördomar. Dessutom säkerställer införlivandet av olika datamängder och övervakning av resultaten att sökmotorn ger mer balanserade, rättvisa och etiska resultat.

Systemkomplexitet och integration

Att integrera LLM-drivna sökmotorer med befintliga arbetsflöden och applikationer kan vara en utmaning, särskilt när det gäller äldre system eller flera datakällor. Komplexiteten i att koppla samman dessa nya verktyg med etablerade plattformar kan bromsa implementeringen.

✨ Med ClickUps Connected Search kan du snabbt hitta alla filer, oavsett om de är lagrade i ClickUp, en ansluten app eller på din lokala enhet.

Problemet med hallucinationer

Hallucinationer avser fall där modellen genererar faktamässigt felaktig, påhittad eller irrelevant information. Detta beror på att modellen, istället för att hämta information direkt från indexerade källor, ibland ”hallucinerar” data baserat på mönster som den lärt sig under träningen.

✨ Avancerade tekniker som prompt engineering och högkvalitativa träningsdata förbättrar LLM:s tillförlitlighet. Finjustering med domänspecifika data minskar hallucinationer, medan integration av kunskapskartor säkerställer faktabaserade, korrekta sökresultat.

Framtiden för sökning med LLM

Nästa generation av LLM-drivna sökmotorer lovar ännu större precision, anpassningsförmåga och responsivitet, särskilt när det gäller att hantera komplexa och dynamiska användarfrågor. Dessa system kommer att anpassa sig dynamiskt till användarnas föränderliga behov genom att lära sig av tidigare interaktioner och realtidsdata.

I en företagsmiljö kan en LLM till exempel tolka en förfrågan som ”Hitta kundbortfallsanalysen för förra kvartalet” och inte bara returnera den råa filen utan även syntetiserade insikter, relevanta trender och praktiska slutsatser.

Branscher som är beroende av att hantera stora och komplexa datamängder har mest att vinna:

- Inom hälso- och sjukvården kan stora språkmodeller stödja diagnostisk precision genom att analysera och korsreferera kliniska anteckningar, bilddiagnostiska resultat och forskningsrapporter på några sekunder.

- Jurister kommer att dra nytta av verktyg som kan analysera omfattande rättspraxis för att lyfta fram relevanta prejudikat.

- Finansavdelningar kan använda LLM för uppgifter som realtidsbedrägeridetektering, prediktiv marknadsanalys och automatisering av efterlevnadskontroller.

Integrering av multimodala sökfunktioner – som kombinerar text-, röst- och bildigenkänning – kommer att ytterligare utöka användbarheten hos LLM.

Ett team som samarbetar kring en produktlansering kan till exempel omedelbart ladda upp bilder, lägga till kommentarer med röstinmatning och hämta relaterade dokument och rapporter. Denna nivå av anpassningsförmåga gör LLM avgörande för att säkerställa smidig åtkomst till olika dataformat.

Plattformar som ClickUp, i kombination med LLM-driven sökning, erbjuder en robust lösning för att organisera och komma åt filer, optimera arbetsflöden och effektivisera beslutsfattandet.

Effektivisera ditt arbetsflöde med LLM-driven sökning

I takt med att AI-drivna sökmotorer som drivs av LLM fortsätter att utvecklas revolutionerar de hur företag hämtar information från webbsidor och hanterar data.

Med sin förmåga att förstå sammanhang, leverera mer exakta resultat och integreras sömlöst med företagsarbetsflöden banar LLM vägen för smartare, snabbare och effektivare verksamhet.

Och när det gäller att hitta en AI-sökmotor som integreras sömlöst med ditt arbetsflöde, finns det inget som slår ClickUp Brain. Oavsett om du behöver hitta en fil eller uppgift snabbt, brainstorma idéer eller till och med skriva ett utkast till ett e-postmeddelande, kan ClickUp Brains kraftfulla AI-funktioner hantera allt.

Integrationen med ClickUps omfattande projektledningsverktyg säkerställer att allt finns inom räckhåll, vilket hjälper dig att hålla ordning, spara tid och fatta datadrivna beslut snabbare.

Så vad väntar du på? Registrera dig för ClickUp idag och få mer gjort med ClickUp Brain!