ความเป็นส่วนตัวเป็นสิทธิมนุษยชนขั้นพื้นฐาน และความเป็นส่วนตัวนี้ยังแผ่ขยายไปสู่ทุกแง่มุมของปัญญาประดิษฐ์ในปัจจุบันด้วย ในรายงานของ Cisco พบว่า64% ของผู้คนกังวลว่าอาจเผลอแบ่งปันข้อมูลที่ละเอียดอ่อนโดยไม่ตั้งใจเมื่อใช้เครื่องมือ AI

นั่นเป็นหนึ่งในเหตุผลที่เครื่องมือ AI แบบออฟไลน์กำลังได้รับความนิยมเพิ่มขึ้น เมื่อโมเดลทำงานบนเครื่องของคุณเอง คุณสามารถเขียน รหัส สรุป และสร้างสรรค์ผลงานได้โดยไม่ต้องอัปโหลดทุกอย่างขึ้นคลาวด์หรือติดขัดเมื่อสัญญาณ Wi-Fi ขาด

ในรายการนี้ เราจะครอบคลุมเครื่องมือ AI ที่ดีที่สุดที่สามารถทำงานแบบออฟไลน์ได้ ซึ่งรวมถึงแอปซูเปอร์แอปที่ช่วยให้คุณจัดระเบียบสิ่งที่เครื่องมือเหล่านี้สร้างขึ้นให้เป็นระบบเดียวที่เชื่อมโยงกันและมีความปลอดภัยสูง

เครื่องมือ AI ออฟไลน์คืออะไร?

เครื่องมือ AI แบบออฟไลน์คือซอฟต์แวร์แอปพลิเคชัน ที่ทำงานบนโมเดลภาษาขนาดใหญ่ (LLMs)บนอุปกรณ์ของคุณเอง โดยไม่จำเป็นต้องเชื่อมต่ออินเทอร์เน็ตหลังจากที่คุณดาวน์โหลดโมเดลแล้ว ข้อมูลของโมเดลจะถูกเก็บไว้โดยตรงบนคอมพิวเตอร์ของคุณ ดังนั้นการประมวลผลทั้งหมด หรือการอนุมาน จะเกิดขึ้นบน CPU หรือ GPU ของคุณเอง

การประมวลผลบนอุปกรณ์นี้มีประโยชน์หลักหลายประการ:

- ความเป็นส่วนตัวของข้อมูลอย่างสมบูรณ์: ข้อมูลที่ละเอียดอ่อนของคุณจะไม่ถูกส่งออกจากคอมพิวเตอร์ของคุณ

- ไม่มีค่าธรรมเนียมรายเดือน: เมื่อคุณมีเครื่องมือและแบบจำลองแล้ว จะไม่มีค่าใช้จ่ายในการสมัครสมาชิก

- ใช้งานได้ทุกที่: คุณสามารถใช้งานได้บนเครื่องบิน ในกระท่อมห่างไกล หรือในช่วงที่อินเทอร์เน็ตขัดข้อง

- ควบคุมได้อย่างเต็มที่: คุณเลือกโมเดลที่จะใช้และกำหนดค่าได้ตามต้องการ

เครื่องมือ AI ออฟไลน์ที่ดีที่สุดในภาพรวม

นี่คือสรุปอย่างรวดเร็วของเครื่องมือ AI ออฟไลน์ที่ดีที่สุดที่มีให้ใช้ในปัจจุบัน

| ชื่อเครื่องมือ | คุณสมบัติเด่น | เหมาะที่สุดสำหรับ | ราคา* |

| คลิกอัพ | โหมดออฟไลน์สำหรับงานและการแจ้งเตือน, ClickUp Brain MAX ซึ่งรวมถึงการแปลงเสียงเป็นข้อความ, การค้นหาแบบองค์กรข้ามแอปที่เชื่อมต่อ, การจัดการเอกสารและความรู้, การทำงานอัตโนมัติ, รวมถึงการผสานรวมและ API | ทีมที่ต้องการการบันทึกข้อมูลแบบออฟไลน์พร้อมการดำเนินการออนไลน์ การกำกับดูแล และบริบท AI ในพื้นที่ทำงานเดียว | ฟรีตลอดไป; ปรับแต่งได้สำหรับองค์กร |

| จีพีที4ออล | แชทท้องถิ่นกับนางแบบเปิด, LocalDocs สำหรับถาม-ตอบเอกสารส่วนตัว, ค้นหาและดาวน์โหลดนางแบบในแอป, เซิร์ฟเวอร์ API ท้องถิ่นที่รองรับ OpenAI | ผู้ใช้ที่ให้ความสำคัญกับความเป็นส่วนตัวและต้องการแชทบอทสำหรับเดสก์ท็อปแบบออฟไลน์ที่ใช้งานง่าย พร้อมเอกสารภายในเครื่อง | มีแผนให้บริการฟรี; แผนชำระเงินเริ่มต้นที่ $40/ผู้ใช้/เดือน |

| LM Studio | การค้นพบและดาวน์โหลดโมเดล, ส่วนติดต่อผู้ใช้สำหรับการแชทพร้อม RAG ในเครื่อง, เซิร์ฟเวอร์ที่รองรับ OpenAI หรือ REST API, การตั้งค่าล่วงหน้าและการปรับแต่งประสิทธิภาพ | นักพัฒนาและผู้ใช้ระดับสูงที่ต้องการเวิร์กเบสแบบออฟไลน์ที่สมบูรณ์แบบ | ฟรี |

| โอลามา | โมเดลคำสั่งเดียว, REST API ท้องถิ่นพร้อมสตรีมมิ่ง, ไฟล์โมเดลสำหรับการกำหนดค่าที่นำกลับมาใช้ใหม่ได้, และการฝังตัวสำหรับสายงาน RAG | นักพัฒนาที่ต้องการรันไทม์ในเครื่องที่เน้น CLI เป็นหลัก พร้อมชั้น API ที่แข็งแกร่ง | มีแผนฟรีให้บริการ; แผนชำระเงินเริ่มต้นที่ $20 ต่อเดือน |

| ม.ค. ai | UI แบบออฟไลน์สไตล์ ChatGPT, ผู้ช่วย, และการสนับสนุน MCP, ส่วนขยายเพื่อเพิ่มความสามารถ, และผู้ให้บริการที่รองรับ OpenAI (หากต้องการ) | ผู้ใช้ที่ไม่มีความรู้ทางเทคนิคที่ต้องการผู้ช่วยออฟไลน์ที่สะอาดพร้อมการปรับแต่ง | ฟรีและโอเพนซอร์ส |

| ลามะไฟล์ | บรรจุโมเดลในรูปแบบไฟล์ปฏิบัติการเดียว, แจกจ่ายข้ามระบบปฏิบัติการได้, โหมดเซิร์ฟเวอร์ภายในเครื่องพร้อมเว็บ UI และ API, รันไทม์ที่ต้องการการติดตั้งน้อยที่สุด | ผู้ใช้ที่ต้องการไฟล์ AI แบบพกพาที่ไม่ต้องติดตั้ง สามารถใช้งานได้ทุกที่ | ฟรีและโอเพนซอร์ส |

| PrivateGPT | การนำเข้าและจัดทำดัชนีเอกสารแบบโฮสต์เอง, ระบบถาม-ตอบ RAG แบบออฟไลน์, การกรองบริบทตามเอกสาร, โมดูล LLM แบบแยกส่วน, และระบบจัดเก็บเวกเตอร์ | ทีมที่ต้องการการถาม-ตอบแบบออฟไลน์ผ่านไฟล์ภายในพร้อมระบบ RAG ที่สามารถควบคุมได้ | ฟรีและโอเพนซอร์ส |

| Whisper.cpp | การแปลงเสียงพูดเป็นข้อความในท้องถิ่น, โมเดลแบบควอนไทซ์เพื่อการใช้ทรัพยากรน้อยลง, รองรับ VAD, การจัดการ FFmpeg แบบเลือกได้สำหรับรูปแบบเพิ่มเติม | ผู้ใช้ที่ต้องการการถอดเสียงแบบออฟไลน์เต็มรูปแบบซึ่งสามารถฝังในแอปได้ | ฟรีและโอเพนซอร์ส |

| เว็บ UI สำหรับการสร้างข้อความ | ส่วนติดต่อผู้ใช้บนเบราว์เซอร์สำหรับโมเดลภายในเครื่อง, เทมเพลตคำสั่ง Jinja2, การควบคุมการสร้าง, การแยกสาขาในแชท, และการแก้ไขข้อความ | ผู้ใช้ที่ต้องการการปรับแต่งสูงสุดในอินเตอร์เฟซเว็บท้องถิ่น | ฟรีและโอเพนซอร์ส |

| llama.cpp | เครื่องมือการอนุมานประสิทธิภาพสูง รองรับการควอนไทซ์อย่างกว้างขวาง เซิร์ฟเวอร์ภายในพร้อมจุดสิ้นสุดแบบ OpenAI การฝังและการจัดอันดับใหม่ | นักพัฒนาที่สร้างแอป AI แบบออฟไลน์หรือระบบหลังบ้านแบบกำหนดเอง | ฟรีและโอเพนซอร์ส |

วิธีที่เราตรวจสอบซอฟต์แวร์ที่ ClickUp

ทีมบรรณาธิการของเราปฏิบัติตามกระบวนการที่โปร่งใส มีหลักฐานการวิจัยรองรับ และเป็นกลางต่อผู้ขาย เพื่อให้คุณสามารถไว้วางใจได้ว่าคำแนะนำของเราอยู่บนพื้นฐานของคุณค่าที่แท้จริงของผลิตภัณฑ์

นี่คือรายละเอียดโดยละเอียดเกี่ยวกับวิธีการที่เราตรวจสอบซอฟต์แวร์ที่ ClickUp

สิ่งที่ควรพิจารณาในเครื่องมือ AI ที่ดีที่สุดที่สามารถใช้งานแบบออฟไลน์

การประเมินเครื่องมือ AI แบบออฟไลน์อาจรู้สึกเป็นเทคนิคและสับสน นำไปสู่การเลือกเครื่องมือที่อาจไม่สามารถทำงานบนคอมพิวเตอร์ของคุณได้ สิ่งที่สำคัญที่สุดที่ต้องพิจารณาคือสิ่งที่คุณต้องการจะบรรลุ นักพัฒนาที่กำลังสร้างแอปที่ใช้ AI มีความต้องการที่แตกต่างกันมากจากคนที่ต้องการเพียงแชทบอท AI ส่วนตัวแบบออฟไลน์เพื่อช่วยในการเขียน

นี่คือเกณฑ์หลักในการประเมิน:

- ความสะดวกในการตั้งค่า: ต้องการความรู้ทางเทคนิคและการทำงานผ่านคำสั่งหรือไม่ หรือเป็นเพียงการติดตั้งแบบคลิกเดียว?

- การเลือกแบบจำลอง: คุณสามารถเลือกจากแบบจำลองที่หลากหลายได้อย่างง่ายดายหรือไม่ หรือคุณถูกจำกัดให้ใช้เพียงไม่กี่แบบเท่านั้น?

- การรับประกันความเป็นส่วนตัว: เครื่องมือนี้ประมวลผลข้อมูลทั้งหมดในเครื่องหรือมีส่วนประกอบบนคลาวด์ที่ซ่อนอยู่หรือไม่?

- ข้อกำหนดด้านฮาร์ดแวร์: เครื่องปัจจุบันของคุณจะทำงานได้ดีหรือไม่ หรือคุณต้องการอัปเกรด?

- ความสามารถในการผสานรวม: สามารถเชื่อมต่อกับเครื่องมืออื่น ๆ ของคุณได้หรือไม่ หรือเป็นแอปพลิเคชันที่ทำงานแบบแยกเดี่ยวโดยสมบูรณ์?

- ความเหมาะสมของกรณีการใช้งาน: ออกแบบมาสำหรับการแชททั่วไป, การถามคำถามเกี่ยวกับเอกสารของคุณ, การถอดเสียง, หรือการเขียนโค้ด?

10 อันดับเครื่องมือ AI ที่ดีที่สุดที่ใช้งานได้โดยไม่ต้องเชื่อมต่ออินเทอร์เน็ต

นี่คือภาพรวมระดับสูงของเครื่องมือ AI ออฟไลน์ที่ดีที่สุด 👇

1. ClickUp (เหมาะที่สุดสำหรับการเก็บงาน เอกสาร และบริบท AI ไว้ในที่เดียว ทั้งการทำงานแบบออฟไลน์และออนไลน์)

ClickUp,ที่ทำงานแบบรวม AI แห่งแรกของโลก, ถูกสร้างขึ้นบนบล็อกของ'AI แบบออฟไลน์' ที่ไม่หยุดเพียงแค่การสร้างคำตอบ นั่นเป็นเพราะคุณยังคงต้องการสถานที่ที่ผลลัพธ์นั้นกลายเป็นคำตัดสิน, งาน, และขั้นตอนต่อไปที่ไม่หายไปในไฟล์และแชท

และแตกต่างจากการตั้งค่าแบบออฟไลน์หลายระบบที่ต้องติดตั้งยาวนานและต้องเชื่อมต่อเครื่องมือต่างๆ ClickUp มอบชั้นการทำงานที่สมบูรณ์ให้คุณในที่เดียว โดยมี AI ทำงานบนบริบทของพื้นที่ทำงานเดียวกัน

สำหรับเริ่มต้นคุณมีโหมดออฟไลน์ของ ClickUp ซึ่งจะเปิดใช้งานโดยอัตโนมัติและช่วยให้งานดำเนินต่อไปได้เมื่อมีการใช้งานแบบออฟไลน์ นั่นหมายความว่างาน การแจ้งเตือน และบันทึกทั้งหมดของคุณยังคงเข้าถึงได้ขณะออฟไลน์ พร้อมตัวเลือกในการเพิ่มงานใหม่หากจำเป็น เมื่อคุณเชื่อมต่ออีกครั้ง งานและคำเตือนใหม่จะซิงค์กลับไปยัง Workspace ของคุณโดยอัตโนมัติ (บอกลาการสูญเสียบริบทได้เลย 👋)

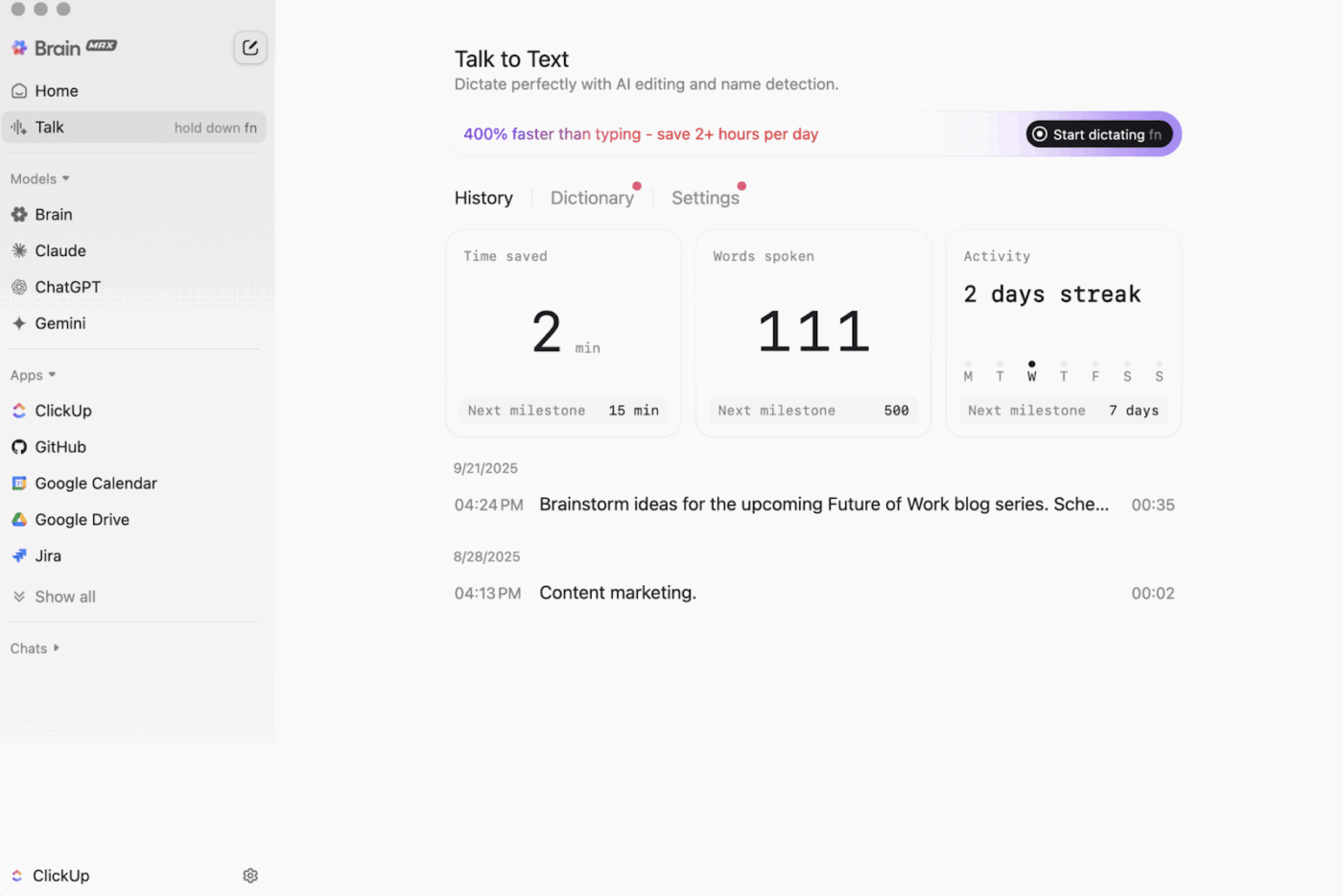

จากนั้นก็มีClickUp Brain MAX, ผู้ช่วย AI บนเดสก์ท็อปที่ให้ความสำคัญกับความเป็นส่วนตัว สามารถจัดเก็บและค้นหาข้อมูลทั่วทั้งพื้นที่ทำงานของคุณ แอปที่เชื่อมต่อ และแม้กระทั่งบนเว็บ

ด้วยฟีเจอร์Talk-to-Text ใน Brain MAX คุณสามารถแปลงเสียงของคุณเป็นข้อความได้โดยไม่ต้องใช้มือ ไม่ว่าจะเป็นการร่างอีเมล เขียนเอกสาร หรือบันทึกข้อมูลสำคัญอย่างรวดเร็วในขณะที่คุณกำลังเดินทาง

Brain MAX ยังมอบ Universal AI ให้กับคุณ ซึ่งออกแบบมาเพื่อการสนทนาผ่านโมเดล AI ล่าสุดสำหรับการเขียนโค้ด การเขียน การให้เหตุผลที่ซับซ้อน และอื่นๆ อีกมากมาย นั่นหมายความว่าคุณสามารถถามคำถามกับโมเดล AI ชั้นนำได้ในที่เดียวรวมถึง ClickUp Brain และตัวเลือกอื่นๆ เช่น OpenAI, Claude และ Gemini โดยไม่ต้องสลับเครื่องมือไปมา

ยิ่งไปกว่านั้นClickUp Securityยังเพิ่มมาตรการป้องกันที่เครื่องมือออฟไลน์มักมองข้าม เช่น การเข้ารหัสข้อมูล การกำหนดสิทธิ์แบบละเอียด และการควบคุมผู้ดูแลระบบ เช่น SSO การจัดเตรียมสิทธิ์ และการบันทึกการตรวจสอบ ทั้งหมดนี้ออกแบบมาสำหรับทีมที่ต้องการความปลอดภัยระดับองค์กร

ClickUp AI Knowledge Managementช่วยได้มากในการส่งต่อข้อมูลจาก 'ออฟไลน์ไปออนไลน์' มันให้ทีมของคุณมีศูนย์กลางในการจัดเก็บทรัพยากรต่างๆ ในเอกสารและวิกิ จากนั้นใช้ClickUp Brainเพื่อดึงคำตอบทันทีจากทั่วทั้งพื้นที่ทำงานของคุณ เพื่อให้บริบทที่ถูกต้องพร้อมใช้งานทันทีเมื่อเริ่มทำงานอีกครั้ง

🎬 ตัวแทนในปฏิบัติการ: ใช้ซูเปอร์เอเย่นต์เพื่อเปลี่ยนงานที่ซิงค์แล้วให้กลายเป็นขั้นตอนถัดไป!

ClickUp Super Agentsคือเพื่อนร่วมทีมที่ขับเคลื่อนด้วย AI ซึ่งคุณสามารถสร้างและปรับแต่งเพื่อดำเนินการเวิร์กโฟลว์หลายขั้นตอนภายในพื้นที่ทำงาน ClickUp ของคุณ คุณสามารถกำหนดค่าทริกเกอร์เฉพาะ คำแนะนำ และการเข้าถึงเครื่องมือ เพื่อให้มั่นใจว่าพวกเขาจะทำงานภายในขอบเขตที่คุณกำหนด

ตัวอย่างเช่น หลังจากที่งานออฟไลน์ซิงค์กลับมาแล้ว ซูเปอร์เอเจนต์สามารถสแกนรายการใหม่ สรุปสิ่งที่เปลี่ยนแปลง ดึงขั้นตอนที่ต้องดำเนินการ ร่างการอัปเดต และส่งต่อไปยังเจ้าของที่เหมาะสมเพื่อตรวจสอบ

และเนื่องจาก Super Agents สามารถควบคุมได้ คุณสามารถควบคุมสิ่งที่พวกเขาสามารถเข้าถึงได้ด้วยการอนุญาต และตรวจสอบสิ่งที่พวกเขาทำ 🔐

คุณสมบัติที่ดีที่สุดของ ClickUp

- ค้นหาทุกสิ่งในเครื่องมือของคุณ: จัดเรียงและค้นหาทั่วทั้งพื้นที่ทำงานของคุณ รวมถึงแอปที่เชื่อมต่อ จากที่เดียวด้วยClickUp Enterprise Search

- สร้างฐานความรู้ที่แท้จริง: สร้างวิกิและเอกสารด้วยClickUp Docsโดยใช้หน้าซ้อนกัน, แม่แบบ, ความช่วยเหลือจาก AI และอื่นๆ

- รักษาการเชื่อมต่อของคุณ: ซิงค์งานกับเครื่องมือต่างๆ เช่น Slack และ GitHub โดยไม่ต้องออกจาก ClickUp ด้วยClickUp Integrations

- สร้างเวิร์กโฟลว์ที่กำหนดเอง: ใช้ClickUp APIพร้อมโทเค็นส่วนตัวหรือ OAuth 2.0 เพื่อขับเคลื่อนการทำงานอัตโนมัติและการผสานรวมที่ปรับแต่งตามความต้องการ

- ทำให้ระบบของคุณเป็นอัตโนมัติ: ดำเนินการต่าง ๆ เช่น การมอบหมายเจ้าของ การอัปเดตสถานะ หรือการส่งต่อการทำงานโดยอัตโนมัติตามการเปลี่ยนแปลงของงาน ด้วยClickUp Automations

ข้อจำกัดของ ClickUp

- เนื่องจากมีคุณสมบัติที่หลากหลาย ผู้ใช้บางรายอาจต้องใช้เวลาในการเรียนรู้

ราคาของ ClickUp

คะแนนและรีวิว ClickUp

- G2: 4. 7/5 (10,000+ รีวิว)

- Capterra: 4. 6/5 (4,000+ รีวิว)

ผู้ใช้จริงพูดถึง ClickUp อย่างไรบ้าง?

ผู้ตรวจสอบ G2กล่าวว่า:

กระดานแบบ Agile การผสานรวม และการปรับแต่ง นอกจากนี้ ฉันชอบที่สามารถออฟไลน์และยังคงทำงานกับงานต่างๆ ได้ อีกทั้งยังสามารถส่งอีเมลไปยังรายการใดก็ได้และสร้างงานโดยอัตโนมัติ ตัวแก้ไขข้อความยอดเยี่ยมมาก ใช้งานได้ทั้งโหมด MD และใช้ทางลัด พร้อมแสดงตัวอย่างเนื้อหาแบบอินไลน์

กระดานแบบ Agile, การผสานรวม และการปรับแต่งตามความต้องการ นอกจากนี้ ฉันชอบที่สามารถออฟไลน์และยังคงทำงานกับงานต่างๆ ได้ อีกทั้งยังสามารถส่งอีเมลไปยังรายการใดก็ได้และสร้างงานโดยอัตโนมัติ ตัวแก้ไขข้อความยอดเยี่ยมมาก ใช้งานได้ทั้งโหมด MD และใช้ทางลัด พร้อมแสดงตัวอย่างเนื้อหาแบบอินไลน์

2. GPT4All (เหมาะที่สุดสำหรับการสนทนา AI ส่วนตัวแบบออฟไลน์กับ LLM ในเครื่อง)

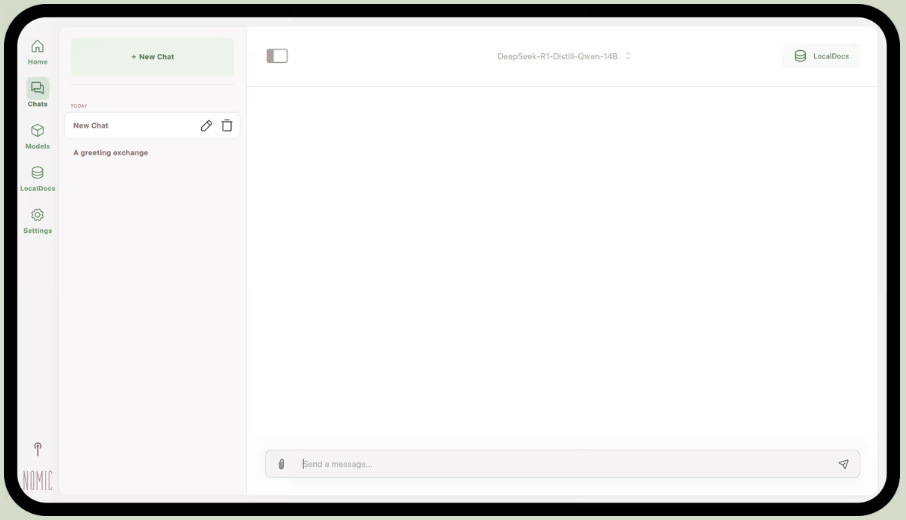

เป็นส่วนหนึ่งของNomic.ai, GPT4All เป็นแอปพลิเคชันเดสก์ท็อปที่ให้คุณรันโมเดลภาษาขนาดใหญ่แบบโอเพนซอร์สได้โดยตรงบนคอมพิวเตอร์ของคุณ ทำให้คุณสามารถสนทนากับผู้ช่วย AI ได้โดยไม่ต้องพึ่งพาการเชื่อมต่ออินเทอร์เน็ตหรือการเรียกใช้ API บนคลาวด์ มันถูกสร้างขึ้นสำหรับผู้ที่ต้องการการตั้งค่าแบบ 'ท้องถิ่นก่อน' ที่ซึ่งคำสั่ง, การตอบสนอง, และไฟล์ต่าง ๆ จะถูกเก็บไว้บนอุปกรณ์ของคุณ

คุณสมบัติที่ดีที่สุดของมันคือ LocalDocs ซึ่งใช้รูปแบบ ของการสร้างเสริมการค้นหาเพื่อให้คุณสามารถสนทนากับเอกสารของคุณเองได้อย่างเป็นส่วนตัว คุณสามารถชี้แอปไปที่โฟลเดอร์ของไฟล์ PDF หรือไฟล์ข้อความ และมันจะสร้างฐานความรู้ภายในที่คุณสามารถถามคำถามได้

GPT4All ยังมีห้องสมุดที่คัดสรรโมเดลยอดนิยมอย่าง Llama และ Mistral ซึ่งคุณสามารถดาวน์โหลดได้โดยตรงผ่านแอป

คุณสมบัติที่ดีที่สุดของ GPT4All

- เริ่มต้นเซิร์ฟเวอร์ API ท้องถิ่น (รองรับ OpenAI) เพื่อใช้โมเดล GPT4All ภายในแอปและระบบอัตโนมัติอื่น ๆ

- ค้นหา เปรียบเทียบ และดาวน์โหลดโมเดล GGUF ได้ภายในแอป พร้อมตัวเลือกการจัดเรียง เช่น จำนวนไลค์ จำนวนดาวน์โหลด และวันที่อัปโหลด

- ปรับความยาวของบริบท, ความยาวสูงสุดของผลลัพธ์, top-p, top-k, ค่าปรับการซ้ำ, จำนวนเธรด CPU, และแม้กระทั่งการถ่ายโอนภาระงานไปยัง GPU (รวมถึงการรองรับ Metal บน Apple Silicon)

ข้อจำกัดของ GPT4All

- ประสิทธิภาพการทำงานขึ้นอยู่กับฮาร์ดแวร์ของคอมพิวเตอร์ของคุณเป็นอย่างมาก

- การจัดทำดัชนีเอกสารจำนวนมากอาจใช้เวลานาน

ราคาของ GPT4All

- แอปเดสก์ท็อปฟรี

- ธุรกิจ: $40 ต่อผู้ใช้ต่อเดือน (Nomic AI)

- องค์กร: ราคาตามตกลง (Nomic AI)

คะแนนและรีวิวของ GPT4All

- G2: รีวิวไม่เพียงพอ

- Capterra: ไม่มีรีวิวเพียงพอ

ผู้ใช้จริงพูดถึง GPT4All อย่างไรบ้าง?

ผู้ใช้ Redditคนหนึ่งกล่าวว่า:

นี่คือตัวที่ดีที่สุดที่ผมเคยลองใช้กับ RAG ดีกว่าทุกอย่าง และง่ายกว่า LM Studio ด้วยซ้ำ ผมชอบวิธีที่คุณแมปมันเข้ากับโฟลเดอร์ และมันติดตามและจัดการการเปลี่ยนแปลงให้คุณ ยังอยู่ในช่วงเริ่มต้นของความสมบูรณ์ เหมือนกับตัวอื่น ๆ แต่ตัวนี้จะกลายเป็นค่าเริ่มต้นของผมในระยะสั้น

นี่คือตัวที่ดีที่สุดที่ผมเคยลองใช้กับ RAG ดีกว่าทุกอย่าง และง่ายกว่า LM Studio ด้วยซ้ำ ผมชอบวิธีที่คุณแมปมันเข้ากับโฟลเดอร์ และมันติดตามและจัดการการเปลี่ยนแปลงให้คุณ ยังอยู่ในช่วงเริ่มต้นของความสมบูรณ์ เหมือนกับตัวอื่น ๆ แต่ผมจะใช้เป็นตัวเริ่มต้นในระยะสั้น

📮 ClickUp Insight: 88% ของผู้ตอบแบบสำรวจของเราใช้ AI สำหรับงานส่วนตัว แต่กว่า 50% ยังลังเลที่จะใช้ในที่ทำงาน อุปสรรคหลักสามประการคืออะไร? การขาดการผสานรวมที่ราบรื่น ช่องว่างทางความรู้ หรือความกังวลด้านความปลอดภัย แต่ถ้า AI ถูกฝังอยู่ในพื้นที่ทำงานของคุณและมีความปลอดภัยอยู่แล้วล่ะ? ClickUp Brain,

ผู้ช่วย AI ในตัวของ ClickUp ทำให้สิ่งนี้เป็นจริงได้ มันเข้าใจคำสั่งในภาษาที่เข้าใจง่าย แก้ไขปัญหาการนำ AI มาใช้ทั้งสามข้อ พร้อมเชื่อมต่อแชท งาน เอกสาร และความรู้ของคุณทั่วทั้งพื้นที่ทำงาน ค้นหาคำตอบและข้อมูลเชิงลึกได้ด้วยการคลิกเพียงครั้งเดียว!

3. LM Studio (เหมาะที่สุดสำหรับโต๊ะทำงานออฟไลน์ที่ดูเรียบร้อยพร้อมการปรับแต่งประสิทธิภาพ)

ผ่านทางLM Studio

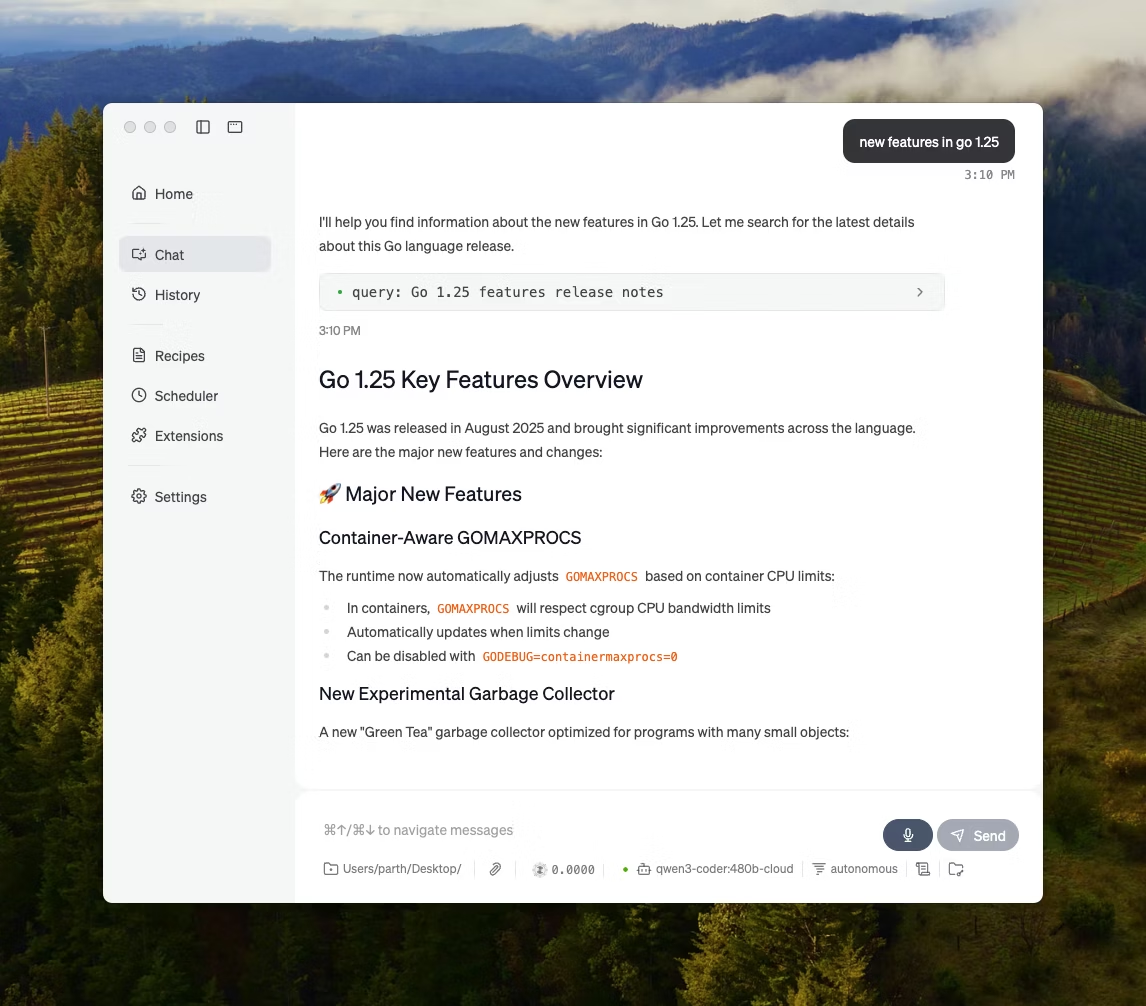

LM Studio เป็นแอปพลิเคชันเดสก์ท็อป AI ท้องถิ่นที่ออกแบบมาเพื่อค้นหา ทดสอบ และใช้งานโมเดลโอเพนซอร์สผ่านอินเทอร์เฟซผู้ใช้ โดยไม่ต้องพึ่งพาเทอร์มินัล เหมาะสำหรับการทดลอง เช่น การเลือกโมเดล ใช้งานบนเครื่องของคุณเอง และปรับแต่งคำสั่งหรือตั้งค่าต่าง ๆ พร้อมรับผลตอบกลับอย่างรวดเร็วและต่อเนื่อง ซึ่งให้ประสบการณ์ที่คล่องตัวกว่าระบบที่เน้น CLI เป็นหลัก

นอกจากนี้ยังรองรับการแชทกับเอกสารแบบออฟไลน์ทั้งหมด (RAG ภายในเครื่อง) ซึ่งคุณสามารถแนบไฟล์เข้ากับการสนทนาและอ้างอิงไฟล์เหล่านั้นในระหว่างการตอบกลับได้ ทำให้เหมาะอย่างยิ่งสำหรับการวิจัยแบบออฟไลน์ การจดบันทึกการศึกษา หรือกระบวนการทำงานเอกสารภายในองค์กรที่ไม่สามารถอัปโหลดไฟล์ได้

LM Studio ยังให้คุณควบคุมอย่างละเอียดเกี่ยวกับการทำงานของ AI ด้วยตัวเลือกในการปรับอุณหภูมิ ความยาวของบริบท และการใช้ GPU

คุณสมบัติเด่นของ LM Studio

- ใช้โหมดความเข้ากันได้ของ OpenAI หรือREST API ของ LM Studio เอง ขึ้นอยู่กับสิ่งที่แอปของคุณคาดหวัง

- LM Studio มีตัวเลือก SDK ทั้ง JavaScript และ Python สำหรับการสร้างเวิร์กโฟลว์ในเครื่องบนโมเดลของคุณ

- บันทึกข้อความแจ้งเตือนของระบบพร้อมพารามิเตอร์เป็นค่าที่ตั้งไว้ล่วงหน้า แล้วนำกลับมาใช้ใหม่ในแชทต่างๆ (สามารถนำเข้าค่าที่ตั้งไว้ล่วงหน้าจากไฟล์/URL และเผยแพร่เพื่อแชร์ผ่าน LM Studio Hub ได้เช่นกัน)

ข้อจำกัดของ LM Studio

- LM Studio สามารถทำให้คอมพิวเตอร์ค้างขณะใช้งาน DeepSeek R1 32B

- ผู้ใช้บางรายรายงานแอปนี้ว่าเป็นปัญหาด้านความปลอดภัยของข้อมูลและความเป็นส่วนตัว เนื่องจากโค้ดที่ปิดและไม่ได้รับการตรวจสอบ

ราคาของ LM Studio

- ฟรีสำหรับใช้ในบ้านและที่ทำงาน

LM Studio คะแนนและรีวิว

- G2: รีวิวไม่เพียงพอ

- Capterra: รีวิวไม่เพียงพอ

ผู้ใช้ในชีวิตจริงพูดถึง LM Studio อย่างไรบ้าง?

ผู้ใช้ Redditคนหนึ่งกล่าวว่า:

มันยอดเยี่ยมมาก มันใช้งานได้ดีจริง ๆ ง่ายมากที่จะเริ่มต้น มีหน้าตา UI ที่ดูดีที่สุดเมื่อเทียบกับคู่แข่งทั้งหมด

มันยอดเยี่ยมมาก มันใช้งานได้ดีจริง ๆ ง่ายมากที่จะเริ่มต้น มีหน้าตา UI ที่ดูดีที่สุดเมื่อเทียบกับคู่แข่งทั้งหมด

4. Ollama (เหมาะที่สุดสำหรับการรัน LLM ท้องถิ่นด้วย CLI ที่เรียบง่าย + เซิร์ฟเวอร์ท้องถิ่น)

Ollama เป็นโมเดลท้องถิ่นที่ทำงานเหมือนกับ LLM runtime มากกว่าจะเป็นแอปแชทแบบสแตนด์อโลน มันถูกออกแบบให้ใช้งานผ่านเทอร์มินัลเป็นหลัก โดยดึงและรันโมเดลเปิดด้วยคำสั่งที่รวดเร็ว (เช่น ollama run llama3) จากนั้นเปิดเผยโมเดลเหล่านั้นผ่านบริการท้องถิ่นที่อินเทอร์เฟซอื่น ๆ สามารถใช้งานได้

จุดแข็งของ Ollama อยู่ที่ REST API ของมัน เมื่อ Ollama ทำงานอยู่ในพื้นหลังแล้ว แอปพลิเคชันใด ๆ ก็สามารถสื่อสารกับมันได้ผ่านคำขอ HTTP ง่าย ๆ ซึ่งช่วยให้คุณสามารถสร้างคุณสมบัติ AI เข้าไปในซอฟต์แวร์ของคุณเองได้

Ollama ยังมีห้องสมุดของโมเดลยอดนิยมที่สามารถดาวน์โหลดได้ด้วยคำสั่งเดียว และคุณสามารถสร้างการกำหนดค่าโมเดลแบบกำหนดเองได้ ซึ่งเปรียบเสมือน Dockerfiles สำหรับ AI

คุณสมบัติเด่นของ Ollama

- สร้างสูตรโมเดลที่สามารถนำกลับมาใช้ใหม่ได้และมีเวอร์ชันได้ (การเลือกโมเดลพื้นฐาน, เทมเพลตคำสั่ง, ข้อความระบบ, พารามิเตอร์, อะแดปเตอร์) โดยใช้ไฟล์โมเดล

- รันโมเดลผ่านเอนด์พอยต์ เช่น แชท/สร้าง พร้อมตัวเลือกการสตรีมมิ่งสำหรับผลลัพธ์โทเค็นแบบเรียลไทม์ในแอปและสคริปต์

- สร้าง embedding สำหรับกระบวนการค้นหาและดึงข้อมูลเชิงความหมายโดยใช้ความสามารถในการสร้าง embedding ของ Ollama และโมเดล embedding ที่แนะนำ

ข้อจำกัดของ Ollama

- ไม่มีอินเทอร์เฟซกราฟิกในตัว ดังนั้นผู้ใช้ที่ไม่มีความรู้ทางเทคนิคจะต้องใช้เครื่องมือส่วนติดต่อผู้ใช้แยกต่างหาก

- แอปเดสก์ท็อป macOS ของ Ollama อาจไม่ตอบสนองขณะออฟไลน์ แม้ว่าจะดาวน์โหลดโมเดลไว้แล้วก็ตาม ในขณะที่ CLI ยังคงทำงานได้

ราคาของ Ollama

- ฟรี

- ข้อดี: $20/เดือน

- สูงสุด: $100 ต่อเดือน

คะแนนและรีวิวของ Ollama

- G2: รีวิวไม่เพียงพอ

- Capterra: ไม่มีรีวิวเพียงพอ

ผู้ใช้จริงพูดถึง Ollama อย่างไรบ้าง?

ผู้รีวิวจากProducthuntกล่าวว่า:

ติดตั้งและจัดการได้ง่าย Ollama ทำให้การรัน LLM ในเครื่องเป็นเรื่องง่าย เพียงจับคู่กับ OpenWebUI เพื่อประสบการณ์การใช้งานที่ยอดเยี่ยมที่สุด

ติดตั้งและจัดการได้ง่าย Ollama ทำให้การรัน LLM ในเครื่องเป็นเรื่องง่าย เพียงจับคู่กับ OpenWebUI เพื่อประสบการณ์การใช้งานที่ยอดเยี่ยมที่สุด

🧠 เกร็ดความรู้: ระบบแปลงเสียงเป็นข้อความเริ่มต้นด้วย 'ตัวเลขเท่านั้น'AUDREY ของ Bell Labs(1952) สามารถจดจำตัวเลข 0–9 ได้ และบันทึกหนึ่งระบุว่ามันทำงานได้ดีที่สุดเมื่อพูดโดยผู้ประดิษฐ์ของมันเอง

5. ม.ค. ai (เหมาะที่สุดสำหรับผู้ช่วยแบบ ChatGPT ที่เน้นความเป็นส่วนตัวและใช้งานแบบออฟไลน์)

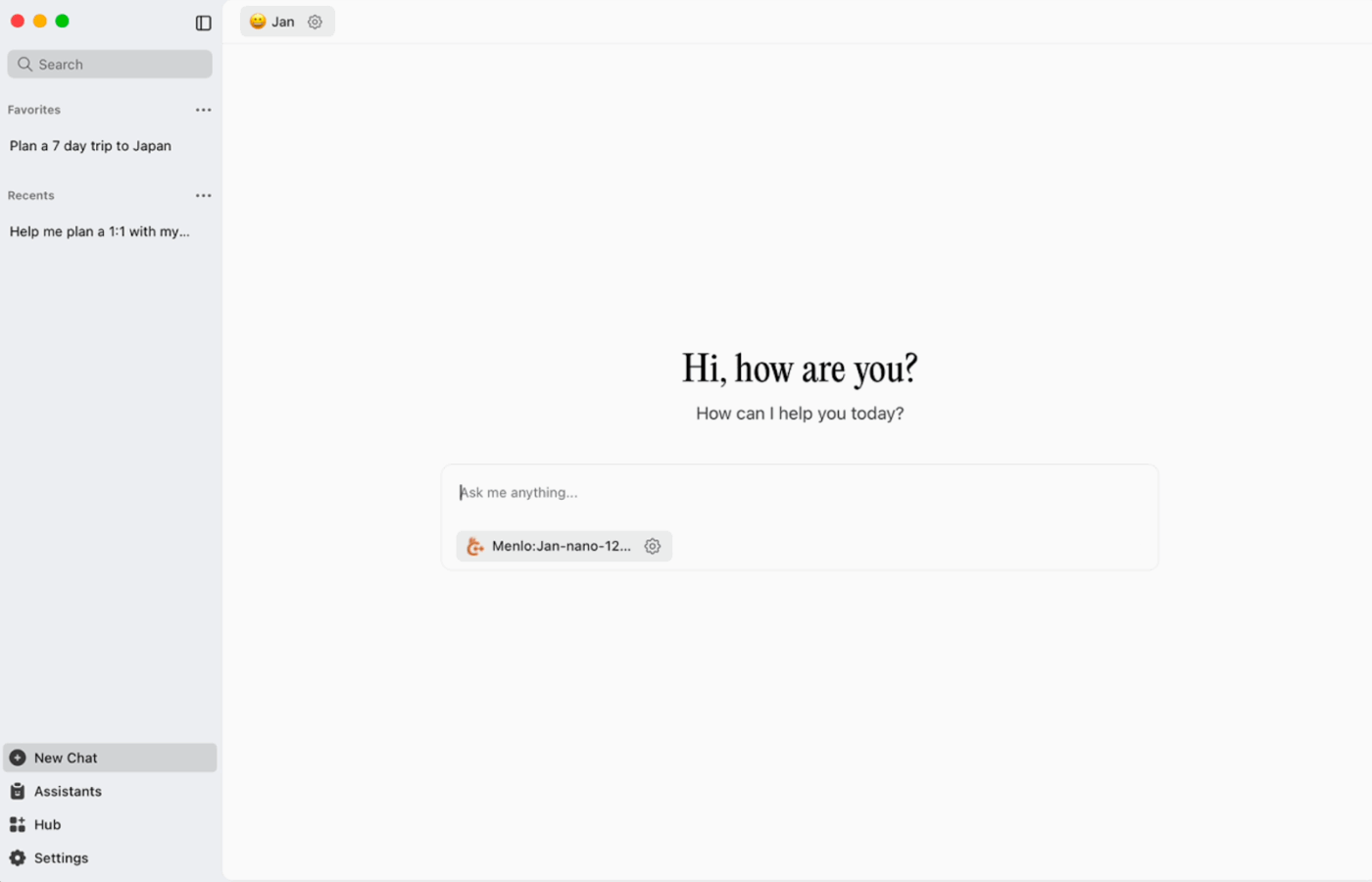

Jan. ai เป็นผู้ช่วยเดสก์ท็อปแบบโอเพนซอร์สที่มอบประสบการณ์การแชทคล้าย ChatGPT ให้กับ macOS, Windows และ Linux โดยเน้นการใช้งานแบบเก็บข้อมูลในเครื่องเป็นอันดับแรกเป็นค่าเริ่มต้น โปรแกรมนี้ทำงานบนอุปกรณ์ของคุณเมื่อคุณต้องการ ในขณะที่ประวัติการสนทนาและข้อมูลการใช้งานจะถูกเก็บไว้ในพื้นที่ส่วนตัวและไม่ถูกส่งออกจากคอมพิวเตอร์ของคุณ

มันรองรับการรันโมเดลโอเพนซอร์สในเครื่อง และยังสามารถเชื่อมต่อกับผู้ให้บริการระยะไกล เช่น API ที่รองรับ OpenAI ได้ตามต้องการ ซึ่งช่วยให้มีความยืดหยุ่นเมื่อการใช้งานแบบออฟไลน์เป็นสิ่งสำคัญ แต่ในบางครั้งก็จำเป็นต้องเข้าถึงข้อมูลผ่านคลาวด์

คุณสมบัติที่ดีที่สุดของ Jan. ai

- สร้างผู้ช่วยที่มีคำแนะนำและการตั้งค่าของตัวเอง จากนั้นสลับระหว่างผู้ช่วยเหล่านี้ได้จากแท็บผู้ช่วย แทนที่จะต้องเขียนคำสั่งใหม่ทุกครั้ง

- เชื่อมต่อ Jan กับเครื่องมือ MCP และแหล่งข้อมูลโดยใช้มาตรฐานเปิดที่สร้างขึ้นเพื่อการทำงานตามรูปแบบการใช้เครื่องมือ

- ติดตั้งส่วนขยายเพื่อเพิ่มฟีเจอร์ใหม่ เช่น การค้นหาเว็บหรือตัวแปลโค้ด วิธีการแบบโมดูลาร์นี้ช่วยให้คุณเริ่มต้นอย่างง่ายและเพิ่มประสิทธิภาพมากขึ้นตามความต้องการ

ข้อจำกัดของ Jan. ai

- Jan อาจอนุญาตให้โหลดไฟล์โมเดลที่ยังดาวน์โหลดไม่เสร็จสมบูรณ์ ซึ่งอาจทำให้เกิดพฤติกรรมที่สับสนหรือไม่สอดคล้องกันจนกว่าไฟล์จะสมบูรณ์

- การเปิดใช้งาน API อาจรบกวนการสนทนาแบบหลายข้อความ และจุดสิ้นสุดพื้นฐาน เช่น 'get loaded model' หรือ 'swap model' อาจทำงานไม่ราบรื่น

ราคาของ Jan. ai

- โอเพนซอร์ส

คะแนนและรีวิวของ Jan. ai

- G2: รีวิวไม่เพียงพอ

- Capterra: ไม่มีรีวิวเพียงพอ

ผู้ใช้จริงพูดถึง Jan. ai อย่างไรบ้าง?

ผู้ใช้ Redditคนหนึ่งกล่าวว่า:

Jan. ai เป็นแอป LLM ในพื้นที่ที่ฉันใช้ประจำ มันยอดเยี่ยมมาก

Jan. ai เป็นแอป LLM ในพื้นที่ที่ฉันใช้ประจำ มันยอดเยี่ยมมาก

6. Llamafile (เหมาะที่สุดสำหรับการบรรจุ LLM ลงในไฟล์ปฏิบัติการแบบพกพา)

Llamafile เป็นโครงการที่นำโดย Mozilla ซึ่งรวบรวม LLM แบบโอเพนซอร์สเต็มรูปแบบไว้ในไฟล์ปฏิบัติการเดียว แทนที่จะต้องติดตั้งรันไทม์ จัดการกับไลบรารีที่จำเป็น หรือเชื่อมต่อส่วนติดต่อผู้ใช้แยกต่างหาก คุณสามารถดาวน์โหลดไฟล์เดียวแล้วรันใช้งานได้ทันทีเหมือนแอปพลิเคชันทั่วไป

แนวคิดหลักคือการกระจาย. 'llamafile' ประกอบด้วยน้ำหนักของแบบจำลองพร้อมรันไทม์ที่คอมไพล์ไว้แล้ว ซึ่งถูกสร้างขึ้นเพื่อทำงานบนระบบปฏิบัติการหลายระบบด้วยการตั้งค่าที่น้อยที่สุด. มันมีประโยชน์เป็นพิเศษเมื่อต้องการแชร์เครื่องมือออฟไลน์กับเพื่อนร่วมทีม, นักเรียน, หรือลูกค้าที่ไม่สามารถแก้ไขปัญหาการติดตั้งได้.

คุณสมบัติที่ดีที่สุดของ Llamafile

- Llamafile รวม llama.cpp กับ Cosmopolitan Libc เพื่อรองรับความสามารถในการใช้งานไบนารีบนแพลตฟอร์มที่หลากหลาย ลดงานแพ็กเกจเฉพาะแพลตฟอร์ม

- โหมดเซิร์ฟเวอร์ให้บริการเว็บ GUI พร้อมจุดสิ้นสุดการเติมเต็มที่เข้ากันได้กับ OpenAI API ซึ่งมีประโยชน์สำหรับการพัฒนาแอปพลิเคชันในเครื่องและการสลับการเรียกใช้คลาวด์ระหว่างการทดสอบ

- ไฟล์แพ็กเกจ llamafiles ถูกออกแบบมาเพื่อทำงานบนเครื่อง x86_64 และ ARM64 ที่พบได้ทั่วไป ซึ่งทำให้การแจกจ่ายง่ายขึ้นในเครื่องที่หลากหลาย

ข้อจำกัดของ Llamafile

- การเลือกแบบจำลองถูกจำกัดเฉพาะสิ่งที่ได้ถูกบรรจุไว้ในรูปแบบ Llamafile เท่านั้น

- ขนาดไฟล์ใหญ่มากเนื่องจากโมเดลทั้งหมดถูกฝังอยู่

ราคาของ Llamafile

- ฟรีและโอเพนซอร์ส

คะแนนและรีวิวของ Llamafile

- G2: รีวิวไม่เพียงพอ

- Capterra: ไม่มีรีวิวเพียงพอ

🧠 เกร็ดความรู้: เว็บไซต์แรกของโลกยังสามารถเข้าชมได้อยู่ CERN เป็นผู้ดูแลเว็บไซต์นี้โดยตรงที่info.cern.ch โดยเรียกมันว่า 'บ้านของเว็บแรก'

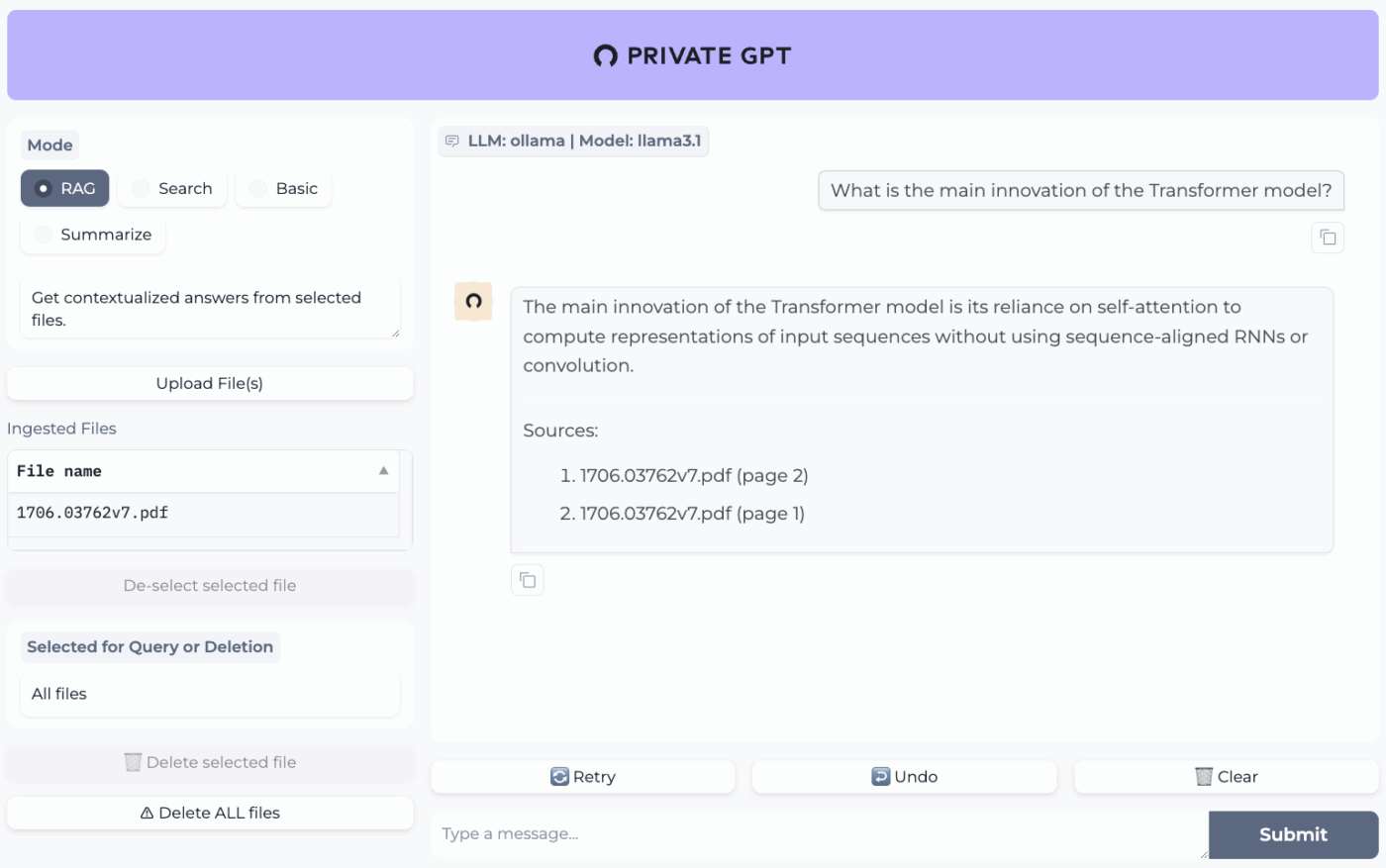

7. PrivateGPT (เหมาะที่สุดสำหรับการถาม-ตอบแบบออฟไลน์กับไฟล์ของคุณผ่าน RAG stack ที่โฮสต์เอง)

PrivateGPT เป็นโครงการที่พร้อมใช้งานจริงและสามารถโฮสต์ได้เอง สร้างขึ้นเพื่อรองรับการทำงานแบบ 'แชทกับเอกสารของคุณ' โดยสามารถนำเข้าไฟล์ในเครื่อง จัดทำดัชนี และตอบคำถามโดยดึงบริบทที่เกี่ยวข้องจากเนื้อหาของคุณเอง แทนที่จะพึ่งพาความจำของแชทบอทบนคลาวด์ โครงการนี้ได้รับการออกแบบให้ทำงานแบบออฟไลน์ได้อย่างสมบูรณ์ พร้อมการันตีว่าข้อมูลจะยังคงอยู่ภายในสภาพแวดล้อมการทำงานของคุณเท่านั้น

สิ่งที่ทำให้มันแตกต่างจากแอปแชทออฟไลน์ทั่วไปคือสถาปัตยกรรมแบบโมดูลาร์ กล่าวอีกนัยหนึ่ง คุณสามารถผสมผสาน LLM, ผู้ให้บริการฝังตัว และที่เก็บข้อมูลเวกเตอร์ตามข้อจำกัดของฮาร์ดแวร์และความเป็นส่วนตัวของคุณ จากนั้นเรียกใช้ทุกอย่างผ่าน API + UI ในเครื่อง

คุณสมบัติเด่นของ PrivateGPT

- นำเข้าไฟล์ PDF, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, รูปภาพ (JPG/PNG/JPEG) และแม้แต่ MP3/MP4 โดยใช้ระบบนำเข้าข้อมูลในตัว

- กำหนดค่าโปรไฟล์การตั้งค่าชั้นด้วย PGPT_PROFILES (เช่น local,cuda) เพื่อรวมไฟล์การตั้งค่าหลายไฟล์และสลับการใช้งานโดยไม่ต้องเขียนการตั้งค่าพื้นฐานใหม่

- กรองคำตอบสำหรับชุดย่อยเฉพาะของเอกสารที่นำเข้าโดยใช้ context_filter เมื่อเรียกใช้จุดสิ้นสุดการเติมข้อความตามบริบท

ข้อจำกัดของ PrivateGPT

- มีข้อกำหนดฮาร์ดแวร์ที่สูงขึ้นเนื่องจากต้องทำงานหลายองค์ประกอบพร้อมกัน

- การนำเข้าเอกสารหลายฉบับจากไฟล์เดียว (เช่น PDF หนึ่งไฟล์ที่สร้างเอกสารหนึ่งฉบับต่อหน้า) อาจเพิ่มปริมาณและความซับซ้อนในการจัดทำดัชนีเมื่อจัดการกับการอัปโหลดขนาดใหญ่

ราคาของ PrivateGPT

- โอเพนซอร์ส

คะแนนและรีวิวของ PrivateGPT

- G2: รีวิวไม่เพียงพอ

- Capterra: ไม่มีรีวิวเพียงพอ

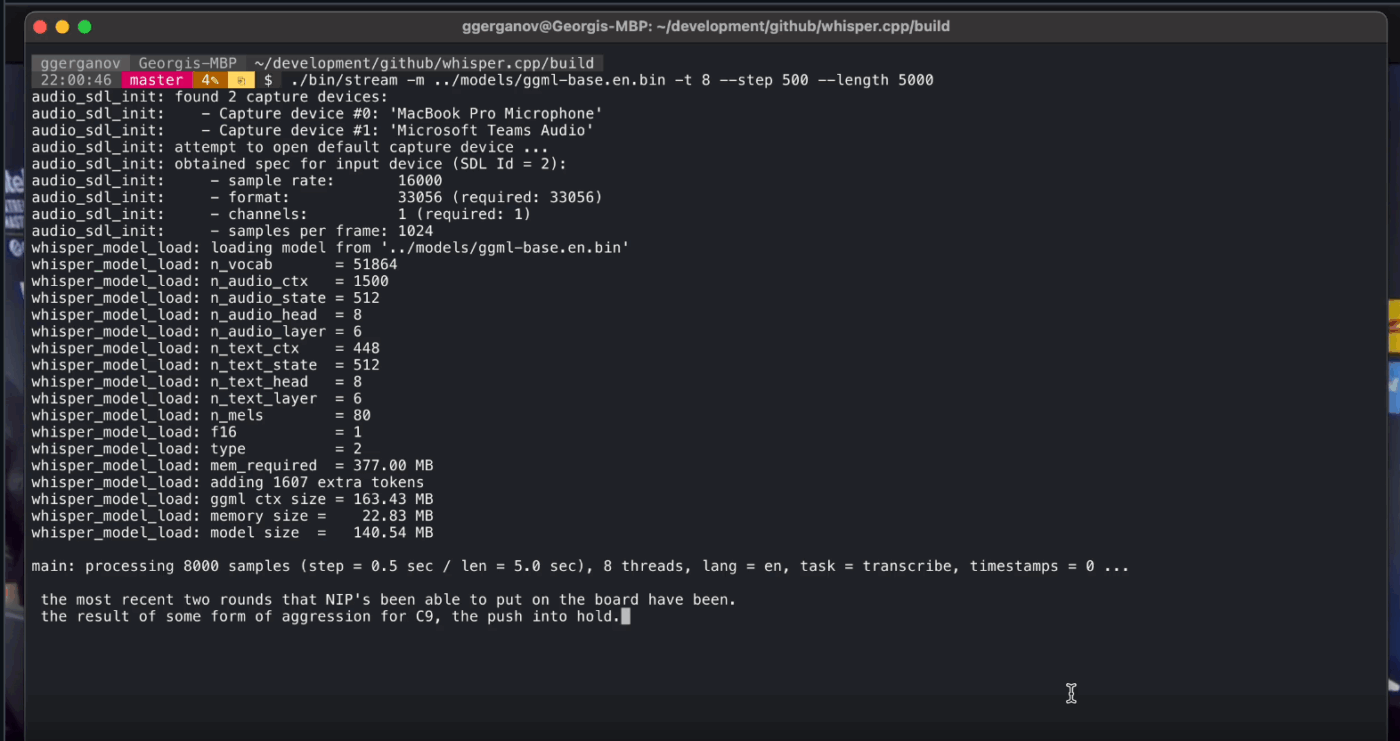

8. Whisper.cpp (เหมาะที่สุดสำหรับการแปลงเสียงเป็นข้อความแบบออฟไลน์เต็มรูปแบบที่สามารถฝังในแอปได้)

Whisper.cpp คือการนำโมเดลการรู้จำเสียงพูดอัตโนมัติ Whisper ของ OpenAI มาพัฒนาใหม่ด้วยภาษา C/C++ ที่มีความประสิทธิภาพสูง ถูกสร้างขึ้นเพื่อทำงานบนเครื่องท้องถิ่นโดยไม่ต้องพึ่งพาไลบรารีที่มีขนาดใหญ่ มันได้รับความนิยมในกระบวนการถอดเสียงแบบออฟไลน์ที่ต้องการไฟล์ไบนารีขนาดเล็กและพกพาได้ หรือไลบรารีสไตล์ C ที่คุณสามารถนำไปใช้ในผลิตภัณฑ์ของคุณเองได้

นอกจากนี้ยังมีความยืดหยุ่นในทุกสภาพแวดล้อม โดยมีการสนับสนุนอย่างเป็นทางการครอบคลุมทั้งเดสก์ท็อป, มือถือ, WebAssembly, Docker, และแม้กระทั่งฮาร์ดแวร์ระดับ Raspberry Pi ซึ่งทำให้เหมาะสมสำหรับเครื่องมือออฟไลน์ที่ต้องการทำงานในหลายที่

ตัวอักษร 'cpp' ในชื่อของมันบ่งบอกถึงความมุ่งเน้นในด้านประสิทธิภาพ การใช้งานนี้มีความเร็วสูงกว่าและใช้หน่วยความจำน้อยกว่าทางเลือกที่ใช้ Python อย่างมาก ทำให้การถอดเสียงแบบเรียลไทม์เป็นไปได้บนคอมพิวเตอร์สมัยใหม่โดยไม่ต้องใช้ GPU ที่ทรงพลัง

Whisper.cpp คุณสมบัติเด่น

- รันการตรวจจับกิจกรรมเสียง (VAD) เป็นส่วนหนึ่งของโครงการเพื่อแบ่งส่วนเสียงและลดการถอดเสียงที่มีเสียงรบกวนหรือเสียงว่างเปล่าในกระบวนการทำงานแบบสตรีมมิ่ง

- ปรับขนาดโมเดล Quantize Whisper เพื่อลดความต้องการพื้นที่ดิสก์และหน่วยความจำ พร้อมตัวเลือกการปรับขนาดหลายแบบที่ออกแบบมาเพื่อการอนุมานในเครื่องที่รวดเร็วขึ้น

- สร้างด้วยการรองรับ FFmpeg แบบเลือกได้บน Linux เพื่อจัดการรูปแบบอินพุตเพิ่มเติมนอกเหนือจากเส้นทางพื้นฐานที่รองรับเฉพาะ WAV เท่านั้น

ข้อจำกัดของ Whisper.cpp

- Whisper.cpp's CLI คาดหวังอินพุต WAV แบบ 16 บิตเป็นค่าเริ่มต้น ซึ่งเพิ่มขั้นตอนการแปลงเพิ่มเติมเมื่อทำงานกับ MP3, MP4, M4A หรือรูปแบบทั่วไปอื่น ๆ

- ระบบนี้ไม่ได้มีการระบุผู้พูดโดยอัตโนมัติ (การบันทึกประจำวันของผู้พูด) ซึ่งทำให้ยากต่อการอ้างอิงคำพูดอย่างถูกต้องในบันทึกเสียงที่มีหลายผู้พูด

Whisper.cpp ราคา

- โอเพนซอร์ส

Whisper.cpp คะแนนและรีวิว

- G2: รีวิวไม่เพียงพอ

- Capterra: รีวิวไม่เพียงพอ

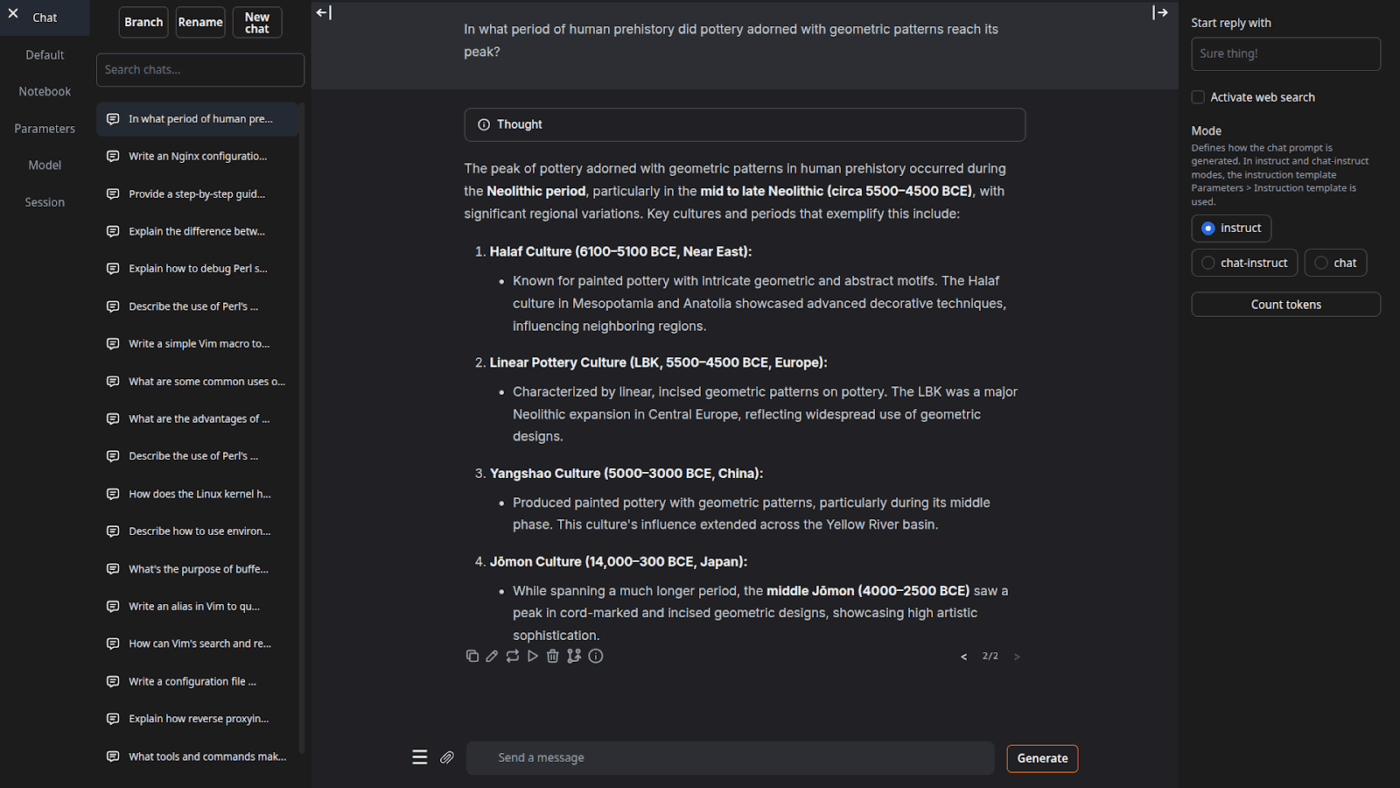

9. หน้าเว็บสำหรับสร้างข้อความ (เหมาะสำหรับผู้ใช้ที่ต้องการแผงควบคุมผ่านเบราว์เซอร์สำหรับ LLM ในเครื่อง)

Text Generation Web UI (มักเรียกกันว่า 'oobabooga') เป็นอินเทอร์เฟซเว็บที่พัฒนาโดยใช้ Gradio สำหรับรันโมเดลในเครื่อง โดยเน้นการควบคุมและการทดลองเป็นหลัก มีลักษณะการทำงานคล้ายกับเวิร์กเบสเต็มรูปแบบ: รองรับโมเดลแบ็กเอนด์หลายตัว โหมดการโต้ตอบหลากหลาย และตัวเลือกปรับแต่งพฤติกรรมการสร้างข้อความมากมาย

นอกจากนี้ยังรองรับกระบวนการทำงานแบบ 'นักเขียน/นักพัฒนา' ที่เครื่องมือออฟไลน์หลายตัวมักข้ามไป ด้วยฟีเจอร์ต่างๆ เช่น การทำงานอัตโนมัติในรูปแบบคำสั่ง การสร้างแบบสมุดบันทึก และการแยกสาขาการสนทนา สำหรับการตั้งค่าออฟไลน์ที่ยังต้องการ UI บนเว็บ มันเป็นหนึ่งในส่วนหน้า (frontend) ที่ปรับแต่งได้มากที่สุดในหมวดนี้

คุณสมบัติที่ดีที่สุดของเว็บ UI สำหรับการสร้างข้อความ

- การจัดรูปแบบข้อความแจ้งอัตโนมัติโดยใช้เทมเพลต Jinja2ช่วยลดข้อผิดพลาดในการจัดรูปแบบข้อความแจ้งระหว่างตระกูลโมเดลที่แตกต่างกัน

- ปรับตั้งค่าหลายสิบรายการเพื่อปรับแต่งผลลัพธ์ของ AI ให้ตรงกับความต้องการเฉพาะของคุณ ไม่ว่าจะเป็นการเขียนเชิงสร้างสรรค์ การเขียนโค้ด หรือการสวมบทบาท

- การแก้ไขข้อความพร้อมการนำทางเวอร์ชันและการแยกสาขาการสนทนา สามารถเก็บแชทในหลายทิศทางเดียวกันได้โดยไม่ต้องเริ่มต้นใหม่

ข้อจำกัดของเว็บ UI สำหรับการสร้างข้อความ

- ตัวติดตั้งแบบคลิกเดียวต้องการพื้นที่ดิสก์ประมาณ 10GB และจะดาวน์โหลด PyTorch ซึ่งทำให้การติดตั้งรู้สึกหนักสำหรับเครื่องที่มีข้อจำกัดด้านพื้นที่จัดเก็บ

- จุดสิ้นสุดการฝังตัวที่เข้ากันได้กับ OpenAI ใช้ sentence-transformers/all-mpnet-base-v2 พร้อมการฝังตัวที่มีมิติ 768 ซึ่งสามารถทำลายสมมติฐานในกระบวนการที่สร้างขึ้นรอบค่าเริ่มต้น 1536 มิติของ OpenAI

ราคาสำหรับผู้ใช้เว็บ UI ในการสร้างข้อความ

- โอเพนซอร์ส

การให้คะแนนและรีวิวเว็บ UI สำหรับการสร้างข้อความ

- G2: รีวิวไม่เพียงพอ

- Capterra: รีวิวไม่เพียงพอ

10. Llama. cpp (เหมาะที่สุดสำหรับการอนุมาน LLM ในเครื่องที่มีประสิทธิภาพสูงทั้งบน CPU และ GPU)

Llama.cpp เป็นเครื่องมือและชุดเครื่องมือสำหรับ C/C++ ที่ใช้สำหรับประมวลผล LLM ในเครื่องโดยมีความต้องการในการติดตั้งน้อยที่สุดและประสิทธิภาพที่แข็งแกร่งบนฮาร์ดแวร์หลากหลายประเภท มันไม่ใช่ 'แอปแชท' แต่เป็นรันไทม์ในเครื่องที่คุณสามารถสร้างเวิร์กโฟลว์รอบๆ ไม่ว่าจะเป็น CLI, เซิร์ฟเวอร์ HTTP ในเครื่อง หรือไลบรารีฝังตัวในผลิตภัณฑ์ของคุณเอง

แม้ว่า Llama.cpp จะไม่ใช่แอปพลิเคชันสำหรับผู้ใช้ปลายทางโดยตรง แต่เป็นเครื่องมือหลักที่ขับเคลื่อนเครื่องมือหลายตัวในรายการนี้ รวมถึง GPT4All และ LM Studio มันได้แนะนำรูปแบบโมเดล GGUF ซึ่งได้กลายเป็นมาตรฐานสำหรับการรันโมเดลขนาดใหญ่บนฮาร์ดแวร์สำหรับผู้บริโภคโดยการลดขนาดอย่างมีประสิทธิภาพ

นอกจากนี้ยังมีการเชื่อมต่อสำหรับภาษาการเขียนโปรแกรมยอดนิยมเช่น Python และ Rust และโหมดเซิร์ฟเวอร์ของมันสามารถให้ API ที่เข้ากันได้กับ OpenAI

Llama. cpp คุณสมบัติที่ดีที่สุด

- เปิดใช้งานเซิร์ฟเวอร์ท้องถิ่นที่รองรับ OpenAI API พร้อมเว็บ UI ในตัว และจุดสิ้นสุด /v1/chat/completions โดยใช้ llama-server

- รันโมเดล embedding (และแม้แต่โมเดล reranking) จากเซิร์ฟเวอร์เดียวกันสำหรับ pipeline RAG แบบออฟไลน์โดยใช้ /embedding และ /reranking

- ลดระดับความละเอียดของโมเดลลงเหลือ 1 บิต 5 บิต ไปจนถึง 8 บิต เพื่อลดการใช้หน่วยความจำและเพิ่มความเร็วในการอนุมานในเครื่อง จากนั้นเร่งความเร็วการทำงานด้วย CUDA/Metal พร้อม Vulkan/SYCL backends เมื่อมีให้ใช้งาน

ข้อจำกัดของ Llama. cpp

- Llama.cpp ไม่ได้ถูกจัดส่งมาเป็นโปรแกรมผู้ช่วยบนเดสก์ท็อปที่สมบูรณ์แบบ ซึ่งหมายความว่าการใช้งานแบบออฟไลน์มักจะต้องใช้คำสั่ง CLI หรือโฮสต์ llama-server และผู้ใช้หลายคนพึ่งพา UI ของบุคคลที่สามสำหรับการแชทในชีวิตประจำวัน

- ความเข้ากันได้ของ Llama. cpp กับ OpenAI ไม่ได้เป็นแบบ 1:1 กับทุกฟีเจอร์ของ OpenAI client เสมอไป และผู้ใช้รายงานความไม่ตรงกันในรอบพารามิเตอร์ผลลัพธ์ที่มีโครงสร้าง เช่น response_format ใน /v1/chat/completions

Llama. cpp ราคา

- โอเพนซอร์ส

ผู้ใช้จริงพูดถึง Llama.cpp ว่าอย่างไรบ้าง?

ผู้ตรวจสอบจากSourceforgeกล่าวว่า:

ยอดเยี่ยมมาก การทำให้ปัญญาประดิษฐ์เป็นของทุกคน และมันทำงานได้ดีมาก!

ยอดเยี่ยมมาก การทำให้ปัญญาประดิษฐ์เป็นของทุกคน และมันทำงานได้ดีมาก!

เปลี่ยนผลลัพธ์จาก AI แบบออฟไลน์ให้กลายเป็นงานจริงด้วย ClickUp

การเลือกเครื่องมือ AI แบบออฟไลน์ที่เหมาะสมนั้น จริงๆ แล้วคือการจับคู่เครื่องมือให้ตรงกับงานที่ต้องการ

หากคุณอยู่ที่นี่ คุณอาจกำลังปรับปรุงให้ดีที่สุดในสามสิ่ง: ความเป็นส่วนตัว, ไม่พึ่งพาอินเทอร์เน็ต, และเสรีภาพจากการถูกผูกมัดกับการสมัครสมาชิกอีกครั้ง

เครื่องมือในรายการนี้ตอบโจทย์ในด้านนั้นด้วยวิธีที่แตกต่างกัน หมายความว่า บางเครื่องมือเหมาะสำหรับการเขียนและเขียนโค้ด ในขณะที่บางเครื่องมือเหมาะสำหรับการค้นหา การจดบันทึก หรือการทำงานสร้างสรรค์

แต่สำหรับทีม ความท้าทายที่ใหญ่กว่าไม่ใช่แค่การรัน AI ในเครื่องเท่านั้น แต่คือการเปลี่ยนผลลัพธ์ของ AI ให้กลายเป็นกระบวนการทำงานจริง

ด้วยความสามารถของ AI จาก ClickUp ที่ผสานเข้ากับงาน เอกสาร และองค์ความรู้ของคุณ คุณสามารถมองเห็นขั้นตอนถัดไปได้อย่างง่ายดายในที่เดียวที่งานเกิดขึ้น (ทั้งหมดนี้มาพร้อมความปลอดภัยระดับองค์กร)

ลองใช้ ClickUp ฟรีและดูว่า AI และการดำเนินการทำงานร่วมกันอย่างไรเมื่อทุกอย่างรวมกันเป็นหนึ่ง ✨

คำถามที่พบบ่อยเกี่ยวกับเครื่องมือ AI แบบออฟไลน์

ใช่ หลังจากดาวน์โหลดไฟล์โมเดลครั้งแรกแล้ว เครื่องมือ AI หลายตัวสามารถทำงานได้ทั้งหมดบนอุปกรณ์ของคุณโดยไม่ต้องใช้อินเทอร์เน็ต ซึ่งทำให้เหมาะอย่างยิ่งสำหรับการจัดการข้อมูลที่ละเอียดอ่อนหรือการทำงานในสถานที่ที่มีการเชื่อมต่ออินเทอร์เน็ตไม่ดี

LLM ท้องถิ่นประมวลผลข้อมูลทั้งหมดบนอุปกรณ์ส่วนตัวของคุณ ดังนั้นข้อมูลของคุณจะไม่ถูกส่งออกจากเครื่องของคุณ ในขณะที่ AI บนคลาวด์จะส่งคำสั่งของคุณไปยังเซิร์ฟเวอร์ระยะไกลเพื่อประมวลผล เครื่องมือท้องถิ่นโดยทั่วไปสามารถใช้ได้ฟรีหลังจากการตั้งค่า ในขณะที่ AI บนคลาวด์มักจะมีค่าธรรมเนียมการสมัครสมาชิกแต่ก็อาจเสนอโมเดลที่ทรงพลังมากกว่า

โมเดลขนาดเล็กที่มีพารามิเตอร์ 1-3 พันล้านสามารถทำงานบนแล็ปท็อปสมัยใหม่ส่วนใหญ่ที่มี RAM 8GB ได้ โมเดลที่ใหญ่ขึ้นและมีความสามารถมากขึ้นที่มีพารามิเตอร์ 7 พันล้านหรือมากกว่าจะทำงานได้ดีที่สุดเมื่อมี RAM 16GB หรือมากกว่าและ GPU ที่แยกออกมา โดย Mac ที่ใช้ Apple Silicon และ GPU ของ NVIDIA จะให้ประสิทธิภาพที่เพิ่มขึ้นอย่างมาก

![10 เครื่องมือ AI ที่ดีที่สุดที่ทำงานแบบออฟไลน์ในปี [year]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)