A magánélet alapvető emberi jog. És ez a magánélet a mai mesterséges intelligencia minden területére kiterjed. A Cisco egyik jelentése szerint az emberek 64%-a attól tart, hogy véletlenül érzékeny információkat oszthat meg, amikor mesterséges intelligencia eszközöket használ.

Ez az egyik oka annak, hogy az offline AI-eszközök egyre népszerűbbek. Ha a modell helyileg fut, akkor írhat, kódolhat, összefoglalhat és alkothat anélkül, hogy mindent fel kellene töltenie a felhőbe, vagy megakadna, ha a Wi-Fi-kapcsolat megszakad.

Ebben a listában bemutatjuk a legjobb offline működő AI eszközöket, köztük egy szuperalkalmazást, amely segít összehangolni ezeknek az eszközöknek a termékeit egy egységes, rendkívül biztonságos rendszerbe.

Mik azok az offline AI eszközök?

Az offline AI eszközök olyan szoftveralkalmazások, amelyek nagy nyelvi modelleket (LLM) futtatnak a helyi eszközön, és a modell letöltése után nincs szükség internetkapcsolatra. A modell adatai közvetlenül a számítógépen vannak tárolva, így az összes feldolgozás, vagyis a következtetés a saját CPU-n vagy GPU-n történik.

Ennek az eszközön történő feldolgozásnak számos fontos előnye van:

- Teljes adatvédelem: Az Ön érzékeny adatai soha nem hagyják el a számítógépét.

- Nincs ismétlődő díj: Miután megvásárolta az eszközt és a modellt, nincs előfizetési díj.

- Bárhol használható: repülőgépen, távoli faházban vagy internetkimaradás esetén is használható.

- Teljes ellenőrzés: Ön választja ki, mely modelleket használja és hogyan konfigurálja őket.

A legjobb offline AI eszközök áttekintése

Íme egy rövid összefoglaló a jelenleg elérhető legjobb offline AI eszközökről.

| Eszköz neve | Főbb jellemzők | Legalkalmasabb | Árak* |

| ClickUp | Offline mód feladatokhoz és emlékeztetőkhöz, ClickUp Brain MAX, amely magában foglalja a Talk-to-Text funkciót, vállalati keresést a csatlakoztatott alkalmazásokban, dokumentumok és tudásmenedzsment, automatizálás, valamint integrációk és API. | Olyan csapatok, amelyeknek offline rögzítésre, online végrehajtásra, irányításra és AI-kontextusra van szükségük egy munkaterületen belül. | Örökre ingyenes; Testreszabás elérhető vállalatok számára |

| GPT4All | Helyi csevegés nyitott modellekkel, LocalDocs privát dokumentumokhoz kapcsolódó kérdések és válaszokhoz, alkalmazáson belüli modellkeresés és letöltés, OpenAI-kompatibilis helyi API-kiszolgáló | Az adatvédelemre összpontosító felhasználók, akik egyszerű, offline asztali csevegőrobotot szeretnének helyi dokumentumokkal | Ingyenes csomag elérhető; a fizetős csomagok ára 40 USD/felhasználó/hónap-tól kezdődik. |

| LM Stúdió | Modell felfedezés és letöltés, csevegőfelület és helyi RAG, OpenAI kompatibilis szerver vagy REST API, előre beállított értékek és teljesítményoptimalizálás | Fejlesztők és tapasztalt felhasználók, akik egy kifinomult offline modell munkaállomást szeretnének | Ingyenes |

| Ollama | Egy parancsmodell, helyi REST API streaminggel, Modelfiles újrafelhasználható konfigurációkhoz és beágyazások RAG-csővezetékekhez | Fejlesztők, akik egy CLI-first helyi futtatási környezetet szeretnének, erős API réteggel | Ingyenes csomag elérhető; fizetős csomagok 20 dollártól/hó |

| Jan. ai | ChatGPT-stílusú offline felhasználói felület, asszisztensek és MCP-támogatás, bővítmények a további funkciókhoz, valamint opcionális OpenAI-kompatibilis szolgáltatók | Nem technikai felhasználók, akik egy tiszta, testreszabható offline asszisztenst szeretnének | Ingyenes és nyílt forráskódú |

| Llamafile | Egyetlen futtatható modellcsomagolás, hordozható terjesztés az operációs rendszerek között, helyi szerver mód webes felhasználói felülettel és API-val, minimális függőségű futtatási környezet | Azok a felhasználók, akik egy telepítés nélküli, hordozható AI fájlt szeretnének, amelyet bárhol futtathatnak. | Ingyenes és nyílt forráskódú |

| PrivátGPT | Saját szerveren futó dokumentumbeolvasás és indexelés, offline RAG Q&A, dokumentumok szerinti kontextusszűrés, moduláris LLM és vektortároló stack | Olyan csapatok, amelyeknek offline kérdésekre és válaszokra van szükségük a belső fájlokhoz, ellenőrizhető RAG-folyamatokkal. | Ingyenes és nyílt forráskódú |

| Suttogás. cpp | Helyi beszéd-szöveg átalakítás, kvantált modellek az erőforrás-felhasználás csökkentése érdekében, VAD támogatás, opcionális FFmpeg kezelés több formátumhoz | Azok a felhasználók, akiknek teljes mértékben offline átírásra van szükségük, amelyet beágyazhatnak az alkalmazásokba. | Ingyenes és nyílt forráskódú |

| Szöveggenerálás webes felhasználói felület | Böngészőalapú felhasználói felület helyi modellekhez, Jinja2 prompt sablonok, generációs vezérlők, csevegés elágazás és üzenetszerkesztés | Azok a felhasználók, akik maximális testreszabást szeretnének egy helyi webes felületen | Ingyenes és nyílt forráskódú |

| llama.cpp | Nagy teljesítményű következtető motor, széles kvantálási támogatás, helyi szerver OpenAI-stílusú végpontokkal, beágyazásokkal és újrarangsorolási támogatással | Egyedi offline AI alkalmazásokat vagy háttérrendszereket fejlesztő fejlesztők | Ingyenes és nyílt forráskódú |

Hogyan értékeljük a szoftvereket a ClickUp-nál?

Szerkesztői csapatunk átlátható, kutatásokon alapuló és gyártóktól független folyamatot követ, így biztos lehet benne, hogy ajánlásaink a termékek valós értékén alapulnak.

Íme egy részletes áttekintés arról, hogyan értékeljük a szoftvereket a ClickUpnál.

Mit kell keresni a legjobb offline működő AI eszközökben?

Az offline AI-eszközök értékelése technikai és zavarosnak tűnhet, ami oda vezethet, hogy olyan eszközt választasz, amely esetleg nem is fut a számítógépeden. A legfontosabb szempont, amit figyelembe kell venni, az, hogy mit akarsz elérni. Egy AI-alapú alkalmazást fejlesztő programozónak egészen más igényei vannak, mint valakinek, aki csak egy privát, offline AI-csevegőrobotot szeretne írási segítségként.

Az értékelés legfontosabb kritériumai a következők:

- Könnyű beállítás: Technikai ismeretekre és parancssori munkára van szükség, vagy egyszerű, egy kattintással elvégezhető telepítésről van szó?

- Modellválasztás: Könnyen választhat a sokféle modell közül, vagy csak néhány közül?

- Adatvédelmi garanciák: Az eszköz minden adatot helyileg feldolgoz, vagy vannak rejtett felhőalapú komponensek?

- Hardverkövetelmények: Jól fog működni a jelenlegi gépen, vagy frissítésre van szükség?

- Integrációs képességek: Csatlakoztatható más eszközeihez, vagy teljesen önálló alkalmazásról van szó?

- Alkalmazási eset: Általános csevegésre, dokumentumokkal kapcsolatos kérdések feltevésére, hangfelvételek átírására vagy kód generálására tervezték?

A 10 legjobb offline működő AI eszköz

Íme egy áttekintés a legjobb offline AI eszközökről 👇

1. ClickUp (A legjobb megoldás a feladatok, dokumentumok és AI-kontextusok egyetlen helyen történő tárolására offline és online munkavégzés során)

A ClickUp, a világ első konvergens AI munkaterülete, az „offline AI” elemeire épül, amely nem áll meg a válasz generálásánál. Ennek oka, hogy továbbra is szükség van egy helyre, ahol ez a kimenet döntéssé, feladattá és következő lépéssé válik, és nem tűnik el a fájlok és csevegések között.

És ellentétben sok offline beállítással, amelyek hosszú telepítési folyamatot és eszközök összekapcsolását igénylik, a ClickUp egy helyen biztosít teljes végrehajtási réteget, ahol az AI ugyanazon munkaterületi kontextuson dolgozik.

Először is, ott van a ClickUp offline mód, amely automatikusan bekapcsol és folytatja a munkát, ha offline tevékenység történik. Ez azt jelenti, hogy minden feladatod, emlékeztetőid és jegyzeted offline állapotban is elérhető marad, és szükség esetén továbbiakat is hozzáadhat. Amint újra csatlakozol, az új feladatok és emlékeztetők automatikusan szinkronizálódnak a munkaterületeddel (búcsút inthetsz a kontextus elvesztésének 👋).

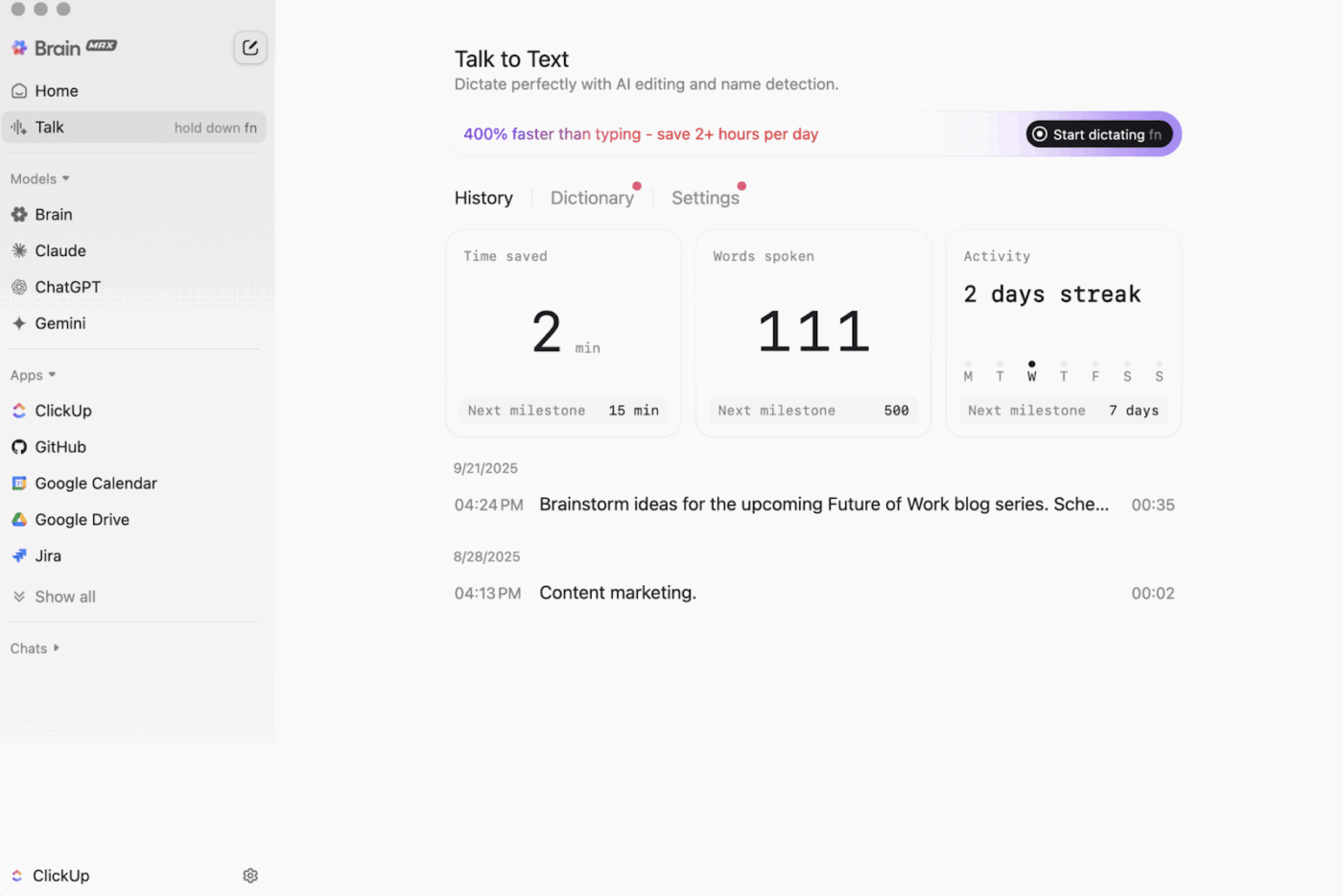

Aztán ott van még a ClickUp Brain MAX , az adatvédelmet előtérbe helyező asztali AI-társ, amely az egész munkaterületen, a csatlakoztatott alkalmazásokban és akár az interneten is képes tárolni és keresni.

A Talk-to-Text funkcióval a Brain MAX kéz nélkül képes átalakítani a hangodat szöveggé. Ez magában foglalja e-mailek megírását, dokumentumok szerkesztését vagy gyors frissítések rögzítését, miközben úton vagy.

A Brain MAX emellett univerzális mesterséges intelligenciát is kínál, amely a legújabb mesterséges intelligencia modellekkel való csevegéshez lett kifejlesztve, például kódolás, írás, komplex érvelés és egyebek céljára. Ez azt jelenti, hogy egy helyen tehetsz fel kérdéseket a legjobb mesterséges intelligencia modelleknek, beleértve a ClickUp Brain-t és olyan opciókat, mint az OpenAI, a Claude és a Gemini, anélkül, hogy eszközöket kellene váltogatnod.

Ráadásul a ClickUp Security olyan védelmi funkciókat is kínál, amelyeket az offline eszközök gyakran kihagynak. Gondoljon csak a titkosításra, a részletes jogosultságokra és az adminisztrátori ellenőrzésekre, mint például az SSO, a provisioning és az audit naplózás, amelyek mind olyan csapatok számára lettek kifejlesztve, amelyeknek vállalati szintű biztonságra van szükségük.

A ClickUp AI Knowledge Management nagy segítséget nyújt az „offline-ról online-ra” való átállásban. Ezzel a csapatod egy központi helyet kap, ahol különböző forrásokat tárolhat a Docs és a wikikben, majd a ClickUp Brain segítségével azonnali válaszokat kaphat az egész munkaterületről, így a munka folytatásakor a megfelelő kontextus már rendelkezésre áll.

🎬 Ügynökök akcióban: Használja a Super Agents szolgáltatást, hogy a szinkronizált munkát következő lépésekre váltsa!

A ClickUp Super Agents mesterséges intelligenciával működő csapattagok, amelyeket létrehozhat és testreszabhat, hogy több lépésből álló munkafolyamatokat futtasson a ClickUp munkaterületén belül. Konfigurálhatja a konkrét kiváltókat, utasításokat és eszközhozzáféréseket, hogy biztosítsa, hogy azok a megadott határokon belül működjenek.

Például, miután az offline feladatok visszaszinkronizálódtak, egy szuperügynök átnézheti az új elemeket, összefoglalhatja a változásokat, kidolgozhatja a teendőket, elkészítheti a frissítés tervezetét, és továbbíthatja azt a megfelelő tulajdonosnak ellenőrzésre.

Mivel a Super Agents szabályozható, engedélyekkel szabályozhatja, hogy mire férhetnek hozzá, és ellenőrizheti, mit csinálnak. 🔐

A ClickUp legjobb funkciói

- Találjon meg bármit az eszközei között: A ClickUp Enterprise Search segítségével egyetlen helyről rendezheti és kereshet az egész munkaterületén, valamint a csatlakoztatott alkalmazásokban.

- Építsen fel egy valódi tudásbázist: Hozzon létre wikiket és dokumentációkat a ClickUp Docs segítségével, beágyazott oldalak, sablonok, AI-támogatás és egyéb funkciók felhasználásával.

- Tartsa összekapcsolva a halmazát: Szinkronizálja munkáját olyan eszközökkel, mint a Slack és a GitHub, anélkül, hogy elhagyná a ClickUp-ot a ClickUp Integrations segítségével.

- Egyedi munkafolyamatok létrehozása: Használja a ClickUp API-t személyes tokenekkel vagy OAuth 2. 0-val a testreszabott automatizálások és integrációk megvalósításához.

- Automatizálja a feladatsorát: Indítson el műveleteket, például tulajdonosok kijelölését, állapotok frissítését vagy átadások elindítását a feladatok változásai alapján a ClickUp Automations segítségével.

A ClickUp korlátai

- A funkciók széles skálája miatt egyes felhasználóknak tanulási görbével kell szembenézniük.

ClickUp árak

ClickUp értékelések és vélemények

- G2: 4,7/5 (több mint 10 000 értékelés)

- Capterra: 4,6/5 (több mint 4000 értékelés)

Mit mondanak a ClickUp-ról a valódi felhasználók?

A G2 egyik recenzensének véleménye:

Agilis táblák, integrációk és testreszabás. Tetszik az is, hogy offline állapotban is folytathatom a munkát. Ezenkívül e-maileket küldhetek bármelyik listára, és automatikusan létrehozhatók a feladatok. A szövegszerkesztő fantasztikus, MD módban és gyorsbillentyűkkel is működik, így a tartalom előnézete is megtekinthető.

Agilis táblák, integrációk és testreszabás. Tetszik az is, hogy offline állapotban is folytathatom a munkát. Ezenkívül e-maileket küldhetek bármelyik listára, és automatikusan létrehozhatók a feladatok. A szövegszerkesztő fantasztikus, MD módban és gyorsbillentyűkkel is működik, és lehetővé teszi a tartalom inline előnézetét.

2. GPT4All (A legjobb magáncélú, offline AI csevegéshez helyi LLM-ekkel)

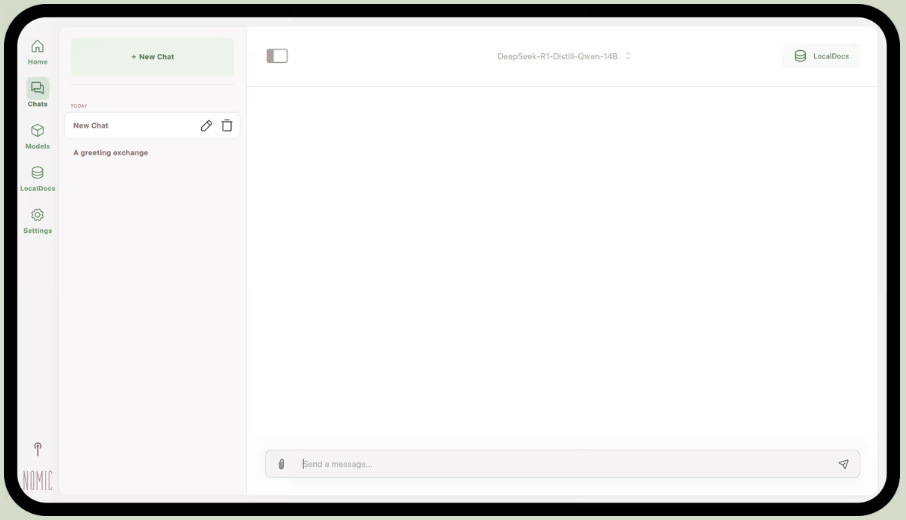

A Nomic.ai részét képező GPT4All egy asztali alkalmazás, amely lehetővé teszi, hogy nyílt forráskódú nagy nyelvi modelleket futtasson közvetlenül a számítógépén, így internet-hozzáférés vagy felhőalapú API-hívások nélkül is cseveghet egy AI-asszisztenssel. Azok számára készült, akik „helyi elsőbbségű” beállítást szeretnének, ahol a parancsok, válaszok és fájlok a készüléken maradnak.

Legjobb funkciója a LocalDocs, amely egyfajta visszakereséssel kiegészített generálást használ, hogy privát módon cseveghess a saját dokumentumaiddal. Az alkalmazást egy PDF-ekből vagy szövegfájlokból álló mappára irányíthatod, és az létrehoz egy helyi tudásbázist, amelynek kérdéseket tehetsz fel.

A GPT4All tartalmaz egy válogatott könyvtárat is olyan népszerű modellekből, mint a Llama és a Mistral, amelyeket közvetlenül az alkalmazáson keresztül lehet letölteni.

A GPT4All legjobb funkciói

- Indítson el egy helyi API-kiszolgálót (OpenAI-kompatibilis), hogy más alkalmazásokban és automatizálásokban is használhassa a GPT4All modelleket.

- Keresés, összehasonlítás és letöltés GGUF modellek az alkalmazáson belül, olyan rendezési lehetőségekkel, mint a lájkolások, letöltések és feltöltés dátuma.

- Állítsa be a kontextus hosszát, a maximális kimeneti hosszúságot, a top-p, top-k, ismétlési büntetést, a CPU szálakat, és akár a GPU réteg terhelésének csökkentését is (plusz Metal támogatás Apple Silicon rendszereken).

A GPT4All korlátai

- A teljesítmény nagymértékben függ a számítógép hardverétől.

- A nagy dokumentumgyűjtemények indexelése lassú lehet.

GPT4All árak

- Ingyenes asztali alkalmazás

- Üzleti: 40 dollár felhasználónként havonta (Nomic AI)

- Vállalat: Egyedi árazás (Nomic AI)

GPT4All értékelések és vélemények

- G2: Nincs elég értékelés

- Capterra: Nincs elég értékelés

Mit mondanak a valódi felhasználók a GPT4All-ról?

Egy Reddit-felhasználó azt mondja:

Ez a legjobb, amit a RAG-gal kipróbáltam, minden másnál jobb, még az LM Studio-nál is egyszerűbb. Tetszik, hogy egy mappához rendelhető, és nyomon követi és kezeli a változásokat. Még korai stádiumban van, mint a többi, de rövid távon ez lesz az alapértelmezett programom.

Ez a legjobb, amit a RAG-gal kipróbáltam, minden másnál jobb, még az LM Studio-nál is egyszerűbb. Tetszik, hogy egy mappához rendelhető, és nyomon követi és kezeli a változásokat. Még korai stádiumban van, mint a többi, de rövid távon ez lesz az alapértelmezett programom.

📮 ClickUp Insight: A felmérésünkben résztvevők 88%-a használja az AI-t személyes feladatokhoz, azonban több mint 50% nem meri használni a munkahelyén. A három fő akadály? A zökkenőmentes integráció hiánya, a tudáshiány vagy a biztonsági aggályok. De mi lenne, ha az AI be lenne építve a munkaterületébe, és már eleve biztonságos lenne? ClickUp Brain,

A ClickUp beépített AI asszisztense ezt valósággá teszi. Megérti a közönséges nyelven megfogalmazott utasításokat, megoldva ezzel az AI bevezetésével kapcsolatos mindhárom aggályt, miközben összekapcsolja a csevegést, a feladatokat, a dokumentumokat és a tudást a munkaterületen. Egyetlen kattintással találhat válaszokat és betekintést!

3. LM Studio (A legjobb választás egy kifinomult offline modell munkaállomáshoz, teljesítmény-optimalizálással)

az LM Studio-n keresztül

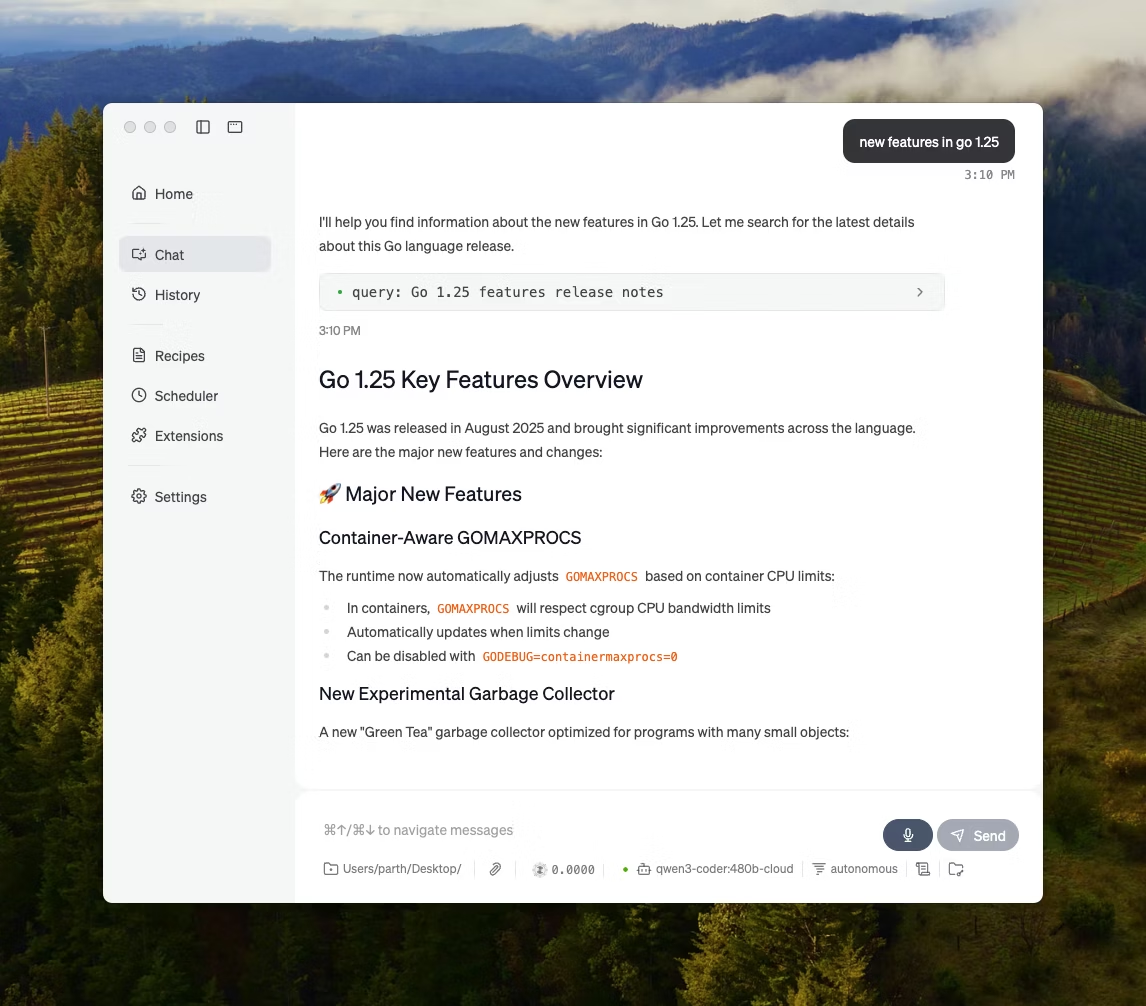

Az LM Studio egy helyi AI asztali alkalmazás, amelynek célja nyílt forráskódú modellek keresése, tesztelése és futtatása egy felhasználói felületen, anélkül, hogy terminálra lenne szükség. Kísérletezésre van kihegyezve, például modell kiválasztására, helyi futtatására, valamint a parancsok és beállítások iterálására, szorosabb visszacsatolási ciklussal, mint a legtöbb CLI-alapú beállítás.

Támogatja a dokumentumokkal való teljesen offline csevegést (helyi RAG) is, ahol fájlokat csatolhat a beszélgetéshez, és válaszai során hivatkozhat rájuk. Ez ideális offline kutatásokhoz, tanulási jegyzetekhez vagy belső dokumentumokhoz, ahol a feltöltés nem lehetséges.

Az LM Studio emellett részletes ellenőrzést biztosít az AI működése felett, hőmérséklet, kontextus hossza és GPU-használat beállítási lehetőségekkel.

Az LM Studio legjobb funkciói

- Használja az OpenAI kompatibilitási módot vagy az LM Studio saját REST API-ját, attól függően, hogy az alkalmazás milyen funkciókat vár el.

- Az LM Studio JavaScript és Python SDK opciókat is kínál a modellek tetején helyi munkafolyamatok létrehozásához.

- Mentse el a rendszer parancsot + paramétereket előre beállítottként, majd használja újra a csevegésekben (az előre beállítottakat fájlból/URL-ből is importálhatja, és az LM Studio Hubon keresztül megoszthatja).

LM Studio korlátozások

- Az LM Studio lefagyaszthatja a számítógépet a DeepSeek R1 32B futtatása közben.

- Egyes felhasználók az alkalmazást adatbiztonsági és adatvédelmi szempontból aggályosnak tartják, mivel a forráskód nem ellenőrizhető.

LM Studio árak

- Ingyenes otthoni és munkahelyi használatra

LM Studio értékelések és vélemények

- G2: Nincs elég értékelés

- Capterra: Nincs elég értékelés

Mit mondanak az LM Studio-ról a valódi felhasználók?

Egy Reddit-felhasználó azt mondja:

Nagyszerű. Egyszerűen működik, nagyon könnyű elindítani. A legszebb felhasználói felülettel rendelkezik az összes versenytárs közül.

Nagyszerű. Egyszerűen működik, nagyon könnyű elindítani. A legszebb felhasználói felülettel rendelkezik az összes versenytárs közül.

4. Ollama (a legjobb egyszerű CLI + helyi szerverrel futó helyi LLM-ekhez)

Az Ollama egy helyi modellfutó, amely inkább LLM futtatóként viselkedik, mint önálló csevegőalkalmazásként. Terminál-elsőbbségű, úgy tervezték, hogy gyors parancsokkal (például ollama run llama3) nyissa meg és futtassa a nyílt modelleket, majd egy helyi szolgáltatáson keresztül tegye azokat elérhetővé más interfészek számára.

Az Ollama erőssége a REST API-ban rejlik. Miután az Ollama a háttérben fut, bármely alkalmazás egyszerű HTTP-kérésekkel kommunikálhat vele. Ez segít az AI-funkciók beépítésében a saját szoftverébe.

Az Ollama egy népszerű modellekből álló könyvtárat is kínál, amely egy parancs segítségével letölthető, és egyedi modellkonfigurációkat is létrehozhat, amelyek hasonlóak az AI Dockerfájlokhoz.

Az Ollama legjobb tulajdonságai

- Hozzon létre újrafelhasználható, verziózható modellrecepteket (alapmodell kiválasztás, prompt sablonok, rendszerüzenetek, paraméterek, adapterek) a Modelfile segítségével.

- Futtassa a modelleket olyan végpontokon keresztül, mint a csevegés/generálás, opcionális streaminggel az alkalmazásokban és szkriptekben történő valós idejű token kimenethez.

- Ollama beágyazási képességeinek és ajánlott beágyazási modelljeinek segítségével generáljon beágyazásokat a szemantikai keresés és visszakeresés folyamataihoz.

Ollama korlátai

- Nincs beépített grafikus felülete, ezért a nem technikai felhasználóknak külön frontend eszközre lesz szükségük.

- Az Ollama macOS asztali alkalmazása offline állapotban nem reagálhat, még akkor sem, ha a modellek már letöltésre kerültek, míg a CLI továbbra is működik.

Ollama árak

- Ingyenes

- Előny: 20 dollár/hónap

- Maximális összeg: 100 dollár/hónap

Ollama értékelések és vélemények

- G2: Nincs elég értékelés

- Capterra: Nincs elég értékelés

Mit mondanak az Ollama-ról a valódi felhasználók?

A Producthunt egyik kritikusának véleménye:

Könnyen telepíthető és kezelhető. Az Ollama megkönnyíti a helyi LLM-ek futtatását. Az OpenWebUI-val párosítva a legjobb élményt nyújtja.

Könnyen telepíthető és kezelhető. Az Ollama megkönnyíti a helyi LLM-ek futtatását. Az OpenWebUI-val párosítva a legjobb élményt nyújtja.

🧠 Érdekesség: A beszéd-szöveggé alakítás kezdetben csak számok esetében működött. A Bell Labs AUDREY (1952) rendszere a 0–9 számokat ismerte fel, és egy beszámoló szerint a legjobban akkor működött, ha a feltalálója mondta ki a számokat.

5. Jan. ai (A legjobb offline, adatvédelmet előtérbe helyező ChatGPT-stílusú asszisztens)

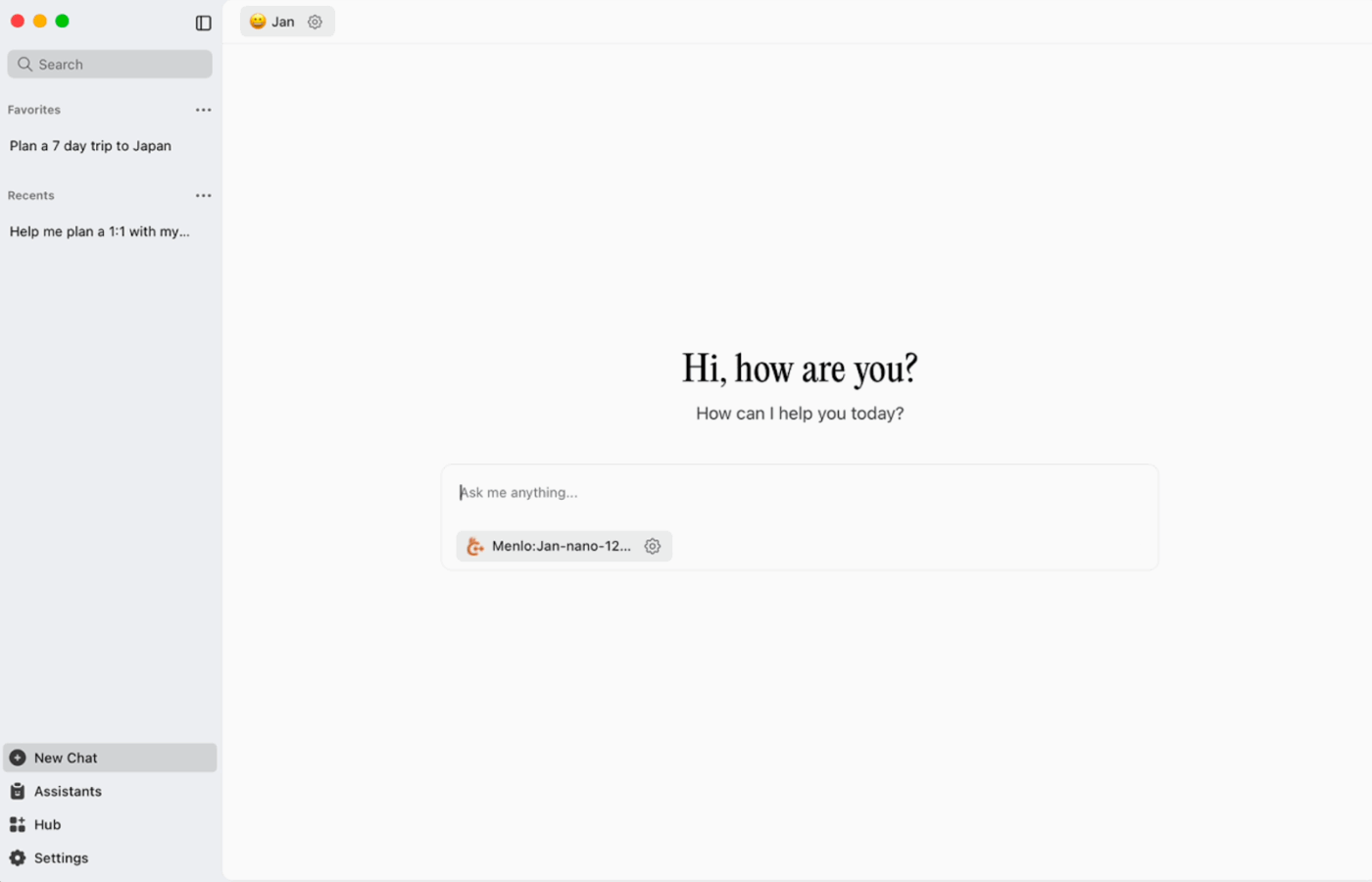

A Jan. ai egy nyílt forráskódú asztali asszisztens, amely ChatGPT-hez hasonló csevegési élményt nyújt macOS, Windows és Linux rendszereken, alapértelmezés szerint elsősorban helyi használatra. Akkor fut a készüléken, amikor Ön azt szeretné, míg a beszélgetési előzmények és a használati adatok helyileg tárolódnak, és nem kerülnek ki a számítógépéről.

Támogatja a nyílt forráskódú modellek helyi futtatását, és opcionális csatlakozást is lehetővé tesz távoli szolgáltatókhoz, például OpenAI-kompatibilis API-khoz, ami rugalmasságot biztosít, ha az offline használat a prioritás, de néha szükség van felhőalapú hozzáférésre is.

Jan. ai legjobb tulajdonságai

- Hozzon létre asszisztenseket saját utasításaikkal és beállításaikkal, majd váltson közöttük az Asszisztensek fülön, ahelyett, hogy minden alkalommal újraírná a parancsokat.

- Csatlakoztassa a Jan-t az MCP eszközökhöz és adatforrásokhoz egy nyílt szabvány segítségével, amely az eszközhasználati stílusú munkafolyamatokhoz lett kialakítva.

- Telepítsen kiterjesztéseket új funkciók, például webes keresés vagy kódértelmező hozzáadásához. Ez a moduláris megközelítés lehetővé teszi, hogy egyszerűen kezdje, és fokozatosan bővítse a rendszer teljesítményét.

Jan. ai korlátozások

- Jan lehetővé teheti egy még nem teljesen letöltött modellfájl betöltését, ami zavaró vagy következetlen viselkedést eredményezhet, amíg a fájl nem lesz teljes.

- Az API bekapcsolása zavarhatja a szálas csevegéseket, és az alapvető végpontok, mint például a „betöltött modell lekérése” vagy a „modell cseréje” nem biztos, hogy zökkenőmentesen működnek.

Január ai árazás

- Nyílt forráskód

Január ai értékelések és vélemények

- G2: Nincs elég értékelés

- Capterra: Nincs elég értékelés

Mit mondanak a valós felhasználók a Jan. ai-ról?

Egy Reddit-felhasználó azt mondja:

Jan. ai az én kedvenc helyi LLM alkalmazásom. Nagyszerű.

Jan. ai az én kedvenc helyi LLM alkalmazásom. Nagyszerű.

6. Llamafile (a legjobb megoldás LLM-ek hordozható végrehajtható fájlokba csomagolásához)

A Llamafile egy Mozilla által vezetett projekt, amely egy teljes nyílt forráskódú LLM-et egyetlen végrehajtható fájlba csomagol. A futtatási környezet telepítése, a függőségek kezelése vagy egy különálló felhasználói felület összekapcsolása helyett egyetlen fájlt kell letölteni, és azt alkalmazásként futtatni.

A központi ötlet a terjesztés. A „llamafile” tartalmazza a modell súlyait és egy összeállított futási környezetet, amely minimális beállítással több operációs rendszeren is futtatható. Ez különösen akkor hasznos, ha egy offline eszközt kell megosztani olyan csapattagokkal, diákokkal vagy ügyfelekkel, akik nem foglalkoznak a telepítéssel kapcsolatos problémák megoldásával.

A Llamafile legjobb funkciói

- A Llamafile a llama.cpp-t és a Cosmopolitan Libc-t ötvözi, hogy széles körű bináris hordozhatóságot biztosítson, csökkentve ezzel a platformspecifikus csomagolási munkát.

- A szerver mód webes grafikus felhasználói felületet és OpenAI API-kompatibilis kiegészítési végpontot biztosít, ami hasznos a helyi alkalmazásfejlesztéshez és a felhőalapú hívások kicseréléséhez tesztelés közben.

- A csomagolt llamafájlok úgy lettek kialakítva, hogy a szokásos x86_64 és ARM64 gépeken futtathatók legyenek, ami egyszerűbbé teszi a vegyes flották közötti terjesztést.

A Llamafile korlátai

- A modellválasztás csak a Llamafile formátumban csomagoltakra korlátozódik.

- A fájlok mérete nagyon nagy, mivel a teljes modell be van ágyazva.

Llamafile árak

- Ingyenes és nyílt forráskódú

Llamafile értékelések és vélemények

- G2: Nincs elég értékelés

- Capterra: Nincs elég értékelés

🧠 Érdekesség: Az első weboldal még mindig megtekinthető. A CERN szó szerint az info.cern.ch címen tárolja, és „az első weboldal otthonának” nevezi.

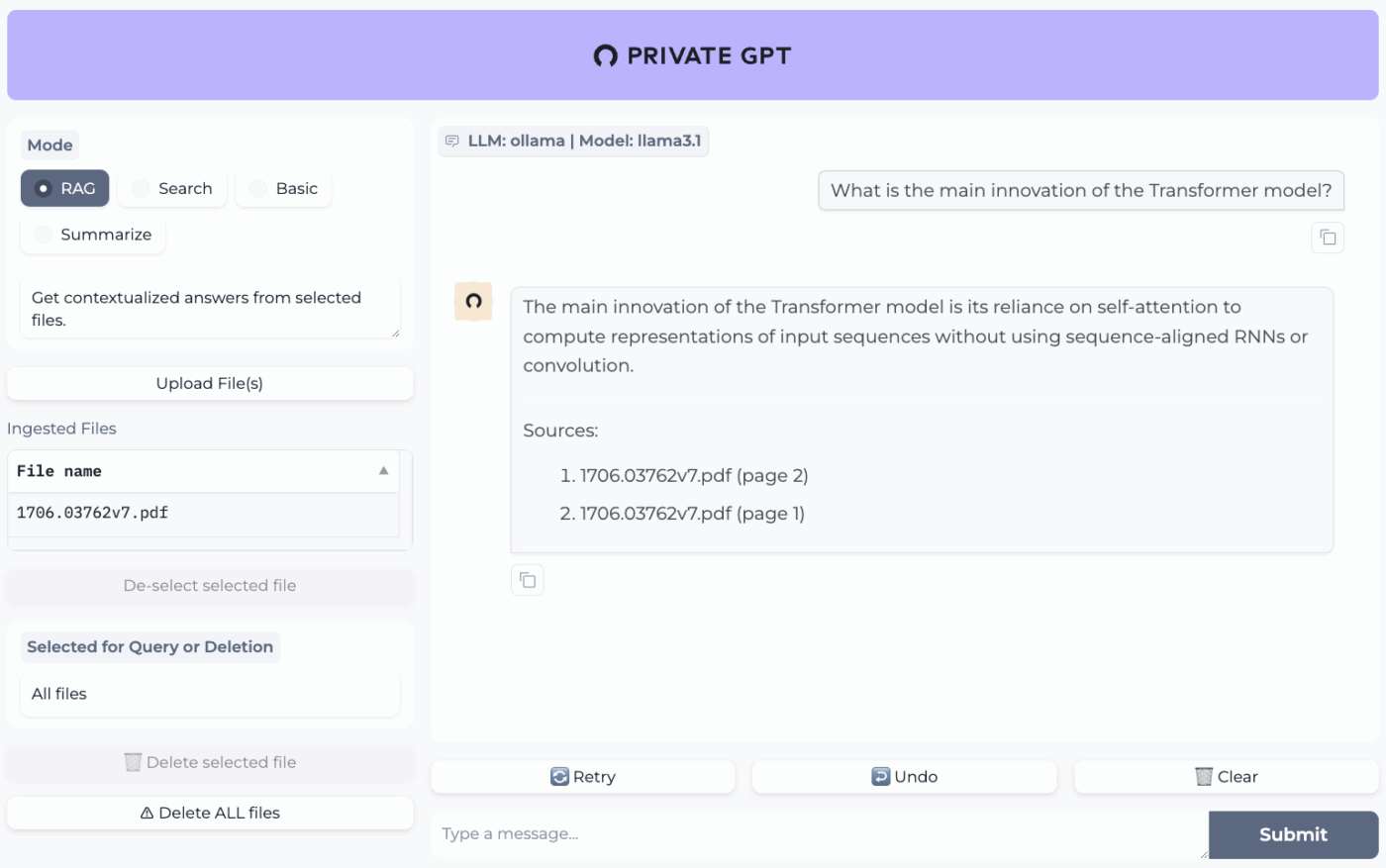

7. PrivateGPT (A legjobb megoldás offline kérdések és válaszok kezelésére a fájlok felett, saját hosztolt RAG-stack segítségével)

A PrivateGPT egy termeléskész, saját hosztolt projekt, amelyet „csevegés a dokumentumaiddal” munkafolyamatokhoz fejlesztettek ki. Beolvassa a helyi fájlokat, indexeli őket, és kérdésekre válaszol úgy, hogy a saját tartalmadból nyeri ki a releváns kontextust, ahelyett, hogy egy felhőalapú csevegőrobot memóriájára támaszkodna. A projekt úgy lett kialakítva, hogy teljes mértékben offline módban futtatható legyen, azzal az ígérettel, hogy az adatok a végrehajtási környezetedben maradnak.

Ami megkülönbözteti az általános célú offline csevegőalkalmazásoktól, az a moduláris felépítés. Más szavakkal, a hardver és az adatvédelmi korlátozások alapján kombinálhatja az LLM-et, a beágyazási szolgáltatót és a vektortárat, majd mindent egy helyi API + UI mögött futtathat.

A PrivateGPT legjobb funkciói

- PDF, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, képek (JPG/PNG/JPEG) és akár MP3/MP4 fájlok beolvasása a beépített beolvasási csatorna segítségével.

- Rétegkonfigurációs profilok PGPT_PROFILES-szel (például local,cuda) több beállításfájl egyesítéséhez és a telepítések váltásához az alapkonfiguráció átírása nélkül.

- A kontextus-kiegészítések végpontjainak hívásakor a context_filter segítségével szűrje a beolvasott dokumentumok egy adott részhalmazára adott válaszokat.

PrivateGPT korlátozások

- Több komponens egyidejű futtatása miatt magasabb hardverkövetelményekkel rendelkezik.

- Több dokumentum egyetlen fájlból történő beolvasása (például egy PDF, amely oldalanként egy dokumentumot generál) növelheti az indexelés mennyiségét és komplexitását nagy méretű fájlok kezelése esetén.

PrivateGPT árak

- Nyílt forráskód

PrivateGPT értékelések és vélemények

- G2: Nincs elég értékelés

- Capterra: Nincs elég értékelés

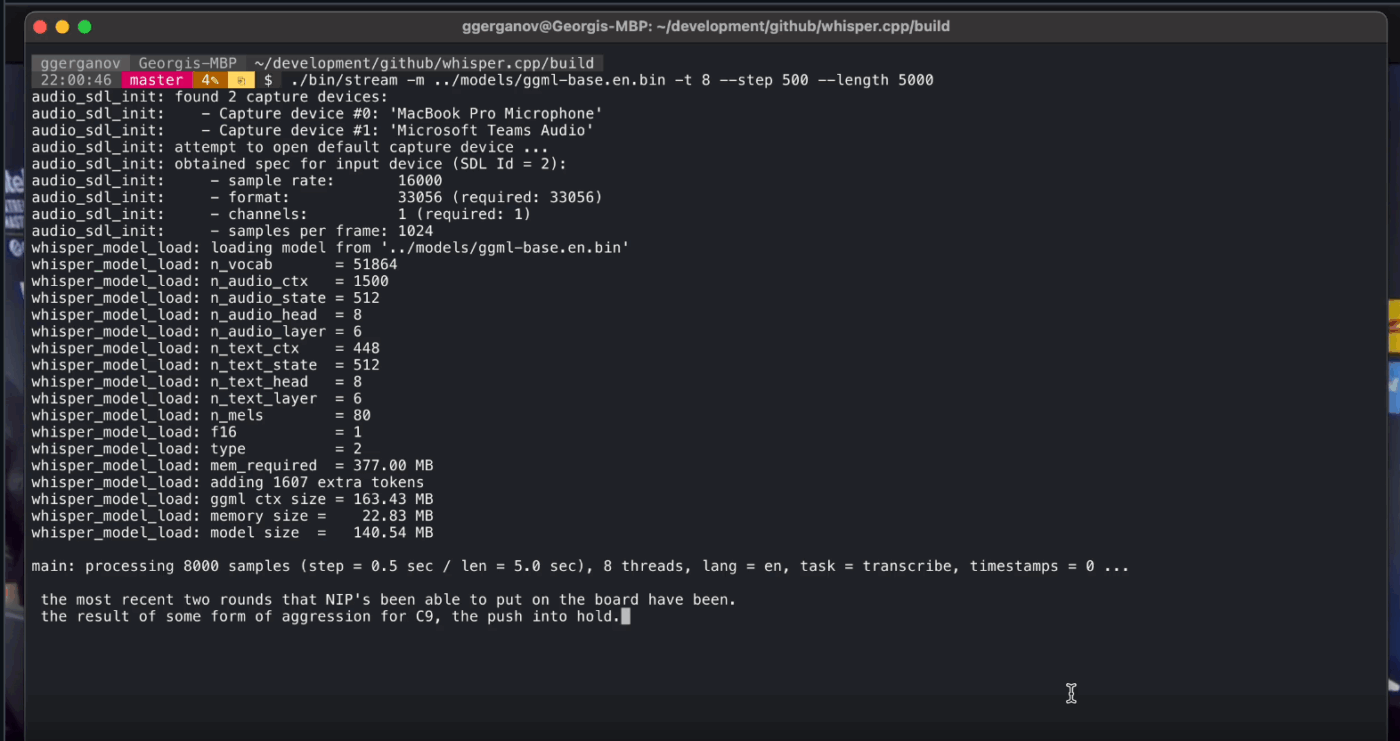

8. Whisper. cpp (A legjobb teljesen offline beszéd-szöveggé alakításhoz, amelyet alkalmazásokba ágyazhat)

A Whisper.cpp az OpenAI Whisper automatikus beszédfelismerő modelljének nagy teljesítményű C/C++ implementációja, amelyet úgy alakítottak ki, hogy helyi szinten, nagy teljesítményű futási függőségek nélkül futtatható legyen. Népszerű offline átírási folyamatokban, ahol kicsi, hordozható bináris fájlra vagy C-stílusú könyvtárra van szükség, amelyet a saját termékbe be lehet építeni.

Emellett rugalmasan alkalmazható különböző környezetekben, hivatalos támogatást nyújtva asztali számítógépek, mobil eszközök, WebAssembly, Docker és akár Raspberry Pi-osztályú hardverek számára is, ami alkalmassá teszi olyan offline eszközökhöz, amelyeket több helyen is futtatni kell.

A névben szereplő „cpp” betűk a teljesítményre való összpontosítást jelzik. Ez a megvalósítás lényegesen gyorsabb és kevesebb memóriát használ, mint a Python-alapú alternatívák, így modern számítógépeken is lehetővé teszi a valós idejű átírást, anélkül, hogy nagy teljesítményű GPU-ra lenne szükség.

Whisper. cpp legjobb funkciói

- Futtassa a hangaktivitás-érzékelést (VAD) a projekt részeként a beszéd szegmentálása és a zajos, üres hangfelvételek csökkentése érdekében a streaming stílusú munkafolyamatokban.

- A Whisper modellek kvantálása a lemez- és memóriaigény csökkentése érdekében, több kvantálási opcióval a gyorsabb helyi következtetés érdekében

- Építsd be az opcionális FFmpeg támogatást Linuxra, hogy az alapvető WAV-formátumon túl más bemeneti formátumokat is kezelni tudj.

Whisper. cpp korlátozások

- A Whisper.cpp CLI alapértelmezés szerint 16 bites WAV bemeneteket vár, ami MP3, MP4, M4A vagy más gyakori formátumok esetén egy további konvertálási lépést jelent.

- Nem jelöli meg natívan a beszélőket (diarizálás), ami megnehezíti a több beszélővel készült felvételek idézeteinek helyes hozzárendelését.

Whisper. cpp árak

- Nyílt forráskód

Whisper. cpp értékelések és vélemények

- G2: Nincs elég értékelés

- Capterra: Nincs elég értékelés

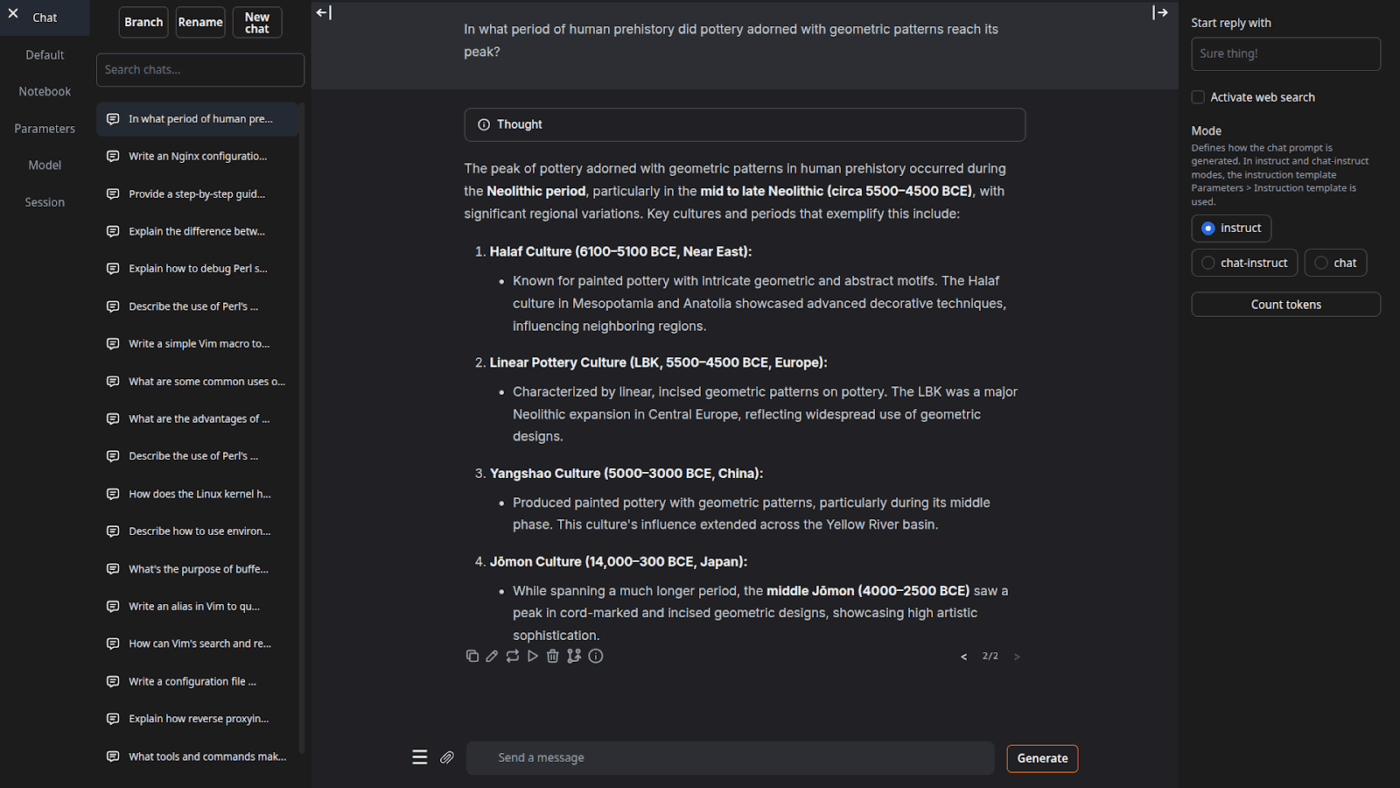

9. Text Generation Web UI (Legalkalmasabb azoknak a felhasználóknak, akik böngészőalapú vezérlőpultot szeretnének a helyi LLM-ekhez)

A Text Generation Web UI (gyakran „oobabooga” néven emlegetett) egy Gradio-alapú webes felület helyi modellek futtatására, amely nagy hangsúlyt fektet a vezérlésre és a kísérletezésre. Inkább egy teljes munkaállomásként viselkedik: több modell-háttérprogrammal, több interakciós móddal és számos generálási viselkedést szabályozó gombbal rendelkezik.

Emellett olyan „író/fejlesztő” munkafolyamatokat is támogat, amelyeket sok offline eszköz kihagy, például a prompt-formátum automatizálását, a jegyzetfüzet-stílusú generálást és a beszélgetés elágazásait. Azoknál az offline beállításoknál, amelyek még mindig webes felhasználói felületet igényelnek, ez az egyik legjobban konfigurálható frontend ebben a kategóriában.

A Text Generation Web UI legjobb funkciói

- Automatikus prompt formázás Jinja2 sablonok használatával, csökkentve a prompt formátum hibáit a különböző modellcsaládok között

- Több tucat beállítást módosíthat, hogy az AI kimenetét az Ön egyedi igényeihez igazítsa, legyen szó kreatív írásról, kódolásról vagy szerepjátékról.

- Üzenetszerkesztés verzió navigációval és beszélgetés elágazással, ugyanazon csevegés több irányának megőrzése újrakezdés nélkül

Szöveggenerálás Webes felhasználói felület korlátai

- Az egy kattintással telepíthető program ~10 GB lemezterületet igényel, és letölti a PyTorch programot, ami miatt a telepítés tárolókapacitás-korlátozott gépeken nehézkesnek tűnik.

- Az OpenAI-kompatibilis beágyazási végpont a sentence-transformers/all-mpnet-base-v2-t használja 768 dimenziós beágyazásokkal, ami megdöntheti az OpenAI 1536 dimenziós alapértelmezései köré épített folyamatok feltételezéseit.

Szöveggenerálás webes felhasználói felület árazása

- Nyílt forráskód

Szöveggenerálás Web UI értékelések és vélemények

- G2: Nincs elég értékelés

- Capterra: Nincs elég értékelés

10. Llama. cpp (A legjobb nagy teljesítményű helyi LLM-következtetéshez CPU-n és GPU-n)

A Llama. cpp egy C/C++ következtető motor és eszközkészlet, amely minimális függőségekkel és kiváló teljesítménnyel teszi lehetővé az LLM-ek helyi futtatását számos különböző hardveren. Ez nem annyira egy „csevegőalkalmazás”, mint inkább egy helyi futtatókörnyezet, amelyben munkafolyamatokat építhetünk, legyen az CLI, helyi HTTP-kiszolgáló vagy a saját termékünkbe beágyazott könyvtár.

Bár nem végfelhasználói alkalmazás, a Llama.cpp az a motor, amely a listán szereplő számos eszközt működteti, beleértve a GPT4All és az LM Studio programokat is. Bevezette a GGUF modellformátumot, amely hatékonyan csökkenti a modellek méretét, és így a fogyasztói hardverekkel való nagy modellek futtatásának szabványává vált.

Emellett népszerű programozási nyelvekhez, például Pythonhoz és Rusthoz is kínál kötéseket, szerver módja pedig OpenAI-kompatibilis API-t biztosít.

Llama. cpp legjobb tulajdonságai

- Indítson el egy OpenAI API-kompatibilis helyi szervert beépített webes felhasználói felülettel és /v1/chat/completions végponttal a llama-server segítségével.

- Futtasson beágyazási modellt (és akár újrarangsorolási modellt is) ugyanarról a szerverről offline RAG-csővezetékekhez az /embedding és /reranking parancsok használatával.

- A modelleket 1,5 bitről 8 bitre kvantálja, hogy csökkentse a memóriahasználatot és felgyorsítsa a helyi következtetést, majd CUDA/Metal és Vulkan/SYCL háttérprogramokkal gyorsítja a futtatásokat, ha azok rendelkezésre állnak.

Llama. cpp korlátozások

- A Llama.cpp nem egy kiforrott asztali segédprogramként kerül forgalomba, ami azt jelenti, hogy az offline használat gyakran CLI parancsokat vagy a llama-server futtatását igényli, és sok felhasználó a mindennapi csevegéshez harmadik féltől származó felhasználói felületekre támaszkodik.

- A Llama.cpp OpenAI-kompatibilitása nem mindig 1:1 minden OpenAI-ügyfélfunkcióval, és a felhasználók eltéréseket jelentenek a strukturált kimeneti paraméterek körül, mint például a response_format a /v1/chat/completions-ben.

Llama. cpp árak

- Nyílt forráskód

Mit mondanak a valódi felhasználók a Llama.cpp-ről?

A Sourceforge egyik recenzensének véleménye:

Fantasztikus. Az AI demokratizálása mindenki számára. És remekül működik!

Fantasztikus. Az AI demokratizálása mindenki számára. És remekül működik!

Az offline AI-kimenetek valódi munkává alakítása a ClickUp segítségével

A megfelelő offline AI eszköz kiválasztása valójában arról szól, hogy az eszköz illeszkedjen a feladathoz.

Ha itt vagy, akkor valószínűleg három dolgot szeretnél optimalizálni: a magánélet védelmét, az internetfüggőség megszüntetését és azt, hogy ne legyél újabb előfizetéshez kötve.

A listán szereplő eszközök különböző módon teljesítik ezt a feladatot. Vagyis egyesek íráshoz és kódoláshoz, mások kereséshez, jegyzeteléshez vagy kreatív munkához alkalmasabbak.

A csapatok számára azonban a nagyobb kihívás nem csupán az AI helyi futtatása. Hanem az AI eredményeinek valódi munkafolyamatokká alakítása.

A ClickUp mesterséges intelligenciájának segítségével, amely beépül a feladatokba, dokumentumokba és tudásbázisba, könnyedén megtervezheti a következő lépéseket ugyanazon a helyen, ahol a munka folyik (mindezt vállalati szintű biztonsággal).

Próbáld ki ingyen a ClickUp-ot, és nézd meg, milyen az, amikor az AI és a végrehajtás végre együtt működik. ✨

Gyakran feltett kérdések az offline AI eszközökről

Igen, a modellfájlok első letöltése után sok AI-eszköz teljes mértékben a készüléken futtatható, internetkapcsolat nélkül. Ezért ideálisak érzékeny adatok kezelésére vagy rossz internetkapcsolattal rendelkező helyeken való munkavégzésre.

A helyi LLM-ek az összes adatot a személyes eszközön dolgozzák fel, így az adatok soha nem hagyják el a gépet, míg a felhőalapú mesterséges intelligencia a parancsokat távoli szerverekre küldi feldolgozásra. A helyi eszközök általában a beállítás után ingyenesen használhatók, míg a felhőalapú mesterséges intelligencia gyakran előfizetési díjakkal jár, de erőteljesebb modelleket kínálhat.

A kisebb, 1-3 milliárd paraméterrel rendelkező modellek a legtöbb modern, 8 GB RAM-mal rendelkező laptopon futtathatók. A nagyobb, nagyobb teljesítményű, 7 milliárd vagy több paraméterrel rendelkező modellek 16 GB vagy annál több RAM-mal és dedikált GPU-val működnek a legjobban, az Apple Silicon Mac számítógépek és az NVIDIA GPU-k pedig jelentős teljesítménynövekedést biztosítanak.

![A 10 legjobb AI eszköz, amely [év]ben offline is működik](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)