Поверителността е основно човешко право. И тази поверителност се отразява и във всички аспекти на съвременната изкуствена интелигентност. В доклад на Cisco 64% от хората се притесняват, че могат случайно да споделят чувствителна информация, когато използват инструменти за изкуствен интелект.

Това е една от причините за нарастващата популярност на офлайн AI инструментите. Когато моделът работи локално, можете да пишете, кодирате, обобщавате и създавате, без да качвате всичко в облака или да засядате, когато Wi-Fi връзката прекъсне.

В този списък ще разгледаме най-добрите AI инструменти, които работят офлайн, сред които е и супер приложение, което ви помага да организирате резултатите от тези инструменти в една цялостна и супер сигурна система.

Какво представляват офлайн AI инструментите?

Офлайн AI инструментите са софтуерни приложения, които изпълняват големи езикови модели (LLM) на вашето локално устройство, без да е необходима интернет връзка след изтеглянето на модела. Данните на модела се съхраняват директно на вашия компютър, така че цялата обработка или извличане на заключения се извършва на вашия собствен CPU или GPU.

Тази обработка на устройството има няколко основни предимства:

- Пълна поверителност на данните: Вашата чувствителна информация никога не напуска вашия компютър.

- Без периодични такси: След като вече разполагате с инструмента и модела, няма разходи за абонамент.

- Работи навсякъде: Можете да го използвате в самолет, в отдалечена хижа или по време на прекъсване на интернет връзката.

- Пълен контрол: Вие избирате кои модели да използвате и как да ги конфигурирате

Най-добрите офлайн AI инструменти на един поглед

Ето кратко резюме на най-добрите офлайн AI инструменти, които са налични днес.

| Име на инструмента | Основни характеристики | Най-подходящо за | Ценообразуване* |

| ClickUp | Офлайн режим за задачи и напомняния, ClickUp Brain MAX, който включва Talk-to-Text, Enterprise Search в свързани приложения, Docs и Knowledge Management, Automations, както и Integrations и API. | Екипи, които се нуждаят от офлайн заснемане, онлайн изпълнение, управление и AI контекст в едно работно пространство | Безплатно завинаги; Възможност за персонализиране за предприятия |

| GPT4All | Локален чат с отворени модели, LocalDocs за частни въпроси и отговори за документи, откриване и изтегляне на модели в приложението, локален API сървър, съвместим с OpenAI | Потребители, които държат на поверителността и искат прост офлайн чатбот за настолни компютри с локални документи | Наличен е безплатен план; Платените планове започват от 40 $/потребител/месец |

| LM Студио | Откриване и изтегляне на модели, чат интерфейс плюс локален RAG, сървър, съвместим с OpenAI, или REST API, предварителни настройки и оптимизиране на производителността | Разработчици и напреднали потребители, които искат усъвършенствана работна среда за офлайн моделиране | Безплатно |

| Оллама | Един команден модел, локален REST API със стрийминг, Modelfiles за повторно използваеми конфигурации и вграждания за RAG пипалини | Разработчици, които искат локална среда за изпълнение с CLI на първо място и силен API слой | Наличен е безплатен план; Платените планове започват от 20 $/месец |

| Януари ai | Офлайн потребителски интерфейс в стила на ChatGPT, асистенти и поддръжка на MCP, разширения за добавени възможности и опционални доставчици, съвместими с OpenAI. | Нетехнически потребители, които искат чист офлайн асистент с възможност за персонализиране | Безплатен и с отворен код |

| Llamafile | Единен изпълним модел на пакетиране, преносимо разпространение в различни операционни системи, локален сървър режим с уеб интерфейс и API, минимална зависимост при изпълнение | Потребители, които искат преносим AI файл без инсталиране, който могат да изпълняват навсякъде | Безплатен и с отворен код |

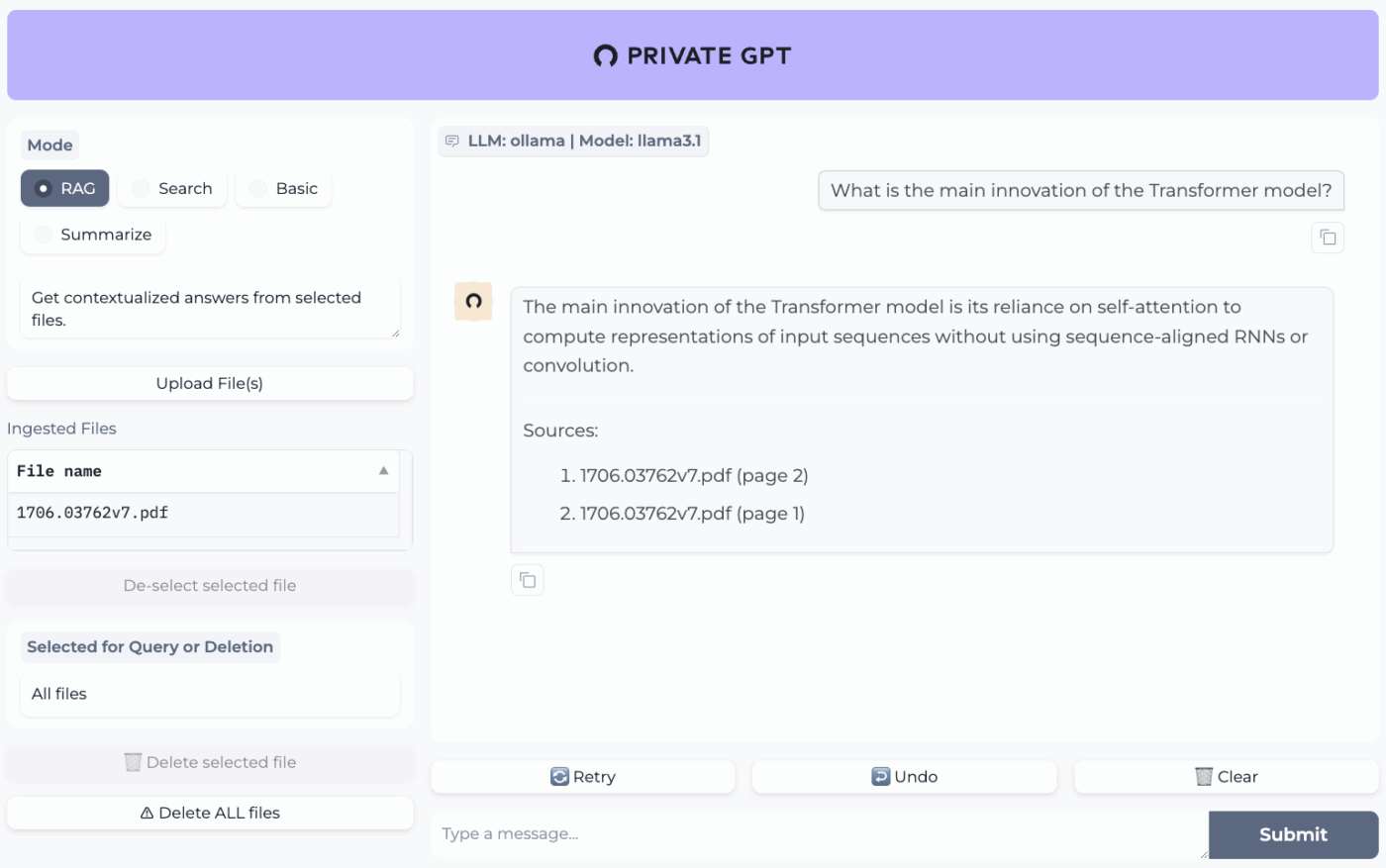

| PrivateGPT | Самостоятелно хостинг на документи и индексиране, офлайн RAG Q&A, филтриране по контекст на документи, модулен LLM и векторно хранилище | Екипи, които се нуждаят от офлайн въпроси и отговори по вътрешни файлове с контролируем RAG канал | Безплатен и с отворен код |

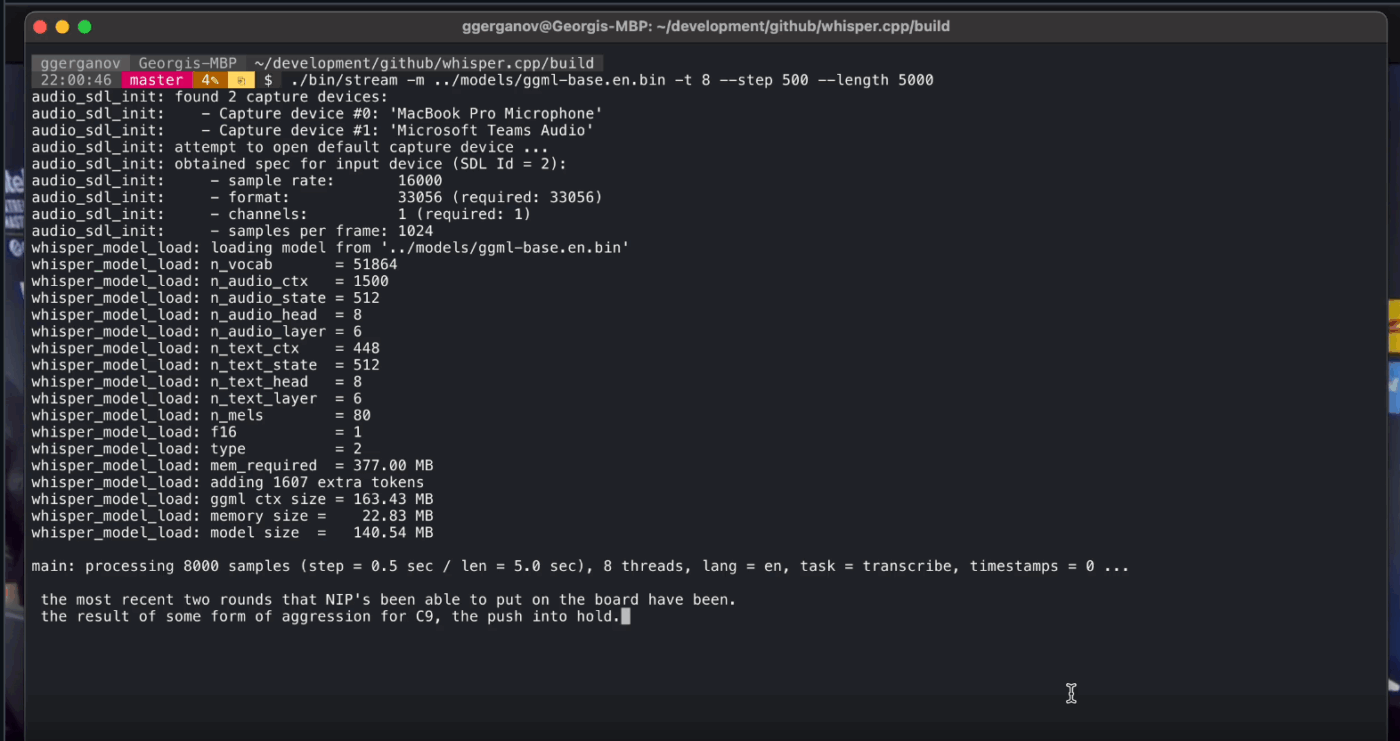

| Шепот. cpp | Локално преобразуване на реч в текст, квантизирани модели за по-ниска консумация на ресурси, поддръжка на VAD, опционална обработка с FFmpeg за повече формати | Потребители, които се нуждаят от напълно офлайн транскрипция, която могат да вградят в приложения | Безплатен и с отворен код |

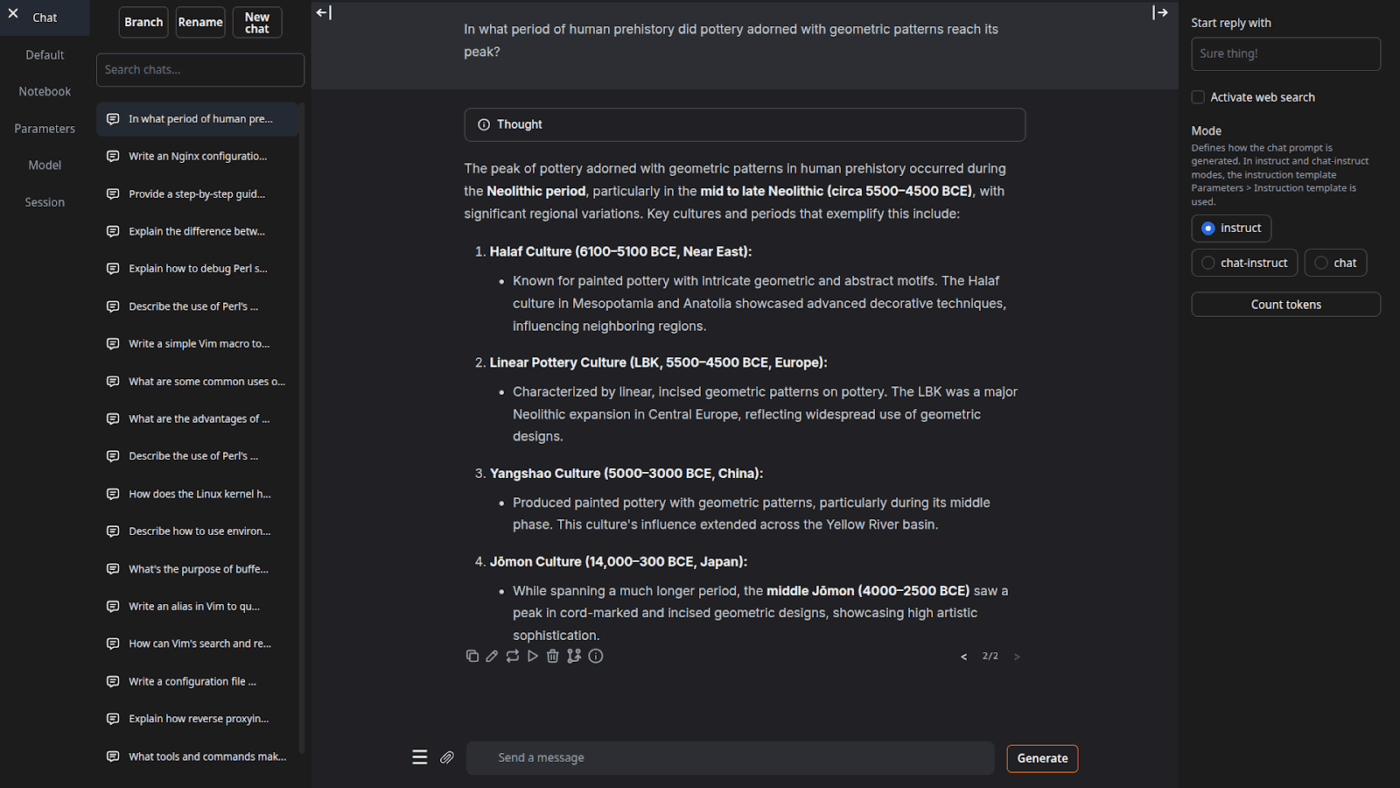

| Уеб интерфейс за генериране на текст | Браузър-базиран потребителски интерфейс за локални модели, Jinja2 шаблони за подсказки, контроли за генериране, разклоняване на чата и редактиране на съобщения | Потребители, които искат максимална персонализация в локален уеб интерфейс | Безплатен и с отворен код |

| lama.cpp | Високопроизводителен инферентен двигател, широка поддръжка на квантизация, локален сървър с крайни точки в стила на OpenAI, вграждане и поддръжка на прекласифициране | Разработчици, създаващи персонализирани офлайн AI приложения или бекенди | Безплатен и с отворен код |

Как преглеждаме софтуера в ClickUp

Нашият редакционен екип следва прозрачен, подкрепен с проучвания и независим от доставчиците процес, така че можете да сте сигурни, че нашите препоръки се основават на реалната стойност на продуктите.

Ето подробно описание на това как преглеждаме софтуера в ClickUp.

Какво да търсите в най-добрите AI инструменти, които работят офлайн

Оценяването на офлайн AI инструменти може да изглежда техническо и объркващо, което да ви накара да изберете инструмент, който може дори да не работи на вашия компютър. Най-важното, което трябва да имате предвид, е какво искате да постигнете. Разработчик, който създава приложение, задвижвано от AI, има много по-различни нужди от човек, който просто иска частен, офлайн AI чатбот за помощ при писане.

Ето основните критерии за оценка:

- Лесност на настройка: Изисква ли технически познания и работа с командния ред или е проста инсталация с едно кликване?

- Избор на модел: Можете ли лесно да избирате от голямо разнообразие от модели или сте ограничени до само няколко?

- Гаранции за поверителност: Инструментът обработва ли всички данни локално или има скрити компоненти в облака?

- Хардуерни изисквания: Ще работи ли добре на настоящия ви компютър или се нуждаете от ъпгрейд?

- Възможности за интеграция: Може ли да се свърже с другите ви инструменти или е напълно самостоятелно приложение?

- Подходящ случай на употреба: Предназначен ли е за общ чат, задаване на въпроси относно вашите документи, транскрибиране на аудио или генериране на код?

Топ 10 на най-добрите AI инструменти, които работят офлайн

Ето един общ преглед на най-добрите офлайн инструменти за изкуствен интелект 👇

1. ClickUp (Най-доброто решение за съхранение на задачи, документи и AI контекст на едно място при работа офлайн и онлайн)

ClickUp, първото в света конвергентно AI работно пространство, е изградено върху блокове от „офлайн AI“, което не спира до генерирането на отговор. Това е така, защото все още се нуждаете от място, където този резултат се превръща в решение, задача и следваща стъпка, която не изчезва в файлове и чатове.

И за разлика от много офлайн настройки, които изискват дълги инсталации и съединяване на инструменти, ClickUp ви предоставя цялостен слой за изпълнение на едно място, с изкуствен интелект, работещ в същия контекст на работната среда.

За начало, имате ClickUp Offline Mode, който се включва автоматично и поддържа работата, когато има офлайн активност. Това означава, че всички ваши задачи, напомняния и бележки остават достъпни, докато сте офлайн, с възможност да добавите още, ако е необходимо. Щом се свържете отново, новите задачи и напомняния се синхронизират автоматично с вашия Workspace (кажете сбогом на загубата на контекст 👋).

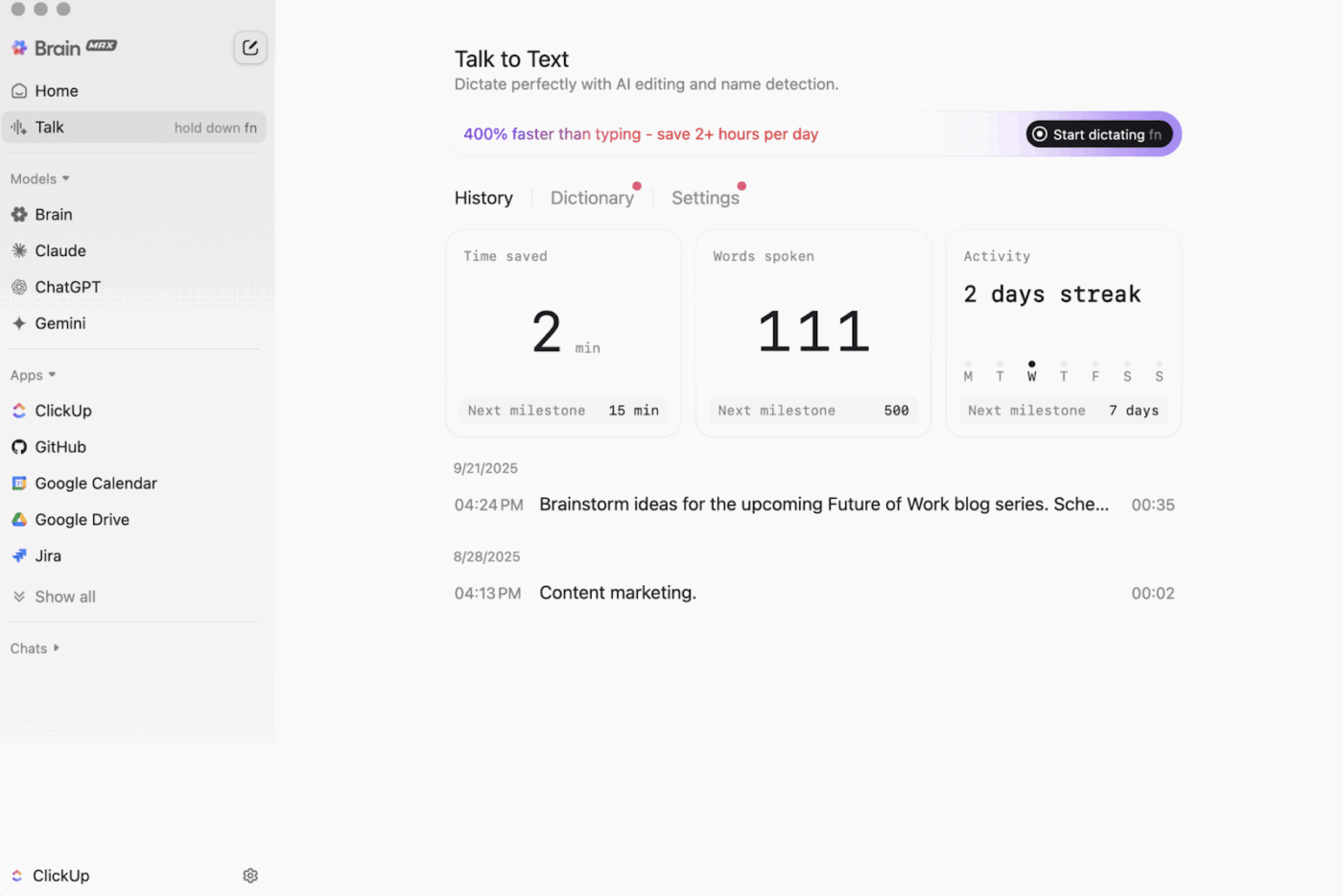

След това има ClickUp Brain MAX , десктоп AI спътник, който поставя на първо място поверителността и може да съхранява и търси информация в цялото ви работно пространство, свързаните приложения и дори в интернет.

С Talk-to-Text в комбинацията, Brain MAX може да преобразува гласа ви в текст без да използвате ръцете си. Това включва изготвяне на имейл, писане на документ или записване на бърза актуализация, докато сте в движение.

Brain MAX ви предоставя и Universal AI, създаден за чат с най-новите AI модели за кодиране, писане, сложно разсъждение и др. Това означава, че можете да задавате въпроси на най-добрите AI модели на едно място, включително ClickUp Brain плюс опции като OpenAI, Claude и Gemini, без да се налага да превключвате между инструментите.

Нещо повече, ClickUp Security добавя предпазни мерки, които офлайн инструментите често пропускат. Помислете за криптиране, детайлни разрешения и административни контроли като SSO, провижининг и аудит логове, всички проектирани за екипи, които се нуждаят от сигурност на корпоративно ниво.

ClickUp AI Knowledge Management помага значително при преминаването от „офлайн към онлайн“. То предоставя на вашия екип център за съхранение на различни ресурси в Docs и уикита, след което използва ClickUp Brain, за да извлича незабавни отговори от цялото ви работно пространство, така че правилният контекст да е наличен в момента, в който работата бъде възобновена.

🎬 Агенти в действие: Използвайте Super Agents, за да превърнете синхронизираната работа в следващи стъпки!

ClickUp Super Agents са съотборници, задвижвани от изкуствен интелект, които можете да създавате и персонализирате, за да изпълняват многоетапни работни процеси във вашата работна среда ClickUp. Можете да конфигурирате конкретни тригери, инструкции и достъп до инструменти, за да се уверите, че те действат в рамките на зададените от вас граници.

Например, след като офлайн задачите се синхронизират обратно, супер агентът може да сканира новите елементи, да обобщи промените, да изведе стъпките за действие, да изготви актуализация и да я изпрати на правилния собственик за преглед.

И тъй като Super Agents са управляеми, можете да контролирате достъпа им с разрешения и да проверявате действията им. 🔐

Най-добрите функции на ClickUp

- Намерете всичко в инструментите си: Сортирайте и търсете в цялото си работно пространство, както и в свързаните приложения, от едно място с ClickUp Enterprise Search.

- Създайте истинска база от знания: Създавайте уикита и документация с ClickUp Docs, като използвате вложени страници, шаблони, AI-помощ и др.

- Поддържайте връзката между вашите проекти: Синхронизирайте работата си с инструменти като Slack и GitHub, без да напускате ClickUp, благодарение на интеграциите на ClickUp.

- Създавайте персонализирани работни процеси: Използвайте API на ClickUp с лични токени или OAuth 2. 0, за да активирате персонализирани автоматизации и интеграции.

- Автоматизирайте вашия стек: Задействайте действия като присвояване на собственици, актуализиране на статуси или стартиране на предаване на задачи въз основа на промени в задачите с ClickUp Automations.

Ограничения на ClickUp

- Поради широкия набор от функции, някои потребители може да се сблъскат с трудности при усвояването им.

Цени на ClickUp

Оценки и отзиви за ClickUp

- G2: 4. 7/5 (над 10 000 отзива)

- Capterra: 4,6/5 (над 4000 отзива)

Какво казват реалните потребители за ClickUp?

Един рецензент от G2 казва:

Адаптивни табла, интеграции и персонализиране. Освен това ми харесва факта, че мога просто да премина в офлайн режим и да продължа да работя по задачите. В допълнение, мога да изпращам имейли до всеки от списъците и задачите се създават автоматично. Текстовият редактор е страхотен, работи както в MD режим, така и с бързи клавиши, което ви позволява да визуализирате съдържанието в реално време.

Адаптивни табла, интеграции и персонализиране. Освен това ми харесва факта, че мога просто да премина в офлайн режим и да продължа да работя по задачите. В допълнение, мога да изпращам имейли до всеки от списъците и задачите се създават автоматично. Текстовият редактор е страхотен, работи както в MD режим, така и с бързи клавиши, което ви позволява да визуализирате съдържанието в реално време.

2. GPT4All (Най-доброто за частен, офлайн AI чат с локални LLM)

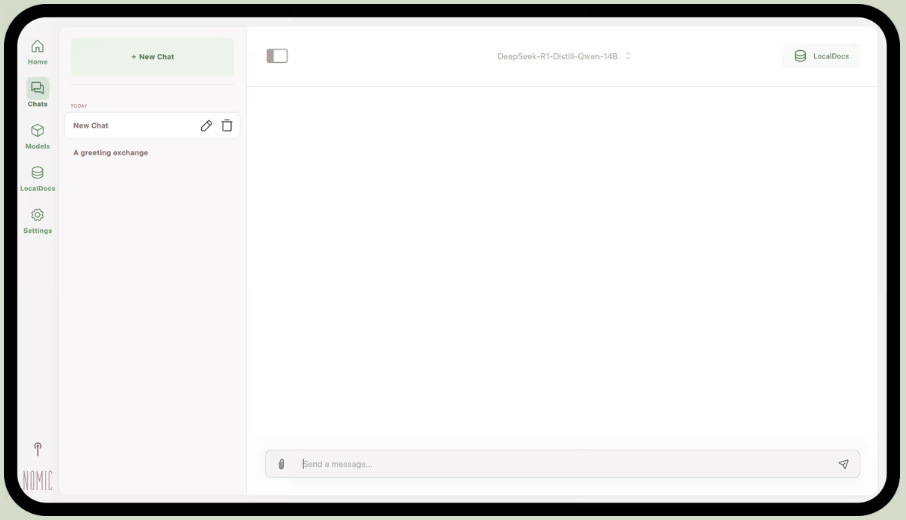

Част от Nomic.ai, GPT4All е настолна програма, която ви позволява да изпълнявате отворени езикови модели директно на вашия компютър, така че да можете да чатите с AI асистент, без да разчитате на интернет достъп или облачни API повиквания. Тя е създадена за хора, които искат „локална“ настройка, при която подсказките, отговорите и файловете остават на устройството.

Най-добрата му функция е LocalDocs, която използва форма на генериране, подсилено с извличане, за да ви позволи да чатите с вашите документи насаме. Можете да насочите приложението към папка с PDF файлове или текстови файлове и то ще създаде локална база от знания, на която можете да задавате въпроси.

GPT4All включва и подбрана библиотека с популярни модели като Llama и Mistral, които можете да изтеглите директно чрез приложението.

Най-добрите функции на GPT4All

- Стартирайте локален API сървър (съвместим с OpenAI), за да използвате моделите на GPT4All в други приложения и автоматизации.

- Търсете, сравнявайте и изтегляйте модели GGUF от приложението, с опции за сортиране като харесвания, изтегляния и дата на качване.

- Настройка на дължината на контекста, максималната дължина на изхода, top-p, top-k, наказание за повторение, CPU нишки и дори разтоварване на GPU слоя (плюс Metal поддръжка на Apple Silicon)

Ограничения на GPT4All

- Производителността зависи в голяма степен от хардуера на вашия компютър.

- Индексирането на големи колекции от документи може да бъде бавно

Цени на GPT4All

- Безплатно приложение за настолни компютри

- Бизнес: 40 долара на потребител на месец (Nomic AI)

- Предприятие: Персонализирано ценообразуване (Nomic AI)

GPT4All оценки и рецензии

- G2: Недостатъчно отзиви

- Capterra: Недостатъчно отзиви

Какво казват реалните потребители за GPT4All?

Един потребител на Reddit казва:

Това е най-доброто, което съм пробвал с RAG, превъзхожда всичко, дори LM Studio по простота. Харесва ми начинът, по който го свързваш с папка, а то проследява и обработва промените за теб. Все още е в начален етап на развитие, както и останалите, но това ще бъде моят избор по подразбиране в краткосрочен план.

Това е най-доброто, което съм пробвал с RAG, превъзхожда всичко, дори LM Studio по простота. Харесва ми начинът, по който го свързваш с папка, а то проследява и обработва промените за теб. Все още е в начален етап на развитие, както и останалите, но това ще бъде моят избор по подразбиране в краткосрочен план.

📮 ClickUp Insight: 88% от участниците в нашето проучване използват изкуствен интелект за личните си задачи, но над 50% се въздържат да го използват в работата си. Кои са трите основни пречки? Липса на безпроблемна интеграция, пропуски в знанията или опасения за сигурността. Но какво ще стане, ако изкуственият интелект е вграден в работното ви пространство и вече е сигурен? ClickUp Brain,

Вграденият AI асистент на ClickUp прави това възможно. Той разбира команди на обикновен език, решавайки и трите проблема, свързани с внедряването на AI, като същевременно свързва вашите чатове, задачи, документи и знания в цялото работно пространство. Намерете отговори и информация с едно кликване!

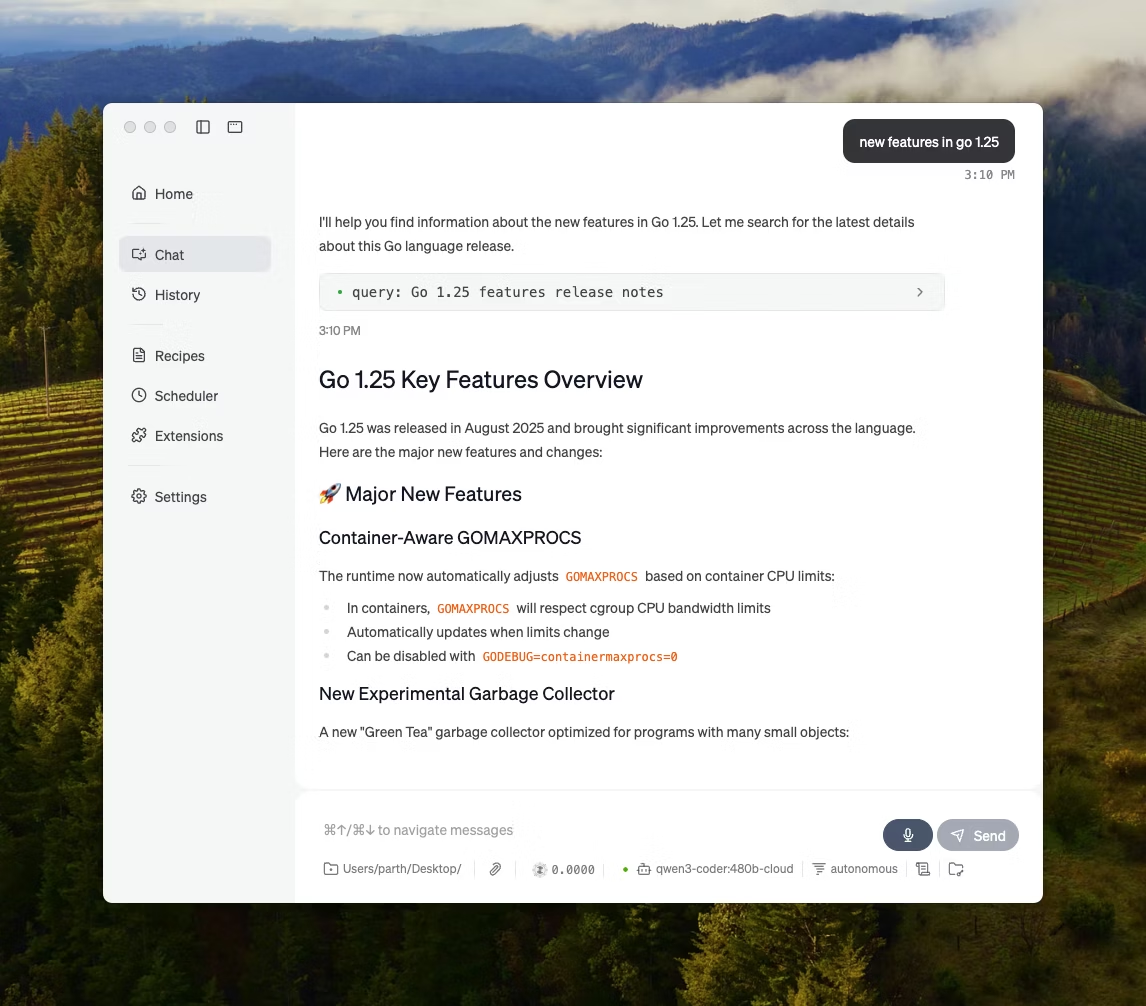

3. LM Studio (Най-подходящ за изпипан офлайн модел работен плот с настройка на производителността)

чрез LM Studio

LM Studio е локално AI приложение за настолни компютри, създадено с цел намиране, тестване и изпълняване на модели с отворен код в потребителски интерфейс, без да е необходимо да се разчита на терминал. То е насочено към експериментиране, като избор на модел, изпълняването му локално и повтаряне на команди и настройки с по-тясна обратна връзка, отколкото при повечето CLI-първи настройки.

Той поддържа и чат с документи изцяло офлайн (локален RAG), където можете да прикачвате файлове към разговор и да се позовавате на тях в отговорите си. Това го прави идеален за офлайн проучвания, бележки за учене или вътрешни работни потоци с документи, където качването на файлове не е възможно.

LM Studio ви дава и подробен контрол върху работата на изкуствения интелект, с опции за настройка на температурата, дължината на контекста и използването на графичния процесор.

Най-добрите характеристики на LM Studio

- Използвайте режим на съвместимост с OpenAI или собствения REST API на LM Studio, в зависимост от това, което очаква вашето приложение.

- LM Studio предлага както JavaScript, така и Python SDK опции за изграждане на локални работни процеси върху вашите модели.

- Запазете системно подсказване + параметри като предварителна настройка, след което го използвайте отново в чатове (предварителните настройки могат да бъдат импортирани от файл/URL и публикувани за споделяне чрез LM Studio Hub)

Ограничения на LM Studio

- LM Studio може да блокира компютъра при работа с DeepSeek R1 32B

- Някои потребители сигнализират за приложението като проблем за сигурността на данните и поверителността поради неаудитиран затворен код.

Цени на LM Studio

- Безплатно за домашна и служебна употреба

Оценки и рецензии за LM Studio

- G2: Недостатъчно отзиви

- Capterra: Недостатъчно отзиви

Какво казват реалните потребители за LM Studio?

Един потребител на Reddit казва:

Страхотно е. Просто работи, супер лесно е да се стартира. Има най-красивия потребителски интерфейс от всички конкуренти.

Страхотно е. Просто работи, супер лесно е да се стартира. Има най-красивия потребителски интерфейс от всички конкуренти.

4. Ollama (Най-подходящ за изпълнение на локални LLM с прост CLI + локален сървър)

Ollama е локален модел, който се държи по-скоро като LLM runtime, отколкото като самостоятелно чат приложение. Той е терминално ориентиран, проектиран да изтегля и изпълнява отворени модели с бързи команди (като ollama run llama3), след което да ги показва чрез локална услуга, върху която могат да се наслагат други интерфейси.

Силата на Ollama се крие в REST API. Щом Ollama започне да работи на заден план, всякакви приложения могат да комуникират с него чрез прости HTTP заявки. Това помага за вграждането на AI функции във вашия софтуер.

Ollama предлага и библиотека с популярни модели, които могат да бъдат изтеглени с една команда, а вие можете да създавате персонализирани конфигурации на модели, които са подобни на Dockerfiles за AI.

Най-добрите характеристики на Ollama

- Създайте многократно използваеми, версионируеми модели рецепти (избор на базов модел, шаблони за подсказки, системни съобщения, параметри, адаптери) с помощта на Modelfile.

- Изпълнявайте модели чрез крайни точки като чат/генериране с опционално стрийминг за изход на токени в реално време в приложения и скриптове.

- Генерирайте вграждания за семантично търсене и извличане на данни, използвайки възможностите за вграждане на Ollama и препоръчаните модели за вграждане.

Ограничения на Ollama

- Той няма вграден графичен интерфейс, така че потребителите без технически познания ще се нуждаят от отделен инструмент за работа с него.

- Приложението Ollama за macOS може да не отговаря, когато е офлайн, дори когато моделите вече са изтеглени, докато CLI продължава да работи.

Цени на Ollama

- Безплатно

- Предимство: 20 долара на месец

- Максимум: 100 долара на месец

Оценки и рецензии за Ollama

- G2: Недостатъчно отзиви

- Capterra: Недостатъчно отзиви

Какво казват реалните потребители за Ollama?

Рецензентът на Producthunt казва:

Лесно внедряване и управление. Ollama улеснява работата с локални LLM. Комбинирайте го с OpenWebUI за най-доброто преживяване.

Лесно внедряване и управление. Ollama улеснява работата с локални LLM. Комбинирайте го с OpenWebUI за най-доброто преживяване.

🧠 Интересен факт: Преобразуването на реч в текст започна като „само цифри“. AUDREY (1952) на Bell Labs разпознаваше цифрите от 0 до 9, а според един отчети тя работеше най-добре, когато беше произнасяна от нейния изобретател.

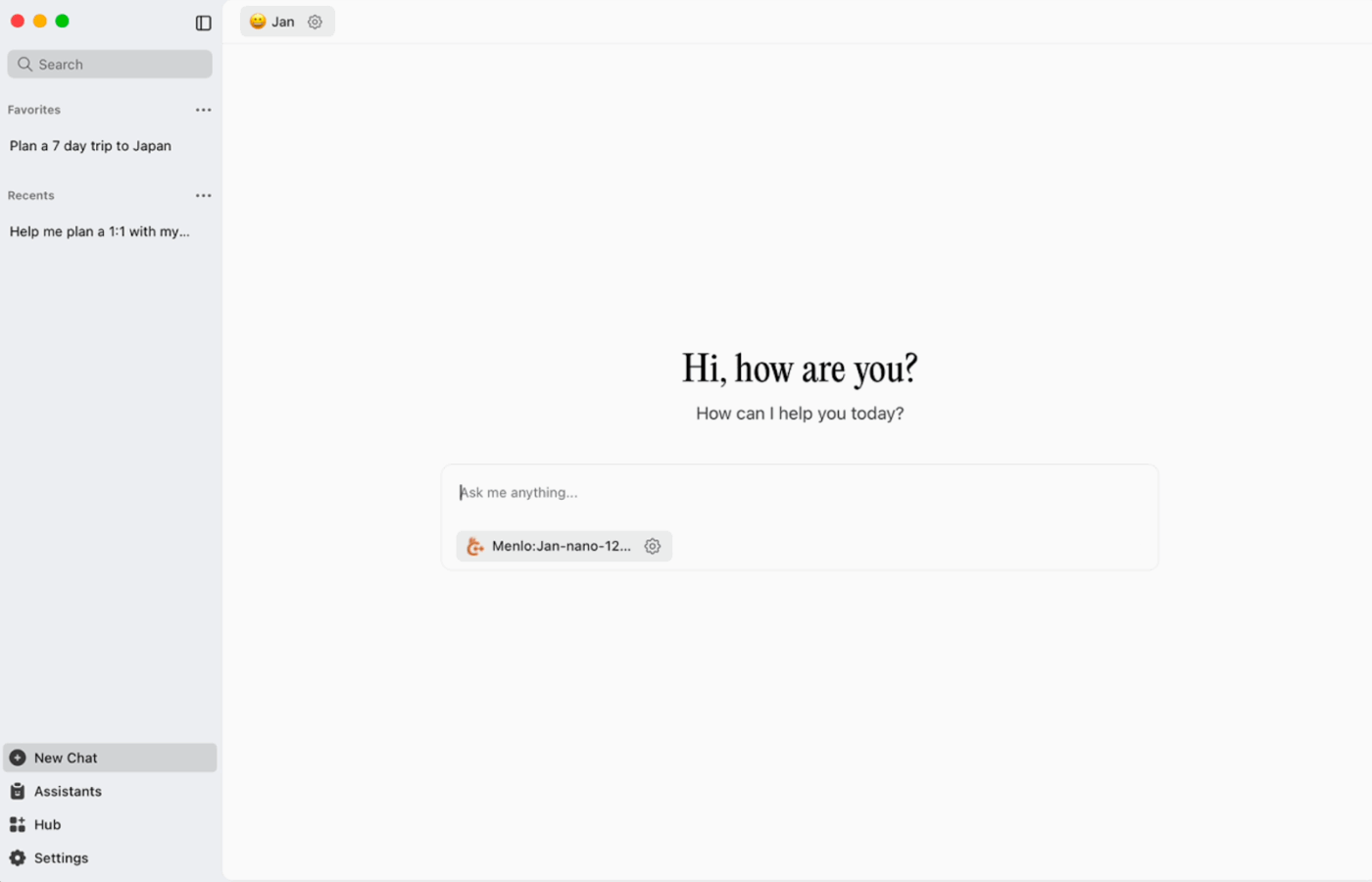

5. Jan. ai (Най-доброто за офлайн асистент от типа ChatGPT, при който на първо място е поставена поверителността)

Jan. ai е отворен софтуер за настолни компютри, който предлага чат опит, подобен на ChatGPT, за macOS, Windows и Linux, като по подразбиране се използва локално. Той работи на устройството, когато пожелаете, а историята на разговорите и данните за използването се съхраняват локално и не напускат компютъра ви.

Той поддържа локално изпълнение на модели с отворен код и позволява опционални връзки към отдалечени доставчици като API, съвместими с OpenAI, което го прави гъвкав, когато приоритет е офлайн използването, но понякога е необходим достъп до облака.

Януари ai най-добри характеристики

- Създайте асистенти със собствени инструкции и настройки, след което превключвайте между тях от раздела „Асистенти“, вместо да презаписвате подсказките всеки път.

- Свържете Jan с инструментите и източниците на данни на MCP, използвайки отворен стандарт, създаден за работни процеси, базирани на използването на инструменти.

- Инсталирайте разширения, за да добавите нови функции като уеб търсене или интерпретатор на код. Този модулен подход ви позволява да започнете с нещо просто и да добавяте повече мощност постепенно.

Януари. Ограничения на AI

- Януари може да позволи зареждането на файл с модел, който все още не е изтеглен напълно, което може да доведе до объркващо или непоследователно поведение, докато файлът не бъде завършен.

- Активирането на API може да повлияе на чатовете с низове, а основните крайни точки като „получаване на зареден модел“ или „размяна на модел“ може да не работят безпроблемно.

Януари ai ценообразуване

- Отворен код

Януари. Рейтинги и рецензии на ai

- G2: Недостатъчно отзиви

- Capterra: Недостатъчно отзиви

Какво казват реалните потребители за Jan. ai?

Един потребител на Reddit казва:

Jan. ai е моето любимо местно приложение за LLM. Страхотно е.

Jan. ai е моето любимо местно приложение за LLM. Страхотно е.

6. Llamafile (Най-подходящ за пакетиране на LLM в преносим изпълним файл)

Llamafile е проект, ръководен от Mozilla, който обединява пълна LLM с отворен код в един изпълним файл. Вместо да инсталирате среда за изпълнение, да управлявате зависимости или да свързвате отделен потребителски интерфейс, вие изтегляте един файл и го стартирате като приложение.

Основната идея е разпространението. „Llamafile“ включва тежестите на модела и компилирана среда за изпълнение, създадена да работи на различни операционни системи с минимална настройка. Това е особено полезно, когато офлайн инструмент трябва да бъде споделен с колеги, студенти или клиенти, които не могат да отстраняват проблеми при инсталирането.

Най-добрите функции на Llamafile

- Llamafile комбинира llama.cpp с Cosmopolitan Libc, за да поддържа широка бинарна преносимост, намалявайки работата по пакетиране, специфична за платформата.

- Сървърният режим предоставя уеб GUI и съвместим с OpenAI API крайни точки за допълване, което е полезно за локално разработване на приложения и замяна на облачни повиквания по време на тестване.

- Опакованите lamafiles са проектирани да работят на обичайни x86_64 и ARM64 машини, което улеснява разпространението им в смесени флоти.

Ограничения на Llamafile

- Изборът на модел е ограничен до това, което е пакетирано като Llamafile.

- Размерите на файловете са много големи, тъй като целият модел е вграден.

Цени на Llamafile

- Безплатен и с отворен код

Оценки и рецензии за Llamafile

- G2: Недостатъчно отзиви

- Capterra: Недостатъчно отзиви

🧠 Интересен факт: Първият уебсайт все още може да бъде посетен. CERN буквално го хоства на info.cern.ch, наричайки го „домът на първия уебсайт“.

7. PrivateGPT (Най-подходящ за офлайн въпроси и отговори върху вашите файлове с самостоятелно хостван RAG стек)

PrivateGPT е готов за производство, самостоятелно хостван проект, създаден за работни процеси от типа „чат с вашите документи“. Той поема локални файлове, индексира ги и отговаря на въпроси, като извлича подходящ контекст от вашето собствено съдържание, вместо да разчита на паметта на облачен чатбот. Проектът е проектиран да работи изцяло офлайн, с твърдението, че данните остават във вашата изпълнителна среда.

Това, което го отличава от обикновените офлайн чат приложения, е модулната архитектура. С други думи, можете да комбинирате LLM, вградения доставчик и векторния магазин в зависимост от хардуера и ограниченията за поверителност, след което да стартирате всичко чрез локален API + UI.

Най-добрите функции на PrivateGPT

- Въвеждайте PDF, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, изображения (JPG/PNG/JPEG) и дори MP3/MP4 с помощта на вградения канал за въвеждане.

- Конфигурирайте профили на слоеве с PGPT_PROFILES (например local,cuda), за да обедините няколко файла с настройки и да превключвате разгръщания, без да презаписвате основната си конфигурация.

- Филтрирайте отговорите към конкретен поднабор от въведени документи, като използвате context_filter при извикване на крайни точки за контекстуално попълване.

Ограничения на PrivateGPT

- Има по-високи изисквания към хардуера, тъй като работи с няколко компонента едновременно.

- Въвеждането на множество документи от един файл (например, един PDF файл, който генерира един документ на страница) може да увеличи обема и сложността на индексирането при управлението на големи качвания.

Цени на PrivateGPT

- Отворен код

PrivateGPT оценки и рецензии

- G2: Недостатъчно отзиви

- Capterra: Недостатъчно отзиви

8. Whisper. cpp (Най-доброто решение за изцяло офлайн преобразуване на реч в текст, което можете да вградите в приложения)

Whisper. cpp е високопроизводителна C/C++ реализация на модела за автоматично разпознаване на реч Whisper на OpenAI, създаден да работи локално без тежки зависимости от средата на изпълнение. Той е популярен за офлайн транскрипционни процеси, при които се изисква малък, преносим бинарен файл или библиотека в C стил, която можете да включите във вашия продукт.

Той е гъвкав и в различни среди, с официална поддръжка за настолни компютри, мобилни устройства, WebAssembly, Docker и дори хардуер от типа Raspberry Pi, което го прави подходящ за офлайн инструменти, които трябва да работят на повече от едно място.

„Cpp“ в името му показва, че е фокусиран върху производителността. Тази реализация е значително по-бърза и използва по-малко памет от алтернативите, базирани на Python, което прави възможна транскрипцията в реално време на съвременни компютри, без да е необходим мощен GPU.

Whisper. cpp най-добри характеристики

- Изпълнете Voice Activity Detection (VAD) като част от проекта за сегментиране на речта и намаляване на шумните транскрипции с празен звук в работните процеси от тип стрийминг.

- Квантувайте моделите Whisper, за да намалите изискванията към дисковото пространство и паметта, с множество опции за квантуване, предназначени за по-бързо локално извличане на заключения.

- Създайте с опционална поддръжка на FFmpeg в Linux, за да обработвате повече формати на входни данни, освен основния WAV.

Whisper. cpp ограничения

- Whisper. cpp CLI очаква по подразбиране 16-битови WAV входни данни, което добавя допълнителна стъпка за конвертиране при работа с MP3, MP4, M4A или други често използвани формати.

- Той не маркира по подразбиране говорещите (диаризация), което затруднява правилното приписване на цитати в записи с няколко говорещи.

Whisper. cpp ценообразуване

- Отворен код

Whisper. cpp оценки и рецензии

- G2: Недостатъчно отзиви

- Capterra: Недостатъчно отзиви

9. Уеб интерфейс за генериране на текст (най-подходящ за потребители, които искат браузър-базиран кокпит за локални LLM)

Text Generation Web UI (често наричан „oobabooga“) е уеб интерфейс, базиран на Gradio, за изпълнение на локални модели с акцент върху контрола и експериментирането. Той се държи по-скоро като пълноценна работна среда: множество модели бекенди, множество режими на взаимодействие и много настройки за генериране на поведение.

Той също така се насочва към работните процеси на „писатели/разработчици“, които много офлайн инструменти пропускат, с функции като автоматизация на формата на подсказките, генериране в стил бележник и разклоняване на разговорите. За офлайн настройки, които все още се нуждаят от уеб интерфейс, това е един от най-конфигурируемите фронтенд в тази категория.

Най-добрите функции на уеб интерфейса за генериране на текст

- Автоматично форматиране на подсказки с помощта на шаблони Jinja2, което намалява грешките във форматирането на подсказки в различни семейства модели

- Настройте десетки параметри, за да оптимизирате резултатите от изкуствения интелект според вашите конкретни нужди, независимо дали става въпрос за творческо писане, програмиране или ролеви игри.

- Редактиране на съобщения с навигация по версии и разклоняване на разговори, запазване на няколко посоки на един и същ чат, без да се започва отначало

Ограничения на уеб интерфейса за генериране на текст

- Инсталаторът с едно кликване изисква ~10 GB дисково пространство и изтегля PyTorch, което прави инсталирането тежка задача на машини с ограничено пространство за съхранение.

- Крайната точка за вграждане, съвместима с OpenAI, използва sentence-transformers/all-mpnet-base-v2 с 768-измерно вграждане, което може да наруши предположенията в тръбопроводите, изградени около 1536-измерните настройки по подразбиране на OpenAI.

Цени за уеб интерфейс за генериране на текст

- Отворен код

Оценки и отзиви за уеб интерфейса за генериране на текст

- G2: Недостатъчно отзиви

- Capterra: Недостатъчно отзиви

10. Llama. cpp (Най-подходящ за високопроизводителна локална LLM инференция на CPU и GPU)

Llama. cpp е C/C++ инферентен двигател и набор от инструменти за локално изпълнение на LLM с минимални зависимости и висока производителност на широк спектър от хардуер. Това е по-скоро локална среда за изпълнение, около която изграждате работни потоци, отколкото „чат приложение“, независимо дали става дума за CLI, локален HTTP сървър или вградена библиотека във вашия собствен продукт.

Макар да не е приложение за крайни потребители, Llama.cpp е двигателят, който захранва много от инструментите в този списък, включително GPT4All и LM Studio. То въведе формата на модела GGUF, която се превърна в стандарт за изпълнение на големи модели на потребителски хардуер чрез ефективно намаляване на техния размер.

Той предлага и връзки за популярни езици за програмиране като Python и Rust, а сървърният му режим може да предостави API, съвместим с OpenAI.

Llama. cpp най-добри характеристики

- Стартирайте локален сървър, съвместим с OpenAI API, с вграден уеб интерфейс и крайна точка /v1/chat/completions, използвайки llama-server.

- Изпълнете модел за вграждане (и дори модел за прекласифициране) от същия сървър за офлайн RAG пипалини, използвайки /embedding и /reranking.

- Квантувайте моделите до 1,5-битови до 8-битови, за да намалите използването на паметта и да ускорите локалната инференция, след което ускорете изпълнението с CUDA/Metal плюс Vulkan/SYCL бекенди, когато са налични.

Ограничения на Llama.cpp

- Llama. cpp не се предлага като изпипан десктоп асистент, което означава, че офлайн използването често включва CLI команди или хостинг на llama-server, а много потребители разчитат на потребителски интерфейси на трети страни за ежедневния чат.

- Съвместимостта на Llama.cpp с OpenAI не винаги е 1:1 с всяка функция на OpenAI клиента, а потребителите съобщават за несъответствия около структурирани изходни параметри като response_format в /v1/chat/completions.

Llama. cpp ценообразуване

- Отворен код

Какво казват реалните потребители за Llama. cpp?

Един рецензент от Sourceforge казва:

Страхотно. Демократизиране на изкуствения интелект за всички. И работи чудесно!

Страхотно. Демократизиране на изкуствения интелект за всички. И работи чудесно!

Превърнете офлайн AI резултатите в реална работа с ClickUp

Изборът на подходящия офлайн AI инструмент всъщност се състои в съобразяването на инструмента с задачата.

Ако сте тук, вероятно се стремите към три неща: поверителност, независимост от интернет и свобода от поредния абонамент.

Инструментите в този списък постигат това по различни начини. Това означава, че някои са по-подходящи за писане и програмиране, а други – за търсене, бележки или творческа работа.

Но за екипите по-голямото предизвикателство не е само да използват AI локално. То е да превърнат резултатите от AI в реални работни процеси.

С AI възможностите на ClickUp, интегрирани във вашите задачи, документи и знания, можете лесно да видите следващите стъпки на същото място, където се извършва работата (всичко това с корпоративна сигурност).

Опитайте ClickUp безплатно и вижте как изглежда, когато изкуственият интелект и изпълнението най-накрая съжителстват. ✨

Често задавани въпроси за офлайн AI инструменти

Да, след първоначалното изтегляне на файловете с моделите, много AI инструменти могат да работят изцяло на вашето устройство, без да е необходим интернет. Това ги прави идеални за работа с чувствителни данни или за работа на места с лоша връзка.

Локалните LLM обработват всички данни на вашето лично устройство, така че информацията ви никога не напуска вашата машина, докато облачната AI изпраща вашите команди към отдалечени сървъри за обработка. Локалните инструменти обикновено са безплатни за използване след настройката, докато облачната AI често включва абонаментни такси, но може да предлага по-мощни модели.

По-малките модели с 1-3 милиарда параметри могат да работят на повечето съвременни лаптопи с 8 GB RAM. По-големите и по-мощни модели с 7 милиарда или повече параметри работят най-добре с 16 GB или повече RAM и специален GPU, като Apple Silicon Macs и NVIDIA GPU осигуряват значително повишаване на производителността.

![10-те най-добри AI инструмента, които работят офлайн през [година]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)