Előfordult már, hogy az AI-modellje olyan magabiztos választ adott, amelyet a felhasználók elavultnak tartottak? Ez az a fajta élmény, amelynek eredményeként a csapata minden válaszát megkérdőjelezi.

Ez minden fejlesztő és AI-rajongó rémálma, nem igaz?

A nagy nyelvi modellek (LLM-ek) képzési adatokon futnak, de az adatok elavulásával pontatlanságok csúsznak be. Mivel az újraképzés milliókba kerül, az optimalizálás a okosabb megoldás.

A Retrieval Augmented Generation (RAG) és a finomhangolás a pontosság növelésének legfontosabb keretrendszerei. Az egyes megközelítések közötti különbségek miatt azonban ezek különböző alkalmazásokhoz ideálisak. A megfelelő keretrendszer kulcsfontosságú az LLM hatékony fejlesztéséhez.

De melyik a megfelelő az Ön számára?

Ez a cikk a RAG és a finomhangolás közötti dilemmát tárgyalja. Akár domain-specifikus adatokkal dolgozik, akár kiváló minőségű adat-visszakeresési megoldásokat szeretne létrehozni, itt megtalálja a választ!

⏰60 másodperces összefoglaló

- Az LLM-ek és az AI-modellek teljesítményének javítása minden üzleti és fejlesztési tevékenység kulcsfontosságú része. Bár a RAG és a finomhangolás népszerű megközelítések, fontos megérteni azok finom különbségeit és hatását.

- A RAG valós idejű, külső adatlekérdezési képességgel ruházza fel az LLM-eket, csökkentve ezzel az újratanítás költségeit.

- A finomhangolás speciális adatkészleteken történő képzéssel optimalizálja az LLM-eket, javítva a domain-specifikus feladatok pontosságát.

- A RAG a legalkalmasabb a gyorsan változó adatkörnyezetekben, mint például a pénzügyek, a jogi frissítések és az ügyfélszolgálat.

- A finomhangolás ideális márkakülönleges AI-hez, a szabályozási követelményekkel terhelt iparágakhoz és a hangulatelemzéshez.

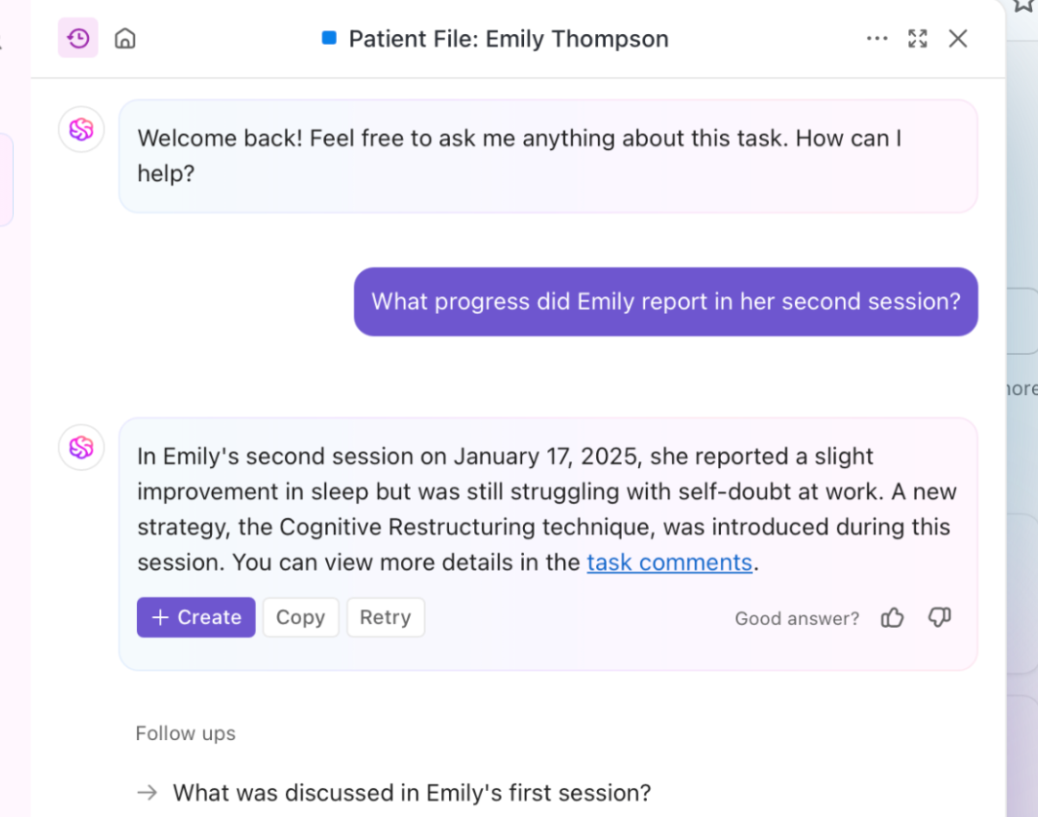

- A ClickUp Brain mindkettőt ötvözi: a RAG-ot a kontextusbeli betekintéshez, a finomhangolást pedig a testreszabott automatizáláshoz és tartalomgeneráláshoz használja.

- A ClickUp mesterséges intelligenciával működő eszközei hatékonyabbá teszik a tudás visszakeresést, a munkafolyamatok automatizálását és a projektmenedzsmentet a maximális hatékonyság érdekében.

Mi az a visszakereséssel kiegészített generálás (RAG)?

Friss jelentéseket és felméréseket keres, amelyeket az LLM nem vett figyelembe? Ehhez van szüksége a RAG-ra. Hogy jobban megértsük ezt, nézzük meg ennek a megközelítésnek az alapjait.

A RAG meghatározása

A RAG egy olyan mesterséges intelligencia keretrendszer, amely további információkat gyűjt az LLM számára a válaszok pontosságának javítása érdekében. Az LLM válaszok generálása előtt a legrelevánsabb adatokat külső forrásokból, például tudásbázisokból vagy adatbázisokból gyűjti össze.

Gondoljon rá úgy, mint az LLM vagy a generatív AI modell kutatási asszisztensére.

👀 Tudta? Az LLM-ek, különösen a szöveggenerátorok, hamis, de hihető információkat generálva hallucinálhatnak. Mindez a képzési adatok hiányosságainak köszönhető.

A RAG legfontosabb előnyei

Mostanra már valószínűleg egyértelmű. A RAG egy további kapcsolódó AI réteg, amelyre üzleti folyamatainak szüksége van. Hogy rávilágítsunk a benne rejlő potenciálra, íme néhány előnye:

- Csökkentett képzési költségek: Dinamikus információ-visszakeresésével kiküszöböli a gyakori modell-újraképzés szükségességét. Ez költséghatékonyabb AI-bevezetéshez vezet, különösen a gyorsan változó adatokkal rendelkező területeken.

- Skálázhatóság: Bővíti az LLM tudását anélkül, hogy növelné az elsődleges rendszer méretét. Segítenek a vállalkozásoknak a skálázásban, a nagy adathalmazok kezelésében és több lekérdezés futtatásában, anélkül, hogy magas számítástechnikai költségek merülnének fel.

- Valós idejű frissítések: Minden válaszban tükrözi a legfrissebb információkat, és biztosítja a modell relevanciáját. A valós idejű frissítések révén a pontosság előtérbe helyezése számos területen elengedhetetlen, többek között a pénzügyi elemzés, az egészségügy és a megfelelőségi ellenőrzések terén.

📮 ClickUp Insight: A válaszadók fele küzd az AI bevezetésével; 23% egyszerűen nem tudja, hol kezdje, míg 27% további képzésre szorul, hogy bármilyen haladó feladatot elvégezzen.

A ClickUp egy ismerős, SMS-hez hasonló csevegőfelülettel oldja meg ezt a problémát. A csapatok egyszerű kérdésekkel és kérésekkel azonnal belevághatnak, majd a munka során természetesen felfedezhetik a hatékonyabb automatizálási funkciókat és munkafolyamatokat, anélkül, hogy meg kellene küzdeniük a sokakat visszatartó, ijesztő tanulási görbével.

RAG használati esetek

Kíváncsi arra, hogy a RAG hol nyújt kiemelkedő teljesítményt? Vegye figyelembe az alábbi főbb felhasználási eseteket:

Csevegőrobotok és ügyfélszolgálat

Az ügyfelek kérdései gyakran naprakész és kontextusérzékeny válaszokat igényelnek. A RAG a legfrissebb támogatási cikkek, irányelvek és hibaelhárítási lépések lekérésével növeli a chatbot képességeit.

Ez lehetővé teszi a pontosabb, valós idejű segítségnyújtást, anélkül, hogy előzetes, kiterjedt képzésre lenne szükség.

Dinamikus dokumentum-visszakeresés

A RAG optimalizálja a dokumentumkeresést azáltal, hogy a legrelevánsabb szakaszokat kiválasztja a hatalmas adattárakból. Az általános összefoglalók helyett az LLM-ek pontos válaszokat adhatnak frissített kézikönyvekből, kutatási cikkekből vagy jogi dokumentumokból.

A RAG-alapú LLM-ek alkalmazásával az információkeresés gyorsabbá és pontosabbá válik.

🧠 Érdekesség: A Facebook, Instagram, Threads és WhatsApp tulajdonosa, a Meta 2020-ban vezette be a RAG-ot az LLM fejlesztésébe.

Mi az a finomhangolás?

Nézzük meg, mit is jelent a finomhangolás.

A finomhangolás meghatározása

A finomhangolás egy előre betanított nyelvi modell betanítását jelenti. Igen, sok betanítást, ami pontosan és fókuszáltan magyarázható.

🧠 Tudta-e: A nagy nyelvi modell (LLM) képzésében a „súlyok” azok a neurális hálózatban beállítható paraméterek, amelyek meghatározzák a neuronok közötti kapcsolatok erősségét, lényegében tárolva a megtanult információkat; a képzési folyamat optimalizálja ezeket a súlyokat a predikciós hibák minimalizálása érdekében.

A „fókusz” viszont több szempontot is magában foglal: gondos adatkezelést igényel a minőség és a relevancia biztosítása érdekében, figyelemmechanizmusok alkalmazását a releváns bemeneti szegmensek prioritásba helyezése érdekében, valamint célzott finomhangolást a modell specifikus feladatokra való specializálása érdekében.

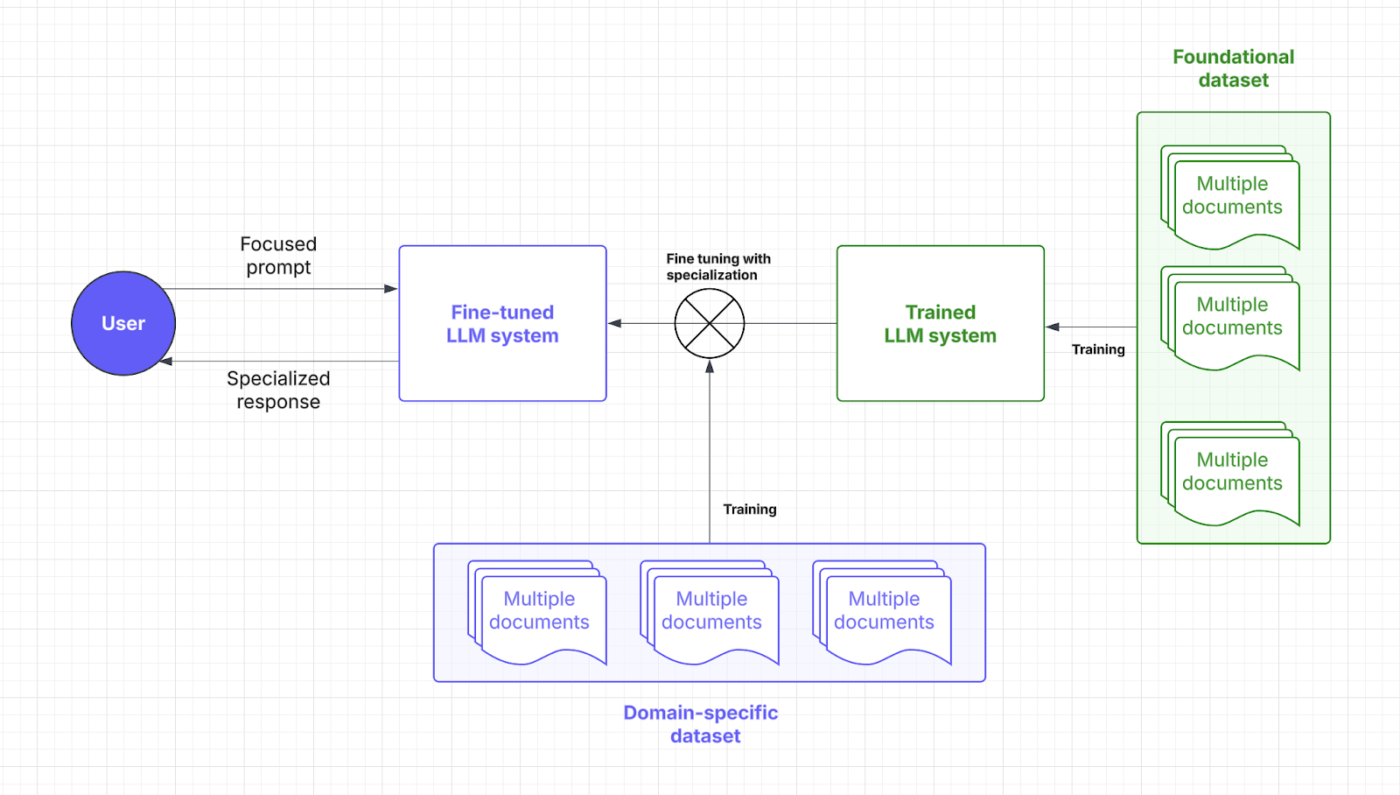

A finomhangolás speciális adatkészletek segítségével lehetővé teszi az AI-modellek számára, hogy szűkítsék a domain-specifikus feladatok végrehajtását. A modell súlyozásának és fókuszának módosításával az LLM jobb kontextusértelmezést és pontosságot ér el.

Gondoljon a finomhangolásra úgy, mint egy mesterképzésre, amelyre az LLM-nek szüksége van ahhoz, hogy az Ön iparágának nyelvét beszélje. Nézzük meg, hol kerül be ez az AI-stratégia a gyors válaszadási folyamatba:

A finomhangolás előnyei

A finomhangolási technikák csupán az AI finomhangolását jelentik. Inkább olyan, mintha előre meghatározott részletekre tudna ráközelíteni. Íme az ezzel járó előnyök:

- Feladatspecifikus optimalizálás: A speciális adatkészletek pontosítják az LLM válaszokat bizonyos feladatokhoz. Szeretné megkönnyíteni a felhasználók számára a bonyolult parancsok használatát? A finomhangolás segít a fejlesztőknek személyre szabott AI megoldásokat készíteni.

- Jobb pontosság niche alkalmazásokhoz: A domain ismeretek csökkentik a hibákat és javítják az egyes válaszok pontosságát. A finomhangolás emellett növeli az LLM megbízhatóságát, így a vállalkozásoknak nem kell aggódniuk a mikromanagement és a manuális felügyelet miatt.

- Testreszabás a márka hangjának és a szabályoknak való megfelelés érdekében: A finomhangolás megtanítja az LLM-eknek a vállalati kifejezéseket, stílust és szabályokat. Ez biztosítja a márka hangjának következetességét és az iparágra vonatkozó szabályoknak való megfelelést.

➡️ Olvassa el még: AI technikák: gépi tanulás, mélytanulás és NLP elsajátítása

Finomhangolás használati esetei

A finomhangolási folyamat célzott hatékonyságot eredményez. Íme, miben jeleskedik:

Doménspecifikus minőségbiztosítási rendszerek

Az olyan iparágak, mint a jogi, az egészségügyi és a pénzügyi szektor, pontos, a területet ismerő AI-válaszokra támaszkodnak. A finomhangolás speciális ismeretekkel látja el az LLM-eket, biztosítva a pontos kérdés-válasz (QA) funkciót.

Például egy jogi AI-asszisztens pontosabban tudja értelmezni a szerződéseket, míg egy orvosi chatbot megbízható adatkészletek segítségével tüneteken alapuló útmutatást tud nyújtani.

Érzelemelemzés és egyedi munkafolyamatok

A vállalkozások finomhangolt modelleket használnak a márkák figyelemmel kísérésére, a vásárlói visszajelzések elemzésére és az egyedi működési igényekhez igazított munkafolyamatok automatizálására. Az AI-alapú eszközök képesek felismerni a termékértékelésekben rejlő finom érzelmi árnyalatokat, segítve ezzel a vállalatokat kínálatuk finomításában.

A HR területén a finomhangolás és a természetes nyelvfeldolgozás kombinálása segít az AI-nek a munkavállalói felmérések elemzésében és a munkahelyi problémák jelzésében, nagyobb kontextuális tudatossággal.

💡 Profi tipp: A finomhangolás magában foglalhatja többféle adat hozzáadását a lehetséges torzítások kiküszöbölése érdekében. Ez nem feltétlenül domain-specifikus, de mégis fontos alkalmazás.

Összehasonlítás: RAG vagy finomhangolás

Tagadhatatlan, hogy mindkét AI-stratégia a teljesítmény növelését célozza.

De a választás még mindig elég bonyolultnak tűnik, igaz? Íme egy összehasonlítás a finomhangolás és a RAG között, hogy segítsen meghozni a megfelelő döntést az LLM-be történő befektetéseivel kapcsolatban.

| Aspektus | RAG (visszakereséssel kiegészített generálás) | Finomhangolás |

| Meghatározás | Lehetővé teszi az LLM számára, hogy dedikált rendszerével valós időben releváns adatokat szerezzen be külső forrásokból. | Előre betanított modellt tanít speciális adatkészletekkel domain-specifikus feladatokhoz. |

| Teljesítmény és pontosság | Kiválóan alkalmas valós idejű adatlekérésre, de a pontosság a külső adatok minőségétől függ. | Javítja a kontextus pontosságát és a feladatspecifikus válaszokat |

| Költségek és erőforrásigény | A költséghatékonyabb előzetes befektetés a valós idejű adat-hozzáférésre összpontosít. | Több erőforrást igényel a kezdeti képzéshez, de hosszú távon költséghatékony. |

| Karbantartás és skálázhatóság | Nagyon jól skálázható és rugalmas, de a külső források frissítésének gyakoriságától függ. | Gyakori frissítéseket és karbantartást igényel, de stabil, hosszú távú teljesítményt nyújt. |

| Használati esetek | Csevegőrobotok, dinamikus dokumentumkeresés, valós idejű elemzés | Doménspecifikus minőségbiztosítási rendszerek, érzelemelemzés és márka hangjának testreszabása |

| Mikor válasszon? | Gyorsan változó adatok, valós idejű frissítések és az erőforrásköltségek prioritása | Niche ügyfélszegmensek, domain-specifikus logika, márka-specifikus testreszabás |

| Ideális | Az iparágaknak valós idejű, pontos információkra van szükségük (pénzügy, jog, ügyfélszolgálat). | Olyan iparágak, amelyek speciális nyelvet, megfelelőséget vagy kontextust igényelnek (egészségügy, jog, HR) |

Szüksége van egy kis további magyarázatra, hogy eloszlassa kétségeit? Itt talál egy összehasonlítást a legfontosabb szempontokról, amelyek befolyásolják az Ön igényeit.

Teljesítmény és pontosság

A teljesítmény tekintetében a RAG kulcsszerepet játszik azáltal, hogy új adatokat von be külső forrásokból. Pontossága és válaszideje az adatok minőségétől függ. A külső adatbázisokra való támaszkodás lehetővé teszi a RAG számára, hogy hatékonyan szolgáltasson naprakész információkat.

A finomhangolás viszont speciális újraképzéssel javítja a modell feldolgozási és válaszadási képességét. Ez a folyamat kontextusban pontosabb válaszokat eredményez, különösen niche alkalmazások esetében. A finomhangolt LLM-ek ideálisak a követelmények szigorú iparágakban, például az egészségügyben vagy a pénzügyekben, a konzisztencia fenntartásához.

Összegzés: A RAG kiválóan alkalmas valós idejű adatokhoz és a kontextusban pontos válaszok finomhangolásához.

Egy Reddit-felhasználó szerint

Ha kis modellt és jó adatbázist használ a RAG-folyamatban, akkor kiváló minőségű adatkészleteket hozhat létre, amelyek jobbak, mint a kiváló minőségű AI kimenetei.

Ha kis modellt és jó adatbázist használ a RAG-folyamatban, akkor kiváló minőségű adatkészleteket hozhat létre, amelyek jobbak, mint a kiváló minőségű AI kimenetei.

💡 Profi tipp: Ahhoz, hogy az LLM-et egy adott kimenet felé irányítsa, összpontosítson a hatékony, gyors tervezésre.

Költségek és erőforrásigény

A RAG általában előzetesen költséghatékonyabb, mivel csak egy réteget ad hozzá a külső adatok lekéréséhez. Mivel nem szükséges az egész modellt újratréningezni, ez egy sokkal költséghatékonyabb megoldásnak bizonyul, különösen dinamikus környezetekben. Azonban a valós idejű adat-hozzáférés és -tárolás működési költségei megnőhetnek.

A finomhangolás több adatkészlet-előkészítést és képzési erőforrást igényel, de hosszú távú befektetés. A finomhangolás után az LLM-ek kevesebb frissítést igényelnek, ami előre jelezhető teljesítményt és költségmegtakarítást eredményez. A fejlesztőknek mérlegelniük kell a kezdeti befektetést és a folyamatos működési költségeket.

Összegzés: A RAG költséghatékony, egyszerűen megvalósítható és gyors eredményeket hoz. A finomhangolás előzetesen erőforrás-igényes, de javítja az LLM minőségét és hosszú távon megtakarítást jelent a működési költségekben.

💡 Profi tipp: A RAG rendszere csak annyira intelligens, mint az adatok, amelyekből merít. Tartsa tisztán forrásait, és töltse meg őket pontos, naprakész adatokkal!

Karbantartás és skálázhatóság

A RAG kiváló skálázhatóságot kínál, mivel elsősorban a külső forrás bővítésére összpontosít. Rugalmassága és alkalmazkodóképessége miatt tökéletesen alkalmas a gyorsan változó iparágak számára. Karbantartása azonban a külső adatbázisok frissítésének gyakoriságától függ.

A finomhangolás meglehetősen gyakori karbantartást igényel, különösen akkor, ha a domain-specifikus információk változnak. Bár több erőforrást igényel, idővel nagyobb konzisztenciát biztosít, és fokozatosan kevesebb beállítást igényel. Ugyanakkor a finomhangolás skálázhatósága sokkal komplexebb, mivel kiterjedtebb és sokszínűbb adatkészleteket igényel.

Összegzés: A RAG a legjobb megoldás a gyors méretezhetőség és a finomhangolás szempontjából, minimális karbantartási igény és stabil teljesítmény mellett.

Egy Reddit-felhasználó hozzáteszi:

Ha a feladat kicsi, gyakran hatékonyabb egy nagyobb modellt használni, mint egy kisebbet finomhangolni.

Ha a feladat kicsi, gyakran hatékonyabb egy nagyobb modellt használni, mint egy kisebbet finomhangolni.

👀 Tudta? Vannak olyan AI-megoldások, amelyek már képesek szagokat érzékelni. A parfümök összetettsége miatt ez rengeteg rendszeres finomhangolást és komplex adatlekérdezést igényel.

Melyik megközelítés a megfelelő az Ön felhasználási esetéhez?

Annak ellenére, hogy megértette a finom különbségeket, a döntés meghozatala üresnek tűnhet, ha nincs egyértelmű referencia vagy kontextus. Végezzünk el néhány üzleti forgatókönyvet, amelyek rávilágítanak arra, hogy melyik AI-modell működik jobban.

Mikor érdemes a RAG-ot választani?

A RAG segít a megfelelő tényekkel és információkkal ellátni az LLM-et, beleértve a műszaki szabványokat, az értékesítési adatokat, az ügyfelek visszajelzéseit és egyebeket.

Hogyan alkalmazhatja ezt a gyakorlatban? Vegye fontolóra az alábbi forgatókönyveket a RAG bevezetéséhez:

1. használati eset: Valós idejű elemzés

- Szituáció: Egy fintech vállalat AI-alapú piaci információkat nyújt kereskedőknek. A felhasználók a részvények árfolyamának alakulásáról érdeklődnek, és a rendszernek be kell szereznie a legfrissebb piaci jelentéseket, SEC-bejelentéseket és híreket.

- Miért nyer a RAG: A tőzsdepiacok gyorsan változnak, ezért az AI-modellek folyamatos újratanítása drága és hatástalan. A RAG csak a legfrissebb pénzügyi adatokat használja, így biztosítva a pontosságot, csökkentve a költségeket és növelve a hatékonyságot.

- Általános szabály: A RAG legyen az elsődleges stratégiája az AI számára a gyorsan változó adatok kezeléséhez. Népszerű alkalmazások: közösségi média adatelemzés, energiaoptimalizálás, kiberbiztonsági fenyegetések észlelése és megrendelések nyomon követése.

2. felhasználási eset: Adatellenőrzés és szabályozási megfelelés

- Szituáció: Egy jogi AI-asszisztens segít az ügyvédeknek szerződések megfogalmazásában és a változó jogszabályoknak való megfelelés ellenőrzésében azáltal, hogy lekérdezi a legfrissebb törvényeket, precedenseket és ítéleteket.

- Miért nyer a RAG: A jogi és kereskedelmi szempontok ellenőrzése nem indokolja a viselkedés mélyreható frissítését. A RAG nagyon jól végzi a feladatát, mivel valós időben lekérdezi a jogi szövegeket egy központi adatbázisból.

- Általános szabály: A RAG erőssége a források és statisztikák alapján nyert betekintés. Ezt legjobban úgy lehet kihasználni, ha orvosi AI-asszisztenseket használunk kezelési ajánlásokhoz, és ügyfélszolgálati chatbotokat a problémamegoldáshoz és a szabályzatok frissítéséhez.

Még mindig nem tudja, hogy szüksége van-e RAG-ra az LLM-ben? Íme egy gyors ellenőrzőlista:

- Szüksége van új, kiváló minőségű adatokra anélkül, hogy magát az LLM-et megváltoztatná?

- Gyakran változnak az információi?

- Az LLM-nek statikus képzési adatok helyett dinamikus információkkal kell dolgoznia?

- Szeretné elkerülni a nagy költségeket és az időigényes modell újratanítást?

➡️ Olvassa el még: A legjobb prompt engineering eszközök generatív AI-hez

Mikor hatékonyabb a finomhangolás?

Mint már említettük, a finomhangolás az AI posztgraduális képzése. Az LLM még az iparági szakzsargont is megtanulhatja. Íme egy iparági áttekintés arról, mikor érvényesül igazán:

1. felhasználási eset: A márka hangjának és hangnemének hozzáadása

- Szituáció: Egy luxusmárka létrehoz egy AI-koncierget, amely kifinomult, exkluzív hangnemben kommunikál az ügyfelekkel. A konciergének meg kell testesítenie a márka sajátos hangnemét, kifejezésmódját és érzelmi árnyalatait.

- Miért nyer a finomhangolás: A finomhangolás segít az AI-modellnek megragadni és reprodukálni a márka egyedi hangját és hangnemét. Minden interakció során konzisztens élményt nyújt.

- Általános szabály: A finomhangolás hatékonyabb, ha az LLM-eknek egy adott szakterülethez kell alkalmazkodniuk. Ez ideális a műfajorientált, magával ragadó játékokhoz, a tematikus és empatikus történetmeséléshez, vagy akár a márkás marketing szövegekhez is.

🧠 Érdekesség: Az ilyen soft skill-ekkel képzett LLM-ek kiválóan alkalmasak a munkavállalók hangulatának és elégedettségének elemzésére. Jelenleg azonban csak a vállalkozások 3%-a használ generatív mesterséges intelligenciát a HR területén.

2. felhasználási eset: Tartalom moderálás és kontextusalapú betekintés

- Szituáció: Egy közösségi média platform AI modellt használ a káros tartalmak felismerésére. A platformra jellemző nyelv, az új szleng és a kontextusfüggő szabályszegések felismerésére összpontosít.

- Miért nyer a finomhangolás: A mondatalkotáshoz hasonló soft skill-ek gyakran kívül esnek a RAG-rendszerek hatókörén. A finomhangolás javítja az LLM platformspecifikus árnyalatok és iparági szakzsargon megértését, ami különösen releváns a tartalom moderálásában.

- Általános szabály: A finomhangolás választása akkor célszerű, ha kulturális vagy regionális különbségekkel kell számolni. Ez kiterjed az iparág-specifikus kifejezésekhez való alkalmazkodásra is, például az orvosi, jogi vagy műszaki szaknyelvre.

Finomhangolni szeretné az LLM-et? Tegye fel magának a következő kulcsfontosságú kérdéseket:

- Az LLM-nek egy niche ügyfélszegmensnek vagy márka témának kell megfelelnie?

- Szeretne saját vagy domain-specifikus adatokat hozzáadni az LLM logikájához?

- Szüksége van gyorsabb válaszokra a pontosság romlása nélkül?

- Az LLM-jei offline megoldásokat nyújtanak?

- Külön erőforrásokat és számítási kapacitást tud-e elkülöníteni az újratanításhoz?

A felhasználói élmény javítása nagyszerű dolog. Azonban sok vállalkozásnak az AI-ra a termelékenység növelése érdekében is szüksége van, hogy igazolja a magas beruházási költségeket. Ezért sokan gyakran választják az előre betanított AI-modelleket.

👀 Tudta? A Gen AI képes automatizálni a munkatevékenységeket, ami akár 70 százalékos időmegtakarítást jelenthet az alkalmazottak számára. Ehhez nagy szerepet játszik az AI hatékony kihasználása!

Hogyan használja a ClickUp a fejlett AI technikákat?

A RAG és a finomhangolás közötti választás meglehetősen nagy vitát vált ki.

Még néhány Reddit-szál átnézése is elég ahhoz, hogy összezavarodjon. De ki mondta, hogy csak egyet kell választania?

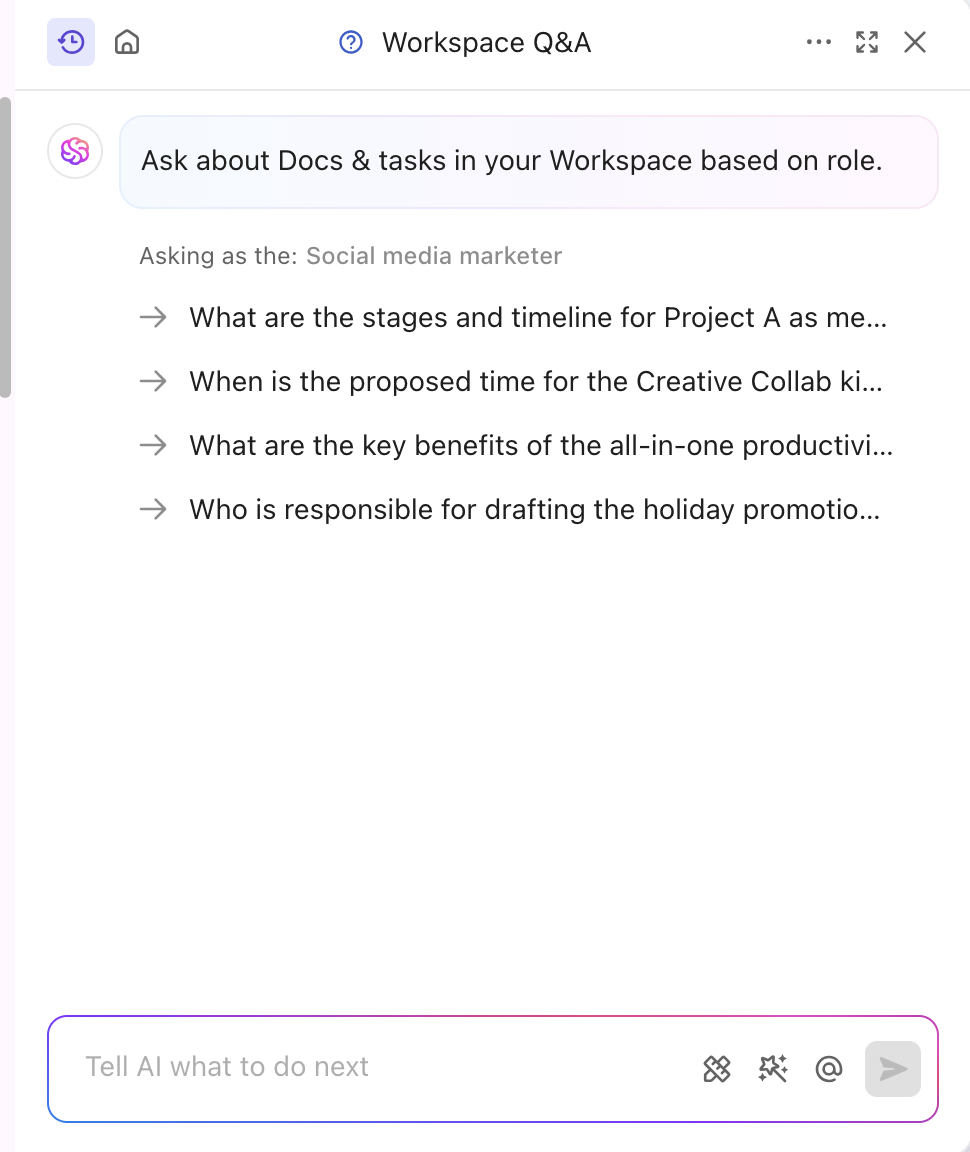

Képzelje el, hogy testreszabható AI-modellek, automatizálás és feladatkezelés egy helyen áll rendelkezésre. Ez a ClickUp, a munkához szükséges mindenre kiterjedő alkalmazás. A projektmenedzsmentet, a dokumentációt és a csapatkommunikációt egy helyen egyesíti, és a legújabb generációs AI hajtja.

Röviden: mindenben kiváló, különösen átfogó AI-megoldásával: a ClickUp Brain-nel.

Gyors, kontextusérzékeny betekintésre van szüksége? A Brain valós idejű információkat gyűjt dokumentumaiból, feladataiból és erőforrásaiból. Ez a továbbfejlesztett RAG működés közben. Ráadásul alapvető LLM-je, a Brain, jelentéseket és rutin projektfrissítéseket is generálhat.

Az AI eszköz az Ön iparágához és szegmenséhez is finomhangolva van, így professzionális és kreatív betekintést nyújt. Manuális képzés nélkül, valós időben személyre szabja a tartalmat. A Brain ötvözi a finomhangolást és a RAG-ot a projektfrissítések, a feladatkiosztások és a munkafolyamat-értesítések automatizálása érdekében. Olyan válaszokat szeretne, amelyek az Ön szerepéhez igazodnak? A ClickUp Brain ezt is meg tudja oldani!

A tartalomra való specializálódás mellett a ClickUp platformját egy hatékony, tudásalapú AI funkció is támogatja.

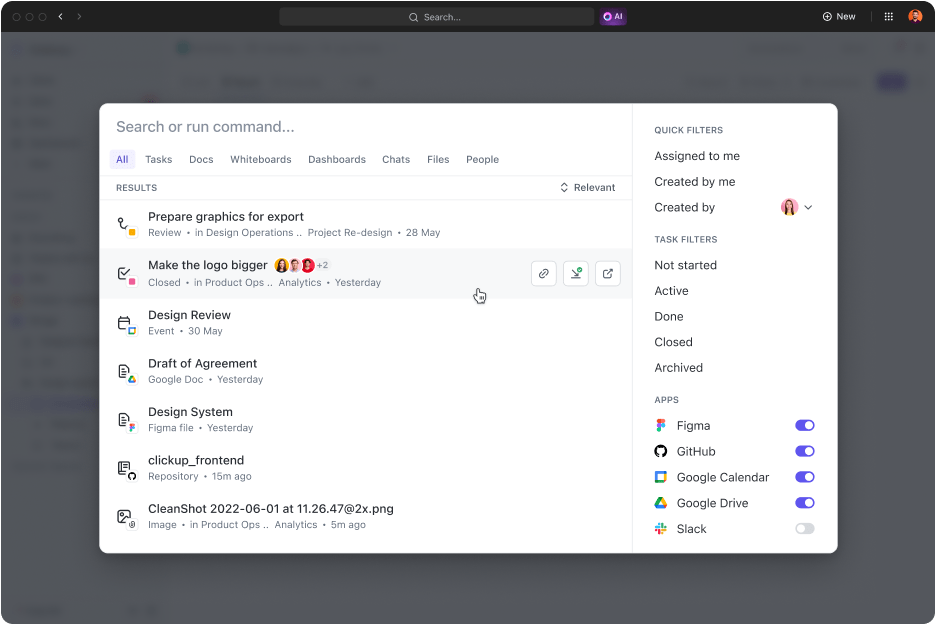

A ClickUp Connected Search egy mesterséges intelligenciával működő eszköz, amely gyorsan lekérdez bármilyen forrást az integrált térből. Akár dokumentumokra van szüksége a mai standuphoz, akár válaszokra bármely feladathoz, egy egyszerű lekérdezéssel forráslinkeket, hivatkozásokat és részletes információkat kaphat.

Emellett alkalmazásokat indít, a vágólap történetét keresi és kivonatokat hoz létre. És a legjobb az egészben? Mindez egyetlen kattintással elérhető a parancsközpontból, az akciósávból vagy az asztalról.

A digitális marketing szakértői, a Hum JAM elnöke szerint

A ClickUp a legcsodálatosabb „all-in-one” csapat-automatizálási eszköz, amely nyomon követi, automatizálja és méri a csapat sikereit. Higgyen nekem, amikor azt mondom, hogy csapata nem tud meglenni e nélkül az eszköz nélkül.

A ClickUp a legcsodálatosabb „all-in-one” csapat-automatizálási eszköz, amely nyomon követi, automatizálja és méri a csapat sikereit. Higgyen nekem, amikor azt mondom, hogy csapata nem tud meglenni e nélkül az eszköz nélkül.

➡️ Olvassa el még: A gépi tanulás és a mesterséges intelligencia közötti különbség

A Gen AI és az LLM pontosságának növelése a ClickUp segítségével

A RAG teljesítményreakciói, amelyeket friss külső adatok és finomhangolás élesít, specifikus feladatokra és viselkedésformákra használhatók. Mindkettő javítja az AI teljesítményét, de a megfelelő megközelítés határozza meg a tempót és a hatékonyságot.

A dinamikus iparágakban a döntés gyakran azon múlik, hogy melyik módszert alkalmazzák először. Általában a hatékony, előre betanított megoldás a bölcsebb választás.

Ha javítani szeretné a szolgáltatás minőségét és a termelékenységet, a ClickUp kiváló partner lehet. AI-képességei elősegítik a tartalomgenerálást, az adatok visszakeresését és az analitikus válaszokat. Ráadásul a platform több mint 30 eszközzel rendelkezik, amelyek mindent lefednek a feladatkezeléstől a lenyűgöző vizuális elemek generálásáig.

Regisztráljon még ma a ClickUp-ra!